|

Chapitre I : Revue de la littérature théorique

et empirique de la détermination du taux de change

d'équilibre

Introduction Générale

L'importante volatilité

observée des taux de change réels pose de manière

récurrente le problème de la détermination d'un niveau de

référence ou d'équilibre. En outre, l'efficacité du

taux de change en tant qu'instrument de la politique économique

dépend fortement de la connaissance de son niveau d'équilibre. En

effet, en l'absence d'une telle référence, les notions de sous ou

surévaluation d'une monnaie par rapport à une autre n'auraient

plus aucun sens. Il apparaît donc primordial de s'intéresser

à la détermination des taux de change d'équilibre. Les

nombreux travaux dans ce domaine

ont pour objet de mettre en évidence une valeur de

référence de long terme, fonction

de variables fondamentales, vers laquelle doit converger

le taux de change réel. Comme le rappelle Cadiou [1999], la notion

d'équilibre envisagée ici provient du fait que les

économies nationales sont au plein emploi et que leur position

extérieure nette

est à un niveau jugé satisfaisant.

La théorie de

référence en termes de détermination du taux

de change d'équilibre est la théorie de la parité des

pouvoirs d'achat. Cependant, même si cette théorie peut

s'avérer utile pour déterminer un niveau de

référence à long terme des taux de change nominaux,

elle apparaît fortement limitée dés lors que l'on raisonne

en termes réels. Cette théorie stipule en effet que le taux de

change réel est constant, ce

qui semble difficilement s'accorder avec les importantes

fluctuations que l'on observe empiriquement. En outre, étant

essentiellement fondée sur la loi du prix unique, la

théorie de la parité des pouvoirs d'achat ignore

toute référence à l'équilibre

macroéconomique. Ces limites nous conduirons à expliciter

l'approche monétaire du taux de change pour en distinguer d'autres

approches alternatives dont l'approche macroéconomique et l'approche

NATREX.

L'approche macroéconomique consiste

à interpréter le taux de change réel comme un

indicateur de la compétitivité globale d'un pays. Nous verrons

que cette approche occupe aujourd'hui une place fondamentale dans les travaux

portant sur ce thème. La deuxième approche a pour objet de

rechercher les fondements

microéconomiques du taux de change.

Chapitre I : Revue de la littérature théorique

et empirique de la détermination du taux de change

d'équilibre

Le premier travail consiste donc à

présenter ces diverses approches du taux de change réel

d'équilibre. Une fois ces théories sont explicitées, nous

avons mené une étude empirique afin d'étudier la

relation entre le taux de change réel et les

fondamentaux. Les méthodes mises en oeuvre font largement appel aux

tests de racines unitaires, à la cointégration. L'idée

est donc d'exhiber une relation de long terme entre

le taux de change réel et les fondamentaux (relation de

cointégration) et d'en expliquer

les déviations entre eux.

Chapitre I - Revue de la litterature théorique et

empirique de la détermination du taux de change d'équilibre

Introduction

L'importante volatilité

observée des taux de change réels pose de manière

récurrente le problème de la détermination d'un niveau de

référence ou d'équilibre. En outre, l'efficacité du

taux de change en tant qu'instrument de la politique économique

dépend fortement de la connaissance de son niveau d'équilibre.

L'objet de ce chapitre est ainsi de

présenter les diverses théories de détermination

du taux de change réel d'équilibre. Face aux insuffisances de la

théorie

de la parité des pouvoirs d'achat, de l'approche

monétaire du taux de change deux nouvelles approches se sont

privilégiées : l'approche macroéconomique et l'approche

NATREX. Le développement de la littérature consacrée

aux taux de change réels

d'équilibre nous conduit ensuite à dresser un

panorama des travaux empiriques.

Section1- Des insuffisances de la parité des

pouvoirs d'achat et l'approche

monétaire du taux de change

Après avoir rappelé

brièvement les principales spécificités de la

théorie de la parité des pouvoirs d'achat, nous mettrons en

avant les insuffisances d'une telle théorie dans la détermination

du taux de change réel d'équilibre. Ces limites nous conduirons

à expliciter l'approche monétaire du taux de change pour

en distinguer d'autres approches alternatives dont l'approche

macroéconomique et l'approche NATREX, que nous présenterons les

grandes lignes.

1.1- Les insuffisances de la parité des pouvoirs

d'achat en tant que théorie

de détermination des taux de change réels

d'équilibre

1.1.1- La parité de pouvoir d'achat

La parité des pouvoirs d'achat1

(PPA) constitue la théorie la plus fréquemment

utilisée pour déterminer les taux de change

d'équilibre. Cette théorie existe en deux formes : la forme

absolue et la forme relative.

La forme absolue de la PPA s'applique

en l'absence de toute entrave au commerce international (barrières

tarifaires, barrières non tarifaires, etc.) en supposant

négligeables les coûts de transaction et d'information. Selon

cette approche, la valeur

du taux de change nominal est déterminée

par le rapport des niveaux de prix entre deux pays. Cette

définition découle de la loi du prix unique selon laquelle le

prix d'un bien échangeable est identique partout, une fois converti dans

une monnaie commune.

La réalisation de cette loi suppose alors que les taux de

change réels bilatéraux sont toujours égaux à

l'unité.

En présence d'entraves au commerce

international, la loi du prix unique ne s'applique plus. Le principe

de la PPA peut alors s'exprimer sous une version dite

1 On rappelle que cette théorie a

été introduit par Cassel en 1916 qui a suggéré de

définir le niveau du taux de change nominal d'équilibre comme le

taux assurant la parité de pouvoir d'achat entre deux monnaies : une

unité monétaire quelconque peut être échangée

contre la même quantité de biens dans son pays d'origine ou dans

tout

autre pays après conversion en monnaie locale.

relative : une variation du taux de change nominal vient

compenser l'écart d'inflation

entre deux pays. Dans ces conditions, le taux de change

réel est constant (mais non nécessairement égal à

l'unité).

1.1.2- Limites de la théorie de la PPA

De façon générale, la

théorie de la PPA souffre de plusieurs inconvénients

majeurs, tant au niveau théorique qu'au niveau empirique, bien qu'elle

puisse être utile pour évaluer les parités de long terme

entre pays à niveau de développement similaire.

Au niveau théorique, le taux de change

réel auquel fait référence la PPA fait abstraction

de toute considération d'équilibre macroéconomique.

En d'autres termes, elle ne permet pas de relier le taux de change

réel à la situation économique d'un pays,

et notamment à sa position extérieure. Au

niveau empirique, les difficultés sont nombreuses. En particulier,

nous avons vu que la PPA suppose la constance du taux de change réel, ce

qui semble difficilement compatible avec les importantes fluctuations

observées des parités réelles. Les partisans de la

PPA ont dès lors mis en avant la validité de cette

théorie, mais uniquement sur le long terme, en raison notamment de

l'existence de diverses rigidités rendant le processus d'ajustement

très lent. Empiriquement, les études ont alors eu pour objet de

tester la stationnarité du taux de change réel. A nouveau,

les résultats sont apparus décevants, même à

long terme. Ainsi, Roll [1979], Adler et Lehmann [1983], Darby [1983]

ou encore Huizinga

[1987] mettent en avant le fait que le taux de change réel

suit une marche aléatoire. D'autres auteurs, comme par exemple Corbae et

Ouliaris [1988], Enders [1988], Taylor

[1988] et Mark [1990], acceptent quant à eux

l'hypothèse d'absence de relation de cointégration2

entre le taux de change nominal et les prix relatifs. Il en

découle donc l'existence d'écarts permanents à la PPA.

Signalons néanmoins, à la suite de Coudert

[1999], que certains travaux ont cherché à

réhabiliter la version relative de la PPA à long terme en

concluant à la stationnarité des taux de change réels d'un

grand nombre

de pays contre le dollar ou contre le mark.

2 On rappelle que deux variables sont dites

cointégrées si elles sont toutes deux non stationnaires

et s'il

est possible de trouver une combinaison linéaire de ces

deux variables qui soit stationnaires.

Ces insuffisances tant au niveau

théorique qu'au niveau empirique liées à la

PPA ont conduit à retirer d'autres approches. Nous

présenterons l'approche monétaire que se soit à prix

flexibles ou à prix rigides.

1.2- L'approche monétaire des taux de change

Comme le taux de change, est par

définition, le prix d'une monnaie locale en termes d'une monnaie

étrangère, il serait nécessaire d'analyser les

déterminants de la demande de ces deux monnaies. D'où la raison

d'être de l'approche monétaire des taux

de change (Frenkel (1976), Kouri (1976) et Mussa (1976,

1979)).

Deux modèles de base dans cette approche

se présentent alors:

· Le modèle monétaire à prix

flexibles.

· Le modèle monétaire à prix

rigides.

1.2.1- Le modèle monétaire à prix

flexibles

1.2.1.1- Fondements

théoriques

Le modèle monétaire à

prix flexibles est basé sur les deux hypothèses de la

continuité de la parité des pouvoirs d'achat (PPA) et de

l'existence de fonctions stables de demande de monnaie dans l'économie

locale et étrangère3 .

Le logarithme de la demande de monnaie

peut dépendre du logarithme du revenu réel (y), du logarithme

du niveau des prix (p), et du niveau du taux d'intérêt (i).

L'équilibre monétaire dans les pays local et étranger peut

être donné par :

mt = pt + á yt - â it (1.1)

mt* = pt* + á* yt* - â* it*

(1.2)

L'équilibre sur le marché des

biens marchands s'établit lorsqu'il n'y a plus

d'opportunités d'arbitrages. Autrement dit, si la PPA est

vérifiée, il s'ensuit que:

3 Ronald MACDONALD and Mark.P. TAYLOR :

«exchange rate economics : a survey», IMF staff papers, vol

39, n° 1, (march 1992).

et = pt* - pt

(1.3)

Où et désigne le

logarithme du taux de change nominal.

Par ailleurs, les niveaux des prix

étrangers, déterminés par la demande

étrangère de monnaie, constituent des variables

exogènes à l'économie locale. En outre, les niveaux

des pris locaux sont déterminés par la demande domestique

de monnaie. Dans ces conditions, le taux de change serait

gouverné par les demandes relatives de monnaies.

Formellement, en substituant les

équations (1.1) et (1.2) dans la relation (1.3)

et en réarrangeant les termes, nous aurons

l'équation de base du modèle monétaire en situation de

flexibilité des prix formulée ainsi:

et = (mt - mt*) - á yt + á* yt* + â it -

â* it* (1.4)

La relation (1.4) stipule qu'un excès

dans l'accroissement de demande locale de monnaie par rapport à la

demande étrangère entraîne une augmentation de et,

signalant ainsi, la détérioration de la valeur de la monnaie

locale en terme de son homologue étrangère.

1.2.1.2- Limites et formulations

alternatives

Le raisonnement préconisé par

le modèle monétaire à prix flexibles semble être

assez intuitif. En fait, toutes choses étant égales par ailleurs,

une augmentation de la production locale entraîne souvent une

appréciation de la monnaie locale (et baisse).

De même, une augmentation des taux d'intérêt

locaux engendre une dépréciation de la

monnaie locale (et augmente).

Pour connaître l'effet réel, il

faut reconnaître le rôle fondamental de la demande relative de

monnaie dans le modèle à prix flexibles.

A cet égard, un accroissement du revenu

réel local crée un excès de demande de

monnaie locale. Les agents vont essayer alors

d'accroître leurs stocks de monnaie en réduisant leurs

dépenses. Les prix, à leur tour, baisseront jusqu'à

ce que le marché monétaire soit en équilibre. Ce

faisant, la PPA entraîne une appréciation de la monnaie locale en

termes de monnaie étrangère.

Une analyse exactement inverse explique

la réaction du taux de change aux variations des taux

d'intérêt: un accroissement des taux d'intérêt

réduit la demande de monnaie et mène à une

dépréciation de sa valeur.

Eu égard à ces

développements, il semble fort nécessaire de

réécrire l'équation

de base du modèle monétaire sous deux formulations

alternatives et équivalentes.

Supposons que les coefficients de demande

de monnaie locale et étrangère soient égaux (á=

á* et â = â*), l'équation (1.4) sera réduite

à :

et = (mt - mt*) - á (yt - yt*) + â (it - it*)

(1.5)

D'autre part, le modèle

monétaire à prix flexibles suppose que l'hypothèse

parité des taux d'intérêt (PTI) soit

vérifiée4 , c'est-à-dire que le

différentiel de taux d'intérêt doit égaler le taux

anticipé de dépréciation ou d'appréciation de la

monnaie locale.

Si nous désignons par « a » les

anticipations des agents formulées à l'instant t.

t+1

alors en substituant (it -it*) par ?ea

dans l'équation (1.5), nous trouvons:

t+1

et = (mt - mt*) -

á (yt - yt*) + â ?ea

(1.6)

4 Mark.P. TAYLOR : « the economics of exchange

rates », journal of economics literature, vol XXXIII ( march

1995), pp 13-47.

Ainsi, les variations anticipées du

taux de change et du différentiel de taux

d'intérêt (qui reflètent les anticipations

inflationnistes), sont interchangeables dans le modèle.

Certains chercheurs ont relâché la contrainte

d'égalité des élasticités du revenu et du

taux d'intérêt. Il en résulte que:

t+1

et = (mt - mt*) -

á yt + á* yt* + â ?ea

(1.7)

Notons que l'équation (1.7) peut

être réécrite comme suit :

t+1

et = (1+â)-1 (mt -

mt*) - á(1+â)-1 yt +

á*(1+â)-1 yt* + â (1+â)-1 ?ea

(1.8)

En supposant que les anticipations sont

rationnelles, et en procédant par

itérations, l'équation (1.8) peut être

formulée comme suit:

t+i

- á y

et = (1+â)-1 [â

/(1+â)]i [ (mt - mt*)a

a

t+i

t+i

+ á* ya

* ] (1.9)

Bien entendu, les anticipations rationnelles

5 sont conditionnées par

l'information disponible à l'instant t.

Dès lors que tous les modèles

adoptent 1'hypothèse des anticipations rationnelles, la présence

du facteur d'actualisation [â / (1 + â)] < 1

dans l'équation

(1.9) n'exige pas une actualisation à l'infini tant

que les variables sont supposées s'accroître à un taux

inférieur à (1/ â).

Dès lors, étant donnée

les ajustements des taux de change afin d'équilibrer l'offre et

la demande sur le marché de change et en supposant l'équilibre

sur le marché

des biens (à travers des prix parfaitement

flexibles)6 et sur le marché de travail (à

5 La première application de la

théorie des anticipations rationnelles aux taux de change

revient à F. Black

(1973).

6 En effet, une économie

macroéconomique ouverte est caractérisée par six

marchés : marchés de biens, de travail, de change,

obligations domestiques, obligations étrangères et le

marché monétaire. Mais le modèle

monétaire à prix flexibles est

concentré sur les conditions d'équilibre d'un seul type

de marché : le marché monétaire. En supposant la

parfaite substitution des actifs domestiques et étrangers, les

marchés d'obligations

domestiques et étrangers deviennent un seul

marché.

travers des salaires flexibles), l'équation du

système total est déterminée donc par les

conditions d'équilibre du marché

monétaire. Le modèle monétaire à prix

flexibles

est donc implicitement un modèle d'équilibre

général « market clearing general equilibrium model

» sous lequel la PPA est toujours vérifiée.

La volatilité élevée

du taux de change réel durant les années 70 du

régime flottant rejette l'hypothèse de continuité de la

parité des pouvoirs d'achat et induit le modèle monétaire

à prix rigides de Dornbusch et Frenkel.

1.2.2- Le modèle monétaire en présence

de rigidité de prix

Le problème majeur de l'approche

monétaire en présence de flexibilité des prix

réside dans la vérification de 1'hypothèse de la PPA.

En effet, sous cette hypothèse, le

taux de change réel ne peut, par définition, changer.

Toutefois, les premières

expériences des régimes de change flottants ont montré une

forte volatilité des taux de change réels entraînant des

fluctuations des niveaux de compétitivité (Dornbusch, 1976)

7 . Ainsi, l'approche monétaire à prix flexibles

ne reflète pas convenablement l'effet réel et c'est ainsi que

l'on a assisté avec Dornbusch (1976) (qui introduit une dynamique

dans le modèle monétaire) au développement

d'une deuxième génération de modèles

monétaires à prix rigides.

1.2.2.1- Fondements

théoriques

Le modèle monétaire à prix

rigides suppose la possibilité de déviations des taux

de change nominaux et réels de leurs niveaux

d'équilibre de long terme, gouvernés par

la PPA.

7 Dornbush. R. (1976) : « exceptations and

exchange rate dynamics», journal of political economy, vol 84, pp

1161-1176.

Il traite fondamentalement, des conditions

d'équilibre sur le marché monétaire

sous 1'hypothèse de parfaite substitution entre les

actifs monétaires locaux et étrangers. L'idée intuitive

sous-jacente à la déviation de ce modèle peut

être illustrée par l'exemple suivant:

Supposons une baisse de l'offre nominale de

monnaie. A court terme, la rigidité des prix implique une baisse de

l'offre réelle de monnaie et par suite un accroissement des taux

d'intérêt. Cette hausse des taux va stimuler l'entrée de

capitaux conduisant à une appréciation du taux de

change nominal qui, à son tour, entraînera une

appréciation du taux de change réel.

Dans de telle situation, les investisseurs

étrangers vont faire baisser les produits

de leurs investissements à l'étranger.

Toutefois, au fur et à mesure que la perte de change

anticipée (taux de dépréciation anticipé) soit

inférieure au différentiel de rendement des capitaux

(c'est-à-dire le différentiel de taux d'intérêt),

les investisseurs averses au risque vont continuer à acheter des

actifs étrangers. L'équilibre de court terme est atteint

lorsque le taux de dépréciation anticipée égalise

le différentiel de taux d'intérêt (la PTI est

vérifié). Dès lors que ces deux variables sont

différents de zéro. Le taux de change va dévier de sa

valeur d'équilibre de long terme, donnée par la PPA. Toutefois,

à moyen terme, les prix locaux vont baisser

Suite à une réduction de l'offre

de monnaie entraînant ainsi une baisse de l'offre réelle de

monnaie et donc du taux d'intérêt local: Le taux de change nominal

réagira à

ces perturbations en se dépréciant

lentement pour converger vers son niveau d'équilibre de long

terme, défini par la PPA.

Il est à noter que l'approche

monétaire de Dornbusch (1976) a été fortement

critiquée par Frenkel (1979) qui a expliqué la faiblesse du

modèle par sa négligence des effets temporels de l'inflation.

1.2.2.2- Présentation du

modèle

Nous adoptons ici la représentation

proposée par Frenkel (1979)8 et reprise par

Meese et Rogoff (1983), qui permet de relier le taux de change

réel à l'écart de taux d'intérêt réel.

L'hypothèse de départ est que la PPA n'est valide que sur longue

période:

e = p - p *

(1.10)

Où:

p et p * les logarithmes des prix domestiques et étrangers

;

e Le logarithme du taux de change à long terme.

Ou bien:

e = (m - m*

) - á ( y - y * ) +

â ( i - i * )

(1.11)

Où les variables représentées avec une

barre sont les variables d'équilibre de long terme.

Le taux de dépréciation anticipée du change

est spécifié de la façon suivante:

t

t

Et( ? et+1) = - ö ( et

- et ) + ( Ïa

- Ïa *) 0< ö<1

(1.12)

Où:

? et = et+1 - et

t

Et est l'espérance mathématique conditionnelle

à l'information disponible en t; Ïa

t

et Ïa * désignent les anticipations

d'inflation à long terme. Enfin. 1'hypothèse de la PTINC

s'écrit:

it -it* = Et (? et+1) (1.13)

En combinant les équations (1.12) et (1.13), on

obtient:

et - et

= - (1/ ö) (it -it*) + (1/ ö) ( Ïa

- Ïa *) = - (1/ ö) ( r - r *)

(1.14)

t t t t

Où

t

rt = it - Ïa

est le taux d'intérêt réel ex-ante.

8 Jeffery. A. FRANKEL : « on the mark : a theory

of floating exchange rates based on real interest differentials», American

economic review, 1979, vol 69, pp 610-622.

En intégrant les équations

(1.10) et (1.14) et en supposant que la meilleure

estimation du niveau d'équilibre des prix, de l'offre

de monnaie, du revenu et des taux d'intérêt sont les niveaux

observés (hypothèse de marche aléatoire), on obtient les

deux représentations suivantes, en notant Rt = et -pt + pt*, le taux

de change réel:

et = pt - pt* - (1 /

ö) (rt - rt*) (1.15)

Et par suite

Rt = -(1 / ö) (rt - rt*)

Le modèle monétaire à prix

rigides se présente comme suit:

et = (mt - mt*) - á (yt - yt *) + â (it - it*)

- (1 / ö) (rt - rt*) (1.16)

La relation (1.15) constitue une

représentation plus générale que la PPA (que l'on

retrouve quand ö ? , c'est-à-dire quand le taux de

change, donc les prix, s'ajustent instantanément à leur

niveau de long terme), mais conserve une forme

aisément testable.

D'une manière analogue, la

spécification (1.16) propose une représentation plus

générale que la spécification du

modèle monétaire à prix flexibles (1.5). Ce

point

est important même dans le cadre d'une analyse des

déterminants de long terme du taux de change.

D'un point de vue théorique, en effet,

les deux modèles doivent être équivalent à long

terme puisque, à cet horizon, les prix s'ajustent pour assurer

l'équilibre entre offre

et demande de biens. Cette notion de long terme n'est

toutefois pas très précise et il n'est pas sûr, en tous

cas, qu'elle corresponde au long terme défini dans le cadre d'une

relation de cointégration. En effet, autant d'un point de vue

théorique l'écart de taux d'intérêt réels

est stationnaire (puisqu'il est, d'après la PTINC, égal

aux taux de dépréciation du change réel), autant

empiriquement les écarts de taux d'intérêt

réels apparaissent souvent non stationnaires.

Les deux modèles monétaires ont

alors des implications différentes en termes

de relation de long terme : d'après le modèle

à prix flexibles, taux de change et écart de prix doivent

être cointégrés ; d'après le modèle à

prix rigides il faut ajouter l'écart de taux d'intérêt

réels pour que la relation soit stationnaire.

1.2.3- Limites et insuffisances des modèles

monétaires

L'échec empirique qui a

caractérisé le modèle monétaire est

attribué à de nombreuses défaillances tant au niveau

théorique qu'au niveau empirique.

Lane (1991) a énuméré

six raisons pouvant expliquer l'échec, apparent, du modèle

monétaire. Elles se résument comme suit:

9 Le manque de fiabilité inhérente aux estimations

des fonctions de demande de monnaie ;

9 L'hypothèse d'égalité des

paramètres caractérisant les fonctions de demande de monnaie,

dans les deux pays ;

9 L'hypothèse de stationnarité du taux de change

réel découlant de l'hypothèse

de la PP A ;

9 L'hypothèse de la parité de taux

d'intérêt couverte (PTIC) impliquant soit la neutralité

à l'égard du risque soit la diversification parfaite du

risque de change ;

9 L'hypothèse d'exogénéité de

la fonction d'offre de monnaie écartant la

possibilité d'un effet retour (Feed-back) ; et

9 La possibilité de bulles spéculatives qui,

en étant présentes contribuent à l'échec

empirique du modèle monétaire. En fait, il serait

extrêmement difficile

de distinguer ces bulles des variables omises ou des erreurs de

spécification ;

Pour contourner ces insuffisances, plusieurs

versions correctives et extensives ont été mises au point.

Dans la suite, nous nous proposons d'examiner

quelques unes de ces tentatives.

Les modèles examinés sont celles du

modèle FEER appelé aussi l'approche macroéconomique

et le modèle NATREX.

Section 2- Les nouvelles approches

2.1- L'approche macroéconomique

Le taux de change réel

d'équilibre selon l'approche macroéconomique, nommé taux

de change d'équilibre fondamental9, est alors

défini comme le taux de change assurant simultanément la

réalisation de l'équilibre interne (l'économie se

trouve sur

son sentier de croissance potentielle ou

soutenable10) et de l'équilibre externe (son

compte courant est soutenable à long terme).

2.1.1- Détermination graphique du taux de change

d'équilibre fondamental

Si l'on suppose que la condition de

Marshall-Lerner 11 est vérifiée, alors la

relation entre le taux de change réel et l'équilibre

externe est claire : en cas de dépréciation du change

réel, le solde de la balance courante s'améliore.

L'équilibre externe est donc défini par

l'égalité du compte courant à une valeur

d'équilibre généralement reliée à la

soutenabilité des paiements extérieurs. Plus

précisément, pour maintenir la balance courante à son

niveau soutenable, toute baisse des exportations induite par une

appréciation réelle du change devra être

compensée par une baisse équivalente des importations, ce

qui implique dès lors une baisse de la production. Ainsi, dans

le plan (PIB, change réel), la pente de la droite

d'équilibre externe

est positive : elle indique les combinaisons du change

réel et de l'activité pour

9 C'est Williamson [1985, 1994] en cherchant à

expliquer les insuffisances de la PPA par l'absence de référence

aux déterminants réels des taux de change qui a introduit la

notion de taux de change d'équilibre fondamental

(Fundamental Equilibrium Exchange Rate, FEER).

10 On rappelle que le sentier de croissance

potentielle ou soutenable est tel qu'il n'engendre pas de tensions sur le

système productif.

11 Cette condition définit la relation sur les

élasticités-prix du commerce extérieur qui permet à

une dépréciation

du change d'engendrer à terme un excédent

commercial pour le pays considéré.

lesquelles le compte courant est à un niveau

prédéterminé, qualifié d'équilibre. Cette

droite décrit donc l'influence du change réel sur

le bloc de demande du modèle.

Comme le soulignent Borowski et al.

[1998a], l'endogénéisation de l'équilibre interne12

est plus problématique. Ainsi, de façon

générale, si l'on n'endogénéise pas

l'équilibre interne, ce dernier coïncide avec la

réalisation d'un niveau potentiel ou soutenable de production. En

conséquence, dans le plan (PIB, change réel), l'équilibre

interne est représenté par une courbe verticale, constituant la

courbe d'offre du modèle, indiquant le niveau potentiel

d'activité. Dans ce cadre d'analyse, le taux de change réel

d'équilibre est alors la valeur du change réel qui permet

d'obtenir une cible donnée de compte courant, sachant que

l'activité domestique et l'activité étrangère

sont à leur niveau d'équilibre de moyen terme. Dans ces

conditions, la détermination du taux de

change réel d'équilibre peut être

représentée comme suit :

Taux de change réel

équilibre interne équilibre externe

R*

Y* PIB domestique

Figure 5. Détermination du taux de change

réel d'équilibre

(cas où l'équilibre est

exogène)

Cette détermination graphique du

taux de change réel d'équilibre étant

présentée, intéressons nous à présent

à sa détermination analytique13.

12 Ceci revient à considérer

l'écriture d'une boucle prix-salaires non pas en niveau, mais en taux de

croissance

13 Nous reprenons ici, en raison de sa clarté,

la formulation proposée par Joly et al. [1996].

2.1.2- Détermination analytique du taux de change

d'équilibre fondamental

En vertu des développements

précédents, le taux de change réel

d'équilibre

est donc la valeur du change réel assurant une cible

donnée de compte courant, sachant que l'équilibre interne est

réalisée. Il est possible d'écrire le compte

courant (Cc) comme une fonction du PIB domestique (Y), du PIB étranger

(Y*), du change réel (R)

et d'un ensemble de diverses variables exogènes (Z) :

Cc =

f (Y , Y * , R,

Z )

(1.17)

Le taux de change réel d'équilibre, noté,

Rà est alors simplement défini par :

Cà =

f (Yà ,

Yà * , Rà , Z

)

(1.18)

où Cc, Y et Y* représentent

respectivement les valeurs d'équilibre du compte courant,

du PIB domestique et du PIB étranger.

Comme le rappellent Joly et al.

[1996], deux difficultés apparaissent ici. En premier lieu la

forme de la fonction f est difficile à évaluer.

En second lieu, les variables exogènes Z ne sont pas

aisément identifiables. Pour pallier ces deux

difficultés, on log-linéarise le modèle :

(1.19)

c

c

C - Cà =

f (Y ,Y * , R,

Z )- f

(Yà,Yà * ,

Rà , Z )

Soit encore :

*

Cc

= - Y + * Y

+ R

(1.20)

Y Y Y * R

, *

et étant des paramètres liés aux

élasticités du bloc du commerce extérieur

et X = X - Xà

donné par :

. L'écart relatif du taux de change réel

à sa valeur d'équilibre est donc

R =

1 Cc

+ OG - *OG *

(1.21)

R Y

Où OG et OG* désignent respectivement les

output gaps

Finalement, on peut donc écrire :

c

R-Rà = 1

C s

-Càc

domestique et étranger.

(1.22)

R Y

c

Où C s désigne le compte

courant structurel défini par :

C

s

c = Cc

Y Y

+ OG - *OG *

(1.23)

Il ressort donc de ces brefs

développements que l'écart relatif du change réel

à

sa valeur d'équilibre est fonction de

l'écart, en part du PIB domestique, du compte courant structurel

à sa valeur d'équilibre. Ainsi, un compte courant structurel

inférieur

à sa valeur d'équilibre correspond à une

surévaluation du taux de change par rapport à

sa valeur d'équilibre. Il reste maintenant à

déterminer précisément la valeur de cette cible de compte

courant.

2.1.3- Les difficultés de définition des

cibles

Au regard des développements figurant

dans les deux paragraphes précédents,

on constate que le calcul des taux de change

d'équilibre fondamentaux nécessite de connaître deux

éléments :

· L'écart entre la production

réalisée et la production potentielle (l'équilibre

interne) ; et

· L'écart entre le solde courant observé et le

solde courant soutenable (l'équilibre externe).

Cependant, la définition de ces deux

cibles, ou niveaux de référence, pose un

certain

nombre

de problèmes et ne fait pas l'unanimité

(voir notamment Borowski

et al. [1998b]). Pour cette raison, l'approche

de Williamson est souvent qualifiée de normative dans la mesure

où le niveau des taux de change d'équilibre est conditionnel aux

hypothèses retenues. C'est pourquoi Artis et Taylor [1993] et

Bayoumi et al.

[1994] préfèrent parler de taux de change

d'équilibre désiré (Desired Equilibrium

Exchange Rates, DEER) plutôt que de taux de change

d'équilibre fondamental.

Joly et al. [1999] insistent ainsi

particulièrement sur le problème de la

définition des cibles de compte courant et

suggèrent plusieurs possibilités 14 . Une

première possibilité consiste à n'autoriser

aucun écart du solde courant par rapport à

l'équilibre pour chacune des périodes

considérées. Néanmoins, comme le soulignent

les auteurs, cet objectif n'est pas efficace dans la mesure

où un pays peut avoir intérêt à tirer profit

d'importations ou d'exportations de capital sur une longue

période. En outre, Williamson [1994] indique que cette

définition n'est pertinente que si l'on s'intéresse

à la détermination d'un équilibre de très

long terme. Il semble donc préférable de chercher à

définir des déséquilibres soutenables plutôt

que d'éliminer automatiquement toute éventualité de

déséquilibre. Même si l'intérêt d'une

telle approche ne fait pas de doute, sa mise en oeuvre est délicate dans

la mesure où peu de théories permettent de quantifier ces

déséquilibres (voir notamment Joly et al. [1999]).

Williamson [1994], faisant appel aux théories du cycle d'endettement et

du cycle de vie, suggère de relier la cible de la balance

courante à la position extérieure nette, compatible avec

le cycle d'endettement et les caractéristiques

démographiques du pays. Cependant, comme Williamson lui même le

souligne, cette approche présente le risque, pour certains pays, de

conduire à des niveaux de déficit courant qui ne sont pas

soutenables à moyen terme. Le recours à la théorie du

cycle de vie autorise également

à effectuer une distinction entre les pays ayant des taux

d'épargne privée plus élevés que d'autres. Enfin,

dans la mesure où l'évolution des finances publiques a un

impact

sur le compte courant à moyen terme, il convient

également de tenir compte des mesures de politique budgétaire

afin d'évaluer la cible de compte courant.

Comme le notent très justement Joly

et al. [1996], ces théories ne permettent pas de

définir de façon précise un niveau de compte

courant d'équilibre. Joly et al.

[1999] suggèrent alors de rattacher le taux de change

réel d'équilibre à la contrainte budgétaire inter

temporelle de la nation en générant un profil de compte courant

qui

permette de rembourser la dette extérieure en un nombre

donné de périodes. Une telle

14 Cadiou [1999] souligne en outre que le choix des

élasticités du commerce extérieur est également

fondamental dans la

mesure où l'élasticité revenue influence

l'évolution du solde commercial lorsque l'économie rejoint sa

production potentielle. Elle détermine l'écart entre la balance

commerciale de plein emploi et sa cible. Les élasticités prix ont

alors pour objet de déterminer l'ampleur de l'ajustement du taux de

change réel permettant d'annuler cet écart.

technique permet ainsi de tenir compte des

déséquilibres extérieurs tant courants que

passés. Une dernière possibilité, moins

restrictive, consiste à stabiliser le stock de la dette en part de PIB.

Cette règle consistant donc à stabiliser le ratio de la dette sur

le PIB à un niveau donné a été retenue par

Williamson et permet de définir un niveau soutenable de déficit

courant pouvant continuer à être financé par des

entrées de capitaux.

2.1.4- Endogénéisation de l'équilibre

interne

Nous avons précédemment

présenté l'approche macroéconomique de base dans

laquelle l'équilibre interne était supposé

exogène. Nous nous proposons à présent de

lever cette hypothèse.

L'endogénéisation de

l'équilibre interne est relativement complexe et repose sur

l'écriture d'une boucle prix salaires en niveau dont l'une

des caractéristiques est de faire

dépendre le chômage d'équilibre du niveau

des variables susceptibles d'engendrer des tensions inflationnistes (coin

fiscal15, taux de remplacement, ...). L'équation de prix se

résume alors à l'application d'un taux de marge sur les

coûts salariaux unitaires. Quant

à l'équation de salaire, elle est telle que les

entreprises fixent le niveau de l'emploi une fois déterminé le

montant du salaire (modèle de "droit à gérer"). Dans ce

cadre, l'un des déterminants fondamentaux du taux de chômage

d'équilibre est constitué des termes de l'échange

intérieurs. On peut alors montrer (voir Borowski et al.

[1998]) Qu'il existe une relation inverse entre le taux de change effectif

réel et la production potentielle qui transite par le marché du

travail. En effet, si le change réel se déprécie,

il s'ensuit naturellement une hausse des prix domestiques

que doivent se partager firmes et salariés. Si les salariés

refusent de supporter cette

Augmentation - qui induit naturellement une baisse de leur

pouvoir d'achat - les firmes sont alors contraintes de réduire le volume

de l'emploi en raison de la hausse du coût réel du travail. Il en

résulte une hausse du taux de chômage d'équilibre et une

baisse du

niveau de la production potentielle.

15 On rappelle que le coin fiscal est défini

par l'écart entre le coût réel du travail payé par

l'employeur et le pouvoir d'achat d'un salarié.

Certains auteurs, tels que Barrell [1993]

mettent cependant en avant un certain

nombre d'arguments allant à l'encontre de

l'endogénéisation de l'équilibre interne. Il souligne

en particulier que si l'offre de travail est inélastique

à long terme, le coin fiscal ne conserve aucun impact durable sur le

niveau du chômage. Ainsi, l'impact du taux de change effectif sur le

chômage d'équilibre mis en évidence empiriquement ne serait

en réalité qu'une importante rigidité nominale des

salaires. Comme le soulignent Borowski et al. [1998], la

discussion relative à la nécessité

d'endogénéiser ou non l'équilibre interne reflète

l'ambiguïté attachée au taux de change d'équilibre

fondamental au sens où il s'agit d'un concept de "moyen terme".

Joly et al. [1998] ont

cependant proposé une extension de l'approche

macroéconomique 16 en prenant en compte les effets

du taux de change réel sur l'équilibre interne, et en

particulier sur le taux de chômage : les auteurs suggèrent ainsi

d'endogénéiser le bloc d'offre habituellement supposé

rigide à court terme. Il est alors possible de définir un

équilibre macroéconomique déterminant simultanément

le taux

de change réel et l'offre potentielle. La

définition du taux de change réel d'équilibre ne change

pas : il s'agit toujours de la valeur du change réel assurant

la réalisation simultanée des équilibres interne et

externe. L'équilibre externe n'est pas modifié par rapport

à la définition précédemment donnée.

Cependant, l'équilibre interne n'est plus indépendant du change

réel et la confrontation des deux courbes permet alors de

déterminer non seulement le change réel d'équilibre mais

également le niveau potentiel

du PIB. La courbe de l'équilibre interne est

décroissante dans la mesure où une

dépréciation du change réel augmente le chômage

d'équilibre et a impact négatif sur l'offre potentielle. Ainsi

que le rappellent Joly et al. [1998] ceci repose sur le fait que

les salaires nominaux s'indexent sur les prix à la

consommation et non pas sur les prix

à la production. Le mécanisme est alors le

suivant. Une dépréciation du change réel engendre une

augmentation des prix à la consommation relativement aux prix

à la production, entraînant par la même une augmentation du

coût nominal du travail par

rapport aux prix de production. Le coût réel

du travail est alors augmenté, ce qui

16 On pourra également se reporter

à Cadiou [1999] pour une brève revue de la

littérature sur l'endogénéisation du bloc d'offre du

modèle.

implique naturellement une baisse de la demande de travail de la

part des entreprises

et donc une hausse du chômage. Graphiquement, on a donc la

représentation suivante :

Taux de change réel

équilibre interne équilibre externe

R*

Y* PIB domestique

Figure 6. Détermination du taux de change

réel d'équilibre

(Cas où l'équilibre est

endogène)

Il est possible, à la suite de Joly

et al. [1998], de transposer cette représentation

dans le plan (taux de chômage, taux de change réel).

En effet, les effets de demande

intervenant dans la relation entre le taux de chômage et le

taux de change réel sont tels

qu'une dépréciation du change stimule les

exportations et engendre une baisse du chômage. Les effets d'offre

sont tels qu'une dépréciation du change réel

détériore les termes de l'échange et conduit les

entreprises à diminuer leur demande de travail

et donc à accroître le chômage. On a alors la

représentation graphique suivante :

Taux de change réel

demande offre

R*

u* Taux de chômage

Figure 7.taux de change réel

d'équilibre dans le plan

(Taux de chômage, taux de change

réel)

Après avoir mis en avant que l'essentiel

du chômage en France est un chômage

de type structurel (par opposition à conjoncturel), Joly

et al. [1998] soulignent que le

lien entre le taux de change réel et le chômage

doit être initialement appréhendé par le biais des effets

d'offre conditionnant le chômage structurel. Ainsi, sur le

marché du travail, une dépréciation du change réel

a pour effet d'augmenter le niveau de chômage d'équilibre, et non

pas de le faire diminuer eu égard au traditionnel effet

keynésien. Joly et al. [1998] notent cependant, en

faisant référence au coin salarial et à la

dégradation des termes de l'échange, que le problème du

chômage en France ne relève pas d'un éventuel

mésalignement du change réel, mais plutôt des

rigidités spécifiques

au marché du travail. En conséquence, la

solution au problème du chômage en France passe par des

politiques structurelles d'amélioration du fonctionnement du

marché du travail.

Globalement, le fait

d'endogénéiser l'équilibre interne ne modifie pas

les principaux résultats obtenus lorsque celui-ci était

exogène. Néanmoins, cette

endogénéisation permet de tenir compte de

l'ensemble des déterminants potentiels du chômage

d'équilibre. Comme le montrent Joly et al. [1996], toute

variable susceptible d'accroître le chômage d'équilibre

(coin fiscal, fiscalité indirecte, taux d'intérêt

réel, ...) peut engendrer une augmentation du taux de change

réel et par là même limiter la hausse du

chômage d'équilibre. Inversement, les déterminants du

chômage d'équilibre peuvent être enrichis par la prise en

compte de l'équilibre externe. Joly et al. [1996] prennent

ainsi l'exemple de l'impact d'un choc pétrolier sur un pays

importateur de pétrole. L'augmentation des prix du pétrole a

pour conséquence une dépréciation du change réel,

en supposant donnés la cible de compte courant et l'équilibre

interne. La courbe décrivant l'équilibre externe se

déplace alors vers le haut indiquant une

dépréciation du change réel et une augmentation du

chômage d'équilibre.

2.2- L'approche NATREX (Natural Real Exchange Rate)

Si l'approche FEER reste assez répandue

au sein des organisations

internationales et des instituts de recherche appliquée,

le NATREX de Stein, ainsi que

d'autres modèles assez proches tels que le BEER

(Behavioral Equilibrium Exchange

Rate) de Clark et MacDonald (1998), se sont

récemment imposés dans la littérature

académique. Ceci tient à la fois à des raisons

d'ordre théorique et empirique. Les

principales caractéristiques du modèle NATREX sont

détaillées dans l'encadré 1.

Encadré 1 : Equations du modèle NATREX

dans le cas d'un petit pays

Soit une petite économie ouverte. Elle ne peut

influencer le taux d'intérêt mondial, de

sorte que celui-ci est exogène. Le modèle NATREX

s'écrit alors, de façon synthétique :

r = r* : à moyen terme, le taux d'intérêt

réel est égal au taux d'intérêt réel

mondial

Y = y - rF : le PNB est la somme du PIB et des revenus de

facteurs (positifs si F < 0 par convention)

y = C + I + B : le PIB est la somme de la consommation, de

l'investissement et de la balance commerciale

C = cY - c'F : la consommation dépend positivement du

revenu (PNB) et négativement

de la dette extérieure

dk / dt = I (r, k, ä) / L : l'investissement par

tête dépend négativement du taux d'intérêt

réel et de l'intensité capitalistique, et positivement du

progrès technique

-dF / dt=BC (Q)=B- r*F=S-I : la variation de la position

extérieure nette est égale au solde de la balance courante

(somme de la balance commerciale et de la balance des revenus de

facteurs), lui-même comptablement égal à l'écart

entre épargne

et investissement.

Les variables exogènes sont r* : le taux

d'intérêt réel mondial, c : la propension marginale

à consommer (appelée «préférence pour le

présent»), ä: le progrès technique,

L : la population. Les variables endogènes sont Q:

le TCR, r : le taux d'intérêt réel national, y : le

PIB, Y : le PNB, C : la consommation (privée et publique), S :

l'épargne,

I : l'investissement, k : le capital par tête, F

: la dette extérieure nette (ou les actifs extérieurs nets

si F < 0), B : le solde commercial, BC : le solde courant.

La solution du modèle est le NATREX de moyen

terme Q [MT]. La solution de long terme est le NATREX de long terme Q

[LT], défini par Q [LT] = {Q [MT], dk / dt = 0,

dF / dt = 0}.

Les flux de capitaux ne sont pas

fixés de manière exogène. Ils résultent

directement des comportements d'épargne et

d'investissement, qui dépendent eux- mêmes de

déterminants explicites. En ce sens, par rapport à

l'approche FEER, le NATREX fait davantage le lien entre

l'évolution du TCR et les comportements microéconomiques

des agents. Outre le taux d'intérêt mondial, exogène

dans le cas d'un petit pays17, il existe principalement

deux fondamentaux 18 qui influencent les flux de capitaux et,

in fine, le taux de change d'équilibre. Le premier est le taux de

consommation ou "préférence pour le présent", qui

désigne la propension des ménages

et du gouvernement à consommer le revenu national. Par

exemple, lorsqu'une hausse des dépenses publiques n'est pas

compensée par une réduction de celles des ménages,

le taux de consommation s'accroît : ceci entraîne

une diminution de l'épargne soit, à investissement

inchangé, une augmentation des flux de capitaux entrants. Le

deuxième facteur fondamental est le progrès technique, dont

l'accroissement élève le niveau d'investissement : ici

encore, à épargne inchangée, il s'en suit une

amélioration du solde de la balance des capitaux.

Le modèle théorique se

fonde sur un lien de causalité comparable à celui

existant dans le FEER: les déterminants «structurels» de

l'épargne et de l'investissement engendrent un solde des flux de

capitaux de moyen terme ; ce dernier

détermine le solde de la balance courante

ex-post, qui est atteint par le biais d'un

ajustement du change réel. Au total, le TCR

d'équilibre est donc fonction des deux principaux

déterminants de l'épargne et de l'investissement, à

savoir la propension marginale à consommer ("préférence

pour le présent") et le progrès technique.

Les enseignements du modèle NATREX

peuvent différer selon l'horizon d'analyse retenu. Le NATREX est

un modèle dynamique. Du fait notamment des effets de

l'évolution de la position extérieure nette sur

l'épargne et sur le solde des

revenus de facteurs, le taux de change d'équilibre

évolue en effet au fil du temps. Sa

17 Mais endogène dans le cas de

vastes zones telles que les Etats-Unis ou la zone euro, dont le

poids dans l'économie mondiale est suffisant pour que leurs

comportements d'épargne et d'investissement influencent le taux

d'intérêt mondial.

18 Un troisième, les termes de

l'échange, est également susceptible d'être

intégré dans le modèle.

dynamique ne prend fin que lorsque la position extérieure

nette se stabilise, c'est-à-

dire lorsque le solde courant est nul : on atteint alors

l'équilibre de long terme, stable, déterminé par les deux

fondamentaux que sont le taux de consommation et le progrès technique.

Par conséquent, les enseignements du modèle peuvent

différer selon qu'on

se place à un horizon de moyen ou de long terme.

Il est possible d'illustrer cette distinction en examinant par exemple

l'impact d'une hausse du taux de consommation

sur le change d'équilibre. A investissement

inchangé, la baisse induite de l'épargne nationale fait monter le

taux d'intérêt réel national.

Ceci attire les capitaux et fait monter le

TCR, jusqu'à ce que le taux d'intérêt réel soit

à nouveau égal au taux d'intérêt réel

mondial. La hausse du TCR dégrade la balance courante, qui contrebalance

ex-post le nouveau solde des flux de capitaux. A

moyen terme, les effets d'une hausse du taux de consommation sont

donc les suivants :

entrées

de capitaux, appréciation du TCR, dégradation

du solde courant. Le TCR

d'équilibre précédent n'est toutefois pas

soutenable à long terme, car il entraînerait un accroissement

perpétuel de la dette extérieure. C'est pourquoi le modèle

impose que celle-ci se stabilise à long terme. Le

mécanisme par lequel cette stabilisation va intervenir repose sur

un "effet de richesse" (ici négatif) : à mesure que la

dette extérieure s'accroît, la richesse nette des ménages

et du gouvernement décline, ce qui

les incite à réduire leur consommation. A mesure

que l'épargne augmente, les capitaux sortent, ce qui

déprécie le TCR et redresse progressivement le solde

courant. Ce processus se poursuit jusqu'à ce que les flux de capitaux

et le solde courant deviennent nuls. La dépréciation du TCR va

plus que compenser son appréciation initiale, pour la raison suivante

: avec une dette extérieure plus forte qu'initialement, les

paiements d'intérêts sont supérieurs à ce qu'ils

étaient au départ, de sorte qu'un solde courant nul

ne peut être obtenu que moyennant un redressement du

solde commercial et donc une baisse du TCR. A long terme, les effets d'une

hausse de la préférence pour le présent sont donc les

suivants : hausse de la dette extérieure nette,

dépréciation du TCR. L'impact du progrès technique sur

le change d'équilibre de long terme apparaît a priori plus

favorable. La différence majeure avec une hausse du taux de consommation

tient

à ce que les entrées de capitaux financent non plus

la consommation, mais la formation

de capital. Cette accumulation va générer un

surcroît de production, et donc d'épargne.

Il est donc possible que le pays passe progressivement d'un

statut d'importateur à un statut d'exportateur net de capitaux, accumule

alors des excédents extérieurs, ce qui apprécierait le TCR

à long terme (cas du Japon dans les années 1970-1980). Cet

effet

est toutefois ambigu, dans la mesure où le

surcroît d'activité engendré par les gains de

productivité entraîne une hausse des importations, laquelle

tend à dégrader le solde courant. Les estimations

économétriques concluent toutefois presque

systématiquement à un impact positif du progrès technique

sur le change réel à long terme.

Section 3- Une brève revue de la

littérature empirique

Comme le rappellent Borowski et al.

[1998], les estimations du taux de change d'équilibre dépendent

bien évidemment des choix méthodologiques effectués. Il

existe

deux grandes catégories de méthodes d'estimation :

d'une part, les simulations réalisées

à partir d'un modèle macroéconomique

multinational complet (approche dynamique)

et, d'autre part, la construction d'une maquette

représentative du long terme d'un modèle donné; cette

seconde approche étant qualifiée de statique comparative. Cette

dernière méthode est la plus fréquemment utilisée

et consiste à comparer la situation historique à une situation

dite d'équilibre, sans se préoccuper de la transition

d'une situation à l'autre. Selon Borowski et al. [1998],

l'avantage de la méthode de statique comparative est qu'elle est simple

et transparente et qu'elle autorise ainsi un calcul de sensibilités

à des hypothèses alternatives.

Nous distinguerons ici les études

basées sur l'approche traditionnelle (approche macroéconomique

généralement appréhendée au travers de la

statique comparative) des études plus positives reposant sur une

démarche économétrique.

3.1- Les études basées sur l'approche

traditionnelle

Les évaluations empiriques de taux de

change réel d'équilibre ont

principalement été effectuées à

partir des travaux pionniers de Williamson [1983] :

citons notamment Barrell et Wren- Lewis [1989],

Barrell et In't Veld [1991],

Williamson [1991], Church [1992]. Rappelons que Williamson a

introduit la notion de taux de change d'équilibre fondamental

(Fundamental Equilibrium Exchange Rate, FEER) défini comme

le taux de change réel assurant à moyen terme la

réalisation simultanée de l'équilibre interne et

de l'équilibre externe. Un modèle macro

économétrique est alors utilisé pour assurer la

cohérence des différentes variables utilisées.

Néanmoins, ainsi que le rappelle Coudert [1999], un grand

nombre de travaux plus récents n'utilisent pas des modèles macro

économétriques complets, mais seulement des équations

de commerce extérieur. En inversant ces équations, une

relation peut être obtenue entre le taux de change réel, la

balance courante et l'output gap.

L'étude de Williamson [1991],

fondée sur l'utilisation de plusieurs modèles macro

économétriques multinationaux, a quant à elle pour

objet la comparaison de diverses estimations du taux de change

d'équilibre fondamental dans plusieurs pays

européens. En 1994, l'auteur utilise les simulations de

plusieurs modèles afin d'estimer

le taux de change réel d'équilibre des pays

industrialisés au début des années 90. Les

résultats qu'il obtient mettent en exergue d'importants écarts

significatifs entre change effectif et change d'équilibre pour les

Etats-Unis, le Japon et l'Allemagne.

Dans leur étude sur les taux de change

d'équilibre fondamentaux des dix grands pays industrialisés sur

la période 1984-1995, Borowski et al. [1998] retiennent

l'approche de statique comparative afin d'estimer ces taux de change

d'équilibre. Dans

ce cadre, les auteurs définissent l'équilibre

interne à la manière de Williamson [1985,

1991, 1994]. Ils supposent en effet que cet équilibre

interne est défini à partir d'une évaluation des rythmes

de croissance potentielle effectuée indépendamment de la

maquette retenue19. En conséquence, l'équilibre

interne est exogène au modèle dans la

19 La méthode de résolution

employée par les auteurs repose sur la construction d'une maquette de

long terme du commerce

extérieur issue du modèle NIGEM (National

Institute Global Econometric Model). La résolution de cette

maquette

est effectuée en log-linéarisant les

différentes équations du modèle à chaque

période au voisinage de l'état réalisé. Elle permet

alors d'obtenir, à chaque période, les écarts des taux de

change à leur valeur d'équilibre. Ceux-ci apparaissent ainsi

comme une combinaison linéaire des output gaps et des

écarts aux cibles de balance courante de l'ensemble des pays.

mesure où il est supposé que la croissance

potentielle et le taux de change réel sont

indépendants. Enfin, dans la détermination de

l'équilibre externe, les auteurs retiennent uniquement les interactions

entre les échanges de biens et services et le taux de change

réel. Les résultats obtenus par les auteurs montrent que

le franc a été proche de sa valeur d'équilibre

jusqu'en 1989 et se caractérise ensuite par un mouvement

d'appréciation réelle qui atteint un pic en 1991. A

partir de 1991, le franc retourne progressivement vers son niveau

d'équilibre qu'il atteint à la fin de l'année

1995. Concernant le mark, les résultats mettent en avant l'existence

d'une importante sous- évaluation de 1983 à 1993. A partir de

1993, le mark rejoint ensuite rapidement son niveau d'équilibre pour

l'atteindre en 1995. Ces résultats confirment ainsi ceux obtenus

par Barrell et In't Veld [1991]. Borowski et al.

[1998] cherchent également à évaluer le rôle

joué par les outputs gaps et les écarts aux

cibles de balance courante dans les surévaluations et les

sous-évaluations réelles des monnaies. Concernant la France, les

auteurs soulignent que de 1986 à 1988, l'output gap et

l'écart à la cible de balance courante contribuent tous

deux à la surévaluation du franc. A partir de 1989, ces deux

effets se compensent partiellement avant de se renforcer mutuellement de 1992

à 1995.

Du point de vue de l'Allemagne, les résultats montrent

que de 1984 à 1990, la sous évaluation du mark s'explique

principalement par l'écart à la cible de la balance

courante; l'excédent de la balance courante ayant pour effet

d'éloigner le taux de change réel du mark de son niveau

d'équilibre. A la fin de l'année 1990 la sous-

évaluation du mark résulte essentiellement du rôle

joué par l'output gap; l'écart à la balance

courante n'exerçant plus aucun effet en raison de l'importante

détérioration de son solde. Enfin, les facteurs expliquant le

retour vers l'équilibre du taux de change réel du mark

à partir de 1993 sont difficiles à identifier dans la mesure

où l'économie allemande ne semble jouer aucun rôle.

Borowski et al. [1998] se sont

également attachés à déterminer les taux de

change d'équilibre de dix pays industrialisés (sur la

période 1987.4 à 1997.2) dans le cadre des relations de long

terme du modèle multinational NIGEM dans deux scénarios :

un scénario à cibles de balances courantes nulles dans tous les

pays et un scénario à cibles de balances courantes

"réalistes". Leurs résultats mettent alors en

avant la grande sensibilité des conclusions au choix des

cibles de balances courantes.

Ainsi, dans le scénario de référence

d'équilibre de tous les comptes courants, le dollar apparaît

nettement surévalué en termes réels sur la période

1988-1997. En revanche, lorsque l'on retient un scénario de cibles

de balances courantes réalistes, le dollar apparaît sous

évalué à partir de 1996 malgré l'important

mouvement d'appréciation qu'il a subi. Borowski et al.

[1998] concluent alors qu'en diminuant l'ampleur de l'ajustement

à réaliser pour les Etats Unis, l'impact des conjonctures

étrangères et la résorption des

déséquilibres externes du reste du monde l'emportent sur

l'impact du déficit courant américain. Notons que les

auteurs mettent également en avant cette sensibilité des

résultats au choix des cibles de balance courante dans le cas

de la France. Ainsi, dans le cas de cibles nulles, le franc apparaît

surévalué jusqu'en 1994.

En retenant une cible plus réaliste (cible de compte

courant d'un point de PIB), cette surévaluation s'atténue

très sensiblement. Une telle conclusion semble confirmée par Joly

et al. [1999].

Joly et al. [1999] ont en effet

également cherché à estimer le taux de change réel

d'équilibre dans le cas de la France sur la période

1977-1997. En retenant initialement une cible de compte courant soutenable

consistant à laisser inchangée la dette externe du pays, les

auteurs montrent que le franc (en termes réels) n'est pas

surévalué par rapport à l'ensemble des

monnaies des partenaires. En supposant ensuite que la cible de compte courant

soutenable consiste à rembourser la dette externe en un nombre

donné d'années, les résultats de Joly et al.

[1999] font ressortir l'existence d'une certaine sous-évaluation

du change en fin de période. Globalement, il ressort de cette

étude que le franc n'est pas surévalué à la fin des

années quatre-vingt-dix et qu'il aurait plutôt tendance

à s'apprécier à moyen terme. Selon les auteurs, ce

résultat témoigne du fait que la France ne souffre pas de

problème de compétitivité dans ses échanges

extérieurs et que le niveau du change effectif réel n'a

pas constitué un obstacle à une croissance plus soutenue au

cours de la décennie quatre-vingt-dix.

Mentionnons également l'étude

de Borowski et Couharde [1999] visant à définir la

parité d'équilibre (en termes nominaux, et non pas réels)

de l'euro vis à vis du

dollar en retenant les spécifications de long terme des

équations du modèle NIGEM.

En supposant une cible de compte courant globalement

équilibrée pour l'ensemble des

pays considérés, les auteurs montrent que

c'est l'excédent courant de la zone euro, combiné au

déficit américain, qui se trouve à l'origine de la

sous-évaluation de l'euro

vis à vis du dollar au premier trimestre 1998. Cette

sous-évaluation est telle que, au premier trimestre 1998, le taux de

change d'équilibre de l'euro s'établit au niveau de

1,20$US. Les auteurs relativisent cependant ce résultat

pour deux raisons principales. D'une part, cette parité peut

être surestimée du fait des incertitudes pesant sur le

chiffrage de l'excédent commercial de la zone euro. D'autre

part, l'accentuation du déficit courant américain et celle du

surplus courant européen se font en grande partie

sur des zones non prises en compte dans l'étude,

ce qui peut à nouveau conduire à surestimer la sous

évaluation de l'euro.

On constate que les études

précédemment citées portent essentiellement sur les pays

industrialisés. A cet égard, les travaux de Coudert

[1999] portant sur les pays émergents apparaissent

intéressants et permettent de compléter ce bref

aperçu de la

littérature empirique. Coudert [1999]

cherche à évaluer les taux de change

réels

d'équilibre de 16 pays émergents d'Asie et

d'Amérique latine sur la période 1977-1997

par le

biais d'un modèle incorporant deux types d'effets :

d'une part, l'effet Balassa

et d'autre part, la soutenabilité de la dette

extérieure liée aux paiements des intérêts (la

soutenabilité de la dette extérieure est définie

par la stabilisation en pourcentage du PIB). L'auteur montre alors que les

périodes de surévaluation détectées sont souvent

suivies de crises de change. C'est ainsi notamment le cas au Mexique, avant les

deux crises de 1981 et 1994, au Brésil depuis 1995 et en Thaïlande

en 1996. Dans ce cadre,

on peut également mentionner les travaux de Mongardini

[1998]. Cette étude portant

sur la monnaie égyptienne met en avant le fait que le

taux de change égyptien était fortement surévalué

avant 1993 mais qu'aujourd'hui, cette surévaluation est nettement plus

faible; le taux de change se trouvant proche de son niveau

d'équilibre.

3.2- Les études économétriques

D'autres approches, plus positives que

normatives, cherchent à évaluer le taux

de change d'équilibre au moyen d'équations

réduites. Ces travaux s'appuient sur les relations de long terme

existant entre le taux de change réel et diverses variables

macroéconomiques influençant les équilibres interne et

externe. La mise en évidence

de telles relations de long terme fait dès lors appel

à la théorie de la cointégration et à l'estimation

de modèles à correction d'erreur (voir notamment Stein [1994],

McDonald

[1995, 1997], Clark et McDonald [1998], Aglietta et al.

[1998]). Ces diverses études

se situent ainsi dans une perspective plus

économétrique que les travaux précédemment

cités. Notons que cette approche économétrique

constitue l'approche adoptée pour estimer les taux de change

réels d'équilibre selon l'approche microéconomique. En

effet, face aux difficultés résultant de la mise en

oeuvre d'un modèle d'équilibre général inter

temporel, les travaux empiriques se sont principalement attachés

à mettre en évidence plusieurs déterminants fondamentaux

des taux de change réels d'équilibre. Ceci peut donc se

faire grâce à la théorie de la cointégration

en mettant en avant l'existence de relations de long terme entre le taux de

change réel et divers facteurs structurels; les écarts de court

terme du change observé

au change d'équilibre résultant de facteurs

cycliques, spéculatifs ou monétaires.

Edwards [1989] a ainsi estimé le taux de

change réel d'équilibre d'un ensemble

de pays en voie de développement. L'auteur a

mis en avant l'existence d'un certain nombre de déterminants du

change réel tels que les termes de l'échange, le

progrès technique, l'accumulation du capital, le niveau de la

répartition des dépenses publiques entre les biens

échangeables et les biens non échangeables et divers

indicateurs du contrôle des changes. Halpern et Wyplosz [1996]

ont cherché à déterminer les fondamentaux du change

réel des pays en transition de l'Europe de l'Est et ont mis en exergue

l'importance de la productivité apparente du travail, des termes de

l'échange

et du taux de participation sur le marché de l'emploi.

Parikh et Kahn [1997] appliquent quant à eux la théorie de la

cointégration au taux de change de l'Afrique du Sud. Leurs

résultats montrent que le taux de change réel

d'équilibre de long terme est fonction d'un certain nombre de

fondamentaux tels que les prix de l'or, la croissance de la

productivité, les coûts de transport et les termes

de l'échange. A court terme, le poids

de la dette extérieure et intérieure influence

le comportement du taux de change réel. Leur analyse montre en outre que

la croissance de la productivité en Afrique du Sud a pour

conséquence une appréciation du taux de change réel

contre le dollar à long terme, alors qu'à court terme

elle ne semble avoir aucun effet. Signalons enfin les travaux de

Abimanyu [1998] analysant, pour l'Indonésie, la relation entre le taux

de change réel effectif, le taux de change réel

d'équilibre et diverses variables macroéconomiques. Son

étude montre que deux déterminants expliquent l'évolution

du change réel : la consommation publique et le déficit fiscal.

Une augmentation de ces deux variables entraîne ainsi une

appréciation du change réel, ce qui remet en cause

l'équivalence ricardienne.

Aglietta et al. [1998]

considèrent quant à eux un modèle de taux de change

réel d'équilibre prenant en compte l'effet Balassa, la

soutenabilité de la position extérieure nette et un terme

représentatif de la compétitivité hors prix. L'effet

Balassa est pris en compte par le biais du rapport des prix relatifs entre les

biens échangeables et les biens

non échangeables : lorsque ce rapport augmente plus vite

dans un pays A que dans un pays B, le taux de change réel du pays A

relativement au pays B tend à se déprécier.

La position extérieure nette est définie

par le solde cumulé de la balance courante : plus un pays a

accumulé d'excédents, plus sa position extérieure nette

est élevée et plus son taux de change réel

d'équilibre s'apprécie. Enfin, à la suite des travaux de

Aglietta

et Baulant [1994], la variable représentative de la

compétitivité hors-prix est constituée des

dépenses en recherche et développement : une augmentation

de la compétitivité hors prix engendre une

appréciation du taux de change réel d'équilibre. Ce

modèle

est appliqué aux taux de change réels

bilatéraux du dollar par rapport à trois monnaies

européennes : mark, franc et lire sur la période 1973.1 à

1996.4. Les tests effectués par Aglietta et al. [1998]

montrent que les séries de taux de change réels sont

intégrées d'ordre un et mettent en avant l'existence d'une

relation de cointégration entre les taux

de change réels et les variables fondamentales

du modèle pour tous les pays considérés.

L'estimation de modèles à

correction d'erreur montre en outre que les écarts de

taux d'intérêt jouent un rôle important dans

la dynamique du taux de change, de même

que le mésalignement 20 constaté

à la période précédente. Les auteurs

agrègent ensuite

les trois monnaies considérées selon leur

poids dans l'ECU afin de construire une proxy du taux de

change d'équilibre de l'euro contre le dollar. Les

résultats obtenus font ressortir le fait que le mésalignement

est croissant depuis 1983, la surévaluation réelle du dollar par

rapport à l'euro dépassant 40% en 1985. Depuis 1986, le taux de

change réel d'équilibre du dollar contre l'euro suit une tendance

légèrement baissière.

En étudiant les contributions des diverses variables

fondamentales à la détermination

du taux de change réel d'équilibre, les auteurs

montrent que l'impact de la recherche- développement, bien que

significatif, joue très faiblement. En revanche, les rapports de prix

relatifs et les positions extérieures nettes apparaissent

comme étant deux déterminants fondamentaux dans la formation

du taux de change réel d'équilibre.

Concernant à présent l'approche

en termes de besoin de financement des nations, la plupart des

études (voir Cadiou [1999]) suppose qu'à moyen terme

la

balance des capitaux s'ajuste à la balance

courante, c'est à dire au besoin (ou

à la

capacité) de financement des différents pays.

Dans ce cadre, Masson et al. [1996]

et Stein [1995] estiment des équations d'investissement et

d'épargne et s'appuient sur la différence entre l'épargne

et l'investissement pour définir les cibles de balance courante

à moyen terme. Stein [1995] réalise alors une

application empirique concernant le taux

de change du dollar contre les autres monnaies des pays du G7. Le

taux de change réel

du dollar ne dépend à long terme que des

préférences pour le présent des Etats Unis

et des pays du G7, définies comme la propension

moyenne des agents domestiques privés et publics à

consommer le revenu national. L'auteur montre qu'il existe une relation

de cointégration entre le taux de change réel et les propensions

à consommer.

20 Bien évidemment, ce mésalignement de

la période antérieure représente le résidu (en t-1)

de la relation de cointégration précédemment

estimée

Plus précisément, le dollar se

déprécie lorsque la préférence pour le

présent

augmente aux Etats Unis en raison de l'aggravation du

déficit extérieur et de la baisse

du stock d'avoirs extérieurs net à long

terme. La balance commerciale doit dès lors s'améliorer

pour répondre aux paiements d'intérêts vis à vis des

pays du G7. A plus court terme, le change réel s'apprécie

en raison de l'augmentation du différentiel d'intérêt

entre les Etats Unis et les pays du G7 afin d'assurer l'équilibre de la

balance

des paiements.

Conclusion

Même si la théorie de la

parité des pouvoirs d'achat constitue une référence

utile

à long terme pour les taux de change nominaux,

nous avons mis en avant ses inconvénients lorsque l'on raisonne en

termes de taux de change réels. En particulier, cette théorie,

postulant la constance ou la stationnarité du change réel, fait

abstraction

de toute considération d'équilibre

macroéconomique : elle ne permet pas de relier le taux de change

réel à la situation économique d'un pays et, en

particulier, à sa position extérieure. Face à ces

insuffisances théoriques et aux nombreuses difficultés

empiriques soulevées par cette théorie, nous nous sommes

tournés vers d' autres approches de détermination du taux de

change réel d'équilibre notamment : l'approche

macroéconomique et l'approche NATREX.

Ces approches nous ont explicité les

fondamentaux et les déterminants du taux

de change réel d'équilibre .La question qui

se pose alors est de savoir s'il y a une rupture entre le taux de

change et ses fondamentaux.

Chapitre II - Expliquer les déviations du taux

de change: mémoire longue

Introduction

Les approches du taux de change

d'équilibre sont fondées sur l'idée que le prix relatif de

deux monnaies doit refléter les différences de structures

économiques entre deux pays à un moment donné du temps.

Cette définition du taux de

change d'équilibre a donné lieu à deux types de

travaux. D'un côté, certains auteurs cherchent à

étudier les trajectoires des taux de change vers un

équilibre de long terme que le théoricien définit au

regard de critères normatifs. Le plus connu de ces critères

est la soutenabilité des équilibres internes

et externe à la Williamson (1994). Cette approche

conduit à définir le taux de change comme un "taux de change

d'équilibre fondamental". D'un autre côté, il est possible

d'avoir une approche plus empirique, basée sur l'estimation formes

réduites. Dans ce cas, les cibles de long terme ne sont pas

fixées a priori, mais déterminées suivant

une relation de long terme entre le taux de change et ses fondamentaux

économiques.

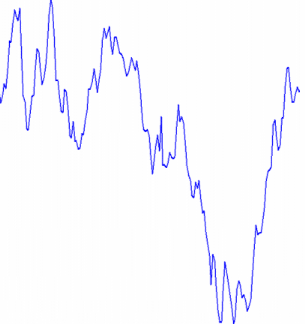

Ce chapitre s'inscrit dans la seconde

optique. Notre but est d'expliquer les écarts persistants du

taux de change euro/dollar par rapport à leurs valeurs

fondamentales durant la période 1990-2004.

Ce chapitre est organisé de la

manière suivante. La section 1 présente le cadre théorique

de base retenu et les séries utilisées. La section 2

est consacrée à une première étude de la

cointégration entre le taux de change et leurs fondamentaux.

Et une section 3 qui met en évidence le caractère

persistant des déviations du taux de change du taux de change

réel à travers le processus de mémoire longue ARFIMA.

Section 1 : Le cadre théorique

1.1. Le modèle théorique

Les modèles monétaristes avec

ses différentes versions sont les plus utilisés dans les

études empiriques afin d'évaluer les propriétés

dynamiques de la relation liant

le taux de change aux fondamentaux.

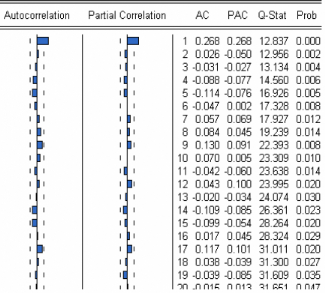

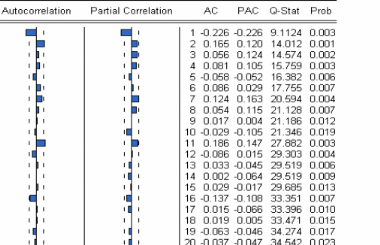

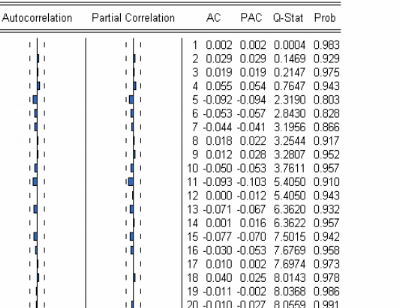

L'équilibre monétaire dans le