|

Estimation

Modélisation 3D

Données récoltées

Coupe horizontale

Corrélation

Variogramme

|

Université de Bretagne Sud

Institut Universitaire Professionnalisé Informatique et

Statistique

Rue Yves Mainguy

56000 Vannes

|

Rapport de stage

« Méthodes géostatistique

pour

l'interpolation et la modélisation en

2D/3D

des données spatiales. »

Par Wilfried DESPAGNE

Master 2 /

2005-2006

Date de soutenance : Juin 2006

Remerciements

C'est un plaisir pour moi de remercier l'ensemble des

chercheurs du groupe LEMEL et plus particulièrement Evelyne GOUBERT,

David MENIER et Valérie MONBET. Ces derniers m'ont accordé

beaucoup de leur temps, m'ont fait bénéficier de leur savoir et

de leur expérience tout au long de ce travail. Ils ont été

d'une aide précieuse pour comprendre la problématique, la cerner

et y répondre.

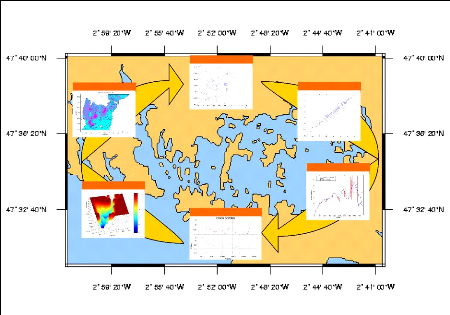

Résumé

Les travaux de recherche présentés dans ce

rapport ont été effectués au sein du laboratoire LEMEL

(Laboratoire d'Etude et Modélisation des Environnements Littoraux). Il

parcourt différentes techniques d'interpolations spatiales. A partir

d'un échantillon de données sédimentologiques,

géophysiques, et bathymétriques, il s'agit de réaliser des

cartes 2D/3D indiquant la profondeur au toit du socle rocheux à l'est de

l'île aux Moines dans le Golfe du Morbihan. Les méthodes

d'interpolations sont également utilisées pour localiser des

zones à forte présence en crépidules au nord ouest de

l'île de Bailleron. Ces deux applications concrètes permettent

d'opposer les méthodes déterministes aux méthodes

géostatistiques. Les fondements mathématiques des techniques

d'interpolations spatiales sont analysés. Des préconisations

générales sont données, sur l'usage des modèles

d'interpolation pour la cartographie.

Mots-clés : coordonnées géographiques,

interpolation, extrapolation, lissage, estimation, sectorisation, variable

régionalisé, géostatistique, variogramme, krigeage,

validation croisée, toit de substratum.

Summary

The research tasks presented in this memory were carried out

within laboratory LEMEL (Laboratory for Study and Modelling of the Littoral

Environments). It goes through various techniques of spatial interpolations.

From a sample of `sedimentologics', geophysics, and bathymetric data, it

involves of realizing 2D / 3D maps modelling the depth to the roof of the rocky

in the Morbihan's bay. The methods of interpolations are also used to localize

zones with strong presence of `crépidules' in the western North of

Bailleron's island. These two concrete applications will oppose the determinist

methods against the géostatistics methods. The mathematical bases as

well as their demonstrations are examined. General recommendations are giving,

on the usage of the models of interpolation for the mapping.

Keywords: geographic coordinated, interpolation, extrapolation,

smoothing, estimation, division into sectors, regionalized variable,

geostatistic, variogram, model fitting, kriging, model validation, roof of

substratum.

REMERCIEMENTS 2

RÉSUMÉ 3

INTRODUCTION : PRÉSENTATION DE L'ÉTUDE 6

CHAPITRE I : DIFFÉRENTS OUTILS DE CARTOGRAPHIE

8

1/ INTERPOLATION SPATIALE 8

1.1/ Forme générale de l'interpolation

linéaire 8

1.1.1/ Méthodes d'interpolation par partitionnement de

l'espace 8

1.1.1.1/ Polygones de Thiessen 8

1.1.1.2/ Triangulation 9

1.1.2 / Méthodes d'interpolation barycentriques 11

1.1.2.1/ Plus proches voisins 11

1.1.2.2/ Méthode de l'inverse des distances 11

1.1.3/ Résumé 12

1.2/ Modèles d'estimation géostatistique 12

CHAPITRE II : MÉTHODES DE LA

GÉOSTATISTIQUE LINÉAIRE 14

1/ NOTATIONS ET DÉFINITIONS 14

1.1/ Notion de variable régionalisée et

notion de champ 14

1.2/ Notations 14

2/ HYPOTHÈSES DE BASE 15

3/ VARIOGRAMME 17

3.1/ Variogramme théorique et variogramme

expérimental 17

3.2/ Propriétés du variogramme 18

3.3/ Modélisation du variogramme 19

3.4/ Isotropie et anisotropie 20

3.5/ Cas multivarié : calcul des variogrammes

croisés 20

4/ KRIGEAGE 21

4.1/ Hypothèses et contraintes 21

4.2/ Estimateur de krigeage 23

4.3/ Cas multivariable : Cokrigeage 23

4.4/ Conclusion 24

CHAPITRE III : RECUEIL ET ANALYSE PRÉALABLE DE

L'INFORMATION 25

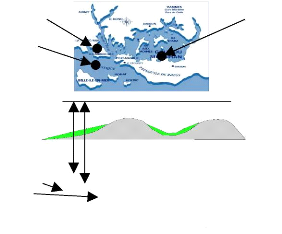

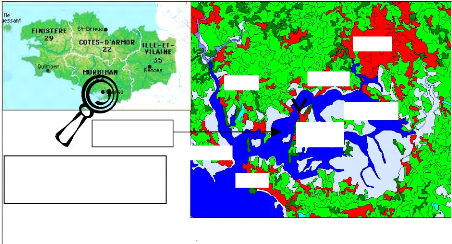

1/ LOCALISATION DE LA ZONE D'ÉTUDE 25

2/ SOURCE DES DONNÉES 25

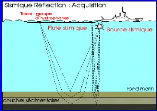

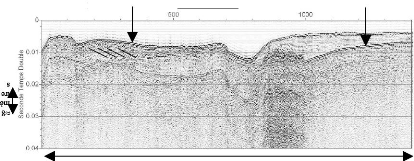

2.1/ Informations provenant des campagnes sismiques

26

2.1.1/ Recueil des données sismiques 26

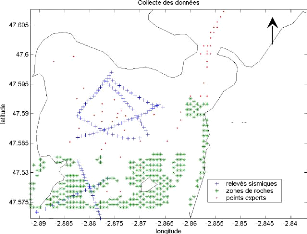

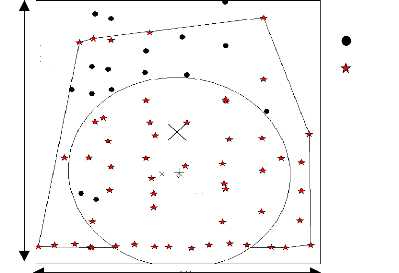

2.1.2/ Plan d'échantillonnage 27

2.2/ Bathymétrie : Information auxiliaire 28

3/ ETUDE EXPLORATOIRE DE L'ÉCHANTILLON DE LA VARIABLE

D'INTÉRÊT 29

3.1/ Histogrammes et statistiques descriptives

29

3.2/ Comportements directionnels : Etude de

stationnarité 30

3.3/ Nuage de corrélation différée ou

« h-scatter plots » 31

3.4/ Description bivariée 32

4/ TRANSFORMATION DES COORDONNÉES 33

5/ CONCLUSION 34

CHAPITRE IV : ANALYSE VARIOGRAPHIQUE

35

1/ VARIOGRAMMES EXPÉRIMENTAUX 35

1.1/ Variogramme omnidirectionnel 35

1.2/ Variogrammes directionnels 36

1.3/ Anisotropie 37

1.4/ Comportement à l'origine du variogramme

39

1.5/ Variogrammes croisés 39

2/ AJUSTEMENT À UN MODÈLE 40

2.1/ Cas monovariable 40

2.2/ Validation croisée 42

3/ CONCLUSION 44

CHAPITRE V : ESTIMATION PAR KRIGEAGE 45

1/ CHOIX DE LA GRILLE ET DU VOISINAGE DE KRIGEAGE 45

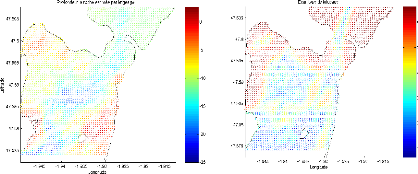

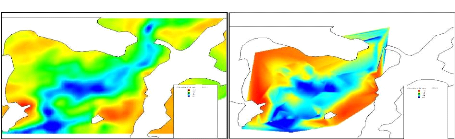

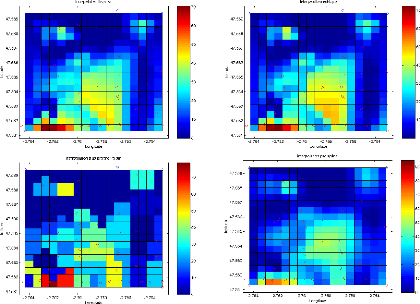

2/ RÉSULTATS OBTENUS PAR KRIGEAGE ORDINAIRE 45

3/ RÉSULTATS OBTENUS PAR COKRIGEAGE ORDINAIRE 46

3.1/ Ajustement du variogramme croisé

47

3.2/ Validation Croisée 47

3.3/ Résultat du cokrigeage 49

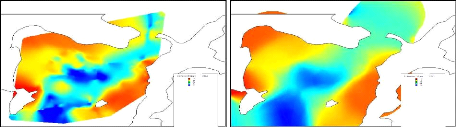

4/ COMPARAISON GRAPHIQUE AVEC D'AUTRES MÉTHODES

D'INTERPOLATION 51

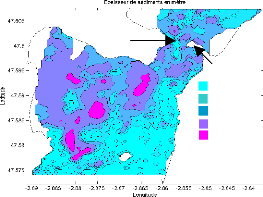

1/ EPAISSEUR DE SÉDIMENT 52

2/ COURANTS MARINS 52

CHAPITRE VII : LOCALISATION DES COLONIES DE

CRÉPIDULES 54

1/ PROBLÉMATIQUE 54

2/ ZONE D'ÉTUDE 54

3/ STATISTIQUES SPATIALES DESCRIPTIVES 55

3.1 Position et dispersion 55

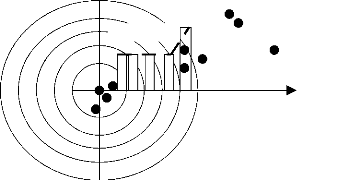

3.2 Sectorisation 56

3.3 Méthode des quadrats 56

3.4 Analyse spatiale exploratoire basée sur les

distances 58

3.4.1 Méthode du voisin le plus proche 58

3.4.2 Fonction de Ripley modifiée (L de Besag)

59

3.5 Conclusion de l'analyse spatiale descriptive 61

4 / MÉTHODE D'INTERPOLATION PAR PARTITIONNEMENT DE

L'ESPACE 61

4.1 Polygones de Thiessen 61

4.2 Interpolation par la méthode des plus proches

voisins 61

5.3 Interpolation suivant le nombre d'individus

comptés 62

5.4 Conclusion 65

BIBLIOGRAPHIE 67

Introduction : présentation de l'étude

Les travaux de recherche présentés dans ce

mémoire ont été effectués au sein du laboratoire

LEMEL (Laboratoire d'Etude et Modélisation des Environnements

Littoraux). Il est rattaché à la « Faculté de Science

et Science de l'Ingénieur » de l'Université de Bretagne Sud.

C'est un groupe pluridisciplinaire (géologues, biologistes,

mathématiciens, statisticiens...) qui s'attache à

modéliser les écosystèmes à l'interface terre/mer.

Il passe pour cela par l'intermédiaire de SIG (Système

d'Information Géographique) afin d'acquérir, de consulter et de

gérer l'information géographique.

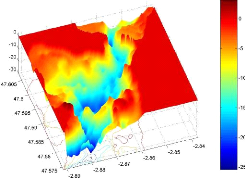

Ce mémoire de stage présente

l'élaboration d'une carte de la profondeur au toit du socle rocheux

à l'ouest de l'île aux Moines et une carte localisant les

crépidules au nord ouest de l'île de Bailleron (golfe du

Morbihan). Une image 3D au du toit du substratum fournit un outil pour

comprendre comment se répartissent les corps sédimentaires dans

l'espace. Localiser les zones à présence de crédidules

permet de lutter contre cet envahisseur. La connaissance, des profondeurs au

toit du substratum* ou la quantité de

crépidules**, en tout point d'une zone, nécessite :

- d'une part, de nombreuses données de mesure

géophysiques, bathymétriques

et sédimentologique que l'on rapporte à des

coordonnées géographiques précises (latitude /

longitude)

- d'autre part, un outil d'interpolation permettant de calculer,

à partir des

données de mesure, les profondeurs en tout point de la

zone : il s'agit alors d'une estimation mathématique de cette

profondeur.

Il existe de nombreuses techniques d'interpolation

définies comme :

- des méthodes d'interpolation déterministes

- des approches statistiques ou géostatistiques

(stochastique)

Elles ont toutes leurs avantages et inconvénients. Mais

dans tous les cas, le principe reste le même : une valeur est

estimée pour des sites non échantillonnés, sur la base

d'observations existantes.

Le premier chapitre du rapport recense différentes

approches déterministes pour interpoler un ensemble de données.

Une description très générale en est fournit.

Le deuxième chapitre, propose une analyse des

techniques géostatistiques et des conditions de leur mise en oeuvre. Les

fondements mathématiques ainsi que leurs démonstrations sont

examinées. Le krigeage et l'analyse variographique, une étape

préalable du krigeage, sont analysés et commentés. Elles

s'appuient sur une synthèse bibliographique.

Les chapitres III à VI présentent une

application des méthodes géostatistiques pour aboutir un

modèle numérique de terrain au toit du substratum. Ils

fournissent également des conseils sur la nature de l'information qu'il

est nécessaire de recueillir pour utiliser efficacement ces

méthodes. Ils préconisent une démarche à suivre

pour interpréter les résultats. Ils mettent en évidence

les avantages et les limites des méthodes géostatistiques.

Le dernier chapitre dévoilera une application des

méthodes d'analyse spatiale concernant

uniquement la position

géographique des objets, et des méthodes non stochastiques

présentées

* Substratum : base (souvent un socle rocheux ou cristallin) sur

laquelle repose les sédiments. ** Crépidule : mollusque

gastéropode

en première partie. Elles ont pour objectif d'identifier

des zones géographiques occupées par les crépidules.

Chapitre I : Différents outils de cartographie

1/ Interpolation spatiale

L'interpolation spatiale est une procédure qui consiste

à estimer la valeur d'un attribut pour des sites non

échantillonnés. Dans le contexte de ce stage, nous utilisons

l'interpolation spatiale pour mettre en oeuvre des algorithmes

mathématiques ou probabilistes afin d'estimer la profondeur de la roche

entre les points d'échantillonnages.

Il existe de nombreuses méthodes d'interpolation parmi

lesquels il faut faire un choix. Nous distinguerons deux familles :

- les méthodes d'interpolation classiques basées

sur des algorithmes purement déterministes.

- Les méthodes d'estimation géostatistiques qui

s'appuient sur une modélisation probabiliste du phénomène

étudié.

Les méthodes s'appliquent à des variables

régionalisées, c'est-à-dire des fonctions

numériques qui prennent leurs valeurs dans des régions

délimitées de l'espace appelées champ. Dans notre cas, la

variable régionalisée est la profondeur au toit du substratum. Le

champ est la zone d'étude décrite dans le chapitre III.

1.1/ Forme générale de l'interpolation

linéaire

Pour estimer la valeur ponctuelle en un site, nous utilisons

des combinaisons linéaires pondérées. La distance entre

les lieux d'observations a une influence sur ce que l'on observe. Autrement

dit, les valeurs dans deux localités voisines sont souvent plus

semblables que dans deux localités éloignées. Les poids

doivent donc tenir compte non seulement de la disposition des observations les

unes par rapport aux autres, mais aussi de la distance entre le site à

estimer et les sites observés.

1.1.1/ Méthodes d'interpolation par

partitionnement de l'espace 1.1.1.1/ Polygones de Thiessen

La méthode consiste à partitionner l'espace

géographique en polygones, puis à attribuer une valeur à

chacun des polygones. Elle permet de déterminer un zonage où la

valeur de la variable à prédire est à priori la même

que celle du site d'observation*.

Supposons que l'on désire estimer la valeur en un point

S0 du champ (cf. figure 1.1). Ce point appartient

nécessairement à l'un des polygones d'influence des sites

d'observations.

Un polygone d'influence pour l'observation C s'obtient en

traçant les médiatrices des segments joignant C aux sites

voisins.

* site d'observation : donnée source connue et

localisée

On attribue à S0 et à tout point

appartenant au même polygone, la valeur du site ayant ce polygone

d'influence. Sur la figure 1.1, la valeur estimée au point

S0 sera identique à celle du site C.

Médiatrice

Angle droit

C

S0

A

B

Figure 1.1

La méthode de Thiessen peut s'améliorer tout en

gardant le même principe. L'idée de Sibson est de construire un

polygone de Thiessen autour du site à estimer. Dans un deuxième

temps calculer les surfaces d'intersection (P(S0,i)) entre le polygone

précèdent et ceux des sites voisins. Enfin, Sibson propose une

estimation de S0 à l'aide d'une combinaison linéaire des

valeurs des sites voisins (Z(S0)) pondéré par les

surfaces P(S0,i).

Notons, n : nombre d'observation

P(S0) : surface du polygone de Thiessen en

S0

P(S0,i) : surface de l'intersection du polygone de

l'observation i et celle de S0

Alors,

|

à

S 0

Z ( )

|

n

?=

i

|

1

|

P S i

( , )

0 Z P ()

S 0

|

()

S 0

|

La méthode de Sibson a les propriétés

suivantes : - l'estimation en S0 est unique

à

- l'estimation est exacte : ? i = 1 ... n Z(

S i ) = Z(S i ) .

1.1.1.2/ Triangulation

La méthode d'interpolation par triangulation consiste

à diviser le champ en triangles disjoints, dont les sommets sont les

sites échantillonnés, puis à interpoler à

l'intérieur de chaque triangle.

La construction des triangles n'est pas unique,

différentes approches sont donc proposées.

Triangulation de Delaunay

On peut à partir du diagramme de Thiessen, en

construire le dual. C'est à dire construire un nouveau

diagramme où cette fois, on relie par un segment toutes les paires de

sites dont les régions de Thiessen correspondantes sont adjacentes (les

points séparés par une arête de Thiessen).

|

Polygone de Thiessen

Polygone de Delaunay

|

Figure 1.2

On observe que la triangulation de Delaunay opère

seulement dans l'enveloppe convexe des sites d'observations et ne recouvre donc

pas entièrement le champ.

Interpolation linéaire

Supposons que le point S à estimer se trouve

à l'intérieur du triangle formé par les sites

S1,S2, S3 (figure 1.3).

L'estimation de la valeur de la variable régionalisée au point S

par interpolation linéaire s'écrit :

+

+

S S S

123

à

Z S

( )

S SS

1 2

Z S

( )

3

SSS

1 3

Z S

( )

2

S SS

2 3

Z S

( )

1

où |.| désigne la surface et Z(.) la valeur prise

en (.).

|S2SS3|

|S1SS2|

S

|S1SS3|

S3

S1

S2

Figure 1.3

L'interpolation linéaire a les propriétés

suivantes : - l'estimation en S0 est unique

à

- l'estimation est exacte : ? i = 1 ... n Z(

S i ) = Z(S i )

- la triangulation ne permet pas d'extrapoler les valeurs

au-delà de l'enveloppe convexe des sites d'observation.

1.1.2 / Méthodes d'interpolation

barycentriques

Les méthodes d'interpolations précédentes

ne considèrent, pour estimer la valeur d'un site S0, que les

sites d'observation immédiatement voisins. Elles ignorent par

conséquent une grande partie de l'information disponible. Les

méthodes barycentriques permettent de prendre en compte un nombre plus

important de données.

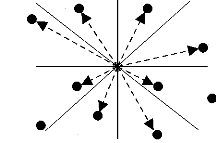

1.1.2.1/ Plus proches voisins

Le plan sur lequel se situe le point à interpoler est

découpé en octants. La méthode de calcul consiste en une

interpolation sur les huit points de référence les plus proches

du point à interpoler, répartis dans les octants. L'importance

d'un point de référence est d'autant plus grande dans le

résultat du calcul que sa distance au point à interpoler est

faible.

P8(v8)

P1(v1)

P2(v2)

Pi(vi)

P3(v3)

P7(v7)

8

)

d Pi Pm

( ,

? ?

vk

1

8

=

k

1

m

m k

?

=

vi

8

8

)

d Pi Pm

( ,

? ?

1

=

k

1m

m k

?

P6(v6)

P5(v5)

P4(v4)

L'algorithme est efficace lorsque l'on dispose de beaucoup de

points bien répartis dans la fenêtre de calcul.

On peut imaginer découper l'espace en plus ou moins huit

parties et prendre plus qu'un point observé par partie. C'est en cela

que l'on se rapproche de la méthode qui suit.

1.1.2.2/ Méthode de l'inverse des distances

La première étape est d'effectuer une recherche

des sites qui vont intervenir dans l'estimation. On peut par exemple se fixer

un rayon de recherche dont le centre est la localisation de la valeur à

estimer. On ne retiendra que les sites Si appartenant au cercle.

Dans un deuxième temps on attribue à chaque site

Si retenu un poids inversement proportionnel à la distance

entre ce site et le point à estimer S0. Considérons que

l'on a retenu n0 données dans le cercle alors on obtient comme

estimateur :

Z S

( )

i

S S

-

i 0

à

Z S

0 0 1

S S

-

i 0

?

i = 1

où |.| désigne la distance.

Les deux méthodes précédentes ont

l'inconvénient de prendre en compte uniquement la distance qui

sépare les sites entre eux. Cela donne un poids important au groupement

de données, alors qu'il n'est pas nécessairement

justifié.

1.1.3/ Résumé

Les méthodes ci-dessus ont la caractéristique de

traiter uniquement les données de la variable étudiée.

Toutes définissent la valeur recherchée en un point comme une

combinaison linéaire pondérée des mesures disponibles.

Ce sont des méthodes implémentées dans la

plus part des logiciels de Système d'Information Géographique

(SIG).

Ces techniques présentent néanmoins des

défauts. Elles ignorent la structure spatiale de la variable et

produisent du coup des surfaces interpolées très lisses. Des

situations locales très spécifiques peuvent alors être

omises (zones de fortes ou de très faibles valeurs). Nous prenons le

risque d'aboutir à des cartes peu réalistes. Enfin, aucun

critère statistique pour juger de la précision de ces cartes

n'est formulé.

Si l'on veut optimiser la précision des estimations, il

faudra utiliser d'autres outils qui feront appel à des modèles

probabilistes. La géostatistique et le krigeage en font partie. Nous

allons les étudier dans la suite.

1.2/ Modèles d'estimation géostatistique

Le mot géostatistique est un néologisme

forgé à l'École des Mines. La géostatistique est

née des problèmes rencontrés dans le secteur de la mine :

contrôle des teneurs, optimisation de maille, cartographie des

ressources, prévision des réserves récupérables,

étude de scénarios d'exploitation...

Daniel Kriege, géologue dans les mines d'or, proposa

dans les années 60 une méthode statistique pour estimer la teneur

d'un bloc de minerai à partir d'échantillons pris autour du bloc

à exploiter. Dix ans plus tard, Georges Matheron développa un

outil pour analyser la continuité spatiale des teneurs appelé le

« variogramme » et une méthode d'estimation basée sur

le « variogramme » appelée le « krigeage ». Nous

étudierons ces deux méthodes.

Aujourd'hui, la géostatistique s'exprime dans des

champs d'applications comme l'océanographie, la

météorologie, le génie civil, l'environnement, la

géologie, la qualité de l'air et des sols, la santé,

etc.

Techniquement, la géostatistique utilise

également une combinaison linéaire des

données

observées, mais à la différence des

méthodes classiques d'interpolation, elle tient compte à

la

fois de l'information relative à leur position et du

caractère aléatoire du phénomène

étudié. De

plus, elle permet d'intégrer des informations auxiliaires

dans l'estimation. Ces avantages font considérablement améliorer

les estimations dans le contexte spatial.

La mise en oeuvre de la méthode de krigeage passe par

une étape d'analyse des données. Elle est destinée

à décrire la structure spatiale de la variable

régionalisée. La carte de l'interpolation est alors

accompagnée d'indicateurs de fiabilité des résultats.

Chapitre II : Méthodes de la

géostatistique linéaire

La géostatistique se réfère aux

méthodes d'analyse probabiliste pour étudier des

phénomènes corrélés dans l'espace appelés

phénomènes régionalisés. A ce titre elle fournit

différents outils pour répondre au problème posé

par la cartographie du socle rocheux dans le golfe du Morbihan.

1/ Notations et définitions

1.1/ Notion de variable régionalisée et

notion de champ

Une variable régionalisée quantifie des grandeurs

mesurées sur l'espace géographique. L'espace dans lequel cette

variable prend ses valeurs est appelé champ.

Exemple de variable régionalisée : la profondeur

du substratum sous le niveau zéro de la mer, mesurée par des

campagnes sismiques dans une zone géographique située à

l'est de l'île aux Moines, dans le golfe du Morbihan.

Exemple de champ : la zone géographique située

entre la côte et l'est de l'île aux Moines. Nous pourrons estimer

les valeurs prises par la variable régionalisée dans cette

zone.

1.2/ Notations

Z : la variable régionalisée

D : le champ (domaine sur lequel la variable

régionalisée est définie) s ? D : une

position dans le champ

Z(s) : une valeur prise par la variable

régionalisée au point s

Z à ( s ) : une estimation de

Z(s)

h : la distance qui sépare deux points

Z(s2)

Z(s3)

Z(s1)

Niveau Zéro

Profondeur à estimer

Bathymétrie

Sédiments

Roche

14

Prenons un exemple dans le golfe du Morbihan

si est un l'emplacement géographique.

Tous les si ont une profondeur de roche :

Z(si).

Chaque profondeur de roche est une variable aléatoire.

Ensemble elles forment une fonction aléatoire de s.

La mesure faite au point si est une

réalisation particulière de la fonction aléatoire

Z(si).

Définissons à présent les hypothèses

indispensables pour utiliser les techniques de la géostatistique

linéaire.

2/ Hypothèses de base

Une fonction aléatoire {Z(s), s ?

D} est caractérisé par sa loi spatiale F. Elle

correspond à la loi de probabilité conjointe de (Z(s1),

Z(s2), Z(s3), ..., Z(sn)).

F v v v P Z s v Z s v Z s v

( , ,..., ) ( ( ) ), ( ( ) ),..., ( ( ) )}

= { < < <

1 2 n 1 1 2 2 n n

Or cette fonction est très complexe par

l'infinité des combinaisons possibles. Nous n'allons donc pas pouvoir

estimer la fonction de distribution conjointe. La géostatistique

linéaire se limite à la fonction de distribution d'ordre un

F(v) et d'ordre deux FZ(si),Z(sj)(vi,vj) .

FZ (s ) ( v) = P{ Z

(s ) = v}

F i

( ) , ( ) ( , ) { ( ( ) ) , ( ( ) )}

=

Z s Z s i j

v v P Z s v Z s v

= =

i i j j

j

i ? j i=1,...,n et j=1,...,n

La première nous permet de calculer l'espérance de

la fonction aléatoire Z en un point s.

E ( Z ( s )) = v

·

fZ(s ) (v)dv

avec ( ) ' ( )

f Z ( s ) v = F Z ( s

) v

La fonction de distribution d'ordre deux, fourni la loi de

probabilité entre les valeurs prises en deux sites si et

sj. On utilise la covariance pour quantifier le degré de

ressemblance entre les valeurs prises en si et sj et le

variogramme pour mesurer la dissemblance entre les valeurs prises aux sites

si et sj.

cov( s i ,s ) = E(Z

( s i ) Z ( s j )) -

E(Z ( s i )) E ( Z (s j

))

ã( s i , s j ) =

Var Z s i Z s j

1 [ ( ), ( )] , (variogramme*)

2

Le problème qui se pose est que la variable

régionalisée est observée qu'une seule fois à un

endroit précis. En d'autres termes, nous n'avons qu'une seule

réalisation de la variable aléatoire. Or pour estimer les moments

d'ordre un et deux il nous faudrait un grand nombre (>30) d'observations. Ce

problème ne concerne pas la quantité d'information disponible

mais le fait que l'on essaie de décrire un phénomène

unique (profondeur au toit du socle rocheux), qui ne se répète

pas, à l'aide de lois de probabilités.

Pour palier à ce problème nous posons comme

hypothèse que la variable régionalisée est stationnaire.

Concrètement cela veut dire que deux paires de points espacés

d'un même vecteur h ont des caractéristiques (moyenne et

covariance) semblables. Ou encore, la variable régionalisée ne

dépend pas de sa position dans l'espace, elle garde les mêmes

caractéristiques

* ã : cigle retenu pour désigner le variogramme

où que l'on se place. Cela nous permet de nous

détacher de la localisation et de nous restreindre uniquement à

la distance qui sépare les points d'observations.

La traduction mathématique est la suivante :

Stationnarité du second ordre :

Une fonction aléatoire Z(s) est stationnaire du

2nd ordre quand l'espérance mathématique existe et ne

dépend pas du point s ; et que la covariance entre chaque paire ( Z(s+h)

, Z(s)) existe et ne dépend que de h (distance).

- L'espérance mathématique ne dépend pas de

s : ? s , E(Z ( s )) = m

constante indépendante de s

- La covariance entre Z(s) et Z(s+h) ne dépend

que de h :

? s s h

, + , cov ( ( ) , ( ) ) ( )

Z s h Z s C h

+ = ne dépend que de h et non de s

C(h) est appelé fonction de covariogramme

- La variance existe en tout site s et est une constante

indépendante du site s :

? s Var ( Z s ) ( Z s Z s ) C

cons te

, ( ) cov ( ), ( ) (0)

= = = tan

- Le covariogramme et le variogramme sont liés :

? s s h Var Z s h Z s

, + , ( ( ) ( ) ) / 2 ( ) (0) ( )

+ - = ã h C C h

= -

Remarque : L'hypothèse de stationnarité d'ordre

deux ne peut être validé de manière rigoureuse et

infaillible à l'aide d'un test statistique sur les données

expérimentales (Arnaud et Emery, 2000 p.107).

L'hypothèse intrinsèque :

On dit qu'une fonction aléatoire Z(s) est

intrinsèque quand ses accroissements Z(s+h)-Z(s)

sont stationnaires d'ordre 2. C'est-à-dire que

- L'espérance des écarts est zéro :

E ( Z ( s + h ) -

Z(s )) = 0 ? s et h fixé

- La variance des écarts ne dépend que de h

:

Var Z s h Z s E Z s h Z s

( ( ) ( )) [ ( ( ) ( ))2 ] 2 ( )

+ - = + - = ã h

Cette hypothèse permet de dire que la variabilité

entre les valeurs prises en deux points différents ne dépend que

de h (la distance entre ces points).

Toute fonction aléatoire stationnaire d'ordre deux est

également intrinsèque (la réciproque est

fausse).

Autrement dit, l'hypothèse de stationnarité intrinsèque

est moins restrictive que la

stationnarité du second ordre. L'hypothèse

intrinsèque ne requiert pas de connaître l'espérance ni sa

covariance de la variable aléatoire.

La fonction la plus utilisée en géostatistique

pour décrire la continuité spatiale est le variogramme. La

continuité spatiale est réalisée lorsque les valeurs

prises entre deux sites proches l'un de l'autre sont similaires.

3/ Variogramme

3.1/ Variogramme théorique et variogramme

expérimental

D'après Marcotte (cours de «géostatistique

minière »), la nature n'est pas entièrement

imprévisible. Deux observations situées l'une près de

l'autre devraient en moyenne se ressembler davantage que deux observations

éloignées. La différence entre les valeurs prises par deux

variables aléatoires est Z(s)-Z(s+h). C'est également

une variable aléatoire dont on peut calculer la variance. Cette variance

devrait être plus petite lorsque les points sont rapprochés (les

valeurs se ressemblent plus en moyenne) et plus grande lorsque les points sont

éloignés. On appelle variogramme la demi-variance de cette

différence.

|

ã

|

( h ) = Var Z s + h - Z

h

1 ( ( ) (

2

|

))

|

L'outil mesure la « variabilité spatiale »,

c'est-à-dire la dissemblance entre les valeurs en fonction de leurs

séparations. Il décrit la continuité spatiale de la

variable régionalisée.

Le variogramme théorique est défini comme :

|

1

1

+ - = [

h Var Z s h Z h E

ã ( )

= ( ( ) ( ))

2 2

|

( ( ) ( ))2 ] (0) ( )

Z s h Z s C C h

+ - = -

|

avec C (0) = Var(Z( s )) et

C ( h ) = Cov(Z( s + h

),Z ( s ))

Démonstration :

h Var

1

( ) =

( Z s Z s h

( ) ( )

- + )

ã

2

1

2

E Z s Z s h

[ ( ( ) ( ) ) 2 ] [ ( ) ( ) ]2

1

- + - E Z s Z s h

- +

2

or dans le cas d'une variable aléatoire stationnaire,

E[Z(s)-Z(s+h)]=0

|

1 E

2

|

[( Z s - Z s + h ( ) ( ) )

2]

|

( )

h Var

=

( Z s Z s h

( ) ( )

- + )

1

ã

2

1 [ ( ) (

) ( )

( ) ]

Var Z s

- Z s Z s h Var Z s h

2

( ) 2 cov ( ), ( )

+ +

+

or si Z est stationnaire d'ordre deux alors

Var(Z(s))=C(0)=constante

C (0) - C(h )

Remarque :

- Un variogramme peut se calculer non seulement pour une

distance donnée mais

aussi pour direction è donnée :

ãè (h)

- La covariance mesure la ressemblance entre les valeurs en

fonction de leur éloignement alors que le variogramme mesure la

dissemblance entre les valeurs en fonction de leur éloignement.

- Dans l'hypothèse de stationnarité d'ordre 2,

covariance et variogramme existent et sont liés par la relation ã

( h ) = C(0) - C(h ) . Dans

l'hypothèse intrinsèque, seul le variogramme existe. C'est

pourquoi il est généralement préféré

à la covariance pour décrire et interprété la

structure spatiale du phénomène étudié.

- Le variogramme réel d'une fonction aléatoire

est généralement inconnu, mais il peut être

évalué à partir des données

d'échantillonnages. On obtient ainsi le variogramme expérimental

proposé par Matheron (1962).

1

2 ( ) N h

N h

( )

[ Z s i h Z s i

( ) ( )

+ - ]

2

?=

i 1

à

ã ( )

h

Effet pépite :C0

Palier :

C

C0+C

12

semi-variogramme

14

10

4

8

6

2

0

0 5 10 15 20

distance : h

Portées : a

N(h) est le nombre de paires dans la classe de distance h.

Z(si) est la profondeur de la roche au point de mesure si.

3.2/ Propriétés du variogramme

Le variogramme est une fonction de h, croissante et

souvent caractérisé par quatre paramètres :

- l'effet pépite : C0 - le palier : C+C0

- la portée : a

Remarque : plus la fonction croit, moins les observations se

ressemblent.

L'effet de pépite : Le comportement à

l'origine du variogramme reflète le degré de

régularité spatiale de la variable régionalisée. Si

le variogramme présente un saut abrupt à l'origine (effet de

pépite), cela indique une absence partielle de corrélation entre

les valeurs prises en deux sites très proches. C'est-à-dire qu'il

y a une faible ressemblance entre les valeurs régionalisées

très voisines.

Le palier : Valeur du variogramme pour la distance

égale à la portée.

La portée : Distance où deux observations

ne se ressemblent plus du tout. Leur covariance est nulle.

Remarques :

- Si le variogramme est borné alors la covariance existe

et l'on peut présumer une stationnarité du second ordre (Journel

et Huijbergts, 1993 p.37).

- Si la variable régionalisée est stationnaire du

second ordre alors le palier est égal à la variance de cette

même variable.

ã ( h ) = ó 2-

C(h )

- Inversement, si un variogramme est non borné, il ne

possède ni portée, ni palier. La variance de la fonction n'est

pas définie et elle n'est donc pas stationnaire du second ordre.

- Arnaud et Emery (2000, p.126) affirment que le variogramme

expérimental n'est pas fiable pour des distances supérieures

à la moitié du diamètre du champ D. Elles sont

peu nombreuses et augmentent la variance de la valeur ãà (.)

estimée.

- Les variogrammes directionnels permettent de détecter

une éventuelle anisotropie. (cf. § 3.4)

3.3/ Modélisation du variogramme

Le variogramme expérimental n'est pas défini

partout, notamment aux distances h pour lesquelles il n'existe pas de

paire de points de mesures. Ainsi lui est-il ajusté une fonction

mathématique appelée modèle de variogramme. Marcotte

recommande d'utiliser des modèles éprouvés ou des

modèles construit à partir de modèles

éprouvés.

Type de modèles courants

|

- Linéaire :

|

ã ( )

h

|

? ??

??

|

C

C + h pour a h

= = 0

0

a

C C pour h a

+ >

0

|

? 3 h 3

h ?

?? C C

+ ? -

? ?

0 a

? ?

3

h = 2 2 a

pour a h

= = 0

pour h a

>

- Sphérique : ã ( )

?? C C

+

0

|

- Gaussien : ã ( h ) = C0

+ C ? 1- exp

?

|

?

-3ah22

?? ?

|

|

?

- Exponentiel : ã ( h ) = C0

+ C? 1- exp

?

|

? - 3h ? ?

?? ?? ?

a ?

|

3.4/ Isotropie et anisotropie

Le variogramme ne dépend que de h,

c'est-à-dire le vecteur de déplacement entre les points s

et s+h. Ce vecteur contient de l'information sur la distance

entre ces deux points, par l'intermédiaire de sa norme, ainsi que sur

l'orientation de h. Si le variogramme ne dépend en fait que de

la norme de h, il est dit isotrope. S'il dépend aussi de la

direction (è) du vecteur de translation, il est dit

anisotrope.

Rappelons que la norme euclidienne d'un vecteur

h=(si,sj) est |h|= 2

s i+ s j .

2

Bien qu'il existe une très grande variété

d'anisotropie, la plupart des ouvrages de géostatistique montrent

uniquement comment modéliser les anisotropies

géométriques.

Les caractéristiques de l'anisotropie

géométrique sont :

- Les variogrammes des différentes directions ont le

même palier et même effet pépite mais des portées

différentes.

- Les portées maximales et minimales s'observent selon

deux directions orthogonales.

Pour revenir à une situation isotrope, le principe

consiste à effectuer une transformation linéaire des

coordonnées spatiales c'est-à-dire une rotation en suivant les

directions de plus petite et plus grande continuité (application chap.

IV § 1.3).

3.5/ Cas multivarié : calcul des variogrammes

croisés

Nous avons vu qu'un des avantages des méthodes

géostatistique (chap. I § 1.2) était de pouvoir inclure dans

le modèle d'interpolation des variables auxiliaires qui apportent de

l'information sur la variable cible. Pour décrire la structure de

dépendance entre la variable cible et les covariables il convient de

calculer le variogramme croisé.

Soit Zp la variable principale et Zq

la variable secondaire, alors

|

à

ã

|

( h) 1

2N( h)

|

N(h )

?= [

i 1

|

Z p (s i ) - Z

p ( s +h) ][ Z q (s

i ) - Zq ( s +h)]

i

|

L'analyse du variogramme croisé se fait de la

même façon que celle du variogramme simple. C'est-à-dire

que l'on relève ses propriétés (effet de pépite,

palier, porté, amplitude) et on y ajuste une fonction.

4/ Krigeage

Cette section expose l'une des techniques de

géostatistique d'estimation locale, connue sous le nom de krigeage et

cokrigeage ordinaire.

Nous cherchons à estimer la valeur d'une variable

régionalisée z (profondeur au substratum) en un point

s0 quelconque du champ à partir des mesures observées

z(si), i=1,..,n (n : nombre de points observés). Le

krigeage est un interpolateur exact (la valeur estimée sur un point de

mesure est égale à la valeur du point de mesure) et optimal (il

minimise la variance sur l'erreur d'estimation).

Il existe trois types de krigeage : le krigeage simple, le

krigeage ordinaire et le krigeage universel. Le krigeage ordinaire est le plus

fréquemment utilisé en pratique car les hypothèses de

départ sont moins contraignantes que celle du krigeage simple. Seul le

krigeage ordinaire sera développé ici car il répond aux

besoins de notre problématique.

4.1/ Hypothèses et contraintes

Le krigeage ordinaire ne requiert pas la connaissance de

l'espérance de la variable régionalisée. Autrement dit, on

se place dans l'hypothèse d'une stationnarité intrinsèque.

Il n'en reste pas moins que la moyenne doit rester constante à

l'échelle du voisinage de krigeage.

Définition du voisinage de krigeage : Domaine du champ

qui contient le site à estimer et les données utilisées

dans l'estimation.

Comme pour les méthodes barycentriques (chap. I §

1.1.3), le voisinage de krigeage se résume à un cercle ou

à une ellipse autour du point à estimer.

Le modèle de base de cette méthode s'énonce

comme suit :

Z ( s ) = ì (s) + ä

(s)

avec s D (le champ),

ì(s)=E(Z(s)) quasi-constante inconnue et

ä(s) fonction aléatoire stationnaire intrinsèque

d'espérance nulle (E(ä(s))=0) et de structure de

dépendance connue (ã(|si-sj|) connu). Dans son

mémoire (2005, p.31), S. Baillargeon explique que le caractère

quasi-constant de ì(s) signifie que

l'espérance n'est pas contrainte à demeurer la même partout

dans le champ D. Elle doit par contre rester constante à

l'intérieur de chaque voisinage de krigeage.

En outre, l'estimateur du krigeage ordinaire doit vérifier

les propriétés suivantes :

à

La linéarité : Z (

s0 ) est une combinaison linéaire des données

Z(si) i=1,..,n.

n n

1

Z s a

à ( 0 ) = + ? ù ( ) avec ?

i Z s i ù =

i

i =1 i=1

Le non-biais : Zà (

s0 ) est sans biais : E[ Z à (

s 0 ) - Z(s 0) ] = 0

Démonstration

à

E(Z ( s 0) -Z

(s 0 ))

E(a + ? ùi

Z(s i) -Z(s0))

i

E ( a + ? ùZ(s

i)) -E(Z ( s 0))

i

or E( Z (s i ) ) =

E( Z (s0)) ì

(stationarité)

= a + ? ù iE(Z

( si))-ì i

x 1- a=ì =

n ? ù ?i ? i = 1 ?

Or ì étant inconnue, le seul

moyen de garantir le non-biais de l'erreur est de poser :

n

a= 0 et ?ù= 1

i 1

Optimalité : c'est-à-dire que Var

( Zà ( s0 ) -

Z(s 0)) est minimale.

Var Z(s 0 ) ) = (2( s

0 ) - Z(s0 )) 1 = E(

2( s0 ) 2) - 2E[ 2( s

0 ) Z ( s 0 )] + E( Z

(s0) 2)

ì 2

2

n n n n n

E( Z ( s 0 ) 2)

=E0),Z(si) ? E w

iwiE(Z (si)Z (s

j)) =? ? ùiùj

cov(Z(s i ), Z ( s

j))+

i=1 i= 1 i==

1 1

j

car dans le cas d'une variable aléatoire stationnaire,

E(Z(si))=E(Z(sj))=ì, d'où

E(Z(si))E(Z(sj))=ì2

2

E( Z (s 0 ) 2) =

Var

(Z( s

+ ì

E[

n n n

2( s 0 ) Z ( s

0 ) ] = i Z(s i ) Z (

s0 ) -?1 = iE( Z

(s )Z ( s 0 ) ) = i cov(

Z(s i), Z ( s 0)) +

ì2

i = 1i=1 i = 1

donc

Var ( 2( s 0 ) -

Z(s 0 )) = Var(

Z(s0 ) ) - ù i

cov(Z(s i ), Z ( s 0

)) + ? ? ùiù j cov(Z(s ),

Z ( s ))

n n n

i= 1 i= 1 j= 1

n

Le but est de trouver le vecteur ù qui minimise

cette variance sous la contrainte ?=ù =

i 1 i 1

Pour y parvenir, on peut utiliser la méthode de Lagrange.

La fonction de Lagrange :

n n n n ?

L = Var Z s

( ) ? (

( ) 2

- ) ? = ? = (

+ ù ù Z s Z s ) ?

? -

( , ,..., )

ë ù ù cov ( ), ( )

ù Z s Z s cov ( ) , ( ) + ë ù 1

1 n 0 i i 0 i j i j ?? i

??

i = 1 i 1 1

j i = 1

ë est le multiplicateur de Lagrange

Minimiser cette fonction revient à trouver la solution du

système :

1

j

1

ù i

ë

0

+

n

Z s Z s

( ), ( ) ) + ? ù ( )

i j cov ( ) , ( )

Z s Z s

0 i j

n

?

1

i

=

n ) = - cov(

? L

(ë , ù1,...,ù

?

ùi

?

Ce système peut se réécrire à l'aide

du variogramme ã(h)=C(0)-C(h)

n

-

-

-

ù

ë

(si

ã

)

)

(si

s0

jã

1

? i = 1, ... , n

1

ù i

?

=

i

?

j

sj

n

?

1

La variance minimum est atteinte au point :

n

ó 2 (ok 0 ) = ?ùiã (

si - s0)- ë

i= 1

Cette fonction est appelée variance de krigeage. C'est la

valeur minimale de la variance de l'erreur de prévision.

4.2/ Estimateur de krigeage

Le krigeage est un interpolateur linéaire sans biais.

Il prend en compte la géométrie des données, les

caractéristiques de la régionalisation et de la variance. Son but

est de lisser les données.

Ayant calculé les poids ùi par la

résolution du système précédent, nous pouvons

écrire l'estimateur de la manière suivante :

n

à

1

?=

i

Z1 ( s0 ) =

ù i Z(s i)

4.3/ Cas multivariable : Cokrigeage

Il est possible d'améliorer les estimations obtenues

par krigeage en ajoutant à la variable à estimer, l'information

fournie par d'autres variables (variables secondaires). La démarche

à suivre est la suivante.

Pour estimer la variable Z1 au point s0, on

utilise une combinaison linéaire pondérée des mesures

concernant toutes les autres variables (Z2, ..., Zp).

p n i

Z( s0 ) = ? ? ù j i i j

i

Z s

( , )

,

i= 1 j=1

Les poids ùj,i sont solution du système

:

j i

,

ù

?

?

?

?

?

?

?

? ?

?

i = =

1 j

?

j

j

p

ni

n1

1

1

ù

ni

1

j

ù ã - - = - =

j i i q i q j q

s s

( ) ë ã

q q i q

( s s q p

) 1 . . .

, , , , , 0

,

1

=

0 i=2...

1

p

Les ëq sont des multiplicateurs de

Lagrange.

Remarques :

- La variance d'estimation (ou de krigeage) obtenue par

cokrigeage est toujours inférieure à celle obtenue par

krigeage.

- En pratique, on observe que le gain est moindre lorsque les

variables sont peu corrélées entre elles (Arnaud et Emery, 2000,

p.195).

- L'estimation ponctuelle par (co)krigeage en un site

d'observation est égale à la

valeur mesurée. D'autre part, la variance d'estimation

associée est nulle.

4.4/ Conclusion

La méthode de krigeage est

précédée par l'estimation d'une fonction variographique.

C'est cette fonction qui va tenir compte à la fois de la

géométrie des données, des caractéristiques de la

régionalisation et de la précision de l'estimation. Il est donc

important de souligner que la qualité de l'estimation et

l'appréciation de sa précision reposent uniquement sur le

modèle variographique utilisé. Il doit par conséquent,

être le plus cohérent possible avec ce qui a été

observé.

Après avoir décrit les fondements

mathématiques des méthodes d'interpolation spatiale, nous nous

efforçons, dans les chapitres suivants, à les appliquer sur des

cas concrets.

Chapitre III : Recueil et analyse préalable de

l'information

Les données observées constituent la

matière première des méthodes d'interpolation. En

géostatistique elles ont la particularité d'être

géo-référencées. L'objet de ce chapitre et de

présenter la zone du golfe du Morbihan retenue pour appliquer les

méthodes d'interpolation géostatistique, puis de présenter

les données utilisées pour aboutir à une cartographie du

socle cristallin.

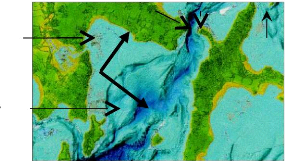

1/ Localisation de la zone d'étude

Le Golfe du Morbihan :

Une petite mer intérieure d'une superficie de 11 500

ha.

Zone d'étude

Locmariaquer

figure 3.1 : source IFEN

Arradon

Baden

Arzon

pointe

Île

Île aux Moines

Île d'Arz

Vannes

La zone d'étude se localise entre l'île aux

Moines et Baden dans le golfe du morbihan. Le passage étroit entre la

pointe de l'île aux Moines et le continent provoque des courants

importants (figure 6.2). Ils sont à l'origine de formations

sédimentaires hétérogènes. La charge de

sédiments et la force du courant génèrent de

l'érosion et modèlent le fond marin. Les courants assurent la

mise en mouvement des particules sédimentaires, ce qui entraînent

l'érosion et l'entretient des chenaux. La proximité de la zone

d'étude à l'atlantique fait que les conditions hydrodynamiques y

sont importantes par rapport aux secteurs à l'est de l'île aux

Moines. Elles expliquent les profondeurs bathymétriques de l'ordre de 10

à 15 mètres et des fonds marins rocheux ou sableux.

2/Source des données

Le golfe du Morbihan a fait l'objet de campagnes

bathymétriques et sismiques. L'évaluation de la profondeur de la

roche dans le milieu marin, s'appuie sur ces relevés. Une partie du

travail consiste à relever l'information apportée par les

données sismiques (support papier), et de l'intégrer dans un

Système d'Information Géographique. Les données

bathymétriques sont quant à elles ajoutées à la

base d'information. Le tout constitue un échantillon de travail.

2.1/ Informations provenant des campagnes sismiques

2.1.1/ Recueil des données sismiques

La sismique est une technique de mesure qui consiste à

enregistrer en surface des échos issus de la propagation dans le

sous-sol d'une onde sismique (figure 3.2). Ainsi les

hétérogénéités du sous-sol sont

relevées. Le passage par exemple d'une couche rocheuse à une

couche sédimentaire va se traduire par la présence d'un

réflecteur sur les enregistrements (figure 3.3).

Figure 3.2 (Ifremer)

Le temps d'arrivée de l'écho permet

d'enregistrer la profondeur des obstacles rencontrés par l'onde. En

résumé, les études sismiques fournissent une image

(profil) de la structure du soussol. On peut y reconnaître la

superposition de certaines couches de roche et/ou de sédiment (figure

3.3).

La profondeur du fond marin et du substratum est

relevée (au décimètre) tous les 70 mètres (figure

3.4). Le profil fourni les profondeurs en « seconde temps double ».

C'est-à-dire le temps que l'onde envoyée par l'appareil met pour

revenir à ce dernier. Cette unité peut être convertie en

mètre. La vitesse de propagation de l'onde est de 1500 m/s dans l'eau et

de 1700 m/s dans les sédiments.

0 marin

Fond marin Profil sismique Toit du substratum

Réflecteur

1000 mètres

Gaz

Couche sédimentaire

Figure 3.3

Conversion du profil sismique en données

numériques

|

0 100 200 300 400 500 600 700 800 900 1000 1100 1200 1300

1400

|

|

|

|

|

|

|

|

|

0

-2

-4

-6

Profondeur

-8

-10

-12

-14

-16

-18

|

Z Eau Z Sed m

P tir Z_Roche_m

|

Figure 3.4

Remarque : les données récoltées peuvent

manquer de précision. Les problèmes suivants sont

rencontrés :

- Lors de la saisie sur papier avec un décimètre,

une erreur de un à deux millimètres est courante (1mm saisi

correspond à 18cm de profondeur réelle).

- La conversion de seconde en mètre amène

à faire un choix sur les arrondis.

- Le niveau zéro autrement dit le niveau de la mer

n'est pas connu pour les profils en notre possession. Il faudra admettre qu'il

est approximativement égal au niveau de référence

utilisé par le SHOM (Service Hydrographique et Océanographique de

la Marine).

2.1.2/ Plan d'échantillonnage

Une campagne sismique permet d'obtenir des informations sur la

nature et la géométrie de la couverture sédimentaire. Pour

rendre une collecte de données efficace, le rapport INERIS (2003, p.52)

conseille de disposer les échantillons selon un maillage

régulier. A nombre d'échantillons égal, la

régularité de la maille facilite l'inférence de la

structure spatiale et garantie une meilleure précision. Toujours

d'après le même rapport, il est prouvé que la variance de

l'erreur d'estimation d'un échantillonnage aléatoire

stratifié est inférieure à celle d'un

échantillonnage aléatoire uniforme. (On peut retrouver ces

affirmations dans l'ouvrage de M. Arnaud et X. Emery, p113.)

En pratique, il n'est pas toujours possible de relever

l'information suivant un maillage régulier comme le préconise la

théorie. En effet, les nombreux bancs de sable du golfe ne permettent

pas aux bateaux de naviguer partout.

Dans tous les cas, il est préconisé de resserrer

la maille d'échantillonnage en quelques endroits, afin de faciliter la

modélisation du variogramme aux petites distances. C'est pourquoi nous

ajoutons aux données sismiques :

- des points de la base bathymétrique (chap. III §

2.2) mesurés sur des zones de roche (figure 3.5).

- des points d'experts, estimés visuellement par des

personnes familiarisées avec le terrain (figure 3.5).

Profil_34 Profil_08

Profil_09

Profil_13

Profil_10

Profil_11 Profil_12

Port Blanc

Ile aux Moines

N

Figure 3.5

Le nombre de points a également son importance. Un

nombre de points trop faible rend le variogramme « instable » et les

résultats de l'estimation peu fiables. Selon Cressie (1993, p.237) 30

paires de points par classe de distance seraient nécessaires à la

construction du variogramme. Dans le cas étudié nous disposons en

moyenne de plus de 100 paires de points par classes de distances (cf. chap.IV,

§ 1).

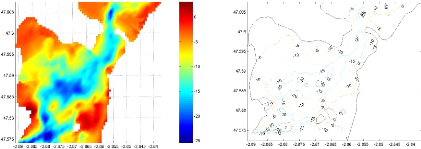

2.2/ Bathymétrie : Information auxiliaire

Un modèle numérique de terrain (MNT) est une

représentation de la topographie (altimétrie et/ou

bathymétrie) d'une zone terrestre. En cartographie les altitudes sont

habituellement représentées par des courbes de niveaux. Le MNT en

notre possession (source SHOM) utilise un maillage régulier carré

de 50 mètres. Il permet ainsi de reconstituer une vue en image de

synthèse du terrain (figure 3.6, image LIDAR : LIght Detection And

Ranging).

N

Figure 3.6

La morphobathymétrie reflète très souvent

la morphologie au toit du socle cristallin (D. Menier, géologue). En

effet la corrélation linéaire entre la profondeur des fonds

marins et celle au substratum est de 0,84. Le MNT peut donc fournir

une information complémentaire lors de la mise en oeuvre du

modèle de cokrigeage.

3/ Etude exploratoire de l'échantillon de la

variable d'intérêt

La mise en oeuvre des techniques d'estimation

géostatistique exige une analyse préalable des données

expérimentales. L'étude exploratoire a pour but

d'apprécier la distribution des données dans l'espace,

d'appréhender leur degré d'homogénéité, de

rechercher et de visualiser les observations atypiques ou tout simplement de se

familiariser avec la variable.

Il est ici rappelé que la variable d'intérêt

étudiée est la profondeur à laquelle nous atteignons la

roche en milieu marin (le toit du socle cristallin ou substratum).

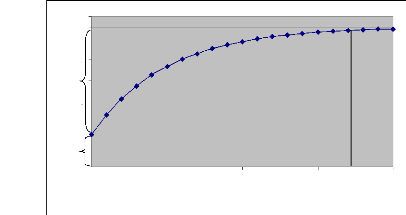

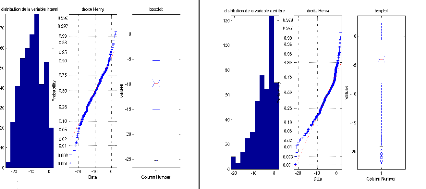

3.1/ Histogrammes et statistiques descriptives

L'étude de l'histogramme permet :

- d'apprécier la variabilité des données

- de détecter d'éventuelles valeurs aberrantes.

La droite d'Henry : si les probabilités sont

alignées le long de la droite d'Henry, nous pouvons supposer que la

variable suit une distribution gaussienne.

Le box plot est une autre façon d'appréhender la

distribution de la variable. Il a l'avantage de mettre en valeur les quartiles.

Les quartiles Q1, Q2 et Q3 sont les éléments essentiels de ce

graphique. Le quartile Q2 (ou médiane) partage la série de

données en deux groupes d'effectifs égaux. Le quartile Q1 partage

le groupe dont les valeurs sont inférieures à la médiane,

en deux groupes d'effectifs égaux. Q3 fait de même pour le groupe

dont les valeurs sont supérieures à la médiane.

La distribution des profondeurs au toit du socle cristallin

(rocheux) est représentée par les trois graphiques de gauche de

la figure 3.8. Ils montrent que les valeurs sont comprises entre 2

mètres au-dessus et 25 mètres en dessous du niveau zéro

(référence SHOM). L'étendue de 27 mètres peut nous

paraître importante. Mais en y regardant de plus près, on

s'aperçoit que la moyenne et la médiane sont toutes deux

égale à -10 mètres. Il en résulte que 1/4 des

valeurs sont comprises entre -5 et -10 mètres et qu'un autre quart entre

-10 et -15 mètres. Sachant qu'il n'y a qu'un très petit nombre de

valeurs supérieures à zéro ou inférieures à

-20 mètres, on peut parler d'une distribution équitablement

répartie sur son étendue (25% des valeurs sur 5 mètres

d'étendue).

La droite d'Henry et un test de normalité

(Kolmogorov-Smirnov) montrent que la distribution des profondeurs au toit du

substratum ne suit pas une loi Gaussienne. Par contre le coefficient

d'asymétrie (cf. tableau du bas) et l'histogramme permettent de penser

qu'elle s'en approche.

Si la propriété de normalité a l'avantage

de définir complètement la distribution par sa

moyenne et son

écart type, elle n'est pas une condition obligatoire en

géostatistique linéaire.

Celle-ci ne fait aucune

hypothèse particulière sur la distribution des valeurs. Toutefois

d'après

C. Cressie (Statistics for Spatial Data, 1993 p.110), le krigeage

a tendance à fournir de meilleures prévisions lorsque les

données suivent une loi normale.

Q3

Q2

Q1

Valeurs extrêmes

Profondeur au toit du socle cristallin

Valeurs du MNT

Figure 3.8

A titre d'exemple, l'histogramme des valeurs du MNT n'est pas

symétrique. D'un côté, 75% des profondeurs se regroupent

entre +2 mètres et -8 mètres (10 m d'amplitude) et de l'autre

coté, 25% des valeurs s'étendent entre -8 mètres et -22

mètres (14 m d'amplitude). Certaines valeurs extrêmes apparaissent

autour des -20 mètres de profondeur. Alors pour estimer le MNT, Cressie

recommande soit une transformation des données par une fonction

mathématique pour rendre la distribution gaussienne, soit

discrétiser en zones géographiques afin que les profondeurs dans

chaque zone soient proches les une des autres. Chaque zone géographique

est alors traitée individuellement.

Principales statistiques relatives aux deux variables

|

Variable d'intérêt

|

Variable Secondaire

|

|

Minimum

|

-25,3

|

-21,8

|

|

Maximum

|

2,1

|

2,3

|

|

Moyenne

|

-9,9

|

-5,1

|

|

Médiane

|

-9,9

|

-4

|

|

Ecart-type

|

6,1

|

5,2

|

|

Variance

|

36,8

|

27,7

|

|

Coefficient d'asymétrie

|

-0,08

|

-0,9

|

Le coefficient d'asymétrie conforte le fait que la

variable d'intérêt a une distribution presque symétrique.

Enfin, le coefficient de corrélation linéaire entre les deux

variables est égal à 0,84 ce qui indique une forte

dépendance entre les variables.

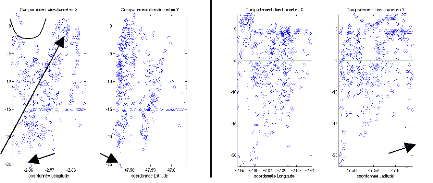

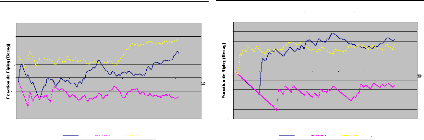

3.2/ Comportements directionnels : Etude de

stationnarité

Pour étudier le comportement dans l'espace des

variables observées, un outil exploratoire synthétique consiste

à visualiser les valeurs des variables le long des directions de

coordonnées.

(Est-Ouest) (Sud-Nord) (Est-Ouest)

(Sud-Nord)

Valeurs atypiques

Moyenne

Moyenne

Valeurs atypiques

Comportement directionnel de la variable d'intérêt

Comportement directionnel de la variable secondaire

Figure 3.9

Le tracé de l'évolution des profondeurs en

fonction de la longitude (axe Est-Ouest) et de la latitude (axe Sud-Nord) est

un moyen de détecter la présence d'une dérive spatiale

qui, si elle existe, devrait se traduire graphiquement par une croissance ou

une décroissance du nuage de points.

Le nuage de points de la variable d'intérêt

(figure 3.9 de gauche), est relativement homogène autour de la moyenne

dans la direction SN, en revanche les valeurs ont une légère

tendance à augmenter lorsque l'on se dirige de l'est vers l'ouest. Une

hypothèse de stationnarité serait adéquate dans la

direction sud-nord (tendance linéaire de pente nulle), mais pas

forcément dans la direction est-ouest, pour laquelle la moyenne n'est

pas constante. On pourrait avoir recours à l'hypothèse de

stationnarité intrinsèque pour décrire son comportement le

long de cette direction.

La variable MNT semble quant à elle être

stationnaire au regard de son comportement directionnel (nuage de point

relativement homogène et dispersion à peu près constante

le long des directions principales).

Les valeurs atypiques indiquées sur la figure 3.9 sont

pour certaines de fortes profondeurs dues au canal causé par le passage

étroit entre l'île aux Moines et le continent au nord de la zone

d'étude. Nous décidons de conserver ces données pour la

suite de l'étude. Mais d'autres sont des incohérences entre la

source des données sismiques et celle du MNT. Elles se localisent autour

du profil 34 (figure 3.5) situé dans une zone rocheuse. Les points

proches à valeurs discordantes sont supprimés.

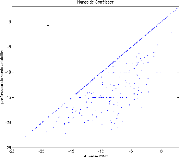

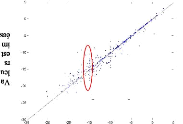

3.3/ Nuage de corrélation différée ou

« h-scatter plots »

Pour un vecteur de séparation h donné,

le nuage de corrélation différée est le nuage des points

formés par les couples de valeurs (z(si), z(si+h)) ; z(si)

représente la profondeur de la roche au point si.

Pour que cet outil soit pertinent, il faut que les observations

soient équitablement réparties sur

l'ensemble du champ. Plus

les valeurs prises aux sites si et si+h sont semblables, plus

le nuage

est proche de la première bissectrice ; au contraire, plus

ces valeurs sont différentes, plus le nuage est diffus.

Le nuage de corrélation différé est donc un

outil qui représente la structuration des valeurs pour une certaine

séparation (h).

Figure 3.10

Dans notre exemple la distance moyenne au voisin le plus

proche est d'environ 50 mètres. La figure 3.10 nous montre les nuages de

corrélation différée pour un vecteur de séparation

de longueur 50 mètres (plus ou moins 5 mètres) orienté

dans la direction est-ouest et sud-nord. Les valeurs prises aux sites

séparés par 50 mètres dans l'axe est-ouest se ressemblent

plus que celles prisent dans l'axe sud-nord. La corrélation est de 0,9

contre 0,8 pour l'axe SN.

Certains points se détachent particulièrement du

nuage ; un examen détaillé à l'aide de la figure 3.6

(carte LIDAR : LIght Detection And Ranging), révèle que ces

valeurs proviennent de zones de profondeur très localisées comme

dans le chenal.

Nous pouvons déduire des « h-scatter plots »,

que l'écart moyen entre la valeur prise en un site si et un

autre en si+50 mètres se rapproche de zéro sur l'axe

horizontal comme sur l'axe vertical. L'analyse variographique nous confortera

dans cette hypothèse.

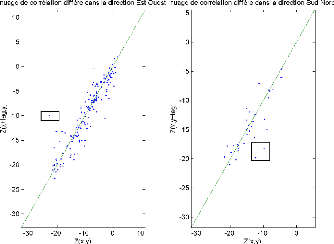

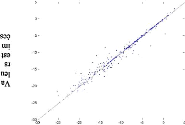

3.4/ Description bivariée

Il est important d'examiner la relation entre la variable

auxiliaire et la variable d'intérêt. Pour ce faire, les techniques

disponibles (coefficient de corrélation, covariance, graphiques)

requièrent des couples de données aux points d'observations

s1 à sn. Etant donnée que la

variable régionalisé auxiliaire n'a pas été

observée en ces points, une interpolation spatiale doit être

préalablement effectuée afin de prévoir ces valeurs

régionalisées.

Le MNT (variable auxiliaire) est connu sur un quadrillage d'un

espacement de 50 mètres. Il

en résulte que la distance maximum

qui sépare une observation de la variable principale à la

plus proche observation de la variable secondaire est de moins

de 50 mètres. Cette distance est très petite à

l'échelle du champ. C'est pourquoi nous avons décidé

d'utiliser la méthode d'interpolation des plus proches voisins. Les

voisins les plus proche seront les plus représentatifs de la

donnée à estimer.

Ceci fait la figure 3.10 montre la dépendance

linéaire des deux variables. Les points alignés sur la

bissectrice sont les points correspondant aux zones de roche (non couvert d'une

couche sédimentaire). Nous leur avions effectivement attribué la

profondeur donnée par le MNT.

Le coefficient de corrélation entre la variable

d'intérêt et la variable auxiliaire est de 0.84. Mais si on ne

prend pas en compte les points des zones de roches ce coefficient décent

à 0,75.

Tous les points

Sans les zones de roche

Y=0,75X-7,45

Figure 3.11

La droite de régression linéaire est alors

définie comme suit :

Y=0,75X-7,45

Y : Profondeur au toit du socle cristallin X : Profondeur

à la surface du fond marin

4/ Transformation des coordonnées

Les coordonnées des points sont en longitude, latitude de

projection WGS84. C'est un système géodésique dont

l'unité est exprimée en degrés.

Projection WGS84 : une

projection est une correspondance entre les points de la terre et ceux de la

représentation plane. La projection WGS84 est un système

universel, mais il en existe un grand nombre suivant l'endroit où l'on

se place sur le globe.

Pour revenir à un système de coordonnées

planes (une unité en ordonné égale une unité en

abscisse), dans le but de calculer une distance euclidienne nous appliquons une

transformation sur les coordonnées.

Longitude = longitude*cos(latitude*ð/180°) Latitude

= latitude

1 degré (longitude / latitude) 111,2 km

5/ Conclusion

L'étude exploratoire nous a permis de nous familiariser

avec les données. Elle montre comment la distribution de la profondeur

au toit du socle cristallin se rapproche d'une loi gaussienne. Il existe bien

une relation forte entre cette profondeur et celle du fond marin. Enfin, les

nuages des valeurs le long des directions de coordonnées et les nuages

de corrélations différées permettent de vérifier la

ressemblance des profondeurs dans un rayon de 50 mètres autour d'une

observation. Il faut à présent étudier plus

précisément la structure spatiale de la variable

d'intérêt. C'est l'analyse variographique qui va y

répondre.

Chapitre IV : Analyse variographique

L'analyse variographique est l'étape préalable

au krigeage. Le manque d'observations de la variable à prédire,

l'abondance d'information de la variable auxiliaire et l'information de

position (longitude/latitude) pour chacune des observations, nous ont

emmené à choisir l'interpolation par « krigeage ».

L'analyse variographique est menée afin d'estimer la

fonction de la continuité spatiale de la variable

d'intérêt. Dans ce chapitre nous présentons les

variogrammes expérimentaux selon diverses directions, l'étude du

comportement à courte distance et enfin l'ajustement d'un

modèle.

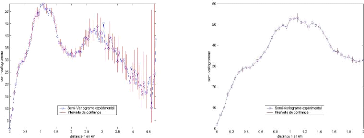

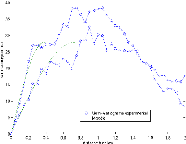

1/ Variogrammes expérimentaux

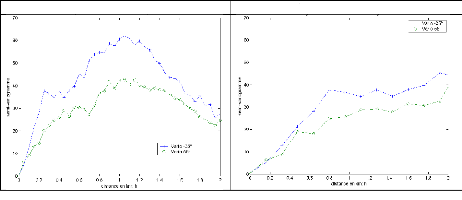

1.1/ Variogramme omnidirectionnel

Le variogramme caractérise la continuité

spatiale de la variable régionalisée. Sur la figure 4.1, on

trouve le variogramme expérimental omnidirectionnel, calculé pour

des distances multiples d'un pas de 50 mètres. L'intervalle de confiance

à 95% accordé à chaque point est indiqué

par une barre verticale. Cet intervalle de confiance est fonction de la

variance et du nombre de paires de points intervenant dans le calcul des points

expérimentaux.

Variogramme Omnidirectionnel Zoom sur 1/2 de la distance

maximale

Figure 4.1

En supposant que la distribution

Z(si)-Z(si+h) pour i=1 à n, suit une

loi gaussienne de moyenne nulle et de variance

2ã(h), on a 2 ( )

n 2 à ( )

ã h qui suit une loi du chi 2

à n degrés de

ã h

libertés. L'intervalle de confiance à á=95%

de la variance est alors donné par :

?

??

) ?

??

n ã h n h

2 à ( ) 2 à

(

ã

2

÷1

2

;

÷ á

á / 2 / 2

n : nombre de paire de points intervenant dans le calcul

des points expérimentaux

ã à ( h ) : valeur du point

expérimental à la distance h (cf. formule estimation du

variogramme) ÷2á : fractile

d'ordre á de la loi du ÷2 à n

degrés de liberté

Avant même de regarder plus précisément

les intervalles de confiances, Arnaud et Emery (2000 p .126) recommandent de ne

tenir compte dans le calcul du variogramme expérimental, que les

distances allant jusqu'à la moitié de la distance maximale

rencontrée entre deux points du champ (cf. figure 4.1 de droite).

Au-delà, le nombre de couples de points intervenant dans le calcul du

variogramme décroît et lui fait perdre en robustesse (cf. chap. II

§ 3.2).

Le variogramme omnidirectionnel atteint un palier à une

distance de 1100 mètres. On peut en déduire que la variable

régionalisée (profondeur au toit du substratum) est une

réalisation d'une fonction aléatoire stationnaire d'ordre 2 (M.

Arnaud et X. Emery, 2000 p.122 / Journel et Huijbergts, 1993 p.37).

1.2/ Variogrammes directionnels

La figure 4.3 montre les variogrammes directionnels, le long

des quatre directions principales du plan, d'orientation -35°, 55°,

100° 145° par rapport à la direction est-ouest. Ces directions

ont été choisies en fonction de l'orientation des profils 13 et

12 (cf. figure 3.5) et de la géographie observée sur l'image

LIDAR (figure 4.2).

embouchure

pointe

N

baie

dunes

55°

-35°

Figure 4.2

La bathymétrie de la zone d'étude montre une

continuité spatiale dans la direction 55°. On remarque que si l'on

se déplace sur un axe du sud-ouest au nord-est, la profondeur du fond

marin reste sensiblement la même, alors que si l'on se déplace du

nord-ouest au sud-est on doit faire face à de forte variation de

profondeurs. Cette morphologie est le résultat de la baie formé

au nord-ouest et de l'écoulement de l'eau provenant en grande force le

l'embouchure au nord-est.

Figure 4.3

Les variogrammes de la figure 4.3 sont sensiblement

différents. La différence d'accroissement à l'origine est

le symptôme d'une anisotropie. C'est un paramètre qu'il faut

prendre en compte.

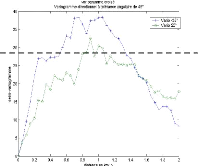

1.3/ Anisotropie

Une anisotropie caractérise un phénomène

qui se déploie préférentiellement dans certaines

directions de l'espace.

Les notions d'anisotropie, de continuité maximale et

minimale peuvent être schématisées de la manière

suivante :

55°

0.56km

-35°

0.175km

Anisotropie : Bien que la distance entre le point central et

celui en direction 55° soit plus grande que celle entre le point central

et le point en direction -35°, les valeurs prises en ces points sont

très proche (la corrélation est la même).

Direction de continuité maximale : direction à plus

forte porté.

On distingue deux types d'anisotropie.

L'anisotropie géométrique : On observe

dans diverses directions des paliers et des composantes pépitiques

identiques mais des portées différentes. Les portées

maximales (ag) et minimales (ap)

s'observent selon deux directions orthogonales (cf. chap. II § 3.4).

L'anisotropie zonale : On observe des paliers

différents selon les directions. Il n'existe pas de modèle

d'ajustement pratique pour traiter ce type d'anisotropie.

En observant la figure 4.3, on remarque que les paliers ne

sont pas identiques. Mais si l'on considère que la variable

régionalisée est stationnaire d'ordre 2, le palier est

approximativement égal à la variance. Les directions de

continuités maximale et minimale sont alors respectivement de 55°

et -35° par rapport à l'axe ouest-est avec une portée de

1100 mètres et 250 mètres.

·

2

Pour prendre en compte l'anisotropie géométrique,

on peut intervenir sur la distance. On peut ainsi évaluer

ã(h,è) en corrigeant la distance h.

?a ?

g

( cos )2

h è è + ?? h è

è

sin ??

? a p ?

Le modèle isotrope avec une portée maximale

ag=1100 mètres est alors

ã(hg).

Distance d'origines

Distances corrigées

Figure 4.4

L'accroissement à l'origine devient sensiblement identique

pour les deux directions principales. La nouvelle définition de la

distance a pour effet d'atténuer l'anisotropie.

· Une autre façon de tenir compte de l'anisotropie

est de faire un changement de repère. Si è est l'angle

de rotation, dans notre cas è=35°, la formule est la

suivante :

?

??

)

)

sin(è

cos(è

- sin( ) cos( )

è è

? ? ?

? ?

y1

y1

x 1

x'

1

' '

·

yi

yi

x i

?

??

xi

? ? ?

? ?

' '

yn

yn

xn

x n

? ? ? ? ?

?

?

?

? ?

De cette façon nous nous replaçons dans un

système de coordonnés redressé de 35° dans le sens

inverse des aiguilles d'une montre. Pour prendre en compte les portées

dans les deux directions on résout le système

? ? ?

ag

·

0

? ? ?

0

? ? ?

? ?

ap

''

x ' '

1

' '

xi

''

xn

ap : portée sur l'axe 0X

ag

: portée sur l'axe 0Y

? ? ?

? ?

? ? ?

? ?

y1

x'

1

' '

xi

yi

? ? ?

? ?

' '

yn

xn

Nouvel axe et unité

Axe et unité d'origine

35°

y1

''

yi

' '

yn

C'est cette seconde méthode que l'on retient pour

l'estimation par krigeage. 1.4/ Comportement à l'origine du

variogramme

Le comportement du variogramme à l'origine, reflète

le degré de régularité spatiale de la variable

régionalisée (cf. chap. II § 3.2).

- Un comportement de ãà ( h ) à

l'origine parabolique indique une grande régularité de la

variable régionalisée (continue et différentiable).

- Un comportement à l'origine linéaire montre que

la variable régionalisée est moins régulière (elle

est continue mais pas différentiable)

- Une discontinuité à l'origine ou effet de

pépite, signale une plus grande irrégularité de la

variable régionalisée. Il y a absence (partielle ou totale) de

corrélation entre les valeurs prises en deux sites très proches.

(Journel et Huijbregts, 1993 p.38).

D'après de la figure 4.1 et 4.3, on constate que les

variogrammes ont un comportement à

l'origine linéaire (

ãà ( h ) 10*h). La profondeur au toit du socle

cristallin est donc une variable

aléatoire continue.

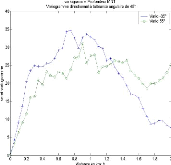

1.5/ Variogrammes croisés

Cov=28,2

Figure 4.5

Comme dans le cas monovarié, l'inférence

statistique nécessite des hypothèses de stationnarité de

la corégionalisation (ensemble des variables

régionalisées).

Pour analyser les liens spatiaux entre la profondeur du

substratum et la profondeur à la surface du fond marin, la figure 4.5

(de droite) montre les variogrammes croisés selon les directions

principales d'anisotropie. A sa lecture, nous faisons l'hypothèse d'une

stationnarité d'ordre deux car ils atteignent tous deux un palier

environ égal à la covariance.

D'autre part, nous observons que les variogrammes des deux

variables régionalisées et le variogramme croisé se

ressemblent fortement. Ca nous emmène à choisir le même

modèle de base pour leurs ajustements.

2/ Ajustement à un modèle

Le variogrammme expérimental calculé et ses

propriétés étudiées, il faut ajuster une courbe

théorique. Elle doit être définie pour toutes les distances

et toutes les directions de l'espace. Cependant toute fonction

mathématique ne peut être utilisée comme modèle. Un

modèle variographique doit être une fonction de type

négatif conditionnel (Cressie, 1993 p.86) c'est-àdire que :

n n

0

? ? ù ù 2ã ( )

i j s i s j

- =

i = =

1 1

j

n

|

quel que soit {si : i=1,...,n} et

{ùi : i=1,...,n / ?= ù =

i

i 1

|

0}

|

C'est pourquoi le modèle de variogramme est choisi parmi

un ensemble de fonction dont on sait qu'elles sont de type négatif

conditionnel (cf. partie II, chap.3.3).

Remarque : quel que soit le mode d'ajustement retenu, la

modélisation du variogramme aux courtes distances est

particulièrement importante.

2.1/ Cas monovariable

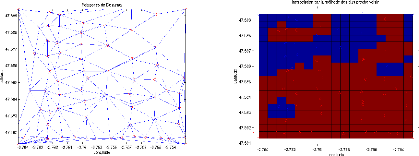

Des anisotropies dans les directions -35° et 55° ont

été détectées dans le paragraphe 1.3. Il convient

d'ajuster le variogramme dans ces directions. D'autre le palier dans les

directions principales est égal à la variance de la variable

régionalisée, soit 38,6. N'ayant pas observé

d'effet pépite, le comportement à l'origine de la variable

aléatoire régionalisée est linéaire.

Ces observations amènent à choisir entre un

modèle sphérique et un modèle exponentiel. Le

modèle sphérique est préférable, d'une part parce

qu'il s'ajuste mieux sur les points de petite distance du variogramme

expérimental et d'autre part parce qu'après plusieurs essais il

donne de meilleurs résultats.

M. Arnaud et X. Emery montrent que la variance d'estimation

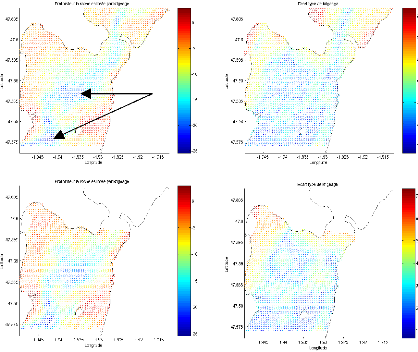

(variance de krigeage) est plus élevée dans le cas du