|

Année Académique 2007/2008

APPROCHE DE RÉSOLUTION

PAR

RÉGULARISATION DES PROBLÈMES DE

PROGRAMMATION

MATHÉMATIQUE À DEUX

NIVEAUX DANS LE CAS DE LA NON

UNICITÉ DE

LA SOLUTION DE LA SOLUTION DU PROBLÈME

DU

SUIVEUR.

MÉMOIRE

Présenté et soutenu en vue de l'obtention du

Diplôme d'Études Approfondies (D.E.A.) Option : ANALYSE

NUMÉRIQUE

Par :

FOUODJI DEDZO FRANCISQUE

Matricule 02W026

Sous la direction de :

PAULINE LAURE FOTSO Maître de Conférence

Dédicaces

Je dédie ce travail

? A mon père,

? A ma mère,

? A la famille Tsapi,

? A mes frères et soeurs.

Mémoire de DEA * Laboratoire

d'analyse numérique * UYI Francisque.D.Fouodji

c~UYI 2007-2008

Mémoire de DEA *

Laboratoire d'analyse numérique *

UYI Francisque.D.Fouodji c~UYI 2007-2008

Remerciements

Ce travail n'aurait pu être réalisé sans

le concours, le soutien et les encouragements de plusieurs personnes que je

tiens à remercier particulièrement. Il s'agit de :

? Professeur Pauline Laure Fotso, qui malgré ses

nombreuses occupations à accepté d'encadrer ce travail, et ainsi

guider mes pas dans ce premier travail de recherche;

? mr Calixte.O.Pieume, dont la disponibilité infinie et

les conseils avisés m'ont permis d'éviter bien

d'écueils;

? le Dr Guy Merlin Mbakop, qui m'a ouvert

généreusement sa bibliothèque personnelle;

? les enseignants du département de

mathématiques de l'université de Yaoundé I et de

l'école normale supérieure de Yaoundé, à qui je

doit la majeure partie de mes connaissances en mathématiques;

? mon père Mr Dedzo André et ma mère Mme

Kamené Marie, qui m'ont transmis le goût de l'effort, et qui n'ont

jamais cessé de m'apporter leurs support tant matériel que

psychologique;

? les familles Tsapi, Nzangué et Zietchou, pour leur

aide matérielle et leur encouragements;

? mes frères aînées Theophile, Merlin et

Gustave, qui ont été mes guides éclairés durant mes

premières années d'université et dont l'apport à ma

formation universitaire et intellectuelle ne saurait être

quantifié.

? mes camarades de promotion: Daoussa Daniel, Tchouaké

Hervé, Kenfac Brice, Ngongang Eric, Ekwadi cyrille, Moualeu Dany, Batkam

cyrille, Kenmogne Marcelin;

? mes amis Chassep Joel, Tagne Takam Cyrille, Mbah .N.Serge,

Tewa Jean Claude, Meta-gheu Gisèle, Pokouo Sandrine, Tagne.K.Steve

william;

? tous ceux que je n'ai pas cité ici et qui m'ont

apporté leur aide durant ce travail.

Mémoire de DEA * Laboratoire

d'analyse numérique * UYI

Francisque.D.Fouodji c~UYI 2007-2008

Table des matières

Dédicaces i

Remerciements ii

Table des matières iv

Table des figures v

Résumé vi

Abstract vii

Introduction générale viii

|

1

|

Genéralités sur la programmation

mathématique à deux

niveaux

|

1

|

|

1.1

|

Formulation générale des PBN

|

2

|

|

|

1.1.1 Définition et présentation

|

2

|

|

1.2

|

Quelques propriétés des PBN

|

3

|

|

1.3

|

Quelques résultats d'optimisation paramétrique

|

6

|

|

1.4

|

Conditions d'optimalités

|

12

|

|

|

1.4.1 Cas des PBN linéaires

|

12

|

|

|

1.4.2 Cas général

|

13

|

|

1.5

|

Algorithmes et méthodes de résolution des PBN

|

14

|

|

|

1.5.1 Algorithme de descente

|

14

|

|

|

1.5.2 L'algorithme du paquet

|

15

|

|

1.6

|

Les applications de la PBN

|

16

|

|

|

1.6.1 Production agricole , production de biocarburant

|

16

|

|

|

1.6.2 Le problème principal-agent [10]

18

|

|

|

2

|

Non unicité de la solution du problème

du suiveur : les différentes

techniques

|

|

|

d'approches.

|

20

|

|

2.1

|

Position du problème

|

21

|

|

2.2

|

L'approche optimiste

|

22

|

|

2.3

|

L'approche pessimiste

|

24

|

TABLE DES MATIÈRES iv

Mémoire de DEA * Laboratoire

d'analyse numérique * UYI Francisque.D.Fouodji

c~UYI 2007-2008

3 Approche de résolution par

régularisation des PBN dans le cas de la non

unicité. 30

3.1 La

régularisation de Tykhonov ............................ 30 3.2

régularisation par l'élément de plus petite norme

.................. 37

3.2.1 première méthode

............................... 37

3.2.2 Deuxième méthode

.............................. 41

3.3 Algorithme de résolution d'un PBN dans le cas de la

non unicité ......... 43

3.3.1 La methode du paquet ............................ 43

3.3.2 Présentation de l'algorithme

......................... 44

3.4 Convergence de l'algorithme du paquet

modifié ................... 47

Conclusion et perspectives 50

Bibliographie 51

Mémoire de DEA * Laboratoire

d'analyse numérique * UYI Francisque.D.Fouodji

c~UYI 2007-2008

Table des figures

1.1 Sur les effets du transfert de la contrainte x

= 0 du premier niveau dans (BLP1)

au second niveau dans (BLP2).

........................... 4

1.2 Sur l'importance de l'ordre du jeu

.......................... 5

2.1 Sur les difficultés rencontrées dans le cas

de la non unicité ............ 22

2.2 Fonction objectif du leader ..............................

27

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji

c~UYI 2007-2008

Résumé

Les approches classiques de résolution des PBN

(Problème de programmation mathématique à deux-niveaux)

dans le cas de la non unicité de la solution du problème du

suiveur qui sont : l'approche optimiste et l'approche pessimiste

présentent de nombreux défauts. Parmi lesquels le problème

d'instabilité des solutions optimiste et pessimiste ainsi que celui de

leurs l'éloignement, par rapport à la solution réelle du

problème [11]. Dans ce document, nous présentons une approche de

résolution des PBN dans le cas de la non unicité qui permet de

contourner ces défauts : l'approche de résolution par

régularisation des problèmes de programmation à

deux-niveaux dans le cas de la non unicité de la solution du

problème du suiveur. Cette méthode consiste à introduire

dans le problème du suiveur un paramètre (le paramètre de

régularisation) de sorte que le nouveau problème du suiveur (le

problème du suiveur régularisé) admette une solution

unique fortement stable. Lorsque le paramètre de régularisation

tend vers zero, la solution du problème régularisé

converge vers une approximation de la solution du problème original qui

présente de meilleures propriétés de

régularité que les solutions obtenues par les approches

classiques (approches optimiste et pessimiste) de résolution des PBN de

ce type. Nous présentons également un algorithme de S.Dempe issu

de cette approche, dont nous étudions la convergence

théorique.

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji

c~UYI 2007-2008

Abstract

Optimistic and pessimistic approaches are classical methods

uses for solving bilevel programming problems with non-unique lower level

solutions. But, both the optimistic and pessimistic solutions can in general

not be assumed to be good approximations of realized solutions in practice, and

small changes in the problem data can result in drastic changes of theses

solutions [11]. We present in this document an approach which circumvents these

difficulties : the regularization approach for solving bilevel problems with

non-unique lower level solutions. This approach consists (in general) of

introducing a regularization parameter in the lower level problem such that the

new problem (regularized problem) has a unique lower level solution which is

strongly stable. This solution converges (when the regularization parameter

converges to zero) to an approximation of the original problem which is more

regular (and even better) than optimistic and pessimistic solutions

respectively. We present also an algorithm by S.Dempe resulting from

regularization approach and show the convergence of this algorithm.

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji

c~UYI 2007-2008

Introduction générale

Les Hommes recherchent en général ce qu'il y'a

de meilleur, et lorsqu'ils sont face à un problème de prise de

décision, tous voudraient prendre la décision optimale.

Un des traits caractéristiques de notre époque

est l'intérêt croissant porté aux problèmes de

planification économique, de gestion, et de contrôle de

systèmes. Comme jamais dans l'histoire, on ressent de nos jours la

nécessité d'une gestion fructueuse et efficace des ressources

naturelles et humaines, des moyens matériels et techniques.

Ainsi se pose le besoin de disposer d'outils objectifs

susceptibles d'aider à prendre face à un problème, la

meilleure décision.

Le domaine des mathématiques qui permet de

modéliser les processus de prise de décision est la programmation

mathématique. Au fil du temps et en fonction des besoins, se sont

développées la programmation linéaire (PL), la

programmation non linéaire (PNL), la programmation multiobjectif (POM)

et la programmation à deux-niveaux.

La PL et la PNL permettent de modéliser des processus

de prise de décisions dans les systèmes centralisés;

c'est-à-dire dans les systèmes où un seul décideur

est préoccupé par l'optimisation d'une fonction objectif soumise

à des contraintes éventuelles. La POM quant à elle permet

d'aborder les problèmes d'optimisation dans lesquels le décideur

voudrait atteindre plusieurs objectifs simultanément.

Pour ce qui est de la programmation à deux-niveaux

(PBN), elle permet de modéliser des processus de prises de

décision dans un système décentralisé. Ici, deux

décideurs ne pouvant agir indépendamment l'un de l'autre, mais

suivant une certaine hiérarchie, souhaitent prendre chacun la meilleure

décision par rapport à des objectifs généralement

différents. La stratégie choisie par l'un des décideurs

(le leader ou décideur du premier niveau) influence la fonction objectif

et/ou la région réalisable de l'autre (le suiveur ou

décideur du second niveau). Par conséquent, la décision de

ce dernier est fortement liée à celle du leader. Ainsi un PBN est

constitué de deux problèmes d'optimisation qu'on ne peux

résoudre séparément.

La PBN suscite depuis quelques décennies

déjà un grand intérêt dans la communauté de

la programmation mathématique; ceci grace à ses nombreuses

applications en économie, en ingénierie et dans plusieurs autres

domaines des sciences.

La plupart des méthodes de résolution des PBN

développées dans la littérature suppose au

préalable que le problème du second niveau admet une solution

unique; ceci dans le but de transformer le PBN en un problème

d'optimisation à un niveau classique. Mais il se trouve que la

majorité des problèmes modélisés sous forme de PBN

sont tels que le problème du suiveur n'admet pas une solution unique

[11].

C'est pourquoi la recherche depuis plus d'une décennie

déjà, est tournée vers la résolution des PBN dans

le cas de la non unicité de la solution du problème du second

niveau.

Notre travail consiste à présenter une approche

de résolution des PBN qui fait actuellement l'objet de recherches

profondes : l'approche de résolution par régularisation des PBN

dans le

TABLE DES FIGURES 0

Mémoire de DEA * Laboratoire

d'analyse numérique * UYI Francisque.D.Fouodji

c~UYI 2007-2008

cas de la non unicité de la solution du problème du

suiveur.

Ce travail est organisé ainsi qu'il suit :

? au chapitre un, nous

présentons les généralités sur la PBN dans le cas

de l'unicité de la solution du problème du second plan;

? au chapitre deux nous

présentons les différentes techniques d'approches des PBN dans le

cas de la non unicité;

? enfin au chapitre trois nous

présentons l'approche par régularisation, ainsi qu'un algorithme

de résolution basé sur cette approche développé par

S.Dempe, dont nous étudions la convergence.

CHAPITRE PREMIER

Genéralités sur la programmation

mathématique à deux niveaux

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji

c~UYI 2007-2008

Introduction

La programmation mathématique à deux niveaux

(PBN) est une branche de la programmation mathématique qui résoud

des problèmes ayant une structure hiérarchique constituée

de deux unités indépendantes de prise de décision. Chaque

unité de la hiérarchie souhaite minimiser (ou maximiser) sa

fonction objectif, en tenant compte du contrôle partiel exercé

à l'autre niveau de prise de décision. La PBN modélise des

problèmes de prise de décision qui exigent des compromis parmi

les objectifs de deux individus ou entités qui interagissent. Un

décideur se voit assigner le rôle de meneur (ou leader ou

décideur du premier plan) et prend sa décision en fonction de la

(ou des) décision(s) éventuelle(s) d'un décideur de second

plan appelé suiveur. La première utilisation d'un modèle

hiérarchique date de 1934 et a été faite

par H.V Stackelberg [2] dans une monographie sur l'économie de

marché, pour décrire la situation de plusieurs décideurs

qui veulent réaliser leurs objectifs respectifs mais ne peuvent le faire

indépendamment les uns des autres. Cependant les toutes premières

formulations liées aux PBN proprement dit sont l'oeuvre d'auteurs tels

que Kornaj et Liptack [3] en 1965, Ross [4], Simaan et Cruz [5] ou Bracken et

McGill [6]. Toutefois, Candler et Norton [7, 8] furent les premiers à

utiliser la terminologie programmation à deux niveaux

ou à plusieurs niveaux dans un rapport de la banque mondiale.

C'est finalement au début des années 1980 que, vu ses

applications dans la résolution d'une multitude de problèmes

concrets (problèmes de gestion, de planification économique, de

contrôle de systèmes, de chimie, de sciences

environnementales,....), la PBN a commencé à susciter une

attention particulière. Motivés par la théorie des jeux de

H.V Sta-ckelberg [2], plusieurs auteurs se sont lancés dans

l'étude de la PBN; ce qui a permis son essor dans la communauté

de la programmation mathématique.

Dans ce chapitre, après avoir donné une

présentation générale et quelques propriétés

des PBN, nous présenterons des résultats d'optimisation

paramétrique généralement utilisés pour leur

résolution. Ensuite, nous donnerons quelques conditions sous lesquelles

les PBN admettent des solutions dans le cas de l'unicité de la solution

du problème du suiveur; ce qui nous permettra de présenter des

algorithmes développés afin de construire de manière

effective ces solutions. Nous terminerons en donnant quelques unes des

nombreuses applications de la PBN.

Genéralités sur la programmation

mathématique à deux niveaux 2

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji

c~UYI 2007-2008

1.1 Formulation générale des PBN

1.1.1 Définition et présentation

Un problème de programmation mathématique à

deux niveaux peut être défini comme un problème

d'optimisation dont l'une des contraintes est un autre problème

d'optimisation. La formulation générale d'un PBN est la suivante

:

|

min F(x,y)

|

(1.1)

|

|

y

|

|

|

sujet à : G(x,y) = 0

|

(1.2)

|

|

min f(x,y)

x

|

(1.3)

|

|

sujet à : g(x,y) = 0

|

(1.4)

|

La fonction F : Rn

× Rm -? R ;

n, in ? N représente la fonction objectif du leader tandis que

la fonction f : Rn ×

Rm -? R ; n, in ? N

représente celle du suiveur.

Les fonctions G : Rn

×Rm -?

Rp et g : Rn

×Rm -?

Rq sont respectivement les contraintes du

problème du leader et du problème du suiveur.

Le leader est le décideur qui à la

possibilité de prendre une décision sans tenir compte des

opinions d'autres décideurs que lui. Mais étant donné

(comme c'est le cas dans plusieurs problèmes d'optimisations concret)

que la possibilité de prendre une décision optimale (i.e celle

qui minimise sa fonction objectif) ne dépend pas uniquement de sa

personne, le leader se voit contraint de prendre en compte les réactions

d'un autre décideur qu'on appelle le suiveur.

les vecteurs x et y qui apparaissent dans le

problème (1.1) - (1.4) sont respectivement appelés variable du

problème du suiveur et variable du problème du leader.

La structure hiérarchique du problème (1.1) -

(1.4) suggère que le problème du leader (1.1) - (1.2) ne peut

être résolu si l'on ne connaît pas la (ou les ) solutions du

problème du suiveur (1.3) - (1.4); ce qui permet de définir une

autre formulation du PBN comme suit :

|

«min

y

|

{ }

» F (x, y) : G(x, y) = 0 et x ? (y)

(1.5)

|

avec pour y fixé dans Rm

:

{ }

(y) := Argmin f(x, y) : g(x, y) = 0

(1.6)

x

(y) représente l'ensemble des solutions du

problème d'optimisation paramétrique (1.3) - (1.4). Les

guillemets dans (1.5) expriment l'incertitude de la définition du PBN

dans le cas où (y) n'est pas réduit à un

singleton ( non unicité de la solution du problème du suiveur) La

formulation (1.5) - (1.6) est celle que nous utiliserons tout au long de cet

exposé.

Pour y fixé dans Rm

, l'ensemble M(y) := {x ?

Rn : g(x, y) = 0}

représente l'ensemble des

décisions admissibles du suiveur ( ou encore la

région réalisable du suiveur ).

{ }

L'ensemble R := (x, y) ? Rn

× Rm : G(x,

y) = 0 et x ? (y)est la région réalisable

du

leader.

Le PBN peut encore se mettre sous la forme :

Définissons à présent ce qu'on entend par

solution d'un PBN

Genéralités sur la programmation

mathématique à deux niveaux 3

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

n o

Définition 1.1.1. On considère le problème

(1.5) - (1.6) On pose Y = y E 1[8m :

G(y) < 0 .

On suppose que Ø(y) est réduit à un

singleton pour tout y E Y .

Un point (x*, y*) E 1[8n

x 1[8m est appelé solution optimale locale du

problème (1.5) - (1.6) si y* E Y, x*

E Ø(y*) et il existe une boule ouverte

centrée en y*

(Uä(y*), 8 > 0) avec

F(x, y) > F(x*,

y*) pour tout (x, y) satisfaisant y E Y

n Uä(y*) , x E

Ø(y).

(x*, y*) est solution optimale

globale si 8 = oo.

Remarques 1.1.1.

1) Si le problème (1.3) - (1.4) admet une solution

unique x(y) pour chaque paramètre y

vérifiant les contraintes du leader, alors sous des

hypothèses de régularité sur les fonctions contraintes du

second plan [ 9,10 ], la fonction

x : 1[8m -? 1[8n y H

x(y)

est continue. avec {x(y)} =

Ø(y) .

2) Si le problème (1.3) - (1.4) n'admet pas une

solution unique pour tout paramètre y vérifiant les

contraintes du premier niveau, alors le leader se trouve face à un

dilemme [11] en ce sens que même s'il connaît sa région

réalisable, il ne sait pas quelle sera la décision du suiveur.

L'analyse des différentes approches permettant d'attaquer (1.1) - (1.4)

dans ce cas de figure fera l'objet du chapitre suivant.

3) Les contraintes du leader sont dites couplées

lorsque la fonction contrainte du premier niveau G dépend

effectivement de la variable x contrôlée par le suiveur.

Rechercher les solutions réalisables qui vérifient ces

contraintes en étant compatibles avec la reaction du suiveur est aussi

difficile que la résolution du PBN lui même [10].

Nous allons maintenant présenter quelques

propriétés caractéristiques des PBN :

1.2 Quelques propriétés des PBN

Propriété 1.2.1. Dans la formulation du PBN

(1.1) - (1.4), la position des fonctions contraintes n'est pas arbitraire. En

effet, en transférant les contraintes du leader au problème du

suiveur, la région réalisable de celui-ci s'en trouve

réduite (ou restreinte) ; ce qui peut modifier la solution (si elle

existe ) du problème du suiveur, et partant la solution du

problème (1.1) - (1.4). Il en est de même si on transfère

plutôt les contraintes du suiveur au problème du leader. Nous

illustrons cette propriété par cet exemple tiré de [13]

:

On considère le PBN linéaire :

(BLP1) :

max

y

y

sujet à : 0 < y < 1

{w:w<y}

x = 0

x E Argmax

w

|

et le problème : (BLP2) :

|

max

y

|

y

|

Genéralités sur la programmation

mathématique à deux niveaux 4

sujet à : 0 < y < 1

|

x E Argmax

w

|

{w : w <

y et w = 0}

|

Les problèmes (BLP1) et

(BLP2) ont les mêmes contraintes excepté

le fait que la contrainte du premier niveau dans

(BLP1) est transféré au deuxième

niveau dans (BLP2).

Comme le montre la figure ci-dessous, les deux problèmes

ont une même région réalisable.

Mémoire de DEA * Laboratoire

d'analyse numérique * UYI Francisque.D.Fouodji

c~UYI 2007-2008

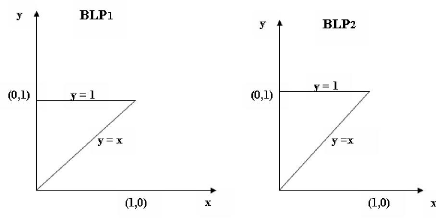

FIG. 1.1 Sur les effets du transfert de la contrainte

x = 0 du premier niveau dans

(BLP1) au second niveau dans

(BLP2).

{ }

On a 1 = (0, y) : 0 <

y < 1

pour les deux problèmes; mais pour y

fixé dans R, on a pour (BLP1) :

Ø(y) = {y} tandis

que (

{0} si y = 0

pour (BLP2) :

Ø(y) = w sinon .

Il s'ensuit que pour (BLP1) la seule

solution réalisable et qui s'avère être la solution

optimale est y = 0. La solution optimale pour

(BLP2) est y = 1.

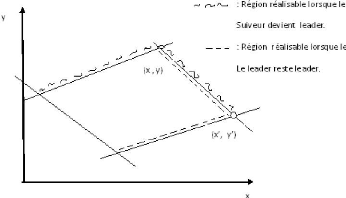

Propriété 1.2.2. La solution optimale du PBN

change en général lorsque l'ordre du jeu

est changé (i.e lorsque le problème du

leader est décalé au second plan tandis que le suiveur devient le

leader). Ceci est dû au fait que le problème étant

hiérarchique, les deux décideurs ne peuvent prendre leurs

décisions simultanément; ce qui signifie que le leader se doit

d'anticiper sur le choix du suiveur sous réserve que celui-ci à

le droit et la possibilité de choisir une solution optimale sous les

conditions posées par les choix du leader [11]. Nous illustrons cet

exemple par la figure 1.2 tirée de [11], sur laquelle

(x, y) et

(x',

y') représente respectivement la

solution

Genéralités sur la programmation

mathématique à deux niveaux 5

Mémoire de DEA * Laboratoire

d'analyse numérique * UYI Francisque.D.Fouodji

c~UYI 2007-2008

FIG. 1.2 Sur l'importance de l'ordre du jeu

optimale lorsque le ieme

décideur à le premier choix.

Propriété 1.2.3. La solution

optimale d'un PBN n'est pas en général indépendante

des

{ }

min (x - 1)2

+ (y - 1)2 :

x E Ø(y) .

y

contraintes inactives ajoutées au problème du

suiveur. L'exemple suivant tiré de [14] illustre bien cette

propriété :

Soit le PBN :

{ }

avec Ø(y) =

Argmin 0.5x2

+ 500x - 50xy .

x

{ }

. Ce problème est équivalent à :

min (x-1)2

+(y -1)2 :

x+500-50y = 0 . La

solution

x, y

unique de ce problème est

(x*, y*)

= (0.82; 10.02) et la valeur

optimale de la fonction objectif est

F(x*, y*)

= 81.33.

Ajoutons la contrainte x ~ 0 au

problème du suiveur; alors

(x*, y*)

est un point réalisable pour le problème et

x* ~ 0; mais la solution optimale

du suiveur est :

1

50y - 500 si y

~ 0

En introduisant cette fonction dans fonction objectif du

leader, on a :

1

(50y - 501)2

+ (y - 1)2 si y

~ 0

F (x(y),

y) =

x(y) = 1 + (y -

1)2 si y ~ 10

.

1 + (y - 1)2 si

y ~ 10

La valeur minimale de cette fonction est 1

et est atteinte en (x°,

y°) = (0, 1). Une

condition nécessaire et suffisante garantissant au PBN l'existence d'une

solution optimale globale indépendante par ajout ou suppression de

contraintes inactive peut-être trouvé dans [14].

Genéralités sur la programmation

mathématique à deux niveaux 6

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

Dans toute la suite, nous ne considérerons que les PBN

dans lesquels les contraintes du leader ne sont pas couplées ; i.e la

fonction contrainte du leader ne dépend pas de la variable du

problème du suiveur. Ainsi les contraintes du leader s'écriront :

G(y) < 0 au lieu de G(x, y) < 0.

Dans le but de prendre en compte les contraintes du type

égalité, les contraintes du deuxième plan seront

désormais de la forme g(x, y) < 0 et

h(x, y) = 0 où h : 1[8n x

1[8m -> 1[8k

le problème (1.1) - (1.4) devient donc :

{ }

min F(x, y) : G(y) <

0, x E Ø(y) . (1.7)

y

|

avec Ø(y) = Argmin

x

|

{ }

f(x, y) : g(x, y) < 0 et

h(x, y) = 0 .

|

Ø(y) représente l'ensemble des solutions

du problème d'optimisation paramétrique :

{ }

min f(x, y) : g(x, y) < 0

et h(x, y) = 0 . (1.8)

x

comme nous l'avons indiqué précédemment,

la résolution de (1.7) - (1.8) suppose la résolution au

préalable du problème d'optimisation paramétrique que

constitue le problème du suiveur (1.8). Par ailleurs, la plupart des

méthodes de résolution des PBN exploitent des conditions

nécessaires et suffisantes permettant de montrer l'équivalence du

PBN à un problème d'optimisation à un niveau classique de

la forme :

|

min

y

|

{F(x(y),y). : G(y)

< 0}. (1.9)

|

Où x(y) représente la solution

de (1.8) pour le paramètre y. La résolution de (1.9)

nécessite outre la régularité des fonctions F et

G, la continuité au moins de la fonction à valeur

optimale x : y i-> x(y). Ainsi donc, la

résolution d'un PBN est fortement lié à la

résolution d'un problème d'optimisation paramétrique.

Dans le paragraphe à venir, nous présentons les

résultats d'optimisation paramétrique nécessaires à

la résolution des PBN.

1.3 Quelques résultats d'optimisation

paramétrique

On considère le problème (1.8) pour y

fixé dans 1[8m ; avec les fonctions f, g

et h suffisamment régulières.

On considère l'application M : 1[8m

-> 2' définie par :

{ }

M(y) := x E 1[8n :

g(x, y) < 0 et h(x, y) = 0 pour tout

y E 1[8m.

M(y) est l'ensemble réalisable de (1.8)

pour le paramètre fixé y. On défini l'ensemble

des minimaux locaux de (1.8) par

{ }

Øloc(y) = x E M(y) :

?E > 0 avec f(x, y) < f(z,

y) Vz E M(y) n

Vå(x) ;

{ }

où Vå := z E

Rn : 11x - z11 < E est la

boule ouverte centré en x et de rayon E.

Soit L(x, y, À, u) := f(x,

y) + ÀTg(x, y) +

uTh(x, y) , le lagrangien du

problème (1.8).

Genéralités sur la programmation

mathématique à deux niveaux 7

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

On pose :

{ }

A(x, y) := (À, u) E 1[8p x

1[8q : À > 0,

ÀTg(x, y) = 0,

VxL(x, y, À, u) = 0

{ }

L'ensemble SP(y) = x E

M(y) : A(x, y) =6 0 est appelé l'ensemble des

points station-

naires du problème (1.8)

Dans la suite, nous utiliserons abondamment l'assertion suivante

:

{ }

(C) : l'ensemble (x,y) E 1[8n x 1[8m

: g(x, y) < 0, h(x, y) = 0 est non

vide et compact

Définition 1.3.1. Soit y0 E 1[8m,

x0 E M(y0)

On dit que lescontraintes de qualification de

Mangasarian-Fromowitz (MFCQ) sont satisfaites au point (x0,

y0) s'il existe une direction d E 1[8n satisfaisant

:

Vxgi(x0, y0)d < 0 pour

tout i E I(x0.y0) := {j :

gj(x0, y0) = 0}

Vxhj(x0, y0) = 0 pour tout j

= 1, ...., q

}, , q sont linéairement indépendants.

{et les gradients Vxhj(x0,y0) : j

= 1

Définition 1.3.2. soit y0 E 1[8m et

x0 E SP(y0)

On dit que les conditions suffisantes d'optimalités

forte (SSOC) sont satisfaites au point (x0, y0) si pour

tout (À, u) E A(x0, y0) et pour tout d

=6 0 satisfaisant :

(i) Vxgi(x0, y0)d = 0 pour

tout i E J(À) := {j :

Àj > 0}

(ii) Vxhj(x0, y0) = 0 pour tout j

= 1, ..., q on a dTV xxL(x0,

y0, À, u)d > 0.

Définition 1.3.3. On dit que les contraintes de

constance de rang (CRCQ) sont satisfaites au point (x0,

y0) si il existe une boule ouverte centrée en (x0,

y0) de rayon e > 0

Wå(x0, y0)

tel que pour tout sous ensembles I Ç

I(x0, y0) := {i :

gi(x0, y0) = 0} ; J Ç {1, ....,

q} , la

{ } { }

famille de gradients Vxgi(x,y) :

i E I U Vxhj(x0,y0) : j E

J ait le même rang pour tout (x, y) E

Wå(x0, y0).

Définition 1.3.4. Une fonction f : 1[8k

-- 1[8 est dite semi-continue inférieurement au point

|

zn = z on a lim inf

n?oo

|

f(zn) > f(z)

.

|

z E 1[8k si pour toute suite

{zn}oon°1 Ç 1[8k avec lim

n?oo

f est dite semi-continue supérieurement au point

z E 1[8k si pour toute suite {zn}oon°1

Ç 1[8k

|

avec lim

n?oo

|

zn = z on a lim sup

n?oo

|

f(zn) < f(z)

.

|

Genéralités sur la programmation

mathématique à deux niveaux 8

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

Définition 1.3.5. Une fonction F : Rk -?

2Rl est dite semi-continue supérieurement au point

z ? Rk si pour tout ensemble ouvert Z avec

F(z) ? Z , il existe une boule ouverte centrée en

z, Uä(z); 8 > 0 telle que

F(z') ? Z pour tout z' ?

Uä(z).

F est dite semi-continue inférieurement au

point z ? Rk si pour tout ensemble ouvert Z avec

F(z) n Z =6 Ø , il existe une boule ouverte

centrée en z, Uä(z); 8 > 0

telle que F(z') n Z =6 Ø pour tout

z' ? Uä(z).

Définition 1.3.6. Une fonction F : Rk -?

2R1 telle que F(y) est non vide et compact pour tout y

? Rk est dite Lipchitz-continue supérieurement

en un point z ? Rk si il existe une boule ouverte

centrée en z, (Uä(z); 8 > 0)

et une constante K < 8 telle qu'on a pour tout z'

? Uä(z), l'inclusion

F(z') ? F(z) + Kkz -

z'kBl ; où Bl

désigne la boule unité de Rl.

F est dite Lipschtz-continue inférieurement en

un point z ? Rk si il existe une boule ouverte

centrée en z,( Uä(z); 8 > 0)

et une constante L < 8 telles que pour tout z', z''

? Uä(z), on a l'inclusion

F(z') ? F(z'') +

Kkz'' -

z'kBl.

Définition 1.3.7. L'optimum local x0 ?

Øloc(y0) est dit fortement stable s'il existe une boule ouverte

centré en y0 (Uä(y0), 8 > 0)

, une boule ouverte centré en x0

(Vå(x0), å > 0) et une

fonction continue

x : Uä(y0) -?

Vå(x0) tel que x(y) soit

l'unique optimum local du problème (1.8) dans

Vå(x0) pour tout y ?

Uä(y0).

Théorème 1.3.1. [16] Soit y0 ?

Rm. On suppose que les assertions (MFCQ) et (SSOC) sont

satisfaites pour (1.8) en (x0, y0) avec x0 ?

Øloc(y0). Alors l'optimum local x0 est fortement

stable.

La preuve originale de ce théorème dans [16]

utilise une théorie que nous n'avons pas abordé dans ce travail :

la théorie du degré. Dans [11], ce résultat est

démontré autrement en supposant qu'en plus, ( 1.8) satisfait les

contraintes d'indépendance linéaire (LICQ) en (x0,

y0).

Définition 1.3.8. On dit que (1.8) satisfait les

contraintes d'indépendance linéaire (LICQ) en (x0,

y0) si la famille de gradients :

n o [ n o

?xgi(x0, y0), i ?

I(x0, y0)

?xhj(x0,y0),j = 1, ..., q est

linairement independante.

Où I(x0, y0) := i :

gi(x0, y0) = 0

Définition 1.3.9. Une fonction f : Rp -? Rq

est dite localement Lipschitz-continue au point x0 ? Rp s'il

existe une boule ouverte centré en x0,

(Vå(x0), å > 0) et

une constante K < 8 tel que

f(x) - f(x') .

= Kkx - x0k pour tout x, x'

? Vå(x0)

F est dit localement Lipschitz-continue

supérieurement en x0 si pour toute boule ouverte

centrée en x0 ? Vå(x0),

å > 0 et pour une certaine constante K < 8, on a

l'égalité :

f(x) - f(x0) =

Kkx - x'k pour tout x ?

Vå(x0)

Genéralités sur la programmation

mathématique à deux niveaux 9

Définition 1.3.10. Une fonction f : 1[8p -? 1[8q

est appelé PC-function (piecewise continuously differentiable

function) en x0 s'il existe une boule ouverte centrée en

x0 (Vå(x0) , e >

0) et un nombre finie de fonctions continûment

différentiables

fi :Vå(x0)

-? 1[8q, i = 1, ..., t

tel que f est continue sur

Vå(x0) et f(w) ?

{f1(w), ..., ft(w)}. pour tout w ?

Vå(x0).

Théorème 1.3.2. [17] Les PC-functions sont

localement Lipschitz-continues avec pour constante de Lipschitz la plus grande

constante de Lipschitz de la famille de fonction qui définit la

PC-function.

La preuve de ce théorème nécessite le lemme

suivant :

Lemme 1.3.1. [24]

Soit g : [0,1] -? 1[8p une fonction continue et soit la

famille d'ensemble non vide fermé {Ai}qi=1 ? 1[8m

telles que

|

[

g([0,1]) :=

x?[0,1]

|

{g(x)} ?

|

[ q i=1

|

Ai

|

alors, il existe une suite de réels

{ti}r+1

i=0 avec t0 = 0, tr+1 = 1,

ti < ti+1 ?i et la suite {ji}ri=0

i = 0, ...,r telle que

{g(ti), g(ti+1)} ? Aji

i = 0, ..., r.

La preuve de ce lemme ce fait par induction sur le nombre r

des différents ensembles Ai pour lesquels il existe des points

t tels que g(t) ? Ai. On peut la trouver dans

[11].

Preuve (du théorème) :

Soit f : 1[8p -? 1[8q une PC-function. Soit x0

? 1[8p ; f est une PC-function en x0.

Par définition, il existe une boule ouverte

Vå(x0) centrée en

x0 de rayon e > 0 et un nombre finie de fonctions

continûment différentiables

fi : Vå(x0)

-? 1[8q, i = 1, ..., k

telles que f est continue sur

Vå(x0 et

f(u) = {f1(u), ..., fk(u)} ?u

? Vå(x0)

soit x, y ?

Vå(x0) Posons :

w(t) = f(x + t(y - x)), t ? [0, 1]

wi(t) := w(t) si fi (x + t(y - x))

= f(x + t(y - x))

x.

n o

Ai = x ?

Vå(x0) : fi(x) = f(x) .

Puisque f est continue sur

Vå(x0), Ai est

fermé.

En effet, soit {xk}k ? Ai une suite de points

telle que xk ?

k?+8

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

Genéralités sur la programmation

mathématique à deux niveaux 10

Il suffit de montrer que x ? Ai. On a :

|

(xk ?

k?+8

|

x) =f(xk) ? f(x) (car f est continue sur Vå(x0))

k?+8

|

De même, puisque fi est continue sur

Vå(x0), on a

|

(xk ?

k?+8

|

x) fi(xk) k?+8 fi(x)

|

Étant donné que xk ? Ai ?k ? N, on a fi(xk) = f(xk)

?k ? N d'où

f(xk) ? f(x) et f(xk) ? fi(x)

k?+8 k?+8

et par unicité de la limite, on a f(x) = fi(x)

d'où x ? Ai. et par suite, Ai est fermé.

D'après le lemme 1.3.1, il existe des points t0 = 0 <

t1 < ... < tr < tr+1 = 1 tels que :

w(ti), w(ti+1) ? Ajz, i = 0, ..., r (i)

on a

|

f(y) - f(x) 1 1 = 1 lw(1) - w(0)Il=

|

r

i=0

|

w(ti+1) - w(ti)

|

|

=

|

r

i=0

|

wjz(ti+1) - wjz(ti)

|

(d'après (i))

|

|

r

= E

i=0 r

= E

i=0

|

wjz(ti+1) - wjz(ti)11

fjz (x + ti+1(y - x) - fjz(x + ti(y - x) 11

|

|

r

= E

i=0

|

Kjz x - ti+1(y - x) - ti(y - x) (car fjz est lip sur

Vå(x0))

|

|

r

= E

i=0

|

Kji (ti+1 - ti)(y - x)

|

|

= max

1=j=k

|

Kjzky - xk

|

r i=0

|

|ti+1 - ti|

|

= Kky - xk

|

Où K = max

j

|

Kjz est la plus grande constante de lipschitz des fonctions fi,

i = 1, ... , k

|

Donc f est localement lipschitzienne.

·

L'intérêt des PC-function est qu'elles

possèdent un grand nombre de propriétés qui sont d'une

grande utilité dans l'optimisation paramétrique. Nous allons

maintenant définir la notion de gradient généralisé

au sens de Clarke.

Définition 1.3.11. Soit f : Rp -? R une fonction

localement Lipschitz- continue. Le gradient généralisé

au sens de Clarke de f en x0 est défini par :

?f(x0) = convn lim k?8 ?f(xk) : k J

xk = xo, V f (xk) existeVk ?

00

où conv désigne l'enveloppe convexe.

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

Genéralités sur la programmation

mathématique à deux niveaux 11

Théorème 1.3.3. [11] Soit f : 118p ->

118 une PC-function alors

n o

?f(x0) = conv ?fi(x0) : x0 E cl

int supp(f, fi)

où supp(f, fi) = {x : f(x) = fi(x)}

; cl int supp(f, fi) est l'adhérence de

l'intérieur de l'ensemble supp(f, fi).

La preuve de ce théorème peut être

trouvé dans [11]

Définition 1.3.12. Une fonction f : 118p ->

118 est dite différentiable en x0 dans la direction r E 118p si

la quantité suivante existe et est finie :

|

f0(x0, r) := lim

t?o+

|

[f(x0 + tr) - f(x0)]

t

|

f0(x0, r) est la

dérivé de f dans la direction r en

x0.

Définition 1.3.13. Une fonction directionnellement

différentiable f : 118p -> 118 est dite

Bouligand-différentiable (B-différentiable) en x0

si la dérivée directionnelle d'ordre 1 de f

en x0 ; i.e

lim

x?x0

= 0

f(x) - f(x0) - f0(x0, x

- x0)

kx - x0k

. Une fonction f localement Lipschitz-continue,

directionnellement différentiable est B-différentiable

[20] et f0(x0, .) est une

sélection continue de fonction linéaires :

n o

f0(x0, r) E ?fi(x0)r :

i E Io f(x0)

n o

où Io f(x0) = i : x0 E supp(f,

fi)

Définition 1.3.14. Une fonction f : 118p ->

118 est dite pseudodifférentiable en x0 si il existe

une boule ouverte centrée en x0,

(Vå(x0), å > 0) et une fonction

semi-continue supérieurement Pf : Vå

-> 2Rp avec Pf(y) non vide,

convexe et compact pour tout y E Vå(x0)

telles que

f(x) = f(x0) + g(x - x0) + o(x, x0, g) Vx

E Vå(x0)

où g E Pf(x) et lim

o(xk,x0,gk)= 0 Pour

toute suite {xk}k i , {gk}k

1 avec lim xk = 0, gk E

k?0 kxk-xok --

k--

Tf(xk)

.

Le théorème suivant est fondamental en ce sens

qu'il permet de transformer (1.7)-(1.8) en un problème d'optimisation

à un niveau.

Théorème 1.3.4. Considèrons le

problème (1.8) en y = y0 et supposons que les assertions (MFCQ), (SSOC),

et (CRCQ) sont satisfaites en un point stationnaire x0 E sp(y0). alors

x0 est fortement stable et l'unique fonction x(y) avec {x(y)} =

Øloc(y) n Vå(x0) est une

PC-function.

La preuve de ce théorème nécessite des

notions que nous n'avons pas jusqu'ici abordées ; elle peut être

néanmoins trouvée dans [11].

Le corollaire suivant découle des propriétés

des PC-functions.

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

Genéralités sur la programmation

mathématique à deux niveaux 12

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

Corollaire

Sous les hypothèses du Théorème 1.3.4 on a

que la solution optimale locale x(y) est

? Localement Lipschitz-continue de jacobien

généralisé au sens de Clarke donné par :

{ }

Ox(y0) = conv Vxi(y0) : i E Io x(y0)

? Directionnellement différentiable avec

{ }

x'(y0, r) = Vxi(y0)r : i E Io x(y0)

? B-différentiable

? Pseudodifférentiable de différentielle

{ }

x(y0) = conv Vxi(y0) : i E Ix(y0)

Nous allons maintenant présenter quelques conditions

sous lesquelles le problème (1.7)-(1.8) admet une solution locale ou

globale. Nous ne traiterons dans le paragraphe suivant par soucis de

clarté de notre exposé , que le cas où le problème

du suiveur (1.8) admet une solution pour chaque paramètre y ; le cas de

la non unicité qui constitue le coeur de notre travail sera

traité au chapitre suivant.

1.4 Conditions d'optimalités

1.4.1 Cas des PBN linéaires

Définition 1.4.1. Un PBN est dit linéaire si toutes

les fonctions contraintes et les fonctions objectifs du leader et du suiveur

respectivement sont linéaires. La formulation générale

d'un PBN linéaire est la suivante :

{ }

min < d1,x > + < d2,y >: A3y = b,y = 0,x E

Ø(y) . (1.10)

y

|

avec Ø(y) = Argmin

x

|

{ }

< c,x >: A1x < a - A2y,x = 0 où x E

IIBn,y E IIBm a E IIBp,b E IIBl et

|

les matrices A1, A2,A3 ainsi que le vecteur c sont de dimensions

appropriées. Ø(y) est l'ensemble des solutions du problème

du suiveur donné par :

{ }

min < c,x >: A1 < a - A2y,x = 0 (1.11)

x

Définition 1.4.2. Une fonction : IIBp -? 2Rq

est dit polyédrique si son graphe

{ }

grph() := (x, y) E IIBp x IIBq : x E (y) s'écrit comme

réunion finie d'ensemble convexes

polyédriques.

Un ensemble convexe polyédrique est une

intersection finie de démi-espaces [15].

Théorème 1.4.1. La fonction

Ø(.) : IIBm -? 2Rn

|

y H Argmin

x

|

{ }

< c, x >: A1x < a - A2y, x = 0 est

polyédrique.

|

Genéralités sur la programmation

mathématique à deux niveaux 13

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

Corollaire

{ }

(x,y) : A1 + A2 < a, A3y = b, x > 0, y > 0

Si le problème (1.11) admet une solution unique pour

chaque paramètre y, alors le problème (1.10) - (1.11) admet une

solution optimale qui est le sommet du polyèdre que constitue

l'ensemble

.

Si le problème du suiveur admet une solution unique

pour chaque paramètre y alors, ces solutions définissent une

application y i- " x(y) linéaire ; le PBN se reformule de la

façon

suivante :

Preuve :

{ }

min < d1, x(y) > + < d2, y >: A3y = b, y > 0 y

ce qui est un problème de programmation linéaire

simple dont on sait que la solution optimale est atteinte sur les sommets du

polyèdre que constitue l'ensemble des contraintes.

·

1.4.2 Cas général

Définition 1.4.3. On suppose que card Ø(y) = 1 pour

tout y E Y . On appelle fonction à valeur optimale la

fonction

? : 1[8m - " 1[8n

{ }

y i- " ?(y) = Argmin f(x, y) : g(x, y) < 0 et h(x, y) = 0

x

On convient de noter ?(y) = x(y) pour tout y E Y .

Théorème 1.4.2. Si les assertion (C), et

(MFCQ) sont satisfaites, alors la fonction ø(.) est

semi-continue supérieurement et la fonction à valeur optimale

?(.) est continue.

Ce theorème est démontré dans [11]

Théorème 1.4.3. On considère le PBN

(1.7) - (1.8) et on suppose que les assertions (C) et (MFCQ) sont satisfaites

en tout point (x, y) E 1[8n x Y , avec x E M(y) ;

on suppose en plus que R =6 0 et que card Ø(y) = 1

pour tout y E Y . Alors le PBN admet une solution optimale

globale.

Preuve :

Puisque card Ø(y) = 1 pour tout y E Y le problème

(1.7) - (1.8) est équivalent au problème :

{F(x, y) = F(x(y), y), y E Y}

min . (1.12)

y

où Vy E Y, x(y) = ?(y) est la solution du

problème du suiveur. La fonction F est continue et d'après le

lemme, ?(.) est continue. D'autre part Y est un fermé borné de

1[8m donc est compact ; d'où , (1.12) admet une solution

optimale globale.

Genéralités sur la programmation

mathématique à deux niveaux 14

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

D'autres conditions d'optimalités des PBN peuvent

être trouvées dans [11].

Maintenant que nous sommes en possession de quelques

résultats nous permettant d'affirmer sous certaines conditions

l'existence de solutions globales ou locales du PBN (1.7) - (1.8), il se pose

la question de savoir : comment déterminer de façon effective ces

solutions ?

1.5 Algorithmes et méthodes de résolution

des PBN

La littérature nous propose dans le cas de

l'unicité de la solution du problème du suiveur, plusieurs

algorithmes permettant le calcul de la (ou des) solution(s) de (1.7) - (1.8).

Nous présentons dans ce paragraphe un algorithme inspiré de la

méthode de descente connue en optimisation à un niveau et un

algorithme dit du paquet.

1.5.1 Algorithme de descente

Si le problème du suiveur admet une solution unique

pour tout paramètre y alors (1.7) - (1.8) est equivalent

à (1.12).

Supposons que (1.8) est un problème d'optimisation

paramétrique convexe et que les assertions (MFCQ), (CRCQ) et (SSOC) sont

satisfaites en tout point (x, y) tel que

x E Ø(y), G(y) <

0. Alors, d'après le théorème 1.3.1 l'unique solution

optimale de ce problème est fortement stable. Par le

théorème 1.3.5 elle est une PC-function et par conséquent

la dite solution est localement Lipschtz-continue . Il s'ensuit que la fonction

objectif de (1.12) est di-rectionnellement différentiable.

Ce qui motive à envisager un algorithme de

descente[11]. La méthode consiste en : étant donné un

point réalisable x chercher une direction de descente d

E Rn suivant laquelle F(.) décroît. Un

nouveau point x + Ed (E > 0) est

déterminé de façon à assurer une

décroissance raisonnable de F(.) tout en demeurant

réalisable pour le PBN. On construit ainsi une suite qui converge vers

une solution stationnaire au sens de Clarke.

Définition 1.5.1. Soient f E C(Rp,

R) et x E Rp.

1. On dit que d E Rp\{0} est une direction de descente

en x s'il existe Eo > 0 tel que

f(x + Ed) < f(x)

VE E [0, E0].

2. On dit que d E Rp\{0} est une direction de descente

stricte en x s'il existe Eo > 0 tel

que f(x + Ed) < f(x) VE

E [0, Eo].

Définition 1.5.2. Soit f : Rp -> R une

fonction et z E Rp. Si f est localement Lipschtz-continue,

z est dit stationnaire au sens de Clarke si 0 E

?f(z) ; si f est pseudodifférentiable, le

point z est dit pseudostationnaire si 0 E (z).

Genéralités sur la programmation

mathématique à deux niveaux 15

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

Algorithme de descente

|

Entrée : Les paramètres du PBN (1.7) - (1.8).

Sortie : Une solution stationnaire au sens de Clarke.

1. Choisir y0 satisfaisant

G(y0) < 0;

2. Initialiser k := 1

3. Déterminer une direction rk,

1rk1 > 1 satisfaisant F(yk,

xk) < sk

VyGi(yk)rk

< -Gi(yk) + sk, Z

= 1, ..., l et sk < 0;

4. Choisir un pas de longueur tk tel que

F(yk + tkrk) <

F(yk) + Etksk,

G(yk + tkrk) < 0

5. Initialiser xk+1 :=

xk + tkrk ,

déterminer xk E

ø(yk) ; incrementer k := k

+ 1;

6. Si un critère d'arrêt est satisfait,

arrêter ; sinon aller à l'étape 2.

|

On se donne en général un critère

d'arrêt de la forme xk+1 -

xk ~< E. De plus, puisque la

convergence n'est pas toujours assuré, une règle de base est de

fixer le nombre d'itérations maximale Kmax.

Sous certaines conditions de régularité, on

montre [11] que chaque point d'accumulation de la suite (xk,

yk) obtenue au moyen de l'algorithme est un point stationnaire

de (1.7) - (1.8) au sens de Clarke.

1.5.2 L'algorithme du paquet

On considère le problème (1.8) en y =

y0 et on suppose que les assertions (MFCQ), (SSOC) et (CRCQ) sont

satisfaites en x0 E SP(y0) . Alors (1.12) est un

problème de minimisation d'une fonction Lipschtz-continue.

Nous présentons l'algorithme dans le cas où la

contrainte G(y) < 0 est absente.

Soit v(y) le gradient

généralisé au sens de Clarke de F ; la méthode du

paquet s'inspire de la méthode dite de découpage de plan (cutting

plane method) pour la minimisation de fonctions convexes.

Soit {yi}ki=1 ; {zi}ki=1

des points d'essaie et des itérées déjà

évalués. La méthode de découpage du plan consiste

à minimiser la fonction :

mia k nv(yi)d +

v(yi)(zk - yi) + F(yi)o (1.13)

La direction d qui minimise ce modèle est une

direction de descente si y n'est pas un point stationnaire. Mais il

s'avère que l'utilisation du modèle (1.13) pour trouver une

direction de descente à une vitesse de convergence très lente;

c'est pourquoi à (1.13) on ajoute le terme de

régularisation quadratique (2tkjdT

d pour obtenir le modèle

e1<rm

1

nv(yi)d - áik > +

F(zk) + (2t )dTd (1.14)

-- = J k

Avec áik = F(zk) -

v(yi)(zk - yi) -

F(yi)

La solution optimale d de (1.14) est une direction de

descente pour F(y) en y = zk sous réserve que

le modèle donne une approximation suffisamment bonne de F(y)

dans un voisinage du point non stationnaire zk. Une nouvelle

itérée est zk+1 = zk + d est

calculée de manière à faire décroître de

façon considérable la fonction modèle ; i.e F(zk

+ d) < F(zk).

Genéralités sur la programmation

mathématique à deux niveaux 16

Mémoire de DEA *

Laboratoire d'analyse numérique *

UYI Francisque.D.Fouodji c~UYI 2007-2008

Si dans le voisinage de zk la direction de descente

n'est pas assez bonne, alors aucune nouvelle itérée n'est

calculée mais les nouveaux points d'essaie yk+1 et zk

seront utilisés pour rechercher une nouvelle direction de descente

dans (1.14) après ajout d'un gradient généralisé

?..F(yk+1).

Algorithme du paquet

|

Entrée : Suite d'itérée

{zi}k i=1 et des points d'essaie

{yi}k i=1, le paramètre de

régularisation tk

Sortie : Une meilleure itérée

zk+1 ou un modèle amélioré.

1. Calculer une solution optimale dk de (1.14);

initialiser : yk+1 := zk + dk

2. Si ..F(yk+1) est suffisamment petit comparé

à ..F(zk) alors :

a) Agrandir tk et retourner à 1 ou

b) Poser zk = yk+1 . Si ..F(yk+1)

n'est pas suffisamment petit comparé à ..F(zk) alors

c) réduire tk et retourner à 1 ou

d) poser zk+1 = zk calculer

v(yk+1) E ?..F(yk+1)

|

Il existent plusieurs critères pour le choix de tk

à l'étape 2; ils peuvent être trouvés dans

[11].

Pour terminer ce chapitre , nous allons présenter

quelques unes des nombreuses applications de la PBN.

1.6 Les applications de la PBN

1.6.1 Production agricole , production de biocarburant

Nous présentons ici un modèle qui nous a

été inspiré par la lecture de [18] et dont la

résolution permettrait non seulement d'augmenter la production agricole

du Cameroun (jugulant ainsi la crise alimentaire dont est sujet le pays), mais

aussi de réduire la pollution de l'air par les gaz d'échappement

d'automobiles et la pollution du sol et des eaux par les engrais chimiques.

Gêné dans sa politique de développement

par la faiblesse de la production agricole, face à la

nécessité de réduire la pollution associé à

l'émission des gaz d'échappement des automobiles et la pollution

des sols et des eaux par les engrais chimiques, le gouvernement Camerounais

décide d'explorer les possibilités afin d'encourager l'industrie

pétrochimique à utiliser les produits agricoles pour produire du

biocarburant. Différents produits agricoles tels que le tournesol, le

soja, les graines de coton, ou l'arachide peuvent être utilisés

à cette fin [18]. Mais il s'avère que le coût de production

de biocarburant est plus élevé que le coût de production de

carburant en utilisant les hydrocarbures. Dans le but d'encourager les

industriels à utiliser les produits agricoles, le gouvernement leurs

accordent une réduction de taxe suffisante. En contrepartie, l'industrie

s'engage à être neutre (i .e à ne pas spéculer sur

les prix) et à produire du biocarburant.

Le secteur agricole est représenté par un

ensemble d'exploitations agricoles; nous décrivons le modèle pour

une seule exploitation agricole; il pourra être facilement

généralisé dans le cas de plusieurs exploitations.

L'exploitant peut librement laisser une partie de sa

plantation en jachère (au quel cas plus tard cette partie pourra

être cultivé sans usage d'engrais chimiques) ou l'utiliser

à la production de plantes pour biocarburant. Dans les deux cas, il

engrange des revenues sous forme de

Genéralités sur la programmation

mathématique à deux niveaux 17

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

prime du gouvernement pour avoir laissé une partie de

ses terres au repos ou sous forme de subventions de l'État plus les

bénéfices faits après la vente de sa production à

l'industrie.

Pour maximiser son profit, le fermier décide par lui

même quelle surface de terre il va laisser en jachère, quelle

surface il va utiliser pour la culture de plantes destinées à la

production de biocarburant et quelle surface utiliser pour la production des

autres produits.

Soit xj E IR, xn E 1[8p,

xd E 1[8q respectivement la surface de terre laissée

en jachère, utilisée pour la production de produits pour

biocarburant et utilisée pour la production des autres denrées.

On considère les vecteurs ep = (1, ....,1)T

E 1[8p ; eq = (1, ....,1)T E

1[8q. (Les entiers p et q representant le nombre de produits agricoles

utilisés pour la productions de biocarburants et le nombre de produits

destinés à la consommation. Chaque composante des vecteurs

xn et xd representant la surface utilisée

pour la culture d'un produit fixé.)

Le problème du fermier consiste à maximiser

l'argent qu'il gagne grace à son exploitation :

|

< pd + u - cd,xd > + <

pn + s - cn,xn > + ãxj

--* max

|

(1.15)

|

|

xj,xd,xn

|

|

|

< ep, xn > + <

eq, xd > +xj C t

|

(1.16)

|

|

< ep, xn > +

xj C ó1t

|

(1.17)

|

|

< ep, xn > + <

eq, xd > C ó2t

|

(1.18)

|

|

xd C t', xn > 0, xd

> 0 , xj > 0

|

(1.19)

|

Où :

D pn,pd désignent respectivement le

vecteur argent gagné par unité de surface cultivé de

produits pour biocarburant et le vecteur bénéfice par

unité de surface cultivés pour les autres produits.

D s est le vecteur subventions accordées par

l'État pour les produits pour biocarburant ; cn le

coût de la production de ces plantes.

D ã est la prime par unité de surface de terre

laissée en jachère.

D u est la subvention accordée par unité de

surface de terre utilisée à la production d'autres produits ;

cd leurs coût de production.

D t est la surface de terre arable que dispose le fermier.

D ó1 et ó2 sont des proportions fixé par

le gouvernement.

D (1.15) est la fonction objectif du fermier.

D (1.16) est la contrainte sur la surface de terre arable

disponible dans l'exploitation agricole. En effet, on ne peut utiliser que ce

que l'on possède.

D (1.17) les restrictions de l'État sur la proportion

de terre laissée en jachère ou utilisée à la

production de plantes pour biocarburant. Car il faut encourager la production

des produits agricole destinées à la consommation.

D (1.18) les considérations agronomique visant

à limiter la surface de terre cultivé (pour éviter

Genéralités sur la programmation

mathématique à deux niveaux 18

la pollution du sol).

D La première inégalité de (1.19)

représente la contrainte sur certaines denrées qu'on ne veut pas

produire au delà de certaines quantités.

Le gouvernement joue le rôle de leader dans ce

problème. Son objectif est de minimiser le total des primes et des

subventions accordées aux exploitants. Soit kr le

vecteur volume de biocarburant r, r = 1, ..., w

produit par unité de surface ; Soit Tr la

réduction de taxe (proportionnelle au volume de biocarburant produit)

accordée à l'industrie pour le biocarburant r.

Alors le gouvernement doit résoudre le problème

:

Xw r=1

|

Tr < kr, xn > +

ãxj + < ueq, xd > + <

sep, xn >? « min

ô,ã,u,s

|

» (1.20)

|

|

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

< ep, xn > < t'

(1.21)

Xw < kr, xn

> < H (1.22)

r=1

pn = pn(T)

> 0, T > 0, ã > 0, u > 0

(1.23)

où xn, xj, xc

résolvent(1.15) - (1.19) (1.24)

Où

D t' et H sont des données

fixés par le gouvernement

D (1.20) est la fonction objectif du gouvernement

D (1.21) est la contrainte sur la surface de terre

utilisé pour la production de biocarburant.

D (1.22) la contrainte sur la quantité de biocarburant

produit.

D (1.23) traduit la neutralité de l'industrie, le prix

du biocarburant est fonction des réductions de taxes T et est

fixé une fois pour toute.

Nous obtenons ainsi un PBN. Ce modèle peut être

élargie à un problème d'optimisation à trois

niveaux en y incluant le problème de l'industrie

pétrochimique.

1.6.2 Le problème principal-agent [10]

Ceci est un cas particulier des problèmes de la

théorie du principal - agent.

Un décideur appelé le principal engage

un autre l'agent pour le représenter dans l'une de ses

structures. Les décideurs signent un contrat ou il est consigné

que le principal délègue (une partie de) son autorité

à l'agent ; en lui donnant ainsi la liberté de choisir ses

actions (de façon limitée ou non) en fonction de ses propres

objectifs seulement. Ainsi, uniquement dans l'espoir d'atteindre ses objectifs,

l'agent cherche à maximiser l'impact de son action a E A en

résolvant le problème :

|

Z

max

a?A

X

|

G(s(x), ag(x|a)dx

.

|

Genéralités sur la programmation

mathématique à deux niveaux 19

Où la fonction d'utilité G : 118 x

A -? 118 permet de mesurer la valeur de la

rémunération s(x) à recevoir du principal

représentant la contrepartie des efforts consentis pour son action a

et X est l'ensemble des résultats possibles des actions

a E A de l'agent. La densité désignée par la

fonction g(x|a) est utilisée pour décrire les

probabilités de réalisation des résultats x E X

si l'agent mène une action a E A. La remuneration s(x)

est payée à l'agent si le résultat x est

obtenu. La fonction s : X -? 118 fait aussi partie du contrat

signé par les deux parties. Du point de vue du principal, la fonction

s représente aussi un ensemble de primes servant à

motiver l'agent à agir afin qu'il puissent atteindre ses objectifs.

Ainsi, le principal doit choisir cette fonction de façon à

approcher son but au maximum. En supposant que le principal utilise la fonction

d'utilité H : 118 -? 118 pour mesurer son profit x

- s(x) provenant des activités de l'agent et qu'il utilise la

même densité g pour évaluer les

probabilités requises pour la réalisation du résultat

x, il aura besoin pour la réalisation de ses objectifs de

résoudre le problème :

|

msESax J

X

|

H(x - s(x))g(x|a')dx).

|

où S désigne l'ensemble de tous les

systèmes de remuneration possible et a' une solution

du problème de l'agent pour une fonction fixé s(.). Le

modèle obtenu ne saurait être complet sans la condition

J G(s(x),

a')g(x|a')dx > c

X

,où a' résoud le

problème de l'agent. Si cette inégalité n'est pas

satisfaite, l'agent n'acceptera pas de signer le contrat avec le principal.

Cette inégalité représente donc une contrainte que doit

respecter le leader. Ce problème peut être résumé

par :

|

max JsES

X

|

H(x - s(x))g(x|a')dx).

|

|

Jsujet :

X

|

G(s(x), a')g(x|a')dx > c

|

|

a' E Argmin

aEA

|

J

X

|

G(s(x), a)g(x|a)dx).

|

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

D'autres applications de la PBN peuvent être trouvés

dans [11] ou [10].

Conclusion

Nous avons dans ce chapitre donné une

présentation générale de la programmation

mathématique à deux niveaux et présenté quelques

algorithmes de résolution dans le cas de l'unicité de la solution

du suiveur. Mais il se trouve que dans la plupart des cas, les problèmes

modélisés sous formes de PBN sont tels que le problème du

second plan admet plus d'une solution ; ce qui complique

considérablement le problème. Dans le chapitre suivant, nous

allons présenter les différentes techniques

développées pour attaquer les PBN dans ce cas ; ce qui nous

permettra par la même occasion de définir la notion de

problèmes d'optimisation mal posés.

CHAPITRE DEUX

Non unicité de la solution du problème

du

suiveur : les différentes techniques

d'approches.

Mémoire de DEA * Laboratoire

d'analyse numérique * UYI Francisque.D.Fouodji

c~UYI 2007-2008

Dans toute la suite, lorsque nous dirons "cas de la non

unicité", ce sera pour dire "cas de la non unicité de la solution

du problème du suiveur".

Introduction

Au chapitre un, nous avons présenté quelques

résultats d'optimalité et quelques algorithmes de

résolution des PBN dans le cas de l'unicité de la solution du

suiveur. Il se trouve cependant que dans la plupart des applications, le

problème du suiveur n'admet pas une solution unique; d'où la

nécessité d'explorer de nouvelles techniques afin de

résoudre les PBN dans ce cas plus général.

Les PBN dans le cas de la non unicité font partie d'une

classe plus large de problèmes de programmation mathématique :

les problèmes de programmation mathématique

mal-posés.

Définition 2.0.1. Soit E un

espace de Banach reexif, ó une topologie sur E, K

un convexe fermé non vide de E et h :

K -* R U {+oo}

Le problème de programmation mathématique :

est dit bien-posé au sens de TIKHONOV (resp

bien-posé au sens général) suivant la topologie

ó, s'il existe une solution unique u0 à (2.1)

et toute suite minimisante 1 de (2.1)

ó-converge vers u0 (resp (2.1) a au plus une solution

et toute suite minimisante admet une sous suite qui ó-converge

vers la solution unique.)

Un problème de programmation mathématique est dit

mal-posé s'il n'est pas bien-posé.

Commençons par présenter la position du

problème dans la resolution des PBN dans le cas de la non

unicité.

|

1Une suite

(un)n ? K

est appelé suite minimisante si uim

n?+8

|

h(un)

= inf

h(v).

v?K

|

Par définition de l'infimum, une telle suite existe

toujours.

Non unicité de la solution du problème

du suiveur : les différentes techniques d'approches. 21

2.1 Position du problème

Considérons une nouvelle fois le PBN :

|

«min

y

|

{ }

» F(x, y) : G(y) <

0, x E Ø(y) (2.2)

|

|

Où

|

Ø(y) = Argmin

x

|

{ }

f(x, y) : g(x, y) <

0, h(x, y) = 0 (2.3)

|

Pour y fixé, Ø(y) est l'ensemble

des solutions du problème.

{ }

min f(x, y) : g(x, y) <

0, h(x, y) = 0 (2.4)

x

F : Rn X Rm -? R, f :

Rn X Rm -? R, G : Rn X Rm

-? Rp,

g : Rn X Rm -? Rq sont des

fonctions suffisamment2 régulières.

{ }

Posons Y = y E Rm :

G(y) < 0 et supposons que Y est fermé.

Les guillemets dans (2.2) expriment l'incertitude de la

définition de (2.2) dans le cas de la non unicité; car lorsque

Ø(y) n'est pas réduit à un singleton pour tout

y E Rm, le leader se trouve face à un dilemme.

En effet, pour prendre sa décision (qu'il souhaite

optimale), le leader doit savoir qu'elle sera la décision du suiveur.

Dans le cas où il existe plusieurs décisions possibles pour le

suiveur, le leader se trouve dans l'embarras (car il ne sait sur laquelle

portera le choix de celui-ci).

La question qu'on se pose ici est celle de savoir : comment

aborder le PBN (2.2)-(2.3) dans le cas de la non unicité de la solution

de (2.4) ?

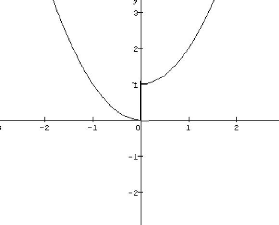

L'exemple suivant illustre les difficultés qu'on peut

rencontrer dans le cas de la non unicité.

Exemple 2.1.1. On considère le PBN :

|

«min

y

|

{ }

» x2 + y2 : x

E Ø(y), -1 < y < 1

|

|

Où Ø(y) = Argmin

x

On a :

|

{-xy : 0 < x < 1}

|

|

Ø(y) :=

|

{

|

{0} si y < 0

{1} si y >

0

[0,1] si y = 0

|

Ainsi,

|

F(x(y), y) =

|

{

|

y2 si y < 0

1 + y2 si y > 0 E [0,1]

si y = 0

|

. (2.5)

|

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

Le tracé de F est le suivant :

2Suivant les résultats que nous

énoncerons, nous exigerons que ces fonctions satisfassent des

propriétés de régularité parfois

différentes

Non unicité de la solution du problème du

suiveur : les différentes techniques d'approches.

22

Mémoire de DEA *

Laboratoire d'analyse numérique *

UYI Francisque.D.Fouodji c~UYI 2007-2008

FIG. 2.1 Sur les difficultés rencontrées dans le

cas de la non unicité

pour y = 0; on a W(y) = [0,

1]. Donc pour ce paramètre, W(y) contient une

infinité d'éléments. On se trouve donc ici dans le cas de

la non unicité.

d'après (2.5), l'expression de la fonction objectif

n'est connue que si le suiveur annonce clairement son choix; la

solvabilité du problème du leader dépend de ce choix. En

effet, si le suiveur fait le choix x(0) = 0 E W(0) alors le

problème du leader est solvable; la solution optimale du PBN est

(0, 0) et la valeur de la fonction objectif du leader est

0.

{ F (x(y), y) = y2

: -1 y < 0 }

min

y

le PBN n'admet pas de solution dans ce cas car

F(x(y), y) = y2 est

dérivable et on a

Si le choix du suiveur se porte sur x(y) = 0

E W(y), avec y < 0 alors le problème du leader

devient :

VF(x(y),y) =

(0,2y)

VF(x(y),y) = 0 =' y

= 0

Or y = 0 ne satisfait pas à la contrainte

-1 y < 0 donc le problème du leader n'admet pas de

point critique et par conséquent n'admet pas de solution.

Jusqu'ici, trois approches ont été

développées dans la littérature pour résoudre les

PBN dans le cas de la non unicité : l'approche optimiste, l'approche

péssimiste et l'approche par régularisation sur laquelle porte

notre travail.

2.2 L'approche optimiste

Cet approche est envisageable dans le cas où le leader

à la possibilité de persuader le suiveur de prendre une

décision qui lui sera favorable (favorable est compris ici au sens ou la

dite décision permet au leader d'atteindre son objectif).

la formulation optimistique de (2.2)-(2.3) est la suivante

:

min

y

{ }

?o(y) : y E Y

(2.6)

Où

Non unicité de la solution du problème du

suiveur : les différentes techniques d'approches. 23

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

{ }

?o(y) = min F(x,

y) : x E W(y) (2.7)

x

Définition 2.2.1. Un point (x*,

y*) E 1[8nx1[8m est appelé

solution optimiste locale de (2.2)-(2.3) si y* E

Y, x* E W(y*) avec

F(x*, y*) <

F(x, y*) Vx E

W(y*)

et il existe Uä(y*), 8 >

0 boule ouverte centrée en y* de rayon 8

telle que

?o(y*) <

?o(y) Vy E

Uä(y*) n Y

(x*, y*) est appelé

solution optimiste globale si 8 = o0

Énonçons maintenant un théorème

d'existence de solution optimiste :

Théorème 2.2.1. Si les assertions (C) et (MFCQ)

sont satisfaites en tout points (x, y) E 1[8n x Y

avec x E M(y), alors

Le problème (2.2)-(2.3) admet une solution

optimistique globale.

Preuve :

Considérons le problème

{ }

min F(x, y) : y E Y, x E

W(y) (2.8)

x,y

Les solutions globales de (2.8) et le problème optimiste

(2.4)-(2.6)-(2.7) coincident.

En effet si (x*, y*)

vérifie (2.8) alors (x*, y*)

vérifie (2.4)-(2.6)-(2.7).

réciproquement, si (x*, y*)

vérifie (2.4)-(2.6)-(2.7) alors par définition de solution

optimiste globale, on a :

F(x*, y*) <

F(x, y*) Vx E W(y)

et

?o(y*) <

?o(y) Vy E Y

{ }

F (x*, y*) < F

(x, y*) Vx E W(y*) =

F (x*, y*) < min F (x,

y*) : x E W(y*)

x

Or

{ } { }

?o(y*) <

?o(y)Vy E Y ? min

F(x, y*) : x E W(y*)

< min F(x, y) : y E Y, x E

W(y)

x x

{ }

Ce qui implique que min F(x, y*) :

x E W(y*) < F(x, y) Vy

E Y, Vx E W(y)

x

d'où F(x*, y*)

< F(x, y) Vy E Y, Vx E

W(y) autrement dit,

|

(x*, y*) E Argmin

x,y

|

{ }

F(x,y) : y E Y,x E

W(y)

|

donc (x*, y*) est optimum global

de (2.8).

D'autre part, puisque les assertions (C) et (MFCQ) sont

satisfaites, la fonction à valeur optimale

(voir définition 1.4.4) est continue ; ce qui permet de

montrer que l'ensemble

{ }

(x, y) : x E W(y) est fermé.

D'autre part, étant donné que Y est fermé,

l'assertion (C) nous

Non unicité de la solution du problème du

suiveur : les différentes techniques d'approches. 24

.

Mémoire de DEA * Laboratoire d'analyse

numérique * UYI Francisque.D.Fouodji (c)UYI 2007-2008

garanti que l'intersection de {(x, y) : x E Ø(y)} avec

Rn x Y est compact (comme fermé dans un compact).

D'où puisque F est continue sur Rn x

Rm, le problème (2.8) admet un optimum global. En vertu de

l'équivalence que nous avons établie entre (2.8) et le

problème optimiste, on conclut que (2.4)-(2.6)-(2.7) admet une solution

optimistique globale.

·

Exemple 2.2.1. Reconsidérons le PBN de l'exemple 2.1.1

:

|

« min

y

|

n o

» x2 + y2 : x E Ø(y), -1 <

y < 1

|

|

Où Ø(y) = Argmin

x

|

n o

- xy : 0 < x < 1

|

Comme trouvé précédemment, on a

?0(y) = minnx2 + y2 : x E Ø(y)=(1 + y2

si y > 0

x

siy < 0

y2

Le problème optimiste s'écrit donc :

n o

min ?0(y) : -1 < y < 1

y

et la solution optimiste globale est (x0, y0) = (0,

0).

L'un des défauts de l'approche optimiste est qu'elle

n'est pas envisageable dans la plupart des cas concrets. En effet, en

économie par exemple, dans le but de faire régner une concurrence

loyale entre des entreprises concurrentes, la législation interdit le

plus souvent une quelconque coopération entre les dites entreprises et

leurs éventuels clients.

Aussi, dans grand nombre de problèmes

modélisés en PBN, le suiveur ne constitue que rarement une

personne physique avec qui le leader pourrait envisager une coopération.

En plus, même si la coopération est permise, le leader n'a pas de

garanti sur le fait que le suiveur respectera ses engagements.

Ceci constitue quelques limites de l'approche optimiste.

|

2.3 L

|

'approche pessimiste

|

Lorsqu'il est impossible au leader d'influencer les choix du

suiveur, une décision optimale du leader, étant donné

qu'il n'a aucun contrôle sur le problème, est celle qui limite au

mieux les dégâts lorsque le suiveur prend des décisions qui

lui sont nuisibles.

Mathématiquement, la formulation pessimiste de

(2.2)-(2.3) s'écrit :

n o

min ?p(y) : y E Y (2.9)

y

|

?p(y) = max

x

|

n o

F(x, y) : x E Ø(y) (2.10)

|

Définition 2.3.1. Un point (x*,

y*) E Rn x Rm est appelé solution

pessimiste locale de (2.2)(2.3) si y* E Y, x* E

Ø(y*) avec

F(x, y*) < F(x*, y*) V x E

Ø(y*)

et il existe Uä(y*), 8 > 0 boule ouverte

centrée en y* de rayon 8 telle que

?p(y*) < ?p(y) Vy E

Uä(y*) n Y

(x*, y*) est appelée solution

pessimiste globale si 8 = +oo.

Le problème 2.4)-(2.9)-(2.10) est appelée

formulation péssimistique de (2.2)-(2.3)).

Non unicité de la solution du problème du

suiveur : les différentes techniques d'approches. 25

Énonçons un théorème d'existence de

solution pessimiste.

Théorème 2.3.1. Considérons le PBN

2.4)-(2.9)-(2.10). Supposons que Ø(.) est

semi-continue inférieurement (Sci) en tout point de Y et que l'assertion

(C) est satisfaite. Supposons que (2.9) admet une solution admissible, alors

2.4)-(2.9)-(2.10) admet une solution optimale globale.

Preuve :

{ }

Posons K = (x,y) ? Rn × Rm

: g(x, y) = 0 et h(x, y) = 0 .

L'assertion (C) nous garanti que K est compact.

Soit P2 : Rn × Rm -? Rm

(x, y) 7-? y la deuxième

projection.

P2(K) n Y est l'ensemble des solutions

admissible de (2.9). P2 étant continue, P2(K)

est compact ; d'où P2(K) n Y est compact

comme intersection d'un fermé et d'un compact.

Montrons que : cpp est semi-continue

inférieurement (Sci).

Soit y0 ? Rm, montrons que cpp

est Sci en y0.

soit (yk)k?N une suite de Rm telle

que (yk)k -? y0

k?+8

Il suffit de montrer que lim inf

cpp(yt) =

cpp(y0)

k?+8

i.e