INTRODUCTION GENERALE

Le réseau informatique est la mise en communication, la

circulation des informations sur des machines (PC) distantes les unes des

autres. Dans le réseau informatique, il existe plusieurs sortes : le MAN

(Metropolitain Area Network), le WAN (World Area Network) et le LAN (Local Area

Network).

Notre travail se basera plus sur le LAN avec une petite

extension sur le WAN. Le LAN qui est un réseau local pouvant pendre en

charge deux à plusieurs machines distantes dans différentes

topologies du réseau. Nous verrons dans les pages qui suivent une

brève esquisse de ces différentes topologies de mise en

réseau et leur fonctionnement.

Nous ne nous arrêtons pas à ce niveau car le

travail consistera en effet à décrire ni les différentes

architectures du réseau ni les différentes topologies du

réseau en informatique mais en fait l'administration d'un système

de réseau LAN avec connexion sur le WAN pour permettre de partager une

connexion sécurisée.

Ce travail consistera en fait à administrer un

réseau ce qui revient à contrôler, gérer et suivre

toutes les informations qui trafiquent sur ce réseau et permettre une

communication Mail intranet par la mise en place d'un serveur de

Messageries.

Pour ce faire, nous aurons le choix entre deux Operating

System (Système d'Exploitation) pour gérer notre réseau.

Un OS payant et graphique qui est le Microsoft Windows et un autre Open Source

et CLI (Command Line) qui est Linux. Nous démontrons leurs avantages et

inconvénients dans les lignes qui suivent et où se portera notre

choix.

De ce choix nous démarrons notre administration, sa

réalisation et sa mise en route pour nous permettre d'avoir un

réseau administré et sécurisé ou il y'aura

fluidité des informations.

I. BREVE ENTREVUE SUR LE RESEAU

La topologie de réseau

A. Structure BUS :

Un réseau de type BUS se compose d'une longueur

continue du câble qui relie deux dispositifs ou plus ensemble. Un

réseau de type BUS s'appelle également un réseau

Backbone.

B. Structure STAR (Etoile) :

Une structure de réseau Étoile se compose de

l'ordinateur individuel relié à un point central sur le

réseau. Le réseau Étoile est le type le plus commun de

réseau.

C. Structure RING (Anneau) :

Une structure de réseau Anneau se compose de l'ordinateur

individuel relié à une longueur simple du câble

disposé dans un anneau.

D. Structure Hybride :

La structure hybride de réseau emploie un mélange

de différents genres de structures de réseau, comme STAR, BUS et

également RING.

TYPE DE RESEAU

Il y a beaucoup de différents types de réseaux

employés par des entreprises et des organisations. Trois types

importants de systèmes répartis sont :

? LAN (Local Area

Network) : est le type le plus commun de réseau

trouvé dans les entreprises. Il relie des ordinateurs et des dispositifs

situés près de l'un l'autre, tel que dedans un même

bâtiment, bureau, etc.

? MAN (Metropolitan Area

Network) : une collection de réseaux locaux. Les MAN

relient des ordinateurs situés dans le même secteur

géographique tel qu'une ville. (LAN + LAN, Village, entreprise

<--> entreprise)

? WAN (Wide Area

Network) : relie des réseaux locaux et

métropolitains ensemble. Les réseaux qui composent d'un

réseau étendu peuvent être situés dans tout un pays

ou même autour du monde. (LAN + LAN + MAN)

E. SERVEUR

Lors de la mise en place d'une infrastructure de type Intranet,

deux directions peuvent être envisagées :

· Soit la confiance est accordée au système

de type Microsoft ;

· Soit la confiance est accordée aux systèmes

ouverts de type Linux.

Même si ces deux environnement peuvent communiquer entre

eux, il y'a un moment ou un choix doit être vraiment

réalisé.

Chaque environnement à ses avantages et peut avoir aussi

ses inconvénients ; parmi ceux-ci nous citons :

> Pour Microsoft

· Intégration global à tous les niveaux,

depuis les postes clients en passant par la gestion du réseau,

l'accès aux applications et aux bases de données. Microsoft

répond à tous les besoins qu'un Intranet peut requérir

;

· Démarrage d'une solution Intranet relativement

aisée ;

· En général les systèmes sont stables

mais il faut appliquer un grand nombre de patch pour corriger les erreurs ;

· Le prix des licences sont relativement

élevé, tant à l'achat que pendant l'exploitation ;

· La maintenance évolutive est trop chère

(humain et matériel) ;

· Le système n'est pas inter opérable ou

difficilement (système propriétaire) quoique certaines portes

sont ouvertes ;

· La sécurité laisse à désirer

bien que la Société Microsoft tente d'améliorer la

situation.

> Pour Linux (Open Source)

· Possibilité de trouver des solutions qui

correspondent à tous les besoins mais comme la plupart des solutions et

outils sont gratuits, la commercialisation, le support peuvent faire

défaut (tout est disponible sur Internet mais tout ne résout pas

le problème adéquat) ;

· De plus de « vendeurs » portent leurs

applications sous Linux, qui deviennent intégrables dans le

réseau Open Source (comme serveur de fichier, gestions du réseau,

serveur de sauvegarde, barrière de sécurité

(pare-feu)....) ;

· Pour des raisons de sécurité et de

réactivité à certaines trous de sécurité,

nous utiliserons des Open Source ;

· Prix de loin inférieur ;

· Les grands producteurs (IBM, HP, COMPAQ, SUN) offrent des

contrats de support à l'année ;

· Peu ou pas de virus, ils ne se lancent pas

automatiquement comme sur Microsoft ;

· Normes standard du marché sont utilisés

;

· Système en constance évolution, stable dans

le temps, qui compte plus en plus de praticien ;

· Possède dans son paquetage beaucoup de

serveur et gratuitement :

· Barriere de sécurité (pare feu)

· Serveur de messagerie (SendMail, PostFix, SquireMail)

;

· Serveur DNS ;

· Serveur NIS ;

· Serveur de fichier (NFS) ;

· Serveur de sauvegarde des données ;

· Serveur LDAP (répertoire électronique,

équivalent à Active Directory de Microsoft) ;

· Serveur de bases de données des grands producteurs

;

· Serveurs d'indexations et de repérages des

données.

II. ADMINISTRATION DU SYSTEME D'EXPLOITATION

A. INSTALLATION DE LINUX RED HAT 9.0

Le choix du Système s'est fait sur un Système

Open Source et nous avons porté sur une distribution Linux (Red Hat

9.0). Pourquoi le choix de cette distribution mais pas d'une autre distribution

Linux. Les causes sont multiples :

· Nous disposons des CD ROM d'installation de cette

distribution et puis de la dernière version la plus stable;

· Les paquetages d'administration tous sont

intégrés dans le CD ROM d'installation et qu'il suffit seulement

de les cochés ;

· Les multiples possibilités d'utilisation du

Système :

> Bureau, pour une utilisation personnelle dans un cadre

privé du système comme Windows XP ou Vista de Microsoft ;

> Poste de travail, plus utilisé par les

développeurs puisque les codes sont libres et donc modifiables à

volonté et à convenance ;

> Serveur, pour administrer un réseau professionnel et

ce sera aussi notre possibilité utilisée ;

> Personnalisé, cette option est la plus

compliquée puisque seuls les professionnels du Linux peuvent l'utiliser

car elle donne la possibilité de développer un autre

Système d'Exploitation à partir de l'ancien et de personnaliser

le Système à ses convenances.

· La stabilité du Système

· L'interopérabilité du Système....

Nous ne citons que ceux.

B. LES ETAPES DE L'INSTALLATION

Les prés requis :

· Le PC doit supporter un affichage de 32 Bits ;

· Le PC doit disposer au moins de 128 Mbits de RAM ;

· Le PC doit avoir un peu de mémoire disponible

sur le Disque (Même 10 Go est largement suffisant pour le bon

fonctionnent d'un Linux contrairement aux dernières versions de Windows)

;

· Apres toutes ces vérifications nous passons

à la première étape de l'installation :

1. Boot

Le PC doit nécessairement booter sur le lecteur DVD/CD

ROM pour permettre l'installation du Système. Là, au

démarrage il faut appuyer sur la touche fonction F2

pour entrer dans le bios pour changer l'ordre de démarrage

(master boot). Dans le bios on met en première position le lecteur

DVD/CD ROM puis on appui sur la fonction F10 pour valider la

nouvelle configuration et sortir du Bios.

2. Démarrage de l'installation

Apres être sortie du Bios, il faut insérer le

premier CD ROM d'installation du Red Hat 9.0 (puisqu'il possède trois CD

ROM d'installation). Apres il faut redémarrer le PC pour qu'il puisse

prendre le CD ROM au démarrage ; si c'est le cas, il ne reste

qu'à appuyer sur la touche Valider

(Entrée) pour valider l'installation.

3. Choix de la Langue

L'étape primordiale de l'installation et la configuration

d'un Système d'Exploitation (Type Serveur) est la langue qui sera

utilisé dans le Système. Nous proposons le

Français.

4. Choix de l'option du Clavier

Ce choix est en fonction du clavier dont dispose le poste qui

doit recevoir ce nouveau Système. Les différents systèmes

du clavier dépendent des langues utilisées.

5. Choix de la Souris

Ce choix est indispensable sinon la souris ne marchera pas.

Quelques descriptions sur les souris :

· Souris à deux boutons, souris possédant

deux touches ;

· Souris à trois boutons, souris possédant

une troisième touche au milieu ou à coté ;

· Souris trois boutons et émulation, souris

possédant à la place du troisième bouton une molette.

6. Choix de la manière de l'Installation

Dans cette partie, il existe deux manière d'installer

Linux si c'est la première installation sinon trois :

· Installer le Système sur tout le disque, formatage

complet du disque ;

· Installer en dual boot pour le permettre de

fonctionner en collaboration avec un Système d'Exploitation (Si c'est

pour faire un dual boot avec un Système Windows, il serait

préférable et conseillé d'installer le Système

Windows avant le Linux quelque soit sa distribution) ;

· Conserver l'ancienne version du Système linux s'il

existe une ancienne version de Linux et faire une mise à niveau.

7. Paramétrage du Grub ou du Lilo

Grub ou le Lilo sont comme pour le Windows le DOS ; nous avons

le choix entre le Grub ou le Lilo au démarrage.

8. Configuration des espaces

La configuration des espaces représentent l'utilisation

des espaces du disque dur. Si la configuration est manuelle :

· Il faut donner le double de la RAM au Swap

L'espace swap dans Linux est utilisé lorsque la mémoire

physique (RAM) est pleine. Si le système a besoin de plus de ressources

de mémoire et que la mémoire physique est pleine, les pages

inactives de la mémoire sont déplacées dans l'espace de

swap. Même si l'espace de swap peut aider les ordinateurs disposant d'une

quantité de RAM limitée, il ne faut pas le considérer

comme un outil remplaçant la RAM. L'espace de swap est situé sur

les disques durs ayant un temps d'accès plus lent que la mémoire

physique.

· L'espace de swap peut être une partition de swap

consacrée (option recommandée), un fichier de swap ou une

combinaison de partitions et de fichiers de swap. La taille de votre espace de

swap devrait être équivalente à deux fois la RAM de votre

ordinateur ou 32 Mo (selon la quantité la plus importante), mais ne doit

pas dépasser 2048 Mo (ou 2 Go). (il représente la mémoire

virtuel du Système)

· Il faut donner au moins 50 Mbits pour le Lilo ou le Grub

selon le choix du Shell de démarrage.

· Si la configuration est automatique, le travail et le

calcul se fait automatiquement par le Système.

9. Choix de l'utilisation du Système

Ce choix détermine la façon de l'utilisation de

Linux Red Hat 9.0 :

· Bureau ;

· Poste de travail ;

· Serveur (le choix s'est imposé à cette

option) ;

· Personnalisé.

10. Choix des paquetages

Arriver à l'avant dernière partie de notre

installation, cette étape permet la configuration du Système

à notre connivence. Comme nous devons utiliser un Système

serveur, nous cochons tous les paquetages disponibles pour éviter que

notre configuration ne puisse pas marcher à cause des problèmes

des dépendances inter paquetages.

11. Adaptation de l'écran

Nous devons à partir d'ici choisir la bonne configuration

qui correspond aux spécificités de notre écran.

12. La manière de l'utilisation

Cette est la partie la plus importante de notre installation

et de l'utilisation prochaine de notre Système. Nous avons le choix

entre :

v' Le mode texte, l'interface ou le bureau (dépend des

prononciations) sera en ligne de commande (CLI, Command Ligne) donc un

écran noir qu'il faudrait entrer des codes pour l'utiliser ;

v' Le mode graphique, l'interface sera conviviale comme Windows

XP avec des images, des graphiques et des animations.

13. Fin de l'installation

Selon le choix de chacun, il y'a le choix :

· Créer un disque de démarrage, il est

obligatoire lors du démarrage d'une nouvelle session du PC à

chaque fois ;

· Ne pas créer un d'amorçage

(démarrage et amorçage c'est la même chose), là Lilo

ou le Grub sera alloué sur un espace du disque dur. Le démarrage

du Système se fera donc automatiquement.

· Maintenant il ne reste plus qu'à retirer le

troisième CD ROM et redémarrer le PC.

III. FIN DE L'INSTALLATION

Lorsque l'installation de Linux est terminée, le

système se réinitialise. Par la suite, chaque fois que l'on

démarre Linux, le système demandera un nom d'utilisateur et le

mot de passe correspondant. Cette requête peut s'effectuer soit en mode

texte, soit en mode graphique; cela dépend de la configuration de la

distribution. Par défaut, sous Linux Red Hat 9.0, c'est un écran

de login en mode graphique qui est proposé. Quoi qu'il en soit, le

principe est le même : on doit se connecter au système avant de

pouvoir l'utiliser.

1) Le démarrage de Linux

Durant le démarrage de Linux, nous verrons bon nombre

d'informations s'afficher à l'écran. Nous ne devrons nous

inquiéter ni du fait que nous n'y comprenons rien, ni que

certains services ne se chargent pas correctement (le mot

« fail » peut, rarement, apparaître en rouge, alors que

généralement il est indiqué « OK »).

Exemple:

Init version 2.84

bootin

Mounting proc filesystem

Init: Entering runlevel: 5

Montage du système de fichier proc (OK)

Configuration des paramètres du noyau (OK)

Chargement de la configuration clavier (OK)

Remontage du système de fichiers en mode

lecture-écriture (OK)

Activation des partitions swap (OK)

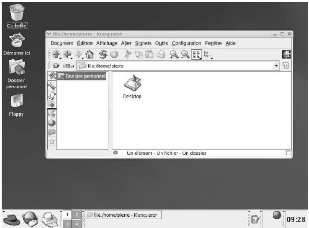

2) L'écran de connexion en mode graphique

Figure : L'écran de login en mode

graphique.

Nous voici à présent devant l'écran de

connexion (également appelé « écran de login»)

en mode graphique. Nous avons la possibilité d'y changer la langue

à utiliser par défaut ou le type de session (par exemple, si nous

avons les environnements graphiques Gnome et KDE, tous deux installés,

nous pouvons décider avec lequel nous allons travailler). Le plus

simple, pour commencer, est d'entrer notre nom d'utilisateur (pierre dans notre

exemple) et le mot de passe (nous avons changé le nom d'utilisateur pour

raison de sécurité).

3) Le chargement de la session

Après avoir entré notre nom d'utilisateur et notre

mot de passe commence le chargement de la session. Nous devrons patienter un

peu, le temps que le système effectue

quelques préparatifs (gestionnaire de

périphériques, gestionnaire de fenêtres, tableau de bord,

etc.). Que nous choisissions Gnome ou KDE comme environnement graphique ne

change rien : le système procède aux mêmes initialisations.

A présent, du moment que nous utilisons un compte normal, nous pouvons

essayer absolument tout ce que nous voulons : nous ne risquons pas d'endommager

quoi que ce soit (voir L'utilisation d'un compte normal).

Le chargement d'une session KDE. Ça y est, nous pouvons

enfin travailler sous Linux !

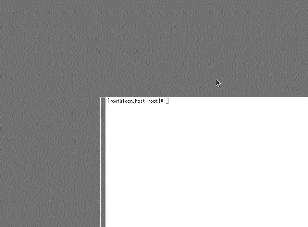

Figure : L'écran de connexion en mode

texte

Lorsque nous nous connecterons à Linux en mode texte

(par exemple parce que notre système est configuré de la sorte ou

parce que nous avons fait appel à un terminal virtuel), nous obtiendrons

les informations suivantes :

Linux Red Hat release 9 (Shrike)

Kernel 2.4.20-8 on an i686

localhost login: root

<ENTRÉE> Password

Last login: Wed Sep 17 19:24:42 on tty1 (

root@enerca.cf)$

Après avoir entré notre nom d'utilisateur,

également appelé nom de login, le système nous demande le

mot de passe correspondant. Comme nous pourrons le constater, le système

ne reflète pas le mot de passe à l'écran (même pas

par des astérisques). Pour ce qui est du reste, ce premier écran

donne déjà un certain nombre de renseignements :

· la version du noyau (2.4 - les deux premiers chiffres

sont les plus importants) ;

· le type de processeur (i686, soit un processeur

compatible Intel et équivalent, au minimum, à un Pentium II) ;

· la date et l'heure de notre dernière connexion

(ou, plus précisément, de la dernière fois que nous nous

étions connectés sur ce compte - pierre dans notre exemple) ;

· le nom d'utilisateur (pierre) ainsi que le nom de la

machine (localhost, ce nom ayant été choisi par défaut

lors de l'installation et qui, pour bien faire, devrait être

changé plus tard) et, sur la même ligne, le nom du

répertoire dans lequel nous nous trouvons (pierre, comme le nom

d'utilisateur dans ce cas-ci).

Lorsque nous nous retrouvons devant l'invite du Shell,

après avoir entré notre mot de passe, nous pouvons lancer

l'interface graphique en entrant la commande startx : (pierre@localhost

pierre)$ startx <ENTRÉE>

Donc, en résumé, démarrer en mode texte

et entrer ensuite startx revient au même que démarrer directement

en mode graphique. L'auteur configure ses différents systèmes de

façon à ce que le login s'effectue toujours en mode texte et il

démarre ensuite manuellement le mode graphique (à l'aide de la

commande startx). Cela peut éviter d'être bloqué si un mode

graphique non supporté par le moniteur est malencontreusement

sélectionné.

4) L'utilisation d'un compte normal

Lorsque l'on découvre pour la première fois

Linux, il est fortement conseillé de ne pas utiliser le compte root

(encore appelé « compte administrateur ») mais bien un compte

normal. La raison en est simple : nous serons soit perdu parmi les centaines de

programmes accessibles depuis l'interface graphique, soit bloqué

à l'invite du mode texte - sans avoir la moindre idée des

commandes à y entrer. Une fausse manoeuvre est alors vite

arrivée, ce qui peut, suivant que l'on soit l'utilisateur root ou un

simple utilisateur, avoir des conséquences désastreuses ou...

aucune importance ! En effet, en tant que simple utilisateur nous ne pourrons

jamais dérégler le système ni effacer de fichiers

importants. Dans le pire des cas, nous pourrions complètement

dérégler nos paramètres de configuration, par exemple

à un point tel qu'il sera impossible de récupérer la

configuration d'origine de ce compte utilisateur en particulier. A ce

moment-là, il n'y aurait qu'à créer un nouveau compte

utilisateur (seul l'utilisateur root a ce droit)....

5) La procédure de reboot

Linux est installé sur notre système et nous

sommes capables de nous y connecter, mais il nous reste encore bien des choses

à apprendre. En effet, même si l'interface graphique de Linux (que

nous utilisions Gnome ou KDE) présente des similitudes avec Windows, il

en va tout autrement du mécanisme intrinsèque du système

d'exploitation. Les différences se situent, entre autres, au niveau du

système de fichiers, du mode multi-utilisateurs, de l'installation de

nouveaux programmes, de l'interface graphique, etc. Avant d'approfondir ces

sujets, voici la démarche à suivre pour quitter Linux. Tout comme

c'est le cas pour Windows, il vaut mieux quitter Linux proprement. Il ne suffit

pas simplement de couper l'ordinateur : cela pourrait endommager le

système de fichiers (voire même, mais c'est très rare,

endommager physiquement le disque dur). Si l'ordinateur n'est pas éteint

correctement, cela se traduira par un prochain démarrage de Linux

ralenti (le système vérifiera si la coupure impromptue n'a pas

entraîné la perte de fichiers). Aucune méthode n'est

meilleure qu'une autre et il n'est pas nécessaire d'apprendre par coeur

des commandes fastidieuses (par exemple shutdown -h 0). Nous en

présentons simplement quelques-unes afin que nous puissions nous faire

une idée de ce qu'il se passe « sous le capot ».

6) L'arrêt depuis l'interface graphique

Si notre système est configuré, comme c'est le

cas par défaut avec la distribution Linux Red Hat 9, pour

démarrer en mode graphique, il suffit de quitter la session en cours

(par exemple en choisissant dans le menu Quitter puis Quitter KDE) : nous nous

retrouvons devant l'écran de connexion en mode graphique et il nous

suffira de cliquer sur Arrêter. Cette technique ne fonctionne pas si

notre ordinateur démarre en mode texte. En effet, lorsque nous quittons

l'interface graphique nous nous retrouvons alors devant l'écran de login

en mode texte, qui ne propose pas de bouton Arrêter. Il est

également possible d'ouvrir un terminal virtuel depuis l'interface

graphique et d'appeler manuellement la commande reboot (ou shutdown).

7) L'appel manuel de la commande reboot

Pour couper ou redémarrer l'ordinateur, il faut lancer

soit la commande shutdown, soit la commande reboot (qui appellera alors

elle-même la commande shutdown avec les paramètres

adéquats). Le système se coupera alors proprement. Lorsque nous

avons accès à un Shell (par exemple si nous avons

démarré en mode texte ou si nous avons lancé un terminal

virtuel dans notre interface graphique), nous pouvons entrer la commande reboot

:

(trinite@localhost trinite)$ reboot

<ENTRÉE> The system is going down for

reboot NOW!!! Init is switching to system level 6

Suivant les distributions de Linux, voire suivant les

différentes versions d'une même distribution de Linux, les droits

d'exécution de cette commande peuvent varier. Par défaut, Linux

Red Hat 9 autorise n'importe quel utilisateur à lancer cette commande

et, donc, à redémarrer l'ordinateur.

8) L'appel de la commande shutdown

Normalement seul l'utilisateur root a le droit d'appeler la

commande shutdown. Dès lors, nous devrons probablement appeler la

commande su avant de lancer la procédure de shutdown. La

commande «shutdown -h 0 » (-h pour halt) permet de couper

l'ordinateur sans qu'il ne redémarre. Exemple:

(trinite@localhost ~/) $ /sbin/shutdown -h 0

shutdown: you must be root to do that!

(pierre@localhost ~/) $ su

Password:

(root@spyda /home/trinite/) # /sbin/shutdown -h 0

The system is going down for reboot NOW!!!

Init is switching to system level 6

Unmounting file system

L'utilisateur trinite essaye d'appeler la commande shutdown

(présente dans le répertoire /sbin/) mais se voit refuser

l'accès (« You must be root to do that »). Il lance alors la

commande su pour devenir l'utilisateur root et il peut ensuite lancer la

procédure de shutdown. Certains utilisateurs gardent leur système

Linux allumé durant des semaines, voire des mois et ceci soit par

nécessité (par exemple parce que le système sert de

serveur) soit par facilité (à quoi bon redémarrer un

système qui ne se bloque jamais ?). La commande uptime permet

de voir depuis combien de temps le système Linux est

démarré. Exemple:

[gospa@enerca ~/] $ uptime

14:46:59 up 15 days, 9:35, 10 users, load average: 0.19,

0.66, 0.57

[gospa@enerca ~/] $

L'utilisateur gospa constate que le système nommé

enerca est allumé depuis plus de 15

jours.

9) La session de secours

Même si nous ne connaissons encore aucune commande

Unix, il peut être bon de préciser que lors du login en mode

graphique nous pouvons lancer une session de secours (dans le menu

Session/Secours). Nous nous retrouvons alors devant un bureau vide (aucun

environnement graphique, ni Gnome ni KDE, n'est lancé) ne contenant

qu'une seule fenêtre : un terminal virtuel. Ce terminal peut alors servir

pour réparer le système (par exemple en créant un nouveau

compte utilisateur).

Figure : La session de secours permet

d'accéder à un terminal virtuel.

10) Le principe multi-utilisateur

Comme tous les systèmes Unix, Linux supporte et,

surtout, encourage l'utilisation de plusieurs comptes utilisateurs...

même si nous sommes le seul à utiliser le système !

Après avoir installé Linux, au moins deux comptes utilisateurs

seront présents sur la machine : l'un étant le compte de

l'administrateur (root) et l'autre un simple compte utilisateur, que le

programme d'installation nous a invité à créer.

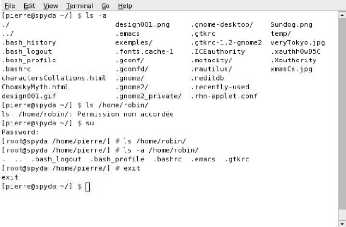

11) Le compte utilisateur

Chaque utilisateur dispose d'un répertoire personnel,

placé, par convention, dans le répertoire /home/. C'est

dans ce répertoire que l'utilisateur pourra organiser, à sa

guise, ses fichiers et répertoires personnels. L'on peut même dire

que c'est le seul répertoire dans lequel l'utilisateur a le droit de

modifier quelque chose ! La session de secours permet d'accéder à

un terminal virtuel. En effet, étant donné le système de

permissions d'accès utilisé par Linux, un utilisateur se voit

dans l'impossibilité d'effacer ou de modifier des fichiers importants.

C'est ce qui explique notamment que les virus ne peuvent pas se reproduire ni

d'un utilisateur à un autre, ni d'une machine à une autre. C'est

ce qui explique également pourquoi Linux est si robuste : il est

impossible qu'une application installée par un utilisateur

dérègle tout le système ! Le répertoire principal

d'un utilisateur contient également ses fichiers de configuration

c'est-à-dire les fichiers de configuration créés par les

différents programmes auxquels l'utilisateur a recours. La capture

d'écran suivante montre le contenu du répertoire principal des

utilisateurs pierre et robin. Nous devons noter qu'il a fallu devenir super

utilisateur, ou root, pour pouvoir lister le contenu du répertoire

/home/robin/ : c'est normal, il n'y a aucune raison que l'utilisateur pierre

puisse avoir accès aux informations personnelles de

l'utilisateur robin ! Le message classique qu'obtient un

utilisateur essayant d'ouvrir un fichier auquel il n'a pas le droit

d'accéder est : « permission non accordée » (ou parfois

« permission denied » puisque les programmes de la Red Hat ne sont

pas tous traduits). Si le terminal n'est pas correctement configuré (ou

si un programme n'est pas correctement configuré), il se peut

également que le message s'affiche en gérant mal les

caractères accentués (par exemple : « permission non

accordée »). Nous verrons plus loin comment configurer le terminal

pour remédier à ce problème. La plupart des fichiers

contenus dans les répertoires de ces deux utilisateurs sont des fichiers

cachés (leurs noms commencent par un point). Le contenu des

répertoires,

/home/pierre/ et /home/robin/.

fichiers de configuration des programmes utilisés.

L'on peut ainsi constater, par exemple, que l'utilisateur pierre a

déjà utilisé l'environnement Gnome tandis que le

répertoire /home/robin/ ne contient que quelques fichiers cachés

(c'est normal, car il s'agit d'un compte tout fraîchement

créé). Quant aux fichiers personnels, l'utilisateur pierre

dispose de quelques images (.gif, .png et .jpg) et de deux fichiers .html. A

noter également la présence du répertoire .metacity, qui

indique que l'environnement graphique Gnome utilise le gestionnaire de

fenêtre metacity. Rien ne nous force à consulter le contenu de

notre répertoire personnel depuis un terminal, nous pouvons tout aussi

bien recourir à un navigateur de fichiers, tel Nautilus.

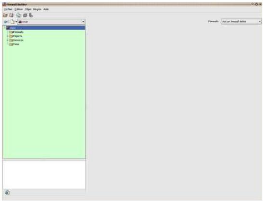

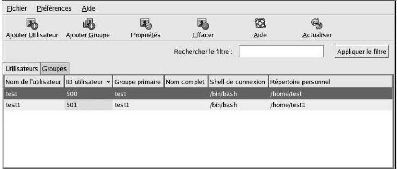

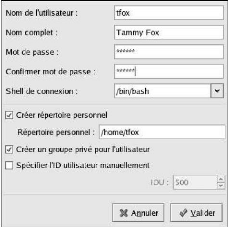

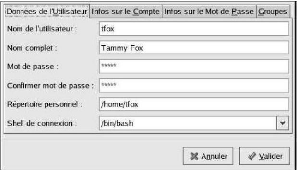

Figure : L'ajout d'un nouveau compte

utilisateur

Nous pouvons ajouter un nouveau compte utilisateur en nous

rendant, par exemple, dans le menu Paramètres systèmes /

Groupes et utilisateurs. Le nom d'utilisateur employé pour le

login doit être écrit en minuscules. Le répertoire

utilisé par défaut se trouve dans le répertoire /home/ et

porte le nom de login (par exemple /home/robin/ pour l'utilisateur nommé

robin). Le contenu des répertoires /home/pierre/ et

/home/robin/.

Ajouter un nouvel utilisateur consiste simplement à

créer une nouvelle entrée dans les fichiers de connexion

(notamment dans le fichier /etc/passwd - qui contient tous les utilisateurs)

ainsi qu'un nouveau répertoire dans le répertoire /home/.

12) Le compte root

Le compte root est quelque peu particulier puisqu'il s'agit

du compte de l'administrateur du système. Tout d'abord, il n'est pas

situé dans le répertoire /home/ des utilisateurs normaux mais

bien directement à la racine du disque dur (répertoire /root/).

Ensuite, l'utilisateur root est l'administrateur du système et il a donc

tous les droits.

L'ajout d'un utilisateur nommé robin (par exemple) au

système. Pour effectuer certaines tâches nous serons

obligés d'être, du moins momentanément, l'administrateur du

système. Il en sera ainsi, par exemple, lorsque nous désirons

installer un nouveau programme ou créer un nouveau compte utilisateur.

Etant donné que l'administrateur a tous les droits, il peut modifier ou

effacer n'importe quel fichier. Une seule fausse manoeuvre peut alors suffire

à compromettre tout le système et c'est pourquoi il est

très fortement recommandé de n'utiliser le compte root que

lorsque c'est vraiment nécessaire.

13) Les terminaux virtuels

Quelle que soit la version de Linux que nous utilisons,

plusieurs terminaux virtuels sont disponibles et ce avant même que nous

ne soyons connectés. En effet, étant donné que Linux est

multi-utilisateur et multitâche il est possible de connecter

simultanément plusieurs utilisateurs (ou plusieurs fois le même

utilisateur) au système.

Il est par exemple possible d'ouvrir simultanément

plusieurs consoles en mode texte sous X (l'interface graphique des

systèmes Unix) et de s'y connecter sous différents noms

d'utilisateur. De même, il est possible d'accéder à

différents terminaux virtuels ; ce qui, en plus d'être très

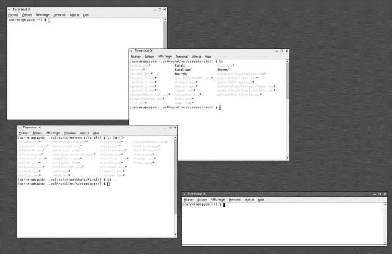

impressionnant, est fort pratique ! Sur la capture d'écran

présente à la page suivante, on peut constater qu'il y a quatre

terminaux X ouverts. Deux appartiennent à l'utilisateur carrera, un

à l'utilisateur pierre et un à l'utilisateur root (le super

utilisateur). On accède à une console en mode texte en combinant

les touches <CTRL>+<ALT> avec la touche de

fonction correspondant au numéro du terminal qu'on désire

obtenir. Par défaut, Linux Red Hat 9 (et beaucoup d'autres distributions

de Linux) permet d'utiliser six terminaux virtuels en mode texte

(numérotés de 1 à 6). Au démarrage, on est

connecté soit au premier terminal en mode texte, soit au premier

terminal en mode graphique. Un exemple valant mieux qu'un long discours, voici

la démarche à suivre :

· démarrons Linux ;

· connectons-nous en entrant notre nom d'utilisateur -

nous nous retrouvons alors face soit à l'invite d'un Shell (en mode

texte), soit à l'écran de login de l'interface graphique (suivant

la façon dont le système est configuré) ;

· appuyez sur les touches

<CTRL>+<ALT>+<F2>...

Autant spécifier que nous venons de faire un reset du

système, mais simplement d'accéder pour la première fois

à un terminal virtuel, en mode texte. Nous pouvons nous en assurer en

« retrouvant » l'interface graphique

(<CTRL>+<ALT>+<F7>) ou notre ancien terminal

(<CTRL>+<ALT>+<F1>) tel que nous l'avons

quitté. Lorsqu'on se connecte pour la première fois à un

autre terminal, on se retrouve devant l'invite login. On peut très bien

se connecter sur le même compte utilisateur depuis différents

terminaux virtuels. Puisque le système propose par défaut six

terminaux virtuels en mode texte (de <F1> à

<F6>), le système permet

d'accéder à l'interface graphique à l'aide de la touche

<F7> (<CTRL>+<ALT>+<F7>). Nous verrons

plus loin qu'il est même possible de lancer plusieurs interfaces

graphiques simultanément et de passer de l'une à l'autre.

Figure : Quatre terminaux virtuels sont ouverts

simultanément 14) L'utilisation de plusieurs

terminaux

A priori, recourir à différents terminaux ne

nous semble peut-être pas utile. Voici donc quelques exemples

d'utilisation de ces terminaux et, à n'en pas douter, nous en trouverons

bien d'autres...

· Lorsqu'on utilise Linux dans notre entreprise ou chez

soi, il vaut mieux travailler en tant que «simple utilisateur » mais

il est parfois nécessaire de lancer des commandes en tant qu'utilisateur

root et de passer d'un compte à l'autre.

· Si notre Shell ou notre interface graphique plante (ce

qui est très rare) ou que nous sommes bloqués dans un logiciel,

la commande <CTRL>+<ALT>+<F2>, par exemple,

fonctionne généralement encore. Nous pouvons alors

rétablir l'ordre dans notre système (par exemple en tuant les

processus douteux depuis le compte root).

· Si nous effectuons des manipulations depuis le Shell

sur deux répertoires simultanément et que ces deux

répertoires ne se trouvent pas du tout au même endroit dans notre

système de fichiers, il peut être pratique d'avoir un terminal

ouvert sur le premier répertoire et un autre sur le second.

· Certaines tâches mettent du temps à

s'exécuter et peuvent donc monopoliser un terminal ou encore afficher

des informations et donc bloquer le terminal (en utilisant, par exemple, un

terminal pour visualiser en continu un fichier de log). Dans ce cas, il est

fort pratique de pouvoir quitter le terminal en question. Il est

également fort pratique de pouvoir y revenir de temps à autre,

afin de voir où en est l'exécution de la tâche.

La touche <CTRL> n'est

nécessaire que lorsqu'on désire quitter l'interface graphique

pour un terminal virtuel en mode texte (pour passer d'un terminal virtuel

à un autre terminal, ou à

l'interface graphique, la combinaison

<ALT>+<FX> suffit), toutefois, il est plus facile

de ne retenir que la combinaison

<CTRL>+<ALT>+<FX>, qui fonctionne à

tous les coups.

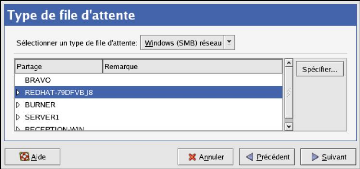

IV. CONFIGURATION RESEAU

nous allons traiter maintenant de la configuration du serveur

Linux Red Hat 9 en tant que passerelle Internet pour un réseau interne

composé de clients Windows. Ce serveur gèrera la connexion

Internet ; il sera serveur DHCP, DNS et firewall.

Donc nous allons nous atteler à installer et

configurer la connexion Internet sur notre serveur Red Hat (dans notre cas la

liaison avec le modem est faite via un câble Ethernet). Il est donc

nécessaire que notre machine possède 2 cartes Ethernet.

L'installation et la configuration se font en 3

étapes:

· 1 - 1 Configuration réseau.

· 1 - 2 Installation et configuration du

modem.

· 1 - 3 Mise en place d'un Firewall

(NAT).

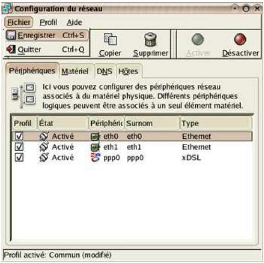

La première des choses à faire est de donner des

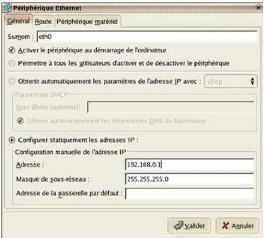

adresses IP fixes à nos 2 cartes réseaux. Nous cliquons sur le

chapeau Redhat ==>Paramètre système

=>Réseau.

Nous sélectionnons la carte Eth0 et nous lui donnons

une adresse du type ex : 192.168.0.1 et

255.255.255.0 en masque de sous-réseau (adresse de

classe C de type privé, carte reliée à notre réseau

interne).

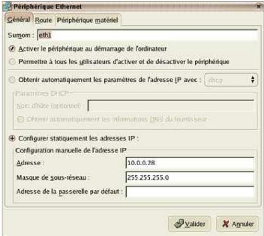

Et nous reproduisons la même opération pour la carte

Eth1 par un double-clic et nous luidonnons une adresse du type

10.0.0.28 et 255.255.255.0 en masque de

sous-réseau ; cette carte sera celle reliée au modem via le

câble Ethernet.

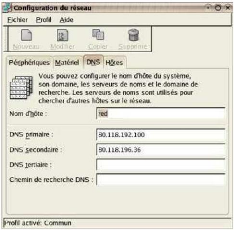

Vu que l'onglet DNS est tout proche, on va ajouter les adresses

Primaire et Secondaire de notre Provider Internet.

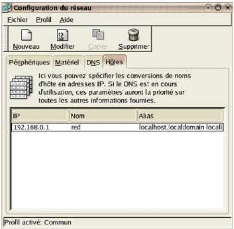

Nous cliquons sur l'onglet Hôtes et indiquer le nom

hostname de notre serveur Redhat.

Puis sauvegarder pour valider la configuration : nous faisons

Fichier ==> Enregistrer.

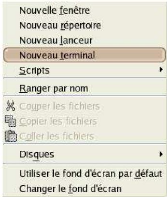

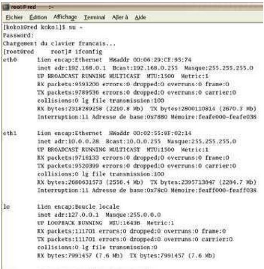

Pour vérifier les modifications, nous ouvrons un

terminal par un clic-droit sur le bureau et nous nous logons sous

root par su, pour relancer le service network

par la commande /etc/rc.d/init.d/network restart ou service

network restart et faire un ifconfig, nous pouvons observer les

nouvelles IP attribuées aux cartes Eth0 et Eth1.

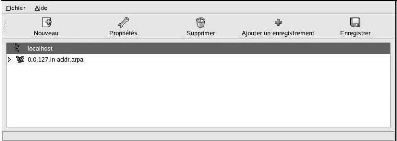

Figure : Installation et configuration modem

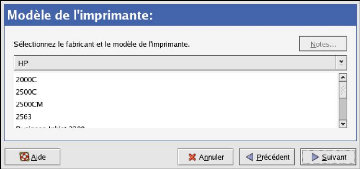

V. INSTALLATION DU MODEM

Pour cela, nous allons installer un Package RPM du type

rp-pppoexxx i386.rpm, i386 si lors de l'installation nous l'avons

oublié.

Pour faire l'installation du Package RPM, nous ouvrons à

nouveau un terminal par un clic-

droit sur le bureau et nous nous logons sous

root, nous nous plaçons dans le répertoire

oünotre RPM a été téléchargé

à l'aide de la commande cd /mon_rep, ls pour lister le

répertoire,

puis utiliser la commande rpm -Uvh mon_package.rpm. Une

fois installé, il nous reste plus qu'à configurer la connexion

PPP0 avec la commande adsl-setup

Nous devons remplir tous les éléments

demandés, attention : choisir la bonne carte Ethernet (Eth0 ou Eth1)

identifiant, mot de passe, DNS, nous devons être vigilants à la

dernière option qui traite du firewall, pour bien indiquer la valeur

0, pour non.

La configuration étant effectuée et le modem

branché correctement, nous pouvons lancer une connexion par la commande

adsl-start ou adsl-connect, au bout de quelques secondes le

Shell nous rend la main.

Nous pouvons vérifier que la connexion est bien active

à l'aide de la commande ifconfig, nous devrions voir

apparaître une IP pour l'interface PPP0. Si c'est le cas nous pouvons

lancer un browser Internet (navigateur) et naviguer sur le Web (Internet

Explorer, Google Chrome ou Mozilla Firefox).

Maintenant que notre serveur Linux est bien connecté

à Internet, nous allons le configurer afin qu'il puisse faire

bénéficier sa connexion aux clients DHCP. Sous Linux, le principe

de partage est similaire à ce que l'on peut rencontrer sur les

routeurs.

Pour que notre serveur puisse partager sa connexion avec des

clients, il est indispensable qu'il fasse du N. A. T. (Network Address

Translation - Translations de ports). De plus, nous allons nous servir du

service DHCP afin que les clients puissent récupérer les DNS de

notre connexion.

En résumé, pour que la configuration des clients

soit allégée, nous allons laisser le soin à notre Redhat

Linux d'être serveur DHCP pour l'instant et de permettre un rapatriement

des adresses DNS aux clients. Ces derniers n'auront plus qu'à se

connecter au réseau pour accéder à Internet.

Nous commençons à installer notre Red Hat Linux

en serveur DHCP, configuration du NAMED et ensuite la partie N.A.T qui sera

mise en place à l'aide de notre firewall logiciel (Firewall Builder).

La première chose est de nous assurer que le DHCP n'est

pas déjà installé : Soit en cherchant l'existence du RPM,

soit par la présence de l'exécutable dhcpd et named dans

/etc/rc.d/init.t par la commande ls /etc/rc.d/init.d.Pour

voir s'il est installé en RPM, nous devons utiliser la commande rpm

-qa |grep dhcp et rpm -qa |grep named, qui nous listera tous les

packages installés portant les chaînes de caractères dhcp ;

sinon, pas de panique, les RPM sont disponibles ici

dhcp-3.0pl1-23.i386.rpm Pour l'installer, même technique que

précédemment: rpm -Uvh dhcp-3.0pl1-23.i386.rpm

Nous pouvons aussi le charger tout simplement en utilisant le

RPM de base fournit dans le CD d'installation de REDHAT 9. Pour cela, nous

insérons le CD d'installation Linux,

une fenêtre s'ouvre et valider l'ajout d'un nouveau

programme ou package, puis nous sélectionnons le RPM ou le serveur

à ajouter, dans notre cas ici le serveur DHCP. Dans ce cas,

l'installation se fait automatiquement.

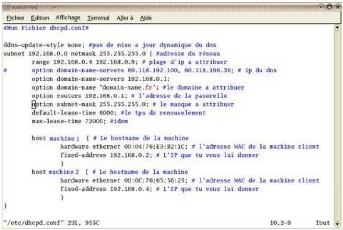

Il ne nous reste plus qu'a configurer notre DHCP : Le fichier de

configuration est situé dans /etc/dhcpd.conf, nous

éditons ce fichier par vi /etc/dhcpd.conf et ajoutons les

lignes suivantes:dhcpd.conf

Une fois le DHCP configuré, il nous faut configurer la

partie DNS, par le fichier /etc/named.conf, même

procédures, nous éditons le fichier par vi, vi

/etc/named.conf et nous ajoutons les lignes suivantes :

named.conf

Nous allons adapter

kokoko.dynd.org de

la copie écran par l'URL de notre serveur Apache. Maintenant nous allons

lancer les processus named et dhcpd, par la

commande /etc/rc.d/init.d/named start, /etc/rc.d/init.d/dhcpd

start ou par service named start, service dhcpd start.Le

contrôle des services ou processus en cours d'exécution se fait

par la commande : ps -ef |grep nom_du_service_rechercher, ici named et

dhcpd : ps -ef |grep dhcpd. On voit bien le process en action et la

carte réseau affectée ici eth0.

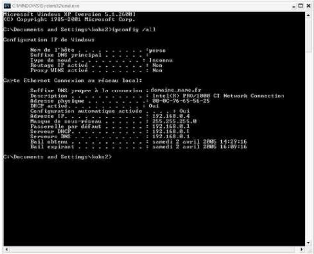

Nous pouvons donc connecter un poste client au(x)

réseau(x), nous nous logons, puis nous faisons

Démarrer==> Exécuter :

cmd ou command et tapez dans la fenêtre

DOS ipconfig /all, nous voyons apparaître les lignes

suivantes:

Cela signifie que notre serveur DHCP fonctionne, car l'adresse

de la passerelle (l'adresse de notre serveur DHCP Linux) et le bail dhcp ont

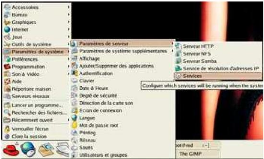

été fournis. Pour finaliser le lancement de ces processus

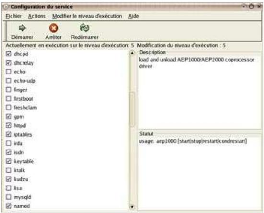

à chaque reboot de la machine, il nous faut vérifier que le

service sera bien chargé dans le rc5.d (configuration

des services au démarrage), pour cela nous cliquons sur le

chapeau Redhat ==>Paramètre système ==>Service.

Nous cochons les lignes des services DHCPD et NAMED, nous

pouvons aussi arrêter et redémarrer les services à l'aide

des boutons ici en les sélectionnant. Puis faire

Fichier==> Enregistrer et valider.

Nous disposons maintenant d'un serveur capable de fournir des

adresses IP à des postes sur le réseau.

VI. MISE EN PLACE D'UN FIREWALL (NAT)

Dernière phase, étape 3 : mise

en place du Firewall (NAT) pour la Passerelle Internet. L'outil utilisé

ici est FIREWALL BUILDER, c'est un programme Graphique qui permet de configurer

et de compiler les règles IPTABLES (firewall), afin de sécuriser

la connexion et faire de la translation de port pour notre partage de connexion

internet (NAT).

FIREWALL BUILDER Release 1:

fwbuilder-1.1.2-1.rh9.i386.rpm

fwbuilder-ipf-1.1.2-1.rh9.i386.rpm fwbuilder-ipfw-1.1.2-1.rh9.i386.rpm

fwbuilder-ipt-1.1.2-1.rh9.i386.rpm fwbuilder-pf-1.1.2-1.rh9.i386.rpm

libfwbuilder-1.0.2-2.rh9.i386.rpm gtkmm-1.2.10-fr3.i386.rpm

libsigc++10-1.0.4-fr3.i386.rpm

FIREWALL BUILDER Release 2:

fwbuilder-2.0.3-1.rh90.i386.rpm

fwbuilder-ipfw-2.0.3-1.rh90.i386.rpm fwbuilder-ipf-2.0.3-1.rh90.i386.rpm

fwbuilder-ipt-2.0.3-1.rh90.i386.rpm fwbuilder-pf-2.0.3-1.rh90.i386.rpm

gtkmm-1.2.10-fr3.i386.rpm

libfwbuilder-2.0.3-1.rh90.i386.rpm

libsigc++10-1.0.4-fr3.i386.rpm

Une fois téléchargée, nous installons les

RPM par la commande :

rpm -Uvh mon_package1.rpm mon_package2.rpm

mon_package3.rpm Une fois le tout installé, deux solutions

s'offrent à nous:

télécharger le fichier fwb (firewall builder) ou

l'installer manuellement.

a. TELECHARGER ET DECOMPRESSER LE

FICHIER fwbuilder dotclear.fwb.tar

Pour décompresser le TAR (fichier compresser), nous

ouvrons un terminal sous root puis nous tapons la commande

tar -xvf fwbuilder_dotclear.fwb.tar ls -la

Pour vérifier si le fichier est exécutable, sinon

nous lui donnons des droits en faisant

chmod 775 fwbuilder_dotclear.fwb chown root:root

fwbuilder_dotclear.fwb (à faire pour des raisons de

sécurité).

Nous ouvrons un terminal sous root et nous

tapons la commande fwbuilder er l'interface graphique

se lance, puis nous ouvrons le fichier et l'adaptons en fonction de notre

système et de notre configuration : Red (hostname de notre linux), eth0,

eth1, nous changeons ou ajoutons les hosts des machines

clientes, plus nos services TCP ou autres.

Puis nous faisons un clic sur le bouton

compiler (ou clic droit sur icône firewall

Red compiler) pour installer les règles, nous ouvrons

un terminal et utilisons les commandes suivantes :

cd /root

ls -la /root/*.fw (liste les fichiers contenant

l'extension fw)

./mon_fichier.fw (ici ./fwbuilder_dotclear.fw) .

Ça y est, le firewall est actif et les règles NAT

sont appliquées, les clients DHCP peuvent surfer en toute

tranquillité. Faire juste, pour les clients DHCP sous Windows dans une

fenêtre DOS, un 'ipconfig /release' puis ipconfig /renew ou pour

un client Linux service network restart

b. INSTALLATION MANUELLE

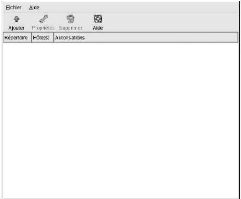

Nous ouvrons un terminal et tapons la commande fwbuilder

l'interface graphique se lance.

Nous sélectionnons le Firewall, un clic-droit

nouveau Firewall, puis nous indiquons le hostname de notre

serveur et choix du type de firewall logiciel IPTABLES, et

l'OS, puis Next.

Nous ajoutons notre carte eth0.

Nous ajoutons notre carte eth1.

Nous ajoutons notre carte lo.

Nous ajoutons notre interface ppp0 (modem), et

sélectionnons Adresse dynamique, puis nous faisons un

clic sur Finish.

Nous faisons édition ==>

Préférences et indiquer le répertoire de travail

(bien mettre sous root pour raison de sécurité).

Pour vérifier la configuration du firewall, nous faisons

un double-clic sur l'icône firewall Red.

Et configuration firewall. Pour

vérifier et ajouter les options puis nous faisons un clic sur

OK.

Maintenant nous allons configurer, les domaines (WorkGroup

DMZ), nos Hosts clients (Pour des liaisons NAT spécifique: Remote XP,

P2P, etc....), nos services TCP et UDP, la politique générale du

firewall, les règles pour l'interface PPP0, eth0 (reliée au

réseau interne), eth1 (reliée au modem), lo (broadcast) et la

fameuse partie NAT (Network Address Translation : Translation De Ports).

Pour configurer notre domaine : nous faisons un clic droit sur

Network, et nous sélectionnons nouveau réseau.

Ou nous cliquons sur la petite flèche à droite de l'icone suivant

et nous faisons nouveau service TCP :

Nous indiquons de surcroit la classe réseau

(Classe C).

Puis nous rééditons l'opération pour ce que

nous appellerons la DMZ, mini réseau entre notre interface (PPP0) et

notre carte eth0 (reliée à notre modem).

Pour configurer les Hosts, nous faisons pour cela un clic

droit sur hosts, sélectionner nouveau Hosts. Ou nous

faisons un clic sur la petite flèche à droite de l'icone suivant

et faire nouveau service TCP :

Nous indiquons le host de notre machine

client, nous cliquons sur Next, puis nous

sélectionnons configuration manuelle et un clic sur

Next et nous ajoutons les cartes réseaux :

eth0=192.168.0.4 masque 255.255.255.0 et lo=127.0.0.1 masque idem et

valider.

Pour le service TCP, nous faisons un clic sur

SERVICE et clic droit sur service TCP pour ajouter nouveau

service TCP.Ou une autre possibilité nous cliquons sur

la petite flèche à droite de l'icone suivant et faire nouveau

service TCP:

Ajouter les ports de destinations désirés.

Cliquer sur la partie marquer USER et

sélectionner Standard.

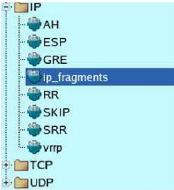

Trouver les services, puis la zone

IP, copier l'icône IP_FRAGMENTS par un

clic droit et retourner dans USER.

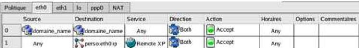

Nous cliquons sur l'onglet politique puis

dans le menu, Règle ==> Insérer une règle

et nous collons l'icone IP_FRAGMENTS dans

service, action en

DENY et Source,

Destination, Horaires en

Any.

Nous cliquons sur l'onglet eth0 et dans le menu,

Règle ==> Insérer une règle ensuite

nous glissons nos icones crées (domaine, host, service TCP) dans les

zones adéquates afin de construire nos règles.

Nous cliquons sur l'onglet eth1 et dans le

menu Règle ==> Insérer une règle puis

nous glissons nos icones crées (domaine, host, service TCP) dans les

zones adéquates afin de construire nos règles.

Nous cliquons sur l'onglet lo puis nous

faisons dans le menu, Règle ==> Insérer une

règle et nous glissons nos icones crées (domaine, host,

service TCP) dans les zones adéquates afin de construire nos

règles.

Et aussi nous faisons un clic sur l'onglet

PPP0, nous faisons dans le menu Règle ==>

Insérer une règle et nous faisons glisser nos icones

crées (domaine, host, service TCP) dans les zones adéquates afin

de construire nos règles.

Nous cliquons sur l'onglet NAT dans le menu,

Règle ==> Insérer une

règle et glisser nos icônes crées (domaine, host,

service TCP, UDP ou autre) dans les zones adéquates afin de construire

nos règles.

Pour sauvegarder nous faisons Fichier ==>

Enregistrer. Puis nous faisons un clic sur le bouton

compiler (ou clic droit sur icône firewall

Red compiler). Apres avoir

Installées les règles, nous faisons un clic sur

le bouton Installer (ou clic droit sur icône firewall

Red Installer) soit en ouvrant un terminal sous

root et utiliser les commandes suivantes :

cd /root ls -la /root/*.fw (liste les fichiers

contenant l'extention fw, extension de notre règle firewall). Si le

fichier n'est pas exécutable, nous lui donnons les droits en faisant

chmod 755 mon_fichier.fw./mon_fichier.fw (ici

./fwbuilder_dotclear.fw) ou directement par root/mon_fichier.fw . Nous

pouvons visualiser alors l'application des Règles

Iptables.

Le Firewall et la Passerelle

Internet de notre serveur Red Hat Linux sont activés. Les

clients DHCP peuvent surfer en toute tranquillité pour l'instant avant

de fixer les adresses pour permettre la Messagerie.

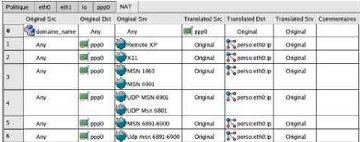

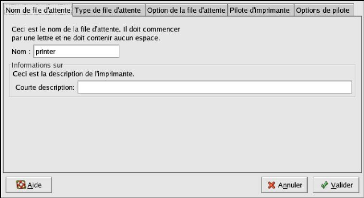

VII. CONFIGURATION DE L'AUTHENTIFICATION

Lorsqu'un utilisateur se connecte à un système

Red Hat Linux, la combinaison nom d'utilisateur/mot de passe doit être

vérifiée, ou authentifiée, comme un utilisateur

valide et actif. Dans certaines situations, les informations nécessaires

à la vérification de l'utilisateur se trouvent sur le

système local et dans d'autres situations, le système demande

à une base de données utilisateur se trouvant sur un

système distant d'effectuer l'authentification.

L'Outil de configuration d'authentification

fournit une interface graphique permettant non seulement de configurer NIS,

LDAP et Hesiod de manière à ce qu'ils extraient les informations

d'utilisateur mais permettant également la configuration de LDAP,

Kerberos et SMB en tant que protocoles d'authentification.

Pour démarrer la version graphique de l'Outil

de configuration d'authentification à partir du bureau, nous

sélectionnons le bouton Menu principal (sur le panneau)

=> Paramètres du système =>

Authentification ou par la commande authconfig-gtk

à une invite du Shell (par exemple, dans XTerm GNOME

terminal). Afin de démarrer la version texte, nous tapons la

commande authconfig à une invite du Shell.

a) INFORMATIONS UTILISATEUR

L'onglet Informations utilisateur offre

plusieurs options. Pour activer une option, nous cochons la case de pointage

située à côté d'elle. Pour désactiver une

option, nous faisons un clic sur la case de pointage située à

côté d'elle et tout choix précédent sera

annulé. Nous faisons un clic sur OK afin de sortir du

programme et mettre en oeuvre les modifications apportées.

Figure : Informations utilisateur

La liste ci-

dessous explique l'élément que chaque

option configure:

· Cache d'informations utilisateur

: nous sélectionnons cette option

pour

qu'il se lance au démarrage. puisse

fonctionner.

· Activer support NIS

activer le démon de cache de service de noms

(nscd) et le configurer de manière à ce Le

paquetage nscd doit être installé pour que cette option

: cette option permet de configurer le système en tant

que

client NIS qui se connecte à un serveur

NI

S pour l'authentification de l'utilisateur et du

Configurer NIS

mot de passe. Nous cliquons sur le bouton pour

spécifier le domaine

NIS et le serveur NIS. Si le serveur NIS n'est pas

spécifié, le démon essaiera de le trouver

par le biais de la diffusion. Le paquetage ypbind doit être

installé pour que cette option puisse fonctionner. Si

la prise en charge NIS est activée, les services

portmap et ypbind sont non seulement lancés mais sont

également activés de manière à

s'amorcer au démarrage.

· Activer support LDAP : cette option permet de

configurer le système de manière à ce

qu'il extraie les informations utilisateur par le biais de LDAP. Nous

Configurer LDAP pour spécifier le

cliquons sur le bouton DN de la base de

recherche de LDAP et le Serveur

LDAP. En sélectionnant Utiliser TLS pour crypter les

mots de passe , Transport Layer Security deviendra la

méthode de cryptage des mots de passe envoyés au

serveur LDAP. Le paquetage openldap-clients doit être

installé pour que cette option puisse fonctionner.

· Activ er support Hesiod : cette option permet

de configurer le système de manière à ce

qu'il extraie ses informations d'une base de données Hesiod distante,

y compris les informations utilisateurs. Le paquetage hesiod

doit être installé pour que cette option pui

sse fonctionner.

b) AUTHENTIFICATION

L'onglet Authentification

permet la configuration des méthodes

d'authentification réseau. Pour activer une option,

nous devons cliquer sur la case de pointage vierge placée à

côté d'elle. Pour désactiver une option,

nous faisons un clic sur la case de pointage située à

côté d'elle et tout choix précédent

sera annulé.

Figure : Authentification

Les informations suivantes expliquent

l'élément que chaque option configure :

· Utiliser des mots de passe

masqués : cette opt

ion permet de conserver les mots de

passe dans un format de mots de passe masqués dans le fichier

/etc/shadow

plutôt que dans le fichier

/etc/passwd

. Les mots de passe masqués

sont activés par défaut lors de l'installation et leur

utilisation est fortement recommandée afin d'augmenter la

sécurité du système. Le paquetage shadowutils doit

être installé pour que cette option puisse

fonctionner.

· Utiliser des mots de passe MD5

: cette option permet d'activer les mots de

passe MD5, qui peuvent avoir une longueur allant jusqu'à 256

caractères au lieu de huit ou moins. Cette option est

sélectionnée par défaut lors de

l'installation et leur utilisation est fortement recommandée

afin d'augmenter la sécurité du

système.

· Activer support LDAP : cette option

permet à

des applications supportant

PAM d'utiliser LDAP pour l'authentification. Nous

cliquons sur le bouton pour spécifier les

éléments suivants :

Configurer LDAP

> Utiliser TLS pour crypter les mots de

passe : cette option permet d'utiliser Transport Layer Security pour

crypter des mots de passe envoyés sur le serveur LDAP.

> DN de la base de recherche LDAP : cette

option permet d'extraire les informations utilisateurs d'après son Nom

Distinct (ou DN de l'anglais 'Distinguished Name').

> Serveur LDAP : cette option permet de

spécifier l'adresse IP du serveur LDAP. Le paquetage openldap-clients

doit être installé pour que cette option puisse fonctionner.

· Activer le support Kerberos : cette

option permet d'activer l'authentification Kerberos. Nous cliquons sur le

bouton Configurer Kerberos pour effectuer la configuration

:

> Zone : cette option permet de

configurer la zone (ou 'Realm') du serveur Kerberos. La zone correspond au

réseau utilisant Kerberos, composée d'un ou plusieurs KDC et

potentiellement, d'un nombre important de clients.

> KDC : cette option permet de

définir le centre de distributeur de tickets (ou KDC, de l'anglais 'Key

Distribution Center'), le serveur émettant les tickets de Kerberos.

> Serveurs Admin : cette option permet de

spécifier les serveurs d'administration exécutant kadmind. Les

paquetages krb5-libs et krb5- workstation doivent être installés

pour que cette option puisse fonctionner.

· Activer support SMB : cette option

permet de configurer les PAM (les modules d'authentification enfichables) de

manière à ce qu'ils utilisent un serveur SMB pour authentifier

les utilisateurs. Cliquez sur le bouton Configurer SMB pour

spécifier les éléments suivants:

> Groupe de travail : cette option permet

de spécifier le groupe de travail SMB à utiliser.

> Contrôleurs de domaine : cette

option permet de spécifier les contrôleurs de domaine SMB à

utiliser.

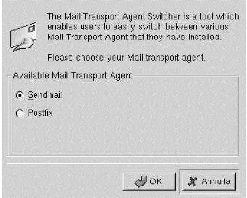

Pour notre cas, comme nous devons aussi mettre en place un

serveur de messagerie avec le serveur Sendmail nous allons activer LDAP pour

permettre une meilleur authentification des utilisateurs.

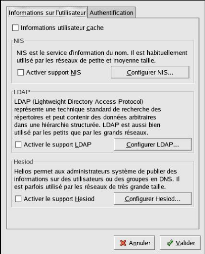

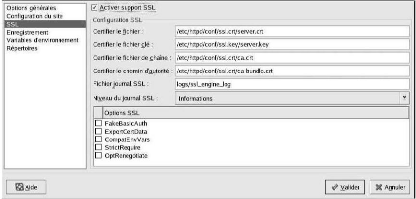

VIII. CONFIGURATION DU SERVEUR HTTP APACHE

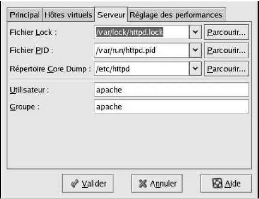

L'Outil de configuration HTTP nous permet de configurer le

fichier de configuration /etc/httpd/conf/httpd.conf pour le Serveur

HTTP Apache. Il n'utilise pas les anciens fichiers de configuration

srm.conf ou access.conf ; nous pouvons donc les laisser

vides. Il est possible, à partir de l'interface graphique, de configurer

des directives telles que des hôtes virtuels, des attributs de

journalisation ou encore un nombre maximal de connexions. Seuls les modules

livrés avec Red Hat Linux peuvent être configurés avec

l'Outil de configuration

HTTP. Si nous installons des modules supplémentaires,

il ne nous sera pas possible de les configurer à l'aide de cet outil.

Les paquetages rpm httpd et

redhat-config-httpd doivent être préalablement

installés si nous souhaitons utiliser l'Outil de configuration HTTP.

Pour son fonctionnement, il a également besoin du système X

Windows et des privilèges de superutilisateur (ou root). Pour

démarrer l'application, nous nous rendons au bouton Menu

principal => Paramètres de système => Paramètres de

serveur => Serveur HTTP ou nous tapons la commande

redhat-config-httpd à l'invite du Shell (dans un terminal XTerm

ou GNOME).

Attention

Il ne faudrait pas éditer manuellement le fichier de

configuration /etc/httpd/conf/httpd.conf si l'on désire

utiliser cet outil. L'Outil de configuration HTTP génère

automatiquement ce fichier une fois que nous avons enregistré nos

changements et quitté le programme. Si l'on souhaite ajouter des modules

supplémentaires ou des options de configuration qui ne sont pas

disponibles dans l'Outil de configuration HTTP, nous ne pouvons pas utiliser

cet outil.

Ci-dessous figurent les étapes principales de la

configuration du Serveur HTTP Apache à l'aide de l'Outil de

configuration HTTP :

1. Configurer les paramètres de base dans l'onglet

Main (Principal).

2. Cliquer sur l'onglet Virtual Hosts (Hôtes virtuels) et

configurer les paramètres par défaut.

3. Dans l'onglet Virtual Hosts (Hôtes virtuels),

configurer l'hôte virtuel par défaut.

4. Si l'on souhaite servir plusieurs URL ou hôtes

virtuels, on ajoute les hôtes virtuels supplémentaires.

5. Configurer les paramètres du serveur dans l'onglet

Server (serveur).

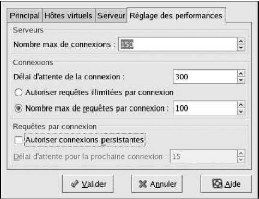

6. Configurer les paramètres de connexion dans l'onglet

Performance Tuning (Réglage des performances).

7. Copier tous les fichiers nécessaires dans les

répertoires DocumentRoot et cgi-bin.

8. Quitter l'application et choisir d'enregistrer les

paramètres.

a) PARAMETRES DE BASE

Nous utilisons l'onglet Main (Principal) pour

configurer les paramètres de base du serveur.

Figure : Paramètres de base

De cette manière nous entrons un nom de domaine

pleinement qualifié pour lequel nous avons des autorisations

d'accès dans la zone de texte Server Name (Nom de

serveur). Cette option correspond à la directive ServerName dans

httpd.conf. Cette directive ServerName définie le nom d'hôte du

serveur Web. Elle est utilisée lors de la création d'URL de

retransmission. Si nous ne définissons pas de nom de serveur, le serveur

Web essaie de le résoudre à partir de l'adresse IP du

système. Le nom de serveur ne doit pas forcément être

identique au nom de domaine résolu à partir de l'adresse IP du

serveur.

Nous entrons alors l'adresse électronique de la

personne qui met à jour le serveur Web dans la zone de texte

Adresse électronique du Webmaster. Cette option

correspond à la directive ServerAdmin dans httpd.conf. Nous configurons

les pages d'erreur du serveur de façon à ce qu'elles contiennent

une adresse électronique, celle-ci sera alors utilisée pour

transmettre tout problème à l'administrateur du serveur. La

valeur par défaut est root@enerca. Nous utilisons la zone

Available Addresses (Adresses disponibles) pour définir

les ports sur lesquels le serveur acceptera les requêtes entrantes. Cette

option correspond à la directive Listen dans httpd.conf. Par

défaut, Red Hat configure le Serveur HTTP Apache de manière

à ce qu'il écoute le port 80 pour des communications Web

non-sécurisées.

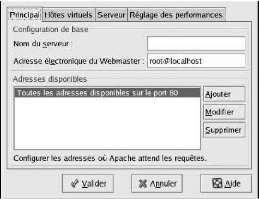

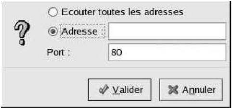

Pour cela nous cliquons sur le bouton Add

pour définir des ports supplémentaires pour la réception

de requêtes. Une fenêtre semblable à celle reproduite dans

la Figure ci dessous apparaîtra. Nous pouvons choisir, soit l'option

Listen to all addresses pour écouter toutes les

adresses IP sur le port défini, ou nous pouvons spécifier une

adresse IP spécifique à laquelle le serveur acceptera des

connexions dans le champ d'adresse, Address.

Figure : Adresses disponibles

Après avoir défini un Nom du

serveur, l'adresse électronique du Webmaster

et Adresses disponibles, nous cliquons sur l'onglet

Hôtes virtuels puis sur le bouton Modifier les paramètres par

défaut. La fenêtre reproduite dans la Figure ci dessous s'ouvre

alors. Nous configurons les paramètres par défaut pour le serveur

Web dans cette fenêtre. En ajoutant un hôte virtuel, les

paramètres que nous indiquons ont la priorité pour cet hôte

virtuel. Si une directive n'est pas définie dans les paramètres

de l'hôte virtuel, la valeur par défaut est utilisée. Les

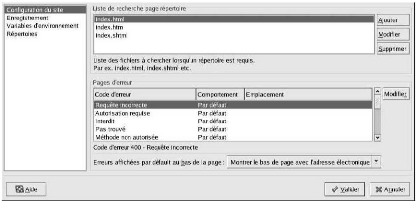

valeurs par défaut de Liste de recherche page répertoire et Page

d'erreur fonctionnent pour la plupart des serveurs.

Figure : Configuration du site

Les entrées énumérées dans Liste

de recherche de pages répertoires définissent la directive

DirectoryIndex. DirectoryIndex est la page

par défaut renvoyée par le serveur lorsqu'un utilisateur demande

l'index d'un répertoire en ajoutant une barre oblique (/) à la

fin du nom de ce répertoire.

Par exemple, lorsque des utilisateurs demandent la page

http://www.enerca.cf/hope/,

ils recevront soit la page Hope, si elle existe, soit une liste de

répertoires générée par le serveur. Ce dernier

essaiera de trouver un des fichiers listés dans la directive Hope et

renverra le premier qu'il trouvera. S'il ne trouve aucun de ces fichiers et que

cette Options Indexes à

ce répertoire comme valeur, le serveur

générera une liste des sous-répertoires et fichiers

contenus dans ce répertoire et la renverra, dans un format HTML.

Nous utilisons la section Code d'erreur pour configurer le

Serveur HTTP Apache afin qu'il redirige le client vers une URL locale ou

externe en cas de problème ou d'erreur. Cette option correspond à

la directive ErrorDocument. Si un problème ou une erreur survient

lorsqu'un client essaie de se connecter au Serveur HTTP Apache, le bref message

d'erreur indiqué dans la colonne Code d'erreur s'affiche par

défaut. Pour remplacer cette configuration par défaut, nous

sélectionnons le code d'erreur et cliquons sur le bouton Modifier. Nous

choisissons Défaut afin d'afficher le message d'erreur par

défaut. Nous sélectionnons URL pour rediriger le client vers une

URL externe et entrons une URL complète, y compris

http:// dans le champ Emplacement.

Nous sélectionnons Fichier pour rediriger le client vers une URL interne

et entrons un emplacement de fichier sous le document root du serveur Web.

L'emplacement doit commencer par une barre oblique (/) et être relatif au

document root. Par exemple, pour rediriger un code d'erreur "404 Not Found"

(impossible de trouver la page) vers une page Web que nous avons

créée dans un fichier nommé 404.html, nous copions

404.html dans DocumentRoot/errors/404.html. Dans ce cas, DocumentRoot

correspond au répertoire Document Root que nous avons défini (la

valeur par défaut est /var/www/html). Nous sélectionnons ensuite

Fichier comme comportement pour le code d'erreur 404 - Not Found et entrer

/errors/404.html dans le champ Emplacement.

Nous choisissons l'une des options suivantes dans le menu

Erreurs affichées par défaut au bas de la page :

· Montrer le bas de page avec adresse

électronique .affiche le bas de page par défaut sur chacune des

pages d'erreur ainsi que l'adresse électronique de l'administrateur du

site Web spécifiés par la directive ServerAdmin.

· Montrer le bas de page. n'affiche que le bas de page

par défaut sur les pages d'erreur.

· Aucun bas de page. n'affiche aucun bas de page sur les

pages d'erreur.

b) JOURNALISATION

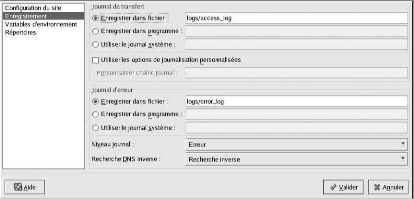

Par défaut, le serveur enregistre le journal des

transferts dans le fichier /var/log/httpd/access_log et le journal des

erreurs dans le fichier /var/log/httpd/error_log.

Le journal des transferts contient la liste de toutes les

tentatives d'accès au serveur Web. Il enregistre l'adresse IP des

clients qui essaient de se connecter, la date ainsi que l'heure de leurs

tentatives et les fichiers du serveur Web auxquels ils veulent accéder.

Nous entrons le chemin d'accès et le nom du fichier où

enregistrer ces informations. Si le chemin d'accès et le nom de fichier

ne commencent pas par une barre oblique (/), le chemin est alors relatif au

répertoire root du serveur, tel que nous l'avons configuré. Cette

option correspond à la directive TransferLog.

Figure : Journalisation

Nous pouvons configurer un format de journal

personnalisé en cochant l'option Utiliser les options de

journalisation personnalisées et en entrant une chaîne de

journal personnalisée dans le champ Personnaliser chaîne

journal. Cela permet de configurer la directive LogFormat.

Le journal des erreurs contient une liste des erreurs de

serveur. Nous devons entrer le chemin d'accès et le nom du fichier

où enregistrer ces informations. Si le chemin d'accès et le nom

de fichier ne commencent pas par une barre oblique (/), le chemin est alors

relatif au répertoire root du serveur, tel que nous l'avons

configuré. Cette option correspond à la directive ErrorLog. Nous

utilisons le menu Niveau journal afin de définir le degré de

prolixité des messages dans le journal des erreurs. Nous avons le choix

(du moins prolixe au plus prolixe) entre emerg, alert, crit, error, warn,

notice, info et debug. Cette option correspond à la

directive LogLevel.

La valeur choisie dans le menu Recherche DNS

inverse définit la directive HostnameLookups. Ne choisir

Aucune recherche inverse (No Reverse Lookup) configure la

valeur sur "off". Choisir Recherche inverse (Reverse Lookup)

configure la valeur sur "on". Choisir Double recherche inverse

(Double Reverse Lookup) configure la valeur sur "double". Nous

sélectionnons Recherche inverse, le serveur

résout automatiquement l'adresse IP de chaque connexion qui demande un

document au serveur Web. Cela signifie que notre serveur effectue une ou

plusieurs connexions au DNS afin de trouver le nom d'hôte correspondant

à une adresse IP donnée.

Si nous sélectionnons Double recherche

inverse, notre serveur effectue une double recherche DNS. Autrement

dit, après avoir effectué une recherche inverse, le serveur en

effectue une deuxième sur le résultat obtenu. Au moins une des

adresses IP de la seconde recherche doit correspondre à l'une des

adresses de la première. En règle générale, nous

devrions conserver la valeur Aucune recherche inverse pour

cette option car les requêtes

DNS ajoutent une charge à notre serveur et risquent de

le ralentir. Si notre serveur est très occupé, ces recherches,

qu'elles soient simples ou doubles, peuvent avoir un effet assez

perceptible.

De plus, les recherches inverses et doubles recherches

inverses affectent l'activité Internet en général. Toutes

les connexions individuelles effectuées pour vérifier les noms

d'hôte s'additionnent. Aussi, pour le bien de notre propre serveur Web et

de l'Internet, nous conservons la valeur Aucune recherche inverse. Il est

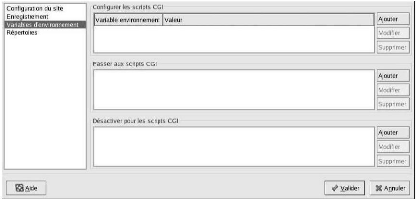

parfois nécessaire de modifier des variables d'environnement pour les

scripts CGI et les pages à inclure (SSI) au niveau du serveur. Le

Serveur HTTP Apache peut utiliser le module mod_env pour configurer les

variables d'environnement transmises aux scripts CGI et aux pages SSI. Nous

utilisons la page Variables d'environnement pour configurer les directives de

ce module.

Figure : Variables d'environnement

Nous utilisons la section Configurer les scripts

CGI pour définir une variable d'environnement transmise aux

scripts CGI et aux pages SSI. Exemple, pour donner à la variable

d'environnement MAXNUM la valeur 50, nous cliquons sur le bouton Ajouter dans

la section Configurer les scripts CGI comme le montre la

Figure : Variables d'environnement et tapons MAXNUM

dans le champ de texte Variable d'environnement et 50 dans le

champ de texte Valeur à définir. Nous cliquons

ensuite sur OK pour l'ajouter à la liste. La section

Configurer les scripts CGI sert à configurer la

directive SetEnv. Nous utilisons la section Transmettre aux scripts CGI pour

transmettre la valeur d'une variable d'environnement aux scripts CGI lorsque le

serveur est lancé pour la première fois. Pour visualiser cette

variable d'environnement, nous entrons la commande env à

l'invite du Shell. Nous cliquons sur le bouton Ajouter dans la

section Transmettre aux scripts CGI et entrons le nom de la

variable dans la boîte de dialogue. Puis nous cliquons ensuite sur

OK pour l'ajouter à la liste. La section

Transmettre aux scripts CGI configure la directive PassEnv. Si

nous voulons supprimer une variable d'environnement afin que sa valeur ne soit

pas transmise aux scripts CGI et aux pages SSI, nous utilisons la section

Désélectionner pour les scripts CGI. Nous

cliquons sur Ajouter dans la section

Désélectionner pour les scripts

CGI et entrons le nom de la variable d'environnement à

désélectionner. Puis nous cliquons sur

OK pour l'ajouter à la liste. Cela correspond à

la directive UnsetEnv directive.

Pour modifier une de ces valeurs d'environnement, nous la

sélectionnons parmi la liste et cliquons sur le bouton

Éditer correspondant. Pour supprimer toute

entrée de la liste, nous la sélectionnons puis cliquons sur le

bouton Supprimer correspondant.

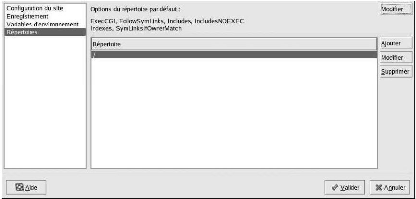

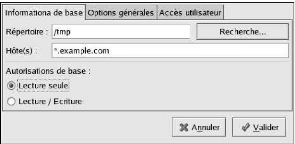

c) REPERTOIRES

Nous utilisons la page Répertoires pour configurer des

options de répertoires spécifiques. Cela correspond à la

directive « Répertoires ».

Figure : Répertoires

Nous cliquons sur le bouton Modifier dans le coin

supérieur droit afin de configurer les Options par défaut des

répertoires pour tous les répertoires non spécifiés

dans la liste Répertoire ci-dessous. Les options que vous

sélectionnez sont énumérées en tant que directive

d'options dans la directive « Directory ». Nous pouvons configurer

les options suivantes:

· ExecCGI : permet l'exécution de scripts CGI. Les

scripts CGI ne sont pas exécutés si cette option n'est pas

sélectionnée.

· FollowSymLinks : permet aux liens symboliques

d'être suivis.

· Includes : permet les inclusions sur le serveur.

· IncludesNOEXEC : permet les inclusions sur le serveur,

mais désactive les commandes #exec et #include dans les scripts CGI.

· Indexes : affiche une liste formatée du contenu

d'un répertoire, si aucun DirectoryIndex (tel que index.html) n'existe

dans le répertoire demandé.

· Multiview.prend en charge la multi vue à contenu

variable; cette option est désactivée par défaut.

· SymLinksIfOwnerMatch : suit les liens symboliques

uniquement si le propriétaire du fichier ou du répertoire cible

est le même que celui du lien.

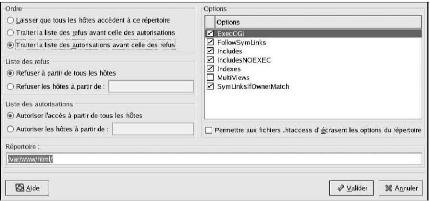

Pour spécifier des options pour des répertoires

particuliers, nous devons cliquer sur le bouton Ajouter

situé près de la zone de liste Répertoire. La

fenêtre présentée dans la Figure :

Paramètres des répertoires s'ouvre alors.

Nous entrons le répertoire à configurer dans le

champ Répertoire situé au bas de la fenêtre. Nous

sélectionnons les options dans la liste située à droite et

configurons la directive Order au moyen des options

situées à gauche. La directive Order

contrôle l'ordre dans lequel les directives d'autorisation et de refus

sont évaluées. Dans les champs de texte Autoriser les

hôtes à partir de et Refuser les hôtes

à partir de, nous pouvons spécifier l'un des

éléments suivants:

· Autoriser tous les hôtes : nous entrons

all pour autoriser l'accès à tous les

hôtes.

· Nom de domaine partiel : autorise tous les hôtes

dont le nom correspond à, ou se termine par, une chaîne

spécifique.

· Adresse IP complète : accorde l'accès

à une adresse IP spécifique.

· Un sous-réseau : par exemple

192.168.1.0/255.255.255.0

· Une spécification CIDR de réseau par

exemple 10.3.0.0/16

Figure : Paramètres des

répertoires

Nous cochons la case Permettre aux fichiers .htaccess

d'écraser les options du répertoire, les directives de

configuration du fichier .htaccess ont la priorité.

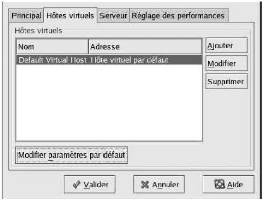

Nous utilisons l'Outil de configuration HTTP pour configurer des

hôtes virtuels. Les hôtes virtuels nous permettent

d'exécuter différents serveurs pour différentes adresses

IP, différents noms d'hôte ou différents ports sur un

même ordinateur. Par exemple, nous pouvons exécuter les sites Web

http://www.enerca.com et

http://www.centrale-energie.com

sur le même serveur Web à l'aide d'hôtes virtuels. Cette