|

Etude du calage, de la validation et des performances des réseaux de neurones formels à partir des données hydro-climatiques du bassin versant du Bandama blanc en Côte d'Ivoire( Télécharger le fichier original )par Yao Blaise KOFFI Université de Cocody Abidjan - Doctorat 2007 |

des connexions (Wij, i=1, m). Wij est le poids de la connexion qui lie l'entrée Xi au neurone nj. Wij est positif, si la série Xi doit augmenter la sortie du neurone nj et Wij est négatif, si Xi doit la diminuer ; ii. la fonction neurone (fj) sert à limiter la sortie du neurone nj dans un intervalle prédéfini et/ou augmenter la non linéarité du neurone. Le modèle du neurone peut inclure une valeur limite appelée Seuil (S). Dans la littérature le mot seuil est souvent remplacé par le terme biais. Lorsque le niveau d'activation, (la somme pondérée WijXi) atteint ou dépasse ce biais, alors l'argument de la fonction d'activation devient positif ou nul ; sinon, il est négatif (Parizeau, 2004). L'équation de la sortie calculée est donnée par la relation (1). Outj = fj(In j ) (1) Inj = WijXi-Si (2) Avec : Inj : l'entrée de la fonction d'activation du neurone j ; Outj : la sortie de la fonction d'activation du neurone j ; Xi : l'entrée i connectée au neurone j ; Wij : le poids de la connexion entre l'entrée Xi et le neurone j ; Sj : le seuil du neurone j ; m : le nombre d'entrées connectées au neurone j ; f : la fonction d'activation du neurone j. Le schéma d'un neurone formel adapté des travaux d'Awadallah (1999) est présenté à la figure 19.

S Xi Xi+1 i m = 1 W X ij i / Out f W X S = ij i i - m i = 1 Xm Unité d'addition Unité d'activation Figure 19 : Schéma d'un neurone formel La modélisation pluie-débit, objectif de ce travail de recherche ne s'intéresse pas aux neurones pris individuellement mais plutôt à leurs différentes combinaisons en réseaux. 3.5. ORGANISATION DES NEURONES EN RÉSEAUXUn réseau de neurones est un maillage de plusieurs neurones, généralement organisés en couches. Les connexions entre les neurones, définies précédemment, qui composent le réseau décrivent la topologie ou l'architecture du modèle. Elle peut être quelconque, mais le plus souvent, dans la littérature, il est possible de distinguer une certaine régularité, (Touzet ,1992). Selon le chemin suivi par l'information dans le réseau on peut classer les réseaux de neurones en deux grandes catégories : les réseaux «feed-forward» et les réseaux «feed-back». 3.5.1. Réseaux «feed-forward»Les réseaux «feed-forward» ou réseaux «nourrir en avant» appelés aussi «réseaux de type Perceptron», sont des réseaux dans lesquels l'information se propage de couche en couche, sans retour possible en arrière. Nous pouvons citer parmi ces réseaux les Perceptrons (objet de cette étude) et les réseaux à fonction radiale. 3.5.1.1. Modèle perceptronsIl existe deux modèles Perceptrons : les modèles Perceptrons Monocouches et les modèles Perceptrons Multicouches (PMC). Le Perceptron Monocouche est historiquement le premier réseau de neurones, c'est le Perceptron de Rosenblatt. C'est un réseau simple, puisqu'il ne se compose que d'une couche d'entrée et d'une couche de sortie. Il est calqué, à la base, sur le système visuel et de ce fait a été conçu dans un but premier de reconnaissance des formes. Cependant, il peut aussi être utilisé pour faire de la classification et/ou pour résoudre des opérations logiques simples («ET» ou «OU»). Sa principale limite est qu'il ne peut résoudre que des problèmes linéairement séparables, ce qui diffère de la relation pluie-débit qui est non-linéaire. Il suit généralement un apprentissage de type supervisé selon la règle de correction de l'erreur (ou selon la règle de Hebb (Parizeau, 2004)). La typologie des apprentissages sera détaillée dans la suite de cette étude. La figure 20 représente un Perceptron Multicouches simplifié avec une seule couche de neurones cachés. Les variables d'entrée sont la pluie et la température et la variable cible est le débit.

Figure 20 : Perceptron Multicouche simplifié avec une seule couche de neurones cachés Le Perceptron Multicouches (PMC) est une extension du précédent, avec une ou plusieurs couches cachées entre l'entrée et la sortie. Chaque neurone dans une couche est connecté à tous les neurones de la couche précédente et de la couche suivante (excepté pour les couches d'entrée et de sortie) et il n'y a pas de connexions entre les cellules d'une même couche. Ce type de réseaux a été récemment classé comme outil de prévision et de simulation des débits (Fortin et al., 1997). Cependant, ces applications se sont largement diversifiées et les fonctions d'activation utilisées dans ce type de réseaux sont principalement les fonctions à seuil ou sigmoïdes. Il peut résoudre des problèmes non-linéairement séparables et des problèmes logiques plus compliqués comme la relation pluie-débit. Il suit aussi un apprentissage supervisé selon la règle de correction de l'erreur. Le Perceptron Multicouches est le Réseau de neurones le plus utilisé en modélisation hydrologique (Coulibaly et al., 1999). Plusieurs auteurs considèrent que ce type de réseau comprend trois groupes de neurones. Par exemple, Awadallah, (1999) identifie trois groupes de neurones : un groupe d'entrée, un groupe intermédiaire et un groupe de sortie. Cette considération, faite notamment par plusieurs auteurs, paraît «impropre» ; car, d'après Dreyfus et al. (2004), la couche des entrées n'effectue aucune modification de l'information donc ne fait aucun calcul. L'équation générale d'un réseau de neurones formels de type Perceptron Multicouches, avec une seule couche cachée et une seule sortie scalaire, est formulée comme suit : m n (3) Y f Wo f Wh X b b = * + + 2 j * 1 ij i 1 2 j= 1 i = 1 Où : Y : est la sortie calculée par le réseau, f2 : est la fonction d'activation du neurone de la couche de sortie, m : est le nombre de neurones cachés, n : est le nombre de variables d'entrée Woj : est le poids de la connexion entre la jième neurone sur la couche cachée et le neurone de sortie, f1 : est la fonction d'activation du neurone de la couche cachée, Whij : est le poids entre la iième entrée et le jième neurone sur la couche cachée, Xi : est la matrice d'entrée, b1 : est le biais de la fonction d'activation du jième neurone caché, b2 : est le biais de la fonction d'activation du neurone de sortie. Pour la classification des Perceptrons Multicouches deux critères peuvent être considérés :

3.5.1.2. Architecture des Réseaux de neurones FormelsUn réseau de neurones formels, comme déjà mentionné, est un ensemble de neurones formels associés sous forme de couches. Les réseaux de neurones formels ont la capacité de stocker de la connaissance empirique et de la rendre disponible pour un usage donné. La connaissance du réseau va être stockée dans les coefficients synaptiques, calculés par des processus d'adaptation ou d'apprentissage (encore appelé adaptation ou calage). En ce sens, les réseaux de neurones formels ressemblent donc à un cerveau car non seulement, la connaissance est acquise au travers d'un apprentissage mais plus, cette connaissance est soit stockée dans les

- 45 - connexions entre les entrées, soit dans les coefficients synaptiques. Deux (2) architectures générales se distinguent : le réseau non bouclé et le réseau bouclé.

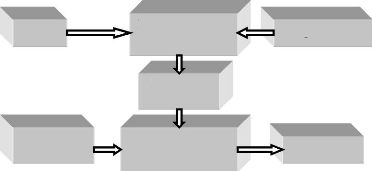

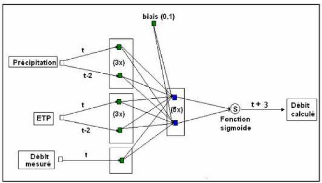

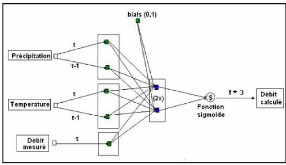

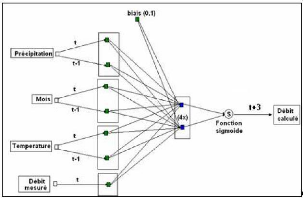

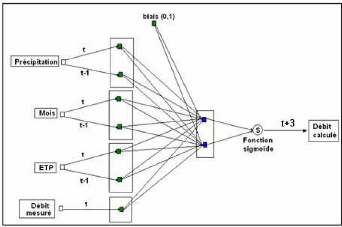

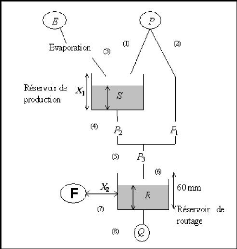

Dans les réseaux bouclés, la sortie de certains neurones est renvoyée sur l'entrée de neurones de la même couche ou d'une couche inférieure. Ce bouclage donne un comportement dynamique au réseau, la sortie ne dépend plus seulement des entrées du réseau, mais également de sa sortie aux instants précédents. Deux types de bouclages peuvent être réalisés, ce qui constitue deux types de réseaux distincts : les réseaux bouclés non dirigés et les réseaux bouclés dirigés. Les réseaux bouclés non dirigés (Figure 21) réalisent un bouclage avec les débits calculés. Ces modèles sont particulièrement intéressants, car lors de la simulation ou la prévision d'un événement (après apprentissage), la connaissance de la sortie à un pas de temps ultérieur permet de recadrer la sortie prévue. Ces modèles donnent de bons résultats notamment dans l'étude de la relation pluie-débit. Il s'agit du modèle le plus intéressant en matière de prévision des crues (Eurisouké, 2006) car les débits calculés par le réseau sont réinjectés et donc ne nécessitent pas d'autres données. Les Réseaux Bouclés Dirigés réalisent un bouclage, non plus sur la sortie calculée par le modèle à un temps t-1, mais par la sortie désirée à un temps t-1 sur les débits observés (Figure 22). Figure 21 : Réseau Bouclé Non Dirigé

Figure 22 : Réseau Bouclé Dirigé Ce bouclage permet au réseau de pouvoir se caler après son apprentissage sur les vraies valeurs. Les résultats de prévisions et/ou de simulations avec ce type de réseau donne généralement d'excellents résultats, notamment dans le cadre de la prévision pluie-débit (Eurisouké, 2006). Toutefois l'intérêt de ce type de réseau dans le cadre de la prévision reste limité si le délai de prévision et/ou de simulation est proche. Les réseaux non bouclés et les réseaux bouclés présentés précédemment comprennent comme variables explicatives la pluie et la température. La variable cible est le débit. Le présent travail de recherche s'intéressera à ces deux modèles, plus particulièrement à ces deux types de réseau : les Réseaux Non Bouclés et les Réseaux Bouclés Dirigés. Les Réseaux Non Bouclés utilisés seront nommés Perceptrons Multicouches Non Dirigés(PMCND) et les réseaux dirigés, Perceptrons Multicouches Dirigés (PMCD). 3.5.2. Réseaux à fonction radialeLes réseaux à fonction radiale sont les réseaux que l'on reconnaît aussi sous le vocable RBF pour «Radial Basic Functions». L'architecture est la même que pour les PMC, cependant, les fonctions de base utilisées ici sont des fonctions Gaussiennes. Les RBF seront donc employés dans les mêmes types de problèmes que les PMC à savoir la classification et l'approximation de fonctions (Parizeau, 2004). L'apprentissage le plus utilisé pour les RBF est le mode hybride qui fait intervenir les modes supervisés et non supervisés définis dans les paragraphes suivants et les règles sont soit la règle de correction de l'erreur, soit la règle d'apprentissage par compétition. 3.5.3. Réseaux "feed - back"Appelés aussi «réseaux récurrents», ce sont des réseaux dans lesquels il y a retour en arrière de l'information. Ces réseaux ramènent l'information en arrière de manière inverse par rapport au sens de propagation défini dans un réseau Multicouche. Ces connexions sont le plus souvent locales, (Touzet, 1992). 3.5.4. Cartes auto - organisatrices de KohonenCe sont des réseaux à apprentissage non-supervisé qui modifient leurs paramètres en fonction des régularités statistiques des entrées et établissent des catégorisations. Ils génèrent à la fin une carte discrète ordonnée topologiquement en fonction des différentes données d'entrée. Le réseau forme ainsi une sorte de treillis dont chaque noeud est un neurone associé à un vecteur de poids. La correspondance entre chaque vecteur de poids est calculée pour chaque entrée. Par la suite, le vecteur de poids ayant la meilleure corrélation, ainsi que certains de ses voisins, vont être modifiés afin d'augmenter encore cette corrélation (Parizeau, 2004 ; Dreyfus et al., 2004). 3.5.5. Réseaux de HopfieldLes réseaux de Hopfield sont des réseaux récurrents et entièrement connectés (Johannet, 2006). Dans ce type de réseau, chaque neurone est connecté à chaque autre neurone et il n'y a aucune différenciation entre les neurones d'entrées et de sorties. Ils fonctionnent comme une mémoire associative non-linéaire et sont capables de trouver un objet stocké en fonction de représentations partielles ou bruitées. L'application principale des réseaux de Hopfield est l'entrepôt de connaissances, mais aussi la résolution de problèmes d'optimisation. Le mode d'apprentissage utilisé ici est le mode non-supervisé. 3.5.6. Réseaux à apprentissage par compétition ou « Adaptative Resonnance Theory » (ART)Les réseaux ART « Adaptative Resonnance Theory » sont des réseaux à apprentissage par compétition. Le problème majeur qui se pose dans ce type de réseaux est le dilemme "stabilité/plasticité". En effet, dans un apprentissage par compétition, rien ne garantit que les catégories formées resteront stables. La seule possibilité, pour assurer la stabilité, serait que le coefficient d'apprentissage tende vers zéro, mais le réseau perdrait alors sa plasticité. Les ART ont été conçus spécifiquement pour contourner ce problème. Dans ce genre de réseau, les vecteurs de poids ne seront adaptés que si l'entrée fournie est suffisamment proche, d'un prototype déjà connu par le réseau ; on parlera alors de résonnance. A l'inverse, si l'entrée s'éloigne trop des prototypes existants, une nouvelle catégorie va alors se créer, avec pour prototype, l'entrée qui a engendrée sa création. Il est à noter qu'il existe deux principaux types de réseaux ART : les ART-1 pour des entrées binaires et les ART-2 pour des entrées continues. Le mode d'apprentissage des ART peut être supervisé ou non. Les différents réseaux de neurones peuvent être résumés comme ce qu'indique la figure 23.

Figure 23 : Récapitulatif des

Principales architectures des réseaux de neurones formels

(RNF) 3.6. APPRENTISSAGE DES RÉSEAUX DE NEURONESPour un modèle type réseau de neurones, l'apprentissage peut être considéré comme le problème de la mise à jour des poids des connexions au sein du réseau, afin de réussir la tâche qui lui est demandée. En effet, parmi les propriétés des réseaux de neurones, la plus fondamentale est sûrement la capacité d'apprendre, et donc d'améliorer sa performance à travers un processus d'apprentissage ou de calage. Cependant, dans la littérature, il n'existe pas de définition générale, universellement acceptée ; car, ce concept touche, d'après Parizeau (2004), à trop de notions distinctes qui dépendent du point de vue du modélisateur. Il donne alors la définition suivante : "L'apprentissage est un processus dynamique et itératif permettant de modifier les paramètres d'un réseau de neurones en réaction avec les stimuli qu'il reçoit de son environnement". L'apprentissage étant la caractéristique principale des réseaux de neurones formels, il peut se faire de différentes manières et selon différentes règles. C'est le lieu ici de faire la part des choses entre mode d'apprentissage et règle d'apprentissage. Le mode d'apprentissage intéresse la manière dont les changements de paramètres surviennent pendant le processus ; et, la règle d'apprentissage concerne le type d'algorithme mathématique utilisé. Au niveau du mode d'apprentissage, Roussillon, (2004) détermine deux classes à savoir l'apprentissage supervisé et l'apprentissage non supervisé. Parizeau (2004), va plus loin et détermine trois types d'apprentissage : le mode supervisé, le mode renforcé et le mode non-supervisé. On peut ajouter à ces trois types d'apprentissage, le mode hybride. Concernant les règles d'apprentissage, on en dénombre quatre : la règle de correction de l'erreur, la règle de Boltzmann, la règle de Hebb et enfin la règle par compétition. 3.6.1. Différentes approches d'apprentissageLes quatre modes d'apprentissage pour les réseaux de neurones sont ici présentés :

communs aux exemples présentés, et modifier les poids, afin de fournir la même sortie pour les entrées aux caractéristiques proches (Roussillon, 2004) ; iv. Mode hybride. : Le mode hybride comprend à la fois l'apprentissage supervisé et l'apprentissage non - supervisé. 3.6.2. Règles d'apprentissageLes quatre règles précédemment énoncées sont ici successivement énoncées. 3.6.2.1. Règle de correction d'erreursCette règle s'inscrit dans le paradigme d'apprentissage supervisé, c'est-à-dire dans le cas où l'on fournit au réseau une entrée et la sortie correspondante. Si on considère la variable y comme étant la sortie calculée par le réseau, et la variable d la sortie désirée, le principe de cette règle est d'utiliser l'erreur (d-y), afin de modifier les connexions et de diminuer ainsi l'erreur globale du système. Le réseau va donc s'adapter jusqu'à ce que y soit égal à d ou très proche. Ce principe est notamment utilisé dans le modèle Perceptron. 3.6.2.2. Règle de BoltzmannLes réseaux de Boltzmann sont des réseaux symétriques récurrents. Ils possèdent deux sousgroupes de cellules, le premier étant relié à l'environnement (cellules dites visibles) et le second ne l'étant pas (cellules dites cachées). Cette règle d'apprentissage est de type stochastique, relevant partiellement du hasard et consiste à ajuster les poids des connexions, de telle sorte que l'état des cellules visibles satisfasse une distribution probabiliste souhaitée. 3.6.2.3. Règle de HebbLa règle de Hebb, basée sur des données biologiques, modélise le fait que si des neurones, de part et d'autre d'une synapse, sont activés de façon synchrone et répétée, la force de la connexion synaptique augmente. Il est à noter ici que l'apprentissage est localisé, c'est-à-dire que la modification d'un poids synaptique wij ne dépend que de l'activation d'un neurone i et d'un autre neurone j. 3.6.2.4. Règle par compétitionsLa particularité de cette règle vient du fait que l'apprentissage ne concerne qu'un seul neurone. Le principe de cet apprentissage est de regrouper les données en catégories. Les patrons similaires vont donc être rangés dans une même classe, en se basant sur les corrélations des données, et seront représentés par un seul neurone, on parle de "winner-take- all". Dans un réseau à compétition simple, chaque neurone de sortie est connecté aux neurones de la couche d'entrée, aux autres cellules de la couche de sortie (connexions inhibitrices) et à elle-même (connexion excitatrice). La sortie va donc dépendre de la compétition entre les connexions inhibitrices et excitatrices. 3.7. DOMAINES D'APPLICATION DES RÉSEAUX DE NEURONESSe trouvant à l'intersection de différents domaines (informatique, électronique, sciences cognitives, neurobiologie et même philosophie), l'étude des réseaux de neurones formels (RNF) est une voie prometteuse de l'Intelligence Artificielle (IA), qui a des applications dans de nombreux domaines tels que l'industrie, les télécommunications, les sciences hydrologiques, etc.

Les paragraphes développés jusqu'à présent ont montré que les réseaux de neurones formels sont utilisés, avec succès, dans plusieurs domaines. Mais pourquoi est-ce que ces modèles arrivent à donner de très bons résultats ? L'objet du chapitre suivant est d'apporter des éléments de réponse à cette question. 3.8. PROPRIÉTÉS DES RÉSEAUX DE NEURONESLes nombreuses performances obtenues avec les modèles à base de réseaux de neurones sont généralement le fait des propriétés qu'ils possèdent. Mangeas (1997) et Haykin (1999) font la description de certaines propriétés telles que : la non linéarité ; la tolérance au manque d'information ; la résistance aux entrées aberrantes ; la possibilité de se passer de pré requis ; la non-unicité du modèle par rapport aux paramètres ; l'adaptabilité ; l'utilisation des données à leur état brut ; l'universalité et l'analogie avec la neurobiologie. 3.8.1. Non-linéaritéEtant donné que le neurone est un élément

non linéaire et que les neurones sont

parallèlement entrées et les sorties sont non linéaires comme c'est le cas entre la pluie et le débit mesurée en un point d'un bassin versant donné. Mais, cette non-linéarité ne dépend pas uniquement de la fonction d'activation, mais également de la norme des poids. Plus cette norme est petite, plus les entrées (In) parvenant aux neurones se situent au voisinage de zéro et plus les fonctions sigmoïdes utilisées sont proches des fonctions linéaires. 3.8.2. Tolérance au manque d'informationVu que la distribution de l'information est parallèle, l'endommagement d'un neurone, ou d'une connexion, ou bien la perte de données, ne provoque pas un échec irrémédiable dans la performance du réseau, mais seulement une dégradation moins sérieuse dans les résultats. Ceci est seulement vrai si la couche cachée est munie de suffisamment de neurones. Le calcul de la sortie étant mené par plusieurs neurones, il y a différents chemins pour relier l'entrée à la sortie. 3.8.3. Résistance aux entrées aberrantesDu fait des filtres saturants que constituent les fonctions d'activation sigmoïde, le réseau est résistant aux valeurs aberrantes qui pourraient se glisser dans les différentes séries hydroclimatiques dont nous disposons. Néanmoins, un réseau de neurones est prisonnier des données qui ont servi à sa calibration (apprentissage). Pour cette raison, des analyses statistiques sont nécessaires afin de détecter et de remplacer les données aberrantes de nos différentes séries. Si ces données ne sont pas réparties sur tout le continuum de leur variabilité, le réseau sera incapable d'extrapoler sur les données. Par contre, pour un modèle linéaire, il suffit que, les exemples pour l'estimation des paramètres se situent sur les extrémités de ce continuum. 3.8.4. Possibilité de se passer de pré requisLe Réseau de neurones est en principe capable de faire correspondre à un ensemble de sorties, un ensemble de données d'entrée, sans avoir recours pour cette opération à une distribution de probabilité des variables du modèle ou à un pré requis des relations entre elles, (Haykin, 1999). Cette notion, bien que présente dans plusieurs références de base sur les réseaux de neurones formels, n'est pas partagée par les statisticiens évoluant dans ce domaine. En fait, Bishop (1995) démontre que les Réseaux de neurones Formels requièrent les mêmes hypothèses de distribution que les autres modèles statistiques pour obtenir des estimations efficaces et optimales. 3.8.5. Non-unicité des modèles neuronaux par rapport aux paramètresDans les modèles neuronaux, on peut trouver deux ensembles de poids différents qui génèrent la même sortie. De même, un même ensemble d'entrées et de sorties peut aboutir à des ensembles de paramètres très différents à chaque fois que le réseau est entraîné. Les performances de ces différents modèles peuvent cependant être identiques. 3.8.6. AdaptabilitéLes modèles neuronaux pourraient être conçus de manière à changer les poids de leurs synapses en temps réel, en fonction des changements environnementaux. Ils peuvent donc opérer dans un environnement non stationnaire. 3.8.7. Utilisation des données dans leur état bruteEn principe, le Réseau de neurones fonctionne avec les données telles qu'elles sont, sans transformation pour rendre leur série homogène ou stationnaire, ou pour changer leur échelle. Néanmoins, il est préférable de standardiser les entrées et les sorties. Cette transformation permet au réseau de mieux éviter les minima locaux et d'avoir, pour une valeur d'initialisation des poids et seuils proches de zéro, une valeur plus proche du minimum global. Ceci est d'autant plus vrai pour les méthodes d'apprentissage de type gradient de la plus forte pente, telle que la rétro propagation définie dans la suite de ce mémoire. Ces méthodes sont très sensibles aux valeurs initiales. 3.8.8. Propriété d'universalité et analogie avec la neurobiologieL'universalité des analyses et des conceptions des

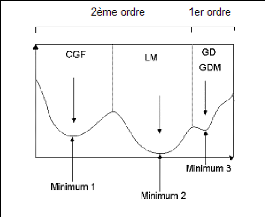

réseaux de neurones est la possibilité de différentes applications. En ce qui concerne l'analogie avec la neurobiologie, la science neurobiologique inspire le développement d'autres réseaux de neurones formels qui sont, à leur tour, des outils de recherche pour interpréter les phénomènes neurobiologiques. Malgré la grande variété des propriétés des réseaux de neurones, ci-dessus énumérées, qui permettent d'obtenir de très bons résultats lorsqu'ils sont utilisés en simulation et en prévision ; il est bon de remarquer que, ces modèles, tout comme les autres modèles hydrologiques, présentent toutefois des limites. Pour pallier à certaines de ces limites qui feront l'objet de la section cidessous, des précautions sont à prendre. 3.9. LIMITES ET PRÉCAUTIONS DANS LA MODÉLISATION AVEC LESRÉSEAUX DE NEURONES FORMELSDans la modélisation avec les Réseaux de neurones Formels, deux questions reviennent de façons récurrentes. La problématique des minima locaux et celle de la généralisation. 3.9.1. Problème des minima locauxPendant l'apprentissage, les paramètres tels que les poids et les biais peuvent converger vers des valeurs qui représentent des minima locaux de la fonction coût et non un minimum global. Atteindre le minimum global est une utopie, à cause de la complexité de la surface de la fonction de coût. Il faut, cependant y être le plus près possible pour représenter fidèlement les variables cibles à simuler ou à prévoir. Chitra, (1993) préconise trois approches pour éviter le plus possible les minima locaux et s'approcher des minima globaux :

La modélisation avec les réseaux de neurones formels est un compromis entre le sous apprentissage et le sur apprentissage. Il s'agit généralement d'éviter les minima locaux et de se rapprocher des maxima globaux. Le sou apprentissage est facile à résoudre, grâce à l'augmentation de la taille du réseau. Concernant le sur-apprentissage, plusieurs méthodes ont tenté de le résoudre, notamment l'élagage, l'arrêt prématuré et la régularisation (Awadallah, 1999). 3.9.2.1. ElagageL'élagage est une méthode d'élimination par pas descendant (stepwise en anglais) qui tend à éliminer les poids d'un réseau de neurones formels entièrement connecté. Cette méthode admet deux variantes, le dommage optimal du cerveau (optimal brain damage) et la variante du chirurgien optimal du cerveau (optimal brain surgeon). La première variante est basée sur le calcul de la matrice de dérivées secondes de la fonction coût en fonction des paramètres ; tandis que la seconde variante est basée sur le calcul de l'augmentation minimale de la fonction coût due à l'élimination d'un poids. Le réseau ainsi allégé est entraîné à nouveau et sa capacité de généralisation est testée à chaque fois. Cette méthode est coûteuse du point de vue temps et il existe un risque de tomber sur des réseaux instables pendant le processus. Dans la littérature, une méthode inverse existe (Awadallah, 1999). Avec cette méthode inverse, on commence par un réseau simple et on le rend complexe en ajoutant des neurones cachés. Le réseau de neurones formels retenu à la fin de tous ces processus est celui qui minimise au mieux l'erreur de généralisation. 3.9.2.2. Arret prematuréL'arrêt prématuré ou précoce (utilisé dans ce travail) consiste à utiliser beaucoup de neurones cachés pour éviter les minima locaux et en même temps réduire le temps d'apprentissage. Cette méthode agit indirectement sur le nombre effectif de paramètres. Elle est basée sur le concept statistique de la division d'échantillon (split-sampling). Les données d'entrée du modèle sont subdivisées en trois ensembles : un premier groupe pour l'apprentissage, un deuxième groupe pour la validation (pour arrêter l'apprentissage) et un troisième groupe pour le test (pour tester la généralisation du modèle). L'apprentissage est arrêté, avant qu'il atteigne le minimum, lorsque le critère d'erreur, mesuré sur l'ensemble de validation, commence à augmenter de façon constante. Le résultat obtenue avec cette méthode est biaisée vers l'ensemble de validation. Elle est très critiquée ; car, ni l'ensemble d'apprentissage, ni celui de validation, n'utilise l'échantillon dans sa totalité (Awadallah, 1999). 3.9.2.3. RégularisationLa troisième méthode joue sur les normes de la matrice des paramètres. Elle consiste à introduire un terme de pénalité dans la fonction coût pour restreindre progressivement l'espace du vecteur des paramètres dans un voisinage de zéro. L'expression de la fonction coût résultant est détaillée dans les travaux d'Awadallah (1999), McKay (1992) et Neal (1996). Ces travaux ont élaboré un cadre statistique basé sur la théorie baryesienne pour la détermination d'un coefficient de régularisation. 3.9.3. Limites conceptuelles pour la modélisation pluie-débitOutre les limites des réseaux de neurones ci-dessus signalées, liées généralement au processus d'apprentissage, la conception de ces modèles pour la modélisation pluie-débit pose d'autres problèmes à cause de leur appartenance aux modèles "boites noires". En effet, ces modèles ne permettent pas de cerner tout le processus qui a lieu en leur sein. Au stade actuel des recherches, aucun modélisateur ne peut donc donner une signification physique des différents poids de ces modèles. A cette limite, s'ajoute également celles de la qualité des données, des longues chroniques nécessaires, de l'impossibilité d'utiliser actuellement ces modèles sur des bassins versants non jaugés, etc. Toutefois, les recherches sont en cours pour tenter de remédier à ces limites et transformer les Réseaux de neurones Formels en des modèles "boites grises" avec moins de limites possibles. 3.10. ÉTAT DE LA MODÉLISATION PLUIE-DÉBIT AVEC LES RÉSEAUX DENEURONES FORMELS OU ARTIFICIELSDepuis les travaux de Mac Culloch et Pitts (1943), les modèles connexionnistes ont eu plusieurs applications dans différents domaines notamment l'hydrométéorologique où de bons résultats ont été obtenus dans les domaines de :

Depuis 1997 plusieurs centaines d'articles ont été publiés sur l'application des réseaux de neurones formels à la gestion des ressources en eau nécessaire à un Développement Durable. La moitié des applications hydrologiques des Réseaux de neurones Formels concernent la modélisation des débits, crues et étiages des cours d'eau. La période 2000 à 2005 fut marquée par la publication de nombreux travaux dans le domaine de la modélisation pluie-débits par Réseaux de neurones. On peut citer notamment les travaux de Li-chiu et al. (2004) ; Ashu et al. (2004) ; Young (2003) ; Masiyandina et al. (2003) ; Gunnar et Uhlenbrook (2003) ; Sudheer et al. (2003) ; Sudheer et al. (2002) ; Cameron et al. (2002) ; Abrahart et See (2000) et Schumann et al. (2000). Toujours dans le même axe de recherche que les auteurs cités ci-dessus, Wenri et al. (2004) ont développé un modèle de neurones pour la prévision des débits du fleuve Apalachicola (USA, Floride). Il s'agissait d'un modèle de type "feed-forward" entraîné avec la rétro propagation de l'erreur sur la période 1939-2000. Ce modèle a donné de très bons résultats au pas de temps journalier, mensuel, trimestriel et annuel avec respectivement 0,98 ; 0,95 ; 0,91 et 0,83 comme coefficients de corrélation de Pearson. Pour valider ces résultats, ces auteurs ont utilisé sur la même période un autre modèle de type ARIMA. Après comparaison des deux modèles, il ressort que le Réseau de neurones Formel est plus performant. De ces résultats, on peut donc dire que les Réseaux de neurones sont utilisables à tous les pas de temps en simulation et en prévision. Dechemi et al. (2003) ont utilisé les réseaux de neurones artificiels pour modéliser le binôme pluie-débit au pas de temps mensuel sur le bassin versant de la Cheffia du Nord Est algérien. L'architecture du réseau utilisé est de type (2-4-1) avec pour règle d'apprentissage l'algorithme de Levenberg Marquard qui est un apprentissage supervisé en bloc. Les résultats obtenus par ces auteurs ont été comparés à deux types de modèles : un modèle hydride neuronale-logique floue et des modèles conceptuels (modèles de Thornthwaite et GR2M). Ils conclurent que tous les modèles donnent de bonnes valeurs mais que le modèle hybride donne les meilleurs résultats, car ce modèle permet de décomposer le processus complexe en un processus physique plus simple. Sur le même bassin versant de Cheffia en Algérie, Tarik et Dechemi (2004), ont testé quatre modèles pluie-débit au pas de temps journalier. Ces modèles appartiennent à deux catégories : les modèles conceptuels, que sont le modèle GR3j, le modèle CREC à huit paramètres ; et les modèles de type «boîte noire», représentés par le modèle ARMAX (modèle autorégressif à moyenne mobile avec variables exogènes) et par un modèle neuroflou, qui combine un modèle structure neuronale et la logique floue. Les modèles ont été testés sur deux périodes, l'une sèche et l'autre humide. Ces auteurs, après comparaison des différents résultats, proposent une meilleure modélisation de la relation pluie-débit, au pas de temps journalier, en combinant l'approche conceptuelle et le modèle du système neuroflou. Une autre étude significative a été réalisée par Hsu et al. (1995). Ces auteurs ont proposé une procédure nommée LLSSIM pour « Linear Least Squares Simplex » pour une identification automatique des paramètres du RNA. Trois modèles neuronaux identifiés à l'aide de la technique LLSSIM sont comparés à deux autres modèles de prévisions classiques : ARMAX, SAC-SMA « Sacramento Soil Moisture Input Model », (U.S. National Weather Service). Les données hydrologiques (pluies et débits journaliers) utilisées sont celles du "Leaf River Basin " dans le Mississipi. En utilisant une seule année hydrologique pour la calibration des différents modèles (ARMAX, SAC-SMA, RNA) et cinq années pour leur validation, les résultats obtenus accordent les meilleures performances aux RNA aussi bien pour la calibration que pour la validation. De même, en calibrant les modèles sur 5 ans et en les validant sur 1 année, les meilleurs résultats sont obtenus par les RNA. Cependant, dans les deux cas, les "meilleurs résultats" obtenus par les modèles neuronaux sont variables de bon à mauvais : la prévision des débits de pointe est bonne, mais celle des périodes de récession est mauvaise. Ces résultats sont néanmoins meilleurs que ceux obtenus par les modèles ARMAX et SAC-SMA pour ces mêmes périodes. Cette étude indique que lorsque très peu de données sont disponibles, le modèle neuronal serait préférable au modèle ARMAX pour la prévision des débits. Par contre, une bonne application du modèle SAC-SMA nécessiterait au moins 8 années d'observations. Karunanithi et al. (1994) ont appliqué le réseau en cascade, "Cascade Network", utilisant l'algorithme dit de " Cascade-Corrélation" (Fahlman et Lebiere, 1990) pour la prévision des débits de la rivière Huron dans l'état du Michigan. Cet algorithme a l'avantage de modifier la topologie du modèle lors de l'apprentissage. Les données hydrologiques utilisées sont les débits journaliers observés sur 13 ans (1960-1972). Dans un premier modèle, les variables d'entrées sont les débits des jours j-5 à j-1 (j étant l'horizon de prévision), tandis que pour le second modèle, les variables d'entrées sont les moyennes mobiles des débits des jours j-5 à j-1. Ces deux modèles sont calibrés à l'aide de 11 ans d'observations et validés sur 2 ans. Les résultats de ces deux modèles neuronaux sont comparés à ceux d'un modèle de puissance (Chow, 1964). Les valeurs de l'erreur quadratique moyenne pour la période de test ou de validation indiquent que les modèles neuronaux sont de meilleurs prédicteurs que le modèle de puissance. La comparaison des erreurs relatives indique que les modèles neuronaux sont surtout meilleurs pour la prévision des débits de pointe. L'analyse de la taille du réseau montre que l'algorithme de "cascade-corrélation" est capable d'adapter la complexité du Réseau de neurones artificiel (RNA) à celle de l'ensemble d'apprentissage. Cette étude a aussi le mérite de montrer que l'utilisation des débits du jour j5 à j-1 comme entrées du RNA est meilleure à celle des débits moyens de j-5 à j-1. De nombreuses autres applications des Perceptrons Multicouches (PMC) à la modélisation de la relation pluie-débits et à la prévision des crues ont été proposées. On peut citer les travaux de Buch et al. (1993); Crespo et Mora (1993); Liong et al. (1994); Zhu et Fujita (1994); Smith et Eli (1995); Dimopoulos et al. (1996); Zhang et Trimble (1996); Asaad et Shamseldin (1997); Huttunen et al. (1997); Clair et Ehrman (1998); Thirumalaiah et Deo (1998). 3.11. CONCLUSION PARTIELLED'après les paragraphes précédents, il ressort que les réseaux de neurones sont des modèles inspirés du fonctionnement du cerveau humain, composé de plusieurs unités de calcul simple appelées neurones et fonctionnant en parallèle. C'est un assemblage d'éléments, d'unités ou de noeuds processeurs pour lequel un sous-groupe fait un traitement indépendant et passe le résultat à un deuxième sous-groupe. Le but de ces modèles est de traiter des informations de façon analogue au système biologique. Il existe alors une analogie entre les deux types de neurones. En effet, les synapses, les axones, les dendrites et le soma, des neurones biologiques correspondent respectivement aux poids des connexions, aux signaux de sortie, aux signaux d'entrée, et à la fonction d'activation, dans les neurones artificiels. Il a été également possible de voir que l'évolution des recherches sur les réseaux de neurones Formels ou Artificiels a connu trois grandes étapes : la naissance ou le début des recherches en 1890, le ralentissement des travaux en 1969 et la renaissance en 1982. La manière dont ces neurones sont disposés définit les différentes architectures des réseaux de neurones formels (RNF) utilisés pour la résolution de problème non-linéaire dans plusieurs disciplines, notamment l'industrie, la télécommunication, l'informatique et les sciences hydrologiques. En effet, plusieurs réseaux de neurones existent : les réseaux feed-forward, les réseaux à fonction radiale, les réseaux feed-back, les cartes auto-organisatrices de Kohonen, les réseaux de hopfield et les réseaux à apprentissage par compétition. Parmi tous ces réseaux, seuls les Perceptrons Multicouches (PMC) sont les plus utilisés pour la prévision et la simulation de la relation pluie-débit. Ces modèles doivent ces différentes performances à leurs innombrables propriétés citées précédemment. Malgré ces différentes propriétés, les réseaux de neurones ne sont fonctionnels que s'ils sont calibrés grâce aux différentes approches d'apprentissage comme le mode supervisé, le mode renforcé, le mode non-supervisé et le mode hybride. Cependant, il faut noter que la bonne applicabilité de ces modèles nécessite le respect d'un certain nombre de règles afin d'éviter les problèmes des minima locaux qui sont les causes de certaines mauvaises performances des modèles de réseaux de neurones. Pour éviter ces problèmes, la généralisation apparaît comme une solution idoine. Le chapitre III qui vient de s'achever a traité de la problématique des réseaux de neurones. Le chapitre IV, de la deuxième partie de ce mémoire, sera consacré au matériel et aux méthodes utilisées pour atteindre les objectifs de cette étude. DEUXIEME PARTIE : MATÉRIEL ET

MÉTHODES

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

Stations hydrométriques |

Période d'observation |

Nombre d'années d'observation |

|

Bada |

1962 à 1997 |

36 |

|

Marabadiassa |

1974 à 1995 |

22 |

|

Tortiya |

1960 à 1997 |

38 |

|

Bou |

1976 à 1997 |

22 |

|

Tawara |

1976 à 1997 |

22 |

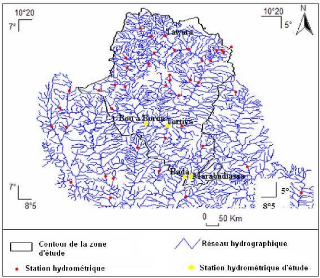

Les series de débits disponibles présentent des données manquantes (lacunes). A la station de Bada, on en dénombre 64, soit 14,81% ; à Marabadiassa, 51 soit 19,31%, à Tortiya 72 soit 15,79% et à Bou 43 lacunes, soit 14,25%. Il convient de noter que la zone d'étude compte en principe 32 stations hydrométriques (Figure 25) mais seulement cinq sont suivies de façon régulière par les services nationaux d'hydrologie. Dans cette étude, seules les stations qui sont supposées fortement perturbées par les barrages agropastoraux feront l'objet de l'étude. Il s'agit des stations de Bada, Marabadiassa, Tortiya et de Bou. La station de Tawara, la plus en amont sur le bassin versant d'étude a été écarté dans cette étude.

Figure 25 : Localisation des stations hydrométriques les plus suivies de la zone d'étude

Pour les variables explicatives de cette étude (pluie et température), nous disposons de deux séries de données différentes. Une première série collectée au près de la Société d'Exploitation et de Développement Aéroportuaire, Aéronautique et Météorologique (SODEXAM) et une deuxième série téléchargée du site Internet du Système d'Information Intégré de Base de Données (IDIS). L'adresse électronique ce site est : ( http://dw.iwmi.org/dataplatform/Links.aspx).

4.2.1.2.1. Données fournies par la SODEXAM

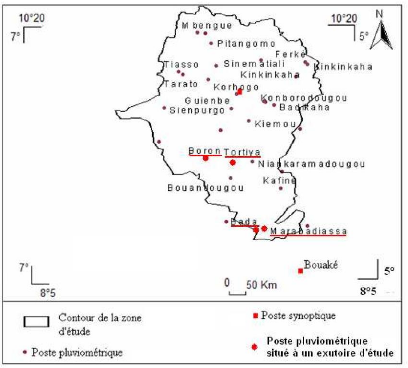

Les données de pluies et de températures fournies par la SODEXAM concernent celles des stations synoptiques de Korhogo et de Katiola (Figure 26).

Pour la station de Korhogo l'étendue de la série des précipitations mensuelles obtenues est de

29 ans (de 1971 à 2000). Cette série de

données comporte des lacunes. En effet, 12,9 3% des

données de

pluie collectées sont aberrantes. En ce qui concerne les

températures à Korhogo,

30 ans de mesures (de 1971 à 2001) sont disponibles.

Pour la station de Katiola, les pluies journalières de 1949 à 2000 ont pu être collectées soit 51 années d'observation. Ces pluies journalières ont été transformées en pluies mensuelles en faisant leur somme. Il faut signaler que les irrégularités observées dans la série de pluie de la station de Korhogo n'apparaissent pas au niveau de la station de Katiola.

Les données de pluie de la station de Katiola sont attribuées aux deux bassins délimités par rapport aux exutoires du Bandama Blanc à Bada et à Marabadiassa à cause de leur proximité. Pour les même raisons, les données de pluie de la station de Korhogo sont affectés aux bassins versants délimités par rapport aux exutoires du Bandama Blanc à Bou et à Tortiya.

4.2.1.2.2. Données fournies par le système IDIS

Le Système d'Information Intégré de Base de Données (IDIS) fournit des données en ligne partageant la plate-forme qui permet d'accéder aux données scientifiques sur l'eau, l'agriculture et l'environnement pour l'allégement de la pauvreté. Le but principal d'IDIS est d'aider les scientifiques de l'International Water Management Institute (IWMI) et du Challenge Program on Water and Food (CPWF). Le système IDIS contient plus d'un milliard de séries chronologiques mensuelles sur les zones géographiques étudiées par IWMI et CPWF. Cette base de données contient les valeurs de précipitation mensuelles de 1900 à 2002 sur la zone d'étude (Tableau II). Elle fournit également la température, au pas de temps mensuel, de 25 localités réparties de façon homogène sur la zone d'étude.

Figure 26 : Répartition de

quelques stations pluviométriques

de la zone d'étude dans la

base IDIS

Les températures et les pluies des localités, résumées dans le tableau II et représentées sur la figure 26, ont permis de déterminer les différentes valeurs mensuelles de ces variables explicatives aux stations de Bada, Marabadiassa, Tortiya et Bou. Les moyennes arithmétiques sont utilisées à cet effet.

Pour la station hydrométrique de Bou, les données de température utilisées dans cette étude sont les températures des localités de Boron, Sienpurgo et de Guiebé ; pour la station hydrométrique de Tortiya. Les températures sont celles des localités de Boron, Sienpurgo, Guienbe, Kiemou, Badikaha, Konborodougou, Korhogo, Tarato, Tiasso, Sinematiali, Kinkinkaha, Ferkessedougou, Pitangomo et de Mbengue ; pour la station de Marabadiassa, les localités sont celles listées précédemment plus la localité de Marabadiassa et ; pour la station hydrométrique de Bada, il s'agit des localités de Boron, Sienpurgo, Guienbe, Kiemou,

Badikaha, Konborodougou, Korhogo, Tarato, Tiasso, Sinematiali, Kinkinkaha, Ferkessedougou, Pitangomo, Mbengue, Marabadiassa, et de Bada.

Tableau II : Présentation de quelques localités extraites de la base de données IDIS

|

Localités |

Période |

Nombre |

|||

|

Localités |

Période |

Nombre |

d'observation |

d'année |

|

|

d'observation |

d'année |

||||

|

Bada |

1900-2002 |

102 |

Korahaha |

1900-2002 |

102 |

|

Badikaha |

1900-2002 |

102 |

Kiemou |

1900-2002 |

102 |

|

Marabadiassa |

1900-2002 |

102 |

Pitangomo |

1900-2002 |

102 |

|

Binguedougou |

1900-2002 |

102 |

Boron |

1900-2002 |

102 |

|

sinématiali |

1900-2002 |

102 |

Bouandougou |

1900-2002 |

102 |

|

Tortiya |

1900-2002 |

102 |

Ferké |

1900-2002 |

102 |

|

Niankaramandougou |

1900-2002 |

102 |

Kinkinkaha |

1900-2002 |

102 |

|

Konborodougou |

1900-2002 |

102 |

Korhogo |

1900-2002 |

102 |

|

Tiébela |

1900-2002 |

102 |

Konbolokoura |

1900-2002 |

102 |

|

Kafine |

1900-2002 |

102 |

Tawara |

1900-2002 |

102 |

|

Tiasso |

1900-2002 |

102 |

Sienpurgo |

1900-2002 |

102 |

|

Guienbe |

1900-2002 |

102 |

Tarato |

1900-2002 |

102 |

|

Mbengue |

1900-2002 |

102 |

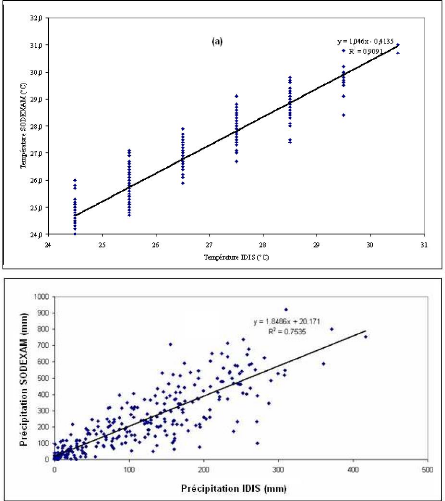

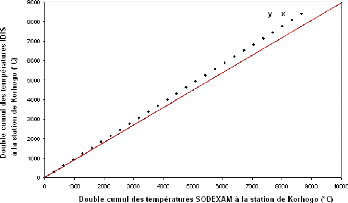

Les pluies et les températures du système IDIS sont comparées à celles fournies par la

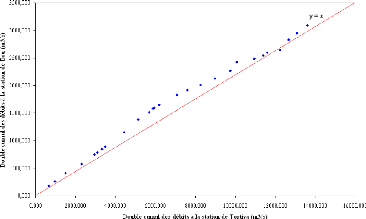

SODEXAM à la station de Korhogo, choisie comme station de référence. Les graphes (a) et (b) de la Figure 27 illustrent respectivement la corrélation entre les températures du système IDIS et les températures SODEXAM d'une part et les pluies IDIS et les pluies SODEXAM d'autre part. Ces graphes montrent que les variables mesurées par les deux systèmes sont, dans l'ensemble, très corrélées. En effet, les températures sont corrélées à 95% et les pluies à 87%. Il faut cependant remarquer que les pluies fournies par la SODEXAM semblent généralement deux fois plus grandes que les pluies fournies par la base IDIS (cf. Figure 28 b avec l'équation y = 1,8x +20). Entre les pluies SODEXAM et les pluies IDIS, la relation suivante peut alors être établie : Pluie SODEXAM = 1, 8486Pluie IDIS + 20,1 7 1

(b)

Figure 27 : Relation entre les

données climatiques. (a) Corrélation température IDIS et

température

SODEXAM, (b) corrélation pluie IDIS et pluie

SODEXAM

Il faut toutefois noter, malgré cette corrélation au niveau des données de pluie et de température des deux systèmes, les irrégularités au niveau des pluies fournies par la SODEXAM. Cette étude n'a pas pour objet de remettre en cause les compétences de la SODEXAM au niveau de la fourniture des données climatiques telles que la température et la

pluie. Mais, on peut tout de même faire certaines remarques pour justifier les différents choix opérés dans la suite de l'étude. En effet, sur la période 1971-1997, certaines irrégularités apparaissent dans la série de pluie de la SODEXAM. Certaines de ces irrégularités sont résumées dans le tableau III.

Tableau III : Récapitulatif de certaines irrégularités dans la série des pluies fournies par la SODEXAM sur la période d'étude (1971-1997)

|

Année |

Mois |

Pluies par le |

Pluies |

Année |

Mois |

Pluies par le |

Pluies |

|

1984 |

Décembre |

0 |

12 |

||||

|

1971 |

Janvier |

0 |

1 |

1985 |

Janvier |

0 |

1 |

|

1972 |

Janvier |

0 |

1 |

1985 |

Décembre |

0 |

12 |

|

1973 |

Janvier |

0 |

1 |

1986 |

Janvier |

0 |

1 |

|

1973 |

Février |

0 |

2 |

1986 |

Décembre |

0 |

12 |

|

1973 |

Décembre |

6 |

12 |

1987 |

Décembre |

2 |

12 |

|

1974 |

Janvier |

0 |

1 |

1988 |

Janvier |

0 |

1 |

|

1974 |

Février |

0 |

2 |

1988 |

Février |

0 |

2 |

|

1974 |

Décembre |

0 |

12 |

1988 |

Décembre |

0 |

12 |

|

1975 |

Janvier |

0 |

1 |

1989 |

Janvier |

0 |

1 |

|

1975 |

Février |

0 |

2 |

1989 |

Février |

3 |

2 |

|

1976 |

Décembre |

0 |

12 |

1990 |

Janvier |

29 |

1 |

|

1977 |

Décembre |

0 |

12 |

1990 |

Décembre |

3 |

12 |

|

1978 |

Janvier |

4 |

1 |

1991 |

Janvier |

0 |

1 |

|

1978 |

Février |

0 |

2 |

1991 |

Décembre |

0 |

12 |

|

1978 |

Décembre |

7 |

12 |

1992 |

Janvier |

4 |

1 |

|

1980 |

Février |

22 |

2 |

1992 |

Décembre |

0 |

12 |

|

1981 |

Janvier |

0 |

1 |

1993 |

Janvier |

0 |

1 |

|

1981 |

Décembre |

0 |

12 |

1993 |

Décembre |

0 |

12 |

|

1982 |

Janvier |

0 |

1 |

1994 |

Décembre |

0 |

12 |

|

1982 |

Décembre |

0 |

12 |

1995 |

Janvier |

0 |

1 |

|

1983 |

Janvier |

0 |

1 |

1995 |

Février |

0 |

2 |

|

1984 |

Janvier |

0 |

1 |

1996 |

Janvier |

0 |

1 |

|

1984 |

Février |

0 |

2 |

1997 |

Février |

0 |

2 |

|

1997 |

Décembre |

4 |

12 |

En analysant le tableau III, il est évident que des valeurs de pluies de certains mois concernés ont été remplacées par le code du mois correspondant. Ainsi pour le mois de janvier la pluie est de 1 mm, pour le mois de février, elle est de 2 mm et pour le mois de décembre la pluie mesurée est de 12 mm. Cette irrégularité se répète pour plusieurs années. Ces irrégularités constatées dans les pluies fournies par la SODEXAM peuvent être en partie imputable à des erreurs de report ou à la défaillance des instruments de mesure.

Les différentes statistiques calculées et consignées dans les tableaux IV et V résument les données fournies par les deux systèmes. Ces tableaux témoignent de la similitude des données fournies, notamment pour les températures.

Tableau IV : Statistiques des températures à Korhogo

Nom des Températures du Température de la

statistiques système IDIS en °C SODEXAM en °C

Min 24 24

Max 30 31

Moyenne 26 27

Ecart type 1,51 1,66

Concernant les données de pluies, le tableau V et la figure 27 montrent que les données SODEXAM sont généralement deux fois plus grandes que les données IDIS.

Tableau V : Statistiques des pluies à Korhogo

Nom des Pluie du système Pluie de la SODEXAM

statistiques IDIS en mm en mm

Min 0 1

Max 417 919

Moyenne 100 206

Ecart type 91,69 195,26

Au niveau de la température, les valeurs estimées par les deux méthodes semblent très proches parce que les statistiques calculées sont du même ordre de grandeur. On note que l'écart moyen entre les valeurs et la moyenne des températures est respectivement de 1,51 pour les températures IDIS et de 1,66 pour celles de la SODEXAM. En ce qui concerne les pluies, les statistiques présentées dans le tableau V sont différentes pour les deux méthodes. Les différentes statistiques ne sont pas de même ordre de grandeur.

Dans un travail de modélisation pluie-débit comme c'est le cas ici, il serait intéressant

d'utiliser des variables climatiques issues d'une même

base de données dans la mesure du

possible. Mais, dans notre

situation, les données de pluie et de température fournies par

la

SODEXAM présente beaucoup de lacunes et assez de données aberrantes. Pour résoudre ce problème de données, il est donc fait recours dans ce travail à la base de donnée IDIS, qui donne des séries de pluies et de températures sans données manquantes et pour plusieurs localités réparties sur l'ensemble du bassin versant d'étude.

Les pluies IDIS sont utilisées pour combler les lacunes dans les séries de pluies de la SODEXAM à la station synoptique de Korhogo. En ce qui concerne les températures IDIS, elles sont utilisées comme entrée des différents modèles développés (réseaux de neurones et modèle à réservoir, GR2M) dans la suite de ce travail. Deux raisons majeures motivent le choix des températures IDIS comme entrée des modèles. En effet, d'après les analyses statistiques, ces températures sont similaires à celles fournies par la SODEXAM et elles sont disponibles pour plusieurs localités du bassin versant d'étude, ce qui permet la détermination de températures moyennes plus représentatives que celles de la SODEXAM qui ne concernent que quelques stations synoptiques.

Mesurer les précipitations revient à mesurer une hauteur d'eau pendant un intervalle de temps donné. On a l'habitude d'exprimer les cumuls de pluies journaliers, mensuels ou annuels respectivement en millimètre (mm) par jour, par mois ou par an, réservant généralement l'expression en intensité de précipitation (mm/h) à des intervalles de temps plus courts (horaire, minute, etc.). L'usage a également consacré la pluviométrie comme l'étude de la répartition et du régime des précipitations. Dans cette étude, la pluviométrie (P) est exprimée en mm par le pas de temps du modèle, ici en mm/mois. Elle représente la hauteur d'eau moyenne tombée sur le bassin d'étude et intégrant la distribution spatio-temporelle. Elle est notée P dans cette étude.

La température exprime la valeur de la chaleur ou le froid de l'atmosphère ou de l'air ambiant d'un lieu donné et est exprimée en degré Celsius (°C). La température de l'air influence directement la température des eaux, et par conséquent, la tension de vapeur saturante de l'eau (Rousselle et El-Jabi, 1987). Elle est de plus liée à d'autres facteurs météorologiques qui influencent eux aussi l'évaporation, comme le rayonnement solaire ou la sécheresse de l'air et est notée T dans cette étude.

L'évapotranspiration potentielle est la quantité d'eau susceptible d'être évaporée par une surface d'eau libre ou par un couvert végétal dont l'alimentation en eau n'est pas le facteur limitant. Pour Margat (1999) la valeur de l'évapotranspiration potentielle est fonction de l'énergie disponible. Elle est mesurée par un évaporomètre ou déduite par des formules empiriques telles que celles de Thornthwaite (1948), Turc (1963), Penman (1946), Morton (1983), etc. La méthode de Thornthwaite présentée dans les sections suivantes sera utilisée pour la détermination de l'évapotranspiration potentielle (ETP) dans la mesure où elles ne nécessitent pas beaucoup de paramètres. L'unité de l'évapotranspiration est le millimètre sur le pas de temps désiré (jour, mois, an). Tout le long de cette étude, l'unité utilisée est le mm/mois et elle est notée ETP.

Suite à une pluie tombée sur le bassin versant du Bandama Blanc, tout un mécanisme complexe d'interaction de phénomènes hydrologiques et climatologiques se met en oeuvre. Il se traduit par une circulation, directe ou indirecte, de l'eau, en surface, à travers le sol ou le sous-sol en passant par les cours d'eau secondaires puis principaux, pour finir à l'exutoire. A l'échelle locale du bassin d'étude, le débit traduit la réaction du bassin versant suite à un phénomène pluvieux. Il est mesuré par différentes techniques hydrométriques, par exemple, le jaugeage par moulinet ou le jaugeage chimique en vue d'établir une courbe de tarage mettant en relation hauteur d'eau et débit au niveau de la station de mesure. C'est le cas des débits mesurés par les services de la sous direction de l'hydrologie de la direction de l'hydraulique humaine sur les stations limnimétriques retenues pour cette étude. Le débit est exprimé en mètre cube par seconde (m3/s). Il est représenté par la lettre Q dans ce travail et est également au besoin exprimé en lame d'eau (mm).

Comme déjà annoncé dans les sections précédentes, les données hydrométriques présentent plusieurs lacunes. L'utilisation de ces données à l'état brute sans traitement est une source d'erreur, même si les modèles Perceptrons Multicouches (PMC) pourraient intégrer ces "lacunes" (données manquantes) en les considérants comme des valeurs nulles (zéro) pendant le processus d'apprentissage. Pour remédier à cette éventualité, ces lacunes méritent d'être comblées à l'aide des techniques adaptées dans ces circonstances.

Pour réconstituer les données de débit manquantes plusieurs techniques existent dans la littérature. On peut utiliser des critères de proportionnalité analogues dans le cas de stations hydrométriques placées sur un même cours d'eau (transposition géographique, conservation des volumes, etc.). Les méthodes basées sur l'analyse des régressions et des corrélations (relation pluie-pluie ou pluie-débit, relations inter-postes) peuvent également être utilisées à cet effet (Musy et Higy, 2003). Pour cette étude, les données de débit, mesurées aux stations hydrométriques de Bada, Marabadiassa, Tortiya et Bou, ont été reconstituées à l'aide de la première méthode citée : la méthode du critère de proportionnalité analogue. Les différentes surfaces des sous bassins ont été calculés et les rapports ci-dessous ont été déterminés et utilisés :

|

Concernant les données de pluies aberrantes répertoriées au niveau de la station de Korhogo, elles ont été remplacées par leur équivalent dans la base de données de pluies fournie par le système IDIS en les multipliant par un facteur de 2. Il faut cependant noter que cette multiplication n'a eu aucun effet sur les valeurs complétées car elles étaient toutes nulles.

Les données ainsi harmonisées sont analysées dans la section suivante afin de déterminer des biais éventuels qui pourraient être présents dans ces séries chronologiques.

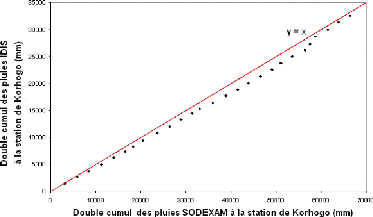

Dans les sciences hydrologiques, il est souvent nécessaire de contrôler un seul type de données (pluie, température, évaporation) à l'échelle locale (à l'endroit où la mesure a été effectuée) ou à l'échelle régionale (d'un bassin versant où plusieurs sites de mesures ont été établis). La comparaison des données IDIS et SODEXAM trouve ici son importance. C'est la méthode du double cumul qui consiste à vérifier la proportionnalité des valeurs mesurées à deux stations qui a été utilisée. L'une des stations (station X) est la station de base ou station de référence, supposée correcte. L'autre station (Y) est la station à contrôler. Un effet de lissage est obtenu en comparant, au pas de temps choisi (année, saison, mois, décade), non pas

les valeurs observées, mais leur cumul. Dans cette étude, les données IDIS représentent la station (Y) et les données SODEXAM la station X. Les auteurs tels que Musy et Higy (2003) propose les relations suivantes :

t

X t

( ) = x i

( ) (8)

i = 0 t

Y t

( ) = y i

( ) (9)

i = 0

Le cumul est établi sur 27 ans avec les valeurs mensuelles des précipitations et des températures. Les pluies et les températures issues de la base de données IDIS et celles fournies par les services de la SODEXAM sont comparées. Les figures 28 et 29 illustrent respectivement les comparaisons avec les pluies et les températures.

Figure 28 : Double cumul des précipitations SODEXAM et IDIS à Korhogo

Figure 29 : Double cumul des températures SODEXAM et IDIS à Korhogo 4.2.6.2. Données hydrométriques

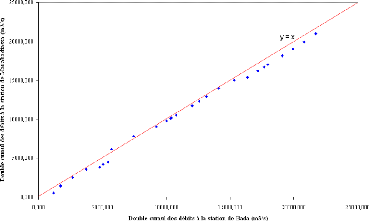

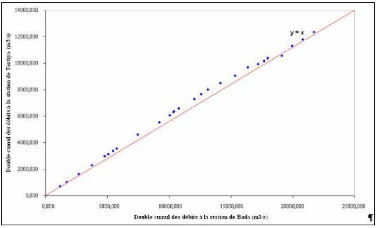

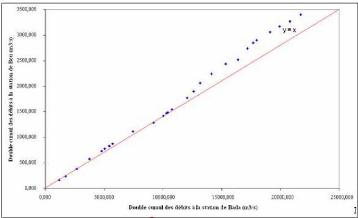

Comme pour la pluie et la température, le cumul des débits mensuels est établi sur 27 ans. Les débits des stations de Marabadiassa, Tortiya et Bou (stations à contrôler) sont comparés aux débits de la station de Bada (station de référence) d'une part (Figure 30 à 32) et d'autre part les débits à la station de Bou (station contrôlée) aux débits de la station de Tortiya (station de référence) (Figure 33).

Figure 30 : Double cumul des débits aux stations de Bada et de Marabadiassa

La figure 30 compare des bassins versants de taille voisine et assez proche géographiquement (les superficies sont de 24 050 km2 pour la station de Bada et de 22 293 km2 pour la station de Marabadiassa). La figure 31 compare les stations de Bada et de Tortiya qui sont deux stations très éloignées l'une de l'autre. Ici on note une différence notable entre les superficies des deux sous bassins (24 050 km2 pour la station de Bada et 14 500 km2 pour la station de Tortiya).

Figure 31 : Double cumul des débits des stations de Bada et de Tortiya

Comme précédemment, la figure 32 compare des bassins versants trop différents (24 050 km2 pour la station de Bada et 3 710 km2 pour la station de Bou).

Figure 32 : Double cumul des

débits des stations de Bada et de Bou

- 74 -

Quant à la figure 33 elle paraît plus intéressante, car elle compare des bassins versants assez proches par la taille et par leur position géographique (Tortya et Bou).

Figure 33 : Double cumul des debits des stations de Tortiya et de Bou

On note que quelque soit la différence de superficie des bassins versants et l'éloignement des stations de mesures, il ne se dégage aucune tendance comme par exemple une rupture de pente significative. Il ressort que la méthode du double cumul suggérée par Musy et Higy (2003) ne permet pas de détecter des biais significatifs au niveau des données hydrométriques disponibles pour cette étude. Cependant, il est bon de remarquer que lorsqu'on compare les débits de la station de Bou à ceux des stations de Bada et de Tortiya, on observe de légers changements de pente.

Cette partie du travail a pour objectif d'apprécier de façon globale la dynamique de l'évolution des précipitations par rapport aux lames d'eau écoulées aux stations de Bada, Marabadiassa, Tortiya et de Bou. Les figures 34 à 37 illustrent respectivement l'évolution des lames d'eau écoulées, des précipitations et des déficits d'écoulements moyens à ces différentes stations hydrométriques.

En Annexe B, les chroniques de pluies et débits sont représentées pour chaque année et pour chacune des 4 stations.

|

Quantite d'eau (mm) |

350,00 300,00 250,00 200,00 150,00 100,00 50,00 0,00 |

||

|

Lame d'eau écoulée (mm) Précipitation (mm) Déficit d'écoulement (mm) |

|||

mars

mai

avril

juin

octobre

juillet

janvier

aoat

fewier

novembre

decembre

septembre

Mois

Figure 34 : Évolution des

lames d'eau écoulées, des précipitations et des

déficits d'écoulements

moyens à la station de Bada

|

Quantite d'eau (mm) |

350,00 300,00 250,00 200,00 150,00 100,00 50,00 0,00 |

||

|

Lame d'eau écoulée (mm) Précipitation (mm) Déficit d'écoulement (mm) |

|||

mars

mai

avril

juin

octobre

juillet

janvier

aoat

Wrier

novembre

decembre

septembre

Mois

Figure 35 : Évolution des

lames d'eau écoulées, des précipitations et des

déficits d'écoulements

moyens à la station de

Marabadiassa

|

Quantite d'eau (mm) |

600,00 |

||

|

300,00 |

Lame d'eau écoulée (mm) Précipitation (mm) Déficit d'écoulement (mm) |

||

|

200,00 100,00 0,00 |

mars

mai

awll

juin

octobre

juillet

janvier

aoat

fewier

novembre

decembre

septembre

Mois

Figure 36 : Évolution des

lames d'eau écoulées, des précipitations et des

déficits d'écoulements

moyens à la station de

Tortiya

|

Quantite d'eau (mm) |

600,00 |

||

|

300,00 |

Lame d'eau écoulée (mm) Précipitation (mm) Déficit d'écoulement (mm) |

||

|

200,00 100,00 0,00 |

mars

mai

avril

juin

acid

fevrier

juillet

octobre

janvier

novembre

decembre

septembre

Mois

Figure 37 : Évolution des

lames d'eau écoulées, des précipitations et des

déficits d'écoulements

moyens à la station de Bou

La

lecture de ces figures ci-dessus montre généralement que pendant

toute la période de

décembre à juin, les rivières du bassin

versant du Bandama Blanc, situées en amont du

barrage de Kossou,

réagissent faiblement aux évènements pluvieux. C'est

seulement à partir

de juin jusqu'à décembre qu'on peut

apprécier une quantité d'eau écoulée non

négligeable

avec un maximum atteint en septembre. Ces faibles écoulements du Bandama blanc à Bada, Marabadiassa, Tortiya et à Bou peuvent être le fait de trois facteurs : (i) l'évapotranspiration intense pendant la saison sèche, (ii) les fortes infiltrations des eaux de pluie pour alimenter les nappes profondes et (iii) l'utilisation des eaux pour les activités anthropiques (agriculture et élevage) à travers la création de barrage agro pastoraux.

4.2.6.4.1. Évapotranspiration potentielle

Sur l'ensemble de la période d'étude (1971 à 1997), la plus grande valeur d'évapotranspiration potentielle, déterminée en mars 1983 et 1990 avec la méthode de Thornthwaite, est égale à 220 mm et la plus petite valeur est de 80 mm, déterminer en Août 1971. L'étendue est donc estimée à 140 mm. Cela montre une très grande dispersion des ETP sur l'ensemble de la période d'étude. La lecture de la figure 38 montre que l'ETP présente généralement deux grandes évolutions au cours de l'année sur l'ensemble de la zone d'étude. En effet, de janvier à mars, l'ETP et les précipitations évoluent de façon proportionnelle. Après mars, les deux variables sont inversement proportionnelles ; car, lorsque l'ETP augmente, la pluie diminue et vis- versa.

Quantite Beau en mm

350,00

300,00

250,00

200,00

150,00

100,00

50,00

0,00

janvier

fevrier

mars

avril

mai

juin

Mois

juillet

adit

septembre

octobre

novembre

decembre

Précipitation (mm) ETP (mm)

Figure 38 : Évolution des ETP et des précipitations sur la zone d'étude

4.2.6.4.2. Variable temporelle (le mois)

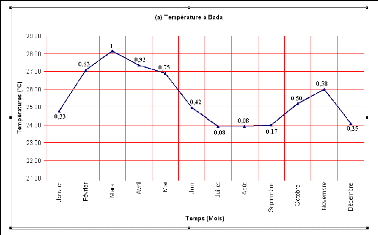

Les chiffres affectés aux différents mois sont compris entre 0,08 et 1. La figure 39 donne les différentes valeurs des mois qui ont été codés en fonction des températures enrégistrées à la station de Bada.

Figure 39 : Codage des mois à partir des températures moyennes mensuelles de la station de Bada

Les mois ainsi codés sont introduits dans les modèles de réseaux de neurones développés dans ce mémoire.

Cette section présente le compilateur RNF PRO et le tableur EXCEL qui ont servi au développement respectivement des réseaux de neurones formels et du modèle GR2M.

Plusieurs environnements sont disponibles pour le développement des Réseaux de neurones notamment Matlab, Statistica, Scilab, RNF PRO, etc. Le compilateur "RNF PRO" développé à l'Ecole des Mines d'Alès (France) sera utilisé de préférence dans cette étude à cause de son usage facile. Il faut préciser que ce compilateur est en amélioration perpétuelle et que le langage de programmation utilisé pour son développement est « Java » à cause de sa flexibilité. En effet, cet environnement permet au logiciel "RNF PRO" d'être utilisable sur plusieurs plates formes (Windows, Unix, etc.) et sur plusieurs PC. Pour optimiser l'utilisation de l'environnement de travail, les paramètres à faire varier sont (Eurisouke, 2006) :

i. l'initialisation avec le choix de la suite aléatoire ;

ii. le choix de la méthode de minimisation de la fonction coût qui est l'erreur quadratique moyenne ;

iii. le pas de gradient ;

iv. le nombre de présentation des événements de l'apprentissage, qui est évalué en fonction de l'allure de la courbe du critère de test. Si ce critère se met à augmenter, l'apprentissage est arrêté car il se spécialise (apprentissage par "coeur" sur les exemples d'apprentissage et donc la qualité de test se dégrade) ;

v. la période d'affichage, si cette période est de p, le critère d'apprentissage est affiché toutes les p présentations de l'ensemble d'apprentissage. Dans cette étude, la période d'apprentissage est égale à 10 ;

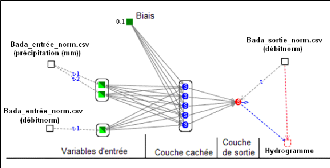

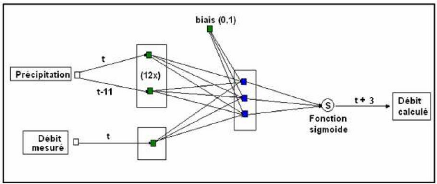

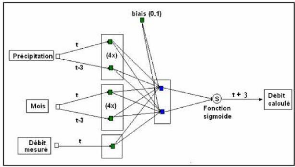

vi. le critère lambdaä , si on utilise l'algorithme de Levenberg Marquarld (LM). Les modèles neuronaux construits avec le logiciel "RNF PRO" se présente sous la forme suivante (Figure 40).

Figure 40 : Présentation d'un

modèle Perceptron multicouche à cinq (5) neurones sur la

couche

cachée

La figure 40 représente un

modèle Perceptron Bouclé Dirigé, de prévision. La

variable

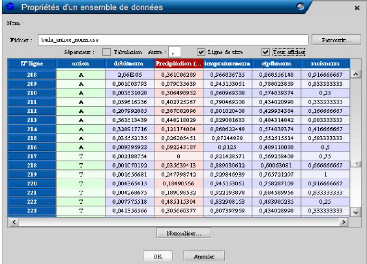

d'entrée est la pluie mensuelle et la variable cible, le débit mensuel. Dans le compilateur RNF PRO, les entrées et les sorties sont rangées dans une matrice. Cette matrice représentée à la figure 41 contient autant de colonnes et de lignes qu'il y a de données. La première colonne porte le nom "action" et les lignes sont occupées par les lettres A pour apprentissage et T pour test. Les autres colonnes portent les noms des variables correspondantes et lorsqu'une colonne est sélectionnée, elle prend la couleur rose.

Si les données ne sont pas déjà normées, cette fenêtre permet leur normalisation en choisissant la méthode dans le menu "normaliser" situé au bas de la matrice.

Figure 41 : Matrice d'entrée

des variables dans le logiciel "RNF PRO"

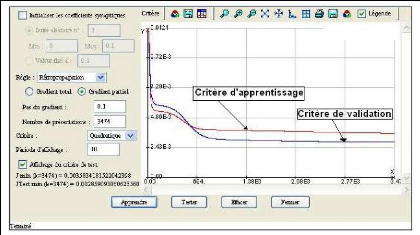

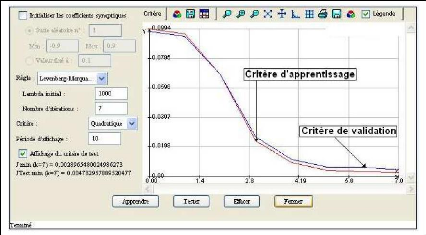

Une fois les données

formatées et rangées dans la matrice ci-dessus

présentée, le programme

peut alors être « lancé ». Pendant ce processus d'apprentissage, l'évolution des critères d'apprentissage et de validation ou test sont visibles grâce aux fenêtres, d'optimisation des paramètres, représentées par les figures 42 et 43. Ces figures sont respectivement les fenêtres d'optimisation utilisées pour l'apprentissage par la méthode de la rétropropagation de l'erreur et de celle de Levenberg Marquarld (LM).

Figure 42 : Fenêtre de saisie des paramètres dans "RNF PRO" pour la retropropagation de l'erreur

Figure 43 : Fenêtre de saisie des paramètres dans "RNF PRO" pour la Levenberg Marquarld

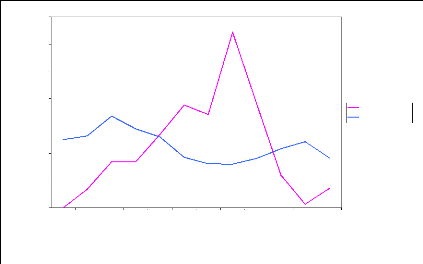

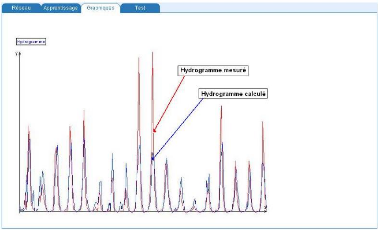

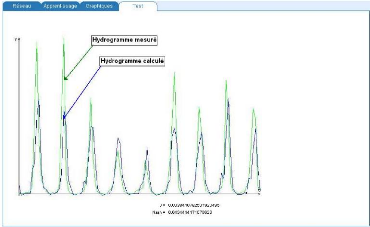

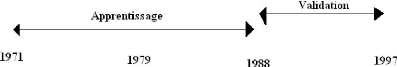

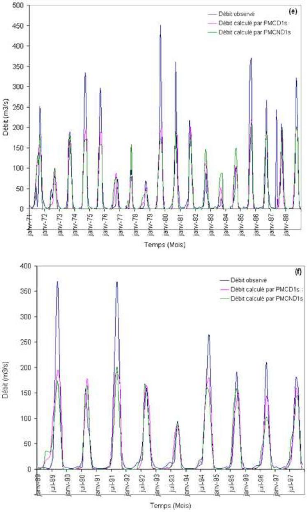

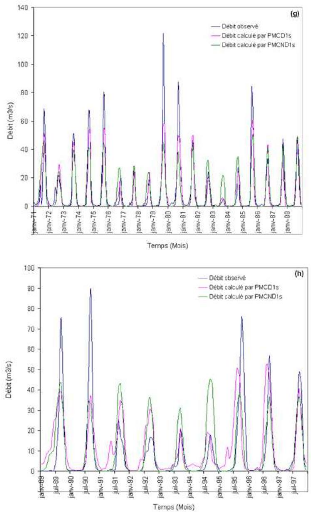

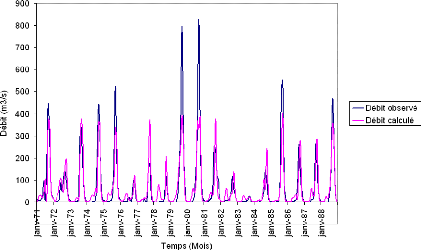

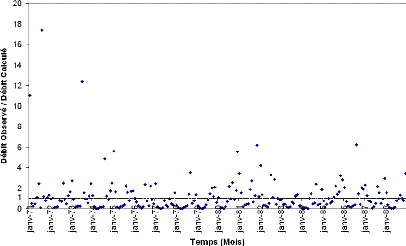

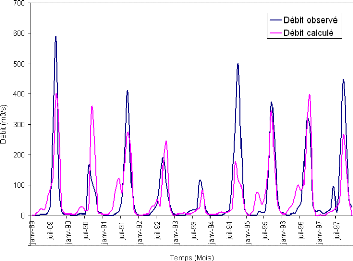

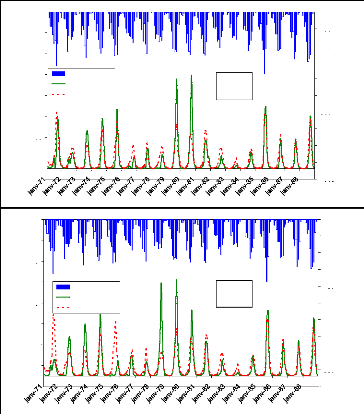

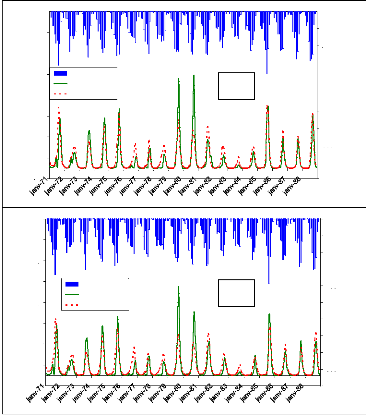

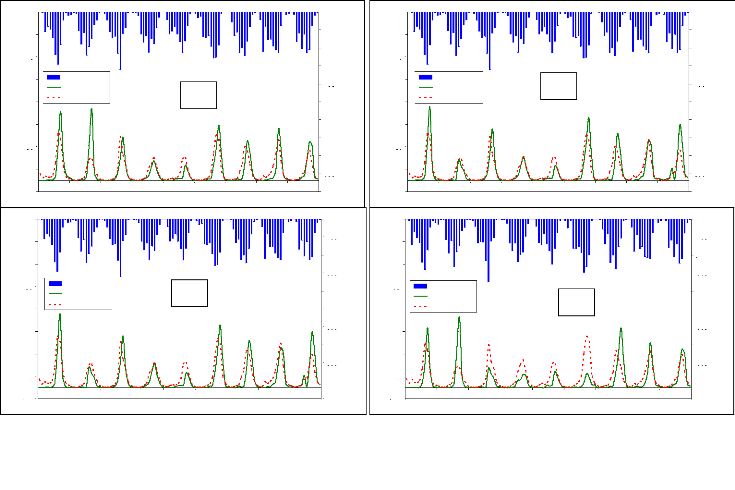

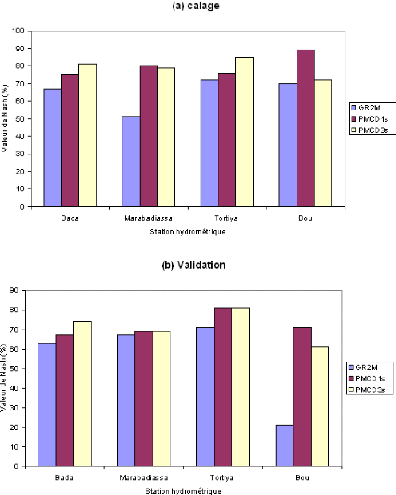

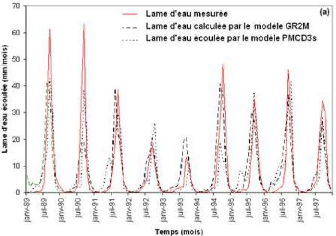

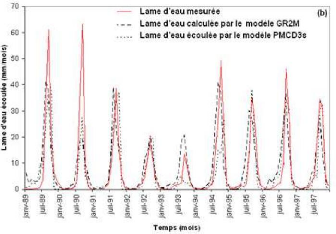

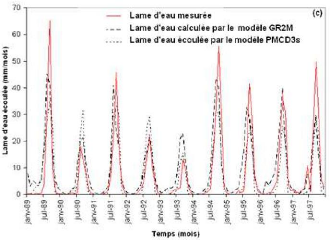

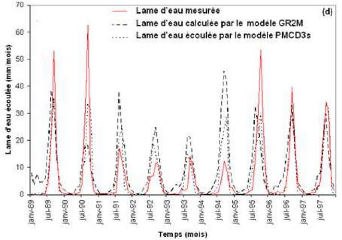

En plus des différents paramètres cités plus haut, les fenêtres d'optimisation affichent également, à la fin de l'apprentissage, les erreurs quadratiques moyennes (MSE) les plus faibles des phases de calage et de validation (ou test). A la fin de cette phase d'optimisation ou d'apprentissage, l'évolution des hydrogrammes (hydrogrammes mesuré et calculé) en apprentissage et en validation sont représentés respectivement par les figures 44 et 45.

Figure 44 : Hydrogrammes mesuré et calculé sous le logiciel "RNF PRO"en apprentissage

Figure 45 : Hydrogrammes mesuré et calculé sous le logiciel "RNF PRO" en validation

Que se soit en apprentissage ou en validation, les modèles développés sont meilleurs si et seulement si les hydrogrammes calculés et les hydrogrammes mesurés se superposent.

En vue d'apprécier les résultats obtenus avec les réseaux de neurones, une approche avec un modèle conceptuel à réservoir, GR2M, a été développée. Cette étape de modélisation est ici présentée. Pour fixer les idées sur les modèles GR, quelques travaux ayant contribué au développement des modèles GR sont présentés dans les paragraphes suivants :

i. Modèles pluie-débit au pas de temps journalier

La conception des modèles GR au pas de temps journalier a débuté dans les années 80 au Cemagref avec les travaux de Claude Michel (1983). Cet auteur a engagé une réflexion sur la modélisation pluie-débit à partir du modèle CREC, un modèle à neuf paramètres développés au Laboratoire d' Hydrologie de l'Université de Montpellier (Cormary et Guilbot, 1973). Se basant sur cette structure, des simplifications ont été faites, dans le but d'obtenir un modèle à peu de paramètres, sans amoindrir les performances du modèle initial en terme de simulation des débits. Une structure simple à deux réservoirs a ainsi été proposée avec un seul paramètre correspondant à une capacité maximale identique de ces

deux réservoirs dans le cas du bassin versant de l'Orgeval (Michel, 1983). Le modèle à deux paramètres, GR2, avec un paramètre pour chaque capacité de réservoir, venait de naître. Après avoir été utilisé par Loumagne (1988) et Devred (1989), GR2 a ensuite été repris et amélioré par Edijatno (1987, 1991) pour obtenir le modèle GR3. Il a modifié la fonction de production et a ajouté un troisième paramètre. Le nouveau modèle journalier GR3 (Edijatno et Michel, 1989) fut testé sur un échantillon de 110 bassins versants français et donna des résultats satisfaisants. Dans une perspective de constante amélioration de cette structure, Nascimento (1991, 1995) a isolé des bassins intermittents pour lesquels le modèle avait du mal à fournir des résultats corrects, et a introduit dans le modèle un quatrième paramètre gouvernant des échanges "souterrains" pour répondre aux exigences de bonne reproduction des débits. Le nouveau modèle GR4 a fourni sur un échantillon de 120 bassins de meilleures performances que la version antérieure à trois paramètres. Parallèlement aux travaux de Nascimento (1995), Makhlouf (1994) a mené des recherches sur l'explication des paramètres du modèle GR4J sur des bassins de Moselle et de Bretagne et a également donné quelques voies pour le traitement de la neige sur les bassins de la Moselle. Plus récemment, Edijatno et al. (1999) ont proposé une nouvelle version à trois paramètres du modèle journalier. Cette version, dans laquelle la capacité du réservoir de production est fixe, est très similaire à la version proposée par Nascimento (1995) avec des fonctions de production et d'échange légèrement modifiées. Enfin, Perrin (2000) et Perrin et al. (2003) ont proposé une version améliorée de ce modèle journalier, comportant quatre paramètres et permettant notamment d'améliorer la simulation des étiages avec l'introduction d'une percolation issue du réservoir de production du modèle.

ii. Modèles pluie-débit au pas de temps mensuel et annuel

Les travaux de Kabouya (1990) ont permis de mettre au point un modèle mensuel GR3M à trois paramètres pour l'appliquer à des problèmes d'évaluation de la ressource en eau en Algérie septentrionale (Kabouya et Michel, 1991). Makhlouf (1994) a également travaillé sur un modèle mensuel en proposant une version à deux paramètres, le modèle GR2M (Makhlouf et Michel, 1994) qui a par la suite été améliorée par Mouelhi (2003). Au pas de temps annuel, les travaux de Bouabdallah (1997) ont permis de jeter les premières bases d'un modèle pluie-débit annuel, avec deux versions, à un paramètre (GR1A) et deux paramètres (GR2A). Par la suite, Mouelhi (2003) a repris la chaîne de modélisation à pas de temps mensuel, annuel et pluriannuel, en essayant d'identifier l'adaptation des structures

des modèles au pas de temps de fonctionnement, et en recherchant les cohérences de structures entre ces différents pas de temps. Il a ainsi pu proposer un modèle mensuel (GR2M) à deux paramètres, un modèle annuel (GR1A) à un paramètre et un modèle interannuel sans paramètres à caler.

Le modèle GR2M est développé sous plusieurs environnements. On a les compilateurs Scilab, le Fortran et le tableur ExcelTM utilisé dans ce travail. Le modèle GR2M développé sous le tableur ExcelTM comprend six feuilles :

i. la feuille "Readme", contient les détails sur l'architecture du modèle, les données à rentrer, la manière de faire les simulations, les critères de performance et sur les graphiques ;

ii. la feuille "GR2M", permet de faire les simulations de débit au pas de temps mensuel ;

iii. la feuille "S", donne l'évolution du taux de remplissage du réservoir de production;

iv. la feuille "R", donne l'évolution du taux de remplissage du réservoir de routage;

v. la feuille "Hydrogramme", présente les hydrogrammes observés et calculés ainsi que la pluie et ;

vi. la feuille "Débit XY", présente la courbe de corrélation entre les débits observés et les débits simulés par le modèle GR2M.

En ce qui concerne les données utilisées dans le modèle GR2M, elles sont toutes exprimées en mm (précipitations, évapotranspirations potentielles et débits). En pratique, les précipitations et les évapotranspirations potentielles sont fournies ou calculées et l'unité est directement le mm. Quant aux débits, ils sont fournis en m3/s et il faut alors les diviser par la surface du bassin concerné et multiplier ce quotient par le temps afin de les avoir en mm.

Au terme de ce chapitre, il convient de noter que les variables explicatives retenues sont la pluie (P), la température (T), l'évapotranspiration potentielle (ETP), estimée avec la méthode de Thornthwaite, et le mois (M) qui a été codé par rapport à la température. Les variables cibles sont les débits mensuels mesurés aux stations hydrométriques de Bada, Marabadiassa, Tortiya et Bou sur le Bandama Blanc en amont de la retenue d'eau du barrage de Kossou. Ces données débimétriques collectées sur ces stations s'étendent généralement de 1962 à 1997 et

présentent des lacunes. En effet, à la station de Bada, on en dénombre 64, soit 14,81% ; à Marabadiassa, 51 soit 19,31%, à Tortiya 72 soit 15,79% et à Bou 43 lacunes, soit 14,25%.

En ce qui concerne les données de pluie et de température, elles proviennent de la SODEXAM et du Système IDIS. Les stations de la SODEXAM retenues pour cette étude sont les stations de Korhogo et de Katiola.

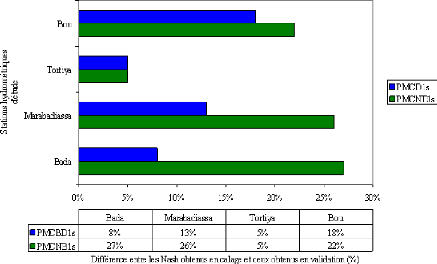

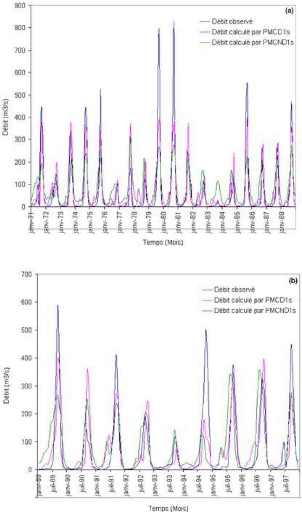

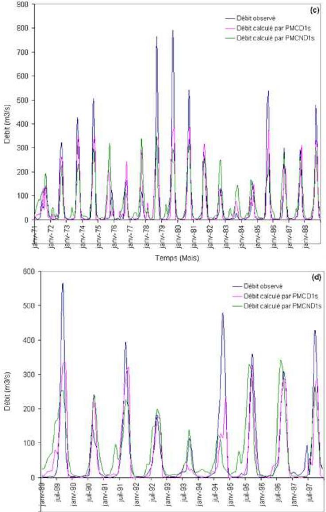

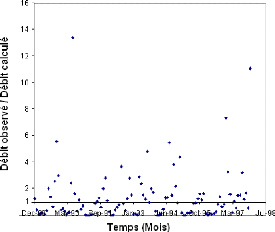

En vue de minimiser les valeurs aberrantes, les pluies de la station de Korhogo ont été affectées aux stations de Bou et de Tortiya qui lui sont plus proches et les pluies de la station de Katiola aux localités de Bada et de Marabadiassa pour les mêmes raisons.