|

CONSERVATOIRE NATIONAL DES ARTS ET METIERS

CENTRE REGIONAL

DES PAYS DE LA LOIRE

CENTRE D'ENSEIGNEMENT DE NANTES

MEMOIRE

présenté en vue d'obtenir

le

DIPLÔME D'INGENIEUR

C.N.A.M.

en

INFORMATIQUE

par

Laurent GARNIER

Stratégie de test au sein du processus

d'évolution

d'architecture de Sodifrance

Soutenu le 16 décembre 2011

JURY

Présidente : Mme METAIS, professeur Cnam Paris

Membres : M. BRIAND, professeur Ecole Polytechnique Nantes

M. BELLEIL, tuteur Cnam, professeur Université de Nantes

M. BRETON, tuteur entreprise, co-directeur DTOP, Sodifrance M. PACAUD,

architecte technique, DTOP, Sodifrance

|

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

Sommaire

1 Introduction 11

2 L'environnement 13

2.1 Présentation de l'entreprise 13

2.2 Le processus d'évolution d'architecture 15

3 Le travail réalisé 23

3.1 Etat de l'art 23

3.2 Plate-forme de migration (« Migration Platform

») 35

4 Les travaux connexes 53

4.1 Réalisation d'un plugin Eclipse 53

4.2 Instrumentation 55

4.3 Partenariat avec la société Kalios 57

5 Conclusion 61

6 Bibliographie 62

7 Annexes 65

7.1 L'architecture dirigée par les modèles

(Model Driven Architecture, MDA) 65

7.2 Documentation partielle du métamodèle «

Migration Platform » 77

7.3 MIA Transformation 85

7.4 MIA Generation 87

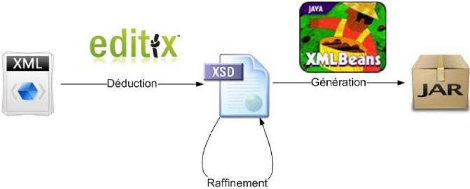

7.5 Du XML au Jar 89

7.6 Du métamodèle au Jar 93

|

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

Acronymes

ADM : Architecture Driven Modernization (Modernisation

dirigée par les modèles)

ANT : Architecture N Tiers

API : Application Programming Interface (Interface de

programmation)

ASTM : Abstract Syntax Tree Metamodel (métamodèle

d'arbre de syntaxe abstrait)

BU : Business Unit (Unité d'affaires)

CDO : Connected Data Objects (Objets de données

connectés)

CIM : Computation Independent Model (Modèle des

exigences)

DAO : Data Access Object (Objet d'accès aux

données)

HTML : HyperText Markup Language (Langage de balises Hyper

texte)

JAR : Java ARchive (Archive Java)

KDM : Knowledge Discovery Metamodel (Métamodèle de

découverte de la connaissance)

MDA : Model Driven Architecture (Architecture dirigée par

les modèles)

MDE : Model Driver Engineering (Ingénierie dirigée

par les modèles

MIA : Model In Action (Modèles en action)

OMG : Object Management Group (groupe de standardisation des

technologies objet)

ORM : Object Relational Mapper (mapping (correspondance) objet /

relationnel)

PDM : Platform Definition Model (Modèle de description de

la plate-forme)

PIM : Platform Independent Model (modèle

indépendant de la plate-forme)

POC : Proof Of Concept (Preuve de concept)

PSM : Platform Specific Model (modèle spécifique

à la plate-forme)

SGBDR : Système de Gestion de Base de Données

Relationnelle

SLOC : Source Line Of Code (Nombre de ligne de code source)

SQL : Structured Query Language (Langage de requête

structure)

UCBT : Use Case Base Testing (Tests bases sur les cas

d'utilisation)

UML : Unified Modeling Language (langage de modélisation

unifié)

XMI : XML Metadata Interchange (standard pour l'échange de

métadonnées)

XML : eXtended Markup Language (langage à balises

extensible)

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

Table des illustrations

Figure 1 : Répartition des agences Sodifrance en France et

en Belgique. 12

Figure 2 : Organisation fonctionnelle 2011 (source Sodifrance)

14

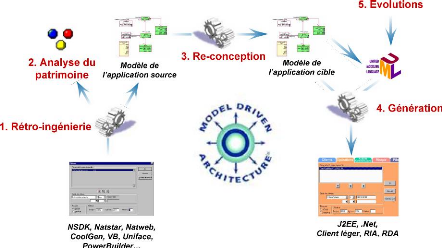

Figure 3 : Processus global de migration (source Sodifrance)

14

Figure 4 : Les transformations des modèles MDA (Villemin

2011, p.12) 16

Figure 5 : Unification PIM et PDM pour produire

le PSM puis le code (Villemin 2011, p.14) 16

Figure 6 : Le processus d'évolution d'architecture (source

Sodifrance) 18

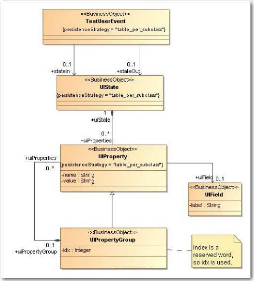

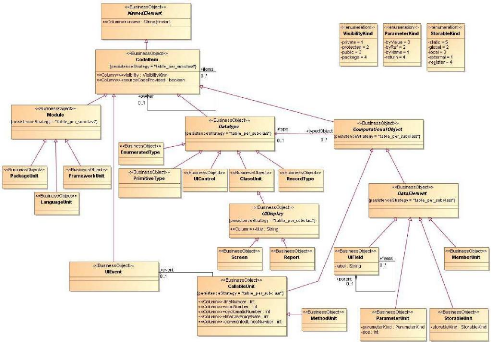

Figure 7 : Extrait du métamodèle architecture

n-tiers (ANT) 18

Figure 8 : Notions de base en technologie des objets

(Bézivin 2004) 22

Figure 9 : Notions de base en ingénierie des

modèles (Bézivin 2004) 22

Figure 10 : Diagramme de classe extrait du

métamodèle KDM 26

Figure 11 : Diagramme de classe extrait du

métamodèle « Migration Platform » 26

Figure 12 : Le modèle en V (Mirman 2011) 28

Figure 13 : Implémentation des tests avec NModel

(Chinnapongse et al. 2009) 30

Figure 14 : Relations entre les sous modèles des tests

basés sur les cas d'utilisation 32

Figure 15 : Cas d'utilisation de la plate-forme de migration

(« Migration Platform ») 34

Figure 16 : Vue d'ensemble des paquetages constituant le

métamodèle « Migration Platform » (Source

Sodifrance, les parties que j'ai modélisées sont en

vert) 34

Figure 17 : Processus d'alimentation de la cartographie

d'application 36

Figure 18 : Diagramme de classe du paquetage « Core »

38

Figure 19 : Diagramme de classe du paquetage « CodeItems

» 38

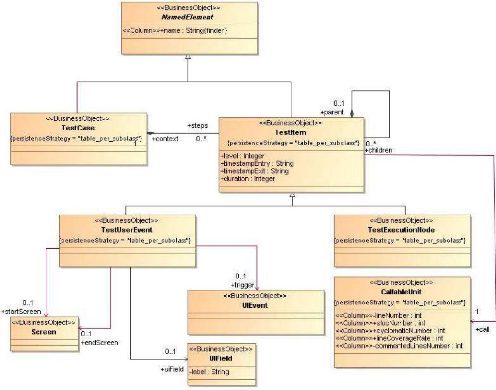

Figure 20 : Les classes du paquetage architecture des tests

(« Testing.Architecture ») 40

Figure 21 : Les classes du paquetage données de test

(« Testing.Data ») 40

Figure 22 : Exploitation de la cartographie pour produire un

diagramme de classe 42

Figure 23 : Exploitation de la cartographie de test pour produire

un diagramme de séquence 44

Figure 24 : Exploitation de la cartographie pour produire un

diagramme de classes... inutilisable 44

Figure 25 : Exploitation de la cartographie pour produire un

graphe 46

Figure 26 : Graphe hiérarchique d'appels entre

éléments 46

Figure 27 : Exploitation de la cartographie de test pour produire

un graphe hiérarchique 47

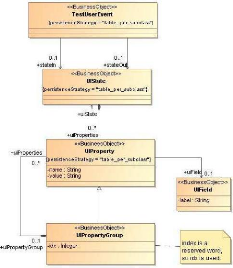

Figure 28 : Les classes du paquetage traçabilité

(« Traceability ) 50

Figure 29 : Vue de synthèse du plugin Eclipse (source

Sodifrance) 52

Figure 30 : Vue du suivi d'intégration du plugin Eclipse

(source Sodifrance) 52

Figure 31 : Copie d'écran de la page Html du taux de

couverture de l'application LV 54

Figure 32 : Copie d'écran de la page HTML

détaillant le code d'une méthode de l'application LV 54

Figure 33 : Diagramme de séquence d'appels à

l'opération « SdfCartography » 56

Figure 34 : Utilisation d'une fonctionnalité de

yEd pour obtenir un premier niveau de lotissement 60

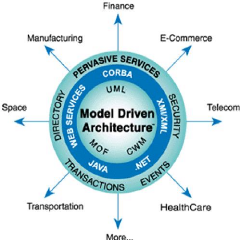

Figure 37 : Model Driven Architecture (Projet ACCORD

2011) 66

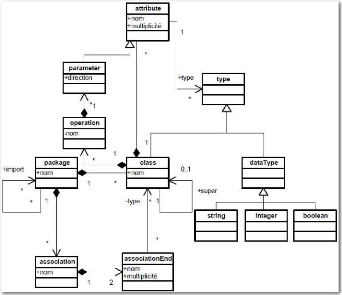

Figure 38 : diagramme de classes du MOF1.4 68

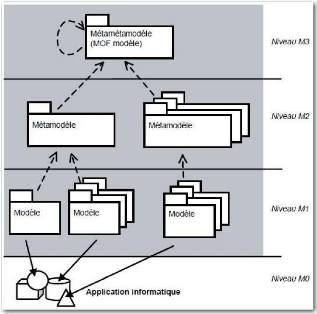

Figure 39 : les quatre niveaux de l'architecture du MDA (Blanc

2005, p.40) 68

Figure 40 : Les transformations des modèles MDA (Villemin

2011, p.12) 70

Figure 41 : transformations de modèles (Blanc 2005, p.11)

70

Figure 42 : Les relations entre les métamodèles de

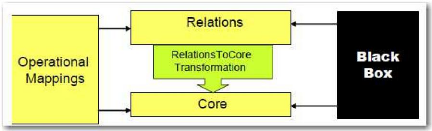

QVT (Object Management Group 2011c) 72

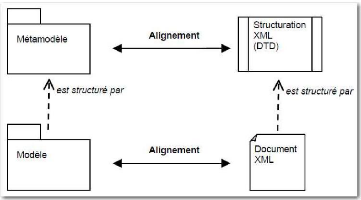

Figure 43 : Alignement entre

modèle/métamodèle et DTD/document XML (Blanc 2005, p.103)

74

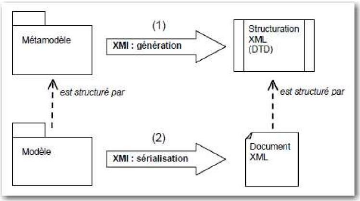

Figure 44 : XMI et la structuration des balises XML (Blanc 2005,

p.104) 74

Figure 35 : CoreDiagram Diagram (Source Sodifrance,

métamodèle « Migration Platform ») 76

Figure 36 : CodeItemsDiagram Diagram (Source Sodifrance,

métamodèle « Migration Platform ») 76

Figure 45 : TestArchitectureDiagram Diagram 80

Figure 46 : TestDataDiagram Diagram 82

Figure 47 : TraceabilityDiagram Diagram 82

|

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

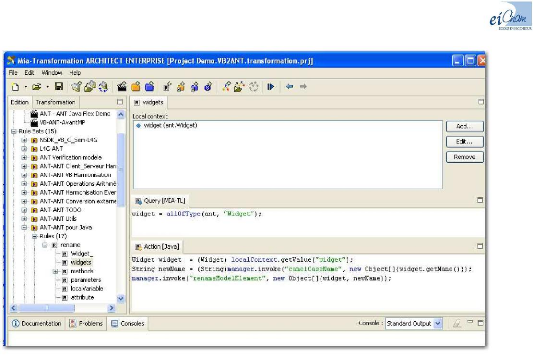

Figure 48 : Copie d'écran du logiciel MIA

Transformation en mode développement 84

Figure 49 : Copie d'écran du logiciel MIA

Transformation en mode trace 84

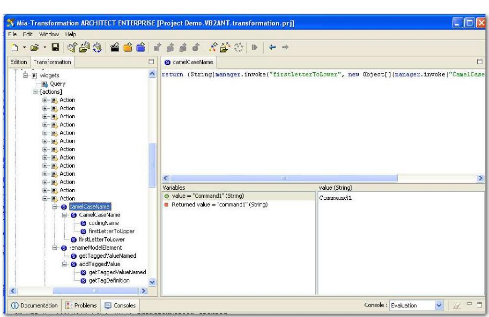

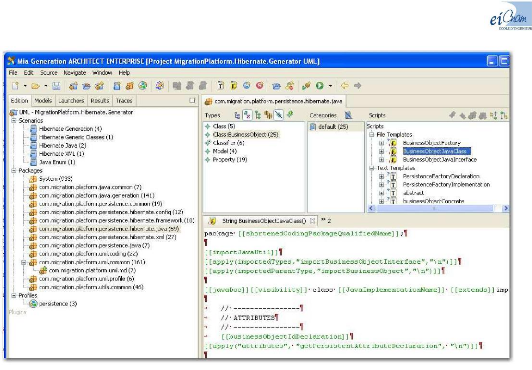

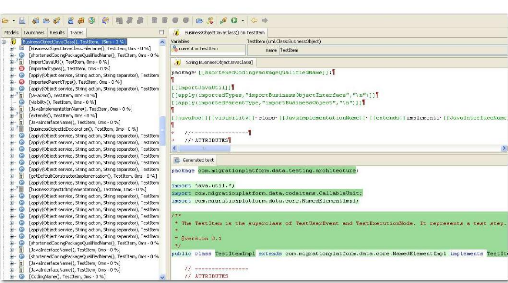

Figure 50 : Copie d'écran du logiciel MIA

Generation en mode développement 86

Figure 51 : Copie d'écran du logiciel MIA

Generation en mode trace 86

Figure 52 : Processus de constitution du Jar à partir d'un

flux XML. 88

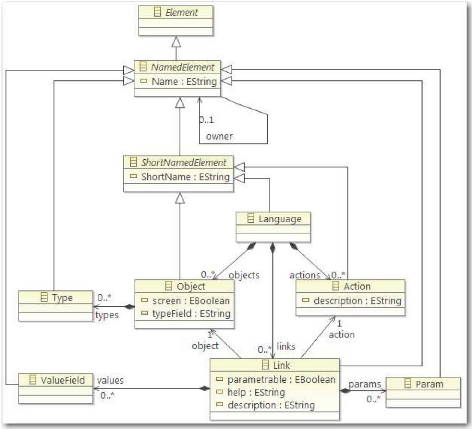

Figure 53 : métamodèle de paramétrage

sYnopsis 92

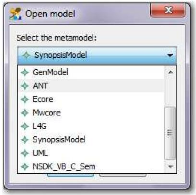

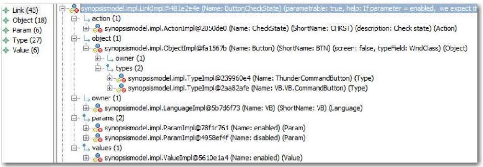

Figure 54 : sélection du métamodèle avec les

outils MIA 94

Figure 55 : exemple de modèle chargé dans MIA

Generation 94

Figure 56 : exemple de génération dans MIA

Generation 95

|

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

Remerciements

Tout d'abord, je tiens à remercier MM. Faia et Breton,

instigateurs puis promoteurs de l'idée de ce cursus d'ingénieur

au CNAM en parallèle à mon activité professionnelle au

sein de Sodifrance. Je remercie aussi toute l'équipe d'évolution

d'architecture de Sodifrance dans laquelle j'évolue actuellement pour

son soutien et son aide, aussi bien morale que technique. Merci aussi à

M. Belleil d'avoir accepté d'être mon tuteur tout au long de ce

mémoire, et aux différents intervenants du CNAM de Nantes pour

leurs prestations de qualité.

Pour finir, je tiens à remercier tout

particulièrement ma femme, pour toutes ces soirées où elle

s'est retrouvée seule à gérer les enfants, la maison,

pendant que son mari étudiait et rédigeait les lignes qui vont

suivre. Sans elle non plus, rien n'aurait été possible, en fait

sans elle, rien n'a vraiment de sens. Merci Valérie.

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

Avertissement

De nombreux termes de ce mémoire sont mentionnés

en langue anglaise. Bien que, dans la plupart des cas, une traduction en

français soit possible, les termes anglais peuvent être tout de

même utilisés si la traduction (par une expression courte)

dénature le concept désigné. Les mots ou expressions en

langue anglaise sont écrits en italique.

|

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

1 INTRODUCTION

Le sujet de ce mémoire, « Stratégie de test

au sein du processus d'évolution d'architecture de Sodifrance », a

été défini d'un commun accord entre mes responsables et

moi-même. Il comprend deux thèmes principaux qui sont la

cartographie des tests d'une part, et l'automatisation des tests d'autre part.

Ce sujet n'a pas été choisi sans raison, il vise à couvrir

un vrai manque dans le processus de migration. En effet, les tests sont

totalement absents de l'automatisation. Réalisés de façon

entièrement manuelle, ils aboutissent à des consommations

très importantes en phase de validation.

Le plan général de ce mémoire s'articule

autour d'une première partie qui présente l'environnement et le

processus d'évolution d'architecture de Sodifrance. La deuxième

partie déclinera l'état de l'art, les travaux

réalisés autour des deux objectifs fixés, et leurs

utilisations dans les projets en cours. La troisième partie

présentera les travaux connexes. Elle sera suivie d'une conclusion

indiquant l'état de la réalisation des objectifs et donnera un

aperçu des orientations futures.

|

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

Figure 1 : Répartition des agences Sodifrance en France et

en Belgique.

|

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

2 L'ENVIRONNEMENT

Avant d'entrer dans le vif du sujet, je vais présenter

dans ce chapitre successivement l'entreprise Sodifrance, puis le processus

« classique » d'évolution d'architecture utilisé lors

des migrations d'applications.

2.1 Présentation de l'entreprise

Sodifrance a été fondée en 1986 par M.

Francis Mazin. Partenaire historique du secteur bancaire, l'entreprise s'est

orientée en 1992 vers la transformation automatisée de

systèmes d'information. L'année 1999 marque un tournant au niveau

organisationnel, en effet cette année survient le décès du

fondateur, et l'entrée en bourse sur le second marché.

L'équipe dirigeante s'organise alors autour d'un conseil de surveillance

et d'un directoire, actuellement composé de :

· M. Franck Mazin : Président du directoire

· M. Yves Lennon : Directeur Général

· M. Frédéric Rivière De

Précourt : Directeur administratif et financier

· Mme Anne-Laure Mazin : Directeur marketing et

communication

Le groupe compte aujourd'hui 870 collaborateurs

répartis en France, Belgique (cf. Figure 1) et Tunisie. Création

en 2004 de la filiale Mia Software afin de capitaliser son savoir-faire dans le

domaine de l'ingénierie des modèles (Model Driven

engineering, MDE), et de commercialiser la suite d'analyse et de

modernisation d'architecture MIA Studio.

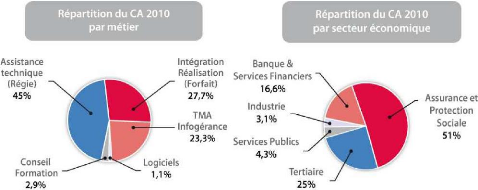

Les chiffres clés de l'année 2010 sont :

· 24 ans d'existence

· 15 ans d'expérience dans l'automatisation des

évolutions d'architectures

· 63 M d'euros de chiffre d'affaire

· Près de 70% du chiffre d'affaire

réalisé dans les secteurs banque et assurance.

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

Figure 2 : Organisation fonctionnelle 2011 (source

Sodifrance)

Phase de cadrage

Exécutée 1 fois

Etude Industrialisation

préalable

Tests de

référence

Intégration

manuelle

Phase industrielle

Exécutée pour chaque lot

Tests de Déploiement

non-régression

Figure 3 : Processus global de migration (source Sodifrance)

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

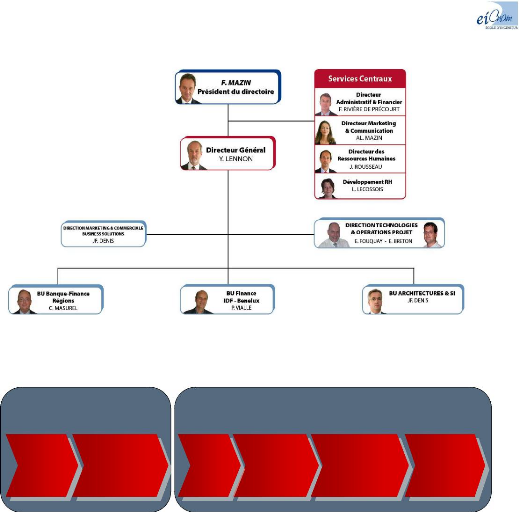

La Figure 2 présente l'organisation fonctionnelle du

groupe. Le découpage matriciel s'articule autour des unités

d'affaires (Business Unit, BU) réparties par région ou

par métier pour la dimension verticale, et de départements

techniques ou marketing pour la dimension transversale.

Je travaille actuellement dans l'équipe

d'évolution d'architecture du département Direction

Technologies et Opérations Projet (DTOP) sous la

responsabilité de M. Breton. Cette équipe réalise

l'ensemble des phases de cadrage lors des migrations.

2.2 Le processus d'évolution d'architecture

Avant de présenter la problématique proprement

dite de ce mémoire, il convient de définir le contexte dans

lequel il s'est déroulé. Comme indiqué

précédemment, j'appartiens à l'équipe

d'évolution d'architecture de Sodifrance. Je devais donc réussir

à intégrer mes travaux dans le processus de migration

existant.

2.2.1 Présentation générale du

processus de migration

Le processus global de migration est divisé en deux

grandes parties :

La phase de cadrage, qui permet de définir

précisément ce qui va être fait :

· étude de la, ou des applications sources

· étude de l'architecture cible

· définition des lots de migration

· adaptation de l'outillage (MIA

Transformation1, MIA Generation2)

· vérification de la validité de la

solution par la réalisation d'un POC (Proof Of Concept) Une

fois la phase de cadrage terminée, l'ensemble des applications à

migrer passe par la phase industrielle. Au cours de cette phase, nous

trouvons:

· les tests de référence

· l'intégration manuelle du code issu de la

génération (rendre le code compilable, corriger manuellement ce

qui n'a pu être généré directement, tests

unitaires).

· les tests de non régression (validation des

résultats des tests de références de l'application source

sur l'application migrée).

· le déploiement sur le site du client

1 MIA Transformation : outil de transformation de

modèles.

http://www.mia-software.com/.../mia-transformation

2 MIA Generation : outil de génération

de code à partir de modèles.

http://www.mia-software.com/.../mia-generation

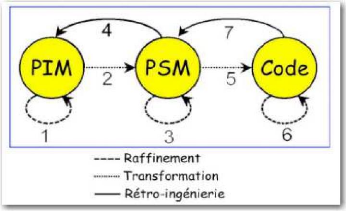

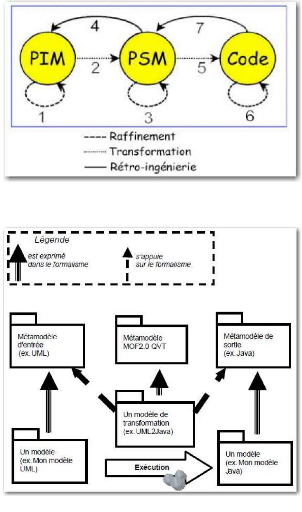

Figure 4 : Les transformations des modèles MDA (Villemin

2011, p.12)

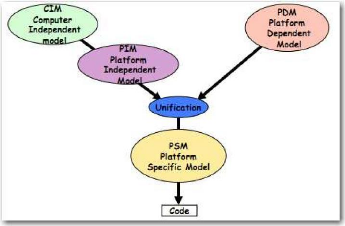

Figure 5 : Unification PIM et PDM pour

produire le PSM puis le code (Villemin 2011, p.14)

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

La seule façon de valider une migration est de passer

les scénarios des tests de référence,

réalisés sur l'application source, sur l'application

migrée. De cette manière, on peut garantir que la migration n'a

pas introduit de régression et est conforme à l'application

source, sur le périmètre des tests de référence

bien entendu. C'est là que l'on s'aperçoit de l'importance de la

couverture des tests de référence. En effet, s'ils ne couvrent

qu'un petit pourcentage de l'application source, toutes les parties non

couvertes risquent potentiellement de contenir des erreurs sur l'application

cible.

2.2.2 Présentation du processus de migration

industrielle

Afin de définir la phase de migration industrielle, il

convient d'approfondir quelques notions. Commençons par l'architecture

dirigée par les modèles (Model Driven Architecture,

MDA). Selon M. Villemin (Villemin 2011) « L'initiative d'architecture

dirigée par les modèles de l'OMG3 "Model Driven

Architecture" (MDA) est motivée par le besoin de

réduire les tâches de reconception des applications

(nécessitées, entre autre, par l'évolution constante des

technologies informatiques) ». Le MDA, qui est une

démarche de développement, répond tout à fait

à ce besoin, car il permet « la séparation des

spécifications fonctionnelles des spécifications d'implantations

sur une plate-forme donnée » (Villemin 2011). Cette

séparation s'effectue avec l'utilisation de modèles

différents décrivant :

· un modèle des exigences (CIM : Computational

Independent Model)

· un modèle de traitements orientés

métier (PIM : Platform Independent Model)

· un modèle d'architecture technique (PDM :

Platform Dependent Model)

· un modèle d'implantation pour une plate-forme

spécifique (PSM : Platform Specific Model). Le passage d'un

modèle à l'autre s'effectue par transformations successives, soit

du modèle le plus abstrait jusqu'au code, soit du code en «

remontant » jusqu'à un modèle abstrait

(retro-ingénierie). La Figure 4 illustre ces différentes

transformations. La Figure 5 quant à elle, illustre l'unification d'un

modèle indépendant de la plate-forme (Platform Independent

Model, PIM), par exemple une gestion de stock, avec un modèle

dépendant de la plate-forme (Platform Dependent Model, PDM),

par exemple un site web. Leur union produit un modèle spécifique

à la plate-forme (Platform Specific Model, PSM), donc dans ce

cas un site web de gestion de stock, qui lui-même permet de produire du

code.

3 OMG : Object Management Group.

http://www.omg.org/

Figure 6 : Le processus d'évolution d'architecture

(source Sodifrance)

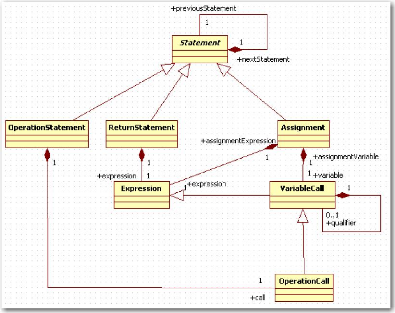

Figure 7 : Extrait du métamodèle architecture

n-tiers (ANT)

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

Ce sont ces différents modèles que l'on retrouve

dans le processus d'évolution d'architecture lors des phases de

transformation (cf. Figure 6 étape 3).

Les sources sont analysées par des outils de d'analyse

syntaxique développés par l'équipe R&D Sodifrance (cf.

Figure 6 étape 1) et alimentent :

· un modèle basé sur un

métamodèle spécifique au langage.

· un outil permettant une analyse du patrimoine4

(cf. Figure 6 étape 2).

On trouve ici une première correspondance avec la

retro-ingénierie du MDA.

Lors de l'étape 3, il y a une série de

transformations qui sont effectuées avec l'outil MIA

Transformation, à partir du modèle de l'application source,

pour obtenir un modèle générique Architecture N

Tiers (ANT5).

Le métamodèle ANT est un

métamodèle propre à Sodifrance, se rapprochant d'UML pour

la définition des classes ou paquetages, mais permettant en plus de

représenter l'ensemble des informations d'un programme, dont notamment

l'algorithmie ou les interfaces graphiques. La Figure 7 nous détaille un

extrait de ce métamodèle.

Toujours durant l'étape 3, de nouvelles

transformations ANT vers ANT sont appliquées pour façonner les

modèles en fonction de l'architecture cible définie par le

client. Il est assez rare que les clients ne sachent pas vers quoi ils veulent

migrer leurs applications. Dans ce cas, nous leur proposons un langage et une

architecture cible. Mais le plus souvent, ils savent exactement vers quoi ils

veulent aller. Certains ont même déjà

développé des applications vers cette cible, d'autres ont

poussé l'exercice jusqu'à produire leurs propres briques

logicielles de base (Framework). A nous d'adapter notre outillage pour

atteindre la cible fixée.

4 MIA-Insight :

http://www.mia-software.com/produits/mia-insight/

5 Le métamodèle ANT a

été conçu par les équipes R&D de Sodifrance.

Comme UML, il permet de définir les applications en termes de classes,

écrans ou package. Mais il permet aussi de stocker les informations

d'algorithmie. Etant insensible au langage source, c'est devenu le

métamodèle de générique de Sodifrance. La plupart

des transformations et des générations s'effectuent vers ou

à partir de ce dernier.

Par exemple, nous pouvons mettre en place des règles

pour créer des nouveaux composants comme des paquetages, des classes,

des variables ou des fonctions, mais aussi créer des instructions

à l'intérieur de ces fonctions. En réalité, on

trouvera au sein de cette troisième étape trois phases

elles-mêmes assez distinctes, et qui là encore rejoignent les

principaux modèles du MDA.

Dans un premier temps, on va chercher à effacer au

maximum les références au langage et à l'architecture

source pour obtenir un modèle « harmonisé ». On tente

autant que possible de passer du PSM au PIM.

Ensuite, on va ajouter des informations indépendantes

de l'architecture ou du langage cible sur les éléments

déjà présents dans le modèle. Ceci afin de

faciliter soit les transformations suivantes, soit la génération

(PIM vers PIM, ou PIM vers PSM vers

code).

Et pour terminer, on va ajouter toutes les informations

nécessaires à la génération vers la solution cible

(PIM vers PSM), avec cette fois-ci des données

liées au langage, au choix d'architecture et bien entendu aux exigences

spécifiques du client.

C'est aussi pendant l'étape 3 que l'on peut extraire

des informations nécessaires pour alimenter des modèles UML

génériques ou spécifiques au client. Cela trouve tout son

sens si le client est déjà dans une démarche de

développement dirigé par les modèles et maintient ses

applications de cette façon (cf. Figure 6 étape 5).

Durant la phase de génération (cf. Figure 6

étape 4), l'outil MIA Generation parcourt le modèle

cible obtenu par les transformations, et produit du code en fonction de scripts

positionnés au niveau des objets du métamodèle. On est

clairement dans la phase PSM vers code de la démarche MDA.

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

2.2.3 Les tests dans le processus de migration

Dans le cadre de ces projets d'évolution

d'architecture, le résultat de la migration est validé en

vérifiant l'iso-fonctionnalité entre l'application d'origine et

l'application migrée. Pour cela, on contrôle que les tests sur les

applications sources et cibles donnent les mêmes résultats. La

charge consacrée à ces tests est donc loin d'être

négligeable, et ce d'autant plus si l'on considère que ces

activités sont menées de manière manuelle, alors que la

migration de code en elle-même est en grande partie

automatisée.

L'enjeu de ce travail de mémoire est donc d'explorer

différentes pistes permettant d'optimiser la gestion des tests et de

mettre en oeuvre une série d'outils afin d'atteindre cet objectif.

Dans le cadre d'un processus de modernisation d'architecture, les

tests sont organisés de la manière suivante :

o Tests de référence : les tests de

référence ont pour but de définir le

référentiel de test qui permettra d'établir

l'iso-fonctionnalité. Ils sont établis sur l'application

source.

o Tests unitaires : validation de manière

indépendante des composants issus de la migration. Les tests unitaires

sont réalisés lors de la phase d'intégration manuelle du

code.

o Tests de non-régression : validation de

l'iso-fonctionnalité de l'application migrée.

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

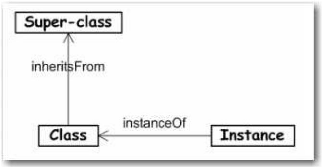

Figure 8 : Notions de base en technologie des objets

(Bézivin 2004)

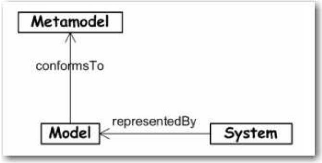

Figure 9 : Notions de base en ingénierie des

modèles (Bézivin 2004)

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

3 LE TRAVAIL REALISE

Après un échange avec mon tuteur et notre

hiérarchie, il a été convenu de traiter les

problématiques de cartographie et d'automatisation des tests. En effet,

c'est à ce niveau que se trouve le plus gros effort manuel et qu'il y a

le plus d'incompréhension entre la vision fonctionnelle des clients et

la nôtre qui est plutôt technique. On peut noter un

élément très important puisqu'il a guidé l'ensemble

de ces travaux : le résultat doit être exploitable par l'ensemble

de notre chaîne d'évolution d'architecture. On verra par la suite

que cela a orienté certains choix. Avant d'aborder le travail

réalisé, faisons un tour d'horizon de l'état de l'art des

principaux sujets.

3.1 Etat de l'art

3.1.1 Model Driven Engineering, Model Driven

Architecture

L'architecture dirigée par les modèles

(Model-Driven Architecture, MDA), présentée au

§ 2.2.2, est « une variante particulière d'une tendance plus

générale nommée ingénierie des modèles

» (Model-Driven Engineering, MDE). Tout comme un des

principes de base de la technologie objet est « tout est objet » (cf.

Figure 8), le principe de base du MDE est « tout est

modèle » (cf. Figure 9) (Bézivin 2004).

Toujours selon M. Bézivin (Bézivin et al. 2007),

le MDE est décrit en se basant sur deux règles

fondamentales :

· Tout type de système peut être

représenté dans un modèle.

· Un modèle doit être syntaxiquement conforme

à un métamodèle.

Il faut bien faire la part des choses entre le système,

qui se base sur le monde réel, et le modèle, qui est d'un niveau

plus abstrait, celui de la modélisation.

Une fois ces notions précisées, les auteurs

(Bézivin et al. 2007) déclinent les grands domaines

d'applications du MDE qui reprennent ceux du MDA :

· Forward engineering, quand le système est

créé à partir du modèle.

· Reverse engineering, quand le modèle est

créé à partir du système.

· Models at run-time, quand le modèle

coexiste avec le système qu'il représente.

Ce sont ces grands domaines que l'on retrouve dans le

processus d'évolution d'architecture de Sodifrance. La

retro-ingénierie correspond à la phase d'analyse du code source

et a pour objectif d'alimenter un métamodèle spécifique au

langage source, décrit comme le modèle initial (cf. Figure 6

étape 1).

La transformation de modèle, réalisée

à l'aide de MIA Transformation, correspond aux transformations

permettant dans un premier temps de passer du métamodèle initial

à un métamodèle dérivé. Dans notre cas, la

cible est un métamodèle générique, le

métamodèle ANT (cf. Figure 6 étape 3). Ensuite, ce

modèle ANT est à nouveau transformé pour répondre

au mieux aux exigences de l'application cible (cf. 2.2.2). La dernière

phase (cf. Figure 6 étape 4) est celle de génération. Elle

correspond au Forward Engineering. L'outil MIA Generation

utilise le modèle ANT comme modèle source et génère

du code en fonction de scripts définis sur les objets du

métamodèle.

On retrouve aussi ce découpage en trois phases dans le

processus d'alimentation de la cartographie qui sera approfondi un peu plus

loin. De manière simplifiée, il y a la phase de

rétro-ingénierie qui alimente un métamodèle

spécifique. Ensuite une transformation permet de passer de ce

métamodèle au métamodèle de cartographie. Et pour

terminer, des services permettent de générer du code (scripts de

rejeu de test) à partir du métamodèle de cartographie.

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

3.1.2 Cartographie d'application

Dans le cadre de la cartographie applicative, on peut trouver

plusieurs objectifs : avoir une vision de haut niveau de ses applications, ou

au contraire, avoir une connaissance très fine de celles-ci en

descendant jusqu'aux lignes de codes qui les composent. Le groupe de travail

modernisation d'architecture dirigée par les modèles

(Architecture-Driven Modernization task force, ADM6) a

défini plusieurs métamodèles pour répondre à

ces besoins, les deux principaux sont le métamodèle de

découverte de la connaissance (Knowledge Discovery Metamodel,

KDM7) et le métamodèle d'arbre syntaxique abstrait

(Abstract Syntax Tree Metamodel, ASTM8).

KDM permet d'obtenir une vision à gros grain des

composants des applications, comme les classes, écrans ou les

données, mais ne descend pas en-dessous des méthodes. ASTM quant

à lui, offre une vision à grain fin de l'application et permet de

représenter l'ensemble de l'algorithmie des programmes. ASTM est

prévu pour être un complément de KDM afin d'avoir une

vision d'ensemble de son parc applicatif.

On retrouve ces deux niveaux de représentation dans

les métamodèles de Sodifrance. ASTM correspond à nos

métamodèles spécifiques à chaque langage source et

au métamodèle ANT. Ils permettent de modéliser cent pour

cent de l'application source. A contrario, le métamodèle de

cartographie est du niveau de KDM et se borne à modéliser les

éléments importants (classes, écrans, fonctions, etc.)

ainsi que les relations qui les unissent. D'ailleurs, notre

métamodèle de cartographie s'inspire fortement de KDM (nommage,

classe de base), mais nous n'avons pas suivi l'ensemble des recommandations de

l'ADM. Nous avions des besoins d'extension de la cartographie pour prendre en

compte des sujets divers comme les tests ou le suivi d'intégration (cf.

Figure 15). Toutefois, cela n'a pas été un critère de

choix décisif, car MM. Dehlen et al. (Dehlen et al. 2008)

démontrent que l'on peut aussi étendre KDM selon ses besoins.

6 ADM : Architecture Driven Modernization (Object

Management Group 2011a)

7 KDM : Knowledge Discovery Metamodel, (Object

Management Group 2010)

8 ASTM : Abstract Syntax Tree Metamodel (Object

Management Group 2011b)

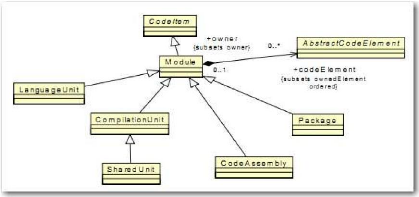

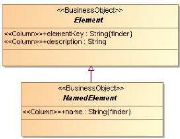

Figure 10 : Diagramme de classe extrait du

métamodèle KDM

(Object Management Group 2010, p.69)

Figure 11 : Diagramme de classe extrait du

métamodèle « Migration Platform »

(source

Sodifrance, partie du métamodèle « Migration Platform

»)

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

En réalité, les critères principaux qui ont

orienté le choix de définir un métamodèle

propriétaire sont d'ordre un peu plus pratique :

· La simplification du métamodèle. Nous

n'avons utilisé que ce qui nous servait réellement. Par exemple,

les informations concernant la compilation ne sont pas présentes dans

notre métamodèle. On remarque bien les similitudes entre les

Figure 10 et Figure 11, mais effectivement, la classe «

CompilationUnit » ou sa sous-classe « SharedUnit

» ne sont pas présentes dans notre métamodèle.

· Nous n'avons pas réussi à obtenir une

manière fiable d'enregistrer nos modèles, parfois très

volumineux (maquettes réalisées avec CDO9 non

concluantes). Donc nous avons opté pour le stockage des informations

dans une base de données relationnelle accessible par le biais de

l'ORM10 Hibernate11. Du fait de cette

simplification du métamodèle et de la stratégie de

persistance appliquée (une table par classe), les jointures sont elles

aussi plus simples, et surtout avec un nombre d'auto-jointures

limité.

· Le résultat de la cartographie doit être

disponible le plus simplement possible pour le reste de la chaîne

d'évolution d'architecture. Dans notre cas, une archive Java (Jar)

incluant l'ensemble de la couche DAO Hibernate est mise à

disposition des outils. Cela répond tout à fait à ce

besoin.

· Enfin, nous sommes très libres dans nos choix

concernant l'évolution du métamodèle. Un

inconvénient est que l'on s'isole des standards et du reste de la

communauté. Mais en contrepartie, cela nous permet de protéger un

certain savoir-faire.

9 CDO : Connected Data Objects (Eclipse project CDO

2011)

10 ORM : Object-relational mapping (Crucianu s. d.,

p.173)

11 Hibernate : cadre de développement libre

pour la correspondance objet-relationnel (Crucianu s. d., p.173)

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

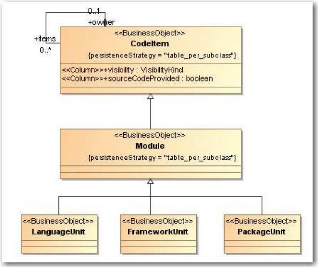

Figure 12 : Le modèle en V (Mirman 2011)

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

3.1.3 Test

3.1.3.1 Généralités

M. Félix donne une définition très

claire de ce qu'est un test (FELIX 2011) : « Toute fabrication de produit

suit les étapes suivantes : conception, réalisation et test. Avec

le test, on s'assure que le produit final correspond à ce qui a

été demandé... ».

Selon l'institut des ingénieurs électriciens et

électroniciens (The Institute of Electrical and Electronics Ehgineers

345 East 47th Street, New York, NY 10017, USA s. d.), « le test est un

processus manuel ou automatique, qui vise à établir qu'un

système vérifie les propriétés exigées par

sa spécification, ou à détecter des différences

entre les résultats engendrés par le système et ceux qui

sont attendus par la spécification ».

M. Gianas affirme que quels que soient les modèles de

conception adoptés, en cascade, en Y ou en V comme le montre par exemple

la Figure 12, on retrouve tout au long du processus de création du

produit les principaux niveaux de tests (Régis-Gianas 2010):

· Test unitaire: le test de composants logiciels

individuels.

· Tests d'intégration : tests effectués pour

montrer des défauts dans les interfaces et interactions de composants ou

systèmes intégrés.

· Test d'acceptation : test formel en rapport avec les

besoins, exigences et processus métier, conduit pour déterminer

si un système satisfait ou non aux critères d'acceptation et

permettre aux utilisateurs, clients ou autres entités autorisées

de déterminer l'acceptation ou non du système.

· Test de régression : tests d'un programme

préalablement testé, après une modification, pour

s'assurer que des défauts n'ont pas été introduits ou

découverts dans des parties non modifiées du logiciel, comme

suites des modifications effectuées. Ces tests sont effectués

quand le logiciel ou son environnement est modifié.

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

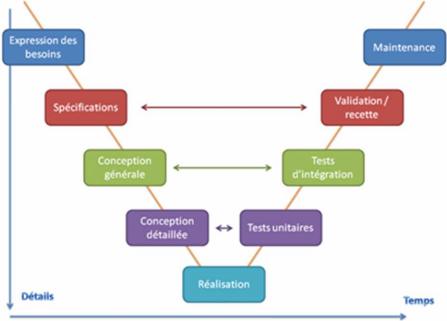

Figure 13 : Implémentation des tests avec NModel

(Chinnapongse et al. 2009)

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

3.1.3.2 Tests basés sur les modèles

(Model Based Testing)

De même que les modèles tendent à

s'imposer dans le monde du développement, la part que

représentent les tests basés sur les modèles commence

à se faire de plus en plus visible. Assez longtemps

délaissée, cette discipline fait désormais l'objet

d'études sérieuses et approfondies. Bien que de nombreux

documents traitent de ce sujet, ils sont souvent ciblés sur une

technologie, un langage ou un environnement.

Dans leur article, MM. Hernandez et al. (Hernandez et al. s.

d.) ciblent le contexte des applications web et des différentes

technologies qui les entoure (HTML, JavaScript, Flash, ActionScript, etc.).

Dans l'objectif de diminuer les coûts de maintenance des scripts de test,

le principe d'automatisation des tests est acquis, et l'utilisation d'un

métamodèle UML vise à ne pas avoir à

réécrire l'ensemble des tests pour chaque environnement cible

(utilisation des principes MDE de transformation des PIM en

PSM). Cependant, tout en utilisant la notion de PIM, le

métamodèle proposé est exclusivement à destination

des environnements web.

Pour MM. Chinnapongse et al. (Chinnapongse et al. 2009), la

cible adressée concerne les appareils portables (Smartphone, etc.).

Globalement, le processus décrit consiste à

· définir un modèle comportemental de

l'application (créé manuellement à partir de la

documentation de l'appareil) avec l'interface de programmation (Application

Programming Interface, API) NModel12.

· le transformer en machine à états finis

(cf. Figure 13, branche model programmer view, mpv)

· générer une suite de tests (cf. Figure

13, branche offline test generator, otg)

· exécuter les tests (cf. Figure 13, branche

conformance tester, ct)

Ici aussi, le contexte adressé est restreint puisqu'il se

limite aux appareils portables, et aux applications développées

en .Net, qui peuvent être testée avec NModel.

12 NModel : est un outil de test basé sur les

modèles et un cadre de développement écrit en C#.

http://nmodel.codeplex.com/

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

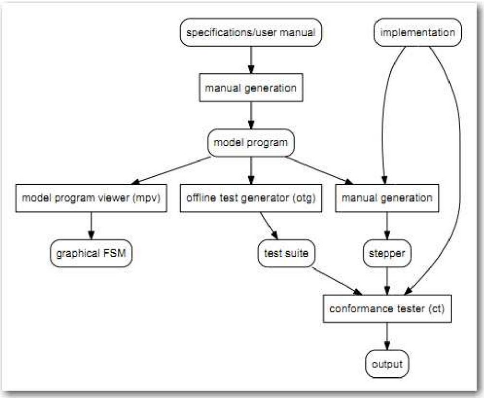

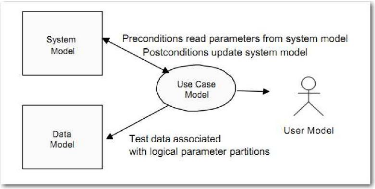

Figure 14 : Relations entre les sous modèles des tests

basés sur les cas d'utilisation

(Use Case Base Testing,

UCBT) (Williams 2001)

M. Williams (Williams 2001) se sert des cas d'utilisation UML

pour décrire le modèle de test et produire des suites de test.

« De même que les classes et leurs concepts associés

nécessitent un métamodèle bien défini afin de

produire du code source, les cas d'utilisation ont besoin d'un

métamodèle précis pour produire des cas de test valides et

robustes. ». Lors des phases de modélisation, les annotations

portées sur les cas d'utilisation déterminent le

sous-modèle cible : modèle système, modèle de

données, modèle des cas d'utilisation ou modèle

utilisateur (cf. Figure 14). Avec cette technique de tests basés sur les

cas d'utilisation (Use Case Based Testing, UCBT13), les

modèles annotés servent à la génération de

suites de test exploitables par l'outil TCBeans14. Les cibles de cet

outil sont des programmes qui possèdent des interfaces de programmation

(Application Programming Interface, API).

13 UCBT : technique d'IBM pour générer

des cas de test à partir de cas d'utilisations.

http://www.research.ibm.com/softeng/TESTING/ucbt.htm

14 TCBeans : logiciel de test conçu pour

élaborer, exécuter et organiser des tests fonctionnels.

https://www.research.ibm.com/haifa/projects/verification/gtcb/index.html

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

Une idée forte qui se dégage de ces

différentes approches des tests basés sur les modèles, est

la réponse à la question suivante : pourquoi faut-il mettre en

oeuvre des tests basés sur les modèles ? La réponse est

très simple : le coût ! (Strohmeier 1996, p.2)

De manière générale, plus une anomalie

est découverte tard, plus elle coûte cher à

résoudre. Sans parler de la constitution des jeux de tests, la

façon la plus efficace de tester une application est d'utiliser un outil

de rejeu de test. On évite ainsi le passage fastidieux des étapes

de test à la main. Ensuite vient le problème de maintenance de

ces tests. C'est là que les tests basés sur les modèles

prennent tout leur sens. On rejoint là encore les avantages du

MDE dans le monde du développement. On retrouve entre autres

l'indépendance entre la logique métier et la plate-forme

technologique ciblée, une meilleure qualité de codage grâce

à la génération du code à partir des

modèles, et cela « force » les concepteurs à formaliser

les spécifications.

Contrairement aux recherches présentées

ci-dessus, nous avons essayé de ne pas limiter notre processus à

certaines technologies ou langages. En effet, nos clients viennent d'horizons

très larges et ont le plus souvent des parcs applicatifs

hétérogènes. Dans la mesure du possible, ils attendent que

nous prenions en compte l'ensemble de leur patrimoine.

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

|

|

|

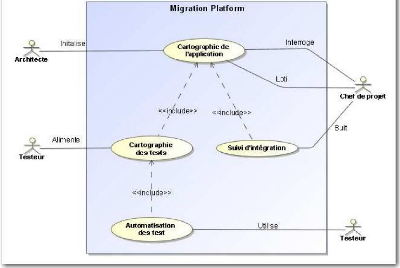

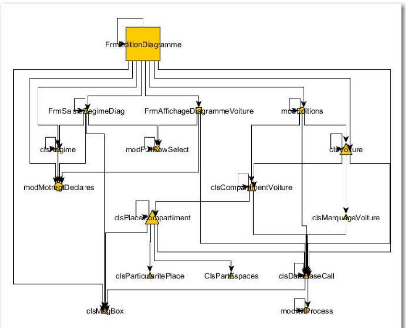

Figure 15 : Cas d'utilisation de la plate-forme de migration

(« Migration Platform »)

Figure 16 : Vue d'ensemble des paquetages constituant le

métamodèle « Migration Platform »

(Source

Sodifrance, les parties que j'ai modélisées sont en vert)

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

3.2 Plate-forme de migration (« Migration

Platform »)

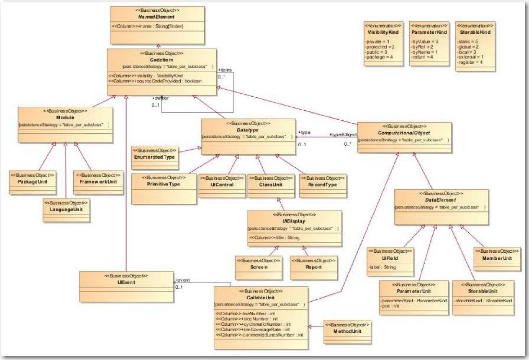

La Figure 15 représente les principaux cas d'utilisation

du système « Migration Platform ». Ils sont

répartis de la manière suivante :

· La cartographie de l'application représente la

base de l'ensemble et contiendra tous les composants applicatifs du projet

(fenêtres, composants graphiques, classes, fonctions).

· La cartographie des tests intègre les

différentes données propres aux tests et s'appuie sur

la

cartographie de l'application pour indiquer quels sont les composants

utilisés par les tests.

· Le suivi d'intégration quant à lui permet

d'avoir un historique des niveaux d'intégration par composant.

· Ensuite vient l'automatisation des tests qui s'appuie

sur la cartographie des tests. Elle permet, comme on le verra un peu plus loin,

de spécifier une relation entre les composants sources et cibles

présents dans la cartographie de l'application.

Les différents acteurs sont l'architecte, qui a pour

rôle principal d'initialiser et de vérifier que la cartographie de

l'application est correcte ; le testeur qui alimente la cartographie des tests

d'une part, et génère les scripts de tests d'autre part ; le chef

de projet qui utilise la cartographie de l'application pour obtenir

différentes visions de celle-ci, et qui se sert du suivi

d'intégration pour avoir une idée réaliste de

l'état d'avancement de l'intégration. Ces différents cas

d'utilisation sont détaillés dans les paragraphes suivants.

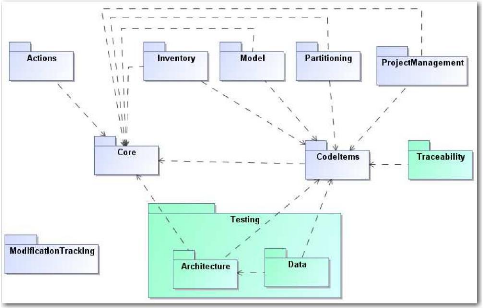

La Figure 16 représente la répartition des

paquetages constituant le système plate-forme de migration («

Migration Platform »). On peut remarquer que les deux principaux

paquetages coeur (« Core ») et éléments de

code (« CodeItems ») forment un noyau autonome. Les autres

« fonctionnalités » viennent se greffer sur ce noyau et sont

indépendantes entre elles, mis à part les deux paquetages

architecture de test (« Testing.Architecture ») et

données de test (« Testing.Data ») qui sont

regroupées au sein du paquetage test.

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

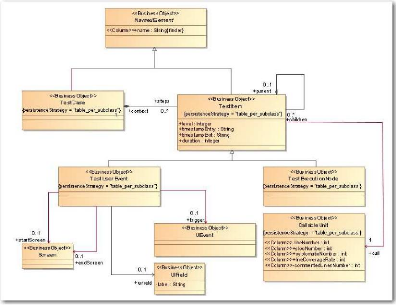

3.2.1 La cartographie des applications

Avant d'approfondir les deux principaux objectifs de ce

mémoire, se pose le problème essentiel de la cartographie des

applications. En effet, pour pouvoir indiquer quels composants sont

utilisés par un scénario de test, il faut déjà

pouvoir lister de manière exhaustive l'ensemble des composants de

l'application et les identifier de manière unique.

Comme indiqué dans l'état de l'art, nous ne

nous sommes pas servis de KDM. Cependant, bien que fortement

simplifié, nous nous en sommes grandement inspirés pour concevoir

le métamodèle « Migration Platform ». La

réalisation de ce métamodèle est le fruit d'un travail

commun entre mon responsable, M. Breton, un collègue, M. Pacaud et

moi-même. Plus précisément, mon rôle a

été de concevoir les parties afférentes aux tests :

· Le paquetage architecture des tests (« Testing

Architecture », cf. Figure 20)

· Le paquetage données de test (« Testing

Data », cf. Figure 21)

· Le paquetage traçabilité («

Traceability », cf. Figure 28)

Ces diagrammes de classe sont détaillés dans les

§ 3.2.2 et 3.2.3.

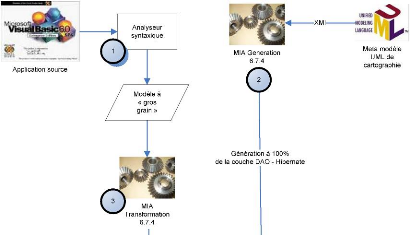

Figure 17 : Processus d'alimentation de la cartographie

d'application

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

Le métamodèle « Migration

Platform » a été réalisé avec le modeleur

UML MagicDraw, sous la forme d'un modèle UML. Il est

décrit principalement par des paquetages, des classes, des attributs et

des relations. MIA Generation permet d'importer un fichier

XMI15 exporté depuis MagicDraw. Nous nous en sommes

servi afin de générer entièrement la couche de persistance

DAO16 Hibernate dans le langage Java17 (cf. Figure 17

étape 2). Nous remplissons ainsi deux des contraintes initialement

fixées, à savoir une façon simple d'exposer les

données aux outils de la chaîne d'évolution d'architecture.

Mais aussi, une solution performante, car même en cas de

volumétrie importante, c'est sur le moteur de base de données

relationnelle (SGBDR18) que repose principalement ce

problème, or il est justement prévu pour ça. Cette couche

de persistance sera intégrée aux outils sous la forme d'une

archive Java (Jar) déposée dans des répertoires

prédéfinis, par exemple : <répertoire installation

MIA Generation>\tools\lib.

La Figure 17 qui présente le processus de cartographie

des applications, permet de voir l'ensemble des actions qui, en partant de

l'analyse du code source, permet de peupler la base de données «

Migration Platform ». En premier lieu se déroule l'analyse

syntaxique du code source (cf. Figure 17, étape 1) afin de produire un

modèle de l'application à « gros grain ». Ce

modèle est du même niveau que KDM et ne descend pas

jusqu'aux instructions mais s'arrête aux méthodes et aux relations

qui les unissent. On évite aussi, grâce à ce niveau de

modèle, des problèmes de volumétrie. En effet, il n'est

pas rare d'avoir à « découper » des applications

sources en plusieurs parties afin que le volume des modèles soit

compatible avec les outils MIA, on parle ici de modèles XMI d'environ

une centaine de mégaoctets. Ce découpage pose de sérieux

problèmes de résolution de type à l'analyseur, lorsqu'une

classe qui est décrite dans un modèle est utilisée dans un

autre.

Après avoir déposé l'archive Java issue

de l'étape 2 dans le répertoire prévu à cet effet,

et effectué quelques paramétrages (adresse de la base de

données, type de serveur), MIA Transformation peut lire le

modèle de l'application source fourni par l'analyseur syntaxique, et

peupler la base de données « Migration Platform »

(cf. Figure 17, étape 3).

15 XMI : XML Metadata Interchange

16 DAO : Data Access Object

17 Java : langage de programmation orienté

objet

18 SGBDR : Système de Gestion de Base de

Données Relationnelle.

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

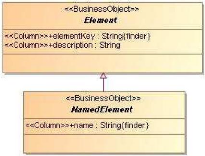

Figure 18 : Diagramme de classe du paquetage « Core

»

(source Sodifrance, extrait du métamodèle «

Migration Platform »)

Figure 19 : Diagramme de classe du paquetage « CodeItems

»

(source Sodifrance, extrait du métamodèle «

Migration Platform »

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

Attardons-nous un instant sur la manière dont sont

identifiés les éléments au sein de la base. Les classes

servant à la cartographie héritent de la classe «

Element » (cf. Figure 18 et Figure 19). Cette classe

possède une propriété « elementKey »

qui est essentielle. En effet, c'est elle qui assure l'identification de

manière unique de chaque élément. La construction de cette

clé répond à des règles très strictes qui,

on le verra par la suite, devront être respectées à tous

les niveaux du processus de migration. Ce formalisme consiste à

reprendre l'ensemble de la clé de l'élément parent, et

à y ajouter l'identifiant de l'élément courant.

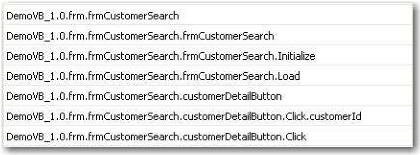

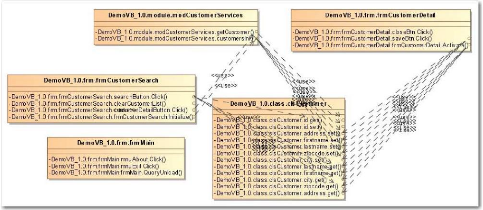

Tableau 1 : Exemples de clefs

Le Tableau 1 montre un exemple concret de cette notation avec

le modèle « DemoVB_1.0 ». Le conteneur «

frmCustomerSearch » se trouve dans le répertoire «

frm ». L'écran « frmCustomerSearch »

contient les événements « Initialize » et

« Load », et a aussi un contrôle graphique

nommé « customerDetailButton ». Ce dernier a un

événement « Click » qui utilise une variable

« customerId ».

Ce système de classification arborescente permet de

lister l'ensemble des composants de l'application de manière exhaustive.

L'élément racine correspond au modèle présent en

base et représente l'application, vient ensuite s'il y a lieu,

l'arborescence des répertoires, puis les fichiers. Dans le modèle

de l'application source, le type du fichier : écran, classe, module,

etc., a déjà été déterminé par

l'analyseur syntaxique. Enfin, on retrouve les méthodes, leurs

propriétés, et le type de retour s'il s'agit des fonctions. Le

fait d'avoir intégré l'arborescence complète des fichiers,

permet de prendre en compte plusieurs fichiers portant le même nom mais

présents dans des répertoires différents.

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

Figure 20 : Les classes du paquetage architecture des tests

(« Testing.Architecture »)

du métamodèle

« Migration Platform »

Figure 21 : Les classes du paquetage données de test

(« Testing.Data »)

du métamodèle «

Migration Platform »

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

3.2.2 Objectif 1 : cartographie des tests

L'instrumentation du code source, détaillé au

§ 4.2, doit fournir, à la suite du passage des tests de

références, deux types de flux XML. Dans le premier, on va

chercher à ajouter du code pour chaque méthode, juste

après l'entrée et juste avant chaque instruction de sortie. On

obtient ainsi une arborescence des appels de méthodes. Le second flux

permet de connaître pour les méthodes de type «

événement utilisateur » l'état de l'ensemble des

éléments graphiques d'un écran à un instant

donné. Il est alimenté, comme le précédent, lors de

entrée et de la (ou des) sortie(s) de la méthode.

Un service Java permet de lire ces flux et de les

intégrer à la base « Migration Platform ».

Cela revient à insérer les tests de référence en

base. Ils sont vus comme des cas de test, composés

d'éléments, qui sont soit des appels de méthode simple :

« testExecutionNode » (cf. Figure 20), soit des appels de

méthodes événementielles : « testUserEvent

».

Ces derniers ont alors un état d'entrée et de

sortie de l'écran : « UIState » (cf. Figure 21). Il

est luimême composé d'un ensemble de paires clé / valeur

permettant de représenter les propriétés de chaque

composant de l'écran.

En Visual Basic 6, langage de programmation sur lequel a

été réalisé une grande partie des maquettes,

l'introspection n'est pas totalement implémentée.

C'est-à-dire qu'on ne peut pas connaitre dynamiquement l'ensemble des

propriétés d'un composant graphique par exemple. En revanche, si

on connaît le nom des propriétés pour lesquelles on veut la

valeur, la commande « CallByName » permet d'interroger dynamiquement

la propriété du composant et d'obtenir sa valeur. Il a donc fallu

définir par le biais d'un fichier de configuration les composants

graphiques et les propriétés faisant l'objet d'une «

surveillance » de la part de l'instrumentation.

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

Figure 22 : Exploitation de la cartographie pour produire un

diagramme de classe

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

3.2.2.1 Vision statique et dynamique de la

cartographie

Avant l'insertion des tests, la base de donnée ne

contient que ce que l'analyseur syntaxique a pu lui fournir. Pour garder le

langage Visual Basic en exemple, l'instruction :

Public Function getCustomer() as clsCustomer

sera interprétée comme une fonction renvoyant

une instance de la classe « clsCustomer ». Dans le modèle, il

en résulte la création d'un lien entre cette fonction et la

classe « clsCustomer ». En revanche, l'instruction suivante ne

donnera pas les mêmes résultats :

Public Function getCustomer() as Object

En effet, même si dans le corps de la méthode,

les instructions font que le type renvoyé sera effectivement une

instance de la classe « clsCustomer », l'analyseur syntaxique ne

réussira pas à résoudre cette relation. On arrive alors

aux limites de l'analyse statique du code. Grâce à

l'instrumentation de toutes les méthodes du code source, la trace XML

permettra de mettre en évidence, à l'intérieur de la

fonction « getCustomer » l'accès au constructeur de la classe

« clsCustomer » ou à des méthodes liées à

cette classe. On obtient donc une vision dynamique de l'application. On pourra

donc ajouter la liaison non résolu par l'analyseur syntaxique entre la

fonction et la classe

Au niveau de la base « Migration Platform

», on ajoute à la vision statique de l'analyseur la vision

dynamique fournie par les tests de références. Au passage, on

peut noter qu'on répond à une des exigences initiales : le point

d'entrée étant un cas de test, on connait l'exhaustivité

des composants utilisés par ce cas de test.

Concernant le langage Visual Basic, il peut être

utilisé de manière assez libre et devenir très peu

typé. Cette vision dynamique est indispensable afin d'obtenir une

idée claire de l'ensemble des relations entre les composants de

l'application.

3.2.2.2 Représentation graphique de la

cartographie des tests

J'ai étudié et maquetté sous forme de

services Java plusieurs types de représentations graphiques.

A partir des données de la cartographie d'application,

j'ai produit un modèle UML qui exporté au format XMI puis

importé dans MagicDraw, permet d'obtenir un diagramme de classe

et de visualiser les relations entre les opérations (cf. Figure 22).

Figure 23 : Exploitation de la cartographie de test pour

produire un diagramme de séquence

Figure 24 : Exploitation de la cartographie pour produire un

diagramme de classes... inutiisable

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

Ensuite, à partir de la cartographie de test, j'ai

produit un diagramme de séquence, plus approprié à

représenter les cas de tests, car il permet de garder la chronologie

entre les appels. Contrairement à UML 1.3, UML 2 n'intègre plus

lors dans son format d'import de fichier XMI la description des diagrammes.

Elles sont déportées dans des extensions spécifiques

à chaque modeleur. J'ai donc utilisé la version UML 1.3 et le

modeleur Star UML afin d'importer le diagramme de séquence (cf. Figure

23).

Ces deux types de représentation, bien que reconnues

de par leur formalisme, ne conviennent pas ou ne répondent pas de

façon satisfaisante à nos besoins. On observe aisément que

les problèmes de volumétrie vont vite devenir

rédhibitoires. Sur une application un peu plus conséquente, le

diagramme de classe mis en forme de manière automatique devient

très rapidement illisible (cf. Figure 24).

On arrive au même souci avec le diagramme de

séquence sur des cas de test plus imposants, d'ailleurs la Figure 23

n'est qu'un extrait d'un diagramme beaucoup plus important. Partant du principe

que le besoin initial est de représenter des objets et leurs relations,

je me suis orienté vers un logiciel de graphe reconnu :

yEd19. Bien sûr l'idée n'est pas d'opposer

MagicDraw et yEd, ces deux logiciels ayant chacun leurs

fonctionnalités, mais de chercher à obtenir une

représentation de l'information exploitable, même en cas de

volumes de données important.

19 yEd : Editeur graphique :

http://www.yworks.com/.../yEd.html

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

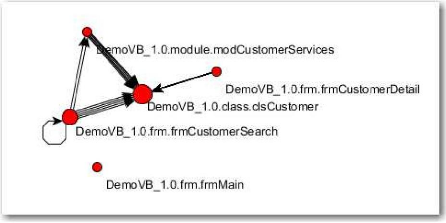

Figure 25 : Exploitation de la cartographie pour produire un

graphe

Figure 26 : Graphe hiérarchique d'appels entre

éléments

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

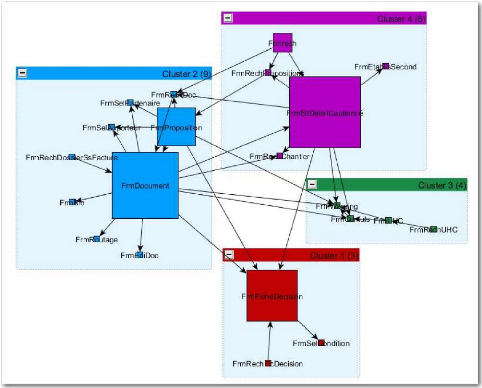

yEd est un logiciel spécialisé dans la

représentation et la mise en forme des graphes. Les graphes sont

composés de noeuds reliés entre eux par des arcs. Par exemple, la

Figure 25 a les mêmes données d'origine que la Figure 24,

simplifié puisqu'on ne détaille pas les méthodes, et mise

en forme selon l'algorithme « organique » définit par

yEd. Il a pour particularité de donner un « graphe

groupé, une répartition équilibrée des noeuds et

peu de croisements d'arcs »20. Outre les nombreuses options de

mises en forme, il y a des fonctionnalités poussées de recherche

et de sélection des noeuds, selon des critères aussi divers que

leurs noms, leurs couleurs, les prédécesseurs de, les successeurs

de.

Par exemple, il est très simple de sélectionner

un noeud ainsi que tous ses descendants, et ensuite de créer un nouveau

graphe à partir de cette sélection. Ici, la Figure 26 reprend les

éléments sélectionnés dans un graphe beaucoup plus

important et les disposent sous forme hiérarchique.

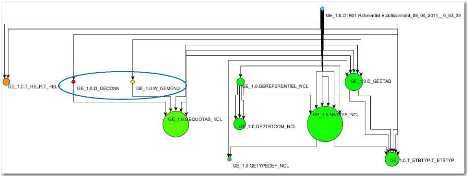

Figure 27 : Exploitation de la cartographie de test pour

produire un graphe hiérarchique

Un inconvénient tout de même si on compare le

graphe hiérarchique au diagramme de séquence, on peut voir qu'on

perd la chronologie exacte des appels de méthodes. En fait l'ordre

général est conservé, mais quand une méthode en

appelle deux autres, on ne peut plus savoir laquelle des deux a

été appelée en premier. Dans la Figure 27, on ne sait pas

quel élément de « GE_1.0.D_GECONN » ou «

GE_1.0.W_GEMENU » est appelé en premier à partir de «

GE_1.0.DTR01 Référentiel

Etablissement_08_04_2011__9_53_39 ».

20 source documentation yEd

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

yEd donne la possibilité de modifier l'aspect

graphique des éléments du graphe. Ainsi, nous avons

déterminé une formule21 donnant une valeur, un poids,

en fonction de la complexité des composants. Le poids d'une classe ou

d'un écran correspond à la somme des poids de ses

méthodes. Il est ensuite très facile de modifier la taille d'un

élément en fonction de son poids, et donc de sa

complexité. Il en ressort des graphes dans lesquels les composants les

plus complexes, en général ceux qui devront recevoir une

attention particulière, sont facilement identifiables (cf. Figure

27).

La troisième piste utilisée pour

représenter les informations de cartographie a été le

développement d'un plugin Eclipse par un stagiaire en Master 2

Informatique que M. Pacaud et moi-même avons encadré, sous la

responsabilité de M. Breton. Ce plugin décrit plus en

détail dans le § 4.1, est plutôt à destination des

chefs de projet qui souhaitent suivre l'avancement de l'intégration des

projets. On y retrouve sous forme arborescente la cartographie de l'application

ainsi que les scénarios de tests et l'avancement de l'intégration

de chaque composant. L'outil est complété par des vues donnant

des indications de volumétrie selon des angles différents :

nombre de composants graphiques par type, nombres d'événements

graphiques par type d'événement et de composant, etc.

21 Cette formule met en relation le nombre de lignes

de code (Source Line Of Code, SLOC), le nombre cyclomatique, et pour

un écran, le nombre de composants graphiques.

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

3.2.3 Objectif 2 : automatisation des tests

Les tests sur les applications cibles se font à l'aide

d'outils de rejeu de test, comme FlexMonkey22 pour une

application Flash par exemple. Habituellement, il faut jouer les

scénarios de test sur l'application à tester afin que l'outil

enregistre les actions qui sont effectuées sur l'interface graphique.

L'idée de l'automatisation des tests, c'est de mettre en place un

processus dont la finalité permettra d'alimenter automatiquement les

outils de rejeu de test. Or, l'ensemble du processus mis en place vise à

atteindre cet objectif. L'instrumentation du code source remplace la phase

d'enregistrement des actions sur l'application cible.

L'outil de test doit être en mesure d'identifier chaque

composant de l'application cible afin de pouvoir tester les valeurs de ses

propriétés ou d'effectuer des actions dessus. On commence

à percevoir le problème de l'automatisation lorsqu'on sait que le

processus d'évolution d'architecture intègre les conventions de

nommage du langage cible, ou encore les spécifications propres à

chaque client.

Au cours de la migration, il faut donc avoir une solution

pour établir un lien entre les composants de la source et ceux de la

cible. Ceci est rendu possible en intégrant trois actions dans le

processus de migration industrielle.

Une première action, en tout début de

processus, consiste à « attacher » une clé à

chaque composant avant que ceux-ci n'aient été renommés ou

modifiés. Cette clé est construite selon le même format que

celui décrit au § 3.2.1.

La deuxième action se situe quant à elle en

toute fin de processus. A ce niveau, les composants ont pu être

renommés, déplacés, ou même avoir changés de

type. En effet un client peut demander à changer tous les boutons «

OK » en liens hypertexte « Valider ». On reconstruit une

nouvelle clé, en suivant les mêmes règles qu'avec la

clé d'origine et encore une fois, on l'« attache » au

composant. Chaque composant se retrouve donc « agrémenté

» de deux clés, celle de la source et celle de la cible.

22 FlexMonkey : outil de rejeu de test

spécifique aux applications Flash :

http://www.gorillalogic.com/flexmonkey

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

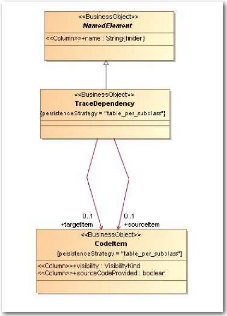

Figure 28 : Les classes du paquetage traçabilité

(« Traceability )

du métamodèle « Migration

Platform »

L'action finale se résume à insérer dans

la base de données Migration Platform, les nouveaux composants cibles

mais aussi leurs relations avec les composants issus de la cartographie

statique par le biais du paquetage de traçabilité («

TraceDependency », cf. Figure 28).

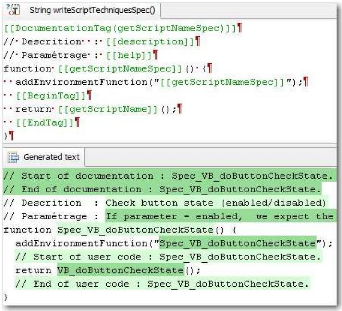

3.2.3.1 Génération des scripts de

test

La génération des scripts de test se fait alors

en parcourant les enregistrements de test, qui pointent sur des composants

sources, et pour chaque composant, en cherchant le composant cible qui lui est

associé. Pour chaque événement en base, on retrouvera

trois actions de génération :

· Positionner les propriétés qui

n'auront pas été changées de manière

événementielle. Par exemple, dans le scénario de test, on

coche une case, et il n'y a pas d'événement associé

à cette action. L'instrumentation du code source n'aura donc pas

ajouté de code pour suivre l'évolution de cette case à

cocher. En revanche, l'événement Click du bouton OK

déjà existant, aura été instrumenté.

L'instrumentation vérifiera l'ensemble des zones de l'écran et

informera que la valeur de la case à cocher a changé. Il restera

alors soit à modifier

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

la propriété, soit à déclencher un

événement afin de modifier la propriété. On peut

noter deux choses importantes :

o seules les propriétés modifiées depuis le

dernier appel sont remontées par l'instrumentation.

o il ne faut pas tenir compte des propriétés du

composant sur lequel porte l'événement en cours. Elles seront

modifiées par l'événement lui-même.

· Déclencher l'événement. Après

avoir positionné les propriétés des autres composants, on

peut déclencher l'événement enregistré. Dans notre

exemple, il s'agira du clic sur le bouton.

· Vérifier les propriétés

après l'événement. L'événement

Click du bouton OK aura déclenché des appels aux

services métier, et les données présentes à

l'écran auront pu être modifiées. L'instrumentation nous

fournit les valeurs des propriétés des composants de

l'écran à la fin de l'événement. Il reste donc

à vérifier que les données attendues ont bien

été mises à jour par l'appel à

l'événement Click et aux services métier.

Pour être précis, il y a bien quelques cas

particuliers à gérer, comme les événements ou

propriétés parasites qu'il y peu d'intérêt à

observer. Par exemple, toujours pour Visual Basic, le changement de ligne dans

une Combobox changera les propriétés Text et SelectedIndex. Seule

la propriété SelectedIndex sera à positionner, le texte de

la Combobox sera mis à jour implicitement.

Certaines propriétés ne font en fait

référence qu'à une seule action de l'utilisateur. Le clic

dans la cellule d'un tableau mettra à jour les propriétés

ColIndex puis RowIndex. Ceci est dû au fonctionnement de

l'instrumentation qui ne peut tester qu'une propriété à la

fois.

Au final sur la cible, il ne faudra générer qu'un

clic sur la grille dans la cellule correspondant aux coordonnées des

propriétés ColIndex et RowIndex.

Un événement utilisateur peut demander deux

événements sur la cible. Cliquer sur une ligne d'une ComboBox

peut obliger à effectuer auparavant un Scroll afin que la ligne à

cliquer soit visible. Cette limitation peut provenir de la technologie de

l'application cible. Pour Flex23 par exemple, on est bien dans ce

cas. On obtient donc un événement source qui doit en produire

deux sur la cible, le Scroll puis le Click.

23 Flex : Le logiciel est un outil Open Source de

développement d'applications web

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

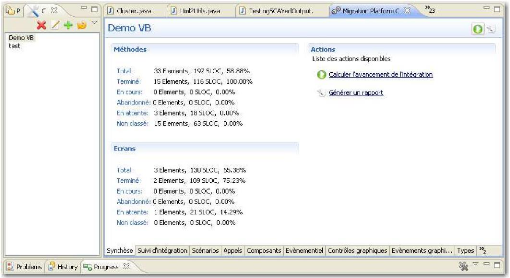

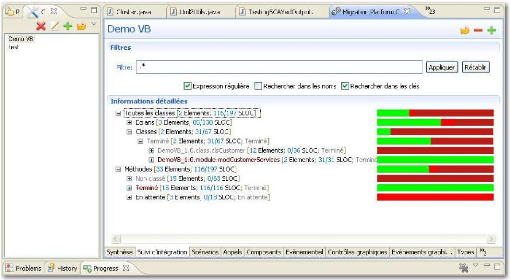

Figure 29 : Vue de synthèse du plugin Eclipse (source

Sodifrance)

Figure 30 : Vue du suivi d'intégration du plugin Eclipse

(source Sodifrance)

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

4 LES TRAVAUX CONNEXES

4.1 Réalisation d'un plugin Eclipse

Durant la réalisation de ce mémoire, j'ai eu

à encadrer le stage en entreprise d'un étudiant en Master 2 en

Informatique, spécialité architecture logicielle de

l'université de Nantes. L'objectif de son stage était la

réalisation d'un plugin Eclipse permettant de suivre l'avancement de

l'intégration des projets de migration. Cet outil de suivi est

centré sur la base de cartographie à laquelle des notions de

suivi ont été greffées, et sur l'analyse des codes sources

en cours d'intégration.

Dans le processus classique de migration, les scripts de

génération des méthodes et des classes ont

été modifiés afin d'intégrer deux types de balises

:

· Une balise identifiant qui ne doit pas être

supprimée.

· Des balises de début et de fin de

méthode.

Elles ont toutes comme information principale l'«

elementKey », leur identifiant en base. Lorsque l'intégrateur

commence à travailler sur une méthode, il supprime la balise de

début.

La méthode est alors reconnue comme étant en

cours d'intégration. Ensuite, lorsque l'intégrateur estime qu'il

a terminé sa méthode, il supprime la balise de fin. La

méthode passe alors en statut terminé. Si on prend pour exemple

une méthode qui contient dix lignes de code et qui a ses balises de

début et de fin, elle comptera pour zéro ligne

intégrée. Avec cette même méthode, si la balise de

début a été supprimée, elle comptera pour cinq

lignes intégrées. Et enfin si cette méthode n'a plus ni

balise de début ni balise de fin, elle comptera pour l'ensemble de ses

lignes de code, donc pour dix lignes intégrées. Ensuite, pour

connaître le niveau d'intégration de la classe, on calcule le

rapport entre le nombre de lignes de code intégrées et le nombre

de lignes de code total. Certes, ce mécanisme assez basique, laissant

des actions manuelles à la charge des intégrateurs n'est pas

parfait. En effet, la plupart des erreurs proviennent justement de ces

interventions humaines. Mais il permet tout de même d'avoir sur

l'ensemble de l'application une idée assez précise de

l'avancement de l'intégration.

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

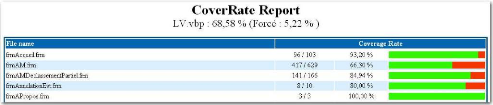

Figure 31 : Copie d'écran de la page Html du taux de

couverture de l'application LV

Figure 32 : Copie d'écran de la page HTML

détaillant le code d'une méthode de l'application LV

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

4.2 Instrumentation

J'ai réalisé une suite d'outils permettant

d'injecter du code dans des applications Visual Basic. L'objectif de ces

injections est de produire des traces au format XML qui seront

interprétées puis insérées dans la base de

cartographie.

4.2.1 Taux de couverture

Le taux de couverture des tests de références est

calculé de la manière suivante :

· On ajoute un appel à une méthode de

comptage pour chaque ligne de code. Chaque appel prend en paramètre un

compteur qui devient son identifiant. Dans le même temps, on

insère dans une table de base de données une ligne correspondant

à la ligne de code traitée, avec bien sûr le même

identifiant.

· Ensuite, lors de l'exécution de l'application

instrumentée, après chaque ligne de code, il y aura l'appel

à la fonction de comptage. Cette dernière peut selon un

paramétrage, soit produire une trace XML donnant la liste des lignes

appelées, soit mettre à jour directement la ligne correspondant

à son identifiant en base.

· Au final, on se retrouve avec une table contenant

l'ensemble des lignes de l'application, et pour chacune d'elle, un indicateur

spécifiant si elle a été utilisée lors de

l'exécution ou non. De simples requêtes suffisent ensuite pour

connaître le taux de couverture24.

J'ai aussi développé un outil produisant un

site web statique permettant de mieux visualiser le taux de couverture (cf.

Figure 31). La première version de l'outil de couverture était

d'une certaine manière plus « intelligente » car elle

n'ajoutait pas d'appels à chaque ligne de code, mais uniquement au

début des méthodes et dans chaque branche (conditions, boucles),

en indiquant le nombre de lignes de code de chaque bloc. La Figure 32

démontre la nécessité d'instrumenter toutes les lignes de

l'application.

En effet, ici si l'instruction «

CommonDialog.ShowPrinter » provoque une erreur, le reste des lignes

jusqu'au traitement d'erreur ne sera pas exécuté. Or, avec la

logique précédente, dès l'entrée dans la

méthode, l'ensemble des lignes se trouvant hors d'une condition ou d'une

boucle, aurait été considérées comme

passées, ce qui est faux, puisque la gestion d'erreur force le

débranchement jusqu'à la balise « ErrHandler: », donc

les lignes 1013 à 1018 n'ont pas été

exécutées.

24 100 . nombre de lignes utilisées

nombre de lignes total

).

Taux de couverture : (

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

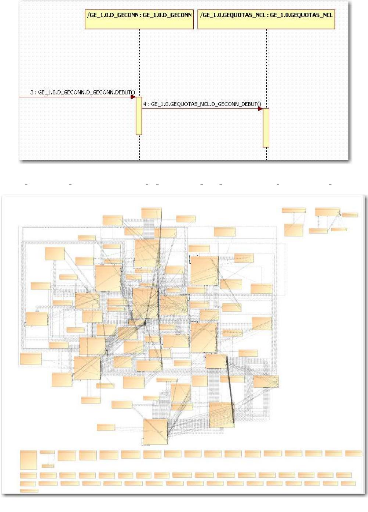

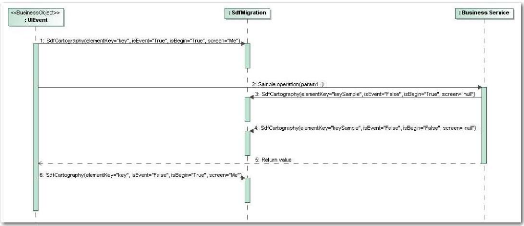

Figure 33 : Diagramme de séquence d'appels à

l'opération « SdfCartography »

de la classe «

SdfMigration ».

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

|

|

|

4.2.2 Cartographie dynamique, état des composants

graphiques

La cartographie dynamique est basée sur l'ajout

d'appels à des fonctions de trace en début et en fin de

méthode. L'ensemble des méthodes de l'application source

étant instrumentées, cela permet d'obtenir un graphe des appels

entre méthodes et donc de résoudre les appels dynamiques (cf.

§ 3.2.2.1).

A noter que les méthodes

évènementielles, produiront en plus un état de

l'écran courant avant et après l'évènement. Cela

donnera la possibilité de connaitre les impacts d'un

évènement sur les données affichées à

l'écran. Le diagramme de séquence d'appel à

l'instrumentation (cf. Figure 33) illustre ce propos. En début

d'événement ou de méthode, le booléen isBegin est

à Vrai. Le booléen isEvent dépend du type de

méthode. La clé correspond à la clé utilisée

en base et l'écran est l'écran courant dans le cas d'un

événement. En fin de méthode, seul le booléen

isBegin passe à Faux.

Cet outil d'instrumentation était spécifique au

Visual Basic, mais un nouvel outil fonctionnant à base de règles

prend maintenant en charge plusieurs langages (VB, NSDK, NatStar, etc.). La

contrainte pour cet outil est de respecter le format XML qui avait

été défini, ainsi que de produire des clés

conformes à la spécification.

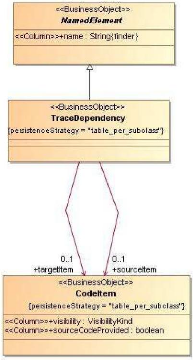

4.3 Partenariat avec la société

Kalios

Même si nous en avons la possibilité, notre but

n'est pas de générer des scripts pour tous les outils de rejeu de

test du marché. La réalisation de maquettes a permis de valider

la viabilité de ce concept (maquette VB6 vers Java/Flex, outil de rejeu

FlexMonkey). Cependant, c'est avec la société

Kalios25, qui développe le logiciel sYnopsis26,

que nous cherchons à poursuivre nos efforts. Le logiciel sYnopsis se

présente comme une « surcouche » aux outils de test. Il permet

d'organiser de manière efficace les scénarios de test et facilite

de manière significative la maintenance des scripts de test. De plus, il

permet de produire de la documentation et possède des connecteurs aussi

bien vers des outils de suivi de test comme Quality Center27, que

vers des outils de rejeu comme Test Complete28 ou Quick Test

Pro29.

25 Kalios : http://www.kalios.com/

26 sYnopsis : produit de pilotage d'outils de rejeu

de test. sYnopsis

27 HP Quality Center : outil de suivi de test.

QC

28 Test Complete : outil de rejeu.

http://smartbear.com/products/qa-tools/automated-testing/

29 HP Quick Test Pro : outil de rejeu. QTP

CNAM de Nantes - 2010 / 2011 - Mémoire

d'ingénieur

Dans le processus d'initialisation d'un projet sYnopsis, il y

a une phase d'importation des composants graphiques des écrans depuis

l'outil de rejeu. La description des scenarios de test ne pourra commencer

qu'après cette initialisation. Or, cette phase de capture des composants

graphiques reste manuelle et fastidieuse. L'idée est de se servir des

données présentes dans la base de cartographie pour

générer un flux XML qui permettra d'initialiser le

référentiel d'objets sYnopsis.

Dans un deuxième temps, les bonnes pratiques de ce