|

Republique Algerienne Democratique et Populaire

Ministere de

l'Enseignement Superieur et de la Recherche Scientifique

Universite Abderrahmane Mira de Bejaia

Faculte des Sciences

Exactes

Departement d'Informatique

Mémoire de Master Recherche

Informatique

SpécialitéRéseaux

et Systèmes Distribués

Th`eme

Algorithmes Evolutionnaires

dans les Systèmes de Parole

Présenté par : Mohamed Oulmahdi

Devant le jury composé de :

|

Mme

|

Rabiha Zeblah

|

Présidente

|

Université de Béjaia

|

|

M.

|

Abdennour Mekhmoukhe

|

Examinateur

|

Université de Béjaia

|

|

Mlle

|

Soraya Tighidet

|

Examinatrice

|

Université de Béjaia

|

|

Mlle

|

Zahira Benkhellat

|

Encadreur

|

Université de Béjaia

|

A mes parents

et à toute personne qui m'est chère.

Merci à tous ceux qui ont contribué de

près ou de loin à la réalisation de ce travail.

Résumé

La nature variable du signal de la parole fait que son

traitement, dans ses différents niveaux, soit une tâche

très difficile. Etant donné qu'il n'existe pas de méthodes

exactes pour traiter cette variabilité, les systèmes de parole

ont toujours recours à des méthodes d'approximation. Dans ce

travail, nous avons étudié les possibilités d'application

d'une famille de ces méthodes d'approximation connue sous le nom

d'Algorithmes évolutionnaires. Ce sont des méthodes qui reposent

sur le principe d'évolution et de sélection naturelles. Nous

avons réalisé une étude comparative entre deux

méthodes particulières de cette famille : les stratégies

d'évolution et la programmation génétique après

avoir proposé des possibilités de mise en oeuvre dans les

systèmes de parole pour chacune d'elle.

A l'issue de cette étude, nous avons constaté

que la puissance de chaque méthode se situe dans la catégorie des

problèmes à laquelle elle a initialement été

conçue. Les stratégies d'évolution offrent des

possibilités importantes en optimisation, et peuvent être

appliquées efficacement dans la phase de reconnaissance. La

programmation génétique quant à elle, peut

améliorer la qualité d'apprentissage et des traitements

linguistiques, vu ses performances en matière de développement

automatique des programmes.

Abstarct

The variable nature of the speech signal makes that its

treatment, in its different levels, is a very difficult task. Since exact

methods don't exist to treat this variability, the speech systems always have

resort to approximation methods. In this work, we studied the possibilities of

application of a family of these approximation methods known as evolutionary

algorithms. These are the methods that rest on the principle of natural

evolution and selection. We realized a comparative survey enters two particular

methods of this family : the evolution strategies and the genetic programming

after having proposed possibilities of implementation in the speech systems for

each of her.

At the end of this survey, we noted that the power of every

method is located in the category of the problems to which it has been

initially conceived. The evolution strategies offer important possibilities in

optimization, and can be applied efficiently in the phase of recognition. The

genetic programming as for her, can improve the quality of learning and

linguistics treatments, seen its performances concerning automatic development

of programs.

Résumé i

Abstract ii

Table des matières iii

Table des figures v

Introduction 1

1 Signal et Traitement de la parole 3

1.1 Généralités sur les signaux 3

1.2 Le signal vocal 4

1.2.1 Caractéristiques déterminantes 4

1.2.2 Informations véhiculées par la parole 5

1.2.3 Niveaux de complexité 6

1.3 Traitement de la parole 7

1.4 Niveaux de traitement 8

1.4.1 Niveau acoustique 8

1.4.2 Niveau phonétique 9

1.4.3 Niveau phonologique et morphologique 10

1.4.4 Niveaux syntaxique, sémantique et pragmatique 11

1.5 Processus de traitement 11

1.5.1 Prétraitement 12

1.5.2 Extraction des paramètres 13

1.5.3 Représentation du signal de la parole 14

1.6 Modèles de reconnaissance 15

1.6.1 Modèles markoviens 15

1.6.2 Modèles de classification 16

1.6.3 Modèles à comparaison dynamique 16

1.6.4 Autres modèles 18

1.7 Apprentissage 19

|

|

Table des matières

|

|

2

|

1.8 Traitements linguistiques de haut niveau

1.9 Conclusion

Algorithmes évolutionnaires

|

20

22

23

|

|

2.1

|

Principes d'inspiration

|

23

|

|

2.2

|

Cycle de base d'un algorithme évolutionnaire

|

24

|

|

2.3

|

Principales familles

|

24

|

|

|

2.3.1 Algorithmes génétiques

|

24

|

|

|

2.3.2 Programmation génétique

|

26

|

|

|

2.3.3 Stratégies d'évolution

|

26

|

|

|

2.3.4 Programmation évolutionnaire

|

26

|

|

2.4

|

Population et représentation des individus

|

27

|

|

2.5

|

Evaluation et Sélection

|

29

|

|

|

2.5.1 Sélection par roulette

|

29

|

|

|

2.5.2 Sélection par rang

|

30

|

|

|

2.5.3 Sélection steady-state

|

30

|

|

|

2.5.4 Sélection par tournoi

|

30

|

|

|

2.5.5 Elitisme

|

30

|

|

|

2.5.6 Sélection de seuil

|

31

|

|

2.6

|

Reproduction

|

31

|

|

|

2.6.1 Création et duplication

|

31

|

|

|

2.6.2 Mutation

|

31

|

|

|

2.6.3 Recombinaison

|

32

|

|

2.7

|

Application dans les systèmes de parole

|

32

|

|

2.8

|

Avantages et inconvénients

|

34

|

|

2.9

|

Conclusion

|

35

|

|

3

|

Stratégies d'évolution et Programmation

génétique

|

36

|

|

3.1

|

Stratégies d'évolution

|

36

|

|

|

3.1.1 Populations dans les SE

|

36

|

|

|

3.1.2 Evolution différentielle

|

37

|

|

|

3.1.3 Sélection

|

37

|

|

|

3.1.4 Mutation

|

37

|

|

|

3.1.5 Recombinaison

|

38

|

|

|

3.1.6 Auto adaptation

|

39

|

|

|

3.1.7 Mise en oeuvre dans les systèmes de parole

|

40

|

|

3.2

|

Programmation génétique

|

41

|

|

|

3.2.1 Population

|

41

|

|

|

3.2.2 Evaluation et sélection

|

42

|

3.2.3 Reproduction 43

3.2.4 Programmation génétique linéaire

46

3.2.5 Approches basées sur les graphes 47

3.2.6 Mise en oeuvre dans les systèmes de parole 47

3.3 Conclusion 48

4 Analyse comparative 49

4.1 Objectifs 49

4.2 Spécificité 50

4.3 Exploitation et exploration 53

4.4 Représentation des individus 55

4.5 Opérateurs de reproduction 57

4.6 Récapitulatif 58

4.7 Conclusion 59

Conclusion et Perspectives 60

Bibliographie 62

Table des figures

|

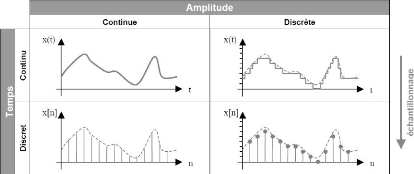

1.1

|

Classification morphologique des signaux

|

4

|

|

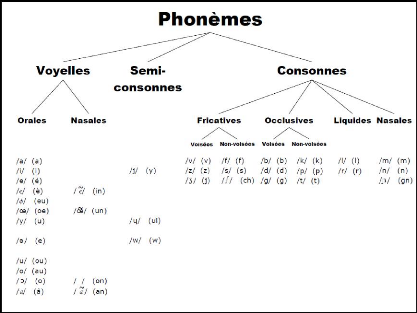

1.2

|

phonèmes du français, symboles de l'alphabet

phonétique international

|

10

|

|

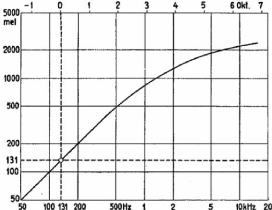

1.3

|

Echelle de Mel

|

15

|

|

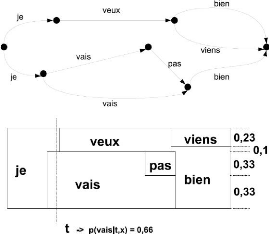

1.4

|

Exemple de graphe de décodage

|

17

|

|

1.5

|

Exemple de classification phonétique

|

17

|

|

1.6

|

Chemin optimal par DTW

|

18

|

|

1.7

|

Exemple de découpage syntaxique

|

21

|

|

2.1

|

Cycle de base d'un algorithme évolutionnaire

|

25

|

|

3.1

|

Schéma d'un croisement direct

|

39

|

|

3.2

|

Exemples de création par la méthode Full

|

42

|

|

3.3

|

Exemples de création par la méthode Grow

|

42

|

|

3.4

|

Différentes possibilités de Mutation

|

44

|

|

3.5

|

Recombinaison par échange de sous-arbres

|

44

|

|

3.6

|

Permutation

|

44

|

|

3.7

|

Encapsulation

|

45

|

|

3.8

|

Permutation

|

45

|

|

3.9

|

Permutation

|

46

|

|

4.1

|

Résumé récapitulatif de l'analyse

comparative

|

58

|

Depuis l'arrivée des premières

générations des ordinateurs, l'idée de les contrôler

à travers des claviers avec un jeu de caractère restreint a

toujours été remise en cause. Le rêve de communiquer avec

les machines de façon plus sophistiquée, plus naturelle et

spontanée n'a cessé de submerger l'esprit humain. Dans les

années 50, cette idée a commencée à devenir une

réalité, grâce à des réalisations qui ont

permis de contrôler le fonctionnement d'un ordinateur avec un nombre

très limité de commandes orales, qu'il comprenait.

Avec toute l'évolution que les systèmes de

parole ont connue depuis cette époque, les résultats obtenus sont

encore loin d'être idéal, et le domaine demeure un sujet de

recherche très actif. Les ordinateurs n'ont plus maintenant à

faire à des données exactes telles que les caractères et

les nombres, mais plutôt à des données de nature

très variable. Pour cette raison, tous les systèmes de paroles

doivent passer par des périodes d'apprentissage durant lesquelles ils

apprennent à faire face à ce problème de

variabilité, en utilisant le plus souvent des méthodes

statistiques et probabilistes. En fait, une étape d'apprentissage n'est

pas tout à fait suffisante, le problème doit encore être

affronté lors de la phase de reconnaissance pour estimer les

correspondances entre les données déjà apprises et les

nouvelles données. Il en résulte par conséquent un travail

important de calcul et d'optimisation.

Etant donné qu'il n'existe pas de méthodes

exactes plus efficaces, les systèmes de parole, quelque soit le

modèle qui leur est adopté, ont toujours recours à des

méthodes d'approximation (heuristiques) pour remédier à la

complexité du calcul. Une famille importante de ces heuristiques,

connues sous le nom d'Algorithmes évolutionnaires, a commencé

à émerger il y a une trentaine d'années, et a pratiquement

intégré tous les domaines scientifiques. Ces méthodes ont

suivi une nouvelle approche inspirée du processus d'évolution

naturelle, et se sont basées sur les principes d'évolution et de

sélection. Avec cette approche très simple et intuitive, ces

algorithmes ont pu fournir des résultats très intéressants

là où ils ont été appliqués. Toutefois, les

travaux sur les systèmes de parole qui sont fondés sur des

algorithmes évolutionnaires ne sont pas nombreux. Le présent

travail consiste en une analyse théorique des possibilités

d'ap-

plication de ces algorithmes dans les systèmes de

parole. Ces systèmes sont complexes et très compliqués; en

conséquence de quoi, un modèle directe basé sur un

algorithme évolutionnaire ne peut être défini. Nous

étudierons donc la façon par laquelle ces algorithmes peuvent

contribuer à l'amélioration de la qualité et de la

performance des systèmes de parole, que ce soit durant l'apprentissage

ou lors de a phase de traitement avec ses différent niveaux.

Ce document est divisé sur trois chapitres. Le premier

présente un état de l'art général sur les

systèmes de reconnaissance de la parole. Nous essayons de traiter d'un

maximum d'aspect afin de pouvoir identifier toutes les possibilités

d'application des algorithmes évolutionnaires. Nous traitons donc des

caractéristiques du signal vocal, de ses niveaux ainsi que de son

processus de traitement, de l'apprentissage et des traitements

linguistiques.

Le second chapitre expose, de façon

générale, les éléments de base des algorithmes

évolutionnaires. Nous tentons de discuter chaque élément

sans tenir compte d'une méthode particulière. A la fin, le

chapitre récapitule l'ensemble des travaux, que nous avons pu

réunir, sur les systèmes de parole qui ont utilisé des

algorithmes évolutionnaires.

Dans les deux derniers chapitres, nous effectuons une

étude comparative de deux méthodes particulières : les

stratégies d'évolution et la programmation

génétique. Dans le troisième chapitre, nous donnons une

présentation détaillée des deux méthodes, et dans

le dernier une analyse comparative. Dans le troisième chapitre aussi,

nous proposons des possibilités de mise en oeuvre, pour chacune des deux

méthodes, dans les différents modèles et niveaux de

traitement.

En traitant d'un ensemble important d'aspects relatifs au

traitement de la parole, et en choisissant deux types d'algorithmes

évolutionnaires largement différents, nous espérons

pouvoir couvrir un maximum de possibilités et de déceler les

différentes options que peut offrir les algorithmes

évolutionnaires pour les systèmes de parole.

1.1 Généralités sur les signaux

Un signal est la représentation physique de

l'information qu'il transmet de sa source à sa destination. La nature

physique du signal peut être de n'importe quelle grandeur mesurable

(ondes acoustiques, signale optique, magnétique ou

radioélectrique).

Les signaux peuvent être classés en de

différents types selon différents critères. Si l'on

considère la durée des signaux, on peut les diviser en des

signaux à durée limitée et des signaux à

durée illimitée. Ces derniers se décomposent à leur

tour en des signaux à énergie finie, à puissance moyenne

finie et des signaux causaux. Selon leur évolution, il existe des

signaux déterministes (périodiques, pseudopériodiques et

transitoires) dont l'évolution peut être parfaitement

décrite par un model mathématique, contrairement aux signaux

aléatoires dont le comportement est imprévisible dans le temps et

pour la représentation desquels on doit se contenter des observations

statistiques. Un autre mode de classification est selon la morphologie. On

distingue des signaux analogiques, quantifiés,

échantillonnés et numériques. Une dernière

classification est suivant la représentation spectrale par laquelle un

signal est classé par le domaine de variation de la fréquence

moyenne (basse fréquence, haute fréquence...).[143]

Le signal qui véhicule l'information est

fréquemment distordu. Cette distorsion peut prendre naissance à

la prise du signale ou durant la transmission. On est donc fréquemment

amené à filtrer le signal. Un filtre est un dispositif

susceptible de privilégier les composantes d'un signal dont les

fréquences sont situées dans un certain domaine, tout en

affaiblissant les autres. Les filtres peuvent aussi être utilisés

pour la mise en forme du signal. Ceci inclus toutes les modifications que l'on

peut faire subir à un signal pour faire apparaitre certaines

caractéristiques ou pour en masquer d'autres.

Les signaux primaires porteurs d'information sont pratiquement

toujours de type analogique (amplitude et temps continu)[143]. Un

système d'acquisition ou tout autres système traite des

données sous forme de suite de nombre discrets. Le rôle de

l'échantillonnage est de représenter le signal sous forme de

suite de valeurs ponctuelles en procédant à un découpage,

dans le temps, du signal.

FIGURE 1.1 - Classification morphologique des signaux

1.2 Le signal vocal

Le signal vocal correspond à une variation de la

pression de l'aire causée par le système articulatoire. Le

phénomène s'accompagne d'une propagation d'énergie entre

la source et le destinataire. Cette propagation est impossible dans le vide et

sa vitesse ne dépond que de la nature du milieu et de ses

caractéristiques physiques. Ces milieux ne transmettent que les ondes

dont les fréquences ont des valeurs bien précises : c'est le

phénomène d'amortissement.

Le signal vocal possède plusieurs

propriétés : il est produit par l'homme, il est très

variable du fait de la diversité phonétique et il est

modifié par l'environnement sonore. Ces propriétés font du

signal vocal un signal complexe, variable et souvent bruité.[113]

1.2.1 Caractéristiques déterminantes

Le signal vocal forme une résonnance lorsque les

fréquences du signal peuvent être modélisées comme

des multiples d'une fréquence de base appelée fréquence

fondamentale. Les différents multiples de cette fréquence sont

appelés des harmoniques.

Pour le signale vocale, la fréquence fondamentale est

celle à laquelle la glotte s'ouvre et se ferme

périodiquement.[82]

Chaque phonème contient un grand nombre d'harmoniques

dont les amplitudes relatives dépendent de la configuration du conduit

vocal. Ils présentent donc un timbre. Ce timbre est lié à

la position, à l'amplitude et la largeur de bande des maxima du spectre.

La production d'un phonème fait apparaître une ou plusieurs

résonnances qu'on regroupe sous le nom de formants. La position des

fréquences formantiques, pour un locuteur donné, peut varier

d'une élocution à l'autre, même dans le même

contexte. Mais elles varient beaucoup plus encor entre un locuteur et un

autre.

1.2.2 Informations véhiculées par la

parole

La parole transmet plusieurs types d'informations :

linguistiques, paralinguistiques mais aussi extralinguistiques. La transmission

d'informations linguistiques est le premier objectif de la parole. Cependant,

les informations paralinguistiques comme l'intonation modifient et ajoutent des

éléments utiles pour la compréhension. Les informations

dites extralinguistiques comme les variabilités dues aux locuteurs sont

souvent des facteurs qui perturbent les systèmes.[63]

Les informations linguistiques sont de plusieurs types. Un

message est composé de phrases, de mots. Chacun de ces mots peut

être décomposé en syllabes. La syllabe est une combinaison

de phonèmes dont le noyau est une voyelle parfois entourée de

plusieurs consonnes. Le phonème est la plus petite unité

segmentale distinctive. Le phonème n'est pas un élément

unique en lui même. Pour un même phonème, on pourra trouver

différentes variantes acoustiques appelées allophones. Il existe

donc des traits caractéristiques communs ou discriminants que l'on peut

exploiter dans la tâche d'extraction de caractéristiques.

Les informations paralinguistiques regroupent les composantes

du signal de parole qui ne sont pas à proprement parler des informations

linguistiques. Souvent, elles permettent une meilleure compréhension du

contexte linguistique. L'intonation est un exemple d'information

paralinguistique utile à la compréhension. Une phrase selon

qu'elle soit prononcée de manière déclarative ou

interrogative peut changer sensiblement de sens. Des variabilités dues

aux locuteurs sont également comprises dans les informations

paralinguistiques. L'état émotif, affectif et l'attitude du

locuteur sont des exemples de ces variabilités. Le niveau social ainsi

que l'accent régional sont également des informations

paralinguistiques. Par définition, les émotions ne sont pas

contrôlables par le locuteur. Quant aux autres informations

paralinguistiques comme le ni-

veau social, le locuteur ne contrôle pas ces informations

dans le cas d'une conversation naturelle.

De nombreuses autres informations dites extralinguistiques

sont présentes dans le signal de parole. Elles transmettent

essentiellement des caractéristiques propres aux locuteurs comme le

genre ou l'âge. L'environnement sonore, Les conditions de prise de son et

le canal de transmission sont des exemples d'informations

extralinguistiques.

1.2.3 Niveaux de complexité

La parole est un signal très complexe et son traitement

est un problème très difficile. Les sources de complexité

sont de natures différentes, elles peuvent être liées au

locuteur, à l'environnement sonore ou au signal lui-même.

Il y a d'abord le problème de la variabilité

intra et inter-locuteurs. Le système est-il dépendant du locuteur

ou indépendant du locuteur? Evidemment, les systèmes

dépendants du locuteur sont plus faciles à développer et

sont caractérisés par de meilleurs taux de reconnaissance que les

systèmes indépendants du locuteur étant donné que

la variabilité du signal de parole est plus limitée. Cette

dépendance au locuteur est cependant acquise au prix d'un

entraînement spécifique à chaque utilisateur.

Le système reconnaît-il des mots isolés ou

de la parole continue? Evidemment, il est plus simple de reconnaître des

mots isolés bien séparés par des périodes de

silence que de reconnaître la séquence de mots constituant une

phrase. En effet, dans ce dernier cas, non seulement la frontière entre

mots n'est plus connue mais, de plus, les mots deviennent fortement

articulés. Dans le cas de la parole continue, le niveau de

complexité varie également selon qu'il s'agisse de texte lu, de

texte parlé ou, beaucoup plus difficile, de langage naturel avec ses

hésitations, phrases grammaticalement incorrectes, faux départs,

etc.

La taille du vocabulaire et son degré de confusion sont

également des facteurs importants. Les petits vocabulaires sont

évidemment plus faciles à reconnaître que les grands

vocabulaires, étant donné que dans ce dernier cas, les

possibilités de confusion augmentent. Certains petits vocabulaires

peuvent cependant s'avérer particulièrement difficiles à

traiter; ceci est le cas, par exemple, pour l'ensemble des lettres de

l'alphabet, contenant surtout des mots très courts et acoustiquement

proches.

Le système est-il robuste, c'est-à-dire capable de

fonctionner proprement dans des conditions difficiles? En effet, de nombreuses

variables peuvent affecter significati-

vement les performances des systèmes de reconnaissance

bruits d'environnement, acoustique déformé et bruits

corrélés avec le signale de parole utile, systèmes

d'acquisition de différents caractéristiques, bande

fréquentielle limitée, etc.

1.3 Traitement de la parole

Les technologies de traitement de la parole recouvrent

différents domaines d'application. On distingue essentiellement la

synthèse vocale et la reconnaissance vocale. Cependant, dans la plupart

des applications courantes, ces deux techniques sont sou-vent

associées[72]. L'identification et la vérification du locuteur

font aussi partie du domaine de traitement de la parole.

La synthèse vocale peut être définie comme

la communication de la machine à l'homme. La synthèse vocale

recouvre tous les aspects liés à l'interprétation, par la

machine, du langage humain. Dans les applications de reconnaissance vocale on

distingue les systèmes de commandes vocales et les systèmes de

dictée.

Les systèmes de commande vocale permettent à

l'utilisateur de contrôler des équipements. Certaines applications

ne permettent que le contrôle par un nombre limités de mots ou de

courtes phrases. D'autres systèmes permettent à l'utilisateur de

s'exprimer par des phrases mais sont entrainés à repérer

certains mots de la phrase, mots qui se trouvent dans leurs dictionnaires

internes et sur lesquels ils basent leurs actions. On trouve aussi d'autres

applications beaucoup plus évoluées où l'on peut

s'adresser au système en langage naturel.

Les systèmes de dictée constituent le

problème le plus difficile à résoudre dans le domaine de

reconnaissance vocale[72]. Comme pour les systèmes de commande vocale,

il existe des systèmes de reconnaissance discrète dans lesquels

l'utilisateur doit parler avec de courtes poses entre chaque mot, et des

systèmes à reconnaissance continue qui permettent à

l'utilisateur de dicter son texte de façon continue et à une

vitesse de locution normale.

La vérification du locuteur consiste à

déterminer si un locuteur est bien celui qu'il prétend

être. Dans ce type d'applications, il s'agit donc de trancher entre les

deux hypothèses soit le locuteur est bien le locuteur autorisé,

c'est à dire celui dont l'identité est revendiquée, soit

nous avons affaire à un imposteur qui cherche à se faire passer

pour un locuteur autorisé. Les applications classiquement

envisagées pour la vérification du locuteur correspondent donc

à l'idée de "serrure vocale" qui peut être

utilisée,

par exemple, pour valider des transactions bancaires

effectuées par téléphone, ou pour compléter un

dispositif d'accès (à un bâtiment, un système

informatique, etc.)

L'identification du locuteur consiste à

reconnaître la voix d'un locuteur parmi une population (une base de

données) composée de N locuteurs connus. En identification, la

réponse apportée n'est plus de type binaire (acceptation ou

rejet) comme dans le cas de la vérification puisqu'il est

nécessaire de désigner un locuteur parmi un groupe. La sortie du

système correspond à l'identité du locuteur de la base de

référence qui est la plus "proche" du signal de parole inconnu.

Dans cette tâche, on fait l'hypothèse que le signal de parole

à identifier est prononcé par l'un des locuteurs de la base de

référence (identification en ensemble fermé)

Il est à noter que pour une identification en ensemble

ouvert, la combinaison des deux tâches précédentes est

nécessaire identification du locuteur le plus probable parmi les

locuteurs de la base des données, puis vérification que

l'échantillon inconnu a bien été prononcé par le

locuteur choisi dans l'étape d'identification.

Pour une application de vérification ou

d'identification, il est nécessaire de disposer d'une base de

données contenant des enregistrements de référence

correspondant à chacun des locuteurs autorisés. En pratique, on

ne conserve pour chaque locuteur que les paramètres utiles pour la

reconnaissance extraits de ses enregistrements de référence. Ces

informations constituent les données de référence du

locuteur.

1.4 Niveaux de traitement

L'information portée par le signal de la parole peut

être analysée de bien de façon. On en distingue

généralement plusieurs niveaux de description acoustique,

phonétique, phonologique, morphologique, syntaxique, sémantique

et pragmatique.[63]

1.4.1 Niveau acoustique

La parole apparait physiquement comme une variation de la

pression de l'air causée et émise par le système

articulatoire. L'étude acoustique de ce signal consiste à le

transformer dans un premier temps en un signal électrique (souvent

numérique) qui peut être soumis à un ensemble de traitement

acoustique qui visent à mettre en évidence les traits acoustiques

correspondant aux grandeurs perceptuelles formant, intensité et timbre.

Le signal est en suite échantillonné et pondéré par

une fenêtre de

pondération (souvent une fenêtre de Hamming). En

effectuant une transformée de Fourier à ces échantillons,

on peut séparer les sons voisés et non voisés selon la

structuration des fréquences, et les formants et les timbres selon la

forme générale des spectres (enveloppe spectrale).

On peut aussi séparer les sons voisés et non

voisés en représentant l'évolution temporelle du spectre

sous forme d'un diagramme à deux dimensions temps-fréquence

appelé spectrogramme, comme on peut représenter

l'évolution de la fréquence fondamentale.

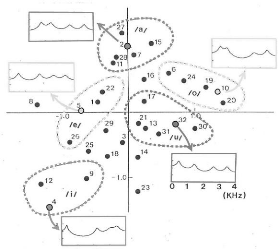

1.4.2 Niveau phonétique

A ce niveau, ce n'est pas tant le signal qui importe que la

façon dont il est produit par le système articulatoire. La parole

peut être décrite comme le résultat de l'action volontaire

et coordonnée d'un certain nombre de muscles. L'alphabet

phonétique international associe des symboles phonétiques

(phonèmes ou unités phonétiques

élémentaires) aux sons de telle façon à permettre

l'écriture compacte et universelle des prononciations.

Ces différents symboles sont regroupés en trois

classes principale : les voyelles, les semi-voyelles (ou semi-consonnes)et les

liquides et les consonnes. La production de chaque classe de phonèmes

fait appel à un ensemble distingué d'éléments de

l'appareil articulatoire et chaque élément se trouve

réagir différemment d'un phonème à un autre. Les

traits acoustiques du signal de la parole sont évidemment liés sa

production. L'intensité du son est liée à la pression de

l'aire en amont. Sa fréquence, qui n'est rien d'autre que la

fréquence du cycle ouverture/fermeture des cordes vocales, est

déterminée par la tension des muscles qui les contrôlent.

En fin, son spectre est le résultat du filtrage du signal par le conduit

vocal.

Il est aussi important de noter qu'une bonne connaissance des

mécanismes de l'audition et des propriétés perceptuelles

de l'oreille humaine est aussi importante qu'une métrise des

mécanismes de production. En effet, tout ce qui peut être

mesuré acoustiquement ou observé par la phonétique

articulatoire n'est pas nécessairement perçu. La plage des

fréquences perçues par l'oreille humaine est bornée par

une limite supérieure proche de 16000 Hz, ce qui limite

considérablement la fréquence d'échantillonnage. En plus,

même dans l'intervalle de son domaine d'audition, l'oreille ne

présente pas une sensibilité identique à toutes les

fréquences. Enfin, les sons peuvent se chevaucher et un son peut donc en

masquer un autre. Ce chevauchement, appelé phénomène de

masquage, peut aider à réduire le débit binaire du signal

acoustique.

FIGURE 1.2 - phonèmes du français, symboles de

l'alphabet phonétique international

1.4.3 Niveau phonologique et morphologique

La phonologie est l'interface nécessaire entre la

phonétique et la description linguistique de niveau plus

élevé. Elle introduit la notion d'unités phonétique

du discours qui est la plus petite unité phonétique distinctive.

Ces unités constituent un ensemble structuré dans lequel chaque

élément est différent des autres, la différence

étant à chaque fois porteuse de sens contrairement aux niveaux

précédant où la parole est considérée comme

si elle ne portait aucune signification.

Les variations phonétiques articulatoires dues à

des différences régionales ou de la dynamique vocale ne donnent

pas naissance à de nouveaux phonèmes. Ces effets sont connus sous

le nom de réduction, assimilation et coarticulation[15]. Les

phénomènes coarticulatoires sont dus au fait que chaque

articulateur évolue de façon continue entre les positions

articulatoires. Au contraire, la réduction et l'assimilation prennent

leur origine dans des contraintes physiologiques et sont sensibles au

débit parlé. L'assimilation est causée par le recouvrement

de mouvements articulatoires et peut aller jusqu'à modifier un trait

acoustique du phonème prononcé. La réduction est

plutôt due au fait que les cibles articulatoire sont moins bien atteintes

dans le parler rapide.ces phénomènes sont en grande partie

responsables des traitements réalisés des signaux de la

parole.

La description phonologique de la parole doit rendre compte de

la durée, de la densité et de la fréquence fond mentale

des phonèmes. La durée des silences et des phones

détermine le rythme de la phrase, tandis que l'évolution de la

fréquence fondamentale constitue sa mélodie.

La suite des phonèmes prononcés correspond

à des mots choisis dans le lexique des mots de la langue. L'étude

morphologique étudie la façon dont les mots peuvent être

construit à partir de mots de base, et par conséquent, et

étant donné la richesse de la langue, réduire la taille du

vocabulaire.

1.4.4 Niveaux syntaxique, sémantique et

pragmatique

Toute suite de mots du lexique ne forme pas une phrase

correcte. En effet, la liste des phrases admises, bien qu'infinie, est

restreinte par leur syntaxe. Les grammaires ne servent pas qu'à dresser

les frontières entre les phrases régulièrement

construites, mais elles permettent également l'organisation

hiérarchique des phrases.

Bien que la syntaxe restreigne le nombre de phrases

acceptables, elle ne constitue cependant pas une limite exhaustive

d'acceptabilité. En effet, un nombre de phrase syntaxiquement correcte

ne sont pas toutes admissibles. L'étude des significations des mots, de

la façon dont ils sont liés les un aux autres fait l'objet de la

sémantique lexicale. Il s'agit principalement d'étudier les

problèmes d'ambiguïté. Notons que la différence entre

syntaxe et sémantique reste relativement floue, car il ne s'agit pas de

l'étude des conditions de vérité comme dans les

expressions logiques.

Le dernier niveau est le niveau pragmatique. Contrairement au

sens sémantique, que l'on qualifie souvent d'indépendant du

contexte, le sens pragmatique est définie comme dépendant du

contexte. Tout ce qui réfère au contexte dans lequel une phrase

s'inscrit et la relation entre le locuteur et son auditoire, a quelque chose

à voire avec la pragmatique. Son étendue couve l'étude de

sujets tels que les présuppositions, les implications de dialogue, les

actes de parole...

1.5 Processus de traitement

La reconnaissance de la parole est un processus complexe

composé de plusieurs étapes qu'on classe

généralement en trois phases : la phase de prétraitement

qui prépare le signale pour améliorer la qualité du

décodage, la phase de reconnaissance qui

constitue l'étape la plus importante et enfin la phase des

traitements linguistiques de plus haut niveau.

Les premiers succès en reconnaissance vocale ont

été obtenus dans les années 70 à l'aide d'un

paradigme de reconnaissance de mots par l'exemple. L'idée, très

simple dans son principe, consiste à faire prononcer un ou plusieurs

exemples des mots susceptibles d'être reconnus, à les enregistrer

et à les comparer avec le signale à reconnaître. Ce

principe est mieux adapté à la reconnaissance monolocuteur de

mots isolés et à petit vocabulaire. Mais dès que la taille

du vocabulaire devient importante, le principe devient inadapté, sans

prendre en compte la continuité de la parole et la variabilité

des locuteurs.

Pour remédier à ces manques, et concevoir un

système réellement multilocuteur et à plus grand

vocabulaire, il devient nécessaire de mener la reconnaissance sur base

d'unités de parole de plus petite taille (typiquement les

phonèmes). On ne se contente plus alors d'exemples de ces unités,

mais on cherche plutôt à en déduire un model qui sera

applicable à n'importe quelle voix.

1.5.1 Prétraitement

Les prétraitements débutent par un

échantillonnage des signaux, suivi d'une préaccentuation. Le

signal est divisé en fenêtres de longueur entre 20 et 30 ms. Le

signal final est obtenu en multipliant le signal par une fonction de

pondération. La préaccentuation consiste en un filtrage du signal

de la parole pour égaliser les graves et les aigues. D'autres

prétraitements, ayant pour but d'augmenter la robustesse, sont par fois

mis en oeuvre comme par exemple la normalisation des sons ou la soustraction

spectrale qui a pour effet d'éliminer les bruits additifs.

Le choix de la fenêtre est très important. Parmi

les fenêtres utilisées on trouve les fenêtres de Hamming,

Hanning, Blackman ou de Kaiser. Le choix de la fenêtre se fait le plus

souvent en fonction de l'application car les fenêtres présentent

différentes atténuations à des fréquences bien

précises. Cependant, il faut noter que la plupart des systèmes

sont directement conçus sur des fenêtres de Hamming. Les efforts

de conception sont consacrés à d'autres étapes comme

l'extraction des paramètres.[113]

La phase de reconnaissance est représentée par

l'ensemble des processus qui ont pour objet de faire passer le signal de sa

forme acoustique vers une forme linguistique constituée d'unités

phonétiques élémentaires et d'associer à ces

dernières les correspondances linguistiques appropriées. Ces

correspondances seront par la suite pas-

sées au module linguistique pour des traitements de

plus haut niveau. Ces traitements concernent l'analyse lexicale, syntaxique,

sémantique et pragmatique. Tous les traitements linguistiques ne sont

pas présents dans tous les systèmes de reconnaissance, selon le

domaine considéré et selon le besoin, le système peut

exclure un traitement ou un autre.

1.5.2 Extraction des paramètres

L'extraction des paramètres est l'objet principal de

l'analyse de la parole et c'est le passage obligé de toutes les

applications de traitement de la parole.[113]

En considérant le degré de connaissance

associé au signal, il existe des méthodes d'extraction non

paramétriques qui sont basées généralement sur une

représentation fréquentielle du signal sans tenir compte de sa

structure fine. Les méthodes paramétriques ou les méthodes

d'identification en revanche, sont fondée sur une connaissance des

mécanismes de production de la parole. Elles reposent sur un model.

Celui-ci repose sur un ensemble de paramètres numériques, dont

les niveaux de variation représentent l'ensemble des signaux couverts

par le model. Pour un signal et un model donné, l'analyse estime les

paramètres du model pour lui faire correspondre le signal

analysé.

Selon que l'on prenne en compte l'évolution

fréquentielle ou temporelle du signal de la parole, on distingue des

méthodes d'analyse spectrales et des méthodes d'analyse

temporelles. L'analyse spectrale est basée sur deux principe : le

premier est que le timbre de la parole dépend de la position, dans

l'échelle des fréquences, des formant qui sont liés aux

résonnances du conduit vocal, le deuxième est le fait que le

spectre du signal vocal présente une certaine stabilité pendant

plusieurs centièmes ou même dixièmes de secondes. On pourra

donc appliquer une transformée de Fourrier aux intervalles de

stabilité du spectre et pouvoir isoler les différentes

fréquences qui le composent. L'analyse peut être

réalisée en utilisant des filtres analogique (unique ou multiples

en parallèle) ou des filtres numériques. Les filtres

numériques présentent une précision plus

élevée et plus de possibilité de simulation mais avec un

prix de complexité considérable.

L'analyse temporelle utilise le fait que certains

évènement, comme la fermeture brusque du conduit vocal, sont

mieux caractérisée par l'évolution temporelle du signal

que par son spectre. La fonction d'autocorrélaton, le taux de passage

à zéro et la prédiction sont les principales techniques

d'analyse temporelle.

L'analyse prédictive est sûrement la plus

utilisée. Le conduit vocal, filtrant le signal d'excitation, peut

être assimilé à un filtre récursif : avec une bonne

approximation, le signal émis à un instant donné peut

être calculé à partir des valeurs qu'il a prises aux

instants antérieurs (exploitation de l'aspect redondant de la

parole).

Les analyses fréquentielles exigent d'être

effectuées sur une durée suffisamment langue. Il en

résulte qu'elles sont peu adaptées à l'étude des

phénomènes évoluant rapidement. La prédiction

élimine une part importante de la redondance que présente le

signal de la parole et fait, par conséquent, débarrasser

l'analyse des éléments n'apportant pas de nouvelles

informations.

1.5.3 Représentation du signal de la parole

Le codage prédictif linéaire Il

repose sur l'hypothèse de linéarité du processus de

production de la parole. Chaque échantillon peut être

prédit à partir d'une pondération linéaire d'un

nombre fini d'échantillons précédents, étant

donné que la forme du conduit vocale n'évolue pas rapidement.

Le codage prédictif linéaire est largement

utilisé en traitement de la parole notamment en transmissions. Le model

est de plus facile à mettre en oeuvre dans les systèmes à

temps réel. Ce model par définition ne prend pas en charge les

phénomènes non linéaire, et de plus, il n'est pas

optimisé pour la tâche de reconnaissance. En effet, des travaux

ont montré qu'il est possible de mettre en oeuvre une meilleure

représentation, et on fait naissance à des modèles plus

optimisés comme la prédiction linéaire perceptive, la

prédiction linéaire perceptive RASTH, le codage WLPC...

Le codage cepstrale la représentation

cepstrale est une représentation non paramétrique : elle ne fait

pas intervenir de model comme le cas du codage linéaire. On obtient le

cepstre en appliquent une transformée de Fourrier au signal, calculer le

logarithme du résultat, à qui on applique en fin une

transformée de Fourrier inverse.

Le cepstre possède plusieurs propriétés

intéressantes qui en font une représentation efficace. Parmi ces

propriétés, le logarithme qui permet par un procédé

de filtrage l'élimination des effets convolutifs dans le domaine

temporel. En effet, grâce à la fonction logarithmique, les bruits

deviennent additifs et une simple soustraction (soustraction cepstrale) permet

l'annulation de ces bruits.

Le codage MFCC (Mel Frequency Cepstral Coding)

C'est la technique de codage la

plus utilisée en traitement

de la parole. Elle intègre la notion de bancs de filtres qui

sont déployés non par une échelle en Hz

mais sur une échelle non linéaire : l'échelle de Mel.

Cette échelle est issue de la connaissance sur la perception humaine. La

résolution perceptive des fréquences diffère selon qu'on

écoute des sons de basses ou de hautes fréquences.

Le codage MFCC représente la référence des

procédés d'extraction de caractéristiques, et toutes les

méthodes proposées doivent s'y comparer.[113]

FIGURE 1.3 - Echelle de Mel

1.6 Modèles de reconnaissance

1.6.1 Modèles markoviens

Dans le cadre des modèles markoviens, les unités

acoustiques sont modélisées par des chaînes de Markov

cachées. A chaque état du modèle est associée une

distribution de probabilité modélisant la

généralisation des modèles acoustiques via cet

état.[17]

L'ensemble des paramètres markoviens (états,

matrice de transition...) sont estimés lors d'une phase d'apprentissage.

Les différentes méthodes d'apprentissage permettent, à

partir d'un certain échantillon, de déterminer les

paramètres qui maximisent les probabilités de

génération des unités acoustiques.

Les modèles de reconnaissances markoviens utilisent, en

outre des paramètres habituels, des modèles de langage. Ils

permettent d'estimer la probabilité de production des mots en

connaissant leur historique. Lors de la phase d'apprentissage, on calcule

les probabilités d'apparition des unités à

partir des évènements observés, et de

généralise par la suite ces estimations à des

évènements qui n'ont pas été observés.

A la phase de reconnaissance, le système

génère un ensemble de mots de départ, dits

hypothèses, à partir des informations récoltées

lors de l'apprentissage. Cet ensemble sera modélisé sous forme

d'un graphe ou d'un treillis de mots. Le système explore ce graphe afin

de trouver le chemin qui maximisera la probabilité de correspondance.

Les modèles markoviens sont les plus utilisés

dans le domaine de reconnaissance vocale et constituent un domaine de recherche

très prometteur. Leurs principal problème est la

difficulté de leur intégrer des informations non acoustiques.

1.6.2 Modèles de classification

Dans ce type de modèles, la reconnaissance vocale est

considérée comme un problème de classification

automatique. La classification automatique consiste à attribuer une

parmi un ensemble de classes à chacun des objets à classifier. La

structure des classes et leurs nombre peuvent être connus avant la

classification ou déterminés automatiquement par le

système. Dans le premier cas, on parle de classification

supervisée. Elle repose sur un échantillon de prototypes qui

représentent chacun une classe. Les objets seront en suite

répartis selon les classes auxquelles ils appartiennent. Chaque

unité acoustique représente une classe. Les prototypes sont

constitués manuellement lors d'une phase d'apprentissage. Par la suite,

le modèle estime, pour chaque unité à reconnaître,

sa classe appropriée. Il existe plusieurs méthodes pour estimer

les correspondances phonétiques : les méthodes probabilistes

gaussiennes, les réseaux de neurones, la règle du proche voisin,

mesures de dissimilarité, etc.

La classification a largement été

appliquée à des problèmes similaires comme la

reconnaissance des formes et le recalage des images médicales. On

utilise généralement la méthode du plus proche voisin. En

reconnaissance vocale, c'est plutôt les mesures de dissimilarité

qui sont utilisées. Etant donné que les approches algorithmiques

de classification sont relativement anciennes, ce modèle permet de

profiter de tous les résultats théoriques et les avancées

des travaux en la matière.

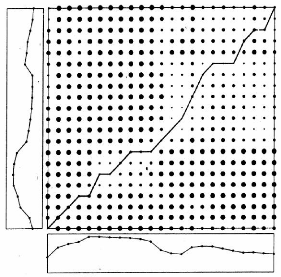

1.6.3 Modèles à comparaison dynamique

La méthode DTW (Dynamic Time Warping) est une

méthode de résolution dynamique. Elle est basée sur le

principe de recalage temporel. Les images acoustiques des unités sources

et celles des unités à reconnaître ne sont pas parfaitement

identiques

FIGURE 1.4 - Exemple de graphe de décodage

FIGURE 1.5 - Exemple de classification phonétique

à cause de la différence dans les vitesses de

locution. Ce principe est pratiquement le même que celui utilisé

dans la reconnaissance des formes et il a largement été

utilisé pour le recalage des images médicales. Le modèle

utilise une mesure de différence entre les vecteurs sources et ceux du

mot à identifier pour tenter de trouver des correspondances

optimales.

L'algorithme commence par l'estimation locale des distances

entre les deux ensembles de vecteurs. Il utilise ensuite une méthode de

programmation dynamique pour obtenir un optimum global qui minimise la

différence accumulée entre les deux ensembles.

Dans ce type de modèles, on représente chaque

couple d'unités phonétiques dans une matrice dont les lignes

représente les vecteurs de l'unité de référence, et

les colonnes ceux de l'unité à reconnaître. Les

éléments de la matrice représentent les différences

locales entres les vecteurs. Le problème revient donc à trouver

un chemin optimal (minimal) entre le premier et le dernier

élément de la matrice.

FIGURE 1.6 - Chemin optimal par DTW

1.6.4 Autres modèles

La quantification vectorielle est une méthode

non-paramétrique qui permet de décrire un ensemble de

données par un faible nombre de vecteurs formant un dictionnaire

associé aux données. Le dictionnaire est en général

calculé de telle façon que la distance moyenne entre un vecteur

issu des données et son plus proche voisin dans le dictionnaire soit la

plus petite possible. La quantification vectorielle est une technique de

groupage qui est d'autant plus adaptée que les données

présentent naturellement des "points d'accumulation" autour desquels la

densité de vecteurs issus des données est importante. Compte tenu

de la nature du signal de parole, le choix d'un tel modèle

semble assez judicieux. En general, la quantification

vectorielle est realisee par une methode dite "spliting K-means" (optimisations

successives de dictionnaires de taille croissante) qui permet de contourner le

delicat problème de l'initialisation de l'algorithme de recherche

iterative des vecteurs du dictionnaire.

Le modèle de melange de distributions gaussiennes

(Gaussian mixture model (GMM)) consiste à supposer que la distribution

des donnees peut être decrite comme une somme ponderee de densites

gaussiennes multidimensionnelles. Ce modèle de melange est classique

dans le domaine de la reconnaissance de forme car il correspond à une

situation où les donnees appartiennent à un ensemble de classes

distinctes, avec une probabilite d'appartenance propre à chaque classe.

Le cas particulier considere ici est celui où dans chaque classe les

donnees suivent une loi gaussienne. Ce choix tient essentiellement au fait que

la loi gaussienne appartient à une famille de distributions dite

exponentielles pour lesquelles le problème de l'identification des

composantes du melange se trouve simplifie. Pour le signal de parole, ce

modèle ne paraît donc pas deraisonnable et il est d'autre part

assez proche de la caracterisation fournie par la quantification vectorielle.

La difference etant qu'avec la quantification vectorielle, on se contente de

mettre en evidence un certain nombre de "points d'accumulation" des

paramètres mesures, alors qu'avec le modèle de melange de

distributions gaussiennes, on cherche en plus à decrire la distribution

des paramètres mesures autours de ces points d'accumulation.

1.7 Apprentissage

Quelque soit le modèle considere, il doit

obligatoirement debuter par une phase d'apprentissage. L'apprentissage

automatique (Machine Learning) est un procede qui permet au système de

generaliser les connaissances qui a pu apprendre, grâce à des

donnees dejà traitees manuellement, à des donnees inconnues.

C'est une technique d'intelligence artificielle qui est appliquee dans une

large gamme de domaines, en premier lieu en classification.

Dans les systèmes de parole, l'apprentissage constitue

une phase cruciale. Pour chaque unite phonetique (mot ou phonème), le

système calcule une estimation à partir d'un echantillon de

donnees de reference. Le choix de cet echantillon est très important: il

faut à la fois minimiser la taille et generaliser la presentation. Ces

deux objectifs sont plus ou mois contradictoires. Si l'on choisi un ensemble

d'echantillons très petit, on risque d'avoir une mauvaise representation

comme reference. Ce qui entrainerait de mauvaises consequences lors de la

reconnaissance. De même, avec un ensemble très

grand, le problème peut devenir complètement

irrésolvable. Il convient donc de trouver un compromis.

Dans les modèles markoviens, le système apprend,

à partir d'un ensemble de mots donné, à prévenir

l'apparition d'un mot à partir des mots déjà apparus. Dans

les modèles de classification, l'apprentissage consiste à adapter

le système à classifier des phonèmes dont l'image

acoustique est légèrement différente de celle du prototype

source correspondant. Quant aux modèles à base de DTW,

l'apprentissage se préoccupe plutôt de surpasser les

décalages temporels dus aux variations de vitesses de locution.

1.8 Traitements linguistiques de haut niveau

Les traitements linguistiques ne sont pas tous disponibles

dans tous les systèmes de reconnaissance. Par exemple, dans les

systèmes de commande à mots isolés, aucun traitement

linguistique n'est nécessaire, voire n'est utile. Dans les

systèmes de dictée, une analyse lexicale et syntaxique est

incontournable; par contre, aucun intérêt ne serait apporté

par une analyse sémantique. Mais dans les applications de dialogue oral

par téléphone, toutes les analyses doivent être mises en

coopération pour qu'elle soit plutôt efficace.

Dans la plupart des systèmes, ces différents

niveaux d'analyse linguistique sont séquentiels et donc

indépendant de point de vue temporel. Cependant, une combinaison entre

eux peut s'avérer bénéfique. Par exemple, l'introduction

d'une analyse sémantique dans la phase de reconnaissance peut

améliorer la précision et lever l'ambigüité. Cette

technique est en quelque sorte implicitement introduite dans les modèles

markoviens dans lesquels, la probabilité de correspondance d'un mot ne

dépend pas seulement de son image acoustique, mais aussi de suite de

mots qui le précèdent.

Les applications de dialogue oral téléphonique

se répondent de plus en plus et couvre une grande variété

de domaines. Dans ce type d'applications, un module de compréhension

(d'analyse sémantique) est indispensable pour la traduction des phrases,

issues du module de reconnaissance et dont la nature est très

spontanée, à des commandes effectives.

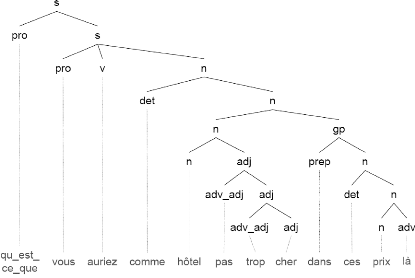

Dans certaines applications, la compréhension

s'effectue suivant deux phases d'analyses séquentielles. La

première phase établie un découpage des phrases en groupes

syntaxiques (groupe nominal, groupe verbal, ...), et de leurs associer les

étiquettes sémantiques correspondantes. La phase suivante

effectue un rattachement sémantico-

pragmatique qui a pour but de relier les constituants minimaux

résultants de la première phase, et de définir les

dépendances entre eux.

D'autres modèles tels que les arbres de décision

sémantiques, le boosting ou les SVM, combinent les opérations de

reconnaissance et de compréhension en une seule phase. Les arbres de

décision sémantiques sont généralement les plus

utilisées. C'est une technique qui repose sur les grammaires

régulières. Les règles de la grammaire sont

constituées automatiquement à partir d'un corpus

d'entraînement.

Un des défis des applications de compréhension

orale, qui doivent souvent confronter, est l'aspect spontané de la

parole. Le problème se présente principalement dans les

hésitations, les fragments inutiles, les répétitions et

les déformations syntaxiques et sémantiques. Ces applications

doivent donc filtrer les phrases reconnues pour extraire ce qui est utile de ce

qui ne l'est pas.

FIGURE 1.7 - Exemple de découpage syntaxique

1.9 Conclusion

Dans ce chapitre nous avons passé en revu les

éléments essentiels intervenant dans le processus de traitement

de la parole. Nous avons d'abord illustré certains aspects du traitement

du signal de façon général ainsi que les

caractéristiques du signal vocal, en faisant apparaître en

particulier l'importance et la complexité de l'information qu'il

contient. Par la suite, nous avons présenté les différents

niveaux de traitement de la parole. Après avoir décrit de

façon général son déroulement, nous avons

détaillé, dans une certaine mesure, le processus de traitement de

la parole en décrivant les différents éléments qu'y

interviennent.

Dans une autre partie, nous avons traité des

modèles de reconnaissance. Nous avons essayé d'illustrer les

principaux modèles de reconnaissance et éventuellement certains

avantages et inconvénients. En fin nous avons survolé rapidement

la phase d'apprentissage et les traitements linguistiques, notamment les

problèmes relatifs à la compréhension de la parole

spontanée.

Il reste néanmoins plusieurs autres problèmes

d'importance capitale, en particulier ceux qui ont un rapport avec le processus

de décodage comme la détermination de la fréquence

fondamentale, la recherche des formants et la suppression des bruits de fond.

Ces problèmes ont le plus souvent une part intéressante dans la

complexité du domaine. Nous n'en dirons pas davantage dans ce

mémoire, une étude exhaustive ferait intervenir de nouveaux

concepts et dépasserait largement le cadre de ce travail.

Chapitre 2

Algorithmes évolutionnaires

Les algorithmes évolutionnaires regroupent un ensemble

d'algorithmes inspirés du processus d'évolution naturelle. Ces

algorithmes sont utiles pour la résolution de problèmes où

les algorithmes classiques d'optimisation, d'apprentissage ou de conception

automatique sont incapables de produire des résultats satisfaisants. Ils

appartiennent à la classe des méthaheuristiques qui, à

leur tour, font partie des méthodes heuristiques. Ce sont des

méthodes d'approximation qui fournissent des résultats de bonne

qualité, en sacrifiant éventuellement l'exactitude ou

l'optimalité de la solution, à des problèmes souvent

réputés difficiles pour lesquels on ne connait pas de

méthodes exactes plus efficace.

2.1 Principes d'inspiration

- Les individus d'une espèce à grande

fertilité ont plus de chance de survivre pour longtemps.

- Sous l'absence d'influence externe, la dimension d'une

espèce reste, en gros, constante. - Encore, sans influences externes, la

ressource de nourriture est limitée mais reste équilibrée

avec le temps.

- Les individus luttent pour la survie à cause de la

concurrence sur les ressources limitées.

- Il n'existe pas d'individus équivalents, notamment pour

les espèces à reproduction sexuelle.

- Les différences entre individus peuvent affecter leurs

aptitudes, et par conséquent, leur capacité de survie.

- Une bonne partie de ces variations est inhéritable.

- Les bons individus ont plus de chances de survivre et de

produire d'autes bons individus.

- Les individus qui survivent transmettront, probablement, leurs

caractéristiques

à leurs enfants.

- Les espèces évoluent lentement, et s'adaptent de

plus en plus à leur environnement.

2.2 Cycle de base d'un algorithme

évolutionnaire

Tous les algorithmes évolutionnaires font

évoluer un ensemble (population) de solutions (individus). La population

initiale est générée aléatoirement. En suite, Pour

chaque individus, on calcul le résultat d'une fonction

d'évaluation (fitness) mesurant le degré de leur adaptation.

L'utilité de chaque individu étant maintenant connue,

l'algorithme filtre la population courante en éliminant les individus

ayant obtenus un mauvais résultat lors du processus d'évaluation,

tout en préservant les autres. Après avoir

sélectionné les bons individus, ces derniers seront

combinés ou variés afin d'en produire de nouveaux. Les nouveaux

individus sont sensés être d'une qualité aussi bonne que

ceux de la génération précédente. Ils seront

passés à leur tour à la phase de sélection, et

ainsi de suite jusqu'à atteindre un des critères

d'arrêt.L'algorithme devrait tendre, de plus en plus, vers la solution

optimale. Le critère d'arrêt est le plus souvent relatif au nombre

de générations. Mais il peut cependant dépendre du

degré d'évolution (amélioration) de l'algorithme, de la

distance entre individus ou du facteur de temps.

2.3 Principales familles

2.3.1 Algorithmes génétiques

Les algorithmes génétiques sont les plus

populaires des algorithmes évolutionnaires. Ils impliquent

l'évolution d'une population de vecteurs de dimension fixe

composés de caractères, généralement des bits.

L'idée des algorithmes génétiques est vaguement

inspirée des chaînes d'ADN, qui composent tout organisme vivant.

Les AG sont utilisés dans le but de découvrir une solution,

généralement numérique, résolvant un

problème donné, et ce sans avoir de connaissance à priori

sur l'espace de recherche. Seul un critère de qualité est

nécessaire pour discriminer différentes solutions. Dans la

plupart des cas, ce critère, l'adéquation, est une mesure

objective qui permet de quantifier la capacité de l'individu à

résoudre le problème donné. Le processus de recherche

s'effectue en appliquant itérativement à une population de

solutions potentielles des opérations de variation

génétique (généralement le croisement et la

mutation), et des opérations de sélection naturelle

biaisées vers les individus les plus forts. En utilisant ce processus,

la population de solutions potentielles évolue dans le temps

jusqu'à ce

qu'un certain critère d'arrêt soit atteint. Dans

un contexte d'optimisation de fonctions à paramètres

réels, une variante importante des AG consiste à

représenter les individus directement par des vecteurs de nombres

réels.

FIGURE 2.1 - Cycle de base d'un algorithme

évolutionnaire

2.3.2 Programmation génétique

La programmation génétique est un paradigme

permettant la programmation automatique d'ordinateurs par des heuristiques

basées sur les mêmes principes dévolution que les

algorithmes génétiques : des opérations de variation

génétique et des opérations de sélection naturelle.

La différence entre la programmation génétique et les

algorithmes génétique réside essentiellement dans la

représentation des individus. En effet, la programmation

génétique consiste à faire évoluer des individus

dont la structure est similaire à des programmes informatiques. La

programmation génétique représente les individus sous

forme d'arbres, c'est-à-dire des graphes orientés et sans cycle,

dans lesquels chaque noeud est associé à une opération

élémentaire relative au domaine du problème. Plusieurs

autres représentations comme des programmes linéaires et des

graphes cycliques, ont été utilisées depuis. La

programmation génétique est particulièrement

adaptée à l'évolution de structures complexes de

dimensions variables.

2.3.3 Stratégies d'évolution

Les stratégies d'évolution représentent

les individus comme un ensemble de caractéristiques de la solution

potentielle. En général, cet ensemble prend la forme d'un vecteur

de nombres réels de dimension fixe. Les stratégies

dévolution s'appliquent à une population de parents à

partir de laquelle des individus sont sélectionnés

aléatoirement afin de générer une population de

descendants. Ceux-ci sont ensuite modifiés par des mutations qui

consistent à ajouter une valeur générée

aléatoirement selon une fonction de densité de probabilité

paramétrée. Les paramètres de la fonction de

densité de probabilité, nommés les paramètres de la

stratégie, évoluent eux aussi dans le temps selon les mêmes

principes que les paramètres caractérisant les individus. Pour

former la nouvelle population, des individus sont choisis parmi les meilleurs

individus des descendants, ou parmi les meilleurs individus des parents et

descendants. Les stratégies dévolution modernes peuvent aussi

intégrer une approche multi-échelle ou des stratégies

d'évolution sont imbriquées.

2.3.4 Programmation évolutionnaire

La programmation évolutionnaire a été

initialement conçue dans le but de faire évoluer des machines

à états finis et a été par la suite étendue

aux problèmes d'optimisation de paramètres. Cette approche met

l'emphase sur la relation entre les parents et leurs descendants plutôt

que de simuler des opérateurs génétiques d'inspiration

naturelle. Contrairement aux trois autres algorithmes évolutionnaires

classiques, la programmation évolutionnaire n'utilise pas une

représentation spécifique mais plutôt un

modèle évolutionnaire de haut niveau, jumelé

à une représentation et à un opérateur de mutation

directement appropriés au problème à résoudre.

Pour effectuer de la PE, une population de solutions

potentielles au problème est d'abord générée

aléatoirement. Chaque individu de la population produit un ensemble de

descendants résultant de mutations. Une opération de

sélection naturelle est alors appliquée afin de former une

nouvelle population. Le processus de mutation-sélection est

répété itérativement jusqu'à ce qu'une

solution acceptable soit trouvée. 1

2.4 Population et représentation des

individus

La population est la représentation de l'ensemble des

solutions possibles. Indépendamment, les individus sont des

éléments statiques qui ne peuvent pas s'adapter, c'est la

population qui forme donc l'unité d'évolution et d'adaptation.

C'est pour cette raison que la plupart des opérateurs de

sélection prennent en compte la totalité de la population. La

diversité d'une population est la mesure du nombre des

différentes solutions existantes. Il n'existe aucune façon de

mesurer la diversité d'une population, on se réfère

généralement au nombre d'aptitudes différentes, au

degré de cette différance ou au nombre d'individus

différents.[?]

A chaque itération d'un algorithmes

évolutionnaires, de nouveaux individus sont créés. A la

prochaine itération, les individus de la génération

précédente peuvent être conservés (avec de

mêmes ou de différentes chances que ceux de la

génération courante) ou tout simplement jetés. Les

algorithmes qui changent complètement de génération

(c'est-à-dire qui ne conservent que les nouveaux individus à la

prochaine itération) sont appelés algorithmes à

sélection générationnelle (Extinctive EA). Par contre,

ceux qui ne modifient qu'une partie de la population sont des algorithmes

à remplacement stationnaire ou préservatif (Préservative

EA). Dans ce cas la population de la prochaine génération est

constituée de la combinaison de la population courante et la nouvelle

génération.

Les algorithmes générationnelles à leur

tour peuvent être divisés en algorithmes à sélection

gauche ou droite. Dans le premier cas, les bons individus ne sont pas

autorisés à participer à la reproduction de la nouvelle

génération pour éviter une convergence

prématurée des individus. Contrairement, se sont les mauvais

individus qui n'ont pas le droit de participer à a reproductin pour

garantir une certaine qualité.

1. Résumé de Christian Gagné [26]

Il existe un autre type d'algorithmes évolutionnaires,

souvent appelés algorithmes élitistes(Elitist algorithms), qui

assurent qu'au moins une copie des meilleurs individus de la

génération courante sera présente dans la prochaine

génération. Les algorithmes évolutionnaires à

état stable (Steady-State EA ou SSEA) sont des algorithmes

préservatifs qi ont la particularité de produire un nombre

d'individus faible comparé au nombre d'individus qui ont

participés à leur production.

Le premier pas dans la définition d'un algorithmes

évolutionnaires est de lier le vrai monde au Monde des algorithmes

évolutionnaires. Il s'agit de définir une sorte de passerelle

entre le contexte original du problème et l'espace du problème

à résoudre où l'évolution aura lieu. Les objets qui

forment des solutions dans le contexte original sont appelés

phénotypes, et leurs représentations génotypes.

L'efficacité d'un algorithme dépend pleinement

du choix de codage. Trouver une structure de donnée et un codage

adéquat est dès lors un des objectifs les plus importants. En

organisant les données d'une certaine manière on favorise leur

traitement automatique efficace et rapide. Adopter une structure de

données appropriée pour un problème informatique peut

également contribuer à decomplexifier de manière

significative une application informatique et ainsi participer à la

diminution du taux d'erreurs.[142]

Il existe principalement trois types de représentations

dans l'ensemble des algorithmes évolutionnaires. La

représentation binaire est le cadre générale des

algorithmes génétiques classiques. Chaque individu est

représenté par un vecteur binaire où chaque

élément peut prendre la valeur 0 ou 1. Cette

représentation s'adapte bien à des problèmes où les

solutions potentielles ont une représentation binaires canoniques. Elle

s'applique aussi à des problèmes d'optimisation continus, mais il

est alors nécessaire d'adopter une technique de codage

approproiée.

Dans la représentation réelle, l'espace de

recherche est l'espace des réels ou un sous ensemble. Cette

représentation a été initialement introduite par les

stratégies d'évolution, mais son utilisation s'est rapidement

étendue aux autres types d'algorithmes évolutionnaires.

Le dernier type est celui utilisant une structure

arborescente. Ce type de codage est à la base de la programmation

génétique pour la représentation et l'évaluation

des instructions des programmes informatiques. Il a été en suite

utilisé comme une technique de codage supplémentaire dans les

algorithmes génétiques.

2.5 Evaluation et Sélection

Dans les approches classiques, l'évaluation d'un

individu ne dépend pas de celle des autres. Le résultat fourni

par la fonction d'évaluation va permettre d'accepter ou de refuser un

individu pour ne garder que les individus ayant le meilleur coût en

fonction de la population courante. Cette méthode permet de conserver

les individus performants et d'éliminer progressivement les individus

peu adaptés. C'est donc la fonction qui permet de mesurer le

degré d'aptitude d'un individu à son environnement. Dans

plusieurs applications pratiques, cette qualité est croissante avec la

qualité de solution, mais dans certains problèmes, notamment ceux

d'optimisation, cette qualité peut être décroissante.

Le fait que le processus d'évaluation soit individuel a

sûrement ses avantages : l'algorithme n'a besoin ni de conserver des

historiques ni de prendre en compte le reste de la population. Cela permet de

gagner en mémoire et d'être indépendant de la taille de la

population. Cette individualité permet en outre de profiter davantage

des possibilités de parallélisassion.

A mesure de ne sélectionner que les meilleurs

individus, ces derniers peuvent tendre à se regrouper et à se

ressembler. Dans ce cas, la population risque de se trouver dans un cas

très homogène et de ne plus évoluer. Plusieurs techniques

ont été proposées pour pouvoir échapper à ce

problème de diversification. Ces techniques, comme le scaling et la

sharing[86, 148], utilisent des principes tels que l'historique

d'évaluation pour tenter d'incorporer plus d'informations et de

refléter, par conséquent, de façon plus

générale, l'état globale de la population.

La sélection permet de filtrer la population courante,

en se basant sur la fonction d'évaluation, de telle façon

à permettre aux bons individus de survivre et de devenir des parents. Il

existe un bon nombre de méthodes de sélection dans la

littérature, nous présentons brièvement quelques unes

ci-dessous.

2.5.1 Sélection par roulette

Il s'agit de la méthode la plus courante. Les individus

parents sont sélectionnés proportionnellement à leur

performance. Meilleur est le résultat fourni par l'évaluation

d'un individu, plus grande est sa probabilité d'être

sélectionné. Le nombre de fois qu'un individu sera

sélectionné est égal à son évaluation

divisée par la moyenne de l'évaluation de la population totale.

Plus exactement, la partie entière représente le nombre de fois

qu'il sera sélectionné, et la partie flottante la

probabilité qu'il aura d'être

sélectionné à nouveau. On peut comparer

cette méthode de sélection a une roulette de casino sur laquelle

sont placés tous les individus de la population, la largeur

allouée a chacun des individus étant en relation avec leur valeur

d'évaluation. Ensuite, la bille est lancée et s'arrête sur

un individu. Les meilleurs individus peuvent ainsi être tirés

plusieurs fois et les plus mauvais ne jamais être

sélectionnés.

2.5.2 Sélection par rang

La sélection par roulette présente des

inconvénients lorsque la valeur d'évaluation des individus varie

énormément. La sélection par rang trie d'abord la

population par évaluation. Ensuite, chaque individu se voit

associé un rang en fonction de sa position. Ainsi le plus mauvais

individu aura le rang 1, le suivant 2, et ainsi de suite jusqu'au meilleur

individu qui aura le rang N, pour une population de N individus. La

sélection par rang d'un individu est identique à la

sélection par roulette, mais les proportions sont en relation avec le

rang plutôt qu'avec la valeur de l'évaluation. Avec cette

méthode de sélection, tous les individus ont une chance

d'être sélectionnés. Cependant, elle conduit à une

convergence plus lente vers la bonne solution. Ceci est du au fait que les

meilleurs individus ne diffèrent pas énormément des plus

mauvais.

2.5.3 Sélection steady-state

Le principe de base consiste à garder une grande partie

de la population à la génération suivante. A chaque

génération sont sélectionnés quelques individus,

parmi ceux qui ont les meilleures évaluations, pour créer un

ensemble d'individus enfants. Les individus ayant les évaluations les

plus faibles sont ensuite remplacés par les nouveaux. Le reste de la

population survit à la nouvelle génération.

2.5.4 Sélection par tournoi

Soit une population de m individus. On forme m paires

d'individus. Ensuite, il faut déterminer un nouveau paramètre,

à savoir la probabilité de victoire du plus fort. Cette

probabilité représente la chance que le meilleur individu de

chaque paire soit selectionné. En principe cette probabilité doit

être grande. A partir des m paires, on détermine ainsi m individus

pour la reproduction.

2.5.5 Elitisme

A la création d'une nouvelle population, il y a de

grandes chances que les meilleurs individus soient modifiés, et donc

perdus après les opérations de reproduction. Pour éviter

cela, on utilise la méthode élitiste. Elle consiste à

copier un ou plusieurs des

meilleurs individus dans la nouvelle génération.

Ensuite, on génère le reste de la population selon l'algorithme

de reproduction usuel. Cette méthode permet de ne pas perdre les

meilleures solutions.

2.5.6 Sélection de seuil

La sélection de seuil ou sélection

déterministe (truncation selection), sélectionne un nombre

d'individus inférieur à la taille de la population

supposée après sélection. Si la taille de la population

après sélection est s, alors la sélection de seuil choisi

un nombre k < s (généralement s/2 ou s/3) des meilleurs

individus et les insert autant de fois que nécessaire pour que la taille

maximale de la population soit atteinte. La sélection de seuil est