ÉCOLE NATIONALE DE LA STATISTIQUE ET DE L'ADMINISTRATION

ÉCONOMIQUE 3, AVENUE PIERRE LAROUSSE - 92245 MALAKOFF CEDEX, FRANCE

Mémoire d'Actuariat présenté

pour

l'obtention du diplôme

de l'ENSAE

et l'admission à

l'Institut des Actuaires

le

Par: GUILLAUME OMINETTI et MARIE TODD

Titre: Modélisation et couverture des Comptes

Courants Postaux

Confidentialité: NON OUI (Durée: 1 an 2 ans)

Les signataires s'engagent à respecter la

confidentialité indiquée ci-dessus

Membre présent du jury de l'Institut des Actuaires

Membres présents du jury de la filière Actuariat

de l'ENSAE

Entreprise

Nom: LA BANQUE POSTALE Signature:

Directeurs de mémoire en entreprise Nom: CHRISTOPHE LUNVEN

Signature:

Nom: LUDOVIC MERCIER Signature:

Invité Nom: Signature:

|

Secrétariat :

Bibliothèque:

|

Autorisation de publication et de mise en ligne sur un

site de diffusion de documents actuariels (après expiration de

l'éventuel délai de confidentialité)

Signature du responsable entreprise

|

Signature du candidat

1

Résumé

Une banque de détail effectue un service dit de

transformation, ou d'intermédiation, c'est-à-dire

qu'elle collecte les dépôts de ses clients et utilise ces

ressources pour investir sur les marchés, en particulier pour

prêter aux particuliers, aux entreprises ou sur le marché

interbancaire. Cette position d'intermédiaire financier expose la banque

à un risque majeur, appelé risque de liquidité :

elle investit en général à long terme des ressources sans

maturité définie, qui peuvent être potentiellement

exigées par les clients du jour au lendemain. C'est la raison pour

laquelle on parle de dépôts à vue. Ainsi, un

retrait important et brutal par de nombreux clients peut créer un

déséquilibre soudain dans le bilan de l'établissement.

Dans un tel scénario, ce dernier ne dispose plus des liquidités

pour faire face à la demande et se voit contraint de réemprunter

sur les marchés et/ou de vendre une partie de ses actifs financiers

d'échéance lointaine. Si le contexte de marché est

défavorable à cet instant, avec des taux d'intérêts

très élevés, la banque enregistre alors potentiellement

une perte.

Pour diminuer son exposition à ce risque, elle doit

donc placer une proportion suffisamment importante de l'encours à court

terme. Cependant, il est aussi dans son intérêt de placer

l'essentiel de ses ressources à long terme afin, d'une part, de profiter

de taux d'intérêts plus avantageux et, d'autre part, de lisser sa

rémunération au cours du temps. Un arbitrage doit être

effectué entre les deux types d'investissement. L'établissement

de crédit doit définir une politique de risque qui pilote ses

stratégies de placement sur les marchés. Ce pilotage

dépend étroitement des modèles statistiques

utilisés pour effectuer les projections sur le niveau des taux et des

encours futurs : on parle de gestion actif/passif. Cette gestion

nécessite une analyse régulière de la situation du bilan

et surtout de son évolution probable. L'estimation des besoins et des

excédents de liquidité aux dates futures y revêt une

importance capitale.

Ce mémoire explore la problématique de la

gestion actif-passif d'une banque de détail en proposant d'abord une

modélisation, puis une couverture, de l'encours des comptes courants de

l'établissement de crédit dans le futur.

La première partie de l'étude a consisté

à proposer des scénarios d'évolution de l'encours global

des comptes à vue. Ce dernier est défini comme l'agrégat

des sommes d'argent déposées par les clients sur leur compte

courant.

Les articles académiques que nous avons lus, pour

orienter notre démarche, ne proposaient que des modèles

d'évolution macroéconomiques insuffisants à nos yeux. Nous

pensons en effet que la dynamique de l'encours est un processus complexe

intégrant des effets très variés, aussi bien

économiques (le Produit Intérieur Brut, l'inflation) que

démographiques (structure par âge de la clientèle) ou

comportementaux (taux de sorties volontaires des clients). La

littérature académique consultée ne tenait pas

suffisamment compte de ces éléments.

Ainsi, nous avons bâti un cadre théorique

microéconomique beaucoup plus fin. Le modèle probabiliste

construit repose sur une ventilation de la clientèle par strates

«financières» et par âges et reproduit les mouvements

aléatoires sur les comptes courants de chacun des clients en

intégrant des facteurs variés comme l'inflation ou les taux de

mortalité par âge. Ensuite, nous avons implémenté

informatiquement la modélisation mathématique innovante que nous

avons construit. L'enjeu de ces simulations a été de valider le

comportement du modèle et d'analyser sa sensibilité aux

différents paramètres.

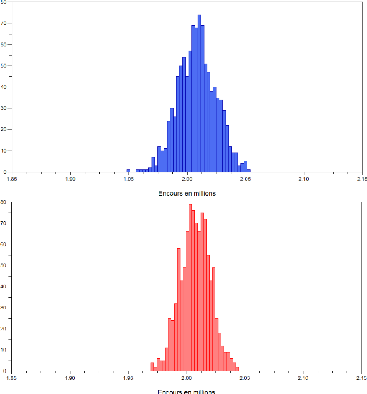

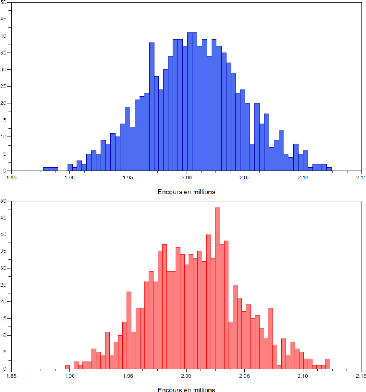

En particulier, nous y avons établi que le

modèle retenu pour l'inflation conditionne fortement la dispersion de

l'encours : une inflation aléatoire, et plus volatile, élargit

les intervalles de confiance pour la valeur de l'encours, à une date

future donnée.

2

Le degré de mobilité des clients, qui

caractérise leur propension à changer facilement d'état et

à sortir plus facilement, est un déterminant essentiel de la

volatilité de l'encours. Cela signifie que, plus la base de

clientèle est mobile, plus notre pouvoir prévisionnel sur

l'évolution de l'encours aux pas de temps suivants est

dégradé. De même, les taux de sortie des clients,

utilisés dans la calibration du modèle, modifient de

manière importante la durée de vie des dépôts dans

une vision de vieillissement du stock existant, lorsque la banque arrête

toute ouverture de compte.

La démographie actuelle de la clientèle est,

quant à elle, un facteur déterminant de la croissance de

l'encours sur le court-moyen terme. Nous y avons mis en évidence que,

dans le cadre de notre modèle, l'arrivée de la

génération du baby-boom dans des âges avancés est

susceptible d'entraîner, dans un futur proche, une surperformance de

l'augmentation de l'encours par rapport à ce que l'on pourrait

s'attendre a priori, notamment parce que les personnes

âgées détiennent en moyenne plus de liquidités. Par

ailleurs, nous avons pu vérifier qu'une banque en ligne, qui se

caractérise par une clientèle très jeune, connaît

une surperformance sensible de la croissance de son encours. Cela est

lié au vieillissement de sa clientèle actuelle et à

l'augmentation de l'effectif de cette dernière. À l'inverse, une

base de clientèle initialement âgée peut entraîner

une stagnation de l'encours, voire une décroissance de celui-ci, sur le

court-moyen terme en raison de la perte prochaine des clients les plus

aisés.

La seconde partie de l'étude a consisté à

analyser les performances de différentes stratégies

d'investissement de l'encours bancaire. L'enjeu est d'y modéliser

l'arbitrage, entre l'investisse-ment à court-terme et l'investissement

à long-terme, qui se pose dans la recherche simultanée d'une

rémunération lisse et pérenne mais avec une faible

exposition au risque de liquidité. Pour atteindre cet objectif, nous

avons considéré une stratégie de placement simple pour la

banque de détail, consistant à investir à court terme une

proportion constante de l'encours de clientèle et à investir le

résiduel à long terme, sur des obligations à cinq ans. En

nous appuyant sur un modèle financier classique sur les taux (celui de

Hull et White), nous avons simulé des scénarios

d'évolution des taux de marché de différentes

échéances. Ainsi, chacune de ces simulations a fourni une

trajectoire possible pour les prix des obligations et les rendements des deux

supports. En couplant cette simulation avec celle sur l'encours bancaire

effectuée en première partie, nous avons alors simulé la

marge nette dégagée par l'établissement sur une

période donnée. Cette marge nette est définie comme la

rémunération qu'il perçoit à chaque date au titre

de ses placements passés sur les marchés. Nous l'avons

effectué pour différentes stratégies de placement,

correspondant à une allocation plus ou moins importante d'investissement

sur le support court-terme (respectivement long-terme). Pour analyser la

robustesse de chaque stratégie, nous avons également

simulé un scénario de stress, qui consiste en une sortie

subite et massive de clients, couplée à une hausse des taux.

Nous avons mis en évidence que plus la banque place une

part importante de l'encours des dépôts à vue à long

terme, plus elle diminue la volatilité de sa marge mais plus elle

s'expose à un fort risque de liquidité : sous le scénario

catastrophe que nous générons, la banque s'expose à une

perte d'autant plus lourde qu'elle a investi massivement à long terme.

Nous avons alors été en mesure de tracer des graphes illustrant

cet arbitrage entre lissage de rémunération et risque de

liquidité. L'optimalité de l'investissement a été

envisagée comme un problème de minimisation de la

volatilité de la marge sous contrainte d'une perte plafond, en cas de

scénario de stress. Ce programme d'optimisation doit être

résolu par la banque au regard de la ligne de conduite sur le risque

qu'elle s'est fixée. Toutefois, nous avons établi que la

structure par âge de la clientèle conditionne le choix de

stratégie de l'établissement de crédit. Ainsi, à

volatilité de marge donnée (correspondant donc à une

certaine allocation entre placements court-terme et long-terme), une banque

présentant une clientèle jeune (respectivement âgée)

s'expose à un risque de liquidité inférieur

(respectivement supérieur) sur

3

le scénario catastrophe généré. La

raison à ce résultat est le différentiel de croissance

dans l'encours de ces banques.

Finalement, dans le cadre de notre modélisation, sous

le problème de minimisation de volatilité avec contrainte sur la

perte, la banque de détail va donc choisir d'investir une proportion

d'autant plus importante de l'encours global sur le long terme que sa

clientèle est jeune.

4

Abstract

A bank provides a so-called maturity transformation

service: it gathers liquidity from its customers' demand deposits and

trades this amount on the financial market, particularly to issue loans to

individuals, to corporates or to other financial institutions. This unique role

of financial middleman exposes the bank to a major risk, known as liquidity

risk : indeed, it invests in long-term financial assets the liquidity held

on «non-maturity» deposits, which have no stated maturity and where

individual depositors have the right to add or substract balances without

restriction. Therefore, an unexpected and massive withdrawal can result in a

sudden mismatch between assets and liabilities of the retail bank. In fact, the

latter becomes incapable of raising enough liquidity and is forced to borrow on

the money market and /or to sell part of its long-term financial assets in

order to face its customers' demand. If the market conditions are quite poor at

this very moment, with very high interest rates, the institution can

potentially carry a significant loss in the event of such a scenario.

In order to minimize its liquidity risk exposure, it has to

invest in short-term assets an important enough proportion of its demand

deposit liability. Nevertheless, it is more interesting to trade long-terme

assets since they generally offer higher return rates and enable the bank to

smooth its margin over time. Thus, the bank has to reach a relevant compromise

between the two kinds of assets. It has to define its risk-appetite internal

policy that will drive its investment strategies on the financial markets. This

management is closely dependent on the statistical models used for predicting

both the interest rates and the demand deposit liability : it is known as

Asset-Liability Management (ALM). It requires a frequent analysis of

assets and liabilities and of their probable evolution. Within this context,

the estimation of both future liquidity needs and excess is of the utmost

importance.

This paper explores the subject of asset-liability management

for a retail bank by proposing first a theoretical evolution model, and then a

hedging, of the demand deposit liability of the financial institution.

The first part of the study consists in proposing scenarios

for the future evolution of the «non-maturity» deposit liability. The

latter is defined as the total amount held by customers on their demand

deposits.

The existing literature on the subject we have read only

proposed macroecomic-oriented models, which appeared to be irrelevant from our

point of view. Indeed, we believe that the stochastic evolution of the deposit

liability is a complex process driven by various effects, ranging from economic

ones (the Gross Domestic Product, the inflation rate) to demographical ones

(the age structure of the customer base) or behavioral ones (the attrition

rate). None of the papers we have consulted wak taking these different aspects

into account.

Therefore, we have built a far more accurate

microeconomic-oriented theoretical framework. This stochastic model relies on

an apportionment, that is to say a breakdown, of the customer base both by

strata (on a financial criterium) and by age and reproduces the random moves on

individuals' demand deposits while integrating various exogenous factors such

as inflation or mortality rates. Then we have implemented this innovative

mathematical model on computer. The purpose of the conducted simulations was to

analyze both the relevance of the results implied by our model and their

sensibility to the different parameters.

We have notably proved that the underlying model used for

inflation strongly influences the demand deposit dispersion: a random and more

volatile inflation broadens the confidence intervals for the value of the

demand deposit at a set date in the future.

5

The degree of mobility of customers, which characterizes their

propensity to move easily from one financial state to another and to leave the

bank, largely conditions the volatility of the deposit balance. This means that

the more mobile the customers are, the more our predictive power on the

evolution of the demand deposit liability is deteriorating. Similarly, the

bank-leaving rate used to calibrate the model significantly modifies the

duration of demand deposit liability in the situation where the bank stops

issuing accounts.

The bank's customer base today's structure is the major driver

of the growth of its demand deposit balance in the short and in the mid term.

We have emphasized the fact, that within the framework of our model, the ageing

of the baby-boom generation is likely to cause in the near future an overgrowth

of the demand deposit balance compared to what we could expect first, given

that elderly people generally hold more liquidity on their accounts. Besides,

we have been able to prove that a bank whose customers are quite young

(typically the case of recently-appeared online banks) will see the growth of

its demand deposit balance overperform because of the ageing of its customers

and the increase in the number of them. On the contrary, an elderly customer

base can result in a stagnation or even a decrease in the demand deposit

liability in the short and in the mid term, due to the loss of the wealthiest

customers in the near future.

The second part of the study has aimed at analyzing the

performance of different investment strategies. The stake was to modelize the

compromise to reach (between investing in short-term and in long-term financial

assets) that raises while trying to ensure both a smooth and sustainable margin

and a low liquidity risk exposure. To achieve this goal, we have considered a

simple investment strategy for the retail bank, that consists in trading a set

and constant proportion of the demand deposit liability on short-term assets

and to invest the remaining on five-year maturity state bonds. Thanks to the

Hull and White classical financial model on market rates, we have generated

future evolution scenarios for the term structure of the rate curve. Each of

these simulations has provided a possible trajectory for the bonds prices and

the returns of the assets the bank can buy. By coupling this implementation

with the one on the stochastic evolution of the demand deposit balance built in

the first part, we have simulated the net margin the bank perceives over a

given period of time. The net margin is defined as the remuneration the bank

gets at each date from its past investments, that is to say the interest rate

cash-flows following its past trades. We have implemented this procedure for

different investment strategies, each one matching a specific allocation in the

demand deposit balance investment between short-term and long-term assets.

What's more, in order to analyze the robustness of the different strategies, we

have generated a stress test consisting in both a sudden and massive attrition

and a dramatic increase in market rates.

We have emphasized the fact that the more the retail bank

invests on long-term state bonds, the more it reduces the volatility of its net

margin but the more it is exposed to an important liquidity risk too : thus,

under the stress test we have simulated, the financial institution is all the

more exposed to a major loss since it has massively invested in long-term

securities. We were then able to plot graphs that give a visual illustration to

the compromise between smooth remuneration and liquidity risk : the optimality

of the investment is seen in the light of a margin volatility minimization

program with condition on the loss incurred under the stress test. This

optimality is then to be determined by each bank in regard of the risk-appetite

policy it follows. However, we have been able to establish that the age

structure of the retail bank's customer base impacts its investment choice.

Thus, for a given margin volatility (matching a specific allocation between

short and long-term investments), a bank whose customers are particularly young

(resp. elderly) is exposed to a lower (resp. higher) liquidity risk under the

simulated stress test. The reason for this result is the significant

differential in the growth of the deposit balance of these banks. As a matter

of fact, within

6

our model framework, under the margin volatility minimization

program with condition on the loss incurred under the stress test, the retail

bank invests an all the more important part of its demand deposit liability in

long-term securities since its customers are young.

7

8

Table des matières

I Analyse de la problématique ALM et revue de la

littérature 11

1 Le pilotage actif-passif 11

1.1 Notions autour du risque ALM 11

1.2 Objectifs 12

1.3 L'approche académique de la problématique :

éléments de bibliographie . . 13

2 Démarche du projet 15

II Modélisation de l'évolution du niveau d'encours

16

3 Observations empiriques et orientation de la

démarche 16

3.1 Analyse du niveau d'encours historique 16

3.2 Motivation de l'approche retenue 18

4 L'approche macroéconomique 19

4.1 Principe et choix des variables explicatives 19

4.2 Résultats 20

4.3 Un modèle pour l'inflation 21

5 L'approche probabiliste interne 23

5.1 La segmentation clientèle 23

5.2 Modélisation de la dynamique des encours 24

5.2.1 Notations 24

5.2.2 Dynamique des clients au sein de la banque 25

5.2.3 Dynamique de l'encours client moyen par cellule 26

5.2.4 Le modèle probabiliste et ses hypothèses

27

III Application informatique du modèle construit 32

6 Analyse de premières simulations 32

6.1 Les paramètres et les variables d'état

initiales 32

6.1.1 Taux de transition et de sortie 32

6.1.2 Lois des processus d'arrivée 33

6.1.3 Inflation et encours client moyen par cellule 34

6.2 Résultats obtenus 34

7 Sensibilités aux paramètres et aux

variables initiales 36

7.1 Influence de l'inflation et des taux de transition 37

7.2 Influence de la démographie initiale 42

7.2.1 Pyramide des âges et calibration des processus

d'arrivée 42

7.2.2 Déséquilibre démographique initial

vers le bas 46

7.2.3 Déséquilibre démographique initial

vers le haut 47

7.3 Vision «mort» du bilan et durée de vie

théorique des dépôts 48

8 Un modèle à «superstrates»

49

9

9 Vers une calibration du modèle sur les

données

historiques? 56

IV Modélisation de l'évolution de la marge nette

57

10 Définition et principes 57

10.1 Une approche économique et comptable 57

10.2 Les stratégies de placement et le «compte

d'intérêts» 57

11 Le modèle 59

11.1 La courbe des taux 59

11.2 Récapitulatif du modèle général

63

11.3 Les stratégies de placement 64

11.3.1 Position du problème 64

11.3.2 Métriques utilisées 65

11.3.3 Notations 66

11.3.4 L'investissement sur les marchés 67

12 Simulations de l'évolution de la marge

nette

d'intérêts 69

12.1 Illustration

des différences entre les stratégies d'investissement sur un cas

très

simple 69

12.2 Volatilité de la marge et perte en situation de

stress 71

12.3 Influence de la structure initiale de la base de

clientèle 73

A Dynamique de l'encours des dépôts à

vue 77

B Résolution détaillée du

modèle de Hull et White 79

C Table INED utilisée pour la calibration des taux

de mortalité 84

10

Introduction

Les banques de détail jouent principalement le

rôle d'intermédiaire financier et rendent un service de

liquidité: elles empruntent à court terme aux personnes ayant un

excès de financement (par le biais de leurs dépôts) et

prêtent, en général à long terme, aux personnes

ayant un besoin de financement. Ce mécanisme fondamental s'appelle la

transformation et fait des établissements de crédit des

acteurs essentiels du paysage économique actuel. Cette opération

d'intermédiation comporte néanmoins des risques substantiels pour

les établissements bancaires.

Le principal d'entre eux est le risque de liquidité,

qui traduit une incapacité de la part de l'établissement à

rééquilibrer son bilan. L'origine de ce risque réside dans

le fait que les sommes déposées par les clients sur leurs

comptes, qui constituent le principal passif de long terme des banques de

détail, sont intrinsèquement des ressources sans maturité

contractuel-lement définie, à la différence des principaux

postes figurant à l'actif (tels les obligations d'Etat ou les

prêts immobiliers ainsi qu'à la consommation). Ainsi, un retrait

soudain et massif des clients peut potentiellement excéder les

réserves de liquidité de l'établissement et créer

une insuffisance de trésorerie. Cela oblige dès lors la banque

à réemprunter et rend nécessaire une liquidation dans

l'urgence de ses actifs longs, avec le risque de marché que cela induit.

On parle ainsi de passif sans échéance. Pour faire face

à ce type de risque, la banque propose en interne des lois

d'écoulement sur les dépôts à maturité

incertaine pour définir ses stratégies de placements. D'autre

part, les programmes de financement qu'elle adopte doivent lui permettre de

réajuster au mieux son bilan en cas de déséquilibre de ce

dernier et prennent en compte l'évolution des marchés, en

particulier celle des niveaux des courbes de taux. Cette gestion est connue

sous le nom de gestion du bilan bancaire ou gestion actif-passif (en

anglais Asset Liability Management abrégé en ALM). Le

second risque le plus important s'inscrivant dans ce cadre, et intimement

lié à celui de liquidité, est le risque de taux (de

change, d'intérêt et même d'inflation). En effet, un

changement des courbes de taux induit, d'une part, une modification de la

valeur des positions financières figurant au bilan et, d'autre part, une

modification potentielle du comportement des clients. Le niveau des taux agit

par ailleurs directement sur l'efficacité des stratégies

financières visant à équilibrer le bilan de

l'établissement de crédit. Il s'agit dès lors pour la

banque de définir une politique de gestion des ressources figurant

à son passif en vue d'optimiser la valeur économique de

l'ensemble sur la durée. Ce pilotage dépend étroitement

des modèles statistiques utilisés pour effectuer les projections

sur le niveau des taux et des encours futurs.

La problématique de gestion des risques ALM, qui n'a

pas encore été beaucoup explorée d'un point de vue

théorique, revêt ainsi une importance capitale pour les banques de

détail, surtout depuis la crise financière de 2008.

L'objectif de notre étude est d'explorer plus en

détail les différents aspects des problèmes posés.

Après une revue de la littérature existante sur le sujet, nous

définirons un cadre théorique innovant pour la

modélisation de l'évolution de l'encours des dépôts

à vue, en l'envisageant sous un angle microéconomique.

Après construction de ce modèle de prévision stochastique

de l'encours, nous diffuserons les courbes de taux sur les marchés selon

le modèle de Hull et White. Cela nous permettra dans une dernière

partie d'analyser les performances de différentes stratégies de

placement de l'encours bancaire, en étudiant notamment l'exposition

qu'elles induisent aux risques de taux et de liquidité. Nous serons

alors en mesure de discuter l'optimalité des différentes

stratégies envisagées selon le point de vue adopté.

11

Première partie

Analyse de la problématique ALM et

revue de la littérature

1 Le pilotage actif-passif

1.1 Notions autour du risque ALM

Le bilan simplifié d'une banque de détail

comprend les principaux postes suivants.

|

Actif

|

Passif

|

|

Immobilisations

|

Capitaux propres

|

|

Crédits immobiliers

|

Comptes-chèques (CCP)

|

|

Crédits à la consommation

|

CSL (comptes sur livrets)

|

|

Autres créances

|

LA/LDD/LEP (livrets réglementés)

|

|

Portefeuille de marché

|

PEL/CEL (épargne logement)

|

|

Trésorerie

|

Programmes de financement

|

|

(émissions d'obligations/emprunts interbancaires)

|

Le passif, qui correspond aux ressources de la

banque, est essentiellement constitué de l'épargne et des

dépôts de la clientèle. Ces dépôts sont dits

à vue, car ils peuvent être exigés à tout

instant par le client (d'où le terme de passif sans

échéance), et constituent la principale «raison

d'être» de la gestion ALM. À l'exception des comptes

courants, les dépôts sont rémunérés selon des

taux qui évoluent'. Tous ces dépôts sont

comptabilisés en couru, c'est-à-dire en coût amorti : on

effectue une analyse période après période des flux

d'intérêts et des décaissements qui seront amenés

à les affecter aux différentes dates futures.

À l'actif, qui correspond aux emplois,

figurent, notamment, les crédits distribués par

l'établissement bancaire aux particuliers et aux entreprises. Environ

90% de ces crédits sont contractés à taux fixe. Les

excédents de trésorerie sont généralement soit

prêtés à d'autres établissements (sur le

marché interbancaire) soit investis en des portefeuilles de titres,

d'échéances similaires à la durée de vie moyenne

estimée des postes au passif. Les titres sont soit affectés en

trading et comptabilisés en valeur de marché, ou

Marked-To-Market, soit détenus jusqu'à maturité

(HTM pour Held To Maturity) et comptabilisés en coût

historique.

La détention d'obligations souveraines,

considérées comme des titres sûrs, permet à la

banque de les mettre en garantie pour se refinancer auprès de la Banque

Centrale en cas de stress de liquidité.

En fonction de l'adossement emplois-ressources, la banque de

détail a un :

- Besoin de liquidités lorsqu'il y a insuffisance des

dépôts pour faire face à la demande de crédits. Il

lui faut alors trouver ces ressources, par exemple en émettant des

titres ou en ayant recours au prêt interbancaire;

- Excédent de liquidités lorsque toute

l'épargne liquide n'a pas été transformée. La

banque peut alors utiliser ces ressources pour prêter sur le

marché interbancaire ou investir en titres.

'Par exemple, le taux du livret A est

actualisé tous les trois mois : réglementé, il tient

compte du niveau de l'inflation et des taux courts

12

Ainsi, la banque de détail finance l'investissement en

transformant l'épargne liquide des différents comptes clients en

prêts à long terme (figurant à l'actif). Cette

activité des banques, l'intermédiation, leur fait porter

un risque de liquidité, en raison des différences de

maturité entre les deux types d'engagements. La difficulté de la

gestion bancaire, pour les établissements de crédit,

réside essentiellement dans le fait suivant : les postes figurant au

passif présentent en majorité une maturité

incertaine et servent à financer les postes figurant à

l'actif qui se caractérisent essentiellement par un

échéancier connu. En pratique, le passif est

globalement considéré comme un poste court terme alors que

l'actif comprend essentiellement des crédits à long terme. Ainsi,

l'établissement de crédit se retrouve engagé sur deux

«terrains» à des niveaux opposés. Intuitivement, on

comprend que toute la difficulté de ce service de transformation pour la

banque est d'assurer une rentabilité a minima tout en contrôlant

ses prises de risque afin de pouvoir tenir à tout instant ses

engagements sur les deux «terrains».

La Banque Postale totalise actuellement plus de 11 millions de

comptes courants actifs (comptes chèques), désignés en

interne sous l'appellation Comptes Courants Postaux (CCP). Ces comptes

courants, non rémunérés, représentent environ un

tiers de son passif, soit approximativement 45 milliard d'euros actuellement.

Cette banque n'est toutefois pas représentative de la plupart des autres

établissements de crédit français dans la mesure où

elle totalise un nombre bien plus élevé de dépôts de

clientèle que la majorité d'entre eux. Cette

spécificité lui permet de prêter massivement sur le

marché interbancaire.

1.2 Objectifs

La gestion ALM a pour objectif d'estimer et de piloter

l'équilibre entre les emplois et les ressources au regard de la

politique de risque souscrite par l'établissement. Les risques les plus

pris en compte dans son pilotage sont le risque de liquidité et les

risques de taux (intérêts, change, inflation), qui demeurent

très liés.

Cette gestion passe d'abord par une analyse

régulière de la situation du bilan et de son évolution

probable. Ainsi, la mesure des besoins et des excédents de

liquidité aux dates futures s'inscrit dans la gestion du risque de

liquidité. La mesure des déséquilibres entre les emplois

et les ressources sensibles aux mouvements d'un même taux

nécessite quant à elle une couverture spécifique de ce

risque.

Le premier enjeu du pilotage du bilan bancaire est de viser un

adossement actif/passif dans le temps, c'est-à dire un équilibre

entre les cash flows générés dans le futur par l'actif et

le passif. Le second consiste à définir une politique globale

permettant de garantir un résultat pérenne et de lisser la

rentabilité dans le temps pour s'affranchir des effets de cycle. Ceci

est réalisé essentiellement au moyen de couvertures

financières contre les mouvements de taux. L'utilisation de produits

dérivés revêt ainsi un caractère indispensable.

Le pilotage ALM implique de pouvoir observer le comportement

financier de la clientèle et de proposer des modèles

d'évolution de ce dernier. Par ailleurs, il nécessite de

travailler en coordination avec le département chargé de la

politique marketing dans la mesure où le comportement clientèle

modélisé est fortement lié aux stratégies

commerciales et marketing proposées.

La gestion ALM s'appuie donc à la fois sur la

modélisation statistique des comportements de la clientèle et sur

les différentes méthodes de couverture sur les marchés

financiers : les modèles de prévision retenus permettent de

définir des stratégies financières d'achat de titres et de

dérivés sur les marchés afin de se couvrir contre les

risques modélisés.

13

1.3 L'approche académique de la problématique

: éléments de bibliographie

La littérature académique sur la gestion ALM, ou

sur la modélisation du niveau de l'encours de dépôts, est

relativement peu étoffée. Certains articles ont

particulièrement retenu notre attention. Nous les présentons

succinctement ci-après.

Le premier d'entre eux, intitulé The arbitage-free

valuation and hedging of demand deposits and credit card loans, fut

écrit en 1997 par Robert A. Jarrow et Donald R. van Deventer. Ce papier

vise à donner, sous certaines hypothèses, la «valeur»

actuelle de la masse totale des dépôts à vue de la banque

et à en déduire des stratégies de couverture. L'approche

est successivement faite en temps discret et en temps continu, de

manière complètement analogue. Nous nous contenterons ici de

décrire leur démarche dans le cas discret.

Dans une économie à temps discret

tE{0,1, ..., ô} munie d'une filtration

naturelle Ft, les auteurs font l'hypothèse d'un marché

segmenté : les individus, comme les banques, ont accès à

un marché de titres du Trésor, mais seules les banques peuvent

créer des comptes courants (sur lesquels les individus peuvent placer

des dépôts). L'encours en t de l'ensemble des

dépôts de la banque est noté D(t). Le

marché du Trésor est supposé parfait 2 et

complet 3. Sur ce marché sont échangés un titre

«cash» sans risque de valeur B(t) en t et

des zéros-coupons. Le prix à la date t d'un

zéro-coupon payant 1$ en T est noté P(t,

T) avec

1

r(t)= P(t, t + 1) - 1

le taux d'intérêt spot. Sous l'hypothèse

d'absence d'opportunités d'arbitrage, les auteurs déduisent

l'existence d'une unique probabilité risque-neutre Q équivalente

à la probabilité historique sous laquelle les

zéros-coupons écrits dans le numéraire cash sont des

martingales, soit

P(t, T)=EQ (P(t+

+r1,T) |Ft) =B(t)EQ

(B(T)|Ft)

Les dépôts à vue sont quant à eux

rémunérés au taux instantané

i(t), c'est-à-dire qu'un dollar versé en t

sur le compte est rémunéré par la banque 1 +

i(t) dollars à la date t + 1. Les individus

ne pouvant pas arbitrer, i(t) < r(t)

pour tout t. L'inégalité stricte est autorisée

car les auteurs laissent la possibilité d'opportunités

d'arbitrage par les établissements de crédit.

Sous ces hypothèses, et en considérant que

D(t) et i(t) sont adaptés

à Ft, Jarrow et van Deventer écrivent la valeur actuelle

nette en 0 des dépôts à vue de la banque comme étant

égale à

|

VD(0)=EQ

|

ô-1E t=0

|

D(t)(r(t) -

i(t))

|

)

|

|

B(t + 1)

|

Il s'agit de l'espérance sous la probabilité

risque-neutre de la somme actualisée des flux futurs affectant les

dépôts. Les auteurs l'interprètent comme la valeur d'un

swap vanille de taux durant ô périodes, recevant le taux

variable r(t) et payant le taux variable

i(t), de nominal variable D(t) en

t. Ils en déduisent la couverture de l'encours, consistant

à investir D(0) (l'encours initial) en zéros-coupons

P(0, 1) et à vendre le swap représenté

par VD(0).

2Les actifs sont divisibles à l'infini, le

marché est infiniment liquide, il n'y a pas de coûts de

transaction ni de dividendes, les ventes à découvert sont

autorisées sans pénalités ni contraintes et les taux de

prêt et d'emprunt sont les mêmes

3Tout flux en r est atteignable par un

portefeuille autofinançant admissible

14

Pour mener à terme les calculs, les auteurs proposent

plusieurs modèles pour D(t) et i(t). Citons notamment

D(t)=a+br(t) ou

ln(D(t))-ln(D(t-1))=a+br(t)+ct+d(r(t)-r(t-1))

où le temps est censé être un proxy de variables

macroéconomiques pertinentes. En temps continu, l'article propose

d'utiliser pour le taux spot r(t) le modèle de Vasicek et

d'expliquer la variation de l'encours par le niveau des taux courts selon

dln(D(t))=(a+br(t)+ct)dt+edr(t). Dans ces conditions, le logarithme de

l'encours est donc une diffusion. Nous reviendrons sur ce dernier point

ultérieurement.

Datant de 2009, l'article Hedging interest rate margins on

demand deposits d'Alexandre Adam, Mohamed Houkari et Jean-Paul Laurent

propose, quant à lui, une approche dite en «couru». Ils ne

considèrent donc pas la valeur actuelle nette de l'encours mais

directement la marge de taux d'intérêt

générée par la banque, période après

période. Celle-ci est définie comme la différence entre le

taux d'intérêt auquel la banque prête et le taux qu'elle

verse sur les dépôts. L'approche est en temps continu. Les auteurs

de l'article modélisent le taux LIBOR forward Lt := L(t, T, T + 6T)

à la date t, prévalant sur l'intervalle [T, T +

6T], par l'équation différentielle stochastique

dLt = Lt(pLdt + ULdWL(t))

avec /1L et UL constants. L'encours de

dépôts à la date t, Kt, est

supposé suivre la dynamique

|

dKt = Kt(aKdt + UKd

|

WK(t))

|

avec /1K et UK également constants.

Leur idée est également de créer une dépendance

entre le niveau d'encours et le niveau des taux. Ils supposent donc, en

s'inspirant d'un article de Kalkbrener et Willing de 2004, que

v'

d WK(t) = pdWL(t) + 1 -

p2dWK(t)

où WK est un mouvement brownien orthogonal

à WL, WK étant censé représenter

d'autres sources de risques indépendantes des mouvements de la courbe

des taux. Le taux versé sur les dépôts est

modélisé par une fonction affine du taux sur le marché,

soit g(Lt) = + /3Lt. Dans ces conditions, la marge de taux

d'intérêt sur la période [T, T + 6T] est

définie par

IRMg(KT, LT)=6TKT(LT - g(LT))

Par la suite, les auteurs considèrent des

stratégies de couverture qui consistent à signer des contrats

à terme de gré à gré appelés FRA (pour

Forward Rate Agreements). Ces derniers conduisent à la famille

de pay-offs {9(L0 - LT), 9 R}. Par extension, ils

définissent les stratégies admissibles comme les

intégrales stochastiques relativement au processus d'Itô

Lt,

soit

(Z T )

9tdLt, (9t)0=t=T

adapté

0

Les auteurs résolvent alors le problème de

minimisation de la variance de la marge de taux d'intérêt sous

contrainte d'espérance. Après calcul, ils en déduisent les

stratégies optimales statiques, puis dynamiques, par des méthodes

de contrôle stochastique.

Citons pour terminer l'article de thèse de Tanja Eronen

intitulé Non-maturity Deposit Valuation and Hedging datant de

2008. Il offre un panorama relativement complet de la littérature

existante sur le sujet et discute certaines hypothèses faites dans les

modèles proposés. Il évoque en outre plusieurs

méthodes et outils de couverture pour la gestion ALM : les floors (de

taux d'intérêt) ainsi que différents swaps de taux.

15

2 Démarche du projet

Notre étude se divise en deux parties.

Elle commence par la modélisation de l'évolution

future de l'encours des dépôts à vue.

Notre approche consistera dans un premier temps à

régresser cette masse des encours ainsi que ses variations (ou une

fonction de celles-ci) sur des variables macroéconomiques telles que le

Produit Intérieur Brut, l'inflation ou encore le niveau des taux courts.

Nous utiliserons pour cela les données de l'encours de La Banque Postale

sur les dernières années. L'enjeu de cette première

étape est d'analyser la sensibilité du niveau des

dépôts à des grandeurs «globales», avant de nous

consacrer à une modélisation plus fine de celui-ci. La

démarche consistant à relier directement l'encours bancaire (ou

ses variations) au niveau des taux, dans un cadre de séries temporelles,

a été largement employée dans le passé, notamment

par Jarrow et van Deventer comme nous l'avons précisé. Elle a

également été reprise par Eronen. Nous pourrons confronter

cette modélisation ad hoc aux données historiques de La

Banque Postale

Dans un second temps, nous définirons un cadre

théorique plus complet qui constitue l'innovation majeure de cette

étude et en est sa principale motivation. Il est fondé sur

l'idée que notre capacité prédictive d'évolution de

l'encours est beaucoup plus forte lorsque nous nous basons sur la structure par

âge des clients et que nous nous focalisons sur un segment de

clientèle particulier. Ainsi, en découpant le portefeuille de

clients de la banque puis en tenant compte des comportements

caractéristiques à chaque groupe plus homogène ainsi

formé, on espère augmenter notre pouvoir explicatif sur

l'évolution de la masse des encours (partiels puis global par

agrégation). En outre, cette approche a l'avantage de permettre une

analyse plus fine du comportement des clients dans chaque segment et donc

d'aider à la définition de politiques commerciales plus optimales

adressées à chacun d'entre eux. Cette approche nécessitera

la mise en place d'un modèle mathématique et d'hypothèses

sous-jacentes, qui sont exposés en détail dans la partie

dédiée. Pour inférer la distribution statistique de

variables liées à l'encours clientèle, nous effectuerons

des simulations Monte-Carlo sous divers choix de paramètres. Le

principal enjeu de cette modélisation est de déterminer la

sensibilité de la dynamique de l'encours à ces derniers.

La dernière partie de ce projet est le volet financier,

qui consiste à exploiter les résultats de la première

partie pour définir des stratégies de placement plus optimales.

Il s'agira en premier lieu de modéliser l'évolution de la courbe

des taux sur les marchés financiers. En croisant cette

modélisation avec celle de l'évolution du niveau d'encours, nous

serons en mesure de projeter les intérêts

générés par les dépôts dans le cadre d'une

politique de placement précise. Ils seront fonction du volume d'encours

disponible, de l'allocation de cette ressource entre les placements potentiels

et du niveau des taux d'intérêts à chaque date. La marge de

taux d'intérêts a déjà été

évoquée; nous rappelons qu'elle s'identifie simplement à

la différence entre le taux de placement de la banque (ce qu'elle gagne)

et le taux de rémunération des dépôts (ce qu'elle

distribue à ses clients). L'objectif sera ensuite de couvrir cette

marge, c'est-à-dire de l'insensibiliser le plus possible aux

fluctuations de taux et de niveau d'encours, sous contrainte toutefois de

pouvoir faire face à un stress de liquidité. Nous

analyserons l'efficacité de différentes stratégies de

placement, en recherchant celle(s) garantissant une marge nette la moins

volatile possible et une prise de risque de liquidité limitée.

Cette approche correspond à une vision plus pérenne de

l'activité, qui s'emploie à s'affranchir des effets de cycle sans

pour autant mettre en péril la santé financière de

l'établissement. Ceci nous permettra de proposer des stratégies

de pilotage ALM.

16

Deuxième partie

Modélisation de l'évolution du niveau

d'encours

3 Observations empiriques et orientation de la

démarche

3.1 Analyse du niveau d'encours historique

Une observation de l'évolution de l'encours

global4 des CCP à la Banque Postale appelle plusieurs

remarques qualitatives. Nous avons tracé ci-dessous l'évolution

de cette grandeur sur la période 1994-2010. Les relevés sont

mensuels, avec interpolation affine.

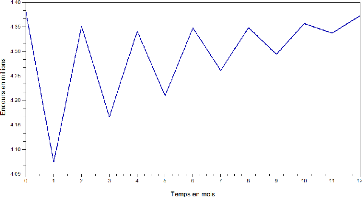

FIG. 1 - Évolution historique des CCP

On constate déjà une tendance nette de

croissance de la masse des dépôts. Les mesures étant

mensuelles, le graphe ici capture en fait la dynamique globale des encours. En

réalité, une étude de cette quantité à une

échelle plus fine révèlerait des saisonnalités

infra-mensuelles intimement liées à la période

étudiée, d'un ordre de grandeur de deux à cinq milliards

d'euros. Les flux importants représentés par le versement des

salaires (en fin de mois), des allocations sociales ou encore des retraites en

sont essentiellement à l'origine. Dans la cadre de cette étude,

nous nous restreindrons à la partie dite «stable» de

l'encours, c'est-à-dire celle représentée sur le graphique

ci-dessus.

Ainsi, bien que les dépôts soient à vue,

et donc, en théorie, sans maturité, on observe une forme de

stabilité remarquable de l'encours, qui ne «s'évapore»

jamais. Cette dernière remarque permet d'investir sur des actifs

financiers les liquidités collectées en considérant que

les dépôts ont une certaine durée de vie moyenne effective.

En pratique, cette dernière est considérée comme

étant de l'ordre de cinq ans. Les banques savent ainsi que les

dépôts

4Nous désignons par cette expression la

somme des dépôts correspondant à tous les comptes courants

ouverts dans l'établissement

17

à vue restent relativement lontemps en base. Toutefois,

précisons ici que La Banque Postale (à titre d'exemple, mais la

remarque est vraisemblablement pertinente pour les autres établissements

de crédit) ne l'a jamais mesuré précisément. En

outre, l'encours total est continuellement «pollué» par la

production nouvelle (arrivées de clients). Les différents effets

(arrivées, sorties...) n'ayant jamais été isolés,

on observe l'évolution de l'agrégat sans pouvoir connaître

ce qui se passe aux échelles inférieures. Notre modèle

permettra de définir une forme de benchmark précis pour

l'appréhender plus finement.

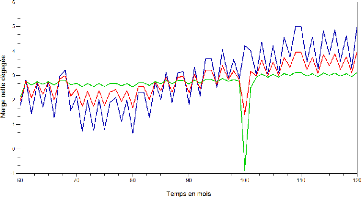

Partant de ce graphe, deux approches ALM sont

envisageables.

La première correspond à une vision

surnommée «mort du bilan», dans laquelle la banque

arrête toutes ses commercialisations de produits. Cette approche consiste

à modéliser le vieillissement du stock existant sans aucune

nouvelle arrivée extérieure. On y étudie

l'évaporation progressive de la masse des encours dans le temps,

consécutive aux départs des clients actuels (volontaires, vers la

concurrence, ou par décès). L'établissement de

crédit adopte alors une forme de convention d'écoulement pour

décrire ce vieillissement, qui va conditionner sa stratégie

d'achat de titres. Quatre scénarios possibles de cette «mort du

bilan» sont représentés ci-après. Les courbes orange,

jaune et mauve correspondent respectivement à une décroissance

linéaire, à une décroissance linéaire après

un premier choc, et à une décroissance de type exponentiel ou

hyperbolique qui ralentit progressivement. L'adoption d'un scénario plus

brutal, avec un écoulement plus rapide, correspond bien

évidemment à une vision plus prudente. Les banques adoptent en

général une convention d'écoulement standard parmi l'une

de ces formes. L'idée est de retenir un scénario de crise dans

lequel l'évolution est relativement simple, typiquement une diminution

brutale de 10% (choc initial) suivie d'une décroissance linéaire

jusqu'à une échéance T (10 ans, 15 ans...)

où tout le stock aura disparu. Le modèle développé

dans ce mémoire permettra a priori des modélisations de

mort du bilan plus «réalistes» correspondant à une

évolution plus stochastique (se rapprochant de l'évolution

historique), tel que cela est suggéré par la courbe rouge. Ceci

permettra de modifier la convention d'écoulement et par

conséquent les stratégies d'achat de titres. À titre

d'exemple, si la convention standard (décroissance linéaire sur

T années) s'avère trop pessimiste, nous pourrons

optimiser les placements en investissant sur des titres de maturité plus

longue aux taux de rendement plus élevés.

FIG. 2 - Scénarios d'évaporation de la masse des

encours de CCP

La seconde approche est quant à elle associée

à une vision dite «dynamique». Ceci passe non seulement par la

modélisation du vieillissement du stock existant mais également

par la modélisation d'une production nouvelle correspondant aux

arrivées progressives de nouveaux

18

clients. Dans cette vision, on opère une projection de

l'encours des dépôts à vue de la banque dans le futur.

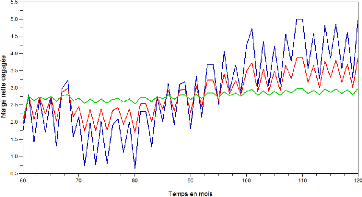

FIG. 3 - Dynamique future de la masse des encours de CCP

L'idée est de calculer (ou à défaut

d'estimer) la distribution statistique du niveau d'encours à

différents horizons. Nous pourrons en déduire des intervalles de

confiance théoriques (ou empiriques) de la grandeur

considérée, aux différentes dates.

Cette modélisation constituera le coeur de ce

projet.

3.2 Motivation de l'approche retenue

Comme nous l'avons expliqué, nous souhaitons avant tout

développer une nouvelle approche de modélisation des encours.

Nous allons exposer ici la raison qui nous a amenés à rejeter les

modèles que nous avons consultés dans la littérature

académique.

Nous observons que dans l'ensemble des articles que nous avons

lus sur le sujet, les auteurs considèrent que l'encours bancaire suit

une dynamique très (trop) simple. En temps discret, leur démarche

consiste généralement à l'écrire comme une fonction

déterministe du temps, du Produit Intérieur Brut et/ou des taux

courts. L'idée est de le décrire comme une fonction croissante du

temps et de la richesse nationale et comme une fonction décroissante du

niveau des taux (en raison de l'attrait supplémentaire induit pour les

livrets rémunérés). Lorsque les auteurs raisonnent en

temps continu, ils supposent généralement que le niveau

Ät des dépôts de la banque est une diffusion.

Autrement dit, ils considèrent que Ät est solution d'une

équation différentielle stochastique (EDS) du type

d1Xt = lXt(adt + adWt)

avec /1 > 0 constant et o- constant.

C'est notamment ce que suggèrent les auteurs sus-cités (Jarrow et

van Deventer ainsi que Adam, Houkari et Laurent).

Notre conviction est que, dans un cas comme dans l'autre, la

modélisation sous-jacente n'est absolument pas pertinente pour l'encours

bancaire. Le plus gros reproche que nous faisons à ces deux approches

est leur «pauvreté» explicative. En effet, l'ensemble de la

dynamique des dépôts est résumé dans un cas par les

variations des taux ou du PIB et dans l'autre par deux paramètres

exogènes (à savoir le drift /1 et la volatilité

a). Il est intuitivement improbable qu'un si petit nombre de

paramètres ou de facteurs puisse expliquer une dynamique aussi complexe

que celle de l'encours des dépôts à vue. Le premier cas

correspond à une approche typiquement macroéconomique et ignore

totalement les aspects microécono-miques, démographiques et

comportementaux sous-jacents dans la dynamique des dépôts.

19

Pour illustrer notre propos, on peut remarquer qu'il pose

implicitement une évolution identique pour toutes les banques quelle que

soit leur structure actuelle. Or il apparaît plausible de

considérer que les encours des comptes courants d'une banque en ligne,

fondée il y a dix ans, et d'une banque implantée historiquement

depuis des décennies, possédant une clientèle d'un

âge avancé, soient amenés à évoluer

différemment dans le futur. De même, les caractéristiques

démographiques du pays d'implantation de l'établissement, qui

apparaissent aussi comme des éléments déterminants, sont

totalement ignorés. Par exemple, une baisse importante de la

mortalité dans un pays donné suggère une croissance

notablement supérieure de l'encours des banques présentes dans ce

pays, au moins sur le moyen-long terme. Les mêmes remarques valent pour

le modèle de diffusion de type Black-Scholes, qui est certes

adapté pour des variations de cours de titre ou de taux, mais dont la

pertinence ici est plus que discutable. Nous critiquons donc ce choix,

probablement influencé par une certaine «culture» du pricing

et de la finance quantitative, consistant à adopter pour le processus de

l'encours des dépôts à vue une évolution similaire

à celui d'un taux de change ou du cours du pétrole. Les processus

sous-jacents sont en effet totalement différents! En outre, tout le

pouvoir explicatif de ce dernier modèle réside dans une unique

variable aléatoire, à savoir Lt lui-même. La

diffusion crée par ailleurs une évolution très erratique

et peut générer des trajectoires paraissant intuitivement

très invraisemblables5 (fortes variations locales,

décroissance vers 0 puis remontée importante. . .).

De notre point de vue, les approches présentées

fournissent ainsi intrinsèquement des modélisations du

comportement de l'encours très irréalistes. Les différents

exemples invoqués ci-dessus prouvent que celui-ci est intimement

lié à des données économiques (notamment

l'inflation) et démographiques ainsi qu'à la structure de la base

de clientèle actuelle ou au comportement des clients. Ce dernier varie

d'ailleurs selon toute vraisemblance avec leur âge et leurs

caractéristiques propres.

Nous proposons dès lors d'adopter une démarche

plus économétrique. Nous reprendrons dans un premier temps

l'approche macroéconomique suggérée dans les articles afin

de nous faire une première idée du «lien» entre

l'encours et certaines variables globales. Nous l'affinerons ensuite en

construisant un cadre théorique fondé sur la segmentation du

portefeuille de clientèle et intégrant des facteurs

démographiques et comportementaux.

4 L'approche macroéconomique

4.1 Principe et choix des variables explicatives

Nous allons chercher ici à régresser la masse

des encours Lt (ou une fonction de celle-ci) sur des variables

macroéconomiques pertinentes. Par exemple, il est

généralement admis que le niveau des taux courts influence

fortement Lt. L'idée derrière cette constatation

empirique est que, lors des périodes à fort taux

d'intérêt sur les marchés, les personnes investissent plus

de liquidités sur des produits rémunérés, tels que

le livret A.

Ainsi, nous avons vu par exemple que Jarrow et van Deventer

proposaient l'équation

ln(Lt) - ln(Lt_1)=a + br(t) + et + d(r(t) -

r(t - 1))

qui relie les accroissements de l'encours à celui des

taux courts. Ils y reconnaissent toutefois que la dynamique de la masse des

dépôts est pilotée par d'autres facteurs, d'où le

terme

5On peut se demander si

l'observation de la trajectoire historique de l'encours des CCP de La Banque

Postale permet de se prononcer sur la validité de l'hypothèse

d'évolution selon dLt = Lt(pdt + adWt) et

notamment de l'infirmer. Cela est l'objet d'une brève discussion

menée en annexe A

20

linéaire en t. Le temps est censé

être ici une approximation des autres variables macroéconomiques

non incluses dans le modèle.

En 2000, James M. O'Brien a, quant à lui,

proposé d'intégrer le revenu national dans les variables

explicatives en écrivant : ln(Lt) - ln(Lt_1) = a + b(r(t)

- i(t)) + cln(Y (t)) + f(t) avec E(f(t))=0 pour tout

t, où i(t) est le taux de rémunération

du dépôt et Y (t) le Produit Intérieur Brut

(PIB) à la date t. Notons au passage que

l'économiste reconnaît ici indirectement la complexité de

l'évolution des dépôts en rajoutant un terme correctif

d'erreur censé représenter un aléa non relié aux

variables macroéconomiques.

Dans le cadre de cette étude, nous avons retenu

plusieurs variables explicatives pour mener nos régressions

linéaires simples et multivariées :

- l'inflation hors tabac : elle représente

implicitement le coût de la vie et les variations de volume des

agrégats monétaires;

- le PIB : il capture la vitesse de croissance de

l'économie, que l'on peut légitimement corréler à

la richesse des ménages et donc au niveau de leurs dépôts

à vue;

- le niveau des taux courts (taux Pibor à 3 mois) : on

s'attend à ce qu'il soit corrélé négativement au

niveau des encours non rémunérés;

- le niveau des taux longs (taux des emprunts d'État

à 10 ans).

Notre plage de données s'étend de janvier 1994

à décembre 2010. Le pas de temps est mensuel, hormis pour

certaines variables (comme le PIB) pour lesquelles les données sont

trimestrielles. Le logiciel statistique utilisé est SAS.

4.2 Résultats

En ce qui concerne les régressions simples, les

variables macroéconomiques (PIB, inflation) se sont

avérées être de très bonnes variables explicatives

pour le niveau d'encours, avec des coefficients de détermination de

l'ordre de 95%. A contrario, la régression de l'encours global

sur le niveau des taux, que l'on prenne les taux courts ou les taux longs, n'a

donné que des résultats médiocres. Pour tenir compte de

décalages éventuels entre les mouvements des différentes

variables, nous avons donc tenté de régresser l'encours sur les

taux passés (en intégrant un retard variable) ainsi que sur leurs

variations dans le passé proche (comme le suggèrent Jarrow et van

Deventer). Aucune de ces tentatives n'a toutefois permis de déceler une

telle relation. Ainsi, de manière assez surprenante, les

régressions que nous avons menées sur l'évolution

historique de l'encours des comptes courants à La Banque Postale ne nous

ont pas permis de relever un lien avéré entre celui-ci (ou ses

variations) et les mouvements de taux sur les marchés. Pour tenter de

capter l'influence éventuelle des taux à un ordre plus

élevé, nous avons donc déflaté l'encours (ou nous

l'avons divisé par le PIB) puis nous avons tenté de mener une

régression de cette nouvelle variable (ou de son logarithme) sur le

niveau des taux. Toutefois, les résultats sont restés

décevants avec des coefficients de détermination très

faibles.

Par la suite, notre démarche a donc consisté

à chercher une représentation de type AR(1)6 sur

l'encours, puis sur l'encours déflaté, en tentant de

régresser leurs variations mensuelles soit sur le niveau des taux, soit

sur les variations de ces derniers sur les périodes

précédentes. Ces méthodes plus sophistiquées n'ont

malheureusement pas non plus permis de résultats probants. Les

procédures de désaisonnalisation des différentes

séries chronologiques n'ont en

6Pour AutoRegressive

d'ordre 1. Il s'agit de chercher une représentation de la variable

Lt - öLt-1, avec

öER, en fonction des autres séries

chronologiques. Nous avons essentiellement travaillé avec =1

21

rien changé la donne, dans la mesure où la

série historique de la masse des dépôts des CCP

présente une composante saisonnière quasi-inexistante.

Ainsi, le meilleur résultat obtenu, en tant que

compromis entre qualité explicative et parcimonie du nombre de variables

de régression, s'est finalement avéré être la

régression simple du niveau des encours sur celui de l'inflation,

correspondant à un excellent coefficient de détermination de

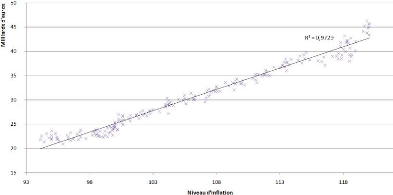

R2 = 0,973! Nous avons tracé ci-dessous la

courbe correspondante.

FIG. 4 - Régression du niveau de

l'encours sur l'inflation hors tabac

L'inflation est donc un très bon indicateur du niveau

moyen de l'encours dans la banque. Cela signifie implicitement que la richesse

réelle détenue par les ménages sur leur compte courant

(à vue) ne varie pas, ou très peu, au cours du temps. Dans la

mesure où les CCP ne sont pas des produits d'épargne, mais des

comptes servant aux retraits quotidiens pour les dépenses courantes

(dont le montant suit par définition exactement le niveau de

l'inflation), un tel résultat est relativement conforme à

l'intuition.

4.3 Un modèle pour l'inflation

La régression précédente nous incite

à intégrer l'inflation dans le modèle mathématique

de dynamique des encours que nous allons construire. Il nous faut donc adopter

un modèle pour cette grandeur économique. Nous allons commencer

par définir les notations et le vocabulaire que nous utiliserons dans

cette étude. Dorénavant, nous appellerons inflation

mensuelle, ou plus simplement inflation, sur la période

[t - 1, t] (où t N"

décompte le temps en mois) le taux itt d'augmentation des

prix sur cette période. Cette variable capture localement, à une

échelle mensuelle, la dynamique d'évolution des prix. Nous

définissons le niveau d'inflation par ilt = (1 +

lrt)llt_1 : il mesure la tendance au cours du temps de

l'évolution des prix. En particulier, le niveau d'inflation est

défini à multiplication par une constante près. Pour y

remédier, on peut donc fixer son niveau à une certaine date de

manière arbitraire (en général à 100). Il

s'identifie alors à ce qui est appelé Indice des Prix

à la Consommation (IPC). C'est sur cette dernière variable,

publiée par l'Institut National de la Statistique et des

Études Économiques (INSEE), que nous avons effectué

la dernière régression.

Nous adopterons pour l'inflation un modèle similaire

à celui proposé par Vasièek en 1977 pour la dynamique du

taux spot sans risque. Nous considérons ainsi que l'inflation men-

suelle 7rt suit sur un espace (S2, IF,

P) - où P désigne la probabilité historique - une

équation différentielle stochastique d'Ornstein-Uhlenbeck,

selon

d7rt = a(b - 7rt)dt

+ QdWt , t E R+

avec Wt un mouvement brownien standard unidimensionnel,

dont la filtration naturelle sera dorénavant notée Gt

=Q(Wt, 0<u<t).

Le modèle est spécifié par trois

paramètres : a, b et la volatilité a

ER*+. Il s'agit d'un modèle dit de

retour à la moyenne car le processus 7rt oscille autour de

b. Ainsi, a > 0 est un paramètre d'échelle

qui mesure la vitesse de rappel vers b du processus 7rt.

Cette équation différentielle stochastique se

résout explicitement par

t

7rt = 7r0e-at + b

(1 - e-at) + a

J

e-a(t-s)dWs (1)

0

On a même plus généralement pour

0<t1 <t2

t2

\ f

7rt2 =

7rt1e-a(t2-t1) + b

(1 - e-a(t2-t1)/ + a J

e--a(t2-s)dWs (2)

t1

Par le théorème d'isométrie des

intégrales stochastiques, l'intégrale de Wiener du membre de

2

droite dans (1) est une variable gaussienne centrée de

variance Q2 Ret,

e-2a(t-s)ds = 2a (1

- e-2at)

Par conséquent

2 1 7rt N

(7r0e-at + b (1 - e-at)

2a (1 - e-2at))

|

En particulier, EP(7rt) =

7r0e-at + b (1 -

e-at) et VP(7rt) =

|

0.2 2a

|

(1 - e-2at), qui convergent

|

22

0.2

respectivement lorsque t ? +oo vers b et

7.

2a

Par ailleurs, l'indépendance des accroissements du

brownien, combinée à l'expression (2),

permet d'affirmer que la loi conditionnelle de 7rt

sachant 7rt-1 est la gaussienne

2

N (7rt-1e-a + b

(1 - e-a) , 2a (1 -

e-2a)/11

Cette remarque est de première importance pour la

simulation informatique de l'inflation. En effet, même si sa dynamique

est décrite ici de manière continue, nous la considèrerons

uniquement à des instants discrets (t=0, 1,

2, ...). Ainsi, partant de 7r0, il suffira de

générer des lois normales successives, dont les paramètres

dépendent du niveau précédent de l'inflation, pour obtenir

de proche en proche une trajectoire de cette dernière.

À titre illustratif, nous avons simulé puis

tracé ci-après deux trajectoires pour un quadruplet de

paramètres identiques (a, b, a, 7r0) = (0.2,

0.002, 0.0002, 0.002) sur un

horizon h = 180 mois, correspondant à 15 ans. Sachant que

l'objectif annoncé de la Banque Centrale Européenne est

une inflation annuelle à 2%, le choix des paramètres s'est

effectué a priori en cherchant à revenir en moyenne vers

une valeur d'inflation mensuelle équivalente. Nous avons fait figurer

entre parenthèses sur l'axe des ordonnées, à

côté de ch9ue niveau 7r d'inflation mensuelle, le taux

d'inflation annuel équivalent, défini par (1 +

7r)1 - 1. Il s'agit du taux d'inflation annuel

réalisé si 7rt =7r tout au long de

l'année.

7On peut en fait montrer que dans ces conditions, le

processus 1rt converge en loi quand t ? +oo vers un

processus stationnaire de loi normale N ~

b, a2

2a

23

Il convient de remarquer que des trajectoires avec des

périodes déflationnistes, bien que n'arrivant que très

rarement, sont également permises par ce modèle (pour la simple

raison que P(rt<0) > 0 pour tout t).

Ce modèle sur l'inflation sera utilisé pour

simuler des trajectoires d'évolution de l'encours. Nous reviendrons plus

en détail sur ce point dans la section dédiée.

5 L'approche probabiliste interne

Cette section vise à conduire une analyse plus

détaillée de l'évolution des encours afin d'affiner la

prévision. La vision que nous adoptons ici n'est donc plus globale, mais

revêt au contraire un caractère

«microéconomique».

5.1 La segmentation clientèle

La clientèle de la banque présente une forte

hétérogénéité selon plusieurs

critères. Elle peut donc être stratifiée, afin de

définir différentes catégories homogènes auxquelles

correspondent des encours partiels. Les critères de classification

envisageables sont par exemple le niveau de revenu, la surface

financière (c'est-à-dire le niveau de patrimoine placé

dans la banque), le nombre de produits contractés, la catégorie

socio-professionnelle ou encore l'ancienneté dans

l'établissement. Ces strates peuvent ensuite être croisées

avec les âges pour obtenir des cellules de clientèle.

L'intérêt attendu de cette segmentation de la base de clients est

d'améliorer notre capacité prédictive des encours en

tenant compte des comportements propres à chaque cellule ainsi

définie. À titre d'exemple, le pouvoir d'achat du client est un

indicateur de la stabilité de son encours personnel. En effet, les

personnes à haut revenu présentent des mouvements sur leurs

comptes plus importants et plus imprévisibles et sont plus susceptibles

de quitter l'établissement que les clients ayant un revenu modeste, car

ils cherchent plus à optimiser leurs placements : ils sont plus

«volatiles» et leur probabilité de sortie est plus

élevée. De même, la probabilité annuelle de

clotûre d'un compte est beaucoup plus faible dans la première

année qu'au bout de cinq ans d'ancienneté. Enfin, les personnes

âgées ont également un comportement plus stable et donc

plus prédictible que les jeunes, ce qui a son importance compte tenu du

fait qu'ils détiennent en général des encours plus

élevés.

5.2 Modélisation de la dynamique des encours

5.2.1 Notations

Le portefeuille de clientèle de l'établissement

bancaire est ventilé par strates et par âges. Les strates, en

nombre s, seront désignées par l'indice

iEE={1, 2, ..., s}. Typiquement, nous aurons 3 <

s < 8. Les âges seront, quant à eux, indicés

par j E E = {á, ..., w} où á et

w désignent les âges limites retenus. Ainsi, á

est l'âge minimum légal pour obtenir un compte tandis que

w correspond à l'âge maximum pour un client de la banque,

dont la probabilité de sortie dans l'année est égale

à 1. Cette segmentation correspond donc à |E| |E| cellules de

clientèle, chacune d'entre elles étant indicée par un

couple (i, j) E ExE. Le temps est indicé par tEN,

l'instant 0 correspondant à aujourd'hui. Le pas de temps peut être

mensuel, trimestriel ou annuel. Dans le cadre de cette étude, nous le

décompterons mensuellement. Comme dans l'approche macroéconomique

précédente, l'encours total des dépôts à vue

à la date t de la banque est noté 0t. L'encours

des clients appartenant à la strate i et l'encours des clients

d'âge j à cette même date sont notés

respectivement 0(i,:),t et 0(:

j) t. Enfin, l'encours détenu par les clients de la

strate i et d'âge j, correspondant à la cellule

de clientèle (i, j), est spécifié de

manière analogue par la variable 0(i,j),t.

En particulier, pour toute date tEN,

|

0t =

|

Xs i=1

|

0(i,:),t =

|

Xù j=á

|

0(:,j),t

|

|

Comme par ailleurs V iEE,

0(i,:),t =

|

Xù j=á

|

0(i,j),t, on obtient à

chaque date tEN

|

|

0t =

|

Xs i=1

|

Xù j=á

|

0(i,j),t

|

comme ventilation de l'encours global des comptes courants en

ses composantes par cellule de clientèle.

Le nombre de clients détenteurs de ces

dépôts à vue à une date t, noté

vt, est de manière analogue ventilé par strate, par

âge et par cellule, avec les notations respectives

v(i,:),t, í(:,j),t

et v(i,j),t. On a donc pour tout

tEN,

|

Vt =

|

Xs i=1

|

v(i,:),t =

|

Xù j=á

|

v(:,j),t et V iEE,

í(i,:),t =

|

Xù j=á

|

v(i,j),t

|

24

|

soit

|

Vt =

|

Xs i=1

|

Xù j=á

|

v(i,j),t

|

Les encours client moyens au niveau de la banque, de la strate

i, de l'âge j et de la cellule (i, j) sont

respectivements notés 0t,

0(i,:),t, 0(:,j),t

et 0(i,j) t. Ils sont définis par la

somme d'argent moyenne détenue par chaque client à

l'échelle considérée, soit

|

0t

0t =

vt

|

, 0(i,:),t =

|

0(i,:),t

í(i,:),t

|

, 0(:,j),t=

|

0(:,j),t

í(:,j),t

|

et 0(i,j),t =

|

0(i,j),t

v(i,j),t

|

Afin d'obtenir des écritures plus condensées,

nous introduisons des grandeurs vectorielles correspondant à ces

différentes variables.

Pour tout tEN, nous définissons

|

vt =

|

?

? ? ?

|

v1,t v2,t

. . .

vs,t

|

?

? ?E N|Ó||Î| avec vi,t

= ?

|

í(i,á),t

í(i,á+1),t

.

. .

í(i,ù),t

|

I

|

E N|Î|, iEE

|

De même, nous posons

|

0t =

|

?

? ? ?

|

01,t 02,t . . .

0s,t

|

?

? ?E R|Ó||Î| avec 0i,t

= ?

|

0(i,á),t

0(i,á+1),t

. . .

0(i,ù),t

|

?

? ? ?

|

E R|Î|, i E E

|

On remarque alors que l'encours partiel de la strate i

et que l'encours global de la banque à la date t

s'expriment respectivement par

|

0(i,:),t =

(vi,t|0i,t) et At

=

|

Xs i=1

|

0(i,:),t =

(vt|0t)

|

25

où (.|.) désigne le produit

scalaire euclidien usuel.

Nous nous intéressons notamment à la

structure par terme des différents encours, c'est-à-dire

à leur évolution en fonction de l'horizon h de

prévision. Il nous faut donc typiquement prévoir les lois de

probabilités des variables aléatoires

Di,t+h et

Ot+h, pour hE{1, 2, ...,10}.

La segmentation opérée, en plus d'affiner la prévision,

permettra d'estimer la «valeur» des différentes strates du

point de vue de la banque de détail.

5.2.2 Dynamique des clients au sein de la banque

Les clients de la banque, à un instant t, sont

mobiles. Ainsi, un client particulier peut, au pas de temps suivant, avoir

intégré une nouvelle strate ou même avoir quitté la

banque (par décision volontaire ou par décès). Partant

d'une répartition initiale v0, on suppose que

chacun des í0 = IIv0II1

clients évolue selon un processus identique, mais

indépendamment de tous les autres. Décrivons ce

processus.

Un client appartenant à la cellule (i, j)

à la date t (c'est-à-dire appartenant à la strate

i et d'âge j) se retrouvera en t + 1 dans

l'une des s strates de la banque, avec un âge qui aura

évidemment augmenté mécaniquement de un, ou aura

quitté l'établissement. Il sera donc intégré dans

l'une des cellules (l, j + 1), l EE ou ne sera plus

client.

Plus précisément, on note

ë(i,j)

k le taux de transition d'un client appartenant

à la cellule (i, j) vers la cellule (k, j + 1), k

E E et o(i,j) son taux de sortie

à toute date. Cela signifie qu'un client dans la

cellule (i, j), à une date quelconque, a une probabilité

ë(i,j)

k d'être dans

la cellule (k, j + 1) et une probabilité

o(i,j) d'avoir quitté

l'établissement à la date suivante. On a donc

l'identité

|

Xs k=1

|

ë(i,j) k +

o(i,j) = 1 pour tout (i, j) E E x Î

|

Il pourrait être envisagé d'introduire des

probabilités de transition évoluant au cours du temps. Toutefois,

nous avons considéré que cela n'introduisait qu'un

intérêt limité rapporté à la forte

complexité supplémentaire que cela aurait induit. En outre, il

apparaît plausible que de telles probabilités de transition

restent très stables, indépendantes de la démographie

26

future du pays par exemple.

La dynamique des clients au sein de l'établissement est

résumée dans le schéma suivant :

Par ailleurs, pour prendre en compte l'arrivée de

nouveaux clients dans la banque étudiée, nous introduisons des

processus d'entrée é(i,j),t,

((i, j), t)EE x x N*. La

variable aléatoire é(i,j),t à

valeurs dans N représente le nombre de nouveaux clients arrivés

dans la banque entre les instants t - 1 et t et

ayant plus précisément incorporé la cellule

clientèle (i, j). Afin de garder une modélisation

suffisamment riche pouvant intégrer des effets démographiques,

nous n'imposons pas l'homogénéité dans le temps des

processus d'arrivée. Ainsi, nous serons amenés à

étudier des cas dans lesquels é(i,j),t

et é(i,j),t/

ont des lois potentiellement différentes pour t =6

t'. On supposera en revanche, et à l'instar de ceux

de transition, que les processus d'arrivée sont indépendants les

uns des autres. Nous pouvons donc écrire

V(((i,j),t), (i',j'),t'))

E (E x x N*)2 ,