CHAPITRE 2

REPRESENTATION DES SIGNAUX NON-STATIONNAIRES

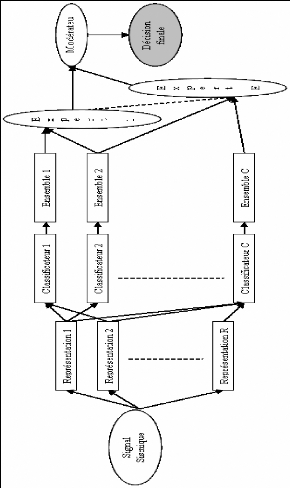

Le choix de la représentation est un paramètre

crucial qu'il faut savoir le choisir de manière adéquate pour

augmenter les performances de tout système de discrimination des signaux

non stationnaires. Ce choix consiste à définir un espace de

représentation discriminant permettant d'extraire l'information

significative portée par le signal, donc qui mette en avant les

différences entre les classes et gomme les ressemblances.

Pour les signaux non stationnaires, devant la

complexité et la variété des situations rencontrées

et compte tenu qu'il n'existe pas de solution universelle valable pour tous

signaux, il s'avère nécessaire de faire une étude

spécifique pour chaque cas afin de sélectionner les

représentations les plus appropriées. Dans ce sens, Marr [211]

note que «Chaque représentation particulière fournit

explicitement certaines informations au dépend d'autres mises en

arrière et qui peuvent être difficiles à retrouver. Ce

point est important car la manière dont l'information est

représentée peut fortement modifier la facilité avec

laquelle on en percevrait les différents

éléments».

Le but de ce chapitre est, d'une part, de mettre en

évidence les différents outils de représentation des

signaux non stationnaires et, d'autre part, de concevoir une nouvelle ondelette

plus adéquate aux signaux sismiques. Nous commençons par les

représentations temporelle et fréquentielle pour lesquelles nous

illustrons le fait qu'en présence de la non stationnarité, ces

deux représentations à une dimension ne sont plus

adaptées. Nous proposons alors d'utiliser des représentations

conjointes en temps et en fréquence (ou échelle). La

démonstration de nouvelles versions du principe d'Heisenberg-Gabor, pour

le spectrogramme, la représentation de Wigner-Ville et la

transformée en ondelette continue font aussi l'objet de ce chapitre.

2.1 Représentations temporelle et fréquentielle

2.1.1 Représentation temporelle

La représentation temporelle (ou spatiale dans certains

cas) constitue la forme la plus simple et naturelle pour représenter les

signaux dérivant d'un phénomène donné. Elle ne

nécessite aucun outil mathématique pour la générer

et son observation révèle plusieurs informations temporelles ou

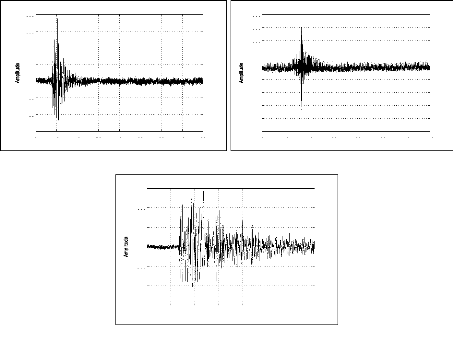

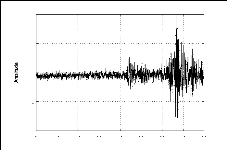

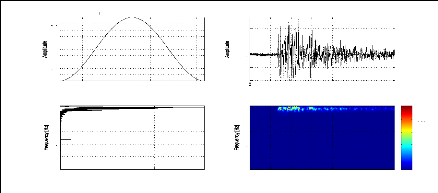

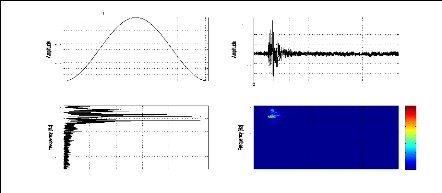

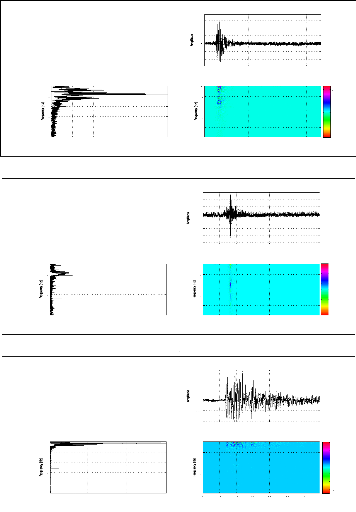

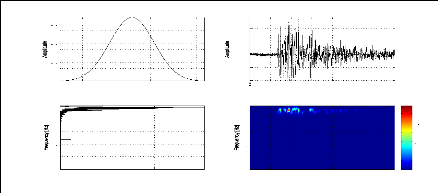

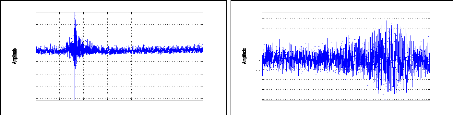

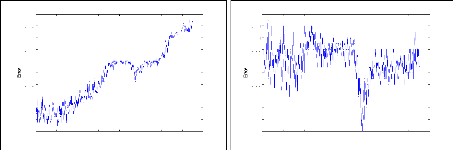

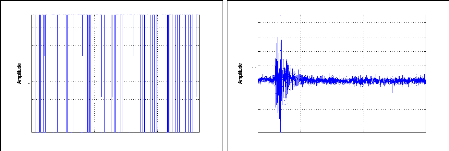

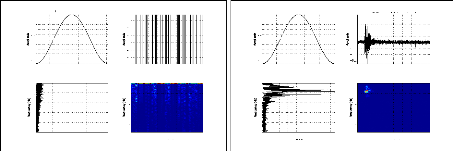

atemporelles. Par exemple, pour le cas des signaux sismiques où la

figure (2.1) donne des signaux relatifs à une explosion chimique, un

séisme local et un séisme lointain; la représentation

temporelle pourrait nous indiquer la durée de l'événement

sismique, le temps d'arrivée des phases, la magnitude, etc. Cependant,

ces paramètres ne sont pas toujours facile à avoir, et donc

généralement inadaptés pour la discrimination de ces

signaux. En effet, pour le cas d'un signal sismique à faible ratio

signal/bruit ou tronqué, il est très difficile d'avoir tous ces

paramètres même par un expert du domaine. La figure (2.2) permet

d'expliciter ce problème pour deux signaux sismiques relatifs au

même événement et enregistrés par les stations MIF

et TGT.

Remarque:

Malgré les problèmes posés par les bruits de

fond pour l'analyse des signaux sismiques, ils sont très utiles dans

d'autres domaines tels que le génie civil [95].

2.1.2 Représentation fréquentielle

Une alternative à la représentation temporelle du

signal consiste à représenter son contenu fréquentiel.

Celui-ci est obtenu en calculant sa transformée de Fourier (FT:

Fourier Transform) définie, pour un signal x(t)

d'énergie finie (c'est à dire appartenant

àl'ensemble des fonctions de carré sommable

L2), par:

FTx : L2(R) ? L2(R)

x(t) ? FTx(í) = R8 -8x(t)e-i2ðítdt

(2.1)

ou x(t) ? FTx(ù) = R8 -8x(t)e-iùtdt

17

(a)

(b)

Es0429-JBB -2005-05-06 02:47:39

2000

1500

1000

500

0

-500

-1000

-1500

-2000

Time [sec]

-2500

0 20 40 60 80 100 120 140

(c)

Es0319-CZDV-2005-09-16 00:50:27

1500

1000

500

0

-500

-1000

Time [sec]

-1500

0 20 40 60 80 100 120 140

Es0001-TIS -2003-01-22 13:11:23

800

600

400

200

0

-200

-400

Time [sec]

-600

0 10 20 30 40 50 60 70 80

Figure 2.1: Représentation temporelle d'une explosion

chimique (a), d'un séisme local (b) et d'un séisme lointain

(c)

-1000

0 10 20 30 40 50 60 70 80

-500

1500

1000

500

0

Es0103-TGT -2003-01-23 12:32:42

Time [sec]

-100

-150

-200

-250

0 10 20 30 40 50 60 70 80

200

-50

150

100

50

0

Es0103-MIF -2003-01-23 12:32:42

Time [sec]

(a) (b)

qui pourra s'écrire, en notant respectivement

|FTx(u)| et ?(u) le module et la phase de FTx, sous la

forme:

FTx(u) = |FTx(u)|ei?(í)

(2.2)

Cette transformée étant inversible:

Z 8

x(t) = IFTFTx(u) =F

Tx(u)ei2ðítdu (2.3)

-8

La FT mesure donc un indice de similarité entre le

signal et une collection d'ondes (exponentielles complexes) de longueur

infinie, où FT x(u) représente la contribution de

l'onde de fréquence u au signal x(t). La FT est en faite une

transformée en ondes du signal, dans laquelle toute information

temporelle disparaît.

Dans l'étude des signaux, FT x(u), qui est

appelé représentation fréquentielle, fournit une

représentation plus simple à interpréter par rapport

à la représentation temporelle. Dans le cadre de la propagation

des ondes sismiques, on peut considérer le milieu de propagation comme

étant une fonction de transfert entre la source et les

sismomètres qui agit séparément sur chaque

fréquence. La vitesse et l'atténuation du signal sismique

dépendent de la fréquence considérée. Une

modélisation en fréquence de la dispersion d'onde est donc

possible.

Le signal sous sa forme fréquentielle FT

x(u) est le plus souvent étudié par l'analyse de la

courbe |FTx(u)| définissant l'amplitude du signal à

chaque fréquence. Cette description est riche mais elle ne suffit pas

à caractériser complètement le signal. En effet, il est

possible d'avoir des signaux dont les représentations temporelles sont

différentes mais ayant le même contenu fréquentiel comme le

montre l'exemple ci-dessous.

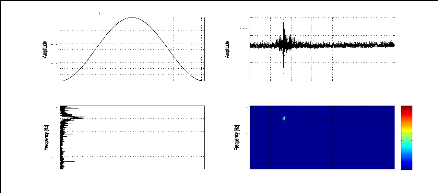

Exemple 2.1: La FT de deux signaux différents en temps

ayant le même con-

tenu fréquentiel.

19

Nous considérons les deux signaux S1 et S2 définis

par:

S1 = sin(2ð.25.t) + sin(2ð.50.t), t ? [0, T]

|

S2=

|

|

sin(2ð.25.t), t ? [0, T1]

sin(2ð.50.t), t ?]T1,T]

|

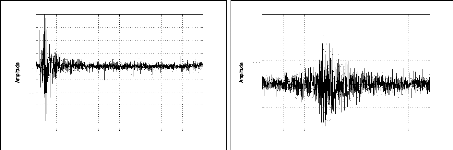

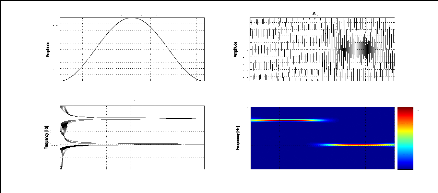

Bien que leurs représentations temporelles sont

différentes (figure (2.3)), les contenus fréquentiels des signaux

S1 et S2 représentés sur la figure (2.4) sont les mêmes.

(a) (b)

-0.2

-0.4

-0.6

-0.8

0.8

0.6

0.4

0.2

-1

0

1

0 005 01 015 02 025

Time[sec]

Signal S2

-0.5

-1.5

0.5

1.5

-1

-2

2

0

1

0 005 01 015 02 025

Time[sec]

Signal S1

Figure 2.3: Représentation temporelle des signaux S1 (a)

et S2 (b)

(a) (b)

40

60

50

30

20

10

0

0 100 200 300 400 500

Modulus of Fourier transform: S2

Frequency [Hz]

120

100

60

40

20

80

0

0 100 200 300 400 500

Modulus of Fourier transform: S1

Frequency [Hz]

Figure 2.4: Représentation fréquentielle des

signaux S1 (a) et S2 (b)

x 10 4 Es0259-CZDN-2003-03-24 14:49:20

-2.85

-2.95

-3.05

0 10 20 30 40 50 60 70 80

-2.9

-3

(a)

Time [sec]

(b)

4

7

6

5

3

2

0

0 5 10 15 20 25

1

x 10 4 Es0259-CZDN-2003-03-24 14:49:20

Frequency [Hz]

20

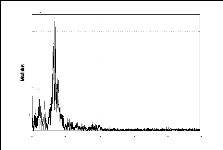

on peut caractériser un signal par son contenu

fréquentiel (figure (2.5)), dans d'autres cas, la perte de la

localisation temporelle dans la FT peut s'avérer handicapante pour

l'analyse de ces signaux. En effet, pour le cas des événements

à faibles amplitudes (ratio signal/bruit faible), la classification

basée sur la FT pourra donner de mauvais résultats à cause

du bruit. La figure (2.6) montre la différence entre la

transformée de Fourier

des signaux représentés dans les figures (2.1.

(a-b-c)) qui correspondent respectivement àune explosion

chimique, un séisme local et un séisme lointain. De plus, la

représentation

fréquentielle limite la généralisation du

système de classification automatique au niveau des classes. Par

exemple, si on veut discriminer des sous-classes du même type, il se peut

qu'elles ont le même contenu fréquentiel mais des

représentations temporelles différentes. Ceci est dû au

fait que l'information temporelle x(t) n'est pas portée par son module

en fréquence |FTx(í)| mais par sa phase en

fréquence ?(í).

(a)

(b)

21

(c)

3

2.5

2

1.5

1

0.5

Frequency [Hz]

x 10 5 Es0429-JBB -2005-05-06 02:47:39

3.5

0

0 5 10 15 20 25

3

2.5

2

1.5

1

0.5

Frequency [Hz]

0

0 5 10 15 20 25

x 10 4 Es0001-TIS -2003-01-22 13:11:23

3

2.5

2

1.5

1

0.5

Frequency [Hz]

x 10 5 Es0319-CZDV-2005-09-16 00:50:27

3.5

0

0 5 10 15 20 25

|

FTxa(u) =

|

? ????

????

|

2FTx(u) si u > 0,

FTx(u) si u = 0,

0 sinon.

|

Figure 2.6: Représentation fréquentielle d'une

explosion chimique (a), d'un séisme local (b) et d'un séisme

lointain (c)

2.2 Signal analytique

Les problèmes posés par la perte de la

localisation temporelle dans la représentation fréquentielle

peuvent être résolus par l'utilisation de grandeurs combinant des

informations de nature temporelle et fréquentielle, à savoir la

fréquence instantanée et le retard de groupe. Avant de

présenter ces deux concepts, il convient de définir au

préalable la notion du signal analytique xa (t).

Le signal analytique xa (t) est défini

simplement en fréquence par [68]:

Ce signal contient la même information que x (t) : la

partie des fréquences négatives (redondante de la partie positive

du fait de la symétrie hermitienne du spectre d'un signal réel,

ce qui n'altère en rien le contenu informationnel) est remplacée

par 0 et le module des fréquences positives est doublé. La

relation qui lie x(t) et xa(t) en temps est:

xa(t) = x(t) + iH[x(t)] (2.4)

où H est la transformée de Hilbert :

[Z +8 ]

1 x(t - r)

H[x(t)] = v.p. r dr (2.5)

ð -8

avec v.p signifiant la valeur principale de Cauchy

donnée par la limite, si elle existe (àcause de la

singularité en r = 0),

[Z ] [Z -å Z +8 ]

x(t - r) x(t - r) x(t - r)

v.p. r dr = lim r dr + r dr (2.6)

å?0

R -8 å

Le signal analytique xa(t) peut se mettre sous la

forme polaire:

xa(t) = |xa(t)|ei÷(t)

(2.7)

où|xa (t)|, et ÷(t) représentent

respectivement l'amplitude (aussi appelée enveloppe) et la phase

instantanée de xa (t). Une telle représentation permet

la séparation de l'information temporelle contenue dans

|xa(t) | et l'information de phase contenue dans ÷(t). De plus,

à partir cette forme polaire, on définit la fréquence

instantanée:

1 d÷(t)

íi(t) = (2.8)

2ð dt

décrivant le contenu spectral instantané du

signal. D'une façon duale, on peut souhaiter décrire le

comportement temporel local d'un signal en fonction de la fréquence.

Ainsi, en considérant la FT du signal analytique sous sa forme

polaire:

23

On peut obtenir une information sur l'instant d'arrivée

d'une fréquence grâce au retard du groupe:

1 dø(í)

ôg(í) = - (2.10)

2ð dí

Le signal analytique permet alors de définir deux

grandeurs conjointes en temps et en fréquence: la fréquence

instantanée et le retard de groupe. Cependant, ces grandeurs ne

conduisent à des représentations aisément

interprétables que dans le cas des signaux mono- composantes [66] pour

lesquels, à un instant donné (respectivement fréquence

donnée), le signal n'existe qu'au voisinage d'une fréquence

donnée (respectivement instant donné). Dans le cas des signaux

sismiques, (multicomposantes, non stationnaires), ces fonctions

unidimensionnelles locales s'avèrent inadéquates, comme le montre

la figure (2.7). Il peut alors être intéressant de

représenter les signaux sismiques conjointement dans les domaines

temporel et fréquentiel afin de caractériser leur

évolution spectrale au cours du temps.

(a) (b)

45

40

35

30

25

20

15

10

5

0

0 5 10 15 20 25

Es0001-TIS -2003-01-22 13:11:23

Frequency[Hz]

25

20

15

10

5

0

0 5 10 15 20 25 30 35 40 45

Es0001-TIS -2003-01-22 13:11:23

Time[sec]

Figure 2.7: Fréquence instantanée (a) et Retard du

groupe (b) du signal sismique représenté par la figure (2.1.a)

2.3 Représentations temps-fréquence

Les limites posées par les représentations

temporelle et fréquentielle ont fait orienter les travaux de recherche

vers l'utilisation des représentations temps-fréquence (TFRs:

Time-Frequency Representations) procurant une information localisée

simultanément dans les domaines du temps et des fréquences. Ce

type de représentations donne une description

naturelle des signaux non stationnaires dont les signaux

sismiques font partie et permet en outre de définir un espace de

représentation discriminant.

Plusieurs formulations de telles représentations ont

été proposées et selon la manière avec laquelle le

signal dépend de sa TFR, on peut répartir les TFRs en trois types

[145]: linéaires, quadratiques et non linéaires non quadratiques.

Pour les représentations quadratiques, une classification basée

sur la propriété de la covariance [148] est très

utilisée et permettant ainsi la définition de quatre classes

très connues [239], à savoir: la classe de Cohen [68], la classe

affine [258], la classe hyperbolique [237, 147] et la classe de puissance [146,

238].

Le problème reste, compte tenu qu'il n'existe pas de

solution universelle valable pour tous signaux, de savoir comment faire le bon

choix de la TFR la plus appropriée pour une application donnée

parmi une infinité de TFRs. Le choix est en fait beaucoup plus vaste,

Meyer [218] note à ce sujet «En exagérant à peine,

nous introduisons presqu'autant d'algorithmes d'analyses qu'il y a de

signaux». Donc, il s'avère nécessaire de faire le choix

selon des critères définis au préalable en

dépendance avec l'application et le signal étudié. Dans ce

sens, des TFRs dépendantes du signal ont été

conçues [22, 141, 80, 124]. Mais la mise en oeuvre de ces

représentations n'est pas possible dans le cas des systèmes de

classifications modulaires. En effet, le noyau d'une représentation

dépendante est toujours liés à un problème

d'optimisation où la connaissance de plusieurs paramètres de

classification au préalable est nécessaire. Par

conséquent, il est justifiable d'utiliser des TFRs indépendamment

du signal étudié. Le compromis consiste à choisir entre

une bonne concentration des motifs et une suppression des termes croisés

d'interférences tout en tenant compte d'autres propriétés

mathématiques telles que la régularité, la

positivité, la marginalité, l'inversibilité, etc.

2.3.1 Transformée de Fourier à court terme

de Fourier à court terme (STFT: Short-Time Fourier

Transform), est définie ainsi:

STFTx : L2(R) ? L2(R)

f 8 (2.11)

x(t) ? ST F Tx(t, í) = x(u)h*(u -

t)e-i2ð"udu

De nombreux choix de h sont possibles. En général,

cette fonction est choisie àsupport compact, suffisamment

régulière et bien localisée en temps et en

fréquence.

Le Signal x(t) peut être reconstruit à l'aide d'une

fenêtre de synthèse g différente de la fenêtre

d'analyse h grâce à la relation:

x(t) = Z8 Z8 STFTx(u,

í)g(t - u)ei2ð"tdudí (2.12)

-8 -8

à condition que g et h vérifient: f8

g(t)h*(t)dt = 1.

La STFT est donc une représentation linéaire

à deux dimensions dépendant du temps et de la fréquence et

permettant la mesure de la contribution de la fréquence í au

signal x à l'instant t. Cependant, cette description n'est pas stricte,

dans la mesure où pour évaluer le contenu spectral pour un

instant choisi, il faut nécessairement observer le signal sur un horizon

non nul autour de cet instant [229]. La fenêtre d'analyse h, dont

plusieurs cas ont été étudiés dans [135, 232], est

ainsi caractérisée par ses extensions temporelles Lt et

fréquentielle Lí. Elle mélange donc l'information contenu

dans le signal entre les instants t #177; Ät

2 dans la bande de fréquence í #177;

Ä" 2 . Ainsi, une localisation arbitrairement précise d'un

événement dans les domaines temporel et fréquentiel n'est

pas possible. En effet, l'augmentation de la résolution temporelle

(respectivement fréquentielle) de cette représentation

nécessite une fenêtre d'analyse plus localisée en temps

(respectivement en fréquence), ce qui a pour effet de dégrader sa

résolution fréquentielle (respectivement temporelle). Par

conséquent, le choix de cette fenêtre repose sur la recherche d'un

compromis entre l'hypothèse de la quasi-stationnarité du signal

sur l'intervalle d'analyse et les résolutions temporelle et

fréquentielle de la représentation. Ceci est dû, au

principe d'incertitude d'Heisenberg-Gabor exprimant le fait qu'un signal ne

puisse être parfaitement localisé à

1/2 ? 1/2

R8 |x(t)|2dt

4ð (2.13)

la fois en temps et en fréquence [273, 252]:

? ? ?

Z8 Z8

-8 -8

?t2|x(t)|2dt ? ? í2|F

Tx(í)|2dí ? =

|

S2=

|

? ?

?

|

sin(2ð.100.t), t ? [0, T1]

sin(2ð.300.t), t

?]T1,T]

|

Cet inégalité a été l'objet de

plusieurs travaux. Ainsi, Rassias [252, 251] a pu la démontrer pour des

ordres supérieurs, Loughlin et Cohen [205] ont abouti à formuler

une version locale, Shinde et Gadre [276] ont pu la reformuler pour le cas de

la transformée de Fourier fractionnaire. Cependant, plusieurs critiques

ont été évoqués tant sur la manière avec

laquelle cet inégalité est interprétée [322, 235]

que sur la limite minimale du terme droite [67]. L'inégalité

(2.13) est un principe général qui tient compte seulement du

signal et de sa FT. Donc, elle ne nous permet pas d'avoir aucune mesure sur

l'influence de la STFT et de la fenêtre d'analyse. Afin d'atteindre cet

objectif, on démontre, dans le paragraphe concernant le spectrogramme,

une nouvelle inégalité en se basant sur le principe

général d' Heisenberg-Gabor.

La visualisation de l'image du module de STFT permet une

interprétation sur le nombre de composantes et sur le contenu

temps-fréquence à la limitation de la résolution

près. Ce qui est explicité par l'exemple ci-dessous.

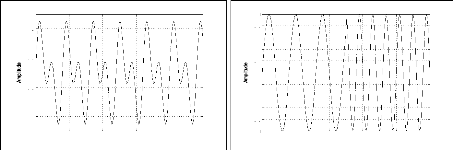

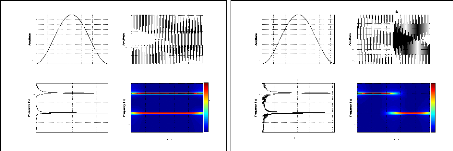

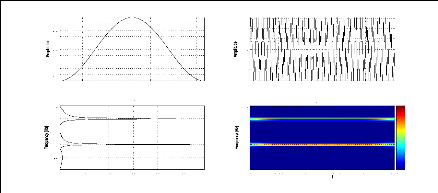

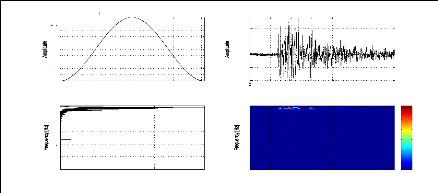

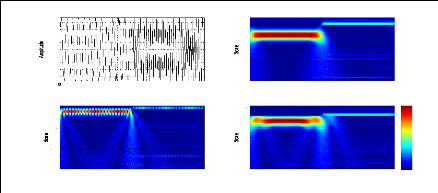

Exemple 2.2: Le module de la STFT de deux signaux

différents en temps

ayant le même contenu fréquentiel.

Nous considérons les deux signaux S1 et S2 suivants:

S1 = sin(2ð.100.t) + sin(2ð.300.t), t ? [0, T]

27

représentation bidimensionnelle de ces deux signaux via

le module de la STFT permet de montrer leurs contenus fréquentiels

à tout instant contrairement au module de la FT qui nous donne juste le

contenu fréquentiel sans aucune information temporelle. Ainsi, pour le

signal S1 le module de la STFT nous montre que les deux fréquences 100Hz

et 300 Hz existent sur tout l'intervalle [0, T] alors que pour le signal S2 les

deux fréquences existent mais sur deux intervalles indépendants

[0, T1] et ]T1, T].

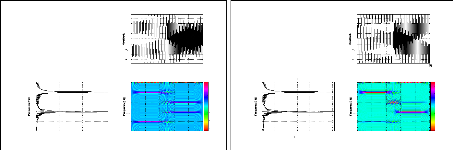

(a) (b)

200

400

100

300

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

0 20 40 60 80 100 120

20 40 60 80 100

Hanning window (128 pts)

Modulus

FT

-1.5

200

300

400

100

1.5

0.5

0.5

-1

0

0

1

0 0.05 0.1 0.15 0.2 0.25

0 0.05 0.1 0.15 0.2 0.25

Modulus of STFT

Time [sec]

Signal S1

4.5

4

3.5

3

2.5

2

1

0.5

1.5

200

300

400

100

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

0 20 40 60 80 100 120

10 20 30 40 50 60

Hanning window (128 pts)

Modulus

FT

-0.2

-0.6

200

300

400

100

0.8 0.6 0.4 0.2

0.4

0.8

0

0

0 0.05 0.1 0.15 0.2 0.25

0 0.05 0.1 0.15 0.2 0.25

Modulus of STFT

Time [sec]

Signal

4.5

4

3.5

3

2.5

2

1

0.5

1.5

Figure 2.8: Le module de la STFT pour deux signaux

différents S1 (a) et S2 (b) mais ayant le même contenu

fréquentiel

En comparison avec le module du spectre, l'information du

module des coefficients de la STFT est plus complète. En fait, cette

image d'amplitude suffit à caractériser le signal à un

déphasage près [68]. Cependant, les coefficients de la STFT,

malgré leur

nécessité pour la synthèse du signal, sont

peu utilisés directement à cause de la difficultéde les

interpréter [303]. Quant à l'information de la phase de la STFT,

elle peut être

utilisée pour définir la fréquence

instantanée locale et le retard du groupe local dans le plan

temps-fréquence [131].

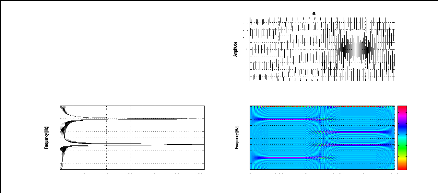

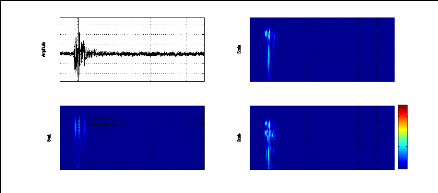

Pour le cas de signaux sismiques, la visualisation du module

de la STFT nous permet de différencier entre les différents types

de signaux. Il est clair sur la figure (2.10) que le contenu

temps-fréquence d'une explosion chimique (a), d'un séisme local

(b) et d'un séisme lointain (c) sont différents. En effet, les

fréquences où il y a une grande concentration de l'énergie

sismique (dômes énergétiques en rouge) et même

l'ordre de

28

Hanning window (128 pts)

Es0103-TGT -2003-01-23 12:32:42

1000

0.9

0.8

500

0.7

0.6

0.5

0

0.4

0.3

-500

0.2

0.1

0 20 40 60 80 100 120

10 20 30 40 50 60 70

Modulus of STFT

FT

0

0

1600

1400

5

5

1200

10

1000

10

800

15

15

600

400

20

20

200

0 10 20 30 40 50 60 70

Time [sec]

1 2 3 4 5

Modulus x 104

(a)

(c)

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

20

10

15

0

5

0 20 40 60 80 100 120

1000 2000 3000 4000 5000

Hanning window (128 pts)

Modulus

FT

-100

-150

-200

-50

150

100

50

20

10

15

0

0

5

0 10 20 30 40 50 60 70

0 10 20 30 40 50 60 70

Es01 03-MIF -2003-01-23 12:32:42

Modulus of STFT

Time [sec]

250

200

350

300

50

150

100

grandeur de cette dernière (voir l'échelle

énergétique) sont différents entre les trois types

représentés. Et même dans le cas d'un signal trop

bruité ou tronqué, les composantes fréquentielles

principales sont faciles à distinguer et par conséquent une

discrimination visuelle est possible (figure (2.9)).

29

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

20

10

15

0

5

0 20 40 60 80 100 120

0.5 1 1.5 2 2.5

Modulus x 104

Hanning window (128 pts)

FT

-200

-400

400

600

200

20

10

15

0

0

5

0 10 20 30 40 50 60 70

10 20 30 40 50 60 70

Es0001-TIS -2003-01-22 13:11:23

Modulus of STFT

Time [sec]

800

600

400

200

1200

1000

(a)

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

20

10

15

0

5

0 20 40 60 80 100 120

0.5 1 1.5 2 2.5 3

Modulus x 105

Hanning window (128 pts)

FT

-1000

-1500

-2000

-500

1500

1000

500

20

10

15

0

0

5

0 20 40 60 80 100 120

0 20 40 60 80 100 120

Es0429-JBB -2005-05-06 02:47:39

Modulus of STFT

Time [sec]

4500

4000

2500

2000

3500

3000

500

1500

1000

(b)

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

20

10

15

0

5

0 20 40 60 80 100 120

0.5 1 1.5 2 2.5 3

Modulus x 105

Hanning window (128 pts)

FT

-1000

-500

1000

500

20

10

15

0

0

5

0 20 40 60 80 100 120

20 40 60 80 100 120

Es031 9-CZDV-2005-09-16 00:50:27

Modulus of STFT

Time [sec]

4000

2000

5000

3000

1000

(c)

Figure 2.10: Le module de la STFT pour une explosion chimique

(a), un séisme local (b) et un séisme lointain (c)

2.3.2 Spectrogramme

Le module carré de la STFT (2.11) conduit à une

représentation quadratique communément appelée

spectrogramme (SPEC: Spectrogram). Cette représentation, qui dis-

tribue l'énergie du signal dans le plan

temps-fréquence, est la plus ancienne qui ait

étéproposée, mais aussi l'une des plus

utilisées. Elle est précisément définie par

[145]:

SPECx : L2(R) ? L2(R)

x(t) ? SPECx(t, í) = | i8

x(u)h*(u - t)e-i2ðíudu|2 (2.14)

= |STFT |2

où h désigne une fenêtre d'analyse. Comme

pour la STFT, le choix de la fenêtre repose sur la recherche d'un

compromis entre l'hypothèse de la quasi-stationnarité du signal

sur l'intervalle d'analyse et les résolutions temporelle et

fréquentielle de la représentation. Afin de mettre en evidence

l'influence du fenêtre d'analyse et du SPEC sur la localisation

temporelle et fréquentielle, nous démontrons le

théorème ci-dessous.

Théorème 2.1 (Version spectrogramme de

l'inégalité d'Heisenberg-Gabor en í). Soit x ?

L2(R) et h ? L2(R) \ {0} une fenêtre d'analyse,

alors on a l'inégalité:

1/2 ? 1/ 2

8

? ?

fZ8

8 Z

?

-8 -8 -8

t2|x(t)|2dt ? ?

?

(R)

4ð (2.15)

khkL2(R)IIxII2 L2

í2SP ECx(u, í)dudí ?

=

~ i8 ) 1/2 ( i8 )1/2

avec hML2(R) = |h(t)|2dt et

xML2(R) = |x(t)|2dt .

-8 -8

Démonstration. Supposons que les deux

intégrales dans l'inégalité (2.15) sont finies.

Par la

propriété de l'invariance par translation de l'intégrale

au sens de Lebesgue et par

utilisation du fait que la STFT d'un signal x par

une fenêtre d'analyse h n'est que la FT

|

> 1 -- 4/r

|

8

f

|

8

f

|

|ST FTx(u, í))|2 dí du

= 14/r11h112L2

(R)11x112L2 (R)

|

de x multiplié au préalable par le conjugué

de la fenêtre d'analyse h translatée, on a:

8 8 8

11h112L2(R) f t2| x (t) | 2 dt = f | h (u)

| 2 du f t2| x (t)| 2 dt

|

=

=

=

|

8

f

8

f

8

f

|

8

f

8

f

8

f

|

t2 | h (t -- u) |2 | x (t) |2 dtdu

t2|I FT* (ST FTx(u,

í))(t)|2dtdu

t2| I FT (ST FTx(u,

í))(t)|2dtdu

En appliquant l'inégalité d'Heisenberg-Gabor (2.13)

et l'égalité de Plancherel-Parseval (conservation de

l'énergie):

ci | x (t)| 2 dt = ci |

FTx ( í) | 2 dí

on a:

1/2 8 1/2

( f88 í2|STFTx (u,

í))|2dí) x ( f t2|IFT(STFTx(u,

í))(t)|2dt) -8

8

f

> 1 -- 4/r

|ST FTx(u, í))|2 dí

par intégration par rapport à u et par application

de l'inégalité de Cauchy-Schwarz, on obtient:

(

f8 í2|STFTx(u,í))|2dídu) 1/2 (f

|h(t)12dt)1/2 (f t2|x(t)|2dt)1/2

-8 -8 -8-8

7 7

1/2 ,21STFTx(u, 0)12 ch idu)

( 7 7 1/2

t2lIFT(STFTx(u, v))(t)12

dtdu)

= (

-8 -8 -8 -8

f88 ( f88 í2|STFTx(u, í)) |2dí) (

f: t2 | IFT(STFTx(u, í))(t)|2 dt) du

1/21/2

De la même façon, nous pourrons prouver le

théorème ci-dessous.

Théorème 2.2 (Version spectrogramme de

l'inégalité d'Heisenberg-Gabor en t). Soit x E

L2(118) et h E L2(118) \ {0} une

fenêtre d'analyse, alors on a l'inégalité:

(f8 í2 |FTx(í)|2dí ( I f

t2SPECx(t, í)dtdhí

)1/2 8 8 -8

(2.16)

11h11L2(R)11x112L2(R)

>

4ð

) 1/2

1/2 1/2

avec 11h11L2(R) = ( 78 f h(t)|2dt) et

11x11L2(R) = (78 |x(t)|2dt) .

Démonstration. La même démarche que le

théorème (2.1).

A partir des deux théorèmes ci-dessus, nous avons

le résultat suivant:

Corollaire 2.1. Soit x E L2(118) et h E

L2(118) \ 101 une fenêtre d'analyse, alors on a

l'inégalité:

1/2 8 8 1/2

( 0f0 8

t2SPECx(t, í)dtdí) (

f f í2SPECx(u,

í)dudhí)

-8 -8 -8 -8

8 1/2 ( 8 1/2

11h112 11x114 (2.17)

X ( f t2|x(t)|2dt) f

í2|FT(í)|2dí) > L2

(R) L2 (R)

-8 -8 16ð2

1/2 1/2

avec 11h11L2(R) = ( 78 f h(t)|2dt) et

11x11L2(R) = (78 |x(t)|2dt) .

Démonstration. Il suffit de multiplier les termes

des inégalités (2.15) et (2.16) pour

obtenir

l'inégalité (2.17).

Remarques:

· A partir de l'inégalité (2.17), nous

constatons qu'il y a un dilemme entre la résolution de la

transformée de Fourier à court terme et celle de la

transformée de Fourier. Ce qui met en cause certaines

interprétations de la résolution des représentations

temps-fréquence basées sur l'inégalité

d'Heisenberg-Gabor standard (2.13).

· Pour le cas d'une fenêtre d'analyse de norme

unité, nous trouvons dans les inégalités (2.15) et (2.16)

la même borne minimale que celle de l'inégalité (2.13).

Le spectrogramme est une représentation

bilinéaire et covariante aux translations en temps et en

fréquence, donc est un élément de la classe de Cohen.

Cependant, le principal problème posé est les

interférences. En effet, le spectrogramme est une représentation

quadratique qui respecte par conséquent le principe de la superposition

quadratique qui s'écrit pour une TFR quadratique T appliquée

à un signal à deux composantes x(t) = P2 ckxk(t):

k=1

Tx(t, u) = |c1|2Tx1(t, u) +

|c2|2Tx2(t, u) + c1c* 2Tx1,x2(t, u)

+ c2c* 1Tx2,x1(t, u) (2.18)

Ainsi, pour un signal N composantes x(t) = PN ckxk(t),

on a [144]:

k=1

· pour chaque composante du signal ckxk, il

correspond une auto-composante |ck|2Txk(t, u);

· pour chaque pair de composantes ckxk

et clxl avec k =6 l, il correspond un terme inter-composantes

(ou terme d'interférences) ckc* kTxk,xl (t, u) + clc*

kTxl,xk (t, u).

Par conséquent, pour N composantes, on a N auto-composante

et N(N-1)

2 termes

d'interférences. Ceci influence la visualisation de la

TFR quadratique d'un signal multicomposantes et la rend difficile. Mais pour le

spectrogramme, les interférences sont de nature oscillatoire et existent

seulement dans les régions du plan temps-fréquence

oùles composantes se superposent et sont proches [167]. Les

exemples (2.3), (2.4) et (2.5) permettent d'expliciter ce

phénomène.

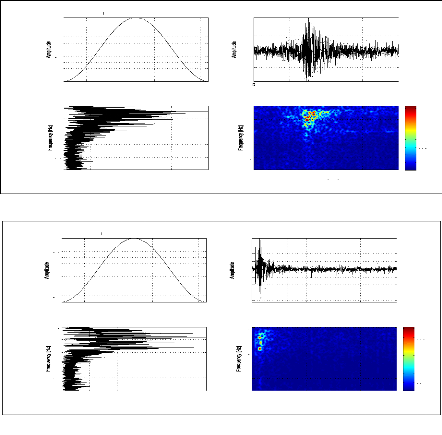

Exemple 2.3: Le SPEC d'un signal à deux composantes non

superposables.

Nous considérons le signal S2 de l'exemple (2.2)

constitué de deux composantes de fréquences 100Hz et 300hz non

superposables. Le SPEC de ce signal, en utilisant une fenêtre de Hanning

de 128 points, est donné par la figure (2.11) où il est clair

qu'il n'y a pas d'interférences entre les deux composantes.

34

400

200

300

100

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

0 20 40 60 80 100 120

10 20 30 40 50 60

Hanning window (128 pts)

Modulus

FT

-0.2

-0.4

-0.6

-0.8

200

400

300

0.8

0.6

0.4

0.2

100

0

0

0 0.05 0.1 0.15 0.2 0.25

0 0.05 0.1 0.15 0.2 0.25

Time [sec]

ignal S2

SPEC

20

5

15

10

Figure 2.11: Le SPEC d'un signal à 2 composantes non

superposables

400

200

300

100

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

0 20 40 60 80 100 120

20 40 60 80 100

Hanning window (128 pts)

Modulus

FT

-0.5

-1.5

400

200

300

100

0.5

1.5

-1

0

0

1

0 0.05 0.1 0.15 0.2 0.25

0 0.05 0.1 0.15 0.2 0.25

Time [sec]

Signal S1

SPEC

20

5

0

15

10

Figure 2.12: Le SPEC d'un signal à 2 composantes

superposables et non proches

Exemple 2.4: Le SPEC d'un signal à deux

composantes superposables et non

proches.

Nous considérons le signal S de l'exemple (2.2)

constitué de deux composantes de fréquences 100Hz et 300hz

superposables mais non proches. Le SPEC de ce signal, en utilisant une

fenêtre de Hanning de 128 points, est donné par la figure (2.12)

où il apparaît clairement que malgré la superposition des

deux composantes il n'y a pas d'interferences.

35

Exemple 2.5: Le SPEC d'un signal à deux composantes

superposables et proches.

Nous considérons le signal S de l'exemple (2.2) mais

cette fois-ci constitué de deux composantes de fréquences 100Hz

et 110hz superposables et proches. Le SPEC de ce signal, en utilisant une

fenêtre de Hanning de 128 points, est donné par la figure (2.13)

où on ne peut plus différencier entre les différentes

composantes à cause des interférences dues à la

superposition et la proximité fréquentielle.

400

200

300

100

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

0 20 40 60 80 100 120

20 40 60 80 100 120

Hanning window (128 pts)

Modulus

FT

-1.5

400

200

300

100

0.5

0.5

1.5

0

0

1

1

0 0.05 0.1 0.15 0.2

0 0.05 0.1 0.15 0.2

Time [sec]

Signal S1

PEC

0.25

0.25

40

35

30

25

20

15 10 5

Figure 2.13: Le SPEC d'un signal à 2 composantes

superposables et proches

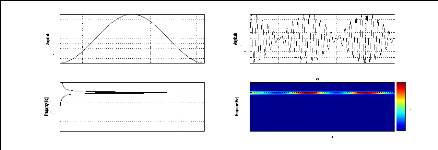

Pour le cas des signaux sismiques, signaux multicomposantes

non stationnaires, le SPEC est caractérisé par des

interférences très difficiles à étudier à

cause, d'une part, du nombre indéfini des composantes et, d'autre part,

de la non connaissance de leurs contenus spectraux à tout instant d'une

façon précise. Mais comme les signaux sismiques sont

constitués de composantes principales (phases) alors, dans le SPEC,

elles seront caractérisées par des dômes d'énergie

plus fort que les autres composantes. Ce qui nous permet de caractériser

la catégorie du signal étudié. La figure (2.14) donne le

SPEC d'une explosion chimique (a), d'un séisme local (b) et d'un

séisme lointain (c).

Si le SPEC présente, d'une part, l'avantage d'avoir des

interférences atténuées et d'être positif partout,

d'autre part, il présente l'inconvénient d'être une

transformation singulière [143, 125], en plus de la difficulté du

choix de la fenêtre d'analyse malgré les propositions de combiner

plusieurs types [204, 114].

36

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

20

10

15

0

5

0 50 100 150 200 250

0.5 1 1.5 2 2.5

Modulus x 104

Hanning window (256 pts)

FT

-200

-400

400

600

200

20

10

15

0

0

5

0 10 20 30 40 50 60 70

10 20 30 40 50 60 70

Es0001-TIS -2003-01-22 13:11:23

Time [sec]

SPEC

x 105

4

2

8

6

14

12

10

(a)

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

20

10

15

0

5

0 50 100 150 200 250

0.5 1 1.5 2 2.5 3

Modulus x 105

Hanning window (256 pts)

FT

-1000

-1500

-2000

-500

1500

1000

500

20

10

15

0

0

5

0 20 40 60 80 100 120

0 20 40 60 80 100 120

Es0429-JBB -2005-05-06 02:47:39

Time [sec]

SPEC

x 106

4

2

8

6

16

14

12

10

(b)

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

20

10

15

0

5

0 50 100 150 200 250

0.5 1 1.5 2 2.5 3

Modulus x 105

Hanning window (256 pts)

FT

-1000

-500

1000

500

20

10

15

0

0

5

0 20 40 60 80 100 120

20 40 60 80 100 120

Es031 9-CZDV-2005-09-16 00:50:27

Time [sec]

SPEC

x 107

2.5

2

3

0.5

1.5

1

(c)

Figure 2.14: Le SPEC d'une explosion chimique (a), d'un

séisme local (b) et d'un séisme lointain (c)

2.3.3 Représentation de Wigner-Ville

La représentation de Wigner-Ville (WV: Wigner-Ville)

peut être considérée comme la plus importante TFR. Elle a

été définie au début, dans un contexte de la

mécanique quantique, par Wigner en 1932 et ensuite, introduite dans le

domaine d'analyse des signaux par Ville en 1948. Cependant, elle n'est devenu

très utilisée qu'après la publication des articles de

Claasen et Mecklenbrauker [63, 64, 65]. L'importance de cette

représentation provient de ses caractéristiques

intrinsèques par rapport à d'autres TFRs et son application aux

différentes situations [214]. La distribution de WV est définie

à partir de la représentation temporelle du signal par [63,

109]:

WVx : L2(R) ?

L2(R2)

f 8 (2.19)

x(t) ? W Vx(t, í) = x(t -u 2)x*(t

+u 2)e-i2ðíudu

En comparaison avec la STFT, la WV a un avantage pratique:

l'utilisateur n'a pas à se soucier du choix de la fenêtre

d'analyse ni de sa longueur. En fait, l'equation (2.19) montre que la

fenêtre d'analyse du signal x(t) est le signal lui-même

renversé. Ce fenêtrage adaptatif permet une concentration

excellente des motifs et permet à la WV de présenter la meilleur

précision temps-fréquence des TFRs actuelles [172]. Cependant,

comme pour le spectrogramme, cette TFR souffre aussi de la limitation de la

résolution temps-fréquence pour lesquelles nous démontrons

les inégalités ci-dessous.

Théorème 2.3 (Version Wigner-Ville de

l'inégalité d'Heisenberg-Gabor en í). Soit x ?

L2(R), alors on a l'inégalité:

? ? 1/2 ? ? 1/2

f 8 f 8 f 8 kxk3 L2(R)

?

t2|x(t)|2dt ? ? í2|W

Vx(u, í)|2dudí ? = 2ð (2.20)

-8 -8

-8

( f8 )1/2

avec xML2(R) = |x(t)|2dt .

-8

Démonstration. Supposons que les intégrales

de l'inégalité (2.20) sont finis. Nous avons, pour un signal x

réel à énergie finie,

|

WVx(t,í) =

|

Z8

-8

|

u u

x(t - 2)x(t +

2)e-i2ðíudu

|

En faisant le changement de variable y = t +u

2, nous obtenons:

WVx(t,í) = Z8 x(y) [2x(2t - y)e-2

iðí(v-2t)] e-2iðívdy

-8

donc la représentation de WV d'un signal réel,

n'est que la STFT de ce signal par une fenêtre d'analyse h où:

h*(t - y) = 2x(2t - y)e-2iðí(v-2t)

Par conséquent, pour obtenir l'inégalité

(2.20), il suffit de changer la norme de h dans l'inégalité

(2.15) par 2 x L2 (R). ~

De la même façon, nous pouvons prouver le

théorème ci-dessous, en utilisant cette fois-ci

l'inégalité (2.16).

Théorème 2.4 (Version Wigner-Ville de

l'inégalité d'Heisenberg-Gabor en t). Soit x ? L2(R),

alors on a l'inégalité:

|

( f 8 ) 1/2 ( f8 )1/2

f 8

í2|F

Tx(í)|2dí t2|W Vx(t,

í)|2dtdí

-8 -8 -8

( f8 )1/2

avec xML2(R) = |x(t)|2dt .

-8

|

(2.21)

IIxII3 ,2(R)

= 2ð

|

A partir de ces deux théorèmes, nous avons le

résultat suivant:

|

Corollaire 2.2. Soit x ? L2(R), alors on a

l'inégalité:

((f 8 ) 1/2 ( f 8 )1/2

f 8 f 8

t2|W

Vx(t, í)|2dtdí í2|W

Vx(u, í)|2dudí

-8 -8 -8 -8

f 8 )

1/2 ( f 8 )1/2 = iixii6 L2(R)

t2|x(t)|2dt í2|F

Tx(í)|2dí4ð2

-8 -8

|

(2.22)

|

1/2

( f8 )

avec xML2(R) = |x(t)|2dt .

-8

Démonstration. Il suffit de multiplier les termes

des inégalités (2.20) et (2.21) pour

obtenir

l'inégalité (2.22). ~

Remarque:

De l'inégalité (2.22), nous constatons qu'il y a

un dilemme entre la résolution temps- fréquence de la

représentation de Wigner-Ville et celle de la transformée de

Fourier. En effet, en augmentant la résolution de l'une, l'autre diminue

et vice-versa.

La WV est une transformation régulière, ce qui

la permet d'avoir des performances supérieures en comparaison avec les

transformations singulières dans certains problèmes de

classification des signaux [143, 139, 125]. En plus de sa vérification

de plusieurs propriétés

mathématiques désirables dans une TFR [143] et

particulièrement la covariance

(propriétéfortement souhaitable pour discriminer les

signaux [79]), toutes les représentations de la classe de Cohen [68]

s'obtienent par la double convolution temps-fréquence de la WV:

Cöx: L2(R) ?

L2(R2)

x(t) ? Cö x(t, õ) = f8

f8 ç(u - t, f - õ)WVx(u, f)dudf (2.23)

où ç est le noyau de la TFR. Par conséquent,

le SPEC peut être obtenu par un noyau ç(t, í) = WVh(t,

í).

Comme toutes les représentations quadratiques, la

représentation de WV entraîne des termes d'interférences

à cause du principe de la superposition quadratique. Ces termes

d'interférences, dont la géométrie a été

l'objet de plusieurs études [16, 144], se car-

40

actérisent par l'apparition d'un point d'interference

pour chaque deux points du plan temps-fréquence provenant de deux

composantes différentes. Ce qui apparaît sous formes

d'oscillations dont la direction est perpendiculaire à la droite liant

les deux points du signal.

Exemple 2.6: La WV d'un signal à deux composantes non

superposables.

Nous considérons le signal 82 de l'exemple (2.2)

constitué de deux composantes de fréquences 100Hz et 300hz non

superposables. La WV du signal est donné par la figure (2.15).

En comparaison avec le SPEC, nous constatons l'apparition des

termes d'interférences dans la représentation de WV même si

les deux composantes sont non superposables. Ceci est justifiable par le fait

que dans ces régions, la WV ne présente que des

interférences fluctuant rapidement entre valeurs positives et

négatives et se compensent si nous faisons une moyenne locale. Ce qui

amène le SPEC à avoir des valeurs proches de zéro dans ces

régions.

0 50 100 150 200 250 300 350 400 450

10 20 30 40 50 60

Modulus

FT

-0.2

-0.4

-0.6

-0.8

0 50 100 150 200 250 300 350 400 450

0.8

0.6

0.4

0.2

0

0 0.05 0.1 0.15 0.2

0 0.05 0.1 0.15 0.2 0.25

Time [sec]

ignal S2

WV

0.25

20

0

-10

-20

-30

10

Figure 2.15: Le WV d'un signal à 2 composantes non

superposables

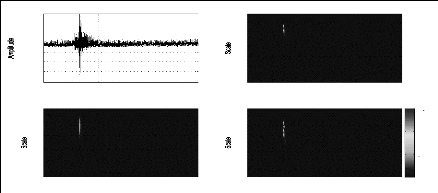

La représentation des signaux sismiques par le module

de la WV est illustrée par la figure (2.16) où l'influence des

interférences rend très difficile la caractérisation du

type de l'événement par la voie visuelle.

41

Es0001-TIS -2003-01-22 13:11:23

600

400

200

0

-200

-400

0 10 20 30 40 50 60 70

WV

FT

x 106

0

0

5

5

5

10

10

0

15

15

20

20

-5

0 10 20 30 40 50 60 70

Time [sec]

0.5 1 1.5 2 2.5

Modulus x 104

(a)

(c)

Es0429-JBB -2005-05-06 02:47:39

1500

1000

500

0

-500

-1000

-1500

-2000

0 20 40 60 80 100 120

x 107

FT

WV

0

0

4

3

5

5

2

1

10

10

0

-1

15

15

-2

20

-3

20

-4

0 20 40 60 80

100 120

Time [sec]

0.5 1 1.5 2 2.5 3

Modulus x 105

Es0319-CZDV-2005-09-16 00:50:27

1000

500

0

-500

-1000

0 20 40 60 80 100 120

WV

FT

x 107

0

0

6

4

5

5

2

10

10

0

15

15

-2

-4

20

20

-6

0 20 40 60 80 100 120

Time [sec]

0.5 1 1.5 2 2.5 3

Modulus x 105

(c)

Figure 2.16: Le module de la WV d'une explosion chimique (a),

d'un séisme local (b) et d'un séisme lointain (c)

42

2.3.4 Représentations à interférences

réduites

La lisibilité des représentations

temps-fréquences étant un facteur essentiel pour l'analyse des

signaux non stationnaires. Ainsi, il est souhaitable de diminuer le nombre et

l'amplitude des interférences. Une première étape, dans ce

cadre, consiste à ne représenter que des signaux analytiques afin

d'éliminer les termes interférentiels provenant des interactions

entre les composantes portées par les fréquences positives et

celles portées par les fréquences négatives (figure

(2.17)). Une seconde étape consiste alors à exploiter la

structure oscillante des interférences, ce qui suggère

d'introduire une opération de lissage

dans le plan temps-fréquence. Appliqué à

la représentation de WV, ce lissage conduit

àl'évaluation du produit de convolution

suivant:

öTF(t, u) * WVx(t, u)

Ce qui conduit explicitement aux éléments de la

classe de Cohen. Donc, le SPEC peut être vu comme une version

lissée de la WV du signal par un noyau égal à la WV de la

fenêtre d'analyse h, ce qui atténue les interférences.

Cependant, ce lissage provoque l'étalement de la distribution

d'énergie dans les régions associées au signal, conduisant

le SPEC à une perte de concentration [167, 174, 144].

200

400

100

300

0

10 20 30 40 50 60

Modulus

FT

-0.2

-0.6

200

300

400

100

0.8 0.6 0.4 0.2

0.4

0.8

0

0

0 0.05 0.1 0.15 0.2 0.25

0 0.05 0.1 0.15 0.2 0.25

Time [sec]

Signal

WV

20

10

0

20

30

10

200

300

400

100

0

10 20 30 40 50 60

Modulus

FT

-0.2

-0.6

200

300

400

100

0.8 0.6 0.4 0.2

0.4

0.8

0

0

0 0.05 0.1 0.15 0.2 0.

0 0.05 0.1 0.15 0.2 0.25

Time [sec]

Signal

WV

60

40

20

0

-20

-40

-60

(a) (b)

Pour le choix de öTF, plusieurs alternatives

sont envisageables. En effet, nous pouvons choisir un noyau de lissage fixe ou

adapté. Pour le premier cas, la solution la plus naturelle consiste

à utiliser un filtre passe-bas bidimensionnel indépendant du

signal analysé. Un certain nombre de représentations repose sur

ce principe, parmi lesquelles on compte celle de Choï-Williams (CW) et la

pseudo Wigner-Ville lissé (SPWV: Smoothed Pseudo Wigner-Ville) [109].

Pour le deuxième cas, la solution consiste à paramétrer un

noyau de lissage et à l'optimiser au sens d'un critère

donné dépendant du signal à analyser. La figure (2.18)

donne la représentation de trois signaux sismiques via la SPWV où

les fenêtres de lissage sont de type Gauss de largeur 128 points. Il est

clair, après la réduction des interférences, qu'il est

possible de caractériser le type d'événement de la

même façon qu'on a fait pour le SPEC.

44

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

20

10

15

0

5

0 20 40 60 80 100 120

0.5 1 1.5 2 2.5

Modulus x 104

Gauss window (128 pts)

FT

-200

-400

400

600

200

20

10

15

0

0

5

0 10 20 30 40 50 60 70

10 20 30 40 50 60 70

Es0001-TIS -2003-01-22 13:11:23

Time [sec]

SPWV

x 105

4

2

8

6

0

(a)

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

20

10

15

0

5

0 20 40 60 80 100 120

0.5 1 1.5 2 2.5 3

Modulus x 105

Gauss window (128 pts)

FT

-1000

-1500

-2000

-500

1500

1000

500

20

10

15

0

0

5

0 20 40 60 80 100 120

0 20 40 60 80 100 120

Es0429-JBB -2005-05-06 02:47:39

Time [sec]

SPWV

x 106

4

2

8

6

0

10

(b)

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

20

10

15

0

5

0 20 40 60 80 100 120

0.5 1 1.5 2 2.5 3

Modulus x 105

Gauss window (128 pts)

FT

-1000

-500

1000

500

20

10

15

0

0

5

0 20 40 60 80 100 120

20 40 60 80 100 120

Es031 9-CZDV-2005-09-16 00:50:27

Time [sec]

SPWV

x 10

4

2

8

6

0

12

10

6

(c)

Figure 2.18: La SPWV d'une explosion chimique (a), d'un

séisme local (b) et d'un séisme lointain (c)

2.4 Représentations temps-échelle

Les méthodes basées sur la STFT ont des

résolutions temporelles et fréquentielles fixes. Il est par

conséquent difficile de faire une mesure précise des composantes

d'un signal à la fois dans les hautes et les basses fréquences.

Pour vaincre ce problème, les représentations

temps-échelle (TSRs: Time-Scale Representations) présentent une

alternative intéressante dans la mesure de pouvoir analyser les

composantes de hautes et de basses fréquences du signal en adoptant

automatiquement une résolution temps-fréquence adéquate.

Dans ce sens, ces représentations sont considérées aussi

comme des TFRs [145]. Mais nous utilisons, dans ce mémoire, la

nomination originale temps-échelle pour les caractériser des TFRs

à résolution fixe.

Comme les TFRs, les TSRs peuvent être réparties

en des représentations linéaires et quadratiques. Pour le cas

linéaire, on trouve les ondelettes et pour le cas quadratique, la classe

affine constitue la classe la plus intéressante des TSR covariantes

[258, 145, 109, 239]. En effet, cette classe, comme la classe de Cohen, est

unitairement équivalente aux classes de puissance et hyperbolique [79]

et admet une formulation similaire à l'equation (2.23) à partir

de la WV par le biais d'une transformation affine [110, 258, 145]. Parmi les

éléments de cette classe, en plus de la WV, on trouve le

scalogramme, la distribution de Bertrand [39] et la distribution de Flandrin

[109] (le lecteur pourra se référer à [239] pour d'autres

représentations).

Dans ce paragraphe, nous restreignons à la

présentation de la transformée en ondelettes continues (CWT:

Continuous Wavelet Transform) et au scalogramme (SCAL: Scalogram). Ces deux

représentations ont montré une grande efficacité dans le

domaine de la géophysique [117] et plus particulièrement dans le

traitement des signaux sismiques utilisés dans la caractérisation

des sous-sols [48, 263].

2.4.1 Transformée en ondelettes continues

La définition de la CWT est proche de celle de la STFT,

où la fenêtre modulée h(t)ei2ðõt a

été remplacée dans l'équation (2.11) par une

ondelette [222, 130, 109]:

|

CWT x ø : L2(R) ?

L2(R2)

x(t) ? CWT x ø (a, t) =

|

|

x(u) * a,t(u)du

|

(2.24)

|

où a > 0 est le paramètre d'échelle (ou

de dilatation), t est le paramètre de position (ou de translation) et

a,t : u?1 va (u-t

a ) représente une famille de fonctions appelées

ondelettes analysantes (ou ondelettes filles) dérivant toutes de la

même ondelette mère .

L'équation (2.24) donne les coefficients d'ondelette

(nombre à valeur généralement complexe) contenant toutes

les informations dont on a besoin pour conduire une analyse

multi-échelle. En effet, changer la valeur de a permet de dilater (a>

1) ou de contracter (a < 1) la fonction a,t

(propriété d'analyse multi-échelle); changer t autorise

l'analyse de la fonction x(t) au voisinage de différents points t

(propriété d'analyse locale). Lorsque le paramètre

d'échelle a croît, l'ondelette couvre une plus grande fraction du

signal permettant d'extraire le comportement à long terme de x(t). Au

contraire, lorsque a diminue,

la fraction du signal analysée diminue et rend possible

l'étude des variations locales àhautes

fréquences. Pour une étude comparative entre l'analyse de Fourier

et l'analyse par ondelettes le lecteur pourra se référer à

[312].

Ainsi par ses propriétés de

dilatation-contraction et de translation, la CWT est caractérisée

dans le plan espace-échelle par une fenêtre dont la largeur

diminue lorsque on se focalise sur les structures de petite échelle

(haute fréquence) ou s'élargit lorsque'on s'intéresse au

comportement à grande échelle (basse fréquence). Cette

capacité d'adaptation en fonction de l'échelle d'analyse lui a

valu la dénomination de «microscope mathématique» dont

le grossissement est donné par1 a et dont l'optique est

donné par le choix de la fonction mère [219].

le domaine fréquentiel par la condition

d'admissibilité suivante:

|

Cø =

|

Z8

-8

|

|F Tø(!)|2

|!| d! <+8 (2.25)

|

et on dit que est admissible. Cette condition étant

relativement souple, un assez grand nombre de fonctions peuvent convenir. Aussi

impose-t-on souvent des contraintes supplémentaires de

régularité, de décroissance rapide ou de compacité

suivant les besoins. Il convient de bien cerner le problème à

étudier et d'être guidé par diverses considérations

incluant, en particulier, une base physique [175] ou à défaut la

ressemblance entre le signal analysé et la famille d'ondelette choisie

[119].

Outre ses propriétés de localisation, une

ondelette possède la propriété de s'annuler en zéro

dans le domaine de Fourier, ce qui simplifie énormément la

condition d'admissibilitédans certains cas comme le montre le

théorème ci-dessous.

Théorème 2.5. Soit ? L2(R) fl

L1(R). Alors les deux assertions suivantes sont équivale

ntes:

1. est admissible,

2. 78 (t)dt = 0 soit FTø(0) = 0.

Démonstration. La démonstration de ce

théorème se trouve dans [278]. ~

La condition d'admissibilité assure la possibilité

de reconstruire un signal à partir de ses coefficients d'ondelettes.

Cette transformée inverse est donnée par [278]:

|

1

x(t) = Cø

|

Z8 Z8

-8 8

|

a-2CWT x ø (a, u) a,u(t)dadu (2.26)

|

Remarque:

Dans les cas où il n'est pas nécessaire de

reconstruire le signal, la fonction ? L2 (R)

Comme toutes les TFRs, la CWT soufre de la limitation de ses

résolutions temporelle et fréquentielle à cause du

principe d'incertitude d'Heisenberg-Gabor (2.13). Le théorème

ci-dessous donne une version de ce principe en t pour la CWT.

Théorème 2.6 (Version ondelette de

l'inégalité d'Heisenberg-Gabor). Soit x E

L2(118) et e une ondelette, alors on a

l'inégalité:

00

8-8

avec 11x11L2(R) = ( i: 1/2

lx(t)12dt) .

8 1/28 81/2

(I y2|FTx (y)|2dy) (

iit2 a- 12 |CWTxe (a,

t)|2dadt > ,V4re

lx112L2(R) (2.27)

Démonstration. Supposons que les deux

intégrales dans l'inégalité (2.27) sont finies. A partir

de la condition d'admissibilité (2.25), nous avons:

Ce f8

y2|FTx(y)|2dy = f8

|'i3(|â|)|2

dâ f8

y2|FTx(y)|2dy

|

=

|

f8

|

f8

|

y2|FTe(ay)|2|FTx(y)|2|a|-1dady

|

(2.28)

|

et en utilisant l'expression de la CWT par le biais de l'IFT:

CWT (a, t) = I FT (FTx (y) ,V|a|

FT*e (ay))(t)

on obtient:

|

i88-i88

|

y2|FT ø (y)| 2 a2 dady = C

nWTx (a,t) -- e

|

I

|

y2|FTx(y)|2dy (2.29)

|

En appliquant l'inégalité d'Heisenberg-Gabor

(2.13), nous avons:

8

1/2 8

(

O'8 t2| CWTxe (a, t)

| 2 dt) (f y2|FTn/uxø (a,t) (y)|2dy) 1/2

-8

7 |nWTxø(a,t)|2dt

8

>

4ð

d'où

1/2 1/2

f [( f8 t2|CWTxø(a, t)|2dt) ( f

í2|FTCWTxø(a,t)(í)|2dí) 1 a2

-8 -8 -8

>

I, I, |CWTxø(a,t)|2 ada dt

4ð

et par la propriété de la conservation

d'énergie,l'inégalité de Cauchy-Schwarz et en utilisant

l'égalité (2.29), nous obtenons:

1/2 ( 8 8 ) 1/2

( f f t2| CWTxø (a, t)|2dtdj

WT

,t

(a,t)(í)|2dídaaffí2|FTC

) 1/2 ) 1/288

o

= ( f f |CWTxø(a,

t)|2dtd; ,VCø ( f í2|FTCWTx

ø (a,t) (í)|2 dí

-8 -8 -8

1/2 8 1/2

> f [( cf°

t2|CWTxø(a, t)|2dt) ( f

í2|FTCWTxø(a,t)(í)|2dí) 1 da2

-8 -8 -8

> C4/r111x112L2(R)

Finalement, en divisant par ,VCø , nous obtenons

l'inégalité (2.27).

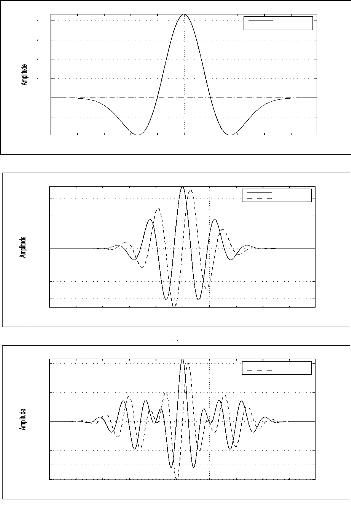

2.4.2 L'ondelette de Ben

Dans la littérature, on trouve plusieurs ondelettes qui

ont été utilisées, particulièrement pour

l'exploration du sol par analyse des signaux sismiques. Nous citons:

l'ondelette de Morlet [78], l'ondelette de Berlage [7], l'ondelette de Ricker

[254, 62] et l'ondelette chapeau Mexicain [78]). Dans ce paragraphe, nous

essayons de présenter une nouvelle ondelette complexe dite ondelette de

Ben qui a été utilisée avec succès par l'auteur

dans plusieurs travaux de classifications des signaux non stationnaires dont

les signaux sismiques en font partie [36, 75, 31].

Deux ondelettes particulièrement populaires pour la CWT

sont l'ondelette chapeau mexicain (dérivée seconde d'une

gaussienne) et l'ondelette de Morlet [78]. La première est une ondelette

réelle et symétrique donnée par [190]:

)

-8 -8

2

3

ømh(t) = ð-1/4(1 --

t2)e-t2/2

(2.30)

.V

Ce qui permet de ne pas introduire de déphasage dans la

transformée en ondelettes contrairement à des ondelettes non

symétriques (comme le sont les ondelettes orthonormales à support

compact d'Ingrid Daubechies [78]. De plus, comme étant issue de la

dérivée d'une ondelette (Gaussienne), elle est

particulièrement adaptée à la détection des

discontinuités. Quant à l'ondelette de Morlet complexe, sa forme

complète est donnée par [4]:

ømc(t) = -1/4(eiù0t -

e-ù2 0/2)e-t2/2 (2.31)

où w0 est sa fréquence centrale. Le terme

e-ù2 0/2 est un terme de correction utilisé

pour remplir la condition de moyenne nulle nécessaire pour

l'admissibilité. En pratique, ce terme devient négligeable pour

des valeurs w0 = 5 (la valeur proposée par Morlet est 5.33). Ce qui a

poussé la majorité des chercheurs à utiliser une forme

dite standard de l'ondelette Morlet [102, 190, 4, 3]:

øms(t) = -1/4eiù0te-t2/2 (2.32)

Cette ondelette est à valeurs complexes et à

oscillations faibles [4], permettant ainsi à extraire des informations

sur l'amplitude et la phase du processus analysé [302].

Numériquement, on peut la considérer à support compact.

Enfin, le meilleur avantage de cette ondelette est qu'avec une fenêtre

gaussienne, les composantes sont caractérisées par des ensembles

de points connexes contenant un maximum local sur l'image du module. Une

composante apparaît alors comme un dôme d'énergie [57] ce

qui facilite la compréhension de l'image temps-fréquence.

Pour les signaux sismiques (non stationnaires,

multicomposantes), afin de profiter des propriétés

intrinsèques de l'ondelette de Morlet et l'ondelette chapeau Mexicain,

nous considérons, la fonction ci-dessous (2.33) que nous l'appellerons

par la suite « ondelette de Ben» [30, 36, 75, 31, 35, 32]:

2

øben(t) = v3 -1/4(1 - t2)eiù0te-t2/2

(2.33)

avec w0 = 7. En vérifiant la condition

d'admissibilité cette fonction peut être

considérée

comme ondelette admissible (voir les théorèmes

(2.5) et (2.7)).

Théorème 2.7. La fonction donnée par

l'équation (2.33) est une ondelette asymptotique- ment admissible.

Démonstration. Afin de montrer que la fonction

'l/)ben(t) = 2 v3ð-1/4(1 -

t2)eiù0te-t2/2 est une ondelette asymptotiquement admissible, nous

montrons que 'l/)ben ? L2 fl L1 et qu'elle a une moyenne nulle quand

w0 ? 8 (voir théorème (2.5)).

· 'l/)ben ? L2:

R8 | 'l/)ben(t) |2 dt = R8 |

'l/)mh(t).eiù0t |2 dt

= R8 | 'l/)mh(t) |2 . |

eiù0t |2 dt

= R8 | 'l/)mh(t) |2 dt

et puisque 'l/)mh est une ondelette normalisée

[190], c'est-à-dire, R8 | 'l/)mh(t) |2 dt = 1,

alors R8 | 'l/)ben(t) |2 dt = 1.

· 'l/)ben ? L1:

R8 | 'l/)ben(t) | dt = R8 |

'l/)mh(t).eiù0t | dt

= R8 | 'l/)mh(t) | . | eiù0t |

dt

= R8 | 'l/)mh(t) | dt

et puisque 'l/)mh est une fonction absolument

integrable, c'est à dire, R8 | 'l/)mh(t) | dt <

8, alors R8 | 'l/)ben(t) | dt < 8.

· R8 'l/)ben(t)dt = 0:

-8

R8 'l/)ben(t)dt =

v3ð-1/4(1 -

t2)eiù0te-t2/2dt

2

R8

4 0

v6ð1/4w2 0e-

ù2 2

= -

= FT * ømh(w0)

0

Il est clair que le terme - 4 v6ð1/4w20e- ù2 2

n'est pas nul. Mais numériquement ce terme est négligeable pour

des valeurs de w0 grandes. Ainsi, pour w0 = 7 sa valeur absolue est

inférieur à 2.5 × 10-9. Et on a

lim

ù0?8

|

(

|

4 0

v6ð1/4 w2 0e- ù2 2) = 0.

|

|

Par conséquent, la fonction 'l/)ben est

asymptotiquement admissible. ~

Afin que la condition de la moyenne nulle soit remplie

exactement, nous pouvons ajouter à 'l/)ben un terme de

correction et la fonction résultante devient une ondelette admissible.

Ce qui est explicité par le théorème ci-dessous.

Théorème 2.8. La fonction

2

'l/)benc(t) =

0)eiù0te-t2/2 (2.34)

v3ð-1/4(1 -

t2 + w2

est une ondelette admissible.

Démonstration. Il est clair que 'l/)benc ? L2 fl

L1. Et on a R8 'l/)benc(t)dt = 0. En effet,

R8 'l/)benc(t)dt =

v3ð

2-1/4(1 - t2 +

w20)eiù0te-t2/2dt

R8

= FT* ømh(w0) + 2ù2

v3 0 F T * øms(0)

= -

4 0

v6ð1/4w2 0e-

ù2 2 + 2

0

2

v3w2 v2ð1/4e - ù2

0

=0

Donc d'après le théorème (2.5),

'l/)benc est une ondelette admissible. ~

Remarques:

· 'l/)ms et 'l/)ben sont,

respectivement, la modulation d'une Gaussienne et de 'l/)mh.

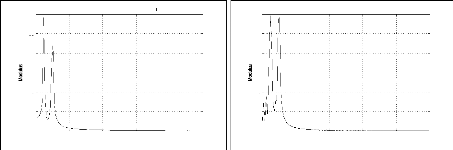

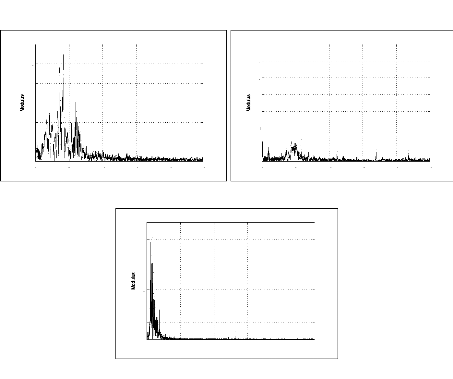

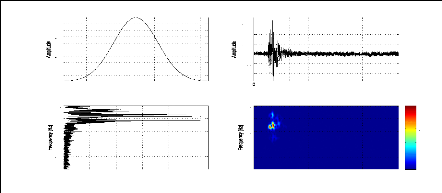

· 'l/)ben est plus oscillatoire que 'l/)mh. Ce

qui est explicité par la figure (2.19).

53

· Comme pour la STFT, le module de la CWT permet une

interprétation facile des composantes du signal (exemple (2.7)).

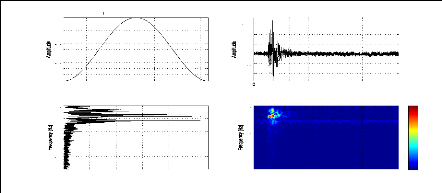

Exemple 2.7: Le module de la CWT d'un signal à deux

composantes non

superposables.

Nous considérons le signal 82 de l'exemple (2.2)

constitué de deux composantes 100Hz et 300Hz. Le module de la CWT du

signal en utilisant les ondelettes 'l/)ms, 'l/)mh et

'l/)ben présentées sur la figure (2.19), est donné par la

figure (2.20) pour le cas d'une échelle entre 0.1 et 30 avec un pas de

0.5. Nous constatons que les trois ondelettes permettent de détecter le

changement de fréquence et le nombre de composantes.

-0.2

-0.4

-0.6

-0.8

0.8

0.6

0.4

0.2

20

25

10

15

0

0

5

0 0.05 0.1 0.15 0.2 0.25

0.05 0.1 0.15 0.2 0.25

Modulus- Mexican hat wavelet

Time [sec]

Signal S2 Modulus- Morlet wavelet

20

25

20

25

30

10

15

10

15

0

5

0

5

0 0.05 0.1 0.15 0.2 0.25

0 0.05 0.1 0.15 0.2 0.25

Modulus- Ben wavelet

Time [sec]

Time [sec]

2.5

2

0.5

1.5

1

Figure 2.20: Le module de la CWT d'un signal à 2

composantes non superposables

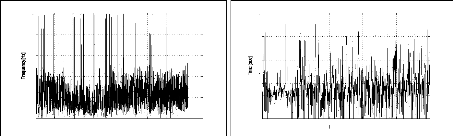

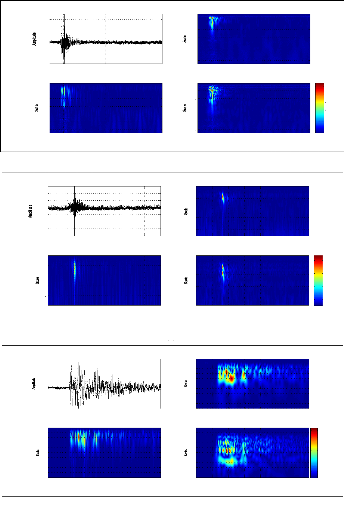

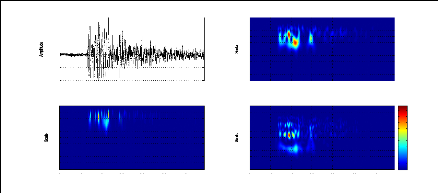

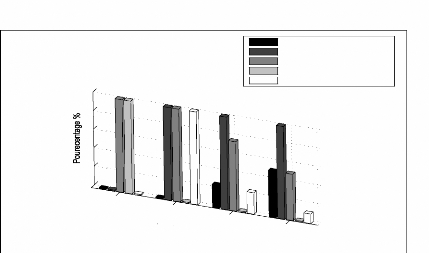

Pour le cas des signaux sismiques come étant des

signaux non stationnaires multicomposantes, la visualisation du module de la

CWT nous permet de différencier entre les différents types de

signaux. Ce qui est explicité dans la figure (2.2 1) pour le cas d'une

explosion chimique, d'un séisme local et d'un séisme lointain.

Cependant

Mexican hat wavelet

Real part Imag part

0.8

0.6

0.4

0.2

0

-0.2

t

-5 -4 -3 -2 -1 0 1 2 3 4

(a)

(c)

Morlet wavelet

Real part Imag part

0.6

0.4

0.2

0

-0.2

-0.4

-0.6

t

-5 -4 -3 -2 -1 0 1 2 3 4

(c)

Ben wavelet

0.8

Real part Imag part

0.6

0.4

0.2

0

-0.2

-0.4

-0.6

-0.8

t

-5 -4 -3 -2 -1 0 1 2 3 4

55

-200

-400

400

200

600

20 40 60 80 100

120

0

0

0 10 20 30 40 50 60 70

0 10 20 30 40 50 60 70

Es0001 -TIS -2003-01-22 13:11:23

Modulus- Mexican hat wavelet

Time [sec]

Time [sec]

60 80 100 120

60 80 100 120

40

40

20

20

0 10 20 30 40 50 60 70

0 10 20 30 40 50 60 70

Modulus- Morlet wavelet

Modulus- Ben wavelet

Time [sec]

Time [sec]

400

200

800

600

1200

1000

(a)

Es0429-JBB -2005-05-06 02:47:39

Modulus- Morlet wavelet

1500

1000

500

0

-500

-1000

-1500

-2000

0 20 40 60 80 100 120

Time [sec]

Time [sec]

Modulus- Mexican hat wavelet

Modulus- Ben wavelet

3500

2

3000

2500

4

2000

6

1500

1000

8

500

10

0 20 40 60 80 100 120

Time [sec]

Time [sec]

5 10 15 20 25 30 35

40

0 20 40 60 80 100 120

5 10 15 20 25 30 35

40

0 20 40 60 80 100 120

(b)

(d)

Es0319-CZDV-2005-09-16 00:50:27

Modulus- Morlet wavelet

1000

500

0

-500

-1000

0 20 40 60 80 100 120

100 120

Time [sec]

Time [sec]

Modulus- Mexican hat wavelet

Modulus- Ben wavelet

7000

10 20 30 40 50 60 70 80 90 100

20 40 60 80 100 120 140 160 180 200

6000

5000

4000

3000

2000

1000

0 20 40 60 80 100 120

0 20 40 60 80 100 120

Time [sec]

Time [sec]

20 40 60 80 100 120 140 160 180

200

0 20 40 60 80

Figure 2.21: Le module de la CWT pour une explosion chimique (a),

un séisme local (b) et un séisme lointain (c)

2.4.3 Scalogramme

Le scalogramme (SCAL: Scalogram) est l'équivalent dans la

classe affine du SPEC dans la classe de Cohen (sa version Q-constant [145]). Il

est donné par [107, 108]:

SCALø x : L2(R) ?

L2(R2)

(2.35)

x(t) ? SCALø x(a,t) = | CWT x ø (a,t)

|2

Il s'obtient aussi par un lissage de la WV du signal avec un

noyau qui est lui même la WV du signal de référence qui

utilise la transformée linéaire qui lui est associée

à savoir l'ondelette ø:

SCALø x : L2(R) ?

L2(R2)

x(t) ? SCALø x(a, t) = (2.36)

WVx(s, î)WVø(s-t

a , aî)dsdî

2ð

Le SCAL présente les mêmes

propriétés que celles du SPEC. Cependant, le SCAL est

préférable pour les signaux sismiques que le SPEC grâce

à la propriété Q-constant qui est adaptée à

la nature physique de ces signaux et même la raison de la

définition des ondelettes par Morlet et al. [222]. Ce point de vue est

repris par les articles de synthèse [56] et [190] en

géophysique.

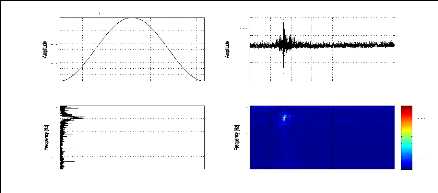

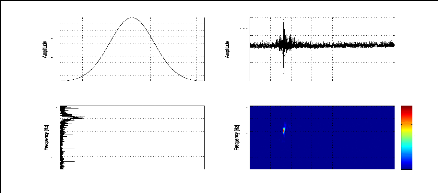

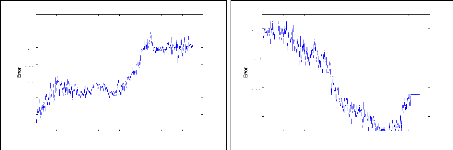

La figure (2.22) présente, respectivement, les

scalogrammes de trois événements sismiques: explosion chimique,

séisme local et séisme lointain pour l'ondelettes de Morlet,

l'ondelette chapeau mexicain et l'ondelette de Ben. Nous constatons qu'à

l'aide du SCAL, nous pouvons différentier entre les trois

événements sismiques de la même façon que le SPEC.

Cependant, le choix des échelles d'analyse pour chaque ondelette reste

un facteur essentiel pour avoir une meilleur représentation.

Généralement, ce choix est empirique mais cela n'exclut pas

l'existence de certaines suggestions comme celles présentées dans

[302]. De plus, nous notons que les SCALs relatifs au séisme local ne

sont pas tellement clairs pour pouvoir visualiser les composantes à

cause de la faiblesse du signal.

57

-200

-400

600

400

200

2

3

4

5

6

7

8

9

10

0

1

0 10 20 30 40 50 60 70

0 10 20 30 40 50 60 70

Es0001-TIS -2003-01-22 13:11:23

SCAL- Mexican hat wavelet

Time [sec]

Time [sec]

5 10 15 20 25 30 35

40

0 10 20 30 40 50 60 70

20

25

30

35

40 0

0 10 20 30 40 50 60 70

5 10 15

SCAL- Morlet

SCAL- Ben wavelet

Time [sec]

Time [sec]

wavelet

x 105

8

6

4

2

16

14

12

10

(a)

-1000

-1500

-2000

-500

1500

1000

500

10

2

4

0

6

8

0 50 100

0 50 100

Es0429-JBB -2005-05-06 02:47:39

SCAL- Mexican hat wavelet

Time [sec]

Time [sec]

5 10 15 20 25 30 35 40

5 10 15 20 25 30 35

40 0

0 50 100

0 50 100

SCAL- Morlet wavelet

SCAL- Ben wavelet

Time [sec]

Time [sec]

x 106

5

15

10

(b)

-1000

-500

1000

500

10 20 30 40 50 60 70 80 90 100

0

0 20 40 60 80 100 120

0 20 40 60 80 100 120

Es0319-CZDV-2005-09-16 00:50:27

SCAL- Mexican hat wavelet

Time [sec]

Time [sec]

20 40 60 80 100 120 140 160 180

200

0 20 40 60 80

20 40 60 80 100 120 140 160 180 200

0 20 40 60 80 100 120

SCAL- Morlet

SCAL- Ben wavelet

Time [sec]

Time [sec]

wavelet

100 120

x 107

5

4.5

4

3.5

3

2.5

2

1.5 1 0.5

(c)

Figure 2.22: Les scalogrammes relatifs à une explosion

chimique (a), un séisme local (b) et un séisme lointain (c)

2.5 Conclusion

Nous avons présenté dans ce chapitre les

différentes représentations possibles pour les signaux non

stationnaires en générales et les signaux sismiques en

particulier. Dans ce sens, des versions du principe d'Heisenberg-Gabor ont

été démontrées pour le cas du spectrogramme, la

représentation de Wigner-Ville et la transformée en ondelette

continue. Pour cette dernière, nous avons conçu une nouvelle

ondelette complexe dite ondelette de Ben permettant de mieux représenter

les signaux sismiques. En ce qui concerne l'analyse des performances de ces

représentations dans le cadre de la discrimination des signaux sismiques

via un système modulaire, le lecteur pourra se référer au

chapitre 5.

Nous notons que ce chapitre présente avec certains

détails les éléments de bases de ce qui est appelé

discrimination visuelle dans le logiciel MSSSA (Moroccan Software for Seismic

Signals Analysis) présenté dans l'annexe I.

La représentation des signaux non stationnaires dans un

espace bidimensionnel temps-fréquence ou temps-échelle conduit

généralement à des images de grandes dimensions en

fonction de la durée du signal, de la fréquence

d'échantillonnage et du nombre de points de la fenêtre d'analyse.

Ainsi, il est très difficile à les utiliser directement pour la

discrimination à cause du problème de la malédiction de la

dimensionnalité. Pour vaincre ce dernier et augmenter la

séparabilité des classes, une réduction de la

dimensionnalité de ces images s'avère nécessaire. Ce volet

fera l'objet du prochain chapitre.

CHAPITRE 3

REDUCTION DE LA DIMENSIONNALITE

Les représentations bidimensionnelles des signaux

sismiques dans les espaces temps- fréquence et temps-échelle

fournissent généralement des images de grandes dimensions. Or,

Les espaces vectoriels de grandes dimensions possèdent des

propriétés qui réduisent sensiblement les performances des

méthodes automatiques de classification à cause du

problème de la malédiction de la dimensionnalité (Curse of

dimensionality). Par conséquent, la réduction de la

dimensionnalité doit être une partie intégrante du

processus global de classification automatique des signaux sismiques.

Pour les signaux sismiques, à la différences des

autres signaux non stationnaires, les images fournies par les TFRs et les TSRs

sont de dimensions variables sur l'axe temporel. En effet, la durée des

événements sismiques diffère de l'un à l'autre

même pour des événements de même nature. Ceci est

dû au fait que la longueur du signal sismique enregistré est

lié aux instants d'activation et de désactivation de l'algorithme

de détection qui dépendent aussi de la magnitude et de la

distance hypocentrale de l'événement. Ainsi, pour avoir des

images sismiques ayant la même taille, tous les travaux

précédents font un découpage du signal en conservant des

durées bien déterminées avant et après le temps

d'arrivée. Or, avec cette méthode, on pourra enlever

l'information pertinente et, par conséquent, les performances de

classification se dégradent.