|

Septembre 2016

ECOLE SUPERIEURE D'INFORMATIQUE SALAMA

République

Démocratique du Congo

Province du Haut-Katanga

Lubumbashi

www.esisalama.org

GESTION DES CONFIGURATIONS D'UN DATACENTER BASEE SUR

PUPPET ET FOREMAN

« Cas de Katanga Networking Academy (KANACAD)

»

Travail présenté et défendu en vue de

l'obtention du grade d'ingénieur en réseaux

Par MUKEYA KIONGO Israël

Option : Administration

systèmes et réseaux

Septembre 2016

ECOLE SUPERIEURE D'INFORMATIQUE SALAMA

République

Démocratique du Congo

Province du Haut-Katanga

Lubumbashi

www.esisalama.org

GESTION DES CONFIGURATIONS D'UN DATACENTER BASEE SUR

PUPPET ET FOREMAN

« Cas de Katanga Networking Academy (KANACAD)

»

Travail présenté et défendu en vue de

l'obtention du grade d'ingénieur en réseaux

Par MUKEYA KIONGO Israël

Option : Administration

systèmes et réseaux Directeur : Bertin POLOMBWE

Co-directeur : Michée KALONDA

EPIGRAPHE

« En gestion, ce que l'on contrôle à

outrance nous contrôle et ce que nous ne gérons pas nous

gère ».

Sylvain Tourangeau

II

DEDICACE

A notre père MUKEYA TSHIBANGU Joseph, qui a fait preuve

d'un parent responsable, se débattant çà et là pour

que l'Ecole Supérieure d'Informatique Salama ne soit pas pour nous une

aventure.

A notre mère MBAYO KIONGO ILUNGA Germaine, pour tant

d'exonération et dont l'attention soutenue ainsi que les conseils ont

marqués notre itinéraire, qui au-jourd'hui se

révèle être le fruit d'une éducation

distinguée. Vous êtes pour nous le modèle parfait d'une

bonne mère.

MUKEYA KIONGO Israël

III

REMERCIEMENTS

Ce travail de fin d'études supérieures,

résultat de longue haleine, de la patience soutenue, fruit des

connaissances acquises, n'est pas l'affaire d'une seule personne.

Par ce biais, nous exprimons notre profonde gratitude à

l'égard de notre Dieu, qui n'a pas cessé de nous donner le

souffle de vie durant toute la période de notre formation jusqu'à

ce jour où nous avons le privilège de présenter ce

travail.

Nous remercions notre directeur et codirecteur, monsieur

Bertin POLOMBWE et monsieur Michée KALONDA, qui malgré leurs

multiples occupations, ont toujours su prendre soin de nous et nous montrer le

chemin à suivre.

Nos remerciements s'adressent une fois de plus à toute

les autorités académiques de l'Ecole Supérieure

d'Informatique Salama et plus particulièrement à notre

coordonnateur de filière, le master Patient KASONGO pour l'esprit de

recherche inculqué en nous.

Nous disons merci à nos très chers parents ainsi

qu'à nos frères et soeurs : Joseph MUKEYA et Germaine MBAYO

KIONGO, Simon Pierre et Claudia MUZAZA, Trésor et Péguy MAKANDA,

Patrick MUKEYA, Dan MUKEYA et Nathan MUKEYA pour toutes les dimensions des

soutiens manifestées en notre faveur.

Nous remercions également nos grand parents, oncles et

tantes : Baudouin et Céline MBAYO, Jeannette et Mike KYONY,

Gisèle et Louis LOSHITA, Michel et Yolande MBAYO, Jerry et Promesse

MBAYO pour leur assistance dans toutes les situations.

Nous remercions vivement Deborah KABILA, Lauraine KISULA,

David MUYUMBA, Léon BITULU et Franck ZALI, grâce à leur

soutien, amour et encouragements durant notre parcours, nous avons pu nous

accomplir pleinement dans nos études.

Nos remerciements s'adressent également à toute

l'équipe d'intercession de la Jeunesse Bonne Semence : frère

Alain, soeur Clarisse, papa Désiré, frère Aubin,

frère Cédron, frères Yannick et Patrick KISULA,

frères Mike et Durck pour tous les moments intenses de prières et

de partage sans oublié leur soutien.

Nous remercions vivement de tout coeur les ingénieurs :

Derick KHON, Luc KA-NIKI, Sam MWIMBI, Ferdos KAHENGA, Herbert KALONJI et

Christopher BAHUKA.

Du reste nous remercions nos amis et compagnons de lutte avec

qui nous avons passé des moments forts d'études : Elie KABUNDA,

Joël KAZADI, Chris KAHOZI, Chris MWEMBO, Ray's BUKASA, Job KAVU, Baudouin

BBK, Mira MBU, Yves MU-LOLWA, Samuel NUMBI, Jenny Gracia, Gloria KASH, LUNA,

Dan MUKOKA, Julie MULASI, Cyrille MPINGO, Yan NGUSU, Monique MPWETO et Marianne

KARUMB.

Et pour clore cette page nous adressons nos remerciements

à tous ceux, qui de près ou de loin ont contribué d'une

manière ou d'une autre à l'élaboration de ce travail et

qui n'ont pas vu leurs noms mentionnés ici, nous vous en supplions de ne

pas nous en tenir rigueur, nous vous portons à coeur.

IV

LISTE DES FIGURES

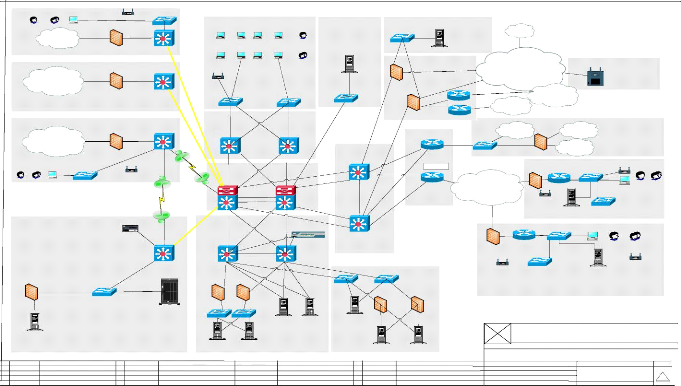

Figure 1.1 structure des académies Cisco 6

Figure 1.2 architecture générale de Katanga

Networking Academy 8

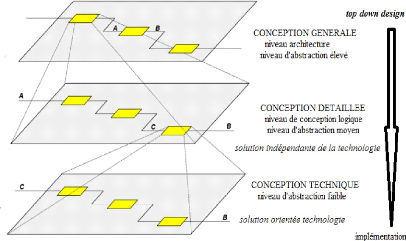

Figure 2.1 niveaux d'abstraction appliqués à

la conception [13, p. 6] 26

Figure 2.2 architecture générale du futur

système 29

Figure 2.3 interaction entre un client et le serveur DNS

32

Figure 2.4 processus d'acquisition d'une adresse IP via le

serveur DHCP 33

Figure 2.5 processus de signature du certificat d'un

client 35

Figure 2.6 interaction entre le gestionnaire des

configurations et les clients 36

Figure 2.7 processus de gestion des configurations

37

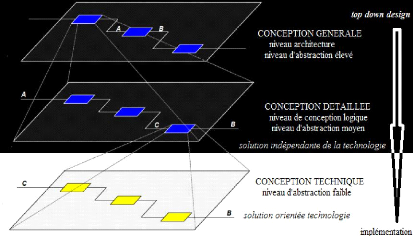

Figure 3.1 niveau d'abstraction de la conception technique

26

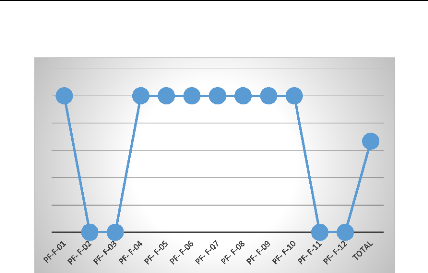

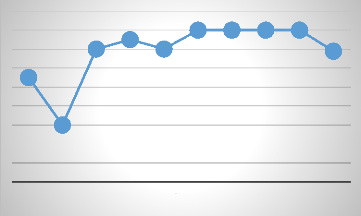

Figure 3.2 diagramme en bâtons 41

Figure 3.3 diagramme en courbes 41

Figure 3.4 principe d'utilisation de puppet 42

Figure 3.5 fonctions principales de puppet 43

Figure 3.6 fonctionnement de Foreman avec Puppet

46

Figure 3.7 architecture générale du

système au niveau physique 47

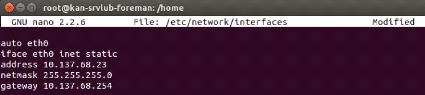

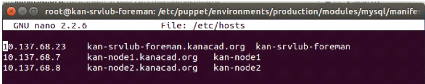

Figure 3.8 fixation de l'adresse IP du serveur 49

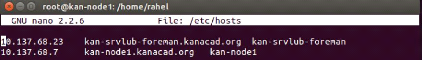

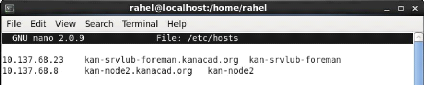

Figure 3.9 configuration du fichier hosts du serveur

50

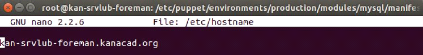

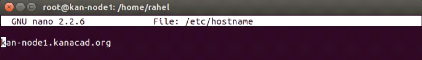

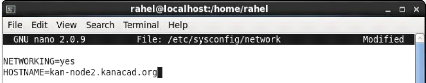

Figure 3.10 configuration du fichier hostname du serveur

50

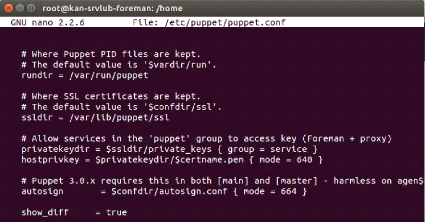

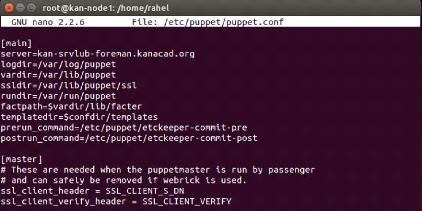

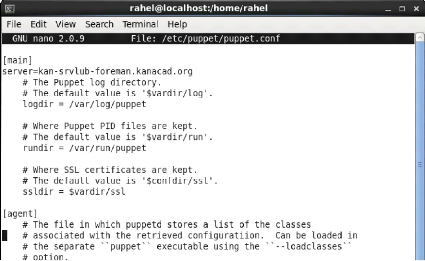

Figure 3.11 configuration du fichier puppet.conf du

serveur 50

Figure 3.12 création du domaine 51

Figure 3.13 création du proxy intelligent

51

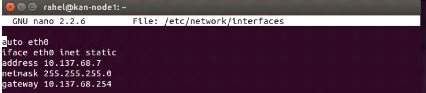

Figure 3.14 fixation de l'adresse IP du client Ubuntu

51

Figure 3.15 configuration du fichier hosts du client

Ubuntu 52

Figure 3.16 configuration du fichier hostname du client

Ubuntu 52

Figure 3.17 configuration du fichier puppet.conf du client

Ubuntu 52

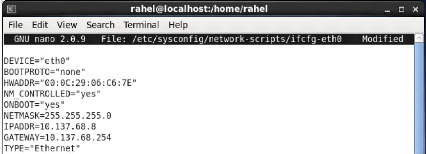

Figure 3.18 fixation de l'adresse IP du client CentOS

53

Figure 3.19 configuration du fichier hosts du client

CentOS 53

Figure 3.20 configuration du fichier network du client

CentOS 53

Figure 3.21 configuration du fichier puppet.conf du client

CentOS 54

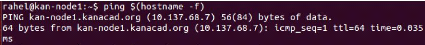

Figure 3.22 résultat attendu après test de

l'hostname 54

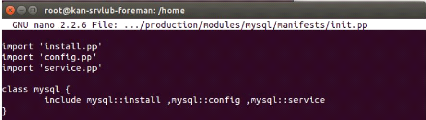

Figure 3.23 configuration du fichier init.pp du module

MySQL 55

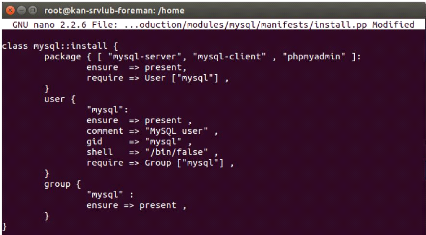

Figure 3.24 configurations du fichier install.pp du module

MySQL 55

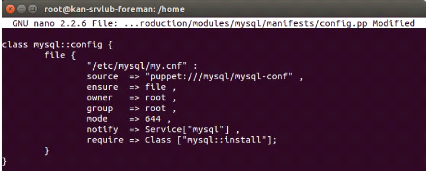

Figure 3.25 configuration du fichier config.pp du module

MySQL 56

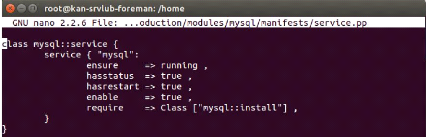

Figure 3.26 configuration du fichier service.pp du module

MySQL 56

V

VI

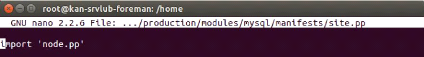

Figure 3.27 configuration du fichier site.pp du module

MySQL 56

Figure 3.28 configuration du fichier node.pp du module

MySQL 56

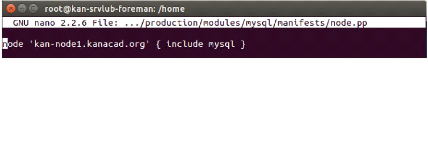

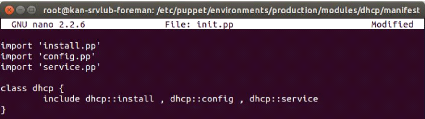

Figure 3.29 configurations du fichier init.pp du module

DHCP 57

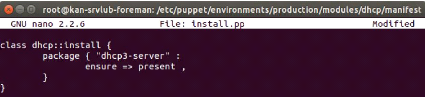

Figure 3.30 configuration du fichier install.pp du module

DHCP 57

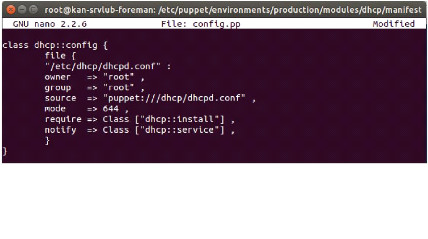

Figure 3.31 configuration du fichier config.pp du module

DHCP 57

Figure 3.32 configuration du fichier service du module

DHCP 58

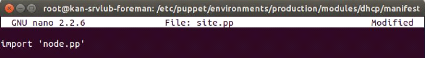

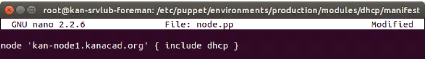

Figure 3.33 configuration du fichier node.pp du module

DHCP 58

Figure 3.34 configuration du fichier node.pp du module

DHCP 58

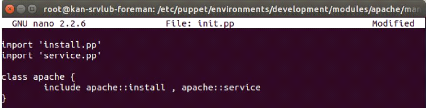

Figure 3.35 configuration du fichier init.pp du module

Apache 59

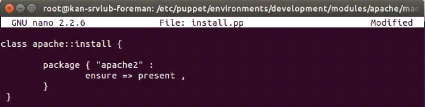

Figure 3.36 configuration du fichier install.pp du module

Apache 59

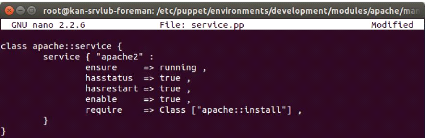

Figure 3.37 configuration du fichier service.pp du module

Apache 59

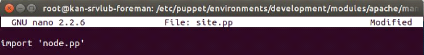

Figure 3.38 configuration du fichier site.pp du module

Apache 59

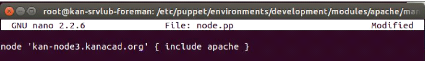

Figure 3.39 configuration du fichier nodee.pp du module

Apache 60

Figure 3.40 importation des classes puppet 60

Figure 3.41 résultat du test de connectivité

avec le serveur 61

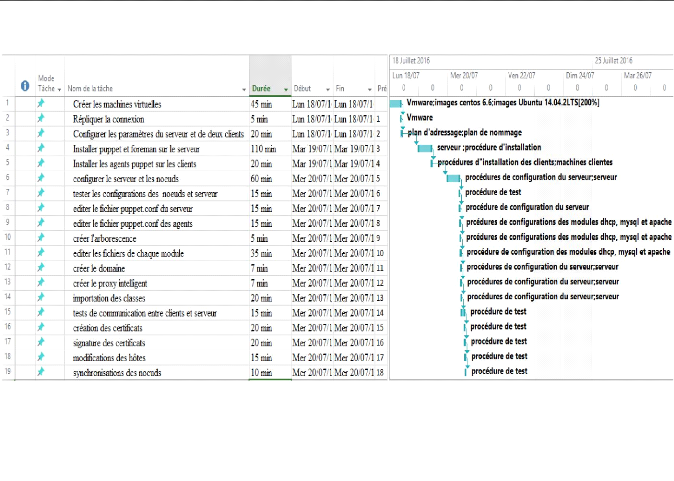

Figure 3.42 extrait du diagramme de GANTT pour la

planification de l'implémentation

65

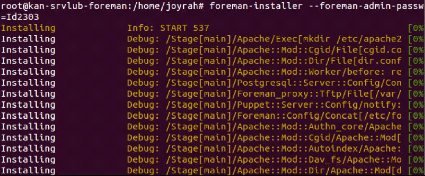

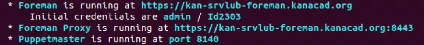

Figure 4.1 test d'installation de puppet et foreman

67

Figure 4.2 résultat du test après

exécution de foreman-installer 67

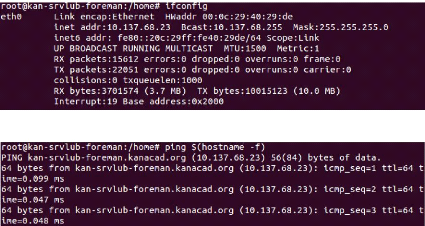

Figure 4.3 résultat du test des paramètres

IP du serveur 68

Figure 4.4 résultat du test de vérification

de l'hostname du serveur 68

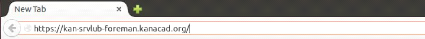

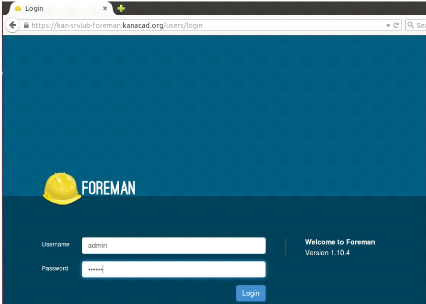

Figure 4.5 connexion à l'interface web de foreman

68

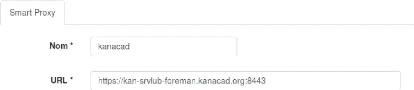

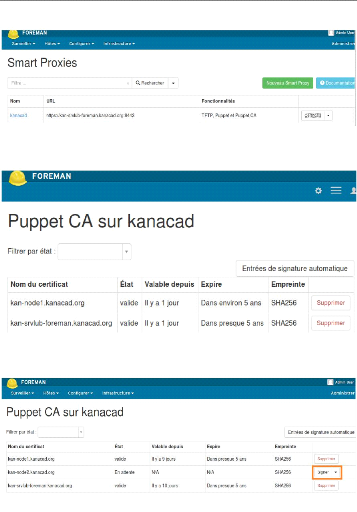

Figure 4.6 interface d'accueil de foreman 69

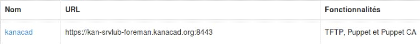

Figure 4.7 informations du proxy intelligent 69

Figure 4.8 résultat après création du

proxy intelligent 70

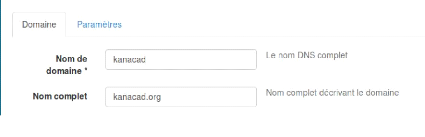

Figure 4.9 création du domaine

kanacad.org 70

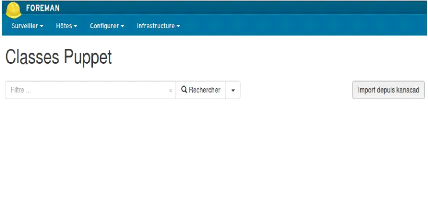

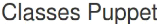

Figure 4.10 importation des classes 70

Figure 4.11 mise à jour des classes puppet

71

Figure 4.12 tableau des classes importées depuis

puppet 72

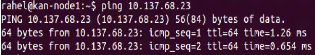

Figure 4.13 résultat du test de configurations des

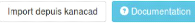

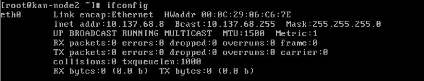

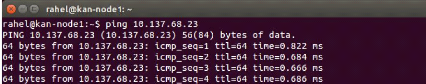

paramètres IP du client kan-node1 73

Figure 4.14 résultat du test de vérification

de l'hostname du client kan-node1 73

Figure 4.15 résultat de test de configuration des

paramètres IP du client kan-node2 73

Figure 4.16 résultat du test de l'hostname du

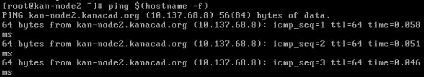

client kan-node2 74

Figure 4.17 résultat du test de connectivité

entre le client kan-node1 et le serveur 74

Figure 4.18 résultat du test de connectivité

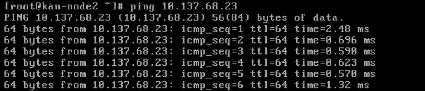

entre le client kan-node2 et le serveur 74

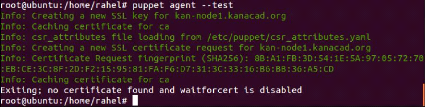

Figure 4.19 création du certificat sur le client

kan-node1 75

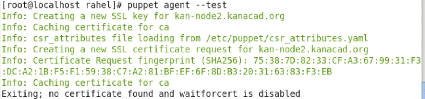

Figure 4.20 création du certificat sur le client

kan-node2 75

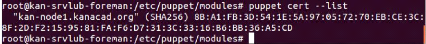

Figure 4.21 liste des certificats en attente de signature

sur le serveur 75

Figure 4.22 procédure de signature des certificats

76

Figure 4.23 signature de certificat du client kan-node1

76

Figure 4.24 signature de certificat du client kan-node2

76

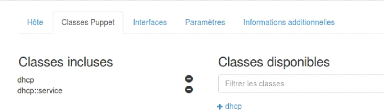

Figure 4.25 inclusion des classes dhcp et dhcp :: service

77

Figure 4.26 inclusion des classes du module Apache

77

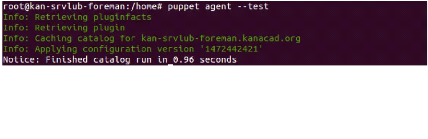

Figure 4.27 résultat du test de synchronisation du

serveur kan-srvlub-foreman 77

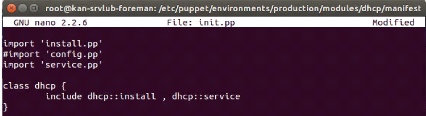

Figure 4.28 modification du fichier init.pp du module dhcp

78

Figure 4.29 résultat du test de synchronisation du

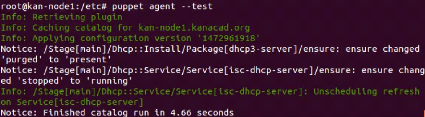

client kan-node1 78

Figure 4.30 résultat du test de synchronisation du

client kan-node2 78

Figure 4.31 résultat de test pour la visualisation

des noeuds gérés 79

Figure 4.32 résultat du test pour la visualisation

du tableau de bord 80

Figure 4.33 résultat du test de visualisation du

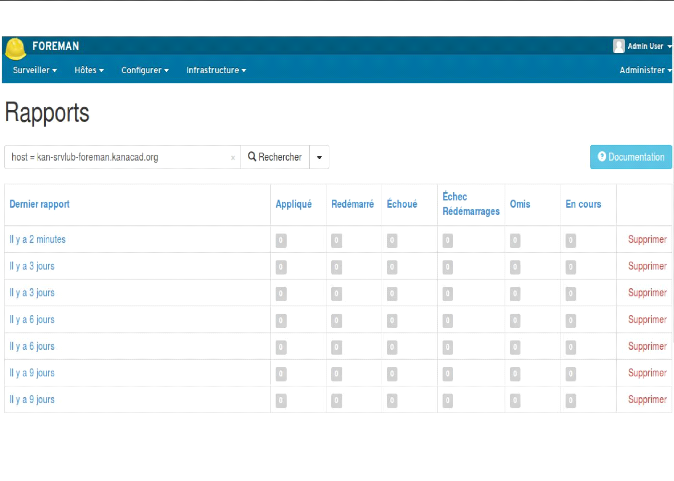

rapport global 81

Figure 4.34 résultat du test de visualisation du

rapport d'un noeud 82

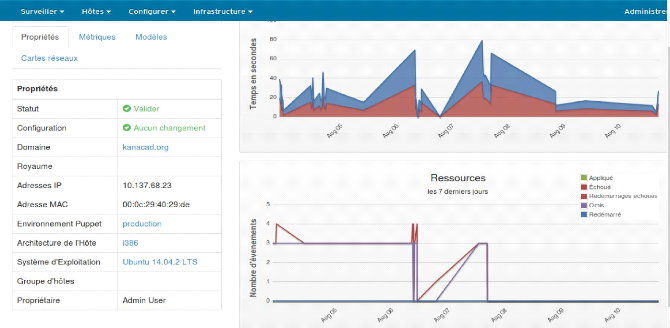

Figure 4.35 résultat du test de monitoring d'un

hôte 83

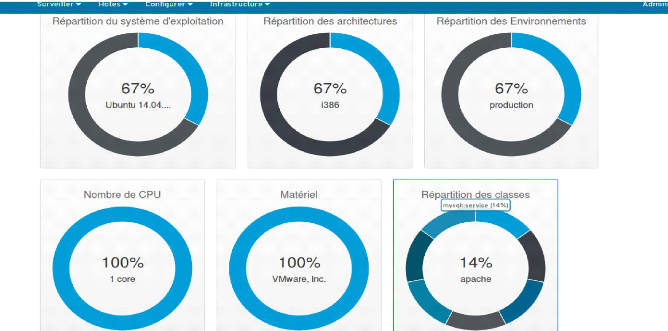

Figure 4.36 résultat du test de visualisation des

statistiques 84

Figure 4.37 résultat du test de visualisation de

l'audit sur l'ensemble du système 85

Figure 4.38 résultat du test de visualisation de

l'audit sur un noeud 86

Figure 4.39 graphique d'évaluation des besoins

fonctionnels 89

Figure 4.40 graphique d'évaluation des besoins non

fonctionnels 89

VII

LISTE DES TABLEAUX

Tableau 1.1 plan d'adressage 9

Tableau 1.2 plan de nommage 9

Tableau 1.3 supports de transmission utilisés dans

le LAN 10

Tableau 1.4 inventaire des équipements 14

Tableau 3.1 cotations des gestionnaires des configurations

40

Tableau 4.1 évaluation des besoins fonctionnels

87

Tableau 4.2 évaluation des besoins non fonctionnels

88

VIII

TABLE DES MATIERES

EPIGRAPHE I

DEDICACE II

REMERCIEMENTS III

LISTE DES FIGURES IV

LISTE DES TABLEAUX VII

TABLE DES MATIERES VIII

AVANT-PROPOS X

CHAPITRE 0: INTRODUCTION GENERALE 1

0.1. Problématique 1

0.2. Hypothèse 1

0.3. Choix et intérêt du sujet 2

0.4. Méthodologie 2

0.5. Etat de l'art 3

0.6. Délimitation du travail 4

0.7. Subdivision du travail 4

0.8. Outils logiciels et équipements utilisés

4

CHAPITRE 1: SPECIFICATIONS FONCTIONNELLES DU FUTUR

SYSTEME 5

1.1. Introduction 5

1.2. Présentation de l'association 5

1.3. Etude de l'existant 7

1.4. Spécification des besoins 22

1.5. Conclusion partielle 24

CHAPITRE 2: CONCEPTION GENERALE ET DETAILLEE LOGIQUE

25

2.1. Introduction 25

2.2. Conception générale 26

2.3. Conception détaillée logique 30

2.4. Conclusion partielle 38

CHAPITRE 3: CONCEPTION TECHNIQUE 26

3.1. Introduction 26

3.2. Choix technologiques 26

IX

3.3. Procédures et planification 47

3.4. Conclusion Partielle 66

CHAPITRE 4: IMPLEMENTATION 66

4.1. Introduction 66

4.2. Installation et configuration 66

4.3. Tests et résultats 74

4.4. Conclusion partielle 87

CONCLUSION GENERALE 90

Perspectives d'avenir 90

REFERENCES 92

X

AVANT-PROPOS

L'Ecole Supérieure d'Informatique Salama régie

par le programme national des institutions supérieures techniques,

prévoit des défenses des travaux ou projets à la fin des

cursus académiques des ingénieurs techniciens en informatique,

c'est dans cet ordre d'idée que s'inscrit ce travail de fin

d'études en administration systèmes et réseaux

intitulé « GESTION DES CONFIGURATIONS D'UN DATACENTER BASEE SUR

PUPPET ET FOREMAN ».

L'automatisation des tâches d'administration a toujours

été une des préoccupations majeures des administrateurs

systèmes, en plus de permettre un gain de temps, la

reproductibilité du processus de déploiement et une garantie du

résultat.

Avec l'arrivée de la virtualisation et l'augmentation

des services proposés aux utilisateurs, les parcs des serveurs sont en

forte expansion. Pour répondre à l'accroisse-ment du nombre des

plates-formes gérées, des nouveaux outils d'administration sont

apparus. Les logiciels de gestion des configurations et de déploiement

automatisé sont maintenant une alternative aux installations manuelles

ou réalisées à l'aide de scripts faits maisons.

Dans ce travail, nous faisons la conception d'un

système de gestion des configurations du parc des serveurs de Katanga

Networking Academy en partant des spécifications fonctionnelles du futur

système, de la conception logique générale et

détaillée du système, du choix des différentes

solutions technologiques et de la planification jusqu'à la mise en place

du dit système, composé de Puppet comme gestionnaire des

configurations et de Foreman comme gestionnaire de cycle de vie des

serveurs.

La compréhension de ce travail exige la lecture globale

de tous les quatre chapitres étant donné que la fin ou la sortie

de chaque chapitre constitue une entrée du prochain chapitre, chaque

cause placée dans le travail produit un effet dans le système.

TFE_ESIS_AS 2016

CHAPITRE 0: INTRODUCTION GENERALE

0.1. Problématique

L'augmentation du nombre d'étudiants,

d'équipements IP et des services (messagerie, web, stockage, etc..) au

sein des académies de formation de Katanga Networking Academy conduit

à la croissance de la taille de son centre de données, ce qui

fait que plus le réseau grandit, plus la gestion des configurations des

composants de ce dernier devient difficile. Ceci dit, nous nous sommes

posé deux questions en vue de pallier à ce problème :

1. Les taches de configuration étant pénibles

pour les administrateurs systèmes devant intervenir sur

différents serveurs du centre de données, que faire pour

permettre une configuration aisée de ces serveurs afin de réduire

le nombre d'erreurs ainsi que celui des tâches répétitives

?

2. Comment arriver à gérer le cycle de vie des

différents serveurs du centre de données tout en ayant une vue

globale sur ces derniers ?

0.2. Hypothèse

L'hypothèse est une réponse provisoire aux

questions posées dans la problématique. Eu égard aux

problèmes posés ci-haut, voici ce que nous proposons et optons

comme solutions provisoires :

1. Nous mettrions en place un outil qui nous permettra de

centraliser les configurations des systèmes, ce qui nous permettra :

? D'automatiser l'administration ainsi que de diminuer le

nombre d'erreur ;

? D'harmoniser et homogénéiser les configurations

pour gagner du temps, de la flexibilité ainsi que les performances ;

? D'appliquer les nouvelles configurations au fil du temps

;

? De s'assurer de manière régulière que les

configurations des différents noeuds correspondent bien à la

configuration voulue.

2. Nous mettrions en place un outil qui nous permettra de

gérer le cycle de vie des serveurs tout en générant des

rapports, statistiques, audits ainsi qu'effectuer des tâches

d'administration plus complexes et faire du monitoring de tous ces serveurs.

TFE_ESIS_AS 2016

2

INTRODUCTION GENERALE

0.3. Choix et intérêt du sujet

L'administration système et réseau est une

discipline en pleine croissance, responsable de la gestion des parcs

informatiques, de la maintenance logicielle et matérielle, de la mise en

place, du déploiement des systèmes et des configurations.

Étant étudiant dans ce domaine, à la fin de notre cycle,

nous devons proposer des solutions d'administration aux organisations, partant

de connaissances acquises tout au long de notre cursus académique,

l'intérêt que nous portons à ce sujet est subdivisé

en trois points, à savoir :

? L'intérêt personnel

Etant étudiant chercheur, nous nous sentons

attiré de manière consciente sur ce sujet et nous aimerions

travailler dessus pour approfondir nos connaissances ;

? L'intérêt scientifique

Ce travail n'est pas fait uniquement pour l'obtention du

diplôme d'ingénieur technicien en administration systèmes

et réseaux mais il se veut plutôt être une

référence sûre, fiable et satisfaisante pour les chercheurs

qui viendront après nous ;

? L'intérêt social

Après avoir constaté une nécessité

continuelle en matière de gestion des configurations dans le centre de

données de Katanga Networking Academy, croissant en étendue et en

nombre d'équipements réseaux, ce présent travail permettra

de réduire le temps de travail des administrateurs, ce qui leur

permettra de consacrer le temps restant vers d'autres tâches.

0.4. Méthodologie 0.4.1.

Méthodes

Une méthode est une démarche organisée et

rationnelle de l'esprit pour arriver à un certain résultat.

Pour permettre de garder le contrôle sur la suite de

notre travail, nous avons utilisé les méthodes suivantes :

? Top down design

Méthode procédant par décomposition du

problème, ce dernier ainsi divisé en un certain nombre des sous

problèmes, chacun de complexité moindre. Cette division est

ensuite appliquée aux sous problèmes

générés, et ainsi de suite, jusqu'à ce que la

résolution de chacun des sous problèmes soit triviale ;

TFE_ESIS_AS 2016

3

INTRODUCTION GENERALE

? L'implémentation

Méthode fondée sur l'expérience scientifique

et sur l'expérimentation, elle nous a permis d'implémenter la

solution, de vérifier et de tester l'hypo-thèse ;

? L'interprétation

Méthode fondée sur l'interprétation des

résultats obtenus lors des différents tests ;

? Traitement des résultats

Méthode basée sur les interprétations des

résultats obtenus lors de tests, si ces derniers ne correspondent pas,

chercher des solutions à mettre en place pour qu'ils correspondent

à nos attentes.

0.4.2. Techniques

? La documentation

Technique se basant sur l'ensemble des documents relatifs

à une question, elle nous a permis d'utiliser des livres, des sites

internet, des rapports ainsi que des revues, ces derniers nous ont permis

d'avoir de données relatives au sujet sur lequel nous travaillons.

? L'interview

Elle nous a permis d'avoir des échanges avec quelques

personnes susceptibles de nous apporter plus d'éclaircissement dans le

domaine qui concerne notre sujet, entre autre : les ainés scientifiques,

les administrateurs systèmes de Katanga Networking Academy et ceux

utilisant nos solutions sous d'autres cieux.

0.5. Etat de l'art

La science évolue du jour au lendemain, toutes les

nouvelles technologies font objets d'études dans le milieu scientifique,

nous ne prétendons pas en un seul instant être le premier à

traiter ce sujet et moins encore le dernier à travailler dessus.

Quelques personnes ont abordé des sujets similaires au nôtre,

c'est le cas de :

Ingénieur Christopher BAHUKA LENGE dans «

Etude et mise en oeuvre d'une administration système

automatisée et centralisée autour d'un gestionnaire de

configuration », 2010-2011.[1, p. 4]

Dans son travail il était question d'implémenter

un gestionnaire des configurations en vue de déployer en masse les

configurations sur les serveurs DNS LINUX dans les environnements de production

de l'office congolais de contrôle (OCC).

Ce présent travail se démarque de celui de

l'ingénieur Christopher BAHUKA dans ce sens que lui, en plus de se baser

sur un gestionnaire des configurations, il implémente

TFE_ESIS_AS 2016

4

INTRODUCTION GENERALE

un outil faisant office d'une interface web pour le

gestionnaire des configurations et qui, en même temps nous permet

d'effectuer des tâches d'administration compliquées et avoir une

vue globale sur tout le parc de nos serveurs.

0.6. Délimitation du travail

Dans le temps, il sied de noter que ce travail couvre la

période allant du mois d'octobre 2015 au mois de septembre 2016.

Dans l'espace, ce travail se focalise sur Katanga Networking

Academy comme cas d'application et se limite aux seules réalités

de cette dernière dont 99% des serveurs tournent sur Linux.

Nous nous sommes limités au déploiement en masse

des configurations sur les serveurs et gérer le cycle de vie de ces

derniers (approvisionnement, monitoring, visualisation des noeuds et la

génération des rapports, audits, statistiques pour toute

l'infrastruc-ture).

0.7. Subdivision du travail

Mise à part l'introduction et la conclusion

générale, notre travail s'articule sur quatre chapitres, qui sont

:

1. Le chapitre premier qui traite des spécifications

fonctionnelles du futur système que nous aurons à mettre en

place. Dans ce chapitre nous aurons à faire la description de notre cas

d'application, critiquer l'existant et enfin y ressortir les besoins

fonctionnels et non fonctionnels du futur système.

2. Le chapitre deuxième traite de la conception

logique du futur système, c'est-à-dire la conception

générale et détaillée logique du système

à partir des besoins recueillis dans la première partie, nous

allons résoudre le problème logiquement.

3. Le chapitre troisième quant à lui s'occupe

de la conception technique du système, c'est-à-dire des choix

technologiques, des procédures d'installation, de configuration, de test

ainsi que de la planification de l'implémentation. Après avoir eu

une solution logique, nous allons l'orienté dans les solutions

technologiques.

4. Le chapitre quatrième se focalise sur

l'implémentation de la solution, Il est question d'appliquer toutes les

procédures prévues et montrer les résultats émanant

de ces dernières.

0.8. Outils logiciels et équipements

utilisés

Dans l'élaboration de ce travail, nous avons pu

recourir à beaucoup d'outils logiciels qui ont donné forme

à ce dernier, c'est le cas de :

? Puppet Master version 3.8.7; ? Puppet agent version 3.4.3;

TFE_ESIS_AS 2016

5

INTRODUCTION GENERALE

? Foreman version1.10;

? VMware 12 Pro;

? Ubuntu 14.04 LTS;

? Microsoft Project 2013;

? CentOS 6.6.

TFE_ESIS_AS 2016

CHAPITRE 1: SPECIFICATIONS FONCTIONNELLES DU FUTUR

SYSTEME

1.1. Introduction

Afin de bien poursuivre notre travail et être sûr

de mettre en place une solution qui répond aux besoins en matière

de gestion des configurations, il nous est indispensable d'étudier

l'existant de façon générale.

Ce chapitre traite de la description de l'infrastructure

réseau du centre de données de Katanga Networking Academy sur ses

différents aspects et des spécifications des besoins fonctionnels

et non fonctionnels de ce dernier. C'est ainsi qu'à la fin de cette

première partie du travail, nous aurons une vue assez

générale sur toute l'infrastructure et nous aurons réuni

les différents besoins qui nous serviront d'entrée dans la

seconde partie de ce travail.

1.2. Présentation de l'association

Fondé en 1984 par Leonard Bosack et Sandra Lerner,

Cisco qui tire son nom de la ville de San Francisco aux Etats-Unis, est une

entreprise informatique qui oeuvre dans le domaine de l'interconnexion des

réseaux de données et dans lequel il est leader du

marché.

Dans le souci de réduire la fracture numérique

entre le nord et le sud, l'entreprise Cisco a mis sur pied un programme (Cisco

networking Academy) pour aider les organismes de formation et éducation

à produire des étudiants plus compétents. Ce programme

fournit aux étudiants les connaissances pratiques, techniques et

technologiques de base sur les systèmes réseaux et des

certifications industrielles.

KANACAD pour Katanga Networking Academy est une association

sans but lucratif qui dispense le programme Cisco networking Academy,

permettant de se préparer à une carrière dans les

technologies de l'information principalement les réseaux du

siècle présent et qui se fixe les objectifs ci-après

[2]:

? La vulgarisation des nouvelles technologies de l'information

et de communication via les concepteurs des technologies et cela de

manière officielle, c'est le cas de CISCO, Microsoft, etc. ;

? Réduire la fracture numérique entre les coins

et les recoins de la province du Haut Katanga en particulier et de la

République Démocratique du Congo en général ;

? Contribuer au développement des communautés

par l'accès aux nouvelles technologies de l'information et de

communication ;

6

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

? Acquérir, par la formation, les

divers outils de communication en renforçant l'autonomie des populations

locales et leur participation responsable à travers une économie

interconnectée à différentes échelles et à

tout niveau, comme par exemple la capacité de générer des

technologies ou encore, celle de rechercher et générer des fonds

;

? Renforcer les connaissances et les

compétences des communautés de base

par les technologies Cisco, Microsoft, Linux, Oracle, etc. ;

1.2.1. Situation géographique

Katanga Networking Academy est basée à

Lubumbashi dans la province du Haut Katanga en République

Démocratique du Congo, son siège principal se situe au

numéro 05 de l'avenue Lubumbashi, au quartier Makomeno.

1.2.2. Structure

La structure des académies CISCO se présente comme

suit :

CISCO

CATC

|

Académie

régionale

|

Académie

régionale

|

|

|

|

|

|

|

|

|

|

|

|

TFE_ESIS_AS 2016

locale

locale

Figure 1.1 structure des académies Cisco

Académie

locale

Académie

Académie

Académie

locale

? Cisco Academy Training Center (CATC)

Ce sont les centres d'académies Cisco qui font le relais

avec Cisco pour

former, assister et suivre les instructeurs des Académies

régionales et

locales ;

? Académie régionale

Fonctionne comme un point central supportant un minimum de dix

académies locales et établit un lien entre ces

dernières et le Cisco Academy

Training Center ;

? Académie locale

Entité qui dispense le curriculum Cisco Networking

Academy.

TFE_ESIS_AS 2016

7

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

1.3. Etude de l'existant

L'infrastructure se compose de trois sites distants : ?

Lubumbashi (le quartier général) :

Qui prend le coeur du centre de données et les

différentes interconnexions avec le local administratif de Lubumbashi et

les différents laboratoires de formation de l'académie CISCO ;

? Likasi

Relié à Lubumbashi via des liaisons WAN

jusqu'aux différents locaux de formation de Likasi ;

? Kolwezi

Relié à Lubumbashi via des liaisons WAN

jusqu'aux différents locaux de formation de Kolwezi.

L'interconnexion avec les sites distants est faite via les

liaisons Frame Relay1 en passant par l'opérateur des

télécommunications Vodacom.

Frame Relay permet un traitement efficace en volume et en

vitesse, en réunissant les fonctions des couches liaison de

données et réseau en un seul protocole simple. En tant que

protocole de liaison de données, Frame Relay permet d'accéder au

réseau en délimitant et en fournissant des trames dans l'ordre

approprié et détecte les erreurs de transmission grâce

à son contrôle de redondance cyclique standard.

En tant que protocole de réseau, il fournit plusieurs

liaisons logiques sur un même circuit physique et permet au réseau

d'acheminer les données sur ces liaisons jusqu'à leurs

destinations respectives.

1.3.1. Architecture 1.3.1.1.

Physique

L'architecture physique du réseau informatique de

Katanga Networking Academy se présente comme suit :

1 Est une évolution de la commutation des

paquets X25. Il établit, en mode connecté une liaison virtuelle

entre les deux extrémités. Cette liaison est soit permanente (PVC

pour Permanent Virtual Circuit), soit établit à la demande (SVC

pour Switched Virtual Circuit).

No Revision

User

Storage Server

User Group

Group

ASA

Blick

Gateway,

X25

Network,

Telco Switch

2G,3G,

Radio,Switch,

VAS/SMSC

Computer

IN,

Signaling

Computer

Access Switch

Remark

NearStore

CISCO1

Location 1

NearStore Client SW

C DIGITAL MEDIA ENCODER 1000

CISCO2

Access Switch

Wireless Access Point

ASA

ASA

ASA

Wireless Access Point

No Revision Remark

Network Cameras

SERIAL ETHERNET

SERIAL

)

Distribution Switch

Distribution Switch

Distribution Switch

Distribution Switch

Access Switch

NGN Location 2

Main Link To Mengo

Backup Link To Mengo

Wireless

ASA ASA

Most Secured Servers

(Billing

& VAS)

Computer ComputerComputer Computer

Computer ComputerComputer Computer Group

Access Point

SERIAL ETHERNET

ALL HQ Buildings, Floors and

Offices

Access Switches

Si

HQ Server Farm Module

HQ Building Distribution

Campus Backbone

Building Access

Revision

No

Distribution

Switches

Distribution Switches

WS C6509-E

WS 3750 G

Access Switches

Core Switches

WS 3760

WS 3750 G

0

IT Servers @bility

Si

WLAN Controller

User

General Architecture

Remark No Revision Remark

Power Status Alarm AP

CISCO 2100 SERIES

Wireless LAN Controller

Network Management

Module

Access Control Server,

Monitoring Server,

Syslog Server,etc...

Management Servers

Edge Distribution

Module

Distribution Switches

NetApp Filer

Storage and risk Management

Access Switch

Access Switches

Storage Server

ASA ASA

Internet Connectivity module

Access Switch

DMZ Module (Public Servers)

ASA

ASA

Risk Management

WAN Module

DMZ Servers (Exchange Front End)

WAN Router

WAN Hub

Router

WAN Router

Frame Relay Backbone For

remote sites

RAS

Access Switch

ASA

DESIGNED : Bertin Polombwe

APPROVED 1 :

CHECKED 1 : CHECKED 2 :

Wireless Access Point

ISP/INTERNET

LAN WAN Architecture Network Diagram

ASA

NGN Network TelcoNetwork

Telco 1

WAN Spoke Router

ADLS

Sites

Wireless Access Point

ASA

Dial-up Client ?

OR

VPN ??

DATE : DATE : DATE :

DATE :

WAN Spoke Router

SERIAL

Access Switch

DATE : 2012

FILE NAME :

File server likasi

GPRS Cabin &&

USSD Gateway

ISP

Access Switch

DRAWN :

File sever kolwezi

This segment is not well specified. Should it

be

on WAN or on the Campus backbone?

Computer User Group

LIKASI

CISCO AIRONET 1200 I WIRELESS ACCESS POINT

IS-HOTSPOT

FILE NAME :

NOC DATE : Oct 12, 2012

KOLWEZI

Wireless Access Point

Computer

Wireless Access Point

SERIAL

SERIAL

User Group

Revision

A

Figure 1.2 architecture générale de Katanga

Networking Academy

TFE_ESIS_AS 2016

8

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

TFE_ESIS_AS 2016

9

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

1.3.1.2. Logique

Sur le plan logique, nous allons donner le plan d'adressage et

le plan de nommage utilisés à travers les tableaux suivants.

Tableau 1.1 plan d'adressage

|

Sites

|

Adresses réseaux

|

Plages

|

Masques

|

|

Lubumbashi

Likasi

Kolwezi

|

10.137.68.0

10.137.69.0

10.137.70.0

|

10.137.68.1

10.137.69.1

10.137.70.1

|

- 10.137.68.254

- 10.137.69.254

- 10.137.70.254

|

255.255.255.0

255.255.255.0

255.255.255.0

|

|

Tableau 1.2 plan de nommage

|

|

|

|

|

Sites

|

Access point

|

Switchs

|

Routeurs

|

Serveurs

|

|

Lubumbashi

Likasi

Kolwezi

|

kan- aplub-

kan- aplks-

kan- apklz-

|

kan- swlub-

kan- swlks-

kan- swklz-

|

kan- rtlub-

kan- rtlks-

kan- rtklz-

|

kan-srvlub-

kan-srvlks-

kan-srvklz-

|

NB : Le plan de nommage est tel que la dernière partie

est réservée à la fonction ou rôle que joue

l'équipement dans le réseau, soit le nom de l'application

principale tournant sur le serveur, voir même un numéro

identifiant l'équipement par rapport à son emplacement, par

exemple kan-srvlub-ad est le nom du serveur situé à Lubumbashi

sur lequel tourne l'annuaire active directory.

1.3.1.3. Supports de transmission ?

WAN

Les ondes électromagnétiques sont

utilisées comme supports de transmission pour les liaisons entre les

différents sites moyennant des antennes VSAT2, qui permettent

la liaison avec l'opérateur des télécommunications

Vodacom, qui fournit des services pour le Frame Relay.

2 Very Small Aperture Terminal ou terminal à

très petite ouverture en français, désigne une technique

de communication par satellite bidirectionnelle qui utilise des antennes

paraboliques dont le diamètre est inférieur à 3

mètres.

10

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

· LAN

Tableau 1.3 supports de transmission utilisés dans le

LAN

Filaire Sans fil

Les câbles UTP3 de catégories 5, 6 ,

7 sont utilisés pour assurer l'interconnexion entre les

différents équipements réseaux et serveurs.

La fibre optique grâce aux haut débits qu'elle

offre est utilisée pour interconnecter les locaux éloignés

géographiquement et aussi pour les connexions

inter-serveurs.

Les signaux radio fréquence sont émis par

différents points d'accès afin de garantir une certaine

mobilité dans le système. La technologie sans fil utilisée

est le Wi-Fi4, avec simplicité comme principale

caractéristique, en dehors de cela, les fréquences

exploitées par ses techniques de transmission sont d'usage libres et ne

nécessitent pas de licence [3, p. 24]. Elle utilise le WPA5

comme solution de sécurisation du réseau sans fil.

TFE_ESIS_AS 2016

1.3.2. Eléments constitutifs

1.3.2.1. Sur le plan physique

Du point de vue physique nous avons :

· Faux plancher

Qui a pour fonctions de faire passer les câbles des

courants forts et faibles, la conduite d'air froid issu de la climatisation de

la salle qui provient des baies par des dalles percées (résultant

du principe d'alternance allée chaude - allé froide) et a aussi

pour fonction de soutenir les matériels ;

· Faux plafond

Permet le passage des câbles des courants

forts/faibles, la conduite de l'air froid issu de la climatisation de la salle

qui ressort par des bouches au plafond, la canalisation d'eau, la reprise de

l'air chaud dans l'allée chaude par des grilles placées

derrière les baies, l'air chaud est capté par les armoires de

climatisation dans le plénum du faux plafond, fixer les

différents équipements de sécurité et passer les

câbles associés (capteurs de température,

hygrométrie, détection d'incendie ainsi que de présence,

etc.), il sert aussi à intégrer l'éclairage ;

3 Unshielded Twisted Pair soit paire torsadée

non blindée en français.

4 Wireless Fidelity, est l'ensemble des protocoles

de communication sans fil régis par les normes du groupe IEEE 802.11

(ISO/CEI 8802-11).

5 Wi-Fi Protected Access est un mécanisme

pour sécuriser les réseaux sans fil de type Wi-Fi utilisant

l'al-gorithme de chiffrement TKIP (Temporary Key Integrity Protocol).

TFE_ESIS_AS 2016

11

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

· Système de détection d'intrusion et

d'extinction d'incendie (DEI)

Ce système a pour fonction de détecter les

départs de feu à l'intérieur des baies, des locaux

voisins, des faux planchers ainsi que des faux plafonds, il permet de

prévoir les asservissements de la climatisation, des contrôles

d'accès et des portes coupe-feu, ce système émet un signal

d'alarme déclenchant un plan d'évacuation, en même temps il

permet d'éteindre les incendies provenant dans les différents

endroits du centre de données ;

· Système de détection d'eau ou

d'humidité

Ce système a pour fonction principale de

détecter le plus vite possible les fuites d'eau, les infiltrations, les

défauts du système de climatisation de telle sorte à agir

avec la plus haute efficacité dans la protection des systèmes

;

· Système de contrôle et de

régulation de la température et de

l'hygro-métrie

Les équipements informatiques produisent une certaine

température lors de leurs fonctionnements et cette dernière est

limitée, il est donc important de maintenir la température

ambiante du lieu où se trouvent ces équipements autour d'une

vingtaine de degrés Celsius, telle est la fonction de

l'hygrométrie qui y arrive en climatisant la salle, en

réfrigérant les baies et les processeurs ;

· Alimentation électrique

Qui permet d'assurer d'une façon fiable l'alimentation

électrique des systèmes d'informations ;

· Alimentation sans interruption

Assure trois fonctions ; celle de la protection contre les

coupures électriques courtes (allant d'une dizaine des minutes

jusqu'à moins d'une heure) et contre les micros-coupures

électriques de l'ordre de quelques centièmes de secondes,

deuxièmement elle régule les niveaux haut et bas de tension du

courant électrique, du maintien de ses caractéristiques

alternatives (fréquence et forme sinusoïdale) ainsi que du filtrage

des harmoniques et enfin la transition tout en permettant la mise en route du

système d'alimentation de secours ;

· Redondance des équipements et des

alimentations

La redondance est un moyen utilisé à tous les

niveaux afin de limiter les risques des pannes. En résumé, chaque

élément est présent au moins en double et le basculement

se fait automatiquement en cas de panne, cela assure une haute

disponibilité ;

· Système de contrôle d'accès

et de surveillance

Ce système a pour fonction de contrôler

l'accès en vérifiant l'authentification via les badges, il est

couplé avec des ensembles mécaniques faisant obstruction au

passage libre, et des ensembles électroniques de détection

d'ouverture prolongée, d'effraction et/ou de

pénétration.

TFE_ESIS_AS 2016

12

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

1.3.2.2. Sur le plan réseau

Plusieurs éléments constituent la structure

réseau de l'infrastructure : ? Les baies

De type 42U, dédiées au

câblage ou mixtes câblage/équipements, accueillant les patch

panel, brush panel dans leurs parties hautes et les équipements actifs

dans leurs parties basses ;

? Les switchs

Relient plusieurs segments par câble ou par fibre

optique dans le réseau, répartis sur trois niveaux :

1. Coeur

Modèle CISCO Catalyst 6509-E, servent

à interconnecter d'autres switchs dits de concentration ou de

distribution, au nombre de deux, ils sont hyper fiables vu que sans eux rien ne

fonctionne, ils fonctionnent en parallèle, mais chacun d'eux

étant capable de gérer tout le trafic en cas de panne ou

d'arrêt quelconque pour modification de l'autre ;

2. Distribution

Modèle CISCO 3750 Avec

PoE6, distribuent le réseau aux switchs

d'accès, ils sont eux même raccordés au switchs coeur dit

de backbone ;

3. Accès

Modèle CISCO 2960-X 24 ports qui

délivrent le réseau aux utilisateurs et équipements

finaux.

? Les pare-feu

Qui sont matériels et logiciel, permettent de faire

respecter la politique de sécurité du réseau en

définissant les types des communications autorisées et

interdites, dans notre cas Pfsense est utilisé comme

pare-feu logiciel et Cisco ASA 5506-X comme pare-feu

matériel ;

? Les routeurs

De modèle Cisco 1921/K9 C1921, ce sont

les éléments intermédiaires permettant d'assurer le

routage des paquets entre les différents sites ;

? Les accélérateurs WAN

Permettant de réduire la quantité de

données circulant dans les deux sens à travers le WAN au moyen

des techniques de compression et de mise en cache de données ;

6 Power Over Ethernet (alimentation

électrique par câble Ethernet), est la technologie qui utilise les

câbles Ethernet RJ45 pour alimenter en électricité les

équipements PoE tels que les téléphones IP, les

caméras en même temps que la transmission des données.

TFE_ESIS_AS 2016

13

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

· Les équipements de liaison WAN

Fournit par la maison des télécommunications

Vodacom ;

· Les équipements d'accès à

Internet

Fournit par la maison des télécommunications

Vodacom ;

· Les points d'accès

Modèle Cisco AP541 qui permettent de

couvrir certaines zones avec des signaux sans fil favorisant ainsi la

mobilité ;

· Les contrôleurs sans fil

Modèle Cisco AIR-CT2504-5-K9

permettent de centraliser l'administration des différents

points d'accès ;

· Les serveurs

Modèle HP PROLIANT GEN8 RAM 64GB

faisant tourner des systèmes d'exploitation basés sur le

noyau Linux et Windows, permettant d'offrir différents services, ils

offrent aussi la possibilité de faire la virtualisation des serveurs

grâce à l'emploie d'un hyperviseur bare-metal7.

· Le câblage

Qui sont de deux types dans l'infrastructure :

ToR (top of rack) : consiste en la mise en

place d'un switch d'accès dans chaque baie pour offrir la

connectivité nécessaire à tous les serveurs qui y sont

rackés. Le but est de garder le plus gros câblage à

l'intérieur de la baie. Le seul câblage est celui des uplinks du

switch ToR vers les switchs de distribution.

EoR (End of rack) : contrairement à

la solution ToR, aucun switch ne se trouve dans les baies serveurs. A la place,

au bout de chaque rangée, un ou plusieurs switchs assurent la

connectivité de tous les serveurs de la rangée.

Voici un tableau qui reprends l'inventaire de quelques

équipements clés de l'in-frastructure réseau :

7 Hyperviseur de type 1 ou natif,

c'est un système qui s'installe directement sur la couche

matérielle de la machine. Cette plateforme est alors

considérée comme outil de contrôle du système

d'exploitation.

14

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

Tableau 1.4 inventaire des équipements

Sites Equipements Modèles Types de machine

nombre

Cisco Catalyst 6509 -E Physique 2

Switch Cisco 3750 Physique 8

Lubumbashi Cisco 2960 Physique

Routeur Cisco 1921/K9 C1921 Physique 5

Serveur HP PROLIANT GEN8 Virtuel & Physique 18

Cisco Catalyst 6509 -E Physique -

Switch Cisco 3750 Physique -

Likasi

|

Cisco 2960 Physique 2

Routeur Cisco 1921/K9 C1921 Physique 1

|

|

Virtuel 2

Serveur HP PROLIANT Physique 1

Cisco Catalyst 6509 -E Physique -

Switch Cisco 3750 Physique -

Cisco 2960 Physique 2

TFE_ESIS_AS 2016

TFE_ESIS_AS 2016

15

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

Kolwezi Routeur Cisco 1921/K9 C1921 Physique

1

Serveur HP PROLIANT

|

Virtuel 2

Physique 1

|

|

TFE_ESIS_AS 2016

16

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

1.3.2.3. Sur le plan système

Un système étant un ensemble

d'éléments interagissant entre eux selon certains principes ou

règles, il est déterminé par la nature de ses

éléments constitutifs, les interactions entre ces derniers, sa

frontière (critère d'appartenance au système) ainsi que

les interactions avec son environnement. Le centre de données de Katanga

Network Academy a en son sein plusieurs systèmes en fonction des

différents besoins.

Les systèmes serveurs Windows sont

propriétaires et offrent des procédures d'ins-tallation

facilitées par le recours à une interface graphique ergonomique,

l'installation peut aussi se faire en ligne de commande, ils jouent un

très grand rôle qui est celui de la centralisation grâce

à active directory et le contrôleur de domaine.

? Active Directory

Annuaire des objets du réseau, il permet aux

utilisateurs de localiser, de gérer et d'utiliser facilement les

ressources, il stocke les informations sur les objets comme les serveurs, le

domaine, sites, utilisateurs, ordinateurs, imprimantes. En somme, il permet la

centralisation des données, l'évolutivité, la

standardisation, l'extensibilité ainsi que la sécurité

;

? Contrôleur de domaine

Il stocke les données de l'annuaire et gère les

communications entre les utilisateurs et le domaine, y compris les processus

d'ouverture de session d'utilisateur, l'authentification et les recherches

d'annuaire. Il synchronise les données d'annuaire en utilisant la

réplication multi maître, assurant ainsi la cohérence des

informations en permanence.

Les systèmes basés sur le noyau Linux quant

à eux sont dits open source, ils offrent la possibilité

d'apporter des modifications à leurs codes source, ce facteur permet

d'améliorer la sécurité de ces systèmes, les

procédures d'installation diffère d'un système Linux

à un autre, les différents services sont

implémentés en ajoutant des packages en fonction du besoin, ainsi

la plupart des serveurs de l'infrastructure sont basés sur le noyau

Linux, c'est le cas de :

? IredMail Server

Qui se présente comme une mise en commun des

composants logiciels dont l'installation et la configuration sont

entièrement automatisées. Il permet d'obtenir très

rapidement un système de messagerie complet (relais de messagerie,

règles de messagerie, Webmail, anti-spam, etc.) ;

? Xivo Server

Qui est une solution open source de téléphonie

sur IP, offrant des services de communication unifiée et centre des

contacts, il est basé sur le célèbre moteur de

télécommunications Astérix et est distribué sous

licence GPL v3, il s'intègre dans les environnements

hétérogènes et convient à tout type d'architecture

[4]. Il dispose des fonctionnalités classiques d'un autocommutateur

téléphonique privé comme la messagerie unifiée,

serveur vocal interactif, conférence téléphonique,

contrôle depuis un ordinateur (CTI serveur), gestion de

répertoire, services internet, résultats

TFE_ESIS_AS 2016

17

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

statistiques, mobilité, auto-configuration, assistance

de bureau, centre de contact, etc. [5] ;

? BigBluButton Server

Logiciel libre sous licence LGPL permettant de

réaliser des conférences web qui sont utiles pour l'association,

il offre des fonctionnalités comme la création des espaces

virtuels de conférences multi-utilisateurs, le partage des documents, le

partage de bureau, communication via la conférence par voix sur IP,

webcam ainsi que le chat qui peut être privé ou public, tableau

blanc pour annoter les présentations, l'enregistrement des sessions pour

relecture en HTML8 5, etc. ;

? Tiki Server

Logiciel libre écrit en PHP et distribué selon

les termes de la licence GNU LGPL, c'est une application web de gestion de

contenu et de travail collaboratif proposant diverses fonctionnalités

supplémentaires comme le calendrier, forum, moteur de sondage, etc. ;

? Bacula Server

Logiciel de sauvegarde centralisée distribué

sous licence GPL, il prend en charge l'automatisation des sauvegardes totales,

incrémentales et différentielles, il prend également en

charge les opérations de restauration de fichiers et, dans certains cas,

de restauration à zéro (bare-metal recovery), il s'appuie sur une

architecture modulaire et distribué, il utilise un SGBD (MySQL,

PostgreSQL) pour la gestion des catalogues des sauvegardes et supporte beaucoup

des médias ( Disque dur, bandes magnétiques, prise en charge des

chargeurs de bandes, etc.) ;

? FreeNAS Server

Distribution Linux basée sur FreeBSD et dont le but

dans l'infrastructure est celui de créer un serveur de stockage

NAS9, elle propose des méthodes de partage CIFS10

pour Windows, NFS11 pour Linux et AFP12 pour Macintosh,

il propose aussi du FTP13 et TFTP14. Le protocole

ISCSI15 lui est intégré pour le stockage

réseau, en ce qui concerne ce dernier nous

8 HypertText Markup Langage, est le format de

données conçu pour représenter les pages web.

9 Network Attached Storage, désigne un

périphérique de stockage permettant de stocker et partager des

fichiers au travers d'un réseau, le plus souvent un réseau local

Ethernet, mais parfois au travers un réseau étendu de type

WAN.

10 Common Internet File System en français

System de Fichier Internet Commun, ancien protocole permettant le partage des

ressources sur des réseaux locaux de PC Windows.

11 Network File System en français

système des fichiers en réseau, est à l'origine un

protocole développé par Sun Microsystems en 1994 qui permet

à un ordinateur d'accéder à des fichiers via un

réseau. Il fait partie de la couche application du modèle OSI.

12 Apple Filing Protocol est un protocole de

partage de fichier utilisé sur Macintosh, il s'utilise

généralement à travers le port TCP 548, il fait partie de

la couche présentation du modèle OSI.

13 File Transfert Protocol ou protocole de

transfert des fichiers est un protocole de communication destiné

à l'échange informatique des fichiers sur un réseau

TCP/IP.

14 Trivial File Transfert Protocol ou protocole

simplifié de transfert des fichiers. Il fonctionne en UDP sur le port

69.

15 Internet Small Computer Interface est un

protocole IP destiné à relier les installations de stockage de

données.

TFE_ESIS_AS 2016

18

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

pouvons mettre en place un RAID16 logiciel ou

matériel car ils sont supportés ainsi que la gestion des

utilisateurs se trouvant dans l'annuaire Active Directory.

Outre les systèmes cités

précédemment, Internetworking Operating System de CISCO est le

système d'exploitation qu'utilisent les équipements de

l'infrastructure, il est muni d'une interface en ligne de commande accessible

via Telnet, port série, et SSH et peut aussi disposer d'une interface

web.

Différentes versions sont utilisées sur la

gamme des routeurs, switchs et point d'accès. Ce système a pour

particularité de prendre immédiatement tous les changements de

configuration en compte, de ce fait, il utilise deux espaces distincts qui

servent au stockage de la configuration dont le running-config stockée

en mémoire vive et qui contient la configuration actuelle

utilisée et startup-config stocké en mémoire non volatile

et qui contient la configuration au démarrage du matériel. [6, p.

10]

1.3.3. Sécurité

Dans les organisations possédant une structure

informatique conséquente, l'accès physique aux données et

aux composants du système d'information fait partie de la politique de

sécurité du même système d'information, il est plus

courant de penser à l'aspect technique/logique lorsque nous parlons de

la sécurité mais l'on oublie souvent de parler de l'accès

et de la protection physique, raison pour laquelle la sécurité

peut être divisée en trois branches en vue de la rendre la plus

optimale possible.

1.3.3.1. Sécurité physique

Le contrôle d'accès a une importance capitale en

ce lieu et c'est parmi les préoccupations majeures au sein de

l'infrastructure. Plusieurs solutions existent afin de contrôler les

identités du personnel accédant au Datacenter. Vu que la

sécurisation de ce dernier passe en premier lieu par la mise en place

d'un fonctionnement cohérent, il est tout d'abord essentiel de

séparer via des barrières physiques les locaux IT17,

techniques et télécoms. Tout cela dans le but de limiter

l'accès aux seules personnes habilitées.

L'accès aux installations est assuré via les

badges, la lecture des informations stockées par le badge d'accès

se fait lors du défilement sur le lecteur de ce dernier. Les

informations étant stockées dans une puce magnétique

située sur le badge. Les lecteurs de badges sont connectés aux

unités de contrôle d'accès qui assurent une

mémorisation locale de la liste des badges autorisés, des plages

horaires, les historiques et une gestion autonome d'accès même en

cas de déconnexion du réseau Ethernet, ces unités sont

raccordées au serveur via le réseau, les unités de

contrôle d'accès dialoguent avec le serveur mais aussi entre elles

pour assurer les interactions, asservissements et les données qu'elles

échangent sont sécurisées par un cryptage de

données. Les échanges de données entre

16 Redundant Arrays of Inexpensive Disks soit

regroupement des disques peu onéreux, est un ensemble des techniques de

virtualisation du stockage permettant de répartir des données sur

plusieurs disques durs afin d'améliorer soit les performances, soit la

sécurité ou la tolérance de l'ensemble du ou des

systèmes.

17 Information Technology (Technologie de

l'information).

TFE_ESIS_AS 2016

19

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

unité de contrôle d'accès et le serveur

se font par des trames UDP18 afin d'optimiser les échanges et

l'encombrement du réseau.

La vidéosurveillance reposant sur un système

numérique permet aussi de renforcer la sécurité,

grâce à des caméras placées sur différents

points à surveiller et sont reliées à un terminal qui

permet de visualiser les images fournies par toutes les caméras de

surveillance, toutes ces données sont stockées sur des

disques.

1.3.3.2. Sécurité réseau

Certes, le recours à la virtualisation et à

d'autres technologies nouvelles s'avère rentable, mais le rôle

capital que joue aujourd'hui le réseau fait qu'il soit essentiel de

remettre à plat la façon dont on le sécurise. Les choix

effectués en la matière peuvent avoir une incidence sur les

coûts d'exploitation d'aujourd'hui et de demain, la durée de

fonctionnement des services de sécurité et la précision

avec laquelle l'accès des utilisateurs à telle ou telle

application est contrôlé.

La solution open source Packetfense

fonctionnant avec une multitude d'équipe-ments sans fil et

filaire possède plusieurs mécanismes pour la gestion des

accès réseau de l'infrastructure tout en assurant les fonctions

suivantes [7] :

· L'enregistrement des composants réseaux ;

· La vérification de conformité des postes

présents sur le réseau ;

· La détection d'activités illicites ;

· La détection proactive de

vulnérabilités ;

· L'isolation des composantes réseau

problématiques ;

· Une gestion simple et efficace des invités sur le

réseau.

L'utilisation de Pfsense comme pare-feu

offre aussi plusieurs fonctions notamment la redondance et l'équilibrage

de la charge, un portail captif, donne des graphes concernant la charge

système et réseau, les tables d'état ou state table qui

contiennent les informations sur les connexions réseaux dans le but de

permettre l'acquisition d'un aperçu des connexions et surtout de

créer des règles, etc.

Le pare-feu Cisco ASA 5506-X grâce

à son module intégré Firepower qui supporte le mode en

ligne et le mode surveillance passive, le premier mode offre les avantages

supplémentaires que le deuxième mode, le module Firepower

déployé en mode en ligne fournit la meilleure analyse de

l'inspection approfondie de cas avant que les paquets soient renvoyés au

plan principal ASA. Il prend des mesures lorsque le trafic malveillant est

détecté.

Lorsque le trafic arrive à l'interface d'entrée de

l'ASA :

· L'ASA déchiffre le trafic si elle faisait partie

d'un tunnel VPN19 établie ;

18 User Datagram Protocol en français

Protocole de Datagramme Utilisateur, est un des principaux protocoles de

télécommunication utilisés par internet. Il fait partie de

la couche transport du modèle OSI, il appartient à la couche 4,

comme TCP.

19 Virtual Private Network ou réseau

privé virtuel est un tunnel garantissant l'exclusivité d'une

connexion entre un point A et un point B distant via un réseau non

sécurisé comme internet par exemple, l'accès à ce

tunnel est non seulement réservé mais aussi chiffré

(crypté).

TFE_ESIS_AS 2016

20

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

? Les paquets sont filtrés par rapport aux politiques

du pare-feu tels que ACL20, NAT21 et inspection ;

? En option, le trafic est envoyé au module Firepower

pour un contrôle plus profond (on peut configurer de sorte qu'on envoie

tout le trafic ou uniquement le trafic à haut risque au module Firepower

afin de conserver les ressources système) ;

? Après passage au Firepower le paquet est

renvoyé au moteur principal de l'ASA pour la prochaine étape de

décision de routage ;

? Le trafic est ensuite passé à l'interface de

sortie de l'ASA pour être transmis au reste du réseau.

1.3.3.3. Sécurité des postes de

travail

Symantec Endpoint Protection offre une protection plus rapide

et plus avancée contre les attaques sophistiquées et

ciblées qui existent sur les postes de travail faisant tourner les

systèmes d'exploitation Windows, les couches de protection incluent le

pare-feu, la prévention des intrusions, l'antivirus ainsi que les

technologies avancées insight et SONAR.

La technologie de surveillance insight de Symentec

basée sur la réputation protège contre les logiciels

malveillants en mutation tout en garantissant des temps d'analyse

réduits. SONAR quant à elle offre une protection puissante contre

les attaques zero day en surveillant le comportement des fichiers. [8]

1.3.4. Virtualisation

La virtualisation est l'ensemble des technologies

matérielles ou logicielles qui permettent de faire fonctionner plusieurs

systèmes d'exploitation et/ou plusieurs applications sur une même

machine, séparément les uns des autres, comme s'ils

fonctionnaient sur des machines physiques distinctes [9, p. 7]. Elle impacte

sur les domaines de stockage, application, système d'exploitation,

réseau et sécurité.

C'est une technologie de plus en plus incontournable, les

environnements virtuels sont très en vogue au sein des entreprises de

toutes tailles. Il est vrai que les avantages de cette technologie sont

nombreux en termes de productivité, de coûts et d'exploitation.

En effet, elle permet la baisse de coûts importantes

par la réduction du nombre des machines physiques, mais aussi par toutes

les autres économies induites : énergie, temps de mise en oeuvre

des systèmes.

Katanga Networking Academy utilise PROXMOX

comme solution de virtuali-sation bare-metal, elle s'installe

directement sur la couche matérielle du serveur hôte sans que

celui-ci n'ait un système d'exploitation tournant dessus, elle est open

source et est

20 Access Control List (Liste de contrôle

d'accès).

21 Network Address Translation en français

Traduction d'adresse réseau consiste à faire correspondre les

adresses IP internes non unique et souvent non routable d'un intranet à

un ensemble d'adresses externes uniques.

TFE_ESIS_AS 2016

21

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

basée sur les composantes OpenVZ22 et

KVM23. Elle permet la gestion des réseaux virtuels, du

stockage et la gestion centralisée de cluster ainsi que de la haute

disponibilité.

Le domaine de la virtualisation des serveurs consiste

à placer les postes clients légers peu encombrants et

sécurisés sur des postes de travail et à les relier sur

des environnements de travail virtualisés. Grâce à ces

derniers, Katanga Networking Academy met à la disposition de ses

utilisateurs des postes de travail sécurisés disponibles en

permanence depuis n'importe quel noeud du réseau. De plus nous pouvons

administrer à distance. Ils ont l'avantage de réduire les couts

liés à la maintenance des postes et à renforcer la

sécurité de ces derniers. [10]

1.3.4.1. Principales caractéristiques de

Proxmox

· Une interface web qui facilite un management de

l'environnement en un point,

· Les snapshots à chaud, qui permettent une

sauvegarde de l'état d'un serveur virtuel, ce qui donne la

possibilité de faire une migration à chaud (les fichiers

sauvegardés peuvent être transférés vers une autre

machine ou peuvent être utilisés pour la restauration) [11] ;

· Le regroupement de plusieurs noeuds au sein d'une

même entité est possible grâce à la fonction

clustering, elle permet d'assurer une haute disponibilité [11] ;

· Le module KVM étant créé pour le

noyau linux permet d'améliorer les performances des machines virtuelles

en faisant une émulation d'un ordinateur complet dans le but de rendre

le système indépendant de l'hôte ;

· OpenVZ est le noyau du système d'exploitation

qui se charge de l'isolation entre différentes machines virtuelles et

permet d'exécuter des applications dans des contextes différents,

ceci permet d'obtenir des meilleures performances ;

· Les ressources sont modifiables à chaud.

1.3.5. Critique du réseau existant

Vu la grandeur et l'évolution du réseau, nous

voyons que l'infrastructure mise en place par Katanga Networking Academy

connait des points forts et faibles.

1.3.5.1. Points forts

· Le réseau est très bien dimensionné

;

22 Est une technique de virtualisation de niveau

système d'exploitation basée sur le noyau Linux. Cette technique

de virtualisation de niveau système est souvent appelée

conteneurisation et les instances sont appelés conteneur. OpenVZ permet

à un serveur physique d'exécuter de multiples instances de

système d'exploitation isolés, qualifiées de serveurs

privés virtuels ou environnements virtuels.

23 Kernel-based Virtual Machine est un hyperviseur

libre de type 1 pour Linux. KVM est intégré dans le noyau Linux

depuis la version 2.6.20.

TFE_ESIS_AS 2016

22

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

· La virtualisation des systèmes qui réduit

les coûts ;

· La réplication des serveurs de fichier sur chaque

site ;

· Une très bonne mobilité grâce aux

différents points d'accès ;

· Une très bonne politique de sécurité

;

· Présence des VLAN24 qui segmentent

logiquement le réseau et augmentent le niveau de sécurité

;

· Présence d'un logiciel de gestion de parc

informatique. 1.3.5.2. Points à améliorer

· La répétition des mêmes tâches

par les administrateurs ;

· La mise à jour faite manuellement sur chaque noeud

;

· L'installation manuelle des logiciels, elle

nécessite le passage sur chaque noeud pour l'exécution de la

tâche ;

· La configuration des différents noeuds est

effectuée manuellement, elle nécessite donc de prendre le noeud

à distance ou aller sur place ;

· Le manque de serveur pour la centralisation de la

configuration des différents noeuds.

1.4. Spécification des besoins 1.4.1.

Introduction

Parmi les tâches des administrateurs systèmes

nous avons la mise à jour, le dépannage, la reconfiguration, le

débogage, la modification, etc., la configuration manuelle est

inadaptée à la croissance, répétitive,

génère des erreurs d'inattention, n'a pas d'historique

(documentation des interventions), n'est pas toujours reproductible de

façon fiable et requiert une grande rigueur surtout pour un travail en

équipe.

Par ailleurs la gestion centralisée par scripts ne

permet pas la gestion des erreurs, pose des problèmes pour

différentes architectures et différents systèmes

d'exploitation, évolue mal et n'est pas transposable ailleurs.

Étant donné le nombre des serveurs qui devient

de plus en plus élevé. Gérer ce nombre devient de plus en

plus difficile et exige l'augmentation du nombre d'heures

supplémentaires de travail des administrateurs et le nombre de ces

derniers.

Dans le but d'améliorer le quotidien des

administrateurs système, Katanga Networking Academy souhaite la mise en

place d'un système qui permettra de gérer plus facilement le parc

de ses serveurs, plusieurs avantages en découlent notamment :

· La gestion de manière efficace et

centralisée de la configuration de plusieurs machines tout en ayant la

souplesse de s'adapter aux spécificités de chacune d'entre elles

;

24 Virtual Local Area Network pour réseau

local virtuel en français, est un réseau informatique logique

indépendant.

TFE_ESIS_AS 2016

23

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

· L'homogénéité de la configuration

;

· La cohérence des configurations ;

· Le gain en temps, en performance et en flexibilité

;

· La diminution du nombre d'erreurs ;

· Automatisation des tâches répétitives

;

· La gestion de manière proactive des changements

;

· Un travail en équipe plus facile pour les

administrateurs système.

1.4.2. Spécification des besoins

fonctionnels

Les besoins fonctionnels permettent de ressortir une action

pouvant être menée sur l'infrastructure en réponse à

la demande.

En somme, après discussion avec les responsables de

Katanga Networking Academy sur ce grand nombre de serveurs à manager, il

en résulte que le nouveau système de gestion des configurations

de l'association devra être un système qui permettra aux

administrateurs systèmes de se concentrer sur l'écriture des

états de configuration à atteindre sur différents noeuds

et les affranchir des commandes propres à chaque système

d'exploitation pour arriver aux états désirés, pour ce

faire, nous aurons à :

· Implémenter un système pour la gestion

des configurations qui nous permettra de définir l'infrastructure comme

le code ;

· Implémenter un système qui permettra aux

administrateurs de gérer les serveurs tout au long de leurs cycles de

vie, de l'approvisionnement et de la configuration à l'orchestration et

la surveillance.

De ces deux implémentations, nous devons ressortir des

fonctionnalités devant répondre aux besoins posés par

Katanga Networking Academy, ces fonctionnalités sont :

· Authentification ;

· Ajout des nouveaux noeuds ;

· Regroupement des hôtes et les gérer

indépendamment des leurs emplacements physiques ;

· Gestion des versions des logiciels installés

;

· Synchronisation automatique des noeuds avec

l'état de configuration ;

· Génération des rapports ;

· Génération des statistiques ;

· Monitoring ;

· Audits ;

· Signature des certificats ;

· Résolution de noms ;

· Attribution automatique d'adresses IP.

TFE_ESIS_AS 2016

24

SPECIFICATIONS FONCTIONNELLES DU FUTUR SYSTEME

1.4.3. Spécification des besoins non

fonctionnels

Les besoins non fonctionnels sont ceux qui

représentent les exigences explicites ou contraintes internes et externe

auxquelles le système doit répondre, c'est ainsi, notre

système doit répondre aux critères ci-après :

· Utilisabilité ;

· Stabilité ;

· Performance ;

· Disponibilité ;

· Sécurité ;

· Portabilité ;

· Simplicité de mise en place ;

· Fiabilité ;

· Coût.

1.5. Conclusion partielle

L'étude que nous avons menée nous a permis de

mettre un accent sur les problèmes réels que rencontre Katanga

Networking Academy afin d'y ressortir le maximum d'idées qui nous ont

mené à la détermination des objectifs que nous devrons

atteindre dans ce présent travail. C'est pour cela que nous aurons

à proposer un système qui apporte des solutions aux

différents problèmes liés à la gestion des

configurations de l'infrastruc-ture.

La suite de notre travail nous mène dans la conception

générale et la conception logique détaillée qui

nous permettra de préparer le cadre pour le choix technologique de la

solution.

TFE_ESIS_AS 2016

CHAPITRE 2: CONCEPTION GENERALE ET DETAILLEE LOGIQUE

2.1. Introduction

L'étude de l'existant nous a permis de ressortir les

besoins et les fonctionnalités qu'aura le futur système. A ce

stade ce dernier parait comme une boîte noire qui encapsule tous les

mécanismes qui pourront répondre aux fonctionnalités

demandées, nous allons la décomposée en modules dans le

but de réduire son niveau d'abstraction.

Nous avons opté pour la méthode top down design

qui procède par décomposition du problème. Le

problème est ainsi divisé en un certain nombre des sous

problèmes, chacun de complexité moindre. Cette division est

ensuite appliquée aux sous problèmes

générés, et ainsi de suite, jusqu'à ce que la

résolution de chacun des sous problèmes soit trivial [12, Chap.

0].

Dans cette partie du travail, nous ferons la conception

générale de notre futur système qui repose sur le concept

de l'infrastructure comme code25 et nous ferons aussi une conception

détaillée logique qui nous permettra de diminuer le niveau

d'abstraction situé au niveau de la conception

générale.

2.1.1. Niveaux d'abstraction appliqués

à la conception

L'abstraction consiste à ne considérer que les

aspects jugés importants d'un système à un moment

donné, en négligeant les autres aspects.

Dans le traitement d'un problème complexe, il est

conceptuellement impossible de l'appréhender d'un seul bloc dans son

intégralité, notre esprit a besoin de dégrossir le

problème afin de le comprendre petit à petit. Une fois que ce

problème sera subdivisé en sous-problème de taille plus

petite, l'analyse de chacun de ces sous problèmes exige à en

comprendre les grandes lignes, ensuite de rendre plus fine sa

compréhension pour enfin comprendre tous les détails [12, Chap.

2]. L'abstraction permet une meilleure maitrise de la complexité, c'est

pour cela notre processus de conception sera divisé en trois phases :

? La conception générale ;

? La conception logique détaillée

;

? La conception physique ou technique.

25 Nouveau concept pour le contrôle et la

gestion des ressources hétérogènes. L'infrastructure comme

code permet de programmer des infrastructures.

TFE_ESIS_AS 2016

26

CONCEPTION GENERALE ET DETAILLEE LOGIQUE

Figure 2.1 niveaux d'abstraction appliqués à

la conception [13, p. 6]

La conception générale avec un niveau

d'abstraction élevé est en fait la description

générale du futur système qui nous permet de faire le

regroupement de tous les composants logiques de la solution qui sont faiblement

couplés entre eux et intervenant dans l'architecture du système,

ceci sera fait sans entrer dans les moindres détails sur la façon

dont ils sont regroupés.

La conception détaillée logique avec un niveau

d'abstraction intermédiaire ou moyen, identifie et inventorie les

composants logiciels nécessaires à l'implémentation de la

solution et décrit les relations existantes entre ces composants tout en

s'appuyant sur les exigences de qualité de service ou

fonctionnalités définies lors de la phase de spécification

des besoins. A ce stade nous ferons abstraction sur la façon dont les

différents composants logiciels seront implémentés.

Pour mettre fin à notre phase de conception, nous

réduirons à nouveau le niveau d'abstraction au plus bas niveau

via la conception physique afin d'offrir les détails maximums avec plus

des concepts de réalisation dans une solution technologique de gestion

des configurations reposant sur les principes de l'infrastructure

définit par le logiciel ou l'infrastructure comme code.

2.2. Conception générale

2.2.1. Adoption de l'infrastructure comme

code

L'infrastructure comme code autrement appelé

infrastructure définie par le logiciel (software defined infrastructure)

est un type d'infrastructure informatique que les équipes d'exploitation

peuvent gérer automatiquement via le code, au lieu d'utiliser un

processus manuel.

TFE_ESIS_AS 2016

27

CONCEPTION GENERALE ET DETAILLEE LOGIQUE

Le concept de l'infrastructure comme code est similaire

à la programmation des scripts, qui sont utilisés pour

automatiser les processus informatiques importants. Cependant, les scripts sont

principalement utilisés pour automatiser une série

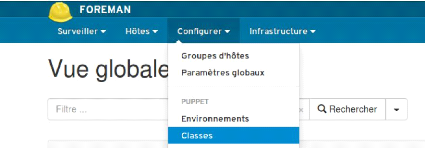

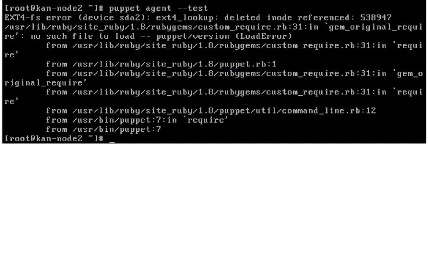

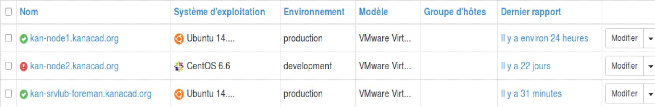

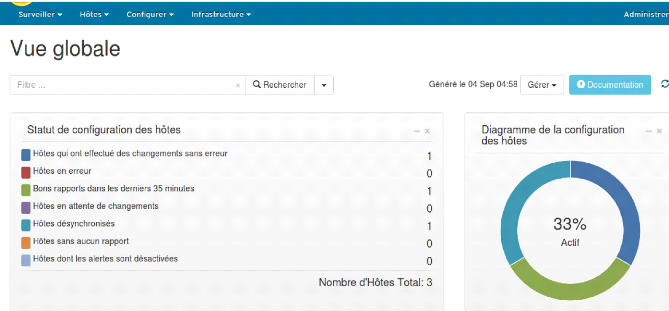

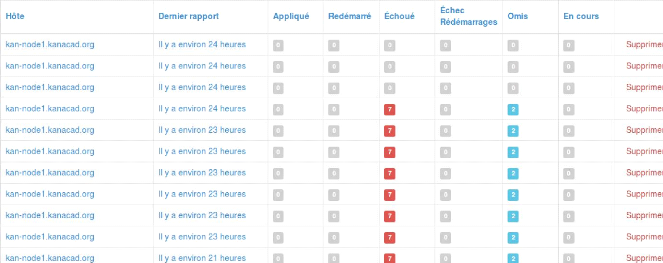

d'étapes statiques qui doivent être répétées