|

ANNEE ACADEMIQUE 2016-2017

UNIVERSITE LIBERTE

FACULTE DES SCIENCES INFORMATIQUES

ETUDE COMPARATIVE D'UN SYSTEME CLOUD

COMPUTING DANS LES

PRODUIT GMAIL, YOUTUBE ET

FACEBOOK

Par KONDO FUNDJI Paul

Dirigé par Professeur Blaise FYAMA Co-directeur : As.

Yannick ZAGABE

SEPTEMBRE 2017

UNIVERSITE LIBERTE

FACULTE DES SCIENCES INFORMATIQUES

ETUDE COMPARATIVE D'UN SYSTEME CLOUD

COMPUTING DANS LES

PRODUIT GMAIL, YOUTUBE ET

FACEBOOK

Par KONDO FUNDJI Paul

Travail présenté et défendu en vue de

l'obtention du grade d'ingénierie en Sciences Informatiques

Option : Réseaux et Télécommunication

Page | i

DEDICACE

A tout chercheur passionné de ce sujet ayant le

souci de bien vouloir l'approfondir, l'améliorer ou encore poursuivre

les recherches.

KONDO FUNDJI Paul

Page | ii

IN MEMORIUM

A mes regretté grand père,

grand-mère, tante paternelle et oncle : LEMBA PAUL, OKELE RACHEL,

ESAKALONGA LOUIS, LOKUTSHU JEAN PAUL, MABOKE ANDRE, LOSELE OSUNGU PASCAL,

LOSELE PASCAL PASSY, TORGA LOKOHO, OKITAFUMBA KOYANANA RAPHAEL pour Ca vie et

C'amour que vous avez semés en moi.

A ceux-Cà qui m'ont donné Ce gout des

études et Ce sens de Ca vie.

KONDO FUNDJI Paul

Page | iii

AVANT-PROPOS

L'expression de notre profonde reconnaissance s'adresse

à l'Université Liberté de nous avoir reçus dans son

installation et formés en qualité d'ingénieur en sciences

informatiques.

A notre Directeur, le professeur Docteur BLAISE FYAMA,

ainsi qu'au codirecteur, assistant YANNICK ZAGABE, qui en dépit de leurs

multiples occupations ont bien voulu accepter la direction de ce travail nous

leurs sont reconnaissant, ainsi qu'à tous les professeurs, chef des

travaux et assistants qui ont défilé devant nous, envie de nous

encadrés durant tout notre parcours à L'Université

Liberté nous vous disons merci.

A mes parents EKANANU LEMBA Henriette, DANGA LEMBA Vicky

et ANTHO LOWALO sans qui ce modeste travail n'aura pas pu voir le jour.

A mes soeurs et frères, OKELE DIVINE, LEMBA PENASHE

Paul, OKITA FUMBA Dode, OMEDIKONGA Nouveau, TAMBASHIE OKITAFUMBA Cezar,

LOKUTSHU ESAKALONGO Jean-Paul, DJANDE OKITAFUMBA Bénédicte,

TSHIATSHIAWO Claudine.

A mes cousins et cousines, OMADJELA Papy, DJOKO Sophie,

DIANA Passy, NONGOTAMBA Junior, FUNDA NAOMIE, FRANCYNE OHAKI, PRISCA OHAKI,

BELINDA OHAKI, DHO OHAKI, MARCELINE OHAKI, TERRE OHAKI, SAMI OHAKI, ainsi

qu'à tout la famille restreinte.

Sans oublier WITAKENGE JEANNOT et sa famille, TSHINYAMA

DECA et sa famille, ELOMBE JULIE et sa famille, KAVULU MATTHIEU et sa famille,

MUZINGU GEULORD et sa famille, pour tous leurs soutient matériel et

moral.

A mes amis et connaissances, NGOMA DOROTHE, MUKOMA DECO,

MBULUNGU CHADRACK, WITAKENGE MARTIN, KABUAYI MPOYI, BUKASA BUCKSON, NGALAMULUME

PATTY, KADIMA JACQUE, KALENGA JUSTINE, KAJIBA NATHALIE, MUKENDI TOY, NTUMBA

SALOMON, JULLE THAWED, NKOSI GRACE, KUMANDA GRACE,

Page | iv

KILONGOZI HERMESS, TRIBELDO TRIBUNAL, BOPE JCHRIS, MWEPA

ARSENE, MULOPO ARSENE, WAKAKA NICKQSIN, KADIATA VICTOR, MUKOMA ERICK, NKUFI

SMITH, KAJIBA NATHALIE, HIDRISS MWABILU, MADIA.

Nous n'allons pas terminer sans pour autant penser

à tous nos compagnons de lutte qui ont accepté

de faire route ensemble avec tant de courage et de labeur notamment, KABAMBA

DANIEL, KUPULA DIEUDONNE, KABUYI ISAAC, KYAMBEZI MATTHIEU, MOSENGO PATIENT,

MPOYI MIKE, KON VERONICA, KALUBISA JOHN, NTUMBA ELIE, KAPANGU FIDEL, KIMBEMBE

CHADRACK, MONGA MARDOCHE, KABUNDA JOSEPH, MWILAMBWE JEAN, CILOMBWE ABRINCE,

MOTATIANE JUNOIR, KANDANDA EMILIE ainsi qu'à toute la promotion

de grade II réseau et télécommunication.

Que tout le monde trouve ici l'expression de nos

sentiments d'indéfectible attachement. A Dieu le père

tout puissant pour le souffle de la vie.

KONDO FUNDJI Paul

Page | v

LISTE DES FIGURES

Figure 1 concept du cloud computing 7

Figure 2 services du cloud computing 11

Figure 3 cloud privé 12

Figure 4 cloud public 12

Figure 5 : Cloud community 13

Figure 6 cloud hybrid 14

Figure 7 Centre des données 17

Figure 8 architecture 3 Tiers 51

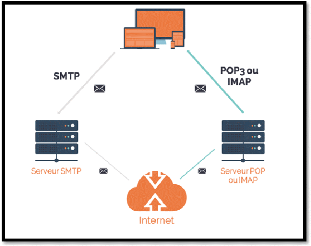

Figure 9 chemin de courrier électronique 52

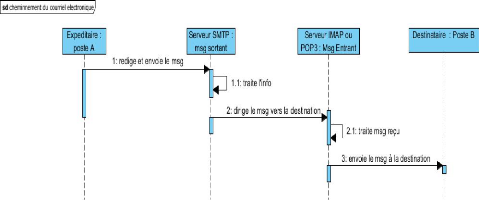

Figure 10 cheminement d'un courrier électronique 53

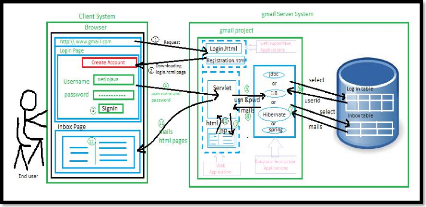

Figure 11 : Système Gmail 54

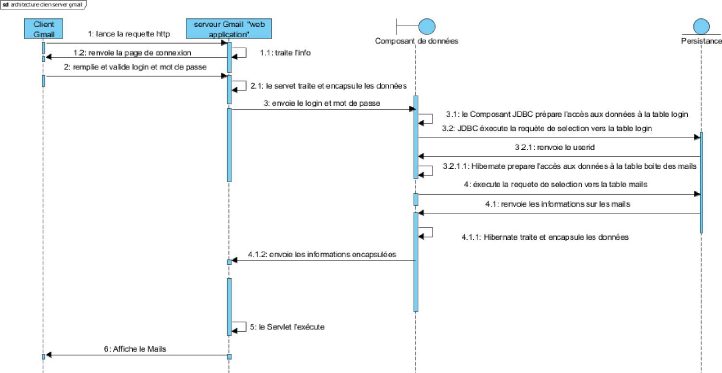

Figure 12 connexion Gmail 55

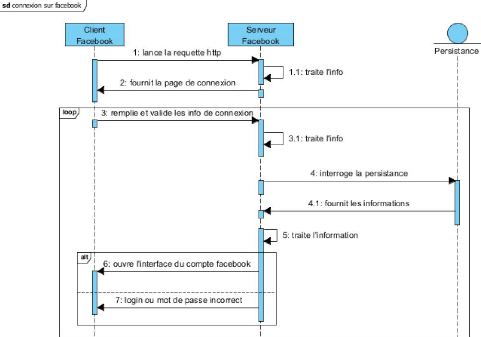

Figure 13 se connecter sur Facebook 56

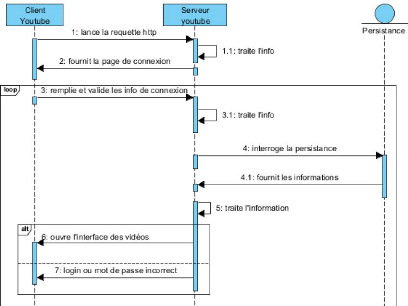

Figure 14 se connecter sur YouTube 57

LISTE DES TABLEAUX

Tableau 1 : comparaison San et Nas 23

Tableau 2 connexion au compte Gmail 54

Tableau 3 : Différentes protocoles 58

Tableau 4 : Comparative du point de vue convergence et

divergence 61

Tableau 5 : Comparative du point de vue capacité de

stockage 61

Page | vi

LISTE DES SIGLES ET ABREVIATIONS

1. ASP : Application Service Provider

2. API: Application Programming Interface

3. AOL: Amirica Online

4. AONT: All Or Nothing Transform

5. BGP: Border Gateway Protocol

6. CAAS: Communication As Service

7. CRM: Customer Relationship Management

8. CIFS: Common Internet File System

9. CNBC: Consumer News and Business Channel

10. CPU : Central Processeur Unit

11. DAAS : Database As Service

12. DAS: Direct Attached Storage

13. DCCO: Distributed Control Centralized Override

14. DNS: Domain Name System

15. E: Elastic Compute Cloud

16. ERP : Enterprise Resource Planning

17. EXIF : Exchangeable Image File Format

18. EO : Exa Octets

19. FAH : Fournisseur d'Applications

Hébergées

20. FSC : Fournisseur Services Cloud

21. FTP : File Transfer Protocol

22. FBML: Facebook Markup Language

23. GO: Giga octet

24. GPS: Global Positioning System

25. GWS: Google Web Server

26. HTTPS: Hyper Text Transfer Protocol Secure

27. IBM: International Business Machines

28. IGP: Interior Gateway Protocol

29. IAAS: Infrastructure As a Service

30. IT: Information Technology

31. IP: Internet Protocol

Page | vii

32. IMAP: Internet Message Access Protocol

33. IETF: Internet Engineering Task Force

34. MPLS: Multi-Protocol Label Switching

35. MDM: Mobile Device Management

36. NAS: Network Attached Storage

37. NAAS: Network As Service

38. NFS: Network File System

39. OSPF: Open Shortest Path First

40. PAAS: Platform As a Service

41. POP: Post Office Protocol

42. PC: Personnal Computer

43. PFS: Perfect Forward Secrecy

44. PHP: Hypertext Preprocessor

45. PNG: Portable Network Graphics

46. QOS: Quality Of Service

47. QUIC: Quick Udp Internet Connection

48. RAID: Raid Arry of Independent Disks

49. RDP: Remote Desktop Protocol

50. RAM: Random Access Memory

51. RTMP: Real Time Messaging Protocol

52. SAAS: Software As a Service

53. SAN: Storage Area Network

54. SSH: Secure Shell

55. SLA: Service Level Agreement

56. SSL: Secure Sockets Layer

57. SMTP: Simple Mail Transfer Protocol

58. SMS: Short Message Service

59. SOAP: Simple Object Access Protocol

60. SEO: Search Engine Optimization

61. UDP: User Datagram Protocol

62. TCP: Transmission Control Protocol

63. TIP: Telecom Ifra Project

64. TLS: Transport Layer Security

65. TO: Tera Octet

Page | viii

66. VG: Volum Group

67. VPN: Virtual Private Network

68. WEB: World Wide Web

69. XCP: Xen Cloud Platform

70. XML: Extensible Markup Language

71. XMPP: Extensible Messaging and Presence Protocol

Page | 1

INTRODUCTION GENERALE

Les jours, les mois, les années et le temps passent si

vite, les sciences informatiques évoluées dans une

compétition extraordinaire, dont chaque scientifique ou chercheur veut

faire le mieux possible dans l'évolution de la technologie des sciences

informatiques au profit de nos besoins pour une bonne amélioration et

efficacité. Vers 1969 l'un des principaux scientifiques du projet

ARPANET appelle Leonard Kleinrock déclara : `' Qu'à partir de

maintenant, les réseaux informatiques sont encore à leurs

balbutiements, mais à mesure qu'ils grandissent et deviennent

sophistiqués, nous allons voir probablement la propagation de services

informatiques qui devient comme les services d'électricité et de

téléphone, il servira toutes les habitations et tous les bureaux

à travers le pays `'. La vision de Leonard Kleinrock est de fournir les

services de l'informatique comme un service public, qui est aujourd'hui une

réalité grâce au cloud computing.

Depuis l'apparition de l'homme sur la terre, il est en

perpétuelle recherche du développement. Ce facteur lui a permis

de se démarquer des autres êtres vivants et de les apprivoiser.

Nous constatons que c'est plus aux cours de ces derniers siècles que

l'homme a vraiment connu un développement qui dépasse tout

entendement, il a pu effectuer des voyages interplanétaires, il arrive

à inventer la bombe atomique, l'automobile, découvert de

l'électricité, etc. Toutes ces réalisations d'un

être humain n'auraient pas pu être possibles sans l'essor de

l'électronique qui a déclenché celui de l'informatique.

Le cloud computing est une méthode qui propose des

différents types de services sur Internet, comme une application

logicielle livrée sur Internet (par exemple Google Drive). D'où

ça peut être une plate-forme de développement comme (Google

App Engine) sur lesquelles les utilisateurs peuvent créer leurs

applications. Il peut être un système d'exploitation (par exemple

Amazon E) ou les utilisateurs peuvent créer leur propre plate-forme et

logicielle. Tous ces services sont accessibles via la toile. Le cloud computing

permet de résoudre les problématiques lies à la

rareté des ressources informatiques comme le réseau, CPU, RAM

etc. Surtout ces dernières années les demandes ont

augmenté de la sorte très élevé.

Parlant du terme informatique qui a vu le jour en 1962 par

Philippe Dreyfus, l'homme ne s'est pas mis seulement de tout ce que les

systèmes de la technologie existante lui offrent en matière de

matériels physiques de stockages. Nous racontons la teinte des logiciels

étant donné que l'homme veux même la partie

matérielle demeure telle qu'elle eut

Page | 2

et que l'on se servait un plus du logiciel pour optimiser en

matière de support de stockage. L'informatique définie comme

étant le traitement automatique de l'information est aujourd'hui un

domaine indispensable, elle a trouvé sa place dans le monde et est

parvenue à le conquérir. Jadis, l'informatique ne se

prétend pas être transformatrice du système existant en un

nouveau système, mais elle vient juste automatiser les flux

d'informations qui existent déjà dans l'ancien système,

chose qui apporte un gain en temps et en couts. Etant dans un monde

compétitif, le temps est un facteur très important qu'il faut

utiliser à bon escient pour un développement intégral.

Le cloud computing grâce à son model

infrastructure as service permet aux personnes qui désire exploiter

l'entreprise en ligne de loué de l'espace virtuel machine et le fournir

le service à leurs besoins, il fournit les ressources informatiques

virtuelles Iaas apporte l'avantage de `' pay-per-use», ce marque

pay-per-use est facilement compris par comparaison d'utilisation d'un courant

électrique dont payer la quantité de consommation du courant

utilisé. De même Iaas permet aux clients de payer les ressources

utilisées, cela permet aux clients de n'est plus investir dans les

capitaux dans l'infrastructure informatique et le permet de concentrer sur leur

Qos à bien fournir à ses clients au lieu de penser à

l'approvisionnement et le sous-dimensionnement des ressources informatiques.

L'informatique comme étant la nouvelle et parmi tant

d'autres sciences, elle est devenue la grande science à l'heure actuelle

incontournable et permet de traiter des solutions possibles pour l'homme

à la société.

Le cloud avec son modèle Iaas appel cloud stakeholders

c.à.d. acteurs et intervenants de cloud sont-ce les fournisseurs et

utilisateurs du cloud, ils sont responsables de la mise en place de

l'infrastructure informatique et ces utilisateurs utilisent les infrastructures

fournie pour effectue leurs taches.

De nos temps, les grandes firmes développent des

technologies et des centralisations des données avec un transfert

énorme de flux d'information qui sollicite des matériels pouvant

offrir un bon débit. Nous avons plutôt besoin des bons

fournisseurs en matière de qualité des bons équipements et

en matière de logiciels. L'administrateur système doit assurer un

entretien continu de toutes ces fournitures que ça soit en software ou

hardware. Voici donc comment qu'intervient d'autre problème que celui de

la complexité de plates-formes des systèmes d'informations. Les

meilleures ou les avantages des uns aux autres peuvent nous profiter de

plusieurs manières tout en sachant que la concurrence est très

utile. Elle nous

Page | 3

conduit à développer une certaine

spécialité qui fera en sorte qu'une entreprise devienne

très utile et intéressante. Sans ignorer, nous savons que

l'informatique étant une science de traitement automatique de

données qui s'avère être trop bénéfique et

important dans tous les domaines qu'ils soient scientifiques, professionnels,

privés et/ou publics.

La plate-forme de gestion du cloud est un logiciel qui

convertit l'infrastructure informatique physique existent à

l'infrastructure de cloud, le nombre de la plate-forme commerciales de gestion

cloud augment beaucoup plus de la popularité de Iaas-cloud, tels que

vCloud, CloudForms, etc. des nombreuses contributions ont été

faites par la communauté open source associé à Iaas-cloud,

certaines plate-forme open source sont : XCP, Nimbus, Eucalyptus, Openstack et

OpenNebula. Pour résoudre le problème lié au choix de

plate-forme de gestion du cloud, un Framework doit être

développée. Le Framework regroupe les fonctionnalités

offertes par la plate-forme de gestion de différents types de cloud que

ce soit en open source ou commerciale afin de faciliter la comparaison. Ce

Framework donne trois avantages à savoir, il permet aux consommateurs

cloud de faire le choix de la plate-forme adapté au besoin

opérationnels, deuxièmement, les éditeurs de ces logiciels

de gestion c.à.d. les entreprises qui vendent leurs plate-forme, par

exemple OpenStack, Eucalyptus etc. Qui peut inclure des fonctionnalités

supplémentaires à leurs logiciels. Enfin les développeurs

de logiciels de gestion cloud c.à.d celui qui commence la

création d'un nouveau logiciel de gestion cloud peuvent commencer

à construire leurs logiciels en mettent les fonctionnalités

répertoires dans le Framework. Openstack et Eucalyptus sont l'un des

plates-formes populaires du cloud computing, en particulier le nombre de

consommateurs du cloud qui télécharger derniers sont plusieurs

milliers par mois.

En faisant l'étude d'observation dans des grandes

entreprises du monde aujourd'hui nous, nous rendons compte qu'elles

réalisent des travaux des plusieurs besoins dans peu de support et de

logiciel de la nouvelle technique que l'informatique apporte dans le Cloud

Computing, ainsi ce genre de travail ne s'effectue pas aux hasard ni à

la main, mais plutôt par des nouvelles technologies de la science de

l'informatique via ces supports et ces logiciels. Par contre la science du

traitement automatique de l'information, dans ses prouesses, nous apporte un

environnement qui a des technologies, des services et des applications qui

s'occupaient de gérer et superviser les fonctionnements sur le champ,

donc avec des bonnes parties de ces exigences (matérielle + logicielle)

et nous propose juste des fournitures comme : la distribution du courant

électrique et le service Internet.

Page | 4

C'est à juste titre que nous avons intitulé

notre sujet de recherche : « Etude comparative d'un

système Cloud Computing dans les produits Gmail, YouTube et Facebook

». Le choix de ce thème de recherche est porté

sur une évaluation des connaissances acquises tout au long du second

cycle de notre formation universitaire en sciences informatiques, en proposant

aux entreprises et aux particuliers comment est-il bon d'embrasser les

systèmes des services technologiques Cloud computing dans leurs

environnements pour être à la page de la modernisation à la

mondialisation qui pourront les aider dans leurs besoins à venir ; mais

aussi à faire un choix du point de vue stockage des données et

partage des informations dans le Cloud sur Gmail, YouTube et Facebook.

Ce sujet nous a permis d'affiner les connaissances sur les

fonctionnements et les réalités du déroulement des

processus de contrôle des technologies, et d'approfondir nos

connaissances acquises. La plupart des entreprises n'utilisent pas les

technologies Cloud Computing comme solution, nous chercherons plutôt

à faire en sorte que ça soit basé sur un minimum de

matériel, une bonne partie qui voudront conserver leurs libertés

en informatique puisse jouir de ces technologies présentes.

Ce travail est un couronnement du long parcours universitaire

de formation en tant qu'ingénieur en réseaux et

télécommunications à l'Université

Liberté en vue d'obtention du grade académique, et

clôture ainsi le long chemin de souffrance, peine, espoir et bonheur

d'études commencé pendant un certain moment d'une vie

académique pour l'étudiant ou étudiante. Nous voudrions

par ce travail de permettre aux futurs chercheurs intéressés par

cette question des circonstances digne pour leurs investigations et permettra

d'ajouter un plus aux sciences informatiques en vue de l'évolution de la

technologie de cette discipline, il nous permet aussi de nous conformer aux

exigences d'une formation universitaire en République

Démocratique du Congo.

Les trois produits Gmail, YouTube et Facebook sont des

services les plus populaires. En particulier, le nombre des utilisateurs

s'ajoute du jour au jour par mois. Certains des travaux existants se sont

focalisés sur la performance de ces plates-formes (OpenStack et

Eucalyptus) ou encore la solution déployée de messagerie Exchange

basée sur le stockage de cloud, dont l'impact sur la solution cloud au

sein de l'entreprise. Cependant, il y a peu d'attention sur la comparaison de

ces services.

Du fait que notre étude soit basée sur les

fonctionnements de la manière d'accéder aux différentes

plateformes à savoir Gmail, YouTube, Facebook et sur la façon

dont sont stocké des données.

Page | 5

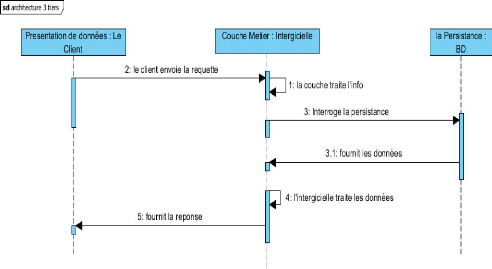

Les technologies d'internet Gmail, YouTube, Facebook

utiliseraient une architecture 3 tiers c'est-à-dire client/serveur. Dans

le cloud computing les données de Gmail et YouTube reposeraient sur

Google Drive et pour le cas de Facebook ses applications tourneraient sur sa

propre infrastructure cloud. Ainsi par cette magie de stockage de la

technologie Cloud computing, les données seraient stockées par

les fournisseurs qui offrent en plus une gestion sécurisée et

confidentielle de nos données.

Ce sujet d'étude, nous pousse au terme de

l'évolution de prendre la méthode d'analyse de fonctionnement de

différentes technologies. Nous utiliserons la méthode UML pour

représenter le fonctionnement logique des différentes

technologies.

Ce mémoire porte sur un grand objectif. Qui est celui

de montrer les différents fonctionnements sur les technologies Gmail,

YouTube et Facebook. A cet exercice, nous pensons pouvoir mettre à la

disposition des autres chercheurs un document qui leur servirait d'enrichir

leurs connaissances en rapport avec les technologies Internet.

Le reste de ce mémoire est organisé comme suit :

- Chapitre 1 : Concepts et terminologie du cloud computing,

- Chapitre 2 : Les technologies Internet dans la messagerie

électronique et les réseaux sociaux,

- Chapitre 3 : Etude fonctionnelle et comparative sur Gmail,

YouTube et Facebook.

A la fin nous résumerons notre mémoire avec une

conclusion générale.

Page | 6

CHAPITRE I : CONCEPTS ET TERMINOLOGIE DU CLOUD COMPUTING

INTRODUCTION

La technologie sur l'internet s'est développée

plus rapidement, au cours de cette dernière année, il y'a eu une

nouvelle destination et ayant pour but d'améliorer les services dans le

domaine de la technologie de l'information et de la communication. Il s'agit du

« cloud computing ». Ce dernier est un concept qui regorge

plusieurs technologies dans sa diversité qui sert à

délivrer différents services. Il peut être

schématisé par un ensemble indéterminé des

ressources informatiques interconnectées et une coopération dans

un réseau bien défini.

L'accès aux services se fait sur demande via une

application standard facilement disponible à savoir « un

navigateur Web ».

Ainsi, dans ce chapitre, nous allons présenter les

notions et les concepts fondamentaux du Cloud Computing.

1.1. HISTORIQUE

La faible performance des processeurs : capacités de

stockage et d'autres ressources employées dans les systèmes

classiques sont limitées et couteuses ; d'où ils ne permettent

pas l'accès à des services et des ressources de façon

rapide. Avec le développement actuel de la technologie, cela a ouvert la

voie à l'émergence du concept de cloud computing, qui permet donc

l'utilisation des serveurs plus efficaces et moins couteux, augmentant la

performance des connexions Internet lorsqu'ils deviennent plus rapides à

la demande des utilisateurs. La notion de ce service a été

proposée pour la première fois en 1961 lors de la

conférence au Massachusetts Institute of Technology par John McCarthy.

Il est également l'inventeur du langage Lisp dans lequel un groupe

d'ordinateurs se relient pour former un ordinateur virtuel unique permettant

ainsi le calcul de haute performance.

Salesforce.com fut le premier

hébergeur de cloud en 1999, suivi en 2002 par Amazon qui proposa un

ensemble d'hébergements d'applications et de stockages. Amazon va

développer ses services en 2005 (Amazon Web Service) et en 2006 (Elastic

Computer Cloud ou E). En 2007, Google, IBM et des universités

lancèrent un projet de recherche sur le cloud qui permet de lui faire

gagner en popularité et en consistance. C'est vers les années

2009 que surgir la réelle explosion du cloud avec l'arrivée sur

le marché de sociétés comme Google (Google App Engine),

Microsoft (Microsoft Azure), IBM (IBM Smart Business Service), Sun (Sun Cloud)

et Canonical Ltd (Ubuntu Enterprise Cloud).

Page | 7

1.2. DEFINITION

Le terme cloud désigne des ressources informatiques qui

sont mises en commun, puis redistribuées en fonction des besoins des

utilisateurs. National Institute of Standards and Technology en français

« Institut national des normes de la technologie », il

définit le cloud computing comme « l'ensemble des disciplines,

pratiques, technologies et modèles commerciaux utilisés pour

livrer un service sur demande et le réseau des capacités

informatiques (logiciels, plateformes et matériels) ».

Les définitions de cloud computing choisies dans

d'autres littératures :

? Le cloud computing : est un

concept qui consiste à déporter sur des serveurs distants des

traitements informatiques traditionnellement localisés sur le poste

client de l'utilisateur ;

? Génération NT :

« le cloud est un concept d'organisation informatique qui

place Internet au coeur de l'activité des entreprises, il permet

d'utiliser des ressources matérielles distantes pour créer des

services accessibles en ligne » ;

? Le cloud est un modèle qui offre aux utilisateurs du

réseau un accès à la demande, à un ensemble de

ressources informatiques partagées et configurables, aussi avec le cloud

n'importe qui peut entrer et à partir de n'importe quel endroit et

à tout moment ;

? C'est un concept abstrait, son but est de pousser les

entreprises à externaliser les ressources numériques qu'elles

stockent. Ces ressources offrant des capacités de stockage et de calcul,

des logiciels de gestion de messagerie, et d'autres services ont mises à

disposition par des sociétés tierces et accessibles, grâce

à un système d'identification via un et une connexion à

Internet.

Figure 1 concept du cloud computing

Page | 8

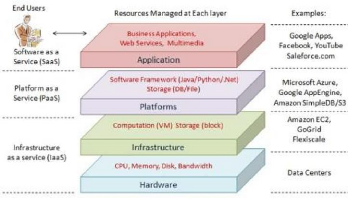

1.3. CONCEPTS DE BASE DU CLOUD COMPUTING

Il y a plusieurs services et modèles qui fonctionnent

en coulisse et qui rendent le cloud possible et accessible aux utilisateurs

finaux. Ainsi les modèles des travails pour le cloud computing sont :

? Modèles de services ; infrastructure as service

(IaaS), plateforme as service (PaaS) et software as service (SaaS).

? Modèles de déploiement ; cloud public, cloud

privé, cloud communautaire et cloud hybride.

1.3.1. MODELES DES SERVICES DU CLOUD COMPUTING

Il existe trois types des services principaux :

A. Infrastructure As A Service (IaaS)

En français `' l'infrastructure en tant que

service», c'est la mise à disposition par l'internet de machines

virtuelles aux ressources « facilement » modifiables à la

hausse et hautement disponible. L'entreprise loue ainsi des capacités de

traitement, de stockage rt autres ressources qu'elle peut structurer et

gérer de façon autonome cote logiciel des système

d'exploitation.

Pour des calculs complexes ou ponctuel (simulations

budgétaires, calculs prédictifs...) ou encore du stockage

(notamment dans le cadre de sauvegardes), les administrateurs de ressources

informatiques trouvent dans le cloud des environnements aux capacités

quasi illimitées et dont la mise en oeuvre est quasi

instantanée.

? Avantages :

- Offre une grande flexibilité ;

- Eviter d'achat et la gestion de matériel ;

- La possibilité d'installer tous types de logiciel ;

- Contrôle total des systèmes (administration

à distante par SSH ou RDP).

? Inconvénients :

- L'application du modèle du cloud computing pour les

infrastructures (ressources informatiques, serveurs, capacité de

traitement, stockage...) implique des changements d'organisation.

- La migration d'infrastructures existantes vers des

Infrastructures as a Service (IaaS) peut poser des problèmes techniques

délicats de compatibilité : la compatibilité des services

de stockage, la sécurité des machines virtuelles, la

sécurité des données, etc.

Page | 9

Parmi les prestataires d'IaaS, nous citons : Amazon avec E qui

est le roi de ce genre d'infrastructures, Gogrid et Terremark.

B. Platform As A Service (PaaS)

En français `' plate-forme en tant que service»,

facturée à la consommation, est un environnement qui permet

à l'entreprise de déployer ses propres applications en dehors de

sa salle informatique. L'entreprise loué un environnement middleware

à l'infrastructure masquée.

L'utilisateur gérer, mais ne contrôle pas

l'infrastructure cloud (réseaux, serveurs, systèmes

d'exploitation, stockage). Il a ainsi le contrôle sur les applications

déployées et la possibilité de configurer l'environnement

d'hébergement applicatif.

? Avantages :

- Le déploiement est automatisé ;

- Facilités à gérer des

développements des applications ;

- Ne nécessite pas une infrastructure.

? Inconvénients :

- L'utilisateur dépend fortement de l'infrastructure

et du logiciel du fournisseur. Par conséquent, il peut se retrouver

lié à un vendeur particulier sans possibilité d'en

changer. Par ailleurs, les éventuelles pannes ou les changements de

roadmap de développement d'un fournisseur peuvent compromettre les

projets des utilisateurs. Si un fournisseur cesse de prendre en charge un

langage de programmation particulier, les utilisateurs seront eux aussi

forcés de changer de langage, ou de faire appel à un autre

fournisseur. Dans les deux cas, il s'agit d'un regrettable contretemps.

Il y a plusieurs fournisseurs des services PaaS, les

principaux sont : Microsoft avec Azure, Google avec Google App Engine et Orange

Business Service.

C. Software as a service (SaaS)

En français `' l'application en tant que service»,

est accessible à toutes les entreprises et, il facturé au nombre

d'utilisateurs. L'entreprise loué les applications du fournisseur de

services. Plus besoin d'acheter un logiciel. Ces applications sont accessibles

via différentes interfaces, navigateurs web, clients légers.

Page | 10

De nombreux logiciels sont disponibles dans le cloud en mode

Saas.

? Messagerie : l'e-mail est certainement l'application la plus

utilisée en mode

cloud.

? CRM : la gestion de la relation client est l'autre application

phare du cloud.

? ERP : certains progiciels de gestion intégrée

sont en mode Saas.

? Collaboratif : les outils de collaboration (partage de

documents, réseaux

sociaux...) se fonctionnent bien au mode Saas.

? Avantages :

- Pas d'installation ;

- Pas de mise à jour ;

- Plus de License ;

- Paiement à l'usage ;

- Facilité de faire le test de nouveaux logiciels.

Les prestataires de solutions SaaS les plus connus sont :

Google avec Google Drive et Microsoft avec Office 365.

? Inconvénients suivants :

- L'entreprise perd son indépendance informatique. En

effet, le prestataire qui lui fournit le service possède les

applications et l'hébergement des données de l'entreprise ;

- Un autre inconvénient majeur est que le changement de

prestataire est souvent difficile car il met en cause le fonctionnement de

l'entreprise et nécessite le transfert de la base de données. Le

retour à un système interne et quant à lui long et

coûteux ;

- Enfin contrairement à ce qu'on peut penser, la

multiplication des applications sur les postes associés à la

durée du contrat (2 à 3 ans en général) peut

être coûteuse, le fonctionnement en mode SaaS peut alors devenir

nettement plus coûteux que l'acquisition de l'application.

Nous résumons les trois services principaux du cloud

computing avec la figure suivant :

Page | 11

Figure 2 services du cloud computing

Aussi bien, il existe d'autres formes de service du cloud

computing à savoir :

? Database as service (DaaS) en français `'Base de

données en tant que service» offre des fonctions traditionnelles de

bases de données, typiquement définition des données, le

stockage et la récupération sur une base d'abonnement sur web

;

? Communication as service (CaaS) en français `'

communication en tant que service», est un service de communication audio

et vidéo, services collaboratifs, communication unifiées,

messagerie électronique, messagerie instantanée partage de

donnée (web conférence) ;

? Network as service (NaaS) en français `'

réseau comme un service» fournir à l'utilisateur la

possibilité d'utiliser le réseau, les services de

connectivité de transport et inter-cloud services de connectivité

réseau. Parmi des modèles de NaaS, le modèle VPN `'

Réseau Privé Virtuel», il permet à un ordinateur

hôte d'envoyer et recevoir des données à travers des

réseaux partagés ou publics, comme s'il s'agissait d'un

réseau privé avec toutes les fonctionnalités et politiques

de ce réseau.

1.3.2. MODELES DE DEPLOIEMENT DU CLOUD COMPUTING

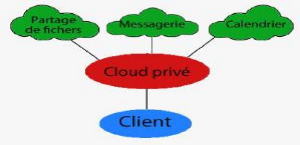

1.3.2.1. CLOUD PRIVE

En anglais `' private cloud» est un ensemble des services

et des ressources

disponibles à un seul client. Il est divisé en

deux cloud, cloud privé Interne qui est hébergé par

l'entreprise elle-même, ou bien avec sa branches, parfois partagé

ou mutualisé en mode privatif avec les filiales ; cloud privé

Externe qui est donc hébergé chez un tiers, il est

entièrement dédié à l'entreprise et accessible via

des réseaux sécurisés de types VPN.

Page | 12

Figure 3 cloud privé

1.3.2.2. CLOUD PUBLIC

En anglais `' public cloud» est un ensemble des services

et des ressources accessibles par Internet et géré par un

prestataire externe, ces ressources et ces services sont partagés entre

plusieurs clients qui utilisent sur demande et à tout moment sans savoir

où elles existent, ainsi ces services peuvent être gratuits ou

payants. Dans cette dernière possibilité, il existe des contrats

Service Level Agrement (SLA) entre les clients et les fournisseurs, SLA est un

document qui définit bien la qualité de service requis entre les

deux. Exemple de cloud public : Windows Azure Service Platform, Sun Cloud,

IBM's Bleu Cloud, Google App Engine, Amazon Elastic Compute Coud et Amazon

S3.

Figure 4 cloud public

Page | 13

1.3.2.3. CLOUD COMMUNAUTAIRE

En anglais `' Cloud Community» est un ensemble des

infrastructures qui permet à plusieurs clients ou organisations de

partager les différentes ressources qui ont des besoins communs, ces

ressources sont généralement spéciales à des

organisations, ce type de cloud peut être géré par ces

organisation elles-mêmes ou par des fournisseurs externes. Ainsi il

permet à un groupe d'utilisateurs de créer leur propre Cloud avec

des caractéristiques de Cloud privé tel que la

sécurité, ressources dédiées et un cout

réduit. Le cloud communautaire peut héberger une application

métier très spécialisée, mais commune à

plusieurs entités qui décident de fédérer et la

gérer, ce cloud est donc plutôt dédié à une

communauté professionnelle spécifique incluant partenaires,

sous-traitants...pour travailler de manière collaborative sur un

même projet ou cloud gouvernemental dédié aux institutions

étatiques.

Figure 5 : Cloud community

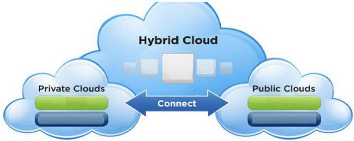

1.3.2.4. CLOUD HYBRIDE

En anglais `' Hybrid Cloud» est une composition de deux

ou trois types de cloud (Privé, Communautaire et Public). Ces

infrastructures sont liées entre elles par la même technologie qui

autorise la portabilité des applications et des données, exemple

l'utilisation des applications dans un cloud public mais ces derniers

nécessitent des données stockées sur un cloud

privé.

Page | 14

Figure 6 cloud hybrid

1.4. CARACTERISTIQUE DU CLOUD COMPUTING

· Elasticité : il a des

capacités illimitées qui peuvent être augmentées ou

réduites selon l'usage. Par exemple lorsque la personne effectue ses

achats en grande surface, elle choisit non seulement la qualité des

produits qu'elle souhaite mais aussi la quantité. Cette dernière

peut donc variée d'une semaine à l'autre en fonction de besoins.

Il est possible de faire l'analogie de cloud non seulement sur le choix des

ressources à consommer par le client, mais aussi en

déterminé la quantité. Ce qui justifie donc la variation

de celle-ci peut à tout moment.

· Self-service : la capacité

à fournir une ressource informatique automatiquement sans recourir

à l'interaction humaine comme fournisseur. Dans un supermarché,

les clients opèrent leurs choix sur les produits qu'ils souhaitent sans

l'aide du commercial. Ce principe se retrouve également dans le cloud

dont les utilisateurs ont accès à un catalogue de service choisi

et qu'il souhaite consommer.

· Pay-as-you-use : les clients cloud

recevront des tarifications les plus précises pour les ressources qu'ils

utilisent. Par exemple la tarification d'Amazon pour les micro machines

virtuelle 0.02$ par heure et 3.10$ par heure pour des grosses machines

virtuelles.

· Mesure de la qualité de services :

évaluer et garantir un niveau de performance et de

disponibilité adaptées aux besoins spécifiques des

clients.

· Accès réseau universel :

l'accès aux ressources est très rapide à travers

un réseau, par des protocoles standards de façon très

élastique.

· Mise en commun de ressources :

Datacenter fournissant les ressources (machines, stockage etc...) pour

les différents clients en mode partagé.

· Multi-tenancy : la capacité de

fournir un service simultanément à plusieurs clients, cela permet

d'augmenter l'utilisation des ressources IT déployée.

Page | 15

? Disponibilité : la haute

disponibilité de la plate-forme est obtenue par redondance et par la

capacité de se remettre rapidement en cas des problèmes.

? Green IT : est un concept qui

décrit l'ensemble des nouvelles technologies à faible impact

environnemental. Le cloud computing, basé sur la virtualisation, qu'il

réduise les risques des machines physiques sur un environnement et sa

consommation énergétique.

1.5. ELEMENTS CONSTITUTIFS DU CLOUD COMPUTING

1.5.1. INFRASTRUCTURE

L'infrastructure du cloud est un assemblage de serveurs,

d'espace de stockage et de composants réseau organisés de

façon à permettre une croissance incrémentale

supérieure à celle que l'on obtient avec les infrastructures

classiques. Ces composants doivent être sélectionnés pour

leur capacité à répondre aux exigences

d'extensibilité, d'efficacité, de robustesse et de la

sécurité. Les serveurs d'entreprise classiques ne disposent pas

des capacités réseau, de la fiabilité ni des autres

qualités possibles pour satisfaire efficacement et manière

sécurisée les accords de niveau de service SLA (Service Level

Agreement). Par ailleurs, les serveurs d'un cloud affichent des couts de

fonctionnement moins élevés et ils peuvent être plus

fiables s'ils ne sont pas tous équipés de disques internes.

1.5.2. VIRTUALISATION

La virtualisation est la principale technologie dans le

cloud, est un procédé pour partitionner une ressource physique en

plusieurs ressources virtuelles, exemple un serveur, espace de stockage ou un

réseau lors de la création des machines virtuelles. Elle permet

d'intégrer les différents serveurs de façons plus flexible

pour faciliter l'utilisation. Elle a pour but de faire la transparence

d'utilisation et l'efficacité d'exploitation des ressources, d'assurer

le fonctionnement des différents services et la séparation entre

de multiples locataires (utilisateurs) impliqués dans un matériel

physique.

1.5.3. INTERFACE DE SERVICE

L'interface de service placée entre le fournisseur et

le client est un élément de différenciation du cloud. Elle

représente un contrat qui fait respecter la proposition de valeur

décrite par des SLA et des conditions tarifaires. Si le cloud semble

nouveau, c'est principalement en raison de cette interface. Elle

représente la valeur d'un fournisseur et sert de base à la

concurrence. Par l'ajout d'interfaces de libre-service, nous obtenons d'autres

optimisations. Les clients du cloud sont en mesure d'engranger des ressources

de manière automatisée sans que le service informatique soit un

obstacle. L'espace de stockage et les ressources sont présentés

au travers d'une interface graphique que l'utilisateur peut

Page | 16

manipuler de manière à obtenir et à

instancier une infrastructure informatique virtuelle. Un navigateur web ou une

carte bancaire à titre d'exemple.

1.5.4. DATACENTER (CENTRE DE DONNEES)

Un centre de traitement de données en anglais `'

datacenter» est un site physique sur lequel sont regroupés des

équipements constituants le système d'information de l'entreprise

(baies de stockage, mainframes, serveurs, équipements réseaux et

de télécommunications, etc.). Il peut être interne ou

externe à l'entreprise, exploité ou non avec le soutien de

prestataires. Il comprend en général un contrôle sur

l'environnement (climatisation, système de prévention de contre

l'incendie, etc.), une alimentation d'urgence et redondante, ainsi qu'une

sécurité physique élevée. Cette infrastructure peut

être propre à une entreprise et utilisée pour

elle-même ou à des fins commerciales. Ainsi, des particuliers ou

des entreprises peuvent venir y stocker leurs données suivant des

modalités bien définies.

? Un Datacenter est constitué de trois composants

élémentaires :

- Infrastructure : est constituée de l'espace et des

équipements nécessaires aux supports des opérations du

Datacenter. Il comprend les transformateurs électriques, alimentations

sans interruption, générateurs, armoires de climatisation,

système des distributions électrique, etc.

- Equipements informatique : ensemble d'équipement de

base de la puissance du traitement de calcul d'information. Ils sont

constitués des racks, serveurs de

stockage, câble, outils de gestion de système et

équipements réseaux.

- Opération : est constituée des personnels

d'exploitation qui pilotent, entretiennent et réparent les

systèmes informatiques et non-informatiques lorsque cela est

nécessaire.

? Caractéristique d'un Datacenter :

- Disponibilité électrique : fournir de

l'électricité en quantité suffisante, de haute

qualité ainsi que l'électricité de secours.

- Système de refroidissement : il doit répondre

à trois exigences principales dont refroidissement des

équipements, de baies ainsi que l'implantation des baies dans la

salle.

- Equipement informatiques : il est là pour traiter,

stocker et router des informations sur des serveurs d'applications, serveurs de

stockages et éléments réseaux. Brève explication

sur les serveurs d'applications, et celle les machines sur lesquelles les

logiciels s'exécutent.

? Les serveurs de stockage, repartie en deux selon la technique

utilisée :

Page | 17

- Stockage local : l'information est stockée sur le

serveur qui l'utilise, le DAS

(direct attached storage).

- Stockage dédié : on dédie à

certaines machines une fonction de stockage,

constituant ainsi une « baie de stockage ».

? Fonctionnement d'un Datacenter répond à 3

grandes missions :

- Stocker de données

- Traiter de données

- Sauvegarder et protéger de données

Figure 7 Centre des données

1.6. DIFFERENCE ENTRE VIRTUALISATION ET CLOUD

COMPUTING ? Virtualisation permet aux entreprises d'utiliser une

seule pièce matérielle physique pour effectuer le travail d'un

grand nombre de machines. Plusieurs instances d'un système

d'exploitation s'exécutant sur un seul dispositif matériel, sont

beaucoup plus économiques qu'une pièce de matériel pour

chaque tache de serveur.

? Cloud computing est l'accès par Internet aux

applications d'entreprise fonctionnant dans un environnement non-local. Le

cloud computing peut certainement tirer des avantages de la virtualisation.

1.7. DIFFERENCE ENTRE GRID ET CLOUD COMPUTING

Le grid ressemble au cloud computing dans le grand nombre de

serveurs, communication réseau très importante, stockage

généralement distribué, etc. ces deux techniques sont

assez différentes.

? Dans le cas du grid, il s'agit surtout de mettre à

disposition de quelques équipements des ressources informatiques

très puissantes pour des périodes de temps données. Par

exemple le projet de Grid 5000 en France, qu'il est utilisé pour faires

des calculs parallèles sur de très gros volumes de données

;

Page | 18

· Dans le cas du cloud computing on note souvent une notion

d'élasticité, de disponibilité et de virtualisation de

ressource, on ne sait trop sur quels serveurs fonctionne les applications ainsi

on paye en fonction de l'utilisation.

1.8. AVANTAGE DU CLOUD COMPUTING

· Possibilité de partager ses contenus avec son

réseau personnel ;

· Possibilité de partager les ressources ;

· Redondance de stockage de données en cas d'un

disque dur tombe en panne, les données restent en sécurité

et disponibles automatiquement sur un autre disque ;

· Possibilité de spécifier des ressources

;

· Manipuler et configurer l'application en ligne à

tout moment ;

· Aucune défaillance c.à.d. qu'il n'y a ni de

problèmes de matériel, ni de logiciel de la technologie ;

· Sécurité dans cloud ou chaque utilisateur

peut être isolé dans son propre environnement ;

· Pas besoin d'installer un logiciel spécifique pour

avoir accès ou manipuler les applications cloud ;

· Plus flexible ;

· Offre le développement en ligne et des outils de

déploiement, de l'environnement d'exécution de la programmation

par la plate-forme comme modèle de service ;

· Augmente la collaboration ;

· Offre un self-service sur demande, les ressources peuvent

être utilisées sans interaction avec le fournisseur de services de

cloud ;

· Mobilité, l'utilisateur peut à tout moment

et à partir de n'importe quel appareil se connecter à ses

applications (Any where-any time) ;

· Les ressources sont disponibles et accessible sur le

réseau indépendamment de la plate-forme utilisé par les

clients ;

· Contrôle de couts ;

· Il est très rentable car il fonctionne de

façon plus efficace avec une plus grande utilisation, il faut juste une

connexion Internet ;

· Offre un équilibrage de charge qui le rend plus

fiable ;

· Accéder sur Internet à des applications

comme les services utilitaires.

Page | 19

1.9. INCONVENIENTS DU CLOUD COMPUTING

· L'accès au cloud passe nécessairement

par une connexion internet, par conséquent si votre connexion est

interrompue momentanément ou durablement, vous n'avez plus accès

à vos documents ou service ;

· Sécurité, la plateforme cloud, si elle

est externe (non installée sur le réseau interne ou avec une

ouverture extérieure) doit être suffisamment

sécurisée pour éviter le risque d'intrusion, de vol des

données par piratage.

· Sécurité et vie privée, la plus

grande préoccupation étant donné que la gestion des

données et gestion des infrastructures en nuage sont fournies par des

tiers, il y a toujours un risque de transfert de l'information sensible

à ces fournisseurs, bien que les vendeurs cloud s'assurent de bien

protéger les comptes de leurs clients avec des mots de passe

crypté et surs, tout signe brèche de sécurité se

traduirait par le perte des données sensibles des clients et l'atteinte

à la réussite des entreprises ;

· Piégé, il est très difficile pour

les clients de changer d'un fournisseur de services cloud(FSC) à

l'autre. Il en résulté une dépendance avec un FSC en

particulier pour le restant de vos activités ;

· Panne d'isolation, ce risque concerne la

défaillance du mécanisme d'isolement qui sépare le

stockage, la mémoire, le routage entre les différents locataires

;

· Interface de gestion compromise, en cas de fournisseur

de cloud public, les interfaces de gestion de la clientèle sont

accessibles par Internet ;

· Suppression des données précaire ou

incomplète, il est possible que les données marquées pour

la suppression ne puissent pas être effacées, cela risque

d'arriver à cause de l'une des raisons suivantes :

- Les exemplaires supplémentaires de données

sont stockés mais ne sont pas disponibles ;

- Un disque endommagé peut également stocker les

données provenant d'autres clients.

1.10. SECURITE DANS LE CLOUD COMPUTING

La sécurité et la conformité sont souvent

citées comme le rétenteur principal à l'utilisation des

services cloud, qu'elles sont les principales préoccupations des

informaticiens pour développer cette technologie. La

sécurité permet de garantir la confidentialité,

l'intégrité, l'authenticité et la disponibilité des

informations.

Page | 20

1.10.1. CONFIDENTIALITE

La confidentialité assure que les données d'un

client ne soient accessibles que par les entités autorisées. Les

différentes solutions de cloud computing comportent des

mécanismes de confidentialité comme la gestion des

identités et des accès, l'isolation ou le cryptage. La

majorité des échanges internes ou externes au cloud sont

encapsulés en SSL (Secure Sockets Layer) et authentifiés avec un

certificat rédigé et signé par client. Tant que ce

certificat assure le contrôle de clé privée de sa cliente,

ce mécanisme permet d'augmenter le degré d'assurance et la

confiance parce qu'elle est spéciale à ces clients

autorisés.

1.10.2. INTEGRALITE

Les utilisateurs de cloud peuvent stocker plusieurs

données, et généralement doivent être

protégés contre le vol et les modifications non

autorisées. Dans le nuage, il existe plusieurs systèmes qui

fournissent des mécanismes pour protéger

l'intégrité des informations. Par exemple pour le service de

stockage de Windows azure, intégrité est définie par les

applications utilisant le modèle de contrôle d'accès.

Chaque compte de stockage a deux clés qui sont utilisées pour

contrôler l'accès à toutes les données dans ce

compte de stockage.

1.10.3. DISPONIBILITE

L'un des principaux avantages fournis par des plates-formes de

cloud computing est la disponibilité robuste basée sur la

redondance réalisée avec des technologies de virtualisation. Par

exemple Windows azure offre de nombreux niveaux de redondance fournissant une

disponibilité maximale des données et des applications, ou les

données sont répliquées sur trois noeuds distincts pour

minimiser les problèmes des pannes matérielles.

1.11. TECHNOLOGIE DE STOCKAGE EN RESEAU

1.11.1. STOCKAGE SAN

Le SAN (Storage Area Network) est une technologie de stockage

en réseau. C'est un réseau physique en fibre optique, il connecte

l'ensemble des unités de stockages et des serveurs. Dans ce

réseau les données stockées sont routées et

structurées via des commutateurs.

Cette technologie est basée sur Fibre Channel, qui

autorise le transfert de données entre périphériques sans

surcharger les serveurs. Cette matière de stockage permet :

? Des partages des ressources de stockage entre plusieurs des

utilisateurs,

? L'accès à des informations très

rapidement,

? La résolution de problèmes de connectivité

entre plusieurs serveurs et unités de stockage.

Page | 21

Le SAN est caractérisé par deux

propriétés principales suivantes :

? Utilise un réseau Fibre Channel, où le Fibre

Channel est un protocole utilisé par des mainframes,

? Permet l'installation distante de sous-systèmes de

disques durs et de librairies de bandes.

Parmi les topologies de SAN :

1) Point à Point : est la plus simple,

est un lien croisé entre les deux ports.

2) Boucle Arbitrée (FC-AL) : est

constitué au maximum de 126 ports reliés entre eux, tous ces

ports se partagent la largeur de bande et utilisent un concentrateur FC.

L'architecture de SAN se compose par des équipements

principaux :

- Baie de disques : est un ensemble des

disques pilotés par un ou des contrôleurs qui seront

regroupés en VG (Volum Group) grâce à un raid.

- Raid : est signifié (Raid Array of

Independant Disks), est une technologie dans le

SAN, permettant de constituer une unité de stockage

à partir de plusieurs disques regroupés de différents

niveaux de raid.

- Switch ou bien commutateur.

a. Avantage du SAN

- La consolidation des informations au sein d'un réseau

de stockage centralisé,

- La simplification des sauvegardes et de la restauration.

- Relie de l'ensemble des ressources de stockage,

- Performances,

- Fourni grand volume de capacités de stockage,

b. Inconvénients du SAN

- Coûteuse : par exemple le prix d'entrée environ

de 283 000 € pour un réseau SAN de taille moyenne,

- Manque de standardisation génère certains

problèmes d'interopérabilité,

- La gestion des composants est plus difficile en fonction de

l'augmentation en taille et en complexité du réseau SAN.

- La complexité du réseau SAN et son expansion

augmentent la difficulté de gestion des composants de ce

réseau.

Page | 22

1.11.2. STOCKAGE NAS

Le NAS (Network Attached Storage) : est un serveur qui fournit

une interface au niveau du fichier pour un stockage pouvant être

partagé sur plusieurs systèmes, ce serveur est attaché

directement au réseau IP, donc il est accessible pour tous les

équipements de ce réseau, généralement le serveur

NAS est plus lent que le réseau SAN ou le stockage DAS.

Il utilise un protocole de transport de fichier comme NFS,

CIFS et FTP. Il peut accepter de consolider des données malgré la

différence des systèmes d'exploitation.

Le NAS se distingue par les caractéristiques suivantes

:

? La connexion directe au réseau et permet l'accès

des clients aux données sans arriver le serveur d'applications, ...

? Il est basé sur le partage de fichiers dans des

réseaux hétérogènes par exemple WindowsNT, Unix,

Windows 2000,

? Facile à déployer et à gérer.

a. Avantage du NAS

- Facile à mis en oeuvre,

- Partage les fichiers facilement,

- Partage multi-environnement lié aux différentes

implémentations du protocole

que l'on utilise.

b. Inconvénients du NAS

- Demande des ressources comme CPU,

- N'est pas valide, en cas des applications qu'ils

nécessitent des grosses performances des disques durs.

1.11.3. STOCKAGE DE DAS

? Le DAS (Direct Attached

Storage) : où chaque disque ou ensemble de disques est physiquement

lié à une seule unité de commande, serveur de fichiers ou

mainframe.

? Ces méthodes consistent à connecter,

directement ou via un bus d'E/S, une ressource de stockage unique à un

hôte dédié, tel qu'un serveur ou une station de travail.

Page | 23

Le tableau suivant résume une comparaison entre les deux

types de stockages SAN

et NAS :

|

SAN

|

NAS

|

|

Orienté paquets SCSI

|

Orienté fichier

|

|

Basé sur le protocole Fibre Channel

|

Basé sur le protocole Ethernet

|

|

Le stockage est isolé et protégé de

l'accès client général

|

Conçu spécifiquement pour un accès client

général

|

|

Support des applications serveur avec haut niveau de

performances SCSI

|

Support des applications client dans un environnement NFS/CIFS

hétérogène

|

|

Le déploiement est souvent complexe

|

Peut être installé rapidement et facilement

|

Tableau 1 : comparaison San et Nas

1.12. ARCHITECTURE DU CLOUD COMPUTING

Le cloud est classé en fonction de son emplacement par

son déploiement dans son environnement qui le distingue, peu importe le

modèle du cloud utilisé par une organisation, ils restent

similaires au niveau des éléments qui composent l'architecture,

les architectures cloud contiennent une série d'éléments

communs qui est :

? Couche de virtualisation : la virtualisation des serveurs et

des systèmes de stockage joue un grand rôle dans l'architecture de

cloud en offrant l'un des principaux avantages du cloud l'agilité, cette

couche de virtualisation permet aux fournisseurs d'autoriser ou de bloquer

l'accès aux serveurs cloud, en fonction des besoins des utilisateurs du

service ;

? Le stockage évolutif horizontal :

l'évolutivité est une autre marque de distinction de

l'architecture de cloud computing, en matière de stockage, elle

résulte également de technologies exploitant des ensembles

importants de composants matériels standard qui peuvent être

facilement développés sur demande à moindres frais au fur

et à mesure de l'évolution des besoins en matière

d'infrastructure et de stockage ;

? Mécanismes de prise en charge d'utilisateurs

multiples : un service cloud doit permettre la séparation physique ou

virtuelle des données stockées pour chaque

Page | 24

utilisateur et être capable de retracer le suivi de

l'utilisation du service par utilisateur. Il est intéressant de noter

que la prise en charge d'utilisateurs multiples est une caractéristique

intégrale, même dans le cloud privé, dans ce contexte, les

divers services ou groupes de travail d'une entreprise représentent les

différents utilisateurs ;

? API Web : est l'ensemble d'API Web (utilisant des

méthodes standard telles que les appels http RESTful, XML et SOAP) au

travers des quelles services cloud peuvent être invoqués. Ces API

permettent la mise à disposition des services par le biais d'un

navigateur Web standard ou d'une autre application cliente http.

1.13. SERVEUR DU CLOUD COMPUTING

Le serveur cloud fonctionne de la sorte qu'un serveur

physique, à la différence toutefois que les fonctions qu'ils

fournissent peuvent être différentes. Il y'a deux principales

fonctionne d'hébergement à savoir, l'hébergement

partagé qui est l'option la plus économique dans la mesure

où les serveurs sont partagés entre les clients est

hébergé sur le même serveur que les sites web appartenant

à d'autres clients. Il présente de nombreux désavantages,

y compris le fait que l'installation manque de flexibilité et n'est pas

en mesure de gérer de grandes quantités de trafic.

L'hébergement dédié est une forme d'hébergement

beaucoup plus avancée, ou le client fait l'acquisition de serveur

physiques complets cela signifie que le serveur est complètement

à lui sans avoir partagé avec d'autres clients. Le serveur

dédié permet d'avoir un contrôle total sur son

hébergement, leur désavantage consiste à ce que les

capacités requises doivent être prévues avec suffisamment

de ressources et de puissance de traitement pour gérer les niveaux de

trafic attendus.

L'hébergement cloud permet d'adapter les ressources

à la hausse ou à la baisse selon les besoins, ce qui en fait un

système bien plus élevé, il est possible d'augmenter

automatiquement leur capacité pour répondre à la demande,

sans devoir payer pour cette capacité de manière permanente. Un

serveur dédié peut fonctionner sur un hyperviseur, dont le

rôle est de contrôler la capacité et de l'affecter là

où elle est nécessaire suivant l'utilisation des systèmes

d'exploitation. Le cloud serveur est disponible pour chaque client, cela permet

de dédier les ressources informatiques à un client

déterminé si cela est nécessaire.

? Avantages clé dans son serveur à savoir :

- Flexibilité et extensibilité, il est possible

d'accéder aux ressources supplémentaires selon les besoins et

quand cela est nécessaire ;

Page | 25

- Efficacité des couts, étant donné que

le serveur cloud est accessible quand les clients en ont besoin, ceux-ci ne

paient que ce qu'ils utilisent à une période

déterminée ;

- Facilité l'installation, le serveur cloud est facile

à installer ;

- Fiabilité, vu le nombre de serveurs disponibles, si

l'un d'entre eux rencontre un problème, les ressources sont

déplacées vers les autres afin que les clients ne soient pas

affectés.

1.14. BIGDATA

Il est appel grosses données ou méga

données (recommandé), parfois appelées données

massives, qui désignent des ensembles de données devenus si

volumineux qu'ils dépassent l'intuition et les capacités humaines

d'analyse et même celles des outils informatiques classiques de gestion

de base de données ou de l'information.

Big Data, inventées par les géants du web, ces

solutions sont dessinées pour offrir un accès en temps

réel à des bases de données géantes. Face à

l'explosion du volume d'informations, le Big Data vise à proposer une

alternative aux solutions traditionnelles de bases de données et

d'analyse (serveur SQL, plateforme de Business Intelligence...).

Confrontés très tôt à des problématiques de

très gros volumes, les géants du web, au premier rang desquels

Yahoo, Google et Facebook ont été les premiers à

déployer ce type de technologies.

Le Big Data a quatre dimensions :

? Volume : les entreprises sont submergées de volumes

de données croissants de tous types, qui se comptent en

téraoctets, voire en pétaoctets. Transformer les 12

téraoctets de Tweets créés quotidiennement en analyse

poussée des opinions sur un produit. Convertir les 350 milliards de

relevés annuels de compteurs afin de mieux prédire la

consommation d'énergie.

? Vélocité : parfois, 2 minutes c'est trop pour

les processus chrono sensibles tels que la détection de fraudes, le Big

Data doit être utilisé au fil de l'eau, à mesure que les

données sont collectées par votre entreprise afin d'en tirer le

maximum de valeur.

? Variété : le Big Data se présente sous

la forme de données structurées ou non structurées (texte,

données de capteurs, son, vidéo, données sur le parcours,

fichiers journaux, etc.). De nouvelles connaissances sont issues de l'analyse

collective de ces données. Utiliser les centaines de flux vidéo

des caméras de surveillance pour

Page | 26

contrôler les points d'intérêt. Tirer parti

de la croissance de 80 % du volume de données image, vidéo et

documentaires pour améliorer la satisfaction client.

? Véracité : 1 décideur sur 3 ne fait pas

confiance aux données sur lesquelles il se base pour prendre ses

décisions. Comment pouvez-vous vous appuyer sur l'information si vous

n'avez pas confiance en elle. Etablir la confiance dans les Big Data

représente un défi d'autant plus important que la

variété et le nombre de sources augmentent.

Big Data va bien au-delà de la seule notion de volume :

il constitue une opportunité d'obtenir des connaissances sur des types

de données et de contenus nouveaux. Aujourd'hui, la plateforme Big Data

d'IBM a recours aux technologies les plus pointues et à des solutions

d'analyse brevetées, afin d'ouvrir la porte à de nouvelles

possibilités.

Les principales technologies de Big Data, elles sont

nombreuses pour optimiser les temps de traitement sur des bases de

données géantes, plusieurs solutions peuvent entrer en jeu :

? Des bases de données NoSQL (comme MongoDB, Cassandra

ou Redis) qui implémentent des systèmes de stockage

considérés comme plus performants que le traditionnel SQL pour

l'analyse de données en masse (orienté clé/valeur,

document, colonne ou graphe).

? Des infrastructures de serveurs pour distribuer les

traitements sur des dizaines, centaines, voire milliers de noeuds. C'est ce

qu'on appelle le traitement massivement parallèle. Le framework Hadoop

est sans doute le plus connu d'entre eux. Il combine le système de

fichiers distribué HDFS, la base NoSQL HBase et l'algorithme MapReduce.

D'autres technologies visant à tendre vers des traitements plus "temps

réel" ont émergé dans la foulée (c'est le cas

d'Apache Spark).

? Le stockage des données en mémoire (Memtables)

permet d'accélérer les temps de traitement des requêtes.

Page | 27

CONCLUSION PARTIELLE

Le Cloud Computing a certainement contribué à

réduire les problèmes, qui ont tourmentés les entreprises

comme : espace de stockage, réalisation les différentes

applications et la disponibilité de données.

Donc le Cloud est un modèle de distribution et de

partage de ressources à grande échelle, qu'il offre aux

utilisateurs un environnement plus simple et plus efficace pour travailler,

parmi les intérêts du Cloud : faciliter le travail, augmenter la

collaboration, réduire le coût de matériel et éviter

le déplacement de clients pour obtenir une donnée. On peut

exploiter les bénéfices du Cloud à partir des

différentes solutions.

Page | 28

CHAPITRE II : LES TECHNOLOGIES SUR INTERNET DANS

LA

MESSAGERIE ELECTRONIQUE ET RESEAUXSOCIAUX

INTRODUCTION

Dans le chapitre précédant, nous avons

présenté les concepts de base du cloud, leurs technologies et

leurs modèles des services, de déploiement et les

éléments constituant le cloud computing ainsi que ses avantages,

ses inconvénients et la sécurité. Nous avions parlé

sur la différence entre cloud et d'autres technologies et aussi

parlé sur quelques technologies de réseaux, sur l'architecture du

cloud, son serveur et la technologie big data.

Quant à ce chapitre, nous expliquerons Google avec ces

produits Gmail, YouTube et produits Facebook tout en donnant un état de

l'art sur ces produits ci-haute

SECTION 1 : SERVICE DE MESSAGERIE GOOGLE MAIL

2.1.1. PRESENTATION GOOGLE

Google est une entreprise américaine offrant des

services sur les technologies de la science informatique, fondé le 4

septembre 1998 en Californie par Larry Page et Serguei Brin. Ce sont eux les

créateurs du moteur de recherche Google, il s'est fait connaître

à travers la grande force de son moteur de recherche, qui à

concurrencé d'autres entreprise. Elle a opéré beaucoup des

changements sur les développements et détient aujourd'hui des

nombreux logiciels et sites web parmi lesquels : YouTube, le système

d'exploitation Android, ainsi que d'autres services tels que Google Earth,

Google Maps ou Google Play. Il s'est donné comme mission d'organiser

l'information à l'échelle mondiale et de la rendre

universellement accessible et utile.

2.1.2. LES ALGORITHMES DE GOOGLE

Le SEO est l'art de comprendre la manière dont

travaillent les moteurs de recherche comme Google, pour faire que son site

sorte dans le haut de la première page de réponse à une

recherche de mots clés. Ce classement est le fruit d'une organisation

effectuée par le moteur de recherche sur la base de calculs

gérés par l'un des secrets les mieux gardés de la

planète : l'algorithme Google (

http://mysocialselling.com/algorithme-google/,

2016).

2.1.3.Les principes des algorithmes Google

Google repose sur quatre grands algorithmes :

? Le PageRank : C'est l'élément le plus connu du

classement de l'algorithme Google développé par Larry Page and

Sergey Brin, qui ont fondé Google. Le PageRank est un indice

correspondant aux nombres de liens sur une page,

Page | 29

gage de qualité pour celle-ci. Il est toujours

utilisé actuellement, il continue à bénéficier

d'évolutions, mais il est largement dépassé, et fait

maintenant partie d'un système plus important.

? Les signaux : L'algorithme Google utilise maintenant 200

critères qu'il appelle « signaux ». Ces derniers

dépendent à la fois du contenu de la page, et de son

évolution, des requêtes et du comportement des visiteurs.

? Les classificateurs sont utilisés sur les

requêtes : leur but est de restituer le

contexte de recherche, le cadre dans lequel elle se place. Par

exemple, veut-

on rechercher un produit pour l'acheter ou se renseigner sur

quelque chose ? ? Les modèles : l'algorithme Google fait appel à

plusieurs modèles. A savoir : - Les modèles de langues : la

capacité à comprendre les phrases, les

synonymes, les accents, les fautes d'orthographe, etc.

- Les modèles de requêtes : il n'y a pas

seulement la langue, mais comment elle est utilisée de nos jours.

- Les modèles de temps : certaines pages

répondent mieux quand elles existent depuis 30 minutes, et d'autres

quand elles ont subi l'épreuve du temps.

- Les modèles personnalisés : toutes les

personnes ne recherchent pas les mêmes choses, ne le cherchent pas avec

les mêmes mots etc.

L'algorithme Google bénéficie d'une puissance de

calcul unique au monde. Le calcul de l'algorithme Google dispose de centaines

de milliers d'ordinateurs pour indexer les milliards de pages de tous les sites

Web au monde, et est capable de mettre à jour l'index tout entier en

quelques jours ! Il est important de savoir que les centres de données

stockent une copie de toutes les pages du Web pour pouvoir y accéder

plus rapidement.

Par ailleurs l'algorithme Google bénéfice d'une

recherche d'amélioration constante : Des groupes travaillent à

l'amélioration de l'algorithme, d'autres opèrent sur

l'évaluation des résultats. L'algorithme Google a

bénéficié de plusieurs milliers de modifications.

Les algorithmes de Google en SEO les plus connus de Google

sont Panda et Pingouin. Apparus en 2011 et 2012, ils font respecter leurs

règles et attention aux faux pas. Enfin, « hummingbird »

ou Colibri en français apparus en 2013. Cet algorithme va plus loin

que les précédents car il ne raisonne pas en fonction des

mots-clés tapés lors de la recherche (

https://www.journalducm.com/2017/03/08/seo-algorithmes-google-panda-pinguin-colibri-15229/,

2017).

Page | 30

? Google Panda : sanctionne les sites de mauvaises

qualités au contenu de faible valeur ajoutée. Par exemple, les

sites publiant du contenu pour générer des revenus publicitaires

ou bien des sites dupliquant du contenu déjà existant ainsi que

les comparateurs de prix. La dernière version officielle de Panda date

du juillet 2015. C'est un algorithme majeur de Google.

? Google Pinguin : s'attaque aux sites «

suroptimisés pour le SEO » dans le but de booster leur

référencement. Cette technique consiste à multiplier des

liens sortants (netlinking) non justifiés, mais de multiplier les liens

entrants issus d'autres sites (backlinking), enfin de décliner un

contenu identique sur différentes pages d'un site. Penguin a

été mis à jour le 23 septembre 2016. Il est enfin

intégré dans l'algorithme de Google avec des mises à jour

« en temps réel ». C'est un autre algorithme majeur

de Google.

? Google Colibri : « Hummingbird » ou

Colibri, mis en ligne en septembre 2013, est né pour améliorer la

pertinence des résultats par une meilleure compréhension de

l'intention de l'internaute. À première vue, colibri

s'intéresse aux requêtes composées de plusieurs mots

clés. Il serait le plus intelligent des algorithmes car il essaie de

deviner la définition qui se cache derrière chaque requête

et la traduit en une interrogation courte.

2.1.3. GOOGLE DANS LE CLOUD

2.1.3.1. Stockage Gmail et YouTube dans le Cloud

Le cloud Gmail et YouTube c'est fait par Google avec son

produit Google Drive, Google Drive propose à chaque nouvel abonné

15 Go à partager entre le Drive mais aussi Gmail et Google+ Photo. Chez

Google un seul compte suffit pour avoir accès à

l'intégralité des services de la marque (Google+, YouTube, Gmail,

Analytics...), ce qui explique le partage du cloud. Si 15 Go semble être

un stockage assez conséquent, Google Drive offre un autre avantage : les

photos inférieures à 2048×2048 et les vidéos de moins

de 15 minutes ne sont pas prises en compte dans l'espace de stockage du

cloud.

Google Drive propose lui 15 Go mais ne compte pas la

quasi-totalité de vos photos, vos courtes vidéos ou certains de

vos documents, Si 15 Go avec une réserve presque illimitée ne

vous suffisent pas, vous pouvez passer à la caisse. Le cloud by Google

est d'ailleurs plutôt économique avec différentes formules,

même si pour notre comparatif, je prendrai les 100 Go comme

mètre-étalon. Ainsi Google Drive propose les 100 Go à

1,99€ par mois. Un tarif tout à fait raisonnable si vous avez

besoin d'un stockage considérable. On mettra quand même un

bémol à l'offre de Google : si vous souhaitez plus de 100 Go, il

faudra passer

Page | 31

directement à un To qui se négocie à

9,99€/mois. Pas d'offre intermédiaire dans le cloud de Google.

Les Services offerts par Google restent la

compatibilité totale entre tous ces services (Gmail, Google+...) mais

aussi sur toutes les plateformes (compte Google sur PC, Smartphone et Tablette

Android et bientôt sur Android Gear ou Google Glass). Google Drive

s'intègre parfaitement dans cette suite : les photos et les

vidéos des Smartphone Android sont stockées sur le cloud, tandis

que des sauvegardes régulières se font également dans cet

outil. La synergie créée par l'association avec Chrome ou Gmail

fait de Google Drive le cloud indispensable des utilisateurs de produits

Google.

2.1.3.2. Fonctionnement de Google Drive

Google drive fonctionne de façon de vous permettent de

charger 30 formats des fichiers pris en charge, musique, vidéo, images,

feuilles de calcul, document texte etc. pour y accéder de n'importe

où. Vous pouvez organiser en dossiers et choisir lesquels vous voulez

partager et avec qui. A l'intérieur du cloud vous naviguez facilement en

utilisant différents volets de navigation, MonDrive regroupe tous vos

éléments, Activité renfermée les fichiers

triés par date de modification ou encore Partages avec moi ou vous

trouvez des fichiers partagés avec vous par vos amis, etc. vous pouvez

faire de recherche d'un document en tapant un mot clé et il existe

encore une petite astuce de recherche,

Google Drive est capable de reconnaitre les lettres dans une

image (si vous avez photographié une boulangerie et que vous tapez

boulangerie dans la barre de recherche, il vous trouvera la photo) et un autre

point fort de ce service vous pouvez y accéder même hors

connexion. Pour cela vous pouvez aller sur

drive.google.com et

sélectionnez configuration de Google Documents hors connexion, en

cliquant sur Autoriser les documents hors connexion et clique sur le bouton

installer, à partir de là vous pouvez ouvrir les feuilles de

calcul en lecture seule et les autres documents en lecture et écriture.

Google vous offre 5 Go d'espace de stockage gratuit, pour les restes il faudra

sortir votre porte-monnaie (

www.androidpit.fr/, s.d.).

2.1.3.3. Avantages de la technologie Google Drive

? La gratuité : les logiciels de bureautique contenus

dans le service Google Drive sont tous totalement gratuits pour peu qu'on ne

dépasse pas les 15 gigas alloués lors de la création du

compte (ce qui représente entre 50 000 et 100 000 documents de

traitement de texte).

? L'importation des fichiers : la suite Google Drive permet

d'importer des fichiers du type traitement de texte (Word), Tableur (Excel), ou

présentation (Power Point). Le

Page | 32

nombre important de formats pris en compte rend Google Drive

souple d'utilisation. Le logiciel intègrera tout seul les

évolutions des autres formats évitant aux utilisateurs les mises

à jour régulières. Le seul bémol réside dans

une possible perte de qualité en cas d'import d'un document qui comprend

une mise en forme complexe.

? Pas de mise à jour pour nouvelle version

nécessaire : lorsque vous achetez un pack Office ou

téléchargez un produit Open Office vous devez vous assurer

d'avoir un système d'exploitation compatible aux dernières

versions. Ce n'est pas le cas avec le service Google Drive, quel que soit le

système d'exploitation (Windows, GNU Linux et Mac OS X) ou le navigateur