|

République Algérienne Démocratique

et Populaire

Ministère de l'Enseignement Supérieur et de

la Recherche Scientifique

|

Université

M'hamed

BOUGARA

Boumerdès

|

|

Faculté

des

Sciences

Boumerdès

|

DEPARTEMENT DE MATHEMATIQUES

MEMOIRE DE MAGISTER

SPECIALITE :

MATHEMATIQUES

OPTION : MODELES STOCHASTIQUES

Thème

PROCESSUS STOCHASTIQUES ET

EQUATIONS AUX

DERIVEES PARTIELLES

Présenté par

HANECHE MOHAMED Soutenu publiquement le

:29/06/2009

Devant le jury composé de:

|

Présidente :

|

Mme H. GUERBYENNE

|

Maitre de conférences A

|

USTHB Alger

|

|

Promoteur :

|

Mr K. KHALDI

|

Maitre de conférences A

|

UMBB Boumerdès

|

|

Co-promoteur :

|

Mr A. ABASSOV

|

Maitre de conférences A

|

UMBB Boumerdès

|

|

Examinateur:

|

Mr H. OSMANOV

|

Professeur

|

UMBB Boumerdès

|

|

Examinateur:

|

Mr S.MAKDECHE

|

Maître de conférences B

|

UMBB Boumerdès

|

Remerciement

J'exprime mes profonds remerciements à mon

promoteur le Docteur KHALDI Khaled pour l'aide compétente qu'il m'a

apportée, pour sa patience et son encouragement à finir ce

travail.

Je tiens à remercier Monsieur ABASSOV Assim mon

co-promoteur et Monsieur MAKDECHE Said pour leurs conseils et remarques

pertinentes.

Ensuite, je tiens à exprimer mes remerciements aux

membres du jury, Mme Hafida GUERBYENNE, Présidente ainsi que Messieurs

Hamid OSMANOV et Said MAKDACHE, membres, qui ont accepté

d'évaluer mon travail.

Certaines personnes ne peuvent être oubliées,

mes professeurs: Monsieur OSMANOV Hamid, Monsieur DOUMAZE, et tous les

enseignants du département de mathématiques, sans oublier tous

les personnels administratif et de soutien du département de

mathématiques

Je remercie enfin toute l'équipe de ma promotion et en

particulier mon ami et collègue d'études TAZEROUTI

Moussa.

J'ai également une pensée pour tous mes

proches, famille et amis, qui ont fait preuve de beaucoup de patience et m'ont

toujours encouragé. J'espère maintenant être plus

disponible et leur rendre ce que je leur dois. Enfin, je souhaite remercier en

particulier mes parents pour leurs efforts, encouragements, pour le temps

qu'ils ont consacré pour moi et pour tout.

Abstract

The aim of this work is to show the relation between the

partial differential equations of the second order and the stochastic processes

of diffusion, and present some results obtained recently on the partial

derivative equations by probabilistic methods.

These results provide a probabilistic method that we allow to

avoid the complication of numerical methods and written the solution as

expectation of functional of diffusion process. This work is presented in five

chapters:

The chapter I, present the basic mathematics

tools, the Brownian motion and the stochastic process solution of stochastic

differential equation (SDE) well-known with noun of diffusion process i.e. that

their future is not depending of any other state excepting the present state,

is key notion of this study. We introduce a new character of integral, is the

stochastic integral says Itô integral that allow to give a sense to the

differential of Brownian motion, the important notion upon rest the SDE

theories.

In the chapter II, we give the generality of

partial differential equations (PDE) of second order and explain the method of

finite difference method this method is used in case where the resolution by

the analytic method is impossible.

In the chapter III, we exhibit the profound

relation existed between the notion of partial differential equations and

stochastic differential equations through the certain theory (Feynman-Kac), the

generalization of this theory given a probabilistic interpretation of PDEs.

The chapter IV is an application which we

help to comprehend the notions of the president chapter, we start by simulating

the trajectory of Brownian motion, and next, we simulate the diffusion process

and resolve a PDE by the probabilistic method.

The chapter V, it is an application in finance,

where we applied the Black and Scholes formula by different methods.

????

ÉíäÇËáÇ

ÉÌÑÏáÇ äã

ÉíÆÒÌáÇ

ÊÇÞÊÔãáÇ

Ê?ÏÇÚã äíÈ

ÉÏæÌæãáÇ

ÉÞ?ÚáÇ ÑÇåÙÅ

ìáÅ áãÚáÇ

ÇÐå á?Î äã Ïåä

|

ÇåáÍ æ

ÉíÆÒÌáÇ

ÊÇÞÊÔãáÇ

Ê?ÏÇÚãÈ

ÉÞáÚÊãáÇ

ÌÆÇÊäáÇ ÖÚÈ

ìáÅ ÞÑØÊáÇ

ìáÅ ÉÇÖ?ÇÈ

|

,

|

ÑÔäáá

ÉíÆÇæÔÚáÇ

ÊÇíáãÚáÇæ

|

.

ÉíáÇãÊÍÇ

ÞÑØÈ

|

: áæÕ ÉÓãÎ

|

ìáÅ

|

áãÚáÇ ÇÐå

ãÓÞäí

|

,

|

ÇåáÂÇÔã

|

ÈäÌÊæ

áÍáá

ÉíãÞÑáÇ

ÞÑØáÇ

áÇãÚÊÓÇ

ÈäÌÊ äã

ÇääßãÊ

ÌÆÇÊäáÇ åÐå

|

ÉÂÑÍ

ÇåäíÈ äã æ

, ÉÓÇÑÏáÇ

åÐå í

ÇåÌÇÊÍä

íÊáÇ

ÉíÖÇíÑáÇ

ÊÇíÓÇÓ?Ç

ÒÇÑÈÅ ìáÅ

áæ?Ç áÕáÇ á?Î

äã ÞÑØÊä

ÉíÆÇæÔÚáÇ

ÊÇíáãÚáÇ

ÇÖí ìãÓí

íÐáÇæ,ÉíÆÇæ

ÔÚáÇ

ÉíáÖÇÊáÇ

ÉáÏÇÚãáá áÍ

æå íÐáÇ

íÆÇæÔÚáÇ

ÑíÓáÇ æ

äÇíäæÑÈáÇ

|

.

äÇíäæÑÈáÇ

|

ÉÂÑÍ

|

ìáÅ

ÉÈÓäáÇÈ

áÖÇÊáá ìäÚã

ÁÇØÚÅ äã

Çääßãí

íÐáÇ æÊíÇ

áãÇßÊ ìáÅ

ÞÑØÊä Çã ,?????

|

|

ÍÑÔä ãË

|

, ÉíäÇËáÇ

ÉÌÑÏáÇ äã

ÉíÆÒÌáÇ

ÊÇÞÊÔãáÇ

Ê?ÏÇÚã áæÍ

ÊÇíãæãÚ ìáÅ

íäÇËáÇ áÕáÇ

á?Î äã ÞÑØÊä

|

|

.Ê?ÏÇÚãáÇ

åÐåá

|

?????? ??

|

ÇäíØÚÊ

íÊáÇæ

|

,ÉíåÊäãáÇ

ÞæÑáÇ ÉÞíÑØ

íå æ Ê?ÏÇÚãáÇ

åÐå

áÍáÉíãÞÑáÇ

ÞÑØáÇ ìÏÍÅ

|

|

ÉíÆÇæÔÚáÇ

|

ÉíáÖÇÊáÇ

|

Ê?ÏÇÚãáÇæ

ÉíÆÒÌáÇ

ÊÇÞÊÔãáÇ

Ê?ÏÇÚã äíÈ

ÉÏæÌæãáÇ

ÉÞíãÚáÇ

ÉÞ?ÚáÇ äíÈä

|

臂臂

áÕáÇ í

|

|

?????

|

ÁÇØÚÅ äã

|

Çääßãí

ÉíÑÙäáÇ åÐå

ãíãÚÊ ,

ÓíÇ ????? ãÓÇ

áãÍÊ íÊáÇ

ßáÊ ÉÕÇÎ

ÉÕÈæ

|

ÊÇíÑÙä á?Î

äã

|

|

|

. íÈíÑÞÊ

áÍ íáÇÊáÇÈæ

ÉíÆÒÌáÇ

ÊÇÞÊÔãáÇ

|

Ê?ÏÇÚãá

ÉíáÇãÊÍÇ

|

|

äÇíäæÑÈáÇ

ÉÂÑÍ ÑÇÓã

áíËãÊÈ

ÞíÈØÊáÇ ÇÐå

ÄÏÈä æ,

ÉÞÈÇÓáÇ

áæÕáÇ í ÁÇÌ

Çãá ÞíÈØÊ äÚ

ÉÑÇÈÚ æå

ÚÈÇÑáÇ

áÕáÇ

,áãÚáÇ ÇÐåá

ãå?Ç ÁÒÌáÇ

ìáÅ áÞÊää

ãË,ÑáíÇ

??íÑØ ÚÇÈÊÅÈ

ßáÐæ

ÉíÆÇæÔÚáÇ

ÉíáÖÇÊáÇ

ÉáÏÇÚãáá

ÑÇÓã áíËãÊ

ìáÅ áÞÊää ãË

Çääßãí íÊáÇ

ÉíÆÒÌáÇ

ÊÇÞÊÔãáÇ

ÉáÏÇÚã

ÑÇÊÎä

ÞíÈØÊáÇ

áíåÓÊá ,

ÉíÆÒÌáÇ

ÊÇÞÊÔãáÇ

Ê?ÏÇÚãá

ÉíáÇãÊÍ?Ç

ÉãÌÑÊáÇ

æåæ

äã ÇåíáÚ

áÕÍÊãáÇ

ÌÆÇÊäáÇ

äÑÇÞäæ

ÉíåÊäãáÇ

ÞæÑáÇ

ÉÞíÑØÈ

ÇåáÍä ãË,(

ÆÇßã ÚØÞ

ÉáÏÇÚ?)

ÉíáíáÍÊáÇ

ÞÑØáÇÈ

ÇåáÍ

|

|

|

|

.

ÉáãÚÊÓãáÇ

ÞÑØ áÇ á?Î

|

|

áæÕáÇ í

ÇåíáÚ

|

áÕÍÊãáÇ

ÌÆÇÊäáÇ

áÇãÚÊÓÇÈ

|

ßáÐæ

íáÇãáÇ

ãÇÙäáÇ í

ÞíÈØÊ æå

ÑíÎ?Ç æ

뇂

áÕáÇ

|

|

ÇääßãÊ

íÊáÇ ÞÑØáÇ

|

?????

|

ãíÏÞÊ á?Î

äã,ÒáæÔ

ß?È

|

ÌÐæãä í

ÊÇÑÇíÎáÇ

ãííÞÊ ìáÚ

ÉÓÇÑÏáÇ

ÒÂÑä ËíÍ

ÉÞÈÇÓáÇ

,

|

|

ÊÇÞÊÔãáÇ

ÉáÏÇÚãÈ

|

ÑæÑãáÇ

|

ÉÞíÑØ

ÑíÎ?Ç íæ

áÇíãæäíÈ

ÉÞíÑØæ

æáÑÇÂ

íÊäæã

ÉÞíÑØ

í,ÊÇÑÇíÎáÇ

ÉãíÞ ÏÇÌíÅ

äã

|

. ÒáæÔ

ß?Èá

ÉíÆÒÌáÇ

Sommaire

INTRODUCTION : . 1

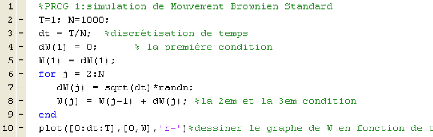

CHAPITRE I: Mouvement Brwonien et calcul

stochastique

0. Introduction : 3

1. Processus aléatoires : 4

2. Processus gaussien : 5

3. Mouvement brownien : 6

3.1. Construction du mouvement brownien : 6

3.2. Régularité des trajectoires du mouvement

brownien : 8

3.3. Mouvement brownien standard : 9

3.4. Transformations du mouvement brownien standard : 10

3.5. Semi-groupe du mouvement brownien : 10

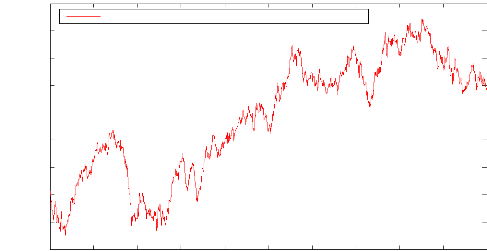

3.6. Mouvement brownien multidimensionnel : 13

4. Martingales et temps d'arrêt : 13

4.1 Martingales : 13

4.2. Comportement d'une martingale à l'infini : 14

4.3 Temps d'arrêt : 16

4.4. Tribu du passé d'un temps d'arrêt : 17

5. Intégrales stochastiques : 19

5.1. Variation quadratique : 19

5.2. Intégrales stochastiques : 21

5.2.1 Propriétés de l'intégrale

stochastique : 23

5.2.2. Extension de l'intégrale stochastique : 24

5.3. Formule d'Itô : 25

6. Equations différentielles stochastiques : 28

6.1. Introduction : 28

6.2. Solutions d'une équation différentielle

stochastique : 29

CHAPITRE II : Généralité sur les

EDPs et la méthode des différences finies

0. Introduction : 34

1. Généralité sur les équations aux

dérivées partielles : 35

1.1. Définitions : 35

1.2. Conditions initiales et conditions aux limites : 36

1.3. Classification des EDPs du second ordre : 37

1.4. EDPs du second d'ordre à plusieurs variables

indépendantes: 39

1.5. Besoins en termes de conditions initiales et aux limites :

39

2. Méthode des différences finies pour les EDPs

paraboliques : 40

2.1. Problèmes du premier ordre en temps: équation

de la chaleur : 41

2.2.1. Schémas numériques de discrétisation

par différences finies : 42

2.2.2. Erreur de troncature, consistance et ordre d'un

schéma : 45

2.2.3. Stabilité des schémas numériques :

46

2.2.4. Convergence des schémas : 50

CHAPITRE III : Interprétation probabiliste des

EDPs

0. Introduction : 52

1. Générateur infinitésimal : 53

2. Interprétation probabiliste des EDP: 54

2.1 Equation de la chaleur : 54

2.2. Formule de Feynman-Kac multidimensionnelle: 56

2.3.Problème de Cauchy pour des opérateurs

généraux : 57

2.4. Interprétation des EDP de type elliptique : 58

a)Problème elliptique sans frontière : 59

b) Problème elliptique avec condition de Dirichlet :

59

2.5. Interprétation des EDP de type parabolique : 60

a. Problème parabolique sans frontière : 61

b. Problème parabolique avec condition de Dirichlet :

62

3. Discrétisation de problèmes : 63

3.1. Le schéma d'Euler : 63

3.2. La méthode de Monte Carlo : 63

CHAPITRE IV : Application

0. Introduction : 67

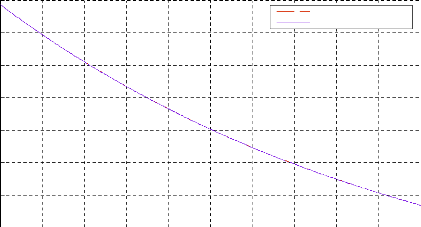

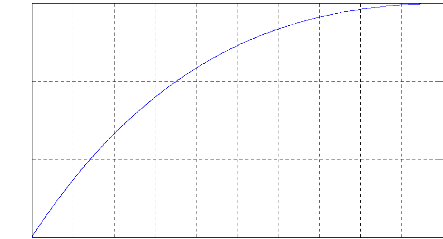

1. Discrétisation du mouvement brownien : 68

2. Discrétisation d'un processus de diffusion: 71

2.1. Schéma d'Euler- Maruyama : 71

2.2. Exemple de discrétisation d'un processus de

diffusion: 72

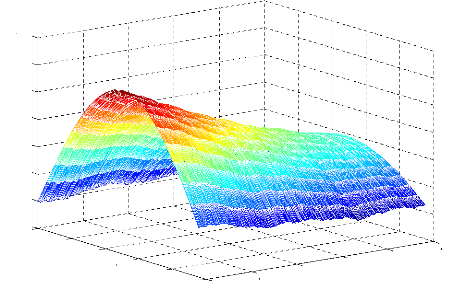

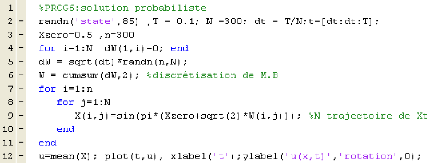

3. Application à l'interprétation probabiliste des

EDPs : 75

3.1. Problème N°=1 : 75

3.1.1. Illustration numérique du problème par la

méthode déterministe(La méthode des différences

finies) : 76

3.1.2. Illustration numérique du problème par la

méthode probabiliste : 80

3.2. Problème N° 2 : 84

3.2.1. Illustration numérique du problème par la

méthode des différences finies : 85

3.2.2. Illustration numérique du problème par la

méthode probabiliste : 88

CHAPITRE V : Application en finance

0. Introduction : 91

1. Modèle du prix de l'actif: 91

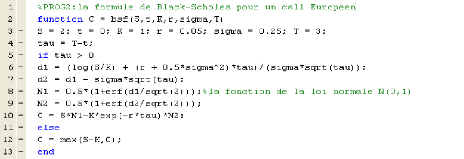

2. Formule de Black et Scholes : 93

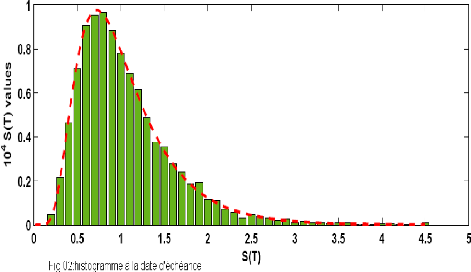

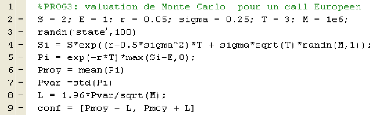

a. La méthode de Monte Carlo : 95

b. La méthode Binomiale : 96

c. EDP de Black et Scholes : 98

i. Mèthode des différences finies pour l'EDP de

Black et Scholes : 99

ii. Méthode probabiliste pour l'EDP de Black et Scholes :

100

CONCLUSION : 103

ANNEXE... ..104

BIBLIOGRAPHIE... 111

INTRODUCTION:

Le but de ce travail est de montrer le lien entre les

équations aux dérivées partielles du second ordre et les

processus stochastiques de diffusion ainsi que de présenter quelques

résultats obtenus récemment sur les équations aux

dérivées partielles par des méthodes probabilistes.

Ces résultats fournissent une méthode

probabiliste qui nous permet d'éviter les complications des

méthodes numériques et écrire la solution comme

l'espérance d'une fonctionnelle d'un processus de diffusion. Ce travail

est présenté en cinq chapitres :

Le chapitre I, présente les outils

mathématiques de base ([5], [9], [11], [12], [16], [17], [19], [26],

[29], [31], [37], [38], [40], [42], [45], [48], [51]) entre autres le mouvement

Brownien et les processus stochastiques solution d'équations

différentielles stochastiques (EDS) connu sous le nom de processus de

diffusion qui sont markoviens i.e. que leur état futur ne dépend

que de leur état présent, notion clé de cette

étude. Nous introduisons un nouveau type d'intégrale qui est

l'intégrale stochastique dite d'Itô qui permet de donner un sens

à la différentielle d'un mouvement brownien, notion importante

sur laquelle repose la théorie des EDS.

Dans le chapitre II, on donne des

généralités sur les équations aux

dérivées partielles (EDP) de second ordre ; ensuite nous

présentons une méthode

numérique pour la résolution des EDP: la

méthode des différences finies ([3], [4], [10], [18], [23], [32],

[54]), méthode utilisée dans les cas où la

résolution par les méthodes analytique est impossible. Dans ce

cas la solution trouvée est une solution approchée.

Dans le chapitre III, Nous exhibons le lien

profond existant entre la notion des équations aux

dérivées partielles (EDP) et celle des EDS à travers des

théorèmes, en particulier, ceux dit de Feynman-Kac ([6], [9],

[15], [16], [23] , [24], [35], [40], [49], [52]). La

généralisation des ces théorèmes nous permet de

donner une interprétation probabiliste des EDPs, et par

conséquent, une solution approchée sous forme d'une

espérance d'une fonctionnelle.

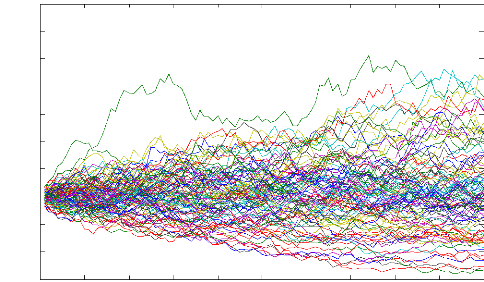

Le chapitre IV, est une application des

notions introduites dans les chapitres I, II et III. Nous commençons par

simuler les trajectoires du mouvement Brownien, ensuite, la simulation de la

diffusion par la méthode d'Euler ([2], [4], [28]) et enfin à la

plus important dans ce travail, qui est l'interprétation probabiliste

des EDPs. Dans cette partie, on choisit une EDP (parabolique) que nous pouvons

résoudre analytiquement, pour ensuite la résoudre par la

méthode des différences finies, et on compare la solution

donnée par les méthodes utilisées ([1], [13], [25], [26],

[30], [34], [35], [50]). Dans le chapitre V, nous abordons

l'application en finance. On s'intéresse particulièrement

à l'évaluation d'options dans le modèle de Black et

Scholes ([29], [41], [43], [44], [46], [53]). On illustre les

différentes méthodes pour obtenir la valeur de l'option, c'est

à dire, la méthode de Monte Carlo, Binomiale et le passage par

l'EDP de Black et scholes (parabolique).

CHAPITRE I :

Mouvement brownien et

calcul stochastique

0. Introduction:

Le mouvement brownien est associé

à l'analyse de mouvements dont l'évolution au cours du temps est

si désordonnée qu'il semble difficile de la prévoir,

même pour un temps très court, tel le mouvement d'une particule

microscopique en suspension dans un liquide et soumise à l'agitation

thermique.

Celui-ci joue un rôle central dans la théorie des

processus aléatoires, d'une part parce que, dans de nombreux

problèmes appliqués, le mouvement brownien sert à

modéliser les erreurs ou les perturbations aléatoires, et d'autre

part parce que le mouvement brownien ou les processus de diffusion qui en

découlent permettent de construire des modèles simples sur

lesquels des calculs peuvent être faits.

Le calcul stochastique, ou calcul

d'Itô, du nom d'un des pionniers en ce domaine, est en fait un calcul

d'intégrale par rapport au mouvement brownien. Ce dernier étant

une fonction qui n'est pas à variation finie, cette notion

d'intégrale n'est pas usuelle et sa définition en est

probabiliste. Elle permet en particulier de définir la notion

d'équation différentielle stochastique qui est une

équation obtenue par la perturbation aléatoire d'une

équation différentielle ordinaire. Les solutions de ces

équations définissent de nouveaux processus, appelés

processus de diffusion, et qui sont à la base du calcul probabiliste

moderne. Ces processus sont souvent markoviens, au sens où leur

comportement futur, conditionnellement au passé, ne dépend en

fait que de l'état présent. Cette propriété, dite

de Markov, est souvent vérifiée dans la réalité, en

particulier, en physique, dans les réseaux de

télécommunication, ou en mathématiques financières.

Ainsi, les processus de diffusion sont précieux dans la

modélisation de nombreux phénomènes aléatoires. On

verra par ailleurs qu'il existe des liens importants entre leur loi et

certaines équations aux dérivées partielles. Ces liens

sont à la base de beaucoup de développements récents liant

des résultats d'analyse et des résultats probabilistes.

1. Processus aléatoires : Définition

1:

On appelle processus aléatoire X =

(Xt)t"une famille de variables aléatoires indexée par

IR+, toutes ces variables étant définies sur le

même espace de probabilité (fl, Jl, P). On suppose ici que chaque

Xt est à valeurs réelles.

On peut également voir le processus comme une variable

aléatoire X définie sur (fl, Jl, P) et à valeurs dans

l'ensemble des fonctions de t 1-0 Xt de IR+ dans IR .

La théorie moderne des probabilités repose sur

les résultats fondamentaux de Kolmogorov qui permettent, en particulier,

de construire sur cet espace de fonctions une tribu qui rend l'application X

mesurable (et permet donc de parler de variable aléatoire). Kolmogorov

montre également que la loi de cette variable est

caractérisée

par ses lois marginales de dimension finie, définies comme

étant les lois des k-uplets (Xt1,

...,Xtk) , pour tous temps (t1, ..., tk).

Définition 2:

Les variables aléatoires Xt -- Xs , t > s ~

0, sont appelées accroissements du processus (Xt).

Définition 3:

On dit qu'un Processus Xt est à accroissements

indépendants et stationnaires si :

(Indépendance): Xt -- Xs 1 Fsx

= o-(Xs, 0 s t), V t > s ~ 0

(Stationnarité) : Xt -- Xs-- Xt+s --

X0, V t > s ~ 0

Pour de tels processus, donner la loi de Xt+s -- X0,Vt

> 0, ainsi que celle de X0 suffit à caractériser

entièrement le processus.

2. Processus gaussien : Définition 4:

Le processus X est un processus gaussien si

chaque famille finie (Xt1, ...,Xtk) est un vecteur aléatoire

gaussien.

Notons par m(t) = E(Xt) la « fonction »

moyenne du processus, et par C(s, t) = cov(Xt,Xs) la fonction de

covariance, les deux fonctions m et C déterminent complètement la

loi de toute famille finie(Xt1, ...,Xtk), et donc aussi

la loi du processus X, On a de manière évidente C(s, t) = C(t,

s), réciproquement, on a le théorème suivant.

Théorème 1:

Soit une fonction m de 11+ à valeurs

réelles, et une fonction C de 11+ x 11 à valeurs

réelles, on suppose de plus que C est de type positif,

c'est-à-dire que pour tous réels positifs (t1, ..., tk):

IC(tk,t1)tkt1 > -0

k,1

Alors, il existe un processus gaussien (Xt)t unique (en loi), tel

que :

Vt E IR+, m(t) = E(Xt)

V t, s E IR+, C(s, t) = E ((Xt -- m(t))(Xs

-- m(s)))

Ce théorème est une conséquence du

théorème fondamental de Kolmogorov sur la construction des

processus aléatoires.

Supposons maintenant que X soit un processus gaussien à

trajectoires continues, au sens où, pour tout w, l'application t 1-0

Xt(w) est continue. On peut alors définir

t

l'intégrale : Yt = f o Xt(w) ds

et obtenir ainsi un nouveau processus Y. Puisque la limite de

toute suite de lois normales est encore une loi normale (cela se prouve en

utilisant la fonction caractéristique), on vérifie, en utilisant

une approximation de Riemann de l'intégrale ci-dessus, que Y est encore

un processus gaussien. Par un calcul on peut montrer que sa fonction moyenne m'

et sa fonction de covariance C' sont données par :

t

me(t) = f m(s)ds

o

sC'(t, s) = f t

du f C(u, v)dv

o o

3. Mouvement brownien :

3.1. Construction du mouvement brownien :

Le mouvement brownien, ou processus de

Wiener, joue un rôle fondamental dans de nombreux domaines. Il

fut introduit pour la première fois en 1827 par le botaniste Robert

Brown en observant des mouvements de grains de pollen dans un liquide. Ensuit

par Louis Bachelier en 1900 pour des applications à la finance et a de

nouveau,

à l'heure actuelle, un rôle important en

mathématiques financières. Il fut redécouvert peu

après Bachelier par Einstein, et est devenu depuis un des outils majeurs

de la modélisation en physique. On le note : W = (Wt)t,0 ou B = (Bt)t,0

, Il peut être construit de différentes manières. Les

définitions les plus usuelles du mouvement brownien sont les suivantes

:

Définition 5 : un processus gaussien

Le mouvement brownien est un processus gaussien centré

(E(Wt) = 0) pour tout t, de covariance C(s, t) = min (s, t) .

Définition 6 : un processus à

accroissements indépendants stationnaires

Le mouvement brownien est un processus à accroissements

indépendants et stationnaires. Plus précisément, pour tous

s, t 0, la variable Wt+s -- Wt est indépendante des variables

(Wr: r t), Wo = 0, et de plus la loi de l'accroissement

Wt+s -- Wt est la loi normale N (0, s). Elle ne dépend donc

que de s.

Commentons les équivalences entre ces deux

définitions. Si W est un processus gaussien centré de covariance

C(s, t) = min (s, t), ses accroissements ont de manière évidente

la distribution souhaitée. Puisque, pour r < t: E((Wt+s --

Wt)Wr) = E(Wt+sWr) -- E((WtWr) = 0, la

variable Wt+s -- Wt est indépendante des variables

(Wr: r t), par les propriétés des vecteurs gaussiens.

Le processus W est donc un processus gaussien à accroissements

indépendants et stationnaires. Si, réciproquement, le processus W

satisfait les propriétés de la définition

2, il est presque immédiat de vérifier que c'est un

processus gaussien possédant les caractéristiques voulues.

Il existe une troisième approche classique du mouvement

brownien, qui consiste à l'obtenir comme limite de marches

aléatoires. Ce résultat fondamental est donné par

le théorème de Donsker et est, en fait, au niveau des processus,

une version du théorème usuel de la limite centrale.

Théorème 2 :

Soit une suite (Xn)n>0 de variables aléatoires

réelles indépendantes, identiquement distribuées, avec

E(Xn) = 0 et E(Xn2) = 1 . Soit Sn =

E i<i.<n Xi. avec So = 0 .

Les processus des sommes normalisées Yt n = vin S[nt]

(où [nt] désigne la partie

entière de nt ) convergent en loi, en tant que processus,

vers le mouvement brownien.

3.2. Régularité des trajectoires du

mouvement brownien :

Ainsi défini, le mouvement brownien n'a pas

spécialement de régularité, en tant que fonction du temps

à valeurs réelles. On va voir que, dans certains cas, le

modèle mathématique permet de construire un processus «

équivalent » au processus initial, et qui possède une

propriété de continuité presque sure.

Définition 7 :

Deux processus X et X', définis sur le même espace

de probabilité, sont dits des modifications l'un de l'autre si pour tout

t , X = X' presque surement.

Le critère suivant, appelé critère

de Kolmogorov, montre que sous certaines conditions, un processus peut

avoir une modification qui est presque sûrement

continue, au sens où, pour presque tout w, la trajectoire t 1-0

Xt(w) est continue. Théorème 3:

Si un processus X est tel qu'il existe trois constantes

strictement positives a, /3, C avec, pour tous t et h :

E(|Xt+h. -- Xt|a) <Ch1+16

(1.1)

alors X admet une modification presque surement à

trajectoires continues.

Dans le cas du mouvement brownien, la variable aléatoire

Wt+h. -- Wt est gaussienne centrée de variance h, donc :

E(|Wt+h. -- Wt|4) < 3h2

Le critère de Kolmogorov s'applique et on obtient :

Théorème 4:

Il existe un processus W = (Wt)t,0 presque surement à

trajectoires continues, à accroissements indépendants et

stationnaires, et tel que, pour tout t, la variable aléatoire Wt est

gaussienne centrée et de variance t.

Cette propriété peut également se

comprendre grâce au théorème 1 de

Donsker. Choisissons des variables Xn, qui prennent

seulement deux valeurs -1 et 1, avec probabilité 1/2

pour chacune d'entre elles. Dans ce cas, les processus discontinus

Yn ont des sauts de taille #177;1/Vn, qui

convergent, uniformément sur tout intervalle de temps

borné, vers 0. On peut donc s'attendre à ce que, à la

limite, le processus W soit continu.

Dans la suite, nous considérons toujours des mouvements

browniens ayant des trajectoires continues et qui sont nuls au

temps 0. On appelle souvent un tel processus un

mouvement brownien standard.

En affinant le critère de Kolmogorov, on peut

également montrer que les trajectoires du mouvement

brownien sont höldériennes d'ordre a, pour a < 1/2,

c'est-à-dire que, presque sûrement |Wt+h -- Wt|

C|h|a, pour une constante C. En dehors de ces

résultats de continuité, les propriétés de

régularité du mouvement brownien sont

très mauvaises. On montre par exemple que :

Proposition 1 :

Les trajectoires t 1-0 Wt sont presque sûrement nulle

part dérivables, et qu'elles sont même à

variation infinie sur chaque intervalle de longueur positive. Cela

signifie donc qu'il n'y a pas de mesure it,,(dx) telle que

Wt(w) = it,,([0, t[). Pour cette raison, on ne pourra pas

définir l'intégrale f f(s)dWt(w) qui serait l'intégrale

de Stieltjes de la fonction f par rapport à la mesure

(non existante) it,,(ds).

3.3. Mouvement brownien standard :

Définition 8:

Un mouvement brownien standard (abrégé

M.B.S.) est un processus aléatoire à temps

continu(Wt, t E IR+) tel que :

i) Wo = 0 p. s,

ii) (Wt) est à accroissements indépendants et

stationnaires

iii) (Wt)--N(0, t), Vt > 0.

Cette définition permet de démontrer la

propriété que (Wt) est à trajectoires

continues.

Remarque :

De cette définition, il suit que pour t ~ s ~ 0, Wt --

Ws--Wt_s--N(0, t -- s) c'est

à dire :

E(Wt -- Ws) = 0 et E((Wt --

Ws)2) = t -- s.

En appliquant la loi des grands nombres, on trouve encore que

/qtt --> 0 p. s, lorsque t --> 00. De plus, on a

/q,/: --N(0,1), pour tout t > 0.

3.4. Transformations du mouvement brownien standard

:

Soit W un mouvement brownien standard. Alors les cinq processus

ci-dessous sont également des

mouvements browniens standards :

1) Wt(1) = --Wt (propriété

de symétrie du mouvement brownien).

2) soit T E IL+ fixé :

Wt(2) = Wt+T -- WT, t E IL+

(stationnarité).

3) soit T E IL+ fixé :

Wt(3) = WT -- WT_t, t E [0, T] (renversement du

temps).

4) soit a > 0 fixé : Wt (4) = 1 ,/a Wat, t E

IL+ (loi d'échelle).

5) Wt(5) = tWi

t

|

, t > 0 et Wt(5): = 0 (inversion du

temps).

|

3.5. Semi-groupe du mouvement brownien :

Définissons tout d'abord la notion de filtration, qui

modélise l'évolution de l'information au cours

du temps.

Soit un processus X = (Xt)t>0 sur un espace de

probabilité (12, Jl, P). Nous notons Ft la tribu

engendrée par les variables aléatoires Xs pour s t,

qui est la plus petite

tribu rendant toutes ces variables

mesurables. Nous avons Ft c Jl, et également

Fs c Ft si s t.

Définition 9 :

1) La famille croissante F = (Ft)t>0 est

appelée la filtration engendrée par le processus

X, et est aussi notée F" = (Ft")t>0.

2) Plus généralement, une

filtration est une famille F = (Ft)t,0 de tribus de A

satisfaisant Fs c Ft si s t.

Propriété de Markov :

Considérons un mouvement brownien W sur (12,A,P), et la

filtration F = (Ft)t,0 qu'il engendre. Puisqu'il est à accroissements

indépendants, la variable Y := Wt+s -- Wt est

indépendante de la tribu Ft, on a pour chaque fonction f

borélienne bornée sur IR :

E(f(Wt+s)\Ft) = E(f(Wt + Y)\Ft)

= f IR 1/ ,2 its e'2/ 2s f (Wt + x)dx

(1.2)

Cette formule montre que conditionnellement à Ft, la

loi de Wt+s ne dépend pas de tout le passé

(c'est-à-dire de toutes les variables W. pour r t), mais seulement de la

valeur « présente » Wt du processus. On dira que le mouvement

brownien est un processus de Markov.

Définition 10:

Un processus (Xt)t est un processus de Markov si, étant

donné la filtration (Ft')t engendrée par le

processus, celui-ci vérifie la propriété de Markov,

à savoir que pour tous s, t 0 et pour toute fonction f borélienne

bornée sur IR :

E(f(Xt+s)\Ft') = E(f(Xt+s)\Xt) (1.3)

Dans le cas du mouvement brownien, les variables W. pour r t

d'une part, et les variables W. pour r t d'autre part, sont

indépendantes, conditionnellement à la valeur de Wt. De plus, la

loi de Wt+s sachant Ft dépend bien sûr de s,

mais pas de t. On dit que le mouvement brownien est un

processus de Markov homogène en temps.

Définition 11 :

Un processus (Xt)t est un processus de Markov homogène

en temps si pour tous s, t 0 et pour toute fonction f borélienne

bornée sur IR, il existe une fonction borélienne hs

telle que :

E(f(Wt+s)\Ft') = hs (Xt)

(1.4)

Si X = (Xt)t>0 est un processus de Markov, son

evolution est decrite par une famille (Ps,t(x, dy))o.s.tde probabilites de

transition de Ir vers Ir, (ou plus

generalement de (E,E) vers (E,E) si X prend ses valeurs dans

l'espace mesurable (E,E) . La probabilite Ps,t(x,

·)

represente la loi conditionnelle de Xt quand Xt = x .

Grâce à la propriete de Markov et à la

relation E( E(X\3)\~) = E(X\~), on montre la propriete de

semi-groupe. Pour 0 r s t :

Pr,t(x, A) = f Ir Pr,s(x,, dy) Ps,t6

7 , A) (1.5)

qui s'ecrit plus rapidement Pr,t =

Pr,sPs,t .Observons que Ps,s(x, dy) est la

mesure de Dirac 8x(dy) au point x.

Dans le cas ou X est un processus de Markov homogène, la

probabilite de transition

Ps,t depend seulement de la difference t - s. En

ecrivant Pt = P~,t = Ps,s+t pour tout t , on definit alors le

semi-groupe de transition.

Définition 12 :

Soit X un processus de Markov homogène.

On appelle semi-groupe de transition de X la famille

(Pt)t>0 d'operateurs positifs lineaires :

Pt: 4) e L'(Irt) 1-0 Pt4) e

L'(Irt)

Pt4)(x) = E(4)(~t)\X0 = x) = .1" 4)(y)Pt(x, dy)

Ird

qui satisfait Pt1 = 1 et la propriete de semi-groupe :

Po = Id, Pt+s = Pt 0 Ps , Vs,t

> 0 (1.6)

Dans le cas du mouvement brownien, qui est un processus de Markov

homogène, le semi-groupe (Pt)t>0 est donne par :

Pt(x, dy) = 1

V 27rt exp (-- (y_ 2:)2) dy (1.7)

comme le montre immediatement la formule (1.2).

En utilisant les relations (1.2) et (1.7), on obtient facilement

les proprietes :

E(Wt\Fs) = Ws ;

E(Wt2\~s) = Ws2 + t -- s

(1.8)

3.6. Mouvement brownien multidimensionnel :

Définition 13:

Un mouvement brownien d-dimensionnel est une

collection W = (Wt)1,t,d de dmouvements browniens à

valeurs réelles Wt = (Wtt)t~o, qui sont

indépendants entre eux.

Ce processus est encore un processus de Markov homogène

(et même un processus à accroissements

indépendants). Son semi-groupe vaut alors :

|

Pt(x, clY) =

|

1 exi 11Y -- x112Vcl

(V2mt) P 2t rY

|

où x et Y appartiennent à Rd,

11

·11désigne la norme euclidienne sur Rd, et clY

la mesure de Lebesgue sur Rd.

4. Martingales et temps d'arrêt :

4.1 Martingales :

Nous allons maintenant définir et étudier en

détails une classe fondamentale de processus, qui

vérifient la propriété de la relation (1.3).

Définition 14:

Soit(Sl, c 4, P) un espace de probabilité, muni d'une

filtration1F = (Ft)t~o.

· Un processus à valeurs réelles M = (Mt)t,o

est une 1F-martingale si :

a) il est adapté à la

filtration(Ft)t,o, ce qui veut dire que pour tout t, Mt est Ftmesurable ;

b) chaque variable Mt est intégrable, et :

s < t Ms = E(Mt\F~) (1.9)

· On dit que M est une 1F-surmartingale

(resp. une 1F-sousmartingale) si l'égalité

cidessus est remplacée par :

Ms > E(Mt\F~) (resp.

Ms < E(Mt\F~) ) (1.10)

En particulier, l'espérance E(Mt) d'une martingale,

(resp. d'une surmartingale,

sousmartingale), est une

fonction constante du temps (resp.

décroissante,

croissante). De manière

évidente, une martingale est un processus qui est à la fois

une surmartingale et une sous-martingale et si M est une

surmartingale, alors --M est une sous-martingale.

Remarque 1 :

Le mot « martingale » vient du monde des jeux, et a

été donné initialement à la suite d'une mauvaise

interprétation des « martingales » soi-disant trouvées

par les joueurs pour gagner à coup sûr.

En fait, le sens mathématique de ce terme,

appliqué à un jeu, est le suivant. Supposons que la variable Mt,

égale au gain du joueur s'il arrête de jouer au temps

t, soit une martingale. L'espérance « conditionnelle

» du gain du joueur, si celui-ci arrête de jouer en un temps

t strictement supérieur à s, et sachant le

passé jusqu'au temps s, est alors égale au gain

Ms qu'il obtiendrait s'il arrêtait de jouer au temps

s. Ainsi, le jeu est équitable en espérance ou, en

d'autres mots, le joueur maximisera la moyenne de ses gains en ne jouant pas du

tout !

Exemples :

Soit W = (1/10t,0 un mouvement brownien, et F = (Ft)t,0 la

filtration qu'il engendre.

Exemple 1 : le processus W est une F

-martingale. En effet, Wt+s--Wrest centré et

indépendant de Ft , et donc E(Wt+s--Wt\Ft) = 0.

Exemple 2 : le processus Mt = Wt2 --

t est une F -martingale. En effet :

Mt+s-- Mt = (Wt+s--Wt)2 +

2(Wt+s--Wt) -- s

~ ~ ~~~ ~~~~ ~ ~~

Exemple 3 : soit ~ ~ ~. Le processus ~~ t) est

une F- martingale.

2

En effet :

~ ~ ~~~ ~~~~~~~~~~~ ~ ~~

~~~~

~ /~~ 2 ~~

A2 0-2

le fait que si U est une variable N(0, a2), alors

E(exp(A.U)) = exp 2 .

4.2. Comportement d'une martingale à l'infini

:

Soit M une surmartingale ou une sous-martingale pour la

filtration F. On peut montrer qu'il existe une « version » de M pour

laquelle toutes les trajectoires sont

continues à droite et ont des limites à

gauche. Nous ne considérerons dorénavant que de telles

versions. En fait, presque toutes les surmartingales et sousmartingales que

nous rencontrerons dans ce travail auront des trajectoires continues.

Nous allons énoncer une propriété

remarquable des martingales.

Proposition :

Si M est une martingale satisfaisant :

suptER+ E(|Mt|) < +00 (1.11)

alors t 1-> Mt(w) admet, pour presque tout w, une limite (qui

peut être infinie) quand t 1-> +00 , et cette limite est notéet

1-> M,(w).

Observons que cette propriété ne s'applique pas

à l'exemple 1 ci-dessus, pour

lequel E(|Wt|) = .12t h r, ni pour l'exemple

2, pour lequel E(|Mt|) = ct pour une

constante c > 0, tandis

qu'il s'applique pour l'exemple 3, puisque

E(IMt~~) =

E(Mt~) = 1.

Une importante question est alors de savoir quand cette

égalité (1.9) reste vraie pour s = 00 . La réponse (non

triviale) est la suivante.

Théorème 5:

Mt = E(Mc\Ft) <=> Mt -

Moo dans L1 (1.12)

Ces propriétés sont, comme on l'a vu grâce

à l'exemple 3, strictement plus fortes que la relation

(1.11). Elles sont en fait équivalentes au fait que M est une

martingale uniformément intégrable, au sens suivant.

Définition 15:

La famille des variables aléatoires (Mt)t>0 est

uniformément intégrable si :

lim sup t E(|Mt|1|m~|>a) = 0 (1.13)

a-+oo tER+

Inégalité de Doob :

L'inégalité suivante est fondamentale et

spécifique aux martingales. Elle donne un contrôle en norme

LP du supremum d'une martingale, sur un intervalle de temps fini, en

fonction de la valeur absolue de sa valeur terminale.

Théorème 6:

|

Soit M une martingale nulle en 0. On note.

Mt~ = sup

.s..t

|

IMsI.

|

Alors, pour tout entier p > 1,

E(( MnP) ( )

P 13

1 - p E(PMt|P)

4.3 Temps d'arrêt :

Cette notion joue un rôle très important en

théorie des probabilités.

Définition 16:

Soit F une filtration. Une application T : 12 1-> [0, oo] est

un temps d'arrêt si (T t} E Ftpour tout t 0.

Un temps d'arrêt est donc un temps aléatoire, tel

que sur chaque ensemble

(w: T(w) t}, l'application w 1-> T(w) dépend seulement

de ce qui s'est passé avant le temps t.

Un joueur honnête, qui ne peut pas anticiper sur les

événements futurs, peut décider d'arrêter le jeu au

temps aléatoire T uniquement si T est un temps d'arrêt.

Un exemple trivial de temps d'arrêt est donné par T(w) =

t pour tout w.

En dehors des temps constants, l'exemple fondamental de temps

d'arrêt est le temps d'atteinte d'un ensemble

borélien A par un processus x à trajectoires

continues à droite et adapté à la filtration F.

On définit plus précisément :

T = inf(t 0 ; xt E A)

(avec la convention que l'infimum de l'ensemble vide vaut+oo).

Le fait que le temps d'atteinte de l'ensemble A est un temps

d'arrêt est difficile à prouver pour un

borélien A arbitraire, mais facile à prouver quand A est un

ensemble ouvert. En effet, dans ce cas :

(T t} = (xt E A} U (urEQn[0,t]

(xr E A}) ce qui permet de conclure.

Considérons X et A comme ci-dessus et

S un temps d'arrêt. Un nouvel exemple de temps

d'arrêt est T = inf(t: t > S ; Xt E A). Ce temps est le temps

d'atteinte de A par X, après le temps S.

En revanche, le dernier temps avant un temps fixé s

où un processus adapté X visite un ensemble

borélien A, défini par T = sup(t: t > s ; Xt E A) (où

le supremum de l'ensemble vide est égal à 0)

n'est pas un temps d'arrêt. En effet, T est mesurable,

mais la valeur de T(w) dépend de tout ce qui s'est passé

pour le processus X entre les temps 0 et s.

4.4. Tribu du passé d'un temps d'arrêt

:

Définition 17:

Soit T un temps d'arrêt. On appelle tribu du

passé T, la tribu notée FT égale à

l'ensemble de tous les événements A E A tels que A n (T

t) E Ft pour tout t.

Il est facile de voir que FT est une tribu, et cette notation

est cohérente avec la notation Ft car si T est

identiquement égal à t, il est clair que FT = Ft. La tribu

FT est appelée tribu du passé de T, car

elle peut être interprétée comme suit : A E FT si,

quand on s'arrête au temps T, on sait si A est

réalisé ou non.

Voici quelques propriétés simples.

Ci-dessous, S, T, (R)n désignent des temps

d'arrêt, et la filtration F est supposée vérifier

que Ft =ns>t Fs.

(U < t) E Ft , Vt = U est un temps d'arrêt.

S < T =FscFT

(S < T) E Fs n FT, (S T) E Fs n FT

R = infn(Rn) est un temps d'arrêt et

FR =nn FRn

R = supn(Rn) est un temps d'arrêt.

Théorème d'arrêt :

Soit M une martingale. La propriété (1.9) peut

facilement être étendue aux temps d'arrêt

bornés.

Théorème 7:

Si S et T sont deux temps d'arrêt et si a E 11., alors :

Ms = E(MT\Fs) sur l'ensemble (S T a) (1.14)

En particulier, si T est un temps d'arrêt qui est

borné, on a :

E(MT) = E(Mo) (1.15)

Quand Mt désigne de nouveau le gain d'un joueur au

temps t , la propriété (1.15) peut être

interprété comme suit. Quelle que soit la stratégie non

anticipante que le joueur choisit pour arrêter le jeu, et s'il doit finir

de jouer avant un temps déterministe donné (aussi grand que soit

ce temps), alors la valeur espérée de son gain est constante et

égale à son capital initial.

Observons que la relation (1.14) est, en général,

fausse sur l'ensemble(S T}, et de même (1.15) est fausse si T n'est pas

borné.

Par exemple si M = W est un mouvement brownien et si T =

inf(t: Mt = 1), alors E(M0) = 0 < E(MT) = 1 Dans ce cas, le temps

aléatoire T est presque sûrement fini, mais n'est pas borné

et a même une espérance infinie.

En revanche, dans le cas d'une martingale uniformément

intégrable, tout se passe bien.

Théorème 8:

Si M est une martingale uniformément intégrable,

alors la relation (1.14) est satisfaite sur (S T}, et (1.15) a lieu pour tout

temps d'arrêt T.

Remarquons que l'on peut considérer des temps

d'arrêt qui peuvent prendre la valeur infinie, pourvu que l'on pose Mt =

M0 sur l'ensemble( T = 0}.

Une autre propriété importante, en lien avec la

propriété (1.14), concerne le processus

arrêté au temps T, défini par

MtT = Mini,i(t,T).

On peut facilement déduire de (1.14) que si M est une

martingale et T un temps d'arrêt, alors :

MTest une martingale.

Définition 18:

Si M est une martingale et T un temps d'arrêt par rapport

à la même filtration, on appelle martingale

arrêtée au temps T la martingale MT.

5. Intégrales stochastiques :

On a vu que le mouvement brownien est à variation

infinie, et que l'on ne peut donc pas definir une integrale de

Stieltjes qui lui serait associee. On va toutefois voir qu'il

est possible de definir une integrale d'une autre nature, definie dans un

sens quadratique.

5.1. Variation quadratique :

Soit X un processus à valeurs reelles. On appelle «

variation quadratique approximee » de X au niveau n le

processus suivant :

V(X, n)t = E_i (Xi/n --

X(i_1)/n)2 (1.16)

où [nt]est la partie entière de nt.

Si X est un processus continu et à variation finie, au

sens où X est la difference de deux processus Y et Z

dont les trajectoires sont croissantes et de valeurs finies, il est

facile de verifier que V(X,n)t tend vers 0 quand n tend vers

l'infini.

Supposons maintenant que X = W soit un mouvement brownien.

Chaque accroissement W/n -- W(i_1)/n a une loi normale .N(0, 1

/n ), et donc [nt]

n

E(V(W,n)t) = . On en deduit que E(V(W,n)t)

tend vers t quand n tend vers

l'infini. Il est alors naturel et facile de prouver que

V(W,n)t converge vers t dans L1. Au vu de ce

resultat, nous disons que la variation quadratique du mouvement

brownien est (W, W)t = t. Cela montre en particulier que les

trajectoires du mouvement brownien ont une variation infinie

sur les intervalles finis.

On considère maintenant plus generalement une martingale

continue M. Définition 19 :

La martingale continue M est dite de carre integrable si pour

chaque t , Mt E L2. On peut alors, grâce au

resultat suivant, definir la variation quadratique de

M. Proposition 20:

Soit M une martingale continue de carre integrable. La variable

aleatoire

V(M,n)t converge dans L1, quand n tend

vers l'infini, vers une variable

(M,M)t notée ( (M,M)t)tn. Le processus est croissant,

continu, et est appelé la variation quadratique de M.

De plus, il vérifie que :

Mt2 -- (M,M)t est une martingale (1.17)

En fait, (M,M)t est l'unique processus croissant, continu et

adapté, nul en 0, tel que l'on ait (1.17).

Remarque 2 :

On a donc :

(W, W)t = t ; Wt2 -- t est une martingale.

En fait ceci est caractéristique du mouvement brownien

d'après le théorème de Paul Lévy suivant.

Théorème 9 :

Toute martingale M continue de carré intégrable, et

telle que Mt2 -- t soit encore une martingale, est un

mouvement brownien.

L'application M 1-0 (M,M)t se comporte comme une forme

quadratique, ce qui explique la notation. Si a, b sont des réels, par la

caractérisation ci-dessus, on obtient facilement que (aM, bM) = ab(M,

M). On peut lui associer une sorte de « produit scalaire », en

posant, pour chaque paire M,N de martingales de carré intégrable

et continues :

(M, N) = 4i ((M + N, M + N) -- (M -- N, M -- N)) (1.18)

formule qui pourrait être comparée à la

formule :

(x, 17) =

4 (11x + 17112 -- 11x -- 17112)

1

pour le produit scalaire usuel et la norme euclidienne dans

IRY.

Observons que MN -- (M, N) est une martingale, et (M, N) est

l'unique processus Y continu, adapté, nul en 0, et à variation

finie, tel que MN -- Y soit une martingale.

En particulier, si W = (Wt)i,t,d est un mouvement

brownien d-dimensionnel, on a :

(Wt, Wl)t = Stlt (1.19)

où Sii = 1 si i = j et 8' = 0 sinon. C'est

evident si i = j, et pour i # j le fait que (Wi, W1) = 0

vient du fait que le produit WiWi est une martingale,

comme produit de deux martingales independantes.

En fait, cette propriete caracterise le mouvement brownien. En

effet, on peut enoncer le théorème de Paul

Lévy suivant.

Théorème 10:

Toute martingale M d-dimensionnelle, continue, de carre

integrable, telle que :

(Mt, Mi)t = atit,

est un mouvement brownien d-dimensionnel.

5.2. Intégrales stochastiques :

Nous souhaitons maintenant donner un sens à l'integrale

fot HAM. quand W est un

mouvement brownien et H = (Ht)t,0 un processus, dont nous

preciserons ces proprietes dans ce paragraphe.

Nous nous limiterons essentiellement à des integrants H

qui sont continus en la

variable t. L'idee est alors d'obtenir C HAWs comme

limite de sommes de Riemann: I(H,n)t = ? ~~~~~~ /~

~~~~ ~~~ ~ ~ ~~~~~~

~ ~ ~1.20~

~~~

La variable W/n -- 1/17(i_1)/n a une taille d'ordre

1/vn, car elle est centree et de variance 1/n, et donc H(i_i) /n (Wi/n --

14i_1/n) est egalement d'ordre 1/vn . La

taille de I(H,n)t devrait donc être vn. Mais, dans ce

cas, les variables I(H,n)t ne pourront en general pas converger ; cela est

coherent avec le fait que les trajectoires de W sont à variation

infinie.

Pourtant, une sorte de « miracle » a lieu, quand on

suppose de plus que le processus H est adapte à la filtration du

mouvement brownien. Par simplicite, on supposera aussi que ce processus H est

borne par une constante, mais cette hypothèse peut être

allegee.

Dans ce cas, la variable

Y(n, i) = 1(i-1) /n (Wi/n -- W(i-1)/n)

satisfait E(Y(n, i) /F(i-1) /n ) = 0

et E(Y(n, i)2/F(i-1) /n ) = H(i-1) /n , n c2 /n , de

telle sorte que

[nt]

I(H,n)t = 1 Y(n, i)

i=1

est centrée, de variance :

|

[nt]

1 E(Y(n, i)2)

i=1

|

< c2t

|

Il n'est alors pas totalement déraisonnable de penser que

la suite I(H,n)t converge et, effectivement, on peut montrer

le théorème suivant.

Théorème 11:

Soit H un processus borné, continu et adapté

à la filtration du mouvement brownien. Alors la suite

:

[nt]

I(H,n)t = IH(i-i) /n (Wi/n -- W4i-1)/n)

i=1

converge dans L2 , quand n tend vers l'infini, vers

une limite, notée :

f

t HAW, o et appelée

l'intégrale stochastique de H par rapport à W sur

l'intervalle [0, t].

Remarque 3 :

1. Si H n'est pas adapté, les sommes de Riemann ne

convergent pas en général.

2. On observe que la relation (1.20) est une forme

particulière de somme de Riemann.

Si on remplace

H(i-i) /n (Wi/n -- W(i-1)/n)

par W

Ht(n,i)( i/n -- W(i-1)/n) ,

avec (i -- 1) /n t(n, i) i/n comme il est possible de le faire

pour les

approximations par les sommes de Riemann pour les

intégrales usuelles, la suite

associée I(H, n)t ne converge pas nécessairement

et, si elle converge, la limite peut être différente def

ot HsdWs.

3. La terminologie « intégrale stochastique

» permet d'insister sur le fait que cette intégrale n'est pas une

intégrale de Stieltjes usuelle, prise séparément pour

chaque valeur de co, mais une limite dans L2 .

4. Il est possible de définir l'intégrale f ot

HsdWs pour des intégrants H bornés qui ne

sont pas continus en temps. Mais, dans ce cas, l'adaptation

de H à la filtration n'est pas suffisante et il faut supposer plus de

mesurabilité. (La propriété requise s'appelle la

mesurabilité progressive).

5. Il est aussi possible de définir l'intégrale

f otHsdWs. pour des

intégrants continus non bornés H, ou même pour des

intégrants non bornés satisfaisants la mesurabilité

progressive mais, dans ce cas, on doit supposer que l'intégrale f

otHs2ds est finie pour tout t.

5.2.1 Propriétés de l'intégrale

stochastique :

Les propriétés d'adaptation sont ici implicitement

définies par rapport à la filtration du mouvement brownien W.

Théorème 12:

Soit H et K des processus bornés, continus et

adaptés.

1. Pour tous réels a,13,

f o

t t t

(aHs + 13Ks)dWs = a f

HsdWs + 13 f KsdWs

o o

2. Le processus M défini par Mt =

f(t) HsdWs est une martingale continue de

carré intégrable, nulle en 0.

3. Si, de plus, Nt = f: KsdWs, on a :

(M,N)t = f(t)

HsKsds (1.21)

En particulier, on a l'isométrie fondamentale,

donnée par la formule suivante :

2

E ((f: HsdWs)) = E(f o t

Hs2ds ) (1.22)

5.2.2. Extension de l'intégrale stochastique

:

Si l'on souhaite definir l'integrale stochastique d'un processus

continu adapte H par

rapport à une martingale M de la forme Mt =

f(t) Ks.dWs., il suffit de poser :

f : Hs.dMs. = f ot(Hs. Ks.)dWs. (1.23)

Plus generalement, on peut definir l'integrale stochastique

d'un processus continu

adapte H par rapport à une martingale continue M,

dès que (f (t) Hs.2d (M, N)s.) <

00

Cette integrale, encore notee par f :Hs.dMs., est obtenue comme

limite des sommes

de Riemann (1.20) où M remplace W. Si Mt =

f(t) Ks.dWs., on retrouve le processus

defini par la relation (1.23).

Nous avons les proprietes suivantes :

Proposition 2 :

Soit M, M' des martingales continues, H et K des processus

continus, adaptes à Fm,

et H' continu et adapte à Fm' .

t t

1. H 1-> f o

HdMs.et M 1-> f o Hs.dMs.

sont lineaires.

2. Si Nt = f :Hs.dMs., alorsf o t Ks.dNs. = f :

Hs.k.dMs. .

3. Si Nt = f :

Hs.dMs. et N' = f :H;dM;, on a :

(N, N')t = f ot Hs.H;d (M,

M')s. (1.24)

En particulier, la formule ci-dessous generalise (1.22) :

2

E ((f : Hs.dMs.) ) = E(f:Hs.2d (M, M)s.)

(1.25)

4. Si H est borne, le processus N defini par Nt = f ot Hs. dMs.

est une martingale

continue nulle en 0. Si H n'est pas borne, le manque possible

d'integrabilite en fait ce qu'on appelle une « martingale locale »,

mais nous ne developperons pas ce point dans cette partie.

5.3. Formule d'Itô :

Quand t 1-0 x(t) est une fonction réelle, continue et

à variation finie, la formule d'intégration par parties implique

que pour toute fonction f continûment dérivable, on a :

f(x(t)) = f(x(0)) + f ot f' (x(s))dx(s) (1.26)

et il existe également une version multidimensionnelle de

cette formule.

Celle-ci devient fausse quand la fonction x est

remplacée par un mouvement brownien W, ou par une martingale continue

M.

En effet, si la relation (1.26) était vraie, en prenant

f(x) = x2 , on obtiendrait

Wt2 = 2 f :

Ws.dWs. et, puisque le processus

défini par l'intégrale stochastique est

encore une martingale, on pourrait en déduire que

Wt2 est une martingale. Or, on a vu au paragraphe

précédent que la variation quadratique de W au point t est

égale à t, et donc le processus Wt2 -- t

est aussi une martingale. Par différence, le « processus » t

devrait alors être une martingale, ce qui est évidemment faux.

Ainsi la relation (1.26) est fausse pour le mouvement

brownien. Pour obtenir une formule juste, on doit ajouter un terme de plus

(appelé quelque fois terme de correction d'Itô) et

supposer plus de régularité sur f.

Théorème 13:

Considérons une martingale continue X, de variation

quadratique ( X, X). Soit f est une fonction de classe C2, alors on

a :

f(Xt) = f(Xo) + f o t f'(Xs.)dXs. +

21 f ot f" (Xs.) d(X, X)s. (1.27)

où f"est la dérivée seconde de f.

Cette formule est connue sous le nom de « formule

d'Itô » et est extrêmement utile.

La formule d'Itô appliquée au mouvement brownien X =

W et à donne

Wt2 = t + 2 f :

Ws.dWs. et on retrouve bien la

propriété que Wt2 -- t est une martingale.

Cette formule n'est pas suffisante pour les applications. On a

souvent besoin de considérer des processus de la forme

plus générale suivante.

Définition 21 :

Un processus X de la forme X = M + A , où M est une

martingale continue et A un processus adapté,

continu et localement à variation finie (à variation finie sur

tout compact de IR+ ), est appelé

une semi-martingale continue.

En regroupant l'équation (1.26) pour A et (1.27) pour M,

on obtient pour f de classe CZ une version de la

formule d'Itô pour les semi-martingales.

Théorème 14:

Soit X = M + A une semi-martingale, et f une

fonction de classe C2. On a:

~ ~~

~~~~~ ~ ~~~~~ ~ ~ ~~~~~~ ~~~ ~ ~ ~~~~~~ ~~~ ~ 2 1 ~ ~~~~~~~ ~~~,

~~~ ~1.28~

~ ~ ~

Donnons égalementt la forme « multidimensionnelle

» de la formule d'Itô..

Théorème15::

Soit X = (Xt)i,t,d des

semi-martingales de décompositionss XL =

Mt + At , oùu les Mt

sont des martingales continues et les At des processus

adaptés,, continus et localement àa variation

finie. Soit f une fonction de classe C2 sur Irt, dont

les~~ dérivées partielles des premier et second ordres sont

notées ~~ ~ et ~~~ b respectivement.

On a:~

~~~~~ ~ ~~~~~ ~ ? ~~ ~~

~ ~

~~~~~ ~~~~ ~ ~ ~~ ~~~~~ ~~~~~

~~~ ~ ~ 0~1.29~

~ 2 1 ? ~ ~~~

~ ~ ~~~~~~ ~~~~, ~~~~

~,~~~ ~ s

Remarque 4 :

Par abus de notation, on écrit souvent cette

équationn sous une forme différentielle, bien

que ce soit purement formel :

d

|

<Ant = fx(t)(dAlt + dmo

i,j=1

|

1

~2 ft7(Xt)d(1',, Mi)t (1.30)

|

Observons que ces formules impliquent en particulier que le

processusf(X),, image

d'unee

semi-martingale X par une fonction f de classe C2,

est encore une

semi-martingale, et que sa décomposition en somme d'une

martingale et d'un processus localement à variation finie, les deux

continus et adaptés, est donnée directement par (1.29).

L'intégrale stochastique par rapport à M est la partie

martingale, et le processus à variation finie est formé de la

somme des autres termes. Exemple 1 :

Considérons deux semi-martingales continues X et Y avec

:

Xt = Mt + At; Yt = Nt + Ct

M et N étant les parties martingales. En prenant f(x, y) =

xy, on obtient immédiatement :

t t

XtYt = X0Y0 + 1 Ys

dXs + 1 XsdY~ + (M,N)t

o o

Exemple 2 :

et ~~~, ~~ ~ ~~~ ~~~ ~ ~~

Appliquons (1.28) pour ~ ~ 2, et ~~ ~ ~ ~~, ~~ ~ ~ ~ ~ y). On

~ ~ ~ ~~

a ~~ ~ ~ ~~, ~~ ~ ~ 0, ~~ ~ ~ 0, ~~ ~ ~ ~, et ~~ ~ ~ ~~ , ~~~

~~ ~ ~~~ , ~~ ~ f On

obtient ainsi :

~

~~ ~ ~ ~~~ ~~~~ ~ ~~ 2 ~~ ~ 1 ~ ~ ~~~ ~~~~ ~ ~~ 2 s)

dWs

~

~

et on retrouve le fait que ~~ est une martingale, comme on

l'avait déjà. Exemple 3:

Plus généralement, si H est un processus

borné, continu, adapté, on définit :

~ ~

~~ ~ ~~~ ~~ ~~~~~ ~ 2 1 f Hsds)

~ ~

et on montre par la formule d'Itô que Z est solution de

l'équation :

Zt = 1 + fot

ZsHsdWs; t 0

Cette équation est un exemple d'équation

différentielle stochastique, équation que l'on étudiera au

paragraphe des EDS.

Exemple 4 :

Un deuxième exemple d'équation

différentielle stochastique, appelé le modèle non

homogène de Black et Scholes, utilisé en finance, est

donné par l'équation formelle:

dSt = St11(t)dt + Sta(t)dWt , SO = 1 (1.31)

Les fonctions 11 et a ?sont à valeurs

réelles, avec a(t) > 0, W est un mouvement brownien, et S est le

processus « inconnu ». C'est une équation linéaire, qui

peut être résolue explicitement. La solution est de la forme St =

exp(Mt + At), où M est une martingale continue et A un processus

adapté, continu et localement à variation finie. Pour trouver M

et A, on applique la formule d'Itô (1.30) à la fonction f(x, y)

= ex+Y , ce qui donne :

dSt = StdMt + StdAt +

1

2 Std(M, M)t

En identifiant avec (1.31), on obtient dMt = a (t)dWt,

d'où Mt = f : a (t)dWt. On en déduit que (M, M)t =

fot a(s)2ds, d'où dAt +

21 a(t)2 dt = 11(t)dt et

At = f ot (11(s)-- 21 a(s) 2 )

ds Finalement une solution de (1.31) est dormée par :

t

1

St = exp (1 a (s)dWs. + f (11(s)-- t

2 a(s)2) ds)

~ ~

6. Equations différentielles stochastiques

:

6.1. Introduction :

De manière informelle, on appelle

équation différentielle stochastique une équation

différentielle ordinaire perturbée par un terme stochastique.

Plus précisément, c'est une équation du type suivant :

dXt = b(t, Xt)dt + a(t, Xt)dWt, X0 = x0 , (1.32)

Dans cette équation, dWt est la «

différentielle » d'un mouvement brownien W, et b, a sont

les coefficients de l'équation (ce sont des fonctions

de 11+ x 11 dans 11), et x0 E 11 est la valeur

initiale. Tous ces termes sont donnés. La notation (1.32) est

la plus usuelle, mais elle n'a pas de sens (car la différentielle dWt

n'a pas de sens). Le sens mathématique sera donné sous forme

d'une équation intégrale.

Définition 22 :

Rechercher une « solution » de l'équation (1.32)

consistera à rechercher un processus X = (Xt)t>0

satisfaisant l'équation intégrale :

t t

Xt = f 0 b(s,Xs)ds + f

0 a(s,Xs)dWs (1.33)où la seconde

intégrale est une intégrale stochastique.

L'équation (1.32) ou l'équation (1.33)

étaient jusqu'à présent unidimensionnelles.

On peut également définir une équation

d-dimensionnelle de la manière suivante.

Le processus inconnu X = (Xt)i,t,d est une famille

de processus à valeurs réelles Xt =

(Xtt)t,0, la condition initiale x0 = (xt0)i,t,d

appartient à Rd , le mouvement brownien W =

(Wt)i<t<ti est q-dimensionnel, et

les coefficients ont les dimensions appropriées, soit b

= (bt)i,t,d et a = (at,i)i,t,d,i,i<ti, où les

coefficients bt et at,i sont des fonctions de

R+ x Rd dans R. On écrit encore l'équation

sous les formes (1.32) ou (1.33), mais cela signifie

maintenant que l'on a :

Xtt = xt0 + f

:bt(s,Xs)ds + Eci=i f :at,i

(s,Xs)dWst , i = 1, ...., d (1.34)

Définition 23 :

Quand les coefficients b et a ne dépendent pas du temps et

sont seulement des fonctions définies sur Rd

, on dit que l'équation est homogène.

Le coefficient b est appelé le coefficient de

dérive, tandis que a? est le coefficient de

diffusion. Un processus qui résout l'équation (1.32), ou

de manière équivalente (1.34), est

appelé processus de diffusion ou, plus simplement,

une diffusion. On notera par EDS le terme

« équation différentielle stochastique ».

6.2. Solutions d'une équation

différentielle stochastique :

Notre première tâche est de donner un sens

précis au mot « solution » de l'équation

différentielle stochastique (1.33).

Définition 24 :

Soit un mouvement brownien W = (Wt)i<t<ti

q-dimensionnel sur un espace de

probabilité (12,A,P) , et F = (Ft)t,0 la filtration qu'il

engendre. Les coefficients b et a, de même que la condition

initiale x0 E Rd , sont donnés. Nous appelons

solution forte de (1.34) tout processus

d-dimensionnel X = (Xt)i,t,d, continu,

adapté à la filtration, et tel que (1.34) a

lieu.

Observons que l'adaptation de X est nécessaire pour que

l'intégrale stochastique dans (1.34) ait un sens.

Remarque 5 :

Il existe une autre notion de solution, qui en un sens est

plus naturelle, bien que moins intuitive. Plus

précisément, nous appelons solution faible de

l'EDS (1.34) la loi d'un processus X qui résout

l'équation (dans un certain espace de probabilité muni

d'un mouvement brownien). On peut montrer que si l'on a unicité

de la solution forte, alors, on a unicité de la

solution faible.

Le premier problème à résoudre concerne

l'existence et l'unicité d'une solution.

Considérons tout d'abord le cas d'une équation

différentielle ordinaire, de la forme:

dXt = b(t, Xt)dt , X0 = x0 (1.35)

où le

coefficient b et la condition initiale x0 sont donnés.

Bien sûr, un tel problème est purement

déterministe. Un résultat classique énonce

que (1.35) admet une et une seule solution dès que :

11b(t,x) -- b(t,Y)11 C11x -- Y11 , 11b(t, 0)11 C (1.36)

où C est une constante, et 11

·11est la norme

euclidienne dans Wi.

La première condition dans (1.36) est

appelée condition de Lipschitz. Revenons

maintenant à l'EDS (1.34). On peut prouver essentiellement le

même résultat. Théorème 16 :

~ (1.37)

Sous les hypothèses de la définition

24 et si, de plus, les coefficients b et a-

satisfont, pour tous t, x, Y :

11b(t, x) -- b(t, Y)11 + 110(t, x) -- a(t, Y)11 C11x

-- Y11

11b(t,0)11 + 110(t, 0)11 C

(où 11.11 désigne la norme euclidienne dans

Wi ou Wig et C une constante positive),

alors pour tout T > 0, il existe une et une seule solution forte X

dans l'espace :

t.T

Li = [Xcontinus, adaptés; E

(sup11Xt112) < 00}

Remarque 6 :

1) L'unicité est comprise au sens presque sûr : si X

et X' sont deux solutions fortes, alors, en dehors d'un

ensemble de P-mesure nulle, on a Xt = X; pour tout t.

2) Le fait que l'on obtienne une solution dans un espace de type

L 2 n'est pas surprenant : c'est en effet dans ce

cadre que l'on a développé le calcul stochastique.

Nous avons déjà rencontré, l'EDS non

homogène linéaire suivante :

dXt = pt(t)Xtdt + a(t)XtdWt, X0 = 1 (1.38)

où pt? et a? sont des fonctions

continues bornées sur IR+ . Elle a une solution

explicite donnée par :

t

1

Xt = exp (1 a(s)dWs. + 1

(pt(s)-- t

2 a(s)2) ds)

~ ~

on a ici d = q = 1 et les coefficients b(t,Xt) = pt(t)x et a(t,x)

= a(t)x

satisfont à (1.37). Le théorème implique

alors que la solution explicite est l'unique solution forte de

cette équation.

Quand pt(t) = pt et a(t) = a sont constants, la solution est

appelée «mouvement brownien géométrique avec

drift ».

Comme pour les équations différentielles

ordinaires, les hypothèses (1.37) de

lipschitzianité et de bornitude sont suffisantes, mais pas

nécessaires, pour obtenir l'existence et

l'unicité de la solution. Par exemple, on a le résultat plus fort

suivant, spécifique à la dimension 1.

Théorème 17 :

Dans le cas d'une EDS unidimensionnelle, si on a :

|

|b(t,x) -- b(t,Y)| + |a(t,x) -- a(t,Y)|2 C|x -- Y|

|b(t, 0)| + |a(t,0)| C

|

~ (1.39)

|

alors il existe une unique solution forte.

Ici, a n'est plus lipschitzienne, mais seulement

höldérienne de rapport 1/2. Remarque 7 :

Très souvent, on considère des EDS

homogènes. Pourtant, en pratique (spécialement

en finance), les EDS non homogènes sont utiles. Dans ce cas,

l'hypothèse (1.37) est un peu restrictive, car souvent, les

coefficients « explosent » quand le temps tend vers

l'infini. Il est alors utile de savoir que l'existence et

l'unicité sont préservées, quand (1.37)

est remplacée par :

Ilb(t, x) -- b(t, y)Il + Ila(t, x) -- a(t, y)Il CtIlx -- yIl

I

Ilb(t, 0)Il + Ila(t, 0)Il Ct

où t 1-0 Ct est une fonction croissante à valeurs

finies. Processus d'Ornstein-Uhlenbeck :

Le mouvement brownien a ete construit pour modeliser le

deplacement d'une particule microscopique, en suspension dans un liquide,

soumise à l'agitation thermique. Une critique importante faite à

cette modelisation est que les accroissements sont independants et ne dependent

pas de la vitesse de la particule au debut de chaque periode. Un modèle

plus sophistique, tenant compte de la vitesse de la particule, conduit alors au

processus suivant.

Définition 25 :

On appelle processus d'Ornstein-Uhlenbeck le processus X à

valeurs reelles, solution de l'EDS :

dXt = --bXtdt + cdwt , Xo = xo (1.40)

où xo E R , b E R et c > 0.

Les coefficients de cette equation satisfont (1.37), donc il y a

une solution et une seule. On peut montrer à l'aide du calcul

stochastique que X a la forme explicite :

Xt = xoe-bt + c f :e-b(t-s)dws

(1.41)

Nous observons que Xt est egal à l'integrale

stochastique d'une fonction deterministe par rapport à un mouvement

brownien. Nous en deduisons que Xt est une variable aleatoire gaussienne, comme

limite (à une constante additive près) des approximations de

Riemann de l'integrale stochastique, qui sont gaussiennes. On en deduit

même que le processus X est gaussien. Il est facile de calculer sa

fonction moyenne m(t) et sa fonction de covariance C(s, t) qui, pour s t ,

valent :

|

m(t) = xoe-bt , C(s, t) =

2C2b (e-b(t-s) -- e-b(t+s))

|

(1.42)

|

Modèle de Vasicek :

Ce modèle, introduit par Vasicek en 1977, sert à

modéliser un taux de placement à court terme. Ce taux fluctue

suivant l'EDS décrite ci-dessous, qui

généralise la précédente. Ici, x0 E I1 , b, b' E I1

et c > 0 :

dXt = (--bXt + b)dt + cdWt , X0 = x0 (1.43)

Les coefficients de cette équation satisfont (1.37), donc

il y a une solution et une seule. De nouveau, on peut trouver une forme

explicite pour la solution :

t

Xt = b' + (x -- b') e-bt + c 1

e-b(t-s)dWs (1.44)

0 b 0

et, par le même argument que pour le processus de

Ornstein-Uhlenbeck, nous voyons que cette unique solution

forte X est un processus gaussien.

Remarque 8 :

Une caractéristique commune aux exemples

précédents est que les coefficients dépendent

linéairement de X, ou n'en dépendent pas du tout. C'est pourquoi

on peut trouver une solution explicite. Dans le cas de coefficients plus

généraux, il n'y a en général pas de solution

explicite, comme pour une équation différentielle ordinaire.

CHAPITRE II :

Généralités sur les EDPs et la

méthode des différences finie

0. Introduction:

Le métier d'ingénieur est toujours besoin

d'utilisation des logiciels de modélisation. Ces logiciels

résolvent des équations telles que les équations aux

dérivées partielles, mais la résolution ici est faite par

une méthode discrète. Donc ces équations

différentielles ne peuvent en général pas être

résolues de façon exacte. Elles sont résolues de

façon approchée, à l'aide des méthodes

numériques.

Les méthodes numériques ne donnent pas la

solution véritable du problème que l'on cherche à

résoudre. Des méthodes numériques mal employées

peuvent conduire à des résultats totalement faux, Il est

indispensable pour un ingénieur de posséder des notions de base

sur les méthodes numériques utilisé pour résoudre

son problème.

Dans ce chapitre on présente une méthode

numérique pour la résolution des EDPs,

La méthode des différences finies.

1. Généralité sur les

équations aux dérivées partielles :

1.1. Définitions :

· Equation aux dérivées partielles

:

Une équation aux dérivées partielles

fait intervenir plusieurs variables indépen- dantes (temps et espace

pour les équations de l'ingénieur), ainsi que les

dérivées partielles de la variable

dépendante (

c.-à-d.

la solution recherchée) par rapport à ces

variables indépendantes.

Exemple : l'équation de convection (parfois

appelée advection)

=

ax 0 (2.1)

ac

+

at +u

ac

est une EDP, la variable dépendent est c , les

variables indépendantes sont le temps t et l'espace x.

La grandeur u (homogène à une vitesse) peut (ou non)être

fonction de t ,x et c.

· Ordre d'une EDP :

L'ordre d'une EDP est défini exactement de la même

façon que pour une EDO : c'est l'ordre le plus

élevé parmi toutes les dérivées partielles de

l'EDP.

Exemple : l'EDP (2.1) est une EDP d'ordre 1 (par rapport

à t ou x ). En revanche, l'EDP suivant :

ac

+

at +u

ac

+ D

ax

ax2 = 0 (2.2)

a2c

est une EDP d'ordre 2 car sa dérivée partielle

d'ordre le plus élevé est une dérivée

seconde(en l'occurrence par rapport à x).

· EDP linéaires, quasi-linéaires et

non- linéaires :

EDP linéaire : est une EDP qui ne fait

intervenir que des combinaisons linéaires des

dérivées partiales de la variable dépendante.

Exemple : l'équation suivante est linéaire :

a2u A+2B ax2

|

a2u ~~~

~~~~ ~ ~ ~2.3~

~~~ ~ ~ ~~, ~, ~~

~~ , ~~ ay) = 0

|

|

où les coefficients A, B et C sont dépend de X et

Y (connues), F est une fonction lineaire et U est la fonction inconnue

(à déterminer).

EDP quasi-linéaire : est une

équation linéaire par rapport aux dérivées

partielles d'ordres supérieurs.

Exemple : l'équation précédente (2.3) est

quasi-linéaire si les coefficients A, B et C sont en fonction de U et/ou

de X, Y et F peut être non linéaire.

EDP non-linéaire : est une EDP où

l'une des dérivées partielles intervient comme argument d'une

fonction non-linéaire.

Exemple : l'équation suivante:

Co

|

~~~~

~~~~ ~ ~~ ~~~~ ~2.4~

~~~~ ~ ~~ ~~~

~~~ ~ ~~ ~~~

~~~ ~ 0

|

|

est non-linéaire si au moins des fonctions Co(x) et C1(x)

n'est pas linéaire par rapport à x.

1.2. Conditions initiales et conditions aux limites

:

Contrairement aux EDOs, les conditions initiales ne suffisent

pas à assurer l'unicité de solution. Il faut également

fournir des conditions aux limites. Pour certains types d'équations (ex.

EDPs elliptiques), le concept de condition initiale n'a pas de sens.

Les conditions initiales et les conditions aux limites se

distinguent de la manière suivante :

· Une condition initiale s'applique pour une valeur

donnée (et unique) d'une variable indépendante. A partir de cette

condition initiale, il est possible de déduire la solution pour toutes

les autres valeurs de la variable indépendante.

· Une condition aux limites est appliquée en

tout point de la frontière du domaine sur lequel on souhaite

résoudre l'équation (et non en un point unique). Il n'est pas

possible de déterminer la solution en partant simplement d'un seul point

de la limite de domaine et en progressant à l'intérieur de

celui-ci, car la solution est également conditionnée par sa

valeur en tous les autres points de la frontière.

1.3. Classification des EDPs du second ordre

:

Les EDPs du second ordre représente une classe

importante des EDPs du monde de l'ingénierie, on traite dans quel suit

des EDPs second ordre quasi-linéaires de la forme générale

:

a2u A + B

aX2

a2u a2u

+

aY2 D

au

+ E

aX

aY + F = 0 (2.5)

au

où A ,B,C,D,F sont des fonctions de X,Y et u. X et Y

sont les variables

indépendantes (ce pourrait être t,x,y etc)

de l'EDP et u la variable dépendante.

Selon la valeur des coefficients A ,B et C, l'EDP est dite

hyperbolique, parabolique ou elliptique.

EDPs hyperbolique :

Une EDP du type (2.5) est dite hyperbolique si son discriminant

A= B2 -- 4AC est strictement positif.

Exemple : l'équation suivante est du

type hyperbolique :

a2u

at2

A. ax2

2 = 0 (2.6)

En effet, l'équation (2.5) peut être mise sous

la forme (2.6) en posant X = t, Y = x, A = 1, C = --A.2, et B = D =

E = F = 0. Il est facile de vérifier que A= B2 -- 4AC > 0.

A noter que A. est homogène à une vitesse.

EDPs paraboliques :

Une EDP du type (2.5) est dite paraboliques si son discriminant

A= B2 -- 4AC est nul.

Exemple : l'équation suivante est du

type paraboliques :

ax2 = 0, v > 0 (2.7)

au

-- v

at

a2u

En effet, l'équation (2.5) peut être mise sous la

forme (2.7) en posant X = t, Y = x , D = 1, C = v, et A = B = E = F = 0. On

vérifiera que A= B2 -- 4AC = 0.

EDPs elliptique :

Une EDP du type (2.5) est dite elliptique si son discriminant A=

B2 -- 4AC est strictement négatif.

Exemple : l'équation suivante est du

type elliptique :

0y2 = Q (2.8)

a2u ax2 +

a2u

En effet, l'équation (2.5) peut être mise sous la

forme (2.8) en posant X = t, Y = x , A = C = 1, et B = D = E = F = 0, on peut

vérifier que A= B2 -- 4AC < 0.

· Une aide mnémotechnique :

L'<< astuce >> suivante peut etre utilisé

pour déterminer la nature d'une EDP du seconde ordre : il suffit, dans

l'équation originale, de remplacer les dérivées

aPu / a XP (p = 1,2) par XP et aPu / a

YP (p = 1,2) par YPet le second membre par une constante.

Ainsi (2.5) devient :

AX2+BXY + Y2 + DX + EX + F = Cst (2.9)

L'équation (2.9) est l'équation d'une courbe

conique dans le plan(X, Y). Si cette courbe est une ellipse, l'EDP est

elliptique ; si la courbe est une parabole, l'EDP est parabolique ; enfin, si

la courbe est une hyperbole l'EDP est hyperbolique.

Exemple : en appliquant la méthode ci-dessus à

l'équation(2.6), on obtient :

T2 -- A.2X2 = Cst (2.10)

qui

est l'équation d'une courbe hyperbolique dans le plan(X, T).

1.4. EDPs du second d'ordre à plusieurs variables

indépendantes:

Le principe de classification des EDPs reste le même

quand on se trouve en présence de 3(ou 4) variable indépendantes.

Par exemple, l'EDP (2.6) peut être généralisée

à deux dimensions d'espace :

a2U a2u a2u

A.2 A2 = 0 (2.11)

at2 x ax2 Y ay2

où A.x2 et 4 sont les vitesses

de propagation des ondes les directions x et y (elles sont égales dans

un milieu isotrope). En utilisant la transformation exposée dans le

paragraphe précédent. On obtient :

T2 --

A.x2X2--A.Y2Y2

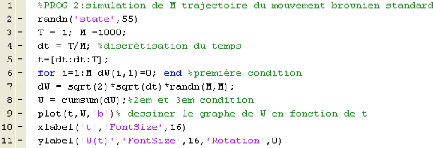

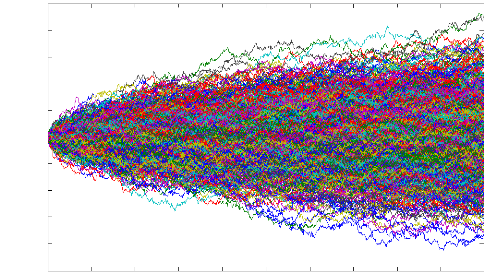

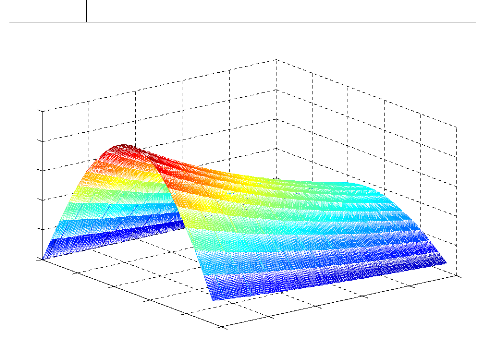

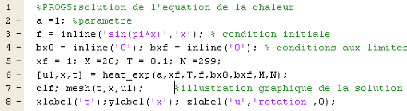

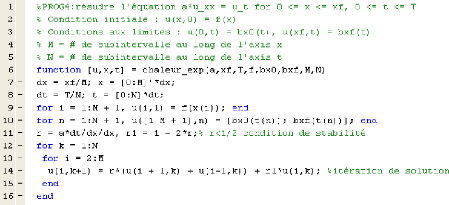

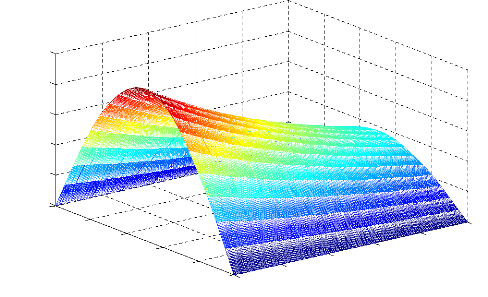

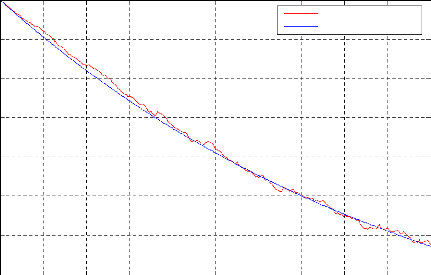

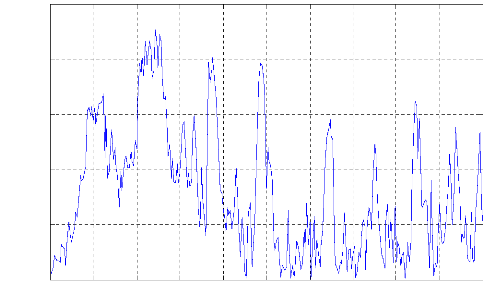

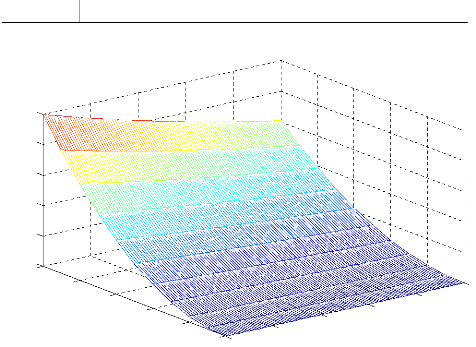

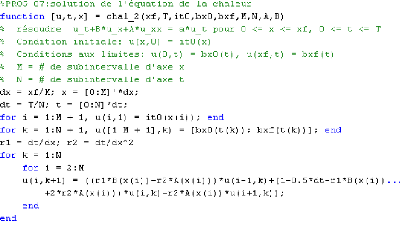

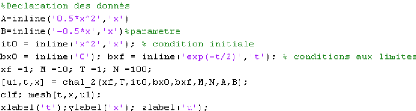

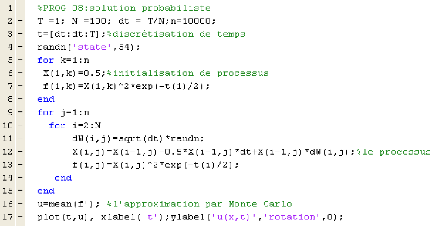

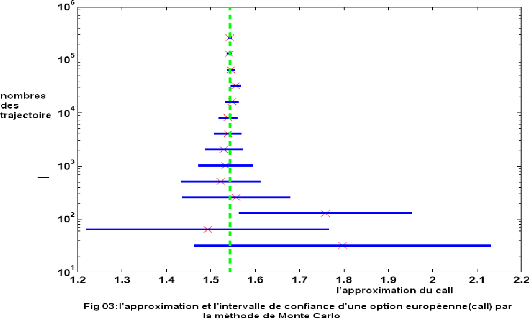

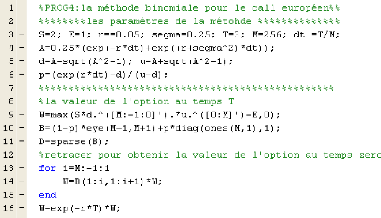

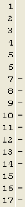

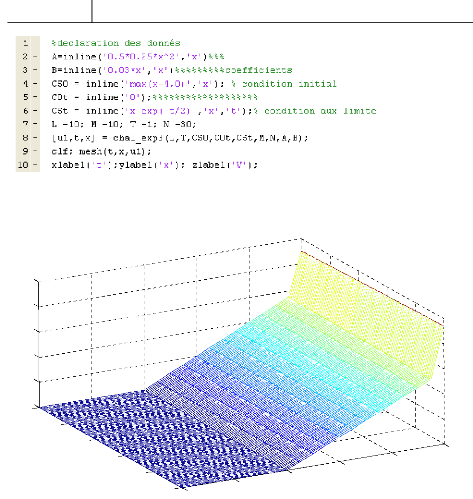

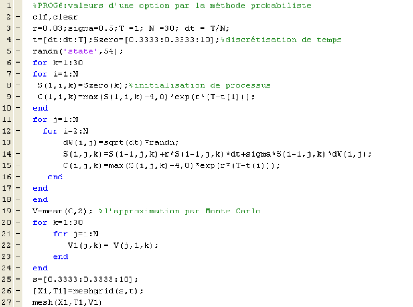

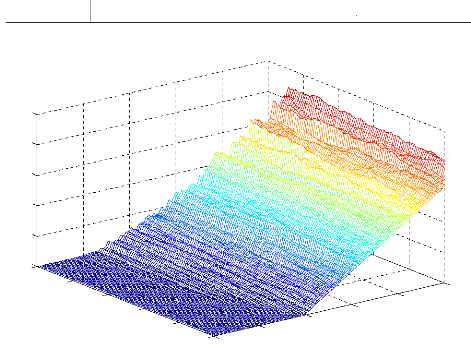

= Cst (2.12)