|

?e?????q?? ????s?????

????ster? ??

????s????????t ???éri??r,

???l????e??e?S???n??fiq?e?et??e ?a?????????c

U????rs?té ??

? \u9670·?????r? a ??rt????

Ecole Superieure de la Statistique et de

l'Analyse de l'Information

Projet de Fin d'Etude

EsTIMATION NON-PARAMETRIQUE PAR NOYAUX

AssOCIIs

ET DONNEEs DE PANEL EN MARKETING

Pres??te ??r?:

I??? BEN KHALIFA

??s ?? ??r??t?? ???

Celestin C. KOKONENDJI, HDR

U????rs?te ?? P?? ?t ??s

P?\u9313‡As ?? ????r

???r?t?r? ??

??t?e??t?q??s ?????q?e?s ?- U?? ????

?\u9670·??

E-mail:

celestin.kokonendji@univ-pau.fr

Dhafer MALOUCHE, MA

???? ??er???r? ?? ??

?t?t?st?q?? ?t ?? ??????\u9313‡As? ??

???r??t??

E-mail:

dhafer.malouche@essai.rnu.tn

Résumé

Dans ce rapport, nous nous interessons a la notion destimation

non-parametrique d'une densite (fonction de masse) inconnue sur ? ?

R par la methode des noyaux associes. Pour ce faire,nous presentons

dabord une definition(unifiee)dun noyau associeà une loi de

probabilite quelconque (continue ou discrete) Nous

etudions de maniere detaillee quelques exemples des

noyaux continus

symetriques(????? normal,

Epanechnikov, etc.), continus asymetriques (?????

beta, gamma, gaussien-inverse et

gaussien-inversereciproque), discret categoriel

(Aitchison & Aitken 1976) et discret de denombrement (?????

triangulaires symetriques, standards

asymetriques dordre 1 tels que Poisson,

binomial et binomial negatif). Ensuite,nous donnonsla definition

delestimateur noyau associe. Nous montrons la convergence

ponctuelle de cet estimateur Nous verifions si cet estimateur est bien de masse

totale egale lunite Dautres proprietes (globales) sont

etudiees, telles que biais, variance et erreur

quadratique moyenne integree. Nous

proposons une extension dans le cas multivarie (? ? Rd) pour des

fonctions de densite (fonction de masse) et de regression. Enfin

nous illustrons une partie de la methode sur des donnees de panel en

marketing, lesquelles donnees sont de comptage

et parsemees.

?ts ??es? ?\u9313‡A?? ?ss??e????etr?

????ss????????i???a???????er??u

???d?a?i???\u9313‡A??????te?re??

???é?s ??rs??e?s

Abstract

In this report, we are interested in the notion of

nonparametric estimation of an unknown density (mass function) in ?

? R by using associated-kernel method First we present an

unified definition of a kernelassociated to a

probabilitylawthatmight be

eithercontinuousordiscrete.Then,weprovideathoroughtreatmentofsomesymmetric

andcontinuouskernels(?????Gaussian,Epanechnikov,etc.)

asymmetricandcontinuous (????? beta, gamma, inverse

gaussian, reciprocal inverse gaussian) ; discrete

categorical (Aitchison & Aitken,1976) and discrete count data

(????? symmetric triangular,or some

knownasymmetricdistributionssuchasPoisson,binomialandnegativebinomial)Furthermore,

we define the associated kernel estimators and investigate some of

their finite

andasymptoticproperties.Morepreciselyweverifyiftheproposedestimatorsarebona

fidedensitiesormassfunctions(i.efunctionswhicharesimultaneouslynonnegativeand

integrate/sum up to one). Their pointwise consistency

bias, variance and mean integrated squared error are

tackled as well Moreover we extend these estimators to the multivariate

setting ? ? Rd for both density/mass and

regression functionsFinallythe practical usefulness of

this approach is illustrated by a case study based on

some sparse count data obtained from a marketing panel research

survey

?\u9313‡A ?r?s? ?ss???t?? ??r????

s?t???? ???????t?? ???a? ??a??????

???? ?n??g?a?? sq??r?? ?rrr?

s??rs? ??t??

Remerciements

J???r? ???t??? a ????re?????

?? s??s ?\u9312‡@trê?????t ???r??s? ????r ???????

?? ????i ç?ça, ?? ???t ?? ??

?a?i????r? ?????t???? ?? r????r??? ?? ????s?r

??????q???t????? ??s ? ?é??es?it ??e

????nt ???????s ??r q?? ??

???ss? s???r ?? q?? ?? ???r???? ?? q?? ??es ???

?u?? ?? ????i?i ??? ???st ?? r????r???? ??

??et??s ??s ?????? ?? ?é??t ???t ?? ?v?? ?d? e??i

???u???i?e??e ????ts ?e????s??ts ???? ??s

???s??s??r ?tt???r?????s??i??? (?a??????

P?r ??s ????ts ???????????s?

?? t???s t?t ????r? d r???r???r Ce??st?? C?

K??????? ?????r ?????re ?? tr????? ??????????? ??

???et????? ????t??s??s?? ?tet ??

??s???????it? ; M?r?? C???st?? ??r

t???????? ??????r??\u9312‡@? ??r t?s ??s

?\u9313‡A??s q?? t? ?s ??s a ??

??i?s?i??? ??u ?????i ???t ????????

?????r t???rs s? r???t?r ?? r?????? ??

????i?r????é ??e ??n???l

???ses? ????? ?? t? r???r??? ??r ?stes

???s ????r??????tt ?e ?e ?ot ????u?

?? s??s ??rt?????ar????t r??????ss??t? a

D????r M?????? ??r t?t? ?????? q????

??????rte ??tt? ???e?? M?r?? D????r

??r t?t? ?? ??????? ??s ??ss? ?? r???r???r ???????r??s????t

t?t ??s ??s??????ts?

???\u9312‡@?r??? ??s r???r??????ts ??s

???s ???s C B??????? A???s ??r s?

s\u9313‡A???t???? s? t????t

?? ?e?????? ?t s? t????

?\u9312‡@???t????????; M?r?? B???????

??r t? ??????? ?t t?s ????r??????ts ?? r???r??? ?

??r??rt ??stér??? ?r??es??u ??

??a??e??? a ????????er???r? ?? ????r?? ??

P??? ?? ??s ???r ??r?? ?tet

?\u9312‡@???q?é ?? ?de???l ?e

???é?s?

??s r???r??????ts ??t e???????t a

Tr?st?? S???? K??sse? ??r s?

???e???t???? s?t???? M?r?? Tr?st?? ??r ??s ????ts

?? ?e?????r? ??s ?????s

??s??ss??s? ??sles ????r??????tt ?e ?

???????it?

M?r??? Z???? ??? ??rs??? q??

???? ?? ?? ?????? ?? ??s??ér?r ???? ???? ??????????? M?r?? M?r???

??r t?s ??s???s? t? s???????t? ???s??? ?tet ?e

??????e ??oo?

L??? Gr???rs??t??

L?\u9313‡A?? L?\u9314‡B???? A??

S?????? D????? G?s??r ?t a t?s ???\u9312‡@

q?? ??? ???? ????s?r ?? ?ot\u9313‡A?r

??r??t q??tr?s ??l

M?r?? P??? & M???? ??r ??????s ??

r??s?s? ??s ?? ????\u9314‡B ??r ??rs

??r ??? t??t ?????r ?t ?? ???????

M?r?? ?? ???r ?rar? A???? ??r t?t

??????r q?? t? ??r?s? ??r ??s

r??????s? ?e ??t?t?s

s?r?r?s?s ?t ??r t?s ?????s?

?? ?? s??s ??s ?????t

?\u9312‡@?r???r s????????t ??cc

q?? ??je ??ff d ??e

???u ??,a?e ??n?e???t? H?s??? ??t?

AT???t ?t a ?? ??r???? R????. M???? M?r?? ??r ????? ?t

??? r??s?s?

U? M?r?? tras ???r ??r ??s s???rs ???s

Rima, Myriam & Omar.

U? ?r??? M?r?? ??ss?

??r t?s ???\u9312‡@ ?t ?????s q?? ??????t?

Table des matières

Présentation générale du

stage 13

1 Introduction a l'estimation non-paramétrique

15

2 Noyau continu

symétrique 17

2.1 Cas univarié .................. . . .. . . . . . . . .

. . 17

2.1.1 Propriétés élémentaires.

. . . . . . . . . . . . . . . . 18

2.1.2 Biais ponctuel . ... . . . . . . . . . . . . . . . . . . .

. . . . . . 19

2.1.3 Variance ponctuelle .... . ... . .. . . .. . . . . .

. . . . . 21

2.1.4 Erreur quadratique moyenne

(MSE) 22

2.1.5 Erreur quadratique moyenne

intégrée (MISE) 22

2.1.6 Choix du noyau .......... . .. . . .. . . . . .

. . . . . 23

2.1.7 Choix de fenêtres . . . . . . . . . . . . . . . . . .

. . . . . . 24

2.1.8 Simulation des données . . . .. . . . . . . . . . .

. . . . . 30

2.2 Cas multivarié........... . ... . .. . . . . . . . . .

. . . . . 31

3 Noyau associé continu

asymétrique 35

3.1 Cas univarié ................ . .. . . .. . . . . . .

. . . . 35

3.1.1 Définition ........................... . .. 36

3.1.2 Propriétés élémentaires.

. . . . . . . . . . . . . . . . 38

3.1.3 Biais ponctuel.................. . .. . . .. . . .

41

3.1.4 Variance ponctuelle .... . ... . .. . . .. . . . . .

. . . . . 42

3.1.5 MISE .... . ... . . . . . . . . . . . . . . . . . . . . . .

. . . 43

3.1.6 Exemples ................ . . .. . . . . . . . . . . 43

3.2 Cas multivarié........... . ... . .. . . . . . . . . .

. . . . . 63

4 Noyau associé discret 65

4.1 Noyau associé discret pour des

données catégorielles 68

4.2 Noyau associé discret pour des

données de comptage 73

4.2.1 Noyau associé poissonien . . 73

4.2.2 Noyau associé binomial. . . . . . . . . .

. . . 75

4.2.3 Noyau associé binomial

négatif . 77

4.2.4 Noyau associé triangulaire . .

. . . . . . 78

4.2.5 Choix de fenêtres .... . . .. . . . . . . . . . . . .

. . . 83

4.3 Noyau associé discret multiple. . . 85

? ?e?r?ss?? ???t???? a

?\u9313‡A??\u9312‡@ ?ss??is ??\u9312‡@t?e ??87

5.1 Estimateur de Nadaraya-Watson 87

? ???e?s ?? P???? a ??et??? ??

6.1 Notions elementaires

· . . . . . . . . . . . . . . .

. .. . . 89

6.2 Traitements preliminaires . . . . . . . . . . . . . . .. . .

90

6.2.1 Repartition des panelistes selon les variables

caracteristiques . . 92

6.3 Application . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . 96

6.3.1 Dans le cas d'un estimateur a noyau associe

triangulaire . . . . 96

6.3.2 Dans le cas d'un estimateur a noyau associe

binomial 97

? ?????s??s ?t ??rs???t???s ???

7.1 Conclusions . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . 103

7.2 Perspectives . . . . . . . . . . . . . . . . . . . . . . . .

. . . . .. 103

? ????\u9312‡@? ?? ???????s s?s ?? ??????? ? ???10

Table des figures

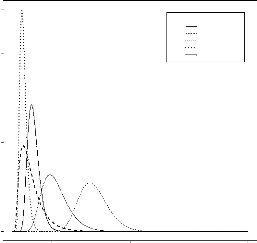

2.1 Illustration des noyaux continus

symétriques 19

2.2 Estimation totale a noyau

gaussien . 20

2.3 Illustration d'un phénomêne de

sous-lissage lors de lestimation dune

densité.............. . ... . . . . . . . . . . . . . . .

. . 24

2.4 Illustration d'un phénomêne de

sur-lissagelors delestimation duneden-

sité..................................... . 24

2.5 Illustration d'une estimation idéale . . . . 25

2.6 Lissages par des estimateurs a noyaux

continus de la distribution dun

échantillon de loi normale centrée réduite,

n = 100 et hPj = 0.338 . . . 31

2.7 Lissages par des estimateurs a noyaux

continus de la distribution dun échantillon de loi normale

centrée réduite, n = 100 et hCV = 0.429 . . . 32

2.8 Comparaison des lissages par lestimateur a noyau continu

d'Epanechni-

kov en faisant varier la fenêtre h 33

3.1 Densité de loi normale centrée .. . . .. . . .

. . . . . . . . . . . . 36

h = 1.5

3.2 Illustration de la densité normale pour et x

varié . . . . .

= . 37

y

x = 2.1 h

3.3 Illustration de la densité normale pour et

varié 38

3.4 Allure générale d'une densité

gamma. . . . . 44

h = 0.2

3.5 Allure du noyau x

associé gamma pour et varié 45

= 2

3.6 Allure du noyau associé gamma

pour x = y et varié .

h . . . . . . 46

3.7 Allure générale de la densité

bêta. . . . . . . . . . 51

3.8 Allure du noyau associé bêta pour h =

0.2 et x varié 52

3.9 Allure du noyau associé bêta pour x =

y = 2 et h varié 53

3.10 Allure générale de la

densité gaussienne inverse 57

3.11 Allure du noyau associé

gaussien inverse pour h = 0.1 et x varié 58

3.12 Allure du noyau associé

gaussien inverse pour x = 2 et h varié 59

3.13 Allure générale de la

densité gaussienne inverse réciproque

61

3.14 Allure du noyau associé

gaussien inverse réciproque pour x = 2 et h

varié 62 4.1 Illustration de la loi d'Aitchison et Aitken 70

h = 0.2

4.2 Illustration du noyau associé dAitchison et

Aitken pour et x varié 71

4.3 Illustration du noyau associé dAitchison et

Aitken pour x = y = 2 et h

varié..................................... . 72

h

4.4 Illustration du noyau associé =

poissonnien 0.1

pour x

et .

variée . . . 73

h =

4.5 Illustration du noyau associé binomial pour

.

0.1 et .

x varié. .

. . . 75

4.6 Illustration du noyau associé binomial pour

x == y7 et h varié 76

4.7 Illustration du noyau associé binomial

négative pour h = 0.1 et x varié 78

4.8 Illustration du noyau associé triangulaire pour

différentes valeurs de h. . 80

4.9 Illustration du noyau associé

triangulaire sans modification du bras 81

4.10 Illustration du noyau associé

triangulaire avec modification du bras 82

6.1 Dispersion des clients selon le lieu d'habitation 93

6.2 Localisation des panélistes du magasin 1

93

6.3 Catégorie socio-professionnelle des

panélistes et actes dachats 94

6.4 Revenu net des panélistes du magasin 1

94

6.5 Répartition des clients du magasin 1 selon

la taille du foyer 95

6.6 Taille de famille des panélistes du magasin

1 95

6.7 Comportement des achats individuels pendant la

premieretranche 96

6.8 Comportement des achats pendant la deuxiême tranche

97

6.9 Estimation des actes d'achats pour la premiere période

97

6.10 Estimation des actes d'achats pour la deuxiême

période 98

6.11 Estimation de la premiere période agrandie

. 98

6.12 Estimation de la premiere période plus

agrandie 99

6.13 Estimation des actes d'achats pour la premiere

période 99

6.14 Estimation des actes d'achats pour la deuxiême

période 100

6.15 Estimation des actes d'achats de la premiere période

agrandie (150 ob-

servations) ................ . ... . . . . . . . . . . . . . .

101

6.16 Estimation des actes d'achats de la premiere période plus

agrandie (50

observations) .............. . . .. . . . . . . . . . . . . .

102

Liste des tableaux

2.1 Exemples de noyaux continus

symétriques 18

2.2 Efficacité des noyaux continus

symétriques 23

3.1 Tableau récapitulatif des lois de probablité

continues asymétriques 39

4.1 Solutions associés standards

h0 pour les discrets

noyaux 86

6.1 Tableau comparatif du marketing transactionnel et

relationnel 90

6.2 Statistique descriptives fondamentales 92

Présentation générale du stage

J'ai effectué mon stage de fin

d'étude au sein du laboratoire de mathématiques

appliquées, département Statistique et

Traitement Informatique des Données STID) Ce

département regroupe 7 enseignants et

enseignantes tous sous la direction du chef de département.

Le STID offre un enseignement théorique assurant

une solide formation de base ainsi qu'une initiation à la

recherche

Mon stage s'est déroulé du

1er février jusqu'à 29 mai, sous

la direction de M Kokonendji. Dés mon arrivée, mon

encadreur direct ma expliqué le sujet ma fait

visité le département, m'a accordé un bureau et m'a

éclairci le régime du travail.

Tout aulong de ce stage, j'ai

assisté au séminaire hebdomadaire de léquipe

probabilités et statistique on j'ai eu l'occasion

de présenter montravail.

Durant ces quatres mois passés au sein du

STID jai eu lopportunité de découvrir le métier

du chercheur sous toute ses formes et de comprendreles

difficultésquipeuvent être rencontrées.

Chapitre 1

Introduction a l estimation

non-paramétrique

L'objet principal de la statistique est

de faire a partir dobservations dun phénomène aléatoire,

une inférence au sujet de la loi

générant ces observations en vue danalyser

le phénomène ou de prévoir un événement

futur Pour réduire la complexité du phénomène

étudié, nous pouvons utilisé deux approches

statistiques non-paramétrique et

paramétrique.

Dans le premier cas, nous considérons que

linférence statistique doit prendre en compte la

complexité autant que possible et donc cherche a estimer la

distribution du phénomène dans son

intégralité,mettant en oeuvre lestimation des

fonctionnelles(densités, régression, etc.). En

opposition lapproche paramétrique cherche a

représenter la distribution des observations par une fonction

densité f(x|è) on le paramètre è est la seule

inconnue. Dans plusieurs cas l'approche non paramétrique est

préférable nous pouvons mettre en oeuvre des lois de

probabilité sur des espaces fonctionnels.

Les estimateurs non-paramétriques

classiques ont étéintroduitparRosemblattpour estimer

des densités de probabilité, par Parzen pour estimer le mode dune

densité de probabilité et par Nadaraya Watson pour

estimer une fonction de régression. Le comportement

asymptotique de ces estimateurs a été

étudié par de nombreux auteurs tel que

Tsybakov (2004). Ainsile but de ce travail est de définir les

estimateurs a noyau associé et d'établir les

propriétés relatives

Avant de présenter les résultats de

façon détaillée nous en donnons tout dabordles

grandes lignes.

Dans le deuxième chapitre, nous nous intéressons a

lestimateur a noyau continu

b

symétrique fn d'une

densité de probabilité f inconnue sur R. Plus

précisémment, nous présentons cet estimateur et nous

prouvons les propriétés fondamentales telle que biais,

variance, erreur quadratique moyenne etc Nous

donnons les méthodes de sélectiondu noyau ainsi de la

fenêtre en s'appuyant sur des exemples de données

simulées. ls'avère que le choix du paramètre de

lissage est beaucoup plus important que celui du

noyau

dansl'estimationdesdensitésinconnuesasupportsymétrique.Nousétudionségalement

CHAPITRE 1. INTRODUCTION A L'ESTIMATION 16

NON-PARAMRTRIQUE

le cas multivarié en fin de chapitre.

Dans le troisième chapitre, nous donnons la

définition dun noyau associé. Nous prée

sentons, a partir de cette définition, les estimateurs de Chen (1999

2000) et de Scaillet (2004) et leurs propriétés en rendant les

calculs moins sombre et plus compréhensible. Toujours dans le

cas du noyau associé

asymétrique, nous

généralisons cesces résultatsats au cas

multidimensionnel.

Dans le quatrième chapitre, nous

représentons pareillement la définition du noyau

associé discret en s'appuyant sur les travaux de

Kokonendji & Senga Kiessé (2006).(2006). Nous

définissons l'estimateur a noyau associé discret Nous

étudions lesles propriétés fondamentales de cet estimateur

d'une manière générale ensuite nous les

appliquons dans deux sections; la première se base

sur les données discrètes catégorielles on nous

allons étudier l'estimateur a noyau associé dAitchison

& Aitken et la seconde partie repose sur les données de

comptage on nous allons traiter des exemples des noyaux

associés symétriques et standards

asymétriques. Nous donnons un critére de

choix des fenêtres de lissages. Nous

généralisons cet estimateur dans une version

multidimensionnelle.

Dans le cinquième chapitre, nous

étudions la régression multiple a noyaux

associés mixtes. Nous nous focalisons sur le fameux estimateur de

Nadaraya-Watson.

Dans le sixième chapitre, nous appliquons une

partie de ces estimateurs a noyaux associés sur des

données parsemées de panel en marketing

Nous terminons ce rapport par une conclusion

générale et des idées de recherches futures.

Nous présentons maintenant de manière plus

développéele contenu des six chapitres de ce rapport.

Chapitre 2

Noyau continu symétrique

Dans cette partie, nous présentons l'estimateur a

noyau continu symétrique. Nous

développons cet estimateur dans le cas univarié ensuite nous le

traitons dans le cas

multivarié.Nousétudionségalementlesdifférentespropriétésélémentairesrelatives

acet estimateur telle que biais, variance erreur

quadratique moyenne et erreur

quadratique moyenne

intégrée. Nous détaillons par la suite les

méthodes de choix des fenêtres et des noyaux en se

focalisant sur limportance du choix du paramètre de lissage.

Nous expliquons explicitement 3 méthodes destimation de la

fenêtre. Enfin, nous concluons par un exemple de données

simulées.

2.1 Cas univarié

Considérons un échantillon de variables

aléatoires X1,X2,. . . ,Xn, indépendant et

identiquementdistribué(i.i.d.),dedensitédeprobabilitécontinueinconnue

f sur? = R. L'estimateur a noyau continu

symétrique de f est défini par:

|

bfn(x) = 1

n

|

Xn

i=1

|

~x - Xi ~

1 (2.1)

h K h

|

= bfn,h,K(x),

on K estlafonctionnoyautelleque K(t) =

0et JR K(t)dt = 1et h > 0estleparamètre de lissage ou la

fenêtre. L'expression (21) découle des travaux des pionniers de

estimation non-paramétrique Rosemblatt (1956) puis Parzen

(1962) Dans lexpression de l'estimateur a noyau continu (2.1), la

fonction noyau K est une densité de probabilité sur R

? R+ et est symétrique par rapport a

zéro:

K(-x) = K(x), (2.2)

ce qui implique

l'égalité suivante

ZR tK(t)dt = 0. (2.3)

De plus, elle est de carré intégrable

et nous avons aussi la variance de K finie

ZR t2K(t)dt < +8. (2.5)

Enfin, le noyau K peut être écrit sous

plusieurs formes dont la plus connue est

|

(x - Xi ~

1

Kh(x - Xi) = hK h

|

.

|

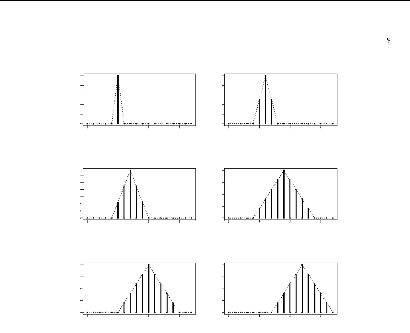

Le tableau 2.1 donne un récapitulatif des fonctions

noyaux continues classiques dont les

graphiques sont présentés dans la

figure 21 Nous rappelons quune loi de Cauchy

n'admet aucun moment fini.

|

TAB. 2.1

|

Eaemples de noyaua continus

symétriques

|

|

Noyau

|

Fonction noyau

|

Domaine de définition

|

|

Cauchy

|

[7r(1 + u2)]-1

|

R

|

|

Biweight

|

(15/16)(1 - u2)2

|

[-1,11

|

|

Triangulaire

|

1 - |u|

|

[-1,11

|

|

Epanechnikov

|

(3/4)(1 - u2)

|

[-1,11

|

|

Gaussien

|

(1/v27r) exp (-u2/2)

|

R

|

Pour plus de détails sur les types des

noyaux, nous pouvons se référer a article

d'Epanechnikov (1969) et le livre de Tsybakov (2004)

L'expression de K détermine la forme du

noyau et h est un paramètre d'échelle qui

détermine le niveau de lissage de l'estimation Dans

lestimation a noyau continu symétrique,

le choix de la fenêtre de lissage est

prépondérant a celui du noyau K. De plus, la

contribution de chaque point de l'échantillon est

additionnée pour obtenir lestimation totale. Ceci est illustré

dans la figure 2.2.

2.1.1 Propriétés

élémentaires

Danscettepartie,nousprésentonslespropriétésfondamentalesdelestimateuretles

critères d'erreurs usuels. Nous calculons dabord le biais et la variance

de lestimateur

b

fn(x). Ensuite, nous exprimons le risque

quadratique exact en un point x fixé, puis le

risque intégré. Enfin, nous approximons ces

résultats. Dans ce qui suit, nous supposons que

les dérivées première et seconde de f existent et

admettent une intégrale finie sur le support de la

densité ?.

FIG. 2.1 - Illustration des noyauc continus

symétriques

b

|

Propriété 1: La fonction x -?

|

de prohahilité

fn(x) est une densité

b

|

|

Démonstration: La somme continue de

|

fn(x) sur le support ? = R est

|

Z Z (x - Xi )

Xn 1

bfn(x)dx = nh K dx

h

R R i=1

Z (x - X1 ~

1

= hK dx,

h

R

en posant t = (x - X1)/h et donc dx = hdt, nous trouvons

Z Z

bfn(x)dx = K(t)dt = 1.

R R

Deplus,lenoyauK

estdéfinipositif.Lasommesurtoutléchantillonresteaussipositive.

Par conséquent, l'hypothèse de

positivité est vérifiée.

2.1.2 Biais ponctuel

Le hiais ponctuel mesure la différence entre la valeur

moyenne de lestimateur bfn et la valeur de la

fonction inconnue f en un point x.

{ } { }

Biais bfn(x) = E

bfn(x)- f(x). (2.6)

Propriété 2: Soit x fixé dans R.

Le hiais de l'estimateur a noyau

présenté dans (21) est

{ } Z

Biais bfn(x) ÿ=1

2h2f00 (x) t2K (t) dt. (2.7)

R

FIG. 2.2 Estimation totale a noyau

gaussien

Le signe » ÿ=» indique

que la quantité à gauche est

équivalente à la quantité à

droite. Démonstration: Comme les variables aléatoires X1,X2,.. .

,Xn sont i.i.d., nous avons successivement

( )}

{ } Xn (x - Xi

1 1

E bfn(x) = E h K

n h

i=1

1

n

Xn

i=1

{ 1 (x - Xi )} E h K h

{ 1 (x - X1 )}

= E hK h

Z ~x - x1 )

1

= hK f (x1) dx1.

h

R

Nous effectuons le changement de variables suivant

-t = (x - x1)/h, d'oñ x1 = ht + x.

b

De là, en utilisant l'hypothèse (2.2),

le biais de fn(x) s'exprime ainsi par

{ } Z

Biais bfn(x) = K (-t) f (x + ht) dt -

f(x)

Z R

= K (t) f (x + ht) dt - f(x).

R

Dans le but d'avoir une forme plus simple qui ne

dépend que du paramètre h, nous approximons la formule

du biais en utilisant la formule de

TaylorrLagrange

f (x + ht) = f(x) + htf' (x) + h2t2

2 f'' (x) + o (h2t2).

Ainsi, nous obtenons

Biais { :fn(x) } = f (x) J K (t)dt + hf(x) JtK(t)dt

R R

+2h2 f" (x) I t2K(t)dt - f

(x) + o(h2).

D'apres les hypotheses (2.3) , (2.4) et (2.5) nous

avons finalement

Biais { in(x)} 12 h2 f00

(x) JRt2K (t) dt.

2.1.3 Variance ponctuelle

Propriete 3 : Soit x fixe dans R. La variance de

l'estimateur bfn est

Var { :fn(x)} =ÿ nhf (x) I K

(t)2 dt. (2.8)

Demonstration: Partant de l'hypothese d'independance

entre les Xi, nous avons

-- Xi V ar { :fii(x) } = V ar n {1 ÷`i x K h

i=1

n

1 V ar{ h 11 K (x - hX1)1

2

E [11 K (x h X1)J )12 n Lt1 1

[Elh 1 K (x h X1)j)11

n

1

1 1

n h2 K2 x h x1) f (x1) dx1

|

n JR

1 h

1 i1K(x x1)

|

2

f (x1) dx1 l .

|

Nous effectuons le changement de variable -t = (x -

x1)/h. Nous trouvons

nh2

1 1

V ar { :fii(x) } = K (-t)2 n f (ht + x)hdt - {IRK

(-t) f (ht + x) hdt} 2

h 1 1

IRK (t)2 f (ht + x) dt - n[Biais {

:fii(x)} + f (x)i2

n

h 1 IRK (t)2 f (ht + x)dt - 1 {O

(h2) + f (x)}2

n

Finalement, sous la condition d'avoir f K(t)2dt <

+8 et pour n grand, nous avons

Var { rn(x)} =ÿ nhf (x) I K

(t)2 dt.

2.1.4 Erreur quadratique moyenne

(MSE)

Propriete 4: L'erreur quadratique

moyenne (en anglais "Mean squared Error") en

un point x fixe s'exprime par

MSE (x) = V ar { :fii(x) } + Biais2 {:fii(x) }

(2.9)

Demonstration: Nous obtenons par succession

MSE (x) = E [{ 1n(x) - f (x)}21

= E ([in(x) E { in(x)} E {

in(x)} f(x)i2)

= E ([ 1n(x) - E { Mx) }i2) + 2E [ 1n(x) -

E { 1n(x)}i

[E { in(x)} f(x)i [E {

in(x)} f(x)i 2

= V ar { rn(x) } + Biais2 {rn(x)}

= MSE(x;n,h,K,f).

D'apres les resultats (2.7) et (2.8), l'approximation du critere

MSE en un point x fixe est

2

AMSE (x) = n1hf (x) I K

(t)2 dt + {1 2 h2 f" (x) I t2K (t)dt } .

(2.10)

2.1.5 Erreur quadratique moyenne

integree (MISE)

Propriete 5: L'erreur quadratique

moyenne integree (en anglais "Mean

Integrated Squared Error ") est la mesure

theorique commune la plus utilisée pour evaluer lerreur entre

la fonction f et bfn. Nous avons etudie dans la partie

precedente le comportement de bfn(x) en un point fixe. Il

est egalement convenable devaluer lerreur globale sur le

support R de cet estimateur.

MISE(n,h,K,f) = I MSE(x)dx (2.11)

R

=

IV ar { :fn(x)} dx + I Biais2

{:fn(x)} dx.

R R

En utilisant l'expression approchee du critere MSE (210) nous

avons successivement

|

AMISE(n,h,K,f) =

|

h1

JRK(t)2dt I f(x)dx

nh

|

2

+h4 t2K(t)dt } f f"(x)2dx

4 R

1 J K(t)2dt +

41h4 t2K(t)dt }2 I

h f" (x)2dx

nR

avec

V (K) = f t2K(t)dt = V ar(K).

2.1.6 Choix du noyau

Le premier choix porte sur la nature de la densité

noyau que nous utilisons. Pour mesurer l'efcacité

de chacun des noyaux continus

symétriques présenté dans lele

tableau 2.1, nous utilisons une mesure commune qui consiste a

calculer le rapport du critere AMISE des deux noyaux mis en

évidence

eff(K1,K2) = AMISE(K1)

AMISE(K2)

Nous supposons que K1 est le noyau

d'Epanechnikov. Ce noyau est considéré comme une

référence par rapport a tous les autres noyaux

continus classiques. Il estest largee ment

apprécié pour ses performances (au sens on sa forme répond

bien a la plupart des questions soulevées par le probleme de

lestimation non paramétrique de densité) et il est

considéré comme optimal au sens des mesures derreur IlII o~re la

valeur défcacité maximale. Nous nous sommes appuis sur les

travaux de Tsybakov (2004).(2004). Ainsi, apres avoir fait les

calculs nécessaires lefcacité dun noyau K para rapport

au noyau d'Epanechnikov se mesure par

1

VfR t2K(t)dt fR

K(t)2dt < 1.

5V5

eff (K) = 3

Le choix de K dépend seulement de la nature de f et

nous admettons qu'en pratique le choix du

noyau d'Epanechnikov est le plus staisfaisant Nous donnons lele

tableau récapitulatif (Tab. 2.2) qui présente la

valeur defcacité des différents noyaux continus

symétriques.

TAB. 2.2 -- Efficacite des noyaux

continus symetriques

Noyau Efficacité

Epanechnikov 1.000

Biweight 0.994

Triangular 0.986

Normal 0.951

Uniform 0.930

Commentaire:

Danslecasdesnoyauxcontinussymétriques,nousremarquonsque

les valeurs d'efcacité des noyaux tels que le

noyau biweight triangulaire ou Epanechnikov

sont tres proches. Par conséquent Le choix du

noyau nest pas tres important.

2.1.7 Choix de fenetres

a. Importance du choix de h

Le parametre de lissage h est un réel

positif dont le choix est prépondérant sur celui du

noyau continu symétrique K. Le choix

d'une valeur de h trop grande conduit a une courbe trop lisse. La

courbe estimée ne traduit pas suffisament les variations de la vraie

distribution (voir figure 2.3).

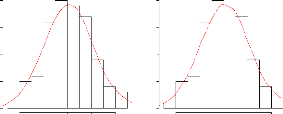

FIG. 2.3???str?t?? ???? ??e??e?? ??

s?s???ss??? ?rs ?? ??et???t?? ????? ???n?it

Ep/0/ch0-

-2 -1 0 1 2 3

x

Par contre, en choisissant un parametre de lissage

tres petit que celui adopté précédemment,

l'allure de la distribution change. Il sagit dune

distribution surestimé (figure 2.4).

FIG. 2.4 -- ???str?t?? ???? ??e??e?? ??

s?r???ss??? ?rs ?? ??st???t?? ????? ???n?it

Ep/0/ch0-

D..

-2 -1 0 1 2 3

x

ment la distribution de depart (figure 2.5). Les

courbes obtenues illustrent a quel point

FIG. 2.5 -- Illustration

d'une estimation ideale

Ep/0/00-

RI.

-2 -1 0 1 2 3

x

les formes estimees sont differentes en fonction de lordre

de grandeur du paramètre de lissage. La principale

difculte repose sur le choix optimal de la fenetre h. La valeur ideale hid du

parametre h est celle qui minimise l'erreur

quadratique moyenne integree (MISE).

Pour une taille d'echantillon n donnée et un noyau K fixe,

nous avons

?h

? AMISE(h) = 0.

Ce qui est equivalent a

h3V (K)2 I f" (x)2dx 1 2

jali K(t)2dt = 0.

nh

Ainsi, nous obtenons successivement

nh5V (K)2 ff" (x)2dx

= K(t)2dt R

h5 = nV (K)2 fR

f"(x)2dx

fR K(t)2dt

1 I fR

K(t)2dt11/5

hid = v .

V(K)2 fR f" (x)2dx (2.13)

En particulier pour K = KEpanechn., nous avons

~ 15 \1/5

hid(KEpanechn.) =

n R .

R f"(x)2dx

En definitive, a partir de (2.13), nous obtenons

2/5 4/5 11/5

5 1

AMISE(hid) =

L,Rt2K(t)dt1 {

K(t)2dt1 { f" (x)2dx

4 n4/5 R R

51/5

4n4/5 I(K) fR f"(x)2 dx }

avec

~Z ~2/5 ~Z ~4/5

I(K) = t2K(t)dt K(t)2dt .

R R

Conséquences: Quand n est

grand, hid tend vers 0. Le parametre de lissage h idéal

dépendenfaitdeladensitéatravers f".Ainsipourun

hpetit,nousavonsunpetitbiais et une variance plus grande. Le

noyau optimal est obtenu en minimisant R R K(t)2dt, ceci en

admettant les hypotheses (2.4) et (25).

b. Méthodes de choix de fenêtres

Nous considéronss donce avec plus d'intérêtt

la question de selection du parametree de lissage h.

Comme fenêtree optimale, nous choisissons la valeur qui

minimis lee MISE.

Nous étudions trois méthodes dans la

déterminationn du parametre d lissagee

optimalhopt:: le "Plug-in", la validation

croisée par moindres carrés e laa validation croisée par

maximum de vraisemblance.e

b.1. Mahodee Plng-inn

Dans la procéduree de

Plug-in,l'idée& de base est destimerr dan lexpressionn

(2.13) la quantité inconnue: : fR

f"(x)2dx. En effet, ilt y a deux approches

possibles pou leefaire:: soit nous supposons que la

densité f appartient a une famille de distributions

paramétriques et la nous estimons les

parametres et nous retrouvon facilement cette cette quantité,

soit nous l'estimons par lapprochee non-paramétrique et donce

faire appel a un estimateur a noyau (par exemple). Ceci va

compliquer davantag less calculs parceque nous

trouvons une fonction qui dépendd elle même de h.

Donc,, en gros, la méthode Plug-in résidee

a "injecter" une estimation de f en adoptant une méthode

commode et pratique. Dans notre étude,, nous supposons

que f(x) appartient a une famille de distribution normale centrée

et de variance ó2..

Sous cette hypothese::

ZR R f"(x)2dx =88 0r33

ó-1/550.212ó-1/5..

Il reste alors a remplacer le parametre inconnu óa par la

valeur estiméee bó.. Nous choisissons la valeur

empirique comme valeur optimale définiee comme suit

1

bó

=

n -- 1

Xn

i=1i

tu u v

(Xii -- X~2,,

tel que XX = n-11 (X1 + X2 +

.

· .

· .

· + Xn).

|

=

|

(4ð)-1/10

~

|

1

|

8ð-1/2 bó

~ ~3 ~-1/5

|

|

n1/5 5

|

Le résultatt obtenu sera remplacée dans la formule

de hid et nous avons

hopt

(4bó55~1/5

= 3n ~ bó)= =1.06 6n1/55)

Ce que nous avons accompli en travaillant sous la

supposition de la normalité estest une formule explicite applicable pour

la selection de la fenetre h. En réalité, cette méthode

donne des résultats raisonnables pour toute les distributions

symétriques, unimodales et ne possédant pas

des queues trop lourdes Le probleme donc avec cette méthode

est qu'elle est tres sensible aux valeurs aberrantes. Un estimateur

plus robuste dans ce cas est obtenu a partir de l'intervalle

interquartile : R =

X[0.75n] - X[0.25n] o1 Xp

désignelequantiled'ordrepd'une N

(u,ó2).Ladifférenceentrecesdeuxquartilesdonne

50% de l'ensemble des observations. En supposant toujours

que X suit une normale N(u,ó2), nous posons Z = (X -

u)/ó qui suit une N(0,1). Ainsi, nous montrons que

(X[0.75n] -X[0.250 = 1.34ó Par conséquent, un

estimateur puissant de ó serait Q = R/(1.34). Dans ce cas, le parametre

de lissage optimal est donné par

~ hopt = 1.06 1R.34 n-1/5 0.796n-1/5.

Enfin, la fenetre optimale est

hopt = 1.06 min bó,

1.34

R

n-1/5

.

Cette méthode présente des inconvénients

: si la vraie densité f devie substantiellement

delaformed'unedistributionnormale(enétantmultimodalparexemple)nouspouvons

etre trompés considérablement et nous aurons soit un

sur-lissage soit un sous-lissage.

b.2. Methode de validation croisee par ioindres carrés

Pour un noyau fixé K, le principe de la

validation croisée est la minimisation destimateur de risque

intégré (MISE) par rapport a h. En effet, Le MISE

dépend de la fonction inconnue f et ne peut donc pas etre

calculé. Nous allons essayer de remplacer la MISE par une

fonction de h, mesurable par rapport a l'échantillon et dont la valeur

pour chaque h > 0, est un estimateur sans biais de MISE(h). Pour

cela, notons que :

MISE(h) = E f {:fn(x) - f (x)}2 dx

= E f

R Tfii(x)2dx - 2E 1

fn(x) f (x)dx + IR f2 (x)dx

Le dernier terme ne dépend pas de h, pour minimiser

MISE(h) il suffit de minimiser l'expression :

J(h) = E f fn(x)2dx - 2E 1

fn(x) f (x)dx.

Pour cela, nous déterminons un estimateur des deux

termes de J(h). Le premier terme

JR

fn(x)2dx comme estimateur trivial (d'apres

la propriété des esti-

b

admet l'estimateur

mateurs sans biais : E(bâ) = â).

Il reste a trouver un estimateur sans biais du second terme. Pour

cela, nous admettons par construction l'estimateur sans biais G défini

en tout points du support sauf en Xi :

|

Gb =1

n

|

Xn

i=1

|

bfn,-i(Xi),

|

|

avec

|

bfn,-i(x) = 1

n - 1

|

1 X h

i6=j

|

(x - Xi ~

K .

h

|

Montrons que E( bG) = E{fR

bfn(x)f(x)dx}. Comme les Xi sont i.i.d., d'une part

nous avons

~Z ~ Z ~

Xn ~x - Xi

1

E bfn(x)f(x)dx = E K f(x)dx

nh h

R R

i=1

Z ~x - X1 ~

1 hE K f(x)dx

h

R

Z Z ~x - x1 ~

1 f(x) K f(x1)dx1dx.

h h

R R

D'autre part, nous avons

E(

= E {n1

i=1

= E{In,-1(X1)}

|

= E

|

? ?

?

|

~Xj - X1 ~?

1 X ?

K

(n - 1)h h ?

j6=1

|

~ 1 ~X - X1 ~~ = E hK h

Z Z ~x - x1 ~

1 f(x) K f(x1)dx1dx

h h

R R

Z

= E bfn(x)f(x)dx.

R

Donc, Gb est un estimateur sans biais de fR

biais de J(h) est donne par

b

fn(x)f(x)dx. Finalement, l'estimateur sans

CV (h) = fn(x)2 dx - 2 E bfn,-i(Xi).

n

Ri=1

Et la fenetre optimale est telle que

|

hCV = arg min

h>0

|

CV (h).

|

???? ?et??? ?? ??????t?? ?r?sé? ??r

??\u9312‡@???? ?? ?r??s????????

|

et l'estimateur a noyau

|

fn s'écrit:

|

D(f , jn) = fRf(x) log {

j.f.:(xx))

dx

= IR f (x) log f (x)dx - IR f (x)log {

rn(x)} dx

= E [log { f (X)}] - E [log {fn(X) }1 .

b

|

L'idée de la validation croisée par vraisemblance

est de minimiser D(f,

|

fn). Toutefois,

|

cette distance n'est pas métrique et les

critères définis en la minimisant ne sont pas ap-

b

propriés pour obtenir un lissage

adéquat. Donc minimiser D(f, fn) revient

a maximiser

E [log {fn(X)}1. Ainsi, la fenetre optimale est

LCV (h),

hLCV = arg max

h>0

oU

.

LCV (h) = E [log {fn(X)}]

Par construction, nous avons l'estimateur sans biais de LCV

(h):

|

1

Jn = n

|

Xn

i=1

|

n o

log bfn,-i(Xi|h) ,

|

oU

1

bfn,-i(Xi|h) = (

~Xi - Xj ~

X

K

n - 1)h h

i6=j

n

Montrons que E(Jn) = E h oi.

log bfn(X)

Comme les variables aléatoires X1,X2, . . . ,Xn

sont i.i.d., d'une part nous obtenons

" o#

Xn n

1

E(Jn) = E log bfn,-i(Xi|h)

n

i=1

h n oi

= E log bfn,-1(X1|h)

|

?

= E ?log

|

?

?

?

|

?

~X1 - Xj ~? ?

1 X K ?

(n - 1)h h ?

j6=1

|

= E [log { h 1 K X 1 h X2

D'autre part, nous trouvons

" ( ~)#

h n oi Xn ~X - Xi

1

E log bfn(X) = E log K

nh h

i=1

= E [log { h1 K (X - hX )11

= E(Jn).

Enfin, la fenêtre optimale obtenue par la méthode de

validation croisée par vraisemblance se calcule a partir de :

" 1 n

hLCV = arg max log { fn,_i (Xi | h) }1.

h>0 n

i=1

Cependant, cet estimateur est très sensible aux valeurs

aberrantes. Sa diiculté apparait lorsque la méthode

est appliquée a des observations dont la distribution

présente de grandes queues. Les points

situés dans les queues de la distribution a estimer ont des

valeurs faibles, ce qui implique de faibles valeurs des

estimations correspondantes. La présence de l'opérateur log dans

l'expression de l'estimateur pose un problème de convergence

pour les valeurs de densités aux queues. Par

conséquent, il estest diicile dans ce cas de choisir hLCV de

facon optimale, puisque l'on risque soit le

sur-lissage soit une trop grande erreur sur les

queues.

2.1.8 Simulation des donnees

Danscettepartie,nousillustronscertainsestimateursanoyauxcontinussymétriques

a savoir le noyau d'Epanechnikov, le noyau

gaussien le noyau biweight et le noyau

triangulaire. Nous simulons un échantillon de taille n = 100

de la loi normale centrée et réduite. Pour chaque

noyau fixé, la fenêtre optimale est choisie par les

méthodes de validation croisée par moindre carrés et de

Plug-in

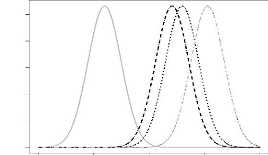

?? ???\u9312‡@ ?? ???etr? ??r

P??????

Cette méthode suppose que la densité

suit une loi normale dans lexpression de la fenêtre h optimale. La valeur

du paramètre de lissage est la même pour un

échantillon donné. Nous obtenons pratiquement des

estimations similairespourchaquenoyau continu

utilisé; ceci s'explique par le fait

que les noyaux continus

symétriquespossèdent tous des

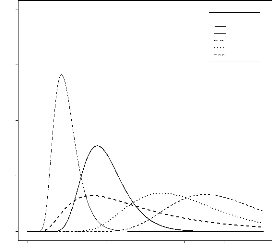

efcacités proches l'une de l'autre (Figure 26)

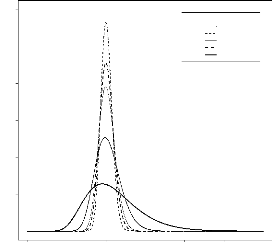

?? ???\u9312‡@ ?? ???etr? ??r ??????t??

?r?sé? ??a ??\u9312‡@???? ?? ?v??i????????

Le choix de la fenêtre optimale hopt se fait en fixant

au préalable le noyau continu Le noyau par

défaut dans le logiciel R est le noyau

gaussien. Le choix des noyaux continus

symétriques n'est pas important car ils ont

quasiment les mêmes propriétés, c'est

pourquoi le choix de la fenêtre optimale se fait sous

lhypothèse gaussienne (et(et aussi pour des

raisons techniques imposées sous R) Pour chaque

noyau continu symétrique fixé,

la figure (2.7) présente la fenêtre optimale hCV =

0.1636. Pour cette valeur de h, les estimations des différentes

densités sont pratiquement similaires.

?? ???ts ?? ???\u9312‡@ ?? ???êtr?s

Nous comparons différentes estimations en faisant varier

la valeur de la fenêtre pour le même noyau continu. Nous

choisissons le noyau optimal dEpanechniiov

Les simulations effectuées dans la figure

(28) mettent en lumière que les performances

pratiques des estimateurs a noyaux continus

symétriques considérés

dépendent fortement du choix de la fenêtre h. Par

conséquent, ce choix est plus crucial que le

choix

Dwelt,

0.0 0.1 0.2 0.9 0.4

Dwelt,

0.0 0.1 02 0.9 0.4

Dwelt,

0.0 0.1 0.2 0.9 0.4

Dwelt,

0.0 0.1 02 0.9 0.4

|

bfn(x) = 1

n

|

Xn

i=1

|

KH (Xi - x) . (2.14)

|

FIG. 2.6 -- ??ss???s ??r ??s ?st???t??rs d

?\u9313‡A??\u9312‡@ ??t???s ?? ? ??ist???t?? ???? ?????

t???? ?? ?? ?r???? ???tré? r(???t?? n = 100 ?t hPI =

0.338

x

Biweight PI

|

Triangulaire PI

|

|

x

du noyau. Les valeurs de h sont celles choisies

par plug-in (hpi = 0.338), validation

croiséeparvraissemblance (hCV =

0.429)etdeuxautresvaleursarbitrairestelque h = 0.05 et h = 1.

2.2 Cas multivarie

Les principales techniques d'estimation

non-paramétriques de densité dans le cas

géneral d'observation de dimension

quelconque restent des variantes destimateurs à

noyau. Nous pouvons choisir destimer toutes les composantes des

observations simultanément ou selon chaque composante

séparément (en faisant le produit des noyaux

univariés).

Nous considérons ainsi les observations (Xij) i.i.d. avec

i = 1, ...,n et j = 1,...,d. Cette échantillon est de densité de

probabilité f continue et inconnue sur = Rd.

b

L'estimateuranoyaucontinusymétrique

fn def admetuneversionmultidimensionnelle et se présente de

maniere générale par

Dwelt,

0.0 0.1 0.2 0.9 0.4

Dwelt,

0.0 0.1 02 0.9 0.4

FIG. 2.7 -- ??ss???s ??r ??s ?st???t??rs d

?\u9313‡A??\u9312‡@ ??t???s ?? ? ??ist???t?? ???? ?????

t???? ?? ?? ?r???? ???tre? re???t?? n = 100 ?t hCy = 0.429

Dwelt,

0.0 0.1 0.2 0.9 0.4

Dwelt,

0.0 0.1 02 0.9 0.4

Epanechn.CV

Biweight CV

|

x

Triangulaire CV

|

|

x

on x =t (x1, ... ,xd) ? Rd, Xi

=t (Xi1, . . . ,Xid) et H = est la matrice de

variance-covariance de la fenetre h, de dimension d × d, donnée

par

H=

?

?? ? .

[H. ... h1d h21 . . . h2d ...

h2j ... hd1 ... h2d

La fonction KH est la fonction noyau définie

sur ?x,h = Rd et reliée avec le noyau

univarié (que nous avons présenté

précédemment) par la relation suivante

|

KH (x) = Idet (H)}

|

--1/2 K (H--1/2x) .(2.15)

|

En effet, comme nous pouvons le remarquer dans

lexpression de H, il peut y avoir des termes de corrélation

entre les différents parametres de lissage. Ces coeffcients

de corrélation vont compliquer davantage les

calculs Nous proposons ainsi une expression plus simple qui fait

appel a un produit des noyaux univariés et qui

néglige leffet des

FIG. 2.8 - ????r??s? ??s ??ss???s

??r ???st???t??r a ?\u9313‡A?? ??t??? ???????????????

???s??t ??r??r ?? ???etr? h

Epanechn.CV h=0.429

Dwelt,

0.0 0.1 0.2 0.9 0.4

Epanechn.PI h=0.338

Dwelt,

0.0 0.1 0.2 0.9 0.4

-2 -1 0 12 -2 -1 0 12

|

x

Epanechn. h=0.05

|

x

Epanechn. h=1

|

-2 -1 0 1 -1 1 2

x

Dwelt,

0.0 0.1 02 0.9 0.4

Dwelt,

0.0 0.1 02 0.9 0.4

corrélations. Dans ce cas, l'estimateur est

|

in(x) = 1

nh1 . . . hd

|

Xn

i=1

|

? ?

?

|

d

j=1

|

(Xij x,) ; hj .1 (2.16) ? ,

|

avec x =t (x1,...,xd) E Rd,hj > 0, Ed

j=1 hj --> 0 et n 1dj=1 hj --> co et Kj est la

fonction noyau univarié présentée

antérieurement En pratique les noyaux-produits

sont recommandés. Les estimateurs a noyau

généralisés sont importants pour lesles

études numériques, mais ils restent cependant utiles

pour des considérations théoriques etet dans certains

cas particuliers.

Note: De manière plus simple, nous prenons le

noyau Kj = K, c'est a dire que nous utilisons ce

même noyau pour toutes les observations. Cependant nous

pouvons faire un mélange de différents

types de noyaux tels que le noyau

d'panechniiov avec le e gaussien, le biweight, etc.

Chapitre 3

Noyau associé continu asymétrique

Dans ce chapitre nous commençons par donner

la définition dun noyau associé continu. A partir de

cette définition, nous présentons lestimateur a noyau

associé continu asymétrique dans le cas

univarié puis multivarié. Nous étudions les

propriétés

élémentairesdecetestimateur.Différentsexemplesseronttraitésenguisedeconclusion.

3.1 Cas univarié

Danscettepremièrepartie,nousprésentonslestimateuranoyauassociécontinuasymétrique

dans le cas univarié. Cet estimateur est approprié pour estimer

des densités a support compact ou bornées d'un côté.

Nous allons traiter quatres noyaux di~érents

gamma, bêta, gaussien inverse (IG) et

gaussien inverse réciproque (RIG) Pour de

réé centes références nous pouvons consulter Chen

(1999 2000) et Scaillet (2004) Nous montrons les propriétés

élémentaires telles que biais, variance et MISE.

Ensuite nous déterminons les fenêtres optimales pour

chaque noyau associé considéré et

lerreur en fonction de ces valeurs.

Soit X1,X2,. . . ,Xn un échantillon de

variables aléatoires iid de densité de probabilité

continue inconnue f a support = [a,b], avec a E R et b E R ( est par exemple

le support [0,1] ou [0, + 8[). De manière

génèrale, l'estimateur a noyau continu est

de la forme suivante:

|

bfn(x) = 1

n

|

Xn

i=1

|

(3.1)

Kx,h(Xi)

|

= bfn,h,K(x),

on x est fixé dans , Kx,h est la fonction noyau

associéU et h est un réel strictement positif appelé

paramètre de lissage.

Dans le cas on Kx,h est associé a un noyau

continu symétrique il vérifie

~x - . ~

1

Kx,h(.) = hK .

h

Dans le cas purement asymétrique,

Kx,h est un noyau variable en fonction de la cible x (point

d'estimation). Il change de forme chaque fois

que x varie dans .

3.1.1 Definition

Definition 1: Soit x ? ? et h > 0. Nous appelons

"noyau associe continu "" Kx,h toute densit( de

probabilit( dune variable aléatoire Kx,h sur le support ?x,h tels

que:

|

?x,h n ? =6 Ø

|

(3.2)

|

|

?x?x,h ? ?

|

(3.3)

|

|

E(Kx,h) ~ x quand h ? 0

|

(3.4)

|

|

V ar(Kx,h) < co

|

(3.5)

|

|

V ar(Kx,h) ? 0 quand h ? 0.

|

(3.6)

|

Commentaires::

a. La relation (3.2) traduit le fait que

l'intersection entre le support des observations et le support du

noyau associé continu

asymétrique doit contenir au moins un

élement. Pour un h fixé, quand x parcourt ?, le

support ?x,h change, l'expression (3.3) suppose que ?

doit etre toujours contenu dans la réunion des ?x,h. La

condition (3.4) permet d'assurer la convergence ponctuelle de

l'estimateur ; elle met en évidence que le noyau

Kx,h est un noyau variable ou adaptif a la cible x. Par

analogie au cas continu symétrique, la

relation (3.5) n'est que la formule annoncée dans (25) du

chapitre précédent. Enfin, la relation (3.6) assure la

convergence de la variance de la variable aléatoire du

noyau associé et va nous servir dans les calculs suivants.

b. Avant que nous passons a l'étude des des

noyaux continus asymétriques, nous

reveFIG. 3.1 - Densit( de loi norinale centrée

Densité de la loi

normale

0.0 0.1 0.2 03 0A

th30040)

-6 -4 -2 0 2 4 6

x

FIG. 3.2 -- Illustration de la densite normale pour h = 1.5 et x

= y varie

0.00 0.05 0.10 0.15 0.20 0.25

K(Y)

|

1

|

Xn

i=1

|

~ ~

exp -1 (Xi x)2 . 2 h2

|

|

nhv2ð

|

-10 -5 0 5 10

y

male N(u,ó2) est une loi continue

définie sur ? = R de densité de probabilité

gN(u,ó2) telle que

~ ~

1 -1 (x - u)2

gN(u,ó2)(x) = v2ðó2 exp .

2 ó2

Si X est une variable aléatoire qui suit la loi

normale alors lespérance et la variance sont respectivement

E(X) = u et V ar(X) = ó2.

La figure 3.1 donne l'allure

génerale d'une densité normale centrée Soit

KN(x,h2) le noyauassociéalavariablealéatoire

KN(x,h2) deloinormale N(x,h2)définisur ?x,h = R.

Nous vérifions ainsi chacune des hypothéses de la

définition 1 En effet, la relation (3.2) se traduit par l'intersection

de ? = R avec ?x,h = R qui n'est que R. En plus, d'apres

(3.3), la réunion sur x de R reste inchangée

puisque le support ne dépend pas de x. A partir de (3.4),

l'espérance est exactement égale a x;

E(KN(x,h2)) = x.

Finalement, la variance est finie et égal

exactement a 0 quand h ? 0;

V ar(KN(x,h2)) = h2 < 8.

A ce niveau, nous donnons l'estimateur a noyau

associé normal défini sur ? = R. Soit X1, ... ,Xn un

échantillon de variables aléatoires iid. de densité de

probabilité f continue et inconnue sur R. L'estimateur a

noyau associé gaussien est

|

bfn(x) = 1

n

|

Xn

i=1

|

KN(x,h2)(Xi)

|

FIG. 3.3 Illustration de la densit normale pour x = 2.1 et h

varié

-1 0 1 2 3 4 5

N(x,h)(y)

0.0 0.5 1.0 1.5 2.0 2.5

h=0.15 h=0.3 h=0.7 h=1.1 h=1.4 h=1.8

Get estimateur est-il une densité de probabilité?

Oui en effet

ZR

Z ( (t - x ~2)

1

bfn(x)dx = -1

hv 2ð exp dx

2 h

R

Z r (x - t )2}

(a) 1 -1

= hv 2ð exp dx

2 h

R

= 1.

(a): La loi gaussienne est

symétrique le fait que nous

intégrons par rapport a x (la cible qui est aussi

la moyenne) ou a t (la variable aléatoire) ne

change rien; nous nous permettons ainsi de permuter entre

la cible x et t et nous trouvons que c'est une densité de

probabilité (voir figure 3.2 et 3.3). Bien que la

vérification dans le cas dun noyau

associécontinusymétriqueparaltsimple,laquestionrestevalablepourchacundesnoyaux

asymétriques.

Nous présentons maintenant les densités continus

asymétriques classiques que

nous allons utiliser dans la suite de cette section (Tab 31)

Soient a et b deux réels strictement positifs

qui vérifient

Z +8

(a) = e_tta_1dt

0

et

Z 1

B(a,b) = ta_1(1 - t)b_1dt.

0

3.1.2 Propriétés élémentaires

Nous donnons dans cette partie les différentes

propriétésfondamentales delestimateur a noyau

associé.

TAB. 3.1 -- ??????? re????t???t?? ??s ??s

?? ?r?????te ??t????s

?s\u9313‡A?éet?i??e

Loi de probabilité Support Densité

Gamma(a,b) R+ (a1)ba ta-1 exp(-t/b)

Beta(a,b) [0, 111 B(a,b)ta-1(1 -

t)b-1

IG(a,b) R+ vvb2ðt3 exp {- 2ba ( a t - 2 + 7)}

RIG(a,b) R+ l2ðtb exp {- 2ba (at - 2 + a1t)}

Loi de probabilité Espérance Variance

Gamma(a,b) ab ab2

Beta(a,b) a/(a + b) ab/ {(a + b)2(a + b + 1)}

IG(a,b) a a3/b

RIG(a,b) 1/a + 1/b 1/ab + 2/b2

Propriétés 1:: ??t X1,X2,. . . ,Xn ??

(????t???? ?? ??r?????s ??e?t?r?s ?????? ?? ????

b

s?t ?? ?r??????te ??t???? ??????? f d

s???rt ?? ??t fn ?? ?st???t??r ?? f a

?\u9313‡A??

b

fn(x) ???st ??s ?e?

?ss??e ??t??? ?s\u9313‡A?etr?q??

?é??? ?r ?? ??rs? ?? ???t?? x 7-?

??ss??r????t ??? ???s?tt ?? ?r??????té ?r ?? ??

?s??t

1,2

c = I bfn(x)dx = c(h,K) = 0,

b

??s ??s??er?s ?esr???s ???st???t??r fn t?? q??

|

in(x) = nc

|

Xn

i=1

|

Kx,h(Xi). (3.7)

|

|

Dans la suite, nous supposons que

|

fn(x) est une densité de probabilité.

Nous illustrons

|

cette hypothese dans la partie exemple

b

densite de probabilite continue inconnue f de support ?. Soit

fn l'estimateur de f a noyau associe continu

asymetrique Kx,h de variable aleatoire Kx,h

sur le support ?x,h. Alors, ?x ? ? et h > 0, nous avons

E {fri(x)} = E{f(Kx,h)} . (3.8)

Démonstration: Soit x ? ?. Nous avons successivement

E {/n(x) } = E nEKx,h(Xi)}

{ 1 n

i=1

= E {Kx,h(X1)}

(a)

=

= E{f(Kx,h)} .

(a); les Xi sont dans ? et le noyau

associé est défini sur ?x,h. D'on l'intégrale

se fait sur l'intersection des deux supports

Dans le but d'assurer la convergence ponctuelle de

lestimateur nous avons adapté le lemme présenté par Hille

(1948) et dont une démonstration a été donnée par

Feller (1966) dans le lemme1,page 219.Noussignalons

que celemme étaiténoncé

dansletravailrécentdeChaubey

etal.(2007)1.Ainsi,nousleformulonsdanslapropriétésuivante

Propriété 3: Soient f une fonction continue et

bornée sur ? et x est fixée sur ce

b

support. Soit fn l'estimateur a noyau

associé continu Kx,h sur ?x,h. Nous supposons que

?x ? ?,?x,h ? ?. Alors nous avons

|

E {In(x)} =

|

ftn?x,h

|

f(t)Kx,h(t)dt ? f(x) quand n ? 8.

|

La convergence est uniforme en toute subdivision de ?

dans laquelle V ar(Kx,h) ? 0 quand h ? 0 et la

fonction f est uniformément continue.

Démonstration: Nous partons de l'expression de lestimateur

dans (3.1) et nous calculons son espérance

E {fn(x)} = Kx,h(z)f (z)dz.

Itx,hn?

Comme?x,h ? ?, nous pouvons écrire f(x) = f(x) R

?x,h Kx,h(z)dz. Ainsi, il existe ä > 0

tel que

~

E{.7.n(x)}- f(x) =h{f(z) - f (x)}

Kx,h(z)dZ

Nx,

f |f(z) - f (x)| Kx,h(z)dz + I |f(z) - f (x)|

Kx,h(z)dz.

?? \u9670·?s et??s r???tes ???s ?? res??t?t ??r ? Pr??ss??r

???????? ????u a ??????er?it ??????????? ?t ?? ??s?t? ?? ???r?t?r? ??

??t?e??t?i??e ?????i?u?e ?? ???

Pour calculer la première quantité, nous

utilisons directement la définition de la continuité:

?e > 0, ? ä > 0, ?z : |z - x| < ä |f(z) -

f(x)| < €. D'on nous obtenons,

|f(z) - f (x)|Kx,h(z)dz = E Kx h(z)dz

lz-x|<ä flz-x|<ä

= €.

Pour calculer la deuxième quantité, nous

utilisons linégalité de Tchebychev-Markov

Comme f est bornée ? M > 0 tel que f = M. Ainsi, nous

avons

fl (z) - f (x)|Kx,h(z)dz = 2M I Kx,h(z)dz

z-xl>5|

1z-x|>ä

2M

ä2

ä2 Kx h(z)dz

flz-x|>ä

2M

L (z - x)2 Kx,h(z)dz

.,h

2M

ä2

E {(Kx,h x)2}

(a) = 2M 2M

ä2 V ar (Kx,h) + ä2 {E (Kx,h) -

x}2

(a): nous appliquons directement la formule

E(X2) = V ar(X) + {E(X)}2. Or, d'après les deux

hypothèses (3.4) et (3.6) du noyau associé,

la dernière inégalité tend vers 0. Nous

concluons enfin que

E { in(x)} -f(x) ? 0 quand n ? +8.

Remarque: ?? ?r?r?ete

q?? ??s ???s ?res??t( ?st ??????? ???s ??le ??s ??e

?\u9313‡A??\u9312‡@??t???s

s\u9313‡A?etr?q??s ?t

?s\u9313‡A?etr?q??s?

Proprietes 4: \u9670·?s ?res??t?s ??

?e?????????t ????t( ??

??\u9313‡A?r????r???? a ?r?d??

?t ?? ???t ?\u9313‡A?? ?? ?? ??r????? ??e?t?r? E(Kx,h) = mx,h

t?? q??

f(Kx,h)ÿ=f(mx,h) + (Kx,h -

mx,h)f0(x) + 12(Kx,h -

mx,h)2f"(x). (3.9)

?? ????????t ???s?er???? ?? ??tt?

q???t?té? ??s ?t???n

E {f(Kx,h)} ÿ=f {E(Kx,h)} +

2V ar(Kx,h)f00(x). (3.10)

1

3.1.3 Biais ponctuel

Propriétés 5:: Soit x fix( dans ?. Nous

avons

Biais {1n(x) } = E {1n(x)} - f(x)

=ÿ [f {E(Kx,h)} - f(x)] + 21 V

ar(Kx,h)f" (x). (3.11)

Demontration : En effet, d'apres le resultat de (38) et les deux

expressions dapproximation de Taylor-Lagrange

(3.9) et (3.10) le biais sobtient facilement en retranchant

f(x).

Remarque: Nous remarquons que le

biais ne d(pend pas de n et tend vers 0 quand h est tres

petit.

|

3.1.4 Variance ponctuelle

Pour un x fixe, nous generalisons l'expression de la

variance de que ce resultat sera utilise dans la partie exemple

|

b

fn.

|

Nous precisons

|

Propriétés 6:: Soit x fix( dans ?. Nous

avons

n o Z h n o i2

V ar bfn(x) =ÿ 1 K2

x,h(t)f(t)dt - 1 Biais bfn(x) . (3.12)

+ f (x)

n n

?x,hn?

Demonstration: Comme les Xi sont i.i.d., nous obtenons

successivement

V ar {:fn(x) } = V ar { 1 E Kx,h (Xi)}

n

i=1

|

1

n

1

n

|

[V ar {Kx,h(X1)}]

[E {Kx,h(X1)}2] -1 n [E{Kx,h(X1)}]2

|

(Z ) (Z )2

1 K2 - 1

x,h(t)f(t)dt Kx,h(t)f(t)dt .

n n

?x,hn? ?x,hn?

Par analogie avec le noyau continu

symetrique nous avons

|

{Z ?x,hn?

|

2

Kx,h(t)f(t)dt }=ÿ [Biais fn(x)} + f

(x) 2

|

et sous la condition f?x,hK x2 h(t) f (t)dt est finie,

la variance de fn est

J

1 2

V ar {in(x)} =ÿ1

h(t) f (t)dt } - n [Biais {fn(x)} + f (x)1 .

n Rxhn?x,

|

3.1.5 MISE L'erreur globale de

|

b

fn s'obtient en sommant le carré de

l'expression (311) avec le

|

resultat obtenu dans (3.12).

Propriétés 7: En sommant sur l'intersection des

deua supports, e MIISE est

|

Z

MISE =

?

|

{ }

E bfn(x) _ f(x) dx

x,hn?

|

Z { } Z }

Biais2 {

= V ar bfn(x) dx +

bfn(x) dx.

?x,hn? ?x,hn?

3.1.6 Exemples

Nous supposons dans toute la suite que f admet une

dérivée seconde continue sur

}2 }2

le support et que les termes suivants sont finis J {

{

f'(x) dx, J xf''(x) dx et

? ?

f{ }2

x3f''(x) dx.

?

a. Cas d'un noyau associé gamma

Chen (2000) était le premier a introduire l'estimateur a

noyau asymétrique. Il

préb

|

sentait au début un premier estimateur

|

fn a noyau gamma de

paramètres a = x/h + 1

|

et b = h, il calculait ensuite les propriétés

ponctuelles et globalesliées a cet estimateur Puis, a cause

des problèmes du biais au bord quavait cet estimateur Chen

e~ectuait

unelégèremodificationauniveaudesparamètresdunoyaugammapourréduirelerreur

|

et il représentait un deuxième estimateur

que nous notons

|

bbfn(x).

|

Nous rappelons qu'une loi gamma est une loi

continue asymétrique définie sur = R+ de

densité de probablité gG(a,b) telle que:

ta-1e-t/b

gG(a,b)(t) = (a)ba ,

Z

(a) =

avec

e-tta-1dt.

R+

Si X une variable aléatoire qui suit la loi

gamma, alors

E(X) = ab et V ar(X) = ab2.

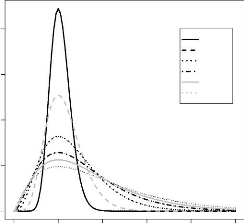

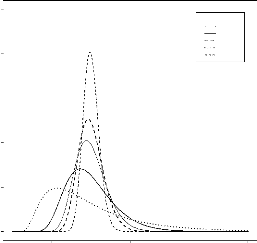

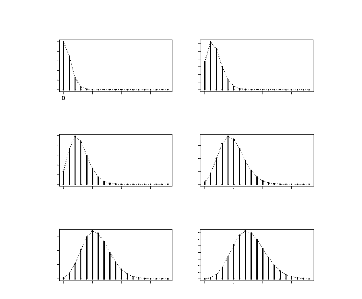

D'après la figure 3.4, nous

remarquons que selon les valeurs que prennent

a et b, l'allure de la courbe change. Dans le cas particulier on a =

1 nous retrouvons la loi exponentionnelle.

Soit KG(x/h+1;h) le noyau associé a la variable

aléatoire 1G(x/h+1;h) de loi gamma et de support x,h = R+. Il

est donné par

FIG. 3.4 Allure générale d'une densit

gamma

Densité de la loi gamma

0 1 2 3 4 5

y

Density Gamma

0.0 0.2 0.4 0.6 0.8 1.0

Gamma

a=1 b=1

a=2 b=1

a=3 b=1

a=4 b=2

a=5 b=2

Les deux figures 3.5 et 3.6 donnent l'allure du

noyau associé gamma qui dépend

des paramêtres x et h. Nous donnons en premier lieu la

représentation du noyau gamma pour un h

fixé, nous remarquons qu'en changeant x

la courbe change légérement de forme et se

déplace principalement sur l'axe des abscisses. Cependant, si nous

varions h comme indiqué dans le

graphique 3.6, l'allure de cette densité

change complétement.

Nous révisons d'abord les différentes

hypotheses du noyau associé KG(x/h+1;h).

R+ = Ø.

i.R+ n =6

R+

ii.uxR+ = R+.

+ 1)h = x ' x h --* 0.

iii.E(JCG(x/h+1,h)) quand

= (x/h + h

xh +

iv.V ar(JCG(x/h+1,h)) = (x/h + 1)h2 = h2

< 00.

v.h --* 0 V ar(JCG(x/h+1,h)) = 0.

Soit X1,X2,. . . ,Xn un échantillon de

variables aléatoires iid. a support = R, de

b

densité de probabilité continue inconnue f. Nous

considérons l'estimateur fn a noyau associé

gamma tel que

Xn

i=1

Xn

i=1

bfn(x) = 1

n

1

n

KG(x/h+1;h)(Xi)

Xx/h

1 i e_Xi/h

(x/h + 1) hx/h+1 ,

FIG. 3.5 Allure du noyau assoei gamma

pour h = 0.2 et x varié

h=0.2

0 1 2 3 4 5

y

Gamma(x,h)(y)

0.0 0.5 1.0 1.5 2.0

x=0 x=0.5

x=1

x=2 x=2.8 x=3.5

on h > 0 est le paramêtre de lissage et K est

le noyau associé a une variable aléatoire de loi

gamma de paramêtres x/h + 1 et h. D'aprês (3.11), nous

avons

{ } = hf'(x) + 1

Biais bfn(x)

2hxf''(x) + o(h). (3.13)

Dans le calcul du biais, nous nous arrêtons a lordre 1

pour avoir une homogénéité des puissances avec

la variance dans le calcul de lerreur quadratique

moyenne intégrée MISE (Le biais sera

élevé au carré) D'aprês cette expression, nous

remarquons que e biais tend vers 0 quand h

tend aussi vers 0. Le fait que f' et f''

figurent dans la même équation, n'est pas

três favorable dans le calcul du biais puisque

ça augmente lerreur La complicité de la

dérivée premiere avec la dérivée seconde est dfe au

fait que x n'est pas la cible mais elle est plutôt le mode.

Nous calculons la variance de cet estimateur Daprês (312)

nous avons

{ o h

V ar bfn(x) = 1 E

~KG(x/h+1;h)(X1)~2i - 1 ~E ~KG(x/h+1;h)(X1)~]2 . n n

Nous calculons chacun des deux termes En effet nous avons

.

( )

X2x/h

1 e_2X1/h

E {KG(x/h+1;h)(X1)}2 = E

h2(x/h+1)2x/h + 1

FIG. 3.6 - Allure du noyau associe gamma

pour x = y = 2 et h varie

0.0 0.2 0.4 0.6 0.8

Gamma(x,h)(y)

x=2

h=0.1 h=0.3 h=0.7

h=1.1 h=1.4 h=1.8

0 2 4 6 8 10

y

Soit KG(2x/h+1;h) un noyau associe gamma de

par/ahme-et2rXe1s /2h

01. 2x/h + 1 et h;

{KG(2+1;h)(X1)} =

2 1 2x h2x/h+1(2x/h +

1).

Ce qui implique

X1 2x/he-2X1/h = h2x/h+1(2x/h

+ 1)KG(2x/h+1;h)(X1). Ainsi, nous trouvons finalement

(

h2x/h+1 (2x/h + 1)

E ~KG(x/h+1;h)(X1)~2 = E

h2(x/h+1) 2(x/h + 1) KG(2x/h+1;h)(X1)

h-1

(2x/h + 1) il K

lG(2x/h+1;h)PC1)}

=

2 (x/h + 1) .

Nous examinons les differentes conditions du noyau

associe KG(2x/h+1;h). i. R+ n R+ = R+ =6 Ø.

ii.?xR+ = R+.

iii. E(KG(20/+1;h)) = (2x/h + 1)h = 2x + h.

iv. V ar(KG(201,+1;h)) = (2x/h + 1)h2 = 2xh +

h2 < co.

v.h ? 0 V ar(KG(2x/h+1;h)) = 0.

Ah(x) ~

-1/2 si x/h ? 8

1h si x/h ? k,

?

??? ?

????

1 x 2vhð

(2k+1) 21+2k2(k+1)

Nous avons ainsi

E~KG(2x/h+1;h)(X1)~ = f(x) + h 2 f0(x) + o(h).

Soit l'expression de Ah(x) telle que

Ah(x) =h-1 (2x/h + 1)

2(x/h + 1).

Nous considerons la fonction R(z) monotone, croissante et

converge vers 1 quand z tend vers l'infini (i.e: ?z >

0, R(z) < 1). Elle est donnée par

v

2ð

R(z) = e-z zz-H. (3.14)

(z + 1)

En prenant z = 2x/h et z = x/h, nous obtenons

v2ð

e-2x/h(20.)2x/h+1/2

R(2x / h) =

(2x/h + 1)

R2(x/h) =

2ð e-2x/h(2x/h)2(x/h+1/2).

2 (x / h + 1)

Ainsi, Ah(x) peut etre exprimee en fonction de R(x/h) et

R(2x/h).

Ah(x) = 1 v2ð R2 (x / h)

e-2x/h 2x \ 2x/h+1/2 x -2(x/h+1/2)

2ð R(2x/h) e-2x/h h h

|

h1/2

|

R2(x/h) x R(2x / h)

|

-1/222x/h+1.

|

|

v2ð

|

Comme R(z) < 1 alors R2(z) reste encore inferieur a

1. Par consequent, le rapport

R(2x/h) < 1 et nous trouvons

R2(x/h)

h1/2 R2 (x/h)

-1/222x/h+1

Ah(x) =

v2ð R(2x/h) x

hv

= 2v.

ðx

Pour un h suffisamment petit,

on k est une constante positive.

Nous calculons a ce niveau le deuxieme terme de la variance

2

\ 112

[E {KG(x/h+1;h)(X1) I .1 = [E {Lfn,h,K(x)dx }i

=(a) 1.

(a): D'apres la propriété (3.7).

En conclusion, la variance est donnée par

-1/2f(x) + O(n-1) si x/h ? 8

1 si x/h ? k.

hnf(x)

V ar {:fii(x)} ~ ??? ? ?

????

1 x 2nvhð

(2k+1)

21+2k2(k+1)

L'impact de la variance au bord est

négligeable dans la calcul de son

intégrale, nous ne tenons compte que du terme

qui se trouve a lintérieur de notre support ceci se

démontre par le calcul suivant:

Soit ä = h1-E, on 0 < E < 1.

f ar {:fii(x)} dx = 1ä V ar

{:fii(x)} dx + f: V ar {:fii(x)} dx

T8 1

x-1/2 f (x)dx + O(n-1 h-€)

2nvher

1 r 2nvher 0 x-1/2 f (x)dx +

o(n-1h-6).

La valeur de la variance dans la petite boule de centre 0 et

de rayon h1-€ dispose d'une valeur dérisoire

ce qui fait que la quantité

qui pése le plus est celle qui se trouve au milieu de

]0, + 8[.

Nous mesurons ainsi l'erreur quadratique

moyenne intégrée MISE

8 2 rMI SE(n,h,K,f) = 10 Biais {fn(x) } + V

ar {:fn(x)}

Z 82

= h2 r f0(x) +

12xf"(x) dx

0

+ 2nN 1 her Jo8

x-1/2f(x)dx + o( 1 ).

nvh

En minimisant le MISE par rapport a h, nous avons

|

2h

|

fo

|

2

(x) + 12xf (x) } dx

|

1 1

2n 2h2Or /0

|

8

x

|

-1/2f(x)dx = 0.

|

Enessayantdedéterminerlafenetreoptimalenousregrouponslestermesen

hdememe coté;

8

0°

2h I {f' (x) + 1 2 x f" (x) }2

dx =

2n 2h2ver

1 x-1/2 f (x)dx.

C'est-à-dire

|

h5/2 = 1/20r f rx-1/2f()dx 4f 0 {1(x) +

(x)}2 dx

n

|

-1.

|

Enfin, la fen:tre optimale est

|

hopt =

|

(1/2vð)2/5 r

if08 x-1/2f(x)dx}2/5 n [f r { f' (x) +

1xf"(x)}2 dx] 2/5

|

-2/5.

|

La fenetre optimale dans le cas

asymétrique est dordre

O(n-2/5) inférieur que dans le cas

symétrique O(n-1/5). En

remplacant cette valeur optimale dans l'expression du MISE, nous

avons successivement

2

MISEopt (hopt)

ho2 pt 8 1

{f (x) + 2x f (x) } dx

|

+

|

1 1

|

8

L-1/2 I

x-1/2 f (x)dx

'opt

|

|

|

2vð n

|

|

=ÿ

|

n-4/5

44/5 2v7r 0

{ 1 /8 -1/2 2 1/5

x f(x)dx }4/5 f (x) + 2x (x) } dx .

[18 1 "

0

|

b

Dans le but de réduire le biais et par la suite

l'erreur entre fn et f, nous présontons le deuxième

estimateur qu'a introduit Chen (2000) ; la modification sest faite

au niveau de la cible de sorte qu'elle devient la moyenne

de la variable aléatoire du noyau associé. Pour cela,

soit

|

fn(x) = 1

n

|

Xn

i=1

|

KG(ñh(x);h)(Xi), (3.15)

|

ofi

|

ñh(x) ~

|

?

?? ?

???

|

x si x = 2h

4h2

x2+1

si x ? [0,2h[.

|

De la meme manière, nous calculons toute les

propriétés de cet estimateur Le biais est tel que:

|

Biais {in(x)} ~

|

?

?? ?

???

|

2 x f" (x)h + o(h) si x = 2h

îh(x)hf'(x) + o(h) si x ? [0,2h[.

|

La variable î dépend de h et change de

valeur en fonction de x, elle est égale à:

îh(x) = (1 - x) {ñh(x) - x/h} / {1 + hñh(x) -

x}.

Clairement, le biais est plus petit dans ce cas ;

quand x tend vers l'infini, nous obtenons une expression

qui ne dépend que de la dérivée seconde

f00, ce qui est plus faible par rapport au biais de

fn.

La variance de f est équivalente a celle de

fn pour x/h tend vers l'infini. Nous distinguons une

légère différence dans le cas on x/h s'approche

de la constante k. En effet, la variance est égale a:

~ ~

V ar bbfn(x) ~

x-1/2f(x) + O(n-1) si x/h ?

8

a(k) n1 h f (x) si x/h ? k,

?

???

???

1

n

v 1 2 hð

avec a(k) un coefficient qui dépend seulement

de k.

La somme du biais au carré et de la variance nous

amène a déterminer le MISE de cet estimateur;

1 1 1 1 2

MISE( r 2 f (x)dx

Tfii)= h2 {x f (x)} dx + v x

hð n 0

4 0

(1/2vð)2/5 U08 x-1/2f(x)dx}2/5 Lb 8 {x

f" (x)} 2 dx] 2/5 n

-2/5.

Ainsi, la fenêtre optimale est

hopt =

En substituant cette valeur dans lexpression du MISE lerreur

quadratique moyenne

intégrée optimale est::

-1/2 f (x)dx ] 4/5

1 1

MIS Eot(hot) =44/5 [ 2vð fo8 x [fo8

fixf"(x)12 dx ] 1/5 n-4/5.

|

Nouspouvonsêtretenterquelesdeuxestimateurs f

et

|

bb

f atteignentlavitessedeconver-

|

gence optimale. Nous montrons que pour

toute densité f continue:

Z 8 ~f (x) + 2 x f,, (x) }2

dx= fo8 {x f,,(x) }2 dx.

Ceci implique

systématiquement

MISEopt( bf) =

MISEopt(bbf).

Enfin, du point de vue purement théorique, il

est clair que le deuxième estimateur bbf donne de

meilleure performance en utilisant une fenêtre plus faible par rapport au

pre-

b. Cas d'un noyau associe beta

Tout comme les noyaux gamma, Chen (1999)

applique le même principe pour les noyaux

bêta. Il introduit pour cela un premier estimateur on ilit

remarque que les paramètres choisis ne sont pas

les plus adéquats donc, ilit essaye de les

harmoniser etet les es

arranger pour aboutir a de meilleures estimations

et par conséquent de meilleures perr formances. L'idée

est strictement la meme nous commencons ainsi par rappeler la loi

beta. La densité de probabilité d'une loi beta est définie

continue sur [0,1] telle que:

|

gBe(a,b)(t) = on a > 0, b > 0 et vérifiant

|

B(a,b)ta-1(1 - t)b-11[0,1](t), 1

|

B(a,b) = I ta-1 (1 - t)b-1dt.

Si X est une variable aléatoire qui suit la loi

beta alors

a ab

E(X) = et V ar(X) =

a + b (a + b)2(a + b + 1).

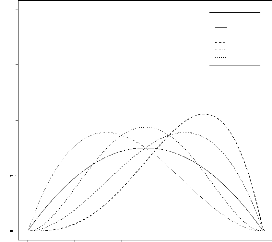

La figure 3.7 donne l'allure de la fonction beta d'une

manière générale.

FIG. 3.7 -- Allure generale de la densit(

bêta

0.0 0.2 0.4 0.6 0.8 1.0

y

Bet3(3,b)

4

3

2

Bêta

a=2 b=2

a=3 b=2

a=4 b=2

a=2 b=3

a=3 b=3

LenoyauKBe(x/h+1;(1-x)/h+1))estlenoyauassociéaunevariablealéatoire

KBe(x/h+1;(1-x)/h+1)) de loi beta et de support ?x,h = [0,1] tel

que:

.

1

KBe(x/h+1;(1-x)/h+1)(t) = B(x /h + 1,(1 - x)/h +

1)tx/h(1 - t)(1-x)/h

FIG. 3.8 -- Allure du noyau associe bêta pour

h = 0.2 et x varie

h=0.2

Beta(x,h)(y)

0 1 2 3 4 5 6

x=0 x=0.1 x=0.2 x=0.3 x=0.4 x=0.5

0.0 0.2 0.4 0.6 0.8 1.0

y

Lesfigures3.8et3.9donnentlavariationdunoyaubetachaquefoisquenouschangeons

les paramètres x et h.

Nous nous assurons que ce noyau est bel et

bien un noyau associé i.[0,1] n [0,1] = [0,1] =6 Ø.

ii.?x[0,1] = [0,1].

(x+h)

iii. E(KBe(x/h+1;(1--x)/h+1)) = (1+2h) x quand h

?0.

x(1--x)h+h2+h3

iv.

V ar(KBe(x/h+1;(1--x)/h+1)) = (1+2h)2(1+3h)< 8.

v.h ? 0 V ar(KBe(x/h+1;(1--x)/h+1)) = 0.

Soit X1,X2,. . . ,Xn un échantillon de

variables aléatoires i.i.d sur ? = [0,1], de densité

de probabilité continue

asymétrique inconnue f. Nous considérons

l'estimateur

fn de f

a noyau beta tel que

|

fn(x) = 1

n

|

Xn

i=1

|

KBe(x/h+1;(1--x)/h+1)(Xi)

|

1

n

Xn

i=1

B(x/h + 1,(1 - x)/h + 1)

,

1 Xi x/h(1 - Xi)(1--x)/h

avec x ? [0,1] et h > 0 est le paramètre de

lissage.

FIG. 3.9 -- Allure du noyau associe bêta pour x

= y = 2 et h varie

x=0.2

Beta(x,h)(y)

0.0 0.5 1.0 1.5 2.0 2.5 3.0

h=0.1 h=0.3 h=0.7

h=1.1 h=1.4 h=1.8

0.0 0.2 0.4 0.6 0.8 1.0

y

En se bénéficiant des calculs antérieurs

nous avons

1

Biais {:fii(x) } = h(1 - 2x) f (x) + 2x(1 -

x)hf"(x) + o(h),

et

V ar {:fii(x)} = n1 [E

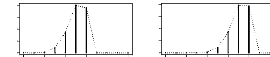

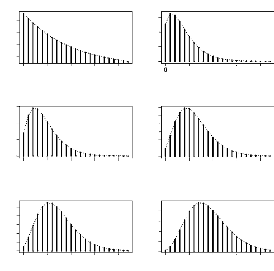

1KBe(x/h+1;(1-x)/h+1)(X1)}21 + O(n-1),