|

INTRODUCTION GENERALE

Depuis l'avènement relativement récent du

règne informatique, les systèmes matériels et logiciels

ont gagné régulièrement en complexité et en

puissance. Ils ont envahi toute notre vie quotidienne et sont désormais

incontournables dans la majorité des secteurs clefs de l'industrie. Peu

de domaines ont échappé à cette révolution au point

que la cohésion de nos sociétés fortement

industrialisées reposent sur la disponibilité des systèmes

complexes qui rythment notre activité de tous les jours : les

transactions bancaires, les télécommunications, l'audiovisuel,

internet, le transport de personne ou de bien (avion train ou voiture), les

systèmes d'informations des entreprises et les services fournis par ces

dernières, etc.

Produire les systèmes stables demande de passer

beaucoup de temps en études et en analyses. Heureusement, il existe des

techniques simples permettant de pallier à la fiabilité des

systèmes complexes, qu'ils soient matériels ou logiciels.

Plutôt que de chercher à rendre ces systèmes stables, on

peut inverser la démarche et intégrer à la source la

notion de panne dans l'étude de ces systèmes : si l'on peut

prévoir la panne d'un composant matériel ou logiciel, on peut

alors l'anticiper et mettre en oeuvre une solution de substitution. On parle

alors de disponibilité du service, voire de Haute Disponibilité

selon la nature de l'architecture mise en place

Aujourd'hui, la trop grande importance que

révèlent les services qu'on offre impose un certain niveau de

sécurité, les solutions de RAID et autres viennent se greffer

à des nouvelles solutions pour assurer une haute disponibilité

des services vitaux, car en effet très souvent d'énormes revenus

sont liés à la disponibilité plus ou moins parfaite de

certains services et ce, en fonction des domaines d'activités.

Voilà pourquoi dans ce présent travail nous

allons longuement parlé de la technologie de haute disponibilité

qui est le cluster d'équilibrage de charge réseau

I. PROBLEMATIQUE

La problématique est l'ensemble des questions

posées dans un domaine de la science, en vue d'une recherche des

solutions à un problème1(*)

La productivité au sein d'une structure

d'entreprise ou autres structures commerciales constituent une mesure de

l'utilisation efficace des facteurs de production, c'est-à-dire de

l'ensemble des moyens techniques, financiers et humains dont dispose cette

entité.

Cette productivité doit être optimale et

surtout ininterrompue ;

En effet, l'arrêt même momentané d'un

module du système d'informations peut paralyser le bon fonctionnement de

l'entreprise pendant la période de remise en production du maillon

manquant.

Par exemple, si le serveur de messagerie ne fonctionne

plus durant une demi-journée suite à un disque dur

défectueux, le temps de remplacer celui-ci et de faire la restauration ;

le service commercial ainsi que la direction sont dans l'incapacité de

répondre aux appels d'offres, le service clients ne peut plus faire le

suivi des réclamations, le service technique ne peut plus passer de

commandes aux distributeurs de matériels. La structure est

paralysée pour tous les échanges de courrier électronique,

qui représente un pourcentage conséquent de la gestion des

activités au sein d'une structure commerciale.

Comme conséquence, des contrats sont perdus, des

bénéfices sont en moins, des heures de travail sont perdues, des

sanctions pour l'équipe de commerciaux et pour le service informatique

peuvent aussi avoir lieu.

Conformément à tous ces problèmes,

nous nous sommes posé des questions qui suivent :

v Quelle technologie peut être mise en place pour

éviter ces genres de scénario catastrophe ?

v Comment faire pour s'assurer que cette technologie

réponde toujours aux critères de la haute disponibilité

des services ?

II. HYPOTHESES

Une hypothèse est, selon le dictionnaire Robert

Méthodique, une proposition relative à l'expression des

phénomènes naturels et qui doit être vérifié

par les faits2(*)

A ces préoccupations exprimées sous forme

des questions au niveau de la problématique, nous avons proposé

les réponses provisoires ci-dessous :

v La mise en place de la technologie du clustering

Network Load Balancing serait une solution pour assurer une haute

disponibilité sans interruption des services

v Pour s'assurer que cette technologie réponde

toujours aux critères de la haute disponibilité, il devrait

être administré et dépanner grâce à certains

utilitaires intégrés au système d'exploitation.

III. DELIMITATION DU SUJET

Toute observation scientifique exige de focaliser son

attention sur un objet en vue d'en tirer les bonnes impressions. Il serait donc

nécessaire que lorsque le sujet est défini, de limiter le cadre

de sa recherche.

Ainsi, pour éviter tout débordement, nous

avons délimité notre sujet dans le temps et dans

l'espace.

Du point de vue temporel, ce travail a été

effectué durant la période allant de Novembre 2015 et Juin

2016.

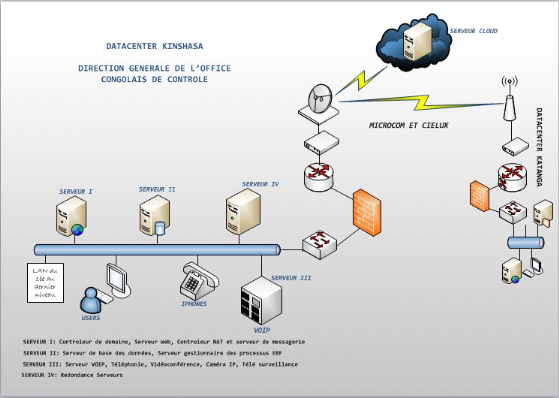

Du point de vue spatial, dans ce travail nous nous sommes

limités à parler uniquement sur la fonctionnalité de haute

disponibilité qui est le Cluster d'équilibrage de charge

réseau, NLB en sigle ; et cela à déployer à la

direction générale de l'Office Congolais

contrôle/Kinshasa.

IV. METHODES ET

TECHNIQUES

Pour arriver à la finalité de ce travail,

nous avons fait recours à certaines méthodes et techniques pour

la collecte et l'analyse de toutes nos données. Il s'agit ici

de :

v Technique d'observation :

qui nous a permit de constater de manière directe les faits ayant trait

à notre étude.

v L'interview : nous a

permit d'entrer en interaction verbale avec les personnes qui nous ont

accueillies sur notre site de recherche pour la collecte des

informations.

v Technique documentaire :

nous a permit de nous familiariser avec les différents manuels pour

trouver les données pouvant contribuer à l'enrichissement de ce

sujet.

v Méthode

structuro-fonctionnelle : nous a permit de rechercher

les impératifs fonctionnels et structurels pour maintenir

l'équilibre du système.

V. CHOIX ET INTERET DU SUJET

V.1 CHOIX

La chose qui nous a

poussé au choix de ce travail est la curiosité de savoir comment

pouvons-nous assurer dans une entreprise les services sans interruption afin de

gagner en temps et en revenu.

V.2 INTERET

Ce travail présente un intérêt non

négligeable du point de vue personnel et un autre, du point de vue

scientifique.

v Sur le plan personnel :

grâce à ce travail nous avons eu à développer plus

les connaissances en nous lançant dans la recherche des solutions de

haute disponibilité pouvant permettre à toute entreprise de

répondre favorablement aux attentes de ses clients.

v Sur le plan

Scientifique : ce travail va servir d'une base des

données aux futurs chercheurs à la compréhension de

fonctionnement des technologies pouvant assurer une haute disponibilité

en entreprise jusqu'à 99,99%

VI. DIFFICULTES

RENCONTREES

En effectuant nos recherches pour l'élaboration de

notre travail de fin de cycle, nous nous sommes heurtés à

certaines difficultés :

v La recherche documentaire a été

compliquée car nous n'avons pas pu avoir des documents suffisant pour

l'enrichissement de ce sujet. Cela se justifie par le manque des moyens

suffisants pour l'accession à des bibliothèques dans des

conditions normales.

v Les informations nous ont été

données après avoir souffert par des rendez-vous qui ne se

terminaient pas.

v L'indisponibilité des personnes qui devraient

toujours nous faire les informations dont nous avions besoin pour faire ce

travail.

VII. SUBDIVISION DU TRAVAIL

Hormis l'introduction générale et la

conclusion générale, ce travail est subdivisé en quatre

chapitres :

Le premier qui a été consacré

à des notions des généralités sur les

réseaux informatiques.

Le deuxième chapitre a présenté les

notions sur la fonctionnalité du clustering Equilibrage de charge

réseau.

Le troisième chapitre parle du site auquel nous

avons effectué nos recherches qui est l'office congolais de

contrôle.

Le dernier a montré les démarches pour

mettre en place la fonctionnalité du cluster NLB et comment

l'administrer et la dépanner en cas de nécessité.

CHAPITREN I : GENERALITES SUR

LES RESEAUX INFORMATIQUES

I.1 Introduction

Un système entant que dispositif ou une mise en

commun d'un certain nombre d'éléments ayant une fonction bien

déterminée a besoin d'un fonctionnement général de

tout ce qui le constitue pour arriver à sa finalité.

Et pourtant le réseau informatique entant que

système est constitué des plusieurs éléments tant

physiques que logiques qui sont obligés de collaborer afin de permettre

une communication.

Il est aussi un vaste domaine dont la compréhension

doit partir d'un certain nombre des concepts de base.

I.2 Définition des concepts

de base

I.2.1 Le réseau

C'est un ensemble d'objets interconnectés les uns

avec les autres et permet de faire circuler les éléments entre

chacun de ces objets selon les règles bien définies3(*).

I.2.2 Le réseau

informatique

C'est un ensemble des ordinateurs ou autres

équipements interconnectés entre eux afin d'échanger les

informations.

I.2.3 La communication

C'est le processus de transmission d'informations. Elle

est l'action de communiquer, de transmettre les informations ou des

connaissances à quelqu'un ou, s'il y a échange, de le mettre en

commun.

I.2.4

Télécommunication

Ce mot vient de la préfixe grecque

télé, signifiant loin, et du latin communicare, signifiant

partagé.

C'est une science qui s'intéresse à la

transmission des signaux à distance au moyen des supports de

transmission4(*).

I.2.5 La

télémaintenance

Elle consiste à prendre le contrôle d'un

ordinateur distant, généralement celui d'un utilisateur en

difficulté via le réseau local ou l'internet, afin d'effectuer

à distance certaines opérations sur cet ordinateur.

I.3 Les différents types

des réseaux informatiques

On peut regrouper les types des réseaux

informatiques selon plusieurs paramètres ou découpages parmi

lesquels le découpage géographique, fonctionnement,...

I.3.1 Découpage

Géographique

Nous allons ici présenter différents types

des réseaux informatiques selon ce découpage dont la subdivision

a été rendue possible suivant leurs tailles, débit ou aire

géographique.

Il en existe plusieurs qui se résument en trois

grandes catégories

Le réseau LAN (Local Area Network)

Ce type de réseau est encore appelé le

réseau local d'entreprise (RLE) ; C'est un ensemble d'ordinateur et

équipements reliés les uns aux autres dans un même

bâtiment ou des bâtiments différents mais ayant une aire

géographiquement proche (généralement pas plus de 10Km).

Ce genre de réseau est local

Le réseau MAN (Metropolitan Area Network)

Celui-ci fait allusion à l'interconnexion des

réseaux locaux se trouvant dans une ville ou dans une même

région. On fera ici usage des lignes du réseau public ou

privé pour permettre la liaison entre les sites. Les utilisateurs se

trouvant à des endroits géographiques différents pourront

partager les ressources comme s'ils étaient dans un LAN

Le réseau WAN (Wide Area Network)

Il s'agit ici d'un ensemble des réseaux locaux

interconnectés les uns aux autres sur un étendu national ou

international. Comme le MAN, il utilise aussi les lignes du réseau

public ou privé pour établir l'interconnexion entre les

différents LAN. Il est aussi appelé réseau étendu.

Au delà de ces trois grands types de réseau

selon le découpage géographique on peut encore trouver d'autres

types.

Le réseau PAN (Personnal Area Network)

C'est un réseau personnel qui peut s'étendre

sur un rayon de quelques 1O mètres. Ici nous trouvons les technologies

comme le Bluetooth pour faire l'échange des fichiers textes,

vidéo et audio,... entre deux ordinateurs, deux téléphones

mobiles ou un téléphone et un ordinateur.

I.3.2 Découpage

fonctionnement

Le réseau Intranet

C'est un réseau informatique utilisant les services

du protocole TCP/IP pour assurer la communication. C'est-à-dire un

réseau dont la configuration se fait sur base du protocole TCP/IP.

Le réseau Extranet

Celui-ci est un réseau Intranet auquel on ajoute

une connexion externe comme l'Internet.

L'Internet

C'est le réseau public mondial utilisant le

protocole de communication IP rendant les services comme le courrier

électronique, l'échange des fichiers, la discussion à

distance accessible au public

I.4 Les topologies

réseaux

Il existe des différentes sortes des topologies

réseaux mais qui sont groupés selon deux grands

types ;

1.4.1 La topologie physique

Celle-ci indique la façon dont les

différents équipements sont reliés dans un

réseau.

Cette topologie est subdivisée en plusieurs autres

dont les trois premières et les plus connues sont : la topologie en

bus, en étoile et en anneau

La topologie en Bus

Cette topologie se repose généralement sur

un câble coaxial sur lequel viennent se connecter des noeuds grâce

à des prises qu'on appelle T-connecteur, les BNC puis les terminaux

ayant tous 50 ohms de résistance sur les deux extrémités

du câble appelé terminator. Ici les ordinateurs sont liés

à une même et seule ligne de transmission.

Fig. I.1. Topologie en bus

La topologie en étoile

Dans un réseau en étoile, les ordinateurs

sont reliés sur un point central qui peut être un concentrateur

(hub) ou un commutateur (Switch) possédant des ports RJ45 capables de

recevoir un câble à double paire torsadée pouvant assurer

la liaison entre un noeud et un point central et puis entre le point central et

les noeuds.

Fig. I.2. Topologie en

étoile

La topologie en anneau

Dans la topologie en anneau, les ordinateurs sont

reliés à un répartiteur appelé MAU qui va

gérer la communication entre les PC qui lui sont reliés en

impartissant à chacun d'eux un temps de parole. C'est-à-dire que

les ordinateurs communiquent chacun à son tour

Fig. I.3. Topologie en anneau

I.4.2 La topologie logique

Cette topologie nous indique la façon dont

les informations circulent ou sont transmises dans un réseau. Bref,

définit comment se passe la communication dans la topologie

physique5(*)

Le réseau Ethernet

Cette famille de réseau repose sur la

méthode d'accès multiple et écoute de la porteuse par

détection de collision appelé CSMA/CD6(*).

Cette architecture a plusieurs

caractéristiques parmi lesquelles nous pouvons citer : le

débit de 10 Mbits à 1 Gbits/s, la transmission en bande basse,

topologie en bus ou en étoile, support de type de câble coaxial,

paire torsadée ou fibre optique.

Le réseau Token ring

Ce type de réseau intervient dans

l'interconnexion de deux réseaux en anneau à travers des ponts

qui permettent de relier les différents réseaux venant des

topologies différentes ou des routeurs différents. Ici chaque

ordinateur intervient grâce à son jeton qui lui est

attribué et selon le principe qu'aucun jeton ne doit circuler deux fois

de suite avec le même niveau de priorité7(*).

I.5 Les méthodes

d'accès

Il existe plusieurs méthodes

d'accès qui permettent de réglementer la circulation des

données dans un réseau et partager les informations entre

ordinateurs du réseau

I.5.1 Méthode TDMA (Time

Division Multiplexing Access)

C'est une méthode selon laquelle le temps

est divisé en tranche attribué à chacun des noeuds

c'est-à-dire qu'une station peut émettre des messages pendant le

temps qui lui est attribué. Ici il n'existe pas des collisions.

I.5.2 CSMA/CD (Carrier Sense

Multiple Access with Collision Detect)

Elle est encore appelée la méthode

d'écoute de la porteuse. C'est la méthode la plus simple par sa

façon de fonctionner. Ici plusieurs stations peuvent tenter

simultanément d'accéder au port, si le réseau est

occupé la station va différer le message et dans le cas

contraire, il passe directement.

I.5.3 La méthode de

jeton

Cette méthode est souvent utilisée

dans la topologie en anneau et en bus. Le jeton a deux états

différents qui sont l'état libre et l'état

occupé

Elle consiste donc à ce que le jeton passe

devant une station et doit être mis en route munie d'une adresse et d'un

message qui doit parcourir toutes les stations qui jouent le rôle des

répétiteurs car ils génèrent le signal

capté.

I.6 Architectures

réseau

Une architecture d'un réseau est la

représentation structurelle et fonctionnelle d'un réseau

informatique. Il en existe deux types entre autre l'architecture poste à

poste et celle client-serveur

I.6.1 L'architecture poste

à poste

C'est un réseau qui ne nécessite pas

la présence d'un serveur dédié. Elle est constituée

de deux ou plusieurs ordinateurs interconnectés où chaque machine

est maître de ses ressources et peut être lui-même

considéré comme un serveur (non dédié)

Son avantage est qu'il a un coup réduit, une

simplicité et une rapidité d'installation

Il présente des failles comme la

sécurité très faible, la maintenance du réseau

difficile, manque de fiabilité,...

I.6.2 L'architecture

client-serveur

C'est une architecture dans laquelle nous avons un

poste central qui est un serveur qui gère le réseau avec toutes

ses ressources. Avec cette architecture nous avons une meilleure

sécurité et un accroissement d'interchangeabilité, une

unicité d'information, une meilleure fiabilité du

réseau.

Son seul inconvénient est qu'il est d'un

coup élevé côté bande passante,

câbles,...

I.7 Les Equipements d'un

réseau informatique

I.7.1 Ordinateur

C'est une machine automatique de traitement de

l'information permettant de conserver, d'élaborer et de restituer des

données sans intervention humaine en effectuant sous le contrôle

de programmes enregistrés des opérations arithmétiques et

logiques8(*).

Fig. I.4. Ordinateur

1.7.2 Serveur

C'est un ordinateur puissant choisit pour coordonner,

contrôler et gérer les ressources d'un réseau. Il accomplit

une opération sur demande d'un client et lui transmet le

résultat. Il est la partie de l'application qui offre un service, il

reste à l'écoute des requêtes du client et répond au

service demandé par lui9(*)

Fig. I.5. Serveur

I.7.2.A Type des serveurs

On distingue des serveurs dédiés et des

serveurs non dédiés

Le serveur dédié c'est un ordinateur

spécialisé qui ne peut pas exécuter des applications comme

client mais qui est optimisé pour répondre à des

requêtes. Il est conçu pour fonctionner spécialement comme

serveur.

Le serveur non dédié c'est un ordinateur

dans son environnement poste-à-poste qui peut à la fois

être utilisé comme client ou comme serveur.

I.7.2.B Caractéristiques des serveurs

Le serveur peut présenter plusieurs

caractéristiques internes qu'externes. Nous pouvons citer :

v Technologie de disque dur

spécifique ;

v Sécurisation des données en cas de crash

disk avec disques configurés en RAID ;

v Sauvegarde quotidienne des données par bande ou

disque dur externe ;

v Périphériques internes remplaçable

à chaud ;

I.7.2.C Fonction ou rôles d'un serveur

v Serveur de fichier : permet de distribuer les

fichiers aux clients qui les demandent

v Serveur de base des données : c'est un

serveur capable de traiter les requêtes des plusieurs ordinateurs clients

simultanément et permet aux utilisateurs de gérer une grande

quantité d'informations.

v Serveur d'impression : il travaille en accord avec

le serveur des fichiers en stockant localement les travaux d'impression en

attente.

v Serveur de messagerie : il centralise la gestion

des messages électroniques dans un réseau.

v Contrôleur de domaine : il centralise la

gestion des comptes utilisateurs dans un réseau.

v Serveur DHCP : il gère les adresses IP d'un

réseau.

1.7.3 Le concentrateur (Hub)

C'est un matériel du réseau qui permet la

connexion des plusieurs noeuds sur un même point d'accès en se

partageant la bande passante totale. Il est un simple répéteur

des données ne permettant pas la protection des données et

dépourvue de la confidentialité.

Il est caractérisé par la bande passante, le

nombre des ports, le débit, la tension qu'il utilise,...

Fig. I.6. Concentrateur (Hub)

I.7.4 Le commutateur

Un Switch ou commutateur est un dispositif

électronique permettant de créer un réseau informatique

local de type Ethernet.

Ce dispositif est dit intelligent par opposition au hub

car, alors que ce dernier fait transiter les données par toutes les

machines, le Switch permet de diriger les données uniquement vers la

machine destinataire en mémorisant les adresses MAC de chaque

hôte. Cette adresse est l'identifiant d'une carte réseau et est

représentée sur six octets en hexadécimal

Fig. I.7. Commutateur

I.7.5 Le routeur

C'est un équipement du réseau qui permet

d'effectuer le routage des paquets. Lorsqu'il reçoit un paquet, il

consulte sa table de routage pour choisir à partir de l'adresse de

destination, vers quelle interface et donc vers quel réseau il va

diriger le paquet pour le rapprocher de sa destination. Grâce au routeur

il ya une optimisation des transmissions entre réseaux ou

sous-réseaux.

I.7.6 La carte réseau

La carte réseau est aussi appelée NIC en

anglais, pour Network Interface Card. C'est le composant le plus important,

elle est indispensable car c'est par elle que transitent toutes les

données à envoyer et à recevoir du réseau dans un

ordinateur. Elle a un identifiant unique que lui attribue son fabriquant qui

est un adresse MAC et c'est grâce à cette dernière qu'un

ordinateur communique en réseau10(*).

I.7.7 Le modem

Le modem signifiant modulateur-démodulateur est un

équipement réseau qui transforme les données

numériques émises sur le port en données analogiques qui

peuvent être envoyées sur une ligne11(*).

I.8 Les supports de

transmission

Un support de transmission est un canal physique qui,

grâce à lui on peut faire circuler les informations dans un

réseau. Il en existe deux types : les supports limités ou

câblés et les supports non limités ou sans fils.

I.8.1 Les supports

limités

Ce sont des supports palpables qu'on peut voir, qu'on peut

toucher et qui conduisent un signal électrique ou lumineux.

Le câble coaxial

C'est un câble qui intervient pour connecter un

réseau informatique de topologie physique en bus ou pour connecter une

antenne et un modem. Il est constitué d'une partie centrale qui est un

fil de cuivre appelé âme enveloppé dans un isolant puis

d'un blindage métallique tressé et enfin d'une gaine qui permet

de protéger le câble de l'environnement extérieur.

Le câble à paire torsadée

Il est encore appelé câble à double

paire torsadée. Il décrit un modèle un modèle du

câblage où une ligne de transmission qui est constitué de

deux brins de cuivre entrelacés en torsade est recouverte d'isolants.

La configuration présente sert à maintenir

précisément la distance entre les fils qui permet à son

tour de définir une impédance caractéristique de la paire

afin de supprimer les réflexions des signaux aux raccords et en bout de

ligne.

Il existe deux types des câbles à paire

torsadée parmi lesquels nous avons les UTP qui sont dépourvue

d'un blindage protecteur et sont utilisés à l'intérieur du

bâtiment. Nous avons aussi les STP qui sont pourvu d'un e couche

conductrice de blindage pour permettre une meilleure protection contre les

interférences.

La fibre optique

C'est un support de transmission qui véhicule une

information en forme lumineuse. Il nécessite un émetteur et un

récepteur optique.

Ce support a plusieurs avantages parmi lesquels la vitesse

est élevée, bonne qualité de la transmission avec l'ordre

de 1Ghz pour 1km, très souple.

Son seul et unique inconvénient réside au

niveau de son déploiement. Il y a beaucoup de difficultés de

raccordement12(*).

Les faisceaux Hertziens

Ces genres de supports sont utilisés pour des

communications interurbaine et cela pour une portée de 50 à 100

Km.

Les faisceaux hertziens utilisent les antennes

d'émissions et de réception qui doivent être en

visibilité directe.

Pour une bonne connexion il faut placer une antenne

après chaque 50 à 60 Km13(*).

I.9 Les protocoles de

communication14(*)

La transmission d'une information d'un émetteur

vers un récepteur nécessite un ensemble des

éléments tant physique que logique qui sont d'un rôle

important pour l'organisation et la sécurité de ces

données. Ces données pour être transférées

doivent circuler dans des supports de transmission par le moyen de certaines

procédures ou certains protocoles qui font partie des

éléments logiques.

Un protocole est un ensemble de règles qui

définissent comment se produit une communication dans un

réseau15(*)

I.9.1 Le protocole TCP/IP

C'est une suite protocolaire signifiant Transmission

Control Protocol/Internet Protocol qui provient de noms des deux protocoles

majeures TCP et IP. Il présente la façon dont les ordinateurs

communiquent sur internet en se basant sur l'adressage IP.

A ses origines, le protocole TCP/IP a été

crée pour un but militaire et sa connaissance est nécessaire pour

les personnes désirant administrer ou maintenir un réseau

fonctionnant dans un système de TCP/IP.

La suite protocolaire TCP/IP assure des rôles en

commun qui peuvent être résumés de la façon

ci-dessous :

v Le transfert des fichiers

v La connexion interactive à distance

v La messagerie électronique

v Le système de fichiers répartis

v L'impression à distance

v L'exécution à distance

v Les serveurs des noms

v Les serveurs des terminaux

v Le système de fenêtrage orienté

réseau

Au-delà de ces rôles qu'ils assurent en

commun, chacun d'eux a ses rôles spécifiques dont en voici pour

chacun

Le protocole TCP

La transmission Control Protocol est un protocole fiable

de transmission en mode connecté qui assure les rôles particuliers

ci-dessous :

v L'établissement d'une connexion

v Le transfert des données

v Les numéros de séquence et

d'acquittement

v La temporisation

v Le contrôle des flux

v Le contrôle de congestion

v La terminaison d'une connexion

Le protocole IP

Internet Protocol est un protocole réseau qui

définit le mode d'échange élémentaire entre les

ordinateurs participants au réseau en leur donnant une adresse unique

sur le réseau.

Ce protocole a connu une évolution en deux versions

différentes :

Le protocole IPV4

C'est un protocole qui traite de l'adressage, du routage

des paquets, de la fragmentation puis du réassemblage des

paquets.

L'IPV4 est la première version d'IP à avoir

été largement déployée et forme encore la base de

l'internet. Il utilise une adresse IP sur 32bits reparties en 4champs de

8bits.

Un adressage IP codé sur 4 octets se

décompose en un numéro de réseau et un numéro de

noeud au sein de ce réseau afin de s'adapter aux différents

besoins des utilisateurs.

Il a la forme X.X.X.X où chaque X représente

8bits en notation décimale pointée de 0 à 255.

Il utilise cinq classes différentes : A, B, C,

D et E. seules les trois premières sont utilisées en

production.

v Classe A : varie entre 1 et 126 et a un masque

255.0.0.0

v Classe B : varie entre 128 et 191 et a un masque

255.255.0.0

v Classe C : varie entre 192 et 223 et a un masque

255.255.255.0

v Classe D : varie entre 224 et 239

v Classe E : varie entre 240 et 255

Le protocole IPV6

C'est le successeur du protocole IPV4. Il permet

d'utiliser un peu plus de 4 milliards d'adresses différentes pour

connecter les ordinateurs et les autres appareils reliés au

réseau. Il utilise à son tour une adresse IP longue de 128bits

répartis en 16 Octets.

Il abandonne la notation décimale pointée

employée pour les adresses IPV4 au profit d'une écriture

hexadécimale où les 8 groupes de 16 Octets sont

séparés par un signe de deux points :

X:X:X:X:X:X:X:X où chaque X représente 16

bits.

I.10 Le modèle de

référence OSI16(*)

Le modèle OSI (Open Systems Interconnection

: « interconnexion de systèmes ouverts ») est une

façon standardisée de segmenter en plusieurs blocs le processus

de communication entre deux entités. Chaque bloc résultant de

cette segmentation est appelé couche. Une couche est un ensemble de

services accomplissant un but précis. La beauté de cette

segmentation, c'est que chaque couche du modèle OSI communique avec la

couche au-dessus et au-dessous d'elle (on parle également de couches

adjacentes). La couche au-dessous pourvoit des services que la couche en cours

utilise, et la couche en cours pourvoit des services dont la couche au-dessus

d'elle aura besoin pour assurer son rôle.

Ainsi le modèle OSI permet de comprendre de

façon détaillée comment se passe la communication entre un

ordinateur A et un ordinateur B.

En effet, il se passe beaucoup de choses dans les

coulisses entre l'instant t, où on, a envoyé une

information et l'instant t1, où le destinataire le

reçoit.

Voilà pourquoi le modèle OSI a

segmenté la communication en 7 couches différentes qui

sont :

v Application

v Présentation

v Session

v Transport

v Réseau

v Liaison des données

v Physique

Expliquons comment fonctionnent ces différentes

couches lorsqu'on veut par exemple envoyer un mail à son

ami :

g. Couche applicative

Vous avez besoin d'accéder aux services

réseaux. La couche applicative fait office d'interface pour vous donner

accès à ces services, qui vous permettent notamment de

transférer des fichiers, de rédiger un mail, d'établir une

session à distance, de

visualiser une page web... Plusieurs protocoles assurent

ces services, dont FTP (pour le transfert des fichiers), Telnet (pour

l'établissement des sessions à distance), SMTP (pour l'envoi d'un

mail), etc.

f. Couche présentation

Elle s'occupe de la sémantique, de la syntaxe, du

cryptage/décryptage, bref, de tout aspect « visuel » de

l'information. Un des services de cette couche, entre autres : la conversion

d'un fichier codé en EBCDIC vers un fichier codé en ASCII.

Certains protocoles, tels que le HTTP, rendent la distinction entre la couche

applicative et la couche de présentation.

e. Couche session

Une fois que vous êtes prêt(e) à

envoyer le mail, il faut établir une session entre les applications qui

doivent communiquer. La couche session du modèle OSI vous permet

principalement d'ouvrir une session, de la gérer et de la clore. La

demande d'ouverture d'une session peut échouer. Si la session est

terminée, la « reconnexion » s'effectuera dans cette

couche.

d. Couche transport

Une fois la session établie, le mail doit

être envoyé. La couche de transport se charge de

préparer le mail à l'envoi. Le nom de cette

couche peut prêter à confusion : elle n'est pas responsable du

transport des données proprement dit, mais elle y contribue.

En fait, ce sont les quatre dernières couches

(transport, réseau, liaison de données et physique) qui toutes

ensemble réalisent le transport des données. Cependant, chaque

couche se spécialise. La couche de transport divise les données

en plusieurs segments (ou séquences) et les réunit dans la couche

transport de l'hôte récepteur. Cette couche permet de choisir, en

fonction des contraintes de communication, la meilleure façon d'envoyer

une information.

La couche de transport modifie également

l'en-tête des données en y ajoutant plusieurs informations, parmi

lesquelles les numéros de ports de la source et de la destination. Le

protocole TCP (Transmission Control Protocol) est le plus

utilisé dans la couche de transport.

c. Couche réseau

Maintenant que nous savons quel numéro de port

utiliser, il faut aussi préciser l'adresse IP du récepteur. La

couche réseau se charge du routage des données du point A au

point B et de l'adressage. Ici aussi, l'en-tête subit une modification.

Il comprend désormais l'en-tête ajouté par la couche de

transport, l'adresse IP source et l'adresse IP du destinataire. Se fait

également dans cette couche le choix du mode de transport (mode

connecté ou non connecté). Le protocole le plus utilisé

à ce niveau est bien sûr le protocole IP.

b. La couche liaison

Ici on doit s'assurer si certaines opérations sont

déjà effectuées entre autre :

Présentation effectuée ? O.K.

Session établie ? O.K.

Transport en cours ? O.K.

Adresses IP précisées ? O.K.

Il reste maintenant à établir une liaison

« physique » entre les deux hôtes. Là où la

couche réseau effectue une liaison logique, la couche de liaison

effectue une liaison de données physique.

Elle fragmente les données en plusieurs trames, qui

sont envoyées une par une dans un réseau local

a. La couche physique

Notre mail est en cours de transport, mettons-le sur le

média. La couche physique reçoit les trames de la couche de

liaison des données et les « convertit » en une succession de

bits qui sont ensuite mis sur le média pour l'envoi. Cette couche se

charge donc de la transmission des signaux électriques ou optiques entre

les hôtes en communication.

CONCLUSION PARTIELLE

En guise de cette partielle conclusion, nous avons

présenté dans le présent chapitre quelques notions de base

sur les réseaux informatiques où nous avons parlé des

différents équipements qui doivent être utilisés

suivant certaines topologies et avons expliqué par un bref exemple

comment une information envoyée sur un réseau passe les

différentes couches du modèle OSI avant d'arriver à

destination.

CHAPITRE II : PRESENTATION DU

CLUSTER D'EQUILIBRAGE DE CHARGE RESEAU

II.1 Idée

générale sur le cluster

II.1.1 Définition

Un cluster est un ensemble des serveurs

indépendants qui fonctionnent ensemble pour augmenter la

disponibilité de services et d'applications sur un réseau

informatique17(*)

Les services notamment sur internet nécessitent une

montée équivalente au nombre grandissant d'utilisateurs leur

faisant appel. Pour assurer cette montée et garantir une

disponibilité de ces services, plusieurs méthodes étaient

envisageables entre autre la mise jour de l'architecture matérielle

afin d'augmenter la puissance de traitement de la machine, l'augmentation du

nombre d'ordinateurs exécutant le service en utilisant un processus

permettant l'équilibrage de la charge de travail. Aujourd'hui plusieurs

technologies sont venues pour faciliter cela, rendant ainsi ces services

disponibles parmi lesquelles nous pouvons citer la répartition de charge

réseau (Network Load Balancing), le basculement automatiques des

requêtes entre les noeuds d'une même grappe, qui sont des

éléments importants lors de la mise en place des services

amenés à croître.

La recherche dans ce domaine est trop poussée avec

un marché représentant le 3 ou 4% de la vente des serveurs ces

dernières années permettant ainsi de satisfaire les

énormes besoins de performances, d'évolutivité et de

disponibilité.

Dans cette partie nous allons présenter de

façon générale les notions sur la solution du clustering

Network Load Balancing.

II.1.2 Historique18(*)

Les clusters sont apparus au moment de l'explosion du prix

des supercalculateurs alors que les microprocesseurs devenaient de ^plus en

plus rapides et de moins en moins chers. A partir de la fin des années

80, les ingénieurs ont commencés à développer ce

qu'ils appelaient alors un « multi-ordinateur »

En 1987, l'université du Mississipi a

commencé à travailler sur les clusters basés sur le Sun

4/110.

C'est toute fois le projet Beowulf2 (l'utilisation d'un

système d'exploitation Linux sur des PC communs) qui a

véritablement lancé l'intérêt pour les clusters, ces

grappes d'ordinateurs qui fournissent en commun un travail de calcul en

parallèle sur un seul problème complexe. Le cout et la

modularité d'un cluster rendant les opérations de calcul moins

onéreuses qu'un superordinateur.

II.2 Le Cluster Network Load

Balancing

Un cluster network Load Balancing dit cluster

d'équilibrage de charge réseau est un ensemble des machines

physiques travaillant en collaboration ou, à minima, échangeant

des informations sur leurs propres fonctionnement19(*).

C'est donc un ensemble des noeuds (serveurs physiques)

participant dans le même cluster. L'ensemble de ces serveurs physiques

indépendants fonctionnant comme un seul système est ce qu'on

appelle une grappe des serveurs.

Le client communique avec cette grappe comme s'il

s'agissait d'une machine unique.

Dans sa forme la plus simple, un cluster est un ensemble

de deux ordinateurs ou plus, appelés noeuds ou

« node » en anglais, qui travaillent ensemble pour fournir

un service.

Et donc la disponibilité d'un serveur est sa

capacité à fournir un service en tout temps, sous toutes

conditions, de l'ordre de 99,99%.

Nous comprendrons aisément qu'il est impossible

d'obtenir une disponibilité de 100%, personne n'étant à

l'abri d'une machine incroyable. Or l'informatique occupant une place

très importante au sein d'une structure d'entreprise ou d'autre

entité organisationnelle, les ordinateurs sont des maillons importants,

voire obligatoire dans leur système de production mais aussi un maillon

très fragile car une panne matérielle, logicielle ou

réseau peut survenir à tout instant et souvent, de manière

invisible.

II.2.1 Avantages et

inconvénients

En gérant mieux la charge des requêtes

arrivant sur les ressources à disposition, il est possible d'augmenter

la satisfaction des clients du système. Le Load Balancing est donc un

moyen économique d'augmenter les performances d'un système

informatique. En conséquence, le Load Balancing augmente la satisfaction

des requêtes et la consommation des ressources informatiques (il n'est

plus nécessaire d'investir dans les ressources supplémentaires

qui ne seront utilisées que 10% de temps).

L'avantage du Load Balancing par rapport à une

augmentation pure et dure des ressources informatiques apparait donc

évident.

Ce pendant, le Load Balancing est assez récent et

se développe très vite. Pour un novice en informatique, il est

difficile d'y prendre part et de comprendre toutes les implications rapidement

car les moyens de Load Balancing restent particulièrement centrés

sur des grosses entreprises disposant des services informatiques pour

gérer leur propre réseau.

a. Avantages

Le cluster d'équilibrage de charge réseau a

comme avantage :

v Augmenter la disponibilité des ressources sur le

cluster

Celles-ci sont garanties disponibles à 99,9% du

temps. Dans le cas où l'un des noeuds du cluster ne pourrait plus

fournir des réponses aux requêtes des clients, alors les autres

noeuds du cluster prennent le relai. Ainsi, la communication avec les clients

et l'application hébergée ou autres ressources sur le cluster ne

subit pas d'interruption ou une très courte interruption.

v Faciliter l'évolutivité

Lorsque la charge totale excède les

capacités des systèmes du cluster, d'autres systèmes

peuvent lui être ajoutés. En architecture multiprocesseur, pour

étendre les capacités du système il faut dès le

départ opter pour des serveurs haut de gamme couteux autorisant l'ajout

d'autres processeurs, des lecteurs et la mémoire

supplémentaire.

v Faciliter l'adaptabilité

Il est possible d'ajouter un à plusieurs noeuds ou

d'ajouter des ressources physiques (disques, processeurs, mémoires

vives) à un noeud du cluster. En effet, il est possible que de part les

trop nombreuses requêtes sur les serveurs que celui-ci soit en saturation

au niveau de la charge processeur, mémoire ou autre, dans quel cas il

est nécessaire d'ajouter des éléments, voire un autre

noeud.

v Faciliter la gestion du processeur, mémoire vive,

disque dur, bande passante réseau.

b. Inconvénients

Le cluster NLB, entant que tout système nous

présente des inconvénients qui sont les suivants :

v Cout élevé ;

v Déploiement technique complexe ;

v Cout de maintenance élevé ;

v Ne prend pas en compte l'utilisation des ressources pour

effectuer l'équilibrage de charge ;

v Les serveurs peuvent posséder une charge

inégale ;

v En cas de panne d'un serveur lors du traitement d'une

requête, il n'y a pas de transfert des requêtes vers d'autres

serveurs.

II.2.2 Architecture

II.2.2.A Sans répartiteur

La méthode la plus simple d'opérer une

répartition de charge consiste à dédier des serveurs

à des groupes des clients prédéfinis. Si cette

méthode est simple à mettre en oeuvre pour un intranet, elle est

très complexe, voire impossible pour des serveurs internet.

Dans ce cas, un paramétrage spécifique du

DNS (Domain Name Server) au niveau réseau et/ou l'optimisation

applicative (Niveau 7) sont un premier pas vers une démarche de

répartition de charge sans répartiteur.

Dans la majorité des cas, la méthode du

DNS en rotation (round robin) est un bon début en

matière de répartition de charge. Pour un même nom de

serveur particulier, le serveur DNS dispose de plusieurs adresses IP de

serveurs, qu'il présente à tour de rôle aux clients, dans

un ordre cyclique.

Pour l'utilisateur, cette méthode est totalement

transparente car il ne verra que l'adresse du site. On utilise

généralement la répartition par DNS pour les moteurs de

recherche, des serveurs POP (messagerie) ou des sites proposant des contenus

statique.

Sans répartiteur, il est donc possible d'engager

une démarche de répartition de charge. Néanmoins, les

méthodes décrites ci-dessus ne fournissent aucun contrôle

de la disponibilité et exigent donc des moyens additionnels pour tester

en permanence l'Etat des serveurs et basculer le trafic d'un serveur

surchargé vers un autre, le cas échéant.

Ces méthodes ne constituent donc pas une solution

de répartition de charge principale mais conservent leur

intérêt et restent complémentaires à la mise en

place d'un répartiteur.

II.2.2.B Avec répartiteur de charge (Load

Balancing)

Le répartiteur de charge ou Load Balancer est la

couche supplémentaire qui permet d'optimiser et de réguler le

trafic, tout en soulageant les serveurs, en répartissant la charge selon

les algorithmes prédéfinis (niveau 3, 4 et 7) et/ou selon des

fonctions intelligentes capables de tenir compte du contenu de chaque

requête (Niveau 7)20(*).

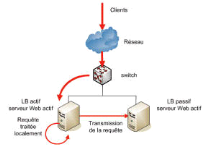

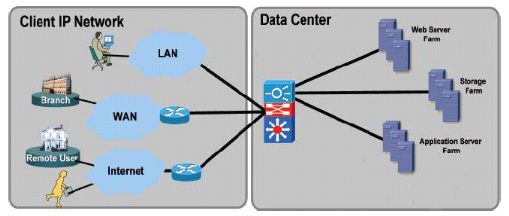

Fig. II.1 Load Balancing

Le répartiteur peut être un routeur, un

Switch, un système d'exploitation ou un logiciel applicatif.

Il repartit les demandes en les distribuant

automatiquement aux serveurs disponibles. Le destinataire des demandes peut

également être imposé. Le répartiteur simule la

présence d'un serveur : les clients communiquent avec le

répartiteur comme s'il s'agissait d'un serveur21(*). Celui-ci repartit les

demandes provenant des clients, les transmets aux différents serveurs.

Lorsqu'un serveur répond à une demande, celle-ci est transmise au

répartiteur ; puis le répartiteur transmet la réponse

au client en modifiant l'adresse IP de l'expéditeur pour faire comme si

cette réponse provenait du serveur.

La répartition de charge de niveau 3 / 4

Celle-ci consiste à travailler sur les paquets

réseaux en agissant sur leur routage (TCP/IP). Le répartiteur de

niveau 3 / 4 intervient donc à l'ouverture de la connexion TCP puis

aiguille les paquets en fonction des algorithmes retenus, selon 3

méthodes :

v Le routage direct

Avec cette méthode, le répartiteur distribue

les cartes. Elles se chargent de repartir les requêtes sur une même

adresse entre les serveurs locaux. Les serveurs répondent ensuite

directement aux clients

On parle alors de DSR (Direct Server return) ; retour

direct du serveur en français.

Simple à mettre en oeuvre car ne nécessitant

aucune modification au niveau IP, cette méthode requiert des solides

compétences du modèle TCP/IP pour obtenir une configuration

correcte et optimale. Elle implique en outre la proximité des serveurs,

qui doivent se trouver sur le même segment réseau que le

répartiteur.

v Le tunneling

Le tunneling est une évolution du routage direct

qui permet de s'amender de la problématique de proximité des

serveurs grâce à la mise en place des tunnels entre des serveurs

distants et le répartiteur.

v La translation d'adresses IP

Dans ce cas, le répartiteur centralise tous les

flux : les requêtes (comme dans le cas du routage direct) sont

reparties entre les serveurs mais aussi les réponses. Il masque ainsi

l'ensemble de la ferme de serveurs, qui ne nécessitent aucun

paramétrage particulier.

En revanche, cette méthode implique une

configuration applicative très stricte afin notamment que les serveurs

évitent de retourner leurs adresses internes dans les

réponses.

En outre, cette méthode augmente

considérablement la charge du répartiteur qui doit convertir les

adresses dans les deux sens, maintenir lui-même une table des sessions et

supporter la charge du trafic retour22(*).

La répartition de charge de niveau 7

(Applicatif)

En s'attaquant à la couche applicative, le

répartiteur de charge ne se contente pas plus d'aiguiller aveuglement

les requêtes. Il analyse le contenu de chaque requête HTTP, RDP ou

autre pour décider du routage.

Le reverse proxy

Dans son rôle de transmission du trafic, le

répartiteur de niveau 7 agit comme un reverse proxy et prétend

être serveur. Il a alors pour rôle d'accepter les connexions

à destination du client et d'établir des connexions avec les

serveurs pour faire transiter les données (requêtes et

réponses).

Cette méthode implique que les serveurs ne

puissent pas être joints directement par les utilisateurs et

nécessite aucune configuration particulière côté

serveur.

Dans ce cas, le répartiteur de niveau 7

nécessite plus de puissance que les solutions matérielles

agissant au niveau du réseau.

Ils fournissent cependant un premier niveau de

sécurité en ne transmettant au serveur que ce qu'ils

comprennent.

v Le reverse proxy transparent

Parfois, la répartition de charge de niveau 7 peut

se heurter à des contraintes d'intégration des serveurs

(surveillance des logs ou pare-feu de niveau 3 / 4) ou de protocole

FTP.

Dans ce cas, le répartiteur peut simuler l'adresse

IP du client en source des connexions qu'il établit vers les serveurs.

On parle alors du reverse proxy transparent.

Nécessitant un mode coupure, le reverse proxy

transparent implique que les serveurs soient non seulement

configurés pour joindre les clients à travers le Load Balancer,

mais aussi se trouver sur un segment réseau différent des

clients.

II.3 Fonctionnement23(*)

II.3.1 Fonctionnalités de

la répartition de la charge réseau

La répartition de charge réseau fonctionne

en trois modes différents de répartition :

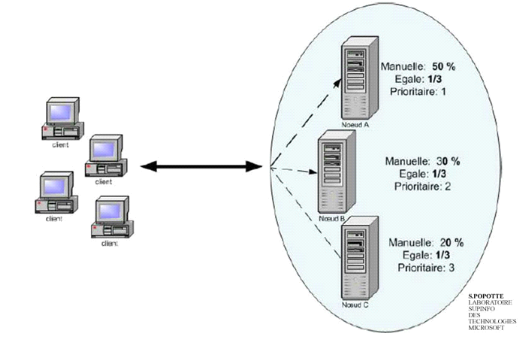

La répartition manuelle

Elle permet de répartir le poids pour chaque noeud

du cluster basé sur un poids de charge. Si trois serveurs sont

configurés avec le poids 50, 30 et 20 ; le premier va recevoir la

moitié des requêtes, le second 30% et le dernier 20%.

La répartition égale

Elle permet de répartir de façon

égale les requêtes sur l'ensemble des serveurs composant le

cluster. S'il y a trois serveurs dans la ferme du cluster, chacun recevra 33%

des requêtes.

La répartition prioritaire

Elle permet de mettre en place la notion de

tolérance de panne en spécifiant un serveur prioritaire.

L'ensemble du trafic est tout d'abord acheminé sur l'hôte ayant la

priorité 1. Si celui-ci tombe en panne, l'ensemble du trafic sera

envoyé au serveur de priorité 2 et ainsi de suite.

Fig. II.2 Répartition prioritaire de

charge

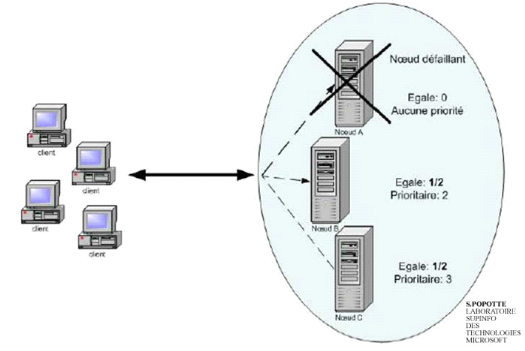

Lorsqu'un serveur membre de la ferme du cluster tombe en

panne, le cluster passe en mode de convergence pendant lequel une

élection est effectuée afin de repartir selon les règles

de la configuration de répartition de charge réseau. Pendant ce

temps les clients en communication avec le serveur en panne n'accèdent

pas aux services jusqu'au moment où la convergence est terminée.

Ce qui permet de repartir ces clients sur les autres serveurs.

Dans le cadre d'une répartition égale entre

trois serveurs, les requêtes sont reparties à 33% sur chacun des

serveurs. Si l'un des serveurs tombe en panne, la convergence démarre et

la répartition se fait à 50% sur les deux serveurs.

Fig. II.3 Convergence en cas de panne

serveur

Lors de la montée en charge d'un serveur pour un

service web, un service VPN ou autre... il est intéressant d'envisager

une solution adoptant la technologie de répartition de charge

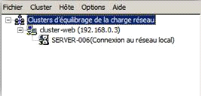

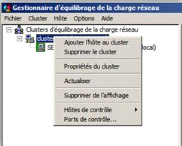

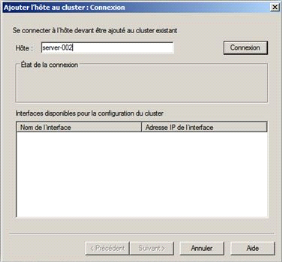

réseau. Le mode NLB proposé par Microsoft permet

l'intégration de 32 noeuds au sein d'un même cluster, l'ensemble

de ces noeuds pourront répondre aux requêtes

simultanément.

Prenons un exemple simple et très

utilisé : vous avez un cluster NLB composé des plusieurs

noeuds, ces derniers sont des serveurs web (Windows server avec IIS) ayant pour

but de fournir une infrastructure web. Ils contiennent tous en local une copie

identique de préférence du site web que vous hébergez et

se connectent à un serveur de base des données externe au cluster

pour le stockage des données.

Les connexions clientes seront alors reparties entre les

différents serveurs web afin de répondre aux différents

pics de charge.

Cependant, cette mise en place peut s'avérer plus

complexe dans certains cas notamment avec l'utilisation des sessions ou encore

la gestion du panier sur le site e-commerce où ces informations

précieuses ne doivent pas être perdues en cas de panne du serveur

web qui traitait la demande. Il est judicieux de stocker ces informations

également en externe des serveurs web.

Par défaut, chaque noeud d'un cluster informe ses

partenaires de sa présence au travers d'un Heartbeat (battement du

coeur). Ce Heartbeat est envoyé sous forme de broadcast après

chaque 5 secondes.

Le cluster a une vision précise de quels noeuds

sont des membres valides à un instant t.

Lorsqu'une application devient indisponible, soit parce

que c'est elle-même qui a un problème, soit parce que c'est le

noeud qui l'héberge qui a un problème, l'application peut,

automatiquement être déplacée vers un noeud disponible. Il

est évidemment plus rapide de basculer une application de cette

façon que de restaurer un serveur depuis une ou plusieurs bandes de

sauvegarde.

Dans ce mode de fonctionnement, on passe sur

« actif/passif » et ou dans ce mode tous

les noeuds sont sollicités continuellement de façon

répartie. Attention, répartie ne veut pas dire équitable,

car cela dépend de la configuration que vous effectuez sur le

cluster.

Ce qui est sûr c'est que tous vos noeuds doivent

être opérationnels, car ils sont susceptibles d'être mis en

contribution à tout moment.

Le service d'équilibrage de charge réseau

(NLB) augmente la disponibilité et l'évolution des applications

serveurs Internet, telles que celles utilisées sur les serveurs web,

FTP, pare-feu, proxy, VPN et d'autres serveurs stratégiques.

Un ordinateur unique exécutant Windows offre une

fiabilité des serveurs et une évolutivité des performances

limitées

Toute fois, en associant les ressources d'au moins deux

ordinateurs exécutant l'un des produits de la famille Windows server

dans un seul cluster, l'équilibrage de la charge réseau est

à même de garantir la fiabilité et les performances dont

les serveurs web et autres serveurs stratégiques ont besoin.

Chaque hôte exécute des copies

séparées des applications serveurs souhaitées, telles que

des applications serveur web, FTP et Telnet. L'équilibrage de charge

réseau distribue les requêtes client entrantes sur les hôtes

dans le cluster.

Le poids de charge devant être traité par

chaque hôte peut être configuré le cas

échéant. Vous pouvez aussi ajouter des hôtes au cluster de

façon dynamique afin de gérer l'augmentation de la charge de

travail. En outre, l'équilibrage de la charge réseau peut

diriger tout le trafic vers un hôte unique désigné,

appelé l'hôte par défaut.

L'équilibrage de la charge réseau permet

à tous les ordinateurs du cluster d'être adressés via le

même ensemble d'adresses IP du cluster (mais il préserve

également leurs adresses IP dédiés uniques.

Pour les applications faisant objet de

l'équilibrage de charge lorsqu'un hôte présente une

défaillance ou est mis en mode hors connexion, la charge est

automatiquement redistribuée parmi les ordinateurs en état de

fonctionnement.

Les applications s'exécutant sur un seul serveur

voient leur trafic redirigé vers un hôte spécifique.

Lorsqu'un ordinateur est en défaillance ou est mis en mode hors

connexion, les connexions actives au serveur défaillant ou hors

connexions sont perdues.

Cependant, si vous mettez un hôte hors service

intentionnellement, vous pouvez utiliser la commande drainstop pour

gérer toutes les connexions avant de mettre l'ordinateur hors

connexion. Dans les deux cas, lorsque l'ordinateur hors connexion est

prêt, il peut en toute transparence rejoindre le cluster et gérer

à nouveau sa part de la charge de travail.

II.4 Les modes

d'opérations, de filtrage et d'affinité du cluster24(*)

II.4.1 Modes

d'opérations

Trois modes d'opération du cluster sont

disponibles : monodiffusion, multidiffusion et multidiffusion IGMP

Monodiffusion (Unicast)

Ce mode attribue une adresse MAC unique à

l'ensemble des noeuds du cluster. Ce pendant cela pose problème au

niveau de Switch puis que par définition un Switch attribue une adresse

MAC par port. Il ne peut pas enregistrer deux fois la même adresse

MAC.

Ce problème de diffusion obligera le Switch

à flooder l'ensemble des ports pour savoir réellement à

qui appartient cette adresse. Cela fonctionnera mais va générer

une quantité de trafic importante. Une solution annexe mais ne faisant

pas partie des bonnes pratiques, consiste à placer un hub entre le

Switch et les noeuds du cluster, comme ça l'adresse MAC sera

enregistrée uniquement sur un port du Switch et le trafic

redistribué à l'ensemble des noeuds grâce au hub.

Multidiffusion (Multicast)

Ce mode règle les problèmes liés

à l'unicité de l'adresse MAC lorsqu'un de type multidiffusion est

utilisé, tout en empêchant les équipements réseaux

de mémoriser l'adresse MAC du cluster.

Par contre, ce mode ne résout pas le

problème de flooding sur le port du Switch.

Certains commutateurs peuvent être configurés

partiellement en hub, ce qui permet d'indiquer à l'équipement de

transférer systématiquement les paquets pour l'adresse MAC du

cluster au port où sont connectés les noeuds.

Multidiffusion IGMP

Ce mode reprend le comportement du mode

précédent sauf que l'on ajoute l'utilisation de l'IGMP (Internet

Group Management Protocol) de ce fait, les noeuds du cluster s'enregistrent

avec une adresse IP de classe D. avec ce mode le problème de flooding

n'existe plus.

Pour rappel, la classe D contient les adresses IP de

224.0.0.0 à 239.0.0.0 et est réservée uniquement aux

communications multicast25(*).

II.4.2 Modes de filtrage

Le choix du mode de filtrage permet de définir le

mode de fonctionnement du cluster au niveau des flux réseaux.

Hôtes multiples

Ce mode est plus intéressant et permet une

véritable répartition de charge entre les noeuds du cluster. En

effet, il est de type actif/actif donc plusieurs noeuds travaillent

simultanément pour se répartir la charge.

Hôte Unique

Ce mode est de type actif/passif et va à l'encontre

de la répartition des charges. Le noeud avec le plus petit ID sera actif

et sera le seul à recevoir le flux réseau.

Aucun

Ce mode de filtrage permet de bloquer le trafic sur

certains ports définis. Intéressant pour protéger les

noeuds du cluster

II.5 Le modes

d'affinités

Lorsqu'on choisit le mode de filtrage `hôte

multiple' afin de faire de la véritable répartition de charge, on

aura le choix entre trois modes d'affinités : Aucun, Unique et

Réseau.

II.5.1 Aucune

Ce mode assure la meilleure répartition de charge

puisqu'à chaque connexion TCP d'un même client, cette

dernière sera redirigée vers le noeud ayant les moins des clients

à l'instant t.

Tout de même, si ce mécanisme

d'affinité est utilisé sur un site comprenant une gestion des

sessions voir même des paniers cela pourrait poser problèmes. Il

vaut mieux garder le client sur l'intégralité de sa

connexion.

II.5.2 Unique

Ce mode maintien le client sur un même noeud par

rapport à son adresse IP, tant que la topologie du cluster n'est pas

modifiée. C'est-à-dire tant qu'il y a pas d'ajout ou de

suppression de noeud.

Si les clients arrivent tous avec une adresse IP

derrière le NAT ou un proxy, la répartition ne sera pas

équitable. Il est important que chaque client arrive avec sa propre

adresse IP pour assurer une meilleure répartition.

II.5.3 Réseau

Plutôt que de répartir les clients par

rapport à leurs adresses IP, la répartition est effectuée

par rapport au réseau. Par exemple, tous les clients du réseau

192.168.1.0/24 iront sur un noeud et tous ceux du réseau 192.168.2.0/24

sur un autre noeud.

Cette méthode peut s'avérer utile et

pertinente lorsqu'il s'agit de l'utilisation des plusieurs sous-réseaux,

sinon un seul noeud recevra toute la charge. Ce qui n'est pas le but du

clustering.

II.6 Les caractéristiques

du Network Load Balancing26(*)

Le network Load Balancing doit répondre à

des certaines caractéristiques qui sont :

v Support de TCP/IP;

v Répartition de charge ;

v Haute disponibilité ;

v Mise à l'échelle ;

v Administration distante.

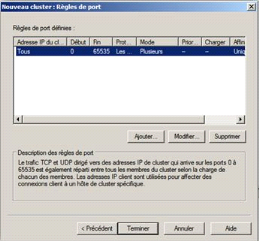

II.7 Les règles de ports

de l'équilibrage de la charge réseau

L'équilibrage de la charge réseau va

être défini grâce à la création de la

règle de port qui va permettre de spécifier les

propriétés de répartition selon les critères

suivants : numéro de port et protocoles (TCP et UDP)

concernés par la règle, le mode d'équilibrage de charge

(hôte multiple, hôte unique, désactiver les ports) et

l'ensemble des paramètres propre au mode

sélectionné27(*).

II.8 Autres logiciels de Load

Balancing

v Nginx :

réalise le Load Balancing en proxy inverse et s'est

démarqué par ses grandes performances (meilleures que celle

d'Apache) à partir de peu des ressources. Nginx est très flexible

puisqu'il prend en charge des nombreux protocoles comme HTTP, HTTPS, IMAP,

SMTP,... ce qui n'est pas le cas des toutes les solutions proposées.

Pour autant, Nginx n'est pas le plus facile des softwares de Load Balancing

à prendre en main. La difficulté de création des modules

sous Nginx Load Balancing a été des nombreuses fois

soulignée.

v HA Proxy :

C'est la solution d'équilibrage de charge la plus

discrète et la plus légère, ce logiciel convient bien pour

les petites applications qui utilisent de préférence l'algorithme

de répartition en fonction du nombre de connexion.

v Varnish :

est pratique et se distingue parce qu'il est formé

d'un plugin. Conçu spécifiquement pour fonctionner en tant que

proxy inverse (au contraire de Nginx), Varnish est particulièrement

adapté pour les sites à données massives où les

utilisateurs ont tendance à revenir. En effet, il évite que les

utilisateurs qui aient déjà visités la page n'aient

à la retélécharger et donc à utiliser les

ressources des serveurs du site. Néanmoins, Varnish ne gère que

le protocole http, ce qui peut fortement bloquer l'utilisation pour certaines

applications.

Microsoft a implémenté à part la

technologie du clustering à équilibrage de charge, deux autres

technologies de clustering.

v Le cluster Scientifique qui est la technologie qui

intervient au niveau du stockage des informations.

v Le cluster MSCS, dit failover cluster en anglais. Cette

technologie est en français, Cluster de basculement. Il résous le

plus grand problème qui s'observe au niveau du cluster

d'équilibrage de charge réseau. Là, lorsqu'il y a un

serveur qui tombe en panne pendant qu'il traitait des requêtes, ces

dernières se perdent toutes. Mais avec cette technologie du failover

clustering, lorsque ce serveur tombe en panne, toutes les requêtes qui

étaient en train d'être traitées seront automatiquement

basculées sur un autre serveur qui fonctionne et cela c'est grâce

à un disque dit de quorum qui est placé entre les serveurs de la

grappe et qui garde les informations à échanger entre les

serveurs.

Une autre architecture qui est le CLB, est souvent

couplée à l'architecture de cluster NLB, dans le cas de serveur

WEB basé sur le commerce e-électronique.

CONCLUSION PARTIELLE

Nous avons passé en revue dans ce chapitre les

notions générales sur le cluster d'équilibrage de charge

réseau qui permet d'assurer une haute disponibilité de

façon efficace avec une possibilité d'assurer en permanence une

bonne gestion et répartition de la charge réseau ainsi que la

haute disponibilité des applications.

CHAPITRE III.

PRESENTATION DE L'ENTREPRISE

III.0 Introduction

Tout travail de fin de cycle

parlant sur les réseaux informatiques comme celui-ci doit porter soit

sur une étude ou une mise en place. Ce dernier s'appliquant dans un

milieu professionnel donné, il nous sera alors question de

présenter ici l'institution au sein de laquelle nous avons

effectué nos recherches qui est l'office congolais de contrôle,

O.C.C en sigle.

III.1 Cadre juridique et nature de l'O.C.C

L'office congolais de contrôle est un organisme

public à caractère technique et scientifique depuis le

décret n° 09/42 du 03 décembre 2009 fixant les statuts d'un

établissement public à caractère scientifique et technique

dénommé Office Congolais de Contrôle

« O.C.C. » en sigle. Doté de la personnalité

juridique et placé sous la tutelle du Ministère du commerce, il a

été créé par l'ordonnance-loi n° 74/ 013/ du

13 janvier 1974.

Ainsi donc, les différents textes de base

régissant ses activités sont :

a) L'Ordonnance-Loi

n° 74/013 du 10 janvier 1974 portant création de

l'OZAC ;

b) La Loi n°73/009 du 05 janvier

1973 particulière sur le commerce telle que modifiée et

complétée par la Loi n°74/014 du 10 janvier

1974 ;

c) L'Ordonnance-Loi n°74/219 du 05

mai 1978 portant statut de l'O.C.C ;

d) Le décret- loi n°09/42 du

03 décembre 2009 fixant les statuts d'un établissement public

à caractère scientifique et technique O.C.C.

Entant qu'organisme tierce partie, impartial et dont la

structure, le personnel, la compétence et l'intégrité

permettent d'accomplir son rôle d'arbitre selon des critères

définis, l'Office Congolais de Contrôle est un organisme

d'évaluation de la conformité : il est membre correspondant de

l'Organisation Internationale de la Normalisation ``ISO''

membre du programme des pays affiliés à la Commission

Electrotechnique Internationale ``CEI'' et membre de

l'Organisation Régionale Africaine de la Normalisation

« ORAN » 28(*).

III.2 Brève historique

L'historique de l'OCC date de l'époque coloniale.

En effet, il existait une société à statut privé,

de droit suisse, dénommée `' Société

Générale de Surveillance'' SGS qui, créée en 1919

et dont les attributions étaient quasi-semblables à celles de

l'actuel OCC, avait son siège social à Genève.

C'est en 1949 que la SGS implante une filiale au Congo sous la dénomination de

Société Congolaise de Surveillance (SCS) dont les principales

activités furent:

v Assurer le contrôle de la qualité et de la

quantité des produits du sol ;

v Assurer le constat d'avaries ;

v Assurer la gestion des silos de Kinshasa ;

v Effectuer le contrôle des importations à

destination du Congo.

Cependant, quelques temps après

l'indépendance du pays, la décision du Bureau Politique du

Mouvement Populaire de la Révolution (M.P.R.) du 27 octobre 1971 portant

changement du nom du Congo à celui du Zaïre, la S.C.S. devint la

Société Zaïroise de Surveillance (S.Z.S.) et poursuivit

toujours ses activités en tant que filiale de la S.G.S. Mais qui sera

dissoute à la suite des mesures économiques du 30 novembre 1973

et qui donnera naissance à l'office Zaïrois de contrôle en

1974.

Néanmoins, avec la politique de la

Zaïrianisation, le président en exercice à l'époque,

le feu Maréchal Joseph MOBUTU Seseseko, promulgue l'Ordonnance-Loi

n°74/013 du 10 janvier 1974 portant création de l'Office

Zaïrois de Contrôle « OZAC » qui se veut

alors une entreprise de droit public à caractère technique et

commercial doté de la personnalité juridique et non plus cette

société privée d'avant 1974.

Avec le renversement du

régime de l'ex-Zaïre de MOBUTU par l'arrivée au pouvoir de

Laurent Désiré KABILA le 17 mai 1997 et le pays étant

devenu la République Démocratique du Congo (R.D.C.), l'Office

Zaïrois de Contrôle changea également d'appellation et devint

l'Office Congolais de

Contrôle, « O.C.C. ».

III.3 Localisation

Notons que, à Kinshasa, le siège social de

l'OCC (la Direction Centrale) est situé au n° 98 sur l'avenue du

Port, dans la commune de Gombe.

III.4

Missions et Objectifs

III.4.1 Missions

En sa qualité d'organisme public à

caractère technique et scientifique, l'O.C.C a pour missions

légales :

v Préserver les intérêts

économiques en assurant les contrôles de la qualité, de la

quantité et de la conformité de toutes les

marchandises ;

v Analyser tous les échantillons et produits pour

protéger les clients ;

v Garantir la sécurité des installations,

machines, appareilles, travaux et étalonnages ;

v Prévenir les sinistres et procéder au

constat des dommages ou des avaries ;

v Exercer toutes opérations quelconques se

rapportant directement à son activité légale, sauf les

opérations de l'achat en vue de la revente.

Partant de ces missions, l'O.C.C. a comme devise :

« la confiance n'exclut pas le contrôle, le

contrôle renforce la confiance ».

III.4.2 Objectifs de l'O.C.C.

Les principaux objectifs de l'OCC

peuvent se résumer en trois volets comme ci-après :

a) En faveur de

l'Etat :

v Aider l'Etat à juguler la fraude fiscale et

à maîtriser la balance de paiements extérieurs par le

contrôle des prix ;

v Aider l'Etat à disposer des statistiques fiables

dans le commerce extérieur et à maîtriser la valeur en

douane de la marchandise ;

v Soutenir l'Etat dans ses efforts de développement

intégral.

b) En faveur de

l'opérateur économique :

v Rassurer les importateurs, les exportateurs et les

assureurs ainsi que les fournisseurs de la qualité, de la

quantité, de la conformité et du prix réel des

marchandises et produits ;

v Aider les opérateurs économiques et

industriels à s'assurer du respect des normes.

c) En faveur du

consommateur et de l'usager

v Sécuriser et rassurer le consommateur et l'usager

de la qualité du produit identifié et retenu comme propre

à la consommation ou des ouvrages en chantier prêts à

être utilisés ;

v Sécuriser l'usager sur le lieu de

travail ;

v Prévenir les atteintes à l'environnement

humain.

III.5 Relation entre L'OCC et le

gouvernement et d'autres Institutions

Dans le cadre de son mandat légal, l'office

congolais de contrôle collabore avec des nombreux ministères et

d'autres institutions ou organismes auxquels il fournit des renseignements

utiles ou signale certaines constatations.

Parmi eux nous pouvons citer : le ministère de

l'économie nationale, ministère de commerce, ministère de

l'environnement, la banque centrale du Congo, et beaucoup d'autres.

III.6 Les activités

normatives

L'OCC s'est également vu confié par l'Etat

la mission d'assurer l'évaluation de la conformité de la

production locale aux normes, en vue de leur conférer une plus grande

compétitivité sur le marché interne et externe, et aussi

pour assurer une plus grande sécurisation du consommateur.

L'OCC a ainsi été amené à

s'investir dans le domaine de la normalisation et de ses activités

connexes pour préparer le pays à répondre aux défis

de la régionalisation et de la mondialisation.

Et conscient de la suppression progressive des

barrières tarifaires et de l'augmentation sans cesse croissante du flux

des marchandises et des services entre les différents pays du monde, il

a accordé à l'activité normative une importance

primordiale, et ce, dans la mesure où elle permet une bonne

intégration dans le système économique mondial et fait

profiter au pays de l'ouverture es marchés régionaux et

internationaux.

Ce faisant, il vise une recherche plus accrue de la

qualité grâce au respect des normes.

Il sied de signaler que l'OCC a été admis

comme membre correspondant d'organisation internationale de normalisation

« ISO » et siège depuis bientôt quatre ans au

conseil d'administration de l'organisation régionale africaine de

normalisation « ORAN »

III.7 Structure Organique Et

Fonctionnelle

Conseil d'Administration

III.7.1 Organigramme de l'Office

Congolais de Contrôle

Division médicale

Coordination du secrétariat de la

D.G

Collège des commissaires aux comptes

Direction générale

Cellule d'études près DG

Division Relation Publique

D.comm.

D.Norm

D.certific.pr.

D. labo

D.metro cont

D.con.avaries

D.con.export

D.con.import

D. Financière

Div stat.

D. informat.

D.plan&dev.

D. juridique

Corp d conseil

Corp d audit.

Div.Hardware

Div.software

Div.Man&qual

Div. Doc.

Div.Statistique

Div.Gest. patrim.

D. Audit

D. sce générale

D. Admin.

Div.Pha

Div.micr.

Div.Gest

Div.Coo

Div.gen

Div.Pha

Div.Ingénierie

Div. Comm.

Div.micr.

Div.gen

Div.Aéroalim.

Div.Gest

Div expertise

Div.Gest

Div.Aérochim.

Div. CEDIN

Div.dev. nor

Div. Cooper

Div. Market

Div.Aéroalim.

Div.Phar et cosm.

Div.tarif et prom

Div.Metrolog.

DivVer export

Div.Protdu trav.

Div suivi exp

Div.Industrie

Div cont

Div.gen

Div.Adm.&f.

Div. Du pers.

Div. Suivi exploit.

Div.compt.

Div. Etudes

Div. Suivi Adm. Fin.

Div.budg.

Div.Approvis

Div. sociale

Div.Rémuner.

Div. Hydrocarbures

Div.Tresor.

Div.Suivi arts.

Div.Analys

Fonction de coordination

D. Coord.

Fonction Technique

Div. Format.

Div.Coo

Fonction financière

Fonction de support

Div.recouvr.

DIREQ

DIRBAC

DIRKIN

DIRNOKI

DIREST

DIRPOR

DIRKOR

DIRCENTR

DIKAT

III.7.2 Fonctionnement de

l'Office Congolais de Contrôle

L'office congolais de contrôle est placé sous

la tutelle du ministère de l'économie nationale et du commerce,

petites et moyennes entreprises pour les matières à

caractère organisationnel et fonctionnel telles que :

v Organisation des services, le cadre organique, le statut

du personnel, le barème des rémunérations ;

v L'Etablissement des départements centraux,

directions provinciales, agences et postes à l'intérieur du

pays ;

v Les rapports annuels ;

v Les emprunts et les prêts ;

v Les prises et cessions des participations

financières, etc...

L'organisation et le fonctionnement des structures

organiques de l'OCC sont régis par les articles 7 à 26 de la loi

n°78 002 du 06 janvier 1978 portant dispositions

générales applicables aux entreprises publiques.

A. Conseil D'administration

Le conseil d'administration est l'organe de conception,

d'orientation, de contrôle et décision de l'office.

Il définit la politique générale, en

détermine le programme, arrête le budget et approuve les

états financiers de fin d'exercice.

A ces fins, le conseil d'administration

délibère sur toutes les matières relatives à

l'objet de l'office et dispose notamment des compétences

de :

v Arrêter le plan de développement, les

programmes généraux d'activité et d'investissements, les

budgets ainsi que les comptes de l'office ;

v Décider de la prise, de l'extension ou de la

cession de participations financières ;

v Fixer les orientations de la politique tarifaires de

l'office, les conditions générales de passation des contrats,

conventions et contrats et règles générales d'emploi de