|

KARAZI Yahya

MR CPSE | PJR

Sous la direction de : Mr Pernot

22/10/2020

ESTIMATION DE LA QUALITE

DES SCANS PAR TECHNIQUE

D'APPRENTISSAGE MACHINE

1

Table des matières

Introduction : 2

Contexte : 2

Etat de l'art : 3

Scan par lumière structurée : 7

Critères géométriques : 8

Indice de qualité : 9

Application : 10

Exemple d'application : 10

Caractérisation géométrique : 12

Evaluation de la qualité : 14

Préparation de données 15

Apprentissage machine : 15

Conclusion : 20

Références : 21

Annexes : 22

2

Introduction :

La numérisation des objets et la capitalisation des

connaissances sous forme numérique est de plus en plus indispensable de

nos jours, dans un monde qui tend vers la virtualisation, ou l'on cherche

à accéder à l'information ou que l'en soit et quand on le

veut.

La numérisation des objets que ce soit pour des

applications de métrologie où l'intérêt est la

mesure et le contrôle des pièces afin de s'assurer de la

qualité de ces dernières, c'est le domaine qui nécessite

le plus de précisions, d'où l'exigence sur le

procédé de numérisation qui est contraint de

récupérer la forme et la géométrie d'une

manière fidèle, on trouve aussi les applications de

rétroconception ou le but est la reconstruction des modèles

virtuels à partir des objets physiques dont on ne dispose pas

d'informations, ceci en ayant une vision de reconstruction de l'objet, ou d'en

créer un modèle pour des applications de réalité

virtuelle, ou pour des fins de restauration comme est le cas des oeuvres d' art

et des sites historiques.

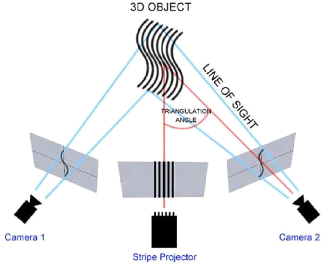

Dans ce contexte il existe plusieurs technologies permettant la

numérisation de l'apparence et de la géométrie des objets

existants avec des grandes résolutions, On trouve la technologie de

lumière structurée, qui réalise un calcul, type

triangulation, à partir de la déformation de la lumière

projetée (qui peut être une grille, des vagues, des points

régulièrement espacés, des formes complexes). Cette

lumière est captée par 2 caméras. En calculant le

déplacement du motif sur la surface, le logiciel en déduit ses

propriétés, On trouve aussi les technologies se basant sur la

triangulation par laser en projetant un rayon laser et analysant la

déviation sur le volume, ainsi que la branche de photogrammétrie

qui est une analyse de photos prises dans différentes positions,

permettant d'en extraire des informations et d'en construire un modèle

3D du sujet. Il existe aussi des technologies de scan par contact utilisant des

palpeurs, et des technologies par impulsion laser qui se base sur le calcul de

la durée mise par la lumière pour atteindre une surface et

revenir.

Contexte :

Comment caractériser et quantifier la qualité d'une

numérisation d'un objet 3D ? et quel lien existe entre cette

qualité définie et les conditions de numérisation ?

connaissant le lien entre les deux, peut-on estimer la qualité d'une

numérisation 3D pour de nouveaux objets pour mieux définir une

stratégie de scan ?

3

L'usage des scanners laser dans la numérisation en

général a permis des vitesses d'acquisition plus importante ainsi

qu'une grande densité de points, mais pour des applications qui

nécessitent de grands degrés de précision comme dans le

domaine de métrologie pour des taches d'inspection, il est indispensable

que les données soient acquis dans les meilleures conditions. Durant la

numérisation d'une pièce, plusieurs sources d'erreurs peuvent

intervenir et le résultat est des données erronées.

D'où la nécessité de déterminer les

paramètres ayant le plus d'influence, ces paramètres ainsi que le

modèle CAO, sont utilisées afin de déterminer les

corrélations qui existent entre la géométrie, la

disposition, l'environnement et la qualité du nuage de points acquis,

afin de trouver les valeurs optimaux de ses paramètres pour une

meilleure numérisation, et par la suite définir un plan pour

numériser précisément et d'une manière

complète la géométrie de l'objet scanné, ce plan

sera un ensemble de position et d'orientation du dispositif d'acquisition par

rapport à l'objet scanné,

Pour ceci on prendra comme cas d'étude un scanner à

lumière structurée, dont la précision est définie

en fonction de la distance et de l'angle d'incidence relativement à la

surface, le but étant naturellement d'obtenir la meilleure

précision durant l'acquisition, il est donc évident de respecter

les deux paramètres précédemment cités, mais ceci

n'est pas évident et ses paramètres ne peuvent être

respectés, surtout dans le cas des surfaces qui présentent de

grandes variabilités.

Etat de l'art :

La définition d'un bon scan a été toujours

liée au respect des paramètres et des consignes des fabricants de

scanners, principalement la distance et l'angle d'incidence ce qui est

justifié par le type des rayons lumineux et leurs intensités et

la précision du dispositif d'acquisition, ses paramètres varient

donc avec le procédé et le dispositif de numérisation,

avec l'avance technologique les nouveaux dispositifs permette l'analyse en

temps réel et l'assistance durant le scan afin d'assurer le bon respect

de ces derniers.

On retrouve des approches qui essaient de la définir comme

le résultat d'une bonne stratégie de numérisation. Alors

que [Tarabanis 95] s'intéresse principalement à la planification

des stratégies de scan en se basant sur des algorithmes de

reconnaissance visuelle, où il commence par la détection des

caractéristiques morphologique du sujet puis la détermination

4

d'un modèle stratégique de numérisation,

[Prieto 03] s'intéresse à l'inspection automatique des objets

contenant des surfaces courbées, en déterminant des plans

d'acquisitions où la qualité dépond exclusivement de la

précision du procédé de mesure. En tenant compte de la

géométrie CAO et du modèle d'erreur du

procédé, ils choisissent le meilleur positionnement du capteur vu

qu'ils s'intéressent à des zones spécifiques pour

l'inspection métrologique.

Les deux approches précédemment citées

définissent des stratégies visant l'obtention d'une bonne

qualité, cependant leur vision reste locale et dépond de la

variabilité locale de la pièce scannée, ces approches sont

donc très longues et complexes et seront plus dédiées

à la numérisation des surfaces spécifiques ou à des

zones d'intérêt, il faut noter aussi que la qualité n'est

pas directement évaluée mais ses deux approches visent à

respecter les bonnes conditions pour avoir de bons résultats,

l'introduction d'autres paramètres inconnus qui peuvent influencer la

qualité ne serait pas prise en compte, et ne sera même pas

détectée, malgré le fait que ces conditions soient moins

probables, ceci doit être pris en compte, afin d'avoir une vision

d'amélioration du processus de planification de scan à un

processus évolutif.

Pour d'autres la notion de qualité est définie par

des indicateurs qui sont évalués après l'acquisition des

données, c'est donc une analyse postérieure au scan, qui

quantifie la notion de qualité.

La numérisation 3D d'un objet nécessite souvent

plusieurs scans de différentes vues, lors du recalage de ces

données afin d'avoir un scan complet, on se retrouve avec des

densités locales inhomogènes, d'où la

nécessité de quantifier la qualité d'un scan et permettre

l'inspection, On trouve plusieurs indicateurs de qualité dans la

littérature, l'évaluation de ces indicateurs est

postérieure au scan vu qu'ils sont calculés à partir d'un

nuage de points.

On retrouve deux types d'indicateurs, les indicateurs

intrinsèques et les indicateurs spécifiques.

Parmi les indicateurs intrinsèques au nuage de points,

[Hoppe 92] à proposer un indicateur de qualité qui est

l'indicateur ñ-dense qui est un calcul de distance entre un point

donné et le point le plus proche, puis réalise une sorte de

moyenne globale sur la totalité du scan, cependant cet indicateur ne

donne pas d'information sur la discontinuité des scans et des zones non

numérisées, afin de tenir compte du caractère anisotrope

de répartition des

5

données, [Contri 00] propose l'utilisation de la

représentation des données sous la forme d'espace voxels. Le

pavage de l'espace ainsi effectué permet l'évaluation locale de

la densité, où on peut quantifier le nombre de points

numérisés contenu dans l'espace voxel.

Afin de définir une stratégie de

numérisation on trouve que dans la littérature on se base souvent

sur l'indicateur de qualité de complétude, [Contri 00] a

proposé une définition intrinsèque, cet indicateur nous

aide à déterminer les zones où on a un manque de

numérisation qui est justifié par une orientation

inadéquate du dispositif d'acquisition, l'indicateur K-complétude

est un taux de couverture de la surface numérisée en terme des

aires des triangles, cet indicateur est par la suite évalué par

un seuil qui est déduit d'une valeur fixée de la

densité.

Les indicateurs spécifiques sont caractéristiques

du dispositif de numérisation et des conditions expérimentales de

cette numérisation. L'indicateur ô-bruit introduit par [Hoppe 92]

évalue le bruit intrinsèque à la numérisation qui

est de type aléatoire, est défini comme l'écart-type entre

le modèle de la géométrie supposé parfait et le

nuage de points au sens des moindres carrés. L'indicateur t-exactitude

est définie comme l'écart entre la mesure et la valeur

réelle du sujet mesuré, la particularité de cet indicateur

c'est le fait de pouvoir évaluer la dispersion sur la position d'un

point, numériser plusieurs fois à travers différentes

vues.

La quantification de la qualité à travers des

indicateurs intrinsèques et spécifiques dans la plupart des

approches précédemment citées reste globale et ne prend

pas en compte la variabilité local, en plus l'évaluation de ces

indicateurs est toujours postérieure à la numérisation, ce

qui signifie qu'afin d'obtenir une précision voulu, le processus est

itératif, on doit effectuer plusieurs scans, puis évaluer les

indicateurs cités chaque fois et vérifier si les résultats

correspondent à la demande, dans cette voie notre approche se voit

estimer la qualité par des techniques d'apprentissage machine avant

d'effectuer le scan afin de permettre la planification stratégique de la

numérisation, pour déterminer de manière exacte le

positionnement et l'orientation du dispositif d'acquisition, et anticiper le

manque de données dans des zones qui représentent des

difficultés et une absence de numérisation. Les résultats

de cette analyse qu'on propose permettront de choisir les données

mesurées lors du recalage des nuages de points, où on pourra

choisir par la suite ceux avec le plus de probabilité d'exactitude en

fonction de la distance et de l'orientation, autrement dit pour un point

numérisé à partir de plusieurs vues, on pourra choisir la

meilleure mesure de ce dernier, et isoler le reste des données ce qui

posait problème de variabilité de densité.

6

Cette démarche qu'on propose se base sur des

caractéristiques géométriques de l'objet dont la courbure,

[LESAGE et al 14] propose pour la caractérisation des formes

géométriques, une combinaison d'approximation de la courbure

discrète, le concept d'invariance de ses approximations, le

prétraitement sur des polyèdres construits à partir

d'objets numérisés a été introduit. Cette

combinaison d'approximations de courbure discrètes et l'utilisation de

prétraitements spécifiques sur un polyèdre construit

à partir d'un objet numérisé peuvent aider à

effectuer sa segmentation pour extraire les lignes polygonales et les zones

polyédriques qui serviront de base pour la génération des

surfaces, ainsi le plus important pour nous c'est l'introduction d'une nouvelle

définition de courbure discrète.

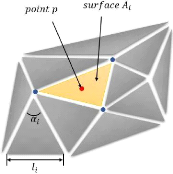

[Lin et al. 82] Définition discrète de la courbure

gaussienne en chaque point en fonction des angles et des aires des triangles

partageant le même point, ceci reste une bonne approximation quand les

triangles sont réguliers, et ont des surfaces similaires.

[Boix 95] propose une approximation similaire mais qui tient

compte de la variabilité des triangles et de leurs

irrégularités, et qui approche d'une manière plus

précise la courbure gaussienne.

Cette définition est très importante du fait

qu'elle nous donne une information locale sur la forme et de sa

variabilité, ceci nous aide à récupérer des

données traduisant l'accessibilité à la zone durant le

scan.

On a développé une méthode d'estimation de

la qualité des scans d'objet, cette méthode nécessite un

modèle CAO (en format STL), et des données du nuage de points

issues d'un scan, dans notre cas on a pris l'analyse par lumière

structurée comme exemple, mais cette méthode peut être

utilisée pour plusieurs procédés, ceci dans une

première phase d'apprentissage.

Scan par lumière structurée :

La numérisation par capteurs de proximité est

devenue de plus en plus répandue vue la vulgarisation des dispositifs,

cependant la différence de précision entre les capteurs à

distance et ceux à base de palpeur reste très large, mais en

matière de vitesse d'acquisition les rôles s'inversent, les

capteurs à proximité permettent une couverture large des surfaces

à numériser durant des secondes ou moins, d'où le besoin

de maximiser leurs performances, pour notre étude d'estimation de la

qualité des données de numérisation, on a choisi un

scanner à lumière structuré, qui se base sur le principe

de la triangulation trigonométrique, en projetant un motif de

lumière sous forme de raies sur le sujet à numériser par

un projecteur LCD dans la plupart des cas, puis une ou plusieurs caméras

légèrement décalées analysent la courbure de la

forme du motif lumineux et calcule la distance de chaque point.

Cette technologie de numérisation est l'une des plus

rapides qui existent et offrent une grande résolution, principalement

dédiée aux courtes distances de l'objet.

Figure (1)

7

8

Critères géométriques :

L'utilisation des scanners à base de lumière

structurés est tenue à respecter des paramètres

définis par les constructeurs de ces appareils, la distance étant

le premier paramètre qui est fonction du type de la lumière et

des motifs projetés, avec une distance trop importante

l'éclairement lumineux devient moins important, par définition de

l'éclairement lumineux qui est un rapport de l'intensité de

lumière I sur la distance de la source d au

carré. Le deuxième paramètre est l'orientation de la

source lumineuse, une inclinaison par rapport à la normale de la surface

entrainera directement la déformation des raies, et vu que la technique

de mesure se base principalement sur la déformation des raies sur les

courbures des surfaces numérisées, les données acquises

sont naturellement biaisées, ceci est justifié par la relation de

l'éclairement en optique physique donnée par eq. (1) :

I

E= d2 . cos(á)

eq. (1)

Pour ces raisons on s'intéressera aux deux

paramètres d et á,

généralement la distance entre l'objet et la source de

lumière était défini de manière globale, cependant

pour des objets qui présentent plusieurs variabilités cette

distance peut varier d'une manière assez considérable, pour notre

analyse on évaluera cette distance pour chaque point de la surface ceci

nous donnera une idée bien précise sur la condition d'acquisition

de chaque point.

On pourra dire de même pour l'orientation du projecteur

par rapport à la normale de la surface, certes, il est impossible de

suivre la forme de manière exacte et réaliser un scan de

manière normal sur chaque point de la surface, mais on

s'intéressera à contrôler l'effet de cette inclinaison dans

la limite du raisonnable.

Ces deux paramètres seront des indicateurs des

conditions dans lesquels la numérisation a été faite pour

chaque point, afin de caractériser la géométrie à

scanner on prendra en compte un autre paramètre qui a le plus

d'influence sur la qualité d'un scan, ce dernier est la courbure

gaussienne, qui caractérise la variation brusque de la morphologie de la

pièce, cependant on ne peut l'évaluer de manière

classique, on procèdera par l'approximation proposée [Boix] par

eq. (2) :

9

K= 2??-? ?? a??

2 ? ????+1

1 8 ? ?? cot (a??)???? 2

??

eq. (2)

Cette approximation est fonction des aires des triangles qui

partage le même sommet, des angles partageant ce même sommet, et de

la longueur des arêtes opposées à ce sommet.

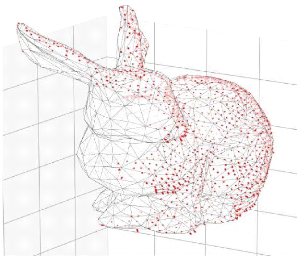

Figure (2)

La valeur de courbure quand attribuera au point

numérisé comme indicateur de forme est une valeur moyenne des

courbures définie dans les trois sommets du triangle le plus proche

à ce point (eq3) :

K = ???????? + ???????? + ????????

eq. (3)

???? : ratio de la distance entre

le point p et le sommet du triangle sur la somme de trois distance avec les

trois sommets du triangle

???? : la courbure gaussienne dans

le sommet i du triangle

On pourra potentiellement ajouter d'autres

caractéristiques géométriques mais en se limitera dans

notre analyse à ceux cité précédemment.

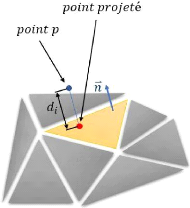

Pour notre analyse de qualité de scan, on prendra comme

indicateur l'écart entre le nuage de point et la CAO du sujet à

numériser dans cette première phase d'apprentissage, cet

écart est

10

défini pour chaque point du nuage comme la distance

entre ce dernier et le triangle le plus proche de la discrétisation de

la CAO.

Figure (3)

Application :

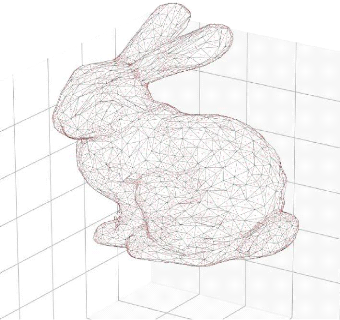

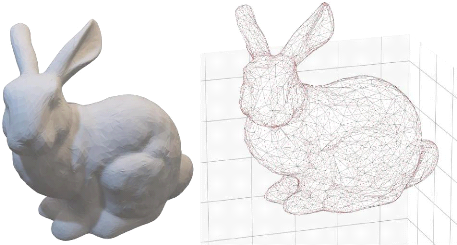

On appliquera les indicateurs et les caractéristiques

introduit dans les chapitres précédents sur un cas d'application

qui est le Stanford Bunny, la CAO étant disponible sera

polygonisé, est la tessellation résultante sera prise comme

référence.

Le choix de la précision de tessellation est

primordial, un pavage assez fin en résultera une grande quantité

de données qui sera difficile dans la phase de traitement, un pavage

assez grossier nous donnera des résultats qui seront assez loin de la

forme initiale, et les valeurs des écarts calculés seront

erronés, on se fixera une valeur qui nous assure un compromis entre la

taille des données et la précision.

Exemple d'application :

Le fichier qu'on utilisera est sous format STL et la librairie

utilisée pour la visualisation est stltools disponible pour python, la

visualisation de la CAO est comme suit :

Figure (4)

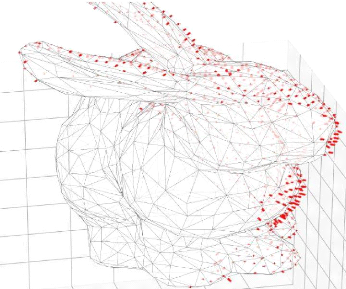

Dans une deuxième étape on superpose le nuage de

point et la tessellation du stanford bunny, durant cette étape il est

nécessaire que les deux soient bien calé.

11

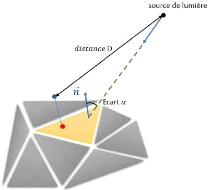

Figure (5)

12

Caractérisation géométrique :

L'étape suivante serait donc naturellement

l'évaluation des caractéristiques géométriques pour

la totalité des points de nuage, on aura besoin pour cela des

informations concernant la position et l'orientation du scanner, donc un point

et un vecteur, en évaluant la distance en peut tracer les droites

reliant le point de la source et chaque point du nuage, les données sont

enregistrées sous format texte(.txt).

Figure (6)

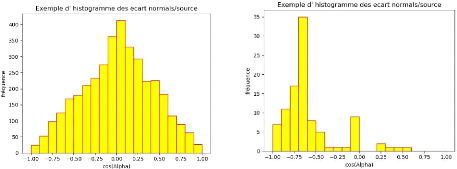

Sur la figure (6) on peut voir l'écart angulaire dont

on parle, cet écart est calculé à partir d'un produit

scalaire entre le vecteur directeur de la source de lumière et la

normale du triangle, la valeur récupérée est un cosinus de

l'angle d'écart, on voit aussi la distance entre la source lumineuse et

le point qui appartient au nuage de points numérisé, cette

distance est calculée comme étant la norme du vecteur dont les

deux extrémités sont le point du nuage et le point de la source

de lumière, sur cette même figure on montre l'écart qui

représente l'erreur de numérisation, entre les points acquis et

la géométrie.

13

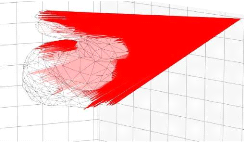

Figure (7)

On évalue aussi l'écart entre le vecteur

d'orientation de la source de lumière et la normale du triangle le plus

proche au point, la définition du triangle le plus proche se base un

algorithme qui calcul la distance entre le point et le plan qui contient le

triangle, puis vérifie que la projection de ce point sur ce plan est

contenue dans le triangle ou non, puis choisit le triangle dont la distance est

la plus petite, le script des fonctions qui permettent de faire ce calcul sont

en annexe.

La courbure comme précédemment définis est

stockée de même sous fichier texte (.txt).

Il est intéressant de mentionner que

l'évaluation de l'écart angulaire entre la source lumineuse et la

normale à la surface peut être utile dans le cas où on

essayerait de déterminer la meilleure orientation donnant un compromis

entre la totalité des surfaces, pour mieux justifier ses propos, on

trace un diagramme de fréquence corrigé par rapport aux aires des

triangles qui montre la distribution des écarts, deux exemples sont les

suivants, un qui est centré autour de la valeur 0 et l'autre autour de

la valeur -0,7 .

Figure (8)

Également, l'intérêt de cette

caractérisation est le fait qu'elle soit intrinsèque à la

disposition de l'objet et du scanner, ce qui est très intéressant

en matière d'informations récupérer.

14

Evaluation de la qualité :

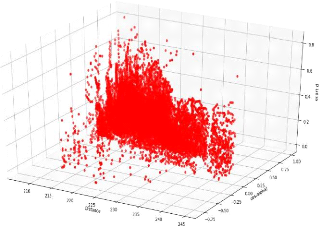

Le calcul entre chaque point du nuage et le triangle le plus

proche se fait d'une manière similaire, le script permettant de

déterminer le triangle le plus proche du point pur le calcul de

l'écart angulaire est le même utilisé pour calculer

l'écart dimensionnel. Les valeurs de ses écarts sont de

même enregistrées sous format txt, on peut visualiser cet

écart quand il est important sur la figure (9).

Figure (9)

Les données récupérées peuvent

être exploitées pour l'apprentissage machine et la construction

d'un modèle permettant la prédiction de la qualité, en

données d'entrer les caractéristiques géométriques,

la distance entre le scanner et le point numérisé, l'écart

angulaire entre la direction de la source de lumière et la normale

à la surface locale, la courbure moyenne entre les trois sommets du

triangle proche, définie pour chaque point, en résultat on aura

l'écart dimensionnel entre le point et la surface

référence.

15

Préparation de données

Les données étant générées

à partir de la géométrie du modèle CAO et du nuage

de points, peuvent être exploitées, les données sont

enregistrées sous format texte (extension :.txt), et sont par la suite

récupérables par un programme de lecture de fichier texte, ce

programme permet de définir le nombre de colonnes ainsi la nature de

chaque valeur présente sur le fichier texte et l'indice de cette

dernière, ces données sont par la suite enregistrées dans

un fichier de format python (extension :.py), cette étape a

été introduite par ce qu'on a opté pour une structure

modulable de notre processus et donc peut être négligé,

elle sert juste a définir de manière explicite le nombre de

caractéristiques est la position de chacune dans notre liste.

Apprentissage machine :

Afin d'avoir une analyse adéquate et globale en

procède par un standard des bonnes pratiques décrit par [Plonsky

18] pour de la multi régression.

Le module qu'on à utiliser pour cette tâche est le

multi perceptron de Scikitlearn, on fait l'appel à celui-ci avec les

autres modules dont on aura besoin pour manipuler les données et tracer

leur allure, on a aussi utilisé un régresseur linéaire

afin de comparer les résultats et avoir une idée sur la nature

des relations entre les différents paramètres

étudiés et la qualité, ainsi pour voir l'atout en

matière de prédiction du modèle lorsqu'on passe du

linéaire au non linéaire, et si le modèle non

linéaire impact le score d'une manière significatif ou non.

le score dont notre cas réfère à R2 qui est

un coefficient qui reflète une mesure de la précision de la

prédiction du modèle en question.

Le choix de la multi régression est justifié par le

fait qu'on a plusieurs prédicteurs en entrée, et cette

régression est standard vue que les données manipulées

sont de nature géométrique non évolutive dans le temps.

On s'intéresse aussi à voir l'influence de la

taille des données d'entrainement sur le score, pour cette raison en

effectue l'apprentissage sur diffèrent taille de données et

évaluer le score obtenu dans chaque cas, il faut noter que les

données utilisé pour chaque configuration sont choisi d'une

manière aléatoire afin d'avoir le plus de variabilité et

d'éviter de faire une analyse local sur une zone précise.

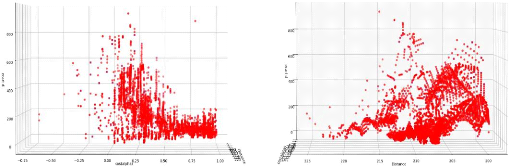

Afin de mieux voir la nature des données traitées

on les affiche sous forme de graphe ou en trace pour chaque couple

d'écart angulaire et distance de scan la valeur de l'écart

dimensionnel (erreur), le graphe obtenu est le suivant pour une taille de

données de 5000.

Figure (10)

16

Figure (11a) Figure (11b)

17

Sur la figure (a) on remarque l'augmentation de la

variabilité de l'erreur lorsque le cos (á) est presque nul, ceci

correspond à un angle d'écart de 90 degrés, ce qui

confirme l'influence de l'écart angulaire sur la qualité.

Sur la figure (b) on remarque que l'erreur est de plus en plus

importante quand la distance est moins importante, cependant on ne peut juger

de manière exacte vue que l'erreur est fonction des deux

paramètres.

En effectuant l'apprentissage sur différentes tailles de

données, le graphe des scores est le suivant.

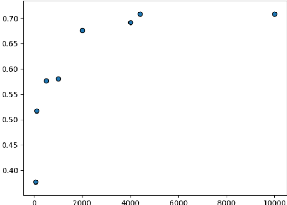

Figure (12)

On remarque que le score se stabilise à une taille de jeu

de données d'environ 5000, le meilleur score résultant est de

70%, ce score est relativement bas mais reste acceptable vue qu'on s'est

limité à deux paramètres en entrée.

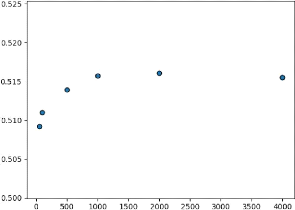

En comparaison avec le modèle de régression

linéaire, les résultats sont les suivants :

Figure (13)

On remarque que le score se stabilise à 51% à

partir d'un jeu de données de taille 1000, cette valeur de score est

plus basse que celle du modèle non linéaire ce qui était

évident vue la complexité du processus de numérisation et

le nombre de facteurs qui influence la qualité d'un manière

général.

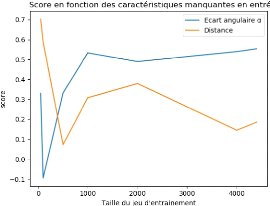

Afin d'avoir une idée sur l'influence de chaque

paramètre, en effectue l'apprentissage sur chaque caractéristique

indépendamment et on analyse les résultats, les résultats

sont les suivants :

Figure (14)

18

19

On remarque que l'écart angulaire a plus d'influence sur

le score que la distance, et que pour des jeux de données de petite

taille les scores sont les plus élevés ceci est dû au fait

qu'avec peu de données, le régresseur arrive a trouver un lien

malgré le fait que ce lien ne reflète pas le lien réel

entre les différents paramètres.

Le score résultant qui représente le coefficient R2

est relativement bas, malgré le fait qu'un bon score aurait

été plus satisfaisant, ce résultat nous donne une

idée sur le fait qu'ils restent encore des paramètres qui ont

été négligés et qui influencent la qualité

du scan, ses paramètres doivent être étudiés et

intégrés dans le modèle.

Une autre interprétation du résultat est le fait

que les données sur lesquelles on a fait cette étude sont

synthétiques et soient potentiellement biaisées, une étude

sur des scans réels serait l'étape suivante naturelle,

On peut aussi justifier la valeur du score par l'existence du

bruit intrinsèque à la numérisation et le traitement de

données, il faut noter que [Prieto 03] avait déjà

cité ceci dans son étude, où il conclut que le bruit est

intrinsèque à la numérisation et qu'il suit une loi

gaussienne, une pré étape de débruitage aura donc

sûrement un impact.

D'une autre perspective, on remarque que les deux facteurs

étudiés sur lesquels on s'est focalisé ont un grand impact

sur la qualité, avec l'écart angulaire ayant le plus d'impact,

à la contradiction de la lois d'éclairage dans la théorie

de l'optique physique, ceci est justifié par le fait que l'écart

angulaire dans les données étudiées varie sur la plage des

valeurs possibles de 0 à 360 degrés, tandis que la distance varie

sur une plage très limitée entre 200 et 220 mm, d'où

l'influence importante du premier facteur sur les résultats.

20

|