|

REPUBLIQUE DEMOCRATIQUE DU CONGO

UNIVERSITE DE KINSHASA

Faculté des sciences économiques et de

gestion

Département d'Economie

Option : Economie mathématique

B.P : 832 Kinshasa XI

Prévision des prix de Chikwangue sur le

marché de Kinshasa : Par l'approche de

Box-Jenkins.

LWAMBA FATAKI Yannick

Licencié en Economie Mathématique

E-mail: ylwamba@yahoo.fr

Tél. : +243 815096593

0. INTRODUCTION

Dans le programme des cours retenu en licence en Economie

mathématique à la faculté des sciences économiques

et de gestion, un séminaire est prévu pour la formation des

étudiants. C'est dans ce cadre que le chargé du

séminaires en première licence économie

mathématique, le professeur BOSONGA BOFEKI et son assistant ALAIN

LUNGUNGU ont mis à notre disposition un nombre important de

données à partir desquelles il fallait mener une étude et

faire une prévision.

Dans ce cadre, il nous a été demandé de

faire un travail pratique en se servant des différentes notions acquises

en statistique approfondie. De notre par le produit retenu est la Chikwange.

Le travail porte sur les données

hebdomadaires de la production de la Chikwange; à partir de cette

dernière on fera la prévision pour les prochaines semaines tout

en étant assuré que l'évolution de la série dont on

dispose est stationnaire.

La raison qui justifie cette prévision est une

probable existence des événements futurs qu'on ignore et qui sont

importants pour les décisions à prendre présentement.

En faite la détermination des prix des biens est une

action importante aussi bien pour l'Etat que pour les opérateurs

économiques.

A une période quelconque, le gouvernement peut s

intéresser a la détermination des prix des biens au cour d'une

période future. Si cette évolution est défavorable, il

devra prendre des mesures correctives.

? Le gouvernement en faisant la prévision cherche

à assurer le bien être de la nation. Il intervient sur le

marché pour participer à la détermination des prix des

biens car le bien être en dépend .Sur ce, ce dernier doit suivre

de près en recourant aux différentes méthodes de

prévision.

? Les opérateurs économiques ont pour objectif

la maximisation de profit. Sur ce, il doit faire un bon usage des

méthodes prévisionnelles en matière des prix pour y

parvenir et ceci lui permettra d'être plus compétitif sur le

marché des biens et services.

METHODOLOGIE DE TRAVAIL

Il existe plusieurs méthodes de prévision,

mais dans ce travail nous utiliserons la méthode de BOX-JENKINS. Cette

méthode de prévision qui est basé sur l'évolution

des séries chronologiques permet d'identifier les processus

générateurs d'une série

En effet, une chronique peut être générer

par quatre types de processus, à savoir : AR, MA, ARMA ou ARIMA.

En présence d'une série complète, deux problèmes

sont posés :

Celui de connaître quand est ce que une série

suit un processus, AR, MA, ARMA ou ARIMA, d'une part et quelle est son ordre

une fois qu'on est fixé sur son processus, d'autre part.

METHODE DE BOX-JENKINS

Cette méthode comme on l'a dit dans l'introduction,

permet de saisir le processus générateur de la série

chronique. Pour cette méthode, la partie auto régressive d'un

processus notée AR, est constituée par une combinaison

linéaire finie de valeur passée du processus. La partie moyenne

mobile notée MA, est constituée d'une combinaison finie en t

des valeurs passées d'un bruit blanc. World (1954) montre que le

modèle ARMA permet de représenter la plupart de processus

stationnaires. L'approche de BOX et JENKINS (1975) consiste en une

méthodologie d'une étude systématique de séries

chronologiques à partir de leurs caractéristiques afin de

déterminer dans la famille des modèles ARIMA qui est le plus

adapté à représenter le phénomène

étudié. Il existe cinq étapes de la méthode de

BOX-JENKINS à savoir :

Ø Analyse exploratoire des données,

Ø Identification,

Ø Estimation,

Ø Validation,

Ø Prévision,

I.1 ETUDES DE LA STATIONNARITE

1. Tests Informels

1.1 Analyse des plots

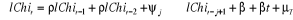

L'analyse visuelle du plot montre à première vue

que la présence d'une tendance non linéaire et même

l'introduction des logarithmes n'apporte rien au comportement du plot.

D'où il y a lieu d'affirmer une présomption de la non

stationnarité de la série Chi. (voir en annexe).

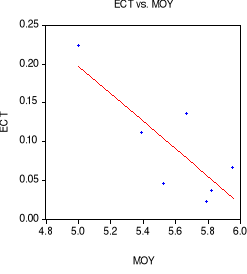

1.2. Analyse des moments

Les écarts types sont non proportionnels, et la

représentation graphique du couple (ECT, MOY) est disposée autour

d'une droite descendante montrant les valeurs des deux moments

dispersées aléatoirement. Par conséquent, on peut affirmer

la présomption d'une non stationnarité de la série. (voir

en annexe).

1.3. Analyse du corrélogramme

La décroissance lente des coefficients

d'autocorrélation simple consolide la présomption de non

stationnarité de la série lChi. En plus un coefficient

d'autocorrélation partielle est significatif, ceci amenant à un

modèle non stationnaire de type ARIMA (1, 0,0) (voir

corrélogramme en annexe). pour arriver à confirmer cette non

stationnarité, il est nécessaire de passer par des test plus

performants, dits tests formels, à savoir le test de la

racine unitaire de Dickey-Fuller.

Trois modèles seront estimés afin de

déterminer si la cause de non stationnarité de la série

lChi est de type déterministe ou stochastique, avec comme

hypothèse :

Ho=  et et

H1= , ,

1°

2°

3°

Le tableau ci-dessous reprend les critères de Akaike et

de Schwartz de l'estimation du modèle avec tendance et intercept qui

donnera le décalage optimal pour un test efficace de Dickey-Fuller.

Tableau 1 :

|

Lags

|

Akaike

|

Schwarz

|

|

0

|

-2,870497

|

-2,793292

|

|

1

|

-2,855305

|

-2,751736

|

|

2

|

-3,031612

|

-2,901353

|

|

3

|

-3,25567

|

-3,09839

|

|

4

|

-3,420379

|

-3,235739

|

|

5

|

-3,427024

|

-3,214677

|

Le critère d'Akaike est minimisé au

5ème décalage et celui de Schwarz au

4ème décalage. Par souci de parcimonie, nous retenons

le critère de Schwarz qui est minimisé au 4ème

décalage.(1(*))

Le test de DF et ADF donne ce qui suit :

Tableau 2 : Test ADF de la non stationnarité

|

ADF Test Statistic

|

-2.881580

|

1% Critical Value*

|

-4.0540

|

|

|

5% Critical Value

|

-3.4557

|

|

|

10% Critical Value

|

-3.1534

|

|

*MacKinnon critical values for rejection of hypothesis of a unit

root.

|

La valeur du test d'ADF en valeur absolue étant

inférieure aux valeurs critiques de Mackinnon à tous les seuils

confirme l'existence d'une non stationnarité de la série lChi.

De ce fait, nous estimons successivement les 3 modèles en

commençant par celui ayant la tendance et l'intercept.

Tableau 3 : Test de ADF du modèle 3° (voir

résultat en annexe).

Tableau 4 : Test de ADF du modèle 2° avec

constante et sans tendance (voir résultat en annexe).

Tableau 5 : Test de ADF du modèle 10

sans constante ni tendance (voir résultat en annexe)

Après estimation de ce modèle, nous constatons

que la valeur d'ADF est positive. Ceci étant nous arrêtons la

discussion.

En regardant nos output, nous constatons que pour le

1er modèle estimé que la probabilité

associé au trend est significativement différent de

zéro ; ceci nous amene à conclure que le source de la non

stationnarité de la série lChi est de type déterministe (

Trend Stationnary).

Ainsi, la stationnarisation se fera par les Moindres

Carrés Ordinaires ou

écart à la tendance.

Genr t = @trend à l'aide du logiciel Eviews

On estime à l'aide des commandes : LS lChi c t

(voir résultat en annexe)

Les deux coefficients de la dernière régression

sont significatifs. De plus, notre série devient stationnaire

lorsqu'elle ne présente ni tendance ni constante.

On génère les résidus issus de

l'estimation à l'aide de la commande Genr V = Resid.

Ainsi, nous faisons la régression suivante pour

vérifier la stationnarité de notre nouvelle variable.

?Vt = èVt-1 + ìt

On estime à l'aide des commandes : LS d(V) V(-1)

(voir résultat en annexe)

Ce qui équivaut à appliquer le Test de

Dickey-Fuller à cette série. Nous obtenons ainsi les

résultats (voir tableau 7 en annexe)

Nous constatons que c'est ce dernier modèle qui remplit

les conditions de stationnarité. Ainsi, nous pouvons maintenant

identifier le processus qui a généré celle-ci.

I.2. IDENTIFICATION DU MODELE

Nous constatons que le premier coefficient

d'autocorrélation est significativement différent de zéro.

Ainsi nous présumons que V est un processus ARIMA (1,0,0). Pour

confirmer cela, estimons le modèle :

Vt = èVt-1 + ìt

(voir tableau 8 en annexe)

I.3. ESTIMATION DU MODELE

LS V V(-1)

L'estimation de ce modèle nous confirme l'existence

d'un ARIMA (1,0,0) car le coefficient de la variable décalée est

significatif. Les résidus de cette estimation que nous avons

générer à l'aide des commandes GENR U = resid du logiciel

Eviews sont stationnaires comme nous l'indique les tableaux 9 et 10 en

annexe.

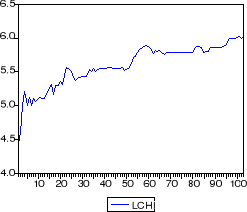

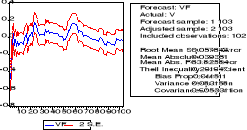

L'estimation de notre série faite sur Eviews

étant valide, nous pouvons l'utiliser pour la prévision. Ceci

peut être confirmé par le tableau et le graphique de

l'étape suivante qui nous montrent que les valeurs actuelles et futures

ne s'écartent pas.

I.4. VALIDATION DU MODELE

a) Hétéroscédastisticité

Ho : il y a absence d'hétéro.

Hi : il y a hétéro

|

ARCH Test:

|

|

F-statistic

|

2.748452

|

Probability

|

0.100514

|

|

Obs*R-squared

|

2.728235

|

Probability

|

0.098588

|

En analysant les données se trouvant dans le tableau ci

haut, on ne peut rejeter l'hypothèse nulle ; c'est à dire

qu'il y a absence d'hétéro.

|

Obs

|

Actual

|

Fitted

|

Residual

|

Residual Plot

|

|

|

|

|

|

|

97

|

-0.02915

|

-0.01989

|

-0.00926

|

| . * . |

|

|

98

|

-0.04377

|

-0.02084

|

-0.02293

|

| . *| . |

|

|

99

|

-0.05329

|

-0.03128

|

-0.02201

|

| . *| . |

|

|

100

|

-0.04974

|

-0.03810

|

-0.01164

|

| . *| . |

|

|

101

|

-0.03430

|

-0.03555

|

0.00125

|

| . * . |

|

|

102

|

-0.07261

|

-0.02452

|

-0.04809

|

| .* | . |

|

|

103

|

-0.06827

|

-0.05190

|

-0.01636

|

| . *| . |

|

En outre, le coefficient de Theil (0,2919) tend vers

zéro, la prévision est donc performante.

Le coefficient d'inégalité de Theil étant

de 29,19% on peut dire qu'il est élevé. Il est donc possible de

réduire sa valeur en estimant directement lChi en fonction de t et de

Chi (-1) en utilisant les commandes suivantes :

LS lChi c t lChi (-1) (voir tableau 11 en annexe)

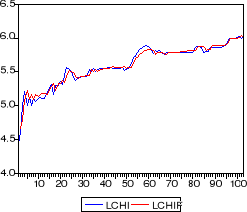

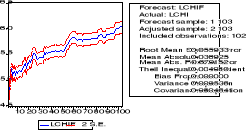

Nous constatons que le coefficient de Theil a baissé

(0,004980). De plus, la prévision faite sur base de cette

régression est meilleure que la précédente du fait que le

Root Mean Square Error est inférieur à celui du premier

modèle. (voir graphique 3 en annexe).

|

Obs

|

Actual

|

Fitted

|

Residual

|

Residual Plot

|

|

97

|

5.99655

|

5.99310

|

0.00345

|

| . * . |

|

|

98

|

5.99146

|

6.00125

|

-0.00979

|

| . *| . |

|

|

99

|

5.99146

|

5.99990

|

-0.00844

|

| . * . |

|

|

100

|

6.00455

|

6.00219

|

0.00236

|

| . * . |

|

|

101

|

6.02951

|

6.01383

|

0.01568

|

| . |* . |

|

|

102

|

6.00073

|

6.03398

|

-0.03325

|

| .* | . |

|

|

103

|

6.01460

|

6.01568

|

-0.00108

|

| . * . |

|

I.5. PREVISION

Dans cette partie du travail, il sera question de faire une

prévision pour 4 horizons ; donc H1,H2,H3 et H4. et cela en servant

ô, c'est à dire le coefficient du trend au tableau 9 de notre

annexe ; soit 0,71820.

Ainsi, H104= 4,321 ; H105= 3,104 ; H106=

2,230 ; H107= 1,60

ANNEXES

Graphique 1

|

Classe

|

Moyenne

|

Ecart type

|

|

1

|

5,001465

|

0,223827

|

|

2

|

5,389119

|

0,111616

|

|

3

|

5,525583

|

0,045212

|

|

4

|

5,669429

|

0,135825

|

|

5

|

5,79178

|

0,022475

|

|

6

|

5,822367

|

0,036714

|

|

7

|

5,953711

|

0,065629

|

Tableau 1

|

Date: 11/03/06 Time: 08:27

|

|

Sample: 1 103

|

|

Included observations: 103

|

|

Autocorrelation

|

Partial Correlation

|

|

AC

|

PAC

|

Q-Stat

|

Prob

|

|

. |*******|

|

. |*******|

|

1

|

0.898

|

0.898

|

85.446

|

0.000

|

|

. |****** |

|

. | . |

|

2

|

0.811

|

0.028

|

155.94

|

0.000

|

|

. |****** |

|

. |*. |

|

3

|

0.766

|

0.169

|

219.39

|

0.000

|

|

. |****** |

|

. |*. |

|

4

|

0.752

|

0.171

|

281.12

|

0.000

|

|

. |***** |

|

.*| . |

|

5

|

0.712

|

-0.073

|

337.03

|

0.000

|

|

. |***** |

|

. |*. |

|

6

|

0.684

|

0.102

|

389.26

|

0.000

|

|

. |***** |

|

.*| . |

|

7

|

0.644

|

-0.079

|

435.95

|

0.000

|

|

. |***** |

|

. | . |

|

8

|

0.615

|

0.034

|

478.96

|

0.000

|

|

. |**** |

|

. | . |

|

9

|

0.578

|

-0.038

|

517.43

|

0.000

|

|

. |**** |

|

. | . |

|

10

|

0.553

|

0.017

|

552.99

|

0.000

|

|

. |**** |

|

. | . |

|

11

|

0.524

|

-0.002

|

585.26

|

0.000

|

|

. |**** |

|

. | . |

|

12

|

0.495

|

-0.030

|

614.42

|

0.000

|

|

. |*** |

|

. | . |

|

13

|

0.457

|

-0.041

|

639.46

|

0.000

|

|

. |*** |

|

. | . |

|

14

|

0.431

|

0.020

|

662.07

|

0.000

|

|

. |*** |

|

. | . |

|

15

|

0.414

|

0.031

|

683.12

|

0.000

|

|

. |*** |

|

. | . |

|

16

|

0.399

|

0.010

|

702.90

|

0.000

|

|

. |*** |

|

. | . |

|

17

|

0.368

|

-0.047

|

719.96

|

0.000

|

|

. |*** |

|

. | . |

|

18

|

0.350

|

0.047

|

735.57

|

0.000

|

|

. |*** |

|

. | . |

|

19

|

0.334

|

-0.006

|

749.91

|

0.000

|

|

. |** |

|

. | . |

|

20

|

0.311

|

-0.047

|

762.49

|

0.000

|

|

. |** |

|

. | . |

|

21

|

0.275

|

-0.056

|

772.46

|

0.000

|

|

. |** |

|

. | . |

|

22

|

0.253

|

0.009

|

781.02

|

0.000

|

|

. |** |

|

. |*. |

|

23

|

0.248

|

0.068

|

789.32

|

0.000

|

|

. |** |

|

. | . |

|

24

|

0.245

|

0.022

|

797.56

|

0.000

|

|

. |** |

|

. | . |

|

25

|

0.242

|

0.058

|

805.66

|

0.000

|

|

. |** |

|

.*| . |

|

26

|

0.224

|

-0.063

|

812.70

|

0.000

|

|

. |** |

|

. | . |

|

27

|

0.205

|

-0.009

|

818.66

|

0.000

|

|

. |*. |

|

. | . |

|

28

|

0.188

|

-0.020

|

823.73

|

0.000

|

|

. |*. |

|

. | . |

|

29

|

0.174

|

-0.022

|

828.14

|

0.000

|

|

. |*. |

|

. | . |

|

30

|

0.158

|

-0.015

|

831.83

|

0.000

|

|

. |*. |

|

. | . |

|

31

|

0.140

|

-0.038

|

834.78

|

0.000

|

|

. |*. |

|

. | . |

|

32

|

0.119

|

-0.016

|

836.94

|

0.000

|

|

. |*. |

|

. | . |

|

33

|

0.111

|

0.043

|

838.84

|

0.000

|

|

. |*. |

|

. | . |

|

34

|

0.098

|

-0.049

|

840.34

|

0.000

|

|

. |*. |

|

. | . |

|

35

|

0.089

|

0.023

|

841.59

|

0.000

|

|

. |*. |

|

. | . |

|

36

|

0.072

|

-0.032

|

842.42

|

0.000

|

Tableau 2

|

Augmented Dickey-Fuller Test Equation

|

|

Dependent Variable: D(LCHI)

|

|

Method: Least Squares

|

|

Date: 11/03/06 Time: 09:17

|

|

Sample(adjusted): 6 103

|

|

Included observations: 98 after adjusting endpoints

|

|

Variable

|

Coefficient

|

Std. Error

|

t-Statistic

|

Prob.

|

|

LCHI(-1)

|

-0.143161

|

0.049681

|

-2.881580

|

0.0049

|

|

D(LCHI(-1))

|

-0.085940

|

0.098439

|

-0.873030

|

0.3849

|

|

D(LCHI(-2))

|

0.258343

|

0.087383

|

2.956429

|

0.0040

|

|

D(LCHI(-3))

|

-0.095600

|

0.065148

|

-1.467432

|

0.1457

|

|

D(LCHI(-4))

|

-0.014514

|

0.065283

|

-0.222318

|

0.8246

|

|

C

|

0.756703

|

0.255683

|

2.959537

|

0.0039

|

|

@TREND(1)

|

0.001091

|

0.000466

|

2.343729

|

0.0213

|

|

R-squared

|

0.240706

|

Mean dependent var

|

0.010244

|

|

Adjusted R-squared

|

0.190643

|

S.D. dependent var

|

0.046994

|

|

S.E. of regression

|

0.042277

|

Akaike info criterion

|

-3.420379

|

|

Sum squared resid

|

0.162651

|

Schwarz criterion

|

-3.235739

|

|

Log likelihood

|

174.5986

|

F-statistic

|

4.808026

|

|

Durbin-Watson stat

|

1.825193

|

Prob(F-statistic)

|

0.000265

|

Tableau 3

|

Augmented Dickey-Fuller Test Equation

|

|

Dependent Variable: D(LCHI)

|

|

Method: Least Squares

|

|

Date: 11/03/06 Time: 09:27

|

|

Sample(adjusted): 6 103

|

|

Included observations: 98 after adjusting endpoints

|

|

Variable

|

Coefficient

|

Std. Error

|

t-Statistic

|

Prob.

|

|

LCHI(-1)

|

-0.033474

|

0.017076

|

-1.960347

|

0.0530

|

|

D(LCHI(-1))

|

-0.161734

|

0.095219

|

-1.698557

|

0.0928

|

|

D(LCHI(-2))

|

0.216264

|

0.087583

|

2.469258

|

0.0154

|

|

D(LCHI(-3))

|

-0.114622

|

0.066200

|

-1.731445

|

0.0867

|

|

D(LCHI(-4))

|

-0.023143

|

0.066752

|

-0.346704

|

0.7296

|

|

C

|

0.199592

|

0.096459

|

2.069186

|

0.0413

|

|

R-squared

|

0.194872

|

Mean dependent var

|

0.010244

|

|

Adjusted R-squared

|

0.151115

|

S.D. dependent var

|

0.046994

|

|

S.E. of regression

|

0.043297

|

Akaike info criterion

|

-3.382176

|

|

Sum squared resid

|

0.172470

|

Schwarz criterion

|

-3.223912

|

|

Log likelihood

|

171.7266

|

F-statistic

|

4.453518

|

|

Durbin-Watson stat

|

1.792220

|

Prob(F-statistic)

|

0.001117

|

Tableau 4

|

Augmented Dickey-Fuller Test Equation

|

|

Dependent Variable: D(LCHI)

|

|

Method: Least Squares

|

|

Date: 11/03/06 Time: 09:30

|

|

Sample(adjusted): 6 103

|

|

Included observations: 98 after adjusting endpoints

|

|

Variable

|

Coefficient

|

Std. Error

|

t-Statistic

|

Prob.

|

|

LCHI(-1)

|

0.001814

|

0.000871

|

2.081873

|

0.0401

|

|

D(LCHI(-1))

|

-0.165452

|

0.096867

|

-1.708043

|

0.0910

|

|

D(LCHI(-2))

|

0.221491

|

0.089077

|

2.486503

|

0.0147

|

|

D(LCHI(-3))

|

-0.097583

|

0.066835

|

-1.460064

|

0.1476

|

|

D(LCHI(-4))

|

0.003725

|

0.066622

|

0.055908

|

0.9555

|

|

R-squared

|

0.157403

|

Mean dependent var

|

0.010244

|

|

Adjusted R-squared

|

0.121162

|

S.D. dependent var

|

0.046994

|

|

S.E. of regression

|

0.044055

|

Akaike info criterion

|

-3.357096

|

|

Sum squared resid

|

0.180496

|

Schwarz criterion

|

-3.225210

|

|

Log likelihood

|

169.4977

|

Durbin-Watson stat

|

1.780733

|

Tableau 5

|

Dependent Variable: LCHI

|

|

Method: Least Squares

|

|

Date: 11/03/06 Time: 09:51

|

|

Sample: 1 103

|

|

Included observations: 103

|

|

Variable

|

Coefficient

|

Std. Error

|

t-Statistic

|

Prob.

|

|

C

|

5.111040

|

0.024874

|

205.4760

|

0.0000

|

|

T

|

0.009528

|

0.000421

|

22.61219

|

0.0000

|

|

R-squared

|

0.835051

|

Mean dependent var

|

5.596955

|

|

Adjusted R-squared

|

0.833418

|

S.D. dependent var

|

0.311514

|

|

S.E. of regression

|

0.127143

|

Akaike info criterion

|

-1.267786

|

|

Sum squared resid

|

1.632693

|

Schwarz criterion

|

-1.216626

|

|

Log likelihood

|

67.29098

|

F-statistic

|

511.3112

|

|

Durbin-Watson stat

|

0.288682

|

Prob(F-statistic)

|

0.000000

|

Tableau 6

|

Dependent Variable: D(V)

|

|

Method: Least Squares

|

|

Date: 11/03/06 Time: 11:50

|

|

Sample(adjusted): 2 103

|

|

Included observations: 102 after adjusting endpoints

|

|

Variable

|

Coefficient

|

Std. Error

|

t-Statistic

|

Prob.

|

|

V(-1)

|

-0.285180

|

0.045400

|

-6.281433

|

0.0000

|

|

R-squared

|

0.275281

|

Mean dependent var

|

0.005994

|

|

Adjusted R-squared

|

0.275281

|

S.D. dependent var

|

0.068047

|

|

S.E. of regression

|

0.057928

|

Akaike info criterion

|

-2.849463

|

|

Sum squared resid

|

0.338925

|

Schwarz criterion

|

-2.823728

|

|

Log likelihood

|

146.3226

|

Durbin-Watson stat

|

1.874517

|

Tableau 7

|

ADF Test Statistic

|

-2.503384

|

1% Critical Value*

|

-2.5868

|

|

|

5% Critical Value

|

-1.9434

|

|

|

10% Critical Value

|

-1.6174

|

|

*MacKinnon critical values for rejection of hypothesis of a unit

root.

|

Tableau 8

|

Date: 11/03/06 Time: 10:08

|

|

Sample: 1 103

|

|

Included observations: 103

|

|

Autocorrelation

|

Partial Correlation

|

|

AC

|

PAC

|

Q-Stat

|

Prob

|

|

. |***** |

|

. |***** |

|

1

|

0.713

|

0.713

|

53.869

|

0.000

|

|

. |**** |

|

.*| . |

|

2

|

0.474

|

-0.069

|

77.917

|

0.000

|

|

. |*** |

|

. |*. |

|

3

|

0.378

|

0.136

|

93.388

|

0.000

|

|

. |*** |

|

. |** |

|

4

|

0.411

|

0.217

|

111.85

|

0.000

|

|

. |*** |

|

.*| . |

|

5

|

0.348

|

-0.101

|

125.18

|

0.000

|

|

. |*** |

|

. |*. |

|

6

|

0.331

|

0.162

|

137.40

|

0.000

|

|

. |** |

|

.*| . |

|

7

|

0.276

|

-0.068

|

145.97

|

0.000

|

|

. |** |

|

. | . |

|

8

|

0.266

|

0.065

|

154.02

|

0.000

|

|

. |** |

|

. | . |

|

9

|

0.208

|

-0.055

|

159.00

|

0.000

|

|

. |*. |

|

. | . |

|

10

|

0.196

|

0.030

|

163.46

|

0.000

|

|

. |*. |

|

. | . |

|

11

|

0.160

|

-0.018

|

166.48

|

0.000

|

|

. |*. |

|

. | . |

|

12

|

0.134

|

-0.044

|

168.63

|

0.000

|

|

. | . |

|

.*| . |

|

13

|

0.055

|

-0.085

|

168.99

|

0.000

|

|

. | . |

|

. | . |

|

14

|

0.032

|

0.002

|

169.11

|

0.000

|

|

. | . |

|

. | . |

|

15

|

0.045

|

0.050

|

169.36

|

0.000

|

|

. | . |

|

. | . |

|

16

|

0.060

|

-0.024

|

169.81

|

0.000

|

|

. | . |

|

. | . |

|

17

|

0.008

|

-0.044

|

169.81

|

0.000

|

|

. | . |

|

. | . |

|

18

|

-0.001

|

0.037

|

169.81

|

0.000

|

|

. | . |

|

. | . |

|

19

|

-0.004

|

-0.011

|

169.82

|

0.000

|

|

. | . |

|

.*| . |

|

20

|

-0.036

|

-0.086

|

169.99

|

0.000

|

|

.*| . |

|

.*| . |

|

21

|

-0.126

|

-0.115

|

172.09

|

0.000

|

|

.*| . |

|

. | . |

|

22

|

-0.166

|

-0.041

|

175.77

|

0.000

|

|

.*| . |

|

. | . |

|

23

|

-0.142

|

0.040

|

178.51

|

0.000

|

|

.*| . |

|

. | . |

|

24

|

-0.110

|

-0.006

|

180.17

|

0.000

|

|

.*| . |

|

. |*. |

|

25

|

-0.074

|

0.108

|

180.92

|

0.000

|

|

.*| . |

|

.*| . |

|

26

|

-0.091

|

-0.088

|

182.08

|

0.000

|

|

.*| . |

|

. | . |

|

27

|

-0.102

|

0.036

|

183.55

|

0.000

|

|

.*| . |

|

. | . |

|

28

|

-0.107

|

-0.006

|

185.21

|

0.000

|

|

.*| . |

|

. | . |

|

29

|

-0.092

|

0.009

|

186.43

|

0.000

|

|

.*| . |

|

. | . |

|

30

|

-0.086

|

0.013

|

187.52

|

0.000

|

|

.*| . |

|

.*| . |

|

31

|

-0.094

|

-0.067

|

188.85

|

0.000

|

|

.*| . |

|

. | . |

|

32

|

-0.115

|

0.012

|

190.87

|

0.000

|

|

.*| . |

|

. | . |

|

33

|

-0.088

|

0.038

|

192.08

|

0.000

|

|

.*| . |

|

. | . |

|

34

|

-0.078

|

-0.052

|

193.03

|

0.000

|

|

. | . |

|

. | . |

|

35

|

-0.052

|

0.035

|

193.46

|

0.000

|

|

.*| . |

|

. | . |

|

36

|

-0.058

|

-0.026

|

194.00

|

0.000

|

Tableau 9

|

Dependent Variable: V

|

|

Method: Least Squares

|

|

Date: 11/03/06 Time: 11:58

|

|

Sample(adjusted): 2 103

|

|

Included observations: 102 after adjusting endpoints

|

|

Variable

|

Coefficient

|

Std. Error

|

t-Statistic

|

Prob.

|

|

V(-1)

|

0.714820

|

0.045400

|

15.74480

|

0.0000

|

|

R-squared

|

0.709394

|

Mean dependent var

|

0.006663

|

|

Adjusted R-squared

|

0.709394

|

S.D. dependent var

|

0.107458

|

|

S.E. of regression

|

0.057928

|

Akaike info criterion

|

-2.849463

|

|

Sum squared resid

|

0.338925

|

Schwarz criterion

|

-2.823728

|

|

Log likelihood

|

146.3226

|

Durbin-Watson stat

|

1.874517

|

Tableau 10

|

ADF Test Statistic

|

-2.947845

|

1% Critical Value*

|

-2.5871

|

|

|

5% Critical Value

|

-1.9434

|

|

|

10% Critical Value

|

-1.6175

|

|

*MacKinnon critical values for rejection of hypothesis of a unit

root.

|

Graphique 2

Tableau 11

|

Dependent Variable: LCHI

|

|

Method: Least Squares

|

|

Date: 11/03/06 Time: 12:04

|

|

Sample(adjusted): 2 103

|

|

Included observations: 102 after adjusting endpoints

|

|

Variable

|

Coefficient

|

Std. Error

|

t-Statistic

|

Prob.

|

|

C

|

1.489058

|

0.227230

|

6.553078

|

0.0000

|

|

T

|

0.002287

|

0.000467

|

4.900640

|

0.0000

|

|

LCHI(-1)

|

0.715477

|

0.044498

|

16.07871

|

0.0000

|

|

R-squared

|

0.962574

|

Mean dependent var

|

5.608382

|

|

Adjusted R-squared

|

0.961818

|

S.D. dependent var

|

0.290550

|

|

S.E. of regression

|

0.056774

|

Akaike info criterion

|

-2.870497

|

|

Sum squared resid

|

0.319108

|

Schwarz criterion

|

-2.793292

|

|

Log likelihood

|

149.3954

|

F-statistic

|

1273.109

|

|

Durbin-Watson stat

|

1.992259

|

Prob(F-statistic)

|

0.000000

|

Graphique 3

* 11. Note de cours de

statistique approfondie, UNIKIN, Première Licence Economie

Mathématique, 2005-2006.

|