|

[I]

Epigraphie

« Confie-toi en l'Eternel de tout

ton coeur, de toute ton âme et de toutes tes forces. Ne t'appuie pas sur

ton propre intelligence, dans toutes tes voies tiens compte de lui et il rendra

droit tes sentiers, ne deviens pas sage à tes propres yeux, crains DIEU

et détourne- toi du mal, cela est santé pour ton âme et

rafraichissement pour tes os.»

Proverbe 3 : 5-8

[II]

DEDICACE

Nous rendons grâce à Dieu pour le courage et la

force qu'il nous a donnée tout au long de notre parcours à

l'Université de Kinshasa.

A nos parents NGYAMA MABILA Ephrem et MINZENZE PUNGU Victorine

pour tant des sacrifices et de souffrance consentie pour nos études.

A nos frères Dieudonné MUNDADI, Yannick NGYAMA,

Cédric KAPOKOTO, et nos soeurs Farida KIMBANDA, Divine MAMENGA, Patricia

MINZENZE pour leur encouragement et soutien moral.

A notre neveu Glody MUYEKE

Nous dédions ce travail

Richard KANGIAMA LWANGI

[III]

AVANT PROPOS

Au terme de ce travail, nous tenons à adresser nos vifs

remerciements aux personnes dont le concours nous a été

précieux pour sa réalisation.

Nous remercions particulièrement le professeur MANYA

DJADI LEONARD, qui a accepté volontiers de diriger ce mémoire,

malgré ses multiples occupations.

Notre profonde reconnaissance s'adresse à tout le corps

professoral du Département de Mathématiques et Informatique de

l'Université de Kinshasa pour avoir participé à notre

formation.

Aux chefs de travaux BATUBENGA, BUKANGA et les autres

Assistants pour leur soutien scientifique ; sans oublier le chef de travaux

Pierre KAFUNDA KATALAY pour son encadrement par des sages conseils.

A nos compagnons de la promotion et amis : Felly MANDA,

Jean-Jacques KATSHITSHI, Bijoux TOBO , Trésor

EBONDO, Billy MATIABA, Minion KITOKO ,Arnold

MANZO ,Freddy

KEREDJIM, KALOMBO KALO, Tito LUFUNGULA, Hendrik MITI ,Frémy MAKANGA, Ben

KANZOKA Laetitia LUSIMBA, ya ANNIE ODIMBA, Orchidée KINKO, Patience

LUFUNGULA, Kiki NDESHO ,Youyou MAYOKO, Trésor ALOMA, A toutes les mamans

du Secrétariat Général Académique et autres .

Nous remercions également les familles KINKO,

LUFUNGULA, FUNDJI et les BYM NODASA pour leur assistance morale et

spirituelle.

[IV]

LISTE DES FIGURES

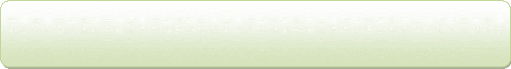

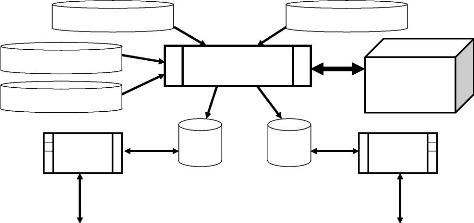

FIG I. 1:ARCHITECTURE GENERALE D'UN SYSTEME DECISIONNEL 7

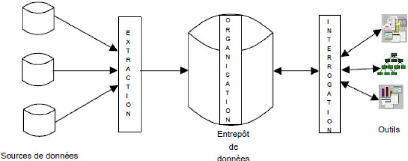

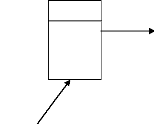

FIG II. 1:ARCHITECTURE D'UN ENTREPOT DE DONNEES 19

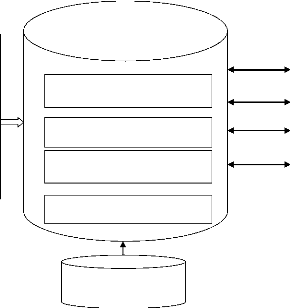

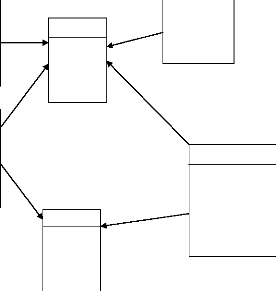

FIG II. 2:ARCHITECTURE D'UN DATAMART 25

FIG II. 3:EXEMPLE DE MODELISATION EN ETOILE 29

FIG II. 4:EXEMPLE DE MODELISATION EN FLOCON DE NEIGE 31

FIG II. 5:EXEMPLE DE MODELISATION EN CONSTELLATION 32

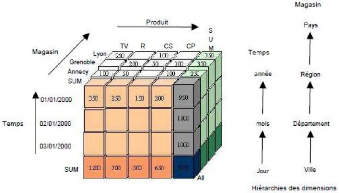

FIG II. 6:EXEMPLE DE SCHEMA MULTIDIMENSIONNEL 33

FIG II. 7: ARCHITECTURE ROLAP 36

FIG II. 8:ARCHITECTURE MOLAP 37

FIG II. 9:ARCHITECTURE HOLAP 38

FIG III 1:ARBRE DE DECISION CONSTRUIT A PARTIR DE L'ATTRIBUT

AGE 54

FIG III 2:ARBRE DE DECISION FINALE 55

FIG IV 1:ORGANIGRAMME 63

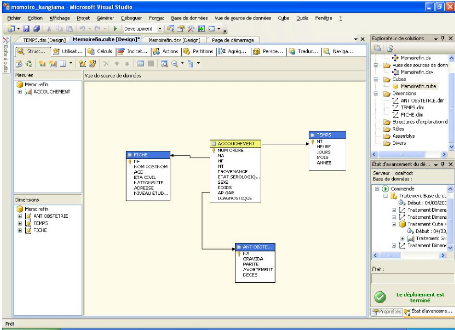

FIG IV 2:MODELE CONCEPTUEL DES DONNEES 67

FIG IV 3:MODELE LOGIQUE DE DONNEES 68

FIG IV 4:SCHEMA EN ETOILE DES ACCOUCHEMENTS 72

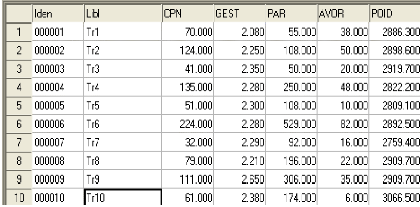

FIG IV 5:VUE DE L'ENSEMBLE DES DONNEES AVEC SPAD 74

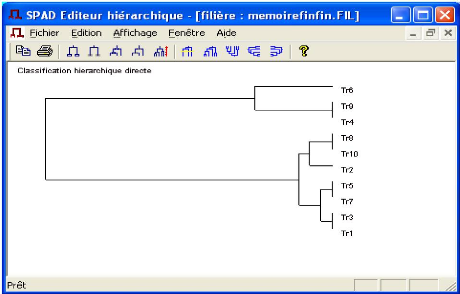

FIG IV 6:ARBRE DE DECISION 77

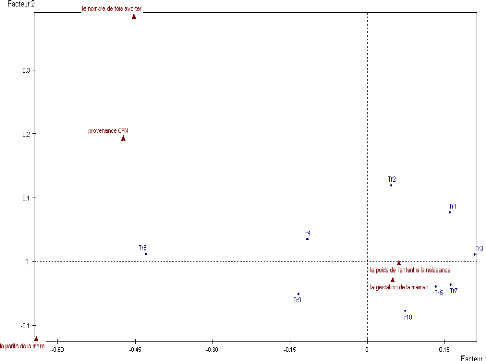

FIG IV 7:GRAPHIQUE 78

FIG IV 8:DIAGRAMME DE CLASSE 83

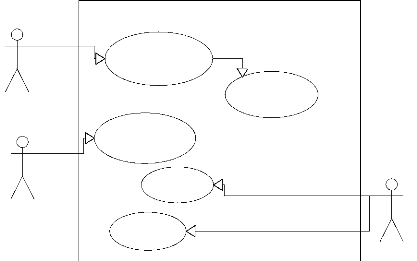

FIG IV 9:DIAGRAMME DE CAS D'UTILISATION 84

FIG IV 10:DIAGRAMME DE SEQUENCE 84

FIG IV 11:DIAGRAMME DE SEQUENCE ANALYSE OLAP 85

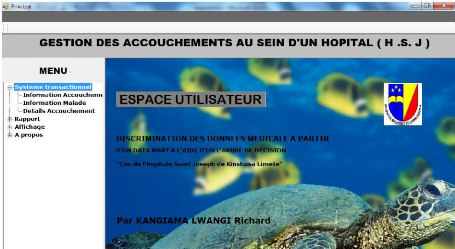

FIG IV 12:FORMULAIRE DE SECURITE 85

FIG IV 13:FORMULAIRE DE MENU PRINCIPALE 86

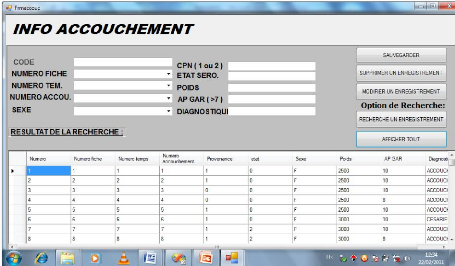

FIG IV 14:FORMULAIRE ACCOUCHEMENT 86

[V]

LISTE DES TABLEAUX

TABLEAU II 1:DIFFERENCE ENTRE SGBD ET ENTREPOTS DE DONNEES

22

TABLEAU II 2:COMPARE LES CARACTERISTIQUES DES SYSTEMES 23

TABLEAU III 1:LA METHODOLOGIE A NEUF ETAPES DE KIMBALL 28

TABLEAU III 2:LE TACHES ET TECHNIQUE DU DATAMINING. 45

TABLEAU III 3:EXEMPLES PRATIQUES 52

TABLEAU IV 1:REPARTITION DE MODULE DE SQL SERVEUR 2008 PAR

COMPOSANTE. 66

[VI]

LISTE DES ABREVIATIONS

SID : Système d'informatique décisionnel

OLAP : Online analytical processing

OLTP : Online transactonal processing

ETL : Extract transform and load

SGBD : Système de gestion de base des données

MDO : Magasin des données opérationnelles

ODS : Operational data store

ROLAP : Relational olap

MOLAP : Multidimensional olap

HOLAP :Hybrid olap

BD :Base de données

DW :Datawerahouse

[1]

INTRODUCTION

La prise de décision est un problème essentiel

qui préoccupe les gestionnaires des entreprises. Cette prise de

décision passe par la modélisation des différents

problèmes qu'ils rencontrent dans la gestion, d'où la

nécessité d'un modèle basé sur l'arbre de

décision.

L'entrepôt de données étant une vision

centralisée et universelle de toutes les informations de l'entreprise,

C'est une structure qui a pour but, contrairement aux bases de données,

de regrouper les données de l'entreprise pour des fins analytiques et

pour aider le manager à la prise de décision

stratégique.

Une décision stratégique est une action

entreprise par les décideurs de l'entreprise qui vise à

améliorer, quantitativement ou qualitativement, la performance de

l'entreprise.

Un problème d'extraction de connaissances consiste

à extraire les connaissances à partir d'un entrepôt de

données ou d'une autre source de données en utilisant les

techniques du Datamining (arbre de décision, réseaux bayesien,

réseaux de neurones, etc.).

0 .PROBLEMATIQUE

Vu la capacité d'accueil de l'Hôpital Saint

Joseph , vu le nombre de consultations et des accouchements au sein de cet

hôpital, le décideur qui est le médecin directeur se

présente devant une grande quantité des données

éparpillées dans des différents fichiers Excel .

Le décideur a besoin d'avoir les informations sur

toutes les données éparpillées.

C'est pourquoi nous avons réalisé notre

système d'aides à la prise de décision qui permettra de

réunir toutes les données afin d'en faire des analyses.

[2]

1 .INTERET DU TRAVAIL

Le choix de ce sujet porte sur un double aspect, d'abord il

est question de répondre au schéma de nos inspirations qui est

d'approfondir la notion d'informatique décisionnelle pour essayer de les

appliquer dans la vie courante et professionnelle et ensuite de réaliser

un outil de travail pour la maternité de l'Hôpital Saint Joseph de

Kinshasa Limete.

2 .METHODOLOGIE

Dans le cadre de notre travail, nous allons mettre en place

une application informatique qui permettra au décideur de prendre une

décision et anticiper les événements sur les

accouchements.

Pour notre système nous aurons un fichier Excel que

nous allons intégrer dans une base de données

opérationnelles qui est comme base de données transactionnelles

.Nous allons utiliser les datamining pour explorer les données de notre

DataMart en vue de faire l'extraction.

Pour la construction de notre DataMart nous allons utiliser la

méthodologie de Raph Kimball.

Elle nous a présenté la faveur d'aller sur terrain,

de récolter les

données ; et nous avons utilisé la technique

d'interview, questionnaire et la documentation pour la récolte des

données.

3. DELIMITATION DU TRAVAIL

Pour parler de la délimitation du travail qui consiste

à évoquer sa précision dans le temps et dans l'espace.

Ainsi, nous sommes limité à concevoir un système

décisionnel pour la maternité et nous avons réalisé

une application opérationnelle pour la maternité qui permettra

aux agents de la maternité de saisir les informations sur les

accouchements.

Ensuite nous avons utilisé l'arbre de décision

comme outil de datamining pour l'extraction de données dans notre

DataMart pour la prise de décision. Notre travail a été

réalisé pour la

[3]

maternité de l'Hôpital Saint Joseph de Kinshasa

Limete pendant l'année 2010.

4. PLAN DU TRAVAIL

Outre l'introduction et la conclusion, notre travail comprend

quatre chapitres.

Le premier chapitre reprend les concepts sur

les systèmes décisionnels, nous définissons les

systèmes décisionnels et ses enjeux.

Le deuxième chapitre traite des

entrepôts des données où nous expliquons les

différents concepts relatifs aux entrepôts de données et

ses différents serveurs.

Le troisième chapitre porte sur le

datamining et l'arbre de décision.

Le quatrième chapitre est

consacré à l'implémentation qui est notre contribution

personnelle.

[4]

CHAPITRE I : LES SYSTEMES DECISIONNELS

[17], [18], [7], [19]

I .1 INTRODUCTION

Dans ce chapitre nous allons définir le système

décisionnel et donner quelques concepts relatifs au business intelligent

avec des applications pour boucler par une conclusion.

Notons qu'un nombre plus important d'acteurs des entreprises

éprouvent des difficultés dans le processus de la prise de

décision notamment dans la conception et les choix des outils à

implanter.

Le marche du décisionnel ne cesse d'exploser surtout

avec l'investissement de plusieurs grandes sociétés qui

souhaitent instaurer un système de business intelligence dans leur

organisation. Sa mise en oeuvre demande des expertises et nécessite une

maitrise d'ouvrage de la part des informaticiens concepteurs.

I.1.0 L'INFORMATIQUE DECISIONNELLE [18]

l'informatique décisionnelle désigne les moyens,

les outils et les méthodes qui permettent de collecter, consolider,

modéliser et restituer les données, matérielles ou

immatérielles d'une entreprise en vue d'offrir une aide a la

décision et de permettre aux responsables de prendre des

stratégie pour l'entreprise et d'avoir une vue d'ensemble de

l'activité traitée au sein de l'entreprise.

En générale, ce type d'application utilise un

entrepôt de données pour stocker des données transverses

provenant de plusieurs sources hétérogènes et fait appel a

des traitements par lots pour la collecte de ces informations.

L'informatique décisionnelle s'insère dans

l'architecture plus large d'un système d'information.

[5]

Néanmoins l'informatique décisionnelle n'est pas

un concept concurrent du management du système d'information.

Au même titre que le management relève de la

sociologie et de l'économie, la gestion par l'informatique est

constitutive de deux domaines radicalement différents que sont le

management et l'informatique.

Afin d'enrichir le concept avec ces deux modes de

pesées, il est possible d'envisager un versant oriente ingénierie

de l'informatique portant le nom d'informatique décisionnelle, et un

autre versant servant plus particulièrement les approches de gestion

appelé management du système d'information.

Pour expliciter ce concept, nous posons ces deux questions :

pourquoi le décisionnel et qui a besoin du décisionnel ?

1.1.1 POURQUOI LE DECISIONNEL [19]

Le décisionnel ne concerne souvent que les entreprises

qui gèrent un historique des événements passés

(faits, transactions etc.). Les entreprises qui viennent de naitre n'ont

souvent pas besoin de faire du décisionnel car elles n'ont pas encore

besoin de catégoriser ou de fidéliser leurs clients.

Le souci majeur pour elles serait plutôt d'avoir le

maximum de clients. Et c'est âpres en avoir récupère un

grand nombre qu'elles penseront certainement à les fidéliser et

leur proposer d'autres produits susceptibles de les intéresser. C'est ce

que l'on appelle Customer Relationship management.

Finalement, le troisième processus correspond à

l'interrogation qui se place entre l'entrepôt et les

[6]

1.1.2 QUI A BESOIN DU DECISIONNEL [19J

Comme cela peut se deviner, les décideurs sont les

principaux utilisateurs des systèmes décisionnels. Les

décideurs sont généralement des analystes. Ces derniers

établissent des plans qui leur permettent de mieux cibler leurs clients,

de les fidéliser.

Et pour cela, ils ont besoin d'indicateurs et des

données résumées de leur activités (ils n'ont

souvent besoin de détail que pour des cas spécifiques).

Par exemple, contrairement aux systèmes relationnels

(ou base gestion) ou les utilisateurs chercheront à connaitre leurs

transactions pour faire un bilan, les systèmes décisionnels eux

cherchent plutôt à donner un aperçu global pour connaitre

les tendances des clients d'où l'opposition des deux modes quantitatif

pour le système relationnel par contre qualitatif pour le système

décisionnel.

1.1.3 ARCHITECTURE DE SYSTEME DECISIONNEL [7]

L'architecture générale d'un système

décisionnel qui se décompose en trois processus : extraction et

intégration, organisation et interrogation.

Nous trouvons le processus d'extraction intégration

entre les sources de données et l'entrepôt.

Ce processus est responsable de l'indentification des

données dans les diverses sources internes et externes ;

De l'extraction de l'information qui nous intéresse et

de la préparation et de la transformation (nettoyage, filtrage, etc..)

des données à l'intérieur de l'entrepôt, nous

trouvons le processus d'organisation, il est responsable de structurer les

données par rapport à leur niveau de granularité

(agrégats).

[7]

différents outils pour arriver à l'analyse des

données, pour les différents utilisateurs de l'entreprise.

FIG I. 1:Architecture Générale d'un système

décisionnel

I.2 LES DIFFERENTS ELEMENTS CONSTITUTIFS DU SYSTEME

DECISIONNEL [19]

1.2.1 .1 LES SOURCES DE DONNEES

Les sources de données sont souvent diverses et

variées et le but est de trouver des outils et afin de les extraire, de

les nettoyer, de les transformer et de les mettre dans l'entrepôt de

données .Ces sources de données peuvent être de fichier du

type Excel, base de données opérationnelle d'une entreprise ou

fichier plat.

I.2.1 L'ENTREPOT DE DONNEES

Il est le coeur du système décisionnel et

demande une analyse profonde de la part de la maitre d'ouvrage. La conception

d'un DataWarehouse diffère de la conception d'une base de données

relationnelle.

En effet, alors que les bases de données relationnelles

tendent le plus souvent à être normalisées, les bases de

données multidimensionnelles, elles, sont de normalisées

respectant le modèle en étoile ou le modèle en flocon.

[8]

1.2.3 LE SERVEUR OLAP OU SERVEUR D'ANALYSE

Le serveur OLAP est opposé à OLTP et a pour but

d'organiser les données à analyser par domaine ou par

thème et d'en ressortir des résultats pertinents pour le

décideur. Les résultats sont donc des résumés et

peuvent être obtenus par différents algorithmes de datamining

(fouille de données) du serveur d'analyse.

Ces résultats peuvent amener l'organisation à

prendre des très bonnes décisions en vue d'améliorer le

rendement de leurs entreprises.

1.2.4 LE GENERATEUR D'ETATS

Le générateur d'état permet seulement de

mieux appréhender le résultat de l'analyse. L'utilisateur final

n'étant pas forcement un informaticien, il aura plus de facilité

dans des états business objets (ou même dans des feuilles de

données Excel) avec des diagrammes et courbes statistiques que d'aller

directement requêter dans le serveur d'analyse. Les états

permettent également de faire de l'exploration ou la navigation sur de

données.

I.3 LES ENJEUX DE L'INFORMATIQUE DECISIONNELLE [18]

De nos jours, les données applicatives métier

sont stockées dans une ou plusieurs bases de données

relationnelles ou non relationnelles. Ces données sont extraites,

transformées et chargées dans un entrepôt de données

généralement par un outil de type ETL.

Un entrepôt de données peut prendre la forme d'un

DataWarehouse ou d'un DataMart. en règle générale, le

DataWarehouse globalise toutes les données applicatives de l'entreprise,

tandis que les DataMarts généralement alimentes depuis les

données du DataWarehouse sont des sous-ensembles

[9]

d'informations concernant un métier particulier de

l'entreprise assurance ,marketing, risque, contrôle de gestion ,sante

etc.

Les entrepôts de données permettent de produire

des rapports qui répondent à la question « que s'est-il

passé ? », mais ils peuvent être également

conçus pour répondre à la question analytique «

pourquoi est-ce que cela s'est passé ? » et à la question

pronostique « que va-t-il se passer ? ». Dans un contexte

opérationnel, ils répondent également à la question

« que se passe-t-il en ce moment ? », voire dans le cas d'une

solution d'entrepôt de données actif « que devrait-il se

passer ? ».

I .4 METHODES D'ANALYSE DECISIONNELLE

A. DU TABLEAU A L'HYPER CUBE

L'informatique décisionnelle s'attache à mesurer

:

Un certain nombre d'indicateurs ou de mesures (que l'on

appelle

aussi les faits ou les métriques), Restitues selon les

axes

d'analyse (que l'on appelle aussi les dimensions).

LE TABLEAU

A titre d'exemple considérons les données sur les

naissances des

enfants à l'hôpital saint joseph de LIMETE.

On peut vouloir mesurer :

Trois indicateurs : les recettes totales des accouchements, le

nombre de naissances, le montant de taxes pour chaque accouchement,

Le premier axe, représente l'axe temps : par

année, par trimestre, par mois,

Et le un second, l'axe par catégorie : naissance

normale, naissance césarienne, cas complique. On obtient ainsi un

tableau à deux entrées :

Par exemple en lignes : la nomenclature des naissances a 3

niveaux (naissance normale, naissance par césarienne,

naissance par cas compliqué), et en colonnes : les années,

décomposées en trimestres, puis en mois, avec au croisement des

lignes et colonnes, pour chaque cellule : les recettes totales des

accouchements, le nombre de naissance et le montant de taxe par

accouchement.

[10]

B. LE CUBE

Si l'on s'intéresse à un troisième axe

d'analyse :

Par exemple, la répartition géographique : par

district, par commune, par localité, on obtient une dimension de plus et

on passe ainsi au cube. Avec les tableaux croises dynamiques d'Excel permet

aussi de représenter ce type de cube avec le champ "page".

C. L'HYPER CUBE

Si l'on s'intéresse à un axe d'analyse

supplémentaire :

Par exemple, la segmentation des responsables : par

catégorie, par profession, on obtient alors un cube à plus de

trois dimensions, appelé hyper cube.

Le terme cube est souvent utilise en lieu et place d'

hyper cube.

D. LA NAVIGATION DANS UN HYPER CUBE

Les outils du monde décisionnel offrent des

possibilités de navigation dans les différentes dimensions du

cube ou de l'hyper cube avec ses différentes opération drill down

(la forage avant), slice and dice (le forage arrière), slice and dice et

le drill throuth dans les lignes qui suivent nous allons expliquer en claire

ces différentes possibilité de navigue dans un cube.

Le forage avant ou le drill down:

est la possibilité de zoomer sur une dimension (par

exemple d'éclater les années en quatre trimestres pour avoir une

vision plus fine, ou de passer du district aux différentes communes),

Le forage arrière ou le drill up

appelé aussi roll-up : représente une

l'opération inverse qui permet d' agréger les composantes de l'un

des axes ,par exemple de regrouper les mois en trimestre, ou de totaliser les

résultats des analyses différentes communes pour avoir le total

par districts.

Le slice and dice, aussi

appelé dice down: est une opération

plus complexe qui entraine une permutation des axes d'analyse, par exemple, on

peut vouloir remplacer une vue par district/commune par une nouvelle vue par

les naissances normale et naissances césarienne.

Le drill through : lorsqu'on ne

dispose que de données agrégées (indicateurs totalises),

le drill through permet d'accéder au détail

élémentaire des informations.

[11]

I.5 FONCTIONS ESSENTIELLES DE L'INFORMATIQUE

DECISIONNELLE

Un système d'information décisionnel assure

quatre fonctions fondamentales, à savoir la collecte,

l'intégration, la diffusion et la présentation des

données. à ces quatre fonctions s'ajoute une fonction de

contrôle du système d'information décisionnelle

lui-même, l'administration.

I.5.1COLLECTE

La collecte est l'ensemble des taches consistant à

détecter, à sélectionner, à extraire et a filtrer

les données brutes issues des environnements pertinents compte tenu du

périmètre du SID.

Les sources de données internes ou externes

étant souvent hétérogènes tant sur le plan

technique que sur le plan sémantique, cette fonction est la plus

délicate à mettre en place dans un système

décisionnel complexe. Elle s'appuie notamment sur des outils d'ETL.

Cette alimentation utilise les données sources issues

des systèmes transactionnels de production, le plus souvent sous forme

de :

Compte-rendu d'événement ou compte-rendu

d'opération : c'est le constat au fil du temps des opérations

(achats, ventes, écritures comptables), le film de l'activité de

l'entreprise.

Compte-rendu d'inventaire ou compte-rendu de stock : c'est

l'image photo prise à un instant donné (à une fin de

période : mois, trimestre) de l'ensemble du stock (les clients, les

contrats, les commandes, les encours).

La fonction de collecte joue également, au besoin, un

rôle de recodage.

Une donnée représentée

différemment d'une source à une autre impose le choix d'une

représentation unique pour les futures analyses.

[12]

I.5.2 INTEGRATION

L'intégration consiste à concentrer les

données collectées dans un espace unifié, dont le socle

informatique essentiel est l'entrepôt.

Élément central du dispositif, il permet

aux applications décisionnelles de

bénéficier d'une source d'information commune, homogène,

normalisée et fiable, susceptible de masquer la diversité de

l'origine des données.

Au passage les données sont épurées ou

transformées par :

un filtrage et une validation des données en vue du

maintien de la cohérence d'ensemble (les valeurs acceptées par

les filtres de la fonction de collecte mais susceptibles d'introduire des

incohérences de référentiel par rapport aux autres

données doivent être soit rejetées, soit

intégrées avec un statut spécial) .

Une synchronisation (d'intégrer en même temps ou

à la même date de valeur des événements reçus

ou constates de manière décalée ou

déphasée).

Une certification (pour rapprocher les données de

l'entrepôt des autres systèmes légaux de l'entreprise comme

la comptabilité ou les déclarations réglementaires).

C'est également dans cette fonction que sont effectues

éventuellement les calculs et les agrégations (cumuls) communs

à l'ensemble du projet.

La fonction d'intégration

est

généralement assurée par la gestion de

métadonnées, pour l'interopérabilité entre toutes

les ressources informatiques, des données structurées (bases de

données accédées par des progiciels ou applications), ou

des données non structurées .

[13]

I.5.3 DIFFUSION OU LA DISTRIBUTION

La diffusion met les données à la disposition

des utilisateurs, selon des schémas correspondant au profil ou au

métier de chacun, sachant que l'accès direct à

l'entrepôt ne correspondrait généralement pas aux besoins

d'un décideur ou d'un analyste.

L'objectif prioritaire est de segmenter les données en

contextes informationnels fortement cohérents, simples à utiliser

et correspondant à une activité décisionnelle

particulière.

Alors qu'un entrepôt de données peut

héberger des centaines ou des milliers de variables ou indicateurs, un

contexte de diffusion raisonnable n'en présente que quelques dizaines au

maximum.

Chaque contexte peut correspondre à un DataMart, bien

qu'il n'y ait pas de règles générales concernant le

stockage physique.

Très souvent, un contexte de diffusion est

multidimensionnel, c'est-à-dire modélisable sous la forme d'un

hyper cube , il peut alors être mis à disposition à l'aide

d'un outil OLAP.

Les différents contextes d'un même système

décisionnel n'ont pas tous besoin du même niveau de

détail.

De nombreux agrégats ou cumuls, n'intéressant

que certaines applications et n'ayant donc pas lieu d'être gères

en tant qu'agrégats communs par la fonction d'intégration,

relèvent donc de la diffusion.

Ces agrégats peuvent être, au choix, stockes de

manière persistante ou calcules dynamiquement a la demande.

On peut distinguer trois questions à élucider

pour concevoir un système de reporting :

À qui s'adresse le rapport spécialise ? (choix

des indicateurs a présenter, choix de la mise en page)

Par quel trajet ? (circuit de diffusion type workflow pour les

personnes, circuits de transmission télécoms pour les moyens)

[14]

Selon quel agenda ? (diffusion routinière ou sur

événement prédéfini)

I.5.4 PRESENTATION

Cette quatrième fonction, la plus visible pour

l'utilisateur, régit les conditions d'accès de l'utilisateur aux

informations. Elle assure le fonctionnement du poste de travail, le

contrôle d'accès, la prise en charge des requêtes, la

visualisation des résultats sous une forme ou une autre.

Elle utilise toutes les techniques de communication possibles

comme les outils bureautiques, raquetteurs et générateurs

d'états spécialises, infrastructure web,

télécommunications mobiles, etc.

I.5.5 ADMINISTRATION

C'est la fonction transversale qui supervise la bonne

exécution de toutes les autres. elle pilote le processus de mise

à jour des données, la documentation sur les données et

sur les métadonnées, la sécurité, les sauvegardes,

la gestion des incidents.

I.5.6 LES PHASES DU PROCESSUS DECISIONNEL

? Phase de recueil des exigences

Trois domaines doivent être particulièrement

documentes :

Le type d'information dont l'utilisateur des rapports a

besoin.

Le type de restitution (ergonomie, fréquence, vitesse

de

restitution) .

Le système technique existant : technologies

utilisées

? Phase de conception et de choix technique :

En fonction des exigences recueillies, quels sont les

éléments de

la chaine de la valeur décisionnelle qui doivent

être

implémentes ?

Doit-on seulement créer un rapport sur un cube OLAP

existant ?

[15]

Construire toute la chaine ?

Quelles sont précisément les données que

l'on doit manipuler ? Cela conduit au choix de technologies précises et

a un modèle particulier.

[16]

I.6 CONCLUSION

Dans ce chapitre, nous avons traite le sujet de système

décisionnel, nous avons définit l'informatique

décisionnel, l'architecture de système décisionnel, ses

différents enjeux avec leurs fonction y compris les phases du processus

dans un système décisionnel.

[17]

CHAPITRE II : LES ENTREPOTS DE DONNEES

[8], [1], [16], [5], [7]

II.1 INTRODUCTION

Les entrepôts des données intègrent les

informations en provenance de différentes sources, souvent reparties et

hétérogènes ayant pour objectif de fournir une vue globale

de l'information aux analystes et aux décideurs.

La construction et la mise en oeuvre d'un entrepôt de

données représentent une tache complexe qui se compose de

plusieurs étapes.

La première à l'analyse des sources de

données et à l'identification des besoins des

utilisateurs, la deuxième correspond à l'organisation des

données à l'intérieur de l'entrepôt. Finalement, la

troisième sert à établir divers outils d'interrogation,

analyse, de fouille de données.

Chaque étape présente

des

problématiques spécifiques. Ainsi, par exemple, lors de la

première étape, la difficulté principale consiste en

l'intégration des données, de manière a qu'elles soient de

qualité pour leur stockage .pour l'organisation, il existe plusieurs

problèmes comme : la sélection des vues a matérialiser, le

rafraichissement de l'entrepôt, la gestion de l'ensemble de

données courantes et historisées.

En ce qui concerne le processus d'interrogation, nous avons

besoin des outils performants et conviviaux pour l'accès et l'analyse de

l'information.

Notre travail se focalise principalement

sur une étape du processus décisionnel, avec une

proposition de la définition d'un modèle multidimensionnel, pour

boucle par une conclusion.

[18]

II.2.1 DEFINITION CLASSIQUE D'UN ENTREPOT DES DONNEES

(5J , (7J

Un entrepôt de données est une collection de

données orientées sujet, intégrées, non volatiles

et historisées, organisées pour le support d'un processus d'aide

a la décision. Nous détaillons ces caractéristiques

Orientées sujet : les données

des entrepôts sont organises par sujet plutôt que par application :

par exemple, une chaine de magasins d'alimentation organise les données

de son entrepôt par rapport aux ventes qui ont été

réalisées par produit et par magasin, au cours d'un certain

temps.

Intégrées : les données

provenant des différentes sources doivent être

intégrées, avant leur stockage dans l'entrepôt de

données. L'intégration c'est à dire la mise en

correspondance des formats, permet d'avoir une cohérence de

l'information.

Non volatiles : a la différence des

données opérationnelles, celles de l'entrepôt sont

permanentes et ne peuvent pas être modifiées .le rafraichissement

de l'entrepôt consiste à ajouter de nouvelles données, sans

modifier ou perdre celles qui existent. historisées :la

prise en compte de l'évolution des données est essentielle pour

la prise de décision qui, par exemple, utilise des techniques de

prédication en s'appuyant sur les évolutions passées pour

prévoir les évolutions futures.

II.2.2 ARCHITECTURE D'UN ENTREPOT DE DONNEES (5J

L'architecture des entrepôts de données repose

souvent sur un SGBD séparé du système de production de

l'entreprise qui contient les données de l'entrepôt.

Le processus d'extraction des données permet

d'alimenter périodiquement ce SGBD. Néanmoins avant

d'exécuter ce processus, une phase de transformation est

appliquée aux données opérationnelles.

Celle-ci consiste à les préparer (mise en

correspondance des formats de données), les nettoyer, les filtrer,...,

pour finalement aboutir a leur stockage dans l'entrepôt.

[19]

Dans cette figure II.1, nous présentons une

architecture simplifiée d'un entrepôt selon Doucet et Gangarski.

Les différents composants ont été intègres dans

trois parties : les sources de données, l'entrepôt et les outils

existants dans le marche.

Données de production (SGBD ,ODS, système

légués)

O U T I L S

Données externes

E T

L

Données légèrement résumées

Données fortement résumées

Entrepôt de données

Données anciennes Archivées

Données de détail

Métadonnées

FIG II. 1:Architecture d'un entrepôt de données

a) les sources : les données de l'entrepôt sont

extraites de diverses sources souvent reparties et

hétérogènes, et qui doivent être transformées

avant leur stockage dans l'entrepôt.

Nous avons deux types de sources des donnes : internes et

externes a l'organisation :

Internes : la plupart des données sont saisies

à partir des différents systèmes de production qui

rassemblent les divers SGBD opérationnels, ainsi que des anciens

systèmes de production qui contiennent des données encore

exploitées par l'entreprise.

Externes : ils représentent des données

externes à l'entreprise et qui sont souvent achetées.

Magasin des données opérationnel (ODS

operational data store) : c'est un mini annuaire des données

opérationnelles actualisées et

[20]

intégrées aux analyses pour un

département spécifique au sein de l'entreprise.

b) Les types de données de l'entrepôt de

données : il existe plusieurs types de données dans un

entrepôt, qui correspondent a diverses utilisations, comme :

Données de détail courantes : ce sont

l'ensemble des données quotidiennes et plus couramment utilisées.

Ces données sont généralement stockées sur le

disque pour avoir un accès rapide. Par exemple, le détail des

ventes de l'année en cours, dans les différents magasins.

Données de détail anciennes : ce sont

des données quotidiennes concernant des événements

passés, comme par exemple le détail des ventes des deux

dernières années. Nous les utilisons pour arriver à

l'analyse des tendances ou des requêtes prévisionnelles.

Néanmoins ces données sont plus rarement utilisées que les

précédentes, et elles sont souvent stockes sur des

mémoires d'archives.

Donnes résumées ou agrégées :

ce sont des données moins détaillées que les deux

premières et elles permettent de réduire le volume des

données a stocker. Le type de données, en fonction de leur niveau

de détail, permet de les classifier commandes données

légèrement ou fortement résumées.

Les métadonnées : ce sont des

données essentielles pour parvenir a une exploitation efficace du

contenu d'un entrepôt. Elles représentent des informations

nécessaires a l'accès et l'exploitation des données dans

l'entrepôt comme : la sémantique (leur signification), l'origine

(leur provenance), les règles d'agrégation (leur

périmètre), le stockage (leur format, par exemple : francs,

euro,...) et finalement l'utilisation (par quels programmes sont-elles

utilisées).

Données archives et sauvegarder : cette partie

de l'entrepôt emmagasine les données détaillées

résumées pour le besoins d'archivage et de sauvegarde.les

données sont transférées dans des stockages d'archivage

tel que des bandes magnétiques ou disques optiques.

d) outils : il existe sur le marché différents

outils pour l'aide à la décision, comme les outils de fouille de

données ou datamining

[21]

(pour découvrir des liens sémantiques), outils

d'analyse en ligne (pour la synthèse et l'analyse des données

multidimensionnelles), outils d'interrogation (pour faciliter l'accès

aux données en fournissant une interface conviviale au langage de

requêtes).

II.2.3 ENTREPOTS ET LES BASES DE DONNEES [7]

Dans l'environnement des entrepôts de données,

les opérations, l'organisation des données, les critères

de performance, la gestion des métadonnées, la gestion des

transactions et le processus de requêtes sont très

différents des systèmes de bases de données

opérationnels.

Par conséquent, les SGBD relationnels orientes vers

l'environnement opérationnel, ne peuvent pas être directement

transplantes dans un système d'entrepôt de données.

Les SGBD ont été crées pour les

applications de gestion de systèmes transactionnels.

Par contre, les entrepôts de données ont été

conçus pour l'aide a la prise de décision. Ils intègrent

les informations qui ont pour objectif de fournir une vue globale de

l'information aux analystes et aux décideurs.

[22]

Le tableau II.1 résume ces différences entre les

systèmes de gestion de bases de données et les entrepôts de

données.

|

SGBD

|

entrepôts de données

|

|

Objectifs

|

gestion et

production

|

consultation et

analyse

|

|

Utilisateurs

|

gestionnaires de

production

|

décideurs, analystes

|

|

taille de la base

|

plusieurs giga-octets

|

plusieurs téraoctets

|

|

organisation des

données

|

par traitement

|

par métier

|

|

type de données

|

données de gestion (courantes)

|

données d'analyse

(résumées, historisées )

|

|

Requêtes

|

simples,

prédéterminées ,données

détaillées

|

complexes ,spécifiques, agrégations et group

by

|

|

Transactions

|

courtes et

nombreuses, temps réel

|

longues ,peu

nombreuses

|

Tableau II 1:Différence entre SGBD et entrepôts de

données

II.2.4 SYSTEMES TRANSACTIONNELS ET SYSTEMES DECISIONNELS

:

Les SGBD ont été crées pour gérer

de grands volumes d'information contenus dans les différents

systèmes opérationnels qui appartiennent a l'entreprise.

Ces données sont manipulées en utilisant des

processus transactionnels en ligne .parallèlement à

l'exploitation de l'information contenue dans ces systèmes

opérationnels, les dirigeants des entreprises ont besoin d'avoir une

vision globale concernant toute cette information pour faire des calculs

prévisionnels, des statistiques ou pour établir des

stratégies de développement et d'analyses des tendances.

[23]

|

système transactionnel

|

système décisionnel

|

|

Données

|

Exhaustives courantes dynamiques

|

Résumées historiques statiques

|

|

orientées applications

|

orientées sujets

|

|

|

(d'analyse)

|

|

utilisateurs

|

Nombreux

|

peu nombreux

|

|

varies (employés,

directeurs)

|

uniquement les

décideurs

|

|

concurrentes

|

non concurrents

|

|

mises à jour et

|

interrogations

|

|

interrogations

|

requêtes imprévisibles et

|

|

requêtes prédéfinies réponses

immédiates

|

complexes

réponses moins rapides

accès a de nombreuses

|

|

accès a peu d'information

|

informations

|

Tableau II 2:compare les caractéristiques des

systèmes

II.2.5 DATAMART OU MINI - ENTREPOT DES

DONNEES [16]

II.2.5.1 INTRODUCTION

Un DataMart est un sous-ensemble d'un entrepôt de

données; il est généralement exploité dans les

entreprise pour restituer des informations ciblées sur un métier

spécifique, constituant pour ce dernier un ensemble d'indicateurs

à vocation de pilotage de l'activité et d'aide à la

décision. Un DataMart, selon les définitions, est issu ou fait

partie d'un DataWarehouse, et en reprend par conséquent la plupart des

caractéristiques.

[24]

II.2.5.2 LES DEFINITIONS

Le DataMart est un ensemble de données ciblées,

organisées, regroupées et agrégées pour

répondre à un besoin spécifique à un métier

ou un domaine

donné. il est donc destine à

être interrogé sur un panel de données restreint à

son domaine fonctionnel, selon des paramètres qui auront

été définis à l'avance lors de sa conception.

De façon plus technique, le DataMart peut être

considère de deux manières différentes, attribuées

aux deux principaux théoriciens de l'informatique décisionnelle,

bill inmon et Ralph Kimball :

Définition d'inmon : le DataMart est

issu d'un flux de données provenant du DataWarehouse. Contrairement a ce

dernier qui présente le détail des données pour toute

l'entreprise, il a vocation à présenter la donnée de

manière spécialisée, agrégée et

regroupée fonctionnellement.

Définition de Kimball : le DataMart

est un sous-ensemble du DataWarehouse, constitue de tables au niveau

détail et à des niveaux plus agrèges, permettant de

restituer tout le spectre d'une activité métier. L'ensemble des

DataMarts de l'entreprise constitue le DataWarehouse.

II.2.5.3 STRUCTURE PHYSIQUE ET THEORIQUE

Au même titre que les autres parties de la base de

données globale de l'entreprise, les DataMarts sont stockes physiquement

sur disque dur par un système de gestion de bases de données

relationnelle héberge sur un serveur.

Le DataMart est souvent confondu avec la notion d'hyper cube ;

il peut de fait être représente par un modèle en

étoile ou en flocon dans une base de données relationnelle

notamment lorsqu'il s'agit de données élémentaires ou

unitaires non agrégées.

[25]

II.5.2.3 DATAWAREHOUSE ET DATAMART

La première étape d'un projet busines

intelligent est de créer un entrepôt central pour avoir une vision

globale des données de chaque service. Cet entrepôt porte le nom

de DataWarehouse.

On peut également parler de DataMart, si seulement une

catégorie de services ou métiers est concernée pour notre

travail nous parlerons de DataMart des suivie de traitement médicale de

la consultation jusqu'a la fin.

Par définition, un DataMart peut être contenu

dans un DataWarehouse, ou il peut être seulement issu de celui-ci.

II.5.2.4 ARCHITECTURE D'UN DATAMART [16]

Système transactionnel

Système transactionnel

Système transactionnel

Data Mart

Data Mart

Système transactionnel

Entrepôt

Des données

II II II II

FIG II. 2:Architecture d'un DataMart

[26]

II.5.2.5 LA PLACE DU DATAMART DANS L'ENTREPRISE

Le DataMart se trouve en toute fin de la chaine de traitement

de l'information. En règle générale, il se situe en aval

d'un DataWarehouse plus global à partir duquel il est alimenté,

dont il constitue en quelque sorte un extrait.

Un DataMart forme la principale

interaction entre les utilisateurs et les systèmes

informatiques qui gèrent la production de l'entreprise (souvent des

ERP).

Dans un DataMart, l'information est préparée

pour être exploitée brute par les personnes du métier

auquel il se rapporte. Pour ce faire, il est appelé a être utilise

via des logiciels d'interrogation de bases de données (notamment des

outils de reporting) afin de renseigner ses utilisateurs sur l'état de

l'entreprise à un moment donné (stock) ou sur son activité

(flux).

La préparation de la donnée pour une utilisation

directe, inhérente au DataMart, peut revêtir plusieurs formes. Il

faut noter que toutes représentent une simplification par rapport au

niveau de données inferieur ; on peut citer pour exemple :

L'agrégation de données : le

DataMart ne contient pas le détail de toutes les opérations qui

ont eu lieu, mais seulement des totaux, repartis par groupements.

Le retrait de données inutiles : le

DataMart ne contient que les données qui sont strictement utiles aux

utilisateurs.

l'historisation des données : le

DataMart contient seulement la période de temps qui intéresse les

utilisateurs.

II.2.6. CONCEPTION D'UN ENTREPOT DE DONNEES [5]

La conception d'un entrepôt de données se fait de

deux façon ,la première consiste à construire d'abord

plusieurs mini-entrepôts selon les directions ou le départements

ensuite les intègres dans un seul entrepôt pour l'entreprise ;la

deuxième consiste à construire un entrepôt pour

l'entreprise

[27]

ensuite mettre en place un ou plusieurs mini-entrepôts

pour chaque direction ou départements que compte l'entreprise.

La conception d'un entrepôt de données peut se

faire en utilisant la modélisation relationnelle classique (pour les

bases de données transactionnelles) ou en utilisant la

modélisation dimensionnelle.

Dans un entrepôt de données les requêtes

pour l'interrogation des données utilisent beaucoup des jointures qui

demandent trop de temps ce qui constitue un problème pour le

système transactionnel. c'est pour quoi il est préférable

de utiliser l'approche multidimensionnelle.

II.2.6.1 MODELISATION MULTIDIMENSIONNELLE (8J, (5J

Pour arriver à construire un modèle approprie

pour un entrepôt de données ou un DataMart, nous pouvons choisir,

soit un schéma relationnel (le schéma en étoile, en flocon

de neige ou en constellation) ; soit un schéma multidimensionnel.

Avant de décrire les différents schémas,

nous commençons par quelques concepts de base. La modélisation

multidimensionnelle consiste à considérer un sujet analyse comme

un point dans un espace a plusieurs dimensions.

Les données sont organisées de manière

à mettre en évidence le sujet (le fait) et les différentes

perspectives de l'analyse(les dimensions).

Le fait représente le sujet d'analyse. Il est compose

d'un ensemble de mesures qui représentent les différentes valeurs

de l'activité analysée.

Par exemple, dans le fait ventes, nous pouvons avoir la mesure

"quantité de produits vendus par magasin". Les mesures doivent

être valorisées de manière continue et elles peuvent

être additives (pour résumer une grande quantité

d'enregistrements) ; semi-additives (si elles peuvent seulement être

additionnées pour certaines dimensions) et non additives.

[28]

Une dimension modélise une perspective de l'analyse.

Elle se compose de paramètres(ou attributs) qui servent à

enregistrer les descriptions textuelles.

A. Méthodologie de design de la base de données

pour l'entrepôt des données

:

Dans cette section nous décrivons une

méthodologie par étapes pour construire la base de données

d'un entrepôt de données cette méthode a été

initialement proposées par Kimball et s'appelle méthodologie a

neuf étape dans la modélisation d'un entrepôt des

données :

|

étape

|

Activité

|

|

1

|

choisir la procédure

|

|

2

|

choisir le grain

|

|

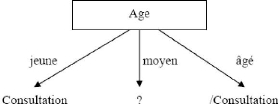

3

|

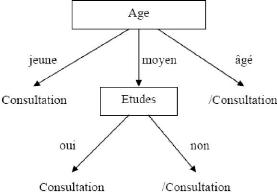

identifier les dimensions et s'y conformer

|

|

4

|

choisir les faits

|

|

5

|

emmagasiner les calculs préliminaires dans la table des

faits

|

|

6

|

finaliser les tables de dimensions

|

|

7

|

choisir la durée de la base de données

|

|

8

|

suivre les dimensions a modification lente

|

|

9

|

Les décideurs doits décidé des

priorités de requêtes et des modes de requêtes

|

Tableau III 1:La méthodologie a neuf étapes de

Kimball

Que nous allons utiliser pour concevoir notre DataMart dans le

chapitre quatre.

II.2.6.2 SCHEMAS RELATIONNELS

Dans les schémas relationnels nous trouvons deux types

de schémas. Les premiers sont des schémas qui répondent

fort bien aux processus de type OLTP qui ont été décrits

précédemment, alors que les deuxièmes, que nous appelons

des schémas pour le décisionnel, ont pour but de proposer des

schémas adaptes pour des applications de type OLAP.

[29]

Nous décrivons les différents types des

schémas relationnels pour le décisionnel.

II.6.2.3 LE SCHEMA EN ETOILE

Il se compose du fait central et de leurs dimensions. Dans ce

schéma il existe une relation pour les faits et plusieurs pour les

différentes dimensions autour de la relation centrale. La relation de

faits contient les différentes mesures et une clé

étrangère pour faire référence à chacune de

leurs dimensions.

La figure 2.2 montre le schéma en étoile en

décrivant les ventes réalisées dans.

Les différents magasins de l'entreprise au cours d'un

jour. Dans ce cas, nous avons une étoile centrale avec une table de

faits appelée ventes et autour leurs diverses dimensions : temps,

produit et magasin.

Produits

Cle_P Description Type Catégorie

Magasin

Cle_M

Raison_soc Adresse Commune Département

Région Pays

Temps

Cle_T Jour Mois Année

Ventes

Cle_P

Cle_T

Cle_M

Quantité

FIG II. 3:Exemple de Modélisation en étoile

[30]

II.6.2.3 LE SCHEMA EN FLOCON DE NEIGE

Il dérivé du schéma

précédent avec une relation centrale et autour d'elle les

différentes dimensions, qui sont éclatées ou

décomposées en sous hiérarchies.

L'avantage du schéma en flocon de neige est de

formaliser une hiérarchie au sein d'une dimension, ce qui peut faciliter

l'analyse. Un autre avantage est représente par la normalisation des

dimensions, car nous réduisons leur taille.

Néanmoins dans, l'auteur démontre que c'est une

perte de temps de normaliser les relations des dimensions dans le but

d'économiser l'espace disque.

Par contre, cette normalisation rend plus complexe la

lisibilité et la gestion dans ce type de schémas. En effet, ce

type de schéma augmente le nombre de jointures à réaliser

dans l'exécution d'une requête.

Les hiérarchies pour le schéma en flocon de

neige de l'exemple de la figure 3 sont :

Dimension temps = jour ? mois ? année

Dimension magasin = commune ? département ?

région? pays La figure 4 montre le schéma en flocon

de neige avec les dimensionnes temps et magasin éclatées en

sous hiérarchies.

Ventes

Cle_P

Cle_T

Cle_M

Quantité

Temps

Cle_T

Jour

Mois

T_Mois

Mois Année

Cle_P Description Type Catégorie

Magasin

Cle_M

Raison_soc Adresse Commune Département

T_Département

|

|

Département Région

|

|

T_Région

|

|

Région Pays

Produits

[31]

FIG II. 4:Exemple de modélisation en flocon de neige

Dans l'exemple ci-dessus, la dimension temps a

été éclatée en deux, temps et T_mois. La

deuxième dimension magasin, a été décomposée

en trois : magasin, m_departement et m_region.

II.6.2.4 LE SCHEMA EN CONSTELLATION

Le schéma en constellation représente plusieurs

relations de faits qui partagent des dimensions communes. Ces

différentes relations de faits composent une famille qui partage les

dimensions mais ou chaque relation de faits a ses propres dimensions.

La figure 2.4 montre le schéma en constellation qui est

compose de deux relations de faits.

La première s'appelle ventes et enregistre les

quantités de produits qui ont été vendus dans les

différents magasins pendant un certain jour. La deuxième relation

gère les différents produits achètes aux fournisseurs

pendant un certain temps.

Produits

[32]

Cle_P Description Type Catégorie

Magasin Cle_M

Ventes

Cle_P Cle_T Cle_M Quantité

Raison_soc Adresse Commune Département

Temps

T_Fournisseur

Cle_F Raison_soc Adresse Code_postal Commune Pays

Cle_T Jour Mois Année

Achats

Cle_P Cle_F Cle_T Quantité

FIG II. 5:Exemple de Modélisation en constellation

La relation de faits ventes partage leurs dimensions temps et

produits avec la table achats. Néanmoins, la dimension magasin

appartient seulement a ventes. Également, la dimension fournisseur est

liée seulement à la relation achats.

II.6.2.5 SCHEMA MULTIDIMENSIONNEL (CUBE) [7]

Dans le modèle multidimensionnel, le concept central

est le cube, lequel est constitue des éléments appelés

cellules qui peuvent contenir une ou plusieurs mesures. La localisation de la

cellule est faite a travers les axes, qui correspondent chacun a une

dimension.

La dimension est composée de membres qui

représentent les différentes valeurs. En reprenant une partie du

schéma en étoile, nous pouvons construire le schéma

multidimensionnel suivant.

[33]

FIG II. 6:Exemple de schéma multidimensionnel

La figure 6, présente un schéma

multidimensionnel pour les ventes qui ont été

réalisées dans les magasins pour les différents produits

au cours d'un temps donne (jour).

II.3 MANIPULATION DES DONNEES MULTIDIMENSIONNELLES

Pour visualise les données

multidimensionnelles, nous pouvons utiliser la

représentation sous forme d'une table de données, qui est la plus

courante. Dans une table, nous représentons les différentes

combinaisons des valeurs choisies pour constituer les noms de lignes et de

colonnes.

Néanmoins, quand le nombre de dimensions est

supérieur à deux, l'utilisateur a des problèmes pour

visualiser simultanément l'ensemble de l'information. Pour

résoudre ce problème, nous devons disposer d'opérations

pour manipuler les données et rendre possible la visualisation.

Nous présentons les opérations pour la

manipulation des données multidimensionnelles, en les divisant selon

leur impact sur la façon de présenter les différentes vues

des données analysées.

[34]

II.3.1 OPERATIONS CLASSIQUES

Ces opérations correspondent aux opérations

relationnelles de manipulation des données :

La sélection :

résulte en un sous-ensemble de données qui respecte

certaines conditions d'appartenance.

La projection :

résulte en un sous-ensemble des attributs d'une relation, qui sont

soit des dimensions, soit des niveaux de granularité. Dans les

systèmes décisionnels, les opérations de sélection

et de projection sont appelées souvent "slice-and-dice". La

jointure : permet d'associer les données de

relations différentes.

A. Les opérations ensemblistes :

D'union, d'intersection et de différence sont des

opérations qui agissent sur des relations qui ont le même

schéma. Par exemple, les opérations agissant sur la structure

visent à présenter une vue (face du cube) différente en

fonction de leur analyse, citons : La rotation (rotate)

: consiste à pivoter ou a effectuer une rotation

du cube, de manière à présenter une vue différente

des données à analyser.

La permutation (switch) :

consiste à inverser des membres d'une dimension, de manière

à permuter deux tranches du cube. La division (split)

: consiste à présenter chaque tranche du

cube en passant d'une représentation tridimensionnelle à une

présentation tabulaire.

L'emboitement (nest) :

permet d'imbriquer les membres d'une dimension. En utilisant cette

opération, nous représentons dans une table bidimensionnelle

toutes les données d'un cube quel que soit le nombre de dimensions.

L'enfoncement (push) :

consiste à combiner les membres d'une dimension aux mesures du cube

et donc de représenter un membre comme une mesure.

L'opération inverse de retrait (pull)

: permet de changer le statut de certaines mesures, pour

transformer une mesure en membre d'une dimension.

La factualisation (fold) :

consiste à transformer une dimension en mesure(s) ; cette

opération permet de transformer en mesure l'ensemble des

paramètres d'une dimension.

[35]

Le para métrisation (unfold) :

permet de transformer une mesure en paramètre dans une

nouvelle dimension.

L'opération cube : permet de

calculer des sous-totaux et un total final.

B. Opérations agissant sur la

granularité :

Les opérations agissant sur la granularité des

données analysées, permettent de hiérarchiser la

navigation entre les différents niveaux de détail d'une

dimension.

Dans la suite nous traitons les deux opérations de ce

type :

Le forage vers le haut (drill-up ou roll-up) :

permet de représenter les données du cube à

un niveau plus haut de granularité en respectant la hiérarchie de

la dimension. Nous utilisons une fonction d'agrégation (somme,

moyenne,...), qui est paramétrée, pour indiquer la façon

de calculer les données du niveau supérieur à partir de

celles du niveau inferieur.

Le forage vers le bas (drill-down ou roll-down ou

scale-down) : consiste à représenter les

données du cube à un niveau de granularité inferieur, donc

sous une forme plus détaillée. Ces types d'opérations ont

besoin d'informations non représentées dans un cube, pour

augmenter ou affiner des données, à partir d'une

représentation initiale vers une représentation de

granularité différente. Le forage vers le haut à besoin de

connaitre la fonction d'agrégation utilisée tandis que le forage

vers le bas nécessite de connaitre les données au niveau

inferieur.

II.4 LES SERVEURS OLAP (ON-LINE ANALYTICAL

PROCESSING)

Les données opérationnelles constituent la

source principale d'un système d'information décisionnel. Les

systèmes décisionnels complets reposent sur la technologie OLAP,

conçue pour répondre aux besoins d'analyse des applications de

gestion.

Nous exposons dans la suite les divers types de stockage des

informations dans les systèmes décisionnels.

[36]

II.4.1 LES SERVEUR ROLAP (RELATIONAL OLAP) [7]

Dans les systèmes relationnels OLAP, l'entrepôt

de données utilise une base de données relationnelle. Le stockage

et la gestion de données sont relationnels. Le moteur ROLAP traduit

dynamiquement le modèle logique de données multidimensionnel

m en modèle de stockage relationnel r ,la plupart des

outils requièrent que la donnée soit structurée en

utilisant un schéma en étoile ou un schéma en flocon de

neige.

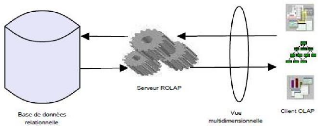

FIG II. 7: Architecture ROLAP

La technologie ROLAP a deux avantages principaux :

(1) elle permet la définition de données

complexes et multidimensionnelles en utilisant un modèle relativement

simple.

(2) elle réduit le nombre de jointures à

réaliser dans l'exécution d'une requête.

Le désavantage est que le langage de requêtes tel

qu'il existe, n'est pas assez puisant ou n'est pas assez flexible pour

supporter de vraies capacités d'OLAP.

II.4.2 LES SERVEUR MOLAP (MULTIDIMENSIONAL OLAP)

Les systèmes multidimensionnels OLAP utilisent une base

de données multidimensionnelle pour stocker les données de

l'entrepôt et les applications analytiques sont construites directement

sur elle. Dans cette architecture, le système de base de données

multidimensionnel sert tant au

[37]

niveau de stockage qu'au niveau de gestion des données.

Les données des sources sont conformes au modèle

multidimensionnel, et dans toutes les dimensions, les différentes

agrégations sont pour le calculées pour des raisons de

performance.

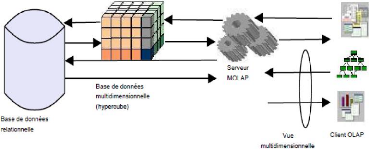

FIG II. 8:Architecture MOLAP

Les systèmes MOLAP doivent gérer le

problème de données clairsemées, quand seulement un nombre

réduit de cellules d'un cube contiennent une valeur de mesure

associée.

Les avantages des systèmes MOLAP sont bases sur les

désavantages des systèmes ROLAP et elles représentent la

raison de leur création. D'un cote, les requêtes MOLAP sont

très puissantes et flexibles en termes du processus OLAP, tandis que,

d'un autre cote, le modèle physique correspond plus étroitement

au modèle multidimensionnel. Néanmoins, il existe des

désavantages au modèle physique MOLAP. Le plus important, a notre

avis, c'est qu'il n'existe pas de standard du modèle physique.

II.4.3 LES SERVEUR HOLAP (HYBRID OLAP)

Un système HOLAP est un système qui supporte et

intègre un stockage des données multidimensionnel et relationnel

d'une manière équivalente pour profiter des

caractéristiques de correspondance et des techniques

[38]

d'optimisation donc c'est l'ensemble des deux serveurs MOLAP

et ROLAP.

Dans la figure 9, nous montrons une architecture en utilisant

les types de serveurs ROLAP et MOLAP pour le stockage de données.

FIG II. 9:Architecture HOLAP

Ci-dessous, nous traitons une liste des

caractéristiques principales qu'un système HOLAP doit fournir

:

La transparence du système : Pour la

localisation et l'accès aux données, sans connaître si

elles sont stockées dans un SGBD relationnel ou dimensionnel. Pour la

transparence de la fragmentation.

Un modèle de données

général et un schéma multidimensionnel global

:

Pour aboutir à la transparence du premier point, tant

le modèle de données général que le langage de

requête uniforme doivent être fournis. Etant donné qu'il

n'existe pas un modèle standard, cette condition est difficile à

réaliser.

Une allocation optimale dans le système de

stockage : Le système HOLAP

Doit bénéficier des stratégies

d'allocation qui existent dans les systèmes distribués tels que :

le profil de requêtes, le temps d'accès, l'équilibrage de

chargement.

Une réallocation automatique : Toutes les

caractéristiques traitées ci-dessus

Changent dans le temps. Ces changements peuvent provoquer la

réorganisation de la distribution des données dans le

système de stockage multidimensionnel et relationnel, pour assurer des

performances optimales.

[39]

Actuellement, la plupart des systèmes commerciaux

utilisent une approche hybride. Cette approche permet de manipuler des

informations de l'entrepôt de données avec un moteur ROLAP, tandis

que pour la gestion des DataMarts, ils utilisent l'approche

multidimensionnelle.

[40]

II.5 CONCLUSION

Dans ce chapitre, nous avons traité le sujet des

entrepôts de données nous avons données l'architecture d'un

entrepôt de données, nous avons expliqué les

différents composants qu'il intègre, comme les diverses sources,

les types de données et les différents outils pour arriver

à la visualisation de l'information.

Nous avons décrit les différents modèles

multidimensionnels pour la construction d'un entrepôt de données,

ainsi que les différentes opérations pour la manipulation des

données multidimensionnelles et une aperçu sur le DataMart, le

parallélisme entre le deux et présenter l'apport de DataMart dans

les entreprise.

La dernière partie a été consacrée

aux types de serveurs décisionnels.

Dans un premier temps, nous avons décrit le serveur

ROLAP qui utilise une base de données relationnelle, tant au niveau du

stockage qu'au niveau de la gestion de données.

Le serveur MOLAP a été la deuxième

architecture que nous avons traitée.

Ces types de systèmes utilisent une base de

données multidimensionnelle pour le stockage des données. Les

systèmes MOLAP doivent gérer le problème de données

clairsemées, quand seulement un nombre réduit des cellules d'un

cube et aspects temporels une valeur de mesure associée.

La troisième architecture que nous avons décrite

est le serveur HOLAP et quelque caractéristique de ce types serveur.

[41]

CHAPITRE III : LE DATA MINING ET ARBRE DE DECISION

[6], [14], [3],[16],[4],[12],[10] ,[11]

III .1 LE DATAMANING

III.1 .1 PRESENTATION

Le terme datamining est souvent employé pour

désigner l'ensemble des outils permettant à l'utilisateur

d'accéder aux données de l'entreprise, de les analyser .

Nous retiendrons ici le terme de data mining aux outils ayant

pour objet de générer des informations riches à partir des

données de l'entreprise, notamment des données historiques, de

découvrir des modèles implicites dans les données.

Ces outils peuvent permettre par exemple à un magasin

de dégager des profils de client et des achats types et de

prévoir ainsi les ventes futures. Ils permettent d'augmenter la valeur

des données contenues dans le DataWarehouse.

Les outils d'aides à la décision, qu'ils

soient relationnels ou OLAP ,laissent l'initiative à

l'utilisateur, de choisir les éléments qu'il veut observer ou

analyser .Au contraire ,dans le cas du datamining ,le système a

l'initiative et découvre lui-même les associations entre

données ,sans que l'utilisateur ait à lui dire de rechercher

plutôt dans telle ou telle direction ou à poser des

hypothèses .

Il est alors possible de prédire l'avenir ,par le

comportement d'un client, et de détecter ,dans le passé ,les

données inusuelles ,exceptionnelles.

Ces outils ne sont plus destinés aux seuls experts

statisticiens mais doivent pouvoir être employés par des

utilisateurs connaissant leur métier et voulant l'analyser,

l'explorer.

[42]

Seul un utilisateur connaissant le métier peut

déterminer si les modèles, les règles, les tendances

trouvées par l'outil sont pertinentes, intéressantes et utiles

à l'entreprise .

Ces utilisateurs n'ont donc pas obligatoirement un bagage

statistique important .L'outil doit être soit ergonomique, facile

à utiliser, soit permettre de construire une application clé en

main, pour la transparence de toutes les techniques utilisées par

l'utilisateur.

Nous pourrions définir le data mining comme une

démarche ayant pour objet de découvrir des relations et des

faits, à la fois nouveaux et significatifs, sur de grands ensembles de

données.

Le terme datamining signifie

littéralement forage de

données dont le but est de pouvoir extraire un élément :

la connaissance.

Ces concepts s'appuient sur le constat qu'il existe au sein de

chaque entreprise des informations cachées dans le gisement de

données . Nous appellerons datamining l'ensemble des techniques qui

permettent de transformer les données en connaissances.

L'exploration se fait sur l'initiative du système, par un

utilisateur métier, et son but est de remplir l'une des tâches

suivantes :Classification, estimation, prédiction, regroupement par

similitudes, segmentation

(cautérisation) ,description et ,dans une moindre mesure,

l'optimisation.

III.1 .2 SATATISTIQUE ET DATAMINING [14J

Nous pourrions croire que les techniques du datamining viennent

en remplacement des statistiques .En fait, il n'en est rien et elles sont

omniprésentes .On les utilise : Pour faire une analyse

préalable,

Pour estimer ou alimenter les valeurs manquantes,

Pendant le processus pour évaluer la qualité des

estimations,

Après le processus pour mesurer les actions entreprises et

faire un bilan.

[43]

Ainsi la statistique et datamining sont tout à fait

complémentaires.

III.1 .3 PROCESSUS DU DATAMINING (14J , (8J

Le datamining est un processus méthodique : une suite

ordonnée d'opérations aboutissant à un résultat.

Le data ming est décrit comme un processus itératif

complet constitué de quartes divisées en six phases.

|

PROCESSUS DU DATA MINING

|

|

Acteur

|

Etapes

|

Phases

|

|

Maitre d'oeuvre

|

Objectifs

|

1. Compréhension du métier :

|

|

2. Compréhension des données

|

|

|

|

Traitements

|

4 .Modélisation

|

|

5.Evaluation de la modélisation

|

|

Maître d'ouvrage

|

Déploiement

|

6. Déploiement des résultats de

l'étude

|

Tableau III 1:le processuce du datamining.

A. Compréhension du Métier :

Cette phase consisté à :

Enoncer clairement les objectifs globaux du projet et les

contraintes de l'entreprise.

Traduire ses objectifs et ses contraintes en un problème

de data mining

Préparer une stratégie initiale pour atteindre ces

objectifs.

B. Compréhension des données

Cette phase consiste à :

Recueillir les données

Utiliser l'analyse exploratoire pour se familiariser avec les

données, commencer à les comprendre et imaginer ce qu'on pourrait

en tirer comme connaissance. Evaluer la qualité des données

[44]

Eventuellement, sélectionner des sous ensembles

intéressants

C. Préparation des données

Cette phase aide à préparer, à partir

des données brutes, l'ensemble final des données qui va

être utilisé pour toutes les phases suivantes :

Sélectionner les cas et les variables à

analyser

Réaliser si nécessaire les transformations de

certaines données,

Réaliser si nécessaire la suppression de

certaines données.

D. Modélisation

La phase de la modélisation consiste à :

Sélectionner les techniques de modélisation

appropriées (pouvant être utilisées pour le même

problème)

Calibrer les paramètres des techniques de

modélisation choisies pour optimiser les résultats ;

Eventuellement revoir la préparation des données

pour l'adapter aux techniques utilisées.

E. Evaluation de la modélisation

Cette résume le rapport final :

Pour chaque technique de modélisation utilisée,

évaluer la qualité (la pertinence la signification) des

résultats obtenus ;

Déterminer si les résultats obtenus atteignent

les objectifs globaux identifiés pendant la phase de

compréhension du métier ;

Décider si on passe à la phase suivante (le

déploiement) ou si on souhaite reprendre l'étude en

complétant le jeu de données.

F. Déploiement des résultats obtenus

Cette phase est externe à l'analyse du datamining .Elle

concerne le maître d'ouvrage.

Prendre les décisions en conséquence des

résultats de l'étude de data mining

[45]

Préparer la collecte des informations futures pour

permettre de vérifier la pertinence des décisions effectivement

mis en oeuvre.

III.1 .4 LES TACHES DU DATA MING

Contrairement aux idées reçues, le Data Mining

n'est pas le remède miracle capable de résoudre toutes les

difficultés ou besoins de l'entreprise .Cependant, une multitude de

problèmes d'ordre intellectuel ,médical ,économique

peuvent être regroupés ,dans leurs formalisation ,dans l'une des

tâches suivantes :

1. Classification

2. Estimation

3. Prédiction

4. Discrimination

5. Segmentation

|

TACHES

|

TECHNIQUE

|

|

Classification

|

L'arbre de décision

|

|

Le raisonnement par cas

|

|

L'analyse de lien

|

|

Estimation

|

Le réseau de neurones

|

|

Prédiction

|

L'analyse du panier de la

ménagère

|

|

Le raisonnement base sur le mémoire

|

|

L'arbre de décision

|

|

Les réseaux de neurones

|

|

Extraction de connaissance

|

L'arbre de décision

|

Tableau III 2:le taches et technique du datamining.

En outre, hormis ces quelques techniques et tâches du

datamining, nous signalons qu'il existe d'autres que nous n'avons pas

énumérez dans notre travail.

[46]

III .2 ARBRE DE DECISION (12J , (10J, (11J

III.2 .0 CONCEPTS THEORIQUES SUR LE GRAPHE [12]

Graphe :

Définition :

Un graphe G est un couple G=(X,U) ,X

est un ensemble non vide et au plus dénombrable .

Nota :X est un ensemble fini ,les éléments de x?X

sont appelés les

sommets ou noeuds ,u = une famille d'éléments du

produit

cartésiens XxX .

Les éléments de U=(x,y) ,x,y?X, sont appelés

:

Soit des arcs lorsqu'on tient compte de l'orientation.

Soit les arêtes lorsqu'on ne tient pas compte de

l'orientation.

Graphe connexe :

Définition :

Un graphe est connexe si l'on peut atteindre n'importe quel

sommet à partir d'un sommet quelconque en parcourant les

différentes arêtes.

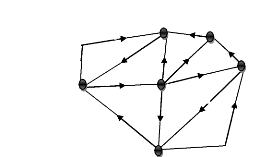

Exemple : soit G=(X,U)

U8

U7

U9

U1

U3 U4

U5

U6

U2

G=(X,U) est un graphe connexe .

[47]

Arbres et arborescence

1. Arbres :

Définition :

Un arbre est un graphe connexe sans cycle. C'est-à-dire

dont on peut atteindre n'importe quel sommet à partir d'un sommet quel-

conque en parcourant différents arêtes et ses arêtes ne

coïncide pas.

Exemple :

Les notions de branches et de cordes :

Soit G=(X,U) un graphe et notons par T=(X,u') un arbre qui est

un graphe partiel de G ,alors :

Les arêtes appartenant à u' sont appelées

les branches de T (ou relativement T )

Les arêtes de u?u' (c'est-à-dire ? (u /u') sont

appelées cordes relativement T.

Exemple : soit G=(X ,U) un graphe connexe ,on peut en

U4

U10

extraire un arbre.

U1

U8

U9

U6

U2 U3

U11

U5

U12

U7

T=(X ,U') ou u'=(U1,U5,U6,U11,U7) : ce sont les branches

tandis que (U2,U3,U4,U12,U11,U9) : ce sont des cordes.

Chaque réponse possible est prise en compte et permet

de se diriger vers un des fils du noeud. De

[48]

a

c

b

f

e

d

Est un arbre extrait du graphe G=(X ,U)

précédent.

2. Arborescence :

Définition :

Soit G=(X,U),on dit que le sommet r?X

est une racine de G si V x?X,(avec x?r)? un chemin de rà x

.c'est -

à -dire un arbre ayant une racine.

Exemple :

c

b

f

e

d

a

C'est une arborescence de racine a.

Nota : un sommet pendant est un sommet sans successeur . En

informatique on les appelle des feuilles ou feuillets.

III .2.1 INTRODUCTION A L'ARBRE DE DECISION [6J

Un arbre de décision est une structure qui permet de

déduire un résultat à partir de décisions

successives. Pour parcourir un arbre de décision et trouver une

solution, il faut partir de la racine. Chaque noeud est une décision

atomique.

[49]

proche en proche, on descend dans l'arbre jusqu'à

tomber sur une feuille. La feuille représente la réponse

qu'apporte l'arbre au cas ou l'on vient de tester.

? Début à la racine de l'arbre

? Descendre dans l'arbre en passant par les noeuds de test

? La feuille atteinte à la fin permet de classer

l'instance testée. Très souvent on considère qu'un noeud

pose une question sur une variable, la valeur de cette variable permet de

savoir sur quels fils descendre. Pour les variables

énumérées, il est parfois possible d'avoir un fils par

valeurs, on peut aussi décider que plusieurs variables

différentes mènent au même sous arbre.

Pour les variables continues, il n'est pas imaginable de

créer un noeud qui aurait potentiellement un nombre de fils infini, on

doit discrétiser le domaine continu (arrondis, approximation), donc

décider de segmenter le domaine en sous ensembles. Plus l'arbre est

simple, et plus il semble techniquement rapide à utiliser.

En fait, il est plus intéressant d'obtenir un arbre qui

est adapté aux probabilités des variables à tester. La

plupart du temps un arbre équilibré sera un bon résultat.

Si un sous arbre ne peut mener qu'à une solution unique, alors tout ce

sous-arbre peut être réduit à sa simple conclusion, cela

simplifie le traitement et ne change rien au résultat final.

III .2.2 DEFINITION

Un arbre de décision est un outil d'aide à la

décision et à l'exploration de données. Il permet de

modéliser simplement, graphiquement et rapidement un

phénomène mesuré plus ou moins complexe. Sa

lisibilité, sa rapidité d'exécution et le peu

d'hypothèses nécessaires a priori expliquent sa popularité

actuelle.

[50]

III .2.3 CARACTERISTIQUES ET AVANTAGES :

Le caractéristique principale est la lisibilité

du modèle de prédiction que l'arbre de décision fourni, et