|

RÉPUBLIQUE DU CAMEROUN REPUBLIC OF

CAMEROON

UNIVERSITÉ DE DOUALA THE UNIVERSITY

OF DOUALA

°~-~°~-~°~-~°~-~°

°~-~°~-~°~-~°~-~°

Matricule : 05A2045

FACULTÉ DES SCIENCES FACULTY OF

SCIENCE

DÉPARTEMENT DE PHYSIQUE DEPARTMENT OF

PHYSICS

Etude des Phénomènes

Critiques

par les Méthodes de Monte

Carlo :

Cas du modèle d'Ising à 2D

pour

la transition de phase Ferro ? Para

Mémoire présenté en vue

de l'obtention du

DIPLÔME DE MAÎTRISE DE PHYSIQUE

OPTION : MATIÈRE

CONDENSÉE

par

TCHUENTE Rostand Choisy

Licencié ès Sciences

Physiques

Sous

et

LA DIRECTION DE : LA SUPERVISION DE :

Dr FOUEJIO David Dr NJEUGNA Ebenezer

CHARGÉ DE COURS MAÎTRE DE

CONFÉRENCES

Année académique

2005 ~ 2006

DEDICACES

A

toi papa ; Feu Roger Dupont TCHUENTE

vous ; mes futurs ...

qui représentez mon passé qui a attendu en vain,

mon espoir qui suivra je l'espère ces pas

REMERCIEMENTS

Alors qu'il m'est offert la possibilité de manifester

toute ma gratitude envers tous, qui ont participé à la

finalisation de ce travail, conscient de ne pouvoir être exhaustif, je

prierai les uns et les autres (ici cités ou non) de reconnaître en

ces petites paroles, la grandeur de la reconnaissance que je leurs accorde.

Au TOUT PUISSANT Seigneur de l'univers, qui sous ses ailles

m'a protégé et guidé à travers tous les

pièges de cette jungle, que ce travail puisse positivement inspirer ton

royaume.

Au staff administratif de l'Université de Douala, du

Département de Physique par le Dr OUSMANOU Motapon pour la constance des

efforts menés pour la bonne marche de notre formation.

Au Dr David FOUEJIO qui a proposé et accepté de

diriger ce travail. Malgré vos multiples charges, vous avez

présenté une disponibilité, un soutient multiforme, une

rigueur constante dans le travail, un esprit de collaboration qui ont fait

tâche d'huile. Recevez mes sincères remerciements.

A tous le corps enseignant du Département de Physique

de notre Faculté, mes enseignants et aînés ; les

Docteurs J. P. NGUENANG, E. WEMBE, C. NOUPA, S.G. NANA ENGO, G.E. NTAMACK,

et les Professeurs Oumarou BOUBA, KWATO NDJOCK, Norbert NOUTCHEGUEME, Pr.

Josué KOM MOGTO. C'est par vous que j'ai d'avantage pris goût

à la chose scientifique. Les modèles se trouvent t'ils à

l'infini ?

A ma famille ;

ma très chère maman Mme TCHUENTE Marthe Viviane

pour qui je n'aurai jamais assez de mots ...

mes grands frères Serge Jr., Christian Hervé,

Stephan Fleury, Henry Patrick TCHUENTE, André KAYO

ma petite soeur Sandrine Gaëlle TCHUENTE.

Votre soutien n'aura jamais d'égal et aucune tribune ne

sera suffisamment haute, aucun mot plus complet, pour vous dire MERCI au regard

de votre désir de me voir réussir.

A mes oncles et tantes, mon tuteur ;

M. KAYO Elie, Mme KOM MOGTO Elisabeth, M. & Mme GOUAMPE

Philippe, TCHATCHOUANG C, WONGTCHOUANG E, KOUONANG J.P. pour votre soutien des

plus remarquables.

M. & Mme KOM Samuel si seulement je savais m'exprimer,

j'aurai su vous dire MERCI...!

A mes cousins et cousines Perrault, Stéphane,

Dieudonné, Moselly, Favière, Marcelline, ... , Guy Alain

KAYO et Pélagie M. & Irène N. TCHUENTE, ...

A tous mes camarades et amis de promotion :

des baccalauréats E et F1, Hermine Jésus,

Lazare, Ghislain Martial, Honoré de Paul, Alban, J. Médard

de maîtrise de Physique, en particulier les

Maîtres Armand HYEUDIP, Nasser MBA T., Thierry NJASSAP, Roger T. MABOU,

C. FANKAM, ... nos échanges ont déterminés les tournures

de ce travail.

de Douala ; Hugues Joël, Christian, Justine

Valérie, Flore Josiane, Odilia, ...

de l'Université de Ngaoundéré ;

Valery Hervé, Ghislain Bérenger, Yves Mathurin, Jean Pierre,

Reine Grâce, Christelle, Linda, Edwige Patricia, Valérie, Emilie

Josyane. Vous avez été pour moi une 3ième

famille.

A tous qui ont été plus près de moi,

rêvés et crus en ce que je fais, encouragé et

supporté ;

Mon AMIE, ... Tave quaviero

A tous, nous avons combattus le bon combat, fraction de ce

qui reste à faire. Le meilleur est à venir

...

TABLE DES

MATIERES

SOMMAIRE

DEDICACE

.......................................................................................................

i

REMERCIEMENTS

...........................................................................................

ii

TABLES DES MATIERES

Sommaire

iii

Tables des Figures & Tableaux

v

Figures

v

Tableaux

vi

QUINTESSENCE

RESUME

vii

ABSTRACT

vii

INTRODUCTION GENERALE

.............................................................................

1

1ERE PARTIE: ETUDE THEORIQUE

Chapitre 1

Bases des simulations par les méthodes de

Monte Carlo pour les transitions de phase magnétiques

3

1.A. Introduction.

3

1.A.2. L'état d'équilibre

5

1.B. Les méthodes probabilistes de

Monte Carlo

6

1.B.1. Expressions théoriques des

grandeurs physiques

6

1.B.2. Fluctuation, Corrélations et

Réponse

7

1.B.3. Cas du modèle d'ISING.

10

1.B.4. Méthodes numériques

11

1.C. Principes de la simulation de Monte

Carlo à l'équilibre thermique

13

1.C.2. Echantillonnage important

14

1.C.2.1. Processus de Markov

14

1.C.2.2. Ergodicité

15

1.C.2.3. Balance spécifique

15

1.C.3. Rapport d'acceptation

17

Chapitre: 2

Etude des phénomènes critiques

À l'aide du modèle d'ISING à 2 D.

19

2.1. Les phénomènes

critiques

19

2.1.1. Les transitions de phase

19

2.1.2. L'exposant critique (sa mesure) et

les classes d'universalités

21

2.1.2.1. Notion d'universalité

22

2.1.2.2. Fluctuations critiques et

ralentissement critique

23

2.1.2.3. Fonction d'auto corrélation

de l'aimantation

24

2.1.2.4. Temps de corrélation et

exposant dynamique.

25

2.1.2.5. Mesure de l'exposant critique

25

2.2. Applications :

27

2.2.1. L'algorithme de construction de la

chaîne du processus de Markov.

27

2.2.2. Algorithme détaillé de

Métropolis.

27

2.2.2.1. Insuffisances de l'algorithme de

Métropolis. Le pas vers Wolff

28

2.2.3. L'algorithme de Wolff

29

2.2.3.1. Rapport d'acceptation pour les

algorithmes de cluster

29

2.2.3.2. Algorithme détaillé

de Wolff et avantages

31

2NDE PARTIE: ETUDE PRATIQUE

Chapitre 3

Les résultats des simulations

32

3.1. Introduction

32

3.2. Détermination de

l'équilibre thermique.

33

3.3. Détermination du temps de

corrélation.

38

3.4. Etude de la transition de phase.

39

3.4.1. Transition de phase Ferro?Para.

41

3.5. Résultats comparés des

algorithmes de Métropolis et de Wolff

45

3.6. Présentation du programme de

simulation : ISampling

48

CONCLUSION GENERALE

...............................................................................

49

REFERENCES BIBLIOGRAPHIQUES

...................................................................

I

ANNEXES

ANNEXE 1 :

II

Organigramme du processus de Markov.

II

ANNEXE 2 :

III

Organigramme de l'algorithme de

Métropolis.

III

ANNEXE 3 :

IV

Programme en C++ de l'algorithme de

Métropolis

IV

ANNEXE 4 :

V

Organigramme de l'algorithme de Wolff

V

ANNEXE 5 :

VI

Programme en C++ de l'algorithme de Wolff

VI

ANNEXE 6 :

VII

Algorithme de génération des nombres

aléatoires par congruence lineaire avec `shuffling'.

VII

ANNEXE 7 :

IX

Classification des transitions de phase

IX

!TABLES DES FIGURES &

TABLEAUX

Figures

Figure 2.1 :

schématisation des regroupements de spin en fonction de la

température

21

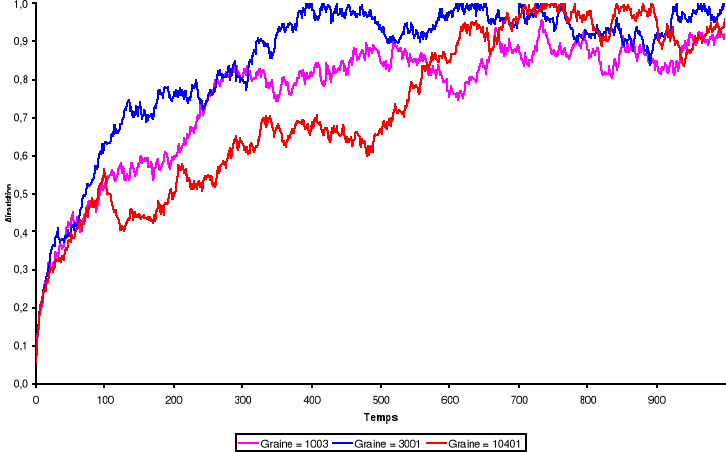

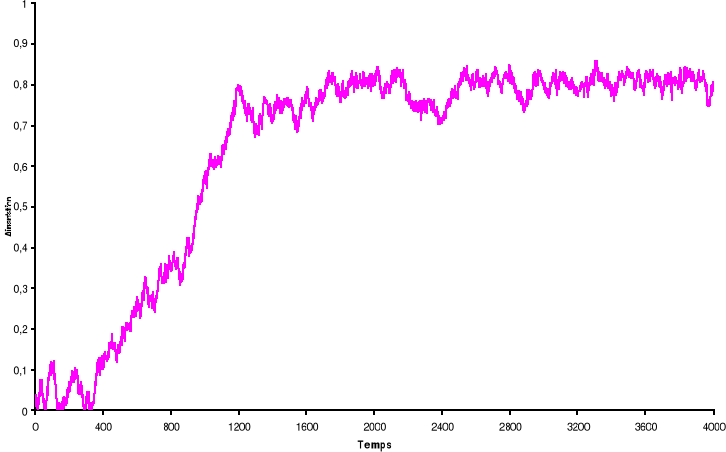

Figure 3.1 :

Aimantation du système de 100 x 100 spins du modèle d'Ising

à 2 D en fonction du temps (en MCS/Site) pour trois types de graine

simulé avec l'algorithme de Métropolis. Les nombres

aléatoires sont générés par congruence

linéaire simple et l'équilibre thermique est atteint au voisinage

de t = 600 MCS/Site à T = 2.4K

34

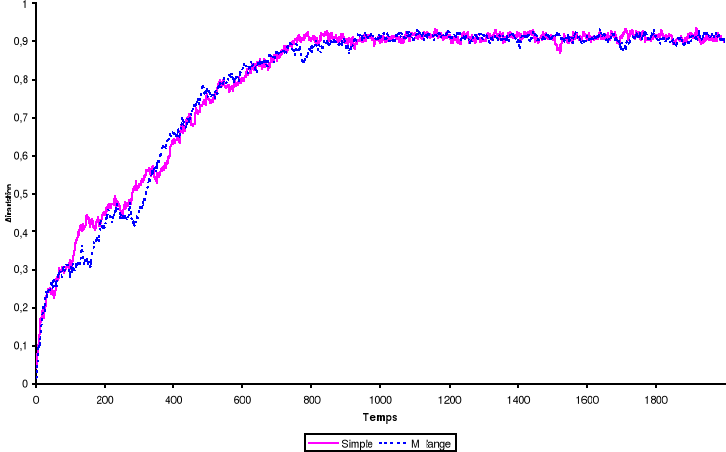

Figure 3.2 :

Aimantation du système de 100 x 100 spins du modèle d'Ising

à 2 D en fonction du temps (en MCS/Site simulé avec l'algorithme

de Métropolis. Les nombres aléatoires sont

générés par congruence linéaire simple ou suivie

d'un shuffling et l'équilibre thermique est atteint au voisinage de t =

800 MCS/Site à T = 2K

35

Figure 3.3 : Douze

états de 100 x 100 spins du modèle d'Ising à 2 D

amenés à l'équilibre thermique à T=2.4K au bout de

t = 400 MCS/Site avec l'algorithme de Métropolis. Les spins Up (+1) sont

représentés en noir et les spins Down (-1) sont en blanc.

36

Figure 3.4 :

Aimantation du système de 100 x 100 spins du modèle d'Ising

à 2 D en fonction du temps (en MCS/Site) simulé avec l'algorithme

de Métropolis. L'équilibre thermique est atteint au bout de t =

200 MCS/Sites à T = 2.2K. La simulation a débutée avec des

spins complètement aléatoires, puis « refroidie'

jusqu'à l'équilibre à T = 2.2K.

37

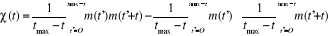

Figure 3.5 : Fonction

d'auto corrélation de l'aimantation pour le modèle d'Ising

à 2D sur un système de 100x100 spins à la

température T=2.2K par Métropolis. Le temps de corrélation

est de ô = 725 MCS/Site

38

Figure 3.6 : Temps de

corrélation pour 100x100 spins du modèle d'Ising à 2D en

fonction de la température simulé avec l'algorithme de

Métropolis.

39

Figure 3.7 :

Aimantation (carrés) et susceptibilité magnétique

(cercles) du système 5x5 spins du modèle d'Ising à 2D en

fonction de la température simulé avec l'algorithme de

Métropolis. Les points (carrés et cercles) sont les

résultats de la simulation et les traits, le calcul exacte à

l'aide de la fonction de partition.

40

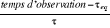

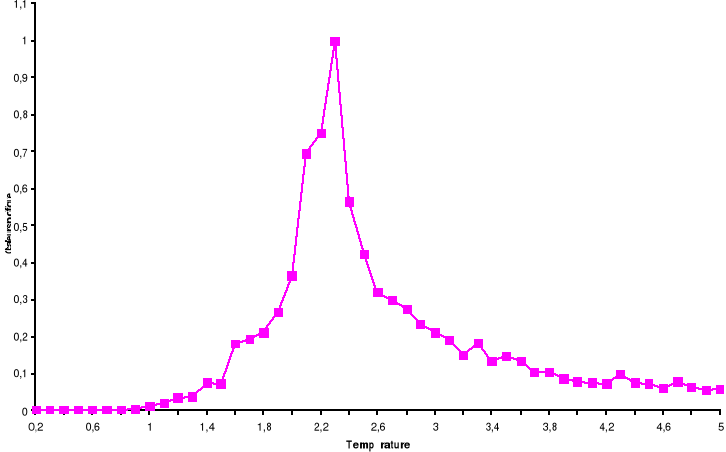

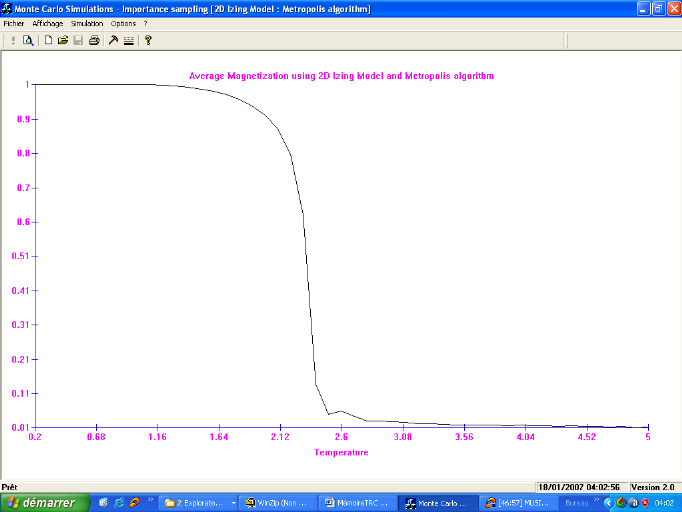

Figure 3.8 :

Aimantation moyenne par spin du système 100x100 spins du modèle

d'Ising à 2D en fonction de la température, simulé avec

l'algorithme de Métropolis. Le tracé représente la

Transition Ferro ? Para. Le tracé représente la Transition Para?

Ferro

42

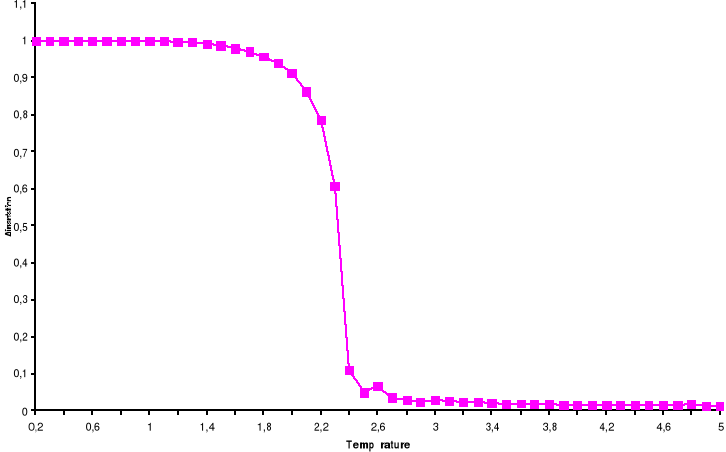

Figure 3.9 : Chaleur

spécifique moyenne à volume constant par spin du système

100x100 spins du modèle d'Ising à 2D en fonction de la

température, simulé avec l'algorithme de Métropolis. Le

tracé représente la Transition Ferro ? Para. Le tracé

représente la Transition Para? Ferro

43

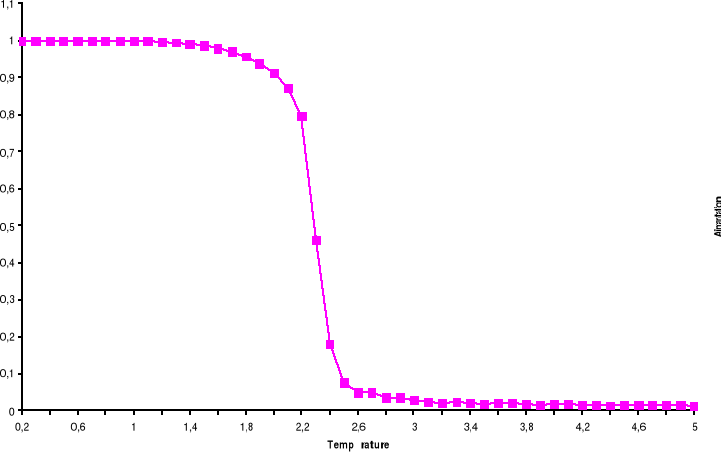

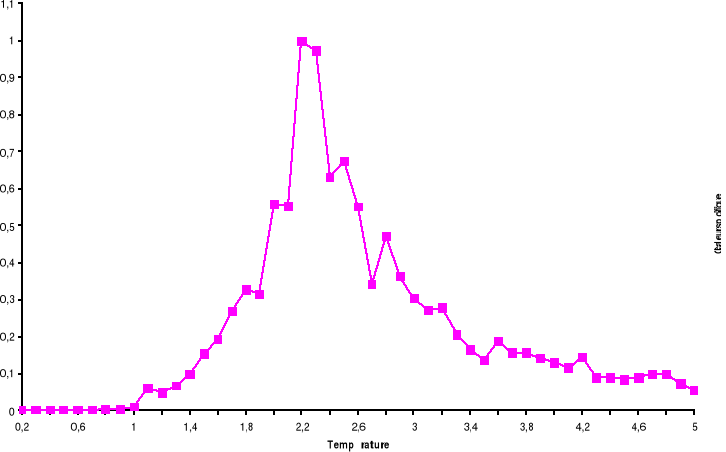

Figure 3.10 :

Susceptibilité magnétique moyenne par spin du système

100x100 spins du modèle d'Ising à 2D en fonction de la

température, simulé avec l'algorithme de Métropolis. Le

tracé représente la Transition Ferro ? Para. Le tracé

représente la Transition Para? Ferro

44

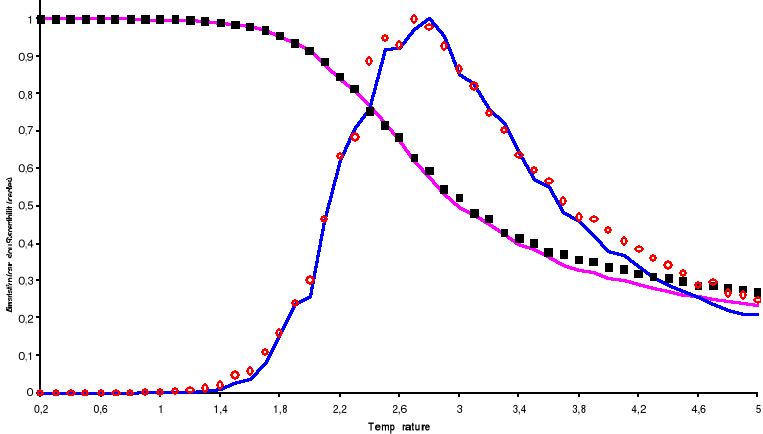

Figure 3.11 :

Aimantation moyenne par spin du système de 100x100 spins du

modèle d'Ising à 2D en fonction de la température.

Carrés : algorithme de Métropolis ; Cercles :

algorithme de Wolff.

46

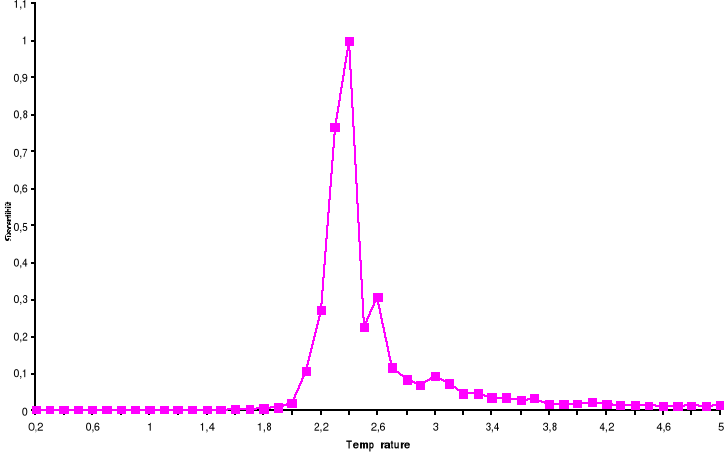

Figure 3.12 : :

Chaleur spécifique moyenne par spin du système de 100x100 spins

du modèle d'Ising à 2D en fonction de la température.

Carrés : algorithme de Métropolis ; Cercles :

algorithme de Wolff.

46

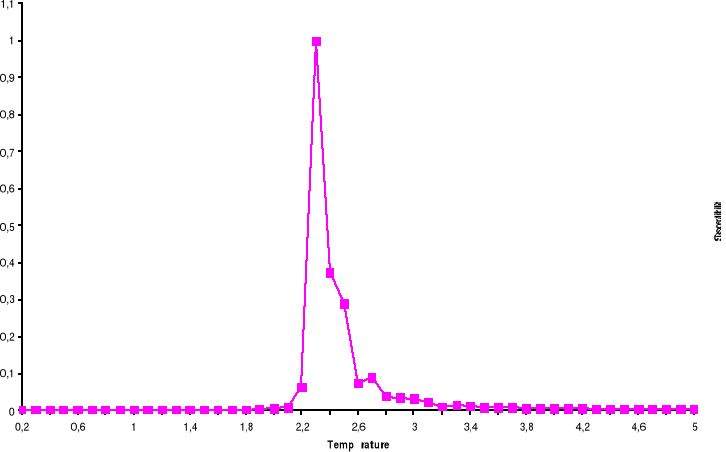

Figure 3.12 : :

Susceptibilité magnétique moyenne par spin du système de

100x100 spins du modèle d'Ising à 2D en fonction de la

température. Carrés : algorithme de Métropolis ;

Cercles : algorithme de Wolff.

47

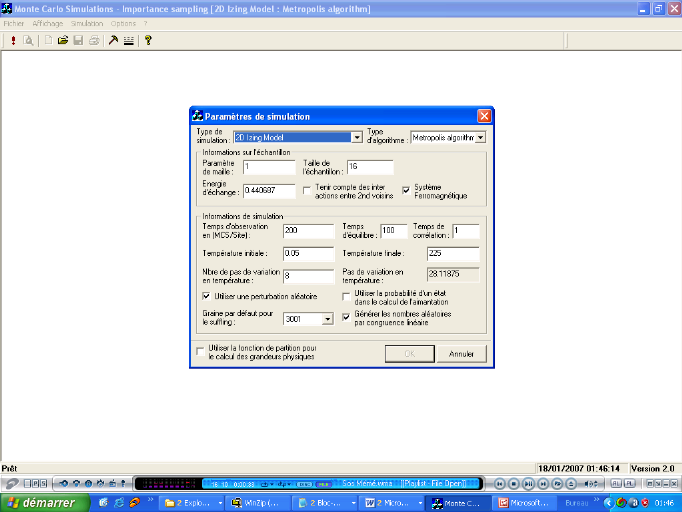

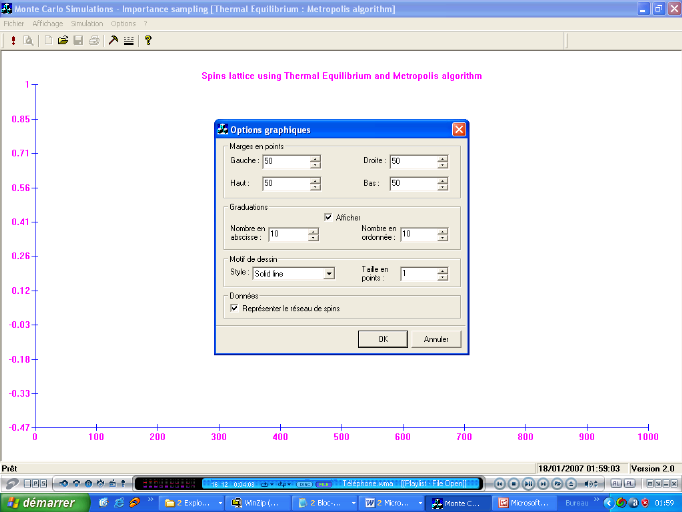

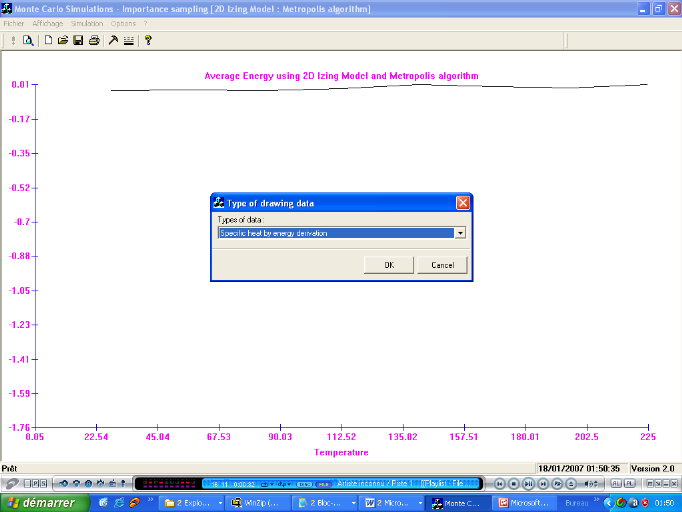

Figure 3.14 :

Fenêtres de paramétrage de simulation (gauche) et d'options

graphiques (droite)

49

Figure 3.15 :

Fenêtre du choix de visualisation d'une grandeur

49

Figure 3.16 :

Fenêtre principale du programme ISampling

49

Figure A1 :

Organigramme du processus de Markov

II

Figure A2 :

Organigramme du processus de Métropolis

III

Figure A4 :

Organigramme du processus de Wolff

V

Tableaux

Tableau 2.1 :

Expressions de quelques grandeurs physiques en fonction de leurs exposants

critiques

22

Tableau 2.2 : Classe

d'universalité et modèles associés

23

Tableau 2.3 : Valeurs

des exposants critiques pour d = 2

26

Tableau A7 :

Classification des transitions

III

QUINTESCENCE.

RESUME

L'objectif initial de notre travail était la

comparaison de deux algorithmes de simulation des phénomènes

critiques par les méthodes de Monte Carlo, - l'algorithme de

Métropolis et l'algorithme de Wolff -. Nous devions par ailleurs

étudier les phénomènes critiques qui s'établissent

à la transition de phase. A cet effet, nous avons

déterminé, les courbes d'évolution des paramètres

du système (énergie, aimantation, susceptibilité, chaleur

spécifique) et celles des propriétés des différents

algorithmes étudiés (temps et longueur de corrélation)

toutes en fonction de la température et / ou de la taille du

système. Pour ce faire, nous avons étudié et simulé

un modèle d'Ising à 2 dimensions. Nous avons

indifféremment travaillé sur les transitions Ferro vers Para ou

Para vers Ferro (Ferro ? Para).

ABSTRACT

The aims of our work was the comparison of two algorithms of

critical phenomena simulation by methods of Monte Carlo, - the algorithm of

Métropolis and the algorithm of Wolff -. We had to study the critical

phenomena that settle to the phase transition of otherwise. Therefore, we have

determine curves of evolution of parameters of the system (energy,

magnetization, susceptibility, specific heat) and those of different studied

algorithm properties (correlation time and length) all according to the

temperature and / or of the size of the system. Thus we have studied and

simulated the two dimensional Ising model. We have worked indifferently on

transitions Ferro towards Para or Para towards Ferro (Ferro ? Para).

... de la même façon, on peut

apprécier les progrès scientifiques et y prendre plaisir,

même si l'on n'a personnellement aucune disposition pour la

créativité scientifique.

Mais demandera - t - on, à quoi

servirait-il ?

La 1ère réponse est que personne

ne peut se sentir chez soit dans le monde moderne, juger la nature de ses

problèmes et les solutions possibles, à moins d'avoir une

idée intelligente de ce que nous réserve la science. De plus

l'initiative au monde magnifique de la science apporte une intense satisfaction

esthétique, inspire la jeunesse, comble le désir de savoir et

permet d'apprécier plus profondément les merveilles

déjà réalisées par l'esprit humain, et celles dont

il est capable.

C'est pour permettre une telle initiative que j'ai

entrepris d'écrire ...

Isaac ASIMOV, L'univers de la science, InterEdition, 1986,

page 15

INTRODUCTION GENERALE

A la base de toute observation des objets de la nature, l'on

aperçoit l'aspect du système (ou objet) observé. Sous

l'influence de l'environnement dans lequel il beigne, cet aspect peut prendre

diverses configurations ou états ; on parle aussi de phase. Ce

à quoi nous nous intéressons dans notre présent travail,

c'est la description du système à l'instant précis

où il change de phase. Il s'agit d'un instant critique où se

produisent des phénomènes dits critiques, c'est à dire de

transition de phase.

Notre travail trouve ses applications sur les ordinateurs qui

permettent de simuler les systèmes physiques pour la résolution

des problèmes en physique statistique. Nous utiliserons à cet

effet comme méthodes numériques, celles de Monte Carlo qui

s'appuient sur un jeu d'échantillon d'une représentation d'un

système physique pris dans un état donné. Elles visent

ainsi à la détermination de manière efficace et rapide

des grandeurs physiques liées au système considéré,

par des procédés probabilistes.

En considérant la configuration granulaire (spin,

atome, molécule, ...) de la matière (système physique) et

sachant que ces éléments composites interagissent mutuellement,

les phénomènes critiques s'étudient avec les

théories de la physique statistique et plus particulièrement de

la mécanique statistique.

Ainsi donc, cumulés aux résultats

théoriques de la mécanique statistique, les simulations par les

méthodes numériques nous apportent des outils

complémentaires pour mieux comprendre les systèmes. Elles sont

essentielles pour des systèmes complexes, à l'approche de

l'instant critique où s'établi la transition. C'est ce qui fit

développer ces méthodes et plus particulièrement celle de

Monte Carlo, très utilisée et adaptée à cet effet.

La technique de Monte Carlo à été assez

développée à la suite de plusieurs travaux, introduisant

ainsi divers algorithmes de simulation, tous intéressants et

présentant des spécificités particulières

liées au système qu'ils étudient. La

1ère simulation de Monte Carlo remonte en 1953 suite aux

travaux de Métropolis & al. [1]. Bien d'autres suivirent, apportant

successivement des corrections remarquables, c'est le cas de [2] l'algorithme

de Wolff (proposé par Ulli Wolff en 1989) à l'encontre du

précédent qui traite sur les spins, celui-ci manipule des blocs

de spins ; l'algorithme de Swendsen - Wang (proposé par ces 2

chercheurs en 1987 et calqué sur le modèle de Wolff) ;

l'algorithme de Niedermayer (adapté à toutes sortes de

modèles, proposé individuellement par Ferenc Niedermayer en

1988), et bien d'autres ...

Le but principal de notre travail est celui de

présenter l'algorithme de Métropolis afin de dégager ses

défaillances et les corrections apportées par Wolff. Pour y

parvenir, nous introduirons :

Dans un premier temps, une partie dite

d' « étude théorique », tout d'abord par

une présentation à travers la mécanique statistique, des

expressions théoriques des grandeurs physiques qui nous

intéressent ; puis nous aborderons les méthodes

probabilistes de Monte Carlo où il s'agira pour nous de présenter

les différents éléments qui permettent d'établir

des résultats numériques proches de ceux déterminés

par les probabilités de Boltzmann. Ce qui nous permettra d'aborder en

fin, l'étude des phénomènes critiques appliqués au

modèle d'Ising à deux dimensions pour la transition de phase

Ferro ? Para, où nous comparerons l'algorithme de Métropolis

à celui de Wolff à travers leurs différentes

propriétés.

Dans un second temps, une partie dite

d' « étude pratique » nous permettra de

visualiser ces grandeurs par les simulations faites sur différents

systèmes, afin de vérifier les conclusions apportées par

la partie précédente.

1ère Partie : Etude théorique

Chapitre 1

Bases des simulations par les méthodes de Monte

Carlo pour les transitions de phase magnétiques

1.A.

Introduction.

Il nous paraît utile de présenter d'entrée

de jeu de cette partie, une vue sur la mécanique statistique qui nous

permet notamment de retrouver les expressions réelles des grandeurs

physiques - que nous déterminerons avant de retrouver l'état

optimal auquel tout système physique à tendance à

basculer (l'état d'équilibre)-, pour mieux étudier

les phénomènes critiques.

1.A.1. La mécanique statistique

La difficulté cruciale rencontrée dans les

systèmes que nous étudions est qu'ils sont composés de

plusieurs blocs (atomes ou molécules) généralement

identiques, pouvant avoir en très petit nombre des différences

mais obéissants tous néanmoins à de simples

équations du mouvement. De ce fait, tout le système peut

être mathématiquement modélisé de différentes

façons. Cependant, le nombre d'équations (obtenu par

l'étendu du problème) rend impossible la résolution

mathématique exacte. Par ailleurs, les conditions macroscopiques

observables dans lequel est plongé le système nous permettent de

prédire et simplifier d'avantage certaines de ces équations. La

mécanique statistique essaye donc de trouver les solutions de ces

équations par des procédés et propriétés

probabilistes définis sur plusieurs états.

Le vrai paradigme que nous étudierons ici, est que le

système est gouverné par un Hamiltonien H qui donne

l'énergie totale du système dans n'importe quel état

particulier. Ces énergies pouvant êtres discrètes ou

continues. L'état d'énergie stationnaire étant celui pour

lequel l'énergie reste constante au cours du temps, on observe des

échanges entre les différents états

dégénérés. Un autre obstacle que nous rencontrons

est celui de l'influence du réservoir thermique. C'est un très

grand système qui peut être pris comme une source (de

température par exemple), échangeant constamment de

l'énergie avec notre système dans la mesure où nous

impulserons toujours de la température au système comme

définie en thermodynamique. Nous pouvons incorporer l'effet de notre

réservoir dans nos calculs en donnant au système la dynamique de

la règle par laquelle il change périodiquement d'état. La

nature exacte de cette dynamique est dictée par la forme de la

perturbation de l'Hamiltonien que le réservoir produit dans le

système. A cet effet, considérons le cas suivant:

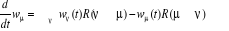

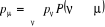

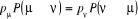

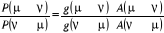

Soit  la probabilité au système de passer d'un état

ì à autre état õ. la probabilité au système de passer d'un état

ì à autre état õ.  est le taux de transition et doit être normalement

indépendant du temps. En supposant cette hypothèse

réalisée l'on peut définir est le taux de transition et doit être normalement

indépendant du temps. En supposant cette hypothèse

réalisée l'on peut définir  pour tout état possible õ que le système peut

avoir. Ces transitions de phases sont généralement tout ce que

nous pouvons avoir sur la dynamique. D'où, connaissant un état u

du système, nous n'avons besoin que d'un court instant

« dt » pour que le système évolue vers

n'importe quel autre état í. Nous appliquons ce raisonnement

lorsque le traitement probabiliste entre en jeu. Définissons pour tout état possible õ que le système peut

avoir. Ces transitions de phases sont généralement tout ce que

nous pouvons avoir sur la dynamique. D'où, connaissant un état u

du système, nous n'avons besoin que d'un court instant

« dt » pour que le système évolue vers

n'importe quel autre état í. Nous appliquons ce raisonnement

lorsque le traitement probabiliste entre en jeu. Définissons 1(*), la

probabilité du système d'être à l'état u

à l'instant t. La mécanique statistique propose que ces poids

nous informe entièrement sur l'état du système. Nous

pourrons donc écrire la grande équation de l'évolution de 1(*), la

probabilité du système d'être à l'état u

à l'instant t. La mécanique statistique propose que ces poids

nous informe entièrement sur l'état du système. Nous

pourrons donc écrire la grande équation de l'évolution de

avec les termes de avec les termes de  tel que : tel que :

(1.1) (1.1)

Le premier terme de droite représente le taux de

probabilité du système d'être à

l'état u, tandis que le second est le taux de probabilité du

système d'être juste au dessus de cet état mais avant le

suivant. Toutefois, nous devons avoir la condition

(1.2) (1.2)

Tant que le système sera dans cet intervalle

d'état. La solution de l'équation (1.1) nous donne la variation

temporelle du taux  qui peut nous permettre de retrouver les propriétés

macroscopiques de notre système. Mais comment donc? qui peut nous permettre de retrouver les propriétés

macroscopiques de notre système. Mais comment donc?

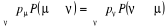

Si nous désirons par exemple déterminer la

quantité Q qui prend à l'état u la valeur Qu,

nous définirons la valeur moyenne de Q à l'instant t pour tout le

système par

(1.3) (1.3)

Il est claire que cette quantité contient d'importantes

informations que nous sommes sensé avoir expérimentalement. Par

ailleurs la valeur précise Q de son observable  n'est peut-être pas assez claire. n'est peut-être pas assez claire.

En effet, imaginons que nous avons un grand nombre de

complexions (copies) de notre système qui interagissent chacun avec son

réservoir thermique passant d'un état à un autre durant

toute la durée de l'observation. L'on croirait que sera dès lors à sa meilleure estimation si nous faisions

une moyenne pondérale des valeurs de Q obtenues séparément

pour chaque système. Pourtant, il en existe bien plus que ce que l'on

considère! En réalité nous n'avons sur la main

expérimentalement qu'un seul système sur lequel nous

opérons toutes nos mesures de Q, d'où il ne s'agit pas d'une

simple mesure instantanée, mais d'une intégration de la mesure

sur une période de temps T. C'est ainsi que l'on détermine

l'espérance sur une moyenne de temps, de la quantité Q. sera dès lors à sa meilleure estimation si nous faisions

une moyenne pondérale des valeurs de Q obtenues séparément

pour chaque système. Pourtant, il en existe bien plus que ce que l'on

considère! En réalité nous n'avons sur la main

expérimentalement qu'un seul système sur lequel nous

opérons toutes nos mesures de Q, d'où il ne s'agit pas d'une

simple mesure instantanée, mais d'une intégration de la mesure

sur une période de temps T. C'est ainsi que l'on détermine

l'espérance sur une moyenne de temps, de la quantité Q.

Le calcul de l'espérance est un des buts principaux de

la mécanique statistique, et des simulations par Monte Carlo en Physique

statistique. Cependant, pour y arriver le système doit être

préparé à nous fournir des valeurs assez

représentatives de sa configuration. [3] Boltzmann nous renseigne que

c'est à un état dit d'équilibre que nous pouvons avoir ces

grandeurs là.

1.A.2.

L'état d'équilibre

Reconsidérons la grande équation (1.1); si

jamais notre système atteint l'état où les 2 termes de

gauche deviennent équivalents au point de s'annuler ou de donner un

autre terme constant, alors la variation du taux  sera nulle et le poids statistique sera constant pour tout le reste du

temps : c'est l'état d'équilibre. C'est à ces

instants que l'on observe les interactions entres les éléments du

système. Tout système gouverné par l'équation (1.1)

atteint forcement l'équilibre. Il s'agira donc pour nous de simuler ces

systèmes par la technique de Monte Carlo. Le taux de transition sera nulle et le poids statistique sera constant pour tout le reste du

temps : c'est l'état d'équilibre. C'est à ces

instants que l'on observe les interactions entres les éléments du

système. Tout système gouverné par l'équation (1.1)

atteint forcement l'équilibre. Il s'agira donc pour nous de simuler ces

systèmes par la technique de Monte Carlo. Le taux de transition  apparaissant dans (1.1) ne doit juste prendre que quelques valeurs. Le

point important est que nous connaissons à priori les valeurs de apparaissant dans (1.1) ne doit juste prendre que quelques valeurs. Le

point important est que nous connaissons à priori les valeurs de  à l'équilibre. Elle nous permet d'avoir ce que l'on

appellera « probabilité d'occupation à

l'équilibre », notée à l'équilibre. Elle nous permet d'avoir ce que l'on

appellera « probabilité d'occupation à

l'équilibre », notée

(1.4) (1.4)

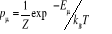

Gibbs (1902) [3] montra que pour un système à

l'équilibre thermique tel un réservoir à la

température T, on a  (1.5) (1.5)

Où Eu est l'énergie à

l'état u et Z la fonction de partition telle que

(1.6) (1.6)

Avec l'énergie d'agitation thermique (1.6') (1.6')

A présent que l'équilibre thermique est atteint

dans les conditions sus-citées, nous pouvons déterminer les

expressions des différentes grandeurs recherchées afin de pouvoir

les simuler pour obtenir les configurations du système.

1.B.

Les méthodes probabilistes de Monte Carlo

1.B.1.

Expressions théoriques des grandeurs physiques

Nous avons pu établir précédemment les

conditions de l'état d'équilibre, en considérant cet

état atteint, nous déterminerons à présent les

grandeurs physiques caractéristiques du système.

Nous remarquons que la fonction de partition Z apparaît

dans beaucoup de développement mathématique en mécanique

statistique; la connaissance de Z nous permet d'évaluer virtuellement

tout ce que nous voulons savoir sur l'environnement macroscopique du

système [3]. Nous prendrons ainsi l'expression (1.6) comme

point de départ pour nos prochains développements.

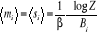

Par généralisation, partant des équations

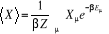

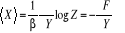

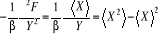

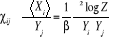

(1.3), (1.4), (1.5), l'espérance

mathématique d'une quantité Q pour notre système Physique

sera

(1.7). (1.7).

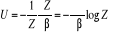

Qu'il en soit pour l'énergie (Q = E) on aura

l'espérance

= U (1.8) = U (1.8)

De l'équation (1.6), nous aurions pu

écrire

(1.9) (1.9)

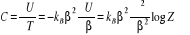

La chaleur spécifique (massique) aura pour

expression :

(1.10) (1.10)

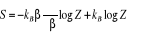

Introduisant l'entropie S l'on obtient

(1.11) (1.11)

En égalant (1.10) & (1.11) et en tenant compte des

conditions d'intégration, de la 3eme loi de la

thermodynamique fixant arbitrairement l'origine de l'entropie, on trouve

(1.12). (1.12).

Par ailleurs, des expressions (1.9,), (1.12)

Helmholtz [3] tire l'énergie libre 2(*)

F = U - TS = kBT logZ

(1.13)

Nous avons ainsi pu définir les grandeurs

thermodynamiques U, F, C, S à partir de Z. D'autres grandeurs dites

conjuguées ont des variables conjuguées qui sont les

réponses du système à ces sollicitations ou en d'autres

termes aux perturbations correspondantes. Par exemple, la réponse

à un système de gaz dans une boite par le changement de volume V

est la pression P. la pression `P' est donc la variable conjuguée de

`V' ; de même l'aimantation M est la réponse à la

variation du champ magnétique B. M et B sont variables

conjuguées.

F étant une différentielle totale par

l'équation (1.13) c'est-à-dire [3] :

dF = dU - TdS - SdT = - PdV - SdT (négligeant le

monôme lié au nombre N de particule du système) et sachant

que dU = TdS - PdV et  , l'on aura , l'on aura

(1.14) (1.14)

(1.15) (1.15)

Donc si nous pouvons avoir l'énergie libre F, nous

obtiendrons l'effet des autres paramètres variants. Tout ceci nous

ramène toujours à la fonction de partition Z. Cette fonction est

très utilisée dans les calculs évolués par la

méthode de Monte Carlo pour les propriétés du

système à l'équilibre.

1.B.2. Fluctuation3(*), Corrélations4(*) et Réponse

La mécanique statistique peut nous informer sur

d'autres propriétés du système telles l'entropie et la

pression. Une des plus importantes classes de ces propriétés est

la fluctuation des quantités observables. Il a été

décrit plus haut comment le calcul des espérances tient compte de

la moyenne temporelle sur plusieurs mesures de la même

propriété pour un système simple. En plus, pour calculer

la vraie valeur de ces différentes mesures, il serait

préférable de calculer leurs variations spécifiques qui

nous donne la mesure de la variation de la quantité que nous observons

sur le temps et nous donne aussi quantitativement (avec approximation) le

nombre d'essais effectués pour avoir la bonne valeur (valeur propre) de

l'espérance (observable).

Par exemple, considérons l'énergie interne U, la

moyenne du carré de la déviation individuelle instantanée

de la mesure de l'énergie est

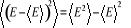

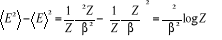

(1.16) (1.16)

Des formules (1.7), (1.8) et (1.9), nous

obtenons aisément  et / ou par dérivation de la fonction de partition Z on a

aussi et / ou par dérivation de la fonction de partition Z on a

aussi , ce qui nous donne , ce qui nous donne

(1.17) (1.17)

Utilisant (1.10) pour éliminer la 2nde

dérivation on écrira alors

(1.19) (1.19)

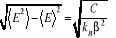

D'où, l'écart type5(*) de E sera  . (1.20) . (1.20)

Ce résultat nous est intéressant pour plusieurs

raisons :

Primo, il nous donne la magnitude (l'étalement) de la

fluctuation en terme de chaleur spécifique `C'6(*). Nous pouvons ainsi trouver

toutes les fluctuations des quantités que nous avons en thermodynamique

classique en sachant que nous devons absolument tenir compte de l'approche

microscopique que la thermodynamique n'a pas accès !

Segundo, hors de la limite de spectre d'énergie, les

fluctuations sont élevées.

Ceci nous prête à croire à nos premiers

arguments, que le traitement statistique peut nous offrir une véritable

estimation exacte de l'environnement de notre système tel que nous

l'espérions. La plus part des questions (le comportement) qui nous

intéresse en matière condensée se trouvent autour de la

limite thermodynamique, où l'on ignore la fluctuation pour de large

systèmes. Ainsi les algorithmes informatiques s'exercent à

simuler le comportement à cette limite pour d'aussi larges

systèmes que possible en un temps appréciable.

Qu'en est il donc à présent de la fluctuation

pour d'autres variables thermodynamiques? D'après les

équations (1.5) à (1.7) ainsi que la

définition de variable conjuguée vu plus haut, nous pouvons

réécrire de manière générale, pour une

grandeur quelconque X

= =  (1.21) (1.21)

Où contiennent les termes en contiennent les termes en  contenus dans l'Hamiltonien du système. La technique

utilisée pour le calcul de la température moyenne d'une

quantité est de réécrire contenus dans l'Hamiltonien du système. La technique

utilisée pour le calcul de la température moyenne d'une

quantité est de réécrire

(1.22) (1.22)

Il est évident qu'aucun champ de couplage de cette

quantité ne se trouve dans l'Hamiltonien. Dans le cas contraire, nous

utiliserons un champ fictif que nous introduirons dans l'Hamiltonien pour y

assurer le couplage, utiliser (1.22) et le réduire enfin en un

champ nul après dérivation. Méthode communément

utilisée en mécanique statistique. Une autre

dérivée de logZ qui respecte Y produit un autre facteur de  dans la somme sur tous les états u. Nous chercherons alors dans la somme sur tous les états u. Nous chercherons alors

(1.23) (1.23)

Où nous reconnaissons les résultats tels

trouvés plus haut à l'équation (1.17). Nous

pouvons ainsi avoir la variance de n'importe quelle quantité X à

partir de la dérivée seconde de l'énergie interne F sur sa

variable conjuguée respective. On défini la

susceptibilité de X sur Y par le rapport

mesurant la force de X par le changement en Y contenu dans l'équation

précédente et usuellement notée ÷ :  (1.24) (1.24)

D'où la valeur moyenne d'une variable X et sa variable

conjuguée Y sont proportionnelles. Ce résultat est connu depuis

le théorème de la réponse linéaire7(*), qui nous donne un moyen de

calculer (1.24) par la méthode de Monte Carlo en mesurant la taille

d'une fluctuation sur une variable.

En étendant l'idée de la susceptibilité

et par là le changement d'état de la thermodynamique classique,

nous pourrons apprécier ce qui arrive lorsque nous changeons

d'état (position sur l'espace de configuration) d'un paramètre.

Pour aborder ce type de problème, nous utiliserons un modèle

planétaire représenté par une matrice. C'est un

modèle plus réaliste où i,j représentent

coordonnées abscisses et ordonnées d'un point k. Une variable

Xk aura un champ conjugué Yk que nous retrouvons

dans l'Hamiltonien par les termes  avec avec  pour tous les N sites k. On réécrira donc (1.21)

et (1.22) pour tous les N sites k. On réécrira donc (1.21)

et (1.22)

(1.25) (1.25)

Où  est la valeur de est la valeur de  en un état u nous donnant donc une généralisation

de ÷ par en un état u nous donnant donc une généralisation

de ÷ par

(1.26) (1.26)

En introduisant le résultat de (1.6) on

obtient

= =

Plus simplement  (1.27) (1.27)

Où  est la fonction de corrélation8(*) de x pour 2 points i et j connectés, que

nous présenterons plus tard. L'exposant (2) représente l'ordre de

la corrélation (ou le nombre de points). est la fonction de corrélation8(*) de x pour 2 points i et j connectés, que

nous présenterons plus tard. L'exposant (2) représente l'ordre de

la corrélation (ou le nombre de points).

1.B.3. Cas du modèle

d'ISING.

Pour essayer de rendre toutes ces relations un peu plus

concrètes, nous introduisons à présent un concept

nouveau : le modèle d'ISING. Certainement l'un des plus

recherché ou étudié en physique statistique. C'est un

modèle d'aimant. Les principes essentiels rodant autour de l'aimantation

et des models magnétiques sont que l'aimantation d'un matériau se

compose de moments magnétiques de plusieurs dipôles

magnétiques conjugués de spin. Le modèle postule qu'une

matrice (de dimension définie en fonction de la géométrie

du problème) peut représenter tous les états possibles de

spin d'un système. L'évaluation des propriétés se

fait donc en manipulant directement la matrice à travers les

différents états du système définis par les

coefficients de la matrice. Par soucis de simplification, ces coefficients

(valeurs des spins) prennent les valeurs 9(*). Dans le

modèle magnétique réel, les spins interagissent entre eux

(entre voisins), l'on tient donc compte de cette autre contrainte en

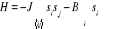

introduisant dans l'Hamiltonien les énergies d'interaction notées

J (pour les 1ers voisins) et J1 (pour les 2nds

voisins) facteurs des termes d'interactions. On aura [11] 9(*). Dans le

modèle magnétique réel, les spins interagissent entre eux

(entre voisins), l'on tient donc compte de cette autre contrainte en

introduisant dans l'Hamiltonien les énergies d'interaction notées

J (pour les 1ers voisins) et J1 (pour les 2nds

voisins) facteurs des termes d'interactions. On aura [11]

(au 1er ordre)  (1.28) (1.28)

(au 2nd ordre)  (1.28') (1.28')

Où i et j sont les coordonnées du spin de la

matrice ; dans la mesure où l'énergie d'interaction

dipolaire varie en  on aura on aura . En plus, le signe (-) en J est conventionnel et indique le sens de

l'interaction sur les paramètres J, lorsque J>0, tous les spins sont

Up et nous avons le modèle ferromagnétique. Dans le cas

contraire, nous obtenons un modèle dit

anti-ferromagnétique. . En plus, le signe (-) en J est conventionnel et indique le sens de

l'interaction sur les paramètres J, lorsque J>0, tous les spins sont

Up et nous avons le modèle ferromagnétique. Dans le cas

contraire, nous obtenons un modèle dit

anti-ferromagnétique.

Autant que chaque site (coefficient) peut prendre deux

valeurs, notre matrice de dimension N (nombre de spin) peut décrire donc

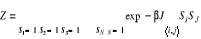

2N états possibles. Ce qui nous permettra de redéfinir

la fonction de partition décrite plus haut à

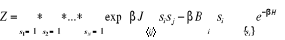

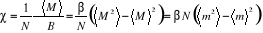

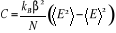

l'équation (1.16) par :

(au 1er ordre)  (1.29) (1.29)

(au 2nd ordre)  (1.29') (1.29')

Comme dit précédemment, nous pourrions ainsi

avoir avec Z toutes les propriétés thermodynamiques du

système et même leurs variables conjuguées. Comme

définies plus haut ;

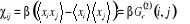

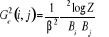

La susceptibilité magnétique par spin

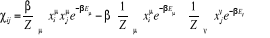

d'après (1.23) est :

(1.30) (1.30)

La chaleur spécifique par spin se

référant à (1.19) sera :

(1.31). (1.31).

De l'expression de l'Hamiltonien donnée en

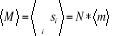

(1.28), si nous considérons à présent une

variation partielle du champ J1 = B, l'on fera donc intervenir

Bi dans la sommation. La moyenne de l'aimantation sera . Où . Où  (simplement notée m) représente la moyenne par spin, elle

est plus généralement utilisée: (simplement notée m) représente la moyenne par spin, elle

est plus généralement utilisée:

(1.32) (1.32)

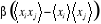

La fonction de corrélation connectée sera

(1.33). (1.33).

Toutes ces grandeurs sont encore plus intéressantes par

visualisation à l'équilibre thermique lorsque nous l'atteignons,

par les méthodes numériques.

1.B.4. Méthodes

numériques

Les méthodes numériques nous permettent

d'obtenir avec plus de justesse et de rapidité, les comportements des

propriétés physiques précédemment définies.

Nous avons la fonction Z qui est (nous l'avons montré) un

élément pivot. Le problème actuel sera d'améliorer

la somme de celle-ci sur un grand nombre d'états. Plus encore, il faudra

considérer qu'à la limite thermodynamique, le nombre

d'états doit être considéré infini. Ce travail

à été réalisé sur un modèle plus

simple d'énergie discret, le modèle d'ISING à deux

dimensions [2]. Par ailleurs, la majorité des modèles

s'intéressent, autant qu'il n'est pas encore possible, d'obtenir

l'expression analytique exacte de Z.

La méthode la plus simple pour résoudre les

problèmes en physique statistique est de convertir notre système

en représentation matricielle (de dimension fonction de la

géométrie du problème considéré) et de

l'appliquer dès lors au modèle choisi. De ce fait, la fonction de

partition Z deviendra une somme de nombre finie de terme (pour un espace

discret) ou une intégrale sur l'espace considéré pour un

spectre continu d'énergie), nous pourrions dès lors utiliser un

ordinateur pour évaluer ces expressions. Regardons à

présent ce qui se passe pour le modèle d'ISING.

Considérons un cas à deux dimensions, un

système de 25 spins modélisables en une matrice carrée 5 x

5. En champ nul (B = 0), limitons les effets de bord en utilisant les

conditions aux limites cycliques de BVK10(*) (Born Von Karmer). Chaque spin pouvant prendre 2

valeurs (suivant qu'il soit Up ou Down), l'on aura alors 225 =

33554432 valeurs possibles (états possibles du système) !

Cependant, la matrice n'est jamais assez grande pour inclure toute la physique

importante. Ceci ne veut pourtant pas dire qu'un développement matriciel

est moins utile. Il existe des méthodes rendant le problème est

moins difficile où le calcul numérique et les solutions exactes

sont très appréciables. La technique des tailles d'échelle

d'intervalle fini (pas de divergence), nous entraîne à extrapoler

les résultats par des matrices de dimension finie aux systèmes de

taille finie ou infinie et donne de bons résultats aux limites

thermodynamiques [7].

Néanmoins, toutes ces techniques peuvent nous donner de

bons résultats pour les propriétés critiques. La

précision et l expression desdits résultats dépendent

de la taille du système. Dès lors, il est judicieux pour nous de

travailler avec d'aussi grand système que possible. Ce qui prendra

nécessairement du temps car il faudra tenir non seulement compte de la

géométrie du système mais aussi des

caractéristiques techniques du calculateur utilisé. La partie sur

les résultats obtenus nous en dira plus.

1.C. Principes de la simulation de

Monte Carlo à l'équilibre thermique

Il est à présent question pour nous de

présenter les éléments de base de la simulations par Monte

Carlo, à travers les trois idées maîtresses :

« l'échantillonnage important», « la balance

détaillé » et le « rapport

d'acceptation ». Maîtriser le sens de ces termes nous offrira

d'avantage informations sur la simulation de Monte Carlo à

l'équilibre thermique développée ces trente

dernières années.

1.C.1. L'estimateur

Nous avons dit plus haut que la recherche des valeurs

moyennes représente les principaux objectifs des simulations Monte

Carlo, mais pour accélérer le processus il serait plus facile

d'orienter nos résultats vers des valeurs probables.

Nous avons obtenu de (1.3), l'expression de la

moyenne de Q, par sommation sur tous les états ì du

système et sur leurs probabilités respectives

(1.31) (1.31)

Pour de grands systèmes, le mieux que nous pouvons

avoir est la moyenne sur une somme restreinte d'états. Il est donc

nécessaire d'introduire une quantité dans le calcul. La technique

de Monte Carlo s'exerce à choisir ce champ restreint d'état avec

une probabilité de distribution öì. En supposant

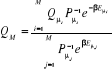

que nous choisissons M états , l'on aura une meilleure estimation de Q par , l'on aura une meilleure estimation de Q par

(1.32) (1.32)

Cette expression est l'estimateur de

Q, nous donnant une estimation de Q sur un model réduit et

avec la propriété que lorsque le nombre M d'états dans

l'échantillon grandit, l'on se rapproche de la vraie valeur  par Q. C'est-à-dire : par Q. C'est-à-dire :

Reste alors à déterminer M pour une meilleure

expression de Q. Pour ce faire, il suffit de considérer une

équiprobabilité entre les états du système (c'est

à dire ), d'où : ), d'où :

(1.33) (1.33)

1.C.2. Echantillonnage

important

Tel qu'il a été abordé dans un

précédent paragraphe, il est utile d'observer un temps moyen afin

de se rassurer que nous parcourrons au moins une période, durant le

temps de l'expérience, d'où il se pose le problème de la

longueur de la chaîne. A titre d'exemple, un litre de gaz, contient

1022 molécules, soient  états possibles qui est un nombre spectaculairement grand

d'où l'importance de prendre une matrice de dimension assez grande sinon

l'on risquera de ne pas parcourir tous les états. On parle dans ce cas

d'échantillonnage important. états possibles qui est un nombre spectaculairement grand

d'où l'importance de prendre une matrice de dimension assez grande sinon

l'on risquera de ne pas parcourir tous les états. On parle dans ce cas

d'échantillonnage important.

1.C.2.1. Processus11(*) de Markov

Dans une simulation par Monte Carlo l'étape difficile

est la détermination de l'estimateur approprié. Au départ,

nous ne pouvons pas simplement choisir au hasard certains états et les

accepter ou rejeter en les prenant équiprobables à . Le résultat ne sera pas meilleur que celui issu d'un

échantillonnage hasardeux. L'on court le risque de

répéter virtuellement certains états autant que leurs

probabilités sont exponentiellement petites. Les algorithmes des

méthodes de Monte Carlo utilisent le processus de Markov pour choisir

les états utilisés (considérées). . Le résultat ne sera pas meilleur que celui issu d'un

échantillonnage hasardeux. L'on court le risque de

répéter virtuellement certains états autant que leurs

probabilités sont exponentiellement petites. Les algorithmes des

méthodes de Monte Carlo utilisent le processus de Markov pour choisir

les états utilisés (considérées).

Le processus de Markov est le mécanisme qui

génère un état í du système à partir

d'un autre  connu. L'état généré n'est pas toujours le

même, il parcourt le système à la recherche de nouveaux

états avec une probabilité de transition P connu. L'état généré n'est pas toujours le

même, il parcourt le système à la recherche de nouveaux

états avec une probabilité de transition P sur lesquels il impose deux conditions: sur lesquels il impose deux conditions:

i) elles ne varient pas avec le temps.

2i) elles dépendent uniquement des

propriétés du système sur les états u et

í.

Ceci traduit le fait que la probabilité de transition

d'un état u à un autre í du processus de Markov

est toujours constante et devra satisfaire la relation de fermeture d'un état u à un autre í du processus de Markov

est toujours constante et devra satisfaire la relation de fermeture

(1.34) (1.34)

Dans la simulation de Monte Carlo, nous utiliserons à

répétition le processus de Markov pour générer la

chaîne de Markov de nouveaux états. Il est

généralement utilisé spécialement lorsqu'on veut

partir de n'importe quel état du système et générer

une suite de configurations de certains états précis (final) par

exemple.

Pour parachever cette étude, il est utile d'imposer

deux nouvelles conditions : « Ergodicité » et

« balance détaillée ou spécifique »

sur le processus de Markov.

1.C.2.2. Ergodicité

La condition d'Ergodicité est le fait qu'il sera

possible par notre processus de Markov d'atteindre n'importe quel état

du système à partir d'un autre si nous évoluons durant un

temps suffisamment grand. Ceci est nécessaire pour atteindre notre

initial, celui de généraliser des états à partir

d'une probabilité correcte dite de Boltzmann. Chaque état  apparaît avec une certaine probabilité non nulle

Pí dans la distribution de Boltzmann. Et si cet état

ne peut-être accessible à partir d'un autre état u ce ne

sera pas un problème, nous continuerons notre processus et dans ce cas

l'on reprendra le schéma à partir de ce nouvel état. apparaît avec une certaine probabilité non nulle

Pí dans la distribution de Boltzmann. Et si cet état

ne peut-être accessible à partir d'un autre état u ce ne

sera pas un problème, nous continuerons notre processus et dans ce cas

l'on reprendra le schéma à partir de ce nouvel état.

La condition d'Ergodicité nous informe que nous pouvons

prendre certaines probabilités de transition nulle dans le processus de

Markov mais ceci ne sera pas le cas pour deux états distincts que nous

prenons dans un espace restreint. En pratique, la plupart des algorithmes de

Monte Carlo configurent toutes les probabilité de transition à

zéro, et il faudra faire attention dans ce cas à ne pas

créer un algorithme qui viole la condition d'Ergodicité.

1.C.2.3. Balance

spécifique12(*)

Cette autre condition du processus de Markov est l'une de

celles qui assurent que la probabilité de distribution de Boltzmann que

nous générerons après que notre système ait atteint

l'équilibre est la plus grande de toutes les autres distributions. La

déviation de cette balance est assez subtile. Comme défini en

introduction, le sens réel de « système à

l'équilibre » : l'équivalence entre les

différents états lors des transitions à

l'équilibre, peut s'exprimer mathématiquement par :

(1.35) (1.35)

Introduite, la relation de fermeture (1.34) sur

l'équation (1.35) conduit à :

(1.36) (1.36)

Si cette équation est satisfaite, la probabilité

pí sera à l'équilibre dans le processus

dynamique de Markov. Mais il peut arriver que la satisfaction de cette

équation ne soit pas totalement efficiente pour garantir que la

probabilité de distribution puisse atteindre pu de n'importe

quel état du système si nous faisons tourner le système

pendant un long temps.

En effet, la probabilité de transition  peut être déterminée comme un élément

de la matrice P13(*). En

considérant peut être déterminée comme un élément

de la matrice P13(*). En

considérant , si nous mesurons le temps mis dans chaque état durant la

chaîne de Markov, alors la probabilité à un instant t + 1

suivant (où sera le système à l'état í)

sera : , si nous mesurons le temps mis dans chaque état durant la

chaîne de Markov, alors la probabilité à un instant t + 1

suivant (où sera le système à l'état í)

sera :

(1.37) (1.37)

Sous forme matricielle, on obtient  (1.38) (1.38)

Où w(t) est le vecteur dont les coordonnées sont

les différents poids statistiques .A l'équilibre ( .A l'équilibre ( à à  ), le processus de Markov satisfera ), le processus de Markov satisfera  (1.39) (1.39)

Toutefois, il est possible au processus d'atteindre

l'équilibre dynamique par rotation de w sur toute la chaîne. En

notant « n » la taille limite du cycle parcouru, on

aura :

(1.40) (1.40)

Si nous choisissons une probabilité de transition (ou

de manière équivalente une matrice de Markov) pour satisfaire la

relation (1.36). Nous garantirons ainsi que la chaîne aura une

simple probabilité d'équilibre de distribution , quelque soit la valeur de « n ». , quelque soit la valeur de « n ».

De ce qui précède nous pouvons dire que nous

sommes informé que rien ne garantie que l'état d'équilibre

généré aura la probabilité de distribution

attendue.

Pour contourner ce problème l'on applique donc une

autre condition à notre probabilité de transition. la condition

de balance spécifique ou

détaillée énoncée telle que:

(1.41) (1.41)

Il est donc alors clair que chaque état qui satisfera

cette condition (1 .41) satisfera alors absolument

(1.35) qui n'est qu'une sommation de (1.41) sur les

différents états concernés. En remarquant la forme

bidirectionnelle équivalente de (1.41), l'on constate bien que la

condition de balance spécifique élimine la notion de cycle qui

incluait la limite « n ». En effet, la balance

détaillée nous informe qu'en moyenne, le système peut

quitter d'un état u vers un autre í indifféremment du

chemin choisi et après un temps infini, l'on aura une probabilité

de distribution . (A . (A  , ,  devra tendre exponentiellement comme les vecteurs propres correspondant

aux fortes valeurs propres de P). devra tendre exponentiellement comme les vecteurs propres correspondant

aux fortes valeurs propres de P).

Observons à nouveau l'équation (1.40), l'on

remarque que les grandes valeurs propres des matrices de Markov P pourront

être équivalentes. Si la limite du cycle de la forme (1.41)

était présente, nous pourrions ainsi avoir des valeurs propres

qui seront des racines complexes, mais la condition de balance

détaillée nous prévient de cette possibilité.

1.C.3. Rapport d'acceptation

De tous ce que nous avons jusqu'ici mentionné comme

élément important pour l'obtention rapide et efficace d'un

système à l'état d'équilibre, nous avons pu

généré un processus de Markov et avec ce dernier, nous

avons pu retrouver de nouveaux états avec une probabilité. Mais

cependant, il est difficile pour nous de prévoir le processus de Markov

approprié si nous nous trouvons dans un état donnée,

à sa bonne probabilité, et recherchons l'état suivant.

Bien qu'il soit encore possible d'utiliser les conditions suscitées,

nous pourrions ainsi suggérer plusieurs processus mais jusque là

sans pouvoir avoir la bonne probabilité de déclenchement, c'est

à dire celle nous permettant de transiter vers un état suivant

tout en respectant les équations (1.34) et

(1.42). (1.42).

La bonne nouvelle cependant est que nous n'aurions pas

à faire cela ! En réalité, il y'a dégât

lorsque nous nous laissons le choix de n'importe quel algorithme pour

générer de nouveaux états et de ce fait il est

nécessaire d'avoir une probabilité de transition souhaitée

par introduction d'une condition d'acceptation du taux de transition.

L'idée cachée derrière cette acceptabilité est la

suivante :

Nous mentionnions précédemment que nous

prévoyons introduire une probabilité de transition de base  si nous le voulions. En posant í = u dans l'équation

(1.42), nous obtenons une tautologie (1 = 1). Ceci voudrait souligner que la

condition de balance détaillée est toujours

vérifiée pour si nous le voulions. En posant í = u dans l'équation

(1.42), nous obtenons une tautologie (1 = 1). Ceci voudrait souligner que la

condition de balance détaillée est toujours

vérifiée pour  quelque soit la valeur de cette probabilité. Nous avons encore

une certaine flexibilité sur comment nous choisirons les autres valeurs

de quelque soit la valeur de cette probabilité. Nous avons encore

une certaine flexibilité sur comment nous choisirons les autres valeurs

de  pour pour . Nous pouvons donc ajuster la valeur de n'importe quelle . Nous pouvons donc ajuster la valeur de n'importe quelle  telle que la règle de fermeture (1.34) soit

vérifiée par simplement compensation de cet ajustement avec un

autre ajustement équivalent mais opposé telle que la règle de fermeture (1.34) soit

vérifiée par simplement compensation de cet ajustement avec un

autre ajustement équivalent mais opposé . La seule dont nous avons à observer est que . La seule dont nous avons à observer est que  ne passe jamais hors de ses limites (soit ne passe jamais hors de ses limites (soit ). Si nous faisons cet ajustement, nous pourrions ainsi nous arranger

pour que l'équation (1.42) soit satisfaite en faisant un changement

simultané aussi sur ). Si nous faisons cet ajustement, nous pourrions ainsi nous arranger

pour que l'équation (1.42) soit satisfaite en faisant un changement

simultané aussi sur  et alors l'on aura conservé leurs rapports. et alors l'on aura conservé leurs rapports.

Autrement dit, ces conditions nous donnent assez de

liberté sur les possibilités d'opérer des transitions sur

chaque site aux probabilités que nous souhaitons. Pour voir cela,

décomposons le rapport de transition en deux parties, soit  où où  est la probabilité sélective (ou la probabilité

d'un état initial u de donner en fin d'étape un autre état

í) et est la probabilité sélective (ou la probabilité

d'un état initial u de donner en fin d'étape un autre état

í) et  étant le rapport d'acceptation. étant le rapport d'acceptation.  (Tel que (Tel que ), nous indique si nous devons commencer sur un état donné

u. Le choix de sa valeur nous est aussi libre. Choisir ), nous indique si nous devons commencer sur un état donné

u. Le choix de sa valeur nous est aussi libre. Choisir  est équivalent à dire la certitude est équivalent à dire la certitude  qui n'est cependant pas un cas que nous rechercherons. Il est donc

à proscrire ! De ce qui précède, nous avons aussi une

totale liberté sur le choix de qui n'est cependant pas un cas que nous rechercherons. Il est donc

à proscrire ! De ce qui précède, nous avons aussi une

totale liberté sur le choix de  depuis la contrainte (1.42) qui fixe le ratio depuis la contrainte (1.42) qui fixe le ratio

(1.43). (1.43).

Remarquons que  ? ? et et peuvent prendre n'importe qu'elle valeur souhaitée. peuvent prendre n'importe qu'elle valeur souhaitée.

Notre contrainte supplémentaire donnée par la

relation de fermeture (1.34) sera aussi satisfaite étant donnée

que la somme limitera à l'état de la chaîne de Markov

où nous avons commencé la sommation. Le cycle peut donc

être déterminé à n'importe quelle niveau !

Ainsi, dans le but de créer notre algorithme de Monte

Carlo, nous créerons un algorithme qui générera les

états successifs simplement avec les données de  et nous sélectionnerons ensuite les états qui nous sont

utiles par la condition d'acceptation et nous sélectionnerons ensuite les états qui nous sont

utiles par la condition d'acceptation que nous choisirons telle qu'elle satisfera à l'équation

(1.43). Ceci devra satisfaire toutes les requêtes des probabilités

de transition tel que lorsque l'algorithme atteindra l'équilibre, l'on

tirera la vraie probabilité de Boltzmann. que nous choisirons telle qu'elle satisfera à l'équation

(1.43). Ceci devra satisfaire toutes les requêtes des probabilités

de transition tel que lorsque l'algorithme atteindra l'équilibre, l'on

tirera la vraie probabilité de Boltzmann.

Tout ceci paraît plaisant, mais il faudra tenir compte

de ce que si le taux d'acceptation est faible, notre algorithme paraîtra

immobile, ce qui bloquera naturellement l'évolution du système.

Il faut donc trouver un algorithme qui évoluera entres les états

pour un large échantillonnage. Il est impératif à veiller

à raccourcir le temps de traitement de notre matrice. Rechercher donc un

algorithme qui respectera un temps convenable par rapport à

l'échantillonnage qu'on dispose. Il suffit pour cela de remarquer que

l'équation (1.43) ne fixe que le taux d'acceptation entre deux états distinct dans n'importe quelle

direction avec la contrainte que ce taux est compris entre 0 et 1 bien qu'on

puisse mathématiquement le multiplier proportionnellement par un

coefficient réel. d'acceptation entre deux états distinct dans n'importe quelle

direction avec la contrainte que ce taux est compris entre 0 et 1 bien qu'on

puisse mathématiquement le multiplier proportionnellement par un

coefficient réel.

La meilleure chose que nous puissions faire toutefois est de

le garder, mais de tenir compte des caractéristiques des

différents états en présence dans la probabilité de

sélection  et d'introduire aussi faiblement que nous pouvons le rapport

d'acceptation idéal (c'est à dire celui qui génère

de nouveaux états avec la vraie probabilité de transition). et d'introduire aussi faiblement que nous pouvons le rapport

d'acceptation idéal (c'est à dire celui qui génère

de nouveaux états avec la vraie probabilité de transition).

Le bon algorithme est celui qui conserve le rapport

d'acceptation (c'est à dire ) ! ) !

Chapitre: 2

Etude

des phénomènes critiques À l'aide du modèle d'ISING

à 2 D.

2.1. Les phénomènes

critiques

Les phénomènes critiques découlent des

transitions de phases qui peuvent s'établir dans un système

quelconque. Il s'agit en effet de la configuration du système à

l'instant précis de la transition qui est une phase critique. Le

système obéit à cet instant à des lois et

propriétés difficilement appréciables et qui

présentent un intérêt particulier à l'étude.

Lequel intérêt nous allons aborder dans ces prochaines lignes

où nous étudierons plus partiellement les configurations du

système à cette zone critique pour enfin déterminer les

paramètres physiques qui nous intéressent. Tout d'abord nous nous

éclairerons sur les notions de transitions de phases.

2.1.1. Les transitions de

phase

L'exemple fondamental, bien connu que l'on peut

présenter pour exprimer la notion de phase, est celui de l'eau dans ses

différents états. Nous savons que l'eau possède 3

différents états ou aspects: Solide (glace), Liquide (eau),

Gazeux (vapeur). Le passage d'une phase à une autre quotidiennement

observé, peut se décrire par le gel, l'ébullition ou la

sublimation qui, (ces différentes phases) sont

caractérisées par leurs propriétés qualitatives ou

quantitatives, qui sont des modifications de certains paramètres tels

(la pression, le volume, la température). La physique de la

matière condensée est notamment très riche en ces

exemples, qu'on parle du ferromagnétisme, de la

ferroélectricité, des liquides superfluides, de la

supraconductivité, des transitions ordre - désordre dans les

alliages ou encore de la transition de localisation d'Anderson ...etc.

De manière générale, toutes ces

transitions de phase ne sont pas identiques, il en ressort

schématiquement deux classes de transitions dépendamment de la

présence de la chaleur latente. C'est P. Ehrenfest, en 1933 [5] qui

proposa une classification14(*) des différentes transitions à partir du

comportement du potentiel thermodynamique associé (enthalpie libre,

énergie libre ...) :

i) Les transitions de phase du premier ordre

s'accompagnent de discontinuités des grandeurs

thermodynamiques, comme l'entropie et la densité, associées

à des dérivées premières de potentiels

thermodynamiques. (C'est le cas de transitions normales subit par l'eau.)

ii) Les transitions de phase du second ordre

pour lesquelles les potentiels thermodynamiques et leurs

dérivées premières sont continus et qui s'accompagnent de

certaines discontinuités des dérivées secondes de

potentiels thermodynamiques (comme la capacité calorifique). Pour ces

transitions, on passe de façon continue d'une phase à l'autre

sans que l'on puisse parler de coexistence des deux phases. (C'est le cas les

matériaux ferromagnétique.)

On peut généraliser la classification de

Ehrenfest et définir des transitions d'ordre supérieur15(*). Cependant, bien que la

classification d'Ehrenfest a le mérite de mettre en évidence des

différences et des similitudes entre diverses transitions, elle se

limite à des concepts thermodynamiques insuffisants pour bien comprendre

la physique d'une transition.

Par ailleurs, c'est aux travaux du physicien L. LANDAU (1937)

qu'on doit l'interprétation de plusieurs notions observées telles

celle de « brisure de symétrie », de

« paramètre d'ordre », et la classification suivante

:

i) Les transitions sans paramètres d'ordre

qui sont toujours de premier ordre au sens de Ehrenfest.

ii) Les transitions avec paramètres d'ordre.

Si le paramètre d'ordre est discontinu à la transition

celle ci est de premier ordre au sens de Ehrenfest. Elle est d'ordre

supérieur si le paramètre d'ordre est continu à la

transition.

Rappelons d'une part qu'une transition de phase sans Chaleur

latente s'accompagne d'un changement de la symétrie du système.

(Ainsi, si l'on prend l'exemple d'un matériau

ferromagnétique, on sait que celui ci ne possède pas

d'aimantation spontanée à haute température. Par contre,

en dessous de la température de Curie, il apparaît une aimantation

permanente orientée dans une direction bien précise. On dit alors

que la symétrie du matériau a été brisée

à basse température car le milieu n'est plus qu'invariant par une

rotation autour d'un axe parallèle à l'aimantation)[5]. D'autres

part, le paramètre d'ordre est une grandeur physique qui

caractérise une transition. Il est nul dans la phase la plus

symétrique (généralement la phase haute

température) et qui devient non nulle dans la phase la moins

symétrique (la phase ordonnée à basse température).

Le paramètre d'ordre des transitions de phase magnétique est

l'aimantation M

Pour l'exemple de l'eau, [8], l'on peut de ce qui

précède dire qu'il existe un point particulier dans son diagramme

de phase. Ce point dit critique, caractérisé par une

température de 647 K et une pression de 217 atmosphères.

Au-delà de ce point, il n'y a plus de distinction entre liquide et

vapeur. Il ne reste qu'une seule phase fluide et l'on ne peut plus faire

bouillir de l'eau. Près du point critique, il existe des variations de

densité sur toutes les échelles de longueurs. Elles apparaissent

sous la forme de gouttes de liquide intimement mélangées à

des bulles de gaz. La taille de ces gouttes et celle des bulles varient de la

taille d'une molécule à celle du récipient. Plus

précisément, au point critique, la longueur

caractéristique des fluctuations les plus grandes devient infinie, mais

les fluctuations les plus petites n'en disparaissent pas pour autant.

Cette attitude observée sur cet exemple fondamental

(l'eau) nous induit alors d'autres notions que nous étudierons plus

bas.

2.1.2. L'exposant critique (sa

mesure) et les classes d'universalités

T >>  T > T >  T = T =

î

î et très petits î et augmentent

î et très grands

Les spins dans le modèle d'ISING se regroupent en

cluster (Région localement ordonnée de taille îd

)16(*), î

appelée « longueur de corrélation » (c'est la

dimension du cluster c'est à dire du bloc de spins parallèles);

les fluctuations en générale gouvernent le comportement du

système près de la transition [5], à l'approche de la

température critique (notée ), il peut exister un laps de temps ô appelé

« temps de corrélation »17(*) qui diverge avec î. Ce

phénomène peut être schématisé tel à

la figure ci-contre : ), il peut exister un laps de temps ô appelé

« temps de corrélation »17(*) qui diverge avec î. Ce

phénomène peut être schématisé tel à

la figure ci-contre :

Figure 2.1 :

schématisation des regroupements de spin en fonction de la

température

Pour l'étude des phénomènes critiques, il

est approprié de travailler avec une nouvelle variable appelée

« température réduite ». Les grandeurs :

le paramètre d'ordre, la chaleur spécifique, la longueur de

corrélation etc. ... peuvent être décrites par une loi en

puissance `t'.

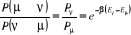

Où  (2.1). (2.1).

À l'approche de la transition de phase (t ? 0 quand

ô >  ), la divergence de la longueur de corrélation est

proportionnelle à la température réduite par la relation. ), la divergence de la longueur de corrélation est

proportionnelle à la température réduite par la relation.

(2.2). (2.2).

La quantité positive non entière í

appelée « exposant critique » est définie par

[5] :

(2.3). (2.3).

Remarquons que la température t peut être prise

des deux côtés de  (à gauche ou à droite du nombre réel (à gauche ou à droite du nombre réel ) pour obtenir une même valeur de î d'où la valeur

absolue sur l'équation (2.2). ) pour obtenir une même valeur de î d'où la valeur

absolue sur l'équation (2.2).

Dans les simulations de Monte Carlo, í est

indépendant de l'algorithme utilisé, mais dépend de la

matrice utilisée : í a différentes valeurs qu'on soit

en dimension 2 ou 3 [5].

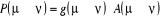

Par ailleurs, il existe d'autres exposants critiques, plus

particulièrement ceux qui nous intéressent proviennent de la

susceptibilité et de la chaleur spécifique qui découlent

directement de la divergence de la longueur de corrélation. De

même que (2.2), l'on a :

et et  (2.4) (2.4)

2.1.2.1. Notion

d'universalité

L'universalité d'une quantité repose sur son

invariance par rapport aux diverses transformations dans lesquelles elle

intervient. Ainsi, [5] l'hypothèse d'universalité proposée

en 1971 par L. Kadanoff et confirmée par la méthode du groupe de

renormalisation stipule qu'une quantité est dite

« universelle » si elle ne dépend que de certains

caractéristiques qualitatives essentielles du système qui

sont :

La dimension de l'espace physique (d),

La dimensionnalité du paramètre d'ordre

(n),

La portée d'interaction et leurs

anisotropies,

La symétrie du système.

Ces facteurs définissent ainsi une classe

d'universalité, chacune caractérisée par un ensemble

d'exposant critique. En l'absence d'un champ extérieur, nous pouvons

exprimer le comportement critique des grandeurs que nous manipulons dans le

tableau ci-dessous [5]:

Tableau 2.1 : Expressions

de quelques grandeurs physiques en fonction de leurs exposants

critiques

|

Grandeur physique

|

Exposant

|

Définitions

|

Conditions

|

|

Chaleur spécifique

|

á

á'

|

C t-á

C (-t-á)

|

t > 0

t > 0

|

|

Paramètre d'ordre

|

â

|

(-t-â)

|

t < 0

|

|

Susceptibilité isotherme

|

ã

ã

|

÷T t-ã

÷T (-t-ã)

|

t > 0

t < 0

|

|

Longueur de corrélation

|

í

í'

|

î t-í

î (-t-í)

|

t > 0

t < 0

|

|

Fonction de corrélation

|

|

g(R) R-(d-2+)

|

t = 0

|

Pour un système en dimension 2 (d =2), on peut citer

dans les cas des interactions à courtes portées les 3 classes

fondamentales représentées par les modèles d'Ising (n =

1), XY (n = 2) et Heisemberg (n= 3). En généralisation, le

tableau (2.2) suivant regroupe l'essentiel des classes d'universalité

avec des exemples à l'appui lorsqu'ils existent [12].

Tableau 2.2 : Classe

d'universalité et modèles associés

|

Classe d'universalité

|

Modèle théorique

|

Système physique

|

Paramètre d'ordre

|

|

d = 2

|

n = 1

|

Modèle d'Ising à deux dimensions

|

Films absorbés

|

Densité de surface

|

|

n = 2

|

Modèle XY à deux dimensions

|

Films d'Hélium 4

|

Concentration de la phase superfluide

|

|

n = 3

|

Modèle d'Heisenberg à deux dimensions

|

|

Aimantation

|

|

d > 2

|

n =

|

Modèles sphériques

|

Aucun

|

|

|

d = 3

|

n = 0

|

Marche aléatoire sans croisement

|

Configuration des polymères à longue

chaîne

|

Densité des extrémités des chaînes

|

|

n = 1

|

Modèle d'Ising à trois dimensions

|

Aimant uni-axial

|

Aimantation

|

|

Fluide aux voisinages d'un point critique

|

Différence de densité entre phase

|

|

Liquide au voisinage du point de mélange

|

Différence de concentration

|

|

Alliage d'une transition ordre - désordre

|

Différence de concentration

|

|

n = 2

|

Modèle XY à trois dimensions

|

Aimant plan

|

Aimantation

|

|

|

Hélium 4 près de la transition super fluide

|

Concentration de la phase superfluide

|

|

n = 3

|

Modèle d'Heisenberg à trois dimensions.

|

Aimant isotrope

|

Aimantation

|

|

d 4

|

n = -2

|

|

Aucun

|

|

|

n = 32

|

Chromodynamique quantité

|

Quarks liés dans les protons, les neutrons, etc ...

|

|

2.1.2.2. Fluctuations critiques et

ralentissement critique

Lorsque nous approchons le point critique, ils se

présentent des fluctuations plus grandes, observées sur nos

grandeurs habituelles, c'est le fait des phénomènes critiques.

Reprenons l'exemple de l'eau présenté au paragraphe sur les

transitions de phases ; au cours d'une transition critique, les

fluctuations spatiales de certaines grandeurs thermodynamiques possèdent

toutes les échelles de longueurs possibles. Ce phénomène

est relativement inhabituel pour le physicien qui généralement se

concentre sur une échelle de longueur donnée pour résoudre

un problème.

Ces fluctuations ralentissent la marche du processus Markovien

et par là induisent un ralentissement du processus. Il est dit critique

à ces températures environnent . Le temps de corrélation grandi dangereusement, nous le

retrouverons par les corrélations existant entre états. . Le temps de corrélation grandi dangereusement, nous le

retrouverons par les corrélations existant entre états.

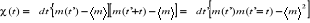

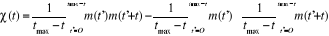

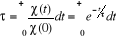

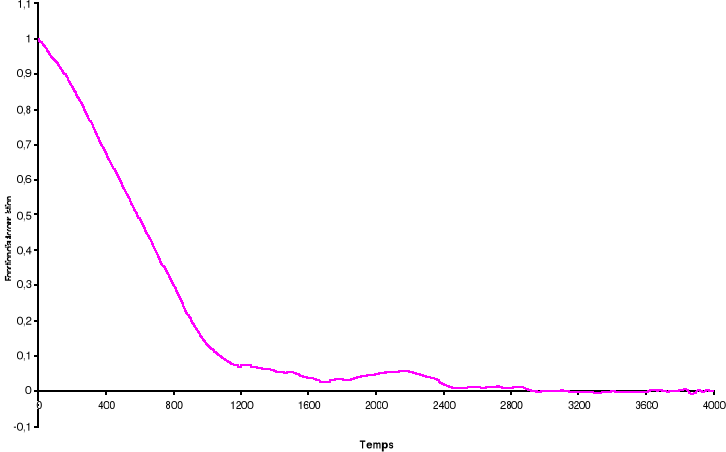

2.1.2.3. Fonction d'auto

corrélation de l'aimantation

Dans une simulation, il est en général beaucoup

plus facile de calculer la fonction de corrélation telle définie

au 1er chapitre (équations 1.26 et 1.27 du §A.1.2)

dès lors que l'on se place à l'état d'équilibre.

Lorsqu'on opère des mesures d'aimantation ou d'énergie sur divers

systèmes de même dimension, l'on constate qu'ils arrivent presque

simultanément à la transition. Ce qui nous permet de penser qu'il