|

Année universitaire: 2015-2016

REPUBLIQUE TUNISIENNE

MINISTERE DE

L'ENSEIGNEMENT SUPERIEUR

ET DE LA RECHERCHE SCIENTIFIQUE

UNIVERSITE TUNIS

EL MANAR

DEPARTEMENT DES SCIENCES DE L'INFORMATIQUE

RAPPORT De Projet de Fin d'Etudes

Présenté en

vue de l'obtention du

Diplôme National d'INGÉNIEUR EN INFORMATIQUE

Sécurisation

Optimisation et virtualisation D'un serveur linux

Au SEiN DE

Élaboré par:

M. Kortli MOHAMED ALi

Encadré par :

Dr. Kaffel-Ben Ayed HELA (FST)

M. Mahjoub OuSSAMA (SOTuTECH)

Dédicaces

Amon adorable mère qui a tout sacrifié pour que

j'arrive là où je suis. Amon père qui m'a aidé

à être autonome dans ma vie et trouver mon chemin.

Amon cher frère Abdelkader et ma famille pour ses

encouragements pour que je puisse aller jusqu'au bout dans mes

études.

Atous mes amis que j'aime et qui m'ont toujours

supporté dans les moments durs de mes dernières années et

qui supporte mon manque quasi permanent de disponibilité à leur

égard.

Atous mes chers collègues activistes dans les

communautés technologiques où j'ai trouvé la passion

informatique conjugué avec l'organisation des événements

et la concrétisation des connaissances techniques.

Remerciements

Au terme de ce travail de fin d'études,

réalisé à la société Sotutech en

collaboration avec Faculté des Sciences de Tunis, je tiens à

remercier vivement Monsieur Mahjoub Oussama pour son assistance lors de la

réalisation de ce projet, pour sa disponibilité qui m'a permis de

mener à terme ma tâche. Son encadrement m'a été

très bénéfique.

Je voudrais, également, exprimer toute ma gratitude

à Madame Hela Kaffel-Ben Ayed pour son suivi de près de

l'avancement de ce projet, pour les conseils judicieux qu'elle n'a cessé

de me prodiguer, ainsi pour la précieuse aide qui a permis

d'amé-liorer la qualité de ce rapport.

Enfin, je voudrais remercier tous mes enseignants. Sans le

savoir faire qu'ils n'ont cessé de me communiquer, ce stage n'aurait pu

être mené à bien.

iii

Table des matières

Dédicaces i

Remerciements ii

Introduction Generale 2

1 Étude préliminaire 4

1.1 Intoduction 4

1.2 Présentation de l'organisme d'accueil 4

1.3 Présentation du projet 4

1.3.1 Problématique 5

1.3.2 Objectif du projet 5

1.3.3 Besoins fonctionnels 6

1.3.4 Besoins non fonctionnels 6

1.4 Audit de sécurité 6

1.4.1 La Sécurité Informatique 8

1.4.2 Étude des failles de sécurité d'un

système Linux 9

1.4.3 Techniques de piratage et logiciels d'audit de

sécurité 11

1.5 Étude des Solutions techniques existantes des failles

et attaques 22

1.5.1 Solutions de détection d'intrusion 22

1.5.2 Solutions de prévention d'attaque force brute

23

1.5.3 Solutions de simulation d'intrusion 24

1.6 Conclusion 25

2 Sécurisation du serveur 26

2.1 Adoption de la politique de sécurité 26

2.2 Stratégie de base de sécurisation du serveur

27

2.2.1 La mise à jour du système 27

2.2.2 la minimisation du système 28

2.2.3 L'isolation du serveur et la protection de son accès

30

2.3 Les pare-feux et les anti-crackages 37

2.3.1 FirewallID 37

2.3.2 Fail2ban 40

2.4 Système de détection d'intrusion IDS 42

|

iv

|

|

Table des matières

|

|

|

2.4.1 Les détecteurs d'intrusion locales HIDS

2.4.2 Le détecteur de balayage de ports portsentry

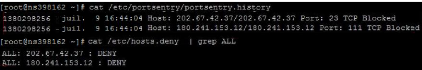

2.4.3 OSSEC

2.4.4 Les détecteurs d'intrusions réseau NIDS

|

43

47

48

49

|

|

2.5

|

Le simulateur d'intrusion Nessus

|

52

|

|

2.6

|

Surveillance du système

|

54

|

|

|

2.6.1 Logwatch

|

54

|

|

|

2.6.2 NtopNG

|

54

|

|

|

2.6.3 Webmin

|

55

|

|

2.7

|

La sauvegarde et la restauration

|

56

|

|

2.8

|

Conclusion

|

59

|

|

3

|

Optimisation des performances et virtualisation du

serveur

|

60

|

|

3.1

|

Optimisation des performances

|

60

|

|

|

3.1.1 Pourquoi optimiser les performances

|

60

|

|

|

3.1.2 Mesure de performance

|

61

|

|

|

3.1.3 Optimisation des performances

|

62

|

|

3.2

|

Virtualisation du serveur

|

64

|

|

|

3.2.1 Virtualisation : cadre d'emploi et concepts

généraux

|

64

|

|

|

3.2.2 Les risques liées à la virtualisation et les

recommandations de sécurité . . .

|

69

|

|

|

3.2.3 Recommandations de sécurité

|

71

|

|

|

3.2.4 Virtualisation du serveur

|

72

|

|

3.3

|

Conclusion

|

76

|

|

4

|

Conclusion et perspectives

|

77

|

v

Table des figures

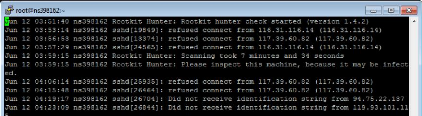

1.1 Exemple des tentatives d'accès ssh 5

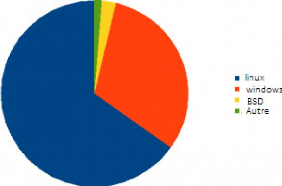

1.2 Distribution du marché Serveurs en 2015 [IMS

research] 7

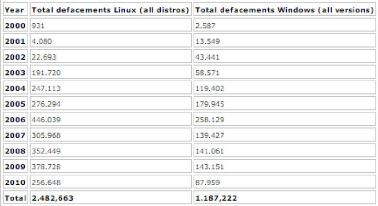

1.3 Statistique des attaques sur Linux X Windows [http ://

www.zone-h.org] 7

1.4 Version de glibc 10

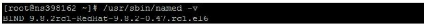

1.5 Version bind du serveur 10

1.6 Répartition des cibles de DDOS [http ://

www.kaspersky.fr/] 12

1.7 Requêtes ICMP(ping) 13

1.8 Liste des ports ouverts et les applications

associées 13

1.9 Interface wireshark 15

1.10 Filtre wireshark 15

1.11 Résultat sniffing avec wireshark 15

1.12 Syntaxe tcpdump 16

1.13 Exemple de capture des paquets avec tcpdump 17

1.14 Découverte des ports ouverts avec nmap 18

1.15 Syntaxe de base pour Hydra 19

1.16 Attaque par dictionnaire avec l'outil Hydra 19

1.17 Attaque force brute sur ssh avec hydra 19

1.18 Syntaxe de base pour Medusa 20

1.19 Interface graphique hoic et loic 21

1.20 Rapport de scan de simulateurs d'intrusions Nessus

21

2.1 Politique de sécurité 27

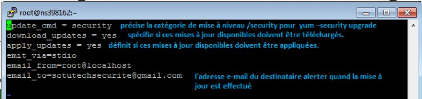

2.2 Exemple de fichier de configuration yum-cron 28

2.3 Exécution du service yum cron 28

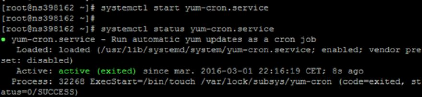

2.4 Liste des services installés 29

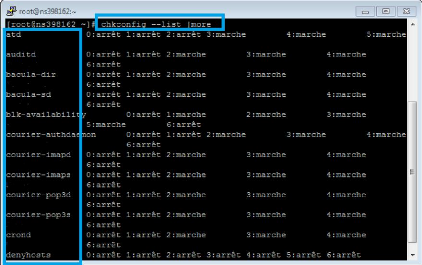

2.5 Authentification SSH 31

2.6 Exemple de fichier de Configuration ssh 31

2.7 Génération des clés rsa 32

2.8 Configuration de l'authentification par clé

publique en utilisant PuTTY sur un

ordinateur Windows 33

2.9 Configuration d'alerte login 33

2.10 Exemple alerte login 34

2.11 Exemple plug-in ssh sous pam 35

vi Table des figures

2.12 Stratégie du mot de passe avec pam-unix et

pam-cracklib 36

2.13 Test de stratégie du mot de passe 36

2.14 Principe de fonctionnement du firewallId 38

2.15 Exemple d'un script firewall 39

2.16 Exemple d'actions fail2ban 40

2.17 Mécanisme de fonctionnement fail2ban 41

2.18 Blocage d'une connexion ssh par fail2ban 41

2.19 Liste des ip bloquées par fail2ban 41

2.20 Architecture d'une plateforme de détection

d'intrusion 42

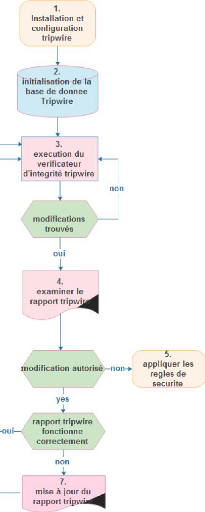

2.21 Diagramme de fonctionnement de tripwire 44

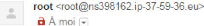

2.22 Exemple d'alerte tripwire 45

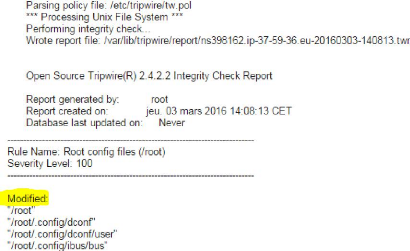

2.23 Test de fonctionnement de etckeeper 46

2.24 Exemple d'alerte de detection de rootkit 47

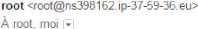

2.25 Échec d'attaque nmap dû à portsentry

48

2.26 Liste d'adresse ip bloquée par portsentry 48

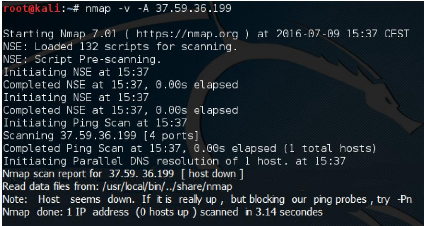

2.27 Processus de traitement d'un incident par OSSEC 49

2.28 Structure du règle snort 50

2.29 Exemple de règle snort de détection d'une

injection sql 50

2.30 Diagramme cas d'utilisation snort 51

2.31 Diagramme de séquence snort 51

2.32 Séquence d'opérations Nessus 52

2.33 Diagramme cas d'utilisation Nessus 53

2.34 Exemple d'un rapport Nessus 53

2.35 Exemple de rapport logwatch du fichier log ssh 54

2.36 Top Hosts (Send-Receive) 55

2.37 Liste des services accessibles via webmin (exemple

FirewallID) 56

2.38 Architecture de Bacula 57

2.39 Restauration du sauvegarde avec bacula 58

2.40 Script de sauvegarde 58

3.1 quelque Statistiques de performance de divers année

61

3.2 Exemple d'analyse d'un site avant optimisation de

performance 62

3.3 Exemple d'un fichier htaccess avec mod-expires 63

3.4 Exemple d'analyse d'un site après optimisation de

performance 64

3.5 Chronologie de la virtualisation 65

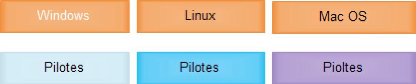

3.6 Architecture de la virtualisation au un niveau

système 66

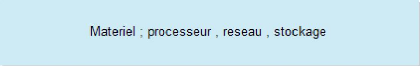

3.7 Architecture de la solution de virtualisation QEMU 67

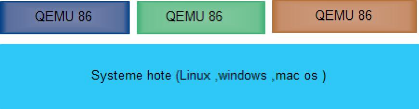

3.8 tableau comparatif de quelques solutions de virtualisation

69

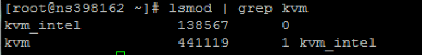

3.9 Vérification de chargement des modules kvm 72

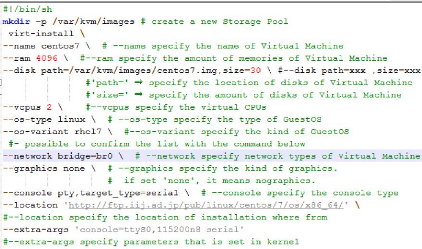

3.10 Script d'installation de machine virtuel centos 7 avec

kvm 73

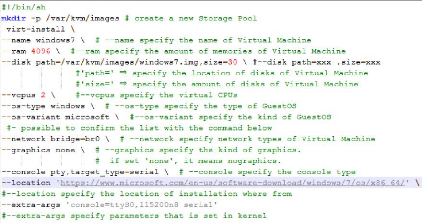

3.11 Script d'installation de machine virtuel windows 7 avec

kvm 73

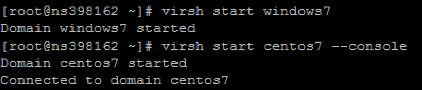

3.12 Démarrage de machine virtuelle 74

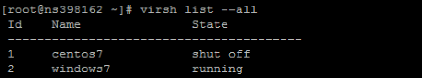

3.13 Liste des machines virtuelles 74

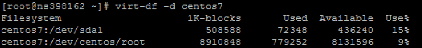

3.14 Usage de disque de la machine virtuelle centos7 74

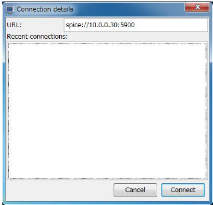

3.15 Interface de saisie d'url de la machine virtuelle 75

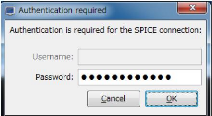

3.16 Interface d'authentification 75

Table des figures vii

3.17 Machine virtuelle centos à distance 75

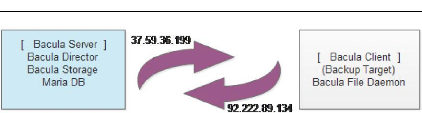

4.1 Topologie de backup avec bacula 79

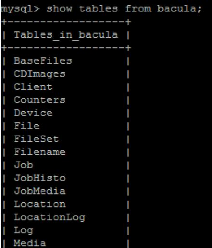

4.2 Liste des tableaux de la base bacula 79

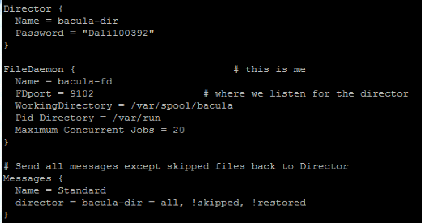

4.3 Fichier de configuration du client bacula 80

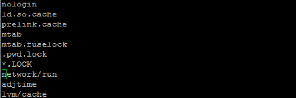

4.4 Liste des fichiers ignorés 81

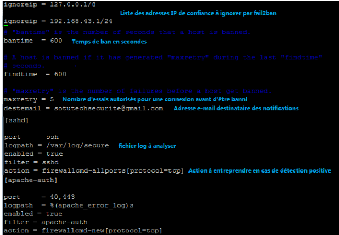

4.5 Configuration de fichier jail.conf 81

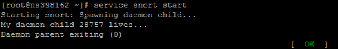

4.6 Démarrage service snort 84

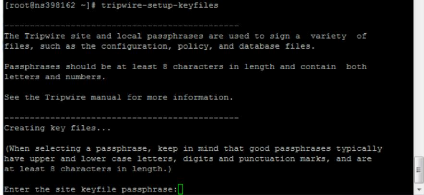

4.7 Initialisation tripwire 85

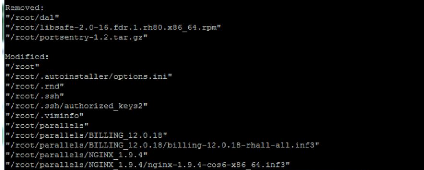

4.8 Vérification d'intégrité de fichier

manuellement avec tripwire 85

1

Liste des tableaux

1.1 Tableau récapitulatif des failles et attaques et

leurs solutions associés 22

1.2 Tableau comparatif des solutions de détection

d'intrusion 23

1.3 Tableau comparatif des simulateurs d'intrusions 25

4.1 Tableau comparatif de quelques solutions de virtualisation

69

2

Introduction Générale

Dés son invention en 1989 ,le web vit de grand

progrès. Fabricants, opérateurs et autres grandes entreprises

anticipent et innovent afin d'investir dans ce marché . De grandes

batailles ce sont livrées autour de ce dernier et ceci n'est que la

conséquence de l'importance que semble avoir le web dans nos vies.En

effet plus que Trois milliards de personnes utilisent Internet et par suite le

web ,soit un demi de la population mondiale.

Le monde du web nécessite obligatoirement la

présence du SERVEUR WEB et des prestataires spécialisés

appelés hébergeurs web.Il existe des différents types de

serveurs web soit Windows soit Linux.

Avec l'arrivée de l'informatique, des réseaux,

puis d'Internet, les vols d'informations physiques se sont peu à peu

transformés en intrusions informatiques. Il devient donc essentiel que

les données stockées sur des serveurs soient suffisamment

protégées et sécurisées. Pour cela, de nombreuses

techniques de sécurisation sont mises en place, afin d'assurer le

respect de bonnes pratiques de sécurités (comme celles

définies dans la série des normes ISO 27000 ).

La sécurité des Serveurs d'informations

aujourd'hui fait partie des priorités des directions des systèmes

d'informations . Mais ni les techniciens ( développeurs, administrateurs

systèmes), ni même les utilisateurs, sont suffisamment

formés et sensibilisés à la sécurité

informatique. Le postulat de Nicolas Ruff, « la sécurité est

un échec », [2] est, 4 ans plus tard, toujours d'actualité.

Peu d'entreprises disposent d'un niveau de sécurité suffisant

pour protéger convenablement leurs données.

De la même façon, on remarque qu'il est

impossible pour un Serveur web d'avoir une sécurité absolue et

à toute épreuve. Il faut donc recourir à des techniques

différentes que la sécurisation pure afin de s'assurer du niveau

de fiabilité du système d'information

La première technique, l'audit de

sécurité, permet de détecter les failles et les

vulnérabilités en amont et d'obtenir un aperçu du niveau

de sécurité du Serveur. La seconde technique est la

détection d'intrusions. Elle permet, comme son nom l'indique, de

détecter des intrusions à posteriori, à partir d'une liste

de critères définissant les activités anormales et

malicieuses qui pourraient survenir.La troisième technique est la

Surveillance : Technique permettant d'analyser, de contrôler et de

surveiller en temps réel l'état du Serveur.

C'est dans ce contexte qu'il nous a été

confié de réaliser une mission de sécurisation

,optimisation et virtualisation D'un serveur Linux chez SOTUTECH .

le travail effectué dans ce projet de fin

d'études est répartie en quatre chapitres :

Le premier chapitre est dédié à

présenter le cadre général de notre projet ensuite nous

allons présenter la problématique pour extraire ensuite les

besoins fonctionnels et non fonctionnels. Puis nous allons aborder

l'état de l'art dans lequel nous présentons les

différentes failles et techniques utilisées Lors d'une attaque

informatique et le choix de la solution adoptée.

Dans le second chapitre, nous allons détailler la

solution à réaliser pour augmenter la sécurité

Introduction 3

du serveur et le test de validation de solution

proposée.

Dans le troisième chapitre, nous allons proposer de

nouvelles solutions techniques pour optimiser les performances du serveur en

cas de forte sollicitation des ressources contenant La virtua-lisation du

Serveur.

Finalement, la conclusion générale présente

le bilan de ce projet, les apports de point de vue savoir-faire ainsi que les

perspectives de notre contribution.

4

Chapitre1

Étude préliminaire

1.1 Intoduction

L'étude préliminaire présente la partie

la plus importante dans un projet vu qu'il permet de tracer les grandes lignes

des parties implémentation et réalisation.

Le présent chapitre aura pour objectif la

présentation du cadre général du projet. Par la suite, une

partie sera réservée aux exigences auxquelles notre travail doit

répondre . A la fin pour situer notre projet, nous présenterons

l'état de l'art .

Le projet a été réalisé au sein de

SOTUTECH , dont nous donnerons un petit aperçu, dans le cadre de la

préparation de mémoire de fin d'études

présenté en vue de l'obtention du diplôme

d'ingénieur en informatique à la Faculté des Sciences de

Tunis pour l'année universitaire 2015/2016

1.2 Présentation de l'organisme d'accueil

SOTUTECH est une Société de Services en

Informatiques et Ingénierie (SSII) spécialisée dans

l'ingénierie logicielle, l'infogérance et le consulting. Ses

équipes en Tunisie et en France apportent leurs expertises et leurs

expériences en fournissant les meilleures solutions IT adéquates

aux différents besoins de ses clients.

Sotutech a des multiples activités et missions Dans le

domaine de l'informatique et des technologies de l'information et de la

communication,elle est notament specialisée dans le conseil qui fait

partie de l'un de ces services, ainsi que les solutions d'entreprises et

l'ingénierie logicielle : Le conseil en stratégie de la DSI, Le

conseil en management de la DSI, Le conseil en organisation d'une DSI, Le

conseil IT, L'intégration de l'organisation et du système

d'information, L'intégra-tion des technologies Les Applications Web :

J2EE, PHP, .Net Les Applications Desktop : Java, C sharp Les Applications

Mobiles: Android, iOS, Windows Mobile

1.3 Présentation du projet

Tout projet démarre à partir d'une

problématique traduisant ainsi une idée qui va se

développer de proche en proche pour arriver au stade de

l'exécution. Au cours de ce chemin, nous adoptons

généralement une méthodologie bien choisie au

préalable.

1.3. Présentation du projet 5

6 Chapitre 1. Étude préliminaire

1.3.1 Problématique

Actuellement il existe environ 156 millions sites Web, sont

évolués du simple texte et pages de lien hypertexte basées

aux normes actuelles d'applications de productivité mobile dynamique. En

raison de l'augmentation de la demande des moyens d'accéder aux demandes

de plus en plus sophistiquées sur Internet, le nombre d'applications web

développées récemment a explosé suite à une

utilisation sur plusieurs plateformes.

Les sites web sont les vitrines sur le web de chaque

société. Les factures, les salaires, les comptes bancaires, les

données secrets sont tous accessibles via le web.C'est pourquoi, les

sites internet ont toujours été des éléments

sensibles de la sécurité dont l'intérêt pour leurs

sécurités augmente de façon spectaculaire par rapport au

nombre d'applications vulnérables.. En effet, un site web est un serveur

public accessible par n'importe qui, n'importe où y compris les

Hackers.Les sites web sont héberges chez des serveurs, par la suite, ces

serveurs sont donc continuellement sollicités en terme de tentatives de

piratage.Pour s'en convaincre, il suffit de consulter les logs du serveurs :

Les tentatives d'accès au contenu du serveur

FIGURE 1.1 - Exemple des tentatives d'accès ssh

L'enjeu majeur pour l'équipe SOTUTECH est de garantir

les données de leurs clients sécu-risées,d'assurer la

disponibilité de leur service et d'améliorer l'expérience

de navigation de inter-nautes.

SOTUTECH met à la disposition de ses clients des

solutions d'hébergement des sites et des applications web

adaptées aux besoins de nombreux secteurs d'activité.

1.3.2 Objectif du projet

Aujourd'hui, SOTUTECH est idéalement placée pour

offrir des solutions parfaitement intégrées permettant de

garantir un haut niveau de performance et de sécurité totale

c'est pour cela que J'ai été chargé de concevoir et

d'implémenter la sécurisation et l'optimisation de la performance

de nos serveurs web. Le piratage des serveurs sera alors bien plus complexe, et

si cela venait de se produire, les restaurations automatiques permettront une

réinstallation rapide et automatique et de virtualiser les serveurs

Linux .

Le premier objectif de ce stage a été de

déterminer l'état de l'art des différentes failles connues

et les techniques de piratage des serveurs (failles aussi bien dans la

configuration du serveur qu'au niveau des applications web

installées).

Ensuite, j'ai cherché à associer à chaque

problème ou faille identifiée, la solution technique de

sécurisation associée qui sera mise en place,

développée ou installée.

Puis , déployer ou développer une solution de

sauvegarde et restauration automatique de l'ensemble des environnements web et

inclure la possibilité de sauvegarder/restaurer en utilisant

également la plateforme plesk .

Une autre objectif de ce stage est qu'il devait

également me permettre de mettre une solution de sécurité

et de monter en compétences sur plusieurs sujets, en particulier la

détection d'intrusions .Au cours de ce stage il faut intégrer

aussi une solution de monitoring de l'état qui permet d'alerter en cas

de failles de sécurité.

Enfin, Proposer de nouvelles solutions techniques pour

optimiser les performances du serveur en cas de forte sollicitation des

ressources et proposer une solution de virtualisation des serveurs Linux.

1.3.3 Besoins fonctionnels

Ces exigences répondent à la question : à

quoi sert notre travail?, nous détaillerons dans ce paragraphe les

besoins fonctionnels autrement dit les objectifs que nous voulons atteindre.

<> Définir une politique de sécurité

<>Corriger les failles de sécurité et

réduire leurs impacts et leurs exploitations par les attaques

.

<>Définir un mécanisme d'isolation du

serveur.

<> Collecter et afficher des informations concernant les

fichiers logs.

<> Identifier et se prémunir des attaques

traditionnels comme les Dos attaques.

<>Implémentation d'un système de

détection d'intrusion.

<> Collecter les alertes concernant les attaques.

<> Surveiller l'état du serveur en temps réel

.

<>Gérer une solution de sauvegarde et restauration

automatique.

<>Proposer de nouvelles solutions techniques pour optimiser

les performances du serveur

<>Déployer une solution de virtualisation .

1.3.4 Besoins non fonctionnels

Ce sont des exigences qui n'affectent pas

spécifiquement le comportement du système mais plutôt

identifient des contraintes internes et externes du travail. Les principaux

besoins non fonctionnels se résument dans les points suivants :

<> Dans la réalisation des différents

étapes de ce projet, il faut tenir compte de la possibilité de

son extension par l'ajout de nouvelles modules ou solutions.

<>Ergonomie: les solutions développées ou

implémentées doivent être facile à manipuler.

<> Test : les solutions doivent montrer leur efficacité suite

à des multiples tests .

1.4 Audit de sécurité

Un audit de sécurité est une partie de la mise

en oeuvre de la sécurité où nous essayons de trouver les

vulnérabilités du système et de proposer des actions pour

améliorer la sécurité. On s'intéresse dans ce que

suit à l'audit de sécurité du système Linux.

D'après une étude d' IMS Research, il y a

aujourd'hui 5 milliards d'équipements connectés à Internet

,et plus de 20 milliards sont envisagés en 2020.les administrateurs

systèmes et réseau se demandent peut être quel est le poids

de chaque OS sur le marché. Dans ce coupon, on essaye à

détailler les parts de marchés que détiennent les

systèmes d'exploitation dans le secteur d'activité des serveurs

basé à des statistiques produite en mai 2015.

La domination de Microsoft sur la poste de travail

répond une domination de Linux du côté serveur, et dans le

Cloud. Les spécialistes le savent bien, mais ils manquent souvent de

chiffres précis pour mesurer cette hégémonie, et percevoir

son évolution. On peut l'estimer à 90%.

1.4. Audit de sécurité 7

FIGURE 1.2 - Distribution du marché Serveurs en 2015

[IMS research]

LINUX présente le standard coté serveur, il est

considéré comme une alternative face aux autres OS. Comme son

part du marché est importante, il présente une cible de choix

pour les pirates. En effet Linux est un os open source Donc il est facile

à parcourir son code à la recherche d'une faille exploitable.

FIGURE 1.3 - Statistique des attaques sur Linux X Windows [http

://

www.zone-h.org]

Ce que nous pouvons dire aussi de ces chiffres est que le

nombre des attaques augmente de manière importante et que Linux est une

cible préférable pour les pirates. Cela montre que Linux a des

trous de sécurité dans la plupart des logiciels applicatifs.

Une bonne compréhension des mécanismes d'attaque

et des failles du système Linux sont à la base de la

sécurité quels que soient les outils utilisés, car il est

possible aujourd'hui de configurer ce système pour atteindre un niveau

de sécurité satisfaisant.

8 Chapitre 1. Étude

préliminaire

Après avoir présenté le poids de Linux

dans le monde des serveurs web et son choix comme cible d'attaque, nous pouvons

maintenant présenter une étude des différentes failles

connues et les techniques de piratage des serveurs afin de poser les bases

nécessaires à la bonne compréhension de ces techniques .

Une bonne compréhension des mécanismes d'attaque et des failles

du système sont à la base de la sécurité quels que

soient les outils utilisés.

Je commencerai cette partie par une introduction à la

sécurité informatique, afin de donner les notions et le

vocabulaire récurrent lié aux solutions de sécurité

proposés. Après Je poursuivrai ce rapport en décrivant les

failles connues et exploitables d'un point de vue pratiques et des

différents outils et techniques de piratage des serveurs, et plus

particulièrement par ceux utilisés lors de mon stage.

Enfin, je terminerai cette partie par la présentation

des solutions où nous allons citer brièvement quelques solutions

existantes et connues qui assurent la sécurité.

1.4.1 La Sécurité Informatique

Avant de pouvoir entrer dans le vif du sujet, il est important

de poser quelques notions de base sur l'informatique, et notamment sur la

sécurité informatique.

La notion de sécurité informatique couvre

l'ensemble des moyens outils, techniques et méthodes pour garantir que

seules les personnes ou autres systèmes autorisés interviennent

sur le système et ont accès aux données, sensibles ou non.

On doit ainsi maîtriser les 3 enjeux suivants :

1. La confidentialité : le fait de s'assurer que

l'information n'est accessible qu'aux personnes autorisées et qu'elle ne

sera pas divulguée en dehors d'un environnement

spécifié.

2. L'intégrité : les personnes

autorisées sont seuls qui ont le droit de pouvoir modifier les

ressources informatiques.

3. La disponibilité : l'assurance que les personnes

autorisées doivent pouvoir accéder à tout instant aux

ressources.

À cela, on peut également rajouter l' enjeu

suivant, qui permet d'atteindre un niveau de sécurité plus

importante.

4. La non-répudiation : signifie la possibilité

de vérifier que l'envoyeur et le destinataire sont bien les parties qui

disent avoir respectivement envoyé ou reçu le message.

La sécurité informatique consiste donc à

s'assurer, qu'à tout instant, les 4 propriétés

précédentes des ressources informatiques sont assurées.

Une démarche de sécurité commence en

premier lieu par l'estimation des enjeux. Puis, l'iden-tification des risques

potentiels est une étape fondamentale qui présente une bonne

pratique pour diminuer les impacts. Elle doit être définie par les

étapes suivantes, l'identification des actifs qui seront infectés

en cas d'attaque ,dans notre cas c'est le serveur Linux, identification des

vulnérabilités et leurs impacts possibles sur la

confidentialité, la non-répudiation, la disponibilité et

l'intégrité du serveur et les moyens possibles pour se

prémunir, car il est inutile de mettre en place des solutions de

prévention ou de protection sans avoir au préalable estimé

exhaustivement les risques potentiels.

L'identification des différents types de failles et

attaques peut aider dans la détermination de leur dangerosité et

des contrôles adaptés permettant de réduire leur impact

potentiel. Ils sont des sources effectives d'incidents pouvant entraîner

des effets indésirables et graves sur le serveur. Ces menaces peuvent

être classées selon leur source, leur type et leur action et

effet.

Une fois les risques sont identifiés, il est alors

temps de sélectionner les solutions de prévention en comparant le

coût d'usage et le risque couvert.

Puis, optimiser les solutions de sécurité avec

une mécanisme pour détecter le plus rapidement possible les

attaques et intrusions.

Enfin, il est nécessaire d'identifier des plans secours

basé sur la situation précédente l'attaque.

1.4. Audit de sécurité 9

1.4.2 Étude des failles de sécurité

d'un système Linux

Selon Secunia, qui est une entreprise danoise

spécialisée dans la sécurité informatique,

notamment dans le suivi de vulnérabilités logicielles 66 % des

vulnérabilités peut être exploitée à

distance, ce qui signifie qu'ils sont exposés à un attaquant qui

ne dispose pas d'un compte sur le système, 17 % des

vulnérabilités peut permettre à un pirate d'élever

ses privilèges sur le système vulnérable, ce qui signifie

que le pirate peut être en mesure d'obtenir les privilèges root et

causer des dommages graves illimité.[9]

La question se pose quelles vulnérabilités des

systèmes d'exploitation Linux sont le plus souvent ciblés par des

attaquants malveillants. Bien qu'il y ait un flux non-arrêt de

vulnérabilités exploitables à distance Linux, mais

seulement quelques-uns d'entre eux ont été utilisés pour

les exploits réels contre des nombreux de serveurs.

L'expérience montre que toute application a des

failles; les attaquants ne perdent pas leur temps à faire de la

recherche sur la résolution d'un équation de second degré,

ils essaient de repérer les failles et ils les exploitent.

Ci - dessous, je présente la liste des

vulnérabilités plus couramment exploitée qui

représentent un vrai danger en ignorant les vulnérabilités

liées aux applications hébergées sur le serveur.

Secure Shell (SSH) est un programme

utilisé pour se connecter à un autre système sur un

réseau, exécuter des commandes sur une machine distante et

déplacer des fichiers d'une machine à une autre. Il fournit

l'authentification forte et des communications sécurisées sur des

canaux de communication non sécurisés. SSH est conçu comme

un remplaçant pour rlogin , rsh et rcp . De plus, ssh fournit des

connexions sécurisées. SSH se présente comme une

vulnérabilité en raison de la complexité du protocole et

sa mise en oeuvre est la façon la plus courante d'entrer dans le

système à distance.

Les versions obsolètes de SSH peuvent permettre

à un utilisateur malveillant de se connecter avec un autre utilisateur,

d'insérer des commandes arbitraires en une session, ou pour obtenir un

accès root distant au serveur SSH.

Avec l'utilisation d'un client SSH comme Putty, un bloc de

code peut être ajouter en terminal ce que permet d'allouer un tableau de

taille zéro, ce qui renvoie un pointeur en propre espace d'adressage

coté serveur. Un attaquant pourrait envoyer un long paquet

spécialement conçu qui exploite cette condition, ce qui

exécute un code arbitraire sur le serveur. On parle d'un

dépassement de tampon.

Problèmes d' authentification

générale Linux tels que les comptes sans mot de passe ou

des mots de passe faibles : une des failles de sécurité les plus

communes à tous les systèmes est la mise en place de mots de

passe à bas niveau de complexité voire leur absence. Pour cela,

l'administrateur du système doit être conscient de l'importance de

la mise en place de mots de passe avec un certain degré de

complexité. La préconisation générale est que le

mot de passe respecte un certain nombre de règles : Il doit être

composé d'un minimum de 8 éléments Il doit contenir des

caractères, chiffres, caractères spéciaux Il doit contenir

des caractères majuscules et minuscules Il doit être changé

régulièrement. Mise en place d'un période de rotation. Il

ne doit pas contenir des éléments du login.

L'une des Vulnérabilités fréquentes de

mot de passe est l'existence d'un ou plusieurs comptes avec des mots de passe

peu résistants ce qui facilite son identification en un peu de temps

avec des logiciels spéciales. L'existence d'un compte par défaut

avec un mot de passe connu de tous les experts lors de l'installation d'un

nouveau système ou logiciel, avoir un mot de passe qui a perdu son

caractère secret, fonction de hachage utilisé par système

pour la sauvegarde d'un mot de passe en un format irréversible est non

fiable, les attaques sur les mots de passe tels que password cracking,le

cassage par "Brute Force" ou l'attaque par dictionnaire montrent le risque

lié à cette

10 Chapitre 1. Étude

préliminaire

vulnérabilité

Les Ports ouverts : chaque application,

service, logiciel installé ouvre un certain nombre de ports pour pouvoir

fonctionner. La majorité de ces programmes est installée par

défaut par Linux et leur présence n'est pas toujours utile.

À l'aide des ports ouverts, l'attaquant peut savoir les

services qui tournent, de trouver leurs failles et les exploiter dans son

attaque pour aller plus loin

Anciennes versions de logiciels : Linux

étant loin d'être parfait, des failles sont découvertes

quotidiennement sur la panoplie des logiciels, services qu'il héberge.

Les éditeurs des logiciels essayent de temps en temps de corriger les

failles de leurs applications et les mettre à jour, car à chaque

fois qu'une faille est découverte, elle sera publiée est

exploitable par tous les intéressants.

Configuration incorrecte et incomplète de

programmes Les nouveaux programmas installés possèdent

des configurations par défaut, cela présente une

vulnérabilité liée à Une configuration incorrecte

ou une faille incluse dans cette configuration.

Apache Web Server : les

vulnérabilités dans l'implémentation Apache du serveur Web

et les composants associés peuvent se traduire par déni de

service, la divulgation d'informations, site web défiguration,

l'accès root à distance, ou d'innombrables autres

résultats défavorables.

Vulnérabilité de dépassement de

mémoire tampon dans GNU C Library (glibc) Si

votre glibc version est inférieur à 2.18, vous devez supposer que

votre serveur est vulnérable. Dans notre cas, la version de glibc est

2.12.

FIGURE 1.4 - Version de glibc

Cette vulnérabilité permet aux acteurs locaux ou

distants afin d' exécuter du code arbitraire dans le cadre du

privilège d'utilisateur exécutant la fonction gethostbyname ().

Cette vulnérabilité touche toutes les distributions CentOS 5.x,

6.x, 7.x .

Qualsys, qui a signalé le bug a été en

mesure d'exploiter à distance ce bogue dans un serveur. Alternativement,

programme de test publié par Qualsys exploite la

vulnérabilité pour prendre contrôle du serveur.voir ( http

://

www.openwall.com/lists/oss-security/2015/01/27/9).

Vulnérabilité dans le service DNS BIND

Le 28 Juillet 2015, Internet Systems Consortium a annoncé une

vulnérabilité critique (CVE-2015-5477) dans tous les serveurs DNS

BIND où les versions de 9.1.0 à 9.9.7-P1. Elle permet à un

attaquant distant d'exploiter une erreur dans le traitement des requêtes

TKEY pour lancer une attaque par déni de service (DoS) qui va provoquer

le crash du serveur.

FIGURE 1.5 - Version bind du serveur

1.4. Audit de sécurité 11

La vulnérabilité de Bash "Shell Shock"

Si vous avez un web Linux serveur d' hébergement, il a Bash

pour traiter certaines commandes et si vous ne l' avez pas expressément

patché il, supposer que votre serveur est vulnérable à

pirater. Linux serveurs d' hébergement Web est

généralement activé avec les modules CGI, et ils

pourraient permettre aux commandes d'être transmis à Bash, ouvrant

ainsi les portes aux pirates. Cette vulnérabilité permet aux

pirates aussi d'exécuter des commandes arbitraires et d'obtenir un

accès non autorisé au système. Ce problème est

particulièrement dangereux, car il existe de nombreuses façons

possibles Bash peut être appelé par une application. Toutes les

versions centos antérieures à celles qui sont

énumérées les mises à jour pour cette question sont

vulnérables à un certain degré.

Un pirate qui désire nuire une à une

société par des attaques pratique presque toujours de la

même manière, il s'informe des failles de sécurité

et les exploite.La reste de cette partie décrit en détail cette

stratégie.

1.4.3 Techniques de piratage et logiciels d'audit de

sécurité

1.4.3.1 Techniques de piratage d'un serveur Linux

Les agences de renseignements et des services de

sécurité de nombreux pays considèrent le piratage de leurs

systèmes et réseaux informatiques comme la plus grande menace

nationale. Ce qui était autrefois considéré comme une

blague inoffensive jouée par génies de l'informatique a

maintenant évolué en un crime à égalité avec

tout autre en termes de ses répercussions. Il est

considéré avce la même sévérité que le

terrorisme par de nombreux pays et est condamné par les gouvernements du

monde entier.

En termes simples, le piratage est rien d'autre que la rupture

dans l'ordinateur ou le système de quelqu'un d'autre en contournant les

mesures de sécurité et de voler les informations contenues dans,

ou pire, de saboter l'ensemble du système.

Dans cette partie, nous allons examiner les divers aspects de

piratage.

Dans sa forme la plus élémentaire, le piratage

peut être défini comme le processus de détermination et

l'exploitation ultérieure des diverses insuffisances et les faiblesses

dans un système informatique ou d'un réseau de ces

systèmes informatiques. Cette exploitation peut prendre la forme

d'accès et de voler des informations, la modification de la

configuration, en changeant l'image structurelle du système informatique

et ainsi de suite.

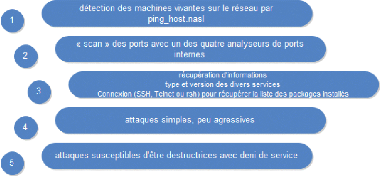

La démarche globale d'un attaque se base sur cinq

étapes, au début, la récupération des informations

publiques concernant la cible, puis cartographier le réseau cible en

listant les machines, les OS, les ports ouverts, les applications fonctionnant

sur le réseau. La troisième étape est de s'informer des

failles des applications et os utilisés. Comme deux dernières

étapes, l'attaque du système défaillant et la destruction

des traces d'attaque.

Il est facile de récolter les informations concernant

la cible en consultant son site web ou grâce au service offerte par

"whois" qui donne les noms de domaines et autres informations. La commande

traceroute aide à deviner facilement l'emplacement géographique

d'un serveur ou réseau en indiquant les passerelles

traversées.

La cartographie du réseau est assurée à

l'aide des dizaines d'outils comme ping, wireshark, nmap etc. Il est

malheureusement assez facile de récolter les informations sur les

failles, il suffit de rejoindre les sites web officiels d'une application ou

logiciel pour rendre compte les bugs et les failles de

sécurité.

Si les étapes précédentes sont bien

faites, l'attaque devient une simple formalité, ce qui reste au pirate

et de masquer ces traces pour ne pas permettre à la cible de se servir

de son attaque.

Sur la base de leur mode de fonctionnement et l'intention

derrière leurs actions, les techniques de piratage peuvent être

classées dans les catégories suivantes :

12 Chapitre 1. Étude

préliminaire

1.4. Audit de sécurité 13

Deni de service Dos Une attaque par

déni de service (en anglais Denial of Service, DoS) est une attaque qui

a pour but de mettre hors-jeu le système qui est visé. Ainsi, la

victime se voit dans l'incapacité d'accéder à son

réseau. Ce type d'attaque peut aussi bien être utilisé

contre un serveur d'entreprise qu'un particulier relié à

internet. Tous les systèmes d'exploitation sont également

touchés : Windows, Linux, Unix, ...

Les attaques DOS se présentent sous plusieurs formes

différentes, de Smurf aux larmes gouttes, à Pings de mort.

D'après Arbor Networks Plus de 2 000 000 DDoS attaques par jour sont

observées à l'échelle mondiale [11]

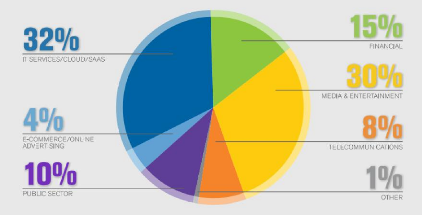

Chaque industrie est une cible, le secteur qui subit la grande

partie des attaques, c'est le Cloud avec 32 % de la totalité. 1/3 de

tous les incidents de temps d'arrêt sont attribués à des

attaques DDoS .

[8]

FIGURE 1.6 - Répartition des cibles de DDOS [http ://

www.kaspersky.fr/]

Le reniflage ou sniffing Une technique qui

consiste à analyser le trafic réseau et capte des informations

vitales du trafic réseau spécifique à ce réseau.

Lorsque deux ordinateurs communiquent entre eux, il y a un échange

d'informations (trafic). Mais, il est toujours possible qu'une personne

malveillante récupère ce trafic. Elle peut alors l'analyser et y

trouver des informations sensibles.

L'objectif de renifler est de voler les login ,les mots de

passe...

Wireshark ,Tcdump et Ethereal sont des célèbres

logiciels de sniffing.

Énumération et balayage des ports

Cette technique de piratage consiste à effectuer un balayage ou

analyse de tous les ports sur un cible en utilisant un outil appelant

scanner.

À fin de vérifier si les ports ciblés

sont ouverts ou non le scanner envoie différents paquets sur divers

ports de la machine et en fonction de leurs réactions, le

résultat du balayage sera déduit.

Les hackers le considéré comme étant un

outil impressionnant qui leur permet de découvrir les points faibles

d'une machine et ainsi de savoir par où ils peuvent lancer leurs

attaques.

Le but principal de cette technique est d'assurer : La

découverte d'hôte, le balayage de ports ouverts, détection

de version et Service associé aux ports, détection OS et

Contournement de

pare-feu.

Avant de lancer n'importe quel type d'attaques, il faut savoir

quels sont les hôtes vivants comme il est impossible d'accéder et

de pénétrer dans une cible morte ou bien hors service sans

accès physique directe ,c'est l'étape initial d'un Test

d'intrusion (« penetration test » ou « pentest » en

anglais).

Variété de méthodes et d'outils sont

utilisés pour découvrir les cibles vivantes. La méthode

courante la plus utilisée est l'envoi des requêtes ping.

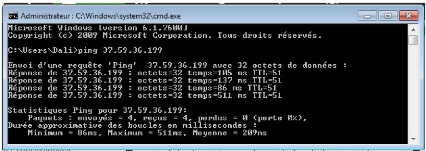

FIGURE 1.7 - Requêtes ICMP(ping)

Comme nous l'avons obtenu une réponse, ceci signifie

que la cible est vivante. Nous pouvons également utiliser un outil

très puissant "nmap" en spécifiant des plages de réseau

pour analyser afin de rendre notre travail plus simple.

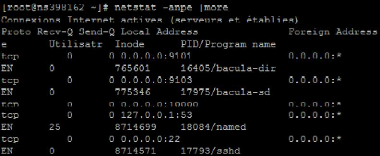

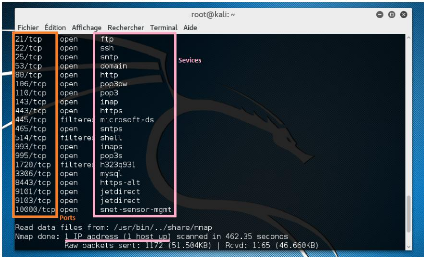

FIGURE 1.8 - Liste des ports ouverts et les applications

associées

Dans la partie précédente, on a parlé du

technique de balayage des ports ouverts et les services correspondants en cours

d'exécution sur ces ports. Maintenant, il est temps d'étudier les

techniques d'exploiter ces vulnérabilités.

Le crackage Tout service ou application qui

prend en charge l'authentification est souvent utilise des mots de passe

faibles ou par défaut, qui peuvent être facilement devinés

ou fissurés par une force brute. C'est le moyen le plus rapide

d'accéder à un système distant si elle est utilisée

de manière intelligente.

14 Chapitre 1. Étude

préliminaire

Le crackage ou attaque force brute est un processus qui

consiste a deviner le mot de passe de la victime par diverses techniques,

généralement, ces attaques sont divisés en trois

catégories :

1-Force Brute traditionnelle : toutes les combinaisons

possibles vont être testées pour deviner le mot de passe correct.

Ce processus coûte beaucoup de ressource et de temps et dépendre

de la machine utilisée pour l'exécuter. Heureusement, tester

toutes les combinaisons prend beaucoup de temps.

2-Attaque par dictionnaire: attaque basée sur un

dictionnaire, une liste de mots personnalisée est utilisée au

cours de ce processus, qui contient une liste de toutes les combinaisons

possibles de nom d'utilisateur et mot de passe, elle consomme moins de temps et

de ressource que l'attaque Force Brute traditionnelle donc elle est plus

rapide, mais elle ne garantit pas le succès si les mots de passe ne sont

pas disponibles dans la liste.

3-Attaque hybride: une technique qui combine deux types

d'attaques traditionnelles, attaque force brute traditionnelle et attaque par

dictionnaire, cela se manifeste par l'application d'un attaque force brute sur

un dictionnaire. Certaines applications qui nécessitent une

authentification obligeant l'utilisateur d'utiliser un mot de passe contenant

des lettres alphabétiques suivant des chiffres. Dans ce cas, ni force

brute traditionnelle, ni attaque de dictionnaire serait efficace, mais

l'attaque hybride serait.

Il existe une variété d'outils exploitant cette

attaque come medusa ,hydra,crunch...

Détournement de session ou "Hijacking"

Nous avons vu dans les méthodes précédentes

comment craquer le mot de passe d'une cible, mais si le mot de passe de la

session est robuste cela devient difficile et prendra beaucoup de temps

à le deviner. Alors c'est inutile parfois de le craquer, mais à

la place le pirate peut attendre jusqu'à ce que la victime s'authentifie

et prendre sa place.C'est le principe du détournement de session et pour

pouvoir réagir avec le serveur, il faut mettre la victime hors-jeu en

bénéficiant d'un attaque par déni de service.

Après avoir étudié les différents

types d'attaques et vulnérabilités et comme stratégie de

sécurité, il est temps de passer à les exploiter à

l'aide des outils pour mieux se protéger.

1.4.3.2 Logiciels d'audit de sécurité

Pour pouvoir valider la sécurité du

système, il faut essayer de trouver, découvrir et détecter

des failles dans le système. Donc il faut se comporter et jouer le

rôle d'un pirate en utilisant ces outils.

Les logiciels d'audit sont classés selon plusieurs

catégories :

1.Les analyseurs du trame network protocol

analyser ou sniffer est un dispositif permettant de récupérer et

analyser les paquets réseaux, ces outils sont indétectables et

servent à aider les responsables de sécurité à

diagnostiquer les problèmes sur leur réseau et peuvent être

utilisé par des malveillants pour collecter des informations.

Wireshark, tcpdump,ettercap,dsniff sont des sniffers ultra

rapide et puissants qui supporte la plupart des protocoles.

Wireshark est un outil open source

célèbre dans le monde du réseau informatique,

précédemment connu sous le nom Ethereal, est l'un des meilleurs

renifleurs de paquets jamais. Il est non seulement utilisé par les

pirates et les testeurs de pénétration, mais aussi par les

administrateurs réseaux pour régler les problèmes au sein

d'un réseau. Depuis Wireshark est un outil vaste, il est impossible pour

moi de couvrir tous les aspects de cet outil dans ce partie; cependant, je vais

vous donnez un aperçu rapide. Nous allons utiliser cet outil pour

capturer les mots de passe en texte envoyés à travers le fil.

Commençons donc :

1.4. Audit de sécurité 15

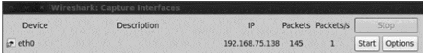

1 -Pour lancer Wireshark on exécute la commande "

Wireshark " du terminal. Une fois lancé, on clique sur le bouton

"Capture " en haut, puis on clique sur le bouton "Analyser"

2 - Ensuite, on sélectionne l'interface qu'on souhaite

le renifler,dans ce cas, c'est eth0 et on clique sur "Démarrer" .

FIGURE 1.9 - Interface wireshark

3 - l'outil de sniffing commence à capturer tous les

paquets qui circulent à travers le réseau. Sur la machine cible.

Je vais connecter à un site Web qui prend en charge l'authentification

http et arrêtera la capture sur ma machine attaquant une fois que je suis

connecté.

4 - Puisque nous avons beaucoup de paquets, nous devons les

filtrer à l'aide de Wireshark pour prendre en compte uniquement les

requêtes HTTP POST. Ainsi, à l'intérieur de la colonne du

filtre, on va taper" http.request.method == POST. "

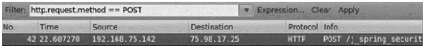

FIGURE 1.10 - Filtre wireshark

La première requête est une demande "POST"

réalisée à la destination 75.98.17.25 de notre victime,

qui a une source IP 192.168.75.142

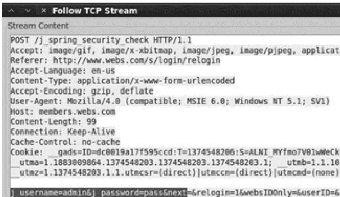

5 - Puis, on fait un clic droit sur le paquet, en cliquant

"Follow stream tcp ", il va nous montrer la demande généré

à partir du navigateur de la victime de message original. La sortie

devrait ressembler à ce qui suit :

FIGURE 1.11 - Résultat sniffing avec wireshark

16 Chapitre 1. Étude

préliminaire

Pour conclure, la requête POST contient le nom

d'utilisateur "admin" et le mot de passe "pass . " . Pour filtrer les

différents types de trafic, il existe différents types de filtres

à Wireshark à utiliser. Pour plus d'informations, je vous

suggère le site officiel de wireshark

wireshark.org .

Tcpdump au contraire que wireshark, tcpdump

travaille en mode texte, il partage la même

bibliothèque "libpcap" avec wireshark et toute capture par

tcpdump peut etre lisible par l'outil

graphique wireshrk a cause qu'ils ont la même syntaxe

d'écriture des filtres.

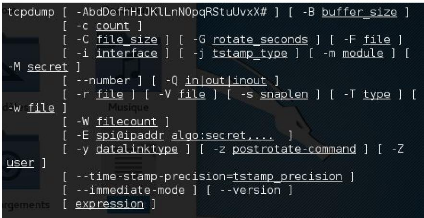

L'expression générale du syntaxe de tcpdump est

tcpdump [option] [expression]

On présente ici quelques options :

-- -a : convertir les adresses en nom

-- -i :specifier l'interface (eth0,eth1...)

-- -n :ne converti pas les adresses en nom

-- -x : affiche chaque paquet en hexadécimal

-- -w fichier :stocke les captures dans un fichier

-- -q :afficher le minimum d'information

les expression :

-- host,net,port : spécifie le type d'objet qu'on analyse

.

-- src ,dst :indique la direction des paquets

-- ip,icmp ... :le protocol utilisé

FIGURE 1.12 - Syntaxe tcpdump

1.4. Audit de sécurité 17

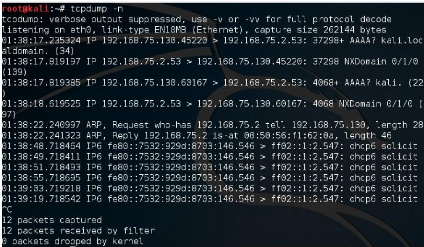

FIGURE 1.13 - Exemple de capture des paquets avec tcpdump

Alors, quelle est l'idée derrière la recherche

de paquets. Eh bien une bonne chose peut être à renifler des mots

de passe. Voici un exemple rapide pour renifler les mots de passe en utilisant

grep

tcpdump port http, or port FTP, or port SMTP, or port imap or

port pop3 -l -A

egrep -i 'pass= pwd= log= login= user= username= pw= passw=

passwd= password= pass: user: name : password : login : pass user'

2.Les balayeurs de ports des outils qui

servent à scanner les ports pour détecter ceux ouverts et savoir

les applications et services actives sur un système distant.

Telnet, nc, hping2, nmap sont les outils de balayage le plus

connu.Nmap se considère comme l'outil phare dans ce domaine.

Nmap ( "Network Mapper" ) est une utilitaire open source pour

la découverte du réseau et de l'audit de sécurité.

Il a été nommé " Produit de sécurité de

l'année » par Linux Journal, WorldInfo ,

LinuxQuestions.Org et codetalker

Digest.[6]

Nmap utilise des paquets IP bruts afin de déterminer

quels sont les hôtes disponibles sur le réseau, quels services

(nom de l'application et la version ) ces hôtes offrent, quels

systèmes d'exploitation (et les versions du système

d'exploitation ), ils sont en cours d'exécution, quel type de filtres de

paquets / pare-feu sont en cours d'utilisation, et des dizaines d' autres

caractéristiques. Il a été conçu pour analyser

rapidement les grands réseaux.

La syntaxe générale de nmap est de la forme nmap

[type d'analyse] [option] hote réseau Les différentes types

d'analyse :

-- -sT : balayer les ports en utilisant la connexion TCP.

-- -sP :determiner les hotes actifs dans un réseaux

-- -sS :balayer les ports en utilisant les paquets SYN.

Les options :

-- -O : essayer de déterminer le système

d'exploitation du système cible

18 Chapitre 1. Étude

préliminaire

-- -A :déterminer les applications et leurs

versions.

-- -r :balayer les ports en séquence de 1 à

1024.

On peut également analyser le réseau varie avec

nmap sur le réseau donné. Voici la commande pour balayer une

gamme d'hôtes de nmap : -sP nmap 192.168.15.1/24 . Il va scanner tous les

hôtes de la gamme 192.168.15.1 à 192.168.15.255 et retourner ceux

qui sont en place.

Comme on peut le voir sur la capture d'écran, trois

hôtes vivants ont été trouvés après avoir

scanné le réseau.

Une fois la découverte d'hôte vivant a

été effectué avec succès, nous essayons de trouver

des ports ouverts et les services qui leur sont associés. Les ports

ouverts révèlent les services qui sont en cours

d'exécution sur l'hôte. L'analyse des ports est effectuée

afin de rechercher des points d'entrée potentiels.

FIGURE 1.14 - Découverte des ports ouverts avec nmap

3.Les logiciels de craquage le craquage des

services se fait en fonction des protocoles ciblés,Il existe plusieurs

moyens qui pourraient être utiles ,le plus connus sont orienté

pour les OS Linux comme Backtrack ,Kali Linux ... Jetons un coup d' oeil sur

eux.

THC Hydra: est l'un des plus anciens de

craquage de mot de passe des outils développés par " La

Communauté Hackers. " De loin, Hydra a une couverture de protocole le

plus que tout autre mot de passe outil de craquage, et il est disponible pour

presque tous les systèmes d'exploitation modernes.[5]

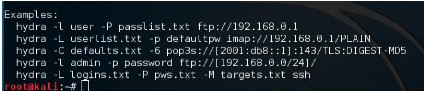

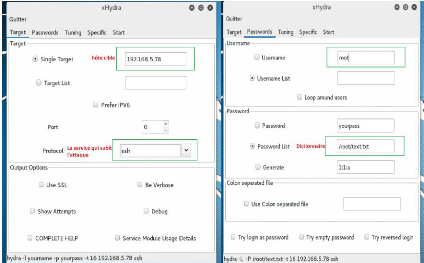

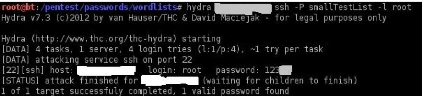

Syntaxe de base pour Hydra:

1.4. Audit de sécurité 19

FIGURE 1.15 - Syntaxe de base pour Hydra

FIGURE 1.16 - Attaque par dictionnaire avec l'outil Hydra

Un simple dictionnaire de mots

téléchargés depuis internet et une liste des noms

d'utilisateurs est suffisante pour lancer une attaque avec hydra et deviner le

nom d'utilisateur et le mot de passe et de prendre contrôle au serveur si

la service attaquée est ssh à l'aide d'un seul commande" hydra -L

user.list -P password.list <@ip cible > "

FIGURE 1.17 - Attaque force brute sur ssh avec hydra

20 Chapitre 1. Étude

préliminaire

Medusa comme Hydra, Medusa est un logiciel de

force brute rapide, stable et surtout fait tourné ses traitements en

parallèle car il utilise " Pthread , " ce qui signifie qu'il ne sera pas

nécessairement dupliqué l'information. Il est aussi modulaire,

car chaque fonctionnalité est conçu comme un module et il couvre

tout les modules ainsi que FTP HTTP IMAP MS-SQL MySQL POP3 PostgreSQL SNMP SMTP

SSHv2 VNC. Syntaxe de base pour Medusa:

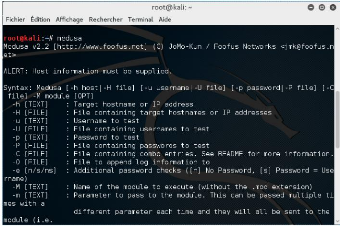

FIGURE 1.18 - Syntaxe de base pour Medusa

4. Les logiciels de dos attaque et dos

distribué DDOS les cyber-attaques de type «déni de

service» (DoS) et «Déni de service distribué»

(DDoS) sont devenue populaires et les applications qui lancent ce type

d'attaque sont devenu à la porter de tous les internautes, même

les débutants peuvent lancer une attaque dos et mettre le serveur hors

disponibilité.

HOIC et LOIC High Orbit Ion Cannon et low

orbit Ion cannon deux logiciels de la même famille,outils de dos attaque

performants, disposant d'une interface facile à utiliser,

multiplate-forme. Ils offrent la possibilité de sélectionner le

nombre de threads dans une attaque en cours et la Capacité à

étrangler les attaques individuellement avec trois réglages :

LOW, MEDIUM et HIGH. Il peut attaquer un grand nombre de cibles

simultanément jusqu'à atteindre 256 cibles.

1.4. Audit de sécurité 21

FIGURE 1.19 - Interface graphique hoic et loic

Les attaques gérées par ces deux outils se

basent sur le lancement de requêtes ping en arriéré plan

vers la cible, cela dépend de la performance de la machine qui effectue

cette attaque.

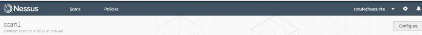

5.Les simulateurs d'intrusions Attack

simulator ou Network vulnerability scanner, outil complet d'attaque ou d'audit

de sécurité, il est, de même, composé d'un ensemble

d'outils comme les balayeurs de ports. Nessus, openvas, sara, Saint et ISS sont

des logiciels est le simulateur de simulateur d'intrusion. Nessus est le

simulateur le plus connu, il fonctionne en client-serveur à travers une

liaison SSL, le client pilote le serveur, il lui indique les applications et

les postes défectueuses et les exploits à utiliser. À la

fin du scan, Nessus génère un rapport sous différents

formats. Ce rapport permet d'établir la liste des machines

scannées, leurs services et leurs vulnérabilités.

FIGURE 1.20 - Rapport de scan de simulateurs d'intrusions

Nessus

Il n'existe pas de « remède miracle » pour se

protéger et se défendre contre les différentes failles et

attaques. Plusieurs solutions techniques doivent être combinées

pour réduire à la fois le risque de faille et pour

atténuer l'impact en cas de d'attaque.

22 Chapitre 1. Étude préliminaire

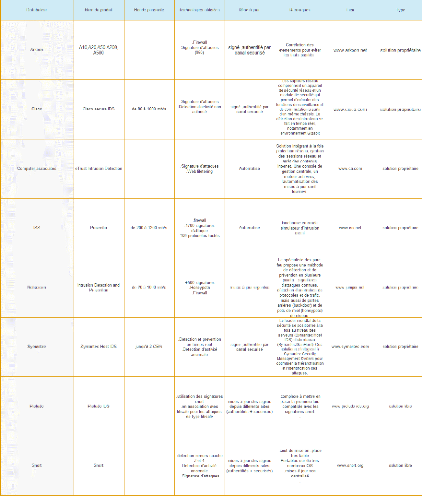

1.5 Étude des Solutions techniques existantes

des failles et attaques

L'approche initiale de défense contre les attaques

ciblées et les failles de sécurité reposait sur la

sécurisation du périmètre à l'aide de pare-feu et

de systèmes de détection des instructions, permettant de

déceler et de bloquer tout comportement anormal. Cette approche peut

être efficace contre certains types d'attaques, mais non contre tous les

types de vecteurs d'attaque.Ci-dessus, je présente un tableau

récapitulatif des vulnérabilités ou attaque et les

solutions existantes pour se défendre.

|

Vulnérabilité ou attaque

|

solution technique

|

|

déni de service

|

fail2ban firewall

|

|

balayage de ports

|

Scanner laa machine pour connaître les ports ouverts

Surveiller les ports ouverts avec un firewall et fermer ceux qui

ne sont

pas utiles

Utiliser un IDS (détecteur d'intrusion)

Desinstallation des Services inutiles

|

|

Cracking

|

Adopter une politique de mots de passe robustes

Choix d'un mot de passe robuste et le garder confidentielle

Changement régulièrement de mot de passe

DenyHosts

fail2ban

|

|

Sniffing

|

Utilisation d'un détecteur de sniffer

Utilisation des protocoles chiffrés pour les

informations sensibles comme les mots de passe.

|

|

Hijacking

|

S'assurer que la communication est sécurisée

Rootkit Hunter

détecteur "activité non autorisée"

|

|

Buffer OverFlow

|

Installation du libsafe ( empêche les exploits de

dépassement de tampon )

Avoir un système à jour

être au courant concernant les failles des logiciels et

télécharger les patchs appropriés

|

|

Vulnérabilité de dépassement de

mémoire tampon

|

mise à jour du version glibc

|

|

Vulnérabilité dans le service DNS BIND

|

migration vers le bind 9

|

|

Shell Shock

|

mise à jour du bash

|

Tableau 1.1 - Tableau récapitulatif des failles et

attaques et leurs solutions associés

A chaque fois qu'on parle des attaques et failles de

sécurité , la première solution que vient à notre

esprit est la mise en oeuvre d'un système de détection

d'intrusion IDS.

1.5.1 Solutions de détection d'intrusion

Les systèmes de détection d'intrusion essayent

de distinguer la différence entre l'usage normale et une usage abusive

accompagnée d'une tentative d'intrusion. On constate une grande

quantité de distributeurs de solutions IDS développes par les

grandes entreprises de sécurité.On présente ci dessous une

comparaison technique entre les solutions propriétaires et libres.

1.5. Étude des Solutions techniques existantes des

failles et attaques 23

DenyHosts est un outil de

sécurité de prévention d'intrusion basée sur

l'analyse du journal d'authentification SSH. DenyHosts vérifie la fin du

journal d'authentification pour les récentes

Tableau 1.2 - Tableau comparatif des solutions de

détection d'intrusion

1.5.2 Solutions de prévention d'attaque force

brute

Dans ce cadre, nous allons citer brièvement quelques

solutions existantes et connues qui assurent la prévention des attaques

par dictionnaire. Ces solutions sont en générales logicielles qui

sont dans leur intégralité des scripts. Nous pouvons citer

24 Chapitre 1. Étude

préliminaire

OpenVAS est un scanner de vulnérabilité qui a

été dérivé de la dernière version gratuite

de Nessus après cet outil a été commercialisé en

2005. Les plugins OpenVAS sont toujours

tentatives de connexion infructueuses. Il enregistre des

informations sur leurs adresses IP d'origine et compare le nombre de tentatives

non-valides à un seuil défini par l'utilisateur. S'il y a eu trop

de tentatives invalides assume une attaque par dictionnaire est en cours et

empêche l'adresse IP de faire d'autres tentatives en l'ajoutant à

/etc/hosts.deny sur le serveur.

Les limites de cette solution sont :

** DenyHosts est limité aux connexions utilisant IPv4. Il

ne fonctionne pas avec IPv6. ** Ne parvient pas à protéger contre

une attaque par force brute distribuée.

** Vulnérable à l'injection de journal distant,

une technique d'attaque similaire à l'injection SQL, dans lequel un nom

d'utilisateur spécialement conçu est utilisé pour

déclencher un bloc contre un site choisi par l'attaquant

** Supporte seulement les attaque force brute sur le service

ssh.

** Utilise le fichier hosts.deny au lieu du pare feu.

Fail2ban : DenyHosts ne fait que

protéger le service ssh. Si on a besoin pour protéger d'autres

services aussi bien, Fail2ban est certainement un meilleur choix. Il est

configurable pour regarder presque tous les services si vous êtes

prêt à modifier sa configuration, mais cela ne devrait pas

être nécessaire que les nouvelles versions de Fail2ban comprennent

des rules par défaut qui conviennent à de nombreux démons

de serveur populaires.Fail2ban utilise des règles iptables pour bloquer

complètement un attaquant pour un laps de temps spécifié,

au lieu de simplement réduire la rapidité, il peut marteler votre

serveur.

Les bénéfices de Fail2ban :

** Supporte tous les services.

** Fonctionne avec la connexion IPV4 et IPV6

** Simple à mettre en oeuvre.

** utilise le pare-feu au lieu de fichier hosts.deny

1.5.3 Solutions de simulation d'intrusion

Comme on a déjà vu un simulateur d'intrusion est

un outil performant qui peut être à la fois une sorte d'attaque ou

un moyen pour s'informer des failles récentes.

SAINTEst un outil d'évaluation des

vulnérabilités. Comme Nessus, il l'habitude d'être libre et

open source, mais est maintenant un produit commercial. SAINT fonctionne sur

Linux et Mac OS X. En fait, SAINT est l'un des rares fournisseurs de scanners

qui ne prennent pas en charge Windows du tout. L'abonnement mensuelle du Saint

est trop cher, il coûte 3 000 $.

Nessus est l'un des scanners les plus populaires et capables

de vulnérabilité, en particulier pour les systèmes UNIX.

Il a d'abord été libre et open source, mais ils ont fermé

le code source en 2005. Il coûte maintenant 2190 $ par année, qui

bat encore beaucoup de ses concurrents. "Nessus Home" version gratuite est

également disponible, même si elle est limitée et seulement

une licence pour l'utilisation du réseau domestique.

Nessus est constamment mis à jour, avec plus de 70.000

plugins. Les dispositifs principaux incluent des contrôles locaux et

distants (authentifié) sécurité, une architecture client /

serveur avec une interface basée sur le web, et un langage de script

intégré pour écrire vos propres plugins ou à

comprendre ceux qui existent déjà.

1.6. Conclusion 25

écrites dans la langue Nessus NASL. Malgré qu'il

est gratuit et libre, les mises à jour sont rares et son interface

graphique est difficile à manipuler.

Ci-dessous on présente quelques problèmes de

sécurité et les simulateurs d'intrusions qui les supportent.

Tableau 1.3 - Tableau comparatif des simulateurs d'intrusion

1.6 Conclusion

Dans ce premier chapitre, nous avons présenté

Sotutech. Puis nous avons expliqué le contexte du projet et

explicité la problématique à résoudre. Finalement,

nous avons décrit les différentes étapes du projet ainsi

qu'un aperçu de l'état de l'art des failles et attaques et une

étude comparative des solutions existantes dans le marché. Le

chapitre suivant mettre en oeuvre, les solutions de sécurité.

26

Chapitre2

Sécurisation du serveur

Dans le chapitre précédant ,j'ai

présenté une définition de la sécurité

informatique ,les types de vulnérabilité et attaque . Dans ce

chapitre je veux prendre un point important : comment se protéger?

Mettre en place une sécurité forte sur un

serveur a pour but d'empêcher, ou au moins de limiter, les attaques de

pirates et de couvrir les vulnérabilités .

L'association à chaque problème ,attaque ou

faille identifiée, sa solution technique ,l'étude et

l'implémentation des différents outils de sécurité

proposés et existants, l'intégration d'un système de

surveillance en temps réel le développant d'un mécanisme

de sauvegarde et restauration du système d'informations peut

réduire le risque de piratage et de perte des données du serveur

.

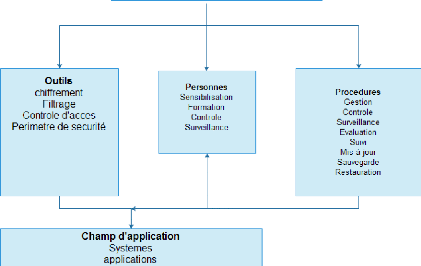

2.1 Adoption de la politique de

sécurité

Comme tout problème qui réside dans n'importe

quelle entreprise en particulier les problèmes informatiques ,leurs

actions doivent être le résultat d'une démarche bien

déterminé méthodologi-quement en l'occurrence une

politique de sécurité ,Celle ci nous permet d'agir en de

manipuler des choix cohérents qui répondre à un cahier des

charges .

Pour établir une politique de sécurité on

doit dans un premier lieu identifier ce qu'il faut protéger , ensuite

passant par analyser et pondérer des risques qui étaient

déjà effectués au niveau du chapitre

précédent .Puis l'évaluation des contraintes ,les

principales sont souvent l'existant coté matériel et logiciel et

le temps. À ne pas oublier une phase importante le choix des moyens qui

vont être regroupés selon trois catégories , Les moyens de

sécurisation citons les pare feux les antivirus ... , Les moyens de

sécurisation citons-les parent feux les antivirus ... les moyens de

détections d'intrusion, les moyens de surveillance du serveur citons

l'analyse des logs, les alertes...Comme dernière étape la phase

du test, après avoir mis en place une politique de

sécurité assurer s'il répond au cahier des charges

.L'objectif principal de la sécurité est de garder ou de

sauvegarder la pérennité de l'entreprise. C'est pour cela que la

politique de sécurité mise en oeuvre doit s'inspirer des besoins

réels qui ont été définis à partir de cahier

des charges, des menaces et des vulnérabilités. Elle impose une

complémentarité entre les procédures, les outils mis en

oeuvre et les personnes impliquées.

2.2. Stratégie de base de sécurisation du

serveur 27

FIGURE 2.1 - Politique de sécurité

2.2 Stratégie de base de sécurisation du

serveur

Sécuriser un serveur Centos passe évidemment par

plusieurs étapes ,l'une des étapes le plus critiques c'est

maintenir le système à jour .

2.2.1 La mise à jour du système

Effectué une mise à jour du système et

des applications est sans doute la tache la plus efficace et la plus importante

car il corrige les failles .La mise à jour devient être

obligatoire et journalière pour un bon fonctionnement du système.

Les principales commandes pour maintenir à jour notre serveur Centos

sont :

yum check-update : vérifier s'il

existe des mises à jour à effectuer.

rpm -q -changelog : consulter l'historique

des mises à jour et leurs raisons.

yum update : effectuer les mises à

jour.

C'est inutile de mettre à jour manuellement le

système donc c'est décisif de programmer le système

à vérifier les mises à jour existant de les effectuer et

d'alerter l'administrateur du serveur à la fin de l'opération .

Pour cela on installe et on modifie Le paquet yum-cron qui offre un moyen

pratique pour vérifier, télécharger et appliquer des mises

à jour automatiquement pour qu'il s'adapte à nos besoins . le

sevice yum-cron est installé sous centos à l'aide de yum -y

install yum-cron puis on édite le fichier de configuration

/etc/yum/yum-cron.conf .

28 Chapitre 2. Sécurisation du serveur

FIGURE 2.2 - Exemple de fichier de configuration yum-cron

Après avoir configurer yum-cron il faut le lancer et vérifier son

fonctionnement .

FIGURE 2.3 - Exécution du service yum cron

2.2.2 la minimisation du système

On désigne par minimiser le système

installé les applications nécessaires et donc désinstaller

tout ce qui n'est pas nécessaires, activer seul les services

fonctionnels , fermer les ports non utilisés, supprimer les

bannières des applications, le principe est de supprimer tout ce qui

indique le nom et la version de l'application [Fig 2.4] car elles simplifient

le travail du pirate, minimiser les comptes utiliser et enfin minimiser les

privilèges d'accès.

Avant de passer à la minimisation du système il

faut lister les services installés, les services actifs, les ports

ouverts et les applications associés..

2.2. Stratégie de base de sécurisation du

serveur 29

30 Chapitre 2. Sécurisation du serveur

FIGURE 2.4 - Liste des services installés

Commençons par supprimer ou désinstaller les

services inutiles . Dans notre serveur Centos on

n'a pas besoin d'utiliser les services portmap, nfs et inetd ,on

les désinstalle ou les arrête à l'aide

des commandes

/etc/init.d/portmap stop

update-rc.d -f portmap remove

yum remove portmap

/etc/init.d/nfs-common stop

update-rc.d -f nfs-common remove

update-rc.d -f inetd remove

yum remove ppp

Passons à la minimisation des

autorisations diverses concernant les compilateurs et les instal-

leurs ,l'ajout et la suppression des comptes utilisateurs et la

modifications du pare-feu ,cela devrait

être effectué seulement par l'utilisateur root :

chmod o-x /usr/sbin/gcc : gcc est un

compilateur

chmod o-x /usr/sbin/make :make est un outil de

construction des fichiers exécutables à

partir d'un code source.

chmod o-x /usr/sbin/yum-complete-transaction :

yum-complete-transaction est un

programme qui trouve les transactions yum incomplètes ou

avortées sur un système et tente de

les compléter.

chmod o-x /usr/sbin/useradd : useradd est une

commande d'ajout d'un utilisateur.

chmod o-x /usr/sbin/userdel : userdel est une

commande de suppression d'un utilisateur.

chmod o-x /usr/sbin/iptables : iptables est le

parefeu Linux.

2.2.3 L'isolation du serveur et la protection de son

accès

Présente évidement la clé de

sécurité ,car il limite tout accès illégal au

serveur ,il concerne toutes techniques servent à garder le serveur loin

des mains des agresseurs.

Les mots de passe

Il existe différentes manières

d'authentification, la plus répondue est l'utilisation d'un mot de

passe, selon SANS (SysAdmin, Audit, Network, Security) une organisation

regroupant 165 000 professionnels de la sécurité , un mauvais mot

de passe constitue la deuxième plus importante faille d'un

système ,la première étant l'absence de la mise à

jour . [12] .Un bon choix des mots de passe robustes est nécessaire pour

rendre difficiles à les retrouver à l'aide d'outils

automatisés et à deviner par une tierce personne.

Un bon mot de passe doit ne pas contenir le prénom ,le

nom , le login,des informations qui ont un rapport avec l'utilisateur "date

naissance , nom d'un membre de la famille ... " , des mots du dictionnaire de

n'importe quelle langue, une suite des lettres de la forme w sur le clavier

comme aqwsedcft ,edcftgbhu ...Tout simplement à ne pas utiliser tout ce

que peut être deviné facilement.Un mot de passe efficace doit

contenir au moins 8 chiffres en assurant la mélange entre les majuscules

, les minuscules ,les chiffres et les symboles et en facilitant sa

mémorisation et la rapidité lorsqu'on tape pour éviter

l'espionnage .Il existe des bonnes pratiques pour générer un mot

de passe , utiliser l'initiales des mots d'une phrase ,prenons comme exemple

"JPCAU14" générer à partir de la phrase "je

préfère Centos à Ubuntu 14" ou mélanger des mots

,par exemple les mots "redhat et Centos " donnent "rceednhoast".Le plus

important que ça est de changer régulièrement le mot de

passe , associer à chaque service son propre mot de passe , garder le

confidentielle et ne le transmettre pas via e-mail ou l'écrire n'importe

où .

Secure Shell SSH

Secure Shell ou SSH est à la fois un programme

informatique et un protocole de communication sécurisé qui offre

un ensemble de commandes en remplaçant les commandes remote (rlogin,rsh)

. Il devient donc impossible d'utiliser un sniffer pour voir ce que fait

l'utilisateur. SSH est implémenté pour différents

environnements tel que linux windows et macintosh .Le logiciel putty pour

windows sert à jouer le rôle d'un client ssh et telnet .

Après avoir lancé putty, il ouvre un tunnel

sécurisé avec le serveur pour établir une connexion avec

le serveur .

L'établissement d'une connexion SSH se fait en

plusieurs étapes : Dans un premier temps le serveur et le

client s'identifient mutuellement afin de mettre en place un canal

sécurisé (couche de transport sécurisée).

Dans un second temps le client s'authentifie auprès du

serveur pour obtenir une session .

La figure ci-dessous présente l'architecture du

protocole SSH .

2.2. Stratégie de base de sécurisation du

serveur 31

FIGURE 2.5 - Authentification SSH

L'authentification ssh Une fois que la

connexion sécurisée est mise en place entre le client et le

serveur, le client doit s'identifier sur le serveur afin d'obtenir un droit

d'accès. Il existe plusieurs méthodes : La méthode la plus

connue est le traditionnel mot de passe. Le client envoie un nom d'utilisateur

et un mot de passe au serveur au travers de la communication

sécurisée et le serveur vérifient si l'utilisateur

concerné a accès à la machine et si le mot de passe fourni

est valide. Une méthode moins connue mais plus souple est l'utilisation

de clés publiques. Si l'authentification par clé est choisie par

le client, le serveur va créer un challenge et donner un accès au

client si ce dernier parvient à déchiffrer le challenge avec sa

clé privée

Afin de mieux sécuriser l'accès SSH au serveur,

j'édite le fichier de configuration de ssh , changer le port de

connexion par défaut est une bonne idée pour éviter

quelques attaques par force brute sur le port 22, qui est bien connu pour

héberger ce service,n'autorisons pas l'accès via compte root

dès le début ,accéder en tant qu'autre utilisateur puis

avec la commande su ouvrons une session root .

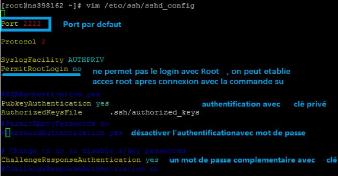

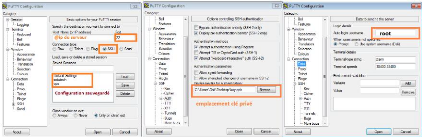

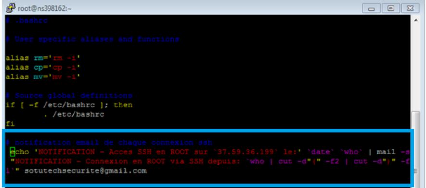

FIGURE 2.6 - Exemple de fichier de Configuration ssh

32 Chapitre 2. Sécurisation du serveur

Notre politique de sécurité de la connexion ssh

se base sur l'authentification à clé publique . Utiliser

l'authentification SSH par une clé publique pour se connecter à

un système distant est un solide alternatif plus sûr pour se

connecter avec un mot de passe . SSH authentification par clé publique

repose sur des algorithmes cryptographiques asymétriques qui

génèrent une paire de clés distinctes un privé et

l'autre public. On garde la clé privée un secret et on le stocke

sur l'ordinateur que l'on utilise pour se connecter au système distant.

La clé publique sera stocké sur le système distant dans un

répertoire .ssh/authorized-keys.

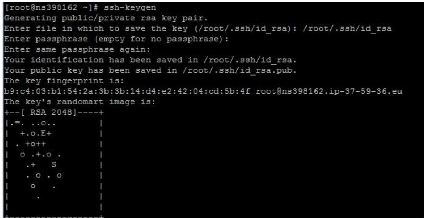

Pour configurer l'authentification par clé publique en

utilisant SSH ,on utilise la ligne de commande SSH pour générer

une paire de clés en utilisant soit l'algorithme DSA ou RSA : pour

générer des clés DSA , on tape ssh-keygen -t dsa , dans

notre cas on génère des clés RSA à l'aide du

commande ssh-keygen -t rsa

FIGURE 2.7 - Génération des

clés rsa

Trois fichiers seront crées sous /.ssh , un fichier

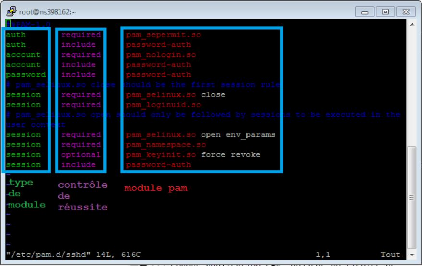

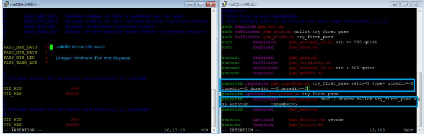

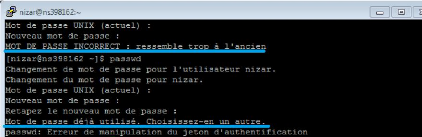

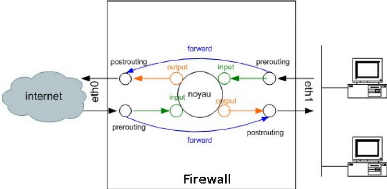

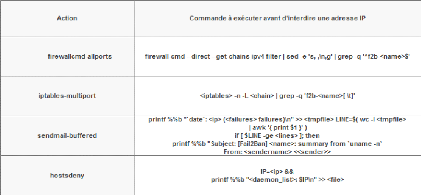

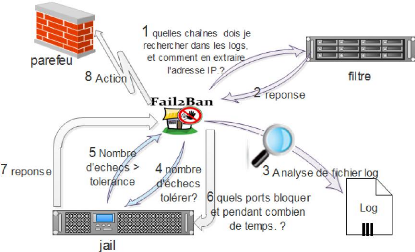

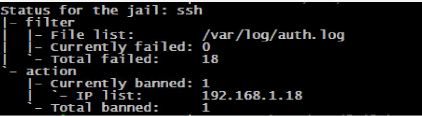

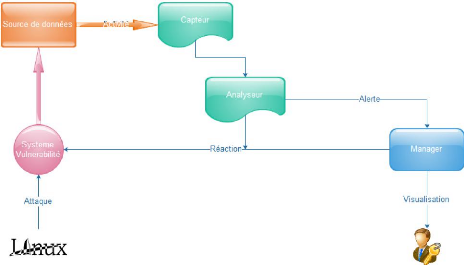

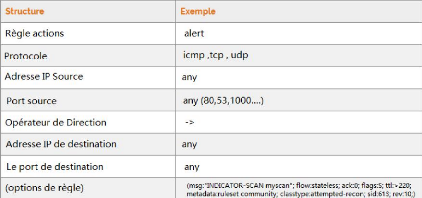

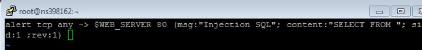

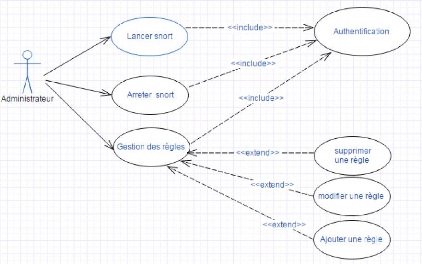

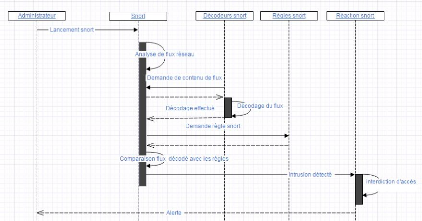

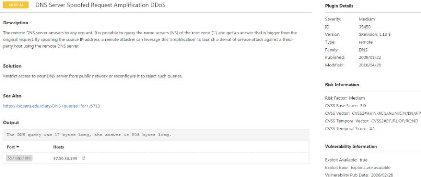

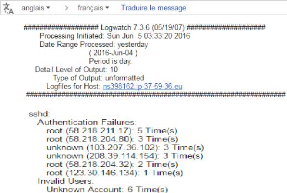

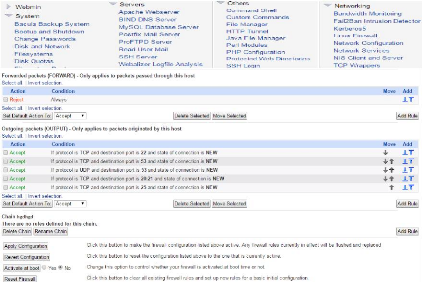

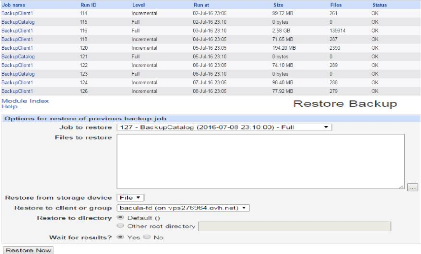

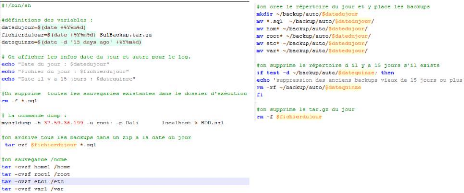

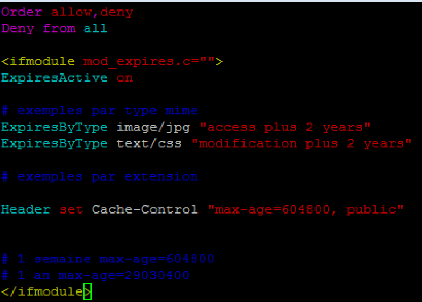

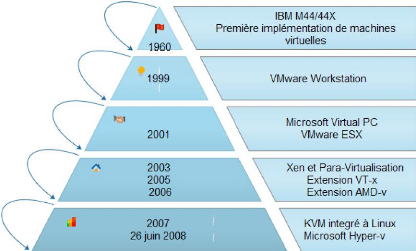

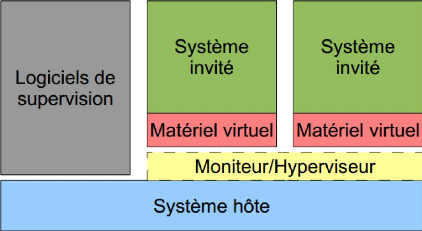

id-rsa présent la clé privé , un fichier id-rsa.pub