|

UNIVERSITÉ AUBE NOUVELLE

INSTITUT SUPERIEUR D'INFORMATIQUE ET DE

GESTION

ISIG High Tech

MEMOIRE DE MASTER RECHERCHE en Informatique

OPTION :

Imagerie Numérique pour le Développent Durable

MOUVEMENT D'OBJET DANS UNE IMAGE : DETECTION D'OBJET EN

MOUVEMEN

THÈME : VERS LA RECONNAISSANCE

DE

Présenté par : Sous la direction de

:

Ali OUCHAR CHERIF Dr Aime METCHEBON

Année : 2013 - 2014

II

Résumé

La reconnaissance de mouvement suspect d'objet ou de personne

dans une image a une grande importance et constitue un challenge dans le

domaine de la surveillance via les caméras. Cette reconnaissances de

mouvement suspect d'objet passe par plusieurs phases à savoir : la

détection, le suivi, la création d'une base de données ou

vocabulaire par rapport à laquelle les mouvements pourront être

comparés afin d'être reconnus et qualifiés de suspects ou

non. Dans ce travail, nous nous intéressons à la phase de

détection d'objet ou de personne en mouvement dans une image. Nous

faisons une étude comparative de méthodes de détection de

mouvement d'objet ou de personnes dans une séquence vidéo. En

nous basons sur les méthodes existantes de détection de

mouvement, nous justifions le choix et faisons l'implémentation de trois

d'entre elles.

Abstract

The recognition of suspect movement of object or anybody in an

image has great importance and constitutes a challenge in the field of the

monitoring via the cameras. This recognitions of suspect movement of object

passes by several phases to knowing: detection, the follow-up, the creation of

a data base or vocabulary compared to which the movements could be or not

compared in order to be recognized and qualified suspects. In this work, we are

interested in the phase of target detection or anybody moving in an image. We

make a comparative study of methods of detection of movement of object or

people in a video sequence. In we let us base on the existing methods of

detection of movement, we justify the choice and make the implementation of

three of them.

III

Dédicaces

Je dédie le fruit de ce travail à mon

père

OUCHAR CHERIF que son âme repose en paix

et ma très chère mère,

SOUAD ALI AKACHA

pour leurs amour, leurs sacrifices acquiescés

à mon égard, pour leurs soutiens

indéfectibles,

leurs confiances,

leurs conseils, leurs orientations et la gratitude

de leur amour pour moi et pour mes frères.

Que Dieu les combles au-delà de leurs

attentes.

iv

Remerciements

Nous tenons à présenter nos sincères

remerciements à Université Aube Nouvelle ex ISIG (Institut

Supérieur de l'informatique et de Gestion) pour nous avoir offert un

cadre d'étude supérieure adéquat, répondant

à nos attentes et critères de formation.

Nos remerciements s'adressent aussi à l'endroit du corps

professoral de l'université Aube Nouvelle pour sa disponibilité,

sa qualité, son effort et sa rigueur dans l'optique de nous inculquer

une formation d'excellence.

Nos vifs remerciements vont à l'endroit de :

Docteur Aimé METCHEBON, qui n'a jamais refusé une

seconde de son temps à suivre mes travaux avec ses orientations,

conseils et par-dessus tout le temps qu'il a sacrifié pour la

réalisation du présent travail malgré ses multiples

occupations;

- M. Mbainadijel ALEXIS, chef de service informatique de la GMIP

Allemagne ;

- Mon père OUCHAR Cherif, que son âme repose en paix

;

- Ma chère maman SOUAD Ali Akacha, une mère unique

en son genre, pour son

amour, son soutien, ses sacrifices, ses conseils et ses efforts

robustes concédés pour la

réussite de mes études ;

- Toute ma famille, mes jeunes frères à savoir :

Cherif, Oumar, Mahadi et sans oublie

mon petit adorable Mahamoud pour leurs concours, soutiens et

amour.

- À AHMAT Hassan Mahamat, BRAHIM Adoum Ahmat et ABOUBAKAR

Djimé des

amis exceptionnels ;

- À la famille OUCHAR et AKACHA pour leurs soutiens tout

au long de mes années

d'études ;

- À Ahmat ALI AKACHA, un oncle pas comme les autres ;

- À KHADIDJA Herindji, une femme exceptionnelle et unique,

merci pour tout ;

- À tous ceux qui comptent pour moi ;

- À tous ceux pour qui je compte.

v

Sommaire

Résumé ii

Abstract ii

Dédicaces iii

Remerciements iv

Liste des figures vii

Liste des tableaux viii

Introduction 1

? Contexte et intérêt de l'étude

1

? Problématique 2

? Objectif 2

? Plan du travail 3

Chapitre 1 : Cadre de l'étude 4

1.1. Cadre théorique 4

1.1.1. Image 4

1.1.2. Définition d'une vidéo 12

Conclusion 14

Chapitre 2 : État de l'art 15

2.1. Détection par Différences entre deux images

consécutives 15

2.2. Flux optique 16

2.3. Soustraction de l'arrière-plan par

modélisation statistique 16

2.4. Détection par Histogramme 19

2.5. Détection par couleur 20

2.6. Méthode de détection par Technique du Gradient

22

2.7. Tableau comparatif de méthodes 23

Conclusion 25

Chapitre 3 : Choix de la méthode retenue et

modélisation 26

3.1. Soustraction d'arrière-plan par modélisation

statistique 26

3.2. Détection par différence d'images 29

Conclusion 33

Chapitre 4 : Le matériel utilisé 34

4.1. Les outils nécessaires pour la vision

artificielle 34

4.1.1. MinGW ou Mingw32 (Minimalist GNU for Windows) 34

4.1.2. CMakesFiles 34

4.1.3. Code::Blocks 35

4.1.4. OpenCv (Open Source Computer Vision) 35

4.2. Les étapes d'installation des

différentes applications 36

4.2.1. Étape 1: Installation de MinGW 36

4.2.2. Étape 2: Ajout de chemin d'accès de MinGW

au système 36

4.2.3. Étape 3: Installation Code :: Blocks (notre API

choisi) 38

4.2.4. Étape 4: Installer OpenCV 38

4.2.5. Étape 5: Ajout de OpenCV à la trajectoire

du système 40

4.2.6. Étape 6: Configuration du Code::Blocks avec OpenCV

40

4.3. Les fonctions utiles 44

Conclusion 46

Chapitre 5 : Implémentation et Discussions sur les

résultats 47

5.1. Implantation logicielle 47

5.1.1. Interface 47

5.1.2. Optimisations 48

5.2. Expérimentations 48

5.3. Performance 49

5.4. Implémentions de méthodes de

détection : Résultats et discussions 49

5.4.1. Détection par différence entre deux images

consécutives 49

5.4.2. Détection par soustraction d'arrière-plan

52

5.5. Élimination des ombres 55

Conclusion 56

Conclusion Générale 57

Bibliographie 58

Annexes 64

1. Programme en C ++ pour la détection par

différence d'images 64

2. Programme en C++ pour la détection par

soustraction d'arrière-plan 66

vi

« La meilleure façon d'apprendre est de

suivre des exemples ». A. Einstein

VII

Liste des figures

Figure 1: Histogramme d'une image en RGB 7

Figure 2: Image en niveau de gris et son histogramme

cumulé 8

Figure 3: Modification d'histogramme 9

Figure 4: Étirement et Histogramme de l'image

Étirée 9

Figure 5 : Égalisation et Histogramme de l'image

égalisée 10

Figure 6 : Dilatation d'image 11

Figure 7 : Érosion d'image 11

Figure 8: Exemple d'une séquence d'images 13

Figure 9: Technique de différence avec image de

référence, (a) l'image à l'instant t, (b) l'image

de

référence, (c) l'image de différence.

30

Figure 10: Technique de différence sans image de

référence, (a) image précédente, (b) image

courante, (c) image de différence. 32

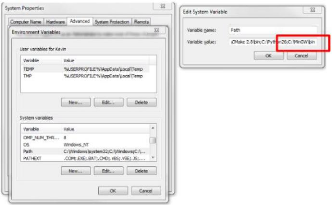

Figure 11: Variable Environnement 37

Figure 12: Ajout de chemin 37

Figure 13 : Décompression OpenCv 38

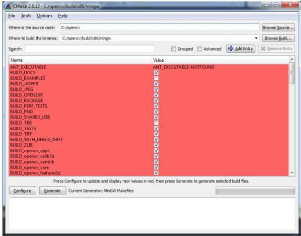

Figure 14: installation de cmake 39

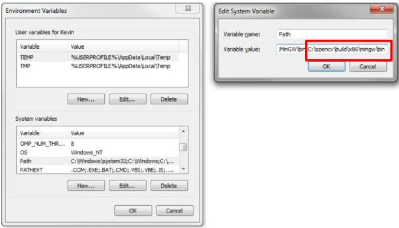

Figure 15: Ajout d'OpenCv à la variable 40

Figure 16: Test de mingw dans la variable path 40

Figure 17: Choix de l'application du projet 41

Figure 18: Interface de code::blocks 41

Figure 19: Interface de Configuration 42

Figure 20: Ajout du répertoire au compilateur

42

Figure 21: Ajout du répertoire OpenCv au Linker du

code::blocks 43

Figure 22: Ajout des librairies à l'IDE 43

Figure 23 : Image de détection 52

Figure 24 : Détection de mouvement par moyen mobile

54

VIII

Liste des tableaux

Tableau 1: Tableau comparative des méthodes

abordées 24

Tableau 2: Tableau comparatif de performance pour la

soustraction de l'arrière-plan à

différentes résolutions d'images et

fréquences de mise à jour du modèle 49

Introduction

? Contexte et intérêt de

l'étude

La vision par ordinateur est une branche d'intelligence

artificielle dont le but est de permettre à une machine de comprendre ce

qu'elle «voit ». Elle peut servir entre autre à la

reconnaissance de formes, qui consiste à reconnaitre une forme dans une

image après l'avoir enregistrée.

Une des particularités des êtres vivants est de

pouvoir acquérir des images, via l'oeil, comme une information, puis de

pouvoir l'interpréter via le cerveau. L'enjeu de la vision artificielle,

domaine dont est issu le sujet que nous allons traiter, est de permettre

à un ordinateur de »voir» ; C'est-à-dire, comme

l'homme, de récupérer l'information par l'intermédiaire

d'un dispositif d'acquisition d'image (une caméra ou bien un autre

support numérique) puis de l'exploiter à travers un programme

(exemple bibliothèque OpenCV), implémenter dans un langage de

programmation tel que (C, C++, Java, Matlab, Python, etc.).

La détection d'objet en mouvement est un domaine

très actif de la vision par ordinateur. De nombreux secteurs, et plus

particulièrement celui de la surveillance nécessitent une analyse

automatique de vidéos présentant des personnes ou des objets en

mouvement. De nombreux travaux ont été menés aux cours des

dernières décennies et de nombreuses approches ont

été mises en oeuvre, on peut citer les travaux de recherches de

(Benabbas, 2012) ; toutefois la plupart d'entre elles ne sont

valables que dans certaines situations spécifiques.

Une méthode fonctionnant parfaitement quel que soit le

type de situation n'existe pas encore. Des algorithmes robustes de

détection de personnes individuelles dans des scènes à

faible densité ont aussi été proposés. Nous allons

nous intéresser au cas de la reconnaissance d'actions et de mouvements

d'une ou plusieurs personnes dans une image obtenue via une caméra.

L'une des difficultés majeures dans ce genre

d'environnement est la forte ressemblance entre les différents

mouvements de personnes ainsi que le nombre important d'occultations partielles

ou totales de certaines détections ou reconnaissances appelées

fausses alertes.

La vidéosurveillance intelligente pour la

sécurité des personnes et d'espaces est une technologie

émergeante et encore peu connue qui change le paradigme d'utilisation

2

de la vidéosurveillance traditionnelle et ouvre de

nouvelles possibilités. C'est pourquoi elle laisse envisager

l'éclosion de nouveaux segments de recherches dans le secteur de la

sécurité.

Dans ce contexte, l'analytique vidéo présente de

nombreux avantages :

- Elle est en fonction 24 heures par jours, sept jours par

semaine ;

- Elle peut enclencher une alarme qui sera traitée par

un opérateur humain, commander le déplacement ou zoom d'une

caméra pour une surveillance plus précise d'un

événement suspects ou pertinents, permettant ainsi une

intervention en temps réel, plutôt qu'après

l'événement ;

- Elle réduit la bande passante et l'espace d'archivage

nécessaires en ne transmettant ou n'enregistrant que les données

sur les événements pertinents ; - Elle libère le personnel

de sécurité d'une surveillance continue ;

- Elle permet la recherche rapide d'événements

pertinents dans les séquences vidéo archivées ;

- Elle permet d'identifier les objets dans une scène et de

suivre leur activité.

? Problématique

Le problème que nous nous proposons de résoudre

dans le cadre de ce travail de fin d'étude en vue d'obtention de

diplôme de Master de Recherches en Imagerie Numérique pour le

Développement Durable peut se formuler par la question suivante :

Comment détecter un objet ou une personne en mouvement dans une

séquence vidéo? La réponse à cette question

constitue une première étape dans la reconnaissance d'objet, de

personne ou de situation suspecte dans une image dans le cadre de la

vidéo surveillance.

? Objectif

L'objectif de ce travail de recherche est de mettre en

évidence le mouvement d'une personne dans une séquence

vidéo.

Pour arriver à cette fin les objectifs spécifiques

seront de :

- Faire un état de l'art des méthodes existantes de

détection d'objet en mouvement;

- Choisir avec justification de méthodes efficaces de

détection d'objet en mouvement eu égard au contexte

socio-économique ;

- Proposer une implémentation de quelques méthodes

efficaces de détection de personne ou d'objet en mouvement.

3

? Plan du travail

Notre travail est subdivisé en cinq chapitres.

- Le premier chapitre présente le cadre de

l'étude comprenant une étude sur le cadre conceptuel et la

méthodologie.

- Le deuxième chapitre fait l'état de l'art des

méthodes existantes de détection d'objets ou de personnes dans

une d'images en mettant en exergue leurs avantages et inconvénients dans

chaque cas étudié.

- Le troisième chapitre, met en exergue le choix de

l'étude de méthodes efficaces de détection d'objet en

mouvement.

- Le quatrième chapitre décrit l'ensemble du

matériel utilisé pour l'implémentation et l'obtention de

résultats, et présente quelques fonctions utiles d'OpenCv.

- Dans le cinquième chapitre, nous proposons une

implémentation de méthodes choisies suivi d'une discussion sur

les résultats obtenus.

Enfin dans la conclusion, nous avançons les

perspectives d'insertion de notre travail dans la reconnaissance de mouvement

suspect dans une séquence vidéo.

4

Chapitre 1 : Cadre de l'étude

Dans ce présent chapitre, nous présentons deux

grands aspects de nos recherches ; le cadre théorique définissant

les concepts clés de traitement d'images, ensuite le cadre

méthodologique. Les définitions utilisées ici sont

extraites de (MEDJAHED, 2012) et de (Maïtine,

2015).

1.1. Cadre théorique

Dans cette partie, nous présentons les notions

essentielles à la compréhension de techniques

développées dans le cadre de la détection de mouvement sur

une séquence vidéo.

1.1.1. Image

Une image numérique est une matrice de pixels

repérée par ces coordonnées (x, y). S'il s'agit d'une

image couleur, un pixel est codé par 3 composantes (R, G, B) (chacune

comprise au sens large entre 0 et 255 ou plus), représentant

respectivement les niveaux de rouge, vert et bleu qui caractérisent la

couleur du pixel. S'il s'agit d'une image en niveau de gris, il est codé

par une seule composante comprise au sens large entre 0 et 255,

représentant la luminosité du pixel.

Exemples de couleurs :

· (0, 0,0)=noir.

· (255, 0,0)=rouge.

· (0, 255,0)=vert.

· (0, 0,255)=bleu.

· (127, 127,127)=gris moyen.

· (255, 255,255)=blanc.

1.1.1.1. Les images couleur

L'espace couleur est basé sur la synthèse des

couleurs, c'est-à-dire que le mélange de trois composantes donne

une couleur. Un pixel est codé par trois valeurs numériques. La

signification de ces valeurs dépend du type de codage choisi. Le plus

utilisé pour manier les images numériques est l'espace couleur

"Rouge-Vert-Bleu" (R, V, B) (RGB en anglais).

5

La restitution des couleurs sur écran utilise cette

représentation. C'est une synthèse additive. Il en existe

beaucoup d'autres : Cyan -Magenta-Jaune (ou CMY en anglais),

Teinte-Saturation-Luminosité (ou HSL en anglais), YUV, YIQ, Lab, XYZ

etc. La restitution des images sur papier utilise cette représentation :

c'est une synthèse soustractive.

Dans ce qui suit nous ne considérerons que des images

en niveaux de gris. En effet, chaque calque (ou canal) couleur peut être

considéré comme une image en niveaux de gris

séparément et on peut lui appliquer les transformations et

méthodes décrites dans l'état de l'art. Toutefois, les

techniques de recalage propres aux images couleur sont délicates et

sortent largement du cadre que nous nous sommes fixés ici.

1.1.1.2. Chrominance

C'est l'information portée par la lumière qui a

probablement la fréquence d'une onde lumineuse influençant la

couleur que nous percevons lorsque le rayon vient frapper notre rétine :

du rouge au violet en passant par tous les tons de l'arc-en-ciel.

1.1.1.3. Les images en niveaux de gris

En général, les images en niveaux de gris

renferment 256 teintes de gris. Par convention la valeur zéro

représente le noir (intensité lumineuse nulle) et la valeur 255,

le blanc (intensité lumineuse maximale). Le nombre 256 est lié

à la quantification de l'image. En effet chaque entier

représentant un niveau de gris est codé sur 8 bits. Il est donc

compris entre 0 et (28-1) = 255. C'est la quantification la plus

courante. On peut coder une image en niveaux de gris sur 16 bits (0 =n

=216-1) ou sur 2 bits : dans ce dernier cas le " niveau de

gris" vaut 0 ou 1.

1.1.1.4. Les images binaires (noir-blanc)

C'est l'exemple des images les plus simples : un pixel peut

prendre uniquement les valeurs noir ou blanc. C'est typiquement le type d'image

que l'on utilise pour numériser du texte quand celui-ci est

composé d'une seule couleur.

1.1.1.5. Luminance

C'est l'information relative à l'intensité de la

lumière. Cela revient à considérer la lumière comme

porteuse d'une seule information, descriptible par un seul nombre : le niveau

de gris. Si l'on raisonne en termes d'ondes lumineuses, on peut

considérer, grosso-modo, que cette information se traduit par

l'amplitude de l'onde.

6

1.1.1.6. Masque

Un masque est un outil pour le traitement d'image ; c'est lui

qui définit la surface des pixels qui va être utilisée pour

un traitement. Imaginons que nous souhaitons effectuer une opération

entre un pixel et ses voisins. Nous allons définir un masque qui

contiendra les pixels dont nous avons besoin pour faire notre calcul.

1.1.1.7. Binarisation

La binarisation consiste à transformer un pixel sur

plusieurs bits (2, 4, 8 ou plus) en une image sur 1 seul bit. Pour ça,

nous allons faire un seuillage. Si la valeur du pixel est en dessous du seuil,

nous lui associons la valeur 0. Si la valeur du pixel est égale ou

supérieure au seuil nous lui donnons la valeur 1. Si l'image est en

niveau de gris, il n'y a qu'une seule composante de couleur.

En ce qui concerne les images couleurs, c'est

différent. En effet nous avons 3 composantes de couleur (rouge bleu

vert), La première étape consiste donc à transformer une

image en couleur en niveau de gris puis en image binaire.

1.1.1.8. Seuillage

Pour exploiter une image numérique, elle a

généralement besoin d'être simplifiée, c'est le but

du seuillage. Ce dernier consiste à transformer l'image codée sur

6, 8 ou 16 bits, en une image binaire ou les pixels à 1 correspondent

aux objets et les pixels à 0 au fond de l'image. À la

différence des différents traitements de l'image

numérique, le seuillage est un passage obligatoire pour toute analyse

morphologique ultérieure. Le seuillage permet de sélectionner les

parties de l'image qui intéressent l'opérateur, par exemple 2

types de grains (blancs et sombres) dans un mélange. On

peut donc, par exemple, attribuer à tous les pixels de l'image

numérique qui ont un niveau de gris compris entre i1 et

i2, choisies par l'opérateur, la valeur 1; à

tous les autres pixels est attribuée la valeur 0. Après

seuillage, les parties de l'image sélectionnées seront traduites

en noir et blanc. L'image, digitalisée par l'ordinateur (0 et 1), est

appelée image binaire. Cette dernière, tout comme l'image

numérique contient des informations superfétatoires, qu'il

convient d'éviter, ou masquées qu'il faut révéler.

Les traitements suivants permettent de modifier l'image binaire à ces

fins.

7

1.1.1.9. Histogramme

Un histogramme est un ensemble de données statistiques

permettant de représenter la distribution des intensités

lumineuses des pixels d'une image, c'est à-dire le nombre de pixels pour

chaque niveau de gris. Pour une image en couleur, il est possible soit de faire

un histogramme par composante (RGB en français rouge, vert et bleue),

soit de faire l'histogramme de la moyenne des trois composantes pour chaque

pixel, soit de faire l'étirement et l'égalisation.

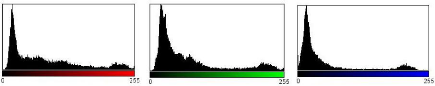

Image originale

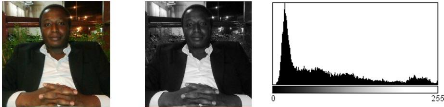

a)Histogramme en R (Rouge) b) Histogramme en G (vert) c)

Histogramme en B (Bleue)

Figure 1: Histogramme d'une image en RGB

La figure 1 représente une image couleur filmée,

en 1.a) nous avons une représentation de l'histogramme en fonction du

canal rouge. 1.b) représente la forme de la représentation

graphique en fonction du canal vert. Et enfin 1.c) c'est représentation

de l'histogramme en fonction du canal bleu.

1.1.1.10. Histogramme cumulé

L'histogramme cumulé représente la distribution

cumulée des intensités des pixels d'une image. En plus de

l'histogramme classique, il peut être intéressant dans certains

cas

8

de travailler sur l'histogramme cumulé. Ce dernier

s'obtient en associant à chaque niveau de gris i le nombre

hi de pixels de l'image qui ont une valeur

inférieure ou égale à i.

En quelque sorte, cela revient à calculer l'histogramme de

l'image et d'associer à chaque niveau i la somme des

hi (nombre de pixel de l'image qui ont une valeur

égale à j) pour ] = ~.

En formule :

hti~ = Eo<1<tihti= ho + h1 +

·

·

· ..............hti (1)

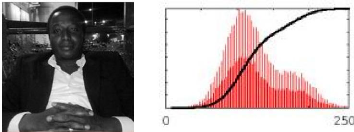

Figure 2: Image en niveau de gris et son histogramme

cumulé

La figure 2 est en niveau de gris, c'est une

représentation sur un seul canal ; c'est la quantification la plus

courante. L'histogramme est la représentation graphique de cette image

en niveau de gris.

a) Modification de l'histogramme

L'histogramme est un outil très utile pour

étudier la répartition de composantes d'une image mais il permet

également de corriger le contraste et l'échelle des couleurs pour

des images surexposées ou sous-exposées : On parle dans ce cas

d'exemples des images qu'on n'arrive pas à identifier ou qu'on n'arrive

pas à lire compte tenu des pixels non lumineux.

En outre sa modification n'altère pas les informations

contenues dans l'image mais les rend plus ou moins visibles. La modification

d'un histogramme est généralement représentée sur

une courbe (appelée courbe tonale) indiquant la modification globale des

composantes de l'image avec en abscisse les valeurs initiales et en

ordonnée les valeurs après modification.

9

|

Figure 3: Modification d'histogramme

La figure ci-contre montre l'histogramme lorsqu'aucun mouvement

n'a eu lieu.

|

Comme illustre la figure suivante, la diagonale indique la

courbe telle que les valeurs initiales sont égales aux valeurs finales,

c'est-à-dire lorsque aucune modification n'a eu lieu. Les valeurs

à gauche de la valeur moyenne sur l'axe des abscisses

représentent les pixels "clairs" tandis que ceux à droite

représentent les pixels foncés.

b) Étirement de l'histogramme

L'étirement d'histogramme (aussi appelé

"linéarisation d'histogramme" ou "expansion de la dynamique") consiste

à répartir les fréquences d'apparition des pixels sur la

largeur de l'histogramme.

Ainsi il s'agit d'une opération consistant à

modifier l'histogramme de telle manière à répartir au

mieux les intensités sur l'échelle des valeurs disponibles. Ceci

revient à étendre l'histogramme afin que la valeur

d'intensité la plus faible soit à zéro et que la plus

haute soit à la valeur maximale.

De cette façon, si les valeurs de l'histogramme sont

très proches les unes des autres, l'étirement va permettre de

fournir une meilleure répartition afin de rendre les pixels clairs

encore plus clairs et les pixels foncés proches du noir. Il est ainsi

possible d'augmenter le contraste d'une image. Par exemple une image trop

foncée pourra devenir plus "visible".

a) Image Originale b) Image Étirée c)

Histogramme

Figure 4: Étirement et Histogramme de l'image

Étirée

10

L'image 4.a) est l'origine ou la source, en 4.b), nous avons une

image étirée de l'image originale en niveau de gris. En 4.c)

c'est une représentation de l'histogramme de l'image

étirée.

c) Égalisation d'histogramme

Il peut arriver que les pixels d'une image, bien qu'occupant tout

l'espace de valeurs disponible entre 0 et 255, soient « agglutinés

», c'est-à-dire que l'histogramme n'est pas uniforme. C'est le cas,

par exemple, sur les images suivantes :

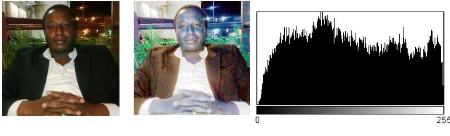

a) Image Originale b) Image Égalisée c)

Histogramme

Figure 5 : Égalisation et Histogramme de l'image

égalisée

L'image 5.a) est l'originale ou la source, l'image 5.b) nous

donne la forme égalisée de l'image originale. On remarque que la

couleur est devenue vive. Enfin en 5.c) une présentation de

l'histogramme. Ce qui nous saute très vite aux yeux, c'est que cette

image contient beaucoup de pixels très sombres ou très clairs, et

relativement peu de pixels d'une luminosité « moyenne ».

1.1.1.11. Morphologie Mathématique

La morphologie mathématique est une méthode de

description de la forme des objets par comparaisons avec des objets de formes

connues, les éléments structurants. Les éléments

structurants les plus employés sont les éléments convexes

tels que le segment et surtout le disque isotrope. Concrètement, si le

réseau régulier de pixels choisi pour représenter une

image binaire est hexagonal, un élément structurant,

assimilé dans cet exemple à un disque, sera parfaitement

déterminé par les valeurs attribuées (1 ou 0) à son

centre et plus proches voisins de ce dernier, répartis selon un

hexagone. L'ensemble des plus proches voisins constitue le voisinage du

centre.

a) Dilatation et Érosion

Une érosion permet de supprimer les pixels «

isolés » qui ne correspondent pas à notre objet

détecté. Ensuite vient l'étape de la dilatation qui nous

permet de renforcer les groupes denses de pixels notamment l'objet suivi.

a) Image originale b) image dilatée

Figure 6 : Dilatation d'image

L'image a) de la figure 5, nous montre l'image originale

acquise via une caméra. L'image 5.b) est l'image dilatée de

l'image 5.a).

a)

11

Image originale b) image érodée

Figure 7 :

Érosion d'image

L'image a) de la figure 6, nous montre l'image originale

acquise via une caméra. L'image 6.b) est l'image érodée de

l'image 6.a).

b) Ouverture

L'ouverture de I par S notée IoS est

le résultat d'une érosion de I suivie d'une

dilatation de l'ensemble érodé par le même

élément structurant.

loS = (lOS) S (2)

12

L'ouverture adoucit les contours et élimine les pics

aigus.

c) Fermeture

C'est l'opération duale de l'ouverture, notée

I

·S, c'est le résultat d'une dilatation suivie d'une

érosion en utilisant le même élément structurant.

I

· S = (I ED S)0S (3)

La fermeture fusionne les coupures étroites,

élimine les petits trous, et comble les vides sur les contours.

1.1.1.12. Étiquetage des composantes

L'étiquetage des composantes connexes1 d'une

image binaire consiste à attribuer un label, étiquette ou

numéro différent pour chaque composante connexe et identique pour

tous les pixels d'une même composante. Il existe de nombreux algorithmes

réalisant cette fonction. Ils dépendent de la connexité

considérée et se différencient aussi par leur approche

séquentielle ou parallèle. Une composante connexe peut alors

être extraite par l'intermédiaire de son étiquette pour

faire un traitement spécifique. L'image des étiquettes est une

formulation implicite des composantes connexes; l'extraction aura pour but la

transformation de cette formulation implicite en une formulation explicite

(liste des composantes connexes avec des attributs par exemple).

1.1.2. Définition d'une vidéo

La vidéo est une succession d'images animées

défilant à une certaine cadence afin de créer une illusion

de mouvement pour l'oeil humain. Elle peut être analogique (signal

continu d'intensité de luminance) ou numérique (suite de trames

ou images). On peut distinguer deux types de vidéo:

La vidéo entrelacée: où

chaque image est formée de deux champs entrelacés. Le premier

champ contenant uniquement les lignes impaires de l'image, le second champ,

quant à lui, contenant les lignes paires (les signaux de

télévision nord-américain et européen sont

entrelacés).

La vidéo progressive: dans une

vidéo progressive, contrairement au mode entrelacé, toutes les

lignes d'une image sont lues en une passe (vidéo numérique).

1 C'est l'ensemble des éléments

constituants la connexité d'un graphe

13

1.1.2.1. Résolution temporelle d'une

vidéo

La résolution temporelle d'une vidéo est

définie par le nombre d'images défilant par seconde. Afin

d'éviter les désagréments dus aux papillotements, et

prenant en considération les spécificités de l'oeil humain

qui garde une image environ 10 micro secondes au niveau de sa rétine ;

les images doivent défiler à une certaine cadence:

Environ 24 images/s pour un film de cinéma ;

25 images/s pour la télévision européenne

;

Environ 30 images/s pour la télévision

nord-américaine et japonaise.

1.1.2.2. Séquence d'images

Une séquence d'images est une succession d'images

bidimensionnelles qui montre l'évolution temporelle d'une scène.

La cadence est de 25 images par seconde, ce qui correspond au seuil à

partir duquel l'oeil humain perçoit la séquence comme un stimulus

continu, grâce à la persistance rétinienne. Par la suite,

nous appellerons « trame » ou « plan » chaque image

bidimensionnelle correspondant à un instant donné de la

séquence.

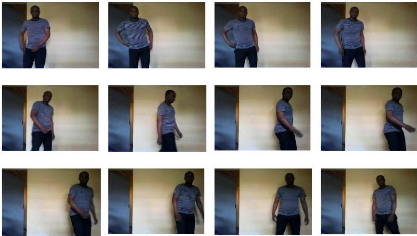

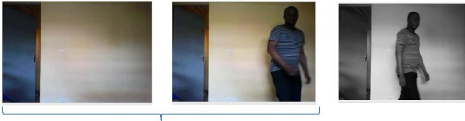

Figure 8: Exemple d'une séquence d'images

La figure 8, nous montre les captures d'images du

déplacement d'une personne dans une séquence vidéo.

Par ailleurs, il est important de bien définir le terme

détection du mouvement afin d'éliminer les ambigüités

qui pourraient survenir.

14

Conclusion

Dans ce chapitre, nous avons rappelé les

différentes notions essentielles à la compréhension. Dans

ce que suit, nous allons faire l'état de l'art de méthode de

détection d'objet en mouvement.

15

Chapitre 2 : État de l'art

Dans ce présent chapitre, plusieurs méthodes de

détection de mouvement par vision numérique seront

présentées. Pour celles-ci, la performance varie en fonction du

temps de traitement et de la qualité des résultats produit.

À partir d'un modèle de l'environnement et d'une

observation ou d'une série d'observations successives, on cherche

à détecter et suivre ce qui a changé.

Il existe plusieurs méthodes dans la

littérature, faire une étude comparative détaillée

de toutes les au-delà du cadre de ce travail. Nous avons eu à

nous baser sur les méthodes les plus récentes de détection

de mouvement dans une séquence vidéo.

2.1.Détection par Différences entre deux

images consécutives

Elle représente une solution très

intéressante et peu complexe. Comme son nom l'indique, elle consiste

à soustraire une image acquise au temps tn

d'une autre au temps tn + k, où

k est habituellement égal à 1. On utilise des

méthodes qui calculent une différence temporelle, pixel par

pixel, entre deux ou trois images successives. On peut citer les travaux de

(Lipton et al., 1998) et de

(Huwer et Niemannqui.,

2000) qui traitent de la détection par différence d'images. La

valeur absolue de cette différence est seuillée pour

détecter les changements. Ensuite, les pixels " labellisés en

mouvement" sont regroupés en objets avec une analyse en composantes

connectées. Cette méthode présente l'avantage d'être

adaptée aux environnements dynamiques puisqu'elle n'est pas

influencée par les variations de luminosité mais ne permet pas de

récupérer tous les pixels de l'objet en mouvement.

Ainsi, l'image résultante sera vide si aucun mouvement

ne s'est produit pendant l'intervalle de temps observé car

l'intensité et la couleur des pixels seront presque identiques.

Par contre, si le mouvement a lieu dans le champ de vue, les

pixels frontières des objets en déplacement devraient changer

drastiquement de valeurs, révélant alors la présence

d'activité dans la scène. Cette technique nécessite

très peu de ressources, car aucun modèle n'est nécessaire.

Cela implique donc qu'il n'y a pas de phase d'initialisation obligatoire avec

une scène statique, ce qui procure une très grande

flexibilité d'utilisation. De plus, une opération de soustraction

d'images requiert très peu de puissance de calcul,

16

lui conférant un avantage supplémentaire.

Par ailleurs, les résultats obtenus par cette

méthode ne sont pas aussi précis que ceux

générés en utilisant un modèle statistique de

l'arrière-plan. En effet, certains traitements supplémentaires

sont nécessaires afin de déterminer la zone en mouvement (zone

intérieure et contours des objets en mouvement), car l'information

disponible ne concerne que les contours des régions en

déplacement.

2.2.Flux optique

Similaire à l'approche précédente,

l'utilisation du flux optique ou flot optique procure une information de

mouvement pour chaque pixel de l'image. Ainsi, il mesure les vecteurs de

déplacement à partir de l'intensité des pixels de deux

images consécutives ou temporellement rapprochées. Dans un

contexte de détection de mouvement, les pixels inactifs

possèderont alors une vélocité nulle contrairement aux

pixels appartenant à des objets dynamiques. Une classification sous

forme de regroupement est donc nécessaire afin d'isoler et de localiser

les zones représentant du mouvement. Cette technique a notamment

été utilisée pour la détection de piétons

(Kunret et al.,

2001). Il y a finalement plusieurs méthodes pour

calculer le flux optique, mentionnons entre autres celle de (Lucas

et Kanade, 1981).

L'inconvénient majeur de l'utilisation du flux optique est la somme

importante de calculs à réaliser pour l'estimation du

mouvement.

Par ailleurs, une variante utilisant le block

matching2 peut bénéficier de certaines instructions

optimisées MMX (MultiMedia eXtension ou MatriX Math), ce qui peut

accélérer le traitement global. Néanmoins, une tâche

supplémentaire de classification et d'interprétation est

nécessaire. De plus, si certaines parties d'un objet ne sont pas en

mouvement, elles seront complétement ignorées par cette

méthode. Ça peut être le cas par exemple d'une

séquence vidéo contenant une personne assise par terre et agitant

les bras. Dans cette situation bien précise, le corps de la personne ne

serait pas détecté contrairement à ses bras.

2.3.Soustraction de l'arrière-plan par

modélisation statistique

La présente technique est la moins récente et

l'une les plus utilisées, probablement grâce à sa

simplicité théorique ainsi qu'à sa faible

complexité algorithmique. Le principe fondamental repose sur une

estimation statistique de la scène observée.

2 Le block matching est algorithme utilisé dans

plusieurs algorithmes de compression vidéo pour l'estimation du

mouvement entre différentes images d'une vidéo.

17

Le mouvement est détecté en comparant une image

test (image de référence) avec le modèle

d'arrière-plan calculé auparavant. Certaines hypothèses de

base doivent par contre être respectées pour un fonctionnement

adéquat de cette méthode.

Tout d'abord, la caméra utilisée est fixe et ne

doit bouger à aucun moment. Une caméra à l'épaule

ou une caméra sur pied est un bon exemple de situation non applicable

à la Soustraction d'Arrière-Plan (SAP). Pour ce qui est de la

scène observée, elle doit être relativement constante et

conserver la même apparence. Un paysage observé à partir

d'une voiture à une vitesse constante est donc une bonne

représentation d'une scène non statique. Il est important de

noter qu'aucune limite n'est utilisée pour la quantité d'objets

en mouvement. De plus, des variations de luminosité sont

tolérées en autant qu'elles ne soient pas trop brusques.

Le modèle statistique calculé lors de la phase

d'initialisation est constamment mis à jour, lui permettant ainsi de

s'adapter aux changements qui peuvent se produire dans la scène

observée (par ex : soleil levant). Cette capacité d'adaptation

est commune à toutes les techniques de SAP par modélisation

statistique et leur confère un atout majeur qui sera abordé en

détails tout au long de nos recherches. Par ailleurs, cette

méthode connaît plusieurs implantations différentes qui

varient principalement selon le type de capteur utilisé.

2.3.1. Visibilité sur deux dimensions (2D)

La première catégorie de méthodes de

soustraction d'arrière-plan regroupe les techniques basées sur

l'utilisation d'images 2D dans le spectre visible. Un des modèles de

couleurs le plus fréquemment utilisé pour la modélisation

statistique est le RGB, soient le rouge (R), le vert (G) et le bleu (B).

La technique de base consiste à modéliser

l'arrière-plan à partir de plusieurs images acquises

séquentiellement. Pour chaque pixel de l'image, ainsi que pour chacun

des canaux (R, G et B), une moyenne et une variance sont calculées.

Lorsqu'un pixel test doit être classifié, il faut tout d'abord lui

soustraire la moyenne correspondante dans le modèle statistique. Il sera

alors étiqueté comme un pixel contenant du mouvement seulement si

la valeur absolue du résultat dépasse un certain multiple de

l'écart-type correspondant.

Les travaux de (Horprasert et

al.,2000) ont proposé un nouveau

modèle de couleurs basé sur le RGB. Leur technique permet la

classification des pixels en quatre catégories, soient

l'arrière-plan original, illuminé, ombré et un pixel en

mouvement. Pour

18

ce faire, deux mesures sont ajoutées à la

méthode de base en RGB : la distorsion chromatique

(á) et la luminosité

(CD). Les points faibles de cette approche

résident surtout dans la somme d'opérations

supplémentaires nécessaires pour calculer ces deux mesures ainsi

que les seuils associés. En pratique, certaines erreurs de

classifications peuvent également se produire entrainant, par exemple,

l'identification d'un objet en mouvement comme étant de l'ombre. Il y a

finalement un très grand nombre de méthodes de SAP par

modélisation statistique non abordées dans le cadre de ce travail

(McIvor, 2000), notamment pour des raisons de

complexité et pour lesquelles les gains en performance sur la technique

de base sont relativement négligeables.

2.3.2. Informations de profondeur à trois dimensions

(3D)

L'utilisation d'informations tridimensionnelles (par. ex :

webcam ou bien une caméra classique) permet la réalisation d'une

soustraction d'arrière-plan très efficace. Tout comme les

méthodes précédentes, cette technique nécessite un

modèle statistique de l'arrière-plan. Mais contrairement aux

autres, elle renferme des valeurs de distances entre la caméra et les

différentes composantes de la scène. Le mouvement sera donc

détecté lorsque des points seront à des distances

différentes de celles retrouvées dans le modèle

statistique.

Une implantation en temps réel de cet algorithme

requiert cependant énormément de puissance de calcul ou de

l'équipement matériel spécialisé tel que

souligné par (Kanade et

al.,1996).

Par ailleurs, (Ivanov et

al., 2000) ont proposé un modèle hybride

utilisant la couleur et les informations 3D pour accomplir la SAP. Dans ce cas,

les informations de profondeurs sont modélisées et

calculées hors-ligne en générant un modèle de

disparité de l'arrière-plan nécessaire à la

validation. Il est ensuite utilisé pour étiqueter un pixel qui ne

respecte pas la couleur d'une image de référence comme

étant de l'ombre ou un objet en mouvement.

Les avantages majeurs de cette méthode reposent sur sa

robustesse à l'illumination et sa capacité à

éliminer les ombres.

19

2.4.Détection par Histogramme

La détection de mouvement par histogramme comprend deux

types de reconnaissance.

Le premier : l'image de référence est toujours

la même, alors que dans le second type : l'image est modifiée

à chaque photogramme. Dans chacun des cas, on va comparer, les

histogrammes de chacune des couleurs, entre l'image de référence

et la particule. Une moyenne sera effectuée, puis inversée de

façon à ce que la différence la plus petite possède

le poids le plus grand.

L'image de référence peut être une image

sélectionnée de la bibliothèque ou une sélection

faite à la main sur le premier photogramme de la vidéo. En effet

il est possible de changer le photogramme d'origine à chaque instant de

traitement, ceci peut être intéressant si l'objet change de forme

ou de couleur. Dans notre cas, les personnes peuvent marcher, courir, se

courber ou s'agiter.

Avec un changement d'image de référence, l'objet

se perd peu à peu. Avec une image fixe, l'objet sera toujours

présent mais si cet objet change de couleur alors il sera impossible de

le repérer. Il faut donc trouver un compromis, permettant de

repérer l'objet à chaque changement de couleur. Lorsque le choix

de l'image de référence se fait à la main sur le premier

photogramme, les particules ne sont alors pas placées

aléatoirement sur tout le frame, mais autour de la particule

sélectionnée. De cette façon, l'objet est

détecté tout de suite, et si les paramètres sont corrects

alors l'objet est correctement suivi à chaque frame. Les

paramètres de tracking3, en particulier avec la

méthode de l'histogramme, sont difficiles à obtenir.

En effet, ces paramètres peuvent dépendre de la

taille de la particule de référence mais aussi des informations

qu'elle contient. De ce fait, il est très difficile avec une

sélection du photogramme référence, de trouver les bons

paramètres car la sélection ne sera pas identique à chaque

fois. Plus le nombre d'information sur l'objet est important, moins les erreurs

sont possibles, plus il y a d'informations, meilleurs sont les

résultats. Mais si ces informations concernent «le

background» en majorité, c'est la particule qui

3 Enregistrement et analyse discrète de toutes

les activités d'un individu, à des fins plus ou moins

honnêtes.

20

correspond le plus au «background» qui sera

reconnue. Si tout le « background » est éliminé, une

partie des informations de l'objet sera également

éliminée.

Si l'image de référence est fixe et que l'objet

change de taille, de forme ou de couleur au cours de la vidéo, la

reconnaissance ne se fera pas. En changeant le frame d'origine et donc

l'histogramme de comparaison, le risque est moindre car l'histogramme varie de

la même manière que l'objet. En revanche si on utilise le

changement de frame il y aura un risque de décalage à chaque

changement et de ne reconnaître que le fond à la fin de la

vidéo. Il est donc nécessaire de trouver un bon équilibre

et de ne changer le frame et l'histogramme que lorsque la particule et

l'histogramme sont très proche mais pas à chaque frame. Les

paramètres sont difficiles à mettre en place, il y a un manque de

précision et les résultats ne sont pas toujours ceux

espérés. Cet algorithme n'est pas idéal dans

l'étude de détection des personnes.

2.5.Détection par couleur

La détection par la couleur est devenue une

méthode rapide de détection des visages. Il a en effet

été montré que l'utilisation de la couleur de la peau pour

détecter la présence d'un visage est un critère fiable, la

peau ayant une couleur caractéristique pouvant aisément

être distinguée des autres couleurs. De plus, l'attribut couleur

est plus robuste que l'attribut contour étant données les

variations géométriques d'un visage ou d'une main. La

construction d'un détecteur de couleur doit répondre à

trois problèmes. Il est tout d'abord nécessaire de choisir un

espace de couleur, puis la représentation à utiliser pour

modéliser la couleur, et enfin la manière d'exploiter le

résultat produit par le détecteur. L'utilisation de cet attribut

induit bien entendu certaines contraintes que nous détaillerons.

2.5.1. Espaces de couleur

De nombreux espaces de couleur ont été

conçus dans les recherches en colorimétrie, synthèse

d'image et transmission du signal vidéo.

RGB

L'espace de couleur RGB fut à l'origine conçu

pour la formation des images dans les tubes cathodiques (cathode-ray tube CRT),

qui supposait pouvoir décomposer la couleur en trois rayons (rouge, vert

et bleu). C'est un des espaces le plus utilisé dans le traitement et le

stockage des images numériques. Par contre la haute corrélation

entre les trois

21

canaux, la non-uniformité perceptuelle, le mélange

des données de chrominance et de luminance font de ce système un

choix peu heureux pour l'analyse d'images d'après leurs couleurs.

RGB normalisé.

Dans le but de diminuer la corrélation des canaux avec la

luminance, il est possible de les normaliser.

Perceptuels.

Les systèmes perceptuels distinguent trois informations

: la Teinte, la Saturation et la Luminance, notés HSV (Hue Saturation

Value). Ils fournissent des informations numériques sur les

propriétés de la couleur et la décrivent de manière

plus intuitive (que les systèmes RGB par exemple). La teinte

dénie la composante chromatique dominante de la région

analysée, la saturation donne la proportion de cette composante de la

région par rapport à sa luminosité. L'intensité, la

valeur et la luminance définissent la luminosité de la

région. Leur capacité à distinguer la chrominance de la

luminance en ont fait des espaces de couleur populaires dans les travaux de

segmentation par la couleur.

Perceptuel uniforme

Un espace perceptuel uniforme est un espace où une

petite perturbation d'un composant est perceptible de manière

égale sur l'ensemble des valeurs du composant.

2.5.2. Modélisation de la couleur de la peau

Le but final d'un détecteur de couleur de peau est de

construire une règle de décision pour faire la différence

entre les pixels de couleur peau et les autres. On introduit habituellement une

métrique pour mesurer la distance (au sens général) entre

la couleur d'un pixel et la couleur de la peau.

Modélisation non-paramétrique.

L'idée principale dans la réalisation

non-paramétrique est d'estimer la distribution de couleur à

partir de données d'apprentissage sans en dériver explicitement

un modèle. Le résultat de ces méthodes est souvent

appelé `' carte de probabilité de couleur `'

détaillée par (Brand et

Mason, 2000) et (Gomez et

Morales 2002) où une probabilité est

associée à chaque point d'un espace de couleur.

22

Modélisation paramétrique

Les modélisations non paramétriques utilisant

des histogrammes nécessitent beaucoup d'espaces et leur pouvoir

discriminant dépend directement de la représentativité de

l'ensemble d'apprentissage. La nécessité de pouvoir disposer de

représentations plus compactes avec des possibilités de

généralisation et d'interpolation des données

d'apprentissage a motivé le développement de modèles

paramétriques de couleur de peau.

Table de correspondance.

Plusieurs algorithmes de détection d'objet en mouvement

(Chen et al., 1995),

(Sigal et al. 2000))

utilisent des histogrammes pour segmenter les pixels de couleur peau. L'espace

de couleur (habituellement l'information de chrominance seule est

utilisée) est quantifié dans les cases de l'histogramme, chacune

correspondant à un certain ensemble de composants de couleur. Ces cases

forment un histogramme 2D ou 3D selon la table de mise en correspondance.

Chaque case contient le nombre d'occurrence d'une couleur dans les images de

l'ensemble d'apprentissage. Après l'apprentissage, l'histogramme est

normalisé, convertissant les valeurs de l'histogramme en distribution de

probabilité discrète.

Pskin(c) = ~~~~|~|

~~~~ (4)

où skin|c| est la valeur de la case de

l'histogramme correspondant à la couleur c, et

Norm le coefficient de normalisation, soit la somme de toutes

les cases de l'histogramme soit la valeur maximum. Les valeurs

normalisées de la table de correspondance constituent la

probabilité que la couleur correspondante soit de la couleur de la

peau.

2.6.Méthode de détection par Technique du

Gradient

Le gradient est une grandeur vectorielle qui indique comment

une grandeur physique varie en fonction de ses différents

paramètres. Dans notre cas, nous voulons analyser la variation

d'intensité entre chaque pixel de l'image. Intuitivement, le gradient

indique la direction de la plus grande variation du champ scalaire, et

l'intensité de cette variation. Par exemple, le gradient de l'altitude

est dirigé selon la ligne de plus grande pente et sa norme augmente avec

la pente. On peut donc considéré qu'un point de l'image (pixel)

correspond à un maximum local de la norme du gradient. La normale du

contour est

23

donnée par le gradient. Si la valeur du gradient est non

nulle on peut donc déduire que l'on se situe dans une zone de transition

entre une partie claire et une partie sombre.

Cette méthode n'a pas été suffisamment

investiguée dans le cadre de ce travail. 2.7.Tableau

comparatif de méthodes

Le tableau ci-dessous fait un résumé comparatif des

différentes méthodes ci-dessus abordées.

24

Tableau 1: Tableau comparative des méthodes

abordées

|

Type

|

Avantages

|

Inconvénients

|

|

Soustraction par arrière-plan

|

SAP (visible 2D)

|

- Algorithme peu complexe

- Classification simple

- Résultats clairs

|

- Initialisation/scène

statique

- Ombres non rejetées

|

|

SAP (visible 3D)

|

- Robustesse aux ombres

- Informations de profondeur

|

- Initialisation/scène

statique

- Complexité et calculs - Plusieurs caméras

|

|

Différences

d'images consécutives

|

- Flexibilité d'utilisation

- Faible complexité de

l'algorithme de base

- Souplesse d'initialisation

|

- Mouvement obligatoire - Ombres non rejetées -

Détection incomplète

|

|

Flux optique

|

- Informations précises sur le mouvement

- Suivi/prédiction possible

|

- Complexité et calculs - Ombres non rejetées -

Mouvement obligatoire - Interprétation difficile

|

|

Couleur

|

- Simplicité

d'implémentation

- Reconnaissance de la

couleur à

détectée

|

- Base de données

couleurs 2653

- Perte de détection par changement de couleur.

|

|

Histogramme

|

- Identification de particule

- Facilité de choix de

particules de

références

- Des informations, moins

d'erreurs

|

- Décalage de

reconnaissance

- Manque d'équilibre

- Difficulté de mise en

oeuvre

|

25

Conclusion

Ce chapitre a présenté, la revue de la

littérature des techniques de détection du mouvement les plus

utilisées et les plus robustes. Une comparaison des méthodes

(voir tableau) est fournie au tableau 1. Dans le chapitre suivant nous

justifions le choix de méthodes de détection qui feront l'objet

d'implémentation. La bibliothèque OpenCv sera un atout avec

certaines de ses fonctions que nous jugeons utiles et indispensables pour tout

traitement d'image ; de la reconnaissance au suivi en passant par la

détection d'objet en mouvement qui est l'objet de notre étude.

26

Chapitre 3 : Choix de la méthode retenue et

modélisation

Il est impératif de faire un choix après une

étude comparative faite à l'état de l'art sur les

avantages et les inconvénients de chacune des approches

envisagées. Parmi toutes les méthodes étudiées et

comparées, peu d'entre elles respectent l'ensemble des exigences et des

besoins de l'objectif que nous avons fixé.

Dans ce qui suit, nous proposons une démarche nous

permettant de choisir les méthodes de détection les plus

adaptées à notre problème eu égard au contexte.

Les contraintes matérielles excluent l'utilisation

d'informations tridimensionnelles ou d'équipements d'imagerie

infrarouge. Pour ce qui est du flux optique, l'importante somme de calculs

nécessaire ainsi que l'interprétation difficile des

résultats générés nuisent à sa

sélection. Ensuite, grâce à leur faible complexité

et leur temps de traitement raisonnable, deux approches différentes sont

finalement sélectionnées, la SAP par modélisation

statistique (visibilité en 2D) et la détection de mouvement par

différence d'images consécutives. Cette dernière

méthode, quoique possédant un avantage certain sur le plan de

l'initialisation, souffre de certaines limitations du côté de la

classification, favorisant finalement la sélection de la méthode

par soustraction d'arrière-plan par modélisation statistique 2D

dans le spectre visible.

3.1.Soustraction d'arrière-plan par

modélisation statistique

La soustraction de l'arrière-plan permet de simplifier

le traitement ultérieur en localisant les régions

d'intérêt dans l'image. À partir d'un modèle de

l'environnement et d'une observation, on cherche à détecter ce

qui a changé. Pour notre application, les régions

d'intérêt sont les régions de l'image où il y a une

forte probabilité qu'il y ait une personne.

L'algorithme utilisé pour la soustraction de

l'arrière-plan par modélisation statistique comporte trois

étapes importantes : l'initialisation, l'extraction du mouvement

(avant-plan) et la mise à jour du modèle.

D'après les résultats présentés

lors de l'étude comparative dans l'état de l'art, il

apparaît clairement que le meilleur compromis entre la qualité de

la détection, le temps de calcul et la mémoire utilisée

sont obtenus avec des méthodes de soustraction de

27

l'arrière-plan simple. Nous avons choisi de

modéliser chaque pixel de l'arrière-plan par une densité

de probabilité Gaussienne.

3.1.1. Initialisation

La première étape consiste à

modéliser l'arrière-plan à partir des N

premières images (N 30) d'une

séquence vidéo. Une moyenne d'intensité est donc

calculée à partir de ces images pour chaque pixel et pour chacun

des canaux (R, G, B). La moyenne d'intensité d'un pixel donné se

résume alors à l'équation suivante :

~

Itc(X, Y) = ~ ~ ? ~~,~(~, ~)

~~~ (5)

Où Ii est la

ième image d'initialisation,

N la quantité d'images utilisées et

c le canal sélectionné.

L'étape suivante consiste à calculer un

écart-type o pour chaque pixel (et pour chaque

canal) afin d'être utilisé comme seuil de détection. Cette

opération nécessite habituellement le stockage des N

premières images. Or, une équation modifiée

permet de contourner cette contrainte de façon incrémentale et

ainsi réduire la consommation d'espace mémoire. Pour ce faire,

deux accumulateurs sont utilisés, soient S(x, y)

pour stocker la somme des intensités des pixels et

SC(x, y) pour emmagasiner la somme des carrés.

Les écarts-types peuvent alors être calculés à

l'aide de l'équation suivante.

~

o(x, ,,) = I (SCc(x,Y)

~ ~ - ~sc(x,Y)

~ ~ (6)

Par ailleurs, il est intéressant de remarquer que

S(x, y) peut être réutilisée pour

le calcul de la moyenne, ce qui évite des opérations

supplémentaires et superflues.

3.1.2. Extraction de l'avant-plan

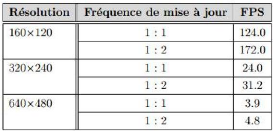

Afin d'extraire le mouvement dans une image, le modèle

de l'arrière-plan doit tout d'abord lui être soustrait. Chaque

pixel, dont la différence en valeur absolue dépasse la valeur

á × o, est ensuite classifié comme

étant un pixel en mouvement. Dans l'expression précédente,

la variable á représente une certaine

fraction de l'écart-type o. En pratique, ce

paramètre se situe dans l'intervalle [2.0, 4.0] et dépend du

niveau d'exclusion désiré. Un masque binaire de mouvement peut

alors être généré pour chaque canal à l'aide

de l'équation ci-après :

28

mc(x,Y) = f1 si IIc(x,Y) -

uc(x,Y)I > a. oc(x, Y) (7)

0 autrement

Où mc(x, y) représente

le masque de mouvement pour un canal c et

Ic(x, y) l'image d'entrée à

analyser.

L'équation mc(x, y)

représente le calcul du masque de mouvement pour un seul

canal. Pour utiliser cet algorithme avec les 3 canaux (RGB) des images

utilisées, les masques individuels doivent tout d'abord être

générés indépendamment et combinés par la

suite à l'aide d'un opérateur OU logique. Par conséquent,

si un mouvement est détecté pour un pixel dans un seul canal,

cela sera suffisant pour en modifier l'état. L'équation suivante

représente cette combinaison produisant ainsi un masque de mouvement

à un seul canal :

M(x,Y) = mr(x,Y) u mg(x,Y) u mb(x,Y)

(8)

Une fois cette opération complétée,

certaines opérations de morphologie mathématique

(Gonzalez et Richard, 2002)

doivent être appliquées afin d'éliminer le bruit et les

fausses détections. Pour ce faire, 2 érosions et 2 dilatations

sont appliquées respectivement dans cet ordre sur le masque de

mouvement. Finalement, l'image d'entrée est combinée avec le

masque pour produire une image à 3 canaux (avant-plan) contenant

seulement les pixels représentant du mouvement. Cette opération

peut se résumer à l'équation suivante :

F(x, Y) = M(x, Y). I(x, Y)

(9)

Où F(x, y) représente

l'image d'avant-plan (mouvement ou foreground) et I(x, y)

l'image d'entrée. Les deux images sont combinées

grâce à une multiplication pixel à pixel pour chacun des

canaux.

3.1.3. Mise à jour du modèle

Au cours de la période d'acquisition, certaines

régions de la scène peuvent subir des modifications

d'éclairage, ce qui rend la mise à jour du modèle

statistique de l'arrière-plan primordiale. Ainsi, un changement graduel

de luminosité (p. ex. : lever du soleil) sera donc intègre au

modèle et ne sera pas considère comme du mouvement. Pour ce

faire, l'extraction de l'avant-plan est réalisée avec l'image

courante, ce qui génère un masque de mouvement

M.

29

Le modèle de l'arrière-plan est ensuite mis

à jour à partir du complément de

M, c'est-à-dire en utilisant tous les pixels

qui sont étiquetés comme faisant partie de l'arrière-

plan. Les changements brusques dans l'image ne sont donc pas ajoutés au

modèle.

L'équation ci-après illustre ce processus de mise

à jour :

I2' (X, y) = (1 - 77). I.Lc(X, y) + 77. I(x,

y).M~ (x,y) (10)

Où u'(x, y) représente

un pixel de l'arrière-plan moyen mis à jour et ç

le taux d'apprentissage. L'expression Ic(x,

y).M~ (x, y) représente les pixels statiques de

l'image courante, c'est-à-dire ceux pour lesquels aucun changement n'est

associé.

Afin de ne pas modifier radicalement le modèle

d'arrière-plan, seulement une fraction i de

l'image temporaire Ic(x, y).M~ (x, y) est

utilisée. En pratique, ce taux d'apprentissage peut prendre des valeurs

comprises dans l'intervalle [0.05, 0.25]. Plus la valeur de ce paramètre

est élevée, plus les changements s'intègreront rapidement.

Cela revient alors à oublier rapidement le modèle construit lors

de la phase d'initialisation. Il est conseillé d'utiliser des valeurs

relativement faibles (p. ex. : 0.05).

Finalement, l'écart-type n'est pas ajusté ou mis

à jour pendant l'exécution de l'algorithme (c.-à-d.. : une

fois l'initialisation effectuée) afin de réduire la somme de

calculs nécessaire. Certaines expérimentations

supplémentaires devraient cependant être réalisées

pour vérifier l'utilité et l'impact de cette mise à jour

sur les résultats.

3.2. Détection par différence

d'images

La détection du mouvement contient les méthodes

de différences d'images (approche directe), de corrélation ou de

recherche dans l'espace des paramètres. Les méthodes basses

niveaux exploitent la comparaison pixel à pixel, ou petite région

à petite région entre deux images consécutives d'une

séquence. Elles permettent de déterminer les régions de

variations de l'image dans le temps. Elles nécessitent soit une

caméra fixe, soit un recalage préalable dans le cas d'un

observateur mobile, afin de détecter uniquement les zones de mouvement

dans la scène. Elles sont généralement limitées aux

mouvements d'objets rigides et au cas de petits déplacements.

3.2.1. Avec image de référence

Dans certaines applications (acquisition avec caméra

fixe en particulier), il peut être possible de disposer d'une image dans

laquelle seuls les éléments stationnaires sont

30

présents. Cette image est alors utilisée comme une

image de référence R(x, y) notée

R. Cette image doit posséder les

caractéristiques suivantes :

- Être exempte de tout objet mobile ;

- Avoir été acquise sous les mêmes conditions

d'éclairement que les images avec lesquelles elle sera

comparée.

L'image de différence notée D

devient alors :

D = II - RI (11)

Où I représente

l'image à l'instant t et R

est l'image de référence. Les régions en

mouvement sont obtenues après seuillage de l'image de différence

(nécessaire à cause du bruit). Cette image de différence

fait apparaître 2 types de régions :

Source : (MEDJAHED, 2012)

Figure 9: Technique de différence avec image de

référence, (a) l'image à l'instant t, (b) l'image de

référence, (c) l'image de différence.

- La première zone est constituée des points

appartenant aux objets mobiles dans leur position courante ;

- La seconde zone est constituée des points

stationnaires présents dans les deux images I(x, y, t)

et R(x, y).

Cette méthode est très utilisée dans le

domaine de détection d'objet en mouvement mais la plus grande

difficulté consiste à obtenir l'image de la

référence (du fond). Dans certains cas, cette image peut

être obtenue en sélectionnant manuellement une image ou aucun

objet n'apparait, mais ce n'est pas toujours le cas. La construction d'une

image de

31

référence est donc une question délicate

abordée dans la littérature par de nombreux auteurs tels qu'avec

(Evelet et Bolles,1998), et

(Long et Yang,1990).L'image de

référence doit en permanence être identique à

l'environnement statique perçu dans chaque image de la séquence.

(Jain, 1984), propose un algorithme qui repose sur l'analyse

de différence d'image. (Makarov,1996) construit l'image

de référence en se fondant sur l'analyse de la moyenne du niveau

de gris d'un pixel donné sur une séquence de N

images. À chaque acquisition d'une nouvelle image

I de la séquence, une nouvelle image de

référence R est construite. Le niveau

de gris de chaque pixel de l'image de référence est

déterminé par la relation suivante :

t1

R(x, y, t) = N 1 ? ~(~, ~, t)

~~t_~ (12)

Où N : le nombre d'images

dans la séquence. Cette méthode nécessite une

mémorisation de N images successives de la

séquence, mais cette opération est assez coûteuse. Une

autre difficulté vient de changements de luminosité ; même

si l'hypothèse du faible changement entre deux images successives est

respectée, le changement à long terme peut être important

sur une séquence très longue.

3.2.2. Sans l'image de référence

La différence temporelle s'exprime par :

FD (Ic ,Ip) = |Ic - I,,| (13)

Où : FD : image de

différence, IC image courante, et

IP image précédente.

L'image FD (IC, IP) ainsi obtenue

est nulle en tout point où le signal d'entrée I

est constant. Les points où un changement temporel s'est

produit sont détectés par simple seuillage de

FD. Le seuillage est nécessaire à cause

du bruit présent dans les 2 images. Le résultat du seuillage est

une image binaire indiquant les zones en mouvement.

32

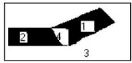

Source : (MEDJAHED, 2012)

Figure 10: Technique de différence sans image de

référence, (a) image précédente, (b) image

courante, (c) image de différence.

- La zone `1' située à l'avant

de l'objet dans le sens du déplacement est constituée de points

qui appartenaient au fond de l'image précédente et qui sont

recouverts par l'objet dans l'image courante. L'amplitude de différences

de niveaux de gris y est fonction du contraste entre l'objet et le fond.

- La zone `2' située à

l'arrière de l'objet est constituée de points qui appartenaient

à l'objet dans l'image précédente et qui ont

été découverts suite au mouvement. Ils appartiennent au

fond de l'image courante. L'amplitude de différences de niveaux de gris

y est fonction du contraste entre l'objet et le fond.

- La zone `3' constituée de points

appartenant au fond et aux objets stationnaires dans les deux images.

L'amplitude des différences de niveaux de gris y est faible.

- La zone '4' qui n'existe que lorsqu'il y a

chevauchement des positions de l'objet et qui est constituée de points

appartenant à l'objet en mouvement dans les deux images. L'amplitude de

différences de niveaux de gris y est faible.

Ainsi, les régions `1' et `4'

retracent l'objet dans l'image à l'instant t,

et les régions `2' et `4' à

l'instant t- dt, les régions `1'

et `2' sont détectées comme des

régions en mouvement, par contre, la région `4'

l'est rarement et le problème est d'extraire cette

région.

33

Conclusion

Dans ce chapitre, nous avons justifié le choix de deux

méthodes de détection de mouvement d'objet ou de personne dans

une séquence vidéo. Il d'agit de la méthode par

soustraction de l'arrière-plan et la méthode différence

d'image consécutive. Nous avons aussi présenté les

techniques d'implémentation de ces dernières. Dans le chapitre

suivant nous présentons le matériel nécessaire à

l'implémentation des modèles de détection de mouvement

retenus.

34

Chapitre 4 : Le matériel utilisé

Pour la réalisation de nos travaux, nous avons

utilisé plusieurs méthodes et techniques dont l'objet de ce

chapitre est de décrire les différentes applications et

bibliothèques utilisées. Une description sur les étapes

utilisées de la mise en place de la plateforme de lecture,

d'écriture et de manipulations de données séquences

images. L'avantage de ces outils est qu'ils sont tous libres de licence GNU.

4.1. Les outils nécessaires pour la vision

artificielle

Nous avons utilisé plusieurs outils et techniques pour

préparer notre plate-forme IDE Code::Block, afin de pouvoir faire les

manipulations sur des séquences d'images.

4.1.1. MinGW ou Mingw32 (Minimalist GNU for Windows)4

Elle est une adaptation des logiciels de développement

et de compilation du GNU (GCC - GNU Compiler Collection), à la

plate-forme Win32. Contrairement à d'autres applications, les programmes

générés avec MinGW n'ont pas besoin de couche

intermédiaire de compatibilité (sous forme d'une

bibliothèque dynamique, DLL (Dynamic Link Library)). L'appellation

Mingw32 a été abandonnée depuis que MinGW supporte les

environnements d'exécution 64 bits en plus de 32 bits.

D'autre part, sa licence libre n'exige pas que les

applications développées avec MinGW soient publiées sous

licence GNU GPL5.

4.1.2. CMakesFiles6

Il sert principalement à faciliter la compilation et

l'édition de liens puisque dans ce processus le résultat final

dépend d'opérations précédentes. Le système

de langage utilisé dans le cmakefiles est de la programmation

déclarative. À l'inverse de la programmation impérative,

cela signifie que l'ordre dans lequel les instructions doivent être

exécutées n'a pas d'importance.

4 Source :

http://sourceforge.net/projects/mingw/files/

5Source :

http://www.linux-france.org/article/these/gpl.html

6Source :

http://www.cmake.org/cmake/resources/software.html

35

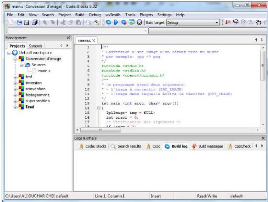

4.1.3. Code::Blocks

C'est notre IDE (Environnement de Développement

Intégré) libre et multiplateforme. Il est écrit en C++

grâce à la bibliothèque wxWidgets. Pour le moment,

Code ::Blocks est orienté C et C++, mais il peut aussi être

supporté par d'autres langages.

La liberté de Code::Blocks implique la

possibilité du contrôle par l'utilisateur de l'ajout de librairie

ou par personnalisation des compilateurs par exemple. De plus, sa

gratuité a permis de créer une communauté de

programmateurs suffisamment conséquente pour que le logiciel soit mis

à jour régulièrement et qu'il soit très simple de

trouver quelques explications complémentaires en cas d'erreurs dans la

compilation. Les principaux avantages de ce logiciel sont la possibilité

de création de projet et la mise en forme automatique (auto

complétion et colorisation du code) qui permet de repérer

rapidement les erreurs.

4.1.4. OpenCv (Open Source Computer Vision)7

OpenCV (Open Computer Vision) est une librairie open source

d'algorithmes de vision assistée par ordinateur, elle est accessible

pour les langages C, C++ et aussi Python. Il s'agit d'une bibliothèque

libre, ce qui présente les avantages précédemment

évoqués, qui se spécialise dans le traitement et l'analyse

d'images ou vidéos en temps réel au moyen d'interfaces.

Grâce à cette bibliothèque, il est

possible de charger, afficher et modifier des images, travailler à

partir d'histogrammes et d'appliquer des transformations de base (seuillage,

segmentation, morphologie...).

OpenCV est composée de 5 librairies différentes

: CV, CVAUX, CXCORE, HIGHGUI et ML. Chacune a sa

spécificité, HIGHGUI par exemple permet la manipulation

des fichiers et l'affichage d'une interface graphique alors que ML

permet la classification des données. On trouve de nombreuses

applications à cette librairie, les ordinateurs à

déverrouillage par reconnaissance faciale par exemple, de même que

le tracking d'objet sur une vidéo. Au moyen d'OpenCV, il est possible de

contrôler une machine par les mouvements oculaires et les clignements

pour des personnes handicapées parmi tant d'autres

possibilités.

7

http://opencv.org/&usg=ALkJrhiMsrQo2SmvZH4Ghd1Cg0bDejVm-Q

36

4.2. Les étapes d'installation des

différentes applications

Pour une bonne vision artificielle, nous allons d'abord

préparer notre propre environ de travail. A cette raison nous allons

suivre quelques étapes ci-après :

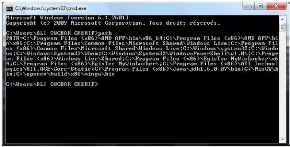

4.2.1. Étape 1: Installation de MinGW

MinGW est un compilateur C/C++, qui doit être

intégré dans notre API. L'installation se fera à la racine

et à l'emplacement par défaut

C:\MinGW. Dans les options

d'installation, nous allons choisir mingw32-base et mingw32-gcc-g

+ +, mais tout en sachant que nous pouvons également installer les

autres composants si besoin sera faites mais nous n'avons besoin que de

compilateur C + + (g+ +).

NB : Une attention particulière

sera portée sur ce passage car l'installation de différents

paquets se fait via un téléchargement, alors il peut ou n'est pas

être correcte, cela posera un grave souci et l'installation n'aura jamais

lieu. Tel est le problème que nous avons rencontré lors de nos

premières manipulations avec les outils de la vision artificielle.

4.2.2. Étape 2: Ajout de chemin d'accès de

MinGW au système Nous allons accéder à :

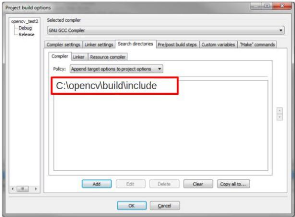

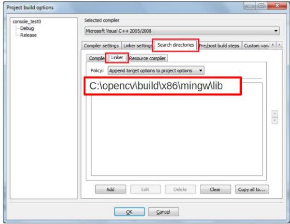

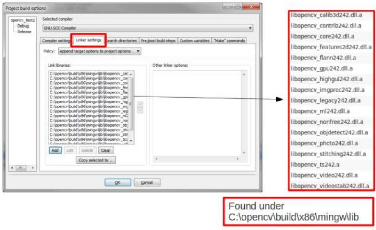

Panneau de configuration -> Système ->

Paramètres système avancés puis comme montre la figure

ci-dessous: Nous allons ajouter le lien C : \MinGW\bin à la

suite des Variables d'Environnement.

37

Figure 11: Variable Environnement

Figure 12: Ajout de chemin

Nous devons mettre évidement un point-virgule après

la dernière entrée dans le "chemin", puis le chemin MinGW

à ajouter (il devrait être

C:\MinGW\bin si nous

avons respecté (effectivement le choix de l'emplacement par

défaut).

Nous allons ouvrir un "chemin" invite de commande et tapons "

mingw" pour s'assurer qu'il a été bien installé

et prêt pour travailler. Les programmes devront être

redémarrés pour que cette modification prenne effet.

38

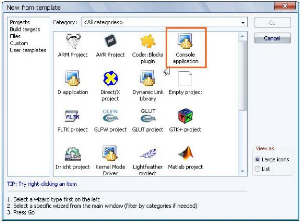

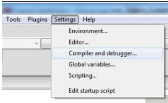

4.2.3. Étape 3: Installation Code :: Blocks (notre

API choisi)

L'installation devra se faire à l'emplacement par

défaut :

C:\ProgramFiles(x86)\CodeBlocks.

Lorsque le programme d'installation terminé, un clic sur Oui est

nécessaire afin d'exécuter Code::Blocks, puis nous irons dans

l'interface de l'IDE pour paramétrer : Paramètres ->

Compiler et Debugger. Selon les exécutables

Toolchain, pour notre cas ci, nous allons sélectionner GNU

compilateur GCC dans le menu déroulant, puis nous appuyons sur

AutoDetect afin de vérifier que si Code::Blocks a trouvé

MinGW comme compilateur par défaut sur la machine.

4.2.4. Étape 4: Installer OpenCV

La bibliothèque OpenCV met à notre disposition

de nombreuses fonctionnalités très diversifiées permettant

de créer des programmes, des données brutes pour aller

jusqu'à la création d'interfaces graphiques basiques.

Il est disponible sur le site officiel en version compression,

la décompression se fera comme suit: Nous allons faire un double clic

sur le fichier téléchargé OpenCV-2.4.2.exe et

choisissez C: \ comme répertoire extrait.

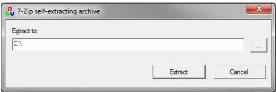

Figure 13 : Décompression OpenCv

OpenCV est maintenant installé mais pas