Ministère de l'Enseignement Supérieur

et

Universitaire

UNIVERSITE PROTESTANTE DE LUBUMBASHI

FACULTE DES SCIENCES INFORMATIQUES

Vérité & Liberté

PROJET TUTORÉ DE FIN D'ETUDES

Sujet : CONCEPTION D'UN SYSTEME INTELLIGENT

D'ANALYSE

DE CV BASE SUR LE TRAITEMENT DU LANGAGE NATUREL

(NLP) POUR UNE

EVALUATION OPTIMISEE DES

CANDIDATURES : APPLICATION AU DEPARTEMENT

DES

RESSOURCES HUMAINES.

Effectué par NKISSA KUDOLYE JOSPIN Promotion :

BAC3

Filière : IAGE

Août 2025

Ministère de l'Enseignement Supérieur

et

Universitaire

UNIVERSITE PROTESTANTE DE LUBUMBASHI

FACULTE DES SCIENCES INFORMATIQUES

Vérité & Liberté

PROJET TUTORÉ DE FIN D'ETUDES

Sujet : CONCEPTION D'UN SYSTEME INTELLIGENT

D'ANALYSE

DE CV BASE SUR LE TRAITEMENT DU LANGAGE NATUREL

(NLP) POUR UNE

EVALUATION OPTIMISEE DES

CANDIDATURES : APPLICATION AU DEPARTEMENT

DES

RESSOURCES HUMAINES.

Promotion : BAC 3 Filière : IAGE

Dirigé par Professeur MWAMBA KASONGO Dahouda

Co-dirigé par Assistant NGOIE NKAYA Philippe

ANNEE ACADEMIQUE

2024-2025

DEDICACE

À ma famille,

Ce mémoire est le fruit de votre soutien inestimable, de

vos encouragements et de votre amour sans limites.

À mes parents, pour vos sacrifices, votre patience et

votre confiance en moi. Sans vous, rien de tout cela n'aurait été

possible.

NKISSA KUDOLYE JOSPIN

REMERCIEMENTS

Avec un coeur profondément reconnaissant et des mots

chargés d'émotion, je tiens à commencer cette page en

rendant gloire à Jéhovah Dieu, le Soutien suprême de ma

vie. À Lui seul reviennent les louanges éternelles pour le

souffle de vie, la santé préservée, la force quotidienne,

et la protection invisible mais constante dont j'ai

bénéficié tout au long de ce parcours. Sans Sa main

puissante, aucun de mes efforts n'aurait porté de fruit.

Je rends un hommage vibrant à mes chers parents,

Kuudolye Celestin et Kikaina Naomie , véritables artisans de mon avenir,

pour leur amour inconditionnel, leur soutien inlassable, et surtout pour avoir

assuré ma scolarité de façon continue, depuis mes premiers

pas à l'école maternelle jusqu'à ce jour. Vous avez

été et restez mes modèles de persévérance et

de foi. Grâce à vous, je me tiens aujourd'hui debout, fier du

chemin parcouru.

Mes pensées les plus affectueuses vont également

à l'ensemble de ma famille élargie, et tout

particulièrement à mes oncles et tantes actuellement

présents ici à Lubumbashi, pour leur soutien moral de haute

qualité, leur proximité affectueuse, et leurs paroles

réconfortantes aux moments les plus décisifs. Je n'oublierai

jamais les cadeaux précieux que vous m'avez offert avec amour et

fierté après chaque réussite. Vos gestes m'ont toujours

rappelé que je n'étais jamais seul.

Je tiens à exprimer ma gratitude la plus profonde

à mon directeur de mémoire, le Professeur MWAMBA KASONGO Dahouda,

pour ses orientations ingénieuses, sa disponibilité constante, et

sa rigueur académique qui ont largement contribué à donner

de la profondeur et de la qualité à ce travail. Son encadrement

bienveillant a été un véritable phare tout au long de

cette aventure intellectuelle.

Mes sincères remerciements vont également

à mon co-directeur, l'Assistant NGOIE NKAYA Philippe, pour ses conseils

avisés, son écoute attentive, et ses encouragements stimulants.

Son accompagnement méthodique m'a permis de progresser avec assurance et

efficacité.

Je ne saurais oublier mes connaissances, mes amis, et toutes

les personnes merveilleuses qui ont, d'une manière ou d'une autre,

laissé une empreinte positive dans cette aventure. Une mention

spéciale et honorifique à Maître ASIM, un ami exceptionnel

et une source inépuisable d'inspiration depuis l'école SHALOM

jusqu'à UPL avec la devise sanguine « rendre les parentes

fières car nous n'avons aucune seconde d'erreur la science ! la science

! »

À tous ceux et celles qui, par un geste, un mot, un

sourire ou une prière, ont contribué à cette

réussite, je vous dis un immense MERCI. Que

Jéhovah Dieu vous comble de ses bénédictions les

plus riches.

Table des matières

REMERCIEMENTS ii

LISTE DE FIGURES v

LISTE DES TABLEAU vii

INTRODUCTION 1

CHAPITRE 1 : Revue de la littérature 4

I.1 Revue des systèmes 4

CHAPITRE 2 : MÉTHODOLOGIE 11

2.1 Introduction 11

2.2 Présentation des méthodologies de

développement logiciel (SDLC) 11

2.3 Outils et technologies utilisés

15

2.4 Architecture du système 17

2.5 Méthode d'implémentation du NLP

17

2.6 Exigences fonctionnelles et non fonctionnelles

19

2.7 Limites méthodologiques 19

2.8 Conclusion 19

Chapitre 3 Conception du système 20

3.1 Introduction 20

3.2 Modélisation du processus métier

21

3.3 Identification des acteurs 22

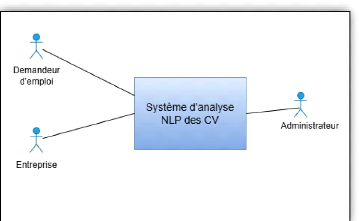

3.4 Diagramme de contexte métier 23

3.5 Diagramme de processus métier BPMN (Business

Process Model and Notation) 24

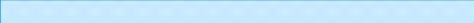

3.6 Diagramme de cas d'utilisation métier

26

3.7 MODELE DU DOMAIN 27

3.7 Analyse du système informatique 28

3.8. Analyse des besoins de conception 32

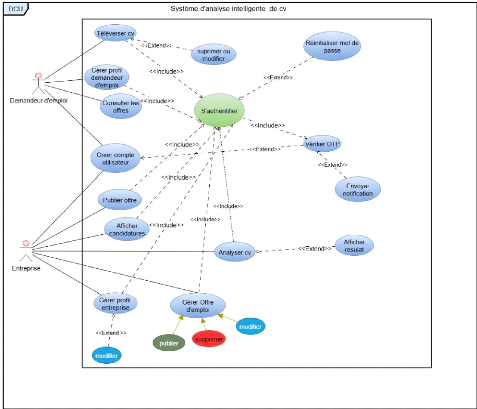

3.9 Diagramme de séquence 37

3.12. CONCEPTION DU MODÈLE LOGIQUE DE

DONNÉES 60

3.13. DIAGRAMME DE DÉPLOIEMENT 61

Conclusion partielle 64

CHAPITRE 4 IMPLEMENTATION DE LA SOLUTION PROPOSEE

65

4.1. Introduction 65

4.1. Technologies 65

4.2 Rappels théoriques essentiels 68

4.2.1. Introduction au Machine Learning 68

1.2.2 Apprentissage supervisé 68

2.2.3 Apprentissage non supervisé 69

2.3.4 Apprentissage par renforcement 69

iv

2.3.5 Notions de Deep Learning 69

4.3 Récolte de données 74

4.4 Conception et Entraînement du Modèle de

Classification pour l'Analyse CV-Offres 75

4.5. Conclusion 80

CHAPITRE 5. RESULTATS ET EVALUATIONS 81

5.1 Résultats 81

Conclusion Générale 87

Bibliographie 88

LISTE DE FIGURES

Figure 1 Diagramme de contexte métier 24

Figure 2 Diagramme de processus métier BPMN 25

Figure 3 Diagramme de cas d'utilisation métier 26

Figure 4 Diagramme de classes système 28

Figure 5 Présentation du système 33

Figure 6 Diagramme de cas d'utilisation 35

Figure 7 Diagramme de séquence CU1 créer compte

38

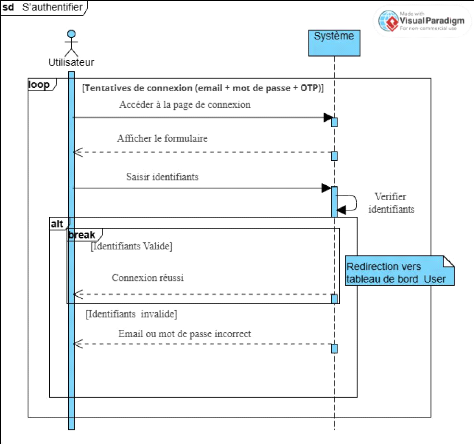

Figure 8 Diagramme de séquence CU2 S'authentifier

39

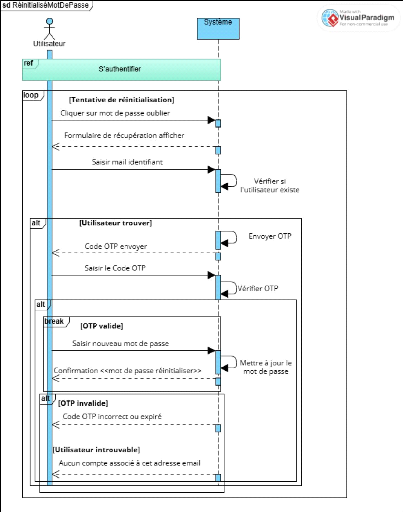

Figure 9 Diagramme de séquence CU 3

Réinitialisation de mot de passe 40

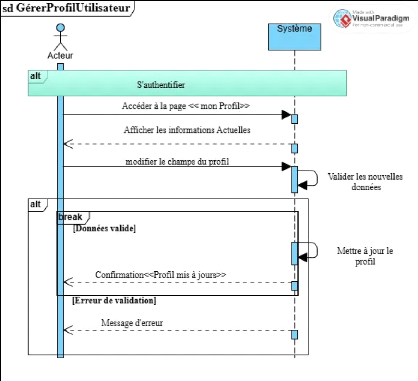

Figure 10 Diagramme de séquence CU 4 Gérer

profil 41

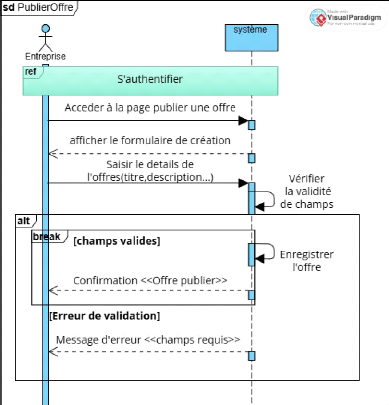

Figure 11 Diagramme de séquence CU 5 Publier offre

42

Figure 12 Diagramme de séquence CU 6 Gérer

l'offre 43

Figure 13 Diagramme de séquence CU 7 Consulter les

offres 44

Figure 14 Diagramme de séquence CU 8

Téléverser un cv 45

Figure 15 Diagramme de séquence CU 9 supprimer ou

modifier un cv 46

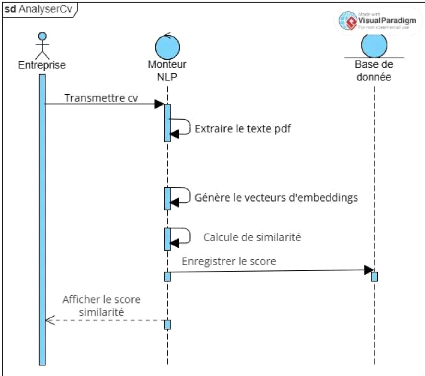

Figure 16 Diagramme de séquence CU 10 Analyser un cv

47

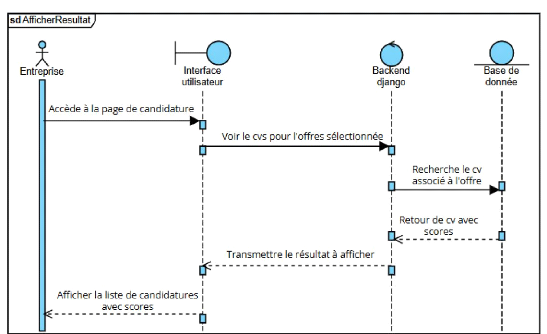

Figure 17 Diagramme de séquence CU 12 Afficher

résultat 48

Figure 18 Diagramme de séquence CU 11 AfficherResultat

48

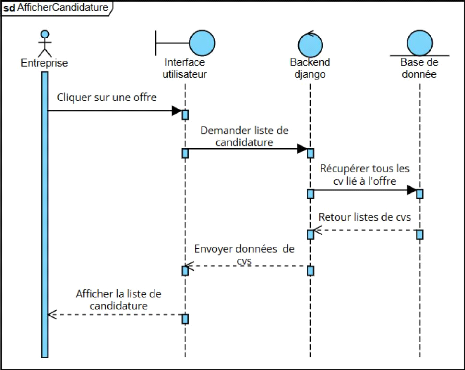

Figure 19 Diagramme de séquence CU 12 afficher

candidatures 49

Figure 20 Diagramme système 51

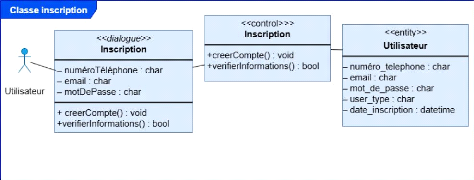

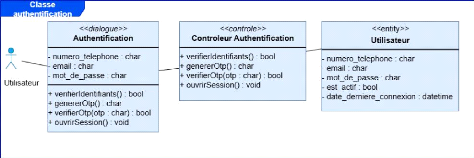

Figure 21 Diagramme de classe participante CU 2

Authentification 52

Figure 22 Diagramme de classe participante CU 2

Authentification 52

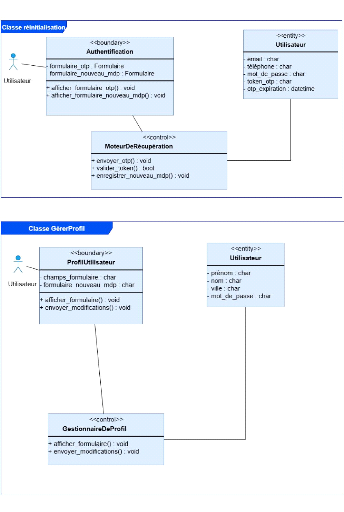

Figure 23 Diagramme de classe participante CU 3

Réinitialisation 53

Figure 24 Diagramme de classe participante CU 4 Gérer

profil 53

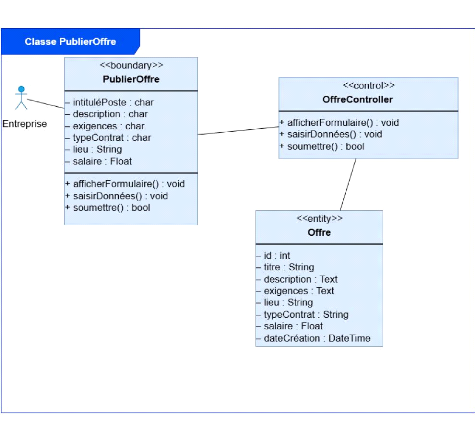

Figure 25 Diagramme de classe participante CU 5 publier offre

54

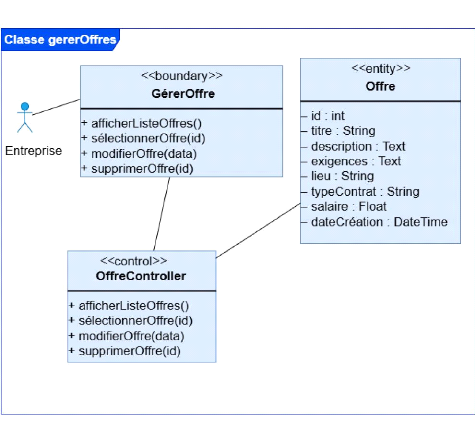

Figure 26 Diagramme de classe participante CU 6 Gérer

offre 55

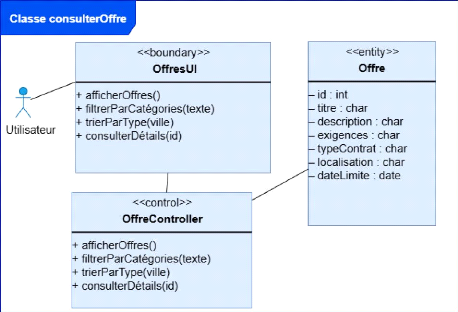

Figure 27 Diagramme de classe participante CU 7 Consulter

l'offre 56

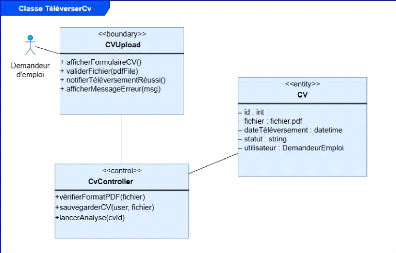

Figure 28 Diagramme de classe participante CU 8

Téléverser cv 56

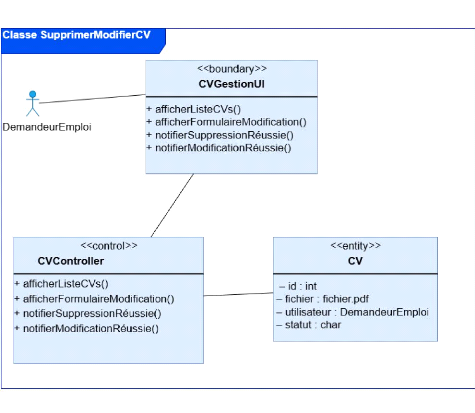

Figure 29 Diagramme de classe participante CU 9 Supprimer

modifier cv 57

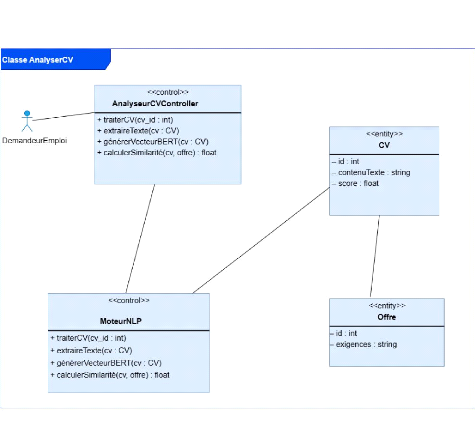

Figure 30 Diagramme de classe participante CU 10 Analyser cv

58

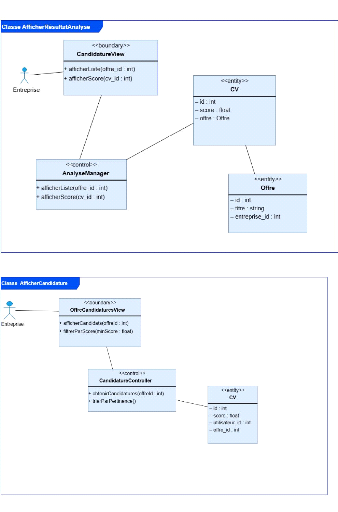

Figure 31 Diagramme de classe participante CU 11 Afficher

résultat 59

Figure 32 Diagramme de classe participante CU 12 Afficher

candidature 59

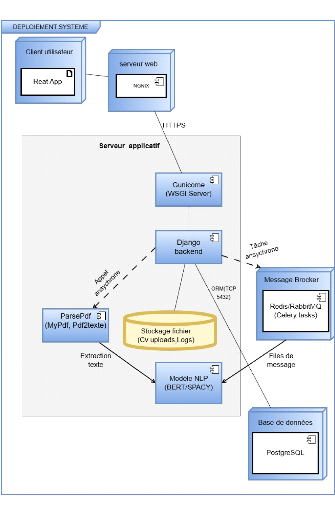

Figure 34 Diagramme de déploiement 63

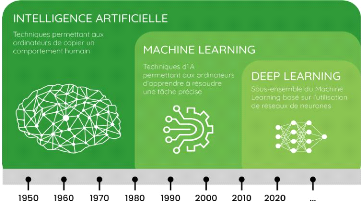

Figure 35 Machine learning, deep learning description 70

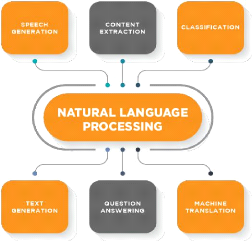

Figure 36 Quelques Domaines du nlp 73

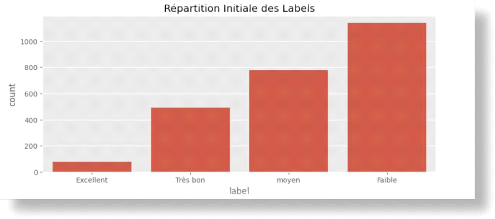

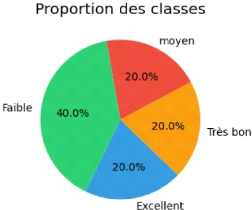

Figure 37 Déséquilibre initiale de classe 76

Figure 38 Equilibres de classes 77

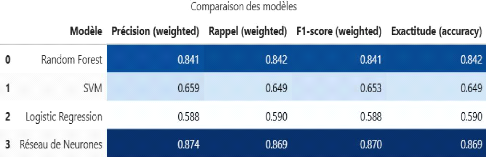

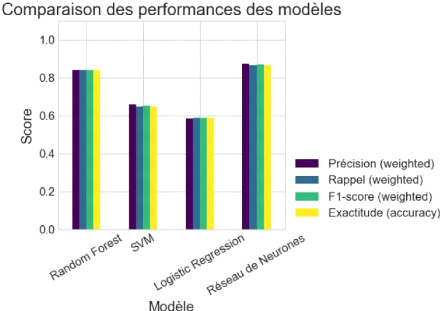

Figure 39 Comparaison de la performance des modèles

78

Figure 40 Tableau comparatif des modèles 78

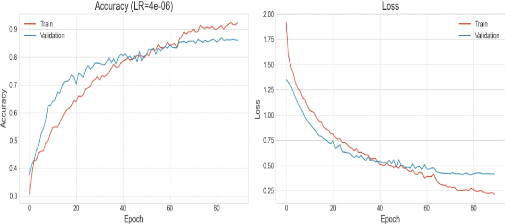

Figure 41 visualisation de la courbe de précision et

perte 79

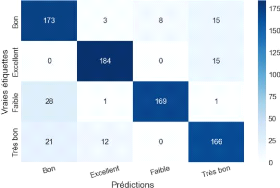

Figure 42 Matrice de confusion du modèle validé

79

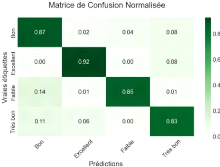

Figure 43 Matrice de confusion normalisé 79

vi

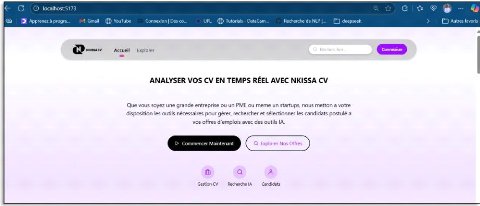

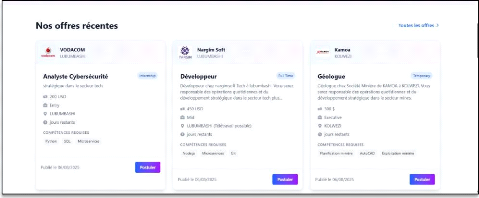

Figure 44 interface d'accueille 81

Figure 45 interface des offres 81

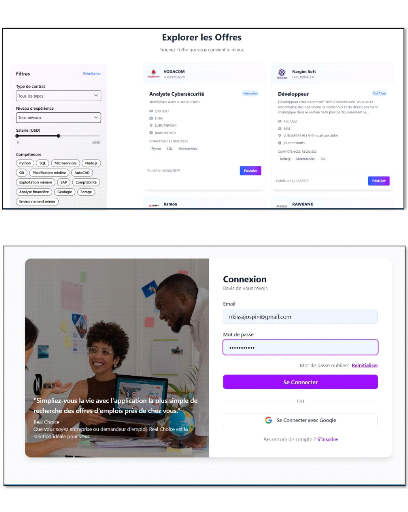

Figure 46 interface des offres avec option de filtre 82

Figure 47 interface de login pour s'authentifier 82

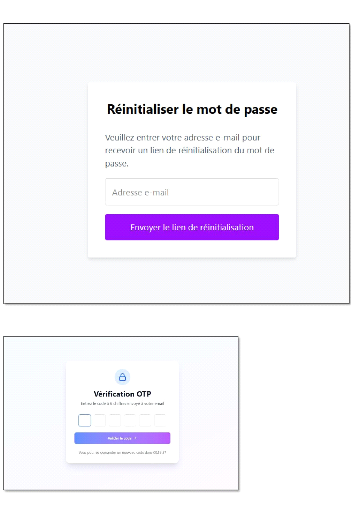

Figure 48 interface pour réinitialiser le mot de passe

83

Figure 49 interface pour la vérification de OTP envoyer

par mail 83

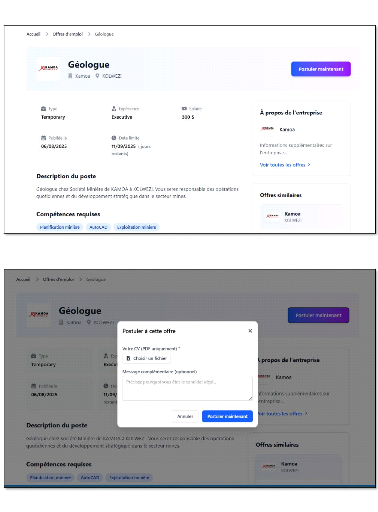

Figure 50 interface pour sur la vue du détaille de

l'offre 84

Figure 51Interface pour uploader le cv 84

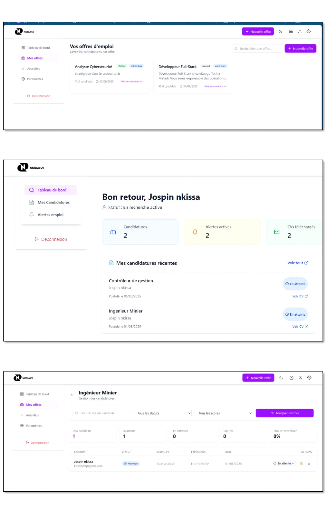

Figure 52 Dashboard Entreprise 85

Figure 53 Dashboard chercheur d'emploie 85

Figure 54 Dashboard entreprise avant l'analyse 85

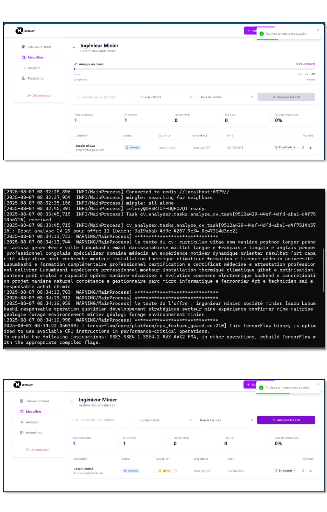

Figure 55Dashboard entreprise l'analyse encours 86

Figure 56 opération Asynchrone avec serveur celery

86

Figure 57 Résultat d'analyse 86

LISTE DES TABLEAU

Tableau 1 Outils et technologies utilisés 15

Tableau 2 Rôles des acteurs 23

Tableau 3 Identification des acteurs du système

d'Analyse de cv basé sur le NLP 33

Tableau 4 Planification des itérations 35

Tableau 5 Contenu du dataset 74

Tableau 6 Algorithmes implémentés 77

INTRODUCTION

Contexte du sujet

Le processus de recrutement constitue un pilier fondamental de

la gestion des ressources humaines, car il détermine la qualité

du capital humain au sein d'une organisation. Avec la numérisation

croissante des candidatures, les entreprises doivent aujourd'hui traiter un

volume massif de CV, ce qui rend les méthodes traditionnelles de

sélection de plus en plus inefficaces.

Cette surcharge d'informations entraîne non seulement

une perte de temps considérable, mais aussi une augmentation du risque

d'erreur humaine ou de biais dans l'évaluation des profils. Si un

recruteur passe une minute au moins pour évaluer un CV. Imaginons que

suite d'une annonce , l'entreprise reçoit 2000 CV, cela voudrait dire

que le recruteur passerait environ 33 heures pour la

sélection de ces CV, ce qui équivaut 4 jours de travail de 8

heures.

Parallèlement, les avancées dans le domaine de

l'intelligence artificielle (IA), et plus particulièrement du

traitement automatique du langage naturel (Natural Language Processing,

NLP), ont ouvert de nouvelles perspectives pour automatiser et

améliorer les processus décisionnels. Le NLP permet aux machines

de comprendre, d'analyser et de générer du langage humain, ce qui

en fait une technologie de choix pour l'analyse de documents non

structurés tels que les CV.

Dans ce contexte, plusieurs solutions intelligentes ont

été proposées dans le monde pour automatiser la

présélection des candidatures. Des systèmes basés

sur la détection de mots-clés, des moteurs de correspondance

sémantique, et plus récemment des modèles d'apprentissage

profond tels que BERT ou GPT ont été mis en oeuvre avec des

résultats encourageants.

À Lubumbashi, le recrutement pour plusieurs structures

reste encore largement manuel, malgré la disponibilité croissante

de CV numériques. Les départements des ressources humaines

manquent souvent d'outils adaptés pour automatiser ce processus, ce qui

ralentit considérablement la sélection des bons profils. Il

existe donc un besoin réel et urgent d'outils intelligents.

Ce mémoire s'inscrit dans cette dynamique. Il vise

à concevoir un système intelligent capable d'analyser

automatiquement des CV numériques rédigés en

français, à l'aide de techniques avancées de traitement du

langage naturel. Ce système pourra ainsi contribuer à rendre le

processus de présélection plus rapide, plus objectif et plus

efficace au sein des entreprises de Lubumbashi.

Objectifs de l'étude

L'objectif principal de cette étude est de

concevoir un système intelligent d'analyse de CV basé sur

le traitement du langage naturel (NLP) permettant d'automatiser

l'évaluation initiale des candidatures au sein d'un département

des ressources humaines.

Les objectifs spécifiques sont :

· D'extraire automatiquement les informations

pertinentes contenues dans les CV (diplômes, expériences,

compétences, etc.).

· De mesurer la correspondance entre les profils et les

offres d'emploi selon des critères définis.

2

· De proposer un classement des candidats en fonction de

leur adéquation avec le poste à pourvoir.

· D'adapter le système au contexte local

congolais, notamment au format des CV rédigés en

français.

Dans un environnement économique de plus en plus

compétitif, les entreprises doivent recruter rapidement les meilleurs

profils. Cependant, les départements RH sont souvent confrontés

à la difficulté de traiter manuellement un grand volume de

candidatures, Ce traitement manuel est non seulement long, mais il peut

également être subjectif et peu reproductible.

Plusieurs outils existent pour aider à cette

tâche, mais ils sont souvent conçus pour des environnements

anglophones, ne tiennent pas compte de la structure des CV francophones, et

nécessitent des ressources techniques importantes. À Lubumbashi,

les petites et moyennes entreprises disposent rarement d'outils intelligents ou

de personnel formé à ce type de technologie.

Dès lors, une question centrale se pose :

comment concevoir un système intelligent, basé sur le

NLP, capable d'analyser automatiquement des CV en français et

d'optimiser le processus de présélection des candidatures

?

Hypothèse

Nous posons l'hypothèse suivante :

L'utilisation d'un système intelligent

basé sur le traitement automatique du langage naturel permet

d'automatiser et d'accélérer le processus de

présélection des CV, tout en améliorant la pertinence des

candidats retenus pour un poste donné.

Importance ou justification de l'étude Ce

travail est justifié par plusieurs besoins :

v Sur le plan pratique, il répond

à une demande réelle d'amélioration des outils RH dans un

contexte local où les ressources sont limitées.

v Sur le plan scientifique, il s'inscrit

dans la dynamique actuelle de recherche autour du NLP appliqué à

des problématiques RH.

v Sur le plan technologique, il explore la

mise en oeuvre de modèles d'IA modernes dans un environnement

francophone et africain, souvent peu représenté dans les bases de

données utilisées pour l'apprentissage automatique.

Portée et limites

La portée de cette étude se limite aux points

suivants :

· Le système ne traitera que des CV

numériques (PDF).

· Seuls les CV rédigés en langue

française seront analysés.

3

· Le système s'arrête à la

phase de présélection : il ne réalise pas

d'évaluation comportementale ni d'entretien.

Les limites incluent :

· L'efficacité du système dépendra de

la qualité des CV (orthographe, structure,

lisibilité).

· Le manque de données locales

annotées pour l'entraînement de modèles peut

limiter la performance initiale.

Structure du travail

Ce mémoire est organisé en cinq chapitres

principaux :

v Chapitre 1 : Revue de la

littérature

Analyse des travaux existants en lien avec l'analyse automatique

de CV, le NLP appliqué aux RH, et les systèmes intelligents

d'évaluation des candidatures.

v Chapitre 2 : Méthodologie

Présentation du modèle de développement

logiciel (SDLC), des techniques NLP adoptées, et des outils mis en

oeuvre.

v Chapitre 3 : Conception du système

Analyse du système informatique (Modélisation des

exigences fonctionnelles et non fonctionnelles ...)

Conception du système informatique (description de

l'architecture, et conception UML ...)

v Chapitre 4 : Implémentation

Description technique de la réalisation du

système, des choix technologiques et des modules

implémentés.

v Chapitre 5 : Résultats et

évaluation

Présentation du système développé,

des tests effectués (fonctionnalité, performance,

utilisabilité ...) et interprétation des résultats

obtenus.

4

CHAPITRE 1 : Revue de la littérature

De nos jours, avec le grand nombre de candidatures que les

entreprises reçoivent, il devient de plus en plus important de trouver

des moyens efficaces pour analyser les CV. C'est dans ce contexte que les

systèmes intelligents, combinant intelligence artificielle, traitement

du langage naturel (NLP) et ressources humaines, prennent tout leur sens. Ce

chapitre propose un regard critique sur les recherches qui ont

déjà été menées dans ce domaine.

Nous allons voir quelles méthodes ont été

utilisées, quels étaient les objectifs, ce qui a

été obtenu et quelles limites ont été

rencontrées. Cela nous permettra d'identifier ce qui manque encore, et

de mieux comprendre pourquoi le projet que nous présentons ici est

pertinent et utile

I.1 Revue des systèmes

Revue (1)

I.1.1 L'intelligence artificielle au coeur du processus de

recrutement E Recrutement 4.0 au Maroc : Etat des lieux et perspectives

[1].

1. Identification des lacunes en matière de

recherche ou de mise en oeuvre

Manque d'application à 100% :

L'e-recrutement 4.0 n'est pas encore pleinement appliqué au Maroc, ce

qui souligne un écart entre les possibilités technologiques et

leur adoption réelle.

Résistance des candidats :

Une grande partie des candidats refuse

d'être évaluée par un robot, en raison :

o du manque de formation numérique,

o de la peur de l'automatisation,

2. Synthèse

L'article synthétise plusieurs travaux

antérieurs en montrant que l'intelligence artificielle apporte :

des gains en efficacité (temps de traitement des CV

réduit de 18h à quelques minutes),

une réduction des erreurs humaines,

une capacité d'analyse de grands volumes de

données (Allal-Chérif et al., 2021).

Mais il regroupe aussi les critiques fréquentes :

manque de transparence des décisions algorithmiques,

risques d'erreurs injustes,

Des études de cas (ex. Amazon) et des

témoignages d'experts (Morgane Fantino, 2021).

3. Analyse critique

Points forts : L'étude met en

lumière les avantages tangibles de l'IA dans le

recrutement, comme l'efficacité et la rapidité,

tout en soulignant les défis techniques et culturels.

5

Limites : Les auteurs notent que les travaux

existants se concentrent souvent sur les perspectives des recruteurs,

négligeant parfois la perception des candidats, notamment dans des

contextes spécifiques comme le Maroc.

Contributions : L'article comble

partiellement cette lacune en analysant la perception des candidats

marocains

4. Contextualisation

La revue de la littérature montre que l'e-recrutement

basé sur l'intelligence artificielle améliore la rapidité

et l'efficacité du tri des candidatures. Cependant, ces solutions sont

souvent développées pour des contextes internationaux,

principalement anglophones, et ne s'adaptent pas bien aux

réalités locales.

À Lubumbashi, les CV sont souvent non

structurés, rédigés en français, et les entreprises

disposent de peu de ressources techniques.

Le présent mémoire vise donc à combler ce

vide en développant une solution NLP adaptée au contexte local,

capable d'analyser automatiquement les CV francophones dans un environnement

à faible technicité.

Revue (2)

I.1.2 Diplôme : Master en gestion des ressources

humaines, à finalité spécialisée en "politique et

management RH" [2].

1. Identification des lacunes en matière de

recherche ou de mise en oeuvre

En parcourant les travaux existants, notamment celui de

Martins et Mariana (2022),plusieurs limites apparaissent dans les approches

actuelles d'automatisation du recrutement par le traitement du langage naturel.

Ces recherches, bien qu'intéressantes, restent souvent

éloignées des réalités du terrain dans des

contextes comme celui de Lubumbashi.

Premièrement, la majorité des

études s'appuient sur des données provenant de grandes

entreprises internationales, avec peu de prise en compte des

spécificités locales. Or, dans des villes comme Lubumbashi, les

candidatures présentent une grande diversité de formats parfois

non structurés, manuscrits ou scannés et les entreprises

disposent rarement des moyens techniques nécessaires pour

intégrer des solutions complexes.

Deuxièmement, bien que des

modèles avancés de NLP tels que BERT soient

évoqués, leur application concrète dans l'analyse de CV,

notamment en langue française, reste encore limitée. Leur

potentiel est loin d'être pleinement exploité, surtout dans des

contextes à faible ressource.

Par ailleurs, les systèmes proposés sont

généralement peu personnalisés. Ils utilisent des scores

standards de similarité(TF-IDF), sans véritablement tenir compte

des attentes spécifiques du recruteur ou des exigences du poste à

pourvoir.

6

Ces constats soulignent la nécessité de

concevoir une solution innovante, à la fois intelligente, éthique

et réellement adaptée au contexte local.

Synthèse

L'article explore l'utilisation des outils de traitement

automatique du langage naturel (NLP) dans le domaine des ressources humaines,

notamment pour l'analyse de CV et l'appariement aux offres d'emploi. Il passe

en revue plusieurs systèmes, outils, et méthodes existantes,

comme le TF-IDF ou encore les moteurs de recommandation classiques.

Analyse critique

L'examen du document de référence fait

apparaître plusieurs limites notables dans les approches existantes de

l'analyse automatisée des candidatures.

D'abord, les solutions reposent encore largement sur des

représentations textuelles traditionnelles, comme le modèle

TF-IDF, qui reste limité. Même si des modèles plus

avancés comme BERT sont mentionnés, leur intégration est

encore incomplète ou expérimentale, ce qui réduit leur

impact réel sur la qualité de l'analyse.

Ensuite, on constate un manque de personnalisation et de prise

en compte du contexte. Les systèmes évalués se contentent

souvent d'un appariement générique, sans s'adapter aux

spécificités d'un poste, d'une entreprise, ou aux

préférences individuelles des recruteurs. Cette approche

compromet la pertinence des résultats proposés.

Contextualisation

Dans un monde du travail en pleine transformation

numérique, les départements des ressources humaines cherchent

à moderniser leurs outils pour gagner en efficacité et en

objectivité. Le recours au traitement automatique du langage naturel

(NLP) s'inscrit dans cette dynamique, en permettant d'analyser plus rapidement

et de manière plus cohérente des centaines de candidatures.

Dans ce contexte, le présent travail vise à

combler ce vide en concevant un système intelligent d'analyse de

CV, combinant des techniques de NLP, une approche éthique et

une adaptation aux conditions spécifiques du terrain local.

Revue (3)

I.1.3 Un système intelligent pour l'optimisation du

processus de e-recrutement [3]

Identification des lacunes en matière de recherche

ou de mise en oeuvre

Malgré les avancées importantes dans le domaine

du e-recrutement assisté par l'intelligence artificielle, plusieurs

lacunes persistent dans les travaux antérieurs, notamment :

7

Identification incomplète du profil de

candidat

La majorité des systèmes d'appariement exploitent

uniquement le texte brut des offres d'emploi, sans en extraire formellement les

caractéristiques clés du profil recherché (ex. :

diplôme, expérience, compétences ...). Cela limite la

qualité des recommandations de candidats.

Synthèse

la littérature sur le e-recrutement intelligent se

structure autour :

Extraction d'entités (NER) : Les méthodes

traditionnelles (à base de règles ou d'ontologies) sont

aujourd'hui dépassées par les modèles basés sur

l'apprentissage automatique (BERT). Ces derniers permettent une meilleure

extraction d'informations à partir des offres et des CV.

Analyse critique

Bien que les solutions existantes soient techniquement

avancées, plusieurs critiques peuvent toujours persister :

Les méthodes de Matching sont souvent

dépendantes de la qualité des données textuelles, ce qui

peut jouer négativement sur les résultats.

Contextualisation

Systèmes d'aide à la décision (SAD) de

Ramdani (2021) s'inscrit dans une dynamique de modernisation des processus de

recrutement en ligne, en combinant :

- l'analyse automatique des documents RH (CV, offres)

- l'extraction de caractéristiques pertinentes (profil

recherché) [3].

Revue(4)

1.1.4 Intelligence artificielle appliquée au

processus de recrutement - Les perceptions des recruteurs [4]

Identification des lacunes en matière de

recherche ou de mise en oeuvre Lacunes théoriques :

- Le mémoire souligne que l'IA dans le recrutement est

un sujet émergent, encore peu étudié scientifiquement.

Lacunes pratiques :

- Les entreprises ont encore du mal à intégrer

l'IA dans leur stratégie RH globale, faute de moyens, de

compétences numériques internes, ou de clarté sur les

retours d'investissement.

8

Synthèse

Le mémoire de Mariana Martins explore les perceptions

des recruteurs vis-à-vis de l'IA dans le processus de recrutement. Il

adopte une méthode qualitative à travers des entretiens

semi-directifs. L'étude montre que :

- L'IA est perçue comme un levier d'efficacité,

surtout dans les phases de présélection.

- Elle soulage les recruteurs des tâches

répétitives, permet un meilleur ciblage et accélère

le traitement des candidatures.

Analyse critique

Points forts du mémoire :

Bonne structuration théorique : le mémoire offre

une revue de littérature approfondie sur la GRH, le recrutement et

l'IA.

Limites :

L'analyse pourrait approfondir davantage les enjeux juridiques

et les dimensions éthiques (RGPD Règlement

Général sur la Protection des Données.),

consentement).

Contextualisation

Dans le contexte socio-économique :

Le mémoire s'inscrit dans un moment post-COVID

où le télétravail, le recrutement à distance, et la

transformation digitale accélèrent la mutation des RH.

Revue(5)

I.1.5 Mise en correspondance entre les CV et les offres

d'emploi en utilisant le Deep Learning [5]

Identification des lacunes en matière de recherche

ou de mise en oeuvre. Lacunes en recherche :

- Peu de références sont faites aux enjeux

juridiques et éthiques (comme la confidentialité des

données personnelles ou les biais algorithmiques dans les

systèmes de recrutement).

Lacunes en mise en oeuvre :

- Le système repose sur des données

collectées via web scraping (Indeed), ce qui peut poser problème

légalement si l'usage n'est pas encadré.

Synthèse du mémoire

Ce mémoire propose un système de recommandation

qui met en correspondance les CV et les offres d'emploi à l'aide du

deep learning, notamment :

9

Un réseau de neurones classificateur

pour étiqueter les segments des CV (éducation,

expérience, compétences).

L'utilisation de cosinus de similarité

pour calculer la similarité sémantique entre les

éléments d'un CV et ceux d'une offre d'emploi.

Analyse critique Points forts :

Travail rigoureux et structuré, avec une bonne

maîtrise des outils de traitement du langage naturel (NLP) et du deep

learning.

Limites :

L'ensemble du système repose sur des

données textuelles extraites automatiquement

Contextualisation

Dans le contexte technologique :

L'usage du deep learning dans le NLP est

pertinent et montre l'évolution des outils classiques (mots-clés)

vers des approches plus intelligentes.

Dans le contexte local et académique :

Le mémoire contribue à valoriser

l'application de l'IA dans les systèmes web au sein des

universités algériennes.

Pourquoi faire une revue de la littérature

?

1. Pour mieux comprendre notre sujet :

Avant de concevoir un système intelligent d'analyse de

CV, il est essentiel de comprendre en profondeur les fondements

théoriques liés au traitement du langage naturel et à son

usage dans le domaine des ressources humaines. La revue de littérature

permet d'explorer les travaux antérieurs, d'identifier les

modèles et techniques couramment utilisés (comme Word2Vec ou

BERT), et de mieux cerner les enjeux liés à l'automatisation du

tri des candidatures. Cette compréhension offre non seulement une base

solide à la démarche, mais oriente aussi le choix des

technologies adaptées aux objectifs du projet.

2. Pour identifier les lacunes et les besoins de

recherche :

Analyser les recherches existantes aide à

révéler les limites que rencontrent les systèmes d'analyse

de CV actuels, comme leur difficulté à traiter les formats non

standardisés, leur manque de contextualisation ou leur tendance à

négliger les compétences transversales. En mettant en

évidence ces insuffisances, la revue de littérature ouvre des

pistes concrètes d'amélioration et permet de mieux cibler les

besoins encore insatisfaits, que ce soit en termes techniques, fonctionnels ou

éthiques.

10

3. Pour justifier notre recherche :

La revue de littérature permet aussi de positionner

clairement sa propre contribution. En s'appuyant sur les études

existantes et en soulignant leurs limites, elle montre en quoi le

système proposé se distingue et répond à des

besoins réels. Dans notre cas, l'intégration du NLP pour analyser

intelligemment les CV vise à offrir une solution plus précise,

plus accessible et mieux adaptée aux exigences des recruteurs, notamment

dans des contextes locaux peu représentés dans la recherche

actuelle.

4. Pour faciliter la rédaction d'un travail de

recherche :

Enfin, la revue de littérature joue un rôle

structurant dans la rédaction du mémoire. Elle permet de

construire la problématique, d'alimenter le cadre conceptuel, et de

justifier les choix méthodologiques. Elle sert également de

repère tout au long du projet, assurant cohérence et rigueur

scientifique. Ainsi, elle facilite non seulement la rédaction du

travail, mais renforce également la recherche.

11

CHAPITRE 2 : MÉTHODOLOGIE

2.1 Introduction

En informatique, la méthodologie désigne

l'ensemble des techniques, processus et approches utilisés pour

concevoir, développer, implémenter et maintenir des

systèmes informatiques. Elle s'applique à toutes les

étapes du cycle de vie logiciel, depuis l'analyse des besoins

jusqu'à la maintenance, en passant par la conception, le codage et les

tests. Une méthodologie rigoureuse permet de structurer le travail, de

garantir la qualité du logiciel produit, et de réduire les

risques d'échec du projet.

Dans le domaine de l'ingénierie logicielle, la

méthodologie représente bien plus qu'une simple succession

d'étapes techniques. Elle incarne une vision structurée du

développement logiciel, qui permet de traduire une idée

fonctionnelle en une solution informatique fiable, performante et

évolutive. Concrètement, elle désigne l'ensemble des

techniques, processus et approches utilisées pour analyser, concevoir,

implémenter, tester, déployer et maintenir un système

logiciel.

Chaque projet, quelle que soit sa taille, repose sur une

série de choix méthodologiques qui influencent directement sa

réussite. Sans une démarche rigoureuse et bien définie, le

développement logiciel devient vulnérable aux retards, aux

erreurs de conception, à l'instabilité du code et à

l'inadéquation entre le produit final et les besoins des

utilisateurs.

La méthodologie s'applique donc à toutes les

phases du cycle de vie logiciel -- depuis la formulation des exigences

jusqu'à la maintenance post-déploiement, en passant par la

modélisation, la programmation et l'évaluation des performances.

Elle permet de structurer le travail des développeurs, de coordonner les

efforts de l'équipe projet, et surtout, d'assurer que chaque

décision technique reste alignée avec les attentes fonctionnelles

du client ou de l'utilisateur final.

Mais au-delà de sa dimension technique, la

méthodologie est aussi une démarche humaine. Elle établit

un cadre de collaboration entre les différents acteurs du projet :

développeurs, chefs de projet, analystes métiers, utilisateurs

finaux. Elle définit les rôles, organise la communication,

facilite les feedbacks et favorise l'amélioration continue. Ainsi, elle

devient un levier stratégique pour anticiper les difficultés,

maîtriser les risques et construire des solutions réellement

utiles et durables.

Dans le cadre du présent projet, qui vise à

concevoir un système intelligent d'analyse de CV à l'aide du

traitement automatique du langage naturel (NLP), le recours à une

méthodologie adaptée est indispensable. Le caractère

innovant, technique et évolutif de cette solution nécessite une

démarche de développement souple, progressive et centrée

sur l'utilisateur.

2.2 Présentation des méthodologies de

développement logiciel (SDLC)

Le développement logiciel repose sur des modèles

méthodologiques bien établis, regroupés sous le terme de

SDLC (Software Development Life Cycle). Chaque modèle organise les

différentes phases du développement selon des principes et une

logique propre. Le choix du modèle influence profondément la

manière de gérer le projet, de collaborer en équipe et

d'interagir avec les utilisateurs finaux.

12

Ci-dessous, une présentation des principales

méthodologies :

1. Le modèle en cascade (Waterfall)

Le modèle en cascade est l'un des plus anciens

modèles de développement. Il se caractérise par une

progression linéaire et séquentielle des phases de

développement. Chaque étape (analyse des besoins, conception,

implémentation, test, déploiement, maintenance) doit être

complétée avant de passer à la suivante.

Caractéristiques :

· Rigidité du processus : pas de retour possible en

arrière.

· Documentation exhaustive à chaque phase.

· Adapté aux projets à exigences fixes et

stables. Avantages :

· Simplicité de mise en oeuvre.

· Bonne traçabilité des livrables.

Limites :

· Faible adaptabilité aux changements.

· Risque élevé si les besoins sont mal

définis au départ.

2. Le modèle en spirale

Ce modèle introduit une approche itérative

combinée à une analyse du risque. Chaque cycle (ou spirale)

contient les étapes classiques du développement, mais avec des

boucles successives qui permettent d'améliorer ou de corriger le produit

progressivement.

Caractéristiques :

· Axé sur la gestion des risques.

· Intègre des retours fréquents.

Avantages :

· Bonne maîtrise des risques.

· Adapté aux projets longs ou complexes.

Limites :

· Coûts élevés.

· Nécessite une expertise en évaluation de

risques.

3. Le modèle en V (ou modèle de validation

et de vérification)

C'est une extension du modèle en cascade, avec une

correspondance stricte entre chaque phase de développement et sa phase

de test. Chaque exigence a un plan de test associé.

13

Caractéristiques :

· Vision claire des étapes de validation.

· Phase de tests bien planifiée. Avantages

:

· Haut niveau de qualité logicielle.

· Réduction des erreurs de validation.

Limites :

· Peu flexible.

· Nécessite une très bonne définition

des exigences dès le départ.

4. Le modèle Agile

Le modèle Agile est itératif, incrémental

et collaboratif. Il repose sur une organisation du travail en sprints (courtes

périodes de développement), avec des démonstrations

régulières, des tests continus et une adaptation rapide aux

retours des utilisateurs.

Caractéristiques :

· Priorité à la satisfaction du client.

· Évolution continue du produit. Avantages

:

· Flexibilité aux changements.

· Amélioration continue.

· Forte implication des utilisateurs. Limites

:

· Moins adapté aux projets très

réglementés.

· Risque de dérive si la gestion de projet est

faible.

5. La méthode DevOps

DevOps (Development + Operations) est une culture qui vise

à rapprocher les équipes de développement logiciel et

celles chargées de l'exploitation (déploiement, surveillance).

Elle met l'accent sur l'automatisation, la livraison continue et

l'intégration continue.

Caractéristiques :

· Développement, test et déploiement

automatisés.

· Surveillance et retour immédiat après mise

en production.

14

Avantages :

· Accélère la livraison des

fonctionnalités.

· Améliore la stabilité des systèmes.

Limites :

· Nécessite une infrastructure technique

avancée.

· Transformation culturelle parfois difficile dans les

grandes entreprises. 6. Le modèle Lean

Inspiré du lean manufacturing, cette méthode vise

à éliminer les gaspillages, optimiser la valeur apportée

au client et réduire les délais. Elle repose sur la

simplification des processus, la réduction des tâches inutiles, et

l'autonomie des équipes.

Caractéristiques :

· Centré sur la valeur utilisateur.

· Recherche permanente de l'efficience. Avantages

:

· Gain de temps et de ressources.

· Produit adapté aux besoins réels.

Limites :

· Peut être difficile à mettre en oeuvre sans

expérience.

· Moins structuré que les modèles classiques.

2.3 Justification du modèle choisi : Agile

Compte tenu de la nature évolutive du projet (analyse de

CV et recrutement intelligent), le choix s'est porté sur la

méthodologie Agile. Cette approche permet de :

· Décomposer le développement en sprints

hebdomadaires,

· Intégrer rapidement les retours des RH et

utilisateurs finaux,

· Livrer des fonctionnalités utiles à chaque

itération,

· Réagir rapidement aux imprévus et

changements fonctionnels.

15

2.3 Outils et technologies utilisés

Le projet a mobilisé des technologies modernes,

adaptées aux besoins du NLP et du développement web :

Tableau 1 Outils et téchnologies

utilisés

Catégorie Outils/Technologies

Justification

|

Environnement de

développement

|

Anaconda

|

Distribution Python complète et stable

avec

gestionnaire d'environnements intégrés

(conda),

idéale pour le NLP et la data science

|

|

Langage principal

|

Python

|

Langage flexible, adapté au traitement NLP et

à l'IA

|

|

Framework Web

|

Django

|

Framework rapide, sécurisé, avec

architecture

MVT intégrée

|

|

Traitement du

langage

|

spaCy, Transformers

(BERT)

|

Extraction avancée d'entités,

compréhension

sémantique

|

|

Base de données

|

PostgreSQL

|

Système relationnel robuste, performant et

open

source

|

|

Interface frontend

|

Rectact

|

Design réactif, moderne et facile à

intégrer

avec l'architecture mvvm

|

|

Visualisation

|

Matplotlib, Seaborn

|

Génération de graphiques analytiques clairs

et

personnalisables

|

SECTION : Environnement et outils de

développement

Afin de concevoir un système intelligent d'analyse de

CV basé sur le traitement automatique du langage naturel, nous avons

soigneusement sélectionné une série d'outils,

bibliothèques et environnements adaptés au contexte du projet.

Cette section décrit en détail les choix technologiques retenus

ainsi que leur justification technique et fonctionnelle.

1. Environnement de développement :

Anaconda

L'environnement de développement utilisé dans ce

projet est Anaconda. Il s'agit d'une distribution open source de Python,

largement adoptée dans les domaines de la data science, du machine

learning et du traitement de données. Anaconda fournit un

écosystème intégré comprenant le gestionnaire de

paquets Conda, un environnement isolé et reproductible, ainsi que des

interfaces comme Jupyter Notebook ou Spyder. Ce choix permet de gérer

facilement les dépendances complexes liées aux

bibliothèques NLP (comme spaCy, transformers) et d'assurer une

compatibilité cohérente des versions. De plus, Anaconda facilite

le déploiement sur différents systèmes (Windows, Linux),

ce qui est crucial pour la portabilité du projet.

L'interface web destinée aux utilisateurs (entreprises

et demandeur d'emploie) a été développée en

s'appuyant sur la bibliothèque JavaScript React. Ce

choix technologique permet de

16

2. Langage de programmation principal :

Python

Le langage central utilisé est Python, en raison de sa

grande richesse en bibliothèques dédiées au traitement du

langage naturel, à l'intelligence artificielle et à la science

des données. Python est aujourd'hui considéré comme la

norme dans les domaines du NLP, grâce à des bibliothèques

comme spaCy, NLTK, scikit-learn, TensorFlow ou encore Hugging Face

Transformers. Sa syntaxe claire et son accessibilité favorisent une

productivité accrue et facilitent la collaboration entre

développeurs. De plus, Python est bien supporté dans les

environnements universitaires, ce qui rend son intégration naturelle

dans un cadre académique.

3. Framework Web : Django

Pour le développement de l'application web, nous avons

utilisé le framework Django. Ce framework Python repose sur une

architecture modèle-vue-contrôleur (MVC) qui favorise la

séparation des responsabilités et la maintenabilité du

code. Django est reconnu pour sa sécurité, sa robustesse et sa

rapidité de développement. Il intègre nativement des

modules pour la gestion des utilisateurs, l'administration des données,

les migrations de base de données, ce qui permet un développement

accéléré et structuré de la plateforme. Django est

également bien adapté à l'intégration de composants

d'intelligence artificielle via des APIs.

4. Traitement automatique du langage : spaCy et

Transformers (BERT)

Le coeur du système repose sur l'analyse linguistique

et sémantique des documents textuels (CV, offres d'emploi). Pour cela,

nous avons utilisé deux outils puissants et complémentaires.

D'une part, spaCy permet un traitement linguistique rapide et précis :

tokenisation, lemmatisation, reconnaissance d'entités nommées

(NER), etc. D'autre part, la bibliothèque Transformers de Hugging Face

fournit des modèles de langage pré-entraînés (comme

BERT) capables de produire des représentations sémantiques

profondes des phrases. Ces modèles permettent un appariement intelligent

entre un CV et une offre d'emploi, même lorsque les termes

utilisés diffèrent. Le couplage de spaCy pour la syntaxe et de

BERT pour la sémantique permet une analyse fine, robuste et

contextualisée.

5. Base de données : PostgreSQL

Le système de gestion de base de données

utilisé est PostgreSQL. Il s'agit d'un SGBD relationnel open source

reconnue pour sa fiabilité, sa conformité aux standards SQL et

ses performances, même avec des volumes de données importants.

PostgreSQL permet de stocker les profils candidats, les offres d'emploi, les

résultats d'analyse, ainsi que les historiques d'évaluation. Sa

capacité à gérer des types de données complexes et

à supporter les requêtes avancées (jointures,

agrégats, indexation) en fait un choix idéal pour ce projet. De

plus, son intégration avec Django via l'ORM (Object Relational Mapper)

permet une manipulation fluide des données côté backend.

6. Interface utilisateur (Frontend) : React

17

construire des interfaces utilisateur dynamiques et

réactives, capables de mettre à jour l'affichage en temps

réel en fonction des interactions et des données reçues du

backend.

React crée un système d'interface modulaire,

où chaque composant peut être stylisé de manière

claire et maintenable.

Grâce à cette approche, l'application propose un

tableau de bord interactif, ergonomique et responsive, optimisé pour

différents formats d'écrans (ordinateurs de bureau, tablettes,

terminaux mobiles). L'utilisation de React offre en outre la possibilité

d'implémenter des fonctionnalités avancées, telles que le

rafraîchissement automatique des résultats de matching, la

navigation fluide entre les pages et la gestion centralisée de

l'état de l'application. Enfin, cette architecture frontend garantit une

accessibilité renforcée et une expérience utilisateur

intuitive, en adéquation avec les standards modernes du

développement web.

7. Visualisation de données : Matplotlib et

Seaborn

Pour visualiser les résultats du système

(statistiques de matching, performances,

comparaisons), des bibliothèques de visualisation ont

été utilisées. Matplotlib est la bibliothèque de

base pour créer des graphiques en Python : histogrammes, courbes,

barres,

etc. Seaborn, construite sur Matplotlib, permet d'obtenir des

visualisations plus esthétiques avec moins de code, et une

intégration facilitée avec les DataFrames (pandas). Ces outils

sont particulièrement utiles pour présenter les

résultats des tests, les performances des

modèles NLP, ou encore les distributions de scores de

similarité entre CV et offres.

2.4 Architecture du système

L'architecture logicielle suit une structure client-serveur avec

les modules suivants :

1. Import des données :

Téléversement de CV au format PDF.

2. Extraction et prétraitement :

Conversion en texte brut, nettoyage, tokenisation.

3. NLP : Extraction des entités (NER),

tokenization, lemmatisation, analyse sémantique.

4. Matching et score : Calcul de

similarité entre le profil et une offre d'emploi.

5. Système d'aide à la décision

: Classement des candidats.

6. Dashboard : Interface RH, consultation des

résultats. 2.5 Méthode d'implémentation du

NLP

2.5.1 Extraction et prétraitement

Les CV sont extraits via un module OCR ou extraction PDF directe.

Le texte est ensuite nettoyé :

· Suppression des caractères spéciaux

· Mise en minuscule

· Suppression des stopwords (ex. "le", "et", "de")

· Lemmatisation pour réduire les mots à leur

racine

18

2.5.2 Reconnaissance d'entités (NER)

Le modèle spaCy est utilisé dans

un premier temps pour détecter :

· Les noms et prénoms

· Les diplômes (ex. Licence, Master)

· Les compétences techniques ("Python", "SQL")

· Les dates d'expérience professionnelle

Un modèle BERT pré-entraîné (par ex.

CamemBERT pour le français) vient enrichir cette extraction avec une

meilleure compréhension contextuelle.

2.5.3 Vectorisation et représentation

Chaque CV et chaque offre sont convertis en vecteurs

sémantiques à l'aide d'un encodeur BERT. 2.5.4

Calcul de similarité (cosine similarity)

Contexte : Après extraction des textes du CV et de

l'offre, le système utilise un modèle BERT (ou autre encodeur

NLP) pour transformer ces textes en vecteurs numériques (embedding).

Chaque document devient un vecteur dans un espace sémantique.

But : Mesurer à quel point le CV et l'offre d'emploi sont

proches dans cet espace vectoriel. On utilise pour cela la similarité

cosinus (cosine similarity).

(AxB)

Formule mathématique :

sim(A, B) = (||A||x||B||

Avec :

· A et B : vecteurs denses du CV et de l'offre.

· A · B : produit scalaire des deux vecteurs.

· ?A? et ?B? : norme (longueur) des vecteurs A et B.

Interprétation du score :

· Score = 1 ? les deux vecteurs sont identiques

(même orientation) ? documents très similaires.

· Score = 0 ? les vecteurs sont orthogonaux ? aucune

similarité.

· Score < 0 (rare dans ce contexte) ? vecteurs

opposés ? contradiction ou divergence sémantique.

Mathématiquement par là tous s'expliquent et

facile à démontrer une fois le texte converti en vecteur .

Supposons que l'encodage donne ces vecteurs :

· CV ? A = [0.5, 0.1, 0.4]

· Offre ? B = [0.6, 0.0, 0.3] sim(A, B) donnera = 0.965

19

2.5.5 Classement intelligent

Les candidats sont classés selon leur score, et ce

classement est affiché dans le dashboard RH Entreprise.

2.6 Exigences fonctionnelles et non fonctionnelles

Fonctionnelles

· Upload de CV PDF

· Extraction automatique des données pertinentes

· Matching avec des offres d'emploi

· Dashboard RH (score, export, tri) Non

fonctionnelles

· Réactivité de l'interface

· Sécurité des données

(authentification, cryptage)

· Compatibilité mobile et navigateurs

· Performances (temps de traitement < 2 secondes)

2.7 Limites méthodologiques

Certaine limite à signaler :

· Difficultés de traitement de certains formats PDF

complexes 2.8 Conclusion

La méthodologie déployée combine des outils

modernes, une approche agile et des techniques de NLP puissantes afin de

répondre aux besoins du e-recrutement intelligent. Le prochain chapitre

abordera en détail la conception technique du système et ses

différents composants fonctionnels.

20

Chapitre 3 Conception du système

3.1 Introduction

Dans le cadre de ce mémoire portant sur le

développement d'un système intelligent d'analyse de CV

fondé sur le traitement du langage naturel (NLP), le présent

chapitre constitue une étape fondamentale de la démarche

méthodologique. Il vise à exposer en détail le processus

de conception de l'application envisagée, depuis l'identification des

besoins métier jusqu'à la définition des modèles

logiques et techniques.

La conception d'un système d'information repose sur un

enchaînement structuré d'activités qui permettent de passer

d'un constat problématique à une solution technique fiable et

pertinente. Dans le domaine du recrutement, la gestion des candidatures est

aujourd'hui confrontée à plusieurs difficultés: la

réception massive de CV non standardisés, la lenteur de

l'évaluation manuelle, et la subjectivité inhérente au tri

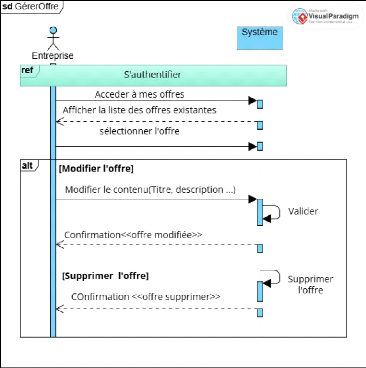

des candidatures. L'émergence des techniques de NLP, notamment les

modèles pré-entraînés comme BERT (Bidirectionnel

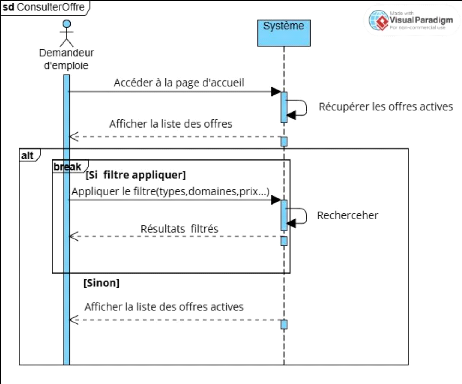

Encoder Représentations from Transformers), ouvre des perspectives

nouvelles pour automatiser l'analyse sémantique des documents et

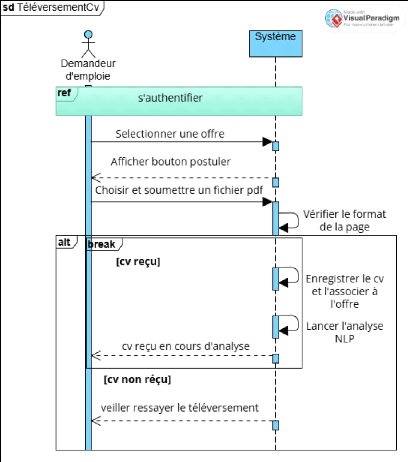

fiabiliser la sélection des profils.

Le système conçu dans ce travail a pour vocation

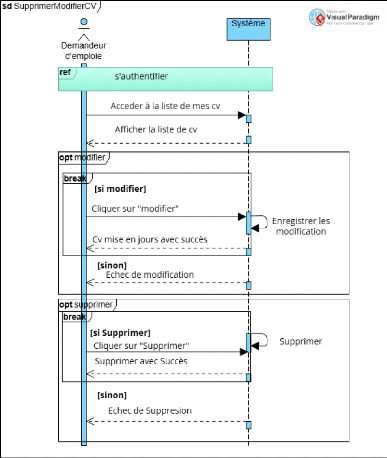

de permettre une comparaison objective et automatisée entre le contenu

des CV déposés par les demandeurs d'emploi et

les offres publiées par les entreprises, grâce

à l'intervention du système intelligent

d'analyse. L'originalité du dispositif repose sur la

capacité à traiter des CV au format PDF, à extraire leur

contenu textuel, à encoder l'information en vecteurs numériques

par BERT, et à calculer un score de pertinence par la mesure de

similarité cosinus. Ce score constitue un indicateur objectif de la

correspondance entre un profil et une offre d'emploi.

Le présent chapitre est organisé en plusieurs

sections complémentaires. La première partie expose

l'analyse métier, qui consiste à étudier

le processus actuel de gestion des candidatures, à identifier les

contraintes et les besoins des principaux acteurs (demandeur d'emploi,

entreprise) et à situer le rôle du système intelligent dans

la chaîne de valeur. Cette étape permet de comprendre le contexte

opérationnel et les enjeux concrets auxquels l'application devra

répondre.

La seconde partie présente l'analyse du

système informatique, notamment la définition des

exigences fonctionnelles (extraction des données, calcul de la

similarité, classement des CV, exportation des résultats) et des

exigences non fonctionnelles (performance, sécurité des

données, ergonomie, évolutivité). Ces

spécifications constituent le référentiel de conception

auquel le développement devra se conformer.

La troisième partie détaille la

conception logique et technique: architecture logicielle de

l'application, modélisation UML du système (diagrammes de cas

d'utilisation, diagrammes de séquence, diagramme de classes) et

définition du modèle logique de données. L'ensemble de ces

éléments permet de structurer le système de façon

cohérente, modulaire et évolutive.

Enfin, le chapitre se termine par la présentation du

modèle de déploiement et par la planification

des itérations de développement, qui permettront de valider

progressivement les fonctionnalités principales et d'assurer la

qualité globale du produit final.

En résumé, le chapitre 3 constitue la

colonne vertébrale conceptuelle et technique du

mémoire. Il établit un lien direct entre les besoins

exprimés par les acteurs du processus de recrutement et les

Le recruteur procède alors à une lecture

détaillée du contenu du CV. Cette lecture est suivie d'une

analyse manuelle visant à apprécier l'adéquation du profil

du candidat avec les exigences définies

21

solutions informatiques proposées, en s'appuyant sur

les meilleures pratiques d'architecture logicielle et sur les avancées

récentes du NLP appliqué à la gestion des ressources

humaines.

3.2 Modélisation du processus métier

La modélisation de processus (en

anglais, business process modeling ou BPM) consiste à

structurer et à représenter les activités d'une

organisation, généralement en utilisant une notation

graphique pour représenter visuellement

l'enchaînement des activités. La modélisation peut

s'appuyer sur des méthodes et outils spécialisés, et

mettre en oeuvre des cadres de références de

processus. [6]

Description textuelle du processus manuel de traitement

des candidatures (CV uniquement)

Le processus de traitement manuel des candidatures au sein

d'une entreprise débute dès l'instant où un demandeur

d'emploi manifeste son intérêt pour une offre d'emploi

spécifique. Dans un premier temps, le candidat consulte l'annonce

publiée, qui peut être diffusée en ligne ou par d'autres

canaux de communication (panneaux d'affichage, presse écrite,

réseaux professionnels). Il prend connaissance des conditions

d'accès au poste et des compétences attendues.

Suite à cette consultation, le candidat prépare

son curriculum vitae (CV), document essentiel permettant de présenter

son parcours académique, ses expériences professionnelles, ainsi

que ses principales compétences. Ce travail est réalisé de

manière autonome par le demandeur d'emploi, sans assistance

automatisée.

Une fois le CV finalisé, le candidat procède

à la soumission de sa candidature auprès de l'entreprise. Cette

transmission peut s'effectuer par voie électronique (email ou plateforme

de dépôt en ligne) ou par remise physique (dépôt du

dossier à l'accueil ou envoi postal). Dans certains cas, une

confirmation de réception est adressée au candidat, mais cette

pratique reste facultative et varie selon les entreprises.

La réception du CV par le service des ressources

humaines marque le transfert de responsabilité et l'ouverture du

traitement interne. La première étape consiste en une

vérification attentive de la complétude du document. L'objectif

est de s'assurer que toutes les informations nécessaires sont

présentes et que le format est conforme aux attentes.

À l'issue de cette vérification, une

première décision est prise:

Si le CV est jugé incomplet (par exemple, absence de

coordonnées, imprécisions sur le parcours professionnel), le

recruteur contacte directement le candidat afin d'obtenir les

compléments requis. Cette démarche s'effectue par email ou

téléphone et retarde l'analyse du dossier.

Si le CV est complet, il est intégré au lot des

candidatures en cours de traitement.

22

pour le poste à pourvoir (niveau de qualification,

années d'expérience, maîtrise des compétences

techniques et comportementales).

Dans un second temps, le recruteur compare les candidatures

entre elles, en utilisant généralement un tableau de suivi ou un

dossier papier, afin de mettre en évidence les différences et

d'établir une hiérarchisation des candidatures. Cette comparaison

repose sur des critères qualitatifs, et elle s'accompagne de la

rédaction de notes d'évaluation et d'appréciations propres

à chaque dossier.

Enfin, une seconde décision intervient. En fonction des

éléments analysés, le recruteur statue sur le statut final

du CV :

Si le profil est jugé pertinent et conforme aux

attentes, le CV est marqué comme présélectionné

pour la suite du processus de recrutement (convocation à un entretien,

tests complémentaires, etc.).

Si le profil est jugé non conforme ou moins

adapté, le CV est archivé dans les bases documentaires de

l'entreprise ou classé selon les procédures internes en

vigueur.

Ce processus manuel, qui mobilise l'expertise et le jugement

du recruteur à chaque étape, prend fin une fois que le statut de

l'ensemble des candidatures reçues a été fixé.

3.3 Identification des acteurs 3.3.1 un acteur

Un acteur représente un rôle joué par une

entité externe (utilisateur humain, dispositif matériel ou autre

système) qui interagit directement avec le système

étudié [7].

Un acteur peut consulter et/ou modifier directement

l'état du système, en émettant et/ou en recevant des

messages susceptibles d'être porteurs de données

[7].

o Les acteurs jouent un rôle clé dans le

fonctionnement du système en effectuant des actions ou en recevant des

informations.

23

Tableau 2 Rôles des acteurs

|

N°

|

Acteur

|

Rôle dans le système manuel

|

|

1

|

Demandeur d'emploi

|

- Recherche des offres d'emploi (presse, affichage, site

web)

- Prépare son CV et sa lettre de motivation

- Soumet sa candidature par email, en main propre ou par

courrier

|

|

2

|

Entreprise

|

- Rédige et diffuse l'offre d'emploi

- Réceptionne les candidatures

- Trie manuellement les dossiers

- Lit les CV un à un et note les candidats

- Compare les profils et sélectionne les meilleurs

|

|

3

|

Responsable RH / Service Recrutement

|

- Participe à l'analyse des dossiers

- Transmet les informations à la hiérarchie

- Organise la suite du processus (entretiens, tests, etc.)

|

3.4 Diagramme de contexte métier

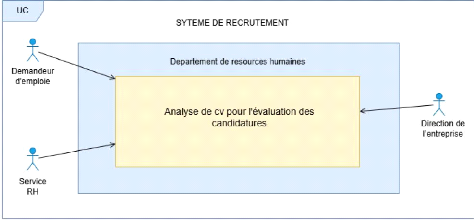

Le diagramme de contexte est le premier modèle à

réaliser dans une démarche de modélisation

systémique. En effet, quel que soit le niveau d'analyse choisi par le

modélisateur, toute modélisation nécessite de

représenter et de clarifier en premier lieu la frontière de

l'entité modélisée ainsi que les objets qu'elle va

échanger avec les autres entités qui se trouvent à

l'extérieur de sa frontière et qui composent son environnement

externe [8].

En réalisant le diagramme de contexte, le

modélisateur va pouvoir définir clairement les frontières

de l'objet modélisé et ses interfaces avec l'environnement

externe et/ou interne. Le diagramme de contexte est une représentation

de l'entité pour répondre à un problème

particulier. En d'autres termes, il peut y avoir différents types de

diagramme de contexte selon la finalité qui est visée par le

modélisateur [8].

24

Figure 1 Diagramme de contexte métier

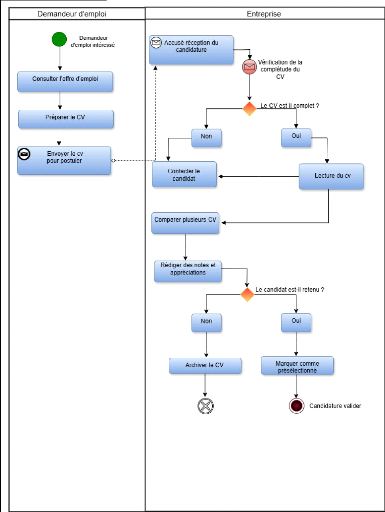

3.5 Diagramme de processus métier BPMN (Business

Process Model and Notation)

Le Business Process Model and Notation (BPMN) ou norme de

modélisation des processus métier en français, est une

méthode de logigramme qui modélise de A à Z les

étapes d'un processus métier planifié.

Élément clé de la gestion d'un processus métier, il

permet de représenter visuellement une séquence

détaillée des activités commerciales et des flux

d'informations nécessaires à la réalisation d'un processus

[9].

Mais aussi il est constituéé d'un schéma qui

peut se révéler bien plus facile à comprendre qu'un texte.

Il permet de communiquer et de collaborer plus facilement pour atteindre un

processus efficace, produisant un résultat de grande qualité. Il

contribue également à la communication menant à la

création des documents XML (Extensible Markup Language)

nécessaires à l'exécution de divers processus.

Figure 2 Diagramme de processus métier BPMN

25

Demandeur d'emploi Entreprise

1 Accusé réception du 16, candidature

A

T

Non

F

ro ntacter le candidat

tVérfication de la

complétude du

CV

ailikk Le CV est-il complet ?

Oui

Lecture du cv

Consulter I offre d'emploi

e

o-

n

Demandeur

d'emploi intéressé

Préparer le CV

Envoyer le cv pour postuler

Comparer plusieurs CV

i

Rédiger des notes et

appréciations

Le candidat est-il retenu ?

V

Oui J

I

Marquer comme

présélectionné

[tom] Candidature valider

Non

Archiver le CV

busines process use case model

26

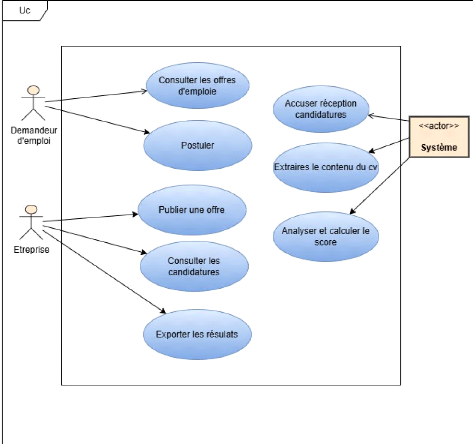

3.6 Diagramme de cas d'utilisation métier

Les diagrammes de cas d'utilisation (DCU) sont des diagrammes

UML utilisés pour une représentation du comportement fonctionnel

d'un système logiciel. Ils sont utiles pour des présentations

auprès de la direction ou des acteurs d'un projet, mais pour le

développement, les cas d'utilisation sont plus appropriés. En

effet, un cas d'utilisation (use cases) représente une

unité discrète d'interaction entre un utilisateur (humain ou

machine) et un système. Ainsi, dans un diagramme de cas d'utilisation,

les utilisateurs sont appelés acteurs (actors), et ils apparaissent dans

les cas d'utilisation [10].

Ils permettent de décrire l'interaction entre l'acteur

et le système. L'idée forte est de dire que l'utilisateur d'un

système logiciel a un objectif quand il utilise le système ! Le

cas d'utilisation est une description des interactions qui vont permettre

à l'acteur d'atteindre son objectif en utilisant le système. Les

use case (cas d'utilisation) sont représentés par une

ellipse sous-titrée par le nom du cas d'utilisation

(éventuellement le nom est placé dans l'ellipse). Un acteur et un

cas d'utilisation sont mis en relation par une association

représentée par une ligne [10].

Figure 3 Diagramme de cas d'utilisation métier

27

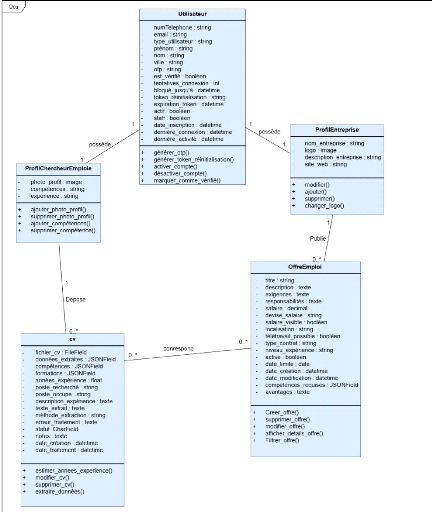

3.7 MODELE DU DOMAIN

Le modèle du domaine est une

représentation des concepts clés du

système, de leurs caractéristiques et des liens qui les

unissent. Il s'agit d'un diagramme de classes

simplifié, destiné avant tout à faciliter la

compréhension des entités fondamentales du domaine métier,

indépendamment de toute considération technique ou de mise en

oeuvre. Ce modèle décrit de manière claire et

structurée les objets qui interviennent dans le fonctionnement du

système, tels que les candidats, les offres d'emploi, les CV ou encore

les entreprises, ainsi que les relations logiques qui les relient.

L'objectif principal du modèle du domaine est

d'établir un vocabulaire commun et partagé entre les parties

prenantes du projet (maîtrise d'ouvrage, développeurs,

utilisateurs finaux), afin de s'assurer que la conception technique

reflète fidèlement la réalité métier et

réponde aux besoins exprimés.

Le diagramme de classes est quant à

lui un outil essentiel qui permet de modéliser la structure

statique du système. Il représente les objets ou

entités du domaine, leurs attributs, leurs méthodes principales,

ainsi que les relations de dépendance, d'association ou

d'héritage qui les relient. Ce diagramme joue un rôle central dans

la démarche de conception: il sert de point de référence

pour la définition des structures de données, la conception de la

base de données relationnelle, et la génération des

squelettes de code objet.

Dans le cadre de ce projet, le diagramme de classes facilite

la visualisation des entités principales du système (Entreprise,

Offre d'emploi, Demandeur d'emploi, CV), de leurs propriétés (par

exemple les coordonnées, les dates de publication ou les scores de

pertinence) et des cardinalités des associations (une entreprise peut

publier plusieurs offres, un demandeur peut déposer plusieurs

candidatures, etc.).

28

Figure 4 Diagramme de classes système 3.7

Analyse du système informatique

Cette section présente l'analyse

détaillée du système informatique envisagé.

L'objectif est de spécifier les exigences auxquelles la solution doit

répondre, afin d'assurer son adéquation aux besoins métier

identifiés et de guider la conception technique. L'analyse porte

à la fois sur les exigences fonctionnelles, qui

décrivent les services attendus du système, et sur les

exigences non fonctionnelles, qui fixent les contraintes de

qualité, de performance et de sécurité.

Avec plaisir. Voici une version bien structurée et

rédigée de la section :

Ø Exigences fonctionnelles du système existant

(manuel)

29

Cette section présente les exigences fonctionnelles du

système actuel, c'est-à-dire le processus manuel tel qu'il est

observé avant toute informatisation ou automatisation. Il s'agit

d'identifier les tâches que les acteurs réalisent aujourd'hui sans

l'aide d'un système intelligent, afin de mieux comprendre les limites du

fonctionnement actuel et de motiver la mise en place d'une solution

numérique.

o Exigences fonctionnelles identifiées dans le

système existant :

1. Publication manuelle des offres d'emploi

§ Les offres d'emploi sont rédigées et

publiées via des canaux classiques : affichage physique, annonces dans

la presse, groupes WhatsApp ou e-mail.

§ L'offre est souvent sous forme de document Word ou

texte simple.

2. Réception des candidatures

§ Les candidats envoient leur CV par e-mail, sur support

physique (clé USB, papier) ou les déposent en personne.

§ Aucun système centralisé ne gère

la réception : chaque dossier est stocké manuellement.

3. Lecture et analyse des CV

§ Le responsable RH lit chaque CV un par un.

§ L'analyse repose sur l'expérience du recruteur

: vérification manuelle des diplômes, expériences,

compétences.

4. Tri manuel des dossiers

§ Les recruteurs trient les candidatures selon des

critères internes (souvent non formalisés).

§ Les profils sont classés manuellement dans des

dossiers : "retenus", "à revoir", "refusés".

5. Sélection

§ Une liste de candidats

présélectionnés est rédigée sur papier ou

dans un fichier Excel.

§ Le classement est subjectif, sans outil de mesure

formel.

6. Absence de retour automatique

§ Les candidats ne reçoivent souvent pas de retour

formel.

§ Le suivi des candidatures est rarement

automatisé.

7. Archivage des CV

§ Les CV sont stockés dans des dossiers

informatiques ou physiques sans étiquetage standardisé.

§ Il est difficile de retrouver un ancien CV ou de

réutiliser une base de données de candidats.

30

Remarque :

Aucune de ces étapes n'est automatisée, ce qui

engendre des pertes de temps, des oublis, et un manque d'objectivité

dans la sélection.

Suggestion

Pour rendre le processus de recrutement plus simple, rapide et

objectif, nous proposons une application web d'analyse intelligente des

candidatures basée sur le traitement automatique du langage naturel

(NLP). Cette solution aidera les entreprises à identifier plus

efficacement les profils pertinents en comparant automatiquement les CV soumis

aux exigences des offres d'emploi grâce à un modèle BERT de

similarité sémantique.

Ce système permettra aux entreprises de simplifier

leurs démarches de présélection sans avoir à

traiter manuellement de grandes quantités de candidatures, ce qui

réduit considérablement le temps d'analyse et le risque d'erreur

humaine. De plus, l'application offrira aux demandeurs d'emploi la

possibilité de postuler directement en ligne, de recevoir un

accusé de réception et d'assurer une meilleure

traçabilité de leur candidature.

L'authentification sécurisée par OTP garantira

la confidentialité des informations sensibles et la protection des

données personnelles des utilisateurs.

Accessible depuis tout appareil connecté (ordinateur,

tablette, smartphone), l'application couvrira l'ensemble du processus de

dépôt, d'analyse et de classement des CV, assurant une

organisation plus rigoureuse et une expérience utilisateur moderne et

fluide.

3.7.1 Spécification des exigences o Exigences

fonctionnelles

Les exigences fonctionnelles définissent les

principales fonctionnalités que le système doit offrir. Elles

couvrent l'ensemble du cycle de traitement des candidatures, depuis la

publication des offres jusqu'à l'analyse automatique des CV et la

restitution des résultats aux utilisateurs.

Exigences fonctionnelles identifiées : Gestion des

utilisateurs

Le système doit permettre aux entreprises de

créer un compte, de s'authentifier de manière

sécurisée et de gérer leur profil.

L'authentification devra inclure un mécanisme

d'authentification forte via OTP (One-Time Password)

envoyé par email pour renforcer la sécurité lors de la

connexion. Les demandeurs d'emploi doivent pouvoir créer un compte, se

connecter avec OTP, et mettre à jour leurs informations personnelles.

v Publication des offres d'emploi

Les entreprises doivent pouvoir créer, modifier et

supprimer des offres d'emploi via une interface conviviale.

Chaque offre doit comporter au minimum les informations

suivantes: Titre du poste

Description détaillée

31

Compétences requises Niveau d'études

souhaité Type de contrat

Lieu

Date limite de candidature Ect

Consultation des offres

Les demandeurs d'emploi doivent pouvoir consulter la liste des

offres disponibles. Ils doivent pouvoir accéder aux détails

complets de chaque offre avant de postuler.

v Dépôt de candidatures

Les demandeurs d'emploi doivent pouvoir déposer leur CV

au format PDF en réponse à une offre

sélectionnée.

Le système doit confirmer automatiquement la

réception de chaque candidature.

v Extraction et analyse automatique des CV

Le système doit extraire le contenu textuel des CV

déposés.

Il doit générer un vecteur d'embedding à

l'aide du modèle BERT pré-entraîné. Il doit comparer

le contenu du CV avec l'offre d'emploi et calculer un score de

similarité.

v Classement et restitution des résultats

Le système doit afficher la liste des candidatures

reçues pour chaque offre, triée par ordre décroissant de

pertinence.

Il doit permettre d'exporter les résultats au format

Excel et PDF.

v Tableau de bord administratif

Le système doit fournir un tableau de bord de suivi avec

les indicateurs suivants :

Nombre d'offres publiées

Nombre de candidatures reçues

Taux moyen de pertinence des candidatures Statistiques des

dépôts par période

o Exigences non fonctionnelles

Les exigences non fonctionnelles précisent les

contraintes techniques, ergonomiques et organisationnelles auxquelles le

système doit se conformer.

32

Exigences non fonctionnelles identifiées

:

v Sécurité

Les données personnelles des utilisateurs doivent

être protégées conformément aux

réglementations en vigueur.

L'authentification doit être sécurisée avec

un mot de passe chiffré et une vérification par OTP

lors de la connexion.

L'accès aux fonctionnalités sensibles doit

être contrôlé selon le rôle (entreprise, candidat,

administrateur).

v Performance

Le système doit être capable d'analyser un CV et

de générer un score en moins de seconde

après le la soumission de cv.

La navigation doit rester fluide même en cas de forte

affluence.

v Compatibilité

L'application doit être compatible avec les principaux

navigateurs (Chrome, Firefox, Edge).

L'interface doit être responsive, adaptée aux

écrans mobiles et tablettes.

v Ergonomie

L'interface doit être claire et intuitive, avec une

navigation facilitée par des menus explicites et des indications

visuelles.

Les messages d'erreur doivent être précis et guider

l'utilisateur pour corriger les actions.

v Maintenance

Le système doit être conçu de façon

modulaire afin de faciliter son évolution. 3.8. Analyse des

besoins de conception

3.8.1 Présentation du système d'analyse de cv

basé sur NLP

33

Figure 5 Présentation du système

3.8.2 Identification des acteurs du système

d'analyse de cv basé sur le NLP

Un acteur représente un rôle joué par une

entité externe (utilisateur humain, dispositif matériel ou autre

système) qui interagit directement avec le système

étudié. Un acteur peut consulter et/ou modifier directement

l'état du système, en émettant et/ou en recevant des

messages susceptibles d'être porteurs de données [11].

Pour le cas de notre nouveau système, nous recenser les

acteurs ci-après :

Tableau 3 Identification des acteurs du système

d'Analyse de cv basé sur le NLP

|

N° ACTEURS DESCRIPTION

|

|

1

|

Demandeur

|

Toute personne à la recherche d'un emploi qui peut

créer un compte, consulter

|

|

d'emploi

|

les offres, déposer son CV au format PDF et suivre le