|

|

L'INTELLIGENCE ARTIFICIELLE DANS LE

SECTEUR DE L'ASSURANCE

|

Mémoire de recherche

BERGER Georges

Master 2 Droit de l'économie

numérique

Année universitaire 2019-2020

1/97

Sous la direction de Madame Catherine LEDIG

Professeure à l'Université de Strasbourg

RÉSUMÉ

La révolution numérique a changé la face

de l'économie, non seulement européenne, mais aussi mondiale. Les

progrès technologiques et le développement des nouveaux

systèmes d'information et de communications ont bouleversé les

sociétés. En effet, le développement des nouvelles

technologies témoigne d'une réelle « mutation

sociétale dont la clé de voûte résulte de

l'information numérique et des communications électroniques

»1 qui vont alors jusqu'à impacter notre manière de

communiquer, d'échanger et d'appréhender le monde qui nous

entoure. Dans ce contexte, l'intelligence artificielle, et plus

particulièrement le machine learning et le deep

learning, offre de nouvelles perspectives économiques.

Ainsi, si leur intégration dans le secteur des

assurances va conduire à une refonte complète des processus

allant vers plus de transversalités entre les métiers, et un

effacement des frontières traditionnelles entre le back office et le

front office, l'intelligence artificielle laisse entrevoir de nouvelles

perspectives en termes d'analyse des risques et des offres qui entendre

répondre à un besoin croissant de personnalisation voulue par les

assurés. En même temps, l'intégration de l'intelligence

artificielle laisse entrevoir de nouvelles perspectives s'agissant de la

prévention et de la lutte contre la fraude à l'assurance.

Cependant, bousculant les codes existants jusqu'alors dans ce

secteur, l'utilisation des nouveaux procédés d'intelligence

artificielle pose la question de leur compatibilité avec le principe de

mutualisation des risques, central dans ce secteur, mais également du

cadre réglementaire applicable en la matière.

2/97

1 Éric A. Caprioli, Droit international de

l'économie numérique : les problèmes juridiques

liés à l'internationalisation de l'économie

numérique, Lexis Nexis, 2e Édition

ABSTRACT

The digital revolution has changed the face of the economy,

not only in Europe, but also globally. Technological advances and the

development of new information and communication systems have turned societies

upside down. Indeed, the development of new technologies is evidence of a real

societal change, the keystone of which is digital information and electronic

communications, which are now impacting the way we communicate, exchange and

understand the world around us2. In this context, artificial intelligence, and

more particularly machine learning and deep learning, offers new economic

perspectives.

While their integration in the insurance sector will lead to a

complete overhaul of processes, with more cross-functionality between

businesses, and the blurring of traditional boundaries between the back office

and the front office, artificial intelligence offers new perspectives in terms

of risk analysis and offers that aim to respond to a growing need for

personalization as required by policyholders. At the same time, the integration

of artificial intelligence opens up new perspectives when it comes to

preventing and combating insurance fraud.

However, the use of new artificial intelligence processes

raises the question of their compatibility with the principle of risk pooling,

which is central to this sector, but also with the regulatory framework

applicable in this area.

3/97

2 ric A. Caprioli, Droit international de

l'économie numérique : les problèmes juridiques

liés à l'internationalisation de l'économie

numérique, Lexis Nexis, 2e Édition

4/97

5/97

******

Je tiens à exprimer ma reconnaissance et mes

sincères remerciements à Madame Catherine LEDIG, ma directrice de

mémoire et responsable de master, qui m'a aidé, conseillé

et orienté tout au long de cette année si particulière.

J'adresse également mes sincères remerciements

à l'ensemble de l'équipe pédagogique, dont les

méthodes d'enseignement et d'évaluation nous auront permis de

mettre en pratique et de contextualiser l'ensemble des connaissances et

compétences acquises au cours de cette année.

Je tiens à remercier mes proches, qui par leur soutien

inconditionnel et leurs encouragements m'ont été d'une grande

aide.

À tous ces intervenants, je présente mes

remerciements, mon respect et ma gratitude.

6/97

TABLE DES MATIÈRES

INTRODUCTION 9

PARTIE I : La refonte du modèle assurantiel

traditionnel par l'usage

des procédés d'intelligence artificielle

13

Chapitre 1 : L'intégration de l'intelligence

artificielle, facteur d'innovation

dans le secteur de l'assurance 14

Section 1.

L'intelligence artificielle, outil de développement

opérationnel et de culture

des transversalités 14

I. Le décloisonnement des métiers induit par

l'utilisation de l'intelligence

artificielle 14

II. L'optimisation opérationnelle par

l'automatisation des processus 18

Section 2.

L'intelligence artificielle, moteur essentiel au développement

de nouvelles

activités à forte valeur ajoutée

centrée sur le client 22

I. Une réponse pertinente à l'ère de la

considération 22

II. Vers une prévention augmentée par le

recours à l'intelligence artificielle 25

Chapitre 2 : L'impact de l'intelligence artificielle sur

le principe de

mutualisation des risques 29

Section 1.

L'appréhension et la mutualisation des risques, piliers du

modèle

assurantiel traditionnel 29

Section 2.

L'usage de l'intelligence artificielle, méthode d'analyse du

risque plus

précise et dynamique 32

I. Le recours à l'intelligence artificielle en

réponse aux risques émergents et

complexes 32

II. L'intelligence artificielle comme outil de correction de

l'asymétrie

d'information 36

Section 3. La

crainte d'une démutualisation du système assurantiel par le

recours à

l'intelligence artificielle 39

PARTIE II : L'intelligence artificielle dans le secteur

de l'assurance,

une technologie en quête de repères

43

Chapitre 1 : Un cadre réglementaire et

éthique peu développé en la

matière 44

Section 1.

L'explicabilité des algorithmes, un enjeu majeur de

développement de

l'intelligence artificielle 44

I. 7/97

La transparence des algorithmes d'intelligence artificielle,

un principe socle

d'une intelligence artificielle soucieuse des droits humains

44

II. Des initiatives pour l'heure limitées et

disparates des acteurs du secteur 48

Section 2. Une

réglementation partielle de l'intelligence artificielle par le cadre

juridique existant 51

I. Le RGPD, une réponse incomplète au

développement de l'intelligence

artificielle 51

II. L'intelligence artificielle à l'origine de

nouvelles logiques de responsabilité 55

Chapitre 2 : Une gouvernance interne primordiale

préalablement au

recours à l'intelligence artificielle

59

Section 1. L'impératif d'une stratégie de

la donnée avant l'intégration des outils

d'intelligence artificielle 59

Section 2.

L'importance d'une prise en considération des risques

liés à la sécurité

des procédés d'intelligence artificielle 64

CONCLUSION 68

BIBLIOGRAPHIE 69

ANNEXES 74

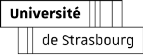

Annexe 1. Chiffres clés de l'assurance en France

74

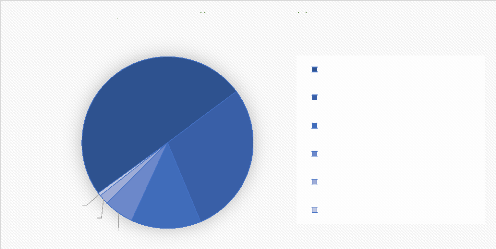

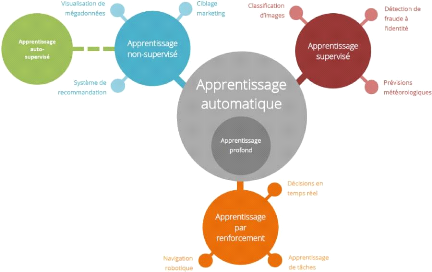

Annexe 2. Les différentes branches de

l'intelligence artificielle 76

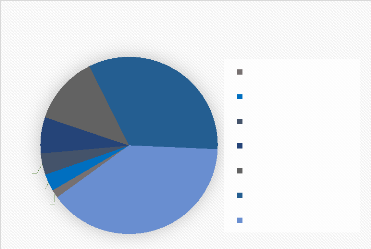

Annexe 3. La mutualisation des risques 77

Annexe 4. Les principaux indicateurs du numérique

en France 77

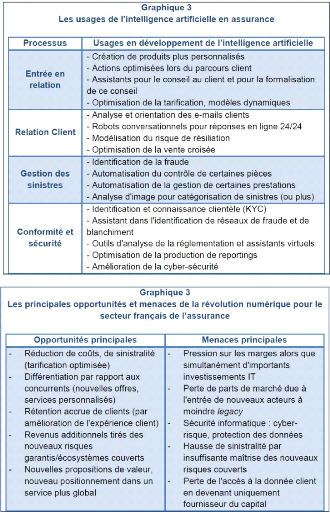

Annexe 5. Les usages de l'intelligence artificielle en

assurance 82

Annexe 6. Classification des différentes formes

d'intelligence artificielle 83

Annexe 7. Codex des biais cognitifs humains

84

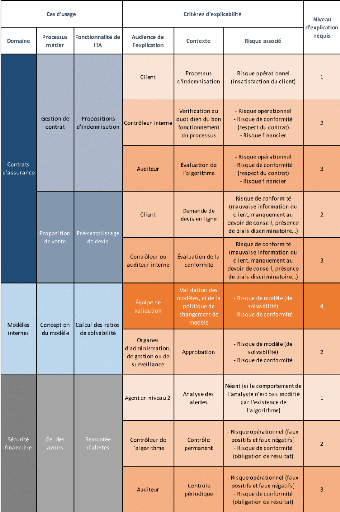

Annexe 8. Niveaux d'explication par cas d'usage

85

Annexe 9. Les objectifs et fonctions de la

cybersécurité 86

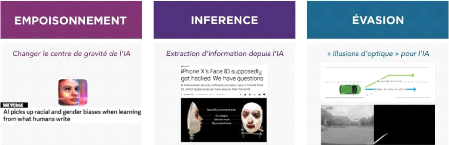

Annexe 10. Synthèse des principaux moyens

d'attaque spécifiques au

machine learning 87

Annexe 11. Briques de fonctionnement d'une application

basée sur la

machine learning 88

Annexe 12. Synthèse des dispositions applicables

au titre du Règlement

général sur la protection des

données personnelles 89

8/97

Annexe 13. Synthèse des cas d'usage de

l'utilisation de l'intelligence

artificielle dans le secteur de l'assurance

90

Annexe 14. Résultats du baromètre 2020

des risques émergents en

assurance 92

Annexe 15. Synthèse de l'approche du Conseil de

l'Europe en matière de

régulation de l'intelligence artificielle

94

Annexe 16. Synthèse de la nouvelle

stratégie de l'Union européenne en

matière de numérique 95

9/97

INTRODUCTION

« Réussir à créer une

intelligence artificielle efficace pourrait être le plus grand

évènement de l'histoire de notre civilisation, ou le pire. Nous

ne savons tout simplement pas. Nous ne pouvons donc pas savoir si nous seront

infiniment aidés par l'intelligence artificielle, ou ignorés par

elle et écartés ou éventuellement détruits par

elle3 ».

Ces mots, prononcés par Stephen Hawking, à

l'occasion de son discours d'ouverture de la Web Summit 20174, témoigne

du contexte actuel englobant l'essor de l'intelligence.

En effet, la révolution numérique a

changé la face de l'économie, non seulement européenne,

mais aussi mondiale. Les progrès technologiques et le

développement des nouveaux systèmes d'information et de

communications ont bouleversé les sociétés. En effet, le

développement des nouvelles technologies témoigne d'une

réelle « mutation sociétale dont la clé de

voûte résulte de l'information numérique et des

communications électroniques »5 qui vont alors jusqu'à

impacter notre manière de communiquer, d'échanger et

d'appréhender le monde qui nous entoure. Dans cet élan de «

digitalisation » des sociétés modernes, deux remarques

peuvent cependant être avancées. D'une part, il est possible

d'observer que les technologies de l'information et de la communication (les

« TIC ») ne sont plus un secteur de l'économie parmi d'autres,

mais constituent aujourd'hui la base sur laquelle repose tous les secteurs de

l'économie6. D'autre part, la révolution numérique entend

placer les données au coeur du processus, tant elles permettent, une

fois collectées, d'anticiper et de prédire. En ce sens, avec

l'essor constant du nombre de données produites par chaque individu, les

méthodes de traitement ont nécessairement dû

évoluer.

Selon les derniers chiffres publiés par IDC en novembre

20197, plus de 16,1 Zettaoctets (soit environ 17 287 243 366, 4 Teraoctets) de

données ont été générées en 2016, et

ce chiffre ne cesse de croitre chaque, puisque le cabinet prédit un

volume de données s'élevant à plus de 163 Zettaoctets

à l'horizon de 2025, soit une augmentation de près de 34% par

année. En telle hypothèse, la croissance exponentielle des

données disponibles a nécessité l'essor de nouvelles

3 Traduction de l'anglais : « success in creating

effective AI could be the biggest event in the history of our civilisation, or

the worst. We just don't know. So we cannot know if we will be infinitely

helped by AI, or ignored by it and sidelined or conceivably destroyed by it

».

4

https://websummit.com/blog/hall-of-famers

Le Web Summit est un évènement fondé par

Paddy Cosgrave, David Kelly et Daire Hickey, inauguré pour la

première en fois en 2009 et qui a lieu chaque année.

L'évènement est centré sur la technologie de l'Internet et

haute technologie, et réunit notamment les PDG des entreprises du

Fortune 500 et les fondateurs de start-ups de l'internet.

5 Éric A. Caprioli, Droit international de

l'économie numérique : les problèmes juridiques

liés à l'internationalisation de l'économie

numérique, Lexis Nexis, 2e Édition

6 Communication de la Commission européenne au

Parlement européen, au Conseil, au Comité économique et

social européen et au Comité des région du 6 mai 2015,

intitulé « Stratégie pour une marché unique

numérique en Europe », COM (2017) 192 Final, SWD (2015) 100

final,

p.3

7

https://www.idc.fr/infographies

10/97

technologies permettant le traitement et l'analyse de

pareilles données, aussi appelées technologies du big data. Qu'il

s'agisse de photographies, SMS ou mails échangés, de tweets ou

posts sur les réseaux sociaux, de données de navigation ou

d'utilisation d'objets connectés en tous genres, ou bien encore de

données météorologiques ou sismique, les données

constituent aujourd'hui des informations cruciales permettant pilotant la vie

des sociétés modernes8.

Dans un contexte où les données occupent une

place fondamentale dans l'économie numérique, l'intelligence

artificielle semble s'imposer non seulement comme une réponse

concrète au traitement des données, mais également de

tirer profit des données afin de fonder de nouveaux modèles

disruptifs pour les entreprises.

Dans sa Communication du 25 avril 2018 sur

l'Intelligence artificielle pour l'Europe, la Commission

européenne soulignait que « l'intelligence artificielle (IA)

désigne les systèmes qui font preuve d'un comportement

intelligent en analysant leur environnement et en prenant des mesures - avec un

certain degré d'autonomie - pour atteindre des objectifs

spécifiques.

Les systèmes dotés d'IA peuvent être

purement logiciels, agissant dans le monde virtuel (assistants vocaux,

logiciels d'analyse d'images, moteurs de recherche ou systèmes de

reconnaissance vocale et faciale, par exemple) mais l'IA peut aussi être

intégrée dans des dispositifs matériels (robots

évolués, voitures autonomes, drones ou applications de l'internet

des objets, par exemple) ». Toutefois, cette définition ne se

concentre que sur l'aspect fonctionnel, par référence aux

systèmes, support de l'intelligence artificielle.

Le Conseil de l'Europe, très actif s'agissant des

questions liées aux rapports entre les libertés fondamentales et

l'intelligence artificielle, définit cette dernière comme «

l'ensemble de sciences, théories et techniques (notamment logique

mathématique, statistiques, probabilités, neurobiologie

computationnelle, informatique) qui ambitionne d'imiter les capacités

cognitives d'un être humain. Initiés dans le souffle de la seconde

guerre mondiale, ses développements sont intimement liés à

ceux de l'informatique et ont conduit les ordinateurs à réaliser

des tâches de plus en plus complexes, qui ne pouvaient être

auparavant que déléguées à un humain9 ».

Laissant entrevoir de larges perspectives économiques,

le cabinet IDC a, dans ses dernières prévisions, estimé

que les dépenses mondiales en intelligence artificielle devraient

atteindre les 110 milliards de dollars en 202410. Plus particulièrement,

le cabinet estime qu'au regard des nouvelles possibilités offertes par

l'intelligence artificielle s'agissant de

8 Hubery Bitan, Droit et expertise du numérique,

Wolters Kluwer, 2015

9

https://www.coe.int/fr/web/artificial-intelligence/history-of-

ai#:~:text=L'intelligence%20artificielle%20(IA),cognitives%20d'un%20%C3%AAtre%20humain

10

https://www.idc.com/getdoc.jsp?containerId=prUS46794720

11/97

l'organisation du travail et de relation client, ce sont

principalement les secteurs de la vente au détail et de la finance qui

dépenseront le plus en solutions d'intelligence artificielle.

À cet égard, le secteur de l'assurance n'est pas

en reste s'agissant de l'intégration de ces nouveaux outils. En effet,

selon les chiffres publiés par Insurance Europe11,

le marché de l'assurance européen occupait en 2018 la

deuxième place du marché mondial de l'assurance, juste

après l'Asie, et avant l'Amérique du Nord. Le marché

européen de l'assurance représente plus de 1 311 milliards

d'euros de cotisations d'assurances sur l'année 2018, ce chiffre

étant en hausse de 6,2% par rapport à l'année 201712.

Et la France n'est pas en reste dans ce secteur. En effet, selon

l'étude, notre pays figure, aux côtés du Royaume-Uni et de

l'Allemagne, parmi les acteurs les plus importants du marché

européen, avec près de 19,4 milliards d'euros de

cotisations (voir annexe 1). Secteur marqué par l'importance de la

donnée, qui constitue le coeur de l'activité assurantielle13,

l'intégration des procédés d'intelligence artificielle

apparait comme une solution aux nouveaux besoins exprimés par les

assurés, dans un contexte le secteur connait une concurrence toujours

plus importante, une réglementation toujours plus contraignante en

matière de portage des risques, et un volume de données en

constante augmentation. En ce sens, ce contexte général pousse

les assureurs à devoir se réinventer et trouver de nouveaux

leviers de croissance. À cet égard, si certains auteurs

qualifiaient le cloud, la data et l'intelligence artificielle comme le

tiercé gagnant des assureurs14, triptyque qui permettrait aux acteurs du

secteur de pouvoir se démarquer par un processus de création de

valeur fondé sur le numérique.

Dans ce contexte où l'intelligence artificielle semble

répondre aux besoins du secteur par une remise en question des processus

prévalant jusqu'alors, comment l'intelligence artificielle

transforme-t-elle le secteur de l'assurance ? En outre, l'intelligence

artificielle constitue-t-elle un levier de transformation pérenne

?

11 Basée à Bruxelles, Insurance Europe est la

fédération européenne d'assurance et de

réassurance, qui représente toutes les entreprises d'assurance et

de réassurance. Ses missions sont les suivantes :

- Attirer l'attention sur les questions d'intérêt

stratégique pour tous les assureurs et réassureurs

européens de manière durable.

- Sensibiliser au rôle des assureurs et des

réassureurs dans la protection et la sécurité de la

communauté ainsi que dans la contribution à

la croissance et au développement économiques.

- Promouvoir - en tant qu'expert et représentant du

secteur de l'assurance - un marché concurrentiel et ouvert au profit du

consommateur

européen ainsi que des entreprises clientes.

https://www.insuranceeurope.eu/about-us

12 Insurance Europe, European Insurance - Key Facts,

Septembre 2019.

Voir :

https://www.insuranceeurope.eu/sites/default/files/attachments/European%20insurance%20--%20Key%20facts.pdf

13

https://arfv2.cdn.axa-contento-118412.eu/arfv2%2F44d8a534-cd54-45e6-8aab-f3e5614a4d01_axa_livreblanc-ia-vf-pdfinteractif.pdf

14

https://www.argusdelassurance.com/la-valorisation-de-la-donnee-dans-l-assurance/cloud-data-et-intelligence-artificielle-le-tierce-gagnant-des-assureurs.153659

12/97

En l'état, il est indéniable que le deep

learning doit conduire à une mutation profonde du modèle

assurantiel traditionnel (Partie I). En effet, si l'intelligence

artificielle peut permettre de répondre à un besoin de

création de valeur par une refonte des processus et des métiers

traditionnels, elle doit également permettre de mieux cerner les besoins

des assurés. Néanmoins, si les perspectives offertes par les

procédés d'intelligence artificielle semblent positives et

nécessaires dans un contexte où le besoin de personnalisation est

toujours plus accentué, force est de constater que le manque de

repères clairs, notamment s'agissant des règles applicables

à l'intelligence artificielle, constitue un frein à son

intégration dans le secteur (Partie II).

PARTIE I :

La refonte du modèle assurantiel

traditionnel

par l'usage des procédés

d'intelligence

artificielle

Dans son étude publiée en 201715, le cabinet

Accenture soulignait que rares sont les secteurs échappant à la

baisse de leur rentabilité et à la crainte de voir l'innovation

et leurs futurs investissements considérablement réduits.

Toutefois, le cabinet soulignait qu'il était possible d'inverser cette

tendance, la croissance pouvant être stimulée par le recours

à l'intelligence artificielle, susceptible d'accroitre la

rentabilité de 38% en moyenne. En ce sens, l'intelligence

artificielle s'inscrit comme un nouveau facteur de productivité et

d'innovation (Chapitre 1), en ce qu'elle devrait permettre

l'automatisation intelligente de la chaine de production dans de

nombreux secteurs, l'extension des capacités humaines et

l'accroissement du capital humain, ainsi que la diffusion de

l'innovation. Néanmoins, si l'intelligence artificielle porte de

nombreuses opportunités, son recours dans le secteur de

l'assurance suscite de nouvelles craintes s'agissant de sa

compatibilité avec un principe central du système : le principe

de mutualisation des risques (Chapitre 2).

13/97

15 Accenture Research, How AI boosts industry profits and

innovation, 2017

14/97

Chapitre 1 :

L'intégration de l'intelligence artificielle,

facteur

d'innovation dans le secteur de l'assurance

Le secteur de l'assurance devrait profiter du potentiel offert

par le machine learning, dont l'intégration constitue non

seulement un outil de développement opérationnel et de

culture des transversalités entre les différents métiers

(Section 1), mais également un moteur essentiel afin de

voir émerger de nouvelles activités à haute valeur

ajoutée (Section 2).

Section 1. L'intelligence artificielle, outil

de développement opérationnel et de culture des

transversalités

Utilisée dans le secteur de l'assurance, l'intelligence

artificielle devrait s'imposer comme un outil permettant le

décloisonnement et la transversalité entre les

métiers du secteur (I), mais également favoriser

l'automatisation des tâches répétitives (II)

afin de favoriser la productivité et replacer le client au

coeur du métier.

I. Le décloisonnement des métiers induit par

l'utilisation de l'intelligence artificielle

Traditionnellement, les métiers de la finance et de

l'assurance sont classés selon deux catégories selon qu'ils

soient dédiés ou non à la relation directe avec le

client.

Ainsi, le « front office » fait

référence à l'ensemble des actions, fonctions ou

tâches de l'entreprise visible par la clientèle et en contact

direct avec elle. Dans l'assurance, il s'agit donc principalement des services

clients, agences commerciales, ou encore le service communication de

l'entreprise, qui apparaissent donc en « première ligne » et

sont garants de l'image de marque de l'entreprise.

À l'inverse, le « back office

» correspond à l'ensemble des fonctions et tâches de

l'entreprise qui n'est pas visible par le client final. Ainsi peuvent

être cités les services de production et gestion des contrats, les

services de souscription, les services logistiques, les ressources humaines, ou

encore les fonctions liées à assurer le bon fonctionnement des

systèmes d'information de l'entreprise ou encore le service

indemnisation (« services sinistres »).

15/97

Toutefois, il faut souligner que la ligne entre « front

» et « back office » tend de plus en plus s'effacer dans un

contexte centré sur le client, de sorte qu'il n'existe pas de

cloisonnement strict dans la pratique. En effet, par exemple, les

chargés de sinistre interagissent de plus en plus directement avec le

client dans le cadre de la gestion de sinistre. En

réalité, cet effacement des frontières entre le «

front office » et le « back office » devrait

s'accélérer avec l'intégration des outils d'intelligence

artificielle.

En tout état de cause, le recours à

l'intelligence artificielle dans ce secteur vise deux principaux objectifs que

sont d'une part, le développement d'une approche centrée

sur le client et ses besoins en s'appuyant sur la technologie pour

proposer une relation assureur-assuré toujours plus personnalisée

et d'autre part, rendre les organisations plus agiles dans un secteur

où la concurrence entre les acteurs traditionnels est forte, et

où de nouveaux acteurs tentent de pénétrer le

marché en s'appuyant sur des modèles disruptifs fondés sur

des investissements importants en matière d'innovation, afin de proposer

des produits et services toujours plus innovants.

En ce sens, le secteur est confronté ces

dernières années à l'émergence de nouveaux acteurs

qui entendent bousculer les codes jusque-là établis de

l'assurance.

En effet, si l'inclusion des géants du

web est devenue pratique courante aux États-Unis ces

dernières années, comme en témoignent les initiatives de

Google avec sa firme d'assurance Coefficient qui se fonde sur un partenariat

stratégique avec la compagnie de réassurance Swiss Re CorSo16

afin de proposer des produits d'assurance santé ou encore l'accord entre

Amazon et la banque JPMorgan Chase visant à la création d'une

nouvelle compagnie d'assurance santé17, le secteur français

l'assurance était jusqu'à très récemment

préservé de l'inclusion des GAFAM. Néanmoins, le

partenariat conclu entre Amazon et Aviva à la fin de l'année 2018

a sonné comme un coup de grâce porté au secteur de

l'assurance français. Selon les termes de Jacques Richier, PDG d'Allianz

France, « avec la technologie, les frontières entre les secteurs

vont devenir de plus en plus floues. Certains acteurs vont venir manger des

morceaux de notre métier, notamment la relation client18 ».

16

https://www.reinsurancene.ws/googles-verily-launches-insurance-partnership-with-swiss-re/

17

https://www.insurancebusinessmag.com/ca/news/healthcare/amazon-and-google-the-next-generation-of-insurance-competition-in-canada-117644.aspx

18

https://www.argusdelassurance.com/a-la-une/assurance-amazon-menace-ou-opportunite.136979

16/97

Bien qu'il ne s'agisse pas d'une inclusion complète

d'Amazon dans l'assurance française (le partenariat conclu entre Amazon

et Aviva vise uniquement à accorder la possibilité pour les

nouveaux souscripteurs d'un contrat d'habitation ou automobile auprès

d'Aviva de pouvoir, au moment du paiement, d'entrer leurs identifiants Amazon

Pay afin de fluidifier et simplifier le parcours client19), ce mouvement

témoigne toutefois de la capacité des géants du web

à intégrer de nouveaux segments de l'économie jusqu'alors

réservés à certains acteurs.

Mais l'une des principales craintes des acteurs traditionnels

n'est pas tant l'entrée de ces géants du web, mais plutôt

le contexte dans lequel s'inscrit cette nouvelle concurrence. En effet, afin de

protéger les consommateurs, les assureurs sont tenus à des

obligations particulières en termes de solvabilité, d'obligation

d'immatriculation, ou encore d'obligations découlant du Code des

assurances. Or, l'arrivée de ces nouveaux acteurs posent une question

fondamentale : celle de la soumission de ces nouveaux acteurs au cadre

réglementaire applicable aux acteurs traditionnels du

secteur.

Outre l'inclusion des géants du web, il faut

également souligner l'émergence des assurtechs,

en référence l'ensemble des entreprises de petite ou moyenne

taille s'appuyant sur les nouvelles technologies et les activités

technologiques pour conquérir des parts sur le marché

convoité de l'assurance. L'objectif de ces sociétés est de

créer une disruption ou une rupture technologique améliorant et

simplifiant les services rendus aux assurés tout en réduisant le

prix. L'assurtech propose donc de s'appuyer sur les technologies

numériques pour créer de la valeur sur les produits en assurance

automobile, habitation, épargne-vie et autres garanties

professionnelles. Tel est le cas par exemple de la start-up Tractable qui

s'appuie sur l'intelligence artificielle pour proposer aux assureurs un

système d'évaluation des dommages et d'estimation des coûts

de réparation en temps réel en assurance automobile20 et les

évènements climatiques,21 le but étant

d'accélérer la gestion de ces sinistres. Mais on peut

également citer Luko, une néo-assurance habitation qui combine

imagerie satellite et intelligence artificielle pour déterminer les

caractéristiques principales de l'habitation. En pratique, après

avoir renseigné son adresse, le souscripteur sélectionne son

terrain, et l'intelligence artificielle se charge de détecter « la

surface du toit, la superficie du terrain, une piscine et d'autres variables22

» afin de proposer un rapport de risques, et des conseils

19

https://bonne-assurance.com/actualites/2018/11/25/doit-on-craindre-une-entree-des-geants-du-web-dans-le-monde-de-lassurance/

20

https://tractable.ai/products/vehicle-damage/

21

https://tractable.ai/products/disasters/

22

https://www.luko.eu/blog/garanties-assurance-maison-luko

17/97

personnalisés (« rappel pour élaguer des

arbres dangereux pour la toiture, alerte en cas d'incendie de forêt,

montée des eaux, etc23 »).

Il faut cependant tempérer l'idée selon laquelle

les assurtechs constituent une menace en termes de concurrence pour les acteurs

traditionnels. En effet, selon l'étude menée par le pôle

FinTech Innovation de l'Autorité de Contrôle Prudentiel et de

Résolution (ACPR) en 2018 sur la révolution numérique dans

le secteur de l'assurance24, les assurtechs ne sont en réalité

pas perçus comme des concurrents pour les acteurs traditionnels de

l'assurance française mais comme des partenaires, qui pourront leur

permettre de pouvoir tirer profit de l'intégration des nouvelles

technologies que les acteurs traditionnels ne peuvent développer

eux-mêmes en interne. On peut d'ailleurs souligner à titre

d'exemple Covéa25, qui s'appuie justement sur les services offerts par

Tractable pour les dommages causés aux véhicules26.

Quoiqu'il en soit, selon l'étude menée par le

pôle FinTech Innovation de l'Autorité de Contrôle Prudentiel

et de Résolution en 2018 sur la révolution numérique dans

le secteur de l'assurance27, l'Autorité souligne que l'intelligence

artificielle est perçue par les compagnies d'assurance comme un axe de

développement très prometteur qui, combinée avec les

optimisations de processus liées au numérique, pourrait avoir des

incidences sur les conditions de travail.

Il apparait donc nécessaire pour les acteurs

traditionnels du secteur de délaisser le fonctionnement en silos - qui

consiste à ce que chaque service de l'entreprise travaille sur ses

propres spécialités sans se soucier des activités et

contraintes des autres services - afin de favoriser approche transverse et

complémentaire des métiers et afin de pouvoir tirer parti de tout

le potentiel offert par l'intelligence artificielle.

En réalité, outre cette approche transverse et

complémentaire des métiers, l'intelligence artificielle doit

permettre une automatisation plus ou moins importante des tâches, afin de

gagner en productivité, et de concentrer l'activité autour de la

relation avec le client.

23

https://www.luko.eu/blog/garanties-assurance-maison-luko

24 Autorité de Contrôle Prudentiel et de

Résolution, Étude sur la révolution

numérique dans le secteur français de

l'assurance, n°87 - Mars 2018

25 Covéa est un groupe d'assurance mutualiste

français regroupant les marques MAAF, MMA et GMF. Pour plus de

détails :

https://www.covea.eu/fr

26

https://www.decisionatelier.com/Covea-pousse-le-digital-dans-le-cadre-de-la-gestion-de-sinistre,11306

27 Autorité de Contrôle Prudentiel et de

Résolution, Étude sur la révolution

numérique dans le secteur français de

l'assurance, n°87 - Mars 2018

II. L'optimisation opérationnelle par

l'automatisation des processus

18/97

D'un point de vue opérationnel, l'intelligence

artificielle constitue un axe majeur de développement, avec plus ou

moins d'opportunités selon les cas d'usage espérés.

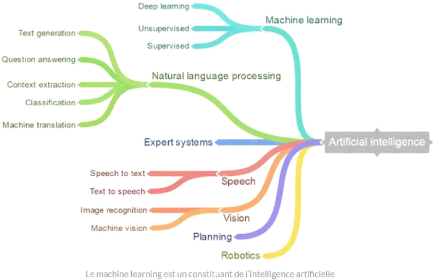

Pour rappel, l'intelligence artificielle est un terme

générique, puisqu'on compte une grande multitude de divisions,

spécialisées sur des points précis. Ainsi, le Machine

learning constitue une division de l'intelligence artificielle visant

à faire apprendre aux machines sans avoir été

préalablement programmées à cet effet. Le Machine

Learning est explicitement lié au Big Data, étant

donné que pour apprendre et se développer, les ordinateurs ont

besoin de flux de données à analyser, et sur lesquels ils peuvent

s'entraîner28. Au sein même de cette division, il existe plusieurs

variantes du machine learning, qui peut être supervisé,

non-supervisé, ou s'appuyer sur le deep learning. Le deep

learning, ou apprentissage profond, s'appuie sur un réseau de

neurones artificiels cherchant à imiter le fonctionnement du cerveau

humain, le but étant de reproduire les fonctions cognitives et

d'interprétation propres au cerveau humain afin de pouvoir proposer des

solutions pertinentes à un problème donné. En ce sens, le

deep learning a vocation à être utilisé dans de

nombreux domaines, qu'il s'agisse de la reconnaissance d'image, de la

traduction automatique, des recommandations personnalisées, des agents

conversationnels, ou encore de la prédiction financière

automatisée29.

En marge du machine learning, plusieurs divisions de

l'intelligence artificielle visent à reproduire certaines fonctions

cognitives (voir annexe 2), que sont :

- le Natural language processing, ou

traitement automatique du langage naturel

(abrégé TALN), constituant une division de

l'intelligence artificielle. Ce procédé vise à permettre

aux ordinateurs de comprendre le langage humain, dans le but de permettre aux

machines de lire, déchiffrer, comprendre et donner sens au langage

humain30.

- la voix, avec le développement des

procédés de reconnaissance automatique de la parole

visant à retranscrire la voix humaine captée via un

microphone sous la forme d'un texte exploitable par la machine (et vice

versa).

- ou encore la vision, par les procédés de

reconnaissance et l'analyse automatique d'éléments

présents dans des images ou des vidéos.

28

https://ia-data-analytics.fr/machine-learning/

29

https://www.futura-sciences.com/tech/definitions/intelligence-artificielle-deep-learning-17262/

30

https://www.lebigdata.fr/traitement-naturel-du-langage-nlp-definition

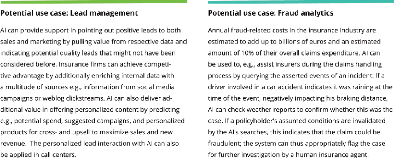

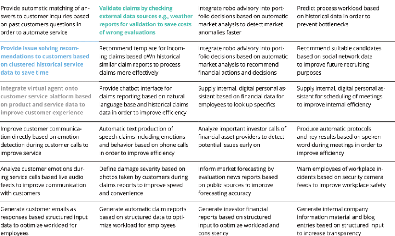

Sans reprendre de manière exhaustive tous les cas

d'usage rendus possibles par le recours aux nouveaux procédés

d'intelligence artificielle, il convient d'en rappeler les grandes lignes. En

parcourant les différents travaux existants en la matière, force

est de constater que l'intelligence artificielle entend bousculer l'ensemble

des processus de l'assurance.

D'abord, s'agissant de l'entrée en

relation, les nouveaux procédés d'intelligence

artificielle vont permettre la création de produits et d'offres plus

personnalisés, mais également permettre le développement

des assistants intelligents pour le conseil au client et la formalisation de ce

conseil. Sur ce dernier point, des initiatives existent déjà en

pratique.

En effet, le Crédit Mutuel utilise depuis 2017 les

solutions offertes en matière d'intelligence artificielle par IBM

Watson. Plus particulièrement, le système mis en place est

composé d'un assistant virtuel disponible pour chaque client afin de les

renseigner sur des interrogations précises, mais également

d'outils spécifiques à destination des chargés de

clientèle. En ce sens, une solution cognitive vise à analyser les

mails afin d'identifier et alerter le chargé de clientèle des

demandes les plus fréquentes, des demandes urgentes ou des

recommandations d'actions à mettre en place dans le suivi de la relation

client. En plus, le système propose un second outil sous la forme d'un

assistant virtuel (via des procédés de NLP) devant aider les

conseillers commerciaux dans leur recherche d'informations sur l'intranet

concernant des produits commercialisés par l'entreprise31.

Ensuite, l'intelligence artificielle doit pouvoir

répondre aux nouveaux enjeux posés par la gestion de la

relation client. En ce sens, elle doit permettre d'analyser et

orienter plus efficacement et rapidement les correspondances des

assurés, identifier et optimiser les opportunités de vente

additionnelle en fonction du contexte et du profil de l'assuré, et

identifier les signaux faibles afin de modéliser les risques de

résiliation.

En l'état, il faut souligner que c'est dans la gestion

de la relation client que les premières initiatives ont

émergé, par le recours aux chatbots, aux

procédés OCR, ou encore à l'automatisation de certaines

tâches comme les rappels automatiques ou les recommandations.

Néanmoins, le développement du machine learning et du

deep learning doit permettre de franchir une nouvelle étape

pour répondre à deux objectifs majeurs, que sont d'une part le

besoin d'une disponibilité sans cesse plus grande afin de

répondre rapidement aux demandes

19/97

31

https://www.creditmutuel.com/fr/actualites/watson-nouvelle-solution-innovante-au-service-du-reseau-et-de-la-relation-client.html

d'assurés toujours plus exigeants, et d'autre part la

recherche d'anticipation afin de détecter au plus tôt les signaux

négatifs pouvant entacher la relation entre l'assureur et son

assuré.

Mais comme le souligne le livre blanc publié par La

Fabrique d'assurance publié en novembre 201932, « depuis toujours

dans le secteur de l'assurance, le client ne découvre réellement

la valeur de son contrat qu'au moment du sinistre ». En ce sens, la phase

de gestion des sinistres est une phase particulièrement

importante dans la relation entre l'assureur et l'assuré, puisque c'est

précisément à ce moment que l'assuré mesure la

qualité du service rendu par son assureur. C'est donc naturellement dans

ce champ que l'utilisation des outils d'intelligence artificielle

présente un intérêt tout particulier. En effet, le recours

à ces nouveaux procédés doit permettre d'une part, une

optimisation du temps de gestion, en hiérarchisant et distribuant les

dossiers en fonction de leur complexité pour faciliter leur traitement.

En ce sens, l'intelligence artificielle doit permettre d'automatiser le

contrôle de certaines pièces et la gestion de certaines

prestations ne présentant pas de difficultés particulières

afin de permettre au collaborateur de se concentrer davantage sur des dossiers

plus techniques et complexes.

En l'état des avancés en la matière, le

recours à l'intelligence artificielle pourrait être

utilisée pour automatiser une partie des dossiers en assurance

automobile ou en assurance habitation. Par exemple, dans le cadre de dommages

légers sur un véhicule suite à un accident entre deux

véhicules, l'intelligence artificielle pourrait analyser les

éléments figurant sur le constat amiable, déterminer les

responsabilités au regard des règles applicables entre assureurs

et en droit commun, estimer le montant des dommages et laisser le collaborateur

proposer ensuite le montant de cette indemnité à son

assuré. Ainsi, l'assureur gagne du temps dans la gestion de sinistre,

mais économise également des frais d'expertise.

Bien entendu, il est nécessaire de distinguer entre la

théorie et la pratique. Si la théorie laisse entrevoir de belles

perspectives en la matière, la pratique nous force à les

tempérer. D'abord, l'automatisation de la gestion des dossiers ne peut

être totale. En effet, les intelligences artificielles étant

incapables de contextualiser de manière globale les choses, les dossiers

présentant une complexité et un degré d'expertise

élevés ne peuvent être délégués

à la machine. Surtout, si elle doit permettre d'optimiser la gestion des

dossiers, l'intelligence artificielle ne doit pas conduire à

éluder la relation entre l'assuré et l'assureur, puisque c'est

justement dans la phase de sinistre que cet échange est primordial.

20/97

32 La Fabrique d'assurance, Intelligence artificielle et

éthique dans le secteur de l'assurance,

livre blanc, novembre 2019

21/97

Enfin, l'intelligence artificielle présent un

intérêt particulier s'agissant la mise en

conformité et la lutte contre les formes de fraude à

l'assurance.

D'une part, le coût de la fraude à l'assurance

serait estimé à 2,5 milliards d'euros chaque année33.

Devenu un enjeu majeur dans le secteur de l'assurance, les systèmes de

détection de fraude existant actuellement peinent à les

identifier, en raison de leur manque de flexibilité et de

complexité. Or, la fraude étant par nature sous-jacente et

dynamique, l'utilisation du deep learning « peut fournir des

outils plus performants, aider à mieux cibler les opérations

douteuses ainsi qu'améliorer la découverte des nouveaux types de

fraudes34 ».

D'autre part, le secteur de l'assurance est marqué par

une réglementation abondante et contraignante. Qu'il s'agisse des

règles de solvabilité contenues dans la paquet européen

« Solvabilité », des obligations issues de la

législation en matière de lutte et d'identification des

réseaux de fraude, de blanchiment et financement du terrorisme, des

règles applicables en matière de protection des données

à caractère personnel ou encore celles relatives au droit de la

consommation, l'intelligence artificielle doit permettre d'optimiser le respect

de ce cadre. Ainsi, par exemple, l'intelligence artificielle peut être

intégrée dans des outils de collecte des données afin de

vérifier la conformité de la collecte au Règlement

général sur la protection des données (RGPD), ou encore

être intégrée dans des outils de production de rapports et

de reporting qui, en plus de rendre compte des principaux indicateurs

nécessaires à vérifier la conformité, pourrait

proposer des axes d'amélioration sur la base de l'analyse de ces

indicateurs.

En somme, si l'intelligence artificielle entend modifier tous

les processus traditionnels des organisations du secteur, elle appelle

néanmoins quelques remarques.

D'abord, l'idée générale n'est pas,

contrairement à ce que sous-tendent les thèses alarmistes sur la

question, de remplacer l'Homme dans ses diverses tâches, mais bien de

l'assister. Dans ce contexte, l'intelligence artificielle vise à

automatiser les tâches les plus répétitives afin que le

collaborateur puisse se concentrer sur les tâches plus complexes et qui

permettent de créer de la valeur.

Ensuite, l'intelligence artificielle n'est pas ce qui

déclenche la digitalisation du secteur mais constitue un facteur

d'accélération et d'automatisation qui nécessite une

approche en termes de compétences. Le métier évolue et les

acteurs doivent donc inclure une montée en compétences de leurs

collaborateurs.

33

https://www.actuia.com/contribution/jean-cupe/la-data-science-a-la-rescousse-des-assurances/

34

https://www.actuia.com/contribution/jean-cupe/la-data-science-a-la-rescousse-des-assurances/

22/97

Enfin, l'intelligence artificielle vise avant tout à

modifier une organisation jusqu'alors trop lourde, dont les strates successives

complexifient les processus décisionnels, afin de gagner en

efficacité opérationnelle et répondre au besoin

d'instantanéité et de personnalisation.

Ainsi, outre le gain de productivité que l'intelligence

artificielle promet, cette dernière doit également permettre la

réalisation d'économies d'échelle notables par

l'automatisation des tâches répétitives.

Dans ce contexte, l'intelligence artificielle s'inscrit comme

un moteur essentiel au développement de nouvelles activités

à forte valeur ajoutée centrées sur le client.

Section 2. L'intelligence artificielle,

moteur essentiel au développement de nouvelles activités à

forte valeur ajoutée centrée sur le client

Comme nous avons pu le développer dans la

précédente section, l'intelligence artificielle s'impose comme un

outil essentiel de décloisonnement des services internes à

l'entreprise, et permet en outre de cultiver la transversalité en

remettant en cause les processus existants jusqu'alors. L'assurance (et d'une

manière plus générale le tertiaire), est un secteur dans

lequel la relation avec client occupe une place centrale. Dans ce contexte,

l'intelligence artificielle vise à apporter une réponse

concrète et efficace à l'ère de la considération

(I), étant par ailleurs souligné que c'est en matière de

prévention que l'assurance est en mesure de pouvoir tirer pleinement

bénéfice de ces nouveaux procédés (II).

I. Une réponse pertinente à l'ère de la

considération

Les clients ont parfaitement intégré les

nouveaux usages induits par le numérique, changeant ainsi leurs modes de

consommation. D'une manière générale, la relation entre le

consommateur et l'assureur est caractérisée par l'utilisation de

plusieurs canaux, cumulant l'utilisation des modes de communication

traditionnels et numériques. Ainsi, par exemple, un client s'informe sur

le site web d'un assureur et/ou utilise un comparateur en ligne, puis se rend

en agence pour contractualiser, bien que la signature du contrat soit

électronique. Pour sa déclaration de sinistre, il va se rendre en

agence pour déclarer son sinistre, mais va suivre l'évolution de

son dossier sinistre par son espace client en ligne, voire converser

directement avec son conseiller sinistre par téléphone ou par

mail.

23/97

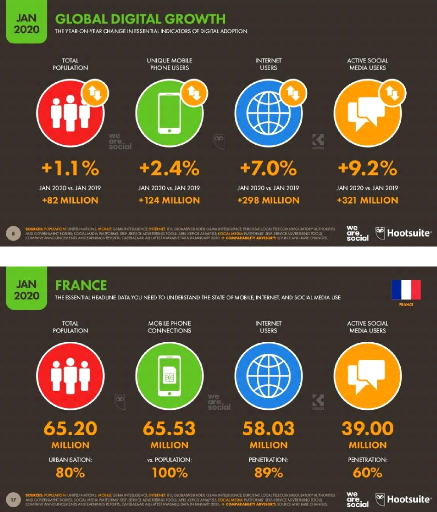

À cet égard, les dernières statistiques

rendues publiques par HootSuite sont sans appel et confirment cette tendance.

En effet, selon le dernier Digital Report pour la France35, plus de 58

millions de français sont connectés à Internet (soit 89%

de la population), et plus de 39 millions d'internautes utilisent les

réseaux sociaux. En outre, on compte 65,53 millions d'abonnements

mobile, et plus de 94% des internautes français (16-64 ans) utilisent un

téléphone portable pour se connecter à internet.

D'ailleurs, l'étude de l'ACPR sur la révolution numérique

dans le secteur français de l'assurance faisait le même constat

s'agissant de l'importance des usages mobiles.

Historiquement, le début des années 2000 a

conduit, dans le secteur de l'assurance, au passage d'une logique

centrée sur l'offre, à une logique tournée vers la

demande, plaçant ainsi le client au coeur de l'activité. Cette

tendance est la conséquence de deux évènements.

D'une part, le développement du web

2.0, qui a entrainé une utilisation massive des réseaux

sociaux, et a conduit le consommateur à s'informer par lui-même,

à comparer, mais également à s'exprimer plus librement et

en public sur les services proposés et leur qualité.

D'autre part, l'avènement du web mobile

a favorisé la convergence entre les usages traditionnels du web

et les possibilités de mobilité offertes par les nouveaux

terminaux et les évolutions techniques et technologiques successives

concernant les infrastructures réseaux. Dans ce contexte, les usages en

mobilité se sont donc développés36.

En réponse, les stratégies des entreprises du

secteur ont nécessairement dû s'adapter, afin de proposer des

offres et services répondant à ces nouveaux usages, dits

ATAWADAC. Cet acronyme, de l'anglais « anytime, anywhere, any device,

any content », décrit la capacité d'un utilisateur de

contenu ou service en situation de mobilité à se connecter et

accéder à ces contenus ou services n'importe quand, n'importe

où, et depuis n'importe quel appareil.

Surtout, dans un contexte fortement digitalisé,

globalisé, en évolution constante et sillonné de

sollicitations commerciales permanentes, l'individu cherche à être

considéré dans sa singularité. Ainsi s'est donc

développée ces dernières années une nouvelle

économie fondée sur la considération, dans

laquelle les marchés traditionnels évoluent pour intégrer

des mécanismes conversationnels entre d'une part, les entreprises et les

consommateurs, et d'autre

35

https://wearesocial.com/fr/digital-2020-france

36

http://marketing-webmobile.fr/2011/10/histoire-du-web-mobile/

24/97

part, entre les consommateurs eux-mêmes qui ont des

attentes particulières et de plus en plus fortes.

En témoigne un sondage réalisé par

OpinionWay pour Amaguiz.com37, lequel souligne que « le

développement des smartphones et des objets connectés a rendu les

Français, tous âges confondus, considérablement plus

exigeants dans la relation client ». Plus

particulièrement, 51% des répondants en attendent plus concernant

la pertinence des informations qu'ils reçoivent, 49% concernant la

disponibilité des informations, 49% s'agissant de la simplicité

des services, et 49% s'agissant de la clarté de l'information.

Surtout, l'économie de la considération

s'inscrit comme un levier de vente. À cet égard,

l'étude réalisée par le cabinet Roland Berger est assez

intéressante puisqu'elle a permis d'établir que près de 86

% des consommateurs sont prêts à payer un supplément pour

une expérience de meilleure qualité et 66 % des consommateurs

vont recommander une marque s'ils se sentent considérés par

elle38.

Dès lors, dans un secteur où l'information

constitue la matière première de toute activité, les

assureurs doivent donc revoir toute leur stratégie. Il est donc

nécessaire pour les assureurs d'intégrer ces nouveaux usages, ce

qui suppose d'optimiser à la fois la qualité de leur service mais

également l'expérience client, par une refonte complète du

parcours de l'assuré dont le modèle traditionnel semble

épuisé et inadapté. En effet, il ne s'agit pas uniquement

de maitriser le risque et sa nature dans une logique purement statistique et

historique, mais de prendre individuellement chaque assuré (et ses

besoins particuliers) en considération. À ce titre, l'enjeu est

donc aujourd'hui de connaitre intimement chaque cas particulier, afin d'une

part, de construire avec l'assuré une relation privilégiée

et d'autre part, lui proposer une solution toujours plus personnalisée,

répondant à ses besoins. Ainsi, tout l'enjeu est donc de

trouver un équilibre entre industrialisation des traitements de masse,

distribution des produits assurantiels standardisés, et

nécessité d'individualisation des réponses.

37 Amaguiz était une marque commercialisée par

Amaline, filiale du groupe Groupama, dont le modèle économique

reposait sur une offre de produits et de garanties à la carte et

modulable. Créée en 2008, Amaline distribuait ses produits

d'assurance automobile, habitation, santé, prévoyance et

chiens/chats uniquement par internet et par téléphone. Depuis le

début de l'année 2020, la marque a cessé de commercialiser

ses produits, et le portefeuille de clients a été

redistribué entre les différentes caisses régionales de

Groupama. Pour plus de détails :

https://www.groupama.com/fr/notre-modele/marques/amaguiz/

38

https://www.forbes.fr/business/comment-le-club-med-dope-ses-ventes-grace-a-la-consideration-client/

C'est donc dans ce contexte que s'inscrit

l'intelligence artificielle, qui semble pouvoir apporter une solution

concrète à un besoin de considération de plus en plus

croissant. Elle doit permettre de mieux collecter les informations

relatives aux assurés, de mieux les traiter et surtout, d'en tirer

pleinement partie afin de valoriser l'échange et la relation avec

l'assuré. Ainsi, à titre d'exemple, l'intelligence artificielle

peut adresser au conseiller clientèle des recommandations sur des

produits d'assurance spécifiques à faire souscrire à un

assuré du portefeuille sur la base des informations concernant cet

assuré, permettant d'augmenter le sentiment de considération, la

vente additionnelle, et satisfaire le devoir de conseil omniprésent dans

le secteur assurantiel.

Mais outre permettre d'apporter une réponse au besoin

de considération des clients qui se veulent de plus en plus exigeants

s'agissant du service leur étant rendu, une autre activité semble

pouvoir tirer pleinement partie de l'intelligence artificielle : la

prévention.

II. Vers une prévention augmentée par le recours

à l'intelligence artificielle

La prévention et la culture du risque ont toujours

existé dans le domaine de l'assurance. Outil de sensibilisation, mais

également indirectement de maitrise des risques, cette

activité fait partie intégrante du rôle de l'assureur

(1). À ce titre, le recours à l'intelligence

artificielle n'entend pas supprimer cette activité traditionnellement

exercée par les assureurs, mais doit permettre sa refonte en profondeur

(2).

1. La prévention et la culture du risque,

rôles traditionnels de l'assureur

Dans sa plaquette synthétique du 13 mai 201939, la

Fédération Française de l'Assurance (FFA)

présentait l'impact de l'assurance sur l'emploi, le développement

économique, l'apport social et sociétal, ainsi que la

prévention et la culture du risque. A cet égard, la

Fédération faisait le constat suivant : «

l'assurance est un métier et un secteur économique au

coeur de la vie des Français. Les assureurs accompagnent les

ménages et les entreprises au quotidien : ils les protègent face

aux aléas de la vie et développent la prévention des

risques dans leurs activités personnelles comme professionnelles. Ce

sont aussi des investisseurs, qui financent les projets des entreprises et des

collectivités sur le long terme et qui soutiennent

25/97

39 Fédération Française de l'Assurance,

L'assurance dans les territoires, 2019

26/97

la croissance. Enfin, les assureurs sont des acteurs

majeurs du développement des territoires : ils encouragent l'emploi

local, soutiennent l'attractivité économique des villes et des

régions et renforcent la cohésion sociale grâce à

leurs actions de mécénat ». En ce sens, la

prévention et la culture du risque font partie intégrante du

rôle de l'assureur, le but étant d'éviter au maximum la

survenance d'un sinistre.

Actuellement, cette activité s'exerce par

l'éducation et la sensibilisation des assurés face à

certains risques. Elle se manifeste en outre par le développement de

partenariats spécifiques et l'organisation d'évènements

autour de thématiques précises. Mais il faut également

souligner l'action de l'association Assurance Prévention, qui regroupe

les sociétés d'assurance et de réassurance

adhérentes de la Fédération Française de

l'Assurance. L'association est chargée de concevoir et déployer

des actions de sensibilisation aux risques courants, seule ou en partenariat

avec d'autres organismes. Ainsi, à titre d'exemple, pendant la

période de confinement, l'association a publié une série

de conseils pour prévenir les risques cyber, les incendies, les

accidents domestiques, les vols et les dégâts des eaux40.

En somme, si l'activité de prévention et la

culture du risque sont des activités traditionnelles des assureurs, il

faut toutefois souligner que le recours à l'intelligence artificielle

offre des perspectives quant à la manière dont cette

activité est exercée.

2. Une approche agile et personnalisée de la

prévention par le recours à l'intelligence artificielle

S'agissant de la prévention, Jean-Pierre DIGUET,

directeur assurance de la Fédération Nationale de la

Mutualité Française (FNMF) et Jean-Charles GROLLEMUND,

Président de la Commission Innovation du Centre Technique des

Institutions de Prévoyance (CTIP), soulignaient que «

l'assureur accompagne l'usager tout au long de sa vie. Il est

incontournable lors de la réalisation du risque assuré.

Grâce au déploiement de la prévention, qui apparaît

aujourd'hui dans la majorité des contrats, l'assureur devient

prescripteur voire précepteur dans un objectif de non-réalisation

des risques41 ».

40

https://www.assurance-prevention.fr/prevenir-incendies-accidents-domestiques-cambiolage-degat-des-eaux

41 La Fabrique d'assurance, Intelligence artificielle et

éthique dans le secteur de l'assurance, livre blanc,

novembre 2019

27/97

Mais tout l'enjeu est de savoir dans quelle mesure et selon

quels moyens l'intelligence artificielle entend impacter cette activité

de prévention. À cet égard, il convient d'ores et

déjà de souligner que cette transformation ne peut se

faire par le seul recours à l'intelligence artificielle. En

effet, pour qu'une approche de prévention puisse être pertinente,

elle suppose des données suffisamment précises sur

l'assuré et son environnement, ainsi que des outils de traitement de

cette information. Ainsi, pour qu'une prévention augmentée

fondée sur la personnalisation des conseils et anticipation des risques

soit possible, il est nécessaire de s'appuyer sur une combinaison de

technologies.

La première est bien entendu celle de

l'internet des objets et des objets connectés. Ces

objets, capables de capter, stocker, traiter et transmettre des données

selon la finalité à laquelle ils sont destinés, n'a

cessé de croitre ces dernières années, et la tendance est

prévue à la hausse dans les années à venir42. Cette

tendance témoigne d'un changement de paradigme : le passage d'une

ère des ordinateurs centraux, puis personnels à celle

qualifiée de web ubiquitaire, dans laquelle le traitement de

l'information a été pleinement intégré dans tous

les objets et activités journalières43. Ainsi, l'informatique et

le web deviennent invisibles, ambiants, distribués et

intégrés, permettant de capter, analyser et valoriser les

données collectées.

La deuxième concerne le développement des

outils de traitement de l'information, et plus particulièrement

ceux rendus nécessaires par le big data, dont les

données sont par nature importantes en volume, en variété

et en vitesse. Elles requièrent donc de recourir à des

technologies de stockage de l'information et de traitement particulières

afin d'assurer leur gestion et traitement en temps réel.

Dans ce contexte, il est incontestable que l'assurance puisse

profiter de la généralisation des données

générées par l'utilisation de ces objets. Par exemple,

l'émergence des offres payas-you-drive permet une

tarification personnalisée selon l'utilisation réelle du

véhicule par recours aux données de géolocalisation

transmises à l'application mobile de l'assureur. Mais dans une logique

de prévention, peuvent également se développer les

offres dites pay-how-you-drive qui visent à analyser

les habitudes et les manières de conduite, et d'adapter le montant de la

prime d'assurance en fonction. Visant clairement à valoriser les bons

comportements, un score est attribué au conducteur sur la base des

éléments recueillis et analysés. Outre la

possibilité pour l'assuré de récupérer une partie

de la prime d'assurance versée à la fin de l'année, ce

système peut, en intégrant des algorithmes d'intelligence

42

https://www.statista.com/topics/2637/internet-of-things/

43

http://dictionnaire.sensagent.leparisien.fr/Informatique%20ubiquitaire/fr-fr/

artificielle, tendre vers une meilleure prévention. En

effet, des données recueillies sur la manière de conduire, le

système peut être capable d'étudier les pistes

d'amélioration et fournir à l'assuré des conseils

pratiques pour améliorer sa conduite.

Mais si le domaine de l'assurance automobile semble

propice à cette démarche de prévention, force est

toutefois de constater que celle-ci peut également être

déclinée dans l'ensemble des branches de l'assurance. En

effet, en matière d'assurance de personne, les

données collectées par le biais par exemple des montres

connectées peuvent permettre à l'assureur de diffuser des

conseils relatifs à l'activité physique ou au sommeil. S'agissant

des personnes plus âgées, l'internet des objets

et l'intelligence artificielle peuvent, dans une logique de

complémentarité, améliorer le suivi des patients et la

prévention des maladies, ce qui permettra une prise en charge plus

personnalisée, et renforcera la qualité des soins44. Enfin, en

matière de risques industriels, et d'analyse des

risques de plusieurs sites simultanés, le recours à

l'intelligence artificielle peut permettre de réaliser une

première analyse concernant l'emplacement des sites, leur construction,

leur gestion, mais également les facteurs de

vulnérabilités, afin de proposer dans un second temps une

démarche préventive personnalisée45.

Cependant, si l'intelligence artificielle offre de belles

perspectives aux assureurs quant à la possibilité de tendre vers

une plus grande personnalisation des offres et des services proposés aux

assurés, ce mouvement de personnalisation pose toutefois la question de

la compatibilité du recours à l'intelligence artificielle avec le

principe fondamental de la mutualisation des risques.

28/97

44

https://www.innovation-mutuelle.fr/actualite/lintelligence-artificielle-une-opportunite-pour-les-

mutuelles/#:~:text=En%20effet%2C%20l'assureur%20accompagne,de%20non%20r%C3%A9alisation%20des%20risques

45

https://axaxl.com/fr/fast-fast-forward/articles/intelligence-artificielle-prevention-des-risques

29/97

Chapitre 2 :

L'impact de l'intelligence artificielle sur le principe

de

mutualisation des risques

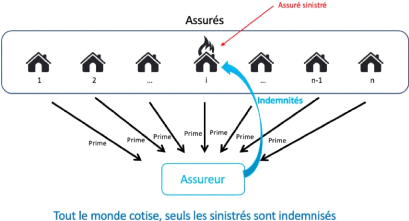

Le modèle assurantiel repose sur un mécanisme de

partage des risques. En ce sens, la mutualisation des risques, pilier

du modèle assurantiel traditionnel (Section 1) consiste

à répartir le cout de la réalisation d'un sinistre entre

les membres d'un groupe soumis potentiellement au même risque. Dans ce

contexte, l'intelligence artificielle offre de nouvelles méthodes

d'analyse des données, de sorte qu'une utilisation dans le domaine de

l'assurance permettrait de développer de nouvelles

méthodes d'analyse des risques plus précises et dynamiques

(Section 2), le but étant de pouvoir proposer une offre

segmentée et personnalisée aux souscripteurs. Néanmoins,

si le recours à l'intelligence artificielle laisse entrevoir de

nouvelles perspectives en termes d'analyse des risques, une personnalisation

des offres poussée à l'extrême laisse craindre la

disparition de la mutualisation des risques, pourtant au coeur du

fonctionnement de l'assurance (Section 3).

Section 1. L'appréhension et la mutualisation

des risques, piliers du modèle assurantiel traditionnel

Schématiquement, suivant le principe de mutualisation

des risques (qui consiste, rappelons-le, à répartir le cout de la

réalisation d'un sinistre entre les membres d'un groupe soumis

potentiellement au même risque), l'assureur collecte les primes

de tous les assurés et utilisent ce montant pour dédommager ceux

qui auront subi un sinistre (voir annexe n° 3).

Pour pouvoir fonctionner, la mutualisation suppose donc une

analyse précise des risques. En effet, en mesurant le

niveau de risque, mais aussi les conséquences et le coût des

sinistres, l'assureur peut calculer le montant optimal de la prime à

faire payer à l'ensemble des assurés. S'il se trompe et que la

prime est trop basse, il n'aura peut-être pas assez d'argent pour payer

tous les sinistres et devra en régler une partie lui-même. Si les

revenus financiers ne compensent pas cette sous-estimation des coûts,

cela peut le mettre en péril46.

46

https://openclassrooms.com/fr/courses/6172816-environnement-de-l-assurance/6418781-le-principe-de-la-mutualisation-et-le-transfert-

des-risques#:~:text=Le%20principe%20de%20mutualisation%20des,soumis%20potentiellement%20au%20m%C3%AAme%20risque.

30/97

Dans le langage commun, le risque est défini comme la

possibilité, la probabilité d'un fait, d'un

événement considéré comme un mal ou un dommage47.

Dans une logique assurantielle, la notion de risque renvoie à deux

acceptions : le « risque objet » et le «

risque évènement ».

Le risque objet fait

référence à ce qui supporte le risque

évènement. Il correspond à une chose dans

l'assurance de biens (un bâtiment, une automobile, les animaux

ou les récoltes d'une exploitation agricole, etc.), et à

une personne dans le cadre de l'assurance de responsabilité

(auteur des dommages causés à un tiers) ou de

l'assurance vie.

Le risque évènement est

l'évènement qui affecte le risque objet. Dans

cette acception, le risque renvoie à un évènement

aléatoire, c'est-à-dire un évènement futur,

incertain et qui ne dépend pas exclusivement de la volonté des

parties. Plus concrètement, il peut s'agir par exemple de la destruction

d'un bien pour une cause déterminée, du dommage causé

engageant la responsabilité civile de l'assuré, de la disparition

de la personne ou d'une atteinte à l'intégrité

physique.

Dans le cadre de ses activités, une des tâches

les plus importantes d'une compagnie d'assurance est de gérer

efficacement les risques auxquels elle s'expose en assurant des clients48. Pour

ce faire, les critères d'assurabilité d'un risque sont

traditionnellement classés en trois catégories.

La première catégorie regroupe les

critères qui relèvent de l'activité actuarielle

des compagnies, qui vise à une gestion maitrisée du

risque. Plus particulièrement, par l'utilisation des techniques

mathématiques (probabilités, statistiques), le but est

d'identifier, de modéliser et de gérer les

conséquences financières qui découlent

d'évènements incertains49. Dans cette catégorie,

l'enjeu est de pouvoir cerner avec précision l'aléa quant

à la survenance du risque évènement, l'absence de

corrélation entre les risques, les pertes maximales qui peuvent

être évaluées et couvertes. Dans ce contexte, l'approche

actuarielle vise à non seulement à déterminer la

charge moyenne de la prestation de l'assureur en cas de réalisation du

risque évènement, mais également la prime qui devra en

contrepartie être réglée par l'assuré.

47

https://www.larousse.fr/dictionnaires/francais/risque/69557?q=risque#68805

48 Jean-Philip Dumont, Gestion des risques des

compagnies d'assurance : une revue de la littérature

récente, Assurances et gestion des risques, vol. 79

(1-2), avril-juillet 2011, 43-81

49

https://euria.univ-brest.fr/menu/menu_1/Le_Metier_d_Actuaire/Qu_est-ce-qu_un_Actuaire__/

31/97

La deuxième catégorie vise à

l'analyse du risque par une vision de

marché. Pour que le risque puisse être

mutualisé, il ne suffit pas uniquement que le risque revêt les

caractéristiques classiques exposés précédemment

(évènement futur et incertain échappant à la

volonté des parties). En effet, dans une logique de marché

guidée par l'offre et la demande, il faut naturellement qu'il

émane des particuliers, entreprises ou collectivités

exposés au risque, une demande quant à la prise en charge

de ce risque par l'assureur. Ce n'est donc qu'en contrepartie de

l'existence d'une demande des personnes et organisations directement

exposées au risque que les assureurs pourront proposer une offre

corrélée au risque, c'est-à-dire une offre

adaptée aux besoins exprimés et propres à chacune des

personnes ou organisations exposée au risque.

De la même manière, l'approche actuarielle vise

à définir de manière précise le risque, le but

étant de déterminer non seulement la charge de la prestation qui

pèsera sur la compagnie d'assurance en cas de sinistre, mais

également la prime qui devra être versée par

l'assuré. Dans une logique de maitrise des coûts, le transfert du

risque à l'assurance suppose, d'une part, que la charge pesant

sur l'assureur ne soit pas disproportionnellement élevée en cas

de sinistre, et d'autre part, que la prime payée par les assurés

ne soient pas exorbitantes.

En effet, il convient de rappeler que les assureurs

sont tenus, en vertu du cadre « Solvabilité II50 », de

garantir une marge de solvabilité suffisante en fonction des

risques, le but étant pour chaque assureur et réassureur

de comprendre les risques inhérents à son activité afin de

pouvoir allouer suffisamment de capital pour les couvrir. Il est donc

nécessaire pour chaque compagnie de déterminer avec

précision le risque pris en charge, l'idée étant

de ne pas prendre en charge un risque qui aurait un impact significatif sur la

marge de solvabilité des assureurs.

50 Directive 2009/138/CE du Parlement européen et du

Conseil du 25 novembre 2009 sur l'accès aux activités de

l'assurance et de la réassurance et leur exercice (Solvabilité

II). Le texte a été transposé en droit français par

l'Ordonnance n°2015-378 du 2 avril 2015, parue au Journal Officiel du 3

avril 2015. La directive vise à harmoniser la règlementation dans

l'Union européenne, d'accroitre la transparence de la communication

financière des assureurs et de garantir leur aptitude à honorer

les engagements pris envers les personnes garanties. L'idée principale

est donc d'assureur l'adéquation entre les risques liés à

l'activité d'assurance et le capital alloué pour couvrir ces

risques. Pour y parvenir, le dispositif repose sur trois piliers :

- Les exigences quantitatives,

c'est-à-dire les règles de valorisation des actifs et des

passifs, les exigences de capital et leur mode de

calcul ;

- Les exigences qualitatives,

c'est-à-dire les règles de gouvernance et de gestion des risques,

ainsi que les règles relatives à l'audit

(évaluation propre des risques de la solvabilité)

;

- Les informations à destination du public et des

autorités de contrôles. La directive harmonise à

cette fin les éléments qui doivent être

communiquées au public et aux autorités de

contrôle prudentielle. En France, l'Autorité de Contrôle

Prudentielle et de Résolution (ACPR), autorité adossée

à la Banque de France, est en charge de l'agrément et de la

surveillance des établissements bancaires, d'assurance et leurs

intermédiaires.

Par ailleurs, pour que ce risque puisse faire l'objet d'un

transfert à l'assureur, encore faut-il que le coût de la prime

soit raisonnable pour chacun des assurés. Cela suppose

dès lors que la prime soit jugée abordable par les prospects au

regard de la couverture offerte pour que ce risque soit transféré

à l'assurance.

Enfin, la prestation d'assurance est

matérialisée par la conclusion d'un contrat entre l'assureur et

l'assuré. Ce contrat, bien qu'il soit spécifique, est soumis aux

règles classiques du droit des contrats, qui suppose notamment que

l'objet et la cause soient licites. Ainsi, du fait de l'existence de certaines

restrictions légales à la couverture de certains risques, il est

donc vital pour une compagnie d'assurance de prendre en

considération des dispositions règlementaires en vigueur lors de

l'étude de l'assurabilité d'un risque.

C'est dans ce contexte que l'assurance peut donc profiter des

possibilités offertes par l'intelligence artificielle afin de

procéder à une analyse plus précise et surtout plus

dynamique des risques.

Section 2. L'usage de l'intelligence

artificielle, méthode d'analyse du risque plus précise et

dynamique

Le cabinet McKinsey&Company s'est intéressé

dans son rapport51 aux impacts de l'intégration du machine

learning dans douze secteurs d'activités clés de

l'économie. Ainsi, s'agissant du secteur de la finance, l'étude

conclut que le principal avantage procuré par l'utilisation de

l'intelligence artificielle est la personnalisation des produits et services,

ainsi que l'évaluation des risques. Dans ce contexte,

l'intelligence artificielle s'impose comme une réponse efficace

aux risques émergents et complexes (I) et vise à

corriger l'asymétrie d'information prévalant jusqu'alors dans les

rapports entre l'assuré et l'assureur (II).

I. Le recours à l'intelligence artificielle en

réponse aux risques émergents et complexes

32/97

51 McKinsey Global Institue, The age of analytics :

competing in a data-driven world, décembre 2016

33/97

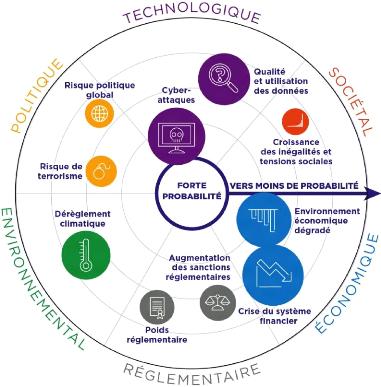

Avant de s'intéresser à la manière dont

l'intelligence artificielle entend révolutionner l'étude des

risques, il faut nécessairement s'intéresser au contexte. Sur ce

point, il faut d'ores-déjà souligner l'existence de deux

tendances.

D'une part, les assurés, qu'il s'agisse des

particuliers, collectivités territoriales ou encore des entreprises,

sont confrontés à des risques de plus en plus complexes

ou nouveaux, qui par nature faussent la loi des nombres sur laquelle

repose la logique assurantielle. En effet, pour estimer son tarif, un assureur

se fonde sur des statistiques tant internes qu'externes. Toutefois, si l'on

prend l'exemple d'un évènement climatique catastrophique, la

logique statistique n'a plus de sens pour un phénomène qui par

nature est rare et dérogatoire. De même, l'émergence de

nouveaux risques, comme le risque cyber, sont par nature dynamique et

corrélé, rendant très complexe l'analyse du risque sur la

base de simples données statistiques. Surtout, du fait de leur

complexité, il est difficile pour les compagnies de déterminer

avec précision la charge des sinistres pouvant en découler, et

qui dès lors peuvent potentiellement coûter très cher aux

assureurs et réassureurs52.

D'autre part, comme nous l'évoquions

précédemment, la société est devenue, du fait du

développement du numérique, de plus en plus connectée,

produisant par voie de conséquence un nombre toujours plus important de

données. L'entrée dans l'ère du web ubiquitaire

a permis le développement des usages mobiles et la

généralisation des objets connectés, dont la tendance

devrait s'accentuer ces prochaines années. De ce constat, les

données collectées sont également de plus en qualitatives

et précises, ce qui en fait une opportunité de taille en termes

de valorisation de ces données. Couplé à l'intelligence

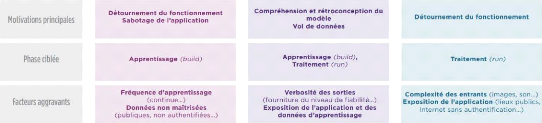

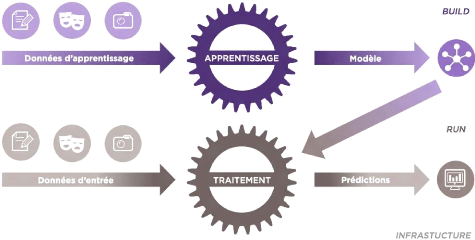

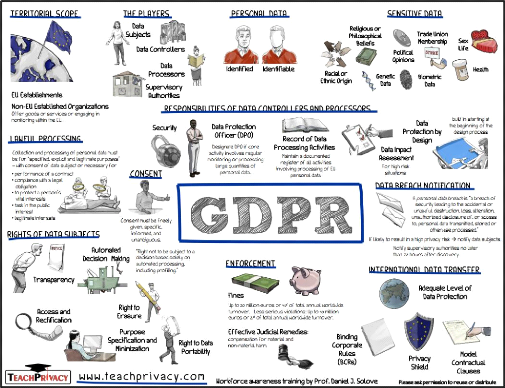

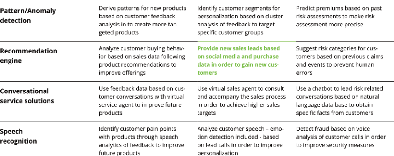

artificielle, les assureurs pourront avoir une meilleure compréhension