Institut Africain d'Informatique

Etablissement Inter - Etats d'Enseignement Supérieur

BP 2263 Libreville (Gabon) Tél. (241) 077 70 55 00 - 077

70 56 00

Site web:

www.iaisiege.org E-mail:

contact@iaisiege.org

Mémoire de fin d'études

En vue de l'obtention du

Diplôme d'Ingénieur

Informaticien

Thème :

EVALUATION DE LA DYNAMIQUE SPATIO-TEMPORELLE DE L'EVOLUTION DE

LA COVID A LIBREVILLE PAR UNE APPROCHE MACHINE LEARNING

|

Réalisé et soutenu le 30 juin 20222 par

RAMADANE BAKARI

|

Jury

Président du jury :Pr

KOUSSOUBE, maitre de conférences. Enseignant permanant à

l'IAI.

Superviseur : M. GUIFO Donacien

Ingénieur Informaticien. Enseignant permanant à l'IAI.

Maître de Stage : Dr. Marius

MASSALA Enseignant Chercheur au LAIMA.

Maître de Stage : Dr. Pierre

MOUKELI Enseignant Chercheur au LAIMA.

Membre : M. Brice ONDJIBOU

Ingénieur Informaticien Enseignant vacataire à IAI.

Rapporteur : M. MATY MAMAN

Ingénieur Informaticien. Enseignant permanant à l'IAI.

Année académique : 2020-

2021

DEDICACE

À la mémoire des 6 millions de morts, victimes

de la pandémie de la covid-19.

À tous les soldats camerounais, tombés sur les

champs d'honneur pour la défense de la patrie, contre les terroristes de

BOKO HARAM et les terroristes sécessionnistes du NOSO.

Au feu : gendarme-Major DAMO DJOMMAILA, tombé les

armes à la main, le 2 juin 2018, en mission commandée, dans le

cadre de la sécurisation des régions du Nord-Ouest et du

Sud-Ouest, en proie aux attaques des terroristes sécessionnistes du

NOSO.

EPIGRAPHE

« Si j'avais une heure pour sauver le monde, je passerais

cinquante-neuf minutes à définir le problème et une

minute à trouver la solution ».

Albert Einstein

REMERCIEMENTS

Nous adressons nos sincères remerciements à

toutes les personnes qui, ont contribué à la réalisation

de ce travail. Nous remercions de façon toute particulière :

· M. EKOMY Clément Achille, le Coordonnateur de

l'IAI, pour le cadre offert afin que cette formation puisse bien suivre son

cours.

· M. GUIFO Donacien, enseignant permanent à l'IAI,

notre superviseur IAI, pour l'excellent suivi du travail ainsi que ses

remarques et suggestions très pertinentes ;

· DR MOUKELI Pierre, enseignant Chercheur au LAIMA, notre

maître de stage au LAIMA, pour l'excellent suivi du travail ainsi que ses

remarques et suggestions très pertinentes ;

· M. MASSALA Marius, enseignant Chercheur au LAIMA, notre

maître de stage au LAIMA, pour l'excellent suivi du travail ainsi que ses

remarques et suggestions très pertinentes ;

· Le corps administratif et enseignant de l'IAI pour leur

encadrement tout au long de notre formation ;

· Tous nos camarades de promotions et toute la

communauté estudiantine de l'IAI .

AVANT-PROPOS

L'Institut Africain d'Informatique créé le 29

janvier 1971 à FORT-LAMY, ancien nom de la capitale politique de la

République du TCHAD, dans le cadre du renforcement de la

solidarité l'unité africaine est une école

inter-état d'enseignement supérieur. L'IAI comprend cinq

(5) filières : Licence, Analystes programmeurs, Maitrise en Informatique

Appliquée à la Gestion des Entreprises (MIAGE), Master et

Ingénieur.

Cette école de renommée internationale,

intègre dans le cursus de formation des ingénieurs de conception

en informatique, en fin de cycle, un stage de formation pratique d'une

durée de 5 (cinq) mois en entreprise ou dans un laboratoire de

recherche. Ce stage de fin d'études vise à mettre les

élèves ingénieurs dans un environnement pratique afin de

leur permettre une intégration en milieu professionnel plus

aisée.

Le présent document constitue donc l'aboutissement de

trois (3) années de formation à l'Institut Africain

d'Informatique de Libreville et cinq (5) mois de stage de recherche

effectué au sein du Laboratoire Africain d'Informatique et de

Mathématiques Appliquées. Il tient lieu de mémoire de fin

de formation d'ingénieurs de conception en Informatique et s'intitule

: « Évaluation de la dynamique spatio-temporelle de

l'évolution de la Covid-19 à Libreville : par une approche

Machine Learning »

RESUME

La crise de la covid-19 a rapidement dépassé le

domaine strictement médical pour impacter l'ensemble des secteurs

d'activités. Le système « Gabon » a été

soumis à une série de chocs majeurs successifs : une crise

sanitaire, suivie d'une crise économique. Relever le défi de la

santé dans un environnement fortement perturbé s'est

imposé aux autorités de santé publique : comprendre le

présent, anticiper le futur, comprendre les leviers d'actions possibles,

étudier des scenarii sont devenus des éléments clés

pour les décideurs. Les prévisions spatio-temporelles des

maladies infectieuses passent rapidement au premier plan des politiques et des

réponses de santé publique en raison de leur rôle

clé dans les stratégies d'atténuation des risques. La

modélisation et la simulation ont ainsi acquis une nouvelle

visibilité liée à ces nouvelles exigences. Mais

très vite des limitations sont apparues dans la seule prise en compte de

la dynamique temporelle de l'épidémie. D'autres facteurs se sont

révélés essentiels : la dimension géographique ou

spatiale. En raison de la complexité du problème

épidémiologique et de la disponibilité des données,

le Machine Learning a récemment attiré l'attention pour la

construction de modèles de prédiction d'épidémie.

Les approches Machine Learning visent à développer des

modèles avec une plus grande capacité de

généralisation et une plus grande fiabilité de

prédiction pour des délais plus longs.

La finalité de ce mémoire est d'explorer

l'application du Machine Learning pour modéliser la pandémie de

la COVID-19. Ainsi il est question d'une part de développer un

modèle de régression, basé sur l'algorithme de «

Facebook Prophet » pour prédire la dynamique temporelle de

l'épidémie dans la ville de Libreville. Ensuite de

développer un modèle de clustering, base sur l'algorithme K-means

et le système d'information géographiques(SIG), pour

déterminer les clusters à risques à l'échelle

d'arrondissements et à l'échelle de quartier. Enfin de concevoir

un tableau de bord intelligent de suivi de la dynamique spatio-temporelle d'une

épidémie

Mots-clés : Covid-19- le machine learning - Facebook

Prophet - K-means - SIG - Cluster - modélisation .

ABSTRACT

The covid-19 crisis quickly went beyond the strictly medical

field to impact all sectors of activity. The "Gabon" system was subjected to a

series of successive major shocks: a health crisis, followed by an economic

crisis. The public health authorities had to take up the challenge of health in

a highly disrupted environment: understanding the present, anticipating the

future, understanding the possible levers of action, and studying scenarios

have become key elements for decision-makers. Modelling and simulation have

thus acquired a new visibility linked to these needs. However, limitations have

appeared in the sole consideration of the dynamics of the epidemic. Other

factors have proved essential: the geographical or spatial dimension. Machine

learning approaches aim to develop models with greater generalisation

capability and prediction reliability for longer time frames.

The aim of this thesis is to explore the application of

Machine Learning to model the COVID-19 pandemic. The aim is to develop a

regression model, based on the "Facebook Prophet" algorithm, to predict the

temporal dynamics of the epidemic in the city of Libreville. Secondly, to

develop a clustering model, based on the K-means algorithm and the geographic

information system (GIS), to determine the risk clusters at the district and

neighbourhood levels. Finally, using an inductive approach, we generalise the

results obtained to all the communes of Libreville, based on data collected at

the University Hospital of Libreville.

Key words: Covid-19- machine learning - Facebook Prophet -

K-means - GIS - Cluster - modelling - simulation- Moran's autocorrelation

test.

SOMMAIRE

DEDICACE

I

EPIGRAPHE

II

REMERCIEMENTS

III

AVANT-PROPOS

IV

RESUME

V

ABSTRACT

VI

SOMMAIRE

VII

TABLE DES ILLUSTRATIONS

VIII

LISTE DES TABLEAUX

X

LISTE DES SIGLES ET ABREVIATIONS

XI

INTRODUCTION GENERALE

1

PREMIERE PARTIE : CONTEXTE GENERAL DE L'ETUDE

2

A. CHAPITRE I : PRESENTATION DE LA STRUCTURE

D'ACCUEIL ET DU SUJET D'ETUDE

3

B. CHAPITRE II : CONCEPTS LIÉS A LA

DYNAMIQUE D'UNE EPIDEMIE

6

C. CHAPITRE III : ETAT DE L'ART DE LA

MODELISATION DES EPIDEMIES

14

DEUXIEME PARTIE : MODELISATION DE LA COVID-19 PAR

UNE APPROCHE MACHINE LEARNING

19

D. CHAPITRE IV : PRESENTATION DU MACHINE

LEARNING

20

E. Chapitre V : démarche Machine

Learning pour la modélisation

25

F. CHAPITRE VI: l'étude de

l'algorithme facebook prophet et conception du modèle de

prédiction

35

TROISIEME PARTIE : REALISATION DU SIMULATEUR

EVAL_EPI

40

G. Chapitre VI : MÉTHODOLOGIE DE

DÉVELOPPEMENT

41

H. Chapitre VII : MISE EN OEUVRE DE LA

SOLUTION

46

QUATRIEME PARTIE : FINALISATION DE LA SOLUTION

66

I. Chapitre VIII : IMPLEMENTATION ET

RESULTATS

67

J. CHAPITRE IX : GESTION DE PROJET ET

BILAN

74

CONCLUSION GÉNÉRALE

78

RÉFÉRENCES BIBLIOGRAPHIQUES

79

ANNEXES

82

TABLE DES ILLUSTRATIONS

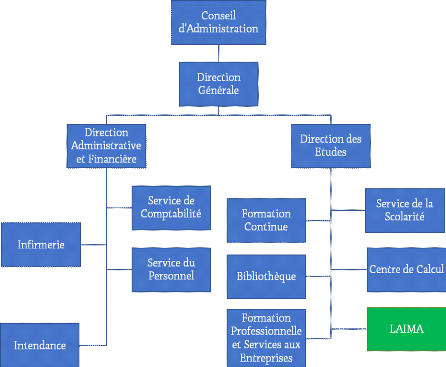

Figure 1: Organigramme de l'IAI

2

Figure 2 : la dynamique d'une

épidémie selon le modèle SIR

9

Figure 3: Dynamique temporelle du

modèle SIR, Source: (Avhad, 2020)

9

Figure 4 : Cartographie des cas actif au

Gabon au 17 fevrier 2022 au 19 mai 2022 (COPIL, 2022)

14

Figure 5: diagramme du modèle SEAIRD

(MATONDO MANANGA, 2021)

15

Figure 6: Représentation graphique des

éléments de RdP

16

Figure 7: modèle SVEIR-RDP de LAIMA

17

Figure 8 : Représentation

imagée d'un agent en interaction avec son environnement et les autres

agents, (Ferber, 1995)

18

Figure 9 : Diagramme de classe des

entités COMOKIT (Taillandier, Drogoul, & Gaudou, 2020)

19

figure 10 : branches de l'intelligence

artificielle, (Mohammed, 2019)

22

Figure 11 : cycle de vie du processus

KDD, source : (Swamynathan, 2017)

28

Figure 12 : méthode CRISP-DM,

adapté de (Shearer, 2000)

29

Figure 13 : Capture d'écran des cas

de guérison dans le monde (partiellement)

31

Figure 14 extraction des lignes et colonnes

32

Figure 15 les captures d'écran du

dataset avant et après le nettoyage

33

Figure 16 : partitionnement des données

en données d'entrainement et données de test

33

Figure 17 : les courbes de nombre

cumulés de cas de guérison à Libreville avant et

après le prétraitement

34

Figure 18 : Courbe d'apprentissage du

modèle

40

Figure 19 : code pour tester la

performance du modèle

41

Figure 20 : la courbe de comparaison entre

les valeurs réelles et les valeurs prédites

41

Figure 21 : la schématisation en Y

utilisée pour représenter la méthode de

développement 2TUP, source : Bassim, K.A. et Akaria, R., 2007

45

Figure 22: Les diagrammes d'UML (UMLversion

1.5), source : (Guiochet, 2009)

47

Figure 23 : Diagramme global de cas

d'utilisation

51

Figure 24:Diagramme de cas d'utilisation -

gérer les utilisateurs.

51

Figure 25: Diagramme de cas d'utilisation

« gestion des données »

52

Figure 26 : Diagramme de cas d'utilisation

«Gestion du prétraitement des données »

52

Figure 27 : Diagramme de cas d'utilisation

- Simuler la dynamique spatio-temporelle

53

Figure 28 : Diagramme de cas d'utilisation

- Gérer les indicateurs épidémiologiques.

53

Figure 29: Diagramme de cas d'utilisation -

Gérer des modèles de simulation

54

Figure 30 : Diagramme de cas d'utilisation

- gérer une visualisation

55

Figure 31: diagramme d'activités du cas

d'utilisation «charger les données »

56

Figure 32 : diagramme d'activités

du cas d'utilisation « gestion du prétraitement »

56

Figure 33: diagramme d'activités du cas

d'utilisation «simuler la dynamique épidémique »

57

Figure 34:diagramme d'activités du cas

d'utilisation « calculer un indicateur »

58

Figure 35 : diagramme d'activités

du cas d'utilisation « Visualiser un indicateur »

58

Figure 36 : diagramme d'activités

du cas d'utilisation «ajouter un indicateur»

59

Figure 37 : diagramme d'activités

du cas d'utilisation « modifier un indicateur»

60

Figure 38 : Diagramme de classes

61

Figure 39 : Architecture applicative de

notre solution. (EVAL_EPI)

62

Figure 40 : Architecture logicielle de

notre solution.

65

Figure 41 : Le prototype

général du simulateur EVAL_EPI

66

Figure 42 : Architecture physique de notre

solution.

67

Figure 43 - Interface de RStudio sous

Windows

73

Figure 44- Diagramme de déploiement.

74

Figure 45 : Page d'accueil du logiciel

« EVAL_EPI ».

74

Figure 46 : Capture d'écran d'une

simulation de la dynamique temporelle

75

Figure 47 : Capture d'écran d'une

simulation de la dynamique temporelle

75

LISTE DES TABLEAUX

Tableau 1 : Valeurs des Ro de quelques

maladies et de leur couverture vaccinale v

2

Tableau 2: Etapes du KDD

27

Tableau 3 : récapitulatif des

phases du processus CRISP-DM.

28

Tableau 4 : résumé des

questionnements qui facilitent la compréhension du métier

30

Tableau 5 : description des

données

31

Tableau 6 : récapitulatif des

proportions des valeurs manquantes dans les data set

32

Tableau 7: comparaison de modèle de

Machine Learning la prédiction des séries temporelles

34

Tableau 8 : Performances de Prophet et de ARIMA

selon la metrique R2-score

35

Tableau 9:récapitulatif des

paramètres de performance de prévision

36

Tableau 10 : exemple de réglage des

hyper paramètres du modèle Facebook prophet

39

Tableau 11: gestion de projet suivie le

processus agile ou le processus unifié

44

Tableau 12 : Package des classes de la

simulation de la dynamique d'une épidémie

60

Tableau 13 : Package des classes de la

visualisation des indicateurs épidémiologique

60

Tableau 14: comparaison du MVC et du MVT

63

Tableau 15 : comparaison des

caractéristiques de R et python

69

Tableau 16:comparaison de performance de R et

Python

69

Tableau 17 : outils de stockage et de

manipulation des données

70

Tableau 18 : Les bibliothèques

spécialisées sur la covid-19

70

Tableau 19 : Les bibliothèques

spécialisées sur le Machine Learning

71

Tableau 20 : Les bibliothèques de

manipulation des données geospatiale

71

Tableau 21 : outils

d'implémentation de l'interface graphique

72

Tableau 22 : Découpage du projet en

étapes

77

Tableau 23:récapitulatif des coûts

des charges du projet

77

LISTE DES SIGLES ET

ABREVIATIONS

|

2TUP

|

Two Track Unified Process

|

|

ABM

|

Agent Base Modeling

|

|

CAH

|

Classification Ascendant Hierarchique

|

|

CHUL

|

Centre Hospitalier et Universitaire de Libreville

|

|

COPIL

|

Comité de Pilotage

|

|

COVID-19

|

Corona Virus Desease 2019

|

|

CRISP-DM

|

Cross Industry Standard Process for Data Mining

|

|

DAO

|

Data Access Object

|

|

DBSCAN

|

Density-Based Spatial Clustering of Applications with Noise

|

|

HTML

|

HyperText Markup Language

|

|

HTML

|

HyperText Markup Language

|

|

HTTP

|

Hypertext Transfer Protocol

|

|

IAI

|

Institut Africain d'Informatique

|

|

JHU CSSE

|

Center for Systems Science and Engineering (CSSE)

at Johns Hopkins University

|

|

KDD

|

Knowledge Discovery in Databases

|

|

LAIMA

|

Laboratoire Africain d'Informatique et de Mathématiques

Appliquées

|

|

MVC

|

Modèle-Vue-Contrôleur

|

|

MVT

|

Modèle-Vue-Template

|

|

OMS

|

Organisation Mondiale de la Santé

|

|

PAM

|

Partitionnement Autour des Medoides

|

|

R0

|

Taux de reproduction de base

|

|

RdP

|

Réseau de Pétri

|

|

SARCOV2

|

Severe Acute Respiratory Syndrome Coronavirus 2

|

|

SIG

|

Système d'Information Géographique

|

|

UML

|

Unified Modeling Language

|

|

UP

|

Unified Process

|

INTRODUCTION GENERALE

La pandémie de la covid-19 semble avoir pris de court

la plupart des autorités politiques et sanitaires. Ceci en raison de la

rapidité de la diffusion du virus et de la nécessité de

contrôler l'épidémie, par des mesures de confinement

strict, sans équivalent en temps de paix à une échelle

planétaire. Plus de deux ans après que la COVID-19 a

été identifiée pour la première fois, les

gouvernements continuent d'être confrontés à un besoin

urgent de compréhension du paysage pandémique en

évolution rapide. Par conséquent, une évaluation

précise de la dynamique spatio-temporelle de la COVID-19 devient

cruciale dans une telle situation.

En raison de la complexité du problème

épidémiologique et de la disponibilité des données,

le Machine Learning a récemment attiré l'attention pour la

construction de modèles de prédiction d'épidémie.

Les approches Machine Learning visent à développer des

modèles avec une plus grande capacité de

généralisation et une plus grande fiabilité de

prédiction pour des délais plus longs. Ainsi il est donc possible

d'utiliser le SIG et le Machine Learning pour aider à atténuer

l'épidémie grâce à la masse des données

collectées sur la Covid-19. Ceci en trouvant des corrélations

spatiales avec d'autres variables sociodémographiques et afin

d'identifier la dynamique spatio-temporelle de transmission de la Covid-19

à Libreville. C'est dans cette optique que ce projet nous a

été confié, afin de développer un modèle

épidémiologique permettant d'analyser la propagation de

l'épidémie dans sa dimension spatio-temporelle, notamment

à l'aide de technique de machine Learning, auxquelles, on associe les

méthodes de système d'information géographique et des

méthodes d'analyse spatiale.

Dans ce mémoire, Il sera question d'abord de

présenter l'environnement de travail en décrivant la structure

d'accueil, ainsi que le projet qui nous a été confié, son

intérêt et les notions y afférentes, suivi d'une

étude sur les modèles épidémiologiques existants et

de la démarche Machine Learning adoptée. Ceci dans la

perspective de proposer un modèle de régression et un

modèle de clustering. Ensuite d'implémenter ces modèles

dans une plateforme web. Ceci dans l'optique de pouvoir faire des

prédictions d'une part sur le nombre de cas de la maladie de la

covid-19 à Libreville. Et d'autre part de déterminer les foyers

épidémiques à risque dans la commune de Libreville.

PREMIERE PARTIE : CONTEXTE

GENERAL DE L'ETUDE

CHAPITRE I : PRESENTATION

DE LA STRUCTURE D'ACCUEIL ET DU SUJET D'ETUDE

Dans ce chapitre, nous présentons d'une part la

structure d'accueil dans laquelle nous avons effectué le stage, d'autre

part ensuite le projet qui nous a été soumis, son utilité,

ses objectifs et la problématique qu'il soulève.

1. Structure d'accueil : le LAIMA

Nous présenterons ici d'abord l'historique du LAIMA,

puis ses missions et enfin l'organigramme de l'Institut Africain d'Informatique

(IAI).

a) Historique du LAIMA

L'Institut Africain d'Informatique (IAI) est une école

inter-état dont le siège est à Libreville au Gabon.

Créée en 1971 à Fort-Lamy (actuel N'Djamena) au Tchad par

plusieurs chefs d'États Africain. L'IAI a à sa tête une

Direction Générale, qui supervise trois directions qui sont :

la Direction des Enseignements, la Direction Administrative et

Financière. L'IAI possède en son sein un Laboratoire Africain

d'Informatique et de Mathématiques Appliquées (LAIMA)

placé sous la Direction de l'étude (DE).

b) Missions du LAIMA

Le LAIMA assure la recherche dans les domaines de

l'informatique et des Mathématiques Appliquées. Ses axes de

recherche sont entre autres : la conception du système d'information,

l'Intelligence artificielle, le Calcul scientifique, l'Optimisation et

l'Informatique décisionnelle... .

c) Structure organisationnelle de L'Institut Africain

d'Informatique (IAI)

L'organigramme de l'Institut Africain d'Informatique se

présente comme suit (figure 1) :

Figure 1: Organigramme de

l'IAI

2. Présentation du sujet et de son

intérêt

a) Contexte du sujet

Le 30 janvier 2020, le Comité d'urgence du

Règlement sanitaire international de l'Organisation Mondiale de la

Santé (OMS) a déclaré l'épidémie de la

maladie appelé COVID-19, comme une "urgence de santé publique de

portée internationale". Le coronavirus, virus responsable de la COVID-19

s'est propagé à tous les continents, devenant une crise de

santé publique sans précédent. A la date du 05 mai 2022,

le Comité de pilotage du plan de veille et de lutte contre la

pandémie à coronavirus au Gabon (COPIL) a fait état d'un

total de plus trois cents décès et de près de

quarante-huit mille cas confirmés sur le territoire Gabonais.Afin de

maitriser et de surveiller la dynamique de propagation de cette

épidémie, il convient de l'analyser dans sa dimension

spatio-temporelle, notamment à l'aide d'un système d'information

géo-référencé, prédictif et intelligent.

b) Problématique

La crise sanitaire causée par la covid-19, a contraint

les décideurs à agir dans l'urgence. Le COVID-19 est un

défi pour l'humanité à bien des égards. Son impact

est destructeur non seulement pour les vies humaines mais aussi pour le

fonctionnement de divers secteurs de la sphère économique et

sociale.

Il est nécessaire de prévoir la propagation de

la maladie pour développer des stratégies de réponse

efficacesau niveau local. Les épidémies locales pourraient

submerger les systèmes de santé publique, les hôpitaux et

les salles d'urgence. Ainsi, les décideurs se tournent vers les

scientifiques, avec cette problématique : quelle est la technologie la

plus adaptée pour suivre, décrire et prédire de la

dynamique spatio-temporelle de l'épidémie de la covid-19 ?

c) Objectifs

A partir des données collectées au CHUL et au

COPIL, Il est question dans ce mémoire :

ï D'abord de proposer un premier modèle de

Machine Learning pour la prédiction du nombre de cas de la maladie de

la covid-19 à Libreville,

ï Ensuite de proposer un deuxième modèle

de Machine Learning pour la détermination des clusters à

l'échelle d'arrondissement ou de quartier à Libreville

ï Enfin de concevoir un simulateur, implémentant

les modèles proposées, et qui permet de suivre et de

prédire l'évolution de la dynamique spatio-temporelle de

l'épidémie de la covid-19 à Libreville.

CHAPITRE II : CONCEPTS

LIÉS A LA DYNAMIQUE D'UNE EPIDEMIE

Il est question dans ce chapitre de

présenterbrièvement le domaine de l'épidémiologie,

puis d'expliciter la notion de dynamique spatio-temporelle.

3. Définitions, méthodes et principes en

épidémiologie

Pour comprendre le domaine de l'épidémiologie,

nous allons exposer tour à tour, la définition de quelques

notions de base, les principes en épidémiologie, les

méthodes et les outils, enfin l'analyse et la maitrise des

épidémiologies.

a) Quelques notions de base

· L'Organisation mondiale de la santé (OMS) a

défini en 1968 l'épidémiologie comme

« une étude de la distribution des maladies et des

invalidités dans les populations humaines, ainsi que des

déterminants qui déterminent cette distribution ».

· Une maladie transmissible ou

infectieuse est une maladie provoquée par la transmission d'un germe

pathogène à un hôte sensible. Les agents infectieux peuvent

être transmis à l'homme :

o directement à partir d'autres personnes

infectés ou,

o indirectement par l'intermédiaire de vecteurs, de

particules en suspension dans l'air ou d'autres supports.

· Foyer épidémique : en

épidémiologie, un foyer épidémique ou un

agrégat spatial ou «cluster» peut être défini

comme un regroupement des cas géographiquement proches, de taille et de

concentration suffisante pour qu'il y ait peu de chance qu'il soit uniquement

dû, au hasard. La détection de tels groupements permet

d'identifier les zones à risque et de dégager des

hypothèses sur la transmission de la maladie.(Guégan, 2009)

b) Principes en épidémiologie

Les termes clés de cette définition

reflètent certains des principes importants de

l'épidémiologie. A savoir : le principe d'étude, le

principe de distribution, et le principe de déterminants

· Principe d'étude :

l'épidémiologie est une discipline scientifique fondée sur

de solides méthodes d'enquête scientifique.

L'épidémiologie est axée sur les données et repose

sur une approche systématique et impartiale de la collecte, de l'analyse

et de l'interprétation des données. L'épidémiologie

s'appuie également sur des méthodes d'autres domaines

scientifiques, notamment la biostatistique et l'informatique.

· Principe de

distribution : l'épidémiologie

s'intéresse à la fréquence et au schéma des

événements de santé dans une population.

· Principe de déterminants :

l'épidémiologie est également utilisée pour

rechercher des déterminants, qui sont les causes et d'autres facteurs

qui influencent l'apparition de maladies et d'autres événements

liés à la santé.

c) Méthodes et outil en

épidémiologie

Il existe en épidémiologie plusieurs

méthodes et outil pour l'Analyse et maîtrise des

épidémies

(1) Outils utilisés en

épidémiologie

Les outils les plus utilisés pour caractériser

l'épidémie sont : la courbe, la carte des points et les

Indicateurs épidémiologiques.

· La courbe

épidémique :c'est un outil important pour

l'investigation de la maladie. Dans la courbe épidémique, la

distribution des cas est tracée sur le temps, généralement

sous forme d'histogramme, avec la date d'apparition des cas sur l'axe

horizontal, et le nombre de cas correspondant à chaque date d'apparition

sur l'axe vertical.

· La carte des points : c'est une

carte de la localité où l'épidémie s'est produite,

sur laquelle l'emplacement des cas est tracé. La carte des points est

souvent utile pour détecter la source d'une épidémie.

(2) Indicateurs

épidémiologiques :

Plusieurs mesures de la fréquence d'une maladie reposent

sur les notions fondamentales de prévalence et d'incidence.

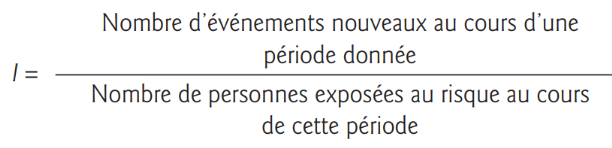

Incidence : fait référence

à la vitesse avec laquelle de nouveaux événements se

produisent dans une population. L'incidence (I) se calcule au moyen de la

formule suivante :

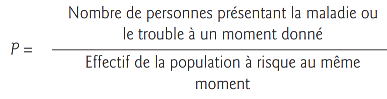

Prévalence :correspond au nombre

de cas observés dans une population déterminée à un

moment donné. La prévalence (P) d'une maladie se calcule au moyen

de la formule suivante :

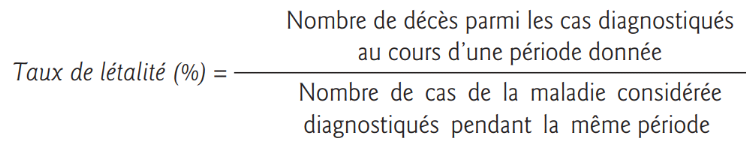

Taux de létalité : permet

d'apprécier la gravité d'une maladie et se définit comme

la proportion des cas d'une maladie ou d'une infection donnée qui ont

une issue fatale au cours d'une période donnée. Il est

généralement exprimé en pourcentage.

Les séries chronologiques

épidémiologiques :Lorsque les données sont

collectées au fil du temps et que le temps est un aspect des

données contenant des informations importantes, il s'agit d'une

série chronologique. Le suivi temporel de l'apparition de cas malades

est un outil prédictif important, car il permet de déterminer la

dynamique de la maladie qui peut être :

· de type épidémique : forte

augmentation ponctuelle de l'incidence ou,

· de type endémique : la transmission est

stable dans le temps.

d) Analyse et maîtrise des épidémies

L'étude d'une épidémie de maladie

transmissible a pour objet d'identifier sa cause et de recenser les meilleurs

moyens pour la combattre. D'après les recommandations l'OMS, publie dans

Éléments d'épidémiologie, l'analyse et la

maîtrise des épidémies nécessite une démarche

rigoureuse qui comporte les étapes suivantes, appliquées de

manière séquentielle ou simultanée (BONITA &

Beaglehole, 2010):

· entreprendre une enquête

préliminaire : La première étape de

l'enquête consiste à vérifier les diagnostics de

présomption et à confirmer l'existence de

l'épidémie.

· identifier et notifier les cas :

l'identification systématique des nouveaux cas

· prendre en charge la maladie et appliquer des

mesures de lutte :assurer le traitement des cas, enrayer

l'extension de la maladie et surveiller les effets des mesures de lutte

instaurées

· recueillir et analyser des

données : la collecte, l'analyse et

l'interprétation des données

· diffuser les résultats obtenus et

assurer un suivi.

Les critères permettant de sélectionner les

maladies sont entre autres :

· incidence et prévalence,

· indices de gravité (taux de

létalité),

· indice de perte de productivité,

· coûts médicaux,... .

L'épidémiologie cherche aussi à

comprendre la dynamique des épidémies, pour mieux ajuster les

mesures préventives.

4. DYNAMIQUE TEMPORELLE D'UNE EPIDEMIE

La propagation d'un agent infectieux au sein d'une population

est un phénomène dynamique. Les effectifs d'individus sains et

malades évoluent dans le temps, en fonction des contacts.Ceci au cours

desquels l'agent infectieux passe d'un individu infecté à un

individu sain non immuniser en l'infectant à son tour. Un tel

phénomène peut être modélisé par des

équations différentielles. Ainsi dans cette section, nous allons

exposer d'un côté la modélisation de la dynamique

temporelle par et les modèles à base des compartiments et de

l'autre côté les effets de la vaccination sur la dynamique

temporelle.

a) Dynamique temporelle d'une épidémie et les

modèles à base des compartiments

Cette approche permet de compartimenter la population des

individus hôtes selon leur état clinique et consiste à

étudier les flux d'individus entre les différents compartiments.

À savoir le compartiment des susceptibles infectés, ou

même éventuellement des retirés... . Un des modèles

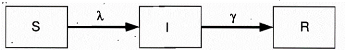

à base des compartiments les plus simples est le modèle de

Kermack et McKendrick dit S.I.R (Figure 2) qui divise la population hôte

en susceptibles (S), infectieux (1) et retirés (R) :

· S désigne, au sein de la population

concernée, les individus Susceptibles d'être infectés,

· I désigne ceux qui sont Infectés,

· R concerne ceux qui sont Rétablis ou immunise

Le modèle décrit la dynamique d'une

épidémie comme suit :

· Les individus susceptibles deviennent infectés

au taux ë communément appelé force d'infection ou taux de

contagiosité et,

· les individus infectés guérissent ou

meurent au taux ã.

· Les flèches entre les boites

représentent les flux d'individus selon les taux indiqués

au-dessus des flèches.

· L'effectif de chacune de ces populations dans un

compartiment varie en fonction du temps

Figure 2 : la dynamique

d'une épidémie selon le modèle SIR

Le système d'équation de la dynamique

temporelle d'une épidémie, selon le modèle SIR est par les

équations suivant :

·

·

·

·

Ces deux équations suffisent pour décrire la

dynamique temporelle d'une épidémie lorsque l'on fait

l'hypothèse que la taille totale de la population hôte N reste

constante. La résolution analytique ou numérique de ce

système d'équations différentielles nous permet de

prédire l'évolution du nombre d'individus hôtes dans

chacune des trois catégories S, let R (Figure 3)

Figure 3: Dynamique temporelle

du modèle SIR, Source: (Avhad, 2020)

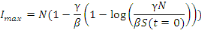

b) Détermination du pique de l'épidémie

ou le nombre maximal d'infectés

À partir du modèle S.I.R on peut

également obtenir des informations pertinentes du point de vue de la

santé publique. On peut par exemple déterminer le nombre maximal

d'infectés Imax. Pour cela, on peut réécrire le

modèle sous la forme suivante:

Ou encore si I?0

lmax sera obtenu lorsque

donc pour

donc pour

soit:

soit:

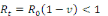

c) Nombre de reproduction de base R0

R0 est le nombre de cas secondaires directement

infectés par une unique personne infectieuse, placée dans une

population totalement susceptible à la maladie. On l'exprime sous la

forme du rapport probabilité de transmission de la maladie ë par

le taux de guérison ã. Il est aussi exprimé sous la

forme des produits du taux de contact "efficace" â, du nombre de

contacts par unité de temps c ; et de la durée de la

période contagieuse d.

R0 est un seuil en

épidémiologie :

· si R0< 1, alors un individu en infecte en

moyenne moins d'un, la maladie disparaîtra de la population à

terme.

· si R0> 1, alors la maladie peut se

propager dans la population et devenir épidémique.

d) Nombre de reproduction effectif Rt

Pendant les épidémies, la dynamique change en

raison des mesures potentielles qui ont été mises en place pour

réduire les interactions sociales et en raison du pourcentage croissant

de personnes immunisées dans la population. Le taux de reproduction

effectif décrit donc le taux de reproduction à un moment

donné. Une valeur de Rt reflète la propagation

potentielle basée sur les interactions sociales. Il est égale a

au produit du taux de reproduction effectif par la proportion de population

exposée à la maladie.

e) Intervalle intergénérationnel (D) :

Mesure le temps s'écoulant entre la survenue de la

maladie chez un cas dénommé, par convention, le "parent" et la

survenue de la maladie chez les personnes qu'il va infecter

dénommées, par convention, les "enfants". Cet intervalle est

fonction de :

· la durée de contagiosité :

période pendant laquelle un infecte peut transmettre la maladie et,

· du temps de latence : période de temps

entre l'infection et le début des symptômes chez l'agent infecte

f) vitesse de croissance d'une épidémie

À partir du taux de reproduction de base

R0 et de l''intervalle intergénérationnel (D), on peut

estimer la vitesse de croissance d'une épidémie. Le nombre

d'infecte I(t) au cours d'un temps t est donné par la formule :

Ainsi on en déduit que l'évolution d'une du

nombre d'infectés au début d'une épidémie est une

croissance exponentielle.

g) Effets de la vaccination sur la dynamique temporelle de

l'épidémie

Une politique de vaccination cherche à protéger

une population dans sa totalité. Ainsi le but d'une politique vaccinale

est de réduire le taux de reproduction de la maladie afin qu'il ne

dépasse pas la valeur de 1. Si la population est vaccinée avec

une couverture vaccinale de v, alors p = 1 - v et la condition pour qu'il n'y

ait pas d'épidémie devient:

Soit,

Cette dernière relation nous donne la couverture

vaccinale minimale qu'il faut appliquer pour empêcher le démarrage

d'une épidémie dans une population. On remarque aussi que la

couverture minimale à appliquer dépend du taux de reproduction de

base R0, d'où l'importance de ce paramètre en

épidémiologie. Ainsi plus le Ro est élevé, plus la

couverture vaccinale doit être importante.

Tableau 1 : Valeurs des

Ro de quelques maladies et de leur couverture vaccinale v

|

Maladie

|

Taux de reproduction de base R0

|

Couverture vaccinale v

|

|

Variole

|

3,5 - 6

|

0,71-0,83

|

|

rougeole

|

16-18

|

0,94-0,95

|

|

Ebola

|

2,5-3

|

0,60-0,67

|

Source :(Guégan, 2009)

5. DYNAMIQUE SPATIALE D'UNE EPIDEMIE

Dans cette section il est question de définir ce qu'on

entend par dynamique spatiale d'une part et de présenter le

système d'information géographique (SIG), l'outil de base pour

l'analyse spatiale.

a) Définition de la dynamique spatiale d'une

épidémie

La dynamique spatiale d'une épidémie correspond

à la répartition des cas d'une maladie, que l'on peut trouver sur

un territoire au fil du temps. La science géographique joue un

rôle majeur pour comprendre comment le virus se propage à travers

les régions. La localisation des cas permet d'identifier les

schémas spatiaux tracés par le virus. La compréhension de

ces schémas permet :

· de mieux contrôler de la propagation du

virus,

· de minimise son impact dans les régions

vulnérables,

· d'anticiper sur les épidémies

potentielles oud'élabore des cartes de risques prédictifs.

L'essor récent des outils informatiques, et notamment

des systèmes d'information géographique (SIG), depuis une

vingtaine d'années a grandement simplifié la manipulation de

données facilitant ainsi la prise en compte de la dimension spatiale

dans l'étude et la surveillance des maladies infectieuses.

b) Système d'information géographique (SIG)

Il est question d'exposer tour à tour de la

définition de de la notion de SIG, puis la représentation

d'entités géographiques dans un SIG enfin le système de

Coordonnées géographiques

(1) Définition

La Société française de

photogrammétrie et télédétection définit en

1989, le système d'information géographique comme «

Système informatique permettant, à partir de diverses sources, de

rassembler et organiser, de gérer, d'analyser et de combiner,

d'élaborer et de présenter des informations localisées

géographiquement, contribuant notamment à la gestion de l'espace

». Un SIG est de ce fait un outil complet de connaissance, d'aide

à la décision et de communication. Le SIG permet la collecte et

le stockage, la visualisation, la superposition, l'interrogation et l'analyse

des données géoréférencées.

(2) Représentation

d'entités géographiques dans un SIG

Deux modes de représentation des entités

géographiques sont principalement utilisés: le mode vectoriel et

le mode matriciel ou raster.

· En mode vectoriel, les objets de

chaque couche d'information sont localisés dans l'espace par leurs

coordonnées géographiques et sont représentés sous

forme de points, de lignes ou de polygones.

· En mode matriciel, ou raster, l'espace

est représenté sous forme d'une grille ou matrice, ou image,

composée de cellules de même taille appelées pixels,

présentant des valeurs différentes en fonction de leur nature. Ce

mode de représentation est donc adapté à la

représentation de variables, changeant de manière continue dans

l'espace.

(3) Système de Coordonnées

géographiques

Les coordonnées sont les repères qui permettent

de définir la position d'un point sur le globe terrestre, en latitude et

en longitude.

· La latitude est définie par la

distance angulaire de ce point à l'équateur, mesurée en

degrés.

· La longitude est définie par la

distance angulaire de ce point au méridien d'origine mesurée en

degrés.

6. Quelques propriétés

épidémiologiques de la pandémie de la COVID-19

D'après l'Avis du Conseil scientifique de France sur

la COVID-19 publié le 12 mars 2020, la COVID-19 est une affection

bénigne dans 80% des formes symptomatiques, auxquellesse rajoutent 15%

de formes sévères et 5% de formes critiques nécessitant un

passageen réanimation. La létalité des formes

symptomatiques est estiméeautour de 2 à 5% selon la distribution

par âge des patients, leurs co-morbidités, et lasaturation des

systèmes de santé. La létalité des patients avec

des formes critiques aété estimée à 61% dans une

série de patients hospitalisés à Wuhan. Parmi les patients

décédés, 20% ont moins de 60 ans. Ces

élémentsont un retentissement majeur sur le système de

santé.Il est donc question ici de présenter les origines de la

COVID-19, les symptômes et les modes de transmission.

a) Origines de laCOVID-19

D'après (COPIL, 2022) le virus identifié en

janvier 2020 en Chine est un nouveau coronavirus, nommé SARS-CoV-2. La

maladie provoquée par ce coronavirus a été nommée

COVID-19 par l'OMS. Depuis le 11 mars 2020, l'OMS qualifie la situation

mondiale du COVID-19 de pandémie ; c'est-à-dire que

l'épidémie est désormais mondiale. La COVID-19 est

dangereuse pour les raisons suivantes :

o il est très contagieux : chaque

personne infectée va contaminer au moins 3 personnes en l'absence de

mesures de protection ;

o une personne contaminée mais qui ne

ressent pas encore de symptômes peut contaminer d'autres personnes.

b) Symptômes de la COVID-19

D'après (COPIL, 2022), le COVID-19 peut se manifester

par : la sensation de fièvre, la toux, des maux de tête,

courbatures, une fatigue inhabituelle, une perte brutale de l'odorat, une

disparition totale du goût, ou une diarrhée. Dans les formes plus

graves : difficultés respiratoires pouvant mener jusqu'à une

hospitalisation en réanimation voire au décès.

c) Modes de transmission de la COVID-19.

D'après (COPIL, 2022) la maladie se transmet :

· par projection de gouttelettes contaminées par

une personne porteuse : en toussant, éternuant ou en cas de contacts

étroits en l'absence de mesures de protection.

· par contact direct physique entre une personne porteuse

et une personne saine.

· par contact indirect, via des objets ou surfaces

contaminées par une personne porteuse.

CHAPITRE III : ETAT DE

L'ART DE LA MODELISATION DES EPIDEMIES

La modélisation des épidémies a pour but

essentiel de comprendre et contrôler, la propagation d'une maladie

infectieuse transmissible. Elle consiste à construire un modèle

qui permet de rendre compte de la dynamique de la maladie à partir de

données et d'hypothèses sur la population.Dans cette session nous

allons présenter d'abord les modèles à base de

compartiment, puis les modèles à base de réseaux de

pétri enfin et les modèles à base d'agent.

7. Modèles à base des compartiments

Les modèles à base des compartiments divisent la

population en un certain nombre de compartiments ou classes différents,

correspondant à des statuts épidémiologiques

différents : sensible, infecté, guéri... . Des

équations différentielles expriment alors l'évolution du

nombre de personnes dans chaque compartiment au cours du temps.

a) Travaux connexes sur les modèles à base des

compartiments

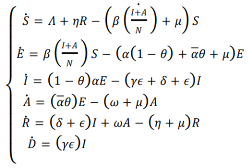

MATONDO MANANGA Herman, dans l'article intitulé :

« Modélisation de la Dynamique de Transmission de la Covid-19

en République Démocratique du Congo à l'Aide du

Modèle SEIRS à Six Classes», décrit, dans le

temps, la dynamique de transmission de la Covid-19 en environnement

déterministe au moyen des équations différentielles

ordinaires. Le modèle qu'il proposé est une extension du

modèle classique SEIRS ayant 6 compartiments. Son compartiment E est

éclaté en deux : A correspondant au compartiment des

asymptomatiques et I correspondant au compartiment de symptomatiques. Les

autres compartiments sont : ?? : compartiment des susceptibles, ?? :

compartiment des exposés, ?? : compartiment des guéris et ?? :

compartiment des décédés dû à la Covid-19. La

Figure 5 ci-dessous, est le diagramme de transfert de la population d'un

compartiment à un autre.

Figure 4: diagramme du

modèle SEAIRD(MATONDO MANANGA, 2021)

Le peuplement de différents compartiments

procède comme suit : dans S, un susceptible devient exposé

après un contact adéquat durant une période d'incubation

moyenne de 14 jours, soit il manifeste les symptômes, devient

symptomatique et entre dans le compartiment I ; soit il ne manifeste pas de

symptômes et passe dans la classe des asymptomatiques A. Un

infecté de la classe ?? peut, après un traitement, guérir

et passer à la classe de guéris R ; soit, il peut

également mourir de la Covid19 et passe dans la classe ??. Enfin, un

guéri de la Covid-19 peut de nouveau devenir susceptible avec un taux

??. D'où l'hypothèse selon laquelle tous les asymptomatiques ne

meurent pas du Covid-19 mais tous guérissent de la maladie après

un certain temps. Du diagramme de la figure 5, on déduit le

système d'équations différentielles ci-dessous qui

décrivent la dynamique temporelle de la pandémie de la covid-19

en République Démocratique du Congo.

b) Limites des modèles à base de

compartiments

Les réseaux de taille réelle sont difficiles

à modéliser par un jeu d'équations différentielles.

L'introduction de nouvelles populations et l'amélioration du

modèle nécessitent la modification de la plupart des

équations du modèle. Les équations différentielles

ne tiennent pas compte des facteurs spatiaux tels que la variable de la

densité de population et la dynamique de la population. Les

modèles à base de compartiments sont déterministes, donc

ne prennent en compte le caractère aléatoire de

l'épidémie de la covid-19. Ces modèles sont

considérés comme très simplistes.

8. Modèles à base de réseaux de

pétri

Les Réseaux de Petri, en abréviation RdP, ont

été introduits par le mathématicien Allemand Carl Adam

Petri dans sa thèse "Communication avec des Automates" en Allemagne

à Bonn en 1962. Les RdP sont des outils à la fois graphiques et

mathématiques permettant de modéliser le comportement dynamique

des systèmes à évènements discrets. Un RdP est un

graphe orienté comprenant deux sortes de noeuds : des places et des

transitions (figure 6). Ce graphe est constitué de telle sorte que les

arcs du graphe ne peuvent relier que des places aux transitions ou des

transitions aux places.

Figure 5: Représentation

graphique des éléments de RdP

a) Principe de modélisation à base des

réseaux de pétri

En général la modélisation des

épidémies avec les RdP se base sur un certain nombre de principes

simples : les places correspondent aux statuts épidémiologiques

de l'individu. Les transitions représentent les conditions ou les

probabilités de changement de statut épidémiologique ou le

temps nécessaire pour le passage d'un statut

épidémiologique à un autre. Enfin les jetons

représentent les individus. Ces jetons peuvent être colorés

pour distinguer les catégories ou classes d'individus.

b) Avantages de la modélisation à base des

réseaux des pétri

Pour relever les limites des modèles à base de

compartiments, l'on a fait appel aux réseaux de Pétri. En effet

les réseaux de Pétri modélisent aisément le

caractère aléatoire de l'épidémie, notamment les

réseaux de pétri stochastiques. Aussi les RdP modélisent

l'hétérogénéité de la population grâce

aux réseaux de pétri coloré, où chaque couleur de

jeton correspond à un groupe particulier de la population.

c) Travaux connexes sur la modélisation à base

des réseaux des pétri

Les chercheurs du Laboratoire Africain d'Informatique et de

Mathématiques Appliquées (LAIMA), ont modélisé le

phénomène Covid-19 au Gabon grâce aux réseaux des

pétri généralisés (figure 7). Ce modèle est

très réaliste et prend en compte : l'aspect stochastique de

l'épidémie de la Covid-19,

l'hétérogénéité de la population et la

vaccination. Le modèle du LAIMA est une extension du modèle SVEIR

en 8 places : le compartiment E se divise en trois place : la place des

asymptomatiques, la place des hospitalises et la place de la

réanimation. Et le compartiment R se divise en deux places : la place

des guéris et la place des décédés.

Figure 6: modèle

SVEIR-RDP de LAIMA (modèle de KAMANA)

d) Limites des modèles à base des

réseaux de Pétri

Les RdP ont des difficultés à modéliser

la dimension spatiale de la population pourtant essentielle pour une

étude complète d'une épidémie. L'expression de la

dynamique temporelle des épidémies modélisée par

les RdP est sous la forme des systèmes dynamiques, souvent très

complexes.

9. Modèles à base d'agents (ABM)

Ces dernières années témoignent d'un

grand essor dans l'utilisation de la modélisation à base d'agents

pour l'étude des systèmes complexes. Cette approche, qui consiste

à représenter explicitement les entités composant le

système étudié sous la forme d'un ensemble

d'entités informatiques autonomes en interaction appelées agent,

connaît aujourd'hui un grand succès dans de nombreux domaines tels

que l'agronomie, l'écologie, la cartographie ou

l'épidémiologie.

a) Principe de la modélisation à base d'agent

(ABM)

Selon Jacques Ferber, dans « Les

Systèmes Multi Agents: vers une intelligence

collective » : développer un modèle de

simulation à l'aide de l'approche multi-agent consiste, à

modéliser un système un système composé des

'éléments suivants (figure 8):

· Un environnement E,

c'est-à-dire un espace disposant généralement d'une

métrique.

· Un ensemble d'objets O. Ces objets

sont situés, c'est-à-dire que, pour tout objet, il est possible,

à un moment donne, d'associer une position dans E.

· Un ensemble A d'agents, qui sont des

objets particuliers (A ? O), lesquels représentent les entités

actives du système.

· Un ensemble de relations R qui

unissent des objets (et donc des agents) entre eux.

· Un ensemble d'opérations Op

permettant aux agents de A de percevoir, produire, consommer, transformer et

manipuler des objets de O.

· Des opérateurs chargés

de représenter l'application de ces opérations et la

réaction du monde à cette tentative de modification, que l'on

appellera les lois de l'univers

Figure 7 :

Représentation imagée d'un agent en interaction avec son

environnementet les autres agents, (Ferber, 1995)

b) Avantages des modèles à base d'agent

Les systèmes multi-agents apportent une solution

radicalement nouvelle au concept même de modèle et de simulation

dans les sciences de l'environnement :

· En offrant la possibilité de représenter

directement les individus, leurs comportements et leurs interactions.

· L'intérêt de ces simulations est de

pouvoir considérer aussi bien des paramètres quantitatifs

(paramètres numériques) que qualitatifs (des comportements

individuels).

· Enfin, les systèmes multi-agents permettent la

modélisation de situations complexes dont les structures globales

émergent des interactions entre individus.

c) Travaux connexes modèles à base

d'agent :COMOKIT

Les travaux sur la modélisationde

l'épidémie de la covid-19 par une approche des systèmes

multi-agents sont abondants. Mais l'un de ces travaux méritent

d'être cite ici.L'équipe des chercheurs de l'Unité de

Modélisation Mathématique et Informatique des Systèmes

Complexes (UMMISCO), constituée de Kevin Chapuis, Patrick Taillandier,

Benoit Gaudou, Arthur Brugière et Alexis Drogoul, ont mis sur pieds,

l'environnement logiciel COMOKIT (covid-19, modeling kit), qui repose sur un

modèle à base d'agents. COMOKIT est un projet

développé à l'origine pour répondre aux besoins du

gouvernement vietnamien et l'aider à prendre des décisions. Il a

été codé en GAMA, et l'une de ses forces est qu'il est

modulaire et évolutif. Les données peuvent être

modifiées pour étudier d'autres villes, ce qui a

été fait pour étudier la propagation du virus à

Nice. Il a été conçu pour aider à la prise de

décision et a réellement été utilisé pour

cela, notamment au Vietnam. La figure 9 montre le diagramme UML du

modèle COMOKIT, résumant les différents agents inclus.

COMOKIT permet d'explorer l'impact des différentes politiques mises en

place.

Figure 8 : Diagramme de

classe des entités COMOKIT(Taillandier, Drogoul, & Gaudou,

2020)

d) Limites des modèles à base d'agents

(ABM)

Bien que les modèles à base d'agents soient

adaptés pour l'évaluation des politiques sanitaires a priori, ils

présentent un inconvénient majeur : leur consommation en

ressources. En effet ces modèles nécessitent une quantité

importante d'information pour l'estimation des paramètres. Et surtout

les modèles à base d'agents demandent un temps de calculs

très long. Ainsi l'implémentation des modèles à

base d'agents est réputée être plus complexe que pour les

modèles à base de compartiments.

DEUXIEME PARTIE :

MODELISATION DE LA COVID-19 PAR UNE APPROCHE MACHINE LEARNING

CHAPITRE IV : PRESENTATION

DU MACHINE LEARNING

Dans ce chapitre, il est question de présenter la

notion de Machine Learning à travers la définition des termes

clés, puis présenter les types d'apprentissages,

l'évaluation des modèles et enfin exposer quelques

algorithmes.

10. Intelligence artificielle

L'intelligence artificielle est une branche de l'informatique.

Il s'agit de développer des programmes informatiques pour accomplir des

tâches qui nécessiteraient autrement l'intelligence humaine. Les

algorithmes d'intelligence artificielle peuvent aborder l'apprentissage, la

perception, la résolution de problèmes, la compréhension

du langage ou le raisonnement logique.Une intelligence artificielle est

caractérisée par :

· Une Capable de prédire et de

s'adapter : l'intelligence artificielle utilise des algorithmes

qui découvrent des modèles à partir d'énormes

quantités d'informations.

· Une autonomie dans la prise de

décisions :L'intelligence artificielle est capable

d'augmenter l'intelligence humaine, de fournir des informations et

d'améliorer la productivité.

· Une Apprentissage

continu :l'intelligence artificielle utilise des algorithmes pour

construire des modèles analytiques. À partir de ces

algorithmes, la technologie de l'IA découvrira comment effectuer des

tâches à travers d'innombrables séries d'essais et

d'erreurs.

· Une approche

futuriste :L'intelligence artificielle est tournée vers

l'avenir, l'IA est un outil qui permet aux gens de reconsidérer la

façon dont nous analysons les données et intégrons les

informations, puis utilisons ces informations pour prendre de meilleures

décisions.

Une intelligence artificielle est subdivisée en

plusieurs branches parmi lesquelles, figure le Machine Learning (figure

10).

figure 9 : branches de

l'intelligence artificielle,(Mohammed, 2019)

11. Machine Learning

Suite à son invention, Arthur Samuel a formulé

la définition historique du Machine Learning : « Le Machine

Learning est la science de donner à une machine la capacité

d'apprendre, sans la programmer de façon explicite. ». Une

définition formelle couramment citée de l'apprentissage

automatique, proposée par l'informaticien Tom M. Mitchell, dit qu'une

machine apprend si elle est capable de prendre de l'expérience et de

l'utiliser de manière à ce que ses performances

s'améliorent par rapport à des expériences similaires

à l'avenir.

Le Machine Learning est un sous-domaine de l'intelligence

artificielle. Chaque système de Machine Learning peut être

divisé en trois composants: Données, Modèle, Tâche.

Les données sont introduites dans le modèle en tant

qu'entrée, le modèle peut être par exemple une fonction ou

un programme sélectionné spécifiquement pour la

tâche. L'apprentissage automatique est réalisé par un

processus dans lequel, en ajustant le modèle aux données, le

modèle devient meilleur pour la tâche souhaitée.

a) Pourquoi utilise-t-on le Machine Learning ?

Pourquoi avons-nous besoin du Machine Learning plutôt

que de programmer directement nos ordinateurs à réaliser une

tâche spécifique ? Deux aspects d'un problème donné

peuvent faire appel à l'utilisation de programmes capable d'apprendre et

de s'améliorer basée sur leurs expériences : la

complexité du problème et le besoin d'adaptation.

(1) Les tâches qui sont trop

complexes à programmer

· Les tâches effectuées par

humains : Il y a de nombreuses tâches que nous en tant

qu'être humain réalisons habituellement, comme la conduite, la

reconnaissance vocale, la compréhension d'images ... Dans tous ces

exemples, les programmes qui « apprennent à partir de leur

expérience », accomplissent des résultats satisfaisants, une

fois exposés à des données d'entraînements

suffisants.

· Les tâches au-delà des

capacités humaines : Apprendre à détecter des

caractéristiques pertinentes dans de larges et complexes ensembles de

données est un domaine prometteur dans laquelle la combinaison de

programmes qui peuvent s'améliorer avec quasiment une mémoire

illimitée et de plus en plus de vitesse de calcul ouvre de nouveaux

horizons.

(2) L'adaptation

Une caractéristique des outils programmés est

leur rigidité. Une fois que le programme a été

écrit et installé, il reste inchangé. Pourtant, de

nombreuses tâches changent au fil du temps ou d'un utilisateur à

un autre. Les outils Machine Learning, programmées avec des

comportements qui s'adaptent à leurs données d'entrées,

offrent des solutions à ces problèmes. Ils s'adaptent

naturellement aux changements dans les environnements où ils

interagissent. Des exemples d'applications du Machine Learning à de

tels problèmes incluent : les programmes capables de décoder des

écritures manuscrites, où le programme peut s'adapter à la

variation de l'écriture de différentes personnes, un autre

exemple, les programmes de reconnaissance vocale.Le Machine Learning

développe des algorithmes qui vont apprendre de manière

automatisée des modèles statistiques à partir de

données d'apprentissage. Ceci peut se faire de manière

supervisée, non supervisée, par renforcement ou encore en

profondeur.

b) Types d'apprentissage

Les algorithmes de Machine Learning peuvent être

divisés en quatre groupes principaux : l'apprentissage

supervisé, l'apprentissage non supervisé, L'apprentissage par

renforcement etl'apprentissage en profondeur .

(1) Apprentissage supervisé

L'algorithme de Machine Learning dispose d'un ensemble de

données d'entrée suffisamment grand pour servir d'exemple de

sortie ou d'événement, généralement

préparé en consultation avec l'expert en la matière d'un

domaine donné. L'objectif de l'algorithme est d'apprendre des

modèles dans les données et de construire un ensemble

général de règles pour faire correspondre l'entrée

à la classe ou à l'événement. De manière

générale, il existe deux types d'algorithmes d'apprentissage

supervisé couramment utilisés :

· Régression :La sortie

à prédire est un nombre continu en rapport avec un ensemble de

données d'entrée donné.

· Classification : La sortie

à prédire est une probabilité d'appartenir à une

classe. L'algorithme doit apprendre les modèles dans l'entrée

pertinente de chaque classe à partir de données historiques.

Enfin il doit être capable de prédire des nouvelles classes dans

le futur en tenant compte des données d'entrée.

(2) Apprentissage non

supervisé

Il existe des situations où la classe ou

l'événement de sortie souhaité est inconnu pour les

données historiques. Dans ce cas, l'objectif est d'étudier les

modèles dans l'ensemble de données d'entrée afin de mieux

comprendre et d'identifier les modèles similaires qui peuvent être

regroupés dans des classes ou des événements

spécifiques.

· Regroupement : supposons que les

classes ne soient pas connues à l'avance pour un ensemble de

données donné. L'objectif ici est de diviser l'ensemble de

données d'entrée en groupes logiques d'éléments

connexes.

· Réduction des dimensions :

l'objectif est ici de simplifier un grand ensemble de données

d'entrée en les transposant dans un espace de dimension

inférieure. Par exemple, l'analyse d'un ensemble de données de

grande dimension nécessite des ressources informatiques importantes.

Pour simplifier, il est possible donc de trouver des variables clés qui

contiennent un pourcentage significatif.

(3) Apprentissage par renforcement

Cette technique consiste pour la machine à

améliorer son comportement à partir d'une méthode d'essai

et d'erreur dans un dynamique environnement. Ici, le problème est

résolu par prise de décision approprié dans une certaine

situation pour maximiser le rendement et obtenir les résultats

acquis.

(4) Apprentissage en profondeur

L'apprentissage en profondeur ou le « Deep

Learning » s'appuie sur un réseau de neurones artificiels

s'inspirant du cerveau humain. Ce réseau est composé de dizaines

voire de centaines de «?couches?» de neurones, chacune recevant et

interprétant les informations de la couche précédente.

Une fois un type d'apprentissage a été

implémenté, il est nécessaire de procéder à

une évaluation.

c) Évaluation d'un modèle en Machine

Learning

L'évaluation permet de tester le modèle par

rapport à des données qui n'ont jamais été

utilisées pour l'entrainement. Cela permet de voir comment le

modèle pourrait fonctionner par rapport à des données

qu'il n'a pas encore vues. Ceci est censé être

représentatif de la façon dont le modèle pourrait

fonctionner dans le monde réel. Il existe plusieurs méthodes pour

calculer le score de chaque algorithme pour ensuite choisir le meilleur pour la

prédiction. Voici quelques méthodes de calcul du score.

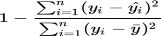

(1) Score R-carré (R²)

Le R-carré est appelé coefficient de

détermination. C'est un indicateur utilisé en statistiques pour

juger de la qualité d'une régression linéaire.

Mathématiquement, il s'agit de la proportion de la variance d'une

variable dépendante qui s'explique par une ou plusieurs variables

indépendantes dans le modèle de régression. On l'exprime

soit entre 0 et 1, soit en pourcentage. Le R² se calcule à partir

de la formule suivante :

Avec :

· yi la valeur du point i,

· yi la valeur prédite pour le point i

par la régression linéaire,

· ? la moyenne empirique des points donnés.

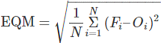

(2) Erreur quadratique moyenne ou le

« Root Mean Square Error » (RMSE)

L'erreur quadratique moyenne d'un estimateur F d'un

paramètre O de dimension 1 est une mesure caractérisant la «

précision » de cet estimateur. Elle est plus souvent appelée

« erreur quadratique » (« moyenne » étant

sous-entendu) ; elle est parfois appelée aussi « risque quadratique

». L'erreur quadratique moyenne est définie via l'équation

mathématique :

Où

· Fi = les valeurs de la prévision du

paramètre en question

· Oi = la valeur de vérification

correspondante

· N = le nombre de points de vérification dans la

zone de vérification

d) Quelques algorithmes de Machine Learning

(1) ARIMA

Il s'agit d'un modèle de série chronologique

hybride où :

· AR désigne AutoRégressif,

· I dénote pour Intégré et,

· MA dénote pour Moyenne mobile.

Il prend des données historiques en entrée et

produit des résultats futurs en observant la tendance. L'objectif

d'ARIMA est de définir les autocorrélations entre les points de

données.

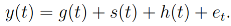

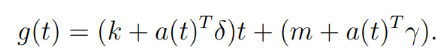

(2) Prophète

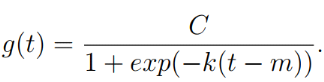

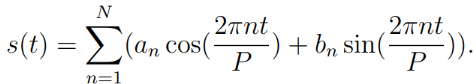

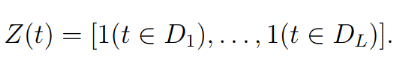

Ce modèle a été conçu et

développé en 2007, par l'équipe Data Scientist de Facebook

dirige par Taylor et Letham, pour prévoir les tendances et la nature

du modèle est additive. Ainsi, le modèle de prophète FB

peut prédire les tendances quotidiennes, hebdomadaires, mensuelles et

saisonnières en fonction des besoins. Fondamentalement, Prophet est un

modèle polyvalent et flexible qui décompose diverses

données de séries chronologiques et produit une sortie

évolutive.

(3) LSTM

Le modèle LSTM a été

développé en 1997 par Hochreiter et Schmidhuber. Il s'agit d'un

modèle spécial de réseau neuronal récurrent (RNN)

spécialisé dans la mémorisation ou le stockage de

données de séquence plus longue pour prédire des tendances

précises. LSTM signifie Long Short-Term Memory network. Cela implique

qu'ils sont très bien adaptés pour recueillir des données

pour des données étendues par rapport à RNN. Le

modèle LSTM appartient à la catégorie des algorithmes

d'apprentissage en profondeur et fournit des résultats optimaux pour un

ensemble de données plus volumineux avec une erreur minimale.

Chapitre V :

démarche Machine Learning pour la modélisation

Dans cette partie il est question de présenter les

deux processus d'extraction de données les plus populaires et largement

pratiqués pour construire des systèmes d'apprentissage

automatique. Ces processus sont les suivants : le processus «Knowledge

Discovery in Databases «(KDD), et le Processus «Cross Industry

Standard Process for Data Mining» (CRISP-DM)

12. Processus «Knowledge Discovery

in Databases «(KDD)

Le processus Knowledge Discovery in Databases (KDD) ou en

français « Bases de données de découverte de

connaissances » est un processus global de découverte de

connaissances utiles, à partir de données. Ce processus couvre

l'ensemble du cycle de vie des données, notamment la manière dont

les données sont stockées, la manière dont on y

accède, la manière dont les algorithmes peuvent être

adaptés efficacement à de base de données gigantesque, la

manière dont les résultats peuvent être

interprétés et visualisés. Le KDD comporte cinq

étapes, présentées dans le tableau 2.

Tableau 2: Etapes du

KDD

|

étape

|

Nom

|

Description

|

|

1

|

Sélection

|

Création des données sur lesquelles la

découverte va s'établir

|

|

2

|

Prétraitement

|

Nettoyage des données pour obtenir des données

consistantes

|

|

3

|

Transformation

|

Transformation des données en utilisant des

méthodes de transformations

|

|

4

|

Data Mining

|

Recherche de modèles en adéquation avec les

objectifs de Data Mining

|

|

5

|

Interprétation/

évaluation

|

Interprétation et évaluation des modèles

trouvés

|

Source: (Swamynathan, 2017)

Le cycle du processus KDD s'apparente à une progression

quasiment linéaire et séquentielle (figure 11).

Figure 10 : cycle de vie

du processus KDD, source :(Swamynathan, 2017)

13. Processus «Cross Industry

Standard Process for Data Mining» (CRISP-DM)

Le Processus CRISP-DM, ou Processus standard interindustriel

pour l'extraction de données, a été établi par le

programme stratégique européen de recherche en technologies de

l'information en 1998. Ceci dans le but de créer une

méthodologie universelle qui ne dépend pas d'un domaine

particulier. Il s'agit d'un processus itératif et

incrémentale, où de nombreuses tâches reviennent sur

celles précédentes et répètent certaines actions

pour apporter plus de clarté. Il y a six phases principales, comme

décrit dans le tableau 3 ci-dessous.

Tableau 3 :

récapitulatif des phases du processus CRISP-DM.

|

Phase

|

objectifs

|

|

Compréhension de l'activité

|

comprendre les objectifs généraux du projet et

les attentes du point de vue de l'entreprise.

|

|

Compréhension des données

|

comprendre les lacunes des données ou leur pertinence

par rapport à l'objectif visé

|

|

Préparation des données

|

Cette phase consiste à nettoyer les données afin

qu'elles soient prêtes à être utilisées pour la phase

de construction du modèle

|

|

Modélisation

|

Choix de l'algorithme en fonction de leur performance

|

|

Évaluation et validation

|

évaluation comparative des différents

modèles choisis et vérification résultats par rapport aux

besoins de l'entreprise identifiés.

|

|

Déploiement

|

L'objectif principal de cette phase est la facilité

d'utilisation des résultats du modèle

|

Source:(Swamynathan, 2017)

Le cycle de vie du processus CRISP-DM est itératif et

incrémentale comme l'indique la figure 10 ci-dessous.

Figure 11: méthode

CRISP-DM, adapté de (Shearer, 2000)

14. Méthodologie choisie : le

processus CRISP-DM

En général, la plupart des chercheurs et des

experts en exploration de données suivent le modèle le processus

CRISP-DM parce qu'il est plus complet et plus précis. CRISP-DM est plus

complet car le flux itératif des connaissances à travers et entre

les phases a été clairement défini. De plus, il couvre

tous les domaines de la construction de systèmes de Machine Learning

fiables. Les avantages de la méthode CRISP DM sont nombreux pour un

projet de Machine Learning. Cette méthode est agile et itérative,

c'est-à-dire que chaque itération apporte de la connaissance

métier supplémentaire qui permet de mieux aborder

l'itération suivante.

15. Mise en oeuvre de la démarche

CRISP-DM

Il s'agit d'appliquer les six étapes du processus CRISP

à notre projet.

a) Compréhension métier

Ici il est question de la définition du

problème. Puis de comprendre : à quoi serviront les

prédictions ? Qui a besoin des prédictions ? Et comment

elles s'intègrent dans l'organisation ? (voir tableau 4)

On commence par une description informelle du problème

dans le but de formuler en une phrase facilement compréhensible le

problème : comment concevoir un modèle de Machine Learning

capable de prédire le nombre des cas de l'épidémie de la

covid-19 ?

Pour la définition formelle du problème, l'on se

base sur la définition de Tom Mitchell en 1997 qui définissait

un programme de Machine Learning comme suit : «on dit qu'un programme

informatique apprend de l'expérience E en ce qui concerne une

tâche T et une mesure de performance P, si sa performance sur T,

mesurée par P, s'améliore avec l'expérience

E. ». En d'autres termes, il va falloir définir le triptyque T

(tâche), P (Performance) et E (Expérience).

· Tâche (T) : prédire le nombre des cas de

l'épidémie de la covid-19.

· Performance (P) : La précision de la

prédiction faite par l'algorithme et le temps d'exécution

raisonnable

· Expérience (E) : Les inventaires des

données réelles sur les cas de la covid-19 au Gabon.

Tableau 4 :

résumé des questionnements qui facilitent la compréhension

du métier

|

questionnement

|

Réponses attendues

|

|

Quelle est le problème à

résoudre ?

|

comment concevoir un modèle de Machine Learning

capable de prédire le nombre des cas de l'épidémie de la

covid-19 ?

|

|

À quoi serviront les prédictions ?

|

Prédire l'évolution de la dynamique

spatio-temporelle de la covid-19

|

|

Qui a besoin des prédictions?

|

les décideurs en santé publique et les

organismes engagés dans la lutte contre la pandémie de la

covid-19.

|

|

Comment sont intégrées les prédictions

dans l'organisation ?

|

Les prédictions seront exploitées sous la forme

d'outils d'aide à la décision

|

b) Compréhension des données

Dans cette phase, nous avons procéder à la

collecte des données initiales, à leur description et à

leur exploration.

(1) Collecte de données

Les données utilisées dans ce projet sont

fournies par :

· Le « Johns Hopkins University Center for Systems

Science and Engineering» (JHU CSSE),

· Le Centre hospitalier et Universitaire de Libreville

(CHUL).

(2) Description des données

Les données utilisées dans ce projet sont

décrits ainsi qu'il suit :

· une partie des données ont été

téléchargées à partir du référentiel

Github qui est géré par l'Université John Hopkins et

l'ensemble de données est public et mis à jour quotidiennement.

Il existe plusieurs fichiers CSV. Pour ce projet, nous extrayons les

données d'un seul fichier à savoir : confirmed_case.csv

· l'autre partie des données

collectéesauprès du CHUL de Libreville sont la forme de fichier

Excel : Chul.civid.xls.

Le tableau 5 ci-dessous récapitule les données

et leurs sources respectives

Tableau 5 : description

des données

|

Fichier

|

Source

|

Données à extraire

|

dimension de la data frame

|

|

confirmed_case.csv

|

JHU CSSE

|

Le nombre cumulé de cas confirmés

|

850 colonnes et 270 lignes

|

|

Chul.covid.xls

|

CHUL

|

Lieu de résidence des cas confirmés à

Libreville.

|

10 colonnes et 1026 lignes

|

(3) Exploration des données

L'inspection des différentesbases de données

nous ont permis de comprendre que :

Pour le fichier provenant l'Université John Hopkins

· Les lignes représentent différents pays

et,

· les colonnes incluent :

o le nom du pays/région et également de la