|

Institut Sous régional de Statistique et d'Economie

Appliquée

(ISSEA)

GROUPE DE TRAVAIL

ISE3

EFFICIENCE DES BANQUES DANS LA

CEMAC : Approche Data Envelopment

Analysis

PAR:

Ngwa Edielle T.H. Jackson

DEA en

Economie

Elève Ingenieur Statisticien Economiste

Hevi Kodzo Dodzi

Maîtrise en

Economie

Elève Ingenieur Statisticien Economiste

Sous la supervision de:

Kamgna Séverin Yves

Ingenieur Statisticien

Economiste

Coordonateur de la Cellule de Recherche de la B.E.A.

C

Chef du Service des Prévisions

Macroéconomiques

EFFICIENCE DES BANQUES DANS LA CEMAC: APPROCHE

Data envelopment Analysis

par

Ngwa Edielle T.H. J et Hevi Kodzo D.

Résumé

Entre la fin des années 80 et le début des

années 2000, les banques de la CEMAC sont passées d' une

situation d' illiquidité a une situation d' excès de

liquidité. Cette nouvelle situation d' après la BEAC pose le

problème de l'incapacité des banques a transformer dans les

meilleurs délais les dépôts du public en crédits. L'

objectif de ce travail est d' évaluer l' efficacité technique de

transformation des dépôts en crédits des banques dans la

zone CEMAC. Nous avons montré que la réaction des crédits

par rapport aux dépôts est positive mais reste faible par rapport

au niveau de réserve obligatoire moyen, traduisant une

surliquidité du système bancaire. L'inefficience observée

dans la zone traduit l'incapacité des banques a transformer les

dépôts a court et moyen terme en crédits a terme. Il

apparaIt ainsi que cette inefficience est négativement

corrélée au nombre de banques du pays de localisation et

présente une relation en U renversé avec la taille des banques

mesurée par le niveau d'actif net.

Mots dles : Data envelopment analysis, frontiere d'ef~cience,

surliquidité, banque, GAM

1 Introduction

Le système bancaire de la CEMAC a été

marqué a la fin des années 80 par une grande crise.

D'après le secrétaire général de la

COBAC1, sur 40 banques que comptait le système, 9 avaient

cessé leur activité au début des années 90. Sur les

31 restantes, une seule respectait les normes réglementaires en vigueur,

20 avaient des équilibres précaires et 10 étaient

insolvables. Trois facteurs sont souvent considérés comme les

causes de la crise : l' environnement international, la mauvaise gestion des

banques et les politiques de crédit.

La baisse des cours des matières premières du

milieu des années 80 a créé une chute des ressources des

Etats et entramné les banques dans une situation d'illiquidité.

Cette illiquidité était due d'une part a la baisse des

dépôts des institutions publiques et a la baisse des

dépôts privés suite a l' accumulation de la dette

intérieure(Adam, 1997)2. Il faut noter qu' avant cette

période de récession mondiale, les banques étaient

caractérisées par une mauvaise gestion. Les dirigeants des

banques prenaient des risques inconsidérés avec des

crédits aux investissements pas souvent rentables. Ce comportement des

banques était favorisé par la politique monétaire de la

BEAC fondé sur le refinancement des banques a travers les taux

préférentiels et côtes globales de crédit (Bekolo,

2001). De plus, il n' existait pas a cette période une véritable

politique de contrôle prudentiel des banques.

Le renouvellement de la politique monétaire et

financière de la BEAC avait pour objectif de redresser le niveau

élevé d'instabilité du système bancaire. La mise

sur pied de la COBAC et la définition des nouvelles règles de

gestion prudentielle des banques a permis de réduire le risque

d'illiquidité des banques. Les indicateurs de liquidité de la

CEMAC dès 1994 sont positifs (Wanda, 2007). Au 31 décembre 2005,

la norme prudentielle de la COBAC relative au rapport de liquidité est

celle la plus respectée par les banques de la CEMAC, soit 31 sur 33

banques (COBAC, 2006). Les rapports de la CEMAC depuis les années 2000

indiquent un fort excèdent de liquidité des banques.

Les excès de liquidité observés ces

dernières années posent le problème de l'

efficacité des banques a transformer les dépôts a court et

moyen terme en crédits, étant donné que le rôle

principal d'une banque secondaire est l'intermédiation

financière.

1Adam Madji, Point sur la restructuration bancaire en

Afrique centrale, Note d'étude :Communication seminaire sur la

mobilisation de l'epargne longue et le financement des investissements en

Afrique Centrale, tenu a

Libreville du 24 au 26 mars 1997. 2op cite

L' objectif principal de ce travail est d' évaluer l'

efficience technique des banques dans la zone CEMAC. L'idée est de voir

si l'excès de liquidité observé dans les banques

représente une forme d'inefcience technique.

Dans ce travail, nous allons exploiter les

développements récents de la statistique non paramétrique

pour, dans un premier temps évaluer la surliquidité des banques

et dans un second temps évaluer le niveau efficience technique des

banques de la CEMAC. Pour évaluer la surliquidité des banques de

la CEMAC, nous allons adopter les modèles GAM développés

par Hasti et Tibshirani (1990). Cette approche a l'avantage de faire

l'évaluation sur la base d'une définition formelle de la

surliquidité. Pour évaluer l'efcience des banques de la CEMAC,

nous allons utiliser la méthode Data Envelopment Analysis (DEA).

L'avantage de cette méthode est qu'elle permet d' estimer la

frontière d' efcacité du secteur bancaire sans hypothèses

sur la forme structurelle de la fonction de production et la structure des

marchés. Contrairement a la plupart des travaux qui utilise l'estimateur

statique DEA, nous nous proposons de développer un estimateur dynamique

permettant aux unités de production de conserver la mémoire de

leurs propres techniques de production. Nous nous limiterons ici a l'efcience

technique de transformation des dépôts en crédits. La

limite d'une telle approche est que comme toutes les méthodes non

paramétriques, cette approche est sensible aux erreurs de mesure.

Le travail sera présenté tel qu'il suit. Dans la

première section nous allons faire une présentation sommaire du

système bancaire de la CEMAC de façon a mieux appréhender

les résultats de l'analyse. A la section deux, nous allons

présenter la méthodologie de toute notre analyse. A la section

trois, nous allons présenter les résultats de l' analyse et

terminer par une conclusion sommaire sur l' analyse.

2 Système bancaire dans la zone CEMAC

2.1 Cadre macro-financier de la CEMAC durant la

période 2000-2005

2.1.1 Cadre juridique

Le secteur bancaire dans la CEMAC est l'un des secteurs les

plus réglementés. Il s'agit notamment de protéger ce

secteur des risques tels que le risque de marché, le risque de

liquidité... définis par le comité de Bale. Les banques

sont, dans ce cadre, soumises a l' autorité de plusieurs organes de

tutelle et de régulation.

Réglementation bancaire

La réglementation bancaire fixe les normes et

règles en matière d' accès a la profession bancaire et

d'ouverture d'établissement de crédits. Ainsi tous les

établissements bancaires doivent obtenir un agrément de

l'autorité monétaire et financière qui est le

ministère en charge des finances de chaque pays avec l' accord

préalable de la COBAC. Ils doivent avant leur ouverture faire preuve de

fonds propres suffisants disponible en permanence. Enfin les dits

établissements devront se soumettre a la surveillance de la COBAC.

Les banques, une fois en exercice, doivent respecter un certain

nombre de règles prudentielles définies par l'autorité

monétaire. Il s'agit de normes fixées sur deux points:

· Les normes de solvabilité (Ratio de couverture

de risque, ratio de division des risques, ratio de couverture des

immobilisation, limitation de participation au capital des établissement

de credit et les limitation des engagements sur apparentés)

· Les norme de liquidité (Ratio de

liqidité et ratio de transformation)

Les banques doivent aussi s'assurer d'un niveau de protection

minimale de la clientèle en assurant une garantie des

dépôts et des conditions de crédits.

Organismes de réglementation

Depuis la crise du système bancaire de la zone CEMAC,

la surveillance bancaire a été renforcée et mise sous la

tutelle d'une autorité suprême. L' autorité suprême

avant 1990 était le comité ministériel des Etats membres.

A partir d'octobre 1990, la COBAC est devenu l'autorité chargée

du contrôle et de la surveillance des banques bien que l'agrément

reste toujours du ressort du ministère en charge des finances de chaque

Etat membre. La COBAC a ainsi défini en 1992 la convention portant

harmonisation de la réglementation bancaire. La COBAC a ainsi

défini les critères suivants:

· le ratio de couverture des risques doit être au

minimum 5% des engagements de la banque;

· le ratio de division des risques doit être au

maximum 45% en faveur des clients.

· le ratio de couverture de risque indique que 100% des

immobilisations doivent être financées par les ressources

permanentes;

· le ratio de liquidité doit correspondre a 100% de

dettes a échoir dans un délai d'un mois;

· 50% des engagements de long terme doivent être

couvert par les ressources de long terme.

2.1.2 Analyse des Règles prudentielles

Le premier enseignement qui ressort de l'analyse des

régles prudentielles est que de façon générale,

plus de 70% des banques de la sous région sont en conformité avec

les normes prudentielles. Mais cette statistique cache quelques

différences.

De 2001 à 2005, on observe au tableau 1 que la norme

prudentielle relative au plafond des risques sur un individu et celle relative

à l' adéquation des fonds propres constituent celles qui causent

plus de difficultés aux banques. En effet, la proportion des banques qui

respectent le critère d'adéquation des fonds propres a

augmenté entre 2001 et 2004 passant de 33,33% à 50%. Cette

proportion a régressé en 2005. La même évolution est

observée au niveau du critère relatif au plafond des risques

individuels. Les autres critères sont par contre assez bien

respectés par les établissements bancaire de la sous

région. Les proportion varient en moyenne entre 63%(couverture des

immobilisations en 2001) et 91%(Rapport de liquidité en 2005).

Norme prudentielle

|

30/09/0 1

|

30/09/02

|

3 0/09/03

|

30/09/04

|

31/03/05

|

Capital minimum

|

85.19

|

90.00

|

86.67

|

87.50

|

84.85

|

Couverture des risques

|

85.19

|

76.67

|

83.33

|

81.25

|

66.67

|

Plafond global des risques

|

81.48

|

80.00

|

80.00

|

81.25

|

81.82

|

Plafond individuel des risques

|

37.04

|

40.00

|

40.00

|

50.00

|

39.39

|

Couverture des immobiisations

|

62.96

|

56.67

|

70.00

|

78.13

|

72.73

|

Rapport de liquidité

|

85.19

|

83.33

|

90.00

|

90.63

|

90.91

|

Coefficient de transformation

|

74.07

|

76.67

|

76.67

|

75.00

|

72.73

|

Engagements sur les apparentés

|

66.67

|

76.67

|

80.00

|

78.13

|

72.73

|

Adéquation des fonds propres

|

33.33

|

33.33

|

36.67

|

50.00

|

36.36

|

|

Tableau 1: Evolution de la proportion des banques en

conformité avec les normes prudentielles. Source: BEAC

· en ce qui concerne le respect des règles

prudentielles, le nombre d'établissements bancaires qui respectent les

dispositions relatives au capital minimum est passé de 23 à 28

sur la période 2001-2005, soit une augmentation de 22%. Au cours de

certaines périodes cette proportion a baissé en dessous du niveau

moyen;

· en matière de solvabilité, 79% des banques

extériorisent un ratio de couverture des risques pondérés

par les fonds propres nets supérieur ou égal au minimum de 8%;

· dans le cadre des normes de division des risques, en

moyenne 81% des banques de la sous

région parviennent à respecter la limite

globale en maintenant en dessous de l'octuple des fonds propres nets la somme

des risques pondérés supérieurs à 15% desdits fonds

propres mais seulement 41,21% des banques se conforment à la limite

individuelle en n'entretenant pas de risques pondérés encourus

sur un même bénéficiaire excédant 45% des fonds

propres nets;

· s'agissant de la couverture des immobilisations par les

ressources permanentes, 68% des banques réalisent un ratio

supérieur ou égal au minimum de 100%;

· en ce qui concerne le rapport de liquidité, les

disponibilités à vue ou à moins d'un mois sont

supérieures ou égales au minimum réglementaire de 100% des

exigibilités de même terme pour plus de 88% des banques;

· quant au respect du coefficient de transformation

à long terme, 75% des banques parviennent à financer à

hauteur de 50% au moins (minimum réglementaire) leurs emplois à

plus de cinq ans de durée résiduelle par des ressources

permanentes;

· enfin, 75% des banques maintiennent la somme des

engagements sur les actionnaires, administrateurs et dirigeants ainsi que sur

le personnel en dessous du plafond réglementaire de 15% des fonds

propres nets.

2.1.3 Statistique macro-financière

Les opérations de caisse ont augmenté de

73,29%, les opérations à vue de 78,74% alors que les

opérations à terme n'ont bougé que de 18,41%. On pourrait

déduire que les banques en moyenne privilégient les

opérations de court terme (Voir Tableau 2).

Sur la période de l' étude, les

opérations de trésorerie ont connu une évolution

remarquable. De Septembre 2002 à Septembre 2005, les ressources de

trésorerie ont augmenté de 23% tandis que les emplois ont

évolué de plus de 61%. Les diverses opérations

effectuées par les banques ont débouché sur un

excédent de trésorerie qui a augmenté de plus de 75%.

L'évolution des autres postes du compte de trésorerie s'est faite

de façon identique avec une forte augmentation pour les postes de

Créances en souffrance nettes (2771%), de Créances

rattachées (255%) et de Dettes rattachées (136%).

Les opérations des banques secondaires avec la BEAC

ont fortement évolué en volume entre 2001 et 2005. Elles se sont

caractérisées par une situation excédentaire passant d'un

solde de

|

30/09/02

|

30/09/03

|

30/09/04

|

3 1/03/05

|

Caisse

|

48.95

|

1.10

|

21.07

|

2.17

|

Opérations à vue

|

37.67

|

22.68

|

7.72

|

10.67

|

Opérations aujourlejouretàterme

|

15.88

|

-9.35

|

9.91

|

1.97

|

Titres de placement et de transaction

|

-22.31

|

-12.25

|

16.37

|

11.03

|

Créancesensouffrancenettes

|

2613.33

|

53.35

|

125.64

|

-21.52

|

Créances rattachées

|

128.57

|

-13.68

|

41.55

|

99.04

|

Emplois de trésorerie

|

27.99

|

7.20

|

10.38

|

6.63

|

Opérations àvue

|

21.87

|

35.25

|

-48.86

|

8.09

|

Opérations au jour le jour età terme

|

-8.97

|

19.89

|

12.30

|

28.96

|

Dettes rattachées

|

75.80

|

50.13

|

-7.09

|

17.32

|

Ressources de trésorerie

|

7.37

|

29.13

|

-26.03

|

19.89

|

Excédent/Déficit de trésorerie

|

35.49

|

0.89

|

23.82

|

3.71

|

|

Tableau 2: Evolution des opérations de

trésorerie.Source: BEAC

266,251 milliards de CFA en 2001 à 415,127 milliards de

CFA en 2005 (Voir tableau 3) soit une augmentation de 55,61%.

|

30/09/2001

|

31/03/05

|

Dépôt courant àla BEAC

|

130 703

|

287 784

|

Dépôts obligatoire à la BEAC

|

147 900

|

146 793

|

Découvert courant à la BEAC

|

1 623

|

4 637

|

Refinancement BEAC

|

10729

|

14 813

|

Solde des opérations avec la BEAC

|

266 251

|

415 127

|

|

Tableau 3: Evolution des opérations avec la BEAC (en

millions de FCFA).Source: BEAC

2.2 Marché bancaire de la CEMAC

2.2.1 Répartition des banques dans la CEMAC

Au 31 décembre 2005, le système bancaire de la

Communauté Economique et Monétaire de l'Afrique Centrale (CEMAC)

compte 33 banques en activité. Elles sont réparties au Cameroun

(10 banques), en Centrafrique (3 banques), au Congo (4 banques), au Gabon (6

banques), en Guinée Equatoriale (3 banques) et au Tchad (7 banques). Il

est important de noter que la majorité de ces banques ne sont que des

banques commerciales. Il n' existe presque plus de banque d' investissement

dans la zone.

2.2.2 Résultats des banques entre 2000 et 2005

Les dépôts de la clientèle ont connue une

très forte augmentation (17,87%) en 2002 par rapport àla

situation de 2001. Cette augmentation a continué jusqu'en 2005

atteignant 2 347 milliards de FCFA. Les crédits bruts à la

clientèle s'élève à 1 734 milliards de FCFA en 2005

soit une augmentation de 26% par rapport àla situation de 2001. Ils sont

en augmentation de 4,7% par rapport à septembre 2002. Les provisions

pour dépréciation des comptes de la clientèle se sont

accrues de 44% de 2001 à 2005 passant de plus 136 milliards à

plus de 196 milliards. Les crédits nets ont donc connue aussi une

augmentation durant la période étudiée allant de 1 234

milliards à 1 538 milliards, soit une augmentation de près de

24%.

|

30/09/2001

|

30/09/2002

|

30/09/2003

|

30/09/2004

|

3 1/03/2005

|

Dépotsdelacientèle

|

1761964

|

2076824

|

2135051

|

2285247

|

2347210

|

Créditsbruts

|

1379817

|

1551478

|

1624993

|

1670203

|

1734416

|

Créances en souffrance

|

176 709

|

215 502

|

237 122

|

264 843

|

258 532

|

Provisions dépréciation comptes

clientèle

|

136 556

|

166 151

|

187 107

|

203 531

|

196 283

|

Crédits nets

|

1 243 261

|

1 385 327

|

1 437 886

|

1 466 672

|

1 538 133

|

Capitaux permanents

|

289788

|

326726

|

336466

|

368489

|

388097

|

Valeurs immobiisées

|

323 324

|

347 432

|

345 730

|

344 395

|

342 848

|

Autrespostesnets

|

9860

|

1512

|

-11751

|

4605

|

24352

|

Excédent/Déficit de trésorerie

|

500 623

|

678 287

|

684 295

|

847 274

|

878 678

|

Totalbilan

|

2079265

|

2443040

|

2497964

|

2658341

|

2759659

|

|

Tableau 4: Evolution de la situation bilancielle (en millions de

francs CFA).Source: BEAC

Situation financière des banques

En général, les banques de la sous

région ont une bonne situation financière, au regard de la

cotation sur la période d'étude. La figure 1 montre

l'évolution de la classification des banques selon leur situation

financière.

La situation financière des banques dans la zone CEMAC

est en moyenne acceptable (bonne situation financière : cote 2). Elles

représente en moyenne près de 57% des banques de la sous

région. Les banques en très bonne situation financière

(cote 1) représentent un peu plus de 4,5%. Les banques en situation

financière fragile (cote 3) représente 20% et celles dont la

situation financière est critique (cote 4), 10%.

Figure 1: Cotation des banques en terme de santé

financière

3 Méthodologie : Une approche non

paramétrique

Dans cette section nous nous intéressons aux

méthodes statistiques utilisées dans toute notre analyse. Deux

étapes principales définissent toute notre analyse. Dans un

premier temps il s'agira d'évaluer empiriquement la surliquidité

bancaire dans la zone CEMAC. Pour cela nous allons procéder a des

régressions non paramétriques. Les méthodes que nous

présenterons sont celles développées par Hasti et

Tibshirani (1990). Le concept de surliquidité bancaire sera clairement

précisé. Dans un second temps, il s'agira d'évaluer

l'efficience technique des banques dans la zone CEMAC. Nous limiterons l'

analyse a l'efficience de transformation technique des dépôts en

crédits du fait des données dont on dispose.

Précisément, cette évaluation consistera en l' estimation

non paramétrique de la frontière technique afin de

déterminer les différents ratios d' efficience des banques. Cette

méthode d' estimation est fondée sur les travaux de Debreu (1951)

et Koopmans (1951) qui ont développé les concepts mesurables d'

efficience (Efficience technique et Efficience allocative). Il sera important a

la fin de ces estimations de procéder aux tests d'hypothèses par

la méthode Bootstrap afin d'inférer les différents

résultats de notre analyse.

3.1 Mesurer la surliquidité bancaire

Il est important avant de mesurer l'efcience des banques dans la

CEMAC de s'assurer que le problème de surliquidité peut

être considéré comme une évidence statistique.

3.1.1 Définir la surliquidité bancaire

Pour évaluer la surliquidité bancaire, on part

la plupart de temps du concept d' excédent de liquidité des

banques (bank excess liquidity). Mais il ne suffit pas d'observer l'existence

de l'excès de liquidité dans une banque pour conclure a la

surliquidité. D'après KIM (2002) la liquidité d'une banque

est sa capacité a faire face a ses engagements. Les banques conservent

ainsi les ressources liquides sous forme d'encaisse de précaution. La

surliquidité n'apparaIt que lorsque les réserves des banques

s'écartent fondamentalement de niveau optimal requis. DIAMOND et DYBVIG

(1983) formalisent cette idée en montrant qu'au delà du niveau

optimal, l'excès de liquidité explose. En d'autres termes, toute

variation permanente et en sens contraire des dépôts par rapport

aux crédits se traduira dans le temps par la surliquidité du

système bancaire. En fait, dans son calcul d'optimisation, les banques

saisissent toutes les nouvelles opportunités de dépôts pour

faire de nouveaux crédits suivant leur propre coefcient de

transformation. Ainsi, toute augmentation des dépôts devrait

être suivie par une hausse des crédits. S'il n'existe pas de

réaction a la hausse des crédits on pourrait croire a un

rationnement de crédit (BATTACHARYA et THAKOR, 1993) et dont a une

surliquidité du système.

Définition 1

On parle de surliquidité du système bancaire

lorsque le niveau de crédit, pour un niveau de transformation, n

'augmente pas dans une proportion près au niveau des

dépôts.

Pour tester la surliquidité du système bancaire

dans la CEMAC, nous allons tester la fonction de réaction des

crédits bancaires. Il est possible que les excès de

liquidité s' accroissent du fait du niveau très

élevé du risque des projets. Par contre, si pour un niveau de

risque donné, l'excès de liquidité augmente a taux

croissant, alors on peut conclure a la surliquidité.

Proposition 1

Supposons que l'offre de crédit C(t) des

banques soit unefonction linéaire des dépôts des clients

D(t) tel qu'il suit:

Ct = ñDt + u (1)

u la composante des autres déterminants et p

est le coefficient de réaction. Si pour tout t, p < 1 - r

(r le taux de réserve obligatoire) alors il y a

surliquidité du système bancaire.

3.1.2 Evaluer la surliquidité du système

bancaire

Pour évaluer la surliquidité du système

bancaire, nous allons estimer le modèle de régression suivant:

Ct=f(Dt)+Et (2)

et évaluer la dérivée première

f'(t) de la fonction de réaction. Si la dérivée

est positive et inférieur a 1 moins le taux de réserve

obligatoire, on pourra admettre l'hypothèse de surliquidité. La

proposition 1 ne donne aucune information dans le cas ott la fonction de

réaction n'est pas linéaire. Il est dans ce cas possible de

considérer que le coefficient de réaction p est variable et

d'admettre la surliquidité si le coefficient de réaction passe

significativement en dessous de 1 - r. On retiendra ainsi la

spécification suivante:

Ct = â(t)Dt + Et (3)

Nous n'allons pas procéder dans cette analyse a des

estimations paramétriques linéaires mais plutôt supposer

que la forme fonctionnelle de la relation est inconnue. Nous procéderons

donc a des estimations non paramétriques et semi paramétriques.

Les modèles non paramétriques ont été introduits

par Hasti et Tibshirani (1990). Cette idée de modèle flexible a

été étendue dans les estimations des modèles a

coefficient variant dans le temps par Hasti et Tibshirani (1993).

3.1.3 Estimations non paramétriques

Ces méthodes sont celles des modèles GAM qui

supposent que les relations entre la variable expliquée et chacune des

variables explicatives sont sous forme additionnelle et ne sont pas

forcément linéaires. 0n spécifie ainsi le modèle

suivant:

yi = a0 + f1(x1i) + f2(x2i) + ... + fk(xik) + Ei (4)

Ott yi est la variable endogène, xli l = 1. .k

les variables exogènes et f(l) des fonctions lisses

iid

inconnues. On supposera que le terme d'erreur Ei? N(0, 1). On

cherche a estimer les fonctions f(x) pour chaque point x. Les estimations des

noyaux de densité de fl() sont obtenues en utilisant la méthode

des moindres carrés ordinaires local (MCOL). On l'obtient en

minimisant

sous la contrainte que chaque point est borné, la somme

carrée des erreurs3:

(5)

(

n k (d2fl(xl))

k ) 2 Zb

yi-fl(xli)+Aldxl

dx2

a

i=1 l=1 j=1 l

Henderson et Ullah (2004) montrent que dans le cas ou les

erreurs sont autocorrélées, il est possible de tenir compte de

l'information contenue dans la matrice de variance covariance des erreurs en

appliquant les moindres carres ordinaires local pondérés (MCOLP).

Pour simplifier on peut supposer que les variables sont ordonnées et

écrire les contraintes de la façon suivante a < xl1 < ...

< xln < b. A le multiplicateur de Lagrange est le paramètre de

lissage et son choix joue un rôle très important4. Une

petite valeur de A réduit la variance de l'ajustement mais

élève le biais. On parle de substitution biais-variance (Hasti et

Tibshirani, 1990). Une façon de déterminer le paramètre de

lissage A est de recourir au critère GCV5 (Hasti et

Tibshirani, 1990, Chap 3). D'après ce critère, A est choisi de

façon à ce que

n GCV(A) =

1

|

n

l=1

|

!

yi - àâë(xi)

(6)

1 - tr(S)/n

|

|

soit minimal. S est une matrice appelée le lisseur et

àâë(xi) est l' ajustement au point xi. Ce

critère fonctionne comme le critère Ordinary Cross Validation

(OCV) : le model est ajuste aux données avec une observation en moins.

Ensuite, on mesure la différence carrée entre la valeur du point

ignoré et la prévision de ce point par le modèle. Le

processus est répété pour chacune des observations. On

calcule la différence moyenne entre le modèle (ajuster pour

toutes les observations à l'exception d'une observation) et les points

ignorés. Enfin, on cherche à minimiser cette différence

moyenne. L'idée est que si le modèle est un peu trop lisse ou

très peu lisse, il ne pourra pas faire une bonne prédiction de l'

observation ignorée dans le processus d'ajustement. La différence

entre OCV et GCV est que le critère GCV remplace les

éléments de la diagonale du lisseur par leur valeur moyenne,

tr(S)/n qui est plus facile à calculer. Il faut enfin noter que pour un

grand nombre d'observations, les estimateurs MCOLP sont asymptotiquement sans

biais et de variance minimale (Lin et R. J. Carroll, 2000).

3.2 Frontière technique et efficiences

techniques

La méthode DEA est utilisée pour analyser les

efficiences relatives et les performances managériales des unités

de production utilisant les mêmes facteurs de production. Cette

méthode nous

3Voir Ryan (1997)

4Voir Fan et Gijbels (1992) et Pagan et Ullah (1999)

pour des détails 5Generalized Cross Validation

permet de comparer les efficiences relatives de l'industrie

bancaire en mesurant une frontière d' efficacité et en

déterminant les inefficiences techniques des banques par rapport a cette

frontière. Depuis les années 80, plusieurs analyses de

l'efficience de l'industrie bancaire ont adopté cette

approche6

3.2.1 Pertinence de l'approche

Pour développer une approche déterministe

d'estimation de la frontière d'efficience, on part du fait qu'il existe

une unique frontière de production du système bancaire a chaque

date. De plus, on admettra que toutes les banques contribuent a la

définition de la frontière et leur système de production

est contraint par cette unique fonction de production. Considérons Yi,t

= Ft(Xi,t) la fonction de production avec l'indice banque i = 1, ...m et

l'indice temporel t = 1, ...T. La matrice d'inputsXi,tindique le

panier de facteurs de production utilisé par la banque i a la date t. Il

est ainsi possible pour chaque banque de définir un indice d'efficience

technique. On notera ainsi:

La méthode DEA permet ainsi pour un ensemble de

production donné d'estimer les indices d'efficience de chaque

banqueAi,tE [0 1] pour tout (i, t) E {1, ..., m} x {0, ..., T}.

L'efficience telle que spécifiée a l'équation 7 est neutre

car la distance a la frontière technologique est orthogonale

àl'espace engendré par les inputs. Avec l'approche DEA, il est

possible de spécifier plusieurs types de distance a la

frontière.

Les pionniers dans l'approche DEA sont Farrell (1957) et

Afriat (1972). Deux principales tendances dominent cette méthode: le

modèle de Charnes et al. (1978) (CCR) qui consiste a maximiser le ratio

output pondéré sur input pondéré, et le

modèle de Banker et al. (1984) qui, contrairement au modèle CCR,

admet des rendements d'échelle variables. Le second modèle permet

d' estimer les coefficients d' efficience technique purs. L' approche

générale consiste a déterminer la borne supérieure

du plus petit ensemble convexe regroupant les données.

Le premier indice d' efficience développé par

Debreu (1951) est en fait un coefficient d'utilisation optimale des ressources.

Cet indice est inférieur a 1 si l'utilisation des ressources n' est pas

optimal et se décompose en:

6On peut citer a titre d'exemple Sherman et Gold

(1985), Rangan et al. (1988), Ferrier et Lovell (1990), Alyet al. (1990),

Elayasiani et Mehdian (1990), Berg et al. (1993), Brockett et al. , et

plusieurs autres publications...

· la sous utilisation des ressources physiques;

· l'inefficience technique des unités de

production;

· l'inefficience de l'organisation économique.

Debreu (1951) pour calculer cet indice multiplie la distance

entre les ressources optimales et les ressources disponibles par le prix pour

chaque bien, ensuite divise la somme sur tous les biens par l'indice

général des prix. On parle d'efficience allocative de

production.OR

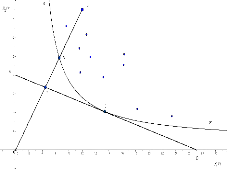

OQ tel que

représenté a la figure 2 représente

l'efficience allocative telle que définie par Debreu (1951). Cet indice

ne respecte pas la caractéristique "homothétie" du fait que la

quantité disponible peut être inférieure ou

supérieure a la quantité optimale. Une autre mesure d' efficience

technique est celle de Farrell (1957) que l'on considère comme

l'efficience technique de production, soit la production maximale que l'on peut

obtenir d'un processus fixe a partir d'inputs donnés.

OQ

OP représente sur la figure 2 l'efficience technique

de production. La difficulté ici est qu'il est important pour cette

mesure de connaltre la fonction de production efficiente. D'oü

l'intérêt de rechercher dans un premier temps la fonction de

production efficiente a partir des observations avant de calculer l'efficience

de chaque unité de production. En supposant que la courbe d'isoproduit

est convexe par rapport a l'origine et que les rendements sont constants, la

courbe 88* toujours sur la figure 2 représente l'estimation

de l'isoproduit efficient.

Figure 2: Frontière d'efficience sur un ensemble

convexe: Efficience Allocative et Efficience Technique. Cette

présentation graphique est inspirée de deux graphiques de Farrell

(1957). Les unités Q et C sont efficientes dans ce système de

production hypothétique.

3.2.2 DEA : un estimateur statique

Considérons pour chaque banque i = 1, ..., N, à

chaque date t = 1, ..., T, un vecteur d'inputs Xi,t un vecteur d'outputs Yi,t E

p +. On supposera que chaque banque est soumise à une date

donnée à un unique niveau efficace de production

tel que Y*

i,t = Ft(Xi,t).Ft : X ? <+ est la

borne supérieure de l' ensemble de production à la

date t

Définition 2

Le niveau ef~cace de production est le maximum de produit

qu'une banque peut obtenir pour un panier d'inputs donné.

On appelle de façon alternative cette efficacité,

la capacité de mise en oeuvre par une banque de la technologie de

transformation disponible dans le système à la date t ou distance

à la

frontière technologique du système. On

note:ei,t= Y *

i,t- Yi,t.

De façon formelle, l' estimateur DEA de la

frontière technologique est donnée par le programme

linéaire suivant:

àFt(X)=max{YE <+/Y=

|

XN

i=1

|

ëi,tYi,t etXi,t~

|

XN

i=1

|

ëi,tUi,t} (8)

|

|

avec U les différents facteurs.

Dans cette optimisation, on a X = ?Xi,t et Y = ?Yi, t. Les

paramètres de lissage {ëi,t}N i=1 sont tels

queëi,t~ 0 etPN i=1 ëi,t= 1. Deux cas de figure

sont couramment envisagés:

· Si on n'impose aucune condition sur laPn j=1

ëj alors il s'agit d'un modèle DEA avec rendements d'

échelle constants tel que développé par Charnes et al.

(1978).

· Si par contre on considère quePn j=1

ëj= 1 on est dans le cadre d'un modèle DEA avec des

rendements d' échelle variables tel que développé par

Banker et al. (1984).

Banker (1993) formule les hypothèses suivantes pour

caractériser les ensembles de production:

· L' ensemble d' inputs est convexe et compacte

· La fonction de production Ft est croissante

monotone et concave

· La fonction de production Ft enveloppe chaque

output Yi,t à la date t

· A la date t, si une fonction satisfait aux

hypothèses de monotonicité, concavité et enveloppement,

alors elle est inférieure à Ft

De l' estimation de la frontière, l' on peut

déduire l'indice d' efcience définit au sens de Farrell (1957)

selon la minimisation suivante:

E( Yi,t, Xi, t) =

min{ë/(Yi,t/ë, Xi,t)E

Ft} (9)

Cet indice de Farrell-Debreu est l'inverse de la proportion

dans laquelle l'output peut être amélioré étant

donnés la technologie et les quantités. Cet indice sera ainsi

calculé en résolvant le problème pour chaque banque de

l'échantillon. Cet indice est égal a 1 pour les unités

efcientes et inférieur a 1 pour celles sous efficientes.

Les propriétés statistiques de l'estimateur

DEA ne sont pas faciles a mettre en évidence du fait qu'il

s'agit d'un estimateur non paramétrique (l'estimation d'un ensemble de

points). Banker (1993) montre que l'estimateur DEA est un estimateur

convergent dont la vitesse de convergence dépend du paramètre de

lissage de la fonction de production. Par contre, cet estimateur est purement

statique et sous estime énormément la vraie frontière

technologique. De plus il laisse la possibilité d'une implosion de la

technologie du fait que l'inefcience des unités les plus performantes

réduit la frontière estimée d'une période a une

autre. Pour éviter ce problème d' implosion, on considère

qu' il existe une suite croissante d' ensembles de production (R())i avec {t =

0, ..., T}7. Ainsi, pour estimer la frontière

technologique a la date T, il est important de considérer la

réunion des ensembles de production entre t = 0 et t = T, d'oü

l'intérêt de définir un estimateur dynamique.

3.2.3 Estimateur Dynamique

Si nous admettons que les ensembles de production

représentent une suite croissante, alors les banques sont touj ours

capables de définir une combinaison convexe entre les technologies

présentes et celles passées. Sous cette base, il est donc

possible a partir de l' estimateur statique de construire un estimateur

dynamique qui enveloppe toutes les technologies passées. L'algorithme

suivant nous a permit d'estimer la frontière d'efcacité technique

dynamique entre une date 0 etT.

Algorithme 1

1. Pour t = 0 estimer la frontiere technologique

F0 en utilisant l 'estimateur statique defini

par l'équation 8 et determiner les banques sur lafrontiere.

7Voir Diewert (1980) pour le développement

d'une procédure similaire

2. Sélectionner toutes les observations a la date

t = 0 avec un nouvel identi~ant et les rajouter dans

l'échantillon observé a la date t = 1.

3. Construire lafrontiere F1 sur la base

du nouvel échantillon toujours en utilisant l'équation 8.

4. Sélectionner toutes les observations a la date

t = 1 avec un nouvel identi~ant et les rajouter dans

l'échantillon observé a la date t = 2 puis reprendre

l'étape 3.

5. Continuer ainsijusqu'à la date T

De cet algorithme on obtient une suite de frontière

efficace croissante qui préserve les caractéristiques de l'

estimateur statique. En fait, les ensembles de production étant une

suite croissante, si chaque ensemble est convexe, alors leur réunion est

convexe. L'estimateur dynamique comme l'estimateur statique converge vers la

vraie frontière technologique. Bien qu'il ait plus d'information que

l'estimateur statique, il sous estime toujours la vraie frontière

d'efficacité.

3.3 Tests d'hypothèse: approche Bootstrap

Dans cette analyse, nous allons procéder aux tests d'

hypothèses du modèle en terme de spécification et de

validation. Dans un premier temps, nous allons vérifier

l'hypothèse de convexité de l'ensemble de production du

système bancaire. En fait l'approche DEA est fondée sur la

convexité de l'ensemble de production. Il est important de

vérifier la convexité de l'ensemble de production du

système pour s'assurer de la qualité des scores d'efficience.

Dans un second temps, nous allons tester la signification des scores moyens d'

efficience dans le système bancaire de la CEMAC. La véritable

difficulté de ces tests est que les scores sont des valeurs

déterministes et non stochastiques. Il est dans ce cas impossible de

procéder aux tests classiques. Pour cela nous proposons

d'élaborer les tests d'hypothèses a partir des procédures

Bootstrap.

3.3.1 Tester la convexité de l'ensemble de

production

Dans la littérature des estimations non

paramétriques, il est possible d' estimer la frontière

technologique sans faire recours a l'hypothèse de convexité de

l'ensemble de production. Si le couple (X, Y) appartient a l'ensemble de

production alors (X, A1Y) et (A2X, Y) appartiennent aussi a l' ensemble de

production avec A1 ? [0 1] et A2 > 1. On parle dans ce cas de Free

Disposal Hull (FDH). Deprins et al. (1984) définissent un

estimateur pour le plus petit estimateur

enveloppant les données. Cet ensemble est contenu ou

égale à l'enveloppe convexe. Tester de la convexité de l'

ensemble de production revient à voir si ces deux ensembles sont

sensiblement les mêmes, soit l' égalité entre la

frontière DEA et la frontière FDH.

Estimateur FDH

Définition 3

Soient (Xi, Yi)i=1

N l'ensemble de production du système observe a une

période, l'estimateur FDH de lafrontière de production du

système est defini comme suit:

èà={(X,y) |? i/X~xi ety = yi} (10)

Par construction, l'ensemble de production défini par

FDH est inclut dans l'ensemble de production DEA. Ainsi, il est possible de

déduire la frontière FDH à partir de la frontière

DEA. Mais dans ce cas, nous allons reprendre le programme pour déduire

l'estimateur FDH. Les analyses sont similaires à l'approche DEA. Si

l'indice d'efficience est égal à 1 alors la banque se situe sur

la frontière technologique, sinon elle est inefficiente. Pour estimer la

frontière FDH, on résout le programme linéaire suivant:

Soit àDFDH

i la distance à la frontière FDH,

i=1...N

[àDFDH(x i, yi)]-1

= max

è,{Ai}

Sous les contraintes suivantes:

èyi = XN )kyk

k=1

xi,l ~ XN )kxk,l

k=1

XN )i =1 et )i ?[01].

i=1

Park et al. (2000) analyse les propriétés de

l'estimateur et montre que comme DEA, cet estimateur converge vers la vraie

frontière mais à une vitesse plus faible. Il montre ainsi que la

distribution asymptotique de la distance normalisée par la taille est

une loi de weibull. Avec l' estimateur FDH, Park et al. (2000) dérivent

des intervalles de confiance et teste si une unité est inefficace.

Formulation du test de distance

Nous allons développé un test de distance entre

deux fonctions : Fdea : N --* [0 1] et Ffdh : N --* [0

1]. Les hypothèses du test sont:

H0 Fdea = Ffdh (Ensemble

convexe)

H1 F dea > Ffdh (Ensemble non convexe)

On peut comme Adjemian (2002) ramener ce test à un test de

ratio des distances. On considère la statistique suivante:

àDDEA

i ,(11)

àDFDH

i

R = m-1 Xn

i=1

on teste R = 1(comvexit'e) contre R < 1(mom comvexit'e).

Btant donné qu'on ignore la distribution de R sous l'hypothèse

nulle, nous allons utiliser les procédures de

rééchantillonnage bootstrap developpées par Bfron (1979).

La difficulté de la procédure bootstrap est que

l'échantillon à partir duquel on fait le

rééchantillonnage est bornée par0 et 1. Or pour des

variables aléatoires continues, la probabilité d'observer une

banque sur la frontière est 0. Il n'est donc pas possible de reproduire

la distribution des distances sous l'hypothèse nulle en

échantillonnant directement. Simar et Wilson (1998) a mis en oeuvre la

procédure Smooth Bootstrap pour résoudre la

difficulté. Btant donné m efficiences estimées et

bornées soit par 0 ou par 1, on estime dans un premier temps la

densité bornée de l' efficience par l' estimateur de noyau et on

rééchantillonne à partir des probabilités

homogènes estimées.

3.3.2 Score d'efcience et intervalles de confiance

Nous allons toujours par des procédures bootstrap faire

de l'inférence statistique sur les différents scores d'

efficience pour analyser leur significativité. La procédure

smooth bootstrap per-met de rééchantillonner les données

et d' estimer pour chaque cas les coefficients d' efficience. La

réplication permet de déterminer la distribution des

différents scores et d' en déduire un intervalle de confiance.

Cette procédure nous permettra de montrer que l'estimateur dynamique

sous estime la vraie frontière technologique. Nous allons calculer le

biais engendré par l' estimateur et dériver l'intervalle de

confiance de la distance à la frontière technologique. On peut

considérer que le biais sur les indices d' efficience sont tel qu' il

suit:

biais = E( àeff) -- eff

.

3.4 Spécification des Données de

l'analyse

Les données de cette analyse proviennent de la

déclaration de bilan des banques auprès de la COBAC. La

confidentialité des données ne nous a pas permis pas d'

accéder a toute l' information sur ces déclarations. Pour cela,

notre analyse va se limiter a certaines variables du bilan, ignorant ici les

caractéristiques telles que l'état du personnel, les

investissements des banques, le portefeuille ou l'origine du capital...

3.4.1 Variables de la fonction de réaction

L'analyse de la surliquidité des banques va se limiter a

une évaluation entre les dépôts des clients :

· DEP dépôts du public

· DTER dépôts a terme

· DVU dépôts a court terme et les

crédits :

· CRENET credits nets

· CRELG crédits a long terme

· CREMY crédits a moyen terme

· CRECR crédits de court terme

les différentes variables de contrôle seront:

· EXTRE excédents ou déficits de

trésorerie

· FPA Fond propre net

· CREDOU créances douteuses

· ACT total actifs (Taille de la banque)

3.4.2 Variables de la frontière d'efficacité

Pour l' estimation de la frontière d' efficacité

du système bancaire, nous allons considérer deux groupes de

variables, les inputs et les outputs.

Les Inputs

Nous retiendrons comme intrant dans la fonction de production

des banques:

· Les dépôts du secteur publique DPU

· Les dépôts du secteur privé DPRI

· Les fonds propres nets FPA

· Les provisions pour dépréciation des

comptes PROV

Il aurait été intéressant dans cette

analyse de disposer des informations sur les dépenses en salaire et la

proportion des managers dans la main d'oeuvre.

Les Outputs

Les outputs de la fonction de production sont:

· Le taux de transformation des dépôts en

crédits RATIODC8

· Crédits au secteur publique CREPU

· Crédits au secteur privé CREPRI

4 Analyse des résultats

En utilisant la méthode d'estimation non

paramétrique, nous allons dans un premier temps évaluer la

surliquidité bancaire dans la CEMAC. L'objectif est de déterminer

les sources de l'excès de liquidité des banques de la CEMAC. Dans

un second temps, nous allons estimer par l'approche DEA appliquée au

bootstrap les scores d'efficience. Deux éléments principaux vont

déterminer cette analyse : le niveau moyen d'efficience des banques et

l'évolution de l' efcience.

4.1 Excès de liquidité des banques :

inefficience ou optimalité

Nous avons spéciflé dans cette analyse

l'équation de réaction suivante:

CRENET = f1(DEP) + f2(EXTRE) + f3(CREDOU) + f4(FPA1) + f5(ACT)

(12)

8On rappelle que RATIODC = CRENET/DEP.

140000 160000 180000 200000 220000

CREDOU_1

La figure 3 montre les courbes lisses de la fonction de

réaction. On constate qu'il existe une relation linéaire entre

les crédits nets et les dépôts dans les banques de la CEMAC

entre 2001 et 2005. La linéarité de la relation est

indiquée par le critère GCV qui est égale à 1.1

pour f19

FPA_1

ACT_1

1600000 2000000 2400000

DEP_1

100000 150000 200000 250000

EXTRE_1

400000 600000 800000 1200000

114 116 118 120 122 124

Figure 3: Evolution comparée des dépôts et

des crédits dans la CEMAC entre 2001 et 2005

On peut donc conclure que les crédits offerts par les

banques dans la zone CEMAC augmente proportionnellement aux

dépôts. On peut entre autre noter que les crédits diminuent

avec les excédents de trésorerie indiquant que les banques dans

le souci de faire des excédents de trésorerie compriment les

crédits. Les créances douteuses ne présentent pas une

influence importante sur les crédits, de même pour les fonds

propres nets. Par contre les crédits offerts augmentent avec la taille

des banques notamment pour les banques relativement importantes.

Etant donné que la réaction des crédits

aux dépôts des clients est linéaire on peut estimer le

coefficient de réaction afin de tester la surliquidité des

banques. Le tableau 5 indique l' estimation du coefficient de réaction

des crédits aux dépôts entre 2001 et 2005. On peut observer

que le coefficient de réaction est statistiquement

significatif10 à 0,1% et p = 0, 86. Si on admet un niveau

moyen de réserves obligatoires de 12%11, on aura p < 1 -

ô = 0,88. Sur la base de notre estimation, on peut conclure que le

système bancaire entre 2001 et 2005 est sur-

9Lorsque le critère GCV est proche de 1, on

pense à une relation linéaire. Dans le cas contraire, la relation

est

non linéaire.

10 * * *, **, * indiquent respectivement la

significativité à 0,1%, 1% et 5%.

11Le taux de réserve obligatoire

depuis quelques années est variable autour de 12%

|

Variable endogène =

|

CRENET

|

|

Estimate

|

Ecart type

|

t student

|

P.value

|

|

Constant

|

-2.73496

|

5.56911

|

-0.491

|

0.625349

|

|

DEP

|

0.86346

|

0.05803

|

14.880

|

2.00E_16***

|

|

EXTRE

|

-0.75268

|

0.05850

|

-12.866

|

2.00E_16***

|

|

CREDOU

|

0.68727

|

0.19065

|

3.605

|

0.000682***

|

|

FPA

|

0.07337

|

0.12851

|

0.571

|

0.570444

|

|

ACT

|

-255.37216

|

520.00539

|

-0.491

|

0.625349

|

|

R_adj

|

0.973

|

variation expliquée

|

97.5%

|

|

|

GCVscore=

|

0.000205 14

|

n

|

59

|

|

Tableau 5: Estimation paramétrique de la fonction de

réaction

liquide. Ce résultat corrobore le fait que la

proportion des crédits dans les dépôts est passée de

0,70 en 2001 à 0,55 en 2005(COBAC, 2006). Pour mieux comprendre cette

surliquidité, nous avons estimé la fonction de réaction

pour les différents types de dépôts.

La figure 8 en annexe montre que les crédits de long

terme ne sont pas financés par les dépôts à long

terme (réaction quasi nulle) mais il existe une relation positive entre

crédits à terme et les fonds propres nets des banques. On peut

donc comprendre comme l'indique le graphique que les créances douteuses

n' aient aucune influence sur les crédits de long terme. En fait ce

comportement des banques matérialise le fait que la plupart des banques

sont des structures d' associé qui servent à financer les

activités des propriétaires. Les crédits à moyen

terme sont financés dans une faible proportion par les

dépôts à terme et le reste positivement

corrélés aux fonds propres des banques (Voir figure 9 en

annexe).

La grande proportion des crédits de court terme est

financée par les dépôts de long terme (Voir figure 10 en

annexe). Ce type de crédits est fortement influencé à la

baisse par le niveau des créances douteuses et évoluent fortement

avec la taille des banques. La figure 11 indique que la grande proportion des

crédits de court terme est financée sur les dépôts

de court terme, mais cette relation est presque inexistante pour les banques de

petite taille.

La figure 12 en annexe montre que la fonction de

réaction des crédits à terme par rapport aux

dépôts à terme est non linéaire et

décroissante. On peut conclure que les banques de la CEMAC ne

transforment pas les dépôts à court terme en crédits

à terme. Il existe toutefois une relation linéaire et positive

entre les crédits à moyen terme et les dépôts

à court terme(Voir figure 13).

Seulement le coefficient réaction estimé des

crédits de moyen terme par rapport aux dépôts de court

terme est faible et très inférieur 1 moins le taux moyen de

réserve obligatoire (6). Ces

|

Variable endogène =

|

CREMY

|

|

|

estimation

|

Ecart type

|

t.student

|

p.valeur

|

|

Constante

|

-1.150e+01

|

4.719e+00

|

-2.437

|

0.0181*

|

|

DVU

|

3.439e-01

|

7.998e-02

|

4.300

|

7.20e-05***

|

|

EXTRE

|

-1.831e-01

|

7.315e-02

|

-2.504

|

0.0153*

|

|

CREDOU

|

-1.937e-01

|

2.009e-01

|

-0.964

|

0.3392

|

|

FPA

|

1.122

|

1.414e-01

|

7.935

|

1.26e-10***

|

|

ACT

|

-1.141e+03

|

4.680e+02

|

-2.437

|

0.0181*

|

Tableau 6: Estimation paramétrique de la réaction

des crédits à moyen terme par rapport aux dépôts

à vue

deux dernières estimations montre que les banques entre

2001 et 2005 ne jouent pas leur rôle de transformation des

dépôts à court terme en crédits à moyen et

long terme.

De façon générale on remarque que les

banques de la CEMAC ne prennent presque pas de risque en matière de

crédits. En fait elles ont tendance à limiter leurs risques en

finançant les crédits à court et moyen terme par les

dépôts à terme et en rationnant les crédits à

terme. Contrairement aux estimations, on se serait attendu à ce qu'

elles financent les crédits à moyen et longs termes par les

dépôts à court terme. Dans la majorité des cas elles

financent essentiellement les activités de court terme. Les

résultats de cette analyse confirment l' appréhension selon

laquelle les activités des banques sont tournées vers le court

terme (Voir sous section 2.1.3 de la page 6) rendant inexistant dans la zone le

financement des activité de long terme tels que les projets d'

investissement.

4.2 Estimation dynamique de la frontière

d'ef~cacité

Contrairement à la majorité des analyses qui ne

vérifient pas l'hypothèse de convexité de l' ensemble de

production avant d'interpréter les coefficients d' efficience, nous

testons dans cette analyse la convexité de l' ensemble de production

nécessaire à l' application de la méthode DEA. Nous

présentons ensuite l' évolution des scores d' efficience des

banques de façon générale, par pays et selon la taille. Il

est important de noter que l'approche étant déterministe, il est

important d' estimer un intervalle de confiance par

rééchantillonnage.

4.2.1 Convexité de l'ensemble de production

Nous avons appliqué le test spécifié a la

page 19 pour l'année 2005 en considérant la mémoire de

chaque banque sur les cinq années. Il n'est pas possible de

procéder a ce test au cours des premières années dans la

mesure ott on ne dispose pas suffisamment d'information sur le passé des

banques. En appliquant 1000 ré échantillonnages par le

procédure smooth bootstrap, on obtient la distribution de la

statistique de test R par l'estimation des densités de noyau (Voir

figure 4). La statistique calculée sur l'échantillon est R

=0.564. On constate sur la figure 4 que

?

????

?? ?? ???

? ?

? ?

? ? ?

? ? ?

??

? ? ? ?

?

? 0.564302183597292

??

?

?

? ? ? ? ? ? ? ? ?

???? ?

???????

??? ????????

0.0 0.5 1.0

Rcalculé

Figure 4: Distribution de la statistique R

la probabilité calculée de la statistique est

élevée. On ne peut donc pas rejeter l'hypothèse de

convexité de l' ensemble de convexité nécessaire a l'

ensemble de production.

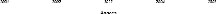

4.2.2 Efficience des banques : Role

d'intermédiation

Un résultat intéressant de notre analyse est que

l' efficience technique des banques dans la zone CEMAC dépend fortement

du pays de localisation de la banque et de sa taille. Nous présentons

ici les résultats de ce que nous pouvons considérer comme

l'efficience en terme de transformation des dépôts en

crédits. Notons toutefois que dans cette approche, le processus de

production est une boIte noire dans laquelle l'efficience est

évaluée a partir du niveau d'output produit a partir d'input

donnés. Il est possible qu'une banque efficiente dans notre analyse soit

totalement incapable de gérer les crédits déjà

offerts.

Efficience des banques : résultat

général

L' estimation des coefficients d' efficience des banques a

partir de l' estimateur dynamique nous a permis d'évaluer les niveaux

moyens d'efficience comparables d'une année a une autre. Les

études telles que Igor et Boris (2002), Elayasiani et Mehdian (1990) ou

Sherman et Gold (1985) concluent a des niveaux moyen d'efficience

élevés parce qu'ils se limitent a un estimateur statique. Et dans

le cadre des banques, l'estimateur statique indique juste la meilleure

pratique a un moment t et non fondamentalement l'efficience. Le tableau 7

indique les niveaux moyens d'efficience technique des banques dans le CEMAC. On

constate aisément que le ni-

|

Périodes

|

2001

|

2002

|

2003

|

2004

|

2005

|

|

Nbre de banques

|

24

|

24

|

24

|

24

|

24

|

|

Nbre de banques efficientes

|

2

|

2

|

2

|

5

|

4

|

|

Efficience moyenne

|

0,18 1

|

0,197

|

0,275

|

0,390

|

0,305

|

|

Inefficience moyenne

|

4,512

|

4,074

|

2,636

|

1,567

|

2,274

|

Tableau 7: Efficience technique moyenne des banques de la

CEMAC

veau moyen d'efficience de la zone au cours de la

période 200 1-2005 est très faible et largement inférieur

a 0,4. Le nombre de banque se trouvant sur la frontière d' efficience

est assez faible. Sur les 24 banques de notre échantillon, 2 a 5 banques

sont situées sur la frontière. Cette forte inefficience des

banques peut être attribuée a l'incapacité des banques de

la zone a transformer les dépôts a terme en crédits a terme

comme nous l'avons indiqué a la page 23.

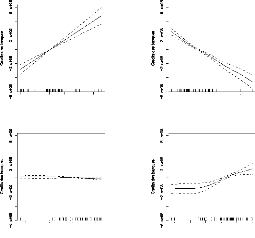

D'autre part on peut constater sur la figure 5 que la

dynamique de l'efficience moyenne est croissante avec une chute après

2004. Cette chute résulte de la chute d' efficience de la seule banque

Congolaise de notre échantillon après 2004 (Voir figure 6 On peut

dire que l'efficacité des banques de la zone CEMAC s'est

améliorée au cours de la période 200 1-2005 avec une

légère baisse en 2005.

Nous avons pu a partir des procédures de

rééchantillonnage déterminer la variance des estimateurs

d' efficience et déduire des intervalles de confiance des scores. La

figure 8 montre qu' a l' exception de 2001, les coefficients d' efficience

estimés sont hors de l' intervalle de confiance. Ceci traduit le fait

que l' estimateur DEA a surévaluer l' efficience des banques de la zone.

Les intervalles de confiance ainsi calculés nous donnent une meilleure

appréciation de l'inefficience des banques.

Figure 5: Evolution de l'efficience moyenne des banques de la

CEMAC

Intervalle de confiance

|

2001

|

2002

|

2003

|

2004

|

2005

|

|

Efficience Moyenne Inefficience Moyenne

|

[0,152 [5,579

|

0,104] 8,643]

|

[0,152 [5,593

|

0,109] 8,195]

|

[0,234 [3,268

|

0,166] 5,029]

|

[0,3 19 [2,140

|

0,229] 3,358]

|

[0,244 [3,103

|

0,175] 4,701]

|

Tableau 8: Intervalle de confiance des efficiences moyennes par

procédures bootstrap

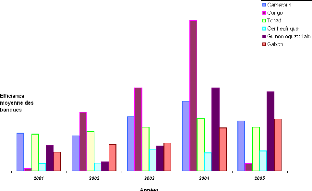

Efficience des banques : résultat par pays

Les coefficients moyens d'efficience évalués par

pays indiquent que le niveau d'efficience dépend fortement du pays dans

lequel est localisée la banque. Le tableau 9 indique les

différents niveaux d'efficience par pays entre 200 1-2005. Le cas du

Congo est extrême du fait qu'il n'y a qu'une seule banque Congolaise dans

notre échantillon. Si on ignore le Congo, on voit sur le

|

Périodes

|

2001

|

2002

|

2003

|

2004

|

2005

|

|

Cameroun

|

0,25 1

|

0,234

|

0,362

|

0,464

|

0,33 1

|

|

Congo

|

0,015

|

0,390

|

0,553

|

1,000

|

0,050

|

|

Tchad

|

0,244

|

0,262

|

0,29 1

|

0,350

|

0,290

|

|

Centrafrique

|

0,051

|

0,053

|

0,145

|

0,120

|

0,133

|

|

Guinée équatoriale

|

0,171

|

0,060

|

0,165

|

0,550

|

0,525

|

|

Gabon

|

0,124

|

0,176

|

0,186

|

0,286

|

0,346

|

Tableau 9: Efficience technique moyenne des banques

groupées par pays

tableau 9 que les niveaux moyen d'efficience les plus

élevés se trouve dans les banques camerounaise. La figure 6

montre la dynamique d'efficience par pays. A partir de cette dynamique

on peut classer les pays de la CEMAC en terme d'efficience

technique de leur banques. Cette

Figure 6: Evolution de l'efficience moyenne par pays

classification montre une forte corrélation entre le

niveau d'efficience du pays et le nombre de banque dans le pays. On obtient

ainsi le classement suivant:

1ier Congo : 4 banques;

2ieme Cameroun: 10 banques;

3ieme Tchad: 7 banques

4ieme Guinée Equatoriale : 3 banques

5ieme Gabon: 6 banques

6ieme Centrafrique: 3 banques

Les pays ayant un grand nombre de banques et présentant

une forte concurrence entre les banques semblent ceux ayant les niveaux

d'efficience moyen les plus élevés.

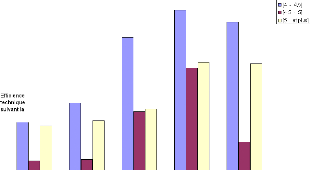

Efficience des banques : résultat suivant la taille

Nous avons ici classifié les banques de la zone CEMAC

en trois groupes selon leur taille. Nous avons retenu trois classes : Grande

taille (4-4,5), Moyenne taille (4,5-5) et Petite taille (5-5,5). Il faut

toutefois noter que les banques au cours du temps sont passées d'un

groupe a un autre changeant la composition de chaque groupe. Le tableau 10

indique les niveaux moyens d'efficience technique par groupe entre 2001 et

2005. On constate que sur toute la période, les

Périodes 2001 2002 2003 2004 2005

[4-4,5] 0,208 0,256 0,4 17 0,484 0,455

[4,5-5] 0,113 0,117 0,235 0,343 0,160

[5 - et plus] 0,199 0,212 0,241 0,356 0,353

Tableau 10: Efficience technique des banques selon la taille

(Actif en logarithme)

banques de petite taille sont techniquement les plus

efficientes. De façon générale, le niveau d'efficience par

groupe de banque respecte la distribution en forme de U sur les 5 ans (Voir

figure 7). Ceci traduit le fait que les banques de petite et de grande taille

sont les plus efficientes en terme de transformation de leurs

dépôts en crédits. Les grandes banques dans ce contexte

sont beaucoup plus orientées vers les activités a terme alors que

les petites banques le sont dans les activités a très court

terme. Les banques de taille moyenne sont pour la plupart relativement

inefficientes (Voir 7). Ce résultat sur la forme en U de la distribution

est conforme a celui de

Figure 7: Evolution de l'efficience technique selon la taille des

banques

Igor et Boris (2002) trouvé dans le cas de la croatie.

5 Conclusion

L' objectif de ce travail était d' évaluer l'

efficience technique des banques de la CEMAC en relation avec les

excédents de liquidité observés dans leur

trésorerie ces dernières années. Il s' est agit dans un

premier temps d'évaluer la surliquidité des banques sur la base

d'une définition formelle et dans un second temps d' évaluer l'

efficience technique des banques.

Nous avons pu montrer à partir des estimations non

paramétriques que de façon globale, entre 2001 et 2005 les

crédits ont réagit positivement, mais faiblement (à un

taux inférieur à 1 moins le taux de réserve obligatoire)

face à l' augmentation des dépôts des clients confirmant

l'idée de surliquidité des banques. En procédant à

des estimations à des niveaux plus désagrégés, nous

avons montré que les banques ne financent pas les crédits

à moyen et long terme par les dépôts à court terme.

Au contraire elles utilisent les dépôts à terme pour

financer les crédits à moyen et court terme. Ceci crée un

niveau élevé de besoin en crédit de long terme dans la

zone. L' inefficience observée dans cette l' analyse relève est

l' incapacité des banques de la zone CEMAC à transformer les

dépôts à vue et à terme en crédit à

moyen et long terme.

Nous avons ensuite estimé les frontières

dynamiques d'efficacité entre 2001 et 2005. Les scores d' efficience

ainsi estimés ont montré que le niveau d' efficience des banques

dans la zone est resté assez faible malgré un accroissement de

l'efficience moyenne. Il a été observé une relation

positive entre le nombre de banques dans un pays et l'efficience moyenne de ce

pays. Enfin nous avons montré que les banques de grandes et petites

tailles sont en majorité plus efficientes que les banques de taille

moyenne.

De façon générale, il est apparu que dans

la zone CEMAC, les banques sont en moyenne inefficiente. Leur inefficience

indique leur incapacité à financer les crédits à

terme. Il est donc important que la politique financière de la BEAC vise

à améliorer la visibilité qui existerait entre les

potentiels demandeurs de crédit à terme et les banques. Il serait

aussi important de favoriser la création ou la réhabilitation des

banques d'investissement qui financeraient les projets de long terme.

Références

Adjemian, Stephan (2002). Divergence des Nation et

Progrès Technique. Thèse du doctorat, Université

d'Evry-Val-d'Essonne.

Afriat (1972). <<Efficiency estimation of production

functions>>. International Economic Review, 13, pages

568-598.

Aly, R, H Y Grabowski, C Pasurka et N Rangan (1990).

<<Technical, scale, and allocative efficiencies in

u.s. banking: An

empirical investigation>>. Review of Economics and Statistics,

72, pages 211-218.

Banker, Rajiv D (1993). <<Maximum likelihood, consistency

and data envelopment analysis : A statistical foundation>>.

Management Science, 39, pages 1265-1273.

Banker, R D, A. Charnes et W W Cooper (1984). <<Some models

for estimating technical and scale inefficiencies in data envelopment

analysis>>. Management Science, 30, pages 1078-1092.

BATTACHARYA, S N et A V THAKOR (1993). <<Contemporary

banking theory>>. Journal of Financial Intermediation, 3.

Bekolo, Ebe Bruno (2001). <<La nouvelle politique de la

beac>>. In Dynamique de developpement. Université de

yaoundé II, Présenté au Colloque Georges Ngango.

Berg, A S, C A Claussen et R F Forsund (1993). <<Banking

efficiency in nordic countries: A multi-output analysis>>. Papier d'

études, no. 3, Research paper, Norges Bank.

Brockett, P L, A Charnes, W W Cooper, Z M Huang et D B Sun.

<<Data transformations in dea cone-ratio envelopment approaches for

monitoring bank performances>>. European Journal of Operational

Research, 98, pages 25 1-269, year = 1997,.

Charnes, A, W W Cooper et E Rhodes (1978). <<Measuring the

efficiency of decision making units>>.

European Journal of Operational Research, 2, pages

429-444.

COBAC (2006). <<Situation du système bancaire de la

cemac au 31 décembre 2005>>. Document de

travail interne, 19.

Debreu, Gerard (1951). <<The coefficient of resource

utilization>>. Econometrica, 19, pages 273-292.

Deprins, D, L Simar et D Tulkens (1984). Measuring Labor

Inefficiency in Post Offices. North-Holland, Amsterdam.

DIAMOND, D et P DYBVIG (1983). <<Banks runs, deposit

insurance and liquidity>>. Journal of Political Economy, 91,

pages 401-419.

Diewert, Erwin W (1980). <<Capital and the theory of

productivity measurement>>. American Economic Review, 70, pages

260-267.

Efron, B (1979). <<Bootsrap method: Another look at the

jackknife>>. Annals Statistics, 7, pages 1-26.

Elayasiani, E et S M Mehdian (1990). <<A nonparametric

approach to measurement of efficiency and technological change: The case of

large u.s. commercial banks>>. Journal of Financial Services

Research, 4, pages 157-168.

Fan, J et I Gijbels (1992). <<Variable bandwidth and local

linear regression smoothers>>. Annals of Statistics, 20, pages

2008-2036.

Farrell, M J (1957). <<The measurement of productive

efficiency>>. Journal of the Royal Statistical Society. Series A

(General), 120, pages 253-290.

Ferrier, G D et C A K Lovell (1990). <<Measuring cost

efficiency in banking: Econometric and linear programming evidence>>.

Journal of Econometrics, 46, pages 229-245.

Hasti, T J et R J Tibshirani (1990). Generalized Additive

Models. London: Chapman and Hall.

(1993). <<Varying coefficient models>>. Journal

of the Royal Statistical Society, 55, pages 757-

796.

Igor, Jemric et Vujcic Boris (2002). <<Efficiency of banks

in croatia: A dea approach>>. Croatian National

Bank, Working paper, 7.

KIM, D H (2002). <<Another look at yields spreads: the role

of liquidity>>. Papier d'études, Centre for Growth and Business

Cycle Research, School of Economic Studies, University of Manchester.

Koopmans, T C (1951). <<Analysis of production as an

efficient combination of activities>>. In Activity Analysis of

Production and Allocation. T. C. Koopmans, Ed.

Lin, X et R J Carroll (2000). <<Nonparametric function

estimation for clustered data when the predictor is measured without/with

error>>. Journal of the American Statistical Association, 95,

pages 520-34.

Pagan, A et A Ullah (1999). Nonparametric Econometrics.

Cambridge: Cambridge University Press.

Park, B, L Simar et C Weiner (2000). <<The fdh estimator

for productivity efficiency scores : Asymptotic properties.>>.

Econometric Theory, 16, pages 855---877.

Rangan, N, R Grabowski, H Y Aly et C Pasurka (1988). <<The

technical efficiency of us banks>>. conomics Letters, pages

169-175.

Ryan, T P (1997). Modern Regression Methods. New York:

J. Wiley & Sons.

Sherman, H D et F Gold (1985). <<Bank branch operating

efficiency. evaluation with data envelopment analysis>>. Journal of

Banking and Finance, 9, pages 297-315.

Simar, L et P W Wilson (1998). <<Sensitivity analysis of

efficiency scores: How to bootstrap in nonparametric frontier models>>.

Management Science, 44, pages 49-61.

Wanda, Robert (2007). <<Risques, comportements bancaires et

déterminants de la surliquidité>>. Cahiers

électroniques du CRECCI, 24.

Annexe

140000 160000 180000 200000 220000

CREDOU_1

300000 340000 380000

400000 600000 800000 1200000

DTER_1EXTRE_1

114 116 118 120 122 124

100000 150000 200000 250000

FPA_1 ACT_1

Figure 8: Fonction de réaction des credits de long terme

sur les depots de long terme.

140000 160000 180000 200000 220000

400000 600000 800000 1200000

300000 340000 380000

CREDOU_1

DTER_1 EXTRE_1

114 116 118 120 122 124

100000 150000 200000 250000

FPA_1

ACT_1

Figure 9: Fonction de réaction des crédits de moyen

terme sur les dépôts de long terme

|

|

|

|

300000 340000 380000

DTER_1

|

400000 600000 800000 1200000

EXTRE_1

|

140000 160000 180000 200000 220000

CREDOU_1

|

|

|

|

|

100000 150000 200000 250000

FPA_1

|

114 116 118 120 122 124

ACT_1

|

|

|

1200000 1400000 1600000 1800000 2000000 DVU_1

|

400000 600000 800000 1200000

EXTRE_1

|

|

|

|

100000 150000 200000 250000

FPA_1

|

114 116 118 120 122 124

ACT_1

|

Figure 10: Fonction de réaction des crédits de

court terme sur les dépôts de long terme

140000 160000 180000 200000 220000

CREDOU_1

Figure 11: Fonction de réaction des credits de court terme

sur les depôts de court terme

140000 160000 180000 200000 220000

CREDOU_1

1200000 1400000 1600000 1800000 2000000 400000 600000 800000

1200000

DVU_1 EXTRE_1

100000 150000 200000 250000

114 116 118 120 122 124

FPA_1

ACT_1

Figure 12: Fonction de réaction des credits de long terme

sur les dépôts à court terme

140000 160000 180000 200000 220000

CREDOU_1

1200000 1400000 1600000 1800000 2000000 400000 600000 800000

1200000

DVU_1 EXTRE_1

100000 150000 200000 250000

114 116 118 120 122 124

FPA_1

ACT_1

Figure 13: Fonction de réaction des credits à moyen

terme sur les dépôts de court terme

|