2.3 Phase de restitution

La restitution du vecteur à partir de ses

transformés revient à extraire un signal d'un

bruit.

Nous avons choisi une méthode dérivée de

celle utilisée pour les potentiels évoqués: l'annulation

du bruit est obtenue par moyennage de copies multiples du signal, chacune

étant bruitée de façon différente.

Pour une clé donnée le vecteur de sortie est obtenu

en faisant la moyenne des vecteurs transformés inscrits sur le

réseau:

mD K

1 k

Sj = ~ T(j*b k )mod(d+1)

~

D d =m1 k=1

3- Modèle avec une modulation associée

à la transformation chaotique

Le principe est le même que le précédent

mais on introduit un traitement du signal avant ou au moment du stockage. Il

s'agit d'une modulation d'amplitude par un signal sinusoïdal.

L'utilisation d'une modulation d'amplitude en radiophonie

permet de décaler, dans le spectre des fréquences, la

fréquence propre du signal à transmettre. Elle permet

d'éviter la superposition des stations émettrices

Y(t) = A(t).sin 2pi F.t

Y(t) est le signal modulé, A(t) le signal modulant, F la

fréquence modulée ou porteuse.

Ici la modulation va avoir pour effet d'orthogonaliser plus

encore les vecteurs à mémoriser, sans perte d'information,

puisque la démodulation restitue le signal d'origine.

La porteuse est générée par

échantillonnage d'une sinusoïde dont la période est un

sous-multiple de la dimension des vecteurs transformés. En d'autres

termes, on trouve un nombre entier de périodes dans chaque vecteur

transformé.

Le pas d'échantillonnage est égal au

paramètre b qui est la clé affectée à chaque

vecteur à mémoriser.

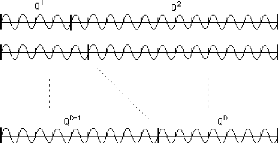

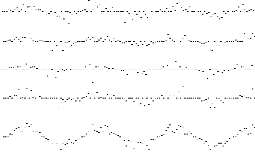

Quelques porteuses obtenues par échantillonnage de la

sinusoïde de base:

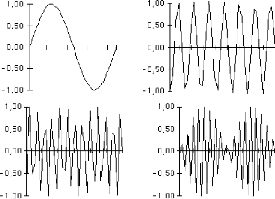

exemple de signal modulé obtenu avec b = 7

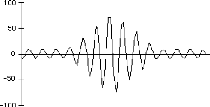

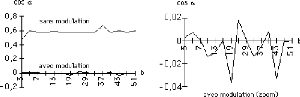

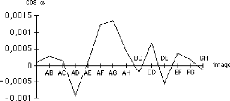

La figure suivante montre le gain obtenu en orthogonalisation

pour un même vecteur, transformé avec des b premiers

différents {5..51}

Le gain en orthogonalisation reste faible pour la seule

transformation chaotique mais celle-ci génère une modulation

propre à chaque image qui se révèle très

puissante.

Si nous prenons deux vecteurs différents à

l'origine les vecteurs transformés deviennent quasi orthogonaux:

4- Etudes:

4.1 Visualisation de l'activité du réseau

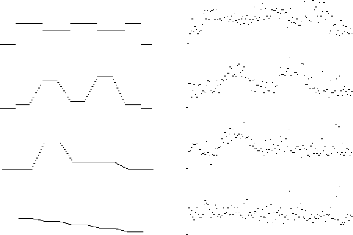

La figure ci-dessous montre les 100 premières valeurs

des 4 premières zones de stockage Qm1, Qm2,

Qm3, Qm4, après l'inscription de 6 vecteurs

transformés Tk k{1.. 6}sur le réseau et la partie du

vecteur somme correspondant. On remarque que les valeurs

particulières

à chaque image s'annulent et que le signal sinusoïdal

échantillonné au départ est reconstitué par

addition des porteuses affectées aux images.

4.2 Capacité maximale théorique de stockage:

L'opération de modulation est une méthode

d'orthogonalisation. Nous l'avons comparée à la méthode de

référence de GRAM SCHMIDT [KEE].

Un premier vecteur à mémoriser est

transformé avec une «clé» b en un ensemble de vecteurs

chaotiques de dimensions d différentes (Q1 à

QD). Cet ensemble constitue la base sur laquelle viendront

s'additionner les ensembles suivants.

Un deuxième vecteur est transformé avec une

clé différente et génère un deuxième

ensemble de vecteurs chaotiques.

Si on veut additionner les deux ensembles de façon

à ce que l'un apparaisse comme un bruit par rapport à l'autre, il

faut orthogonaliser le deuxième ensemble par rapport au premier.

C'était le rôle de la modulation dans notre méthode.

Dans la méthode de GRAM SCHMIDT l'ensemble est

recalculé. Le coefficient à appliquer à chaque composante

d'un vecteur transformé de dimension d donnée est

mémorisé. Il permettra la reconstruction du vecteur d'origine en

phase de restitution.

Les vecteurs suivants sont mémorisés de la

même façon: chaque nouvel ensemble est recalculé de

façon à être orthogonal aux éléments

déjà mémorisés.

Dans notre expérimentation la méthode de GRAM

SCHMIDT permet de doubler la capacité de stockage (20 vecteurs-tests

à niveaux de gris au lieu de 10).

La suite logique de ce travail est l'articulation de ce

modèle avec une mémoire associative classique et l'étude

quantitative des capacités de mémorisation en fonction de la

dimension du réseau.

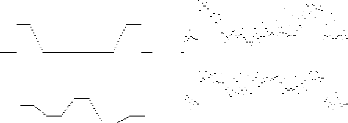

20 «images» mémorisées

exemples restitution après superposition

Ci-dessus quelques échantillons d'images 1D

mémorisées sur le réseau et leur restitution après

stockage, sans traitement

5- Références

[DAV89] Eric Davalo, Patrick Naïm, Le modèle de

HOPFIED , in des Réseaux de Neurones, Eyrolles 89, p

104-112

[DEW87] Dewdney A., Explorez le monde étrange du

chaos, Récréations informatiques, in Pour la Science,

N° 119, Sept 87, p 13-16

|