3- Les Variantes du réseau de neurones

récurrents

Plusieurs variantes du RNN ont vu le jour pour remédier

aux problèmes rencontrés avec les réseaux de neurones

récurrents. Nous allons ici décrire le LSTM pour Long Short-Term

Memory et le GRU pour Gated recurrent unit.

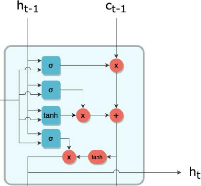

a- Long Short-Term Memory - LSTM

L'idée derrière ce choix d'architecture de

réseaux de neurones est de diviser le signal entre ce qui est important

à court terme à travers le hidden state (analogue à la

sortie d'une cellule de RNN simple), et ce qui l'est à long terme,

à travers le cell state, qui sera explicité plus bas. Ainsi, le

fonctionnement global d'un LSTM peut se résumer en 3 étapes :

1. Détecter les informations pertinentes venant du

passé, piochées dans le cell state à travers la forget

gate ;

2. Choisir, à partir de l'entrée courante,

celles qui seront pertinentes à long terme, via l'input gate. Celles-ci

seront ajoutées au cell state qui fait office de mémoire longue

;

3. Piocher dans le nouveau cell state les informations

importantes à court terme pour générer le hidden state

suivant à travers l'output gate. Regardons cela de plus près. En

respectant la même convention que pour le schéma simplifié

de la cellule RNN, on peut représenter une cellule LSTM de la

façon suivante :

Figure 11 : Représentation simplifiée d'une

cellule LSTM

Master Data Science - Big Data 23

Comme le RNN, le LSTM définit donc une relation de

récurrence, mais utilise une variable supplémentaire qui est le

cell state c :

ht = f(xt, ht-1, ct-1)

L'information transite d'une cellule à la suivante par

deux canaux, h et c. À l'instant t, ces deux canaux se mettent à

jour par l'interaction entre leurs valeurs précédentes ht-1 et

ct-1 ainsi que l'élément courant de la séquence xt.

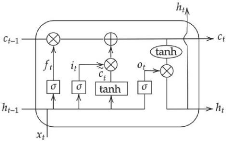

b- Gated Recurrent Unit - GRU

Variante du LSTM, le GRU :

l Combine les portes forget et input gate

Figure 12 : Représentation simplifiée d'une

cellule GRU

Le GRU définit donc une relation de récurrence

établie comme suit : ht = (1 - zt) * ht-1 + zt * tanh(W · [rt *

ht-1, xt])

Où :

l zt : l'équation de la porte update gate

l W : le vecteur de poids.

Master Data Science - Big Data 24

|