1

UNIVERSITE DE YAOUNDE I FACULTE DES SCIENCES

UNIVERSITY OF YAOUNDE I FACULTY OF SCIENCES

DEPARTEMENT D'INFORMATIQUE

DEPARTMENT OF COMPUTER SCIENCE

GESTION D'INFORMATIONS : MUTATION

LANGAGE DE PROGRAMMATION SQL

VERS LES BASES DE DONNEES

RELATIONNELLES ET LE

Mémoire présenté en vue de

l'obtention du diplôme de

MASTER II RECHERCHE

Option : S.I &

G.L

Par :

AMINI MUDUMBI Jacques Ingénieur en

Informatique

Sous la direction de :

MARCEL FOUDA NDJODO, Professeur

Année Académique 2017-2018

1

Sommaire

Introduction générale

Chapitre I : L'ordinateur auxiliaire de stockage

Chapitre II: Les bases des données : une nouvelle

considération de stockage et manipulation des données

Chapitre III: Les évidences de mutation vers les bases de

données relationnelles Chapitre IV: Le langage Sql : un manipulateur de

bases de données relationnelles Chapitre V: Le Sql intégré

: un paquetage de Sql Embarqué

Conclusion générale

Bibliographie

2

La mort est certaine mais l'heure de la mort est incertaine.

C'est en sachant que nous sommes poussière et retourneront à la

poussière que notre coeur coule de larmes et de blessures

intérieures surtout que vous n'étiez plus. A notre

regretté Père MUDUMBI Edmond, que vous soyez immortalisée

par ce travail. Vos empreintes restent à jamais marquées dans le

souvenir de nos pensées. C'est aujourd'hui plus que jamais que nous

apprécions la valeur de vos efforts, la justesse de votre

éducation et le caractère précieux de vos conseils.

3

Programmez toujours vos applications comme si la personne qui

doit les maintenir ensuite

était un psychopathe violent qui sait où vous

habitez.

John F. Woods

4

A mes parents et aux êtres qui sont les plus chers au

monde et auxquels je ne saurais jamais exprimer ma gratitude et ma

reconnaissance en quelques lignes.

5

Remerciements

De prime à bord, je remercie Dieu, le Tout Puissant

pour ses faveurs et ses gratitudes, de m'avoir donné le courage et la

patience pour avoir mené à bon escient ce travail durant toutes

ses deux années de recherche.

Mes sincères remerciements s'adressent à

l'ensemble des personnes qui ont eu la gentillesse et la bienveillance de

m'accorder de leur temps et d'eux-mêmes en acceptant de participer

à cette recherche.

Je remercie le Professeur Marcel FOUDA NDJODO

pour m'avoir fait l'honneur de m'encadrer et pour la confiance qu'il

m'a accordée dès le début me permettant ainsi

d'élaborer un travail personnel et propre à mes aspirations. Je

le remercie également pour ses compétences de recherche et son

ouverture d'esprit qui m'ont conduit à tirer le meilleur parti de mes

capacités intellectuelles.

En effet, je lui suis infiniment reconnaissant de m'avoir

encouragé et soutenu durant ce travail, j'ai ainsi pu apprécier

sa rigueur scientifique, ses relectures du manuscrit, ses remarques et

suggestions, son recueil, ses grandes qualités humaines et son oeil

critique qui m'as été très précieux et m'ont

amené à affiner et clarifier toujours plus ma réflexion et

cela m'a permis de structurer mon travail et améliorer sa

qualité. Qu'il soit persuadé de mon plus profonde

considération et plus grand respect.

Un mémoire de recherche ne pourrait être

présenté sans l'évaluation de la qualité et de

l'originalité de la recherche par un jury. Mes seconds remerciements

iront donc, tout naturellement, à ces personnes qui ont jugés ce

travail avec conscience et impartialité. Je remercie tout d'abord mes

deux rapporteurs, le Prof. DONTSI et le Prof. Charles

AWONO ONANA, de m'avoir faire l'honneur d'accepter de lire mon

manuscrit et d'avoir apportés des remarques et des commentaires

constructifs. Je les remercie de leur gentillesse et leur compréhension.

Je remercie mon premier examinateur, Dr. LOUKA Basile, pour sa

sympathie et sa confiance tout au long de mon travail. Je remercie

également le président du jury et mon second examinateur, le

Prof. TCHUENTE Maurice d'avoir pris le temps de m'expliquer le

fonctionnement de sa plate-forme en mathématique-informatique (de

m'avoir à la fois fourni des exemples illustratifs et des explications

théoriques). Je le remercie également d'avoir répondu

rapidement à chacune de mes interrogations et d'avoir su me donner des

conseils pertinents sur la construction de mon modèle.

Je remercie tout particulièrement Armel,

Justine, Blaise, Pascal, Nicolas. Sans eux, je n'aurais sans doute pas

réussi à accéder à certaines données de mes

terrains.

6

Je remercie également mes collègues du Centre

Informatique et Laboratorium (CIL), et en particulier d'autres chercheurs :

Stéphane, Jadel, Sangara, Patient, Pierre, Virginie, Vidal,

Marc-Claudia. Je ne compte plus les séminaires, colloques et

interminables discussions passés ensemble. Au cours de ces deux

années de recherche, ils m'ont été d'une aide inestimable,

que ce soit sur un plan scientifique ou personnel.

Merci aussi à Marie-Anne et Sophie

d'avoir été à mes côtés pour

organiser des moments de réflexion collective autour des

hypothèses que cette mémoire de recherche se propose

d'éprouver. Je remercie à cette occasion toutes les personnes qui

ont contribué à faire vivre ce séminaire.

Je souhaite également faire part de mon attachement et

de ma profonde reconnaissance à Marie-Aziza. Elle m'a

donnée le goût de la recherche et aidé à croire en

moi, et en l'intérêt de mes travaux.

En ce moment si particulier, j'ai bien sûr une

pensée pour mes ami(e)s :

Joseph, Junior, Jonathan, Espoir, Arnold, Louis,

Trésor, Semence. Je pense tout particulièrement à

Ma grande Soeur L'Inf. Justine MUDUMBI, pour tous les

sacrifices consentis jusqu'à l'aboutissement de ce travail, je partage

ma joie avec elle, mais aussi à Francisca et Djemimah,

pour leurs interminables conseils de qualité pour l'accomplissement de

ce travail de recherche. A l'évidence, sans eux, ce mémoire de

recherche ne serait pas ce qu'elle est.

Je remercie également ma famille. Je pense

évidemment à ma mère Marie LUBAO et

à la bienveillance avec laquelle elle s'est attachée à me

mettre dans les meilleures dispositions pour aller au terme de cette recherche.

Je pense aussi à mes frère et soeurs, Prince, Elie,

David, Daniel, Michel, Boniface, Damien, Moise, Inf. Justine, Djemimah,

Francisca, Consolatrice, Lucie, Thèrese, Elysée, Cécile,

Orthance. Il va sans dire qu'un tel projet ne se réalise sans

la compréhension et le soutien moral de ses proches.

Enfin, je ne remercierai jamais assez mon oncle Maternel

Blaise, pour le soutien qu'il m'a apporté, dans les

moments où j'en avais le plus besoin, et la patience dont il a fait

preuve dans la dernière ligne droite de ce travail de recherche.

7

Lexique

ANSI (American National Standard Institute):

Organisme de Normalisation Américain, Constitué des producteurs,

de consommateurs et de groupes d'intérêt général, et

qui est le représentant US à l'ISO.

BD (Base de données) : Est un ensemble

d'informations associées à un sujet particulier. CD

(Compact Disk) : Disque faisant 12centimètres de

diamètre, 1,2 millimètre d'épaisseur, constitué de

polycarbonate recouvert d'une couche d'aluminium, le tout étant vernis

et permettant de stocker environ 650 Mo de données.

CPU (Central Processing Unit) : Unité

de Calcul Centrale, généralement c'est le processeur principal

d'une unité centrale.

DD (Diques et Disquettes)

DVD (Digital Versatil Disk) : Disque Vidéo

Digital, Leur capacité est de 4.7 Giga octets sur une face avec

un taux de transfert de 1.5 Méga octet par seconde. Oui, c'est bien

« Versatil » au milieu, et pas « Vidéà »,

parce qu'on peut mettre toutes sortes de données sur un DVD, pas

seulement de la vdéo...

ISO (International Standard Organisation) :

Organisation internationale de Standardisation, réunissant les

organismes de normalisation de pas mal de pays dans le monde et qui travaille

dans tous les domaines.

GHRZ (Giga Hertz)

LISP (LIST Processing ou de « Lots of Insipid and

Silly Parenthesis») : Langage de programmation basé sur le

traitement de listes et beaucoup utilisé en Intelligence Artificielle.

MCC (Modèle Conceptuel de la Communication):

Elément de la méthode MERISE. MERISE

(Méthode d'Analyse d'un Système d'Information): Elle

vise à remplacer un système manuel d'une organisation par un

système automatisé du traitement de l'information. SI

(Système d'Information) : Ensemble des moyens techniques et

humains permettant à une organisation de traiter son information.

SGBD (Système de Gestion de Base de

Données) : est un ensemble de logiciels prenant en charge la

structuration, le stockage, la mise à jour et la maintenance des

données

SGBDR (Système de Gestion de Base de

Données Relationnel): C'est lorsque les données sont

organisées en fonction de leur utilisation (données fixes dans

une table, données variables dans une autre, etc.). Le «

relationnel » dans SGBDR est au masculin, car c'est le système qui

l'est.

SPARC (Scalar Processor ARChitecture) : RISC

(`Reduced Instruction Set Computer' i.e ordinateur à jeu d'instructions

réduit) qu'on trouve dans les stations Sun et qui fut une

8

référence en matière de calcul scientifique

intensif. De plus, ses spécifications sont dans le domaine public.

USB (Universal Serial Bus) : Interface

destinée à remplacer pas mal de choses dans un PC (Personnel

Computer) (à commencer par le port série et le port

parallèle).

RAM (Random Access Memory) : c'est la

mémoire vive.

ROM (Read Only Memory) : C'est la mémoire

morte.

9

Résume

Ce travail de recherche décrit la définition et

les évidences sur les mutations de la mise en oeuvre d'une base de

données relationnelle et le langage Sql. Dans ce contexte, la gestion

d'informations se déploie massivement dans toutes les fonctions et dans

les secteurs des organisations. Elle devient vite sujet à pinailles et

transforme profondément l'activité des toutes les couches des

organisations. Cependant, cette émergence de gestion d'informations au

service des organisations et de pilotage met en évidence la

nécessaire adéquation entre les services informatiques offerts et

les finalités des organisations.

L'objectif de bases de données, la gestion

d'informations, « le but déterminant des systèmes de gestion

de bases des données relationnelles, c'est la plus-value.

Au demeurant, l'ère des technologies de stockage des

données a conduit à une mutation sensible et pérennes vers

les bases de données relationnelles dans des organisations et de

s'interroger sur la manière de ranger les informations pour que

celles-ci soient retrouvées rapidement. De ce fait, les bases de

données relationnelles constituent des nos jours l'étude

partitionnée si ses données sont gérées sur

plusieurs partitions (également appelées noeuds). Cependant, on

se rend bien compte que les données dans les bases de données

relationnelles sont conservées dans des tables et la table en lignes et

colonnes. D'où, l'approche adoptée est le langage SQL (un

programme informatique chargé de gérer les données) qui

constitue un manipulateur des bases de données relationnelles et un

ensemble d'instructions standard, qui sont exécutées par un

gestionnaire de bases de données.

Dans ce sens, le problème qui se pose toujours c'est de

savoir comment mettre en place un système de gestion informatisé

où des mesures et solutions de gestion d'informations efficacement afin

de réellement protéger les systèmes d'information des

bases des données? La recherche des solutions aux problèmes de

gestion d'informations procède de manière plus ou moins

compromettante car le fait de juxtaposer et de multiplier les solutions de

gestion sans analyser au préalable leur compatibilité et leurs

objectifs respectifs n'a jamais été une solution fiable.

Mots clés: Bases de données,

Mutation, Langages Sql, Base de Données Relationnelles, Gestion

d'informations, Système de Gestion de Base des Données

Relationnelles, Programme informatique.

10

Abstract

This work of research describes the definition and the

evidences on the mutations of the implementation of a relational data base and

the Sql language. In this context, the management of information spreads out

massively in all functions and in the sectors of the organizations. She/it

becomes quickly topic to nitpick and transform the activity of the deeply all

layers of the organizations. However, this emergence of management of

information to the service of the organizations and piloting puts in evidence

the necessary adequacy between the offered computer services and the finalities

of the organizations.

The objective of data bases, the management of information",

the goal determining systems of management of bases of the relational data, it

is the increment.

Moreover, the era of the technologies of storage of the data

drove to a sensitive and perennial mutation toward the relational data bases in

organizations and to wonder about the manner to arrange the information so that

these are recovered quickly. Of this fact, the relational data bases constitute

the our days the survey partition if his/her/its data are managed on several

partitions (also named knots). However, one realizes well that the data in the

relational data bases are kept in tables and the table in lines and columns. Of

where, the adopted approach is the SQL language that (a computer program

assigned to manage the data) constitutes a manipulator of the relational data

bases and a set of standard instructions, that are executed by an administrator

of data bases.

In this sense, the problem who always lands that is to know

how to put a computerized management system in place where measure and

solutions of management of information efficiently in order to protect the

systems of information of the bases of the data really? The research of the

solutions to the problems of management of information proceeds more or less

from manner compromising because makes it to juxtapose and to multiply the

solutions of management without analyzing their compatibility beforehand and

their respective objectives were never a reliable solution.

Key words: Data bases, Mutation, Language

Sql, Data base Relational, Management of information, System of Management of

Basis of the Relational Data, computer Program.

11

Liste des figures

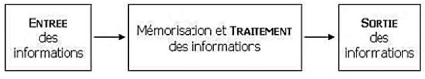

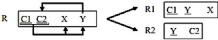

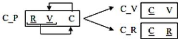

Figure I.1. Mémorisation et traitement d'ordinateur 20

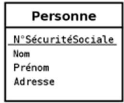

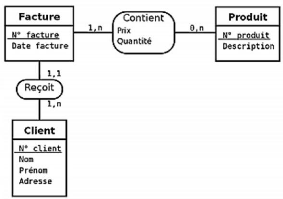

Figure II.1. Cas pratique de type-entité 36

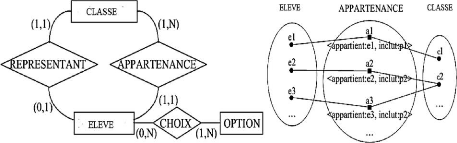

Figure II.2. Cas pratique de modèle

entité-association 37

Figure II.3. Exemple d'occurrences de l'association APPARTENANCE

37

Figure II.4. Représentation graphique et exemples (suppose

qu'un livre ne peut posséder

qu'un auteur) sur les cardinalités .38

Figure II.5. Cas pratique d'associations plurielles entre un

type-entité 39

Figure II.6. Cas pratique d'associations réflexives sur le

type-entité personne 40

Figure II.7. Cas pratique de type-association ternaire

inapproprié 41

Figure II.8. Cas pratique de Type-association ternaire

de la figure précédente corrigé en deux

type-associations binaires 41

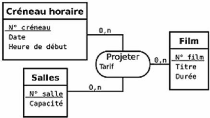

Figure II.9. Cas pratique de

type association ternaire entre des type-entités Créneau

horaire,

Salle et Film 42

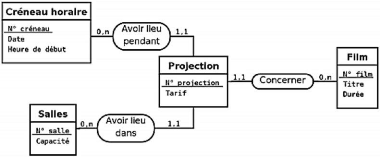

Figure II.10. Cas pratique de transformation

du type-association ternaire de la figure 2.10 en

un type-entité et trois typeassociations binaires

43

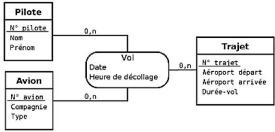

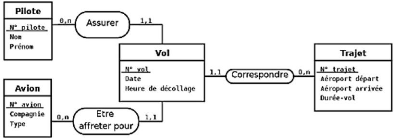

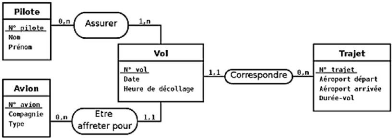

Figure II.11. Cas pratique du Modèle représentant un

type-association ternaire Vol liant trois

type-entités Avion, Trajet et Pilote ..44

Figure II.12.

Cas pratique de transformation du type-association ternaire de la figure 2.12

en

un type-entité et trois typeassociations binaires

44

Figure II.13. Cas pratique du Modèle de la figure 2.13

corrigé au niveau des cardinalités...44

|

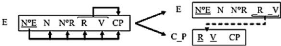

Figure III.1 : Erreur de conception du modèle

entité association

|

56

|

|

Figure III.2 : Cas pratique de normalisation de la 2FN

|

..59

|

|

Figure III.3 : Cas pratique de normalisation de la 3FN

|

59

|

|

Figure III.4. Cas pratique de normalisation de la BCFN

|

60

|

|

Figure III.5. Forme non normalisée

|

.61

|

|

Figure III.6. Forme 1NF

|

61

|

|

Figure III.7. Forme 2NF

|

61

|

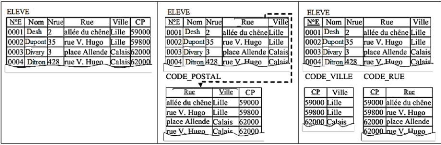

Figure III.8. Passage en 3NF, en ajoutant la table Code_postal

avec attributs (rue et ville)...61 Figure III.9. Passage en 3NF, après

ajout de la table Code_postal avec attributs (rue et ville)61

|

Figure III.10. Forme 2NF

|

.62

|

|

Figure III.11. Forme 3NF

|

.62

|

|

Figure III.12. Forme BCNF

|

.62

|

|

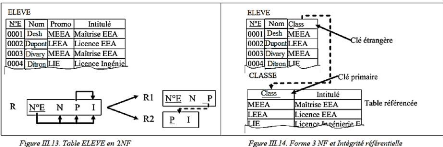

Figure III.13. Table ELEVE en 2NF

|

63

|

|

Figure III.14. Forme 3NF et intégrité

référentielle

|

63

|

12

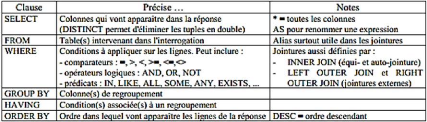

Figure IV.1. Les différents types de jointures ..80

13

Liste des tableaux

Tableau II.1. Exemples cardinalités et types 37

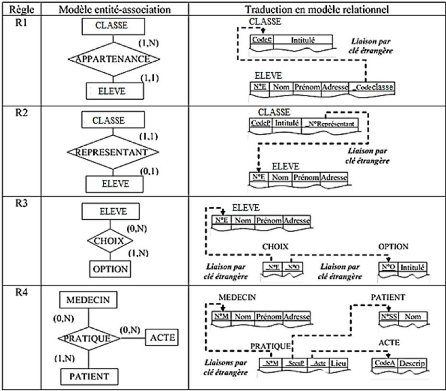

Tableau III.1 : Cas pratique d'usage des règles de

passage modèle entité-association du

modèle relationnel 56

Tableau IV.1. Les opérateurs de comparaison d'une

valeur à un ensemble de valeurs 83

Tableau IV.2. Récapitulatif des différentes

clauses 84

14

Introduction générale

Partant de l'approche informatique, cette réflexion

prouve, sur base du système de gestion de base de données, qu'une

gestion d'informations est soumise à une évolution constante. Le

progrès liés à l'augmentation de la finesse de stockage et

de manipulation d'informations en sont la base.

C'est un fait pour toutes les organisations, que la gestion

d'informations a fait ses preuves, à travers différentes

approches de sa capacité à fournir des services de stockage

gigantesque aux organisations en nécessitées. Les

possibilités techniques et les enjeux informatiques actuels incitent la

quasi-totalité des couches sociétales et entrepreneuriales

à réaliser des bases des données de plus en plus

complexes. Comme on peut le constater, l'émergence accrue des

systèmes d'informations impose aux organisations une réaction

rapide et une prise de décisions pertinentes celle de doter leur

Système d'Information d'une interface Web suite à

l'évolution du suivi automatisé des toutes les tâches

entrepreneuriales. Dans ce contexte, il n'est plus possible sans avoir

accès aux informations significatives relatives au problème

traité car l'époque où une faible quantité

d'informations était suffisante pour décrire la situation des

organisations appartient au passé.

Cette motivation de fond, fait que l'accroissement de stockage

et de manipulation de la quantité d'informations requises par les

décideurs a rendu l'identification et l'accès aux informations

des organisations de plus en plus difficiles. C'est dire que l'information est

devenue une des ressources stratégiques des organisations. Cette

dernière s'est développée, faut-il le rappeler, s'est

fortement sur l'organisation de la collecte, du stockage, de la

présentation, de la distribution et de la maintenance des informations

devient un élément ou un facteur prédominant et

conditionnant son fonctionnement efficace.

Au regard du branding réputationnel de l'augmentation

spectaculaire du nombre d'informations manipulées, il n'est plus

possible à concevoir en faisant appel uniquement au bon sens. Le

paradigme sur les évidences des mutations vers des systèmes de

stockage et de manipulation des données a émergé dans ce

contexte comme réponse aux besoins en gestion d'informations. Sans que

cela ait été prémédité, il existe un moyen

simple de se représenter les ressources de la collecte et de la

manipulation de données en considérant chacune d'entre elles

comme un ordinateur physique. Pour ce faire, l'indépendance entre le

niveau physique et le niveau logique de la description des données est

un autre atout de ces SGBD. C'est principalement grâce à ce

fondement théorique que les SGBD relationnel ont des interfaces

d'accès très voisines les unes des autres qui ont convergé

vers le standard qu'est le langage SQL [1] Ce qui est positif reste la

méthode la plus courante pour organiser

15

et accéder à des ensembles de données.

Partant, la situation est essentiellement due à la multiplication des

données en matière d'organisation.

C'est pour cette raison que l'apparition des engins

informatiques qu'éprouvent actuellement la toile mondiale tout et pour

très longtemps d'indiquer la manière dont l'automatisation de la

gestion de l'information a accéléré la réflexion

sur la nature et la structure du "système de pilotage" des organisations

que constituent les circuits d'information.

Une conviction est, à ce sujet, utile : l'ère

des ordinateurs a facilité le stockage et la manipulation de grandes

quantités d'informations. Bien plus, les avantages des ordinateurs ont

permis de comprendre de manière concrète ce que doit être

le système d'information, les composantes qu'il doit posséder et

comment il doit évaluer.

Tout de même, le paradoxe informatique mitigé

entre la compréhension des «services informatiques offerts »

et dès lors, nous pouvons nous poser la question de la nature du lien

entre ces services informatiques et l'«informatique de gestion » nous

pouvons asseoir les termes univoque Informatique qui fournit les moyens du

traitement automatique de l'information et l'informatique de gestion qui

s'appuie sur l'informatique pour automatiser le système d'information et

rendre transparent le traitement de l'information utile et nécessaire

aux activités opérationnelles et de pilotage des organisations.

Cette partie du système d'information automatisé à l'aide

de la technologie des ordinateurs est souvent nommée : Système

d'information informatisé.

Une caractéristique fondamentale liée à

la question du système d'information considérer comme

degré d'existence est la base de données.

De ces quelques réflexions est né le sujet de

cette étude: il nous fait découvrir les services offerts par la

gestion d'informations et les mutations vers le système de gestion de

base de données relationnelles, ce qui permettent de décrire et

d'adapter la structure logique du modèle relationnel de certaines

organisations, la sémantique de pilotage, enfin un contrôle par un

programme qui se fait via une suite d'instructions. Pour y parvenir, il ne nous

serait pas commode d'introduire des instructions et des informations dans

l'ordinateur directement sous forme de signaux électriques.

Cette étude est composée de deux grands temps.

Le premier est une analyse des nombreux concepts introduits pour la gestion des

informations et des bases de données.

Il se base sur une étude informatique comme

mémoire de stockage et propose une approche lié à la

codification d'informations des bases de données et de migrations vers

les SGBDR. Cette partie est couverte par les chapitres 1, 2, et 3.

16

Le deuxième et dernier temps constitue le

dénouement de toute notre démonstration qui contient les

chapitres 4 et 5 ; Ces chapitres décrivent le travail que nous avons

effectué dans le domaine des langages de programmation pour la base de

données. Trois aspects sont principalement traités : notions au

langage Sql, ses catégories d'instructions et le sql

intégré. Le moment où l'ensemble des termes

élaborés tout au long de cette étude de recherche entrent

en cohérence et forment un système pour donner naissance à

la conclusion et aux concepts fondamentaux qui la composent.

17

Chapitre I : L'ordinateur auxiliaire de stockage

I.1. Introduction

Dans ce chapitre, nous présentons l'ordinateur comme un

dispositif auxiliaire de stockage décrivant les différents

outils, langages, méthodes et modèles dont nous avons

réalisés l'étude. Pour cela l'ordinateur comporte des

organes d'entrée et de sortie qui permettent à l'utilisateur de

placer ses informations dans la mémoire et de les y relire lorsque la

machine les a manipulées.

En effet, un ordinateur est une machine à traiter de

l'information; l'information est fournie sous forme de données

traitées par des programmes (exécutés par des ordinateurs)

ce qui ne limite nullement la possibilité de généraliser

notre approche à ceux-ci. Il est donc nécessaire de bien

organiser les données afin d'en ressortir les parties les plus

pertinentes : l'unité logique et arithmétique.

L'information est stockée dans des fichiers (tables).

Ces derniers sont organisés de façon à répondre

efficacement aux attentes de gestion.

I.2. Ordinateur auxiliaire de stockage

La question de l'ordinateur a traversée l'histoire des

différentes lignées et pensées. Au demeurant les

évolutions de son histoire, c'est à coup sûr, et pour cette

raison que ce constat a conduit à la démocratisation d'une

science à travers un outil avec intérêt de savoir manipuler

et stocker très rapidement et sans erreur d'énormes

quantités d'informations.

En termes de remède, l'ordinateur est non sans raison

une affaire de spécialistes, est aujourd'hui devenue l'affaire de tous;

d'où l'importance d'une solide utilisation trousse l'avancement des

toutes les organisations. Par ailleurs cette affaire ayant été

estimée louable, et relativise qu'elle soit pérennisée

tout en améliorant: l'assoupissement de gestion envers les

inconvénients inhérents à tout progrès des

informations.

Ce premier tour d'horizon des problèmes des entreprises

révèle qu'il est un outil qui nous aide à résoudre

certains problèmes. Ces problèmes font généralement

intervenir des symboles ou des signes qui ne nous sont familiers tels que les

lettres de l'alphabet, les chiffres, les signes de ponctuation et quelques

caractères spéciaux comme *,#,+..{[|\^@. Bien entendu, nous

pouvons introduire un ensemble de symboles dans l'ordinateur. Cette

démarche nous rend un autre ensemble de symboles en relation avec ceux

que nous avons introduits.

Pour y parvenir, nous n'examinerons pas en détails la

façon dont l'ordinateur travaille mais nous apprendrons à lui

donner les instructions requises pour qu'il exécute une tâche

18

donnée. Seulement, il est cependant utile de

connaître les différentes parties de sauvegarde et de traitement

d'informations qui constituent un ordinateur.

Cependant, pour ce qui est du rôle joué

actuellement par l'ordinateur, il s'avère que tout

l'intérêt de l'ordinateur réside dans trois de ses

caractéristiques, à savoir: sa capacité d'emmagasiner

une grande quantité d'informations, sa rapidité de traitement, sa

capacité d'assimiler un programme qui contrôle son propre

fonctionnement.

Ainsi, au dire de cette première

caractéristique, il est donc intéressant de pouvoir sauver

certaines informations utiles pour des tâches ultérieures de

façon à les rendre à l'ordinateur autrement qu'en les

tapant au clavier (ce qui s'avérerait vite fastidieux et risquerait

d'introduire des erreurs...).

Au fait, cette mémoire de sauvegarde est

généralement un support magnétique sur lequel on eut

enregistré des informations puis les relire grâce à un

appareil enregistreur/lecteur ad hoc. A ne se limiter qu'à cela, on

laisse bien comprendre que cet appareil peut servir à recevoir les

résultats venant de l'ordinateur (Output) ou à y introduire des

informations (Input).

Outre de ce qui précède, pour les

micro-ordinateurs, il s'agit habituellement des disques durs, de lecteurs de

disquettes souples ("floppy disks") ou de mémoires flash.

Que dire alors de l'information? Mais qu'est-ce qu'une

information pour un ordinateur ? Comment est-elle formée,

stockée, traitée, transmise ? Es-ce-une histoire de 0 et de 1...

Et c'est tout?

Tout d'abord, un ordinateur peut traiter des informations,

c'est-à-dire qui constituent une ressource technique auxiliaire dans le

cadre d'une tâche accomplie par un être humain. Il ne traite pas ce

que cette information signifie, il se contente de manipuler les codes qui la

représentent, la forme de l'information, nous dirons des données,

et non pas le contenu sémantique de l'information.

Cela permet d'en assurer la pérennité et la

disponibilité. En effet, il a été constaté que les

données dans une base de données sont rangées dans des

tables, sortes de grilles où sont rangés les codes

destinés à représenter ces données.

A l'inverse, l'ordinateur est incapable de savoir ce que

représentent ces codes mais cela ne l'empêche pas de savoir les

trier, y chercher un code particulier, les compter, les comparer [W1].

19

Figure I.1. Mémorisation et traitement

d'ordinateur

I.3. Fonctionnalités

Construire des systèmes de gestion d'informations est

une activité informatique fondée sur le raisonnement logique.

Comme on peut le constater, l'accroissement des informations des entreprises a

introduit l'usage de l'ordinateur ce qui revient à dire -de

manière réelle- que cela pour un temps a eu la pleine valeur de

preuve, à la suite il est alors possible que l'outil précieux de

stockage d'informations est l'ordinateur.

Eu égard cette concrétisation, on utilise

presque exclusivement des ordinateurs digitaux (dans lesquels les informations

sont codées sous forme des circuits électriques) et qui

fonctionnent selon les principes d'un calculateur. Bien entendu, ce calculateur

comprend deux parties : une unité logique et

arithmétique.

Dans son sens large, un programme décrit les

opérations logiques à réaliser sur les données.

Considérant les parties du calculateur comme préalable,

l'unité logique est banalisée. La variété

étudiée présente les caractéristiques sur

lesquelles on ne sait pas lors de sa construction à quoi elle va servir,

et si elle sera seulement capable d'exécuter séquentiellement

certaines instructions.

Cela ne signifie certes pas que les programmes et les

données sont placés sur un pied d'égalité dans la

mémoire. Ainsi pour passer à leur exécution, il est

impossible de discerner les programmes des données si ce n'est par

l'effet qu'ils ont sur l'unité logique. Plus précisément,

il importe qu'un ordinateur individuel soit utilisé par une seule

personne à la fois qui décide seule de l'activité de la

machine. C'est à l'issu de celui-ci que sont mis à la disposition

de chacun et connectés en réseau.

De par la nature, lorsque vous saisissez des informations dans

votre ordinateur avec la souris ou clavier, vous envoyez un signal à la

CPU. Ceci suppose que le CPU dispose d'une unité logique qui peut faire

de l'arithmétique de base. Si l'unité de commande ordonne

à l'ordinateur d'exécuter des programmes qui ont

été stockées dans la mémoire, il sera toujours

possible d'effectuer la vitesse à laquelle un ordinateur exécute

des programmes est mesurée en millions d'instructions par seconde, la

vitesse du processeur est mesurée en gigahertz (GHz).

20

De même, lorsque l'information a été

traitée, elle est sortie sous une forme lisible par l'homme à

travers l'écran et haut-parleurs. Dans cette ligne, elle peut

également être stockée à nouveau pour un traitement

ultérieur. En conséquence, les supports de stockage peuvent

être utilisés à la fois données d'entrée et

de sortie [W2].

I.4. Tumulte des couloirs du cosmopolite et trivial

de complexité

I.4.1. Tumulte des couloirs du cosmopolite

Au niveau de la planète terre, divers problèmes

des différentes organisations liés au stockage des données

caractérisent actuellement presque tous les milieux.

Toutes les entreprises sont devenues des grandes chef-d'

accusation, il suffit qu'une erreur se glisse dans la base de données et

la réponse urgente devienne « c'est une erreur de saisi, c'est une

erreur de frappe ».

Dans cette même lancée, nous voyons éclore

de l'ordinateur l'accusation de tous les maux, alors que celui-ci réunit

un correcteur automatique voire des onglets de détection d'erreurs.

I.4.2. Trivial de complexité

En unissant ces trois perspectives de l'analyse du trivial de

complexité, la gestion des données s'affirme, en fait, comme une

dynamique fondamentale de la transformation de toutes les entreprises,

positivement ou négativement. En agissant sur le système de

pilotage et celui opérant, de ce fait, on peut changer l'entreprise et

toute son organisation, dans le bon sens comme dans un sens désastreux

et destructeur.

Cela veut dire qu'il n'est pas un simple réceptacle des

représentations. Cette vision d'ensemble, largement partagée, est

constituée d'un faisceau de vicissitudes, parfois contradictoires, que

nous proposons de classer en trois catégories :

? Trivial de contenus : il laisse

entendre qu'il n'y a pas de contenus spécifiques aux technologies

informatisées à gérer.

? Trivial d'impact : il laisse

penser que les technologies informatisées sont un ensemble d'outils et

de moyens qui changent la gestion des données en place, qu'elles sont

changeables avec les moyens manuelles classiques sans que cela n'ait de

conséquences majeures sur la perte d'une grande quantité des

données.

? Trivial de contexte : il veut

faire croire que les entreprises sont nécessairement mieux avec les

technologies informatisées, quelles que soient les

réalités matérielles.

21

Cela veut dire que les technologies informatisées sont

un ensemble d'objets complexes à intégrer dans des pratiques

complexes. Concrètement, elles ne simplifient ni les contextes, ni les

enjeux, ni les publics entrepreneuriaux.

I.5. Repères pour une question

De par la nature, il importe de remarquer que, dans cette

définition, l'information est le support de la connaissance et non pas

la connaissance elle-même. Il serait donc naïf d'imaginer que les

machines informatiques "comprennent" la signification des informations qu'elles

traitent.

Cela signifie que ces machines ne font que traiter des codes

choisis assez judicieusement par leurs concepteurs pour représenter des

connaissances et de sorte que les manipulations automatisées faites sur

ces codes donnent à leur tour des codes similaires qui

représentent des informations qui ont un sens.

C'est vrai non seulement pour ce qui est de l'informatisation

d'une tâche, lorsqu'elle est possible, consiste à identifier les

informations à traiter, représenter ces informations,

opérer le traitement, produire les informations résultantes du

traitement. La question de preuve des traitements automatisables font appel

à des algorithmes. Ce qui revient à dire que la construction d'un

algorithme suit une démarche créative essentiellement

basée sur l'abstraction appelée analyse [W3].

C'est ce à quoi toute information est

véhiculée par un support, par exemple écrite sur papier,

enregistrée sur cassette audio, Le micro-ordinateur travaille sur une

représentation binaire des informations. Chaque élément

électronique ou magnétique ne sait prendre que deux états

physiques distincts (conducteur ou non conducteur, deux niveaux de tension)

représentés par les chiffres 0 et 1 d'une numérotation

binaire, c'est-à-dire de base 2.

Cela s'applique en particulier avec des bits, d'octets ou de

kilo-octets. Tous ces mots désignent en fait des unités pour

mesurer de capacité de mémorisation d'information par

l'ordinateur.

De même, l'information minimale pour l'ordinateur est le

bit imaginé comme un fil dans l'ordinateur. Deux états le

caractérisent: le courant passe ou ne passe pas. Avec un seul fil, on

peut donc mémoriser une information binaire, c'est-à-dire, deux

valeurs: le courant passe, représenté 1, le courant ne passe pas,

représenté 0. Cette information 0 ou 1 est appelée bit.

A ces raisons s'ajoute la ROM qui sert à stocker le

micro logiciel d'amorçage, les informations que l'ordinateur utilise

pour démarrer.

22

I.6. Des perspectives pour la recherche ?

C'est une évidence : les termes mémoire et

stockage de données sont souvent confondus. Les deux sont des moyens par

lesquels un ordinateur conserve les données utilisées pour

effectuer des tâches.

En tant que tels, les deux sont mesurés en octets.

Cependant, la mémoire et le stockage de données sont deux

entités distinctes et les termes ne doivent pas être

interchangés. Bien que la mémoire est communément

appelée RAM (Random Access Memory), mais comprend également la

mémoire en lecture seule (ROM). Le stockage de données est

également appelé espace sur le disque dur.

Comme le rôle de chacune de partie est défini, la

principale nuance entre la mémoire et le stockage de données est

leur fonction. Le stockage est utilisé pour stocker toutes les

informations de l'ordinateur à l'inverse des données qui sont

stockées sur le disque dur sont permanentes et ne sont pas perdues

lorsque l'ordinateur est éteint.

Lorsqu'un fichier est supprimé, seul l'accès

à ce fichier est supprimé, pas les informations

elles-mêmes. C'est pourquoi les experts en informatique peuvent restaurer

des informations sur un ordinateur même si ces informations ont

été supprimées. Pour supprimer définitivement un

fichier, le disque dur doit être formaté ou remplacé. Il

est même possible que même si un disque a été

formaté, un expert peut toujours visualiser les informations.

Il existe des programmes disponibles qui écrivent des

données sans signification sur les informations du disque, rendant ainsi

les informations illisibles pour quiconque.

C'est pourquoi la mémoire, en revanche, permet à

l'ordinateur d'accéder rapidement aux fichiers du disque dur. Comme la

plu part des fois lorsqu'un ordinateur exécute une application telle

qu'un traitement de texte, l'unité centrale (CPU) récupère

les données du disque dur et les charge dans la RAM, ce qui permet un

accès rapide.

D'où, la quantité de RAM d'un ordinateur limite

le nombre de programmes pouvant être exécutés

simultanément. Etant donné que les informations stockées

dans la RAM sont perdues lors de la mise hors tension de l'ordinateur,

l'enregistrement d'un fichier dans une telle application écrit les

informations sur le disque dur afin qu'elles ne soient pas perdues.

23

Ce qui laisse comprendre que la mémoire et le stockage

de données peuvent cependant fonctionner ensemble et perçues

comme flux de paires que lorsque l'ordinateur ne dispose pas de suffisamment de

RAM pour prendre en charge ses processus, une partie du disque dur est

convertie en mémoire virtuelle alors la mémoire virtuelle agit de

la même manière que la RAM. Cependant, comme il fait partie du

disque dur, l'utilisation de la mémoire virtuelle ralentit l'ordinateur

[W4].

I.7. Bilan du chapitre

A l'issue de ce chapitre nous avons présenté

l'ordinateur et démontrer qu'il est la mémoire précieuse

de stockage. Etant donné que la quantité d'informations des

entreprises fleurit abondamment.

De cette évidence admise, nous avons

démontré de manière permanente que l'ordinateur peut faire

dans un premier temps la gestion des données (mémoriser de

l'information : DD, RAM, ROM, DVD, CD, clé USB, ...) sans lui rajouter

beaucoup d'instructions. Pour bien vérifier ceci il y a

possibilité que cette performance d'informations au sein des entreprises

nécessité des méthodes assez gestionnaire des

données.

24

Chapitre II: Les bases des données : une

nouvelle considération de stockage et manipulation des

données

II.1. Introduction

Depuis peu, avec le développement d'une grande

quantité d'informations, l'ensemble des entreprises ont aspirées

à l'usage des bases de données. Bien attendu, les BD sont

nées à la fin des années 1960 pour combler les lacunes des

systèmes de fichiers et faciliter la gestion qualitative et quantitative

des données informatiques. On peut dire alors que les SGBD comme

étant au carrefour des applications de gestion des données sont

des applications informatiques permettant de créer et de gérer

des BD.

Nous précisons ici, que les BD relationnelles, issues

de la recherche de Codd, sont celles qui ont connu le plus grand essor depuis

l'évolution des différentes années, et qui reste encore

aujourd'hui les plus utilisées.

Cette considération laisse bien comprendre qu'on

utilise des SGBDR pour les implémenter. Un dernier élément

à retenir est que le langage SQL est le langage commun à tous les

SGBDR, ce qui permet de concevoir des BD relativement indépendamment des

systèmes utilisés [5].

Cette appréciation, veut signifier que les usages de BD

se sont aujourd'hui généralisés pour entrer dans tous les

secteurs de l'entreprise, depuis les petites bases utilisées par

quelques personnes dans un service pour des besoins de gestion de

données locales, jusqu'aux bases qui gèrent de façon

centralisée des données partagées par tous les acteurs de

l'entreprise.

Rien n'interdit l'accroissement de l'utilisation du

numérique comme outil de manipulation de toutes données

(bureautique, informatique applicative, etc.) et comme outil d'extension des

moyens de communication (réseaux) ainsi que les évolutions

technologiques (puissance des PC, Internet, etc.). Dans toute la suite sauf

mention du contraire, l'usage numérique a rendu indispensable, mais

aussi complexifié la problématique des BD.

Actuellement, la trajectoire sur les conséquences de

cette généralisation et de cette diversification des usages se

retrouve dans l'émergence de solutions conceptuelles et technologiques

nouvelles, les bases de données du mouvement NoSQL

particulièrement utilisées par les grands acteurs du web.

25

II.2. Base de données

II.2.1. Définition

Que retenir de la définition exacte d'une BD ? Cette

approche par la division de la fonction exercée pour chaque

modélisation reste, de notre point de vue, des quelques

définitions à retenir pour approcher les clivages qui peuvent

exister dans cet ensemble de conception.

Mis à part les définitions modéliser pour

chaque cas, les modélisations s'intéressent aux atouts et

finalités de chaque conception. De cela, retenons quelques

définitions avant d'en tirer une jugée universelle.

§1. Définition d'une BD comme ensemble de

données

a. Est appelé base de données, tout ensemble de

données stocké numériquement et pouvant servir à un

ou plusieurs programme. De leur côté, des fichiers sur un disque

dur, un fichier de tableur, voire un fichier de traitement de texte peuvent

constituer des bases de données.

b. Quel que soit, le support utilisé pour rassembler

et stocker les données (papier, fichiers, etc.), dès lors que des

données sont rassemblées et stockées d'une manière

organisée dans un but spécifique, on parle de base de

données.

§2. Définition d'une BD comme ensemble de

données structuré

a. Une base de données est un ensemble de

données numériques qui possède une structure ; c'est

à dire dont l'organisation répond à une logique

systématique. On parlera de modèle logique de données pour

décrire cette structure.

b. Une base de données est un ensemble

structuré et organisé permettant le stockage de grandes

quantités d'informations afin d'en faciliter l'exploitation (ajout, mise

à jour, la suppression et la recherche de données).

§3. Retenons ces quelques définitions

informatisées

? On appellera base de données un ensemble

structuré de données enregistrées dans un ordinateur et

accessibles de façon sélective par plusieurs utilisateurs [2].

? Est appelle Base de données un gros ensemble

d'informations structurées mémorisées sur un support

permanent [3].

? Une base de données est considérée comme

un recueil d'informations liées à un sujet donné [4].

Certaines mesures visent les bases de données ? Et

comme pour dire que les bases de données de demain devront être

capables de gérer plusieurs dizaines de téraoctets de

données,

26

II.2.2. Domaine problème posé

Tout d'abord, le résultat de la conception d'une base

de données informatisée est d'un premier ordre une description

des données. Compte tenu de la description on entend définir les

propriétés d'ensembles d'objets modélisés dans la

base de données et non pas d'objets particuliers.

Les objets particuliers sont créés par des

programmes d'applications ou des langages de manipulation lors des insertions

et des mises à jour des données. Il faut donc dire, que cette

description des données est réalisée en utilisant un

modèle de données qui du reste est un outil formel utilisé

pour comprendre l'organisation logique des données.

S'agissant de la gestion et l'accès à une base

de données, leurs rapprochements sont assurés par un ensemble de

programmes qui constituent le Système de gestion de base de

données (SGBD). Cela révèle d'un SGBD une

caractéristique par le modèle de description des données

qu'il supporte (hiérarchique, réseau, relationnel, objet).

Ce cadrage rappel que les données sont décrites

sous la forme de ce modèle, grâce à un Langage de

Description des Données (LDD). Cette description est appelée

schéma. D'où, nous consacrons une fois qu'une base de

données spécifiée, on peut y insérer des

données, les récupérer, les modifier et les

détruire. C'est ce qu'on appelle manipuler les données. Ces

données peuvent être manipulées non seulement par un

Langage spécifique de Manipulation des Données (LMD) mais aussi

par des langages de programmation classiques.

Sans prétendre à l'exhaustivité, il

s'agit là d'appréhender la place des bases de données avec

une spécificité importante en informatique, et

généralement dans le domaine de la gestion.

Cette manière de gestion a conduit à une

étude des bases de données qui consacre le développement

de concepts, méthodes et algorithmes spécifiques, notamment pour

gérer les données en mémoire secondaire (i.e. disques

durs).

Il nous faut esquisser ces éléments qui en

effet, dès l'origine de la discipline, les informaticiens ont

observé que la taille de la RAM ne permettait pas de charger l'ensemble

d'une base de données en mémoire. Cette hypothèse est

toujours vérifiée car le volume des données ne cesse de

s'accroître sous la poussée des nouvelles technologies du WEB.

27

géographiquement distribuées à

l'échelle d'Internet, par plusieurs dizaines de milliers d'utilisateurs

dans un contexte d'exploitation changeant (on ne sait pas très bien

maîtriser ou prédire les débits de communication entre

sites) voire sur des noeuds volatiles. En physique des hautes énergies,

on prédit qu'une seule expérience produira de l'ordre du

péta-octets de données par an.

Comme il est peu probable de disposer d'une technologie de

disque permettant de stocker sur un unique disque cette quantité

d'informations, les bases de données se sont orientées vers des

architectures distribuées ce qui permet, par exemple, d'exécuter

potentiellement plusieurs instructions d'entrée/sortie en même

temps sur des disques différents et donc de diviser le temps total

d'exécution par un ordre de grandeur.

II.2.3. Modèle de base de données

1. Modèle hiérarchique

Est appelé base de données hiérarchique

est une forme de système de gestion de base de données qui lie

des enregistrements dans une structure arborescente de façon à ce

que chaque enregistrement n'ait qu'un seul possesseur (par exemple, une paire

de chaussures n'appartient qu'à une seule personne).

De ce fait, les structures de données

hiérarchiques ont été largement utilisées dans les

premiers systèmes de gestion de bases de données conçus

pour la gestion des données du programme Apollo de la NASA.

En effet, à cause de leurs limitations internes, elles

ne peuvent pas souvent être utilisées pour décrire des

structures existantes dans le monde réel. Cependant, les liens

hiérarchiques entre les différents types de données

peuvent rendre très simple la réponse à certaines

questions, mais très difficile la réponse à d'autres

formes de questions.

Si le principe de relation « 1 vers N » n'est pas

respecté (par exemple, un malade peut avoir plusieurs médecins et

un médecin a, a priori, plusieurs patients), alors la hiérarchie

se transforme en un réseau.

2. Modèle réseau

On appelle modèle réseau, modèle qui est

en mesure de lever de nombreuses difficultés du modèle

hiérarchique grâce à la possibilité d'établir

des liaisons de type n-n (relations plusieurs à plusieurs), les liens

entre objets pouvant exister sans restriction.

28

Pour retrouver une donnée dans une telle

modélisation, il faut connaître le chemin d'accès (les

liens) ce qui rend les programmes dépendants de la structure de

données. Ce modèle de bases de données a été

inventé par C.W. Bachman. Pour son modèle, il reçut en

1973 le prix Turing.

3. Modèle relationnel

Une base de données relationnelle est une base de

données structurée suivant les principes de l'algèbre

relationnelle. Le père des bases de données relationnelles est

Edgar Frank Codd. Chercheur chez IBM à la fin des années 1960, il

étudiait alors de nouvelles méthodes pour gérer de grandes

quantités de données car les modèles et les logiciels de

l'époque ne le satisfaisaient pas. Mathématicien de formation, il

était persuadé qu'il pourrait utiliser des branches

spécifiques des mathématiques (la théorie des ensembles et

la logique des prédicats du premier ordre) pour résoudre des

difficultés telles que la redondance des données,

l'intégrité des données ou l'indépendance de la

structure de la base de données avec sa mise en oeuvre physique.

Vers les années 1970, Codd (1970) publia un article

où il proposait de stocker des données

hétérogènes dans des tables, permettant d'établir

des relations entre elles. De nos jours, ce modèle est extrêmement

répandu, mais en 1970, cette idée était

considérée comme une curiosité intellectuelle. On doutait

que les tables puissent être jamais gérées de

manière efficace par un ordinateur.

Ce scepticisme n'a cependant pas empêché Codd de

poursuivre ses recherches. Un premier prototype de Système de gestion de

bases de données relationnelles (SGBDR) a été construit

dans les laboratoires d'IBM. Depuis les années 80, cette technologie a

mûri et a été adoptée par l'industrie. En 1987, le

langage SQL, qui étend l'algèbre relationnelle, a

été standardisé.

4. Modèle objet

La notion de bases de données objet ou

relationnel-objet est plus récente et encore en phase de recherche et de

développement. Elle sera très probablement ajoutée au

modèle relationnel.

29

II.3. Système de gestion de base de

données (SGBD

) II.3.1. Notions et définition

La recherche sur la gestion et l'accès à une

base de données sont assurés par un ensemble de programmes qui

constituent le Système de gestion de base de données (SGBD). Un

SGBD exerce les fonctions comme l'ajout, la modification et la recherche de

données. Il est chargé d'héberge

généralement plusieurs bases de données, qui sont

destinées à des logiciels ou des thématiques

différents.

Cependant du fait de recevoir plusieurs requêtes, la

plupart des SGBD fonctionnent selon un mode client/serveur. Le serveur

(sous-entendu la machine qui stocke les données) reçoit des

requêtes de plusieurs clients et ceci de manière concurrente. Le

serveur analyse la requête, la traite et retourne le résultat au

client. Le modèle client/serveur est assez souvent

implémenté au moyen de l'interface des sockets (voir le cours de

réseau) ; le réseau étant Internet.

Dans ce mouvement, une variante de ce modèle est le

modèle ASP (Application Service Provider). Dans ce modèle, le

client s'adresse à un mandataire (broker) qui le met en relation avec un

SGBD capable de résoudre la requête. La requête est ensuite

directement envoyée au SGBD sélectionné qui résout

et retourne le résultat directement au client.

La déclinaison de ce modèle est qu'un des

problèmes fondamentaux à prendre en compte est la

cohérence des données. Par exemple, dans un environnement

où plusieurs utilisateurs peuvent accéder concurremment à

une colonne d'une table par exemple pour la lire ou pour l'écrire, il

faut s'accorder sur une évidence d'écriture. Cette

évidence peut être : les lectures concurrentes sont

autorisées mais dès qu'il y a une écriture dans une

colonne, l'ensemble de la colonne est envoyée aux autres utilisateurs

l'ayant lue pour qu'elle soit rafraîchie.

Un Système de Gestion de Base de Données est

alors considérer comme un ensemble de logiciels prenant en charge la

structuration, le stockage, la mise à jour et la maintenance des

données. Autrement dit, il permet de décrire, modifier,

interroger et administrer les données. C'est, en fait, l'interface entre

la base de données et les utilisateurs (qui ne sont pas forcément

informaticiens).

30

II.3.2. Objectifs, propriétés, composants et

organisation de la mise en oeuvre d'un SGBD

§1. Objectifs d'un SGBD

Les objectifs et les propriétés principaux ont

été fixés aux SGBD dès l'origine de ceux-ci et ce,

afin de résoudre les problèmes causés par la

démarche classique.

· Indépendance physique

: La façon dont les données sont définies

doit être indépendante des structures de stockage

utilisées.

· Indépendance logique

: Un même ensemble de données peut être vu

différemment par des utilisateurs différents. Toutes ces visions

personnelles des données doivent être intégrées dans

une vision globale.

· Accès aux données

: L'accès aux données se fait par

l'intermédiaire d'un Langage de Manipulation de Données (LMD). Il

est crucial que ce langage permette d'obtenir des réponses aux

requêtes en un temps « raisonnable ». Le LMD doit donc

être optimisé, minimiser le nombre d'accès disques, et tout

cela de façon totalement transparente pour l'utilisateur.

· Administration centralisée des

données (intégration) : Toutes les données

doivent être centralisées dans un réservoir unique commun

à toutes les applications. En effet, des visions différentes des

données (entre autres) se résolvent plus facilement si les

données sont administrées de façon centralisée.

· Non redondance des données

: Afin d'éviter les problèmes lors des mises

à jour, chaque donnée ne doit être présente qu'une

seule fois dans la base.

· Cohérence des données

: Les données sont soumises à un certain nombre de

contraintes d'intégrité qui définissent un état

cohérent de la base. Elles doivent pouvoir être exprimées

simplement et vérifiées automatiquement à chaque

insertion, modification ou suppression des données. Les contraintes

d'intégrité sont décrites dans le Langage de Description

de Données (LDD).

· Partage des données :

Il s'agit de permettre à plusieurs utilisateurs d'accéder aux

mêmes données au même moment de manière transparente.

Si ce problème est simple à résoudre quand il s'agit

uniquement d'interrogations, cela ne l'est plus quand il s'agit de

modifications dans un contexte multi-utilisateurs car il faut : permettre

à deux (ou plus) utilisateurs de modifier la même donnée

« en même temps » et assurer un résultat d'interrogation

cohérent pour un utilisateur consultant une table pendant qu'un autre la

modifie.

31

· Sécurité des données

: Les données doivent pouvoir être

protégées contre les accès non autorisés. Pour

cela, il faut pouvoir associer à chaque utilisateur des droits

d'accès aux données.

· Résistance aux pannes

: Que se passe-t-il si une panne survient au milieu d'une

modification, si certains fichiers contenant les données deviennent

illisibles ? Il faut pouvoir récupérer une base dans un

état « sain ». Ainsi, après une panne intervenant au

milieu d'une modification deux solutions sont possibles : soit

récupérer les données dans l'état dans lequel elles

étaient avant la modification, soit terminer l'opération

interrompue.

§2. Propriétés d'un SGBD

Cette partie retrace les propriétés fondamentales

d'un SGBD à savoir:

· Base formelle reposant sur des

principes parfaitement définis,

· Organisation structurée

des données dans des tables interconnectées

(d'où le qualificatif relationnelles), pour pouvoir détecter les

dépendances et redondances des informations,

· Implémentation d'un langage

relationnel ensembliste permettant à l'utilisateur de

décrire aisément les interrogations et manipulation qu'il

souhaite effectuer sur les données,

· Indépendance des données

vis-à-vis des programmes applicatifs (dissociation entre

la partie "stockage de données" et la partie "gestion" - ou

"manipulation"),

· Gestion des opérations concurrentes

pour permettre un accès multi-utilisateur sans conflit

· Gestion de l'intégrité des

données, de leur protection contre les pannes et les

accès illicites,

§3. Composants des SGBD

La montée en possession d'un certain nombre des

composants logiciels d'un SGBD précise:

· La description des données

au moyen d'un Langage de Définition de

Données(LDD). Le résultat de la compilation est un ensemble de

tables, stockées dans un fichier spécial appelé

dictionnaire (ou répertoire) des données,

· La manipulation des données

au moyen d'un Langage de Manipulation de Données(LMD)

prenant en charge leur consultation et leur modification de façon

optimisée, ainsi que les aspects de sécurité,

32

· La sauvegarde et la

récupération après pannes, ainsi que des

mécanismes permettant de pouvoir revenir à l'état

antérieur de la base tant qu'une modification n'est pas finie (notion de

transaction),

· Les accès concurrents aux

données en minimisant l'attente des utilisateurs et en

garantissant l'obtention de données cohérentes en cas de mises

à jours simultanées,

§4. Organisation de la mise en oeuvre des

SGBD

Les entreprises cherchent à généraliser

les outils d'aide à la décision pour la gestion des

données. Au travers les besoins que concernent cette gestion, c'est sans

conséquence que le souhait des fonctions avec pour objectif de

sécuriser, maintenir et mettre à jour ces informations que le

partage beaucoup plus fin et transparent de l'information via le système

informatique entre les cadres et les agents a des effets sur les modes

d'évaluation du travail des entreprises.

De ce fait, nous décrivons quatre catégories de

fonctions qui consacrent cette gestion de données:

· Les tâches liées à

l'architecture de données consistent à analyser,

classifier et structurer les données au moyen de modèles

confirmés,

· L'administration de données

vise à superviser l'adéquation des

définitions et des formats de données avec les directives de

standardisation et les normes internationales, à conseiller les

développeurs et les utilisateurs, et à s'assurer de la

disponibilité des données à l'ensemble des applications.

L'administrateur assume en outre des responsabilités importantes dans la

maintenance et la gestion des autorisations d'accès,

· Les professionnels en technologie de

données ont en charge l'installation, la supervision, la

réorganisation, la restauration et la protection des bases. Ils en

assurent aussi l'évolution au fur et à mesure des progrès

technologiques dans ce domaine,

· L'exploitation de données

consiste à mettre à disposition des utilisateurs

les fonctions de requête et de reporting (générateurs

d'états), ainsi qu'à assurer une assistance aux différents

services pour qu'ils puissent gérer leur stock propre de données

en autonomie (service infocentre).

Pour atteindre certains de ces objectifs

précités (surtout les deux premiers), trois niveaux de

description des données ont été définis par la

norme ANSI/SPARC.

II.3.3. Affinement de niveaux de description des

ANSI/SPARC

Ce modèle, utilisé pour la phase de conception,

s'inscrit notamment dans le cadre d'une méthode plus

générale et très répandue :

Merise.

33

? Le niveau externe : correspond

à la perception de tout ou partie de la base par un groupe donné

d'utilisateurs, indépendamment des autres. On appelle cette description

le schéma externe ou vue. Il peut exister plusieurs schémas

externes représentant différentes vues sur la base de

données avec des possibilités de recouvrement. Le niveau externe

assure l'analyse et l'interprétation des requêtes en primitives de

plus bas niveau et se charge également de convertir

éventuellement les données brutes, issues de la réponse

à la requête, dans un format souhaité par l'utilisateur.

? Le niveau conceptuel :

décrit la structure de toutes les données de la base, leurs

propriétés (i.e. les relations qui existent entre elles : leur

sémantique inhérente), sans se soucier de l'implémentation

physique ni de la façon dont chaque groupe de travail voudra s'en

servir. Dans le cas des SGBD relationnels, il s'agit d'une vision tabulaire

où la sémantique de l'information est exprimée en

utilisant les concepts de relation, attributs et de contraintes

d'intégrité. On appelle cette description le schéma

conceptuel.

? Le niveau interne ou physique :

s'appuie sur un système de gestion de fichiers pour définir la

politique de stockage ainsi que le placement des données. Le niveau

physique est donc responsable du choix de l'organisation physique des fichiers

ainsi que de l'utilisation de telle ou telle méthode d'accès en

fonction de la requête. On appelle cette description le schéma

interne.

II.4. Modélisation des bases de données

: le modèle entités-associations

II.4.1. Généralités

§1. Pourquoi une modélisation

préalable ?

Ouvrir l'aspect sur la modélisation revient à

dire qu'il est difficile de modéliser un domaine sous une forme

directement utilisable par un SGBD. Cependant, une ou plusieurs

modélisations intermédiaires sont donc utiles, le modèle

entités-associations constitue l'une des premières et des plus

courantes.

Ce modèle, présenté par Chen (1976),

permet une description naturelle du monde réel à partir des

concepts d'entité et d'association. Basé sur la théorie

des ensembles et des relations, ce modèle se veut universel et

répond à l'objectif d'indépendance

données-programmes.

34

§2. Merise

C'est bien ce qui constitue la spécificité de

la méthode MERISE (Méthode d'Étude et de

Réalisation Informatique pour les Systèmes d'Entreprise) qui est

certainement à la disparité comme le langage de

spécification le plus répandu dans la communauté de

l'informatique, des systèmes d'information, et plus

particulièrement dans le domaine des bases de données.

Une représentation Merise permet de valider des choix

par rapport aux objectifs, de quantifier les solutions retenues, de mettre en

oeuvre des techniques d'optimisation et enfin de guider jusqu'à

l'implémentation. Reconnu comme standard, Merise devient un outil de

communication. En effet, Merise réussit le compromis difficile entre le

souci d'une modélisation précise et formelle, et la

capacité d'offrir un outil et un moyen de communication accessible aux

non-informaticiens.

Cela explique que certains des concepts clés de la

méthode Merise est la séparation des données et des

traitements. Cette méthode est donc parfaitement adaptée à

la modélisation des problèmes abordés d'un point de vue

fonctionnel [6].

Si on prend l'exemple méthodologique, on observe que

les données représentent la statique du système

d'information et les traitements sa dynamique. L'expression conceptuelle des

données conduit à une modélisation des données en

entités et en associations.

Merise règne et propose une démarche, dite par

niveaux, dans laquelle il s'agit de hiérarchiser les

préoccupations de modélisation qui sont de trois ordres :

la conception, l'organisation et la technique.

Des nombreuses études ont régulièrement

mis en avant cette méthode, pour aborder la modélisation d'un

système, au fil de temps il convient de l'analyser en premier lieu de

façon globale et de se concentrer sur sa fonction : c'est-à-dire

de s'interroger sur ce qu'il fait avant de définir comment il le fait.

Quelques niveaux de modélisation, sont organisés dans une double

approche données/traitements.

La contrainte est de parler de ces trois niveaux de

représentation des données :

? Niveau conceptuel : le

modèle conceptuel des données (MCD) décrit les

entités du monde réel, en termes d'objets, de

propriétés et de relations, indépendamment de toute

technique d'organisation et d'implantation des données. Ce modèle

se concrétise par

35

un schéma entités-associations

représentant la structure du système d'information, du point de

vue des données.

· Niveau logique : le

modèle logique des données (MLD) précise le modèle

conceptuel par des choix organisationnels. Il s'agit d'une transcription

(également appelée dérivation) du MCD dans un formalisme

adapté à une implémentation ultérieure, au niveau

physique, sous forme de base de données relationnelle ou réseau

d'où les choix techniques d'implémentation (choix d'un SGBD) ne

seront effectués qu'au niveau suivant.

· Niveau physique : le

modèle physique des données (MPD) permet d'établir la

manière concrète dont le système sera mis en place (SGBD

retenu).

II.4.2. Le modèle entités-associations

[W2] II.4.2.1. Définitions

· Une entité est un

objet spécifique, concret ou abstrait, de la réalité

perçue. Ce peut être une personne, un objet inerte, un concept

abstrait, un événement, ...

· Un attribut est une

caractéristique ou une qualité d'une entité ou d'une

association. Il peut être atomique (ex. nom,

prénom) ou composé (ex.

adresse=n°+rue+code_postal+ville)

et peut prendre une ou plusieurs valeur(s) (on parle d'attribut mono- ou

multivalué). Le domaine d'un attribut est

l'ensemble des valeurs que peut prendre celui-ci; il est utile pour

vérifier la validité d'une donnée.

· Un type d'entité est

la classe de toutes les entités de la réalité

perçue qui sont de même nature et qui jouent le même

rôle. Un type d'entité est défini par un nom et un ensemble

d'attributs, qui sont les caractéristiques communes à toutes les

entités de même type; ces dernières forment un ensemble

d'entités (par exemple, un ensemble des travailleurs,

caractérisés par leurs nom et prénom). Par simplification

de la terminologie, on appellera entité un type d'entité, et

occurrence d'une entité un individu

particulier faisant partie d'une entité.

· Le schéma ou intention d'une

entité en est la description ; l'ensemble des occurrences

d'une entité qui existent dans la base à un instant donné

s'appelle l'extension de l'entité. Le schéma d'une entité

ne change pas fréquemment car il en décrit la structure ; son

extension, en revanche, change à chaque insertion ou suppression d'une

occurrence d'entité.

36

? L'attribut clé ou identifiant d'une

entité est un groupe minimal d'attributs permettant de

distinguer sans ambiguïté les occurrences d'entités dans

l'ensemble considéré.

? Un identifiant ou clé d'un

type-entité ou d'un type-association est constitué

par un ou plusieurs de ses attributs qui doivent avoir une valeur unique pour

chaque entité ou association de ce type.

Il est donc impossible que les attributs constituant

l'identifiant d'un type-entité (respectivement type-association)

prennent la même valeur pour deux entités (respectivement deux

associations) distinctes. Prenons un cas pratique : Exemples

d'identifiant: le numéro de sécurité sociale

pour une personne, le numéro d'immatriculation pour une voiture, le code

ISBN d'un livre pour un livre (mais pas pour un exemplaire).

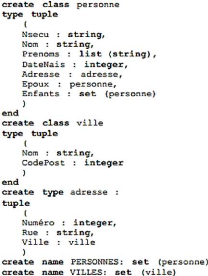

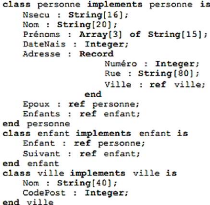

Figure II.1. Cas pratique de type-entité

Sémantique de la figure II.1. Comportant quatre

attributs dont un est un identifiant : deux personnes peuvent avoir le

même nom, le même prénom et le même âge, mais

pas le même numéro de sécurité sociale.

? Une association ou relation est

une correspondance entre 2 ou plusieurs occurrences d'entités à

propos de laquelle on veut conserver des informations. On dit que les

occurrences d'entités participent ou jouent un rôle dans

l'association. Un type d'association est défini par un nom et une liste

d'entités avec leur rôle respectif (notation : A (ro1:E1,

ro2 :E2... ron: En)). Eu des termes simples, on appelle

association un type d'association et occurrence d'association toute

correspondance qui existe entre deux ou plusieurs occurrences d'entités.

L'ensemble des occurrences d'une association qui existe dans la base à

un instant donné s'appelle l'extension de l'association.

Exemple d'association: APPARTENANCE (appartient: ELEVE,

inclut: CLASSE) décrit le fait qu'un élève appartient

à une classe et, symétriquement, qu'une classe inclut plusieurs

élève.

37

Figure II.2. Cas pratique de modèle

entité-association Figure II.3. Exemple d'occurrences de

l'association APPARTENANCE

? Une association peut aussi

posséder des attributs. Un attribut de l'association APPARTENANCE

pourrait être, par ex., un entier indiquant le(s) semestre(s) scolaire(s)

suivi(s) par l'élève.

? Le degré (ou la dimension) d'une

association est le nombre d'entités y participant. Le cas

le plus fréquent est celui de l'association binaire

II.4.2.2. Cardinalité d'une association

La cardinalité d'une association exprime le nombre

minimum et le nombre maximum de fois où chaque occurrence

d'entité participe à une relation.

Autrement dit, la cardinalité de A(ro1:E1,

ro2:E2,...,ron:En) est définie par un ensemble de

couples (mini, maxi) où mini (resp. maxi) indique le nombre minimum

(resp. maximum) de fois que toute occurrence de Ei doit assumer le rôle

roi.

De ce fait, on distingue 4 cas principaux :

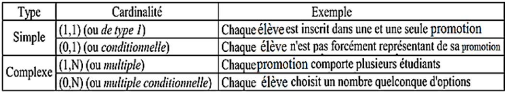

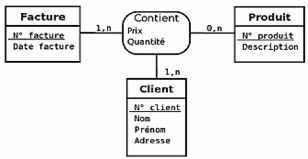

Tableau II.1. Exemples cardinalités et types

38

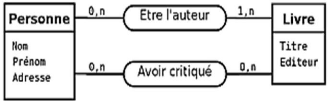

Figure II.4. Représentation graphique et exemples

(suppose qu'un livre ne peut posséder

qu'un auteur) sur les

cardinalités

La mobilité, en particulier des cardinalités

revêt deux explications à savoir :

? L'expression de la cardinalité est obligatoire pour

chaque patte d'un type-association. ? Une cardinalité minimal est

toujours 0 ou 1 et une cardinalité maximale est toujours 1 ou n.

L'idée de basculer de son fonctionnement revient

à dire que, si une cardinalité maximale est connue et vaut 2, 3

ou plus, alors nous considérons qu'elle est indéterminée

et vaut n.

Cela limitait en effet l'idée : si nous connaissons n

au moment de la conception, il se peut que cette valeur évolue au cours

du temps. Il vaut donc mieux considérer n comme inconnue dès le

départ.

De la même manière, on ne modélise pas des

cardinalités minimales qui valent plus de 1 car ces valeurs sont

également susceptibles d'évoluer. Enfin, une cardinalité

maximale de 0 n'a pas de sens car elle rendrait le type-association inutile.

Les seuls cardinalités admises sont donc :

? 0,1 : une occurrence du

type-entité peut exister tout en étant impliquée dans

aucune association et peut être impliquée dans au maximum une

association.

? 0,n : c'est la cardinalité

la plus ouverte ; une occurrence du type-entité peut exister tout en

étant impliquée dans aucune association et peut être

impliquée, sans limitation, dans plusieurs associations.

? 1,1 : une occurrence du

type-entité ne peut exister que si elle est impliquée dans

exactement (au moins et au plus) une association.

? 1,n : une occurrence du

type-entité ne peut exister que si elle est impliquée dans au

moins une association.

39

Pour pouvoir procèder à des mouvements des

éntités du type-entité, il est tout à fait possible

de preciser qu'une cardinalité minimale de 1 doit se justifier par le

fait que les entités du type-entité en questions ont besoin de

l'association pour exister.

Dans tous les autres cas, la cardinalité minimale vaut

0. Ceci dit, la discussion autour d'une cardinalité minimale de 0 ou de

1 n'est intéressante que lorsque la cardinalité maximale est 1.

Cela explique, que nous verrons cette traduction vers un schéma

relationnel, lorsque la cardinalité maximale est n, nous ne ferons pas

la différence entre une cardinalité minimale de 0 ou de 1.

II.4.3. Notations d'associations

type-entité

II.4.3.1. Associations plurielles

Figure II.5. Cas pratique d'associations plurielles entre un

type-entité

Sémantique de la figure II.5. Cette figure comporte

un type-association qui permet de modéliser que des personnes

écrivent des livres et un autre que des personnes critiquent (au sens de

critique littéraire) des livres.

Il faut aussi noter que deux mêmes entités

peuvent être plusieurs fois en association comme la figure

précédente le démontre.

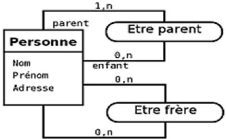

II.4.3.2. Associations réflexives

Les type-associations réflexifs sont présents

dans la plupart des modèles, il est défini comme un

type-association est qualifié de réflexif quand il

matérialise une relation entre un type-entité et lui-même

comme la fugure suivante.

40

Figure II.6. Cas pratique d'associations réflexives

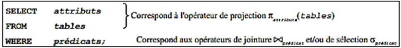

sur le type-entité personne