|

Internet : Une nouvelle dimension du Système

International

Sous la direction de Mr Igor LEFEVRE

Université

des Sciences Sociales - Toulouse 1

Remerciements

Remerciements tout d'abord à notre directeur de

mémoire, Mr LEFEVRE, qui par son expérience, son écoute et

son humour a réussi à encadrer et à mettre en valeur une

recherche motivée mais parfois désordonnée.

Remerciements à toutes les personnes que j'ai pu

interviewer en direct ou par email : Mme Anne-Rachel INNE, Mr Joseph BREHAM, Mr

Louis POUZIN et Mr José BALLANCHO. Sans eux, ce mémoire n'aurait

pu exister. Merci à eux de leur disponibilité et de leur aide

jamais démenties.

Remerciements à ma mère qui m'a aidé,

notamment par ses relectures, ses commentaires, son aide matérielle et

son point de vue profane qui m'a obligé à revoir mes propos et

mon travail. Merci à elle pour tout cela.

Introduction

Avec 1, 35 milliards d'utilisateurs en 2007 d'après une

étude du cabinet d'analyse Research and Markets1, des revenus

estimés à 524 milliards de dollars par des économistes

français2 en 2001 et une croissance égale à 50%

de l'augmentation du PIB des Etats-Unis, Internet est devenu un enjeu des plus

actuels.

La structure du « réseau des réseaux »

ou « Inter-Networks », Internet, est complexe et pourtant très

intéressante à étudier car certaines de ces

spécificités techniques ont engendrées des enjeux

conséquents. Le premier exemple et le plus connu est celui du service

DNS, équivalent d'un annuaire permettant de relier une adresse physique

(IP)3 à une adresse virtuelle tapée sur un clavier

(URL - Ex. :

www.univ-tlse1.fr). La

gestion de ce service est essentielle car sans lui, Internet ne serait pas

accessible à la plupart des utilisateurs : on pourrait dire qu'il ne

fonctionnerait pas. Le second exemple tient à la nature « neutre

» ou bien encore à l'intelligence «

décentralisée » du réseau. Cela signifie qu'Internet

est un simple outil de transmission : peu lui importe la nature de ce qu'il

transporte puisque c'est « au bout » de la chaîne de

transmission que l'information va être analysée,

décodée et utilisée. Au final, ces aspects purement

techniques ne doivent pas être écartés en raison des

importants enjeux politiques qu'ils entraînent. Ces enjeux trouvent

notamment un écho dans les relations internationales et c'est l'objet de

ce travail de décrypter ces enjeux et d'en donner une brève

analyse.

Le second aspect d'Internet est celui de sa gestion proprement

dite, de sa « gouvernance ». Le retard affiché par la

quasi-totalité des Etats (mis à part les Etats-Unis) au regard de

l'importance croissante que prend le réseau en termes d'économie

ou bien encore de diffusion de la démocratie..., a pour effet de donner

un « coup de fouet » à la prise en compte politique et

diplomatique de cet objet dans les Relations Internationales. Cependant,

s'arrêter aux Etats pour analyser l'importance d'Internet serait une

erreur,

1 Information extraite de la Veille Stratégique concernant

Internet disponible à :

http://arnaudgarrigues.blog.com

.

2 Gaudeul A., & Julien B. (2001), Revue Economique., V. 52

3 Il est difficile d'être pertinent à propos

d'Internet sans être technique. Cependant, tous les termes seront

abondamment expliqués dans la première partie. Quant à

ceux-là, ils paraissent encore abordables.

d'autant plus que la plupart des acteurs habituellement

décrits dans le système international ont à un niveau ou

à un autre, intégré le réseau.

Par ailleurs, il ne s'agit pas de décrire une

géopolitique d'Internet comme plusieurs auteurs ont pu le

faire4. Le terme géopolitique renvoie par trop à la

notion de territoire et bien évidemment, de géographie. Or, ici,

l'objet est tout sauf unidimensionnel. En effet, on peut d'abord le diviser en

deux parties : celle des enjeux techniques d'une part et des enjeux de la

gouvernance d'autre part. Une subdivision est encore possible dans la partie

technique : on considérerait alors trois niveaux de réflexions :

le niveau des infrastructures physiques du réseau, le niveau des

protocoles basiques du réseau et enfin, le niveau de la nature des

données transportées par le réseau. On ne peut donc se

référer simplement à un cadre géopolitique car bien

qu'il soit bidimensionnel (géographique et politique), il est par nature

incapable de rendre compte des phénomènes liés à

Internet. Enfin, il est encore possible de diviser la partie purement politique

d'Internet, les phénomènes créés par la simple

existence et l'utilisation du réseau, en plusieurs parties. En effet, en

terme de relations internationales, Internet agite tous les niveaux, que ce

soit le système, les états ou bien les autres acteurs.

Enfin, un dernier commentaire s'impose. En raison des enjeux

que le système Internet induit, des acteurs qu'il implique et des

dynamiques que l'on peut y trouver, on ne peut s'empêcher de penser au

pétrole ou bien encore au nucléaire. L'importance prise par ce

qui ne peut être vu à la base que comme des outils (pour

l'industrie, pour la stratégie militaire) et les enjeux qui en

résultent en termes de relations internationales, tout cela constitue un

ensemble de phénomènes très proches de ceux que l'on peut

observer à propos d'Internet. Ce sera donc l'objet de ce mémoire

que de montrer en quoi Internet constitue une nouvelle dimension du

Système International.

4 Notamment : Godeluck, S. (2002). La Géopolitique

d'Internet : La découverte ou bien encore le dossier du même titre

dans le 3ème numéro de 2006 de la revue

spécialisée Politique Etrangère.

Prolégomènes

L'objectif de cette partie sera de mettre en valeur plusieurs

points déterminants : le cadre d'analyse choisi, la

problématique et les hypothèses qui ont été

construites, la justification et l'annonce du plan et les outils

de recherche utilisés et méthodologiquement justifiés

et expliqués.

Le but est ici de mettre en avant tous les choix

méthodologiques qui ont été faits que ce soit dans le

choix du type d'analyse ou bien des outils de recherche utilisés. Par

ailleurs, cela permet de construire l'articulation logique de ce

mémoire, de donner aux analyses qui seront développées

plus de pertinence et ainsi donner à ce travail un caractère plus

scientifiq ue.

Analyse Stratégique :

Analyser Internet conduit à se poser des questions

entrant dans des dimensions multiples. Actuellement, une simple recherche sur

Internet dans les catalogues des facultés permet de voir que l'aspect

social ou économique d'Internet (blogs, nouvelles formes de

démocratie,...) est très en vogue. Or ici, l'intérêt

est porté uniquement sur une vision stratégique d'Internet et

dans les relations internationales plus précisément. Ainsi, il

est donc nécessaire de bien définir le sens de l'analyse dans

laquelle nous allons inclure cette recherche.

Le type d'analyse choisi est donc l'analyse stratégique.

En effet, Raymond Aron a affirmé que

« toute étude concrète des relations

internationales est une étude sociologique »5. Or, ici,

il

est question d'analyser un objet social (Internet) dans une

optique de Relations Internationales. Une analyse de type sociologique

paraît donc pertinente. L'intérêt porté aux enjeux et

aux relations de pouvoirs, de dominations...renvoie de façon

immédiate à une analyse stratégique. Cependant, Il semble

nécessaire à ce niveau de justifier une telle affirmation qui,

sans cela, serait péremptoire et pour ce faire, de décrire plus

précisément les fondements et la méthode de l'analyse

stratégique.

5 ARON, R. (1967). Qu'est ce qu'une théorie des Relations

Internationale, Revue Française de Science Politique, 17 (5), Octobre

1967, p. 837-861.

Les travaux de Michel Crozier et de Francis

Pavé6 ont livré une méthode et une

description de l'analyse stratégique permettant de fixer le cadre

d'analyse et les modèles logiques liés à ce type

d'analyse.

Tout d'abord, l'analyse stratégique se situe dans une

logique heuristique : elle a pour but de découvrir un objet social. La

pratique du raisonnement, les techniques d'investigation lui sont propres et

sont bien particulières.

Elle repose sur divers postulats, qui peuvent être

contestés ainsi que le disent les auteurs, mais qui permettent de fonder

une représentation de l'objet social en vue d'un but bien particulier.

Dans le cadre de ces idées, elle met en place trois notions

fondées sur des postulats :

L'Acteur. C'est l'objet central de l'analyse. Il est

capable de calcul et de choix : il est rationnel au moins en partie. L'analyse

ne se pose pas de questions sur la nature de l'acteur : il est acteur

simplement parce qu'il appartient à un contexte d'action (il agit sur

Internet ou sur la nature, l'évolution d'Internet), c'est presque un

agent. L'étude permet de reconstruire empiriquement l'acteur et c'est

pourquoi on ne se pose pas de questions sur lui : seules ses

caractéristiques par rapport à l'objet social intéressent.

L'acteur est l'élément de premier plan de l'analyse et selon les

auteurs, cela s'explique par le fait qu'il est le seul à avoir la

capacité à mobiliser et faire exister les contraintes, les

problèmes, les solutions et les opportunités.

Le Pouvoir : c'est la seconde notion pertinente de

l'analyse. Le postulat lié à cette notion est une vision des

rapports humains « médiatisés » par des relations de

pouvoir. Si, pour des relations humaines, le postulat est contestable, il

paraît en revanche, parfaitement adapté à l'étude du

système international. L'objet est ici de montrer que cette vision est

adaptée à l'étude d'Internet. Cette façon de voir

permet d'introduire différents éléments : l'existence de

conflits, d'accords ou d'alliances et évite une vue trop consensuelle.

Par ailleurs, son plus grand avantage est de considérer

l'instabilité et la conflictualité comme normales et de chercher

à expliquer la stabilité, la régularité.

L'adaptation de cette vision à un système international

considéré comme anarchique, hobbesien est manifeste. L'intuition

la rapproche d'une certaine vision d'Internet, apportée notamment par

les éléments que j'ai pu citer au début du

résumé de la phase exploratoire (inflation normative, lien entre

le terrorisme et le réseau...). Par ailleurs, une telle vision a le

mérite d'expliquer l'absence de

6 Voir Bibliographie en fin de mémoire

« comportements à logique linéaire »

de certains acteurs en lien avec la considération du pouvoir comme une

motivation : il s'agit tout simplement d'expliquer les « stratégies

» entendues ici au sens commun. Cette vision concentre aussi le

raisonnement sur les relations entre les acteurs, l'existence de

minorités et de volonté de domination et la capacité des

acteurs à créer des compétences et des capacités

pour répondre à leur motivation. Cette vision n'est pas sans

rappeler la guerre de l'information à laquelle fait

référence Jean Guisnel7.

Système : adopter une analyse

stratégique, c'est sous-entendre l'existence d'un système. En

effet, l'étude du pouvoir comme motivation absolue est un postulat qui

entraîne l'existence de relations d'interdépendances entre les

acteurs. Cela veut donc dire que l'on fait un « pari » sur

l'existence de ces relations dans la réalité sans quoi, il est

impossible de faire une telle analyse. Le postulat donc, ou «

hypothèse heuristique », est qu'il existe un ordre ou une

interdépendance des acteurs. Les conséquences d'un tel postulat

sont que l'on s'abstient de rechercher la cause de cet ordre (bien que l'on

puisse le faire dans un autre cadre d'analyse) au bénéfice du

« comment ».

Problématique et Hypothèses :

Au final, l'enchaînement des postulats donne le

raisonnement suivant : la motivation est le pouvoir, ce qui entraîne une

interdépendance des acteurs dans la recherche de pouvoir, ce qui donc

explique les phénomènes. On parle alors

d'endogénéisation des phénomènes : on trouve leur

explication dans les relations entre les acteurs. C'est pourquoi la notion de

système s'intègre à l'analyse stratégique. La

relation avec le système international est donc immédiate : la

vision réaliste s'adapte tout particulièrement bien à ce

type d'analyse et l'objet du mémoire est donc de montrer l'existence

d'un tel système. Or précisément, la délimitation

du système est un objet de recherche comme disent les auteurs. Cela

permet donc de constituer une partie de la problématique.

Après avoir décrit les principaux fondements de

l'analyse stratégique, il est alors possible de donner la

problématique de mon mémoire :

7 GUISNEL, J. ((2005).Guerres dans le Cyberespace - Services

secrets et Internet : La Découverte

La question principale que l'on peut se poser est la suivante

: En quoi Internet est-il certes un univers nouveau mais où les

dynamiques observables sont comparables à celles du système

international contemporain et où les acteurs impliqués dans ces

dynamiques sont aussi ceux du système international ?

Cette problématique a plusieurs mérites. Le

premier est qu'elle rappelle qu'Internet est un « univers nouveau »,

ce qui renvoie à la fois à sa spécificité qu'il

faudra expliquer mais aussi aux capacités des acteurs à

créer des compétences, des moyens et à faire surgir les

opportunités comme il a été dit plus haut à propos

de l'analyse stratégique. Le second aspect est qu'elle permet à

la fois de revenir sur les acteurs, cela est dit de façon explicite mais

aussi de revenir sur les relations de pouvoir. En effet, la mise à jour

des « dynamiques » évoquées dans la

problématique devrait, pour autant que les hypothèses soient

justes, mettre en avant des relations entre acteurs basées sur un besoin

de pouvoir et de contrôle. Enfin, le dernier atout d'une telle

problématique est de permettre de reconstruire un système, que ce

soit en premier lieu, un système Internet ou bien encore une fois, si

les hypothèses sont justes, le Système International

d'aujourd'hui. Si l'on peut reconstruire un tel système en

étudiant Internet, c'est que ce dernier est intégré dans

un système plus général et donc, qu'il constitue bien une

nouvelle dimension du Système International.

Evoquant les hypothèses, il paraît judicieux de

les développer rapidement. Ayant amplement développé la

méthode et les caractéristiques de la problématique,

énoncer ces hypothèses est dorénavant aisé.

La première et la plus évidente est qu'Internet

constitue un système bien particulier qui va au-delà d'un simple

outil. Il a été fait référence dans l'Introduction

à une comparaison avec le nucléaire ou le pétrole en

raison des « débordements » ayant lieu au-delà de la

simple nature d'outils. La première hypothèse est donc celle-ci :

Internet est un objet social en plus d'un outil dont les conséquences

issues de l'utilisation de masse et du développement vont bien

au-delà de sa nature simple d'outil de communication.

La seconde concerne l'existence d'un système Internet

que l'on peut décrire stratégiquement. La vision «

cachée » derrière cette hypothèse est plutôt

« réaliste » au sens des théories des Relations

Internationales et peut être dédoublée en deux

sous-hypothèses : l'existence de relations de pouvoirs d'une part et

d'acteurs d'autre part tels que définis dans la méthodologie de

l'analyse Stratégique.

La dernière hypothèse repose sur la

définition des acteurs et des dynamiques ou des relations mises à

jour. Cette étude prétend montrer que les identités des

acteurs en présence sont les mêmes que celles des acteurs du

Système International et que les relations de pouvoir y sont de

même nature. C'est-à-dire qu'elles prétendent

défendre ou obtenir les mêmes choses et ce pour les même

raisons : du contrôle, de la sécurité, une capacité

de réponse voire de contrainte plus forte en raison de la

souveraineté.

La démonstration de ces hypothèses entend

montrer par corollaire qu'Internet est devenu un enjeu du Système

International, qu'il est intégré dans le Système

International et doit donc être considéré comme tel pour

les politiques futures.

Justification du Plan :

Le fonctionnement d'Internet est relativement complexe et ce,

pour plusieurs raisons. Toutes ces raisons n'ont pas forcément pour

corollaire immédiat de créer des enjeux mais il est

nécessaire de maîtriser les concepts et les termes pour comprendre

les analyses qui suivront. Il s'agit aussi de décrire « l'univers

nouveau » évoqué dans la problématique.

Cependant, certains aspects du fonctionnement sont

effectivement en tant que tels des enjeux et, afin d'éviter des

descriptions plus tardives, la description sera faite de telle manière

que ces problématiques apparaîtront clairement.

Internet est une structure multidimensionnelle par nature. En

premier parce que le fonctionnement n'est pas abordable de façon

linéaire, la plupart des actions de base de l'internaute débutant

déclenchant des réactions en chaîne à plusieurs

« étages » nécessaires à la réalisation

de l'opération envisagée. Cela veut donc dire que le

fonctionnement technique du réseau est difficile à expliquer et

nécessite déjà un travail important.

Ensuite, il y a l'aspect administratif et politique

correspondant à la gestion d'Internet, à sa gouvernance. Les

interactions entre l'ICANN8, le gouvernement américain, celui

des autres états, les entreprises se font dans un cadre précis

qu'il convient de décrire. Ces relations en tant que telles seront

abordées dans la seconde partie.

Pour respecter ce premier double aspect, la division la plus

pertinente paraissait être la suivante : « l'Architecture du

réseau » où seront expliqués le fonctionnement

technique et l'aspect « Administration » où sera

développée et définie la gouvernance d'Internet.

8 Voir la Première Partie pour un exposé sur

l'ICANN.

Tout cela constitue donc une première partie qui

sera nommée : « Histoire et fonctionnement d'Internet d'un point de

vue stratégique ». On décrira donc les

éléments cités plus haut en insistant sur l'aspect

stratégique qui leur sont liés.

Une fois les concepts et l'histoire maîtrisés,

l'analyse en tant que telle peut débuter. La problématique du

mémoire consistait à relever les principaux enjeux

stratégiques de l'objet et à montrer que malgré les

aspects nouveaux (dus principalement à l'aspect technique, ce qui donne

tout son sens à la première partie), les acteurs et les

dynamiques fondamentales de la prise de pouvoir ne changeaient pas par rapport

à ce que l'on pouvait trouver dans le système international

contemporain. Au final, les lectures, les interviews et la veille

stratégique faite sur Internet m'ont conduit à recenser diverses

problématiques et différentes façons de les expliquer ou

de les concevoir. C'est ce qui va être développé dans la

seconde partie.

Aussi, adopter un outil utilisé dans les

théories de relations internationales semble pertinent et c'est pourquoi

la seconde partie se fonde sur les niveaux d'analyses. En effet, le propre de

ce type d'outil est de considérer la multicausalité des

phénomènes sociaux comme évidente et de proposer des

explications les plus larges possibles. C'est ce qu'affirme Barry BUZAN dans

son article : « The level of analysis problem is about how to identify and

treat different types of location in which sources of explanation for observed

phenomena can be found».9 Autrement dit : « Le

problème des niveaux d'analyses est de savoir comment identifier et

traiter différentes sources auprès desquelles on peut trouver des

explications aux phénomènes observés ».

Pour cette raison, le choix de cet outil apparait des plus

pertinents lorsque l'on considère qu'Internet est un

phénomène mondial qui conserve pourtant des

caractéristiques bien particulières aux niveaux des états

ou des individus.

Le choix du nombre des niveaux d'analyse et de leur

signification relève d'une seconde réflexion. Une fois, le choix

de cet outil méthodologiquement justifié, il faut savoir comment

s'en servir. Plusieurs théoriciens des relations internationales ont

travaillé sur le nombre de niveaux d'analyse, leurs significations et

leurs distinctions.

K. WALTZ retenait trois niveaux : systémique,

étatique et individuel. J.ROSENAU, quant à lui retient 5 niveaux

(systémique, sociétal, gouvernemental, rôle de l'individu,

particularités de

9 BUZAN B., (2001), The level of Analysis Problem Reconsidered,

Theories in International Relations : University of Pennsylvania Press

10 Ibid.

l'individu) et PAPP en adopte 6 en rajoutant un niveau, les

sous-systèmes.10L'approche défendue par WALTZ

paraît ici la plus à même de permettre de traiter l'objet

dans l'optique choisie. Cependant, c'est en quelque sorte la qualité des

développements qui permettront de justifier définitivement ce

choix.

Cette approche veut respecter les particularités

d'Internet, à savoir l'importance de l'individu par rapport au groupe

auquel il peut appartenir (terroriste, criminel...) et le fait que l'anarchie

au sens littéral du terme (absence de pouvoir central)

caractérise particulièrement bien ce système.

Tout cela constitue donc une seconde partie qui sera

nommée : « Analyse des enjeux ». Les subdivisions seront au

nombre de 3 : une première pour le Système, une seconde pour

l'Etat et une dernière pour l'Individu.

Concernant la dernière partie, son but est

double : montrer une approche critique du travail réalisé

auparavant et pouvoir apporter des éléments

récoltés notamment au niveau des entretiens ou des lectures de

tous les « bords » politiques ou encore idéologiques.

Par ailleurs, considérant que le lecteur est maintenant

averti des différentes problématiques, dynamiques et tendances se

développant sur ou autour du réseau, il est possible de montrer

un affrontement de nature plus philosophique derrière ses

développements stratégiques.

Enfin, comme dit précédemment, la question de la

validité, de la généralisation des observations et

peut-être même des prénotions imposées, doit

être posée. C'est l'objet de cette partie.

Par ailleurs, ce développement aura pour objectif de

reprendre les différents outils utilisés et de montrer que par

nature, ils induisent des biais de compréhension et de

représentation de la réalité. Il faut noter aussi que

l'utilisation de ces outils conduit à définir certaines variables

et ces définitions peuvent conduire à des erreurs de

compréhension.

Ce seront donc ces deux aspects qui seront

développés ici. La démonstration de l'utilisation des

outils et le choix des variables seront, eux, développés dans la

suite de cette partie.

Un second développement à l'intérieur de

cette partie aura pour objet de développer les philosophies ou les

grandes idées sous-tendant les actions et les prises de positions des

différents acteurs d'Internet.

En effet, et c'est la première critique, le

rédacteur n'a pas été totalement exempt de partispris et

ses opinions ont sans doute influencé les développements

précédents. Il sera donc intéressant d'essayer de donner

un écho à certaines opinions ou prises de positions afin de

permettre une plus grande objectivité des éléments

déjà exposés. Il s'agit de faire « parler les acteurs

». Par ailleurs, il faut bien voir que l'étude a deux biais

relativement importants que l'on ne peut ignorer :

- Un temps d'étude trop court : cela a pour

conséquence une sorte d'étude à partir d'une «

photographie » d'Internet. A la fois parce que l'objet est très

jeune et parce qu'il évolue à une vitesse impressionnante, un tel

mémoire ne peut bien rendre des enjeux, des stratégies et des

développements. Certains évènements ont eu lieu pendant

l'étude et les étudier est particulièrement difficile

à ce niveau de temps et d'expérience de recherche.

- L'objet est réellement vaste et l'appréhender

à la fois, dans sa généralité et dans ses

particularismes est de l'ordre de l'impossible en si peu de temps et de place.

Cela dit, cela permet d'avoir des axes de recherche et de poser des questions

pour des recherches ultérieures.

Outils méthodologiques de recherche :

Après avoir défini la problématique et

justifié le plan, il convient de justifier les méthodes

utilisées pour l'étude et la résolution de ce

problème. Pour cela, il semble pertinent de faire à nouveau un

rapide retour méthodologique sur l'analyse stratégique et surtout

ses implications en termes de modèle de logique.

Selon M. CROZIER, la posture intellectuelle naturelle

liée à une telle analyse est une posture d'induction. Il s'agit

effectivement de reconstruire un modèle représentant la logique

et les propriétés d'un « ordre local »11.

11 CROZIER M., &PAVE F. (1994), Analyse stratégique -

Colloque de Cerisy: Ed. Du Seuil, p. 133 -153

Cela implique plusieurs éléments fondamentaux.

Le premier est qu'une posture d'induction entraîne la construction d'un

modèle mimétique fondé sur des observations empiriques. Il

s'agit ici uniquement des idées tirées d'une reprise du

cours12.

Le second élément est propre à l'analyse

stratégique. En effet, selon les auteurs, reconstruire sous forme de

modèle un ordre local a une première implication : la

nécessité d'avoir une description et une analyse des faits

poussées. La seconde implication est l'utilisation de la comparaison

afin de mettre en exergue les faits significatifs et d'avoir à

disposition des résultats d'études faites à

proximité du sujet.

Au final, la méthode utilisée est donc une

méthode inductivo-comparative. Le lien avec mon sujet est fait sans

effort car il postule l'existence d'un « Système Internet » et

l'induction va permettre de construire ce système ou alors d'infirmer

cette hypothèse. Quant à la comparaison, elle est satisfaite par

le rapport au système international tel que présenté dans

nos cours et en empruntant des éléments au paradigme

réaliste (les relations liées au pouvoir) et au transnationalisme

(un certain dépérissement de l'Etat et des relations

dépassant les frontières étatiques habituelles).

Ce retour méthodologique permet donc d'avoir des

précisions quant aux méthodes les plus adaptées pour

fournir des réponses.

La méthode utilisée est bipartite : elle a un

aspect comparatif et un aspect inductif. L'aspect comparatif et les sujets de

comparaison amènent logiquement à considérer l'analyse

documentaire comme un moyen privilégié d'acquérir les

outils, notions et connaissances nécessaires à cette étape

de l'analyse.

L'aspect inductif a plusieurs conséquences : la

première est qu'étant donné que les hypothèses sont

empiriques, formulées à partir de constatations faites en

recherche préliminaire sur Internet, il faut se confronter au

réel pour pouvoir les tester. De plus, les indicateurs permettant de

s'orienter dans l'analyse et de confirmer ces hypothèses sont

données par le réel : ce n'est qu'une conséquence de ce

qui a été dit plus haut. Il faut donc un « aller-retour

» entre le réel et le conceptuel pour pouvoir dégager des

hypothèses, construire un modèle testé par les

réponses aux hypothèses et enfin obtenir par le biais des

indicateurs, les résultats des tests des hypothèses et donc la

validité du modèle.

Dans ce cadre là, c'est l'entretien semi-directif qui

paraît être la meilleure façon de se confronter au

réel. En effet, l'analyse stratégique met en avant les acteurs et

l'entretien

12 Cours de Travaux Dirigés de Mr LEFEVRE.

permet de rencontrer ces acteurs. De plus, cela permet de

recueillir un matériau de recherche précis et de qualité,

permettant ainsi de construire le système.

Par ailleurs, il paraît intéressant de noter que

si l'entretien semi-directif est performant, il a besoin d'une grille

précise, préalablement préparée, pour obtenir les

informations souhaitées13. Or, la recherche documentaire

effectuée dans le cadre de la comparaison permet de réduire le

champ des investigations, de constituer les indicateurs de comparaison et donc

de construire une partie de la grille de questions.

Ayant ainsi justifié les méthodes au regard du

cadre d'analyse, il convient maintenant de les confronter au terrain. Il faut

donc dans un premier temps, faire un point rapide sur la nature et les

caractéristiques du terrain.

Le terrain choisi est donc Internet. Cependant, la

problématique postule une analyse stratégique d'Internet,

à la fois phénomène et objet. Cela a pour

conséquence d'avoir des acteurs ayant entre eux des relations

liées au pouvoir. Cela modifie donc le terrain qui devient donc à

la fois Internet mais aussi tous les acteurs ayant des comportements

stratégiques sur Internet. Par ailleurs, le type d'analyse choisi

amène à la constitution d'un système et l'aspect

comparatif de cette méthode est lié au système

international. En résumé, il s'agit donc d'étudier

Internet en se demandant en quoi il s'intègre dans le Système

International et donc d'étudier les acteurs ayant des menées

stratégiques dans le Système International et à fortiori,

Internet. On a donc la définition du terrain et il ne reste plus

qu'à montrer que les méthodes choisies sont parfaitement

adaptées à un tel terrain.

Premièrement, la comparaison avec le système

international nécessite une bonne documentation sur ce sujet. Cela

nécessite de bien connaître les différentes actions se

menant sur le réseau ou autour, de même que les tendances, les

dynamiques. Tout cela conduit à se documenter sur les analyses

réalisées par des spécialistes des Relations

Internationales ou d'Internet ou bien des spécialistes dans les deux

matières. L'analyse documentaire paraît donc être la

méthode la plus indiquée.

Deuxièmement, la confrontation avec le réel est,

on l'a vue, nécessaire pour pouvoir tester les hypothèses. Or, le

« réel » de ce terrain est constitué principalement

d'acteurs qui sont prépondérants dans cette analyse. La

confrontation au réel passe donc par la confrontation avec ces acteurs.

On a ainsi la seconde méthode : l'entretien semi-directif qui permet de

tester les hypothèses et de faire produire de l'information à

l'acteur d'Internet.

13 Voir la Grille en question en annexe

Les méthodes ainsi justifiées par rapport au

cadre d'analyse et au terrain, il faut maintenant préciser les

conditions d'utilisation de ces méthodes.

La nature du terrain est bien particulière et le cadre

d'analyse choisi également : il s'agit d'une analyse stratégique

d'Internet avec une orientation certaine dans le domaine des relations

internationales.

De cela, on tire plusieurs conséquences : la

première est qu'il ne s'agit pas d'analyse du type de celles que peut

proposer la sociologie électorale par exemple. On est dans le cadre

d'une analyse stratégique : on observe les acteurs, de quelque nature

qu'ils puissent être, et leurs relations de pouvoir. Donc, étant

donné la diversité des acteurs (états, individus, firmes

multinationales...), il est très difficile de recourir à certains

outils que sont par exemple les questionnaires ou même les focus groups.

Cela est corroboré par la nature des relations étudiées :

les relations de pouvoirs sont par nature discrètes et les acteurs, peu

enclins à les divulguer où à les expliciter. Donc,

certains outils sont à proscrire de par leur caractère

inadéquat.

La seconde conséquence est la complexité du

terrain. En effet, Internet reste quand même à la fois un espace

vaste mais aussi un monde extrêmement complexe et notamment, en termes de

relations internationales ou d'acteurs ayant pour objectif un relatif

contrôle de cet objet. Aussi, en raison des contraintes de temps de cette

étude, de l'évolution très rapide de l'objet et des

contraintes liées à la nature des acteurs, il était

nécessaire à la fois de trouver des sources fiables et

préalablement renseignées, d'essayer d'avoir une vision de

l'intérieur de certains des acteurs et enfin de maintenir une connexion

avec l'évolution de l'objet très rapide. Il aurait

été dommage de rendre une étude dont certaines

informations étaient périmées alors qu'il aurait

été possible de les mettre à jour.

Tout cela a pour conséquence de valoriser certains

outils et ce sont ceux qui ont été utilisés : l'analyse

bibliographique, l'entretien semi-directif et le processus de veille

stratégique qui constitue une analyse bibliographique bien

particulière. Un retour rapide sur ces outils s'impose maintenant.

Concernant l'analyse bibliographique, le corpus choisi a

été surtout celui des périodiques de langue

française et anglo-saxonne. Plusieurs raisons à cela : la

première est que si le nombre d'ouvrages consacrés à

Internet commence à devenir important, la plupart s'intéresse

à la sociologie d'Internet dans le monde du travail ou encore de

l'éducation pour ne citer que ceux-là. En effet, peu d'entre eux

s'intéressent à la configuration des pouvoirs dans ou autour

d'Internet et étant donné à la fois, la relative jeunesse

de l'objet et l'intensité actuelle

de la question stratégique, les périodiques

paraissaient tout indiqués. Le choix des périodiques

résulte d'une « stratégie » simple tenant

essentiellement à des questions pratiques : le corpus a

été limité aux revues de la Bibliothèque

Universitaire de l'Université Toulouse 1 traitant des questions de

relations internationales, de stratégique, de sécurité et

de défense. Ainsi construit, ce corpus paraissait à même

d'apporter une conscience relativement large du sujet et en même temps,

de respecter une certaine diversité de points de vue (Europe,

Etats-Unis), de façon de travailler (France, Etats-Unis) ou encore

d'aspects du sujets (défense, sécurité...).Concernant les

choix bibliographiques, tout paraît avoir été

explicité mais les défauts de la méthode et les

défauts dans l'utilisation de la méthode seront explicités

en partie 3.

Les entretiens semi-directifs ont été

réalisés à partir d'une grille d'entretien basée

sur les hypothèses de travail. Idéalement, il aurait

été souhaitable de rencontrer des représentants de tous

les types d'acteurs sur Internet : l'ICANN, les états, les hackers, les

firmes multinationales, l'ONU... Au final, trois entretiens ont

été réalisés en direct et un dernier par e-mail. Le

premier a été fait avec un membre de l'ICANN, Mme INNE, ayant un

travail politique de liaison avec une région bien particulière du

monde, l'Afrique. Le second a été réalisé avec une

personne ayant réalisé un mémoire de DEA sur l'incitation

au terrorisme et ayant travaillé pour l'ONUDC, notamment en relation

avec l'informatique, Internet et le terrorisme, Mr BREHAM. Le dernier a

été réalisé avec un spécialiste de

l'informatique, Mr POUZIN ayant participé à la création de

réseaux dans les années 70, réseaux à structure

proche de celle d'Internet. Dernièrement, il a participé aux

travaux préparatoires du SMSI14 et au sommet lui-même.

Il milite actuellement au sein d'une association pour la promotion des langues

dites naturelles au sein d'Internet. Enfin, l'entretien par e-mail s'est

déroulé avec un officier de la Marine spécialisé

dans la communication, Mr BALLANCHO.

La grille d'entretien a été

réalisée notamment en se basant sur les cours et sur des ouvrages

méthodologiques15. Elle a donc été construite

de façon à permettre à la fois d'obtenir des informations

sur l'acteur interrogé et sur ces relations de pouvoir tout en jouant

avec les contraintes du « non-dit » de ces relations de pouvoir. Au

final, elle s'est articulée autour de deux grands thèmes : les

tendances, les dynamiques sur Internet en premier et les acteurs participant

à ces dynamiques en second. Une subdivision était apportée

afin d'éviter les biais : il était demandé une vision

professionnelle et une vision plus personnelle de la

14 Sommet Mondial de la Société de l'Information

qui s'est tenu pour la première fois à Genève en 2003.

15 Cités dans la bibliographie.

situation. Enfin, des éléments plus libres de

considération générale étaient également

demandés à la fois pour des questions d'intérêt

général et aussi, afin d'avoir un meilleur aperçu de la

personne interrogée.

Le dernier outil, la veille stratégique, a

été réalisé sur 6 sites web d'informations

générales ou spécialisées16. Le choix de

ces sites témoigne de deux considérations. La première est

que ces sites ont été désignés par des

spécialistes en informatique et Internet comme les meilleurs,

informations recoupées par le simple fait que toutes les données

relevées ailleurs ont toujours été retrouvées par

la suite sur ces mêmes sites. Par ailleurs, des sites d'informations

générales comme Google News dont le fonctionnement simple

consiste à afficher les informations statistiquement les plus

répandues dans le cadre de sujets généraux, ont toujours

donné ces sites comme sources. Ces 6 sites ont donc été

consultés très régulièrement (entre 3 et 5 fois par

semaines) et ont été relevées toutes les informations

relatives à l'aspect stratégique des évolutions

d'Internet. Ce relevé présente donc chaque information,

datée, résumée et la ou les sources. Il a permis beaucoup

de découvertes et une meilleure compréhension de certains

évènements.

Voilà donc, développés les outils

méthodologiques de recherche utilisés. Bien évidemment,

chacun présente des failles en tant que tel ou dans leurs utilisations

mais comme il a déjà été dit, la dernière

partie traitera de ces différents biais ou problèmes.

16 Les sites sont dans la partie Bibliographie. La veille est

disponible à cette adresse :

http://arnaudgarrigues.blog.com

Plan

Introduction p. 4

Prolégomènes p. 6

Partie 1 : Histoire et fonctionnement d'Internet d'un point de

vue stratégique p. 21

I- Histoire p.21

A- 1969-1998 : le temps des professionnels p. 21

B- 1998 à nos jours : l'apparition du reste du monde p.

24

II- Fonctionnement p. 26

A- Architecture du système p.26

a) Infrastructures p. 27

b) Protocoles Techniques Basiques p. 29

B- Administration, Gouvernance et Politique p. 34

a) Une structure contestée : l'ICANN p. 35

b) SMSI et FGI p. 37

Partie 2 : Analyse des enjeux p. 39

I- Le système Internet et le système International

p. 40

A- Internet : Une égale répartition de la

Ressource ? p.40

B- Eléments de Gouvernance et de Contrôle p. 42

a) Economie Mondialisée p. 42

b) Démocratie et Cultures p. 45

C- Internet : un Système Stable ? p.46

II- Les Etats : Du Nord au Sud, une préoccupation

désormais commune p. 48

A- Les Etats et Internet : La souveraineté p. 48

B- Les Etats et Internet : Sécurité et

Contrôle p. 52

III- Les Individus et Internet : activisme,

cybercriminalité, terrorisme p. 57

A- Activisme et Internet p. 57

B- Cybercriminalité p. 59

C- Terrorisme p. 61

Partie 3 : Vision critique méthodique et quelques

éléments d'évolutions envisageables p. 64

I- Des outils de recherche biaisés par nature et par

utilisation p. 64

A- Biais Norm atifs p. 64

B- Biais Méthodologiques p. 66

II- Que faut-il attendre des évolutions d'Internet ? p.

68

Conclusion p. 71

Bibliographie p. 74

Annexes p. 78

Première Partie : Histoire et fonctionnement

d'Internet d'un point de vue

stratégique

Après cette longue mais nécessaire introduction

relative à la méthodologie de tout ordre, il paraît

nécessaire de s'intéresser au coeur du sujet. Comme il a

été dit précédemment, un rappel de l'histoire et du

fonctionnement d'Internet doit être fait. On se consacrera en premier

lieu à l'histoire de l'objet toujours en mettant en avant l'aspect

stratégique.

I- Histoire

Ainsi qu'on va pouvoir le constater, l'évolution

d'Internet s'est faite en deux temps. Cette distinction n'est pas arbitraire.

En effet, avant 98, Internet a été le fruit d'une conception

universitaire administré par les tenants de la « Woodstock-era

». Cette expression imagée provient de Kenneth Neil Cukier dans un

article paru dans la revue spécialisée Foreign

Affairs17 et entend démontrer, en référence au

mouvement hippie qui suivit la tenue de cet évènement, à

quel point la gestion et le développement d'Internet par les

universitaires avait quelque chose de fondamentalement idéaliste.

Cependant, en 98, naît l'ICANN et c'est à ce moment là

qu'Internet devient à la fois un objet de « business » mais

aussi commence à connaître son développement sans

précédent. Voilà donc pour la distinction.

A- De 1969 à 1998 : le temps des professionnels

C'est en 1969 qu'Internet naît dans les laboratoires des

universités américaines. Le projet a été

commandité par l'armée des Etats-Unis qui, en ces temps de Guerre

Froide et d'incertitude stratégique, a voulu développer et

construire un réseau susceptible de remplacer les réseaux

habituels au cas où ceux-ci seraient détruits lors d'une attaque

nucléaire ou stratégique contre les réseaux de

télécommunications. Ce sera l'Agence pour les Projets

Technologiques Evolués (Advanced Research Projects Agency - ARPA)

17 CUKIER, K.N., (1995), Who Will Control the Internet, Foreign

Affairs, 84, 6, Nov.-Dec 1995., p. 10

appartenant au Département de la Défense

américain qui fournira les fonds et s'occupera du projet.

De 1969 à 1982 seront développés les

grands protocoles qui permettent à Internet de fonctionner aujourd'hui

(TCP/IP, FTP, Telnet...). En effet, comme on le montrera dans le II de cette

partie, ce sont toujours ces protocoles fondés dans les années

70-80 qui permettent à Internet de fonctionner. Différentes

universités vont être intégrées au projet et vont

héberger des « noeuds », c'est-à-dire des serveurs

« ressources » d'Internet : le Massachusetts Institute of Technology

(le célèbre MIT de Boston), University of California Los Angeles

(UCLA), University of South California (USC). Le Département de la

Défense américain abrite aussi un de ces noeuds. Par ailleurs, il

est à noter qu'à ce moment là, Internet existe sous le nom

d'Arpanet en raison du nom de l'agence américaine qui en a fait la

commande. En 1974, Vint CERF et Bob KAHN finissent l'écriture des

protocoles TCP et IP en leur donnant leurs spécifications techniques.

Jusqu'en 1980, le développement du réseau n'est

pas encore finalisé et s'il commence à se diffuser aux USA, il

reste très largement cantonné aux universités et au monde

universitaire qui voit en lui un moyen formidable de partage des connaissances.

On voit déjà se dessiner une certaine opposition dans la

façon de concevoir le Net. En 1982, les protocoles TCP et IP sont

implantés et on peut donc dater la naissance d'Internet à ce

jour. En 1983, 562 noeuds sont interconnectés et forment le

réseau Arpanet. C'est à cette époque que la division se

fait entre Internet qui est alors créé en tant que tel et Milnet,

la version militaire du réseau. Internet continuera sa croissance

jusqu'à atteindre le million d'ordinateurs connectés environ 10

ans plus tard, en 1992.

Une personne est à citer aussi, il s'agit de Jon

POSTEL. Universitaire et informaticien parmi la poignée de main

d'ingénieurs qui ont participé à la construction

d'Internet c'est lui qui va gérer Internet jusqu'en 98. Ce sera lui qui

écrira notamment les « Request For Comments » ou RFC : cet

ensemble de textes constitue en quelque sorte la « Bible »

d'Internet18, le socle de son fonctionnement à la fois

technique mais aussi administratif. Les sujets traités sont assez larges

et il a même prévu la gestion des noms de domaines dans ces

textes.

Dans les années 80-90, le problème commence

à venir du nombre d'ordinateur interconnectés et de la

capacité de tel ordinateur à rejoindre tel autre. En effet, le

problème des doublons d'adresses et la difficulté à

trouver sa route vont obliger Jon POSTEL à mettre

18 L'expression provient de la retranscription de l'interview

effectuée avec Mme INNE, membre de l'ICANN.

en place le service DNS19 (Domain Name System).

Cela se traduira notamment par la création des noms de domaines qui

proviennent en fait d'une liste de codes conservée à l'ISO, la

liste des codes-pays 3166/1. C'est à ce moment que furent

créés les Country Code Top Level Domains (CCTLD)20,

c'est à dire tous les domaines réservés au pays.

Cependant, la gestion de ces noms de domaines sur lesquels les pays

détiennent en général la souveraineté a

été faite par POSTEL jusqu'en 98 et de manière

plutôt aléatoire.

Les CCTLD ont été créés en

même temps que les GTLD (Generic Top Level Domains) qui correspondent eux

aux .com, .biz... Or, ces domaines plus généraux ne correspondent

à aucun droit de souveraineté et des entreprises ont

immédiatement vu le potentiel de tels outils.

En 1992, fut créé l'ISOC (Internet Society),

sorte d'association, ayant pour objectif de promouvoir Internet de par le monde

et plus généralement l'interconnexion des systèmes de

communication. Son siège est à Reston en Virginie et elle

entretient des contacts étroits avec l'ICANN et les organisations

affiliées. Toute personne peut devenir membre de l'ISOC.

C'est ainsi que Network Solutions (aujourd'hui Verisign) s'est

« porté volontaire » en 1996 pour gérer, non

gratuitement, bien évidemment, le .com. Le département du

Commerce américain qui s'était vu transmettre la gestion de la

ressource par le Département de la Défense qui avait obtenu le

réseau militaire souhaité et dont l'objet n'était

sûrement pas une gestion commerciale d'Internet, a donc passé un

contrat avec cette entreprise. Or, dans le même temps, J. Postel

continuait sa gestion plus aléatoire et « universitaire » des

CCTLD, dans une vision totalement différente d'Internet.

La multiplication des demandes de contrats et les pressions

persistantes pour une gestion commerciale de la ressource a conduit le

Département du Commerce à envisager une autre possibilité

de gestion d'Internet. C'est ainsi que sous l'administration Clinton, une sorte

de plénipotentiaire fut désigné afin d'engager des

pourparlers avec toutes les parties en présence afin de

déterminer la meilleur solution de gestion dans l'avenir. Ira MAGAZINER

fut donc chargé de ces consultations.

Après plusieurs consultations et de très

intenses négociations (si intenses que J. POSTEL mourut à ce

moment-là d'une crise cardiaque), c'est en 98 que l'ICANN fut

créé. L'Internet Corporation for Assigned Names and Numbers est

un nom trouvé par J. POSTEL lui-même et

19 Se reporter au II pour l'explication

20 Ex. : .fr pour la France, .de pour l'Allemagne etc. ...

il devait en devenir le premier employé avant son

décès. Esther DYSON, première présidente du Conseil

d'Administration nomma le premier PDG, Mike ROBERTS et réussit à

donner à l'ICANN sa structure de fonctionnement et sa capacité de

travail actuelle. Cette société de droit privé californien

basée aux environs de Los Angeles a donc la possibilité de signer

les contrats avec les entreprises souhaitant acquérir des noms de

domaines et les administrer.

B- De 1998 à nos jours : l'apparition du reste du

monde

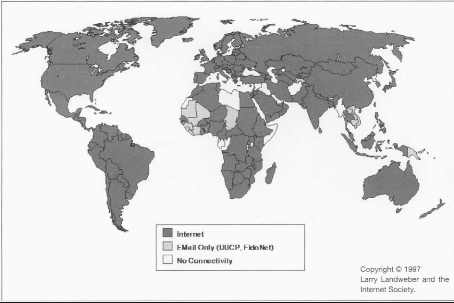

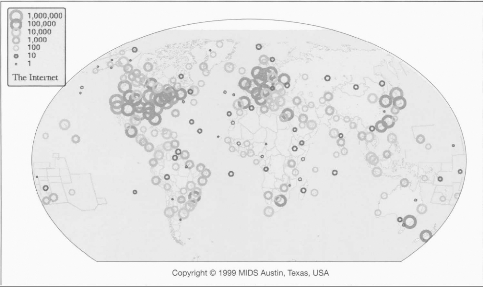

A partir des années 2000, on peut sans conteste

affirmer que la croissance d'Internet fut fulgurante. Du million d'ordinateurs

connectés en 92, le milliard d'ordinateurs connectés a

été franchi courant 2005.

Hormis les USA qui ont présidé à la

création d'Internet, les Etats se sont « éveillés

» petit à petit à Internet. L'utilisation de plus en plus

importante du réseau par les entreprises, le phénomène des

start-up et la bulle Internet et son éclatement ont contribué

à la diffusion du réseau à grande échelle.

Les grandes capacités d'échange de savoir, les

contenus dérivés comme la télévision, le

téléphone ont contribué à l'essor d'Internet et

à son nombre grandissant d'utilisateur.

Dans un autre ordre d'idée, la constatation des

dégâts causés par les hackers, leurs

démesurées capacités de nuisance, la

cybercriminalité, le terrorisme ont obligé les états

à se saisir du problème.

Si certains états ont légitimement des questions

concernant la sécurité et la souveraineté, d'autres, plus

autoritaires, y voient la fin de leurs régimes et mettent en place des

répressions intenses contre les internautes se positionnant contre le

régime en place. C'est notamment le cas de la Chine ou de la Tunisie. Il

existe une liste « noire » de pays opposés à

Internet.

Tout cela induit une difficulté de

compréhension, des problèmes nouveaux et la

nécessité de réponse à toutes des questions a

conduit l'ONU, par ailleurs relativement absente de cette problématique,

à organiser le premier sommet mondial de la société de

l'information à Genève en 2003. Cela a permis une première

prise en compte du problème et la rencontre des différents

acteurs entre eux. La France a envoyé un ambassadeur à ce sommet

montrant ainsi que les implications pouvaient devenir cruciales.

En 2004, Kofi Annan a créé eu sein de l'ONU, un

groupe de 40 personnes chargées de rendre un rapport sur la question de

la gouvernance d'Internet. Ce rapport réclamait notamment le transfert

de la gestion d'Internet à l'ONU. Cependant, conscient de la

montée des revendications nationales de plus en plus fortes, Washington

qui auparavant, pensait garantir une autonomie totale à l'ICANN pour

2006, a refusé d'y souscrire. La preuve en est que des accords ont

été repassés entre la société et le

Département du Commerce américain en 2006.

La seconde phase du SMIS s'est tenue à Tunis en 2005.

La tension internationale du moment sans doute exacerbée par d'autres

évènements et la position des Etats-Unis à propos

d'Internet ont conduit ce sommet à un relatif fiasco. Relatif car la

participation a été surprenante, notamment de la part de la

société civile : 18 000 personnes se sont rendus làbas.

Relatif échec encore à cause de la création de Forum pour

la Gouvernance d'Internet, qui bien que n'ayant aucun pouvoir de

décision, constitue un lieu de débat ouvert à tous.

La première session de ce Forum s'est tenue à

Athènes en novembre 2006. 1200 participants se sont rendus là bas

ainsi que des représentants de l'ONU. La nature du Forum étant

telle, aucune décision n'a été prise. Mais le nombre de

proposition pour accueillir le Forum témoigne de l'importance de la

question et de la volonté des pays de prendre en charge la question.

C'est à l'occasion de telles réunions qu'a été

dévoilée la conception d'Internet par l'ONU : selon

l'organisation, il s'agit d'une « ressource publique mondiale ».

Cependant, à côté de ces élans

démocratiques pour la gouvernance d'Internet, il ne faut pas oublier de

tenir compte des tendances à la balkanisation que peut connaître

actuellement Internet. Le développement de protocoles incompatibles avec

le reste du réseau, la création de service DNS «

personnalisés » par la Chine ou l'Arabie Saoudite sont une tendance

plutôt homicide par rapport au réseau.

L'évolution depuis la création d'Internet, du

besoin militaire allié à la vocation universitaire à la

récupération par les entreprises à des fins

économiques pour terminer par la peur des états, montre combien

cette question peut-être importante. Il ne faut pas oublier que cette

évolution est d'une rapidité saisissante. En effet, à

peine environ 40 ans séparent Aujourd'hui des premiers pas du projet. Et

la plupart des grands changements ne datent que de 10 ans à peine. C'est

donc un phénomène d'une importance considérable en

relations internationales car ainsi que l'on peut le voir, absolument tous les

acteurs ont été cités au

cours de cette histoire et tous ont approché le

réseau avec l'intention de profiter de ce qu'il offre ou avec une

certaine peur, une envie mais aucun ne l'a considéré avec «

dédain ».

Cet aperçu rapide de l'histoire d'Internet comporte un

certain nombre de sigles techniques et de concepts difficiles à

appréhender. Aussi, la partie suivante sera consacrée à

l'explicitation du fonctionnement du système Internet.

II- Fonctionnement d'Internet

Ce développement sera divisé en deux. La

première partie sera essentiellement technique et remplira un

double-rôle : rendre compte du fonctionnement d'Internet d'un point de

vue technique en insistant sur les aspects pouvant créer des enjeux et

donner les explications des sigles et des concepts techniques. En effet, si on

a pu rapidement utiliser ces concepts auparavant, la suite fera montre d'un

usage beaucoup plus intensif. La seconde partie quant à elle, abordera

l'architecture des différents organes de gestion, de contrôle et

de gouvernance d'Internet. A cette occasion, nous nous attarderons quelque peu

sur la notion de gouvernance, non pas en tant que concept nouveau dans la

science politique mais dans son sens pour Internet.

A- Architecture du Système technique

Avant de commencer à traiter de ce sujet, deux notions

importantes doivent être expliquées. La première est celle

de réseau « de bout en bout » ou « end-to-end » ou

bien encore à « intelligence décentralisée ».

Comme on a pu le faire remarquer plus haut, Internet a été

créé en dehors de tout contexte de normalisation21.

Cela a pour conséquence une très forte volonté des

concepteurs d'interconnecter des réseaux qui pouvaient avoir des

conceptions différentes. Aussi, le réseau est-il à la fois

adaptable et surtout indépendant du contenu qu'il transporte. Cela veut

dire que quelque soit le contenu transporté, ce sont les «

terminaux » ou encore les ordinateurs en fin de chaîne de

transmission qui vont créer les données, les coder puis, les

analyser, les retranscrire et enfin, les utiliser.

21 Se référer aux notes de retranscription de

l'entretien avec Louis Pouzin, notamment sur les réseaux Cyclades.

Un Ex. : Lorsque vous « surfez » sur le Web, les

pages que vous affichez dans votre navigateur vous sont envoyées

directement sur votre ordinateur par les serveurs sur lesquelles elles sont

enregistrées. Il n'est nulle part question d'une « fenêtre

» de lecture sur ces mêmes serveurs. De même, l'envoi d'un

film sur Internet n'est significatif pour le receveur que s'il le lit sur son

ordinateur. Dans les deux cas, pour Internet lui-même, il n'y a aucune

différence de nature entre la page et le film.

La seconde notion permettra de clarifier les explications.

Elle a été empruntée à Lawrence Lessig22

dans son article sur Internet paru dans Foreign Policy. Il construit une

représentation en trois niveaux d'Internet particulièrement

efficiente et c'est celle-ci que nous allons utiliser. Le premier niveau, de

base concerne les infrastructures, les serveurs, les « câbles »

de transmission. Le second concerne les protocoles réseau de base (TCP/

IP, DNS) permettant l'acheminement des données. Le dernier quand

à lui est tout simplement celui du contenu (Pages Web, Mp3,

films...).

En combinant les deux notions exposées, le lecteur

pourra se faire une idée bien plus claire de la nature du réseau

et de son fonctionnement.

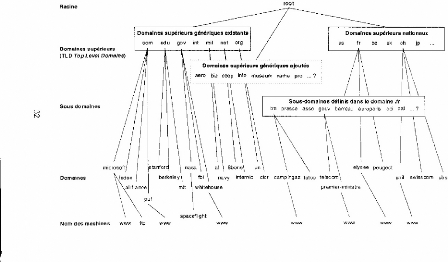

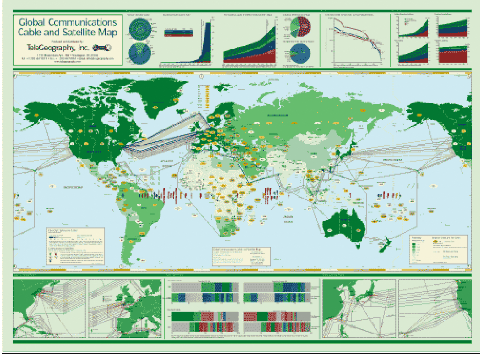

a) Infrastructures

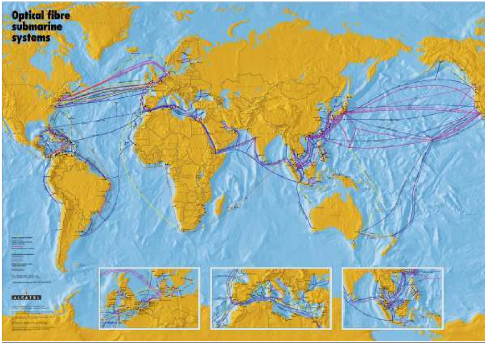

Le coeur d'Internet est constitué de systèmes

intermédiaires ou réseaux de taille inférieure

reliés entre eux par des liens que sont les supports de transmissions

comme les câbles de fibres optiques transocéaniques23,

le tout constituant un maillage.

Par ailleurs, le coeur du service DNS (annuaire) est

géré par 13 serveurs racines (root servers). Ils sont

répartis de la façon suivant et cela constitue déjà

un enjeu : 9 aux USA, 2 en Europe, 1 au Japon et 1 au Kenya. La racine (les 13

serveurs) est complétée par un grand nombre de serveurs DNS de

niveau inférieur.

Cependant, peut-être conscient de l'apparente

fragilité du système encore attaqué il y a peu de temps,

l'ICANN a mis en place un nombre relativement important de serveurs miroirs

(identique) à ces 13 serveurs. Le nombre de ces miroirs est entre 120 et

130.

22 LESSIG, L. (2001), The Internet Under Siege, Foreign Policy,

Nov.-Dec. 2001, p. 56-65

23 Cette définition de base est très largement

empruntée à l'ouvrage Internet, de la célèbre

collection « Que sais-je ? ». Voir bibliographie.

Par ailleurs, il faut être bien conscient que la plupart

du temps, les requêtes (ex. : lorsque vous tapez une adresse ou cliquez

sur un lien hypertexte) ne passent pas par les serveurs racines. Malgré

le peu d'information relatif dont disposent les serveurs de plus bas niveau, le

très grand nombre de ces serveurs et l'existence des « caches

»24 ont pour conséquence une utilisation relativement

rare de ces serveurs racines25.

L'organisation du DNS est faite de façon

hiérarchique en fonction de l'organisation des noms de domaines.

Cependant, cette organisation des serveurs DNS pose problème. En effet,

Paris par exemple, ne possède pas de tel serveur et est donc

obligé d'être connecté en plus à la fois à

celui du Kenya et à Tokyo. Par ailleurs, cela met aussi des pays en

situation de dépendance à Internet car malgré tout, le

service DNS reste indispensable dans le fonctionnement d'Internet.

Après avoir réussi à résoudre

l'adresse, l'ordinateur sait donc « où » il doit aller

chercher les informations. Cependant, il ne connaît pas toujours la route

à emprunter pour y aller. Or, ce « routage » comme est

appelé cette opération technique nécessite d'autres

serveurs et surtout des points de passages entre des réseaux

différents.

Ce routage est effectué très souvent par des

serveurs imposants, importants à des points de contacts qui ont

été décidés par des réseaux

différents. Par exemple, il n'existe que 7 points de contacts entre le

réseau des Etats-Unis et le réseau européen. Cela permet

donc de relativiser car il faut bien imaginer que tout le trafic passe par

là. Il peut certes emprunter des routes différentes et plus ou

moins longues et c'est ce qui fait la richesse d'Internet mais il reste certain

que ces autres routes auront aussi des points de passages obligés. Or,

ces points de passages sont gérés par des serveurs de taille plus

que conséquente, ce qui fait que certaines entreprises seules sont

capables de concevoir de telles machines et bénéficient d'un

marché important et d'une capacité d'action sur les flux

très importants aussi. C'est notamment le cas de CISCO.

Enfin, il est à savoir que ces routeurs entretiennent,

pour fonctionner, des tables de routage indiquant les prochains points de

passage pour les routes, gardant en fait en mémoire toutes

24 La mémoire cache est la mémoire contenue dans

les ordinateurs et qui mémorise à la fois les chemins

empruntés pour aller à telle ou telle adresse mais aussi les

liens entre les IP et les URL, se passant ainsi du service DNS.

25 Il existe 13 serveurs DNS pour la France, de niveau

intermédiaire et dont s'occupe notamment l'AFNIC, l'Association

Française pour le Nommage Internet en Coopération qui gère

en même temps le .fr.

les informations quant à ces routes. Cependant,

à la fois, la capacité de ces serveurs est limitée en

termes de mémoire d'abord et de capacité de gestion du nombre de

requêtes, ce qui crée aussi un enjeu.

Il est à noter qu'il existe aussi un maillage Internet

réalisé par satellite mais l'utilisation de cette technologie

pour certaines zones oubliées par les câbles, reste relativement

limitée. Par ailleurs, l'existence de la fracture numérique

montre bien l'incapacité de certaines zones à se doter d'Internet

et le fait que les grandes « lignes » de support de

télécommunication ont « oublié » ces zones. A ce

sujet, il est intéressant de savoir que la Banque Mondiale vient

d'approuver le déblocage de 123 milliards d'euros pour financer des

infrastructures Internet à haut-débit pour le Kenya, Madagascar

et le Burundi qui en sont dépourvus.

Enfin, il ne faut pas oublier actuellement le

développement des technologies WiMax26, transmission par

ondes radios à des échelles départementales ou

régionales, l'arrivée de la fibre optique chez les particuliers

(Fiber to The Home - FTH), et le financement par la commission

européenne27 d'un dernier support de transmission, le CPL ou

Courant Porteur en Ligne. Tout cela montre l'importance que prennent

actuellement la capacité de connexion et les enjeux que l'on peut

imaginer.

Avec l'exposé de ces dernières techniques prend fin

le développement concernant l'infrastructure d'Internet. Nous allons

maintenant nous intéresser aux protocoles de base.

b) Protocoles techniques basiques

En fait, nous allons surtout expliquer le service DNS. Cependant,

quelques précisions seront faites auparavant.

Tout d'abord, la première question que l'on doit se poser

est : qu'est-ce qu'une adresse IP ?

Une adresse IP est une suite de chiffres

présentés comme suit : 234. 245. 165. 168. Il s'agit donc d'une

suite de quatre groupes de chiffres. Ces chiffres peuvent être au nombre

de 1, de 2 ou de 3. Ex. : 1. 245. 65. 167. Le terme IP signifie Internet

Protocole.

26 Sorte de Wifi à l'échelle régionale.

Certains départements ont fait le choix de cette technologie pour

désenclaver certaines zones.

27 A hauteur de 9 millions dans le cadre du projet OPERA.

La première constatation de ce type d'adresses est que

son nombre est limité. En effet, la première adresse serait donc

0.0.0.0 et la dernière 255.255.255.255. Cela constitue donc ce que l'on

appelle actuellement une ressource rare. En effet, le nombre d'adresses maximum

est de 232 avec cette version de l'IP encore la plus répandue

IPv428. C'est pour cela qu'un nouveau type d'adressage a

été conçu, l'IPv6 qui lui, conçu

différemment est virtuellement inépuisable. En

réalité, il y aurait 2128 d'adresses possibles et on

comprend mieux le « virtuellement ».

En terme pratique, toute machine se connectant à un

réseau dit « TCP/IP », c'est-à-dire un réseau se

servant des protocoles d'Internet doit donner à chaque terminal ou

ordinateur connecté, une telle adresse. Cependant, tous les ordinateurs

ne sont pas connectés à Internet : ils peuvent être

connectés à un réseau qui lui est connecté

grâce à un ordinateur à Internet. Ainsi, X ordinateurs

appartenant à un réseau Y auront chacun une seule et unique IP,

Z, sur Internet, tout en ayant X IP internes sur le réseau «

interne » ce qui relativise tout de même la raréfaction de

ces adresses.

Enfin, lorsqu'on sait que ces adresses font l'objet de

transactions économiques et que chaque fournisseur d'accès

à Internet est obligé d'acheter des IP sous des formes de

transactions économiques parfois originales, on comprend que des enjeux

puissent se constituer. Nous y reviendrons dans la suite de ce

mémoire.

Le protocole TCP - Transmission Control Protocol- est souvent

associé au protocole IP. On désigne généralement

Internet et les réseaux qui utilisent les mêmes protocoles comme

des réseaux « TCP/IP ». Ce protocole est celui qui garantit le

transfert des données entre les différents ordinateurs. Il est

important de préciser une chose dans le cadre de ces transferts.

L'information envoyée d'un ordinateur à un autre sur Internet est

divisée en « paquets », en partie d'information. Ces

informations sont envoyées munies de l'adresse de l'expéditeur et

de l'adresse du récepteur. Cela implique qu'il n'est pas

nécessaire que toutes les informations passent par les mêmes

groupes de réseaux de niveau inférieurs. En d'autres termes,

elles n'empruntent pas forcément le même chemin et passent

à différents endroits et par différents noeuds. Les

concepteurs d'Internet avaient conscience de cela et surtout du fait que le

passage par différent réseau impliquait probablement des

redécoupages de ces paquets ou des agencements différents. C'est

pour cela que les protocoles ont été conçus sur le

principe de l'adaptation et de l'interconnexion. Contrairement aux

réseaux Cyclad,

28 Pour Internet Protocole version 4.

basés sur un pari de normalisation des réseaux,

Internet supporte les différences de réseaux et de normes et

c'est ce qui en fait la richesse. Cependant, une tendance actuelle tend

à contrecarrer cela et engendre un mouvement de balkanisation

d'Internet. Nous y reviendrons plus tard.

Le dernier protocole auquel on s'intéressera concerne

le DNS - Domain Name Service. C'est sans doute le plus intéressant et

certains n'hésitent pas à dire que maîtriser le DNS, c'est

maîtriser Internet.

L'acronyme DNS regroupe plusieurs choses : une

procédure technique permettant de « résoudre » les

adresses, des serveurs avec des fonctions spécifiques et une

organisation hiérarchique des membres d'Internet.

Concernant la procédure technique, il s'agit d'un

annuaire hiérarchisé mettant en rapport les adresses web URL

(Uniform Ressource Locator) du type :

http://ww.univ-tlse1.fr et

les adresses IP correspondantes telles que nous avons vues plus haut.

Comme nous l'avons dit plus haut, chaque « machine »

connectée en permanence et qui héberge des sites web a besoin

d'une adresse IP pour être intégrée sur le réseau.

Cependant, plusieurs choses sont alors possibles : la première, c'est le

simple fait qu'un serveur hébergeant des sites web peut en

héberger plusieurs et qu'il lui est nécessaire de savoir ce que

l'on veut obtenir de ce serveur. La seconde raison est que les routeurs qui

indiquent la route à suivre fonctionnent avec les IP, tout simplement

parce que la gestion des sites ou des domaines est très difficile en

raison, entre autres, de leur capacité de mouvement29. Donc,

satisfaire une requête de la part d'un internaute, c'est-à-dire

tout simplement afficher le site demandé réclame la connaissance

de deux éléments : l'IP et l'adresse en tant que telle du site.

C'est là qu'intervient les serveurs DNS, en fournissant la ou les IP

nécessaires pour arriver au site, l'URL provenant elle de la

mémoire de l'internaute, de son navigateur ou bien des moteurs de

recherche30. Ainsi, l'absence de DNS a pour conséquence

l'incapacité de la machine à utiliser Internet et à se

diriger dans le réseau : il ne s'agit alors pas d'un manque d'indication

sur la route à suivre mais tout simplement qu'elle ne sait pas où

aller.

29 Ex. : le site radioblog a changé de domaine (. Fr

à .com) en moins d'une semaine car il était devenu illégal

en France.

30 Google, Yahoo et les autres

Cependant, le DNS existe en raison de l'organisation

d'Internet en domaines. L'expansion de l'ordinateur et la difficulté de

gestion du routage dans les années 90 ont eu pour conséquence un

phénomène orignal mais gênant : il était devenu plus

facile d'indiquer la route à suivre que l'IP de destination ou encore

l'adresse. C'est pour cela que Jon POSTEL a créé les CCTLD et

qu'ont été créés les GTLD.

Les CCTLD31 et les GTLD32 correspondent

donc à la partie supérieure de l'organisation hiérarchique

des domaines. Le premier désigne les domaines appartenant au pays et les

seconds sont plus généraux et généralement

gérés comme une ressource économique pour les entreprises.

La liste des noms de domaines et leur organisation hiérarchique est

disponible en annexe.

Pour expliciter la nature de ces noms de domaine, nous

prendrons 3 exemples :

1er Ex. :

http://www.univ-tlse1.fr :

Lorsqu'on analyse cette adresse, nous avons tout d'abord une suite de lettre et

de sigles techniques « http:// » qui ne nous intéressent pas

ici. Les trois « w » désignent le World Wide Web,

c'est-à-dire l'espace particulier de contenu dans lequel nous naviguons.

Le reste est plus intéressant : le « univ-tlse1 » est le nom

du sous-domaine dans lequel nous naviguons et qui appartient lui, à un

domaine plus important, celui du CCTLD français, le .fr. Si vous vous

référez à l'annexe 1, vous comprendrez aisément

cette disposition hiérarchique.

2ème Ex. :

http://arnaudgarrigues.free.fr

: Il s'agit ici d'une page personnelle mise à disposition par un

fournisseur d'accès à Internet. Nous avons ici une subdivision

supplémentaire. Nous sommes dans le sous-domaine « arnaudgarrigues

»appartenant au sous domaine « free » qui appartient lui au

CCTLD français.

3ème exemple :

www.google.com : Le site du

moteur de recherche bien connu lui nous montre seulement que quelque soit la

nature du domaine de niveau supérieur envisagée, qu'il soit

général ou bien « national », la rédaction est

la même. Seul le nom de domaine change.

Cependant, il ne faut pas oublier de préciser que le

«

arnaudgarrigues.free.fr

» est un nom de domaine bien particulier et constitue un domaine bien

particulier. De même que le «

google.com » ou le «

univ-tlse1.fr ». Il y a une

responsabilité sur ce domaine et des droits

31 Country Code Top Level Domains: .fr, .de

32 Generic Top Level Domains: .com, .biz

patrimoniaux33 de même qu'il y a

souveraineté sur les CCTLD. C'est pourquoi tout cela créé

des enjeux.

La conséquence première du DNS est son

caractère obligatoire pour le fonctionnement d'Internet. La seconde est

que toute personne voulant créer un site doit en passer par les noms de

domaines. En conséquence de quoi, la gestion du DNS et son

évolution sont devenues un des aspects les plus importants d'Internet et

des plus controversés.

Le dernier aspect de l'architecture d'Internet auquel nous

allons nous intéresser est celui des contenus. On sait donc maintenant

comment sont positionnées les infrastructures dans le système et

nous avons décrit les protocoles basiques et permis ainsi une meilleure

compréhension d'Internet.

Cependant, aucun mot n'a été dit à propos

du Web, de la Toile... Lorsque vous surfez sur Internet à l'aide des

moteurs de recherche ou des sites enregistrés sur votre ordinateur, vous

utilisez des programmes spéciaux appelés Navigateurs. Ces

navigateurs vont aller chercher pour les utilisateurs les informations

nécessaires sur les serveurs où elles sont enregistrées et

les compiler, les traiter afin d'afficher les pages web auxquelles nous sommes

habitués.

Le Web ou plus exactement le World Wide Web a

été inventé par Tim-Berners LEE, un chercheur du

CERN34, dans les années 90. C'est lui qui va inventer les

protocoles clés que sont le HTTP, les URL et le langage de programmation

de base des sites web, le HTML. En 93, aux Etats-Unis, naît le premier

navigateur Mosaic qui sera rapidement remplacé par Netscape. Cette

interface entre l'utilisateur et le système va permettre aux

non-spécialistes d'y accéder plus facilement et c'est à

partir de ce moment que l'utilisation d'Internet va grimper en flèche.

Si le Web n'a pas de conséquence immédiate en termes de politique

ou de Relations Internationales, il paraît important de savoir comment le

placer dans le système Internet.

D'autres logiciels ont vu le jour, concernant les contenus, et

se sont rapidement popularisés. C'est notamment le cas des logiciels de

Peer-to-Peer (P2P) comme Kazaa ou eMule. Ou bien

33 J. POSTEL a écris dans les RFC que les noms de domaine

n'appartiennent en théorie à personne. Tant que vous payez pour

l'obtenir, il est à vous. L'arrêt de ces paiements entraîne

la disparition de ces noms de domaine. Cependant, cela n'est pas vrai pour les

CCTLD en raison de la souveraineté.

34 Conseil Européen pour la Recherche Nucléaire

encore les logiciels de discussion en ligne tels que MSN

Messenger. La dernière innovation est le Web 2.0 dont l'évolution

passionne actuellement un certain nombre de chercheurs et dont

l'évolution principale concerne la relation entre les internautes et

leurs utilisations de plus en plus importantes d'Internet dans la vie de tous

les jours et pour des tâches qui auparavant, ne concernaient en rien le

Web. C'est notamment le cas de l'administration en ligne qui pose des

problèmes comme la sécurité ou l'indépendance de

ces systèmes.

Ici se termine donc l'exposé de l'architecture

d'Internet. De plus, l'importance du DNS entraîne l'importance accrue de

la personne chargée de la gestion de ce service. C'est pourquoi nous

allons nous intéresser dans la partie suivante à cette personne

morale : l' I CAN N.

B- Administration, Gouvernance et Politique du

Système Internet

Après les développements à propos du

fonctionnement technique d'Internet, nous allons maintenant aborder l'aspect

plus « politique » de la gestion du réseau. La nature

décentralisée de l'objet le rend très difficile à

contrôler et de plus, la tendance libertaire existant depuis la

création ne rend pas facile une telle prise de contrôle. C'est

pour cela que la notion d'Administration du réseau, dans le sens d'une

gestion où l'aspect politique est pris en compte peut être

pertinente. La notion de gouvernance quant à elle sera d'abord

explicitée dans la strict cadre d'Internet et peut être

rattachée à la tendance actuelle qui a permis la création

des Sommets Mondiaux de la Société de l'Information (SMSI) et du

Forum sur la Gouvernance d'Internet (FGI). Enfin, l'aspect politique du

réseau constituera une approche transcendante de cette partie afin

d'obtenir une vision non pas seulement technique mais aussi politique et

surtout stratégique de l'articulation des différents organes se

préoccupant à la fois de la bonne marche d'Internet et de son

devenir.