|

MEMOIRE DE RECHERCHE APPLIQUEE

Présenté et

soutenu par

Dimitri Duval

MASTER FINANCE DE MARCHE

« Efficience des marchés et Méthodes

de Monte Carlo :

Peut-on réaliser des profits anormaux au moyen de

l'Analyse Technique ?»

Année universitaire

2008-2009

Pilote de mémoire : Jérôme Senanedsch,

Docteur en Sciences de Gestion

REMERCIEMENTS

J'adresse mes remerciements à Jérôme

Senanedsch, pour l'aide encadrante qu'il m'a apportée, Alexis, pour son

aide dans l'obtention des données brutes de Bloomberg,

Sarah et Sébastien, pour leur précieuse

relecture,

Et enfin, à Claudia, pour être là.

Je remercie aussi l'INSEEC, de m'avoir donné les moyens,

au terme de mes années d'études, de réaliser ce travail

d'investigation.

SOMMAIRE

INTRODUCTION p 4

I. L'Efficience informationnelle des Marchés

Financiers p6

A. Définition p6

B. Les tests d'efficience p7

II. Analyse empirique de la performance de

méthodes simples d'analyse technique, et propriétés

stochastiques des prix de marchés. p13

A. Données et stratégies de trading par

Analyse Technique p14

B. Résultats empiriques : Tests traditionnels

p21

C. Bootstrap p29

CONCLUSION p36

ANNEXES p38

REFERENCES BIBLIOGRAPHIQUES p41

TABLE DES MATIERES p44

RESUME ET ABSTRACT p45

INTRODUCTION

En plein coeur de la crise, diverses questions ont

été soulevées au sujet des méthodes d'analyse des

cours boursiers notamment. Les portefeuilles d'actions ont perdu de la valeur

au point d'amorcer la faillite de grands groupes financiers mondiaux comme

Lehmann Brothers, et certains indices boursiers comme le CAC40, ont perdu

près de 60% de leur valeur en l'espace d'à peine 21 mois, nous

ramenant ainsi à des niveaux de 6 ans en arrière. Divers

scandales ont éclaté sur la gestion des opérateurs de

marché, dont certains annonçant pour le compte de leur banque des

pertes avoisinant les 5 milliards d'euros, un record. Cette crise sans

précédent est sans aucun doute aussi un excellent moyen de

remettre en cause un système qui avait tendance à fonctionner

jusqu'alors, mais dont on connaissait encore mal les limites : celui de la

finance quantitative. Face à ce terrible constat d'échec,

nombreux sont ceux qui ont commencé à remettre les bases

conceptuelles actuelles de la finance néoclassique en question. En

effet, pour beaucoup, la mathématisation trop importante de la finance

est la source des excès et de l'effondrement du système financier

connu pendant la crise des subprimes.

Et pour cause. Depuis les années quatre-vingt,

jusqu'à aujourd'hui, près d'un siècle après la

thèse de louis Bachelier (1900), les mathématiques

appliquées à la finance ont connu un essor formidable aboutissant

à la formation d'un cadre théorique d'une grande puissance et

d'une élégance remarquable. En amont de cela, la

problématique était de rendre compte du hasard boursier et de

rationaliser son modèle de formation de prix. Car dans un contexte de

dérégulation des marchés financiers au milieu des

années 1970, tenir compte de la nouvelle volatilité des taux de

change permettait de couvrir ces risques dans un environnement incertain. C'est

ainsi qu'ont émergé les produits dérivés et les

travaux de Black, Scholes et Merton (1973) récompensés par un

prix Nobel en 1997 (à titre posthume pour Black

décédé en 1995), qui ont permis une avancée sans

précédent en théorie financière, grâce

à leur stratégie permettant d'annuler tous les risques possibles

dans tous les scenarii de marché. La révolution technologique et

financière qui caractérisent deux des ruptures de notre

société post-industrielle (Daniel Cohen, 2006) ont ensuite permis

une évolution rapide et prolifique du concept, l'avènement du

calcul stochastique appliqué à la finance, et un

développement mondial extraordinaire de nouveaux marchés

organisés. Mais voilà, le modèle de BlackScholes repose

sur une hypothèse que l'on savait fausse depuis déjà

longtemps, et qui est aujourd'hui remise en question avec d'autant plus de

force qu'elle a abouti à des pertes colossale pendant cette crise. Cette

hypothèse est celle de la normalité des prix. Nassim Nicholas

Taleb, dans son essai intitulé Le Cygne Noir, La puissance de

l'imprévisible dira

même « Je trouve choquant que la courbe en

cloche soit employée comme outil de mesure des risques par ces

régulateurs ou ces banquiers qui portent des costumes sombres et

tiennent des propos assommants sur les monnaies » (Nicholas Taleb,

2008, p. 301)

Non moins provocant, Mandelbrot écrira dans son ouvrage

Fractales, hasard et finance que « l'approximation gaussienne

optimale [de l'histogramme des changements d'un prix] est uniformément

détestable », mais nuancera en précisant qu'il croit

« possible de préserver quelques idées de base [de la

thèse de Bachelier] tout en modifiant le mouvement brownien de fond en

comble. » (Mandelbrot, 2009, p. 139)

Ces évidences ont trouvé leur écho dans

la crise actuelle, et le constat est aujourd'hui fait que la finance

néoclassique est en « manque de lanceurs d'alerte »

(interview de Raphaël Douady, 2009, docteur en mathématiques au

CNRS et faisant référence à la VaR), alors que la question

est lancée par Rama Cont, directeur de recherche du CNRS au laboratoire

de probabilité et modèles aléatoires (université

Paris VI-VII), de savoir « s'il s'agit d'une défaillance des

méthodes quantitatives » (Cont, 2009, p. 24)

Des méthodes de trading autrefois

considérées comme « voodoo finance » (Lo et.

al, 2000, pp. 1705) sont aujourd'hui reconsidérées pour mieux

tenter d'appréhender le hasard boursier. Se pose alors la question de

l'efficience de marché : Les marchés sont-ils efficients, et en

quel sens ? Peut-on réaliser des profits anormaux avec des

méthodes d'analyse technique ?

Ce mémoire a pour objectif de déterminer si

l'efficience faible des marchés peut être validée. Pour

cela, nous utiliserons un échantillon de cours d'indices boursiers sur

une dizaine d'année, que nous soumettrons à divers tests

statistiques classiques, ainsi qu'à un test de bootstrap à partir

d'une simulation de Monte-Carlo, pour l'étude de la

significativité des performances par rapport à la

stratégie d'achat conservation sous les critères du ratio de

Sharpe.

I. L'Efficience informationnelle des Marchés

Financiers

A. Définition

La théorie de l'efficience des marchés tire sa

source dès les années 30 avec Cowles & Jones (1937).

Après la seconde guerre mondiale, les économistes

commencèrent à douter des méthodes de prévision des

cours boursiers, alors essentiellement basées sur l'idée que les

marchés sont caractérisés par des tendances

haussières ou baissières. L'idée alors opposée

était le modèle de marche aléatoire des cours, mais il

faut attendre les années 70 avec Samuelson, Fama, puis Jensen, pour

avoir le cadre théorique que l'on connaît actuellement du concept

d'efficience (Roland Portrait, Poncet p.24).

En réalité, le concept d'efficience revêt

plusieurs définitions. Et le pilier de la finance moderne repose

aujourd'hui sur la dimension informationnelle de l'efficience et sur les

anticipations rationnelles des agents. Nous distinguerons ici l'efficience

informationnelle de l'efficience allocative, qui fait état du calcul de

l'allocation optimale entre l'épargne classique et les

marchés.

La première définition formelle de l'efficience

informationnelle des marchés financiers est donc proposée par

Fama (1965) où l'atomicité des agents fait en sorte qu'aucun

d'entre eux ne puisse seul influer sur le prix du marché, et où

le prix du marché agrège l'ensemble des comportements des

individus reflétant ainsi, à chaque instant, toute l'information

pertinente et disponible.

« [...] sur un marché efficient, les actions

conjuguées des nombreux opérateurs doivent amener le prix

réel à fluctuer au hasard autour de la valeur intrinsèque.

Si les divergences entre les prix réels et les valeurs

intrinsèques sont systématiques plutôt que de nature

aléatoire, la connaissance de ces divergences doit aider les

opérateurs intelligents à mieux prédire le cheminement par

lequel les prix réels vont se mouvoir en direction des valeurs

intrinsèques. [...] Et bien que l'incertitude concernant les valeurs

intrinsèques demeure, les prix réels vont fluctuer

aléatoirement autour de celles-ci » (Fama, 1965).

Ce qui explique qu'il est possible d'affecter une distribution de

probabilité aux prix.

L'apport substantiel de Samuelson (1965) consistera à

montrer que les prix de marché ne se contentent pas de fluctuer autour

de leur valeur fondamentale, mais qu'ils en sont toujours égaux.

Mais le concept d'efficience informationnelle tel

qu'évoqué ci-avant reste trop général et impossible

à vérifier empiriquement. Fama (1970) proposera ainsi trois

formes de l'efficience informationnelle, qu'il complétera ensuite en

1991: L'efficience au sens faible, l'efficience semi-forte, et l'efficience

forte, sur lesquelles nous reviendront dans notre partie sur les tests

d'efficience.

Revenons, à la notion samuelsonienne de prix de

marché toujours égaux à leur valeur fondamentale. La

différence apportée est loin d'être triviale. Car elle est

lourde d'implications. En effet, on peut toujours espérer tirer profit,

par la spéculation, de la différence qui peut être

générée entre le prix et sa valeur fondamentale. Dans le

cas où le prix et sa valeur fondamentale sont toujours égaux,

toute spéculation devient vaine.

En 1978, Jensen donnera une nouvelle définition de

l'efficience informationnelle des marchés financiers. « Un

marché est efficient, relativement à un ensemble d'information

donné, s'il est impossible de réaliser des opérations

profitables sur la base de cet ensemble d'information [...] Par profit, on

entend le taux de rentabilité ajusté au risque et net de tout.

» Jensen (1978).

B. Les tests d'efficience

Comme nous l'avons souligné précédemment,

le cadre théorique de l'hypothèse d'efficience des marchés

énoncée par Fama (1965) est longtemps resté trop

générique, et par conséquent difficile à tester

empiriquement. Ce qui l'a amené à distinguer trois types

d'efficience informationnelle des marchés. Nous allons succinctement

présenter deux des trois types d'efficience informationnelle, en ayant

soin de présenter plus en détail l'efficience faible, qui

siège au coeur de notre étude par la suite.

1. L'Efficience forte et semi forte

L'efficience forte stipule que les prix des

marchés reflètent à chaque instant l'historique

des

prix, l'information publique, ainsi que l'information privée. Les

tests mettent en évidence des

rendements anormaux après des décisions importantes

concernant le titre considéré, mais non rendues publiques (avant

l'annonce d'une OPA mais après sa décision, par exemple).

L'efficience semi-forte stipule elle, que les prix des

marchés reflètent à chaque instant, toute l'information

contenue dans l'historique des cours boursiers, et toute l'information

publique. Les tests tentent de détecter la présence

d'éventuels rendements anormalement élevés sur les

périodes suivant une bonne nouvelle, ou anormalement faibles sur les

périodes suivant une mauvaise nouvelle. Si tel est le cas, l'anomalie

d'efficience informationnelle est incompatible avec l'efficience semi-forte.

« Une attitude raisonnable penche en faveur de

l'efficience semi-forte des marchés. Selon certaines études, il

n'est pas possible de systématiquement tirer profit d'une information

connue de tous, pour réaliser des profits anormaux, si l'on tient compte

des coûts de transactions, et cela compte tenu de la

rémunération du risque encouru ». (Pontrait et Poncet, 2008,

p. 35)

2. L'Efficience faible

L'efficience au sens faible postule que l'ensemble des

informations disponibles comprend uniquement l'historique des prix, et par

conséquent des rentabilités.

Les tests d'efficience faible cherchent à

détecter une éventuelle auto-corrélation dans le temps des

rendements successifs des titres. S'il y a bien auto-corrélation,

c'est-à-dire, si l'on peut prévoir les rentabilités

futures à partir des rentabilités passées, alors sous

certaines conditions, l'efficience se trouve invalidée. Deux types de

tests sont utilisés pour aboutir :

a. Les tests directs

Des tests directs visant à déterminer

l'efficience ont été réalisés par Fama & Blume

(1966). Leur test de « méthode des filtres » consistait

essentiellement à comparer le marché avec un portefeuille

naïf. Leurs résultats aboutirent à la validation totale de

l'efficience

De même, Hakkio & Rush (1989) ont testé les

relations inter-marchés pour déterminer si

l'interdépendance des cours permettait d'obtenir des profits anormaux.

Ces tests réalisés au moyen de méthodes de

co-intégration, ont abouti à l'invalidation de l'Efficience.

D'autres tests directs ont permis de mettre en évidence

des « anomalies » d'efficience informationnelle des marchés,

comme l'« effet taille » de Banz (1981), l'« effet janvier

» de Reinganum (1983), ou encore l'« effet vendredi 13 » de Kolb

& Rodriguez (1987)

b. Les tests indirects

Les tests indirects sont en grande partie des tests de marche

aléatoires ou de processus stochastiques (cf glossaire) visant à

vérifier si les rentabilités futures peuvent être

déterminées à partir des rentabilités

passées.

Mais parmi l'abondante littérature visant à

tester l'efficience faible des marchés, de plus en plus d'études

portent sur l'analyse technique, qui par essence n'a d'objet que la

réalisation de profits anormaux dans un environnement incertain, au

moyen des informations uniquement contenues dans les cours.

? De l'Analyse Technique et de ses

critiques...

Depuis son apparition, dont la plus ancienne technique est

attribuée à Charles Dow dans les années 1800, l'analyse

technique ne fait pas l'unanimité au sein de la communauté

académique. Notamment à cause de son manque de rigueur et de

cadre théorique. Mais aujourd'hui, ce formalisme prend corps dans un

courant de recherche alternatif à la finance néoclassique ou

moderne, au sein de la finance comportementale (Orléan, 2008).

Pour proposer une définition de l'analyse technique,

citons Benoît Mandelbrot (1997), qui dit de l'ambition de ses praticiens,

dans son ouvrage Fractal, hasard et finance p.137 :

« [l]es praticiens de l' « analyse technique

» ont l'ambition de prévoir l'avenir sur la base des

évolutions du passé. » Ce qui au passage, montre bien

que l'analyse est un test d'efficience faible. Puis, il poursuit la phrase

suivante en clarifiant :

« Leurs méthodes sont subtiles, mais rarement

décrites assez précisément pour permettre

une

vérification. Dans les cas exceptionnels où l'on a pu les

vérifier, leurs affirmations se sont

révélées sans fondements. Nous le

verrons dans le cas des « filtres » proposés par S.S

Alexander. »

Dans l'article de Jensen & Benington (1970), ledit

Alexander (1961, 1964) est également cité aux côtés

de Fama & Blume (1966) pour mentionner qu'effectivement les

stratégies de trading basées sur l'analyse technique ne

surperforment pas la stratégie Buy & Hold, et est cité aux

côtés de James (1968) et Van Horne & Parker (1967) pour

mentionner les mêmes résultats, avec des méthodes de

moyennes mobiles en particulier.

Mais dans le même article, Jensen & Benington (1970)

citent ensuite, Robert A. Levy (1967a, b) qui par une méthode d'analyse

technique ainsi nommée des « forces relatives » ou «

portfolio upgrading », obtient des résultats significativement

supérieurs à ceux de la stratégie Buy & Hold.

Quelle attitude alors avoir face à l'analyse technique?

Est-elle une méthode indirecte fiable pour tester l'efficience faible

des marchés?

Brock, Lakonishok & LeBaron (1992), ont fait remarquer que

l'attitude de l'académie envers la discipline est bien

résumée par Malkiel (1981) qui écrivait :

« Obviously, I am biased against the chartist. [...]

Technical analysis is anathema to the academic world. Our bullying tactics are

prompted by two considerations : (1) the method is patently false ; and (2) it

's easy to pick on. ».

Mais ils concluront en fournissant des résultats sans

équivoque sur les performances d'outils simples d'analyse techniques,

comme les moyennes mobiles ou les bandes de support et résistances.

Comme une réponse à cette dernière

critique de Malkiel (1981), Lo, Maymaysky & Wang (2000), dans «

Foundation of Technical Analysis : Computational Algorithms, Statistical

Inference, and Empirical Implementation » ont réalisé une

approche mathématique très formelle et rigoureuse, de ce qu'il

convient encore parfois de nommer dans certains milieux et selon eux, la

« voodoo finance ». Ils ne manquent d'ailleurs pas non plus

de citer Malkiel (1996), comme ayant largement contribué à cette

décrédibilisation de l'analyse technique dans son livre A

Random Walk down Wall Street, concluant en ces termes :

« [u]nder scientific scrutinity, chart-reading must

share a pedestral with alchemy ».

, avec o. l'écart-type de l'échantillon, et n la

taille de l'échantillon.

x -- u0

o.

t=

Cependant, Lo et al. (2000) rappellent dans l'article

sus-cité, que nombre de contributions ont été faites

depuis, en faveur de l'analyse technique. Comme les études de Tabell

& Tabell (1964), Trynor & Ferguson (1985), Brown & Jennings (1989),

Jegadeesh & Titman (1993), Blume, Easley, & O'Hara (1994), Chan,

Jegadeesh, & Lakonishok (1996), Lo & MacKinlay (1997), Grundy &

Martin (1998), et enfin Rouwenhorst (1998).

Et faisant référence aux contributions les plus

directes dans cette discipline, Lo et al. citent Pruitt & White

1988), Neftci (1991), Neely, Weller & Dittmar (1997), Neely & Weller

(1998), Chang & Osler (1994), Osler & Chang (1995), Allen &

Karjalainen (1999), et enfin Brock, Lakonishok, and LeBaron (1992), notamment

grâce à des méthodes simples de moyennes mobiles pour ces

derniers. A cette liste, j'ajoute également Osler (2003).

Brock et al. guideront structurellement l'étude

empirique de ce mémoire.

s Méthodes de calcul des

significativités des rentabilités

Diverses méthodes de significativités

statistiques sont utilisables, afin d'éviter notamment le data-snooping

(cf glossaire). Citons à ce titre John D. Lyon, Brad M. Barber, &

Chih-Ling Tsai (1999) pour des méthodes de tests sur les anomalies

d'efficience à long terme, Robert J. Shiller (1981) sur les mesures de

volatilité, et enfin Ryan Sullivan, Allan Timermann, & Halber White

(1999), pour des méthodes de bootstraping sur des performances de

stratégies type analyse technique.

Globalement, ces articles évoquent les mêmes outils,

et dans chaque cas, des p-values, où des probabilités critiques

sont obtenues, permettant de valider ou d'invalider l'hypothèse

nulle.

i) La t-statistic ou test t de Student : testant

l'hypothèse nulle selon laquelle la moyenne x de l'échantillon

considéré s'approche d'une valeur théorique

ì0, avec une probabilité déterminée par

l'intervalle de confiance de la variable x - ì0. L'intervalle

de

confiance choisi est souvent de 95% (ou 99%) ce qui autorise une

marge d'erreur de 5% (ou 1%)

Le t de Student est alors donné par la formule

générale ci-dessous :

ii) Le Bootstraping : Méthode de

rééchantillonage de données à partir d'un

échantillon initial sans aucune nouvelle donnée, d'où son

nom de bootstrap. Ces rééchantillonages se font par simulations

probabilistes (dites de Monte-Carlo), ici suivant des modèles de

formation des cours boursiers.

Les bootstraps peuvent donc se faire à partir de

simples simulations de marches aléatoires, jusqu'à des

simulations stochastiques bien plus élaborées, telles que les

modèles ARCH ou GARCH. Citons à cet effet Brock et al.

(1992). Ces derniers les utilisent tous, sauf le mouvement brownien

géométrique.

iii) Le ratio de Sharpe : utilisé pour comparer les

performances à celle de la stratégie Buy & Hold, parfois

complété par des simulations de type Monte-Carlo. Ryan Sullivan

et al. (1999), ont utilisé ce type de méthode pour

asseoir la significativité de leurs tests.

|

S ? R ? r

o.

|

, avec R le taux de rendement de l'indice

considéré, r le référentiel de comparaison

|

choisi, et o. l'écart-type du taux de rendement de

l'indice considéré. Dans le cadre des tests d'efficiences faible,

il s'agit souvent du rendement de la stratégie Buy & Hold.

iv) Les méthodes de Monte-Carlo :

Elles servent dans les méthodes de

rééchantillonage pour un test t de Student, un bootstrap ou un

ratio de Sharpe. La littérature est abondante sur le sujet, mais le

meilleur exemple d'utilisation de cette méthode dans les tests

d'efficience faible est l'étude faite par Brock et al.

(1992).

A l'ensemble de ces méthodes, auxquelles s'ajoutent

l'ensemble des outils classiques de statistique descriptive, notamment dans le

cas d'échantillons gaussien ou supposés comme tels, nous avons

trouvé intéressant d'ajouter un test de Bartlett, sur le

modèle de Brock et al. (1992).

II. Analyse empirique de la performance de

méthodes simples d'analyse technique, et propriétés

stochastiques des prix de marchés.

Deux articles majeurs sous-tendent et guident cette

étude. Le premier dont est inspiré le titre de cette partie, est

celui déjà évoqué de William Brock, Joseph

Lakonishok et Blake LeBaron (1992).

Le second, sans doute le plus important par son apport

théorique car il valide le formalisme et pose les fondements rigoureux

des techniques utilisées, est l'article également

déjà évoqué d'Adrew W. Lo, Harry Mamaysky, et Jiang

Wang (2000). Il permet notamment d'implémenter informatiquement, avec

une rigueur auparavant inédite, les différentes méthodes

d'analyse technique, des plus simples, aux plus subtiles.

A. Données et stratégies de trading par

Analyse Technique

1. Les données

Les séries de données utilisées dans

cette étude sont issues de Bloomberg. Il s'agit du cours du

CAC40 et du DJ Eurostoxx depuis le premier jour de bourse ouvré de

l'année 2000, le 3 janvier 2000, avant l'éclatement de la bulle

Internet, jusqu'au 19 mai 2009, après le dernier plus bas des cours

(espérons) suivant de la crise des subprimes de 2007. Ce qui

représente pour le CAC40 d'une part, 2 393 jours de trading successifs,

et pour le DJ Eurostoxx (cf glossaire) d'autre part, 2 391 jours ouvrés

de tradings successifs.

Toutes les rentabilités évoquées dans

l'étude sont en fait des Log-rentabilités. Une fois ceci

évoqué, nous utiliserons indifféremment et par abus de

langage, l'une ou l'autre expression. Cela permet en outre de rester

cohérent avec le modèle mathématique de formation des

cours boursiers que nous développerons plus tard. De plus, le choix des

données n'est pas anodin, car il permettra de déterminer si,

même dans un marché à tendance baissière, les outils

d'analyse techniques permettent non seulement de faire mieux que la

stratégie Buy and Hold, c'est-à-dire ne pas trop perdre d'argent,

mais aussi de réaliser un gain positif significatif.

2. Les stratégies d'analyse technique

utilisées

Dans cette étude, tout comme dans celle de Brock et

al. (1992), nous avons choisi de tester

deux des techniques les plus

simples et les plus largement utlisées : les oscillateurs

type

moyennes mobiles, et l'exploitation des cassures de support et

résistance. Si, comme Brock et

al. (1992), nous avons choisi d'utiliser des moyennes

mobiles non pondérées ou exponentielles, pour des raisons de

cohérence avec le modèle de Monte-Carlo choisi pour le bootstrap,

nous avons cependant pris le parti de tester des bandes de Bollinger pour le

canal support-résistance.

a. Les Moyennes Mobiles oscillantes

Les stratégies de trading reposant sur des moyennes

mobiles oscillantes, consistent à observer les signaux

générés par le croisement d'une moyenne mobile

court-terme, et d'une moyenne mobile long-terme. Le croisement de ces moyennes

mobiles révèle alors, selon le signe de leur différence,

des signaux d'achat, ou des signaux de ventes. Dans sa forme la plus simple, la

stratégie de trading consiste à acheter (vendre) lorsque la

moyenne mobile court-terme (long-terme) traverse à la hausse (à

la baisse) la moyenne mobile long-terme (court-terme).

En effet, lorsque la moyenne mobile court-terme traverse la

moyenne mobile long-terme par le bas, c'est un signal de hausse du

marché. Lorsqu'elle la traverse par le haut, c'est un signal

baissier.

Pour reproduire le mode opératoire de Brock et al.

(1992), nous testerons 5 oscillateurs selon 2 règles de trading. Le

premier des 5 oscillateurs est trivial. Il s'agit des MM1 et MM200, avec la MM1

la moyenne mobile court-terme à 1 jour, et la MM200, la moyenne mobile

long terme à 200 jours. Par souci de concision dans l'écriture,

et pour reprendre la typologie de Brock et al. (1992), nous noterons

cet oscillateur 1-200. Les quatre autres sont 1-150, 5-150, 1-200 et 2-200.

L'introduction d'une bande absorbante de faible épaisseur (+/- 1%)

autour de la moyenne mobile long-terme permet d'éliminer nombre de

signaux perturbateurs. Cette méthode de Brock et al. (1992) a

pour but d'éliminer les signaux de trop faible intensité lorsque

les moyennes mobiles sont très proches.

A cette méthode de filtrage horizontal, nous avons

choisi d'ajouter une nouvelle méthode, de filtrage vertical. Cette

dernière a pour but d'éliminer les signaux annonciateurs de

tendance inversée trop proches dans le temps quand la moyenne mobile

court terme est très volatile au croisement de la moyenne mobile

long-terme. Ce filtrage horizontal a ainsi pour effet d'exclure les signaux

inverses parasites générés sur une période de 2

jours consécutifs. Avec ce filtre, seuls les signaux initiés et

non inversés le jour suivant, seront considérés.

s L'oscillateur flottant ou Variable-Length Moving

Average (VMA)

La première règle, concernant la durée sur

laquelle les signaux devront être considérés, est

appelée oscillateur flottant, ou VMA, pour reprendre la terminologie de

Brock et al. (1992). Cette règle génère des

signaux d'achat (de vente) lorsque la moyenne mobile court- terme est au dessus

(en dessous) de la moyenne mobile long terme, par une cassure supérieure

à la largeur de bande. Cela a pour effet de simuler les

stratégies Long et Short des traders. Lorsque la largeur de bande

choisie est de 0%, chaque jour tradé est identifié comme

étant soit un signal d'achat, soit un signal de vente.

Algorithmiquement, si nous notons JA le signal d'achat

généré (jour Achat), JV le signal de vente

généré (jour Vente), EL la moyenne mobile long terme, et

EC la moyenne mobile court terme, cela se formalise par :

Avec la bande de 0% :

Pour chaque jour de trading

Si EC - EL > 0

alors JA

Fin Si

Si EC - EL < 0

alors JV

Fin Si

Fin Pour

Avec la bande de 1% :

|

Pour chaque jour Si EC - EL <

|

de trading 0

|

|

|

alors

|

Si

|

EL *(1-1%)- ES alors JV

|

> 0

|

|

Fin

|

Si

|

|

|

|

sinon

|

Si

|

EC - EL*(1+1%)

|

> 0

|

alors JA Fin Si

Fin Si

Fin Pour

s L'oscillateur fixe ou Fixed-Length Moving

Average (FMA)

D'autres variations de la stratégie visant à

observer les oscillateurs de type moyenne mobile courte-longue, mettent en

avant l'importance du croisement de celles-ci. Comme le disent Brock et al.

(1992) cette vision souligne que les rendements devraient être

différents durant les quelques jours suivant ledit croisement. Cette

règle est celle que nous avons choisi de nommer oscillateur fixe, ou

selon la terminologie de Brock et al. (1992), la FMA. Pour

modéliser cette règle, nous avons enregistré les

rendements durant les 10 jours suivant un signal d'achat ou de vente. Tous les

signaux alors générés par d'éventuels croisements

durant cette période de 10 jours, sont alors ignorés. La

période de 10 jours n'est pas arbitraire, dans une optique

d'homogénéisation des tests dans la littérature, nous

avons choisi la même que celle de Brock et al. (1992). Suivant

cette logique, les signaux fonction des volumes de trade seront

ignorés.

Typiquement, ayant stocké pour chaque jour les signaux

générés par la règle VMA, l'algorithme pour

modéliser les signaux FMA, avec les notations XA pour les croisements

signaux de tendance haussière, et XV pour les croisements signaux de

tendance baissière :

Pour chaque jour j de trading

Si signal(jour j-1) = JV Et signal(jour j) = JA

alors signal(jour j) = XA

sinon Si signal(jour j -1) = SA et signal(jour j) = SV

alors signal(jour j) = XV

Fin Si

Fin Si

Fin Pour

N = numéro du dernier jour de trading j = N

Faire

Si signal(jour j) = XA Ou signal(jour j) = XA

alors signal = signal(jour j)

Pour k de 0 à 9

signal(jour j - k)= signal

Suivant

Fin Pour j = j - 9 Fin Si

j = j - 1

Boucler jusqu'à ce que j = 1

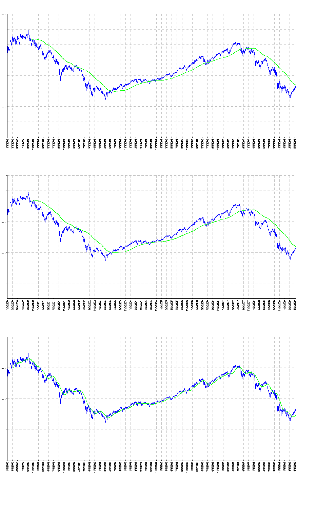

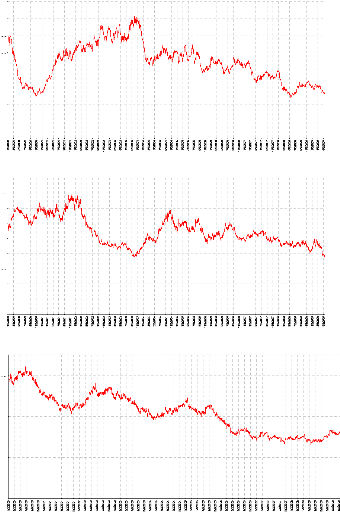

Après implémentation sur Excel, les cinq

oscillateurs obtenus sont les suivants :

18

8000

7000

6000

5000

4000

3000

2000

1000

0

CAC40 (MM1 & MM200)

8000

7000

6000

5000

4000

3000

2000

1000

0

CAC40 (MM1 & MM50)

CAC40 (MM2 & MM200)

8000

7000

6000

5000

4000

3000

2000

1000

0

CAC40 (MM1 & MM150)

|

8000 7000 6000 5000 4000 3000 2000 1000 0

|

|

CAC40 (MM5 & MM150)

8000 7000 6000 5000 4000 3000 2000 1000 0

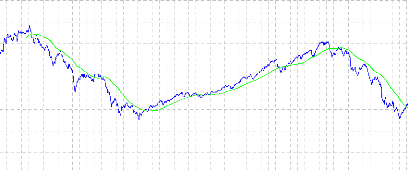

b. Les Bandes de Bollinger

La dernière règle d'analyse technique dont sera

étudiée la performance, sera celle des Bandes de Bollinger. Cette

méthode d'analyse technique consiste à générer des

signaux d'achat ou de vente lorsque les bandes de Bollinger sont

traversées par les cours. Les signaux d'achats sont émis quand le

cours traverse la bande supérieure, et des signaux de ventes sont

émis par la cassure de la bande inférieure. Pour comprendre cette

stratégie des analystes techniques, nous définissons nos bandes

de Bollinger ci-dessous :

Soient :

xk le cours de l'indice du k-ième jour de notre

échantillon de taille N,

{ xk - 19,

·

·

·, xk} l'ensemble

composé de xk et des 19 jours précédents,

MM20(xk) la moyenne mobile long-terme sur 20 jours, de

l'ensemble { xk - 19,

·

·

·, xk}, et 020(xk)

l'écart-type de l'ensemble { xk - 19,

·

·

·,

xk}.

Alors,

La ligne de support de la bande de Bollinger est donnée

par l'ensemble :

{MM20(xk) - 2020(xk)}1 ~ k ~ N - 19

La ligne de résistance de la bande de Bollinger est

donnée par l'ensemble :

{MM20(xk) + 2020(xk)}1 ~ k ~ N - 19

On obtient alors le résultat suivant sur Excel :

CAC40 (Bandes de Bollinger)

|

8000 7000 6000 5000 4000 3000 2000 1000 0

|

|

puis après un zoom :

CAC40 (Bandes de Bollinger)

|

7000 6000 5000 4000 3000 2000 1000 0

|

|

Ainsi notre bande de Bollinger, par construction, et par

hypothèse de log-normalité des rentabilités, devrait selon

les analystes techniques, borner les cours qui ne devraient pas sortir du canal

créé par l'intervalle de +/-2o autour de la moyenne mobile

à 20 jours d'un cours. Cela avec un niveau de confiance de 95%, car la

stratégie repose sur l'hypothèse gaussienne. Nous testerons donc

cette méthode avec un taux d'absorption des signaux de 1% sur les lignes

de support et résistance qui constituent les bandes de Bollinger. Suite

à l'apparition du signal d'achat ou de vente, nous enregistrerons, comme

Brock et al. (1992), les rentabilités obtenues durant 10 jours

consécutifs. A cette stratégie de trading selon les bandes de

Bollinger, nous avons décidé de tester les performances obtenues

avec davantage de jours. Nous avons fixé arbitrairement ce nombre jour

à 20 pour notre deuxième stratégie.

B. Résultats empiriques : Tests traditionnels

1. Statistiques de l'échantillon

a. Corrélations intermarchés

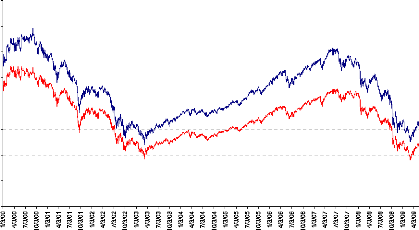

Le tableau ci-dessous présente une étude de

corrélation entre les cours du Dow Jones DJ Eurostoxx, et les cours du

CAC40 sur une période similaire, allant du 3 janvier 2000, au 19 mai

2009. Les jours ouvrés n'étant cependant pas les même

à Paris, Francfort ou Zürich, le nombre de variables diffère

d'un échantillon à l'autre. Par conséquent, 2

possibilités

s'offraient à nous : soit supprimer les cours

correspondant aux dates non concordantes, soit compléter les dates

manquante par un jour tradé, dont le cours est égal à

celui de la veille. Nous avonse choisi cette dernière solution. En effet

supprimer les cours correspondant aux dates non concordantes pouvait avoir pour

conséquences d'annuler une variation journalière non

négligeable, et ainsi biaiser la volatilité.

|

CAC40

|

|

DJ Eurostoxx

|

|

|

Dates ajoutées à l'échantillon

|

CAC Index

|

Dates ajoutées à l'échantillon

|

SX5E Index

|

|

12 juin 2000

|

6549.05

|

24 décembre 2002

|

2456.5

|

|

14 juillet 2000

|

6570.36

|

31 décembre 2002

|

2386.41

|

|

4 juin 2001

|

5432.71

|

24 décembre 2003

|

2721.57

|

|

|

28 mai 2007

|

4463.52

|

|

|

24 décembre 2007

|

4384.55

|

Nombre de jours ajoutés 3 5

Taille de l'echantillon 2 396 2 396

écart-type relatif 0.23711 0.24795

Coefficient de corrélation 99%

Corrélation CAC40 & DJ Eurostoxx

DJ Eurostoxx

CAC40

8000

7000

6000

5000

4000

3000

2000

1000

0

A la vue de ces résultats, nous avons fait le choix de

porter notre étude uniquement sur les données historiques du

CAC40.

Comme nous pouvons le voir, les cours du CAC40 et du Dow Jones

DJ Eurostoxx ont le même comportement, en effet leur cours est

très fortement corrélé, et leur volatilité relative

est du même ordre. Nous en concluons que les résultats obtenus sur

les cours du CAC40, seront valable également pour le Dow Jones DJ

Eurostoxx.

b. Résumé statistique de l'échantillon

étudié : indice CAC40 sur une dizaine d'années

Les résultats empiriques de ces 2 393 jours

tradés consécutifs du 1er jour ouvré de

l'année 2000, à la fin mai 2009, sont calculés à

partir des log différences des cours. Les données montrent alors

une claire leptokurticité des log rentabilités

considérées.

Nous avons aussi testé l'auto-corrélation des

cours avec un décalage de i jours, puis calculé leur p-value. Les

résultats des calculs sont accessibles, en annexe, et ont

été réalisés à l'aide du logiciel R, mis en

ligne par l'université Pierre et Marie Curie. Suivant la typologie

adoptée dans la littérature, nous avons marqué ces

autocorrélations d'une étoile * pour une significativité

à 5% d'erreur, et marquées de deux étoiles **, quand

l'erreur est inférieure à 1%. Il apparaît alors une

très faible autocorrélation des log rentabilités. Ce qui

semble intervenir en faveur de l'efficience faible des marchés. Nous

avons également réalisé un test

1

de Bartlett standard pour estimer l'erreur des

autocorrélations, par la formule . Bien qu'il

N

ne s'agisse pas d'indices boursiers identiques, nos

résultats sont concordants avec ceux de Brock et al. (1992)

Rendements journaliers

p(i), test d'autocorrélation avec un décalage de

i

calculés ramenés à 1 jour

p(i), test d'autocorrélation avec un décalage de

i

0.065 0.020

239 2 383

-0.0025 -0.00023

0.0503 0.01 37

N

|

2 393

|

|

Moyenne

|

-0.00025

|

|

?

|

0.0159

|

|

Skew

|

0.0410

|

|

Kurtosis

|

5.08

|

|

p(0)

|

1

|

p(1)

|

-0.047**

|

p(2)

|

-0.046

|

p(3)

|

-0.069

|

p(4)

|

0.062*

|

p(5)

|

|

-0.073*

|

|

|

Bartlett std.

|

0.020

|

|

Rendements sur 10 jours (glissants)

|

|

N

|

2 383

|

|

Moyenne

|

-0.0023

|

|

?

|

0.0433

|

|

Skew

|

-0.9724

|

|

Kurtosis

|

3.50

|

|

p(0)

|

1.000

|

p(1)

|

0.862

|

p(2)

|

0.731

|

p(3)

|

0.622

|

p(4)

|

0.535

|

p(5)

|

|

0.429

|

|

|

Bartlett std.

|

0.020

|

2. Résultats de la stratégie des moyennes

mobiles oscillantes

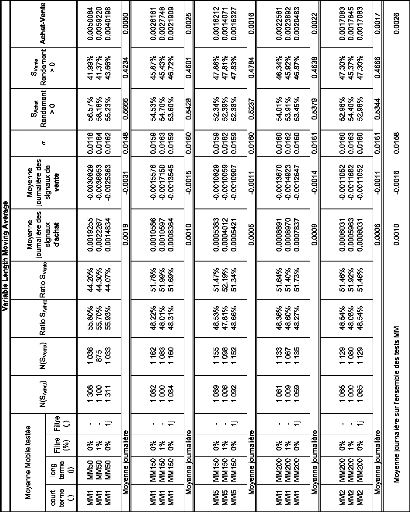

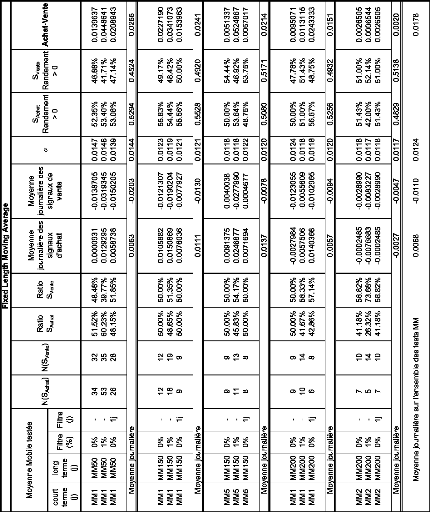

Les tableaux suivants présentent les résultats

de performance de la méthode des oscillateurs flottants ou VMA, ainsi

que les résultats de performance de la méthode FMA. Nous y avons

réalisé, pour chaque méthode, une synthèse des

résultats des 5 oscillateurs évoqués

précédemment.

Pour chaque oscillateur, nous avons distingué les 3

règles déjà auparavant énoncées, sur 3

lignes successives.

Nous avons donc testé les performances de 30

oscillateurs au total, dans les deux tableaux qui suivent.

En première ligne, nous présentons les

résultats de l'oscillateur classique, sans contrainte. En

deuxième ligne, ceux de l'oscillateur muni d'une bande absorbante de 1%

sur sa moyenne mobile long terme. En troisième ligne enfin, nous

présentons les résultats de l'oscillateur muni d'un filtre

évitant les signaux s'annulant d'une journée à l'autre.

Rappelons que les signaux de trading de ces oscillateurs sont initiés

lors du croisement des moyennes mobiles

court-terme et long-terme. Un signal d'achat (vente) est

généré quand la moyenne mobile court terme passe au dessus

(dessous) de la moyenne mobile long terme.

N(SAchat) et N(SVente)

représentent le nombre de signaux d'achat et de vente

générés par la méthode. Des ratio sont ensuite

calculés. Nous présentons ensuite la moyenne des log-

rentabilités journalières cumulées des signaux d'achat,

puis celle des signaux de vente. Vient ensuite le calcul des

écart-types. Les colonnes suivantes montrent la proportion de signaux

d'achat ayant engendré des rentabilités positives pour le

praticien de l'analyse technique. Enfin, en dernière colonne sont

présentés les rendements obtenus au moyen de ces oscillateurs sur

l'ensemble de la période de l'échantillon.

Il est intéressant de constater que pour les

oscillateurs VMA, plus de 50% des signaux d'achat sont gagnants. Ce

résultat est en parfaite cohérence avec les résultats de

Brock et al. (1992), mais leur interprétation ne fonctionne pas

sur l'échantillon considéré ici. En effet, ceux-ci

affirment, après avoir trouvé ces mêmes proportions de

signaux d'achats gagnants, que cela est consistant avec un marché

à tendance haussière. Or on sait que sur l'échantillon

choisi, la tendance du marché n'était pas haussière. Il se

caractérise en effet par la création de la bulle Internet, son

éclatement, une tendance haussière, puis une crise sans

précédent, celle des subprime. Celle-ci a fait perdre 59,2% de sa

valeur au CAC40 en l'espace de 21 mois et demi, entre le 1 juin 2007, et le 9

mars 2009. Ce qui a eu pour effet d'annuler 6 ans de tendance haussière

et d'atteindre un « plus bas » à cette date. Il semble donc,

empiriquement, que cette importante proportion de signaux d'achat gagnants,

soit due à un autre élément. Probablement l'outil en

lui-même.

Pour les tests de FMA, deux cas nous donnent cependant des

résultats inférieurs (supérieurs) à 50% et

inférieurs (supérieurs) au nombre de signaux d'achat (vente). Il

s'agit des oscillateurs 5-150 et 2-200, avec une bande filtrante de 1%. Cela

indique, puisque la moyenne journalière des rendements cumulés

Achat-Vente est toujours strictement positive, que cette règle de

trading implique implicitement que l'on réalise

régulièrement des opérations de moyenne à la

baisse. Ce qui est clairement illustré par le ratio de signaux d'achat

à 26% selon nos résultats, et de vente à près de

73% de l'oscillateur 2-200-(1%).

Dans la dernière colonne des tableaux, Achats-Ventes,

on constate de plus que les log- rentabilités journalières

espérées sont bien supérieures à celles du

marché. En synthèse, les stratégies VMA et FMA permettent

respectivement, toutes règles confondues d'espérer des

rentabilités journalières de 0.0026, et 0.0 178, alors que le

marché propose, nous l'avons vu dans la section 1. b., une

rentabilité journalière moyenne de -0.00025.

3. Résultats de la stratégie des bandes de

Bollinger

Suivant cette stratégie, rappelons-le, les agents

interprètent respectivement les traversements des bandes hautes et basse

de Bollinger comme des signaux de vente et d'achat. Les positions de trading

sont maintenues pendant 10 ou 20 jours selon la règle testée, et

les rendements moyens journaliers sont exprimés dans le tableau. Il s'en

suit par construction, que seuls les signaux apparaissant dans un ?t > 10

jours, ou ?t > 20 jours pour la seconde règle, sont

générés.

On constate alors qu'imposer un enfoncement à travers

le support ou la résistance supérieur 1% pour

générer un signal, engendre des pertes plus importantes.

Cela reste cohérent avec le fait que cet outil est fait

pour rendre compte de la faible probabilité du cours de traverser cette

bande. D'autre part, cet outil doit sa notoriété à sa

réactivité. Attendre un enfoncement de 1% est synonyme de perte

de profit. Cependant, concrètement, cet outil ne donne pas de

résultats probants. Et clairement, l'espérance de gain est

négative.

De plus, le nombre de signaux d'achat est anormalement

élevé, et très nettement supérieur au nombre de

signaux de vente. Ce qui est incohérent avec la tendance du

marché sur les 10 ans. Par ailleurs, en gardant ses positions sur 20

jours, plutôt que de les garder sur 10, on observe que les pertes sont

moins importantes, mais que la méthode ne permet toujours pas de gagner

de l'argent.

D'autant que les frais de transactions ne sont pas

modélisés ici dans le calcul des rentabilités.

|

Bandes de Bollinger - rentabilités sur

10j

|

|

Canal

|

N(SAchat)

|

N(SVente)

|

Ratio SAchat

|

Ratio SVente

|

Moyenne

journalière

des

signaux

d'achat

|

Moyenne

journalière des

signaux

de

vente

|

g

|

SAchat

Rendement

> 0

|

SVente

Rendement

> 0

|

Achat-Vente

|

|

MM (j)

|

Haut

|

Bas

|

Filtre

(%)

|

|

MM20

MM20

|

+2 g

+2 g

|

-2 g

-2 g

|

0%

1%

|

50

21

|

48

5

|

51.02%

80.77%

|

48.98%

19.23%

|

-0.0298583

-0.0504645

|

0.0083102

0.0172875

|

0.0176

0.0260

|

45.20%

42.86%

|

53.13%

50.00%

|

-0.0381685

-0.0677521

|

|

Moyenne journalière -0.0402 0.0128 0.0218 -0.0530

|

|

Bandes de Bollinger - rentabilités sur

20j

|

|

Canal

|

N(SAchat)

|

N(SVente)

|

Ratio

SAchat

|

Ratio

SVente

|

Moyenne

journalière

des

signaux

d'achat

|

Moyenne

journalière des

signaux

de

vente

|

g

|

SAchat

Rendement

> 0

|

SVente

Rendement

> 0

|

Achat-Vente

|

|

MM (j)

|

résistan

ce

|

suppo

rt

|

Filtre

(%)

|

|

MM20

MM20

|

+2 g

+2 g

|

-2 g

-2 g

|

0%

1%

|

39

19

|

35

5

|

52.70%

80.51%

|

47.30%

19.49%

|

-0.0168600

-0.0388239

|

0.0069475

0.0151060

|

0.0163

0.0241

|

46.79%

47.89%

|

52.14%

48.91%

|

-0.0238076

-0.0677521

|

|

Moyenne journalière -0.0278 0.0110 0.0202 -0.0458

|

4. Synthèse de la performance des

différentes stratégies par rapport au ratio Sharpe

Afin de déterminer si les résultats

précédents, qui semblent démontrer que VMA et FMA,

permettent de réaliser des profits plus élevés que ceux du

marché, reflètent la réalité, nous réalisons

une analyse des ratios de Sharpe de l'ensemble des stratégies

présentées dans cette étude. Nous pourrons ainsi montrer

si les rentabilités obtenues ne sont que la juste

rémunération d'une prise de risque plus élevée.

|

Stratégie :

|

VMA

|

FMA

|

Bollinger

(rendements 10j)

|

Bollinger

(rendements 20j)

|

B&H

|

|

Rendements journaliers moyens

|

0.00260

|

0.01782

|

-0.05296

|

-0.04578

|

-0.00025

|

|

Volatilité journalière moyenne

|

0.0158

|

0.0124

|

0.0218

|

0.0202

|

0.0159

|

|

ratio de Sharpe

|

0.1804

|

1.4527

|

-2.41 51

|

-2.2573

|

0.0000

|

Ces ratios nous indiquent sans surprise que les bandes de

Bollinger sous-performent réellement la simple stratégie d'achat

conservation. En ce qui concerne les stratégies VMA et FMA, les

résultats sont plus intéressants, et montrent une sur-performance

du marché. Ces résultats semblent en adéquation avec les

résultats de Brock, Lakonishok, & Blake (1992) et Sullivan,

Timmermann, & White (1999). Mais ces résultats sont à

nuancer, car la faiblesse du Sharpe de VMA, indique que le rendement obtenu

< 0.5 rémunère une prise de risque trop élevée

pour le rendement obtenu. Quand au fort ratio de Sharpe observé pour

FMA, nous restons mitigé, et un rééchantillonage par

bootstrap s'impose pour vérifier sa significativité.

C. Bootstrap

Afin de vérifier la significativité des

résultats semblant remettre en cause l'efficience faible des

marchés, nous nous sommes attachés à créer un

modèle de Bootstraping qui pourra sans doute nous apporter des

éléments complémentaires de réponse. En effet, le

bootstraping consiste en une méthode informatique de

rééchantillonage, sans données supplémentaires que

celles de l'échantillon de départ. Dans cette étude, le

modèle stochastique utilisé pour réaliser ce bootstrap

diffère de celui de Brock et al. (1992), qui en en ont choisi

plusieurs, soit plus simples, comme celui de la marche aléatoire, ou

plus élaborés, comme les modèles GARCH ou ARCH, dont

l'inventeur, Robert Engel, reçu un prix Nobel en 2003. La

méthodologie abordée ici différera également de

celle de Brock et al. (1992), et tendra davantage vers celle

adoptée par Sullivan, Timmermann, et White (1999). Effet,

nous analyserons les résultats ainsi que leur significativité par

rapport aux critères du ratio de Sharpe.

1. Le choix du modèle

Notre étude empirique sur l'historique des cours du

CAC40, nous a conduit à la très faible auto-corrélation

des log-rentabilités. Nous choisirons donc un modèle de formation

des prix S(k), cohérent avec la non-corrélation des

rentabilités logarithmiques R = lnS(k+1) - lnS(k). En outre, cette

représentation est cohérente avec le marché, car les prix

ne peuvent être négatifs, (le domaine de définition de la

fonction ln x est ]0,+oo[ ) et est cohérente avec l'efficience faible.

En effet, une auto corrélation des log rentabilités serait

exploitée pour tirer des profits anormaux. Comme on le sait, le TCL

(Théorème Central Limite) implique la normalité des

rentabilités logarithmiques. Malgré les limites de ce

modèle face à la réalité empirique (nous avons en

effet constaté la forte lepto-kurticité des

log-rentabilités des cours dans nos premiers résultats), c'est

celui que nous adoptons et choisissons de représenter pour notre

Bootstrap. Il a également l'avantage d'être cohérent avec

les moyennes mobiles simples utilisées dans nos tests de performances.

En effet, si les moyennes mobiles avaient été

pondérées en accordant davantage d'importance aux

dernières volatilités des cours, par des oscillateurs

pondérés ou MACD, il aurait été cohérent

d'utiliser un modèle autorégressif intégrant en plus

l'hétéroscédasticité des cours, comme le ARCH.

La représentation que nous avons choisie des

log-rentabilités est donc faite à l'aide d'un mouvement brownien

géométrique, ainsi caractérisé en temps discret

:

lnS(t+At) - lnS(t) ? AlnS=mAt+oAW avec W, un processus de Wiener,

et oAW distribué selon une N(0, o2At)

Nous choisissons d'adopter un pas de 1 entre les points de la

trajectoire, ce qui a pour but de réduire la complexité

algorithmique, car la variable t disparaît.

En passant à l'exponentielle, on obtient :

eAlnS = emAt ? oAW? elnS(k ? 1)

- lnS(k) ? em + oW

accroissements par unité de temps.

Ayant calculé nos paramètres sur

l'échantillon que constituent les cours du CAC40 sur une période

de près de 10ans, nous avons obtenu ces valeurs :

Paramètres Stochastiques

m=E(AlnS(k)) o2=var(AlnS(k)) o drift

4u

-0.000247991 0.000253348 0.01591692 -0.00012132

Puis nous avons implémenté l'algorithme suivant,

dont le code VBA Excel figure en annexe, pour un nombre n de points de la

trajectoire Brownienne géométrique souhaitée :

Fonction W

W = - 2 x Log(Random) x cos (27cx Random)

Fin

Fonction MBG

m + ox W

MBG = S0 x e

Fin

Procédure

Pour i de 1 à n

Faire

MBG

Boucler k fois `pour permettre converger en loi enregistrer

MBG

Fin Pour

Fin

Dans notre modèle algorithmique, nous avons choisi,

plutôt que d'utiliser le générateur de v.a.r gaussiennes

centrées réduites d'Excel, de concevoir personnellement un tel

générateur suivant la méthode de Box-Muller, pour ses

propriétés de convergence rapide. Il faudrait réaliser

plusieurs centaines, voir un millier d'itération pour obtenir des

résultats significatifs pour une loi gaussienne. Par cette

méthode, dans la pratique et pour obtenir des résultats

intéressants, une cinquantaine d'itérations suffisent. Aussi,

pour chaque point d'une trajectoire brownienne affiché, une cinquantaine

sont calculés.

Nous avons donc choisi pour notre bootstrap, de ne simuler

qu'une centaine de trajectoires browniennes géométriques. Cent

une, exactement. Mais ces 101 trajectoires affichées pour le calcul des

significativités correspondent à un total de 50 x 101, ie

5 050 trajectoires calculées en chaque point, à

l'issu des 101 itérations.

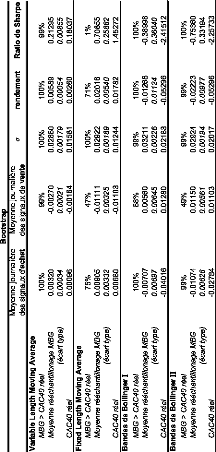

Voici 3 exemples de trajectoires obtenues avec notre

modèle Brownien géométrique (2e au 4e chart),

comparé aux cours réels (1er chart) :

CAC40 (raw)

|

8000 7000 6000 5000 4000 3000 2000 1000 0

|

|

CAC40 (SIMULATION MBG)

CAC40 (SIMULATION MBG)

CAC40 (SIMULATION MBG)

7000

6000

5000

4000

3000

2000

1000

0

8000

7000

6000

5000

4000

3000

2000

1000

0

9000

8000

7000

6000

5000

4000

3000

2000

1000

0

2. Synthèse des résultats des

différentes stratégies par rapport au ratio Sharpe

A l'issu de ce test, de nouvelles conclusions s'imposent. Tout

d'abord, les gains spectaculaires de la méthode FMA ne sont pas

significatifs. Car même si dans 71% des cas, les rendements journaliers

espérés sont supérieurs à ceux observés sur

notre échantillon initial, le ratio de Sharpe montre que dans 99% des

cas il sous performe la stratégie Buy & Hold. Ce qui semble en

accord avec l'hypothèse selon laquelle, cette méthode induit

implicitement des stratégies de moyenne à la baisse, capable de

faire gagner beaucoup, mais de mener à des catastrophes

également.

Autres résultats, les tests de Bollinger I à 10

jours, et Bollinger II à 20 jours montrent un ratio de Sharpe, certes

significativement supérieur à celui observé sur les cours

réels du CAC40, mais ce ratio reste négatif. Ce qui implique

qu'ils sous-performent systématiquement la stratégie

d'achat-conservation. Un résultat intéressant est donné

par la VMA. On peut en effet affirmer avec une erreur de 1%, relativement au

modèle de formation de prix adopté, que cette stratégie

est plus performante que la stratégie Buy & Hold. Ce qui induirait

l'invalidité de l'hypothèse nulle selon laquelle les

méthodes d'analyse technique ne permettent pas de réaliser des

profits systématique supérieurs au marché. Et là

même, invaliderait, du moins partiellement, l'hypothèse

d'efficience faible des marchés, conjointement au modèle de

formation de prix choisi. Mais l'invalidation est à nuancer et demeure

partielle pour trois raisons. La première est que nous savons que le

modèle de formation des prix n'est pas vraiment log normal. Celui-ci est

leptokurtique et hétéroscedastique. De plus, les ratios de Sharpe

montrent que les rendements anormalement élevés observés

rémunèrent simplement une prise de risque trop

élevée même pour le rendement obtenu car < 0.5. Enfin,

ces rendements finalement faibles pour la prise de risque acceptée, sont

calculés sans coûts de transaction.

CONCLUSION

L'objectif de ce mémoire était de

déterminer, si en temps de crise, l'efficience de marché pouvait

toujours être considérée comme une hypothèse

raisonnable, au sens faible de la définition donnée par Fama

(1991). Pour cela, nous avons utilisé les tests d'efficiences faibles

moyennes mobiles nommés VMA et FMA selon la terminologie de Brock et

al. (1992), et les bandes de Bollinger bornant les cours boursiers par +/-

2 écart-types. Avec différentes règles de

stratégie, notre analyse nous a conduit à tester 34

méthodes de trading différentes utilisées en analyse

technique. (2 fois 15 pour les oscillateurs, et 2 fois 2 pour les bandes

indirects que sont les outils de l'analyse technique. Nous avons ainsi

utilisé 2 oscillateurs de Bollinger) Pour évaluer les

résultats observés, nous avons utilisé un ensemble de

tests statistiques classiques, tels que les études

d'auto-corrélation des cours avec p-values, écart-types, et

autres moyennes et tests de Bartlett standard. Synthétisant ces

résultats, nous avons alors choisi de comparer les performances des

outils d'analyse technique testés à la stratégie d'achat

conservation sur l'ensemble de la période définie par

l'échantillon. L'analyse de la significativité des nos

résultats nous a alors amené à élaborer et

implémenter un modèle de formation des prix par des

méthodes de Monte-Carlo. Nous avons ainsi choisi, pour des raisons de

cohérence avec l'efficience informationnelle faible des marchés

financiers, de représenter les rentabilités logarithmiques du

CAC40 par un mouvement brownien géométrique. A partir de cela,

nous avons pu utiliser des tests statistiques non standards, le bootstrapring,

pour valider la significativité des résultats que nous avions

observés. Ces résultats ont abouti à la remise en cause

partielle de l'hypothèse nulle d'efficience informationnelle faible des

marchés financiers. Notamment par la possibilité d'obtenir des

profits anormaux et systématiques la méthode nommée VMA

par Brock et al. (1992). Cependant, l'analyse des ratios de Sharpe

nuance ce rejet de l'hypothèse nulle, en faisant ressortir que les

rentabilités obtenues sont trop faibles pour le risque accepté.

De plus, ce ratio pourrait s'inverser si les coûts de transactions

étaient intégrés aux algorithmes des méthodes

d'analyse techniques considérées.

Pragmatiquement, cette étude montre que les

stratégies de trading à partir des bandes de Bollinger 20 jours,

sont intrinsèquement vouées à l'échec. De

même, elle montre que les méthodes de trading basées sur

les croisements de moyenne mobile sur une durée fixe, FMA, sont in fine

des méthodes perdantes. Mais cette dernière remarque n'est

significative que conjointement à l'acceptation de l'hypothèse

log-normale des rentabilités boursières.

Finalement, nous ne pouvons certes pas expliquer les

rendements de la méthode VMA, mais nous pouvons les observer. Et

immanquablement, force est de constater que s'il existait des agents, ayant

utilisé cet outil technique durant toute la période

définie par l'échantillon, sur le même indice, et avec

rigueur, c'est-à-dire sans déroger à la règle,

alors ces agents auraient très certainement navigué sur

l'éclatement de la bulle internet, et sur la dernière crise des

subprimes, avec sérénité en engrangeant des

bénéfices bien supérieurs au marché nonobstant les

coûts de transaction. En effet, nous l'avons dit, dans notre

étude, toutes les stratégies adoptées sont à

coût de transaction nulle. Et c'est là une critique acceptable.

Mais au-delà de celle-ci, le problème soulevé est celui de

la rationalité des agents, déjà évoqué par

Orléan (2008). Et des études visant à mesurer leur impact

seraient un prolongement naturel à cette étude concluant à

l'inefficience faible des marchés. Il faudrait pour cela réaliser

des tests de stratégies d'analyse techniques, basées entre autres

sur les volumes de trading et des coûts de transactions non nuls. Mais

implémenter de telles stratégies informatiquement n'est pas

aisé, même si des travaux comme ceux réalisés par

Lo, Harry, & Wang (2000) permettent déjà d'avancer dans ce

sens.

ANNEXES

Calculs réalisés à l'aide du

logiel R

http://www.u707.jussieu.fr/biostatgv/tests.ph

p(1) p(2)

Résultats Résultats

Student, t : 0.01 83 Student, t : 0.0715

Degre de liberte : 4779.996 Degre de liberte : 4777.99

P value = 0.9854 P value = 0.943

Intervalle de confiance à 95% : Intervalle de confiance

à 95% :

-0.0008935384 0.0009103957 -0.0008687800 0.0009345941

Statistique de la variable 1 : Statistique de la variable 1 :

|

Minimum

|

1er quartile

|

Médiane

|

Moyenne

|

3ème quartile

|

|

-7.73E-03

|

9.50E-05

|

-2.30E-04

|

7.63E-03

|

1.06E-01

|

|

Minimum

|

1er quartile

|

Médiane

|

Moyenne

|

3ème quartile

|

|

-0.007709

|

0.000108

|

-0.000216

|

0.00763

|

0.1059

|

n : 2391 n : 2390

Somme : -0.5508471 Somme : -0.5163521

Variance : 0 Variance : 0

Ecart type : 0.02 Ecart type : 0.02

Statistique de la variable 2 : Statistique de la variable 2 :

|

Minimum

|

1er quartile

|

Médiane

|

Moyenne

|

3ème quartile

|

|

-0.008

|

0

|

-0.000239

|

0.008

|

0.106

|

|

Minimum

|

1er quartile

|

Médiane

|

Moyenne

|

3ème quartile

|

|

-0.008

|

0

|

-0.000249

|

0.008

|

0.106

|

n : 2391 n : 2390

Somme : -0.571 Somme : -0.595

Variance : 0 Variance : 0

Ecart type : 0.02 Ecart type : 0.02

p(3) p(4)

Résultats Résultats

Student, t : 0.0801 Student, t : 0.0662

Degre de liberte : 4775.99 Degre de liberte : 4773.987

P value = 0.9362 P value = 0.9472

Intervalle de confiance à 95% : Intervalle de confiance

à 95% :

-0.0008651862 0.0009389095 -0.0008718485 0.0009327983

Statistique de la variable 1 : Statistique de la variable 1 :

|

Minimum

|

1er quartile

|

Médiane

|

Moyenne

|

3ème quartile

|

|

-0.007709

|

0.000121

|

-0.000214

|

0.007631

|

0.1059

|

|

Minimum

|

1er quartile

|

Médiane

|

Moyenne

|

3ème quartile

|

|

-0.007719

|

0.000108

|

-0.000221

|

0.007627

|

0.1059

|

n : 2389 n : 2388

Somme : -0.51 09376 Somme : -0.5272259

Variance : 0 Variance : 0

Ecart type : 0.02 Ecart type : 0.02

Statistique de la variable 2 : Statistique de la variable 2 :

|

Minimum

|

1er quartile

|

Médiane

|

Moyenne

|

3ème quartile

|

|

-0.008

|

0

|

-0.000251

|

0.008

|

0.106

|

|

Minimum

|

1er quartile

|

Médiane

|

Moyenne

|

3ème quartile

|

|

-0.008

|

0

|

-0.000251

|

0.008

|

0.106

|

n : 2389 n : 2388

Somme : -0.599 Somme : -0.6

Variance : 0 Variance : 0

Ecart type : 0.02 Ecart type : 0.02

p(5)

Résultats

Student, t : 0.0271

Degre de liberte : 4771.989 P value = 0.9784

Intervalle de confiance à 95% :

-0.0008898970 0.0009148066

Statistique de la variable 1 :

|

Minimum

|

1er quartile

|

Médiane

|

Moyenne

|

3ème quartile

|

|

-7.73E-03

|

9.50E-05

|

-2.29E-04

|

7.63E-03

|

1.06E-01

|

n : 2387

Somme : -0.5462703 Variance : 0

Ecart type : 0.02

Statistique de la variable 2 :

|

Minimum

|

1er quartile

|

Médiane

|

Moyenne

|

3ème quartile

|

|

-0.008

|

0

|

-0.000241

|

0.008

|

0.106

|

n : 2387

Somme : -0.576 Variance : 0

Ecart type : 0.02

Code Excel de l'implémentation du mouvement

brownien

Une version commentée du code est jointe au mémoire

au format Excel :

Option Explicit

Dim n As Integer, i As Integer, k As Byte

Dim m as Double, sigma As Double, S0 As Double

Function W()

W = Sqr(-1 * 2 * Log(Rnd)) * Cos(2 * Application.Pi * Rnd)

Randomize

End Function

Function MBG()

m = Cells(2, 4)

sigma = Cells(2, 5)

S0 = Cells(i - 1, 3)

MBG = S0 * Exp(m + sigma * W) End Function

Sub TrajectoireBrownienne () n = 2400

For i = 9 To n

k = 1

Do

Call MBG

k = k + 1

Loop Until k = 50

Cells(i, 3) = MBG

Next

End Sub

REFERENCES BIBLIOGRAPHIQUES

BROCK, W., LAKONISHOK J., ET LEBARON B. (1992). « Simple

Technical Trading

Rules and the Stochastic Properties of Stock Returns »,

The Journal of Finance, Vol. 47, No. 5, pp. 173 1-1764

COHEN, D. (2006). Trois leçons sur la

société post-industrielle, La République des

Idées, Seuil

CHO, D.C., EUN C.S. ET SENBET L.W. (1986). « Empirical

Investigation », The Journal of Finance, Vol. 41, No. 2, pp. 3

13-329

CONT, R. (2009). « Risques financiers : quelle

modélisation mathématique ? », Pour la Science No.

375, janvier 2009, p. 24

DHRYMES, J., FRIEND I. ET GULTEKIN M.N. ET GULTEKIN N.B.

(1985). « New Tests of the APT

and Their Implications », The Journal of Finance,

Vol. 40, No. 3, pp. 659-674 DOUADY, R. (2009). « Les maths et la crise :

« La finance manque de lanceurs d'alerte » »,

Sciences et Avenir No. 743, janvier 2009, p.

74

EL KAROUI, N. (2004). Couverture des risques dans les

marchés financiers, Cours Master 2 Mathématiques, Option

Finance, Université Paris VI

EVEN, W. E. et NOBLE N. R. (1992). « Testing Efficiency in

Gambling Markets », Applied Economics, Vol. 24, pp.

85-88

FAMA, E.F. (1965). « The Behavior of Stock Market Prices

», Journal of Business, Vol. 38, No. 1, pp. 31-105.

FAMA, E.F. (1968). « Risk, Return and Equilibrium: Some

Clarifying Comments », The Journal of Finance, Vol. 23, No. 1,

pp. 29-40

FAMA, E.F. (1970). « Efficient Capital Markets: A Review of

Theory and Emprical Work », The Journal of Finance, Vol. 25, No.

2, pp. 3 83-417.

FAMA, E. F. ET MACBETH J. D. (1973). « Risk, Return, and

Equilibrium: Empirical Tests », The Journal of Political Economy,

Vol. 81, No. 3, pp. 607-636

FAMA, E.F. (1991), « Efficient Capital Markets: II »,

Journal of Finance,

Vol. 46, No. 5, pp. 1575-1617.

FRANK, J. (1999). « Applying memetics to financial markets:

Do markets evolve towards efficiency? », Journal of Memetics -

Evolutionary Models of Information Transmission, Vol. 3 Issue 2, pp

1-15.

GOFFIN, R. (2008). Principes de Finance Moderne,

Economica

JENSEN, M.C. (1978). « Some Anomalous Evidence Regarding

Market Efficiency»,

Journal of Financial Economics, Vol. 6, pp. 95-101.

JENSEN, M.C. ET BENINGTON G.A. (1970). « Random Walks and

Technical Theories:

Some Additional Evidence », The Journal of Finance,

Vol. 25, No. 2, pp. 469-482 LARDIC,S. et MIGNON V. (2006). L'efficience

informationnelle des marchés financiers,

Repères, La Découverte, Paris.

LEROY, S.F. (1982). « Expectations Models of Asset Prices: A

Survey of Theory », Journal of Finance, Vol. 37, pp. 185-217.

LO, A.W., MAMAYSKY H. ET WANG J. (2000). « Foundations of

Technical Analysis: Computational Algorithms, Statistical Inference, and

Empirical Implementation », The Journal of Finance, Vol. 55, No.

4, pp. 1705-1765

LUCAS, R.E. JR. (1978). « Asset Prices in an Exchange

Economy », Econometrica, Vol. 46, No. 6, pp. 1429-1445.

LYON, J.D., BARBER B.M., TSAI C. (1999). « Improved Methods

for Tests of Long-Run

Abnormal Stock Returns », The Journal of Finance,

Vol. 54, No. 1, pp. 165-201 MANDELBROT, B. (2009). Fractales, hasard et

finance, Champs, Flammarion

MERTON, R. C. (1986). « A Simple Model of Capital Market

Equilibrium with Incomplete

Information », The Journal of Finance, Vol. 42, No.

3, pp. 483-5 10

MILLET, A. (2008). Calcul Stochastique 2, Cours Master 2

Mathématiques Appliquées à l'Economie et à la

Finance, Spécialité Modélisation et Méthodes

Mathématiques en Economie et Finance, Université Paris I

MILLET, A. (2008). Méthodes de Monte-Carlo, Cours

Master 2 Mathématiques, Spécialité Modélisation

Aléatoire, Université Paris VII et Paris I

NICHOLAS TALEB, N. (2008). Le Cygne Noir. La puissance de

l'imprévisible, Belles Lettres ORLEAN, A. (2008). Les

marchés financiers sont-ils rationnels ? In P. Askenazy et D. Cohen

(Eds.), Vingt sept questions d'économie contemporaine

(pp. 63-85), Economiques,

Albin Michel

OSLER, C.L. (2003). « An Explanation for the Predictive

Success of Technical Analysis », The Journal of Finance, Vol. 58,

No. 5, pp. 1791-1819

PORTRAIT, R. ET PONCET P. (2008). Finance de marché -

Instruments de base, produits dérivés, portefeuilles et

risques, Dalloz

SEHGAL, S. ET GUPTA M. (2007). « Tests of Technical Analysis

in India », The Journal of Business Perspective, Vol. 11, No. 3,

pp.1 1-23

SHILLER, R.J. (1981). « The Use of Volatility Measures in

Assessing Market Efficiency », The Journal of Finance, Vol. 36,

No. 2, pp. 29 1-304

SULLIVAN R., TIMMERMANN A., WHITE H. (1999). «

Data-Snooping, Technical Trading Rule Performance, and the Bootstrap »,

The Journal of Finance, Vol. 54, No. 5,

pp. 1647-1691

TABLE DES MATIERES

INTRODUCTION p4

I. L'Efficience informationnelle des Marchés

Financiers p6

A. Définition p6

B. Les tests d'efficience p7

1. L'Efficience forte et semi forte p7

2. L'Efficience faible p8

a. Les tests directs p8

b. Les tests indirects p9

II. Analyse empirique de la performance de

méthodes simples d'analyse technique, et

propriétés stochastiques des prix de

marchés. p13

A. Données et stratégies de trading par

Analyse Technique p14

1. Les données p13

2. Les stratégies d'analyse technique

utilisées p13

a. Les Moyennes Mobiles oscillantes p14

b. Les Bandes de Bollinger p19

B. Résultats empiriques : Tests traditionnels

p21

1. Statistiques de l'échantillon p21

a. Corrélations intermarchés

p21

b. Résumé statistique de

l'échantillon étudié : indice CAC40 sur une

dizaine d'année p23

2. Résultats de la stratégie des moyennes

mobiles oscillantes p24

3. Résultats de la stratégie des bandes de

Bollinger p28

4. Synthèse de la performance des

différentes stratégies par rapport au ratio

Sharpe p29

C. Bootstrap p29

1. Le choix du modèle p30

2. Synthèse des résultats des

différentes stratégies par rapport au ratio Sharpe

p34

CONCLUSION p36

ANNEXES p38

REFERENCES BIBLIOGRAPHIQUES p41

TABLE DES MATIERES p44

RESUME ET ABSTRACT p45

RESUME ET ABSTRACT

Ce mémoire a pour but de tester l'efficience faible des

marchés au moyen de l'analyse technique et conjointement avec

l'hypothèse stochastique de formation des prix.

This paper has the purpose to test market efficiency under

Technical Analysis rules, jointly with the stochastic hypothesis of stock

returns shaping.

|