SECTION 2 : LES MESURES RÉGLEMENTAIRES DU RISQUE

OPÉRATIONNEL SELON BÂLE II

La mesure du risque opérationnel correspond à

une valeur en risque, similaire dans son principe à celle

calculée dans les domaines du risque de marché et du risque de

crédit. Elle doit donc couvrir à la fois les pertes attendues

(expected loss) et les pertes exceptionnelles (unexpected loss). Pourtant, en

théorie, les fonds propres réglementaires ne couvrent que les

pertes exceptionnelles et non les pertes moyennes, ces dernières

étant censées être couvertes par des provisions ou

imputées sur le résultat courant. Le Comité de Bâle

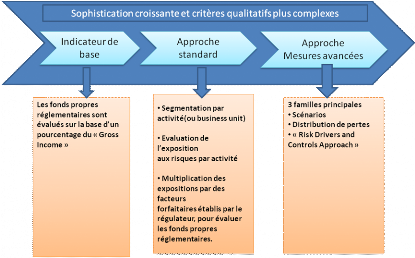

propose trois approches distinctes pour déterminer le capital

réglementaire au titre du risque opérationnel :

· L'approche indicateur de base (Basic Indicator Approach

ou BIA)

· L'approche standard (Standardised Approach ou SA)

· Les approches de mesures avancées (Advanced

Measurement Approach ou AMA).

Les banques ont la possibilité de choisir celle qui

leur paraît correspondre le mieux à la spécificité

de leur activité, mais aussi à leur capacité globale

d'action. Elles doivent en effet s'assurer qu'elles disposent de l'ensemble des

moyens nécessaires à la mise en oeuvre de la solution retenue. Le

degré de sophistication de chacune de ces trois méthodes est en

effet croissant.

1. L'approche de l'indicateur de base :

Selon l'approche de l'indicateur de base (basic indicator

approch ou BIA), le capital réglementaire en couverture du risque

opérationnel est égale à un pourcentage, appelé

facteur alpha, égale à 15% du revenu annuel brut moyen de

l'établissement sur les trois dernières années. Celui-ci

se définit comme la somme des intérêts créditeurs

nets et autres produits d'exploitation. Il exclut les provisions, les plus ou

moins values liées au portefeuille-titres, et les éléments

exceptionnels.

La règle peut donc être exprimée de

l'équation suivante :

K= á. RB

Avec k le capital réglementaire, RB est le revenu brut

et á = 15%

Selon cette approche très simplifiée, l'ampleur

du risque opérationnel est une fonction positive du volume des

activités, dont les différents éléments du revenu

annuel brut sont ici des estimateurs. Les données de revenus,

directement puisées dans la comptabilité officielle, ont

l'avantage d'être disponible pour toutes les institutions, à la

différence d'autres indicateurs plus complexes.

Le taux de 15% a été retenu suite aux deux

premières études quantitatives d'impact réalisées

lors du calibrage de l'accord.

En effet il apparait qu'en moyenne 15% du revenu annuel brut

représente le montant cible de capital réglementaire

opérationnel, pour les 29 établissements ayant répondu aux

premières études quantitatives d'impact lancées par le

comité en mai 2001.

L'approche de l'indicateur de base vie spécifiquement

les plus petits établissements, les petites structures de banques

locales ou filiales, de moindre importance, d'autres grands

établissements, pour lesquelles les quelles le cout de mise en place

d'approches plus élaborées serait prohibitif ou

économiquement déraisonnable.

2. L'approche standard:

L'approche standard est en fait un prolongement plus fin de

la BIA en déclinant ce type de calcul par type d'activité.

Le capital réglementaire est ici fonction d'un

pourcentage du produit brut, appelé facteur béta, établi

à 12%, 15%, ou18% selon le niveau du risque opérationnel

estimé de chaque activité.

Cela se traduit par la règle suivante :

K = Ó kLI = Ó âLI . RBLI

Avec kLI représente le capital réglementaire

associé à la ligne i, RBLI est le revenu brut de la ligne

correspondante, et âLI est le coefficient associé.

L'approche standardisée permet en outre de prendre en

compte la nature de l'activité de l'institution.

Ainsi une institution dont l'activité se concentre sur

les opérations les moins risquées ou bénéficiera

d'une charge en capital moindre que celle présente dans tous les types

d'activités ou dans les plus risquées.

Le tableau ci-dessus détaille les lignes

d'activités et les pourcentages de revenus correspondants pour le calcul

du capital réglementaire.

|

Catégories d'activité

|

Taux â

|

|

Financement des entreprises

|

18%

|

|

Négociation et vente

|

18%

|

|

Banque de détail

|

12%

|

|

Banque commerciale

|

15%

|

|

Fonction d'agent

|

18%

|

|

Paiement et règlement

|

15%

|

|

Gestion d'actifs

|

12%

|

|

Courtage de détail

|

12%

|

Tableau 1 : Facteur béta par ligne

d'activité- approche standardisé

Les taux de calcul du capital réglementaire

proviennent de la deuxième étude quantitative d'impact, portant

sur 29 établissements, ceux qui ont répondu à

l'enquête lancé par le comité de Bâle.

A propos des méthodes standard et des coefficients

béta, le comité reste d'ailleurs prudent, en précisant

que : « une banque doit élaborer des politiques

spécifiques et disposer de critères consignés par

écrit pour mettre en correspondance le produit brut des diverses

catégories d'activité et unités avec le dispositif

standardisé. Les critères doivent faire l'objet d'un examen et

d'un ajustement, selon les besoins, de façon à intégrer

les innovations/changement d'activité et de modification des

risques ».

D'autre par on a Approche standard alternative

et que selon le comité de Bâle : L'autorité

de contrôle nationale peut, à sa discrétion, autoriser un

établissement à appliquer l'approche standard alternative (ASA),

à condition qu'il puisse démontrer que celle-ci apporte une

amélioration, permettant par exemple d'éviter un double comptage

des risques. Une fois qu'il aura adopté une approche ASA,

l'établissement ne pourra pas revenir à l'approche standard sans

l'autorisation de son autorité de contrôle. Il n'est pas

envisagé de permettre aux grosses banques détenant des

portefeuilles diversifiés sur les principaux marchés d'utiliser

l'approche ASA.

Aux termes de l'ASA, l'exigence de fonds propres au titre du

risque opérationnel et sa méthodologie de calcul sont identiques

à celles de l'approche standard, sauf pour deux lignes de métier

: banque de détail et banque commerciale. Pour celles-ci, les

prêts et avances - multipliés par un facteur fixe « m »

- sont utilisés au lieu du produit brut comme indicateur de risque ; les

bêta sont identiques à ceux de l'approche standard. L'exigence de

fonds propres ASA au titre du risque opérationnel pour opérations

de détail (la formule de base étant identique pour

l'activité de banque commerciale) est exprimée de la façon

suivante :

KNI = âNI x m x

PANI

Où KNI correspond à l'exigence de fonds propres

pour l'activité de détail âNI correspond au bêta pour

l'activité de détail, PANI correspond au total de l'encours des

prêts et avances à la clientèle de détail (non

pondérés des risques et avant déduction des provisions),

calculé en moyenne sur les trois années écoulées m

est égal à 0,035.

Aux fins de l'ASA, le total des prêts et avances dans

l'activité de détail comprend l'ensemble des montants

tirés sur les portefeuilles de crédit suivants : détail ;

PME assimilées à la clientèle de détail ;

acquisition de créances sur la clientèle de détail. Pour

la banque commerciale, le total des prêts et avances comprend les

montants tirés sur les portefeuilles de crédit suivants :

entreprises ; emprunteurs souverains ; banques ; financement

spécialisé ; PME assimilées aux entreprises ; acquisition

de créances sur les entreprises. La valeur comptable des titres

détenus dans le portefeuille bancaire doit également être

incluse.

En appliquant l'ASA, les banques de détail et

commerciales, si elles le désirent, peuvent agréger leurs

activités de détail et de banque commerciale, en leur affectant

un bêta de 15 %. De même, les banques qui ne sont pas en mesure

d'affecter le produit brut aux six autres lignes de métier peuvent

agréger le produit brut total correspondant et lui appliquer un

bêta de 18 %, le produit annuel brut étant traité

conformément au paragraphe 654.

Comme dans l'approche standard, l'exigence de fonds propres

totale ASA représente la somme des exigences de fonds propres pour

chacune des huit lignes de métier.

3. Les approches de mesures

avancées :

Il ne s'agit plus d'une approche

unique, définie par le régulateur, mais d'un ensemble de

modèles internes réunies sous le vocable « d'approche

de mesures complexes » ou AMC (Advanced measurement approch ou AMA)

approuvé par les autorités de contrôle sur la base d'une

série de critère.

Selon l'AMa, l'exigence de fonds propres réglementaire

équivaut à la mesure du risque opérationnel produite par

le système interne de la banque, sur base de critères

quantitatifs et qualitatifs.

Le Comité de Bâle propose plusieurs alternatives

au sein du régime AMA : la méthode Scorecard, l'analyse de

scénarios (Scenario-based AMA), et enfin, la méthode LDA (Loss

Distribution Approach), la plus sophistiquée au plan technique. La

pratique de chacune de ces méthodes est soumise au respect d'un ensemble

de critères qualitatifs, notamment en termes d'évaluation du

risque opérationnel et de procédure de collecte des

données de perte. C'est là leur dénominateur commun. Sur

le fonds, la différence concerne essentiellement le type d'information

privilégié dans le calcul du capital réglementaire.

Les accords de Bâle II n'imposent aucune méthode

particulière de calcul pour les banques adoptant l'approche de mesures

complexes (AMA). Ce choix est laissé à la discrétion des

banques, pourvu qu'elles satisfassent aux critères qualitatifs et

quantitatifs énoncés dans l'accord.

Deux principales méthodologies sont utilisées

pour le déploiement de ces approches de mesures avancées.

v La méthodologie Top -DOWN :

La méthodologie Top down donne une estimation

du risque opérationnel sur la base des variations historiques des

résultats après intégration de facteurs tels que

l'évolution de l'activité où le coût lié aux

changements. L'hypothèse sous-jacente est que les pertes historiques

sont une bonne mesure des pertes futures.

Dans cette approche, certaines banques ont tendance

à évaluer l'exigence de fonds propres pour le risque

opérationnel en prenant simplement un pourcentage d'un indice

d'activité comme le produit brut bancaire.

D'autres estiment le risque opérationnel selon un

pourcentage fixe correspondant aux coûts opérationnels de

l'établissement où de la ligne métier. La Bank of America

prend par exemple 25 % des coûts fixes et 50 % des dépenses autre

que les intérêts versés.

Selon cette approche, on peut envisager un

schéma dans lequel le montant alloué en fonds propres pour

couvrir le risque opérationnel serait égal :

Indice d'activité * multiplicateur de la ligne

d'activité*k

Avec k est un score représentant l'environnement.

Cette approche présente l'avantage de sa

facilité à mettre en place, une fois que l'élément

inconnu de volatilité des résultats historiques des

activités est résolu. Toutefois elle présente une faible

valeur analytique ; un rapport difficile à établir entre perte

et revenu variable et entre risque opérationnel et revenu variable.

On peut dire que les modèles proposés par cette

méthode ne sont pas propices à la mise en oeuvre d'un

contrôle interne, d'où son ignorance à la qualité

du contrôle. Dans ce cadre et pour mieux maîtriser le risque

opérationnel les établissements s'orientent d'avantage vers des

approches à forte valeur ajoutée type " Bottom Up ".

v Méthodologie Bottom -Up :

Les modèles Bottom -Up correspondent à

une approche structurelle dans laquelle l'identification, l'évaluation

des pertes et risques sont définis à l'intérieur de la

banque en fonction de la logique de comportement, en séparant tout ce

qui peut provenir des personnes, des processus et de la technologie.

En effet, lors d'une telle approche, chaque

opération est analysée de son initiation jusqu'à sa

comptabilisation. A chaque étape les tâches et contrôles

clés sont décrits, testés et évalués.

Le recensement et l'évaluation des risques

opérationnels se faisant selon une cartographie (zones

géographiques, ligne métier, entité, activité et

productivité) qui se décline de la plus globale à la plus

exhaustive.

Cette approche apparaît plus utile pour comprendre la

nature du risque opérationnel et pour permettre un contrôle

interne. Elle est à forte valeur ajoutée car elle intègre

des cartographies des risques opérationnels liés aux

activités et processus comprenant l'identification, l'analyse et

l'évaluation des risques.

Elle permet de contribuer à la connaissance

des risques opérationnels au niveau des activités, et au

changement comportemental des différents acteurs et notamment les

opérationnels.

Toutefois elle présente l'inconvénient

de la subjectivité et la consistance des évaluations.

Les approches de mesures avancées sont :

3.1. La Loss Distribution Approach :

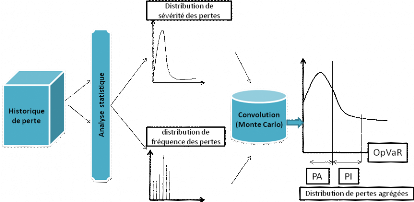

L'idée de base de LDA est assez simple : on

considère que la perte annuelle totale d'une banque due au risque

opérationnel se compose de deux éléments, la

fréquence et la sévérité. Chacune se

présente sous la forme d'une distribution statistique. La distribution

de fréquence représente l'occurrence d'événements

de pertes opérationnelles, c'est-à-dire le nombre de pertes

observées. La distribution de sévérité traduit

quant à elle l'amplitude de ces pertes, à savoir le montant, en

unités monétaires, des pertes individuelles subies par la banque.

L'idée générale de la méthode LDA

(Loss Distribution Approach) est de modéliser la perte liée au

risque opérationnel pour une période donnée (par exemple,

un an) et d'en déduire la valeur en risque. Frachot et al. (2003)

proposent de procéder en cinq étapes pour implémenter

cette méthode :

- Estimation de la distribution de

sévérité ;

- Estimation de la distribution de la fréquence ;

- Calcul de la charge en capital;

- Calcul des intervalles de confiance;

- incorporation des avis d'experts.

Pour cette approche on ne va pas entrer dans la formulation

mathématique de ces différentes étapes, mais simplement de

comprendre l'idée générale de la méthode LDA.

A l'instar de la plupart des modèles de mesure du

risque opérationnel, la LDA se fonde sur une approche actuarielle

(fréquence/sévérité) très ancienne largement

utilisée dans le domaine de l'assurance pour modéliser des

problèmes similaires.

Pour que le modèle LDA puisse tourner, il faut lui

fournir deux éléments essentiels : la distribution de la

sévérité des pertes (loss severity distribution) et la

distribution de la fréquence des pertes (loss frequency distribution).

Ces deux distributions, qui forment l'historique des pertes, sont ensuite

combinées par une technique statistique

appelée « convolution »(Monte Carlo) afin

d'obtenir la distribution de la perte totale. Celle-ci étant le

résultat de plusieurs pertes successives, il s'agit d'une perte

agrégée (aggregate loss distribution).

A partir de la perte totale, on dérive ensuite la perte

attendue ou moyenne (expected loss) et la perte exceptionnelle (unexpected

loss), pour un niveau de confiance donné. La Figure 5 illustre le

principe de la méthode LDA.

Figure 4: La Méthode Loss distribution Approach

(LDA)

L'accord stipule que « un établissement doit

faire la preuve que sa mesure du risque opérationnel répond

à un critère de solidité comparable à celui de

l'approche NI pour le risque de crédit (correspond a une période

de détention d'un an et à un intervalle de confiance de 99,

9éme percentile de la distribution de perte agrégées). On

utilise souvent cette notion en matière de gestion des risques

financiers sous le terme de Valeur-au-risque avec un intervalle de confiance de

99,9%.

Afin de différencier le risque opérationnel du

risque de marché ou ce terme est né, nous utiliserons la

terminologie « valeur-au-risque opérationnel »

ou OpVaR.

Le comité de Bâle a décomposé les

OpVaR en deux éléments : la perte attendues PA et les

pertes inattendues(PI).

3.2. L'approche Scorecard :

L'appellation « scorecard » regroupe un

ensemble d'approche visant à identifier, mesurer et surveiller les

risques opérationnels. Ces approches traduisent une évaluation

qualitative des risques et des contrôles en une valeur numérique

ou score.

L'un des objectifs poursuivis par les banques ayant

développé et implémenté une approche Scorecard est

de se doter d'un outil permettant de faire le lien entre la mesure et la

gestion du risque opérationnel.

Les grandes étapes de mise en oeuvre de la

démarche scorecard sont les suivantes :

Evaluation du capital initial en se basant sur une autre

approche : celle-ci pourrait être l'approche LDA, l'approche des

scénarios, l'utilisation du benchmarking ou une méthode

forfaitaire. Il est crucial à ce stade de considérer ce capital

initial crédible.

Définition de la structure de la scorecard et sa mise

en oeuvre, permettant d'aboutir à un score pour chaque catégorie

de risque et pour chaque ligne de service.

Allocation du capital initial aux lignes de service sur base

du score et donc des performances de l'organisation en matière de

maitrise du risque opérationnel. Par la suite, le capital alloué

à chaque ligne de service va varier en fonction de l'évolution

des résultats de scorecard. Dans cette approche, le capital initial

n'est pas recalculé à chaque évaluation.

Conformément aux exigences du comité de

Bâle, les données internes ont également un rôle

à jouer dans l'approche scorecard.

Ces données internes et externes sont utilisées

à plusieurs niveaux. En effet, elles peuvent être utilisées

de la détermination du capital initial en utilisant une approche de

distribution de pertes.une autre utilisation intéressante de ces pertes

est leur analyse afin d'identifier les facteurs de risques ayant amené

à la réalisation de ces pertes est leur analyse afin d'identifier

les contrôles internes permettant de réduire l'impact ou de

contrôler les facteurs de risque identifiés.

Une fois la scorecard établie et utilisée, les

pertes internes et externes peuvent etre utilisées afin de valider la

qualité des réponses apportées aux questionnaires. De

plus, leur analyse régulière permet de s'assurer que les risques

et facteurs de risque associés sont actualisés, ce qui permet de

prendre en compte l'apparition de nouveaux facteurs de risque dans l'anlyse. La

validation des résultats de la scorecard avec des donnés

objectifs est importante, compte tenu des nombreux éléments

subjectifs intervenant dans sa construction.

Le Comité de Bâle n'a fourni aucune formulation

mathématique pour cette approche. Néanmoins, les groupes de

travail au sein des banques ont proposé des formules de calcul du

capital réglementaire (K) de la forme :

KScorecard = EIij × ùij × RSij

Avec EI l'indicateur d'exposition (Exposure Indicator), RS le

score de risque (Risk Score) et ù un facteur d'échelle (Scale

Factor).

3.3. L'approche par les scenarios :

L'approche scénarios est en fait un prolongement de

l'approche scorecard. Le risque y est envisagé comme une combinaison de

la sévérité et de la fréquence des pertes

potentielles sur une période donnée. La fréquence et la

sévérité (potentielles) de la perte peuvent être

mesurées en unités monétaires et en nombre d'occurrences

annuelles. Le risque reflète en quelque sorte la

vulnérabilité de la banque. L'évaluation du risque devrait

par conséquent se focaliser sur les vecteurs de cette

vulnérabilité. Or, celle-ci provient pour l'essentiel des

facteurs de risque sous-jacents. Réduire le niveau de risque

opérationnel impose donc une bonne lisibilité de l'exposition du

portefeuille de la banque aux différents facteurs de risque

préalablement définis.

L'un des objectifs de l'utilisation de cette approche dans la

quantification des risques opérationnels est de fournir une

évaluation prospective du risque opérationnel.

En fait, on pourrait considérer que l'évaluation

du risque est intrinsèquement liée à l'analyse de

scénarios, qui s'applique d'ailleurs également aux risques de

marché et de crédit.

De manière générale, les

scénarios sont des événements susceptibles de se produire

dans l'avenir. Ils expriment l'idée selon laquelle les experts d'une

banque ont certaines intuitions ou des informations sur le risque qui ne sont

pas contenues dans l'historique de données. Pour être

réellement utile à des fins de décision en matière

de risque, une analyse de scénarios doit être en mesure de

répondre à ces deux questions : à quelle fréquence

le scénario X est-il susceptible de se produire ? Quel est le montant de

la perte si le scénario X se produit ?

L'axe principal de développement de cette approche est

le développement et l'évaluation des scénarios, ces

derniers doivent permettre d'évaluer les deux paramètres

caractérisant le risque : la fréquence et la

sévérité potentielle d'un événement

générateurs de pertes.

Cette évaluation nécessite la constitution de

scénarios, chaque scénario prenant en considération

l'ensemble des facteurs de risque opérationnel.

Parmi les facteurs de risque opérationnel les plus

courant, on recense le niveau de compétence/qualification du personnel,

l'organisation interne/transferts d'information, l'infrastructure IT (

sécurité des systèmes), les procédures de

contrôle des activités non autorisées/vol et fraude/erreurs

non intentionnelles ( saisie, exécution et suivi des transactions), les

mesures de protection contre des catastrophes et autres sinistres, ou encore,

le respect des obligations légales ( conformité, diffusion

d'informations et devoir fiduciaire).

En considérant ces différents

éléments, la banque va donc générer des

scénarios sous forme de questions « what if ».

Pour chaque scénario, l'évaluateur

considère plusieurs hypothèses, dont par exemple un cas normal,

un cas extrême et un cas catastrophique.

En effet, les scénarios vont se construire en fonction

de l'organisation de la banque et de la catégorisation

d'événement de pertes. Les facteurs de risque et les indicateurs

de risque associés serviront de contexte et de base a

l'évaluation des scénarios.

Figure 5 : Les approches de mesure du risque

opérationnel

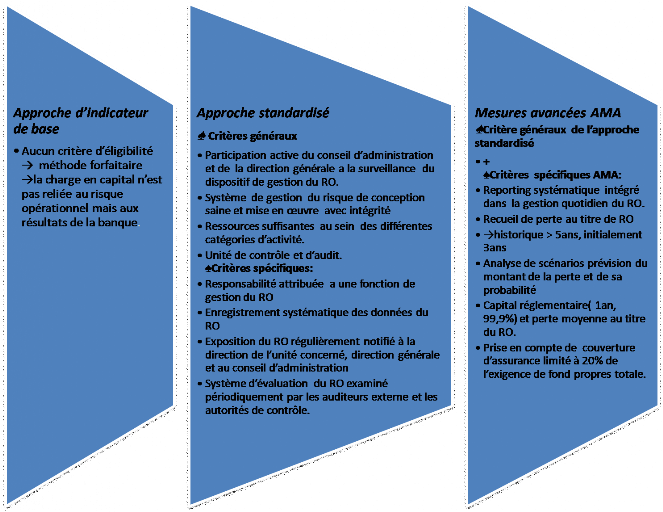

4. Les critères d'agrément pour l'approche

standard et l'approche de mesure avancées :

Les critères généraux sont identiques par

définition entre les différents approches. Les critères

qualitatifs sont quant à eux similaires entre les approches

standardisé et complexes, qu'il est préférable de les

présenter conjointement.

Ils sont relatifs aux modes d'organisation de la gestion des

risques, et représentent en réalité une version

synthétique du document « sound practices for the

management and supervision of operational risk »qui complète

le premier pilier en matière de risques opérationnels. Il vise

à assurer un niveau minimum en matière de risques.il est

applicable à l'ensemble des établissements, indépendamment

de l'approche choisie. Seuls les critères quantitatifs d'agrément

sont propres aux approches complexes.

v Critères

généraux :

Ces critères doivent être rencontrés par

toutes les institutions, quelle que soit l'approche adoptée :

· Participation active du top management de

l'établissement (conseil d'administration et direction

générale) à la surveillance du dispositif de gestion du

risque opérationnel.

· Intégrité dans la mise en oeuvre d'un

système sain de gestion des risques.

· Allocation de ressources suffisantes par rapport

à l'approche choisie dans les unités principales et à

l'audit interne.

v Critères qualitatifs :

Ces critères s'appliquent pour l'approche

standardisé lorsqu'elles sont mises en oeuvre par des banques actives

au niveau international, ainsi que pour l'approche de mesures

complexes :

Définition des rôles : les

fonctions et les responsabilités des gestionnaires des risques

opérationnels doivent être clairement définies et

attribuées. Ils sont responsables de la conception et de la mise en

oeuvre du système d'identification, de mesure, de surveillance,

d'atténuation et de notification du risque opérationnel au sein

de la banque.

Collecte des données : la banque

doit enregistrer systématiquement les pertes significatives par

catégorie d'activité. Ces informations doivent tenir une place

prépondérante dans la notification des données sur les

risques dans les rapports adressés à la direction. La banque doit

disposer de techniques permettant d'inciter à une meilleure gestion du

risque opérationnel dans l'ensemble de l'établissement.

Notification et documentation :

L'exposition aux risques et notamment les pertes importantes

doivent faire l'objet d'une notification régulière au top

management. Le système de gestion et les procédures doivent faire

l'objet d'une documentation correcte et complète au sein de la

banque.

Révision périodique : les

processus de gestion feront l'objet d'une validation et d'un examen

périodique par les auditeurs externes et/ou les autorités de

contrôles.

5. Critères quantitatifs propre à

l'approche des mesures avancées :

v Critères de

solidité :

Le comité de Bâle s'abstient

délibérément de préciser l'approche, les

hypothèses ou les distributions a utilisé pour quantifier le

risque opérationnel.

Sa seule exigence est que la banque apporte la preuve que sa

mesure du risque opérationnel présente une robustesse suffisante

pour couvrir les pertes avec un intervalle de confiance de 99,9%. En d'autre

terme le capital réglementaire doit être suffisant pour couvrir

les pertes dans 99, 9% des cas possible.

v Critères spécifique :

· Le système de mesure interne des risques doit

couvrir la totalité des types d'événements de risque

opérationnel définis par le comité.

· La banque doit calculer les fonds propres suffisants

pour couvrir ses pertes anticipées ou attendues et ses pertes

inattendues, sauf si elle fait la démonstration que ses systèmes

internes couvrent adéquatement les pertes attendues (parfois

appelées pertes moyennes).

· La granularité du système de mesure doit

être suffisante pour appréhender les sources de risque affectant

les plus grands montants de pertes de la distribution.

· Pour le calcul des fonds propres, les

différentes mesures individuelles et de pertes doivent être

agrégées « la banque peut toutefois être

autorisée à appliquer des corrélations

déterminées en interne entre ces estimations

individuelles ...la banque doit valider ses hypothèses de

corrélation »

· Tout système interne de mesure du risque doit

comprendre les éléments- clés suivant : utilisation

des données externes pertinentes, analyses de scénarios, prise en

compte de facteurs reflétant l'environnement de travail et les

systèmes de contrôles internes.

· La banque doit disposer d'un système complet,

bien documenté et transparent, décrivant la méthodologie

de mesure du risque et justifiant les poids relatifs donnés aux

différents éléments décrits au point

précédent.

v Données internes :

La banque doit collecter ses données internes de

pertes, afin de mettre en relation les estimations de risques et les pertes

effectives.

La banque doit disposer de procédures claires afin de

relier les pertes à un types d'activité ;

L'historique de pertes collectées doit être d'au

moins cinq ans, avec une exception de trois années historique pour la

première année de la mise en oeuvre de la méthode AMC (en

2007).

Le processus de collectes des données de pertes interne

doit répondre aux caractéristiques suivantes :

· La mise en correspondance des données avec les

catégories prudentielles définies, tant en terme de types

d'événement que de lignes d'activité ; la banque doit

donc documenter sa règle de conversion éventuelle entre ses

catégories internes et les catégories officielles du

comité.

· La fixation d'un seuil de notification des pertes. La

banque doit disposer d'un montant minimum de pertes brutes à partir

duquel elle notifie la perte. Un montant de 10000 euros est mentionné

à titre d'exemple. Le seuil de notification doit être globalement

similaire à celui de banques comparables.

· Outre le montant brut rapporté, divulgation

d'une information complémentaire dans la notification. La

quantité d'information à collecter est liée à

l'empileur de la perte.

· Identification d'une clé spécifique pour

l'allocation des pertes par ligne d'activité, en particulier pour la

survenance d'événements dans les fonctions centrales.

· Isolation des pertes importantes associées au

risque crédit et traitement comme résultant d'un incident

opérationnel.

· Traitement des pertes opérationnelles

liées à un risque de marché comme du risque

opérationnel pour le calcul de l'adéquation du capital.

Les critères de données internes

détaillent donc les exigences et le processus de collecte de

données de pertes internes. Ce sont ces exigences qui ont

constitué l'aiguillon le plus puissant pour le démarrage de la

mise en place de la gestion de risques opérationnels dans les banques.la

nécessité de disposer, au moment de la mise en oeuvre de

l'accord, d'un historique de pertes de trois ans minimum a sorti brutalement

les banques de leur torpeur et lancé le processus long. Couteux, mais

indispensable pour la collecte des données de pertes, qui constitue la

pierre angulaire de la modélisation du risque et des outils de sa

gestion active.

v Données externes :

Le système de mesure du risque opérationnel

d'une banque doit utiliser des données externes pertinentes notamment

lorsqu'il existe des raisons de croire que la banque est exposée

à des pertes peu fréquentes mais potentiellement lourdes, une

banque doit disposer d'un processus systématique pour déterminer

les situations nécessitant de recourir à des données

externes et les méthodologies à utiliser pour incorporer ces

données.

v Analyse de scénarios :

D'après le comité de Bâle, la banque doit,

sur base de son expérience et d'avis d'experts en gestion des risques,

procéder à l'analyse des scénarios, permettant d'obtenir

« des évaluations raisonnables des pertes

sévères plausibles ».

v Environnement de contrôle

interne :

Outre l'approche quantitative basée sur les

données de pertes et les analyses de scénarios, la

méthodologie doit intégrer les facteurs de risque pouvant

modifier le profil de la banque. La prise en compte de ces facteurs doit

répondre aux caractéristiques suivantes :

ü Chaque facteur doit représenter un vecteur de

risque pertinent, basé sur l'expérience et sur un jugement

d'expert.

ü La sensibilité des risques face à ce

facteur, ainsi que le poids de chaque facteur doivent être

justifiés.

ü Tous les aspects de l'application de chaque facteur, y

compris ses conséquences sur l'ajustement des estimations empiriques,

doivent être documentés et soumis à un examen

indépendant de la banque. Le résultat modélisé doit

être comparé aux données de pertes réelles

collectées dans la banque.

Figure 6: les critères qualitatifs des

approches de mesure du risque

Opérationnel

|