Ré sultats exp érimentaux

3.1. Introduction

Dans ce chapitre, nous allons soumettre notre

implémentation SVM avec l'algorithme SMO à deux types de tests:

les tests binaires appliquées aux paires des chiffres les plus

fréquemment confondus et les tests multi-classes Par l'approche

un-contre-tous. Différents noyaux serons utilisées avec

différents paramètres pour évaluer les performances des

SVMs .

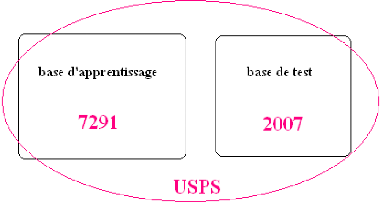

Figure 3.1.Représentation de la base USPS.

3.2. Critères d'évaluations

3.1.1. Base de données USPS (de

l'anglais«US postal Service »)

L'USPS est une base de données de chiffres manuscrits

extraits à partir d'enveloppes. La base de données contient 9298

images de chiffres manuscrits arabes dont 7291 images d'apprentissage servent

à construire le classifieur et 2007 images de test servent à

tester le classifieur et l'estimation de son taux d'erreur réel. Ces

images ont été saisies à partir d'images d'enveloppes

collectées au centre CEDAR à Buffalo (États Unis) [30].

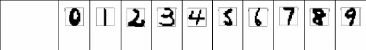

Chaque image de chiffre est représentée par 16×16 pixels de

niveau de gris allant de 0 à 255 (Tableau 3.1). Il est connu que

l'ensemble de test d'USPS est plutôt difficile puisque l'erreur humaine

se situe autour de 2.5% [13].

Etiquettes

|

0

|

1

|

2

|

3

|

4

|

5

|

6

|

7

|

8

|

9

|

|

Images

Tableau 3.1. Échantillon représentant la

première dizaine d'images binarisées et

leurs

étiquettes dans la base de données USPS

Dans ce mémoire, nous nous restreignons à la

méthode SVM et aux images originales d'USPS. Une fraction de 500 images

a été extraire à partir de 7291 pour servir a

l'apprentissage et pour le test nous utilisons tous les prototypes (2007

image).

Pour évaluer la robustesse du classifieur, nous utilisons

la matrice de confusion pour estimer le taux de bonne reconnaissance.

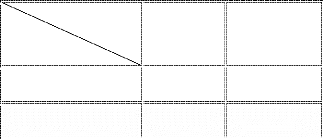

3.1.2. Matrice de confusion

Dans la terminologie de l'apprentissage supervisé, la

matrice de confusion est un outil servant à mesurer la qualité

d'un système de classification. [29].Par exemple, si on considère

un système de classification dont le but est de classer des prototypes

en classe1 et en classe2, on va vouloir savoir combien de prototypes seront

faussement considérés comme du classe1 et combien de classe2 ne

seront pas identifiés comme tels. On va supposer qu'on a testé

notre classificateur avec 100 prototypes de classe 1 et 100 prototypes de

classe2. Ainsi la matrice suivante se lit comme suit :

· sur les 100 prototypes de classe 1, 95 seront

considérés comme tels et 5 seront pris pour du classe2 ;

· sur les 100 prototypes de classe2, 3 seront

interprétés comme classe1, et 97 seront reconnus en tant que

classe 1 ;

· sur les 98 prototypes que le système classe comme

classe1, 3 sont en fait du classe2 ;

· sur les 102 prototypes que le système classe comme

classe2, 5 sont en fait du classe 1.

· Taux global de bonne reconnaissance (TGBR) : (somme de

prototypes bien classées (diagonale)/somme totale) * 100

· Dans cet exemple= ((95+97)/200)*100=96.00

Référence

Classe 1 95 5

Classe 2

Décision

Classe 1

3

Classe 2

97

Figure 3.2.Exemple d'une matrice de confusion

· les colonnes correspondent aux décisions

correctes

· les lignes correspondent aux décisions

données par le classifieur.

Cette notion peut bien sûr s'étendre à un

nombre quelconque de classes. Un système de classification sera d'autant

meilleur que sa matrice de confusion s'approchera de la matrice diagonale.

3.3. Apprentissage des SVMs

3.3.1. Réglage des paramètres

Nous avons utilisé pour l'apprentissage binaire et

multiclasse les paramètres suivants :

3.3.1.1. Paramètre de régularisation C

La valeur du paramètre C est un hyper-paramètre

qui régit la performance du SVM. Ce paramètre sert à fixer

le compromis entre la minimisation de l'erreur d'apprentissage et la

maximisation de la marge. En pratique, le comportement du SVM est sensible

à la valeur de C uniquement si les données d'apprentissage ne

sont pas séparables. Dans ce cas, il existe des valeurs critiques qui

peuvent compromettre la performance du classifieur. Une très grande

valeur de C (quelques milliers) peut faire que la fonction objective

minimisée par le SVM ne soit plus convexe et empêcherait sa

convergence. Une très faible valeur de C tend à diminuer la

capacité du classifieur [20].

Dans ce travail, après quelques expériences, le

paramètre C a été fixé à 100 car il offre

les meilleures performances.

3.3.1.2 .Réglage des seuils de Tolérance et

å (=eps) :

L'algorithme SMO est basé sur

l'évaluation des conditions de KKT. Quand tous les multiplieurs

vérifient ces conditions, l'algorithme s'arrête. En pratique ces

conditions sont vérifiées à une erreur près

å . Platt [21] a mentionné dans son article que

å est typiquement choisi dans l'intervalle 10-2 et

10-3.

La maximisation de la marge doit être

tolérée de l'ordre :10%, 0.1%..etc

Dans notre cas nous avons fixé å , et la

tolérance a 1 0-3 .

3.3.2. Choix du noyau

Quatre noyaux ont été utilisés dans notre

travail :

· Polynomial

· RBF (Radial Basis Function)

· Distance négative

· KMOD : (de l'anglais «Kernel with Moderate

Decreasing») 3.4. Classification binaire

3.4.1. Choix des pairs de classes

Dans cette expérimentation, nous voulons

expérimenter la performance des SVMs pour séparer deux classes

les plus fréquemment confondus.Ces classes correspondant aux paires

(9,4), (5,6) et (7,1).

3.4.2. Evaluations

Pour évaluer l'influence du paramètre de chaque

noyau sur la qualité de la classification, nous avons calculé le

taux de bonne classification pour chaque paire de classes .Les résultats

sont présentés dans les tableaux suivants :

p=1

|

classe 9

|

classe4

|

classe 9

|

94.91

|

5.09

|

classe 4

|

3.5

|

96.5

|

|

a =3

|

classe 9

|

classe4

|

classe 9

|

94.91

|

5.08

|

classe 4

|

3.5

|

96.5

|

|

y = 0.2

|

classe 9

|

classe4

|

classe 9

|

96.04

|

3.95

|

classe 4

|

3

|

97

|

|

|

p=2

|

classe 9

|

classe4

|

|

classe 9

|

95.48

|

4.52

|

|

classe 4

|

4

|

96

|

(a)

a=10

|

classe 9

|

classe4

|

classe 9

|

96.04

|

3.95

|

classe 4

|

4

|

96

|

|

(b)

|

y=0.1

|

classe 9

|

classe4

|

|

classe 9

|

96.61

|

3.38

|

|

classe 4

|

4.5

|

95.50

|

(c)

|

p=3

|

classe 9

|

classe4

|

|

classe 9

|

96.04

|

3.95

|

|

classe 4

|

3.5

|

96.5

|

|

a =25

|

classe 9

|

classe4

|

|

classe 9

|

94.91

|

5.08

|

|

classe 4

|

3.5

|

96.5

|

|

y = 0.05

|

classe 9

|

classe4

|

|

classe 9

|

96.04

|

3.95

|

|

classe 4

|

4.5

|

95.5

|

|

a =6

et

y=0.2

|

classe 9

|

classe4

|

|

classe 9

|

95.48

|

4.51

|

|

classe 4

|

2.5

|

97.5

|

|

a =6

et

y=0.5

|

classe 9

|

classe4

|

|

classe 9

|

96.04

|

3.95

|

|

classe 4

|

3.50

|

96.50

|

(d)

|

Noyau

|

RBF

|

polynomial

|

Distance négative

|

KMOD

|

|

|

|

|

|

|

p=3

|

|

|

|

a=6

|

a=6

|

|

classe

|

a=3

|

a=10

|

a=25

|

p=1

|

p=2

|

|

y=0.2

|

y=0.1

|

y=0.05

|

et

|

et

|

|

|

|

|

|

|

|

|

|

|

y=0.5

|

y=0.2

|

|

9

|

94.91

|

96.04

|

94.91

|

94.91

|

95.48

|

96.04

|

96.04

|

96.61

|

96.04

|

96.04

|

95.48

|

|

4

|

96.50

|

96.00

|

96.50

|

96.50

|

96.00

|

96.50

|

97.00

|

95.50

|

95.50

|

96.50

|

97.50

|

|

TGBR

|

95.75

|

96.02

|

95.75

|

95.75

|

95.75

|

95.75

|

96.55

|

96.02

|

95.75

|

96.28

|

96.55

|

Tableau 3.2.Matrices de confusion pour les paires de classes (9

,4) pour chaque type de noyau (a) Polynomial (b) RBF (c) Distance

négative (d) KMOD

|

p=1

|

classe 5

|

classe6

|

|

classe 5

|

98.12

|

1.87

|

|

classe 6

|

5.29

|

94.70

|

|

a =3

|

classe 5

|

classe6

|

|

classe 5

|

98.75

|

1.25

|

|

classe 6

|

4.70

|

95.29

|

|

y = 0.2

|

classe 5

|

classe6

|

|

classe 5

|

98.75

|

1.25

|

|

classe 6

|

4.70

|

95.29

|

|

p=2

|

classe 5

|

classe6

|

|

classe 5

|

98.12

|

1.87

|

|

classe 6

|

4.70

|

95.29

|

(a)

a=10

|

classe 5

|

classe6

|

classe 5

|

98.12

|

1.87

|

classe 6

|

4.12

|

95.88

|

|

(b)

|

y=0.1

|

classe 5

|

classe6

|

|

classe 5

|

98.12

|

1.87

|

|

classe 6

|

5.29

|

94.70

|

(c)

|

p=3

|

classe 5

|

classe6

|

|

classe 5

|

99.37

|

0.62

|

|

classe 6

|

7.05

|

92.94

|

|

a =25

|

classe 5

|

classe6

|

|

classe 5

|

98.12

|

1.87

|

|

classe 6

|

4.7

|

95.29

|

|

y = 0.05

|

classe 5

|

classe6

|

|

classe 5

|

98.12

|

1.87

|

|

classe 6

|

4.11

|

95.88

|

|

a =6

et

y=0.2

|

classe 5

|

classe6

|

|

classe 5

|

98.75

|

1.25

|

|

classe 6

|

3.52

|

96.47

|

|

a =6

et

y=0.5

|

classe 5

|

classe6

|

|

classe 5

|

98.75

|

1.25

|

|

classe 6

|

3.52

|

96.47

|

|

p=1

|

classe 7

|

classe1

|

|

classe 7

|

99.31

|

0.68

|

|

classe 1

|

2.27

|

97.72

|

|

p=2

|

classe 7

|

classe1

|

|

classe 7

|

99.31

|

0.68

|

|

classe 1

|

2.65

|

97.34

|

(a)

|

p=3

|

classe 7

|

classe 1

|

|

classe 7

|

100

|

0

|

|

classe 1

|

2.65

|

97.34

|

(d)

|

Noyau

|

RBF

|

polynomial

|

Distance négative

|

KMOD

|

|

|

|

|

|

|

p=3

|

|

|

|

a=6

|

a=6

|

|

classe

|

a =3

|

a =10

|

a =25

|

p=1

|

p=2

|

|

y = 0.2

|

y = 0.1

|

y = 0.05

|

et

|

et

|

|

|

|

|

|

|

|

|

|

|

y=0.5

|

y=0.2

|

|

5

|

98.75

|

98.12

|

98.12

|

98.12

|

98.12

|

99.37

|

98.75

|

98.12

|

98.12

|

98.75

|

98.75

|

|

6

|

95.29

|

95.88

|

95.29

|

94.70

|

95.29

|

92.94

|

95.29

|

94.70

|

95.88

|

96.47

|

96.47

|

|

TGBR

|

96.96

|

96.96

|

96.66

|

96.36

|

96.66

|

96.06

|

96.96

|

96.36

|

96.96

|

97.57

|

97.57

|

Tableau 3.3.Matrices de confusion pour les paires de classes (5

,6) pour chaque type de noyau (a) Polynomial (b) RBF (c) Distance

négative (d) KMOD

|

a=3

|

classe 7

|

classe1

|

|

classe 7

|

100

|

0

|

|

classe 1

|

3.40

|

96.59

|

|

a=10

|

classe 7

|

classe1

|

|

classe 7

|

99.31

|

0.68

|

|

classe 1

|

2.66

|

97.34

|

|

a=25

|

classe 7

|

classe1

|

|

classe 7

|

99.31

|

0.68

|

|

classe 1

|

2.65

|

97.34

|

|

y=0.2

|

classe 7

|

classe1

|

|

classe 7

|

99.31

|

0.68

|

|

classe 1

|

3.40

|

96.59

|

(b)

|

y=0.1

|

classe 7

|

classe1

|

|

classe 7

|

99.31

|

0.68

|

|

classe 1

|

3.40

|

96.59

|

(c)

|

y=0.05

|

classe 7

|

classe1

|

|

classe 7

|

99.31

|

0.68

|

|

classe 1

|

3.40

|

96.59

|

|

a =6

et

y=0.2

|

classe 7

|

classe1

|

|

classe 7

|

100

|

0

|

|

classe 1

|

3.40

|

96.59

|

|

a =6

et

|

classe 7

|

classe1

|

|

y=0.5

|

|

|

|

classe 7

|

100

|

0

|

|

classe 1

|

3.40

|

96.59

|

(d)

|

Noyau

|

RBF

|

polynomial

|

Distance négative

|

KMOD

|

|

|

|

|

|

|

p=3

|

|

|

|

a=6

|

a=6

|

|

classe

|

a =3

|

a =10

|

a =25

|

p=1

|

p=2

|

|

y = 0.2

|

y = 0.1

|

y = 0.05

|

et

|

et

|

|

|

|

|

|

|

|

|

|

|

y=0.5

|

y=0.2

|

|

7

|

100

|

99.31

|

99.31

|

99.31

|

99.31

|

100

|

99.31

|

99.31

|

99.31

|

100

|

100

|

|

1

|

96.59

|

97.34

|

97.34

|

97.72

|

97.34

|

97.34

|

96.59

|

96.59

|

96.59

|

96.59

|

96.59

|

|

TGBR

|

97.81

|

98.05

|

98.05

|

98.29

|

98.05

|

98.29

|

97.56

|

97.56

|

97.56

|

97.81

|

97.81

|

Tableau 3 .4.Matrices de confusion pour les paires de classes (7

, 1) pour chaque type de noyau (a) Polynomial (b) RBF (c) Distance

négative (d) KMOD

3.4.3. Comparaison des résultats et

discussions

|

Noyau

|

RBF

|

Polynomial

|

Distance négative

|

KMOD

|

|

pairs

|

a=3

|

a=10

|

a=25

|

p=1

|

p=2

|

p=3

|

y=0.2

|

y=0.1

|

y=0.05

|

a=6

|

a=6

|

|

|

|

|

|

|

|

|

|

|

et

|

et

|

|

|

|

|

|

|

|

|

|

|

y=0.5

|

y=0.2

|

|

(9,4)

|

95.75

|

96.02

|

95.75

|

95.75

|

95.75

|

95.75

|

96.55

|

96.02

|

95.75

|

96.28

|

96.55

|

|

(5,6)

|

96.96

|

96.96

|

96.66

|

96.36

|

96.66

|

96.06

|

96.96

|

96.36

|

96.96

|

97.57

|

97.57

|

|

(7,1)

|

97.81

|

98.05

|

98.05

|

98.29

|

98.05

|

98.29

|

97.56

|

97.56

|

97.56

|

97.81

|

97.81

|

Tableau 3.5.Taux global de bonne reconnaissance pour les trois

paires de classes (9,4), (7,1) et (5,6).

D'une manière générale, les

résultats obtenus sont sensiblement similaires en termes de bonne

classification .Cependant, l'analyse comparative montre que le choix du noyau

dépend des paires de classes et des paramètres utilisés.

En effet nous avons constaté que les noyaux KMOD et Distance

négative ont les mêmes performances pour la paire (9,4) .Tandis

que le noyau Polynomial fournit le meilleurs taux pour la paire(7,1) .Pour la

paire (5,6) le noyau KMOD fournit le meilleurs taux de bonne reconnaissance.

3.5. Classification multi classe

3.5.1. Evaluations

Dans cette section, nous évaluons la classification

multi-classe en utilisant l'approche un contre tous pour les différents

noyaux et différents paramètres des noyaux.

Les matrices de confusion sont reportées dans les tableaux

suivants :

|

ó =3

|

zéro

|

Un

|

deux

|

trois

|

quatre

|

cinq

|

six

|

sept

|

huit

|

neuf

|

|

|

zéro

|

92.75

|

0

|

2.50

|

0.27

|

1.39

|

0.55

|

0.83

|

0.27

|

1.39

|

0

|

|

un

|

0

|

93.18

|

0.75

|

0

|

3.40

|

0

|

1.51

|

0

|

1.13

|

0

|

|

deux

|

1.01

|

0

|

84.34

|

2.02

|

3.53

|

1.51

|

1.01

|

0.50

|

6.06

|

0

|

|

trois

|

1.20

|

0

|

3.61

|

80.12

|

0.60

|

7.83

|

0

|

0

|

6.02

|

0.60

|

|

quatre

|

0

|

0.50

|

3.00

|

0

|

85.50

|

0

|

1.00

|

0.50

|

3.00

|

6.50

|

|

cinq

|

2.50

|

0

|

1.25

|

5.00

|

1.87

|

82.50

|

0

|

0

|

5.00

|

1.87

|

|

six

|

2.35

|

0

|

4.70

|

0

|

1.76

|

3.52

|

86.47

|

0

|

1.17

|

0

|

|

sept

|

0

|

0

|

2.04

|

0.68

|

6.12

|

0

|

0

|

80.27

|

4.08

|

6.80

|

|

huit

|

1.80

|

0

|

1.80

|

0

|

1.20

|

3.61

|

0

|

0

|

90.96

|

0.60

|

|

neuf

|

0

|

0

|

0.56

|

0

|

3.38

|

0

|

0

|

0.56

|

2.25

|

93.22

|

|

TGBR

|

|

87.84

|

Tableau 3 .6.Matrice de confusion de la classification multi

classe pour le noyau RBF (ó =3)

|

ó =10

|

zéro

|

Un

|

deux

|

trois

|

quatre

|

cinq

|

six

|

sept

|

huit

|

neuf

|

|

|

zéro

|

89.69

|

0

|

5.01

|

1.39

|

1.39

|

1.11

|

0.27

|

0

|

0.27

|

0.83

|

|

un

|

0

|

95.07

|

0.37

|

0

|

3.40

|

0

|

0.37

|

0

|

0.37

|

0.37

|

|

deux

|

1.51

|

0

|

80.30

|

3.53

|

7.07

|

2.02

|

0.50

|

0.50

|

4.54

|

0

|

|

trois

|

1.20

|

0

|

3.01

|

83.73

|

1.20

|

3.61

|

0

|

0

|

3.61

|

3.61

|

|

quatre

|

0.50

|

0.50

|

2.00

|

0

|

87.00

|

0.50

|

0.50

|

1.00

|

3.00

|

5.00

|

|

cinq

|

2.50

|

0

|

3.12

|

10.62

|

3.12

|

73.75

|

0.62

|

1.25

|

3.75

|

1.25

|

|

six

|

2.35

|

0

|

7.05

|

0

|

4.11

|

6.47

|

77.64

|

0.58

|

1.17

|

0.58

|

|

sept

|

0.68

|

0

|

2.72

|

2.72

|

6.12

|

0

|

0

|

79.59

|

1.36

|

6.80

|

|

huit

|

3.01

|

1.20

|

2.40

|

3.61

|

5.42

|

4.81

|

0

|

1.80

|

74.09

|

3.61

|

|

neuf

|

0

|

0

|

0.56

|

0

|

6.21

|

0.56

|

0

|

1.12

|

2.25

|

89.26

|

|

TGBR

|

|

84.35

|

Tableau 3 .7.Matrice de confusion de la classification multi

classe le noyau RBF (ó = 10)

|

ó =25

|

zéro

|

Un

|

deux

|

trois

|

quatre

|

cinq

|

six

|

sept

|

huit

|

neuf

|

|

|

zéro

|

90.25

|

0

|

3.89

|

1.94

|

1.39

|

0.27

|

0.83

|

0

|

1.11

|

0.27

|

|

un

|

0

|

95.83

|

0

|

0.75

|

1.89

|

0

|

1.13

|

0

|

0.37

|

0

|

|

deux

|

2.02

|

0

|

78.78

|

7.07

|

6.56

|

1.01

|

0.50

|

0.50

|

3.53

|

0

|

|

trois

|

2.40

|

0

|

2.40

|

86.14

|

1.20

|

4.81

|

0

|

0

|

2.40

|

0.60

|

|

quatre

|

0

|

1.5

|

3

|

0

|

86.00

|

0

|

1.00

|

0

|

4.50

|

4.00

|

|

cinq

|

1.87

|

0.62

|

5.00

|

12.50

|

1.87

|

72.50

|

0.62

|

0

|

3.75

|

1.25

|

|

six

|

2.35

|

0

|

7.64

|

0

|

3.52

|

3.52

|

81.17

|

0

|

1.76

|

0

|

|

sept

|

0.68

|

0.68

|

2.04

|

2.72

|

6.80

|

0

|

0

|

74.82

|

7.72

|

9.52

|

|

huit

|

3.61

|

1.80

|

3.01

|

3.61

|

4.21

|

2.40

|

0

|

1.20

|

78.91

|

1.20

|

|

neuf

|

0

|

1.12

|

1.12

|

1.12

|

5.64

|

1.12

|

0

|

0.56

|

2.25

|

87.00

|

|

TGBR

|

|

84.55

|

Tableau 3.8.Matrice de confusion de la classification multi

classe le noyau RBF (ó =25)

|

P=1

|

zéro

|

Un

|

deux

|

trois

|

quatre

|

cinq

|

six

|

sept

|

huit

|

neuf

|

|

|

zéro

|

89.41

|

0

|

3.89

|

0.55

|

1.11

|

2.78

|

1.11

|

0.55

|

0.55

|

0

|

|

un

|

0

|

95.07

|

0

|

0

|

2.27

|

0

|

1.51

|

0.37

|

0.75

|

0

|

|

deux

|

1.01

|

0

|

72.72

|

2.52

|

8.08

|

2.52

|

4.04

|

3.03

|

6.06

|

0

|

|

trois

|

1.80

|

0

|

3.01

|

68.07

|

0.60

|

13.25

|

0.60

|

1.20

|

9.03

|

2.40

|

|

quatre

|

0.50

|

1.00

|

1.00

|

0

|

81.50

|

3.50

|

1.50

|

2.50

|

4.50

|

4.00

|

|

cinq

|

3.75

|

0

|

0

|

5

|

1.25

|

83.75

|

0

|

2.5

|

2.5

|

1.25

|

|

six

|

2.35

|

0

|

2.35

|

0

|

2.94

|

7.64

|

82.35

|

0.58

|

1.76

|

0

|

|

sept

|

1.36

|

0

|

1.36

|

0.68

|

3.40

|

1.36

|

0

|

87.07

|

1.36

|

3.40

|

|

huit

|

4.21

|

0

|

0.60

|

0.60

|

3.61

|

9.63

|

0

|

2.40

|

77.10

|

1.80

|

|

neuf

|

0

|

0.56

|

1.12

|

0

|

5.64

|

2.25

|

0

|

5.08

|

6.77

|

78.53

|

|

TGBR

|

|

82.76

|

Tableau 3.9.Matrice de confusion de la classification multi

classe pour le noyau Polynomial (p=1)

|

P=2

|

zéro

|

Un

|

deux

|

trois

|

quatre

|

cinq

|

six

|

sept

|

huit

|

neuf

|

|

|

zéro

|

89.97

|

0

|

3.06

|

0.83

|

1.67

|

2.78

|

1.11

|

0

|

0.55

|

0

|

|

un

|

0

|

95.45

|

0

|

0

|

3.03

|

0

|

1.13

|

0

|

0.37

|

0

|

|

deux

|

1.51

|

0

|

73.23

|

3.03

|

7.57

|

2.52

|

4.04

|

1.01

|

7.07

|

0

|

|

trois

|

3.61

|

0

|

2.40

|

73.49

|

0.60

|

10.24

|

0

|

0

|

8.43

|

1.20

|

|

quatre

|

0.50

|

1.00

|

1.50

|

0

|

83.50

|

1.50

|

1.50

|

0

|

3.00

|

7.50

|

|

cinq

|

3.12

|

0

|

0.62

|

5.00

|

1.87

|

85.00

|

0

|

0.62

|

2.50

|

1.25

|

|

six

|

0.58

|

0

|

2.35

|

0

|

3.52

|

8.82

|

82.35

|

0

|

2.35

|

0

|

|

sept

|

0

|

0

|

2.04

|

0.68

|

4.76

|

1.36

|

0

|

78.23

|

2.04

|

10.88

|

|

huit

|

3.61

|

1.20

|

0

|

1.20

|

2.40

|

9.63

|

0

|

1.20

|

78.91

|

1.80

|

|

neuf

|

0

|

0.56

|

0.56

|

0

|

5.08

|

1.69

|

0

|

0.56

|

3.95

|

87.57

|

|

TGBR

|

|

84.01

|

Tableau 3.1 0.Matrice de confusion de la classification multi

classe pour le noyau Polynomial (p=2)

|

P=3

|

zéro

|

Un

|

deux

|

trois

|

quatre

|

cinq

|

six

|

sept

|

huit

|

neuf

|

|

|

zéro

|

92.47

|

0

|

2.50

|

1.11

|

1.39

|

0.55

|

0.83

|

0.27

|

0

|

0.83

|

|

un

|

0

|

95.83

|

0

|

0

|

2.65

|

0

|

1.13

|

0

|

0.37

|

0

|

|

deux

|

2.02

|

0

|

77.27

|

3.53

|

6.56

|

1.51

|

4.04

|

1.51

|

3.53

|

0

|

|

trois

|

2.40

|

0

|

2.40

|

80.12

|

0.60

|

6.02

|

0.60

|

0

|

4.21

|

3.61

|

|

quatre

|

1.00

|

1.00

|

2.00

|

0

|

82.50

|

1.00

|

1.50

|

1.00

|

2.00

|

8.00

|

|

cinq

|

1.87

|

0

|

1.25

|

9.37

|

1.87

|

79.37

|

0.62

|

1.25

|

1.87

|

2.5

|

|

six

|

2.35

|

0

|

2.35

|

0

|

4.70

|

3.52

|

85.88

|

0.58

|

0.58

|

0

|

|

sept

|

0

|

0

|

2.04

|

0.68

|

4.08

|

1.36

|

0

|

82.99

|

0.68

|

8.16

|

|

huit

|

4.81

|

0.60

|

1.80

|

1.80

|

4.21

|

7.83

|

0.60

|

2.40

|

71.08

|

4.81

|

|

neuf

|

0

|

0.56

|

0.56

|

0

|

3.38

|

1.12

|

0

|

0.56

|

2.25

|

91.52

|

|

TGBR

|

|

85.25

|

Tableau 3.11 .Matrice de confusion de la classification multi

classe pour le noyau Polynomial (p=3)

|

ã=0.2

|

zéro

|

Un

|

deux

|

trois

|

quatre

|

cinq

|

six

|

sept

|

huit

|

neuf

|

|

|

zéro

|

93.31

|

0

|

3.34

|

0.27

|

1.11

|

0.27

|

0.83

|

0.83

|

0

|

0

|

|

un

|

0

|

95.83

|

0

|

0

|

2.27

|

0

|

1.51

|

0.37

|

0

|

0

|

|

deux

|

1.51

|

0

|

86.86

|

2.52

|

3.53

|

1.51

|

1.01

|

2.02

|

1.01

|

0

|

|

trois

|

1.80

|

0

|

3.61

|

86.74

|

0.60

|

5.42

|

0.60

|

0

|

0

|

1.20

|

|

quatre

|

0

|

1.50

|

5.00

|

0

|

85.50

|

0

|

1.00

|

2.50

|

0

|

4.50

|

|

cinq

|

1.87

|

0

|

3.12

|

10.62

|

1.87

|

78.75

|

0.62

|

1.87

|

0

|

1.25

|

|

six

|

2.94

|

0

|

5.29

|

0

|

2.35

|

2.94

|

86.47

|

0

|

0

|

0

|

|

sept

|

0.68

|

0.68

|

2.72

|

0.68

|

3.40

|

0

|

0

|

88.43

|

0

|

3.40

|

|

huit

|

2.40

|

1.80

|

6.62

|

8.43

|

7.83

|

8.43

|

0

|

3.61

|

56.02

|

4.81

|

|

neuf

|

0.56

|

0.56

|

1.12

|

0.56

|

5.64

|

0.56

|

0

|

3.38

|

6.77

|

78.53

|

|

TGBR

|

|

86.00

|

Tableau 3.1 2.Matrice de confusion de la classification multi

classe pour le noyau KMOD ã =0.2 et ó =6

|

ã =0.5

|

zéro

|

Un

|

deux

|

trois

|

quatre

|

cinq

|

six

|

sept

|

huit

|

neuf

|

|

|

zéro

|

93.87

|

0

|

1.67

|

0.55

|

1.11

|

0.55

|

0.55

|

0.55

|

0

|

1.11

|

|

un

|

0

|

93.81

|

0

|

1.13

|

1.89

|

0

|

2.27

|

0.37

|

0

|

1.13

|

|

deux

|

2.52

|

0

|

78.28

|

5.05

|

5.55

|

2.02

|

1.51

|

2.52

|

2.02

|

0.50

|

|

trois

|

1.20

|

0

|

2.40

|

87.34

|

0.60

|

6.02

|

0

|

0

|

0

|

2.40

|

|

quatre

|

0.50

|

0.50

|

2.50

|

0

|

81.50

|

1.00

|

1.00

|

2

|

0

|

10.00

|

|

cinq

|

2.50

|

0

|

1.25

|

8.75

|

1.87

|

80.62

|

0

|

1.87

|

0.62

|

2.50

|

|

six

|

3.52

|

0

|

3.52

|

0

|

2.35

|

4.70

|

85.88

|

0

|

0

|

0

|

|

sept

|

0

|

0

|

0.68

|

0.68

|

3.40

|

0

|

0

|

89.79

|

0

|

5.44

|

|

huit

|

4.81

|

0

|

0.60

|

7.22

|

4.21

|

8.43

|

0

|

3.01

|

63.25

|

8.43

|

|

neuf

|

0.56

|

0

|

0.56

|

0

|

2.25

|

0.56

|

0

|

2.25

|

0

|

93.78

|

|

TGBR

|

|

85.89

|

Tableau 3.13 .Matrice de confusion de la classification multi

classe pour le noyau KMOD ã =0.5 et ó =6

|

ã=0.2

|

zéro

|

un

|

deux

|

trois

|

quatre

|

cinq

|

six

|

sept

|

huit

|

neuf

|

|

|

zéro

|

90.25

|

0

|

1.94

|

0.83

|

1.39

|

3.06

|

1.67

|

0

|

0.83

|

0

|

|

un

|

0

|

93.93

|

0

|

0

|

2.27

|

0

|

1.51

|

0

|

1.51

|

0.75

|

|

deux

|

2.02

|

0

|

68.68

|

3.03

|

7.57

|

2.02

|

3.53

|

1.01

|

12.12

|

0

|

|

trois

|

2.40

|

0

|

1.20

|

75.90

|

1.20

|

5.42

|

0.60

|

0.60

|

10.24

|

2.40

|

|

quatre

|

1.00

|

0.50

|

0.50

|

0

|

84.00

|

0

|

3.00

|

1.00

|

5.00

|

5.00

|

|

cinq

|

3.12

|

0

|

1.25

|

10

|

3.12

|

74.37

|

0

|

1.25

|

5.00

|

1.87

|

|

six

|

0.58

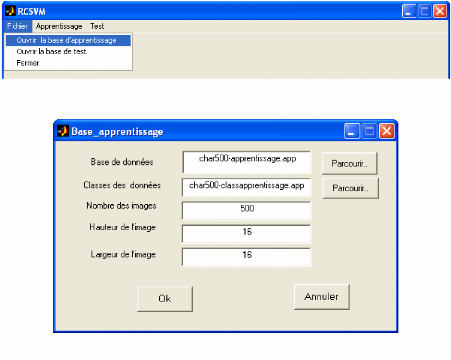

|

0

|

1.17

|

0

|

2.94

|

7.64

|

85.29

|

0

|

2.35

|

0

|

|

sept

|

0.68

|

0

|

1.36

|

1.36

|

4.76

|

0

|

0

|

82.31

|

4.08

|

5.44

|

|

huit

|

3.01

|

0

|

0

|

1.80

|

0.60

|

3.61

|

0

|

0

|

90.36

|

0.60

|

|

neuf

|

0

|

0.56

|

0

|

0

|

3.95

|

1.12

|

0

|

0.56

|

8.47

|

85.31

|

|

TGBR

|

|

84.10

|

Tableau 3.14.Matrice de confusion de la classification multi

classe pour le noyau Distance négativeã =0.2

|

ã=0.1

|

zéro

|

un

|

deux

|

trois

|

quatre

|

cinq

|

six

|

sept

|

huit

|

neuf

|

|

|

zéro

|

91.36

|

0

|

3.62

|

0.55

|

1.11

|

0.27

|

2.22

|

0

|

0.27

|

0.55

|

|

un

|

0

|

95.45

|

0

|

0

|

2.27

|

0

|

1.51

|

0

|

0

|

0.75

|

|

deux

|

1.51

|

0

|

77.27

|

4.04

|

6.06

|

1.51

|

4.04

|

2.02

|

3.03

|

0.50

|

|

trois

|

2.40

|

0

|

1.20

|

77.10

|

2.40

|

7.22

|

0.60

|

1.20

|

3.01

|

4.81

|

|

quatre

|

0.50

|

0.50

|

1.50

|

0

|

82.00

|

0

|

4.00

|

0.50

|

1.00

|

10.00

|

|

cinq

|

4.37

|

0

|

2.50

|

12.50

|

3.12

|

71.25

|

0.62

|

0.62

|

2.50

|

2.50

|

|

six

|

1.17

|

0

|

2.35

|

0

|

2.94

|

5.29

|

87.64

|

0

|

0.58

|

0

|

|

sept

|

0

|

0

|

1.36

|

0

|

4.08

|

0

|

0

|

87.07

|

0.68

|

6.80

|

|

huit

|

5.42

|

1.80

|

3.61

|

1.80

|

4.21

|

7.83

|

0

|

1.20

|

71.08

|

3.01

|

|

neuf

|

0

|

0

|

0.56

|

0

|

3.38

|

0.56

|

0

|

1.12

|

1.12

|

93.22

|

|

TGBR

|

|

84.65

|

Tableau 3. 15.Matrice de confusion de la classification multi

classe pour le noyau Distance négative ã=0.1

|

ã =0.05

|

zéro

|

un

|

deux

|

trois

|

quatre

|

cinq

|

six

|

sept

|

huit

|

neuf

|

|

|

zéro

|

92.75

|

0

|

1.39

|

0.83

|

1.11

|

0.27

|

2.22

|

0.55

|

0.27

|

0.55

|

|

un

|

0

|

93.93

|

0

|

0.75

|

1.51

|

0

|

3.03

|

0

|

0

|

0.75

|

|

deux

|

2.52

|

0

|

69.19

|

7.57

|

7.07

|

1.01

|

6.06

|

3.03

|

3.03

|

0.50

|

|

trois

|

1.80

|

0

|

1.20

|

86.74

|

0.60

|

3.61

|

0.60

|

1.80

|

0.60

|

3.01

|

|

quatre

|

1.00

|

0.50

|

1.00

|

0

|

84.00

|

0

|

3.00

|

1.50

|

0.50

|

8.50

|

|

cinq

|

4.37

|

0

|

1.25

|

13.12

|

2.50

|

75.00

|

0

|

1.25

|

0

|

2.50

|

|

six

|

2.35

|

0

|

0

|

0.58

|

2.94

|

5.29

|

88.82

|

0

|

0

|

0

|

|

sept

|

0.68

|

0

|

1.36

|

0.68

|

4.08

|

0

|

0

|

89.11

|

0

|

4.08

|

|

huit

|

4.81

|

0.60

|

0.60

|

7.83

|

7.22

|

7.22

|

0.60

|

1.20

|

66.26

|

3.61

|

|

neuf

|

0.56

|

0

|

0.56

|

0

|

5.64

|

1.12

|

0

|

1.69

|

0.56

|

89.83

|

|

TGBR

|

|

84.75

|

Tableau 3.16.Matrice de confusion de la classification multi

classe pour le noyau Distance négative ã=0.05

3.5.2. Comparaison des résultats et

discussions

|

noyau

|

RBF

|

polynomial

|

Distance négative

|

KMOD

|

|

classe

|

|

|

|

|

|

|

|

|

|

ã = 0.5

|

ã = 0.2

|

|

ó=3

|

ó=10

|

ó=25

|

p=1

|

p=2

|

p=3

|

ã=0.2

|

ã=0.1

|

ã=0.05

|

ó=6

|

ó=6

|

|

0

|

92.75

|

89.69

|

90.25

|

89.41

|

89.97

|

92.47

|

90.25

|

91.36

|

92.75

|

93.87

|

93.31

|

|

1

|

93.18

|

95.07

|

95.83

|

95.07

|

95.45

|

95.83

|

93.93

|

95.45

|

93.93

|

93.18

|

95.83

|

|

2

|

84.34

|

80.30

|

78.78

|

72.72

|

73.23

|

77.27

|

68.68

|

77.27

|

69.19

|

78.28

|

86.86

|

|

3

|

80.12

|

83.73

|

86.14

|

68.07

|

73.49

|

80.12

|

75.90

|

77.10

|

86.74

|

87.34

|

86.74

|

|

4

|

85.50

|

87.00

|

86.00

|

81.50

|

83.50

|

82.50

|

84.00

|

82.00

|

84.00

|

81.50

|

85.50

|

|

5

|

82.50

|

73.75

|

72.50

|

83.75

|

85.00

|

79.37

|

74.37

|

71.25

|

75.00

|

80.62

|

78.75

|

|

6

|

86.47

|

77.64

|

81.17

|

82.35

|

82.35

|

85.88

|

85.29

|

87.64

|

88.82

|

85.88

|

86.47

|

|

7

|

80.27

|

79.59

|

74.82

|

87.07

|

78.23

|

82.99

|

82.31

|

87.07

|

89.11

|

89.79

|

88.43

|

|

8

|

90.96

|

74.09

|

78.91

|

77.10

|

78.91

|

71.08

|

90.36

|

71.08

|

66.26

|

63.25

|

56.02

|

|

9

|

93.22

|

89.26

|

87.00

|

78.53

|

87.57

|

91.52

|

85.31

|

93.22

|

89.83

|

93.78

|

87.57

|

|

TGBR

|

87.84

|

84.35

|

84.55

|

82.76

|

84.01

|

85.25

|

84.10

|

84.65

|

84.75

|

85.89

|

86.00

|

Tableau 3. 17.Résumé des résultats pour la

classification multi classe

Globalement, les taux de bonne reconnaissance sont

sensiblement similaires. Cependant, nous constatons que le choix du noyau et

ses paramètres influent sur le taux de bonne de reconnaissance .Le noyau

RBF pour ó =3 semble fournir les meilleurs taux de bonne de

reconnaissance comparativement aux autres noyaux. L'examen du taux de bonne de

reconnaissance pour chaque classe montre qu'il n'existe pas un noyau plus

favorable .En fait les résultats obtenus dépendent des

classes.

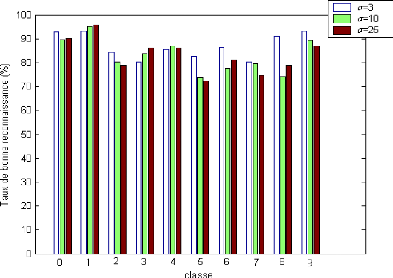

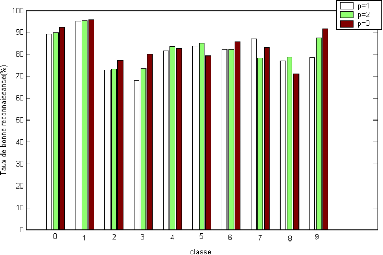

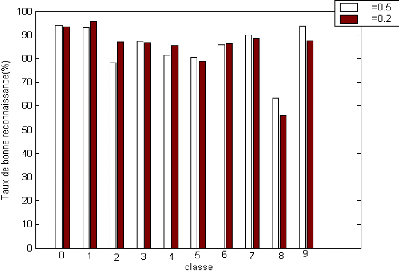

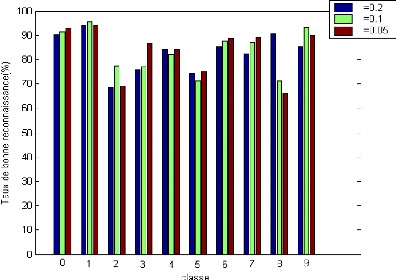

Nous présentons dans les figures suivantes le taux de

bonne de reconnaissance pour chaque classe et pour différentes valeurs

du paramètre du noyau.

Figure 3.3.Taux de bonne reconnaissance (%) pour chaque classe

pour différents valeurs du

paramètre du noyau RBF.

Figure 3.4.Taux de bonne reconnaissance (%) pour chaque classe

pour différents valeurs du

paramètre du noyau Polynomial.

Chapitre 3 Résultats expérimentaux

Y Y

Figure 3.5.Taux de bonne reconnaissance (%) pour chaque classe

pour différents valeurs du

paramètre du noyau KMOD (a

=6)

Y Y Y

Figure 3.6.Taux de bonne reconnaissance (%) pour chaque classe

pour différents valeurs du

paramètre du noyau Distance

négative

3.6. Comparaison classification binaire et

multi-classe

L'analyse comparative entre la classification binaire et la

classification multi-classe montre que le taux de bonne reconnaissance pour la

classification binaire est meilleur quelques soit le noyau utilisé

comparativement à la classification multi-classe. Cela peut se justifier

par le fait que le classifieur SVM a beaucoup plus de difficultés

à séparer une classe des autres classes comparativement à

la classification binaire.

3.7. Présentation de la plateforme

Nous présentons dans cette section la plate forme de

reconnaissance de chiffres manuscrits implémentés sous

environnement Matlab .Les différentes fonctions

implémentés sont décrits dans les sous- sections

suivants.

3.7.1. Fenêtre principale

La fenêtre principale est composée (voir figure3.7)

de trois menus :

· Fichier,

· Apprentissage

· Test.

Figure 3.7. Fenêtre principale

3.7.2 Menu

3.7.2.1. Sélection des fichiers (voir figure3.8)

Le menu Fichier contient trois rubriques :

> Ouvrir la base d 'apprentissage : permet de

sélectionner le fichier sur lequel porte l'apprentissage des SVMs .La

sélection porte sur (voir figure3.9) :

· Le nom du fichier de données

· Le nom du fichier des classes

· Nombres d'images

· Hauteur de l'image

· Largeur de l'image

> Ouvrir la base de test : permet d'ouvrir la base

de test et les classes correspondantes

>

Figure 3.8. Rubriques de menu Fichier

Figure 3.9. Exemple de chargement de la base d'apprentissage.

Fermer : sert à quitter la plateforme.

3.7.2.2. Sélection des paramètres pour

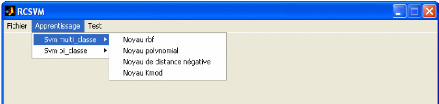

l'apprentissage (voir figure3.10) Le menu Apprentissage

contient deux rubriques :

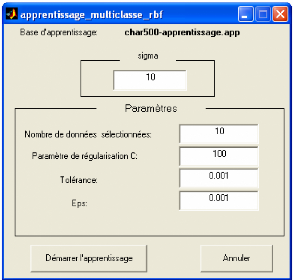

> Svm multiclasse : permet de faire la classification

multi-classe par le choix du noyau et le réglage de ses

paramètres (figure3.11)

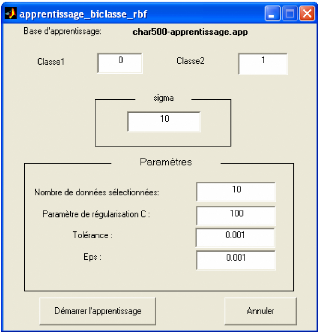

> Svm biclasse : permet de faire la classification bi-classe

entre deux classes choisis en sélectionnant le noyau et ses

paramètres (figure3.12).

Figure 3.10. Rubriques de menu Apprentissage.

Figure 3.11. Exemple de choix de noyau et les paramètres

pour la classification multiclasse

Figure 3.12. Exemple de choix de noyau et réglage des

paramètres avec possibilité de

sélectionner deux

classes pour la classification biclasse.

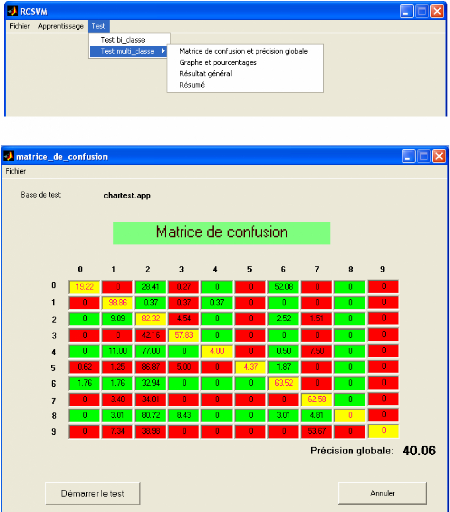

3.7.2.3. Evaluation de la classification (voir figure

3.13)

Le menu Test contient deux rubriques :

> Test binaire : permet d'afficher la matrice de confusion et

la précision globale pour la classification biclasse.

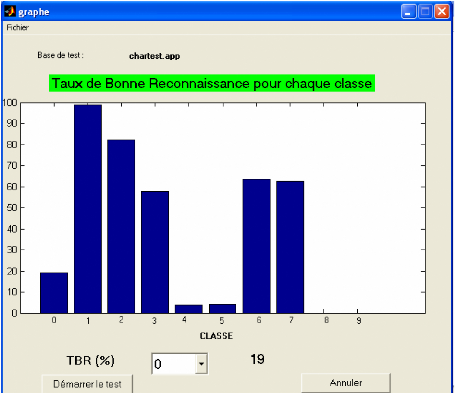

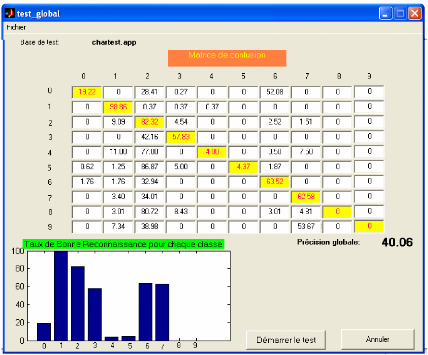

> Test multi : permet pour la classification multiclasse :

+ De calculer la matrice de confusion et la précision

globale (voir figure 3.14).

+ D'afficher le taux de bonne reconnaissance de

déférentes classes avec leur graphe (voir figure 3.15).

+ D'afficher le taux de bonne reconnaissance de

déférentes classes sous forme d'une matrice de confusion et

graphique avec la précision globale. (voir figure 3.16).

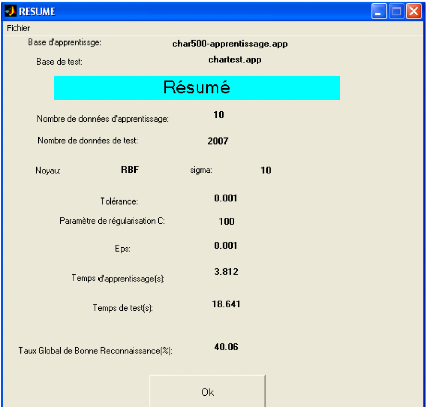

+ De récapituler tous les résultats obtenus avec

les paramètres utilisés et d'afficher le temps d'apprentissage et

le temps de test (voir figure 3.17).

Figure 3.13. Rubriques de menu Test.

Figure 3.14.Matrice de confusion avec précision

globale.

Figure 3.15. Taux de bonne reconnaissance pour chaque classe

représenté sous forme

graphique

Figure 3.16. Taux de bonne reconnaissance pour

déférentes classes représenté sous forme

d'une

matrice de confusion et graphique.

Figure 3.1 7.Résumé des résultats

3.8. Conclusion

Ce chapitre a été consacré à

l'évaluation du classifieur SVM pour la reconnaissance des chiffres

manuscrits. Les résultats obtenus montrent que la qualité de la

reconnaissance dépend du choix du noyau et du réglage de ses

paramètres.

Par ailleurs, nous avons pu constater que la séparation

bi-classe permet de séparer plus facilement deux classes que de

séparer une classe des autres classes.

|