III/ Résultats de la modélisation par les

réseaux de neurones

Après la modélisation logistique, notre

étude s'attachera dans cette section à tenter une

modélisation prédictive par la méthode neuronale. Pour

mémoire, nous rappelons que la fonction de transfert utilisée

dans la première couche cachée est la sigmoïde logistique ou

logsigmoide Y=F(x) = 1/(1+exp(-x)), similaire à celle

de la régression logistique que nous avons vu plus haut. Dans une

deuxième couche, il s'agira d'une fonction linéaire.

L'idée c'est d'obtenir une fonction qui présente un comportement

linéaire lorsque les poids des noeuds sont petits (au voisinage de

zero), et non linéaire lorsque l'on se situe aux

extrémités.

3.1. Identification des données en entrée et en

sortie.

Les données en entrées sont celles composant

notre échantillon après épurement de l'analyse

fréquentielle. En l'occurrence, il s'agit des 212 individus

décrits à travers leurs 18 variables explicatives, qui

constitueront les neurones input. Les données en sortie sont

soit la modalité 1 pour « bon payeur », ou la

modalité 2 pour « mauvais payeur ». Le type de

réseau qui sera utilisé est le perceptron multicouches (PMC),

encore appelé « Multi Layer Perceptron ». Celui-ci

semble adapté aux modèles non linéaires, et se compose en

plusieurs couches : les variables en entrée, les variables de

sortie, les niveaux cachés.

Tableau 27 : Caractéristiques du réseau

neuronal PMC utilisé

|

Libellé

|

caractéristiques

|

|

« poids »

|

Poids pi, et Poids qi

|

|

Couches cachées

|

Fonction de combinaison

|

Produit scalaire ?i

pixi

|

|

Fonction transfert

|

Logistique

F(X)= 1/(1+exp(-X))

|

|

Nombre de couches cachées

|

2

|

|

Couche de sortie

|

Fonction de combinaison

|

Produit scalaire ?k

pkxk

|

|

Fonction transfert

|

Logistique

F(X)= 1/(1+exp(-X))

|

|

Rapidité

|

Plus rapide en mode « application du

modèle »

|

|

Avantage

|

Meilleure généralisation

|

Source : Recherche de Fred Ntoutoume, Crefdes, 2007

(inspiré de Tufféry, 2006)

Nous avons augmenté le pouvoir de prédiction en

admettant deux couches cachées entre la couche d'entrée et la

couche de sortie. La structure générale de notre réseau

est de la forme :

Figure 10: Structure générale du

réseau neuronal PMC utilisé

Variables explicatives

(Couches d'entrée)

& Poids synaptiques (p et q)

Fonction de sortie (couche de sortie)

Fonction de combinaisaon

(couches cachées)

Source et Format

des données

(pi)

(qi)

SEXEDIR

(pi)

(qi)

STATMAT

Ó pi xi

(pi)

(qi)

AGE

Y=F(X)= 1/(1+exp(-X))

Base de données UMECUDEFS

(212 individus)

Ó qi xi

(pi)

(qi)

NBENF

.

.

.

.

.

.

.

.

(pi)

(qi)

Source :

Recherche de Fred Ntoutoume, Crefdes, 2007

DEMOCT

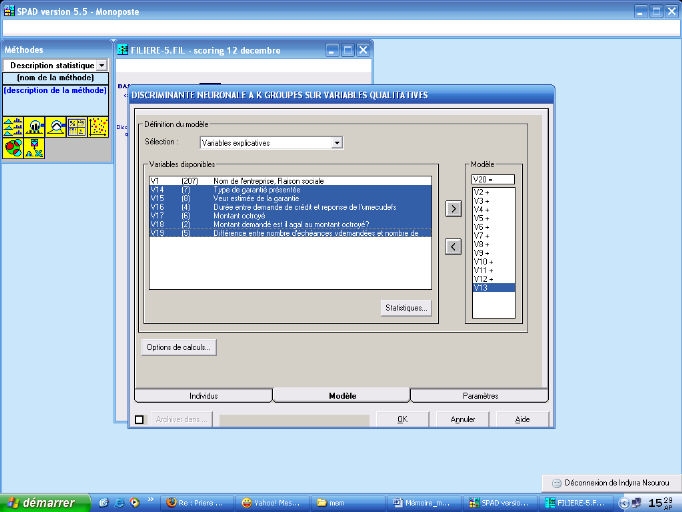

Pour procéder à l'identification des

données en entrée et en sortie sur le logiciel SPAD 5.5, nous

procédons par exportation de la base de données d'origine de SPSS

à SPAD, via une conversion en extension *.sba, puis par création

et enregistrement d'une filière, non sans avoir précisé la

méthode que nous souhaitions utiliser. Après un double clic sur

l'icône de la méthode, nous obtenons la boite de dialogue de

définition du modèle (cf figure ci-dessous).

Figure 11: procédure de définition du

modèle neuronal sous SPAD

Source : Recherche de Fred Ntoutoume, Crefdes, 2007

Cette procédure SPAD nous permet, d'une part, de

définir la variable à discriminer (variable de sortie) qui

correspond dans notre cas à la variable REM3MOIS (remboursement

du crédit au plus 3 mois a près la dernière

échéance). Cette variable est codée en V20 sur SPAD.

D'autre part, le logiciel nous demande de spécifier les variables

explicatives du modèle, ou variables d'entrée. Celles-ci

correspondent aux variables V2 à V19.

Les réseaux de neurones souffrant fréquemment de

« sur-apprentissage » on a scindé l'échantillon de base

en deux : l'échantillon d'apprentissage et son complément

l'échantillon test. Par ailleurs, on utilise la fonction sigmoïde

et l'apprentissage s'effectue avec une fonction d'erreur quadratique (encore

appelée coût). La vitesse de convergence est alors sensible au

coefficient å.

|