1. Extraction des informations pertinentes à partir

de données non structurées

Les architectures de Deep Learning telles que BERT, SBERT et

les pipelines de traitement linguistique comme spaCy, intégrant la

reconnaissance d'entités nommées (NER), facilitent l'extraction

automatisée de données essentielles, notamment :

· L'identité du candidat

· Les diplômes et le niveau académique

· Les expériences professionnelles

antérieures

· Les compétences techniques (ex. : langages de

programmation, systèmes d'exploitation)

· Les langues maîtrisées

71

· Les certifications obtenues

Cette démarche permet de convertir des documents

textuels non standardisés en représentations structurées

exploitables par des systèmes décisionnels.

2. Évaluation sémantique de la pertinence

entre CV et offres d'emploi

La correspondance automatisée entre le profil d'un

candidat et les exigences d'un poste repose sur la vectorisation

sémantique des contenus textuels. Les modèles comme Sentence-BERT

(SBERT) transforment le CV et l'offre en vecteurs dans un espace latent

partagé. La mesure de similarité cosinus entre ces vecteurs

permet d'évaluer le degré de correspondance. Ce processus

constitue une étape essentielle dans la mise en oeuvre de

systèmes intelligents de recommandation et de

présélection.

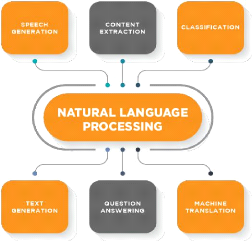

2.3.6 Traitement automatique du langage naturel (NLP)

Le NLP pour Natural Language Processing ou Traitement du

Langage Naturel est une discipline qui porte essentiellement sur la

compréhension, la manipulation et la génération du langage

naturel par les machines. Ainsi, le NLP est réellement à

l'interface entre la science informatique et la linguistique. Il porte donc sur

la capacité de la machine à interagir directement avec l'humain.

[14]

À quelles problématiques répond le

NLP ?

Le NLP est terme assez générique qui recouvre un

champ d'application très vaste. Voici les applications les plus

populaires :

Ø Traduction automatique

Le développement d'algorithmes de traduction

automatique a réellement révolutionné la

manière dont les textes sont traduits aujourd'hui. Des applications,

telles que Google Translator, sont capables de

traduire des textes entiers sans aucune intervention humaine.

Le langage naturel étant par nature ambigu et variable, ces applications

ne reposent pas sur un travail de remplacement mot à mot, mais

nécessitent une véritable analyse et modélisation de

texte, connue sous le nom de Traduction automatique statistique (Statistical

Machine Translation en anglais) [14].

Ø Sentiment analysis

Aussi connue sous le nom de « Opinion

Mining », l'analyse des sentiments consiste

à identifier les informations subjectives d'un texte pour

extraire l'opinion de l'auteur [14].

À titre exemple, lorsqu'une marque lance un nouveau

produit, elle peut exploiter les commentaires recueillis sur les réseaux

sociaux pour identifier le sentiment positif ou négatif globalement

partagé par les clients.

De manière générale, l'analyse

des sentiments permet de mesurer le niveau de satisfaction des clients

vis-à-vis des produits ou services fournis par une entreprise ou un

organisme. Elle peut même s'avérer bien plus efficace que

des méthodes classiques comme les sondages [14].

En effet, si l'on rechigne souvent à passer du temps

à compléter de longs questionnaires, une partie

croissante des consommateurs partage aujourd'hui fréquemment leurs

opinions sur les réseaux sociaux. Ainsi, la recherche de textes

négatifs et l'identification des principales plaintes permettent

d'améliorer les produits, d'adapter la publicité et de

réduire le niveau d'insatisfaction des clients [14].

72

Ø Marketing

Les spécialistes du marketing utilisent également

le NLP pour rechercher des personnes étant susceptible d'effectuer un

achat [14].

Ils s'appuient pour cela sur le comportement des

internautes sur les sites, les réseaux sociaux et les

requêtes aux moteurs de recherche. C'est grâce à ce type

d'analyse que Google génère un profit non négligeable en

proposant la bonne publicité aux bons internautes. Chaque fois qu'un

visiteur clique sur une annonce, l'annonceur reverse jusqu'à 50 dollars

!

De manière plus générale, les

méthodes de NLP peuvent être exploitées

pour dresser un portrait riche et complet du marché existant, des

clients, des problèmes, de la concurrence et du potentiel de croissance

des nouveaux produits et services de l'entreprise.

Les sources de données brutes pour cette analyse

comprennent les journaux de ventes, les enquêtes et les médias

sociaux...

Ø Chatbots

Les méthodes NLP sont au coeur du

fonctionnement des Chatbots actuels. Bien que ces systèmes ne soient pas

totalement parfaits, ils peuvent aujourd'hui facilement gérer

des tâches standards telles renseigner des clients sur des

produits ou services, répondre à leurs questions, etc. Ils sont

utilisés par plusieurs canaux, dont l'Internet, les applications et les

plateformes de messagerie. L'ouverture de la plateforme Facebook

Messenger aux chatbots en 2016 a contribué à leur

développement [14].

Autres domaines d'application

· Classification de texte : cela

consiste à attribuer un ensemble de catégories

prédéfinies à un texte donné. Les

classificateurs de texte peuvent être utilisés pour organiser,

structurer et catégoriser à ensemble de textes.

· Reconnaissance de caractères :

Cela permet d'extraire, à partir de la reconnaissance

des caractères, les principales informations des

reçus, des factures, des chèques, des documents

de facturation légaux, etc.

· Correction automatique : la plupart

des éditeurs de texte sont aujourd'hui muni d'un correcteur

orthographique qui permet de vérifier si le texte contient des fautes

d'orthographe.

73

Figure 35 Quelques Domaines du nlp Parmi les

principales étapes, on retrouve :

· Nettoyage : Variable selon la source des

données, cette phase consiste à réaliser des tâches

telles que la suppression d'urls, d'emoji, etc.

· Normalisation des données:

o Tokenisation, ou découpage du texte en

plusieurs pièces appelés tokens. Exemple : «

Vous trouverez en pièce jointe le document en question » ; «

Vous », « trouverez », « en pièce jointe »,

« le document », « en question ».

o Stemming : un même mot peut se

retrouver sous différentes formes en fonction du genre (masculin

féminin), du nombre (singulier, pluriel), la personne (moi, toi, eux...)

etc. Le stemming désigne généralement le processus

heuristique brut qui consiste à découper la fin des mots dans

afin de ne conserver que la racine du mot. Exemple : « trouverez

» -> « trouv »

o Lemmatisation : cela consiste à

réaliser la même tâche mais en utilisant un vocabulaire et

une analyse fine de la construction des mots. La lemmatisation permet donc de

supprimer uniquement les terminaisons inflexibles et donc à isoler la

forme canonique du mot, connue sous le nom de lemme. Exemple : «

trouvez » -> trouver

o Autres opérations : suppression des

chiffres, ponctuation, symboles et stopwords, passage en minuscule.

Afin de pouvoir appliquer les méthodes de Machine

Learning aux problèmes relatifs au langage naturel, il est indispensable

de transformer les données textuelles en données

numériques. Il existe plusieurs approches dont les principales

sont les suivantes :

· Term-Frequency (TF) : cette

méthode consiste à compter le nombre d'occurrences des

tokens présents dans le corpus pour chaque texte.

74

· Chaque texte est alors représenté par un

vecteur d'occurrences. On parle généralement

de Bag-Of-Word, ou sac de mots en français.

Néanmoins, cette approche présente un

inconvénient majeur : certains mots sont par nature

plus utilisés que d'autres, ce qui peut conduire le modèle

à des résultats erronés.

· Term Frequency-Inverse Document Frequency

(TF-IDF) : cette méthode consiste à compter le

nombre d'occurrences des tokens présents dans le corpus pour

chaque texte, que l'on divise ensuite par le nombre d'occurrences total de ces

même tokens dans tout le corpus.

Dans le cadre de ce travaille nous avions utiliser le

modèle Sbert(paraphrase-multilingual-MiniLM-L12-v2) pour l'encodage de

texte et non (TF-IDF) ni

(TF)

|