III.2.2 CLASSIFIEUR

BAYESIEN

Soient k classes et X vecteur caractéristique de taille

M

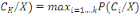

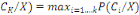

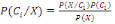

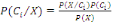

On choisit la classe   qui maximise P(Ck /X), probabilité que X appartienne

à qui maximise P(Ck /X), probabilité que X appartienne

à   : P ( : P (  avec : avec :

; ;

P(X)=  et et

P(Ci) =  est la probabilité d'observer la classe est la probabilité d'observer la classe   étant donné l'ensemble étant donné l'ensemble

D'exemples N. Ou encore P(Ci)=1/k.

La vraisemblance de l'événement « observer la

donnée x » si elle est de classe La vraisemblance de l'événement « observer la

donnée x » si elle est de classe   en disposant des exemples de taille N. Ce terme est plus difficile

voir impossible à estimer que le précédent. En absence

d'autre information, on utilise « L'hypothèse de Bayes naïve

» en disposant des exemples de taille N. Ce terme est plus difficile

voir impossible à estimer que le précédent. En absence

d'autre information, on utilise « L'hypothèse de Bayes naïve

»

III.2.2.1 HYPOTHESE DE BAYES NAIVE

La donnée x est une conjonction de valeur d'attributs ;

cette hypothèse consiste à supposer que les attributs sont des

variables aléatoires indépendantes, c'est-à-dire que les

valeurs de ses attributs ne sont pas corrélées entre-elle.

Clairement, cette hypothèse n'est à peu près

jamais vérifiée; cependant, elle permet de faire des calculs

simplement et, finalement, les résultats obtenus ne sont pas sans

intérêt d'un point de vue pratique

Avec

· Ni le cardinal de la classe i ;

· N le cardinal de l'ensemble de données

· K le nombre de classe.

III.2.2.2 ESTIMATION DE

Quand les variables aléatoires sont issues d'une

séquence d'événements aléatoires, leur

densité de probabilité prend la forme de la loi normale, N(  , ,   ). Ceci est démontré par le théorème de la

limite centrale. Il est un cas fréquent en nature. ). Ceci est démontré par le théorème de la

limite centrale. Il est un cas fréquent en nature.

Les paramètres de N(  , ,   ) sont les premiers et deuxième moments des exemples. Donc, on

peut les estimer pour n'importe quel nombre d'exemples. On peut même

estimer les moments quand il n'existe pas les bornes (Xmax-Xmin) ou quand X est

une variable continue. ) sont les premiers et deuxième moments des exemples. Donc, on

peut les estimer pour n'importe quel nombre d'exemples. On peut même

estimer les moments quand il n'existe pas les bornes (Xmax-Xmin) ou quand X est

une variable continue.

Dans ce cas, p( ) est une "densité" et il faut une

fonction paramétrique pour p().

Dans la plupart des cas, on peut utiliser N (  , ,  ) comme une fonction de densité pour p(x). ) comme une fonction de densité pour p(x).

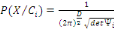

p(x)  N(x; N(x;  , ,  )= )=

Le base "e" est : e = 2.718281828....

Le terme   sert à normaliser la fonction en sorte que sa surface est 1. sert à normaliser la fonction en sorte que sa surface est 1.

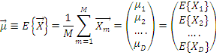

Estimation d'un vecteur de variables

aléatoires

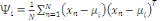

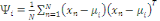

Pour un vecteur de D propriétés

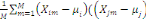

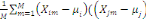

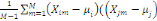

Pour D dimensions, la covariance entre les variables xi et xj est

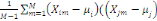

estimée à partir de M observations

=E{( =E{(  )( )(  )} )}

= =  Et encore, pour éviter le biais, on peut utiliser : Et encore, pour éviter le biais, on peut utiliser :

= =

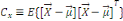

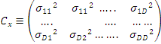

Ces coefficients composent une matrice de covariance. C

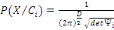

Dans le cas d'un vecteur de propriétés,   , la loi normale prend la forme : , la loi normale prend la forme :

p(x)  N(x; N(x;   , ,   )= )=

Le terme   est un facteur de normalisation. est un facteur de normalisation.

En vertu de la loi des grands nombres, nous avons :

Avec

: la matrice de variance covariances : la matrice de variance covariances

Hypothèse :

Distribution normale à l'intérieur de chaque classe

Ci

Les variables sont corrélées entre elles

|