IV La régression PLS comme

généralisation des MCO

La régression PLS, comme nous l'avons constaté

à l'étape 3, et comme nous l'avons constaté dans l'analyse

à une seule variable explicative, converge parfaitement vers la

régression linéaire.

A la première étape, les coefficients sont

strictement proportionnels aux coefficients de corrélation de la

variable explicative concernée par rapport à la variable

expliquée.

Mais dès la seconde étape, on s'éloigne de

ce schéma en tentant d'expliquer les relations entre les

résidus.

Souvent, les relations entre la variable expliquée et

les variables explicatives dépassent les simples coefficients de

corrélation. Il est possible d'avoir, par exemple, une relation

très faible entre la variable expliquée et les différentes

variables explicatives prises indépendamment, et au final,

d'obtenir une relation très forte entre la variable expliquée et

les différentes variables explicatives. C'est le cas lorsque les

relations entre les variables explicatives sont fortes.

Si les variables explicatives étaient orthogonales

entre elles, la variable expliquée pourrait s'expliquer, dans le cadre

d'une régression linéaire, directement en fonction des

coefficients de corrélation variable expliquée/variable

explicative concernée. Nous verrons ainsi que, pour une

régression portant sur des variables explicatives

orthogonales (c'est-à-dire que les coefficients de

corrélation des variables explicatives prises deux à deux sont

nuls), il n'y a aucune différence entre une régression PLS

à une ou plusieurs étapes et une régression

linéaire simple ou multiple au sens des moindres carrés.

Ce qui peut provoquer une différence entre les deux

méthodes, c'est la multicolinéarité des variables

explicatives (en d'autres termes, lorsque les variables explicatives sont

corrélées entre elles).

Lorsque les variables explicatives présentent des

relations entre elles, la régression PLS, à l'étape 1, les

néglige. A l'étape 2, ce n'est déjà plus le cas.

Pourquoi ? Parce que la régression PLS(1) ne suffit pas à

expliquer toute la relation entre la variable expliquée et l'ensemble

des variables explicatives. Elle prend en compte la relation entre la variable

expliquée et chacune des variables explicatives prise

indépendamment, mais néglige le fait que plusieurs variables

explicatives peuvent expliquer une même partie de la variance de la

variable expliquée, et qu'une combinaison linéaire de ces

variables explicatives peut aussi expliquer davantage que le pourront jamais le

faire les variables explicatives additionnées.

Prenons un cas extrême pour nous en convaincre.

IV.1. Un exemple d'inefficacité de la

régression PLS à une étape

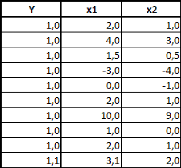

Nous choisissons une variable à expliquer Y étant

fonction linéaire de deux variables explicatives x1 et x2. Y est

créée selon une relation linéaire exacte Y = x1 - x2.

Volontairement, nous avons créé les séries de sorte

à ce que la variable Y n'ait une très faible variance. Nous avons

toutefois évité le cas extrême, pour des raisons

mathématiques, où Y aurait une variance nulle.

Voici donc les trois séries générées

:

Naturellement, la série Y ne variant pratiquement pas,

elle ne peut pas non plus « covarier » avec l'une ou l'autre des

autres séries. Nous sommes donc en présence d'un cas où

les coefficients de corrélation R(Y,xi) et R(Y,x2) sont pratiquement

nuls et surtout non significatifs.

Par conséquent, la régression PLS à une

étape affectera des valeurs pratiquement aléatoires aux

coefficients des variables xi et x2, et ne sera pas du tout pertinente,

puisqu'elle tentera d'expliquer les quasi-inexistantes variations de Y par ses

quasi - inexistantes « covariations » avec xi et x2.

La régression PLS(1) nous donne donc un modèle Y

= 0.045*xi + 0.04*x2, ce qui n'a rien à voire avec la relation que nous

avons créée. Le coefficient de détermination en

témoigne : 0.72% !

Si on passe à l'étape 2, ou si on pratique une

régression linéaire, on obtient bien entendu la relation que l'on

attend : Y = 1 *xi -- M*x2. Le coefficient de régression est bien

entendu de 100%.

Nous voici donc en présence de variables où

aucune des variables explicatives n'est significativement

corrélée à Y, et où il existe pourtant une relation

linéaire exacte entre Y et l'ensemble des variables explicatives.

Prenons maintenant un tout autre exemple avec une variable

expliquée Y et trois variables explicatives xi, x2 et x3.

|