|

UNIVERSITE DE TUNIS EL MANAR FACULTE DES

SCIENCES DE TUNIS

|

|

|

|

ECOLE DOCTORALE EN INFORMATIQUE

F

MEMOIRE DE MASTERE

présenté en vue de l'obtention

du

Diplome de Mastere en In formatique

par

Tarek HAMROUNI

Maitrise en Informatique, FS de Tunis)

Extraction des bases

génériques

informatives de règles sans calcul

de fermetures

soutenu le 14 juillet 2005, devant le jury d'examen

MM. Habib OUNELLI Président

Mohamed Mohsen GAMMOUDI Membre

Yahya SLIMANI Directeur du memoire

Sadok BEN YAHIA Invite

Dedicaces

Ce travail est dedie a mes Maitres, rues

parents et ma famille.

Qu'ils trouvent ici le Mmoignage de ma gratitude et de

mon

respect.

REMERCIEMENTS

C'est avec un grand plaisir, que j'exprime ici ma

reconnaissance a tous ceux qui m'ont apporté leur aide scientifique,

matérielle ou morale pour mener a terme ce travail.

A Mr. Habib Ounelli, Maitre de Conférences a la

Faculté des Sciences de Tunis, pour avoir accepté de

présider le jury de ce Mastère. Je le remercie pour l'attention

avec laquelle il a lu et évalué ce mémoire.

A Mr. Mohamed Mohsen Gammoudi, Maitre Assistant a la

Faculté des Sciences de Tunis, pour avoir accepté de participer

au jury de ce Mastère. Je le remercie pour l'attention avec laquelle il

a lu et évalué ce mémoire.

A Mr. Yahya Slimani, Maitre de Conférences a la

Faculté des Sciences de Tunis, pour ses orientations, ses conseils et

ses suggestions. J'ai spécialement apprécié son esprit

critique et sa rigueur scientifique. Qu'il trouve ici l'expression de mon

respect.

A Mr. Sadok Ben Yahia, Maitre Assistant a la Faculté

des Sciences de Tunis, qui m'a aidé dans ce travail et en a rendu

possible la réalisation. J'ai particulièrement

apprécié ses qualités humaines indéniables, sa

disponibilité et ses conseils de bon aloi. Qu'il trouve ici l'expression

de ma gratitude.

Je souhaite aussi exprimer toute ma reconnaissance envers Mr.

Yves Bastide, Professeur adjoint a l'Ensar de Rennes, qui s'est montré

toujours disponible a répondre a mes questions et pour avoir mis a ma

disposition les codes sources des algorithmes CLOSE, A-CLOSE et TITANIC

utilisés dans le cadre de ce travail.

Je tiens également a remercier Mlle Yosr Slama,

Assistante a la Faculté des Sciences de Tunis, pour son aide a

l'élaboration de l'étude théorique de la complexité

de l'algorithme proposé.

Je remercie les membres de l'URPAH de la Faculte des Sciences de

Tunis de m'avoir accueilli au sein de leur unite et fait beneficier de leurs

experiences.

Mes remerciements vont aussi a tous ceux qui, non cites ici,

m'ont soutenu tout le long de ce travail.

Résumé: Durant ces

dernières ann'ees, les quantit'es de donn'ees collect'ees, dans divers

domaines d'application de l'informatique, deviennent de plus en plus

importantes. Ces quantit'es ont suscit'e le besoin d'analyse et

d'interpr'etation afin d'en extraire des connaissances utiles. Ce m'emoire

s'int'eresse a` la technique d'extraction de règles associatives, une

des techniques les plus utilis'ees dans le domaine de la fouille de donn'ees.

La première approche permettant la g'en'eration de règles

associatives s'est bas'ee sur l'extraction des itemsets fr'equents. Cependant,

cette approche souffre de deux problèmes majeurs, a` savoir le coüt

de l'extraction des itemsets fr'equents, qui sont n'ecessaires a` la

g'en'eration de règles associatives, et la g'en'eration d'un nombre

important de règles associatives, dont un bon pourcentage est redondant.

Pour rem'edier a` ces problèmes, une nouvelle approche bas'ee sur la

d'ecouverte des itemsets ferm'es fr'equents en utilisant les treillis de

Galois, issus de l'analyse formelle de concepts, a 'et'e

propos'ee. Toutefois, les algorithmes relatifs a` cette nouvelle approche se

sont focalis'es sur la r'esolution du premier problème, sans se soucier

de la construction de la relation d'ordre partiel li'ee a` un treillis de

Galois. Cette relation est une condition sine qua non pour

l'extraction, sans perte d'information, d'un sous-ensemble de règles

associatives, appel'e base g'en'erique. Dans ce cadre, nous avons propos'e un

nouvel algorithme appel'e PRINCE pour la g'en'eration de bases g'en'eriques de

règles associatives. Cet algorithme effectue une exploration par niveau

de l'espace de recherche. Sa principale originalit'e est qu'il est le seul a`

construire la relation d'ordre partiel dans l'objectif d'extraire les bases

g'en'eriques de règles. Pour r'eduire le coüt de cette

construction, la relation d'ordre partiel est maintenue entre l'ensemble des

g'en'erateurs minimaux des itemsets ferm'es fr'equents et non plus entre les

itemsets ferm'es fr'equents. Une structure, appel'ee treillis des

générateurs minimaux, est alors construite a` partir de

laquelle la d'erivation des bases g'en'eriques devient imm'ediate. Les

exp'erimentations que nous avons r'ealis'ees sur diff'erents contextes

d'extraction ont montr'e l'efficacit'e de l'algorithme propos'e,

comparativement a` des algorithmes de r'ef'erence tels que CLOSE, A-CLOSE et

TITANIC.

Mots-clés: Fouille de donn'ees, Analyse

formelle de concepts, Itemsets (ferm'es) fr'equents, Treillis de

Galois, Treillis des générateurs

minimaux, Règles associatives, Base

générique de règles.

Abstract: In the last few years, the amount

of collected data, in various computer science applications, becomes

increasingly significant. These large volumes of data pointed out the need to

analyze them in order to extract useful hidden knowledge. This Master thesis

focusses on the association rule extraction, one of the most popular knowledge

extraction technique. The first approach to extract association rules, uses the

notion of frequent itemsets. However, this approach suffers from two major

problems, namely the cost of extracting frequent itemsets and the high number

of extracted association rules, among which many are redundant. Thus, a new

approach based on Galois lattice uses the notion of frequent closed itemsets

instead the frequent ones. However, algorithms related to this new approach

have only resolved the first problem and have avoid the problem of construction

of the order relation associated to a Galois lattice. This partial order

relation is a sine qua non condition to obtain a subset of all

association rules, without information loss, called generic basis. For this

purpose, we proposed a new algorithm called PRINCE that performs a level-wise

browsing of the search space. Its main originality is that it is the only one

which constructs the partial order in order to extract generic bases. In order

to reduce the cost of this construction, the partial order is maintained

between frequent minimal generators and not between frequent closed itemsets. A

structure called minimal generator lattice is then built, from

which the derivation of the generic association rules becomes straightforward.

Several experimentations of our algorithm have showed the efficiency of the

proposed algorithm, comparatively to well-known algorithms like CLOSE, A-CLOSE

and TITANIC.

Key-words: Data mining, Formal concept

analysis, Galois lattice, Frequent (closed) itemsets, Minimal

generator lattice, Association rules, Generic

rule basis.

Table des matières

|

Introduction generale

1 Fondements mathematiques pour l'extraction de regles

d'association

|

1

5

|

|

1.1

|

Introduction . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . .

|

5

|

|

1.2

|

Dérivation des regles d'association . . . . . . . . . .

. . . . . . . . . . . . .

|

7

|

|

|

1.2.1 Base de transactions . . . . . . . . . . . . . . . . . .

. . . . . . . .

|

7

|

|

|

1.2.2 Regles d'association . . . . . . . . . . . . . . . . . .

. . . . . . . . .

|

7

|

|

1.3

|

Analyse formelle de concepts . . . . . . . . . . . . . . . . .

. . . . . . . . .

|

9

|

|

|

1.3.1 Introduction . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . .

|

9

|

|

|

1.3.2 Notion d'ordre partiel . . . . . . . . . . . . . . . . .

. . . . . . . .

|

10

|

|

|

1.3.3 Connexion de Galois . . . . . . . . . . . . . . . . . . .

. . . . . . .

|

12

|

|

|

1.3.4 Itemsets fermés et leurs générateurs

minimaux . . . . . . . . . . . .

|

14

|

|

1.4

|

Dérivation des bases génériques de regles

d'association . . . . . . . . . . .

|

16

|

|

1.5

|

Conclusion . . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . .

|

19

|

|

2

|

Algorithmes d'extraction des itemsets fermes frequents : Etat de

l'art

|

21

|

|

2.1

|

Introduction . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . .

|

21

|

|

2.2

|

Algorithmes d'extraction des itemsets fermés

fréquents . . . . . . . . . . .

|

22

|

|

|

2.2.1 Les algorithmes de type "Générer-et-tester"

. . . . . . . . . . . . .

|

23

|

|

|

2.2.2 Les algorithmes de type

"Diviser-et-générer" . . . . . . . . . . . . .

|

29

|

|

|

2.2.3 Les algorithmes hybrides . . . . . . . . . . . . . . . .

. . . . . . . .

|

32

|

|

2.3

|

Discussion . . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . .

|

34

|

|

2.4

|

Conclusion . . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . .

|

38

|

|

3

|

L'algorithme PRINCE

|

39

|

|

3.1

|

Introduction . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . .

|

39

|

|

3.2

|

L'algorithme PRINCE . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . .

|

40

|

|

|

3.2.1 Détermination des générateurs

minimaux . . . . . . . . . . . . . . .

|

41

|

|

|

3.2.2 Construction du treillis des générateurs

minimaux . . . . . . . . . .

|

46

|

|

|

3.2.3 Extraction des bases génériques

informatives de regles . . . . . . . .

|

50

|

|

3.3

|

Structure de données utilisée . . . . . . . . . .

. . . . . . . . . . . . . . . .

|

55

|

|

3.4

|

Preuves théoriques . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . .

|

57

|

|

3.5

|

Complexité . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . .

|

60

|

|

3.6

|

Conclusion . . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . .

|

64

|

4 Ètude experimentale 65

4.1 Introduction . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . 65

4.2 Environnement d'expérimentation . . . .

. . . . . . . . . . . . . . . . . . . 66

4.2.1 Environnement materiel et logiciel . . . . . . . . . . . .

. . . . . . . 66

4.2.2 Description des executables . . . . . . . . . . . . . . . .

. . . . . . 66

4.2.3 Bases de test . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . 66

4.3 Optimisations et evaluations . . . . . . . . . . . . . . . .

. . . . . . . . . . 68

4.4 Effets de la variation de la mesure minconf . . .

. . . . . . . . . . . . . . . 74

4.5 Comparaisons des coits des

étapes de PRINCE . . . . . . . . . . . . . . . . 75

4.5.1 Bases benchmark . . . . . . . . . . . . . . . . . . . . . .

. . . . . . 76

4.5.2 Bases "pire des cas" . . . . . . . . . . . . . . . . . . .

. . . . . . . 82

4.6 Performances de PRINCE vs. CLOSE, A-CLOSE et TITANIC .

. . . . . . . . 83

4.6.1 Bases benchmark . . . . . . . . . . . . . . . . . . . . . .

. . . . . . 83

4.6.2 Bases "pire des cas" . . . . . . . . . . . . . . . . . . .

. . . . . . . 90

4.7 Conclusion . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . 93

Conclusion generale 93

Table des figures

1.1 Exemple de contexte formel . . . . . . . . . . . . . . . . .

. . . . . . . . . 9

1.2 Join - Meet . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . 11

1.3 Join-irréductible - Meet-irréductible . . . .

. . . . . . . . . . . . . . . . . . 12

3.1 Contexte d'extraction 1C . . . . . . . . . . . . .

. . . . . . . . . . . . . . . 56

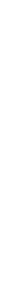

3.2 Construction du treillis des generateurs minimaux et le

treillis d'Iceberg

associés au contexte d'extraction 1C pour

minsup2. . . . . . . . . . . . . . 56 3.3 Gauche : La base

générique de regles exactes BG. Droite : La

réduction

transitive des regles approximatives RI. . . . . . . . .

. . . . . . . . . . . . 56

3.4 Exemple d'un trie . . . . . . . . . . . . .

. . . . . . . . . . . . . . . . . . . 57

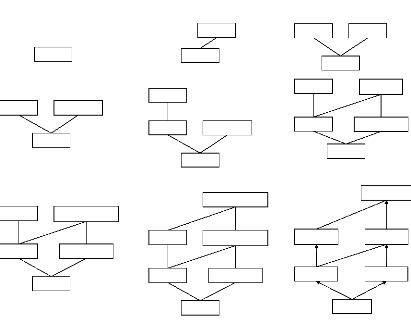

4.1 Exemple d'une base "pire des cas" avec n4 . . . . .

. . . . . . . . . . . . 68 4.2 La structure Itemset-Trie (Gauche) et la

structure IT-BDT (Droite)

associées au contexte d'extraction de la Figure 3.1 . . .

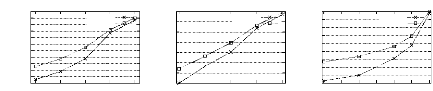

. . . . . . . . . . . 70 4.3 Effet de l'utilisation d'une représentation

compacte de la base sur les per-

formances de PRINCE . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . 71

4.4 Effet de l'exécution de la procédure

GEN-ORDRE sur les performances de

PRINCE. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . 72

4.5 Effet de l'utilisation des 2-itemsets fréquents

non générateurs minimaux

sur les performances de PRINCE . . . . . . . . . . . . . . . .

. . . . . . . . 73 4.6 Effet de l'utilisation des listes prohibées sur

les performances de PRINCE . 74 4.7 Effet de la variation de minconf sur les

performances de PRINCE . . . . . . 75 4.8 Temps d'exécution des

étapes constituant PRINCE pour les bases denses . . 77 4.9 Temps

d'exécution des étapes constituant PRINCE pour les bases

éparses . 82 4.10 Temps d'exécution des étapes constituant

PRINCE pour les bases "pire des

cas" . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . 83

4.11 Les performances de PRINCE vs. CLOSE, A-CLOSE et

TITANIC pour les

bases denses . . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . 88

4.12 Les performances de PRINCE vs. CLOSE, A-CLOSE et

TITANIC pour les

bases éparses . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . . 91

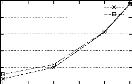

4.13 Test de mise a l'échelle de PRINCE

vs. CLOSE, A-CLOSE et TITANIC pour

les bases "pire des cas" . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . 92

Liste des tableaux

|

2.1

|

Caractéristiques des algorithmes CLOSE, A-CLOSE, TITANIC,

CLOSET et

|

|

|

CHARM. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . .

|

37

|

|

3.1

|

Notations utilisées dans la procédure GEN-GMS . . .

. . . . . . . . . . . .

|

42

|

|

4.1

|

Description des exécutables des différents

algorithmes . . . . . . . . . . . .

|

66

|

|

4.2

|

Paramètres des bases synthétiques . . . . . . . . .

. . . . . . . . . . . . . .

|

67

|

|

4.3

|

Caractéristiques des bases benchmark . . . . . . . . . . .

. . . . . . . . . .

|

67

|

|

4.4

|

Tableau comparatif des étapes constituant PRINCE pour les

bases denses. .

|

78

|

|

4.5

|

Tableau comparatif des étapes constituant PRINCE pour les

bases éparses.

|

81

|

|

4.6

|

Tableau comparatif des étapes constituant PRINCE pour les

bases "pire des

|

|

|

cas". . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . .

|

84

|

|

4.7

|

Tableau comparatif des résultats expérimentaux de

PRINCE vs. A-CLOSE,

|

|

|

CLOSE et TITANIC pour les bases denses. . . . . . . . . . . . . .

. . . . . .

|

87

|

|

4.8

|

Tableau comparatif des résultats expérimentaux de

PRINCE vs. A-CLOSE,

|

|

|

CLOSE et TITANIC pour les bases éparses. . . . . . . . . .

. . . . . . . . .

|

94

|

|

4.9

|

Tableau comparatif des résultats expérimentaux de

PRINCE vs. A-CLOSE,

|

|

|

CLOSE et TITANIC pour les bases "pire des cas". . . . . . . . . .

. . . . . .

|

95

|

Liste des algorithmes

|

1

|

GEN-GMS

|

43

|

|

2

|

GEN-GMS-SUIVANT

|

44

|

|

3

|

GEN-ORDRE

|

50

|

|

4

|

GEN-BGRS

|

53

|

|

5

|

BASE-FIRE-CAS

|

69

|

Introduction générale

Il est chaque jour plus facile de collecter des donnees mais

notre capacite a en extraire des informations a forte valeur ajoutee reste

limitee [16]. Ainsi, l'attention des entreprises s'est progressivement

detournee des systemes operationnels, vitaux mais sans valeur ajoutee

concurrentielle reelle. Elle s'est alors portee sur des systemes decisionnels,

sans apport direct en matiere de productivite mais qui contribuent

veritablement a la differenciation strategique de l'entreprise [42]. Afin

d'exploiter ces masses importantes de donnees stockees dans les systemes

decisionnels, la fouille de donnees se propose de donner les outils et/ou

techniques necessaires pour l'extraction de cette connaissance. La fouille de

donnees (ou Data mining) est le domaine de recherche au sein duquel cooperent

statisticiens, specialistes en bases de donnees et en intelligence

artificielle, ou encore chercheurs en conception d'interfaces homme-machine

[16]. Les informations extraites, suite a l'application d'un processus de

fouille de donnees, peuvent prendre plusieurs formes, telles que les regles

d'association, les arbres de decisions, les reseaux de neurones, etc [24,

42].

Dans ce memoire, nous allons nous interesser, en particulier,

a la technique d'extraction de regles d'association. Cette technique a ete

introduite par Agrawal et al. en 1993 [1]. En 1994, Agrawal et al. ont propose

un des premiers algorithmes, appele APRIORI [2], pour l'extraction des regles

d'association a partir de bases de donnees des grandes surfaces commerciales.

Cet algorithme adoptait une strategie d'exploration par niveau de l'espace de

recherche, appelee "Generer-et-tester". Ainsi, le probleme d'extraction des

regles d'association est alors decompose en deux sous-problemes [2] :

1. Extraction des ensembles d'items (ou itemsets) interessants

(ou frequents) pour l'utilisateur, cad presentant une frequence d'apparition

superieure ou egale a un certain seuil minimal fixe par l'utilisateur.

Motivations

L'approche d'extraction des regles d'association -- basee sur

la decouverte des itemsets frequents -- souffre de deux problemes majeurs, a

savoir le coUt de l'extraction des itemsets frequents et surtout la generation

d'un tres grand nombre de regles, et ce meme pour de petites bases de

donnees.

Pour pallier ces inconvenients, une nouvelle approche basee

sur l'extraction des itemsets fermes frequents [48] est apparue. Cette approche

est issue des fondements mathematiques de l'analyse formelle de concepts

introduite par Wille en 1982 [66]. Cette nouvelle approche propose deux

alternatives seduisantes :

1. Une reduction du coUt de l'extraction des itemsets

frequents.

2. Une selection d'un sous-ensemble de toutes les regles

d'association, a partir duquel le reste des regles pourrait etre derive sans

perte d'information. Ce sous-ensemble de regles d'association est communement

appele base generi que.

Cependant, pour extraire ces bases generiques de regles, il faut

prealablement decouvrir trois composantes primordiales, a savoir [9] :

1. Les itemsets fermes frequents ;

2. La liste des generateurs minimaux associes a chaque itemset

ferme frequent ;

3. La relation d'ordre entre les itemsets fermes frequents.

Un survol critique des algorithmes, bases sur l'extraction des

itemsets fermes frequents, montre que les algorithmes existants dans la

litterature ont failli a leurs objectifs [9]. En effet, la quasi-totalite de

ces algorithmes se sont focalises sur l'extraction de la premiere composante,

cad les itemsets fermes frequents, en oubliant les deux dernieres. Seuls les

algorithmes adoptant la strategie "Generer-et-tester" font mieux en permettant

aussi l'extraction des generateurs minimaux, sans se soucier de la construction

de la relation d'ordre partiel. Par consequent, les algorithmes existants n'ont

pas reussi a generer les bases generiques de regles d'association.

Pour remedier aux insuffisances enumerees, nous proposons,

dans ce memoire, un nouvel algorithme, appele PRINCE, permettant l'extraction

des itemsets fermes frequents, leurs generateurs minimaux associes ainsi que

les bases generiques de regles d'association. A cet effet, l'algorithme propose

permet la construction de l'ordre partiel. L'algorithme PRINCE effectue une

exploration par niveau de l'espace de recherche. Sa principale originalite est

qu'il est le seul a construire la relation d'ordre partiel dans l'objectif

d'extraire les bases

generiques de regles. Pour reduire le coUt de cette

construction, la relation d'ordre partiel est maintenue entre l'ensemble des

generateurs minimaux des itemsets fermes frequents et non plus entre les

itemsets fermes frequents. Ceci evite le coUt du calcul des fermetures des

itemsets. Une fois la structure partiellement ordonnee construite, l'extraction

des bases generiques devient immediate.

Structure du memoire

Les resultats de nos travaux de recherche sont synthetises dans

ce memoire qui est compose de quatre chapitres.

Le premier chapitre introduit la technique d'extraction des

regles d'association ainsi que les fondements mathematiques de l'analyse

formelle de concepts. Il definit egalement la connexion de ces fondements avec

le processus d'extraction des bases generiques de regles d'association.

Le deuxieme chapitre presente des algorithmes d'extraction des

itemsets fermes frequents. Ensuite, il presente une etude comparative critique

de ces algorithmes selon des criteres que nous introduisons.

Le troisieme chapitre est consacre a la presentation de

l'algorithme que nous proposons pour l'extraction des trois composantes

permettant la derivation des bases generiques de regles d'association. La

presentation des differentes etapes de l'algorithme PRINCE est donnee. La

demonstration de la validite, la completude et la terminaison ainsi que l'etude

de la complexite theorique de l'algorithme PRINCE seront aussi presentees.

Le quatrieme chapitre presente les experimentations effectuees

sur l'algorithme PRINCE. Ces experimentations sont divisees en deux parties. La

premiere partie s'interesse a l'analyse de quelques optimisations apportees a

notre algorithme ainsi qu'a l'analyse de ses caracteristiques. La deuxieme

partie compare les performances de l'algorithme PRINCE a celles des algorithmes

CLOSE, A-CLOSE et TITANIC.

Chapitre 1

Fondements mathematiques pour

l'extraction de regles d'association

1.1 Introduction

Avec le développement des outils informatiques, nous

avons assisté ces dernières années a un véritable

déluge d'informations stockées dans de grandes bases de

données scientifiques, économiques, financières,

médicales, etc [42]. Le besoin d'interpréter et d'analyser ces

grandes masses de données a suscité beaucoup

d'intérêt. Ainsi, la mise au point de nouvelles techniques

d'analyse est devenue un réel défi pour la communauté

scientifique. Pour répondre a cette pénurie de connaissances sur

les données, de nouvelles méthodes d'extraction de l'information

ont vu le jour, regroupées sous le terme générique de

fouille de données [11]. La fouille de données est un domaine de

recherche en plein essor visant a exploiter les grandes quantités de

données collectées dans divers domaines d'application de

l'informatique. Ce domaine pluri-disciplinaire se situe au confluent de

différents domaines, tels que les statistiques, les bases de

données, l'algorithmique, les mathématiques, l'intelligence

artificielle, etc [54]. On lui donne d'autres appellations, comme par exemple

extraction de connaissances dans les bases de données, traitement de

motifs de données ou encore exploration de données [54]. Selon

Frawley et al. [25] : L'Extraction de Connaissances dans les Bases de

Données (ou Knowledge Discovery in Databases)

désigne le processus interactif et itératif non trivial

d'extraction de connaissances implicites, précédemment inconnues

et potentiellement utiles a partir de données stockées dans les

bases de données.

Ce domaine de recherche a commencé a être

distingué en 1989, quand G. Piatetsky-

Shapiro a organisé la premiere réunion de

chercheurs et d'utilisateurs sur l'extraction automatique de connaissances dans

les grandes bases de données. Une autre étape marquante a

été la création du projet QUEST par IBM en 1993, source de

nombreux algorithmes et méthodes [4].

L'idée sous-jacente de la fouille de données est

donc d'extraire les connaissances cachées A partir d'un ensemble de

données. Le terme fouille de données regroupe un certain nombre

de tAches, telles que la prédiction, le regroupement par similitude, la

classification, l'analyse des clusters, etc [11]. Ces tAches sont elles

mêmes divisées en plusieurs techniques, telles que les regles

d'association, les arbres de décisions, les réseaux de neurones,

etc [24, 42].

Dans ce mémoire, nous allons nous intéresser aux

regles d'association [1]. L'extraction des regles d'association est l'un des

principaux problemes de la fouille de données. Ce probleme, introduit

par Agrawal et al. [1], fut développé pour l'analyse de bases de

données de transactions de ventes. Chaque transaction est

constituée d'une liste d'articles achetés, afin d'identifier les

groupes d'articles achetés le plus fréquemment ensemble [47].

L'analyse d'associations, appliquée aux données des points de

vente, est alors appelée analyse du panier de la ménagère.

L'analyse des associations part des données les plus fines qui composent

une transaction : les ventes des articles élémentaires. La

recherche des associations vise alors a retrouver les corrélations qui

pourraient exister entre n produits (par exemple, les acheteurs de

salade et de tomates achetent de l'huile dans 80% des cas), mais aussi entre

les comportements de produits (quand les ventes de X augmentent alors

les ventes de Y augmentent dans 80% des cas) [42]. L'extraction de

regles d'association a donc pour intérêt l'identification de

corrélations significatives, cachées entre les données

d'une base de données. Les corrélations obtenues peuvent

être utiles pour les utilisateurs finaux (experts, décideurs,

etc.) qui peuvent les exploiter pour différents objectifs.

Dans ce chapitre, nous allons présenter la

problématique d'extraction des regles d'association basée sur les

itemsets fréquents. Ensuite, nous allons présenter les fondements

mathématiques de l'analyse formelle de concepts et leur connexion avec

la dérivation de bases génériques de regles

d'association.

1.2 Derivation des regles d'association

1.2.1 Base de transactions

Une base de transactions peut etre formellement representee

sous la forme d'un triplet K = (O,I,R) dans lequel O

et I sont, respectivement, des ensembles finis d'objets (les

transactions) et d'attributs (les items) et R ? O × I est une

relation binaire entre les transactions et les items. Un couple

(o,i) ? R denote le fait que la transaction o ?

O contient l'item i ? I.

Une transaction T, avec un identificateur appele TID

(Tuple IDentifier), contient un ensemble, non vide, d'items de I. Un

sous-ensemble X de I ou k = |X| est appele

un k-itemset ou simplement un itemset, et k represente la

longueur de X. Le nombre de transactions de K contenant un

itemset X, |{T ? K | X ? T }|, est appele

support absolu de X. Le support relatif de X est le

quotient de son support absolu par le nombre

1IX.

total de transactions de K, cad Supp(X)

{TEK

= Un itemset X est dit frequent

|O| cni

si son support relatif est superieur ou egal a un seuil minimum

minsup(1) specifie par l'utilisateur.

1.2.2 Regles d'association

La formalisation du probleme d'extraction des regles

d'association a ete introduite par Agrawal et al. en 1993 [1]. Une regle

d'association r est une relation entre itemsets de la forme r

: X (Y-X), dans laquelle X et Y sont des

itemsets frequents, tel que X ? Y . Les itemsets X et (Y

-X) sont appeles, respectivement, premisse et conclusion de la

regle r. La generation des regles d'association est realisee a partir

d'un ensemble F d'itemsets frequents dans un contexte d'extraction

K, pour un seuil minimal de support minsup. Les regles d'association

valides sont celles dont la mesure de confiance, Conf(r) =

SSuuppp*(Y

X , est superieure ou egale a un seuil minimal de confiance, defini par

l'utilisateur et qui sera note dans la suite minconf. Si Conf(r) = 1

alors r est appelee regle d'association exacte, sinon elle

est appelee regle d'association approximative [50].

Ainsi, chaque regle d'association, X (Y

-X), est caracterisee par :

1. Le niveau de support : il correspond au nombre de fois oft

l'association est presente, rapporte au nombre de transactions comportant

l'ensemble des items de Y.

Le niveau de support permet de mesurer la frequence de

l'association [42].

2. Le niveau de confiance : il correspond au nombre de fois

oft l'association est presente, rapporte au nombre de presences de X.

Le niveau de confiance permet de mesurer la force de l'association [42].

Ainsi, etant donne un contexte d'extraction /C, le probleme de

l'extraction des regles d'association dans 1C consiste a determiner

l'ensemble des regles d'association dont le support et la confiance sont au

moins egaux respectivement a minsup et minconf. Ce probleme peut etre decompose

en deux sous-problemes comme suit [1] :

1. Determiner l'ensemble des itemsets frequents dans /C, cad les

itemsets dont le support est superieur ou egal a minsup.

2. Pour chaque itemset frequent Ii, generer

toutes les regles d'association de la forme r : I, = I, tel

que I, C I, et dont la confiance est superieure ou egale a minconf.

Ces deux problemes sont resolus par un algorithme fondamental

dans la fouille de donnees, a savoir APRIORI [2]. Le premier sous-probleme a

une complexite exponentielle en fonction du nombre d'itemsets. En effet, etant

donne un ensemble d'items de taille n, le nombre d'itemsets frequents

potentiels est egal a 2'. Le deuxieme sous-probleme est exponentiel en la

taille des itemsets frequents. En effet, pour un itemset frequent I,

le nombre de regles d'association non triviales qui peuvent etre generees est

2|I| - 1. Toutefois, la generation des regles d'association

a partir des itemsets frequents ne necessite aucun balayage de la base de

donnees et les temps de calcul de cette generation sont faibles compares aux

temps necessaires pour la decouverte des itemsets frequents [47]. Neanmoins, le

probleme de la pertinence et de l'utilite des regles extraites est d'une

premiere importance etant donne que dans la plupart des bases de transactions

reelles, des milliers et meme des millions de regles d'association sont

generees [56, 67]. Or, il a ete constate que dans la pratique, plusieurs regles

etaient redondantes [10].

Afin de resoudre ces deux problemes, cad les temps

d'extraction des itemsets fréquents ainsi que la redondance au niveau

des règles d'association valides, Pasquier et al. [48] ont propose, en

1998, une approche qui consiste a extraire les itemsets fermés frequents

au lieu des itemsets frequents. Cette approche est basee sur le fait que

l'ensemble des itemsets fermes frequents est un ensemble generateur de

l'ensemble des itemsets frequents [47]. L'approche par extraction des itemsets

fermes frequents repose sur les fondements mathematiques de l'analyse formelle

de concepts [66]. La section suivante est consacree a la presentation de ces

fondements.

1.3 Analyse formelle de concepts

1.3.1 Introduction

Une base de donnees, appelee aussi contexte d'extraction ou

d'une maniere generale contexte formel, est generalement representee par une

relation binaire entre un ensemble d'attributs I et un ensemble

d'objet O.

Definition 1 Contexte formel

Un contexte formel est un triplet K =

(O,I,R), decrivant deux ensembles finis O et I et

une relation (d'incidence) binaire, R, entre O et I

tel que R ? O × I. L'ensemble O est habituellement

appele ensemble d'objets (ou transactions) et I est appele

ensemble d'attributs (ou items). Cha que couple

(o,i) ? R designe que l'objet o ? O possede

l'attribut

i ? I (note oRi).

Un exemple de contexte formel K est illustre dans la

figure 1.1, avec O =

{1,2,3,4,5} et

I = {A, B,C, D, E}.

|

A

|

B

|

|

CD

|

E

|

|

1

|

×

|

|

×

|

×

|

|

|

2

|

|

×

|

×

|

|

×

|

|

3

|

×

|

×

|

×

|

|

×

|

|

4

|

|

×

|

|

|

×

|

|

5

|

×

|

×

|

×

|

|

×

|

FIG . 1.1 - Exemple de contexte formel

L'analyse formelle de concepts, introduite par Wille en 1982

[66], traite des concepts formels : un concept formel est un ensemble d'objets,

l'extension, auxquels s'appliquent un ensemble d'attributs, l'intention.

L'analyse formelle de concepts offre alors un outil de classification et

d'analyse, dont la notion centrale est le treillis de concepts. Le treillis de

concepts peut etre vu comme un regroupement conceptuel et hierarchique d'objets

(a travers les extensions du treillis), et interprete comme une representation

de toutes les implications entre les items (a travers les intentions) [58].

L'analyse formelle de concepts permet aussi de reduire

considerablement le nombre de relations entre ensembles d'attributs, en ne

generant que celles considerees comme non redondantes.

Dans ce qui suit, nous allons presenter les elements fondamentaux

de l'analyse formelle de concepts.

1.3.2 Notion d'ordre partiel

- Ensembles ordonnes :

Soit E un ensemble. Un ordre partiel sur l'ensemble

E est une relation binaire = sur les elements de E, tel

que pour x, y, z ? E nous avons les proprietes suivantes [21] :

1. Reflexiyite : x = x

2. Anti-symetrie : x = y et y = x x =

y

3. Transitiyite : x = y et y = z x = z

Un ensemble E dote d'une relation d'ordre =,

note (E,=), est appele ensemble partiellement ordonne

[21].

Soient P et Q deux ensembles partiellement

ordonnes. Nous dirons que P et Q sont ordre-isomorphes,

note P ~= Q, s'il existe une bijection f : P

Q et tel que x = y dans P si et seulement si

f(x) = f(y) dans Q. La bijection

f est ainsi dite ordreisomorphisme [21].

- Relation de couverture :

Soient E un ensemble ordonne (E,=

) et x, y deux elements de E. La relation de

couverture entre les elements de E, notee ?, est definie

par x ? y si et seulement si x = y et tel qu'il n'existe pas

d'element z ? E tel que x = z = y pour z =~

x et z =~ y.

Si x ? y, nous disons que y couvre x

ou bien que y est un successeur immediat de x (et donc

x est couvert par y ou x est un predecesseur immediat

de y) [21].

- Join et Meet :

Soit un sous-ensemble S ? E de l'ensemble partiellement

ordonne (E,=). Un element

u ? E est un majorant, ou borne-sup, de S si

pour tout element s ? S, nous avons s = u. L'ensemble des

majorants de S est note UB(S). D'une maniere duale, un element

ü ? E est un minorant, ou borne-inf, de S

si pour tout element s ? S, nous avons v = s.

L'ensemble des minorants de S est note LB(S) [27].

UB(S) = {u ? E | ?s ? S, s =

u}

LB(S) = {v ? E | ?s ? S, v = s}

Le plus petit majorant d'un ensemble S, s'il existe,

est le plus petit element de l'ensemble UB(S) des majorants

de S. Cet element est note Join(S) (?S). D'une

maniere duale, le plus grand minorant d'un ensemble S, s'il existe,

est le plus grand element de l'ensemble LB(S) des minorants

de S. Cet element est note Meet(S) (?S) [27].

h i

e

a b

c

f g

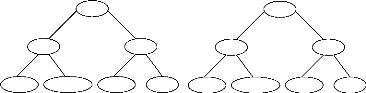

FIG . 1.2 -- Join - Meet

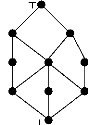

Exemple 1 Soit le treillis de concepts illustre par la figure

1.2. Ainsi, nous avons : UB({a,b}) = {T, h,i, f}

LB({e, f}) = {a, ?}

- Treillis complet : Un ensemble partiellement ordonne

(E,=) non vide est un treillis si pour tout couple d'elements

(x, y) ? E, l'ensemble {x, y} possede un plus petit

majorant, note x ? y, et un plus grand minorant, note x ?

y.

L'ensemble partiellement ordonne (E,=) est un

treillis complet si pour tout sous-ensemble S ?E, les elements

Join(S) et Meet(S) existent [21].

Les treillis sont frequemment representes sous forme d'un

diagramme de Hasse (les arcs transitifs sont omis), appele egalement graphe de

couverture [21]. Dans ce type de graphe, les sommets correspondent aux elements

de l'ensemble E et les arcs aux relations de couverture entre les sommets

[21].

Theoreme 1 Theoreme fondamental de l'analyse formelle de

concepts [27] : L'ensemble des concepts formels, extrait a partir d'un

contexte formel, constitue un treillis complet quand les concepts

formels sont ordonnes par inclusion des extensions (ou par inclusion

des intentions).

- Join-irreductible et Meet-irreductible :

Pour un element l d'un treillis complet L, nous

definissons [21] :

l* = ?{x ? L|x <

l}

l* = ?{x ? L|l < x}

Un element l est dit Join-irreductible s'il couvre un

element unique. D'une maniere duale, l est dit Meet-irreductible, s'il

est couvert par un seul element.

L'ensemble des elements Join-irreductible de L est

note par J (L) et l'ensemble des elements Meet-irreductible

de L est note par M(L). Chacun de ces ensembles

herite de la relation d'ordre de L [21].

Exemple 2 Dans la figure 1.2, b est un element

Meet-irreductible, alors que e est un

element

Join-irreductible. Dans la figure 1.3, nous avons J(L) =

{b, c} et M(L) = {e, f}.

b c

a

d

e f

FIG 1.3 -- Join-irreductible - Meet-irreductible

1.3.3 Connexion de Galois

- Operateurs de fermeture :

Soit un ensemble partiellement ordonne

(E,=). Une application ã de

(E,=) dans (E,=) est appelee un

operateur de fermeture, si et seulement si elle possede les proprietes

suivantes. Pour tout sous-ensemble S, S' ? E [21] :

1. Isotonie : S = S' ã(S) ?

ã(S')

2. Extensivite : S ? ã(S)

3. Idempotence :

ã(ã(S)) = ã(S)

Etant donne un operateur de fermeture ã sur un

ensemble partiellement ordonne (E,=), un element

x ? E est un element ferme si l'image de x par l'operateur de

fermeture ã est egale a lui-même, cad

ã(x) = x [21].

- Connexion de Galois :

Soit un contexte d'extraction K =

~O,I,R~. Soit l'application ö, de

l'ensemble des parties de OM dans l'ensemble des parties de

I, qui associe a un ensemble d'objets O ? O l'ensemble des

items i ? I communs a tous les objets o ? O [27] :

ö : 2O ?

2I

ö(O) = {i ? I|?o ? O ? oRi }

Soit l'application ø, de l'ensemble des

parties de I dans l'ensemble des parties de O, qui

associe a tout ensemble d'items (communement appele itemset) I ? I

l'ensemble des objets o ? O contenant tous les items i ? I

[27] :

ø : 2I ?

2O

ø(I) = {o ? O|?i ? I ? oRi

}

Le couple d'applications (ö,ø)

est une connexion de Galois entre l'ensemble des parties de O et

l'ensemble des parties de I [3, 27]. Etant donne une connexion de

Galois, les proprietes suivantes sont verifiees quelques soient I,

I1, I2 ? I et O,

O1, O2 ? O [27] :

1. I1 ? I2

ø(I2) ?

ø(I1);

2. O1 ? O2

ö(O2) ? ö(O1)

;

3. O ? ø(I) ? I ?

ö(O) ? (I,O) ? R.

- Fermeture de la connexion de Galois :

Nous considerons les ensembles des parties

2I et 2O dotes de la relation

d'inclusion ?, cad les ensembles partiellement ordonnes

(2I, ? ) et (2O, ? ).

Les operateurs ã = ö ? ø de

(2I, ? ) dans (2I, ?

) et ã'= ø ? ö de

(2O, ? ) dans (2O, ?

) sont des operateurs de fermeture de la connexion de Galois [3, 27].

Etant donne une connexion de Galois, les proprietes suivantes sont verifiees

quelques soient I, I1, I2

? I et O, O1, O2 ?

O [27] :

1. I ? ã(I) 1'. O ?

ã'(O)

2.

ã(ã(I))=ã(I)

2'.

ã'(ã'(O))=ã~(O)

3. I1 ? I2

ã(I1) ?

ã(I2) 3'. O1 ?

O2 ã'(O1) ?

ã'(O2)

4. ã(ø(I)) =

ø(I) 4'. ã(ö(O))

= ö(O)

- Treillis de concepts formels (de Galois) :

Etant donne un contexte d'extraction

K=(O,I,R), l'ensemble de concepts formels

CK est un treillis complet LC,, = (CK, =),

appele treillis de concepts formels (de Galois), quand l'ensemble

CK est considere avec la relation d'inclusion entre les itemsets [3, 27].

La relation d'ordre partiel entre des concepts formels est definie comme suit

[27] : ? c1=

(O1,I1), c2

=(O2,I2) ? CK,

c1 = c2 ? I2 ?

I1 (? O1 ? O2) avec

I1, I2 ? I et

O1, O2 ? O.

Dans un treillis de concepts, l'element

ø(O) x O est appele element Bottom du

treillis (note 1) et l'element Z x

ö(Z) est appele element Top du treillis (note T).

Le chemin amenant du Bottom jusqu'au Top est appele chaine maximale du treillis

[27].

Dans un treillis de concepts, les operateurs Join et Meet

permettent d'obtenir, respectivement, la plus petite borne superieure et la

plus grande borne inferieure. Les operateurs Join et Meet sont definis comme

suit [27] :

V O1, O2 C O

et I1, I2 C Z :

- (O1, I1) V

(O2, I2) =

(ã(O1 U O2),

I1 n I2),

- (O1, I1) A

(O2, I2 = (O1 n

O2, ã(I1 U

I2)).

La relation d'ordre partiel est utilisee pour generer le graphe

du treillis, appele Diagramme de Hasse, comme suit [27] :

Il existe un arc (c1, c2), si

c1 c2 oft est la reduction transitive de <,

cad Vc3 E CK,

c1 < c3 < c2

c1 =c3 ou c2 =c3.

Dans ce graphe, les sommets correspondent aux elements de

l'ensemble Ck et les arcs aux relations de couverture entre les

sommets. Chaque element c E Cic est connecte aussi bien a un

ensemble de ses successeurs immediats, appele Couverture superieure

(Couvs), et a un ensemble de ses predecesseurs

immediats, appele Couverture inferieure (Couvi).

1.3.4 Itemsets fermes et leurs generateurs minimaux

Dans cette section, nous definissons :

G les itemsets fermes qui peuvent être ordonnes sous la

forme d'un treillis des itemsets fermes.

G les itemsets fermes frequents qui peuvent être ordonne

sous la forme d'un treillis d'Iceberg.

les generateurs minimaux.

- Itemset ferme :

Etant donne l'operateur de fermeture de la connexion de

Galois ã, un itemset l C Z tel que

ã(l) = l est appele itemset ferme. Un itemset

ferme est donc un ensemble maximal d'items communs a un ensemble d'objets

[47].

[BC} n'est pas un itemset ferme car il n'est pas un ensemble

maximal d'items communs a certains objets : tous les objets contenant

les items B et C, cad les objets 2,3 et 5 contiennent egalement l'item

E.

- Ensemble d'itemsets fermes :

Soit un contexte d'extraction K =

(O,I,R) et l'operateur de fermeture de la connexion

de Galois ã. L'ensemble IF des itemsets fermes dans le

contexte K est defini comme suit [47] :

IF = {l ? I 1 l= Ø ?

ã(l~=lP.

Le plus petit (minimal au sens de l'inclusion) itemset ferme

contenant un itemset l est obtenu par l'application de l'operateur

ã a l [47].

- treillis des itemsets fermes :

L'operateur de fermeture ã induit une

relation d'equivalence sur l'ensemble de parties de I, cad l'ensemble

de parties est partionne en des sous-ensembles disjoints, appeles aussi classes

d'equivalence. Dans chaque classe, tous les elements possedent la meme valeur

de support. Les generateurs minimaux d'une classe sont les elements

incomparables (selon la relation d'inclusion) les plus petits, tandis que

l'itemset ferme est l'element le plus large de cette classe. Ces classes

d'equivalence sont ordonnees sous forme d'un treillis de concepts formels (de

Galois) oft chaque concept formel est dans ce cas un itemset ferme. Ainsi, le

couple LIF =-- (IF,?) est un treillis complet appele

treillis des itemsets fermes [47].

- Itemset ferme frequent :

Un itemset ferme l est dit frequent si son support

relatif, Supp(l) = |ø~l~|

|O| ,excede un seuil minimum fixe par l'utilisateur note

minsup [47]. Notons que |ø(l~| est appele

support absolu de l.

Agrawal et al. ont introduit dans [1], les deux proprietes

suivantes relatives aux supports des itemsets frequents :

1. Tous les sous-ensembles d'un itemset frequent sont

frequents.

2. Tous les sur-ensembles d'un itemset infrequent sont

infrequents.

Ces proprietes restent applicables dans le cas des itemsets

fermes frequents [47]. Ainsi,

1. Tous les sous-ensembles d'un itemset ferme frequent sont

frequents.

2. Tous les sur-ensembles d'un itemset ferme infrequent sont

infrequents.

Sachant que le support d'un itemset (frequent) l est

egal au support de sa fermeture ã(l) qui est le plus

petit itemset ferme contenant l : Supp(l) =

Supp(ã(l~) [47].

- Treillis d'Iceberg :

Quand nous considerons seulement l'ensemble des itemsets

fermes frequents ordonnes par la relation d'inclusion ensembliste, la structure

obtenue (àL, ? ) preserve seulement l'operateur

Join. Cette structure forme un semi-treillis superieur et elle est designee par

treillis d'Iceberg [6, 57, 63].

- Generateur minimal :

Un itemset g ? I est dit generateur minimal d'un

itemset ferme f, si et seulement si ã(g)

= f et il n'existe pas g1 ? I tel que

g1 ? g [5]. L'ensemble GMf des generateurs

minimaux d'un itemset ferme f est defini comme suit :

GMf = { g ? I l

ã(g)=f ? l g1 ? g

tel que ã(g1) =f }.

Dans la suite, nous allons montrer la connexion de l'analyse

formelle de concepts avec l'extraction des bases generiques de regles

d'association.

1.4 Derivation des bases generiques de regles

d'association

Depuis l'apparition de l'approche basee sur l'extraction des

itemsets fermes frequents [48], une nouvelle formulation du probleme de

l'extraction des regles d'association est proposee et qui consiste a extraire

les itemsets fermes frequents au lieu des itemsets frequents. Ceci permet [47]

:

D'ameliorer les temps de calcul, puisque dans la plupart des

cas, le nombre d'itemsets fermes frequents est largement inferieur au nombre

d'itemsets frequents, surtout pour les bases de transactions fortement

correlees ou denses.

De generer que des regles d'association non redondantes.

Cette nouvelle approche -- l'extraction des itemsets fermes

frequents -- a donne lieu a une selection de sous-ensembles de regles sans

perte d'information. La selection de regles sans perte d'information repose sur

l'extraction d'un sous-ensemble de toutes les regles

d'association, appele base generi que, a partir duquel le

reste des regles pourrait etre derive. Dans ce memoire, nous allons nous

interesser en particulier a l'approche de Bastide et al. [4, 5]. Cette

approche presente deux bases generiques qui sont definies comme suit :

1. La Base generi que de regles d'association exactes, adaptee

de la base d'implications globales de Guigues et Duquenne [31], est definie

comme suit [4, 5] :

Definition 2 Soit IFFK l'ensemble des itemsets

fermes frequents extrait d'un contexte d'extraction K. Pour

cha que itemset ferme frequent f ? IFFK, nous designons par GMf

l'ensemble de ses generateurs minimaux. La base generi que de regles

d'association exactes est donnee par : BG = {R :

g (f - g) | f ? IFFK et g ? GMf

et g f(3)}

2.

.

La base generique de regles d'association approximatives

appelee Base informative de regles d'association approximatives,

adaptee de la base d'implications partielles de Luxenburger [45], est definie

comme suit [4, 5] :

Definition 3 Soit GMFK l'ensemble des generateurs

minimaux frequents extrait d'un contexte d'extraction K. La

base informative de regles d'association approximatives BI est donnee

par : BI = {R : g (f - g) | f

? IFFK et g ? GMFK et ã(g) ? f

et Conf (R) = minconf}.

Afin de reduire le nombre de regles generiques approximatives,

Bastide et al. proposent une reduction transitive de la base informative [4,

5], qui est elle-meme une base pour toutes les regles approximatives, definie

de la maniere suivante :

Definition 4 La reduction transitive RI de la base

informative est donnee par : RI {R : g (f

- g) | f ? IFFK et g ? GMFK et

ã(g) ? f et Conf (R) =

minconf}.

Ainsi, il est possible de determiner toutes les regles de la

base informative et donc toutes les regles approximatives a partir de la

reduction transitive [4, 5]. Ceci a pour avantage de presenter un ensemble

minimal de regles a l'utilisateur, ce qui lui permet de mieux les visualiser et

les utiliser.

Dans la suite, nous allons considerer les regles d'association

generiques formees par l'union de la base generique de regles exactes et la

reduction transitive de la base informative. Ces regles seront designees par

regles d'association informatives. Ainsi, etant donne un treillis d'Iceberg,

dans lequel chaque itemset ferme frequent est decore par sa liste de

generateurs minimaux, la derivation de ces regles peut se faire d'une maniere

directe. En

3La condition g 0 f permet de ne pas

retenir les regles de la forme g Ø.

effet, les regles approximatives génériques sont

des implications "inter-nceuds" assorties d'une mesure de confiance. Cette

implication met en jeu deux classes d'équivalence comparables, cad d'un

itemset fermé vers un autre itemset fermé le couvrant

immédiatement dans la structure partiellement ordonnée. En

revanche, les regles génériques exactes sont des implications

"intra-nceud", avec une confiance égale a 1, extraites de chaque nceud

dans la structure partiellement ordonnée.

Il faut noter que les bases considérées

présentent plusieurs avantages [4, 5, 41] :

1. Ces bases donnent des regles génériques avec

un nombre minimal d'items dans la prémisse et un nombre maximal d'items

dans la conclusion [38]. Ceci donne les regles les plus informatives pour

l'utilisateur [47].

2. Ces bases n'induisent aucune perte d'information. En

effet, ces bases génériques présentent un ensemble minimal

de regles, a partir duquel toutes les regles valides peuvent etre

retrouvées par application d'axiomes d'inférence comme ceux

proposés dans [10]. En plus, ces bases sont informatives, cad qu'elles

permettent de retrouver, pour chaque regle redondante, son support et sa

confiance sans acces au contexte d'extraction.

3. Ces bases sont valides, cad qu'elles ne permettent de

générer que les regles redondantes ayant un support et une

confiance dépassant respectivement minsup et minconf.

4. La réduction transitive regroupe les regles

approximatives génériques ayant des confiances

élevées. En effet, chacune des regles, formant la

réduction transitive, constitue un lien entre deux classes

d'équivalence dont l'une couvre l'autre immédiatement. Ces

classes d'équivalence ont généralement des supports

proches. Ceci permet d'avoir des regles d'association présentant des

confiances élevées. Sauf rares exceptions, ces regles sont les

plus intéressantes [4].

Les algorithmes présentés dans [5, 47]

permettent d'extraire ces bases en supposant l'existence des itemsets

fermés fréquents ainsi que leurs générateurs

minimaux respectifs. Ceci nécessite l'application en amont d'un autre

algorithme tel que CLOSE [48, 49] ou A-CLOSE [50], etc. La

génération de la base générique de regles

d'association exactes se fait alors d'une maniere directe. Cependant pour les

regles d'association approximatives, des tests d'inclusion coitteux, mettant en

jeu les itemsets fermés fréquents, sont réalisés

pour déterminer les successeurs immédiats de chaque classe

d'équivalence.

1.5 Conclusion

Un problème classique de la fouille de données

est la recherche de regles d'association dans les données, introduit par

Agrawal et al. [1]. Etant donné, le nombre élevé

d'itemsets fréquents et donc le nombre élevé des regles

d'association (redondantes) extraites même dans le cas de contextes

d'extraction de petites tailles, une nouvelle approche préconisant

l'extraction des itemsets fermés fréquents [48], a vu le jour.

Cette approche vise a réduire le cotit de l'extraction des itemsets

fréquents et surtout a ne générer qu'un sous-ensemble

généri que de l'ensemble de toutes les regles d'association. Dans

le chapitre suivant, nous allons présenter les principaux algorithmes

permettant l'extraction des itemsets fermés fréquents.

Chapitre 2

Algorithmes d'extraction des itemsets

fermes frequents : Etat de l'art

2.1 Introduction

L'extraction des regles d'association est l'une des techniques

les plus importantes dans le domaine de la fouille de données [11]. La

premiere approche d'extraction des regles d'association s'est basée sur

la découverte des itemsets fréquents [2]. Cependant, cette

approche souffre de deux problemes majeurs, a savoir le coit de l'extraction

des itemsets fréquents a partir desquels seront extraites de grandes

quantités de regles d'association. Cette quantité énorme

de connaissance rend quasi impossible leur analyse par un expert humain. Pour

pallier ces inconvénients, une nouvelle approche basée sur

l'extraction des itemsets fermés fréquents [48] est apparue.

Cette approche exploitant les fondements mathématiques de l'analyse

formelle de concepts [66], propose de réduire le coit de l'extraction

des itemsets fréquents en se basant sur le fait que l'ensemble des

itemsets fermés fréquents est un ensemble

générateur de l'ensemble des itemsets fréquents [48]. En

outre, elle propose une sélection, sans perte d'information, d'un

sous-ensemble de toutes les regles d'association, appelé base

générigue, a partir duquel le reste des regles pourrait etre

dérivé [48]. Cette approche permet de réduire le nombre de

regles extraites en ne gardant que les plus intéressantes pour

l'utilisateur et lui donne la possibilité de mieux les visualiser et les

exploiter.

2.2 Algorithmes d'extraction des itemsets fermes

frequents

La premiere approche d'extraction des regles d'association

s'est basee sur l'extraction des itemsets frequents. Les algorithmes, adoptant

cette approche, peuvent etre classes suivant les strategies d'exploration

utilisees pour traverser le treillis des itemsets : en largeur d'abord [2], en

profondeur d'abord [34] ou une strategie hybride [70]. En adoptant une

strategie en largeur d'abord, tous les k-itemsets candidats sont

generes en faisant une auto-jointure de l'ensemble des (k-1)-itemsets

frequents [2]. Quand une strategie en profondeur d'abord est adoptee, etant

donne un (k-1)-itemset frequent X, les k-itemsets

candidats sont generes en ajoutant un item i, i/?X, a

X. Si {X U i} est aussi frequent, le processus est

repete recursivement pour {X U i} [34]. La troisieme

strategie explore en profondeur d'abord le treillis des itemsets, mais ne

genere qu'un seul itemset a la fois [70].

Afin de resoudre les problemes rencontres par les algorithmes

d'extraction des itemsets frequents, une nouvelle approche basee sur

l'extraction des itemsets fermes frequents est apparue. Cette approche est

basee sur la fermeture de la connexion de Galois [27] pour resoudre le probleme

d'extraction de regles d'association [48]. Elle est fondee sur un elagage du

treillis des itemsets fermes, en utilisant les operateurs de fermeture de la

connexion de Galois [27]. Plusieurs algorithmes ont ete proposes dans la

litterature [49, 50, 51, 57, 69], dont le but est de decouvrir les itemsets

fermes frequents.

Quand nous nous interessons a l'extraction des itemsets fermes

frequents seulement, la generation des candidats et la verification s'ils sont

fermes ou non, ne peuvent pas etre directement appliquees contrairement aux

algorithmes permettant de determiner les itemsets frequents [43]. En effet, il

n'est pas possible de generer des itemsets fermes candidats en faisant une

auto-jointure des itemsets fermes dejà decouverts. Par exemple, etant

donne un itemset ferme X, il peut arriver qu'aucun des sur-ensembles

de X, obtenus en etendant X par un seul item, ne soit un

ferme [43].

Etant donne le fait que les candidats fermes frequents ne

peuvent pas etre generes directement, tous les algorithmes, permettant de

trouver les itemsets fermes frequent, sont bases sur deux etapes qui

co-existent. La premiere etape consiste a naviguer dans l'espace de recherche

en traversant le treillis des itemsets frequents d'une classe d'equivalence a

une autre. Durant la deuxieme etape, ces algorithmes calculent les fermetures

des itemsets

frequents visites, dans le but de determiner les itemsets fermes

frequents de la classe d'equivalence correspondante [43].

Ainsi, nous proposons que les strategies adoptees pour

l'exploration de l'espace de recherche soient decomposees en trois strategies,

a savoir "Generer-et-tester", "Diyiser-etgenerer" et une strategie hybride :

1. La strategie "Generer-et-tester" : les algorithmes

adoptant cette strategie parcourent l'espace de recherche par niveau. A chaque

niveau k, un ensemble de candidats de taille k est genere.

Cet ensemble de candidats est, generalement, elague par la conjonction d'une

metrique statistique (cad le support) et des heuristiques basees

essentiellement sur les proprietes structurelles des itemsets fermes et/ou des

generateurs minimaux [9].

2. La strategie "Diviser-et-generer" : les algorithmes

adoptant cette strategie essaient de diviser le contexte d'extraction en des

sous-contextes et d'appliquer le processus de decouverte des itemsets fermes

recursivement sur ces sous-contextes. Ce processus de decouverte repose sur un

elagage du contexte base essentiellement sur l'utilisation d'une metrique

statistique et d'heuristiques introduites [9].

3. La strategie hybride : les algorithmes adoptant cette

strategie utilisent les proprietes des deux strategies precedentes. Ils

explorent l'espace de recherche en profondeur d'abord (tel que les algorithmes

de la strategie "Diyiser-et-generer") mais sans diviser le contexte

d'extraction en des sous-contextes. Ces algorithmes genèrent un ensemble

de candidats tel que c'est le cas dans la strategie "Generer-et-tester".

Cependant, cet ensemble est toujours reduit a un seul element. Ces algorithmes

essaient alors de verifier si ce candidat est un itemset ferme frequent ou non.

Le processus d'extraction se base aussi sur des strategies d'elagage [69]. Ces

derniers consistent a utiliser une metrique statistique en conjonction avec

d'autres heuristiques.

Dans la suite, nous allons passer en revue les principaux

algorithmes permettant l'extraction des itemsets fermes frequents en les

distinguant par rapport a la strategie d'exploration etant donne que c'est le

critère utilise dans la litterature [9, 36].

2.2.1 Les algorithmes de type

!,Générer-et-tester!,

Dans cette sous section, nous allons passer en revue les

algorithmes les plus connus operant selon la strategie "Generer-et-tester". Une

structure generale d'un algorithme entrant dans cette categorie est presentee

dans [9].

Chacun des algorithmes, que nous allons presenter dans la

suite, est caracterise par une phase d'elagage et par une phase de

construction. Lors de la phase d'elagage et en plus de l'elagage des candidats

infrequents, cad ayant un support strictement inferieur a minsup, chaque

algorithme introduit de nouvelles strategies d'elagage pour essayer de reduire

le coUt supplementaire du calcul des fermetures des itemsets [9]. Notons que

ces strategies dependent de l'information dont dispose l'algorithme. Cette

information peut être soit l'ensemble des generateurs minimaux seuls,

soit accompagne de l'ensemble des itemsets fermes [9]. La phase de construction

relative a une iteration k, permet de generer les candidats de

taille k a partir de ceux retenus lors de l'iteration (k-1)

(cad de taille (k-1)).

Une methode d'elagage commune aux algorithmes adoptant la

strategie "Generer-ettester" se base sur la verification de l'ideal d'ordre des

generateurs minimaux frequents. Cette notion est definie comme suit :

Proposition 1 [55, 571 L'ensemble GMFK des

generateurs minimaux frequents extraits d'un contexte d'extraction

K verifie la propriete de l'ordre ideal de

(P(I),? ), cad si g ? GMFK et

g1 ? g alors g1 ? GMFK,

pour tout g, g1 ? I.

La definition d'un ordre ideal des generateurs minimaux frequents

est equivalente a : g1 ?/ GMFK,

g1 ? g g ?/ GMFK, pour tout g,

g1 ? I.

Definition 5 [55, 571 Soit GMFK un ordre ideal de

(P(I),? ). Un itemset candidat g pour

GMFK est un sous-ensemble de I tel que tous ses sous-ensembles

sont des generateurs minimaux frequents.

Ainsi, tout candidat generateur minimal frequent g de

taille k, est elague dans le cas oft un de ses sous-ensembles n'est

pas un generateur minimal frequent.

2.2.1.1 L'algorithme CLOSE

L'algorithme CLOSE propose par Pasquier et al. [48, 49] est le

premier algorithme permettant l'extraction des itemsets fermes frequents. Cet

algorithme se base sur les generateurs minimaux pour calculer les itemsets

fermes. Ces generateurs minimaux sont utilises pour construire un ensemble

d'itemsets fermes candidats (itemsets fermes potentiellement frequents), qui

sont les fermetures des generateurs minimaux. Ainsi, etant donne un contexte

d'extraction K, CLOSE genere toutes les regles d'association en trois

etapes successives [9] :

1. Decouverte des itemsets fermes frequents ;

2. Derivation de tous les itemsets frequents a partir des

itemsets fermes frequents obtenus durant la premiere etape ;

3. Pour chaque itemset frequent, generation de toutes les regles

ayant une confiance au moins egale a minconf.

L'algorithme CLOSE parcourt l'ensemble des generateurs

minimaux des itemsets fermes frequents par niveaux. L'ensemble d'itemsets

fermes frequents candidats d'une iteration k est l'ensemble des

fermetures des k-generateurs minimaux frequents de cette iteration.

Durant la premiere iteration, l'ensemble des 1-generateurs minimaux est

initialise avec la liste des 1-itemsets du contexte d'extraction, tries par

ordre lexicographique. CLOSE calcule alors le support et la fermeture de ces

generateurs moyennant un acces au contexte d'extraction. Les generateurs

minimaux infrequents et leurs fermetures sont alors elimines. Ensuite, pour

chaque iteration k, CLOSE construit un ensemble de candidats

generateurs minimaux frequents de taille k en utilisant la phase

combinatoire d'APRiORi-GEN [2] appliquee aux (k-1)-generateurs

minimaux frequents retenus lors de l'iteration precedente. De cet ensemble est

elague tout candidat ne verifiant pas l'ideal d'ordre des generateurs minimaux

frequents ou s'il est inclus dans la fermeture d'un de ses sous-ensembles de

taille (k-1), calculee lors de l'iteration precedente [48, 49]. Une

fois ces tests d'elagage effectues, CLOSE accede au contexte d'extraction pour

calculer le support et la fermeture des candidats retenus. Pour calculer la

fermeture des candidats, CLOSE utilise la fonction GEN-CLOSURE [48, 49]. Cette

fonction determine, pour chaque transaction T du contexte

d'extraction, les generateurs minimaux qui sont inclus dans T. Pour

chacun de ces generateurs minimaux, GEN-CLOSURE calcule sa fermeture et

incremente son support. La fermeture est egale a l'intersection de T

avec l'ancienne valeur de la fermeture, si cette derniere est non nulle sinon

la nouvelle valeur est egale a T. Une fois l'acces au contexte

d'extraction termine, CLOSE ne retient que les fermetures des generateurs

minimaux qui sont frequents. Ainsi, les candidats infrequents, et pour lesquels

le calcul de la fermeture est logiquement non necessaire, sont elimines.

L'execution de l'algorithme CLOSE prend fin quand il n'y plus de candidats a

generer.

Etant donne que dans chaque iteration, le calcul des supports

et des fermetures des candidats est l'etape la plus exigeante en temps

d'execution, CLOSE utilise une structure de donnees avancee basee sur la notion

d'arbre prefixe (ou trie(')) derivee de celle proposee

'Le mot trie est inspire du mot anglais reTRIEval.

par Mueller dans [46]. Dans cette structure, chaque candidat

est represente par un chemin de la racine a une feuille du trie. La fermeture

de chaque candidat est stockee au niveau de la feuille le representant dans le

trie. A la fin de chaque iteration, les generateurs minimaux frequents, leurs

supports et leurs fermetures sont stockes dans un autre trie ayant la

meme structure que celui utilise pour le calcul des supports et des fermetures.

Le fait d'utiliser un trie pour chaque ensemble de generateurs minimaux

frequents, d'une taille k donnee, necessite une grande quantite

d'espace memoire (etant donne qu'il y a beaucoup de redondance).

CLOSE necessite au pire des cas acces au contexte d'extraction

(TIT etant la taille

maximale possible d'un generateur minimal).

2.2.1.2 L'algorithme A-CLOSE

L'algorithme A-CLOSE, propose par Pasquier et al. [50], permet

l'extraction des itemsets fermes frequents en utilisant les proprietes des

supports des generateurs minimaux des itemsets fermes frequents. L'amelioration

apportee a l'algorithme A-CLOSE par rapport a l'algorithme CLOSE, reside dans

le fait que A-CLOSE, apres avoir construit un ensemble de

k-generateurs candidats a partir des (k-1)-generateurs minimaux

retenus dans la (k1)i`eme iteration, supprime de cet

ensemble tout candidat g dont le support est egal au support d'un de

ses sous-ensembles de taille (k-1) [50].

Ainsi, A-CLOSE procede en deux etapes successives :

1. Il determine tous les generateurs minimaux frequents, cad les

plus petits elements incomparables des classes d'equivalence induites par

l'operateur de fermeture ã.

2. Pour chaque classe d'equivalence, il determine l'element

maximal residant au sommet de la hierarchie, cad l'itemset ferme frequent.

Lors de la premiere etape, A-CLOSE parcourt l'espace de

recherche en largeur d'abord. A-CLOSE initialise alors l'ensemble des

1-generateurs minimaux par les 1-itemsets du contexte d'extraction, tries par

ordre lexicographique. Un acces au contexte d'extraction permet de calculer

seulement le support de ces generateurs (les fermetures ne sont pas calculees).

Ensuite, a chaque iteration k, A-CLOSE construit un ensemble de

k-candidats generateurs minimaux en joignant les generateurs minimaux

frequents retenus lors de l'iteration precedente (cad de taille (k-1))

grace a la phase combinatoire d'APRiORi-GEN [2]. De cet ensemble est elague

tout candidat ne verifiant pas l'ideal d'ordre des generateurs minimaux

frequents. Une fois cet elagage effectue, un acces au contexte d'extraction

est

effectué pour calculer le support des candidats

retenus. Ensuite, A-CLOSE élimine tout candidat g qui se

révèle infréquent ou ayant un support égal a celui

d'un de ses sous-ensembles de taille (k-1) [50]. Afin de

vérifier cette dernière condition, A-CLOSE effectue un balayage

des générateurs minimaux retenus de taille (k-1)

permettant de comparer le support de g avec le support de ses

sous-ensembles de taille (k-1) [50]. La première étape

de l'algorithme A-CLOSE prend fin lorsqu'il n'y a plus de candidats a

générer.

Lors de la deuxième étape, A-CLOSE calcule les

fermetures de tous les générateurs minimaux fréquents

retenus lors de la première étape. A cette fin, A-CLOSE

accède au contexte d'extraction et utilise la fonction AC-CLOSURE [50]

qui est la même que la fonction GEN-CLOSURE utilisée dans

l'algorithme CLOSE amoindrie de la phase du calcul du support [50].

Pour alléger le calcul des fermetures, l'algorithme

A-CLOSE mémorise le numéro de la première itération

durant laquelle un candidat fréquent non générateur

minimal (cad ayant un support égal a celui d'un de ses sous-ensembles) a

été identifié. Le numéro de cette itération

correspond a la taille t de ce candidat. Il n'est alors pas

nécessaire de calculer la fermeture des générateurs

minimaux fréquents de tailles inférieures a (t-1),

puisqu'ils sont tous des itemsets fermés fréquents [50]. En

effet, ils sont eux-mêmes leur propres générateurs uniques

[47].

Comme dans le cas de l'algorithme CLOSE, et pour chaque

itération, A-CLOSE utilise un trie pour accélérer le

calcul du support des candidats et un autre trie pour stocker l'ensemble des

générateurs minimaux fréquents retenus. La fermeture de

chaque générateur minimal fréquent sera

complétée lors de la deuxième étape.

A-CLOSE nécessite au plus (1/1+1) accès au

contexte d'extraction (1/1 étant la taille maximale possible d'un

candidat générateur minimal). Les 1/1 accès sont

nécessaires pour déterminer l'ensemble des

générateurs minimaux fréquents, alors que le dernier

accès permet éventuellement de calculer les fermetures des

générateurs retenus.

2.2.1.3 L'algorithme TITANIC

L'algorithme TITANIC a été proposé par

Stumme et al. [55, 57], pour la découverte des itemsets fermés

fréquents. L'idée clé est de minimiser le coUt du calcul

des fermetures en adoptant un mécanisme de comptage par inférence

[6]. Ainsi, l'algorithme traverse

l'espace de recherche par niveau en focalisant sur la

determination des generateurs minimaux (ou itemsets cles [55, 57]) frequents

des differentes classes d'equivalence induites par l'operateur de fermeture

ã.

Une des particularites de TITANIC est qu'il considere,

contrairement a CLOSE et A-CLOSE, l'ensemble vide (0) comme etant un generateur

minimal. Pour calculer la fermeture de l'ensemble vide, TITANIC collecte les

items de meme support que cet ensemble, cad qui se repetent dans toutes les

transactions. Ainsi, l'ensemble vide est le generateur minimal de support egal

au nombre de transactions du contexte d'extraction (cad 101).

En plus, TITANIC evite le balayage supplementaire (des generateurs

minimaux frequents retenus de taille (k-1)) effectue dans A-CLOSE pour

chaque candidat g de taille k. En effet, TITANIC utilise une

variable dans laquelle il stocke le support estime de g. Ce dernier

est egal au minimum des supports des (k-1)-generateurs minimaux

frequents inclus dans g et il doit etre different du support reel

de g sinon g n'est pas minimal [55, 57].

De meme que CLOSE et A-CLOSE, TITANIC parcourt l'espace de

recherche par niveau. Il initialise l'ensemble des 1-generateurs minimaux par

les 1-itemsets du contexte d'extraction, tries par ordre lexicographique.

TITANIC calcule alors le support de ces itemsets et determine ensuite la

fermeture de l'ensemble vide. Les items infrequents ou ayant le meme support

que l'ensemble vide ne sont pas des generateurs minimaux frequents. Ensuite, a

chaque iteration k, TITANIC genere un ensemble de candidats moyennant

l'utilisation de la phase combinatoire d'APRIORI-GEN [2]. De cet ensemble, sont

elimines les candidats ne verifiant pas l'ideal d'ordre des generateurs

minimaux frequents. Un acces au contexte d'extraction permet de calculer le

support des candidats non elagues. De ces candidats, sont elimines les

generateurs infrequents ou ayant des supports reels egaux a leurs supports

estimes. Une fois les k-generateurs minimaux frequents determines,

TITANIC calcule la fermeture des generateurs minimaux frequents retenus lors de

l'iteration precedente (cad de taille (k-1)). Neanmoins, TITANIC evite

l'acces au contexte d'extraction pour calculer les fermetures et ceci en

adoptant un mecanisme de comptage par inference [6]. Ainsi, pour chaque

(k-1)-generateur minimal frequent g, TITANIC fait appel a la

fonction CLOSURE [55, 57]. Cette derniere se deroule de la maniere suivante

[55, 57] :

1. Pour alleger les calculs, la fermeture de g,

ã(g), serait egale a l'union des fermetures de ses

sous-ensembles de taille (k - 2), calculees lors de l'iteration

precedente.

2. Ensuite, pour tout item frequent i n'appartenant pas

a ã(g) a ce moment du traitement, i est

ajoute a ã(g) si Supp(g U {i}) =

Supp(g). Deux cas sont a distinguer :