II- L'allocation optimale dans le plan Moyenne - VaR

relative

II-1 La modélisation du problème d'optimisation du

portefeuille p 25

II-2 Le cadre de l'étude empirique p 30

II-3 L'application des méthodes de mesure de la Value at

Risk p 33

II-4 La construction des frontières d'efficience p 34

II-5 L'allocation optimale dans le cadre statique ..p 34

II-6 L'allocation optimale dans le cadre dynamique .p 37

Conclusion p 41

Annexes p 42

Bibliographie ..p 56

L'optimisation d'allocation d'actifs devient de plus en plus

un enjeu important sur les marchés financiers. Les coûts relatifs

à une mauvaise gestion de portefeuille et à un erreur de

prévision des tendances du marché peuvent engendrer des

situations financières précaires pour les sociétés

voir même les exposer au risque de faillite.

En théorie moderne de portefeuille, l'allocation

optimale de la richesse initiale se base sur la maximisation de la prime de

risque espéré par unité de risque. L'approche

traditionnelle de mesure de ce dernier est celle de la Moyenne Variance. Dans

ce cas, le risque est définie en terme de variation possible des

espérances de rendement du portefeuille dans les deux sens, celui de la

hausse et de la baisse: on parle de la volatilité des actifs financiers.

Elle est égale à la racine carrée de la variance des

rendements. Néanmoins, cette approche présente des

inconvénients. Le principal inconvénient est qu'elle

considère l'investisseur comme indifférent devant

l'évolution de la valeur du portefeuille dans le sens de la hausse ou

dans le sens de la baisse. Il est supposé que pour lui, il s'agit

toujours d'un risque à assumer. Un deuxième inconvénient

important est l'hypothèse implicite de la symétrie de la

distribution des rendements et plus précisément la

normalité de cette distribution. En pratique, il est bien montré

que la distribution de plusieurs séries de rendements financiers est non

normale avec un coefficient d'asymétrie (skewness) et un coefficient

d'aplatissement (kurtosis) trop élevés. De même, les agents

économiques traitent évidemment les pertes et les gains d'une

façon asymétrique. Il existe pas mal d'études sur

l'aversion à la perte (voir par exemple, Kahneman et al.1990).

Le choix de l'approche Moyenne Variance apparaît ainsi

comme une stratégie inefficiente pour optimiser l'espérance de

rendement tout en minimisant le risque. Il sera plus intéressant de

chercher une mesure de risque qui peut incorporer n'importe quel non

linéarité dans la distribution des rendements des actifs

financiers tout en se focalisant sur la valeur potentielle à perdre

plutôt que sur l'évolution en valeur absolue. Dans ce cas on aura

l'avantage de pouvoir considérer des payoff non normal tel que ceux des

produite dérivés et ainsi un cadre d'étude plus

générale. Cependant, il faut signaler qu'en finance la

déviation à

l'hypothèse de normalité suggère des

critiques dont on peut citer principalement la perte de l'opportunité de

passage d'un cadre discret à un cadre continue.

Dans ce cadre de recherche, la notion relativement

récente de la Valeur à risque (Value at Risk) apparaît

être capable de répondre à la problématique

présentée ci dessus. D'une part, l'estimation de cette mesure de

risque peut incorporer la composante de non normalité de la distribution

des rendements du portefeuille. D'autre part, cette mesure s'intéresse

directement au montant de la perte potentielle à subir sur

l'investissement. En effet, la Value at Risk (VaR) peut se

définir simplement comme la perte potentielle maximale que

l'investisseur peut subir dans un horizon de temps donné et pour un

niveau de probabilité fixé. La Value at Risk mesure directement

et en terme monétaire la perte future dans la valeur de portefeuille. Le

résultat additionnel résultant d'une non normalité peut

être inclut et absorbé dans l'estimation de la Value at Risk.

Cette mesure semble à ce jour s'imposer comme le standard pour la mesure

des risques de marché dans l'industrie financière et surtout

bancaire.

L'objectif de ce travail est d'analyser un modèle

d'allocation optimale de la richesse en se référant à la

VaR comme la mesure du risque. On cherche aussi à valider les

méthodes d'estimation de la VaR incorporé dans ce

modèle. Dans le premier chapitre, on s'intéresse à la

présentation de la VaR, de ses paramètres et des

méthodes pratiquées pour son estimation. On étudie aussi

le concept de la VaR ainsi que sa relation avec la gestion de

portefeuille tel que cité en littérature financière.

Dans le second chapitre, on commence par présenter le

modèle permettant de déterminer la répartition optimale

entre les actifs risqués d'un portefeuille. Ce modèle permet

aussi de calculer le montant de prêt emprunt nécessaire pour

ramener la VaR du portefeuille optimal à un niveau

prédéterminé. Ceci nous rappelle du théorème

de séparation de Tobin (1958) dans l'approche traditionnelle de gestion

de portefeuille. Ensuite, on élabore le cadre empirique de notre

étude avec des hypothèses sur les différents facteurs.

Cette étude empirique sera composé de trois parties : Dans la

première partie, on applique et on analyse les différentes

méthodes d'estimations de la VaR cités dans le chapitre

précédent. Dans la seconde partie, on applique et on analyse les

résultats de notre modèle dans un cadre statique. Les

méthodes d'estimation de la VaR retenue sont la méthode

empirique, la méthode de l'hypothèse de normalité et la

méthode de la théorie des valeurs extrêmes (TVE ou aussi

GPD en se référant à la distribution de Pareto

Généralisé). Dans la troisième partie, on passe

à un

cadre dynamique. L'objectif est de tester les trois approches

d'estimation de la VaR dans notre modèle

générale. Pour cela, on procède à l'application de

ce dernier pour une gestion quotidienne sur 465 jours. On se

réfère ensuite à un Backtesting en comparant les pertes

effectives des portefeuilles optimaux constitués quotidiennement avec

les VaR limites prévues par les investisseurs. Le

critère retenu dans ce cas est donc le taux d'échec des

prévisions pour les trois approches. Un deuxième critère

peut être retenu qui est celui de la richesse finale obtenue à la

fin de la période de gestion (après les 465 jours). Le

modèle choisi sera celui qui maximise cette richesse.

I-1 Le concept de la Value at Risk :

Selon Berdin et Hyde (2001) la VaR est définie

comme étant la mesure qui fournit une estimation statistique de la perte

potentielle sur un actif ou un portefeuille qui peut survenir avec une

probabilité donnée suite à des mouvements de prix ou de

taux relativement adverses. Ceci est valable sous l'hypothèse que

pendant une période de temps (l'horizon de calcul de la VaR) la

composition du portefeuille resterait inchangée. D'après A. Louis

Calvet (2000) la VaR d'un portefeuille d'actifs financiers correspond

au montant de pertes maximales sur un horizon de temps donné, si l'on

exclut un ensemble d'évènements défavorables (worst case

scénarios) ayant une faible probabilité de se produire. Une autre

définition de la VaR peut être avancée : il s'agit

de la perte maximale par rapport à la valeur espérée du

portefeuille et non par rapport à la valeur initiale. Dans ce cas, on

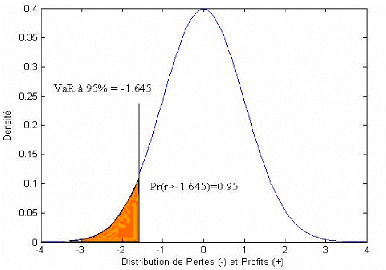

parle de la VaR relative. La figure 1 illustre la notion de la

VaR dans le cas d'une distribution normale centrale réduite des

rendements du portefeuille étudié. Dans ce cas, dire que la

VaR à 95% pour un jour est égale à -1,645%

signifie qu'au maximum on aura 5 rendements sur 100, dans le jour suivant, qui

soient inférieures à -1,645%.

Figure 1 : Un exemple de la Value-at-Risk sous

la distribution normale

Selon Paul Glasserman et al.(2000), deux

événements ont concouru à l'adoption

généralisée de la VaR sur le secteur financier et

un autre a favorisé son développement dans les entreprises

surtout américaines.

> Le premier date de 1995. Réunis en comité

à la banque des règlements internationaux à Bale, les

représentants des banques centrales de dix grandes économies de

l'ouest proposent de nouvelles règles amendant l'accord de Bale de 1988

et imposant aux établissements financiers un niveau de fonds propres

proportionnels aux risques résultant de leurs engagements.

Officiellement adoptés en 1996, cette proposition incite les banques

à développer des modèles internes sophistiqués pour

calculer leurs VaR. En effet, elles peuvent ainsi espérer une

diminution des fonds propres qu'elles doivent détenir par rapport aux

montants des fonds propres exigés sur les autres banques qui se fondent

sur les modèles standard (édictés par les autorités

de tutelle pour déterminer les besoins des banques en capitaux propres).

Ainsi, dès le départ, la recherche d'un allègement des

obligations règlementaires est un important facteur de la croissance de

la VaR.

> Le deuxième évènement s'est produit

sur Internet. En 1994, la banque américaine JP Morgan a mis gratuitement

son système RiskMetrics à la disposition de tous sur Internet. Ce

système fournissait les données financières et la

méthodologie nécessaire au calcul de la VaR d'un

portefeuille. Les autres établissements financiers et les entreprises

peuvent utiliser le calculateur de VaR de RiskMétrics ou

télécharger les données sur leurs propres systèmes

de gestion des risques. Très vite, sont apparus de nouveaux fournisseurs

de programmes de gestion des risques exploitant RiskMetrics, transformant cette

méthodologie en une référence incontournable.

Un troisième évènement a probablement

moins d'impact à ce jour, mais c'est l'un des grands facteurs

d'expansion de la VaR parmi les entreprises américaines. En

1997 aux EtatsUnis, la Securities and Exchange Commission (SEC),

préoccupée des risques cachés derrière les

instruments hors bilan, a émis des règles de communication

relative aux produits dérivés employés par les entreprises

: celles-ci ont trois solutions pour faire état des risques

associés

aux instruments dérivés : tableau des valeurs de

marché, mesure de sensibilité ou VaR. C'est la raison

pour laquelle les rapports annuels de Microsoft, de Philip Morris et de bien

d'autres grandes sociétés présentent maintenant des

calculs de la VaR. Récemment, les recommandations du

comité Bale II publié en 2004 ont renforcé

l'utilité de cette notion.

En ce qui concerne la littérature, plusieurs articles

évaluent le risque de marché en se basant sur la technique de la

Valeur à Risque et ses différentes méthodes. La

VaR donne lieu à différents modèles

d'évaluation qui lient le rendement des différents actifs aux

différents facteurs de risque :

Le premier type de modèle repose sur la méthode

des Variances Covariances développée et diffusée par JP

Morgan grâce à son système RiskMetricsTM en 1996. Cette

méthode qui se base sur une évaluation locale des positions est

appelée aussi delta normal (Jorion 2001).

Le deuxième type de modèle utilisant une

évaluation complète regroupe les méthodes de simulation

historique et de Monte Carlo.

Il existe une quatrième méthode

complémentaire aux trois précédentes appelée "

Stress testing " recommandée par le régulateur pour

évaluer la qualité des modèles de contrôle interne.

Lopez (1996) compare ces méthodes et répartit les aptitudes de

chacune. Jackson et al. (1997) examinent la possibilité de

prédire la variance des facteurs de risque (taux d'intérêt,

prix de l'actif et taux de change). Ils comparent les méthodes

paramétriques et non paramétriques de la mesure de la

VaR.

CrnKovic et Drahmann (1996) examinent la possibilité de

prédire tous les paramètres de distribution des facteurs de

risque. Kupiec (1995) étudie le Backtesting pour le modèle de la

VaR et il examine la période du temps passé jusqu'au

premier échec de l'estimation. A un niveau plus tardif, le comité

de Bale adopte ces épreuves comme une base pour examiner les

modèles internes des banques. Ces études ne fournissent pas des

épreuves statistiques claires et manquent d'exactitude quant aux

méthodes d'estimation. La plupart d'entre eux traitent l'exigence

minimale du capital en utilisant plusieurs méthodes de calcul de la

variance, et aussi par l'utilisation des données historiques de

marché plutôt que des simulations.

Hendricks (1996), Pritsker (1997), Linsmeier et Pearson

(1996), Jackson et al. (1997) et Aussenegg et Pichler (1997) comparent

l'approche standard, présentée par le Comité Bale comme

une alternative pour l'estimation du risque de marché, avec toutes les

méthodes de calcul de la VaR. Ces études examinent les

avantages et les inconvénients de chaque méthode en jouant sur

les aspects suivants : le temps de calcul vis-à-vis de l'exactitude des

évaluations (Pritsker, 1997) ; l'adaptation aux régions

géographiques différentes (Powell et Balzarotti, 1996) ; l'effet

des instruments financiers inclus dans le portefeuille d'investissement

(Aussenegg et Pichler ,1997) .

Parmi les études qui examinent l'utilisation des

modèles VaR, celle de Powell et Balzarotti (1996) qui fait une

comparaison entre l'utilisation du modèle VaR et l'approche

standard dans plusieurs pays latino américains. Powell et Balzarotti

(1996) concluent que l'approche standard est préférable à

plusieurs modèles VaR. Plusieurs modèles internes font

des suppositions et des usages d'outils de mesures différentes qui

peuvent produire des résultats variables pour le même ensemble de

paramètres du marché et de position dans le portefeuille

d'investissement. En outre, les modèles VaR sont très

sensibles aux suppositions et aux données estimées, surtout dans

le contexte d'actifs qui ne sont pas fondamentalement linéaires tels que

les produits dérivés (Marshall et Seigel, 1997). Ces derniers

notent que cette sensibilité, accompagnée de la liberté

des banques dans le choix de leurs modèles internes, expose les

systèmes bancaires et de surveillances au risque.

|