CONCLUSION

La gestion des risques opérationnels est très

récente dans les banques. Celles-ci ne se sont

intéressées à ce type de risque que depuis quelques

années suite aux diverses catastrophes qui se sont produites dans le

domaine financier et bancaire.

Dans ce chapitre, nous avons essayé d'examiner les

définitions et types des risques définis par les

théoriciens et principalement par le Comité de Bâle puis

compte tenu du lien étroit entre les risques et la rentabilité

nous avons essayé de définir la performance au niveau des

banques. Il s'agit donc d'un chapitre qui a pour objet principalement de mieux

connaître les risques opérationnels et mieux connaître la

performance bancaire compte tenu du lien entre la performance et les

risques.

CHAPITRE II : ANALYSE CRITIQUE DE LA

LITTERATURE EMPIRIQUE DU RISQUE OPERATIONNEL

INTRODUCTION

Après avoir défini le périmètre du

risque opérationnel, il faut identifier les événements

à l'origine de ce risque. Cette identification s'effectue selon une

démarche structurée principalement selon une démarche de

type bottom-up ou de type top-down.

Cette identification s'accompagne de l'établissement

d'une cartographie définissant les impacts des risques, les facteurs qui

les déclenchent ainsi que les facteurs qui déterminent leur

envergure.

Bâle II a adopté une classification des risques

qui institue sept catégories d'événement formant les

causes principales des pertes et a proposé trois Approches de mesure de

l'impact des risques opérationnelles.

La première section de ce chapitre traitera de

l'identification des risques et des outils adéquats permettant cette

identification.

Quant à la deuxième section, elle sera

consacrée aux modalités de mesures quantitatives du risque

opérationnel telles que définies par le Comité de

Bâle.

SECTION I : IDENTIFICATION DU RISQUE

OPERATIONNEL.

L'identification du risque est la première chose par

laquelle il faut commencer pour développer un contrôle et un

suivi viable du risque opérationnel.

En effet, pour pouvoir mettre en place un système

viable de gestion du risque opérationnel, il est tout d'abord

nécessaire d'identifier les facteurs internes du risque

opérationnel (la structure de la banque, nature de ses activités,

la qualité de ses ressources humaines, les modifications de

l'organisation et le taux de rotation du personnel) et externes (comme les

évolutions du secteur bancaire et les progrès technologiques) qui

pourraient empêcher la banque d'atteindre ses objectifs.

Cette identification des événements de risque

suit une démarche structurée, basée sur la

compréhension et l'analyse des processus opérationnels de la

banque, de ses produits et de ses systèmes. Elle peut s'effectuer de

différentes manières mais les deux grands types d'identification

utilisés sont l'identification bottom-up et l'identification

top-down.

· Identification bottom-up :

l'identification est effectuée ici de manière relativement libre

et ouverte par les personnes les plus proches de l'activité. Il s'agit

donc d'effectuer une remontée des risques du terrain vers les personnes

en charge de l'élaboration de la cartographie.

Ce type d'identification se fait généralement

par l'intermédiaire d'interviews. Il est souvent souhaitable d'utiliser

une grille déterminée à l'avance pour s'assurer que tous

les types de risques possibles ont bien été évoqués

au cours de l'interview.

· Identification top-down :

l'identification des risques est dans ce cas effectuée de manière

plus fermée c'est à dire au moyen d'un questionnaire de type QCM

par opposition à une identification ouverte par interviews. Le sujet

ciblé peut permettre ici l'élaboration de questionnaires

relativement exhaustifs par les personnes en charge de l'élaboration de

la cartographie. Ce processus permet ainsi de descendre chercher l'information

au lieu que l'information monte vers les personnes chargées de

l'établissement de la cartographie.

A l'issue d'une bonne évaluation, la banque disposera

pour l'ensemble de ses processus et de ses produits d'un inventaire des

événements de risques, ainsi que d'une bonne compréhension

des facteurs de risques associés.

1-1- Outils d'identification du risque

opérationnel.

Le Comité de Bâle II a proposé plusieurs

outils qui peuvent être utilisés par la banque pour identifier et

évaluer ses risques opérationnels.

1-1-1- Cartographie des

risques.

La cartographie des risques permet de définir de

manière approfondie les impacts potentiels du risque, les facteurs qui

déclenchent la survenance du risque ainsi que les facteurs qui

déterminent l'envergure du dommage. Cette phase est une étape

clé, car elle détermine sensiblement la nature des incidents qui

seront collectés et donc suivis par la suite. Elle permettra

également de définir une nomenclature des risques valables pour

l'ensemble de l'organisation, cadre indispensable à une collecte

efficace et homogène des incidents.

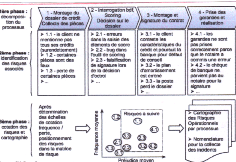

Cet exercice peut être décrit par les phases

suivantes :

1) Décomposer en activités chaque processus

supportant des risques opérationnels : Cette étape consiste

à diviser les différents processus élémentaires de

la banque en sous processus, voire d'affiner cette division en dressant une

liste des différentes fonctions au sein de chaque département de

la banque.

2) Pour chaque activité, recenser les risques

associés c'est à dire faire l'inventaire des

différents facteurs du risque opérationnel auxquels les

métiers de la banque peuvent être exposés (recensement des

litiges clients, des pertes financières dues à des

dédommagements, des rectifications d'erreurs, des discontinuités

de services, des délais anormaux de traitement d'opérations

clientèles...)

3) Pour chaque risque, coter les pertes et leur

probabilité d'occurrence c'est à dire évaluer le

risque en fonction de sa probabilité d'occurrence (fréquence)

et en fonction de la perte encourue en cas de sa réalisation

(sévérité).

4) Matricer les risques sur les axes fréquence et

préjudice : il s'agit d'un graphe à deux dimension, la

sévérité et la fréquence. La matrice est

divisée en zones selon le niveau de risque et la nécessité

des contrôles.

5)

Déterminer « visuellement », à partir de

la matrice, les risques significatifs (c'est à dire ceux que l'on

décide de recueillir dans l'outil de collecte).

A titre d'exemple, le schéma ci-dessous illustre les

phases de l'exercice de cartographie dans le cadre de l'activité

« banque de particuliers » pour le processus

« octroi de crédit immobilier » :

Figure 2 : phases de l'exercice de

cartographie dans le cadre de l'activité « banque de

dépôt » - (Source :

sia-conseil)

Il s'agit donc d'un processus dans lequel des fonctions

organisationnelles sont portées sur une carte par type de

risque selon la gravité et la fréquence de ce dernier.

La gravité est définie par les décideurs selon ce

qu'ils entendent par « grave ». Sont graves,

une perte financière, humaine, des dégâts

environnementaux,sanitaires....

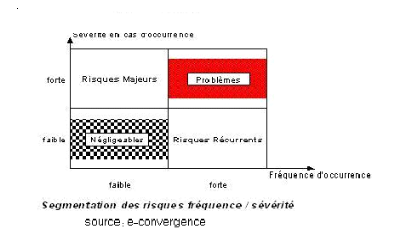

La cartographie des risques se décline en quatre grandes

catégories :

§ Risques de fréquence et de

gravité faibles : Ce sont des risques qui se

réalisent rarement et dont l'impact est limité même s'ils

se réalisent. L'organisation peut vivre avec ces risques, nous parlerons

de risques mineurs.

§ Risques de fréquence faible et de

gravité élevée : ce sont des

événements qui se produisent rarement mais dont les

conséquences sont significatives lorsqu'ils se produisent. En raison de

leur faible fréquence il est difficile de prévoir et d'anticiper

leur survenance. La concrétisation du risque entraîne des

conséquences pouvant affecter sérieusement l'activité de

l'organisation, le redémarrage nécessite l'injection de capitaux

extérieurs. Cette deuxième catégorie et

dénommée risques catastrophiques

§ Risque de fréquence élevée

et de gravité faible : ces événements se

produisent assez régulièrement mais leurs conséquences

sont relativement faibles, le risque est généralement

prévisible.

§ Risques de fréquence et de

gravité élevées : les

évènements se produisent fréquemment et leurs

conséquences sont à chaque fois significatives. Dans ce cas la

banque n'est pas viable parce qu'elle est en situation de perte permanente et

il y a un problème soit dans le fonctionnement même de la banque

soit dans l'évaluation des enjeux.

Figure 3 : segmentation des risques selon la

fréquence et la sévérité

(Source

e-convergence)

___________________________________________________________________

La conception d'une cartographie de risque est un travail

complexe et délicat et nécessite l'effort pour la collecte des

données internes et la constitution d'une base de données des

pertes recensées dont la mise à jour est indispensable pour le

suivi de l'évolution des anciens risques et la prise en

considération des nouveaux. En effet c'est à partir de cette base

qu'il sera possible plus tard de quantifier le risque, de le distribuer et

d'analyser les impacts de telle ou telle mesure prise.

1-1-2- Les indicateurs de

risque.

La cartographie représente un support de base pour la

mise en place des indicateurs de risque, de types statistiques

et souvent financiers, qui fournissent un aperçu de la position de la

banque relativement au risque et qui sont revus périodiquement.

Ces indicateurs sont de deux types, des indicateurs-

clés de risques ( key risks indicators) spécifiques

à chaque activité et constituent des indices de perte ou de

danger à venir et des indicateurs-clés de performances

(key performance indicators) qui constituent des mesures d'évaluation de

la qualité d'une activité.

Chaque activité disposera de son propre ensemble

d'indicateurs, spécifique à la nature des tâches

effectuées, au mode d'organisation des fonctions, au niveau

d'automatisation des opérations, au niveau des flux financiers

impliqués ou de la législation en vigueur.

Il n'existe pas de liste standard d'indicateurs de risque et

de performances pour l'ensemble des institutions bancaires mais on peut citer

les indicateurs de risque suivants :

· Ressources humaines : rotation du personnel,

pourcentage d'employés intérimaires, plaintes de la

clientèle ...

· Système : interruption du système,

tentative d'intrusion informatique...

· Traitement et procédures : corrections

d'écritures, plaintes et contestations...

· Indicateurs d'alerte, liés aux facteurs de

risque : volumétrie, turnover des équipes, ...

· Indicateurs de risques avérés,

liés aux conséquences : nombre d'erreurs, de sinistres ou de

litiges, durées d'indisponibilité des systèmes, nombre de

tentatives d'intrusion, d'incidents ...

· Indicateurs de coûts/ressources : le niveau

de ressources allouées au contrôle des risques

opérationnels, Budget "sécurité"

· Indicateurs de pertes : pertes financières

liées aux incidents, aux erreurs, dédommagements

clientèle...

SECTION II : LES MESURES REGLEMENTAIRES DU RISQUE

OPERATIONNEL SELON BALE II

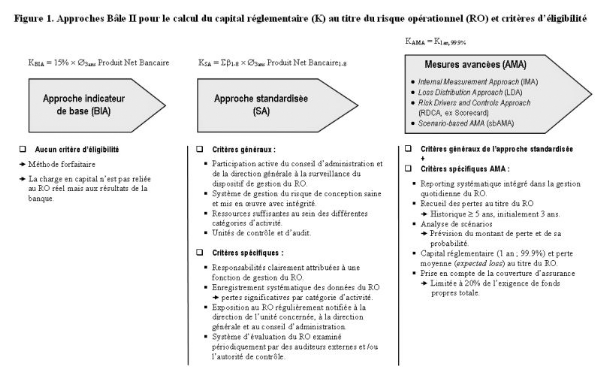

La mesure du risque opérationnel correspond à

une valeur en risque, similaire dans son principe à celle

calculée dans les domaines du risque de marché et du risque de

crédit. Elle doit couvrir à la fois les pertes attendues

(expected loss) et les pertes exceptionnelles (unexpected loss). Pourtant, en

théorie, les fonds propres réglementaires ne couvrent que les

pertes exceptionnelles et non les pertes moyennes, ces dernières

étant censées être couvertes par des provisions ou

imputées sur le résultat courant. Le Comité de Bâle

propose trois approches distinctes pour déterminer le capital

réglementaire au titre du risque opérationnel :

· L'Approche Indicateur de Base (Basic Indicator

Approach ou BIA)

· L'Approche Standard (Standardised Approach ou SA)

· Les Approches de Mesures Avancées (Advanced

Measurement Approach ou AMA).

Les banques ont la possibilité de choisir parmi ces

Approches celle qui leur paraît correspondre le mieux à la

spécificité de leur activité, mais aussi à leur

capacité globale d'action. Elles doivent en effet s'assurer qu'elles

disposent de l'ensemble des moyens nécessaires à la mise en

oeuvre de la solution retenue. Le degré de sophistication de chacune de

ces trois méthodes est en effet croissant.

Seulement si une banque a opté pour une approche

donnée, elle ne pourra revenir à une approche plus simple que si

elle a obtenu l'approbation de l'autorité de contrôle. Cette

autorité, au cas où elle détermine qu'une banque ne

répond pas aux critères d'éligibilité à une

approche donnée peut demander à cette banque de revenir à

une approche plus simple pour une partie ou pour l'ensemble de ses

activités, jusqu'à ce qu'elle satisfasse aux conditions

posées par l'autorité de contrôle pour utiliser à

nouveau l'approche plus élaborée.

2-1- L'Approche de l'Indicateur de

Base.

Selon l'Approche de l'Indicateur de Base (Basic Indicator

Approach ou BIA), le capital réglementaire en couverture du risque

opérationnel est égal à un pourcentage, appelé

facteur alpha, égal à 15% du revenu annuel brut positif moyen

(Gross Income ou GI) de l'établissement sur les trois dernières

années. Celui-ci se définit comme la somme des

intérêts créditeurs nets et autres produits d'exploitation.

Il exclut les provisions, les frais d'exploitation, les plus ou moins values

réalisées sur la cession de titres du portefeuille, et les

éléments exceptionnels ou inhabituels

La règle peut être exprimée par

l'équation suivante :

K= á. RB (3)

Avec K le capital réglementaire, RB le revenu brut et

á = 15%

Selon cette approche très simplifiée, l'ampleur

du risque opérationnel est une fonction positive du volume des

activités, dont les différents éléments du revenu

annuel brut sont des estimateurs. Les données de revenus, directement

puisées dans la comptabilité, ont l'avantage d'être

disponible pour toutes les institutions, à la différence d'autres

indicateurs plus complexes.

Le taux de 15% a été retenu suite aux deux

premières études quantitatives d'impact réalisées

lors du calibrage de l'accord de Bâle. En effet, il apparaît qu'en

moyenne 15% du revenu annuel brut représentent le montant cible de

capital réglementaire opérationnel pour les 29

établissements ayant répondu aux premières études

quantitatives d'impact lancées par le Comité de Bâle en

mai 2001 (BIS, 2002).

L'Approche de l'Indicateur de Base BIA vise

spécifiquement les plus petits établissements, les petites

structures de banques locales ou filiales, de moindre importance, pour

lesquels le coût de mise en place d'approches plus

élaborées serait excessif. Les banques internationales sont

toutefois invitées à adopter l'une des deux approches plus

complexes ( Approche Standard SA ou Approche de Mesures Avancées

AMA).

Le Comité de Bâle (BIS, 2OO3 b) précise

à ce sujet, en effet, que :

« - les banques sont invitées à

passer de l'approche la plus simple à l'approche la plus complexe

à mesure qu'elles développent des systèmes et des

pratiques de mesure plus élaborées du risque

opérationnel.

- les banques à dimension internationale ou

exposées à un risque opérationnel important

(établissements spécialisés offrant des services de

traitement par exemple) sont censées utiliser une approche correspondant

à leur profil de risque et à la complexité de leurs

activités) ».

2-2- L'Approche Standard

L'Approche Standard SA est un prolongement plus fin de

l'Approche Indicateur de Base BIA. Elle se base sur le revenu brut annuel moyen

non pas de l'ensemble de l'établissement mais de celui

détaillé par ligne d'activité.

Le capital réglementaire est ici fonction d'un

pourcentage du produit brut, appelé facteur bêta, établi

à 12%, 15%, ou 18% selon le niveau du risque opérationnel

estimé de chaque activité ce qui se traduit par la règle

suivante :

K = Ó KLi = Ó âLi .

RBLi (4)

Avec KLi désigne le capital

réglementaire associé à la ligne i, RBLi le

revenu brut de la ligne correspondante, et âLi le

coefficient associé.

L'Approche Standardisée permet par ailleurs de prendre

en compte la nature de l'activité de l'institution.

Ainsi, une institution dont l'activité se concentre sur

les opérations les moins risquées bénéficiera d'une

charge en capital moindre que celle existante dans tous les types

d'activités ou dans les plus risquées.

Le tableau ci-dessous détaille les lignes

d'activités et les pourcentages de revenus correspondants pour le calcul

du capital réglementaire.

|

Catégories d'activité

|

Taux â

|

|

Financement des entreprises

|

18%

|

|

Négociation et vente

|

18%

|

|

Banque de détail

|

12%

|

|

Banque commerciale

|

15%

|

|

Fonction d'agent

|

15%

|

|

Paiement et règlement

|

18%

|

|

Gestion d'actifs

|

12%

|

|

Courtage de détail

|

12%

|

Les taux de calcul du capital réglementaire de 12%,

15% et 18% proviennent de la deuxième étude quantitative

d'impact portant sur les 29 établissements ayant

répondu à l'enquête lancée par le Comité de

Bâle.

A propos des Méthodes Standardisées et des

coefficients bêta ß, le Comité

reste prudent, en précisant que : « une banque

doit élaborer des politiques spécifiques et disposer de

critères consignés par écrit pour mettre en correspondance

le produit brut des diverses catégories d'activité et

unités avec le dispositif standardisé. Les critères

doivent faire l'objet d'un examen et d'un ajustement, selon les besoins, de

façon à intégrer les innovations/changements

d'activité et de modification des risques »

( BIS, 2OO3b).

D'autre part, le Comité de Bâle préconise

à l'autorité de contrôle nationale d'autoriser une banque

à appliquer la variante de l'Approche Standard qui est

l'Approche Standard Alternative ASA au cas où cette

banque démontre que l'Approche ASA

apporte une amélioration, permettant par exemple d'éviter un

double comptage des risques. Seulement, si cette banque a adopté une

approche ASA, elle ne pourra pas revenir à l'Approche Standard sans

l'autorisation de son autorité de contrôle. Par ailleurs, Il n'est

pas envisagé de permettre aux grosses banques détenant des

portefeuilles diversifiés sur les principaux marchés d'utiliser

cette approche ASA.

En plus, dans le cadre de l'Approche Standard Alternative ASA,

l'exigence de fonds propres au titre du risque opérationnel et sa

méthodologie de calcul sont identiques à celles de l'Approche

Standard, sauf pour les deux lignes de métier « banque de

détail » et « banque commerciale » pour

lesquelles sont utilisés comme indicateur de risque les prêts et

avances - multipliés par un facteur fixe « m » - au lieu du

produit brut; les bêta sont identiques à ceux de l'approche

standard. L'exigence de fonds propres dans le cadre de l'Approche ASA au titre

du risque opérationnel pour l'activité de banque de détail

est exprimée de la façon suivante (la formule étant

identique pour l'activité de banque commerciale) :

KNI = âNI

. m . PANI

(5)

Où KNI correspond à l'exigence de

fonds propres pour l'activité de détail,

âNI au bêta pour

l'activité de détail, PANI au total de l'encours des

prêts et avances à la clientèle de détail (non

pondérés des risques et avant déduction des provisions),

calculé en moyenne sur les trois années écoulées et

m égal à 0,035 ou 3,5%.

Par ailleurs, le total des prêts et avances dans

l'activité de détail comprend l'ensemble des montants

tirés sur les portefeuilles de crédit suivants : détail

; PME assimilées à la clientèle de détail ;

acquisition de créances sur la clientèle de détail. Quant

à la banque commerciale, le total des prêts et avances comprend

les montants tirés sur les portefeuilles de crédit suivants :

entreprises ; emprunteurs souverains ; banques ; financement

spécialisé ; PME assimilées aux entreprises ; acquisition

de créances sur les entreprises. La valeur comptable des titres

détenus dans le portefeuille bancaire doit également être

incluse.

En appliquant l'ASA, les banques de détail et

commerciales peuvent agréger leurs activités de détail et

de banque commerciale, en leur affectant un bêta de 15 %. De même,

les banques qui ne sont pas en mesure d'affecter le produit brut aux six autres

lignes de métier peuvent agréger le produit brut total

correspondant et lui appliquer un bêta de 18 %.

Comme dans l'Approche Standard, l'exigence de fonds propres

totale représente la somme des exigences de fonds propres pour chacune

des huit lignes de métier.

2-3- Les Approches de Mesure Avancées

(AMA)

Il ne s'agit plus d'une approche unique, définie par le

régulateur, mais d'un ensemble de modèles internes réunies

sous le vocable d'« Approche de Mesures Complexes AMC » ou

« Approche de Mesure Avancées Advanced Measurement Approach

AMA » approuvé par les autorités de contrôle sur

la base d'une série de critères.

Selon l'Approche AMA, l'exigence de fonds propres

réglementaires équivaut à la mesure du risque

opérationnel produite par le système interne de la banque, sur

base de critères quantitatifs et qualitatifs. (BIS, 2003b)

Le Comité de Bâle propose plusieurs alternatives

au sein du régime AMA, dont principalement, la méthode Scorecard,

l'analyse de scénarios (Scenario-based AMA), et la méthode LDA

(Loss Distribution Approach), la plus sophistiquée au plan technique. La

pratique de chacune de ces méthodes est soumise au respect d'un ensemble

de critères qualitatifs, notamment en termes d'évaluation du

risque opérationnel et de procédure de collecte des

données de perte qui constituent leur dénominateur commun. La

différence, par contre, concerne essentiellement le type d'information

privilégié dans le calcul du capital réglementaire.

Les accords de Bâle II n'imposent aucune méthode

particulière de calcul pour les banques adoptant l'Approche de Mesures

Complexes (AMA). Ce choix est laissé à la discrétion des

banques, pourvu qu'elles satisfassent aux critères qualitatifs et

quantitatifs énoncés dans l'accord de Bâle.

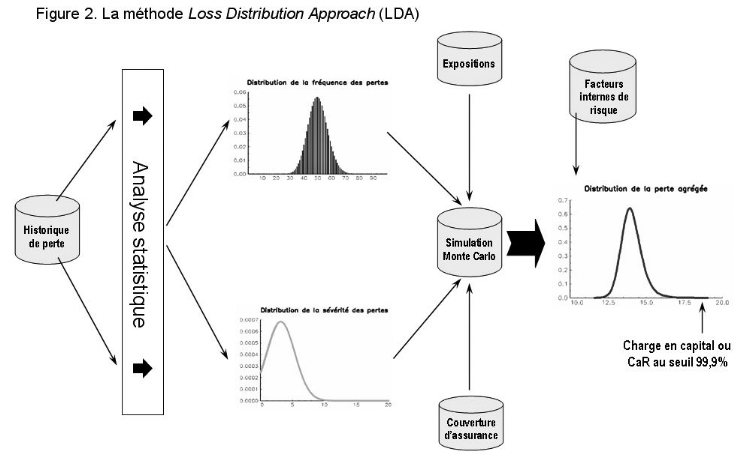

2-3-1- L'Approche de Distribution des

Pertes ou Loss Distribution Approach LDA.

L'idée de base de cette approche est simple. Elle

consiste à considérer que la perte annuelle totale d'une banque

due au risque opérationnel se compose de deux éléments qui

sont la fréquence et la sévérité. Chacun de ces

éléments se présente sous la forme d'une distribution

statistique. La distribution de fréquence représente l'occurrence

d'événements de pertes opérationnelles,

c'est-à-dire le nombre de pertes observées. La distribution de

sévérité traduit par contre l'amplitude de ces pertes,

à savoir le montant, en unités monétaires, des pertes

individuelles subies par la banque.

L'idée générale de la méthode LDA

(Loss Distribution Approach) est de modéliser la perte liée au

risque opérationnel pour une période donnée (par exemple,

un an) et d'en déduire la valeur en risque. Frachot et al. (2003)

proposent de procéder en cinq étapes pour implémenter

cette méthode :

? Estimation de la distribution de

sévérité ;

? Estimation de la distribution de la fréquence ;

? Calcul de la charge en capital;

? Calcul des intervalles de confiance;

? Incorporation des avis d'experts.

Pour cette approche on ne va pas entrer dans la formulation

mathématique de ces différentes étapes, mais simplement de

comprendre l'idée générale de la méthode LDA.

A l'instar de la plupart des modèles de mesure du

risque opérationnel, la LDA se fonde sur une approche actuarielle

(fréquence/sévérité) très ancienne largement

utilisée dans le domaine de l'assurance pour modéliser des

problèmes similaires.

Pour que le modèle LDA puisse tourner, il faut lui

fournir deux éléments essentiels : la distribution de la

sévérité des pertes (loss severity distribution) et la

distribution de la fréquence des pertes (loss frequency distribution).

Ces deux distributions, qui forment l'historique des pertes, sont ensuite

combinées par une technique statistique

appelée « convolution » (Monte Carlo) afin

d'obtenir la distribution de la perte totale. Celle-ci étant le

résultat de plusieurs pertes successives, il s'agit d'une perte

agrégée (aggregate loss distribution).

A partir de la perte totale, on dérive ensuite la perte

attendue ou moyenne (expected loss) et la perte exceptionnelle (unexpected

loss), pour un niveau de confiance donné. La Figure ci après

illustre le principe de la méthode LDA.

Figure 4 : la méthode Loss

Distribution Approach (LDA)

__________________________________________________________

L'accord de Bâle stipule qu' « un

établissement doit faire la preuve que sa mesure du risque

opérationnel répond à un critère de solidité

comparable à celui de l'approche NI pour le risque de crédit

(correspondant à une période de détention d'un an et

à un intervalle de confiance de 99,9%) (BIS

2004 § 667) ce qui revient à prendre le 99,9ème percentile

de la distribution de pertes agrégées. On utilise souvent cette

notion en matière de gestion des risques financiers sous le terme de

Valeur-au-Risque avec un intervalle de confiance de 99,9%.

2-3-2- L'approche Scorecard.

L'appellation « Scorecard » regroupe un

ensemble d'approches visant à identifier, mesurer et surveiller les

risques opérationnels. Ces approches traduisent une évaluation

qualitative des risques et des contrôles en une valeur numérique

ou score.

L'un des objectifs poursuivis par les banques ayant

développé et implémenté une approche Scorecard est

de se doter d'un outil permettant de faire le lien entre la mesure et la

gestion du risque opérationnel.

Les grandes étapes de mise en oeuvre de la

démarche Scorecard sont les suivantes :

Evaluation du capital initial en se basant sur une autre

approche : celle-ci pourrait être l'approche LDA, l'approche des

scénarios, l'utilisation du benchmarking ou une méthode

forfaitaire. Il est crucial à ce stade de considérer ce capital

initial crédible.

Définition de la structure de la Scorecard et sa mise

en oeuvre, permettant d'aboutir à un score pour chaque catégorie

de risque et pour chaque ligne de service.

Allocation du capital initial aux lignes de service sur base

du score et donc des performances de l'organisation en matière de

maîtrise du risque opérationnel. Par la suite, le capital

alloué à chaque ligne de service va varier en fonction de

l'évolution des résultats de Scorecard. Dans cette approche, le

capital initial n'est pas recalculé à chaque évaluation.

Conformément aux exigences du comité de

Bâle, les données internes ont également un rôle

à jouer dans l'approche Scorecard.

Ces données internes et externes sont utilisées

à plusieurs niveaux. En effet, elles peuvent être utilisées

de la détermination du capital initial en utilisant une approche de

distribution de pertes. Une autre utilisation intéressante de ces pertes

est leur analyse afin d'identifier les facteurs de risques ayant amené

à la réalisation de ces pertes est leur analyse afin d'identifier

les contrôles internes permettant de réduire l'impact ou de

contrôler les facteurs de risque identifiés.

Une fois la Scorecard établie et utilisée, les

pertes internes et externes peuvent être utilisées afin de valider

la qualité des réponses apportées aux questionnaires. De

plus, leur analyse régulière permet de s'assurer que les risques

et facteurs de risque associés sont actualisés, ce qui permet de

prendre en compte l'apparition de nouveaux facteurs de risque dans l'analyse.

La validation des résultats de la Scorecard avec des données

objectives est importante, compte tenu des nombreux éléments

subjectifs intervenant dans sa construction.

Le Comité de Bâle n'a fourni aucune formulation

mathématique pour cette approche. Néanmoins, les groupes de

travail au sein des banques ont proposé des formules de calcul du

capital réglementaire (K) de la forme :

KScorecard = EIij ×

ùij × RSij (6)

Avec EI l'indicateur d'exposition (Exposure Indicator), RS le

score de risque (Risk Score) et ù un facteur d'échelle (Scale

Factor).

2-3-3- L'approche par les

scénarios.

L'approche par les scénarios est un prolongement de

l'approche Scorecard. Le risque y est envisagé comme une combinaison de

la sévérité et de la fréquence des pertes

potentielles sur une période donnée. La fréquence et la

sévérité (potentielles) de la perte peuvent être

mesurées en unités monétaires et en nombre d'occurrences

annuelles. Le risque reflète en quelque sorte la

vulnérabilité de la banque. L'évaluation du risque devrait

par conséquent se focaliser sur les vecteurs de cette

vulnérabilité. Or, celle-ci provient pour l'essentiel des

facteurs de risque sous-jacents. Réduire le niveau du risque

opérationnel impose donc une bonne lisibilité de l'exposition du

portefeuille de la banque aux différents facteurs de risque

préalablement définis.

L'un des objectifs de l'utilisation de cette approche dans la

quantification des risques opérationnels est de fournir une

évaluation prospective du risque opérationnel.

En fait, on pourrait considérer que l'évaluation

du risque est intrinsèquement liée à l'analyse de

scénarios, qui s'applique d'ailleurs aussi aux risques de marché

et de crédit.

De manière générale, les scénarios

sont des événements susceptibles de se produire dans l'avenir.

Ils expriment l'idée selon laquelle les experts d'une banque ont

certaines intuitions ou des informations sur le risque qui ne sont pas

contenues dans l'historique de données. Pour être

réellement utile à des fins de décision en matière

de risque, une analyse de scénarios doit être en mesure de

répondre à ces deux questions : à quelle fréquence

le scénario X est-il susceptible de se produire ? Quel est le montant de

la perte si le scénario X se produit ?

L'axe principal de développement de cette approche est

le développement et l'évaluation des scénarios, ces

derniers doivent permettre d'évaluer les deux paramètres

caractérisant le risque : la fréquence et la

sévérité potentielle d'un événement

générateur de perte.

Cette évaluation nécessite la constitution de

scénarios, chaque scénario prenant en considération

l'ensemble des facteurs de risque opérationnel.

Parmi les facteurs de risque opérationnel les plus

courants, on recense le niveau de compétence/qualification du personnel,

l'organisation interne/transferts d'information, l'infrastructure IT (

sécurité des systèmes), les procédures de

contrôle des activités non autorisées/vol et fraude/erreurs

non intentionnelles ( saisie, exécution et suivi des transactions), les

mesures de protection contre des catastrophes et autres sinistres, ou encore,

le respect des obligations légales ( conformité, diffusion

d'informations et devoir fiduciaire).

En considérant ces différents

éléments, la banque va donc générer des

scénarios sous forme de questions « what if ».

Pour chaque scénario, l'évaluateur

considère plusieurs hypothèses, dont par exemple un cas normal,

un cas extrême et un cas catastrophique.

En effet, les scénarios vont se construire en fonction

de l'organisation de la banque et de la catégorisation

d'événement de pertes. Les facteurs de risque et les indicateurs

de risque associés serviront de contexte et de base à

l'évaluation des scénarios.

Figure 5 : Approches Bâle II pour le calcul

du capital règlementaire au titre du risque opérationnel et

critères d'éligibilité

________________________________________________________________________ ________________________________________________________________________

|